从GoogleSpanner漫谈分布式存储与数据库技术

分布式数据库技术与应用分析

分布式数据库技术与应用分析随着互联网的发展和应用范围的拓展,数据规模也不断地扩大,因此,人们需要更高效的方式来存储、管理和处理数据。

在这样的背景下,分布式数据库技术应运而生。

本文将对分布式数据库技术进行分析及其应用。

一、分布式数据库技术的概念与优势分布式数据库技术指的是将一个数据库分为多个部分,分别存储在多个不同的计算机上,并通过网络进行通信,从而形成了一个虚拟的数据库,使得数据可以在不同的地方、不同的时间点进行存取。

与传统的集中式数据库相比,分布式数据库技术具有以下的优势:1. 可靠性更高:分布式数据库技术使用了数据备份、冗余和分布式交易等多种机制,保证了数据的复制和恢复能力,在一台计算机出现故障时,仍然可以进行数据的读取和操作。

2. 更高的性能:由于数据分布在多台计算机上,分布式数据库可以通过对各个计算机的并行处理来提高处理速度,从而提高了整个数据库的性能。

3. 扩展性更强:由于分布式数据库可以不断地添加计算机来扩展存储空间,使得整个系统的存储和处理能力可以很方便地进行扩展,以适应数据规模的增长。

二、分布式数据库技术的实现方式分布式数据库技术的实现方式主要包括:垂直划分、水平划分和复制等。

其中,垂直划分是将数据库按照数据表进行划分,每个表分别存储在不同的计算机上;水平划分是将数据表中的数据按照行或列进行划分,使得同一个数据表中的数据可以分布在不同的计算机上;而复制则是将同样的数据存储在多个不同的计算机上,以实现数据的备份和冗余。

三、应用场景及实践案例分布式数据库技术在实际应用中可以解决很多问题,如数据安全性、负载均衡和数据存取速度等方面的问题,适用于大型企业和互联网应用。

以下是一些常见的应用场景和实践案例:1. 金融行业:在交易、结算等领域,金融行业需要处理海量的交易数据,采用分布式数据库技术可以实现高效的交易系统,保证金融系统的安全性和可靠性。

2. 电商平台:电商平台的订单、库存等数据会随着用户的增多而呈指数增长,采用分布式数据库技术可以实现大规模并发操作,以及快速的数据读取和写入。

tidb 原理

tidb 原理TiDB原理:分布式数据库的新选择TiDB是一种分布式数据库,它采用了分布式事务和分布式存储技术,可以实现高可用性、高性能和高扩展性。

TiDB的核心原理是将数据分散存储在多个节点上,同时使用Raft协议保证数据的一致性和可靠性。

TiDB的分布式存储技术是基于TiKV实现的。

TiKV是一种分布式键值存储引擎,它采用了Raft协议来保证数据的一致性和可靠性。

TiKV将数据分散存储在多个节点上,每个节点都有自己的数据副本。

当一个节点发生故障时,其他节点可以接管它的工作,保证数据的可用性和一致性。

TiDB的分布式事务技术是基于TiDB实现的。

TiDB是一种分布式关系型数据库,它采用了Google Spanner的分布式事务技术。

TiDB 将数据分散存储在多个节点上,每个节点都有自己的数据副本。

当一个事务需要跨越多个节点时,TiDB会使用2PC协议来保证事务的一致性和可靠性。

TiDB的高可用性是基于Raft协议实现的。

Raft协议是一种分布式一致性协议,它可以保证数据的一致性和可靠性。

当一个节点发生故障时,其他节点可以接管它的工作,保证数据的可用性和一致性。

TiDB的高性能是基于分布式存储和分布式事务技术实现的。

TiDB将数据分散存储在多个节点上,每个节点都有自己的数据副本。

当一个事务需要跨越多个节点时,TiDB会使用2PC协议来保证事务的一致性和可靠性。

这种分布式存储和分布式事务技术可以大大提高数据库的性能和扩展性。

TiDB是一种分布式数据库,它采用了分布式事务和分布式存储技术,可以实现高可用性、高性能和高扩展性。

TiDB的核心原理是将数据分散存储在多个节点上,同时使用Raft协议保证数据的一致性和可靠性。

TiDB是分布式数据库的新选择,它可以满足大规模数据存储和处理的需求。

分布式系统Spanner

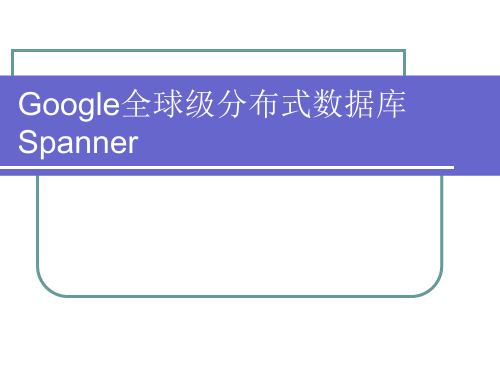

全球级分布式数据库Google Spanner原理介绍与分析1摘要Spanner 是Google的分布式数据库(Globally-Distributed Database) 。

其扩展性能达到了令人咋舌的全球级,可以扩展到数百万的机器,数已百计的数据中心,上万亿的行。

除了夸张的扩展性之外,它还能同时通过同步复制和多版本来满足外部一致性,在CAP三者之间完美平衡。

Spanner设计中一个亮点特性就是TrueTime。

在时间API中明确给出时钟不确定性,以更加强壮的时间语义来构建分布式系统。

本文对Google Spanner从提出背景、设计、原理应用等方面进行了详细的介绍。

在本文的最后,作者对GoogleSpanner进行了分析,就CAP理论和其优点谈及了自己的看法。

关键字: 分布式系统、数据库、TrueTime、RDBMS2ABSTRACTSpanner is Google's global distributed database. The expansion performance reached global level that can be extended to millions of machines, hundreds of data centers, trillion data rows. In addition to the amazing expansion performance, Spanner can meet the external consistency both through synchronized replication and multi version, achieved the perfect balance between the three CAP theorem. One of the highlights in the design of the Spanner isTrueTime. In this time API, the uncertainty of the clock is defined, and the distributed system is constructed with a more robust time semantics.In this paper, the background, design, principle and application of Spanner Google are introduced in detail. At the end of this paper, the author analyzes the Google Spanner, and talked about his own views on the CAP theory and its advantages.Keywords:Distributed System、Database、TrueTime、RDBMS目录1 摘要 (1)2 ABSTRACT (2)3 绪论 (1)3.1 背景介绍 (1)3.2 Spanner的前身——著名的Bigtable (1)3.3 可容错可扩展的RDBMS-F1 (2)3.4 Spanner简介 (2)4原理与实现 (3)4.2 Spanserver软件栈 (4)4.3目录和放置 (5)4.4数据模型 (7)4.5 TrueTime API (8)5 Spanner的应用 (9)6 总结 (11)6.1 CAP理论 (11)6.2 Spanner的优点 (12)7 参考文献 (14)3绪论3.1背景介绍Google是全球著名的互联网公司,拥有全球最大的谷歌搜索引擎,全球广泛使用的谷歌分析、谷歌地球、谷歌地图等核心业务。

细数Google核心数据库技术

细数Google核心数据库技术 2010-08-13 09:58 榆钱沽酒博客园我要评论(0)∙摘要:在这里我们将细数Google的核心数据库技术,包括大规模数据处理,分布式数据库技术和数据中心方案等等。

∙标签:Gooele∙限时报名参加“甲骨文全球大会·2010·北京”及“JavaOne和甲骨文开发者大会2010”分布式大规模数据处理MapReduce首先,在Google数据中心会有大规模数据需要处理,比如被网络爬虫(Web Crawler)抓取的大量网页等。

由于这些数据很多都是PB级别,导致处理工作不得不尽可能的并行化,而Google为了解决这个问题,引入了MapReduce这个编程模型,MapReduce是源自函数式语言,主要通过"Map(映射)"和"Reduce(化简)"这两个步骤来并行处理大规模的数据集。

Map会先对由很多独立元素组成的逻辑列表中的每一个元素进行指定的操作,且原始列表不会被更改,会创建多个新的列表来保存Map的处理结果。

也就意味着,Map操作是高度并行的。

当Map工作完成之后,系统会先对新生成的多个列表进行清理(Shuffle)和排序,之后会这些新创建的列表进行Reduce操作,也就是对一个列表中的元素根据Key值进行适当的合并。

下图为MapReduce的运行机制:图2. MapReduce的运行机制(参[19])点击查看大图接下来,将根据上图来举一个MapReduce的例子:比如,通过搜索Spider将海量的Web页面抓取到本地的GFS 集群中,然后Index系统将会对这个GFS集群中多个数据Chunk 进行平行的Map处理,生成多个Key为URL,value为html页面的键值对(Key-Value Map),接着系统会对这些刚生成的键值对进行Shuffle(清理),之后系统会通过Reduce操作来根据相同的key值(也就是URL)合并这些键值对。

GOOGLE分布式数据库技术演进研究

GOOGLE分布式数据库技术演进研究熊剑(中兴通讯股份有限公司成都研发中心)【摘要】大数据和云计算已经成为现有信息技术发展主流方向和趋势,分布式数据库技术是这些技术的基础和核心,GOOGLE作为整个业界技术的领导者,提出了BIGTABLE、DREMEL、SPANNER等一系列分布式数据库产品,让人感叹其超凡技术成就的同时,也展示出GOOGLE在分布式数据库技术上的演进路线,国内对于这些技术都有一些介绍,但是还未把这些产品串接起来,对分布式数据库技术实践和探索方向进行整合分析,作者对这些产品核心技术进行分析,结合自身对于分布式数据库的理解,力争展示出分布式数据库技术前进的脉络和方向。

【关键词】ACID;CAP;RDBS;Bigtable; Dremel; Spanner; F1;GFS;TrueTime; Colossus【中图分类号】【文献标识码】A Research of Evolution of distributed database technologyGOOGLE.Xiong Jian(ZTE Corporation Chengdu Research Center)【ABSTRACT 】Big data and cloud computing has become the current mainstream IT development trends, distributed database technology is the foundation of these technologies, GOOGLE is the role of this industry, proposed Bigtable, Dremel, Spanner series distributed database products, these products got extraordinary technical achievements, demonstrated the GOOGLE evolution path of distributed database technology, in recent years ,paper or BBS has introduction of these technologies, but these products have not yet connected in series, gave corresponding distributed database technology practice and exploration direction of meta-analysis, the authors analyze the core technology of these products, combined with their understanding of the distributed database, and strive to show the direction of distributed database technology.【KEY WORDS 】ACID;CAP;RDBS;Bigtable; Dremel; Spanner; F1;GFS;TrueTime; Colossus1 引言在传统RDBM系统中,对于事务处理必须处理为一个完整的逻辑处理过程,具备ACID四个特性,A Atonomy 事务处理的原子性,要么成功,要么失败,C Consistency 一致性,数据库必须保持原有约束的关系,数据之间必须符合数据完整性,I Isolation 事务处理必须要彼此隔离,由RDBM保证能够并发处理事务,而不需要用户显示的干预,DDurability 数据能够被持久化下来,不会出现事务涉及数据丢失的情况。

全球级的分布式数据库 Google Spanner原理

全球级的分布式数据库Google Spanner原理红薯发表于9-20 08:34 1个月前, 44回/13733阅, 最后回答: 1个月前讨论区»技术分享【珠海】11月25日(周日下午)OSC 源创会我要报名»Google Spanner简介Spanner 是Google的全球级的分布式数据库(Globally-Distributed Database) 。

Spanner的扩展性达到了令人咋舌的全球级,可以扩展到数百万的机器,数已百计的数据中心,上万亿的行。

更给力的是,除了夸张的扩展性之外,他还能同时通过同步复制和多版本来满足外部一致性,可用性也是很好的。

冲破CAP的枷锁,在三者之间完美平衡。

Spanner是个可扩展,多版本,全球分布式还支持同步复制的数据库。

他是Google的第一个可以全球扩展并且支持外部一致的事务。

Spanner能做到这些,离不开一个用GPS和原子钟实现的时间API。

这个API能将数据中心之间的时间同步精确到10ms以内。

因此有几个给力的功能:无锁读事务,原子schema修改,读历史数据无block。

EMC中国研究院实时紧盯业界动态,Google最近发布的一篇论文《Spanner: Google’s Globally-Distributed Database》, 笔者非常感兴趣,对Spanner进行了一些调研,并在这里分享。

由于Spanner并不是开源产品,笔者的知识主要来源于Google的公开资料,通过现有公开资料仅仅只能窥得Spanner的沧海一粟,Spanner背后还依赖有大量Google的专有技术。

下文主要是Spanner的背景,设计和并发控制。

Spanner背景要搞清楚Spanner原理,先得了解Spanner在Google的定位。

从上图可以看到。

Spanner位于F1和GFS之间,承上启下。

所以先提一提F1和GFS。

F1和众多互联网公司一样,在早期Google大量使用了Mysql。

Google全球级分布式数据库Spanner

Colossus系统架构

Colossus(GFS II)

GFS将整个系统的节点分为三种角色:GFS Master (总控服务器),GFS Chunkserver(数据块服务器, 简称CS)以及GFS Client(客户端)。 GFS文件被划分为固定大小的数据块(Chunk),由 Master在创建时分配一个64位全局唯一的Chunk句柄。 CS以普通的Linux文件的形式将Chunk存储在磁盘中。 为了保证可靠性,Chunk在不同的机器中复制多份,默 认为三份。 Master中维护了系统的元数据,包括文件及Chunk名字 空间,GFS文件到Chunk之间的映射,Chunk位置信息。 它也负责整个系统的全局控制,如Chunk租约管理,垃 圾回收无用Chunk,Chunk复制等等。Master会定期与 CS通过心跳的方式交换信息。

Colossus(GFS II) [kəˈl ɒsəs]

Colossus是第二代GFS,对应开源世界的新 HDFS。Google文件系统GFS是构建在廉价的 服务器之上的大型分布式系统。它将服务器故 障视为正常现象,通过软件的方式自动容错, 在保证系统可靠性和可用性的同时,大大减少 了系统的成本。 GFS是Google云存储的基石,其它存储系统, 如Google Bigtable,Google Megastore, Google Percolator [p:klet(r)]均直接或者间接 地构建在GFS之上。另外,Google大规模批处 理系统MapReduce也需要利用GFS作为海量数 据的输入输出。

Spanner背景

Spanner 是Google的全球级的分布式数 据库 (Globally-Distributed Database) 。 Spanner的扩展性达到了令人咋舌的全球 级,可以扩展到数百万的机器,数已百计 的数据中心,上万亿的行。更给力的是, 除了夸张的扩展性之外,它还能同时通过 同步复制和多版本来满足外部一致性,可 用性也是很好的。冲破CAP的枷锁,在三 者之间完美平衡。

Google全球级分布式数据库Spanner精品PPT课件

Colossus系统架构

Colossus(GFS II)

GFS将整个系统的节点分为三种角色:GFS Master (总控服务器),GFS Chunkserver(数据块服务器, 简称CS)以及GFS Client(客户端)。

GFS文件被划分为固定大小的数据块(Chunk),由 Master在创建时分配一个64位全局唯一的Chunk句柄。 CS以普通的Linux文件的形式将Chunk存储在磁盘中。 为了保证可靠性,Chunk在不同的机器中复制多份,默 认为三份。

Design Goals

Spanner背景

要搞清楚Spanner原理,先得了解Spanner在Google的 定位。

F1

和众多互联网公司一样,在早期Google 大量使用了Mysql。Mysql是单机的,可 以用Master-Slave来容错,分区来扩展。 但是需要大量的手工运维工作,有很多的 限制。因此Google开发了一个可容错可 扩展的RDBMS-F1。和一般的分布式数据 库不同,F1对应RDMS( Relational Database Management System )应有的 功能,毫不妥协。起初F1是基于Mysql的, 不过以后会逐渐迁移到Spanner。

F1特点

7×24高可用。哪怕某一个数据中心停止 运转,仍然可用。

可以同时提供强一致性和弱一致性。 可扩展 支持SQL 事务提交延迟50-100ms,读延迟5-10ms,

高吞吐

众所周知Google BigTable是重要的NoSql产品, 提供很好的扩展性,开源世界有HBase与之对 应。为什么Google还需要F1,而不是都使用 BigTable呢?因为BigTable提供的最终一致性, 一些需要事务级别的应用无法使用。同时 BigTable还是NoSql,而大量的应用场景需要有 关系模型。就像现在大量的互联网企业都使用 Mysql而不愿意使用HBase,因此Google才有 这个可扩展数据库的F1。而Spanner就是 F1的 至关重要的底层存储技术。

分布式存储技术在大数据应用中的研究与实现

分布式存储技术在大数据应用中的研究与实现随着互联网时代的到来,我们生活在信息化的时代,大数据逐渐成为各行各业中不可或缺的一部分。

对于信息量极大的数据,其存储与管理也变得愈发困难。

在这种情况下,分布式存储技术便应运而生。

一、分布式存储技术的介绍分布式存储技术,又称分布式文件系统,指在多个计算机上分散存储相同的文件数据,从而增加存储容量及保障安全性,分布式存储系统具有容错能力好、扩展性强、管理和维护方便等特点。

二、大数据应用中的分布式存储技术在大数据时代中,出现了一些新型的应用,例如云计算、物联网等。

这些应用往往带来了大量的数据,这些数据的处理已经超出了传统的存储技术。

因此,大数据时代更加需要稳定可靠的分布式存储技术。

无论是数据分析、数据挖掘还是图像处理,分布式存储技术都能够帮助我们轻松地实现大量数据的存储和管理。

三、分布式存储技术的实践应用早在2004年,全球最大的搜索引擎之一,Google已经开始使用自己的分布式文件系统——Google File System (GFS)。

它是一个提供类似于本地文件系统接口的系统,可处理数PB(10^15 bytes)级别的数据,因其处理能力优异而备受瞩目。

在此基础上,Hadoop、Ceph、GlusterFS等分布式存储系统也相继推出并得到广泛应用。

四、Ceph 分布式存储技术的高可靠性Ceph分布式存储技术是一个基于RADOS (Reliable Autonomic DistributedObject Store) 的开源存储系统。

它的主要优势在于其高可靠性和可扩展性,Ceph能够在物理服务器层与逻辑分区层之间部署,能自动检测和修复硬件故障,并提供多个硬件故障时的数据保护能力。

同时,Ceph还支持使用普通的服务器组织出一个可扩展的集群,可以轻松地进行水平扩展,以适应数据容量的增加。

从而使其广泛应用于云计算、虚拟化环境、高性能计算等领域。

五、结语分布式存储技术的出现解决了大量数据的存储难题,并在应用领域得到广泛的应用,其稳定性和可扩展性也得到了业内广泛的肯定。

从Google Spanner漫谈分布式存储与数据库技术

从Google Spanner漫谈分布式存储与数据库技术

曹伟

【期刊名称】《程序员》

【年(卷),期】2012(000)011

【摘要】Spanner的设计反映了Google多年来在分布式存储系统领域上经验的积累和沉淀,它采用了Megastore的数据模型,Chubby的数据复制和一致性算法,而在数据的可扩展性上使用了BigTable中的技术。

新颖之处在于,它使用高精度和可观测误差的本地时钟来判断分布式系统中事件的先后顺序。

Spanner代表了分布式数据库领域的新趋势——NewSQL。

【总页数】5页(P98-102)

【作者】曹伟

【作者单位】不详

【正文语种】中文

【中图分类】TP333

【相关文献】

1.图书馆的Google发展模式——从图书馆和Google的SWOT分析看图书馆和Google的合作 [J], 徐健

2.Spanner数据库初探 [J], 陈超

3.漫谈数据库技术发展之未来 [J], 孟静

4.Electric Spanners [J],

5.Thixocasting combination spanners using stainless steel X39CrMo17 [J],

M.BüNCK;E.SUBASIC;A.BüHRIG-

POLACZEK;K.JIANG;S.MüNSTERMANN;J.M.SCHNEIDER;K.FICKERT;H.J.GüNT HER

因版权原因,仅展示原文概要,查看原文内容请购买。

高效的分布式数据存储与检索技术综述

高效的分布式数据存储与检索技术综述随着互联网的快速发展和大数据时代的到来,分布式数据存储与检索成为了一个重要的研究领域。

分布式系统具有高可用性、高扩展性和高性能等优势,能够应对数据规模不断增大和访问并发量大的挑战。

在这篇文章中,我们将综述当前主流的高效分布式数据存储与检索技术。

一、数据存储技术1. 分布式文件系统分布式文件系统是一种将文件分散存储在多个节点上的技术。

常见的分布式文件系统包括Hadoop的HDFS、GFS、Ceph等。

这些系统通过将文件切块并复制到多个节点上,提高了数据的可靠性和可用性,同时也提供了高吞吐量的数据存储和访问能力。

2. 分布式键值存储分布式键值存储系统采用键值对的形式进行数据存储和检索,其中键是用于唯一标识数据的,而值则存储了实际的数据。

常见的分布式键值存储系统包括Bigtable、Dynamo、Redis等。

这些系统通过将数据按照键进行划分和分布到不同节点上,实现了数据的高效存储和快速检索。

3. 分布式数据库分布式数据库是一种将数据存储在多个节点上,并通过一些协议实现数据的一致性和访问的并发性的技术。

常见的分布式数据库包括Cassandra、MongoDB、Spanner等。

这些系统通过数据的分区和冗余存储,提供了高可用性和高性能的数据存储和检索能力。

二、数据检索技术1. 分布式索引分布式索引是一种将索引数据存储在多个节点上的技术。

常见的分布式索引技术包括Lucene、Elasticsearch、Solr等。

这些系统通过将索引根据一定的规则进行分片和分布到不同节点上,实现了大规模数据的高效检索。

2. 倒排索引倒排索引是一种将数据中的每个词与包含该词的文档建立映射关系的技术,用于快速检索文本数据。

常见的分布式倒排索引技术包括Inverted Index、MapReduce 等。

这些系统通过将倒排索引进行分片和分布到不同节点上,实现了大规模文本数据的高效检索。

3. 分布式搜索引擎分布式搜索引擎是一种将数据存储在多个节点上,通过索引和查询进行数据检索的技术。

云计算中的分布式数据存储与备份技术研究

云计算中的分布式数据存储与备份技术研究随着云计算的广泛应用,大量的数据需要存储和备份。

传统的集中式存储和备份方案存在单点故障和性能瓶颈等问题,因此分布式数据存储与备份技术成为了一种重要的解决方案。

本文将对云计算中的分布式数据存储与备份技术进行研究,探讨其原理、特点、优势以及应用案例。

一、分布式数据存储技术分布式数据存储技术是将数据分散存储在多个节点上,以提高数据的可靠性和性能。

常见的分布式数据存储技术包括分布式文件系统、对象存储和分布式数据库等。

1. 分布式文件系统分布式文件系统是一种将文件分布存储在多个节点上的文件系统。

通过将文件切分成多个块,并存储在不同的节点上,可以提高数据访问的并发性和容错性。

同时,分布式文件系统还支持文件的复制和容错,使得数据可以在节点故障时仍然可用。

常见的分布式文件系统包括Hadoop HDFS、GlusterFS和Ceph等。

2. 对象存储对象存储是将数据以对象的方式存储在多个节点上的存储技术。

与传统的文件系统相比,对象存储不仅可以存储文件,还可以存储非结构化数据、元数据和自定义的属性等。

对象存储采用分布式存储架构,可以实现高可靠性、高可扩展性和高性能的数据存储。

常见的对象存储系统有Amazon S3、OpenStack Swift和Ceph Object Gateway等。

3. 分布式数据库分布式数据库是将数据分布存储在多个节点上的数据库系统。

分布式数据库采用一种或多种分布策略,将数据划分为多个分片,然后存储在不同的节点上。

通过将数据进行分片和复制,可以提高数据库的可扩展性和容错性。

常见的分布式数据库包括Google Spanner、Cassandra和MongoDB等。

二、分布式数据备份技术分布式数据备份技术是为了保证数据的可靠性和容灾性而设计的。

通过将数据备份存储在多个节点上,可以防止单点故障和数据丢失的风险。

1. 数据冗余备份技术数据冗余备份技术是最常见的分布式数据备份技术之一。

分布式存储技术在数据中心中的应用

分布式存储技术在数据中心中的应用一、分布式存储技术的概念分布式存储技术是一种将数据存储在多个存储设备上,通过分布式的管理方式,实现数据的高可用性、高性能、高扩展性的技术。

与传统的集中式存储相比,分布式存储技术具有更好的灵活性和可靠性。

二、分布式存储技术的分类1.根据数据存储方式的不同,分布式存储技术可以分为直接存储和分布式文件系统两种类型。

2.根据存储设备的连接方式不同,分布式存储技术可以分为网络存储和分布式存储系统两种类型。

3.数据中心的规模不断扩大,传统的集中式存储已经无法满足数据中心对于存储性能和扩展性的需求。

分布式存储技术可以将数据存储在多个存储设备上,实现高性能和可扩展性。

4.分布式存储技术可以实现数据的高可用性和容错性。

在多个存储设备上存储数据的副本,当某个存储设备出现故障时,可以自动切换到其他正常的存储设备上,保证数据的可靠性和可用性。

5.分布式存储技术可以实现数据的分布式管理和优化。

通过对数据的分布式管理,可以实现负载均衡和资源优化,提高数据中心的整体性能。

6.分布式存储技术可以实现数据的灵活性和可靠性。

通过对数据的分布式存储和备份,可以实现数据的灵活性和可靠性,满足不同场景下的数据存储需求。

四、分布式存储技术在数据中心中的挑战1.数据的一致性和同步性。

在多个存储设备上存储数据的副本,需要保证数据的一致性和同步性,防止数据出现不一致的情况。

2.数据的可靠性和安全性。

在多个存储设备上存储数据,需要保证数据的可靠性和安全性,防止数据出现丢失和泄露的情况。

3.数据的分布式管理和优化。

在多个存储设备上存储数据,需要实现数据的分布式管理和优化,提高数据中心的整体性能。

五、分布式存储技术的发展趋势1.分布式存储技术将继续朝着高性能、高扩展性、高可用性的方向发展。

2.分布式存储技术将更加注重数据的管理和优化,提高数据中心的整体性能。

3.分布式存储技术将更加注重数据的可靠性和安全性,保障数据中心的稳定运行。

全球级数据库——谷歌spanner

Placement driver会周期性地与spanserver进行交互,来发现那些需要被转移的数据,或 者是为了满足新的副本约束条件,或者是为了进行负载均衡。

录的集合称作一个 Directory。例如,

一个用户的记录及该用户所有相册的记 录组成了一个 Directory。Directory 是 Spanner 中对数据进行分区、 复制和

迁移的基本单位,应用可以指定一个

Directory 有多少个副本,分别存放在 哪些机房中,例如把用户的 Directory 存放在这个用户所在地区附近的几个机 房中。

x1000

Moscow Berlin Krakow

Russia

READ TRANSACTIONS

Generate a page of friends’ recent posts

• Consistent view of friend list and their posts

Why consistency matters? Remove untrustworthy person X as friend

EXAMPLE: SOCIAL NETWORK

Sao Paulo Santiago Buenos Aires

x1000

x1000 US

San Francisco Brazil Seattle User posts Arizona Friend lists

x1000 Spain

London Paris Berlin Madrid Lisbon

3.3 存储虚拟化-分布式数据库(20230216)

分布式数据库

➢ 数据库架构模型 数据库常用的架构模型分为共享计算存储资源

(shared-Everything)的单机集中式数据库架构、共享存储 的架构、不共享资源的分布式架构。

分布式数据库

➢ 数据库架构模型

分布式数据库

➢ OLTP和OLAP融合的数据库 联机事务处理(OnLine Transaction Processing)是一种快

分布式数据库

➢ 分布式数据库 数据分片是分布式数据库的关键设计,将存放在同一

个数据库实例中的数据分散存放到多个数据库实例上,进 行多台设备存取以提高性能,在切分数据的同时可以提高 系统整体的可用性。

数据同步是分布式数据库的基础,由于数据库理论传 统上是建立在单机数据库基础上,而引入分布式理论后, 一致性原则被打破,因此需要引入数据库同步技术来帮助 数据库恢复一致性。

节点上计算完成后,将各自部分的结果汇总在一起得到最终的 结果。

MPP 数据库通常有无Master和Master-Slave两种架构方式 , 该领域的产品主要是商业产品,如无Master的MPP架构的独立 厂商 Teradata的数据库Asterdata和华为的自研数据库 GaussDB, HP 的 Vertica。主从(Master-Slave)MPP架构的产品:EMC 的 Greenplum ,IBM的Netezza数据仓库数据库 。

分布式数据库

➢ 分布式数据库产品 PG-XC( 类似PostgreSQL-XC)架构风格的分布式数

据库产品有中兴的 GoldenDB、 华为的 GaussDB 300、 腾 讯的 TDSQL、 亚信科技AntDB等等。

NewSQL风格分布式数据库有Google(谷歌)的 Spanner、PingCAP 的 TiDB、蚂蚁集团的OceanBase、巨杉 的SequoiaDB 、 星环的NuoDB、CockroachDB和 YugabyteDB等等。

实现快速实时处理的一种新数据库Kudu

实现快速实时处理的一种新数据库Kudu 作者:李敏虞金中来源:《电脑知识与技术》2019年第25期摘要:针对快速变化的数据,目前的数据库还无法做到快速处理。

对于这样的现状,客户希望有一种数据库不仅能够对数据快速地分析,而且能够对数据快速地修改、删除和随机读取。

为此,Cloudera参考了Google发表的介绍其分布式数据库[1](Spanner)的论文,在2012年开始秘密研发的一款介于HDFS[2]和HBase[3]之间的高速分布式存储数据库Kudu[4]。

Kudu 不仅有效地兼具了HBase的实时性,HDFS的高吞吐,以及传统数据库的SQL支持,而且它更有效地利用了现代硬件的CPU和IO资源,降低了混合架构系统的复杂性。

Kudu作为一款实时、离线之间的存储系统被誉为下一代分析平台的重要组成部分,填补了HDFS和HBase之间的空白,并将进一步把Hadoop[5]市场向传统数据仓库市场靠拢。

关键词:Kudu;快速实时处理;分布式存储数据库;大数据中图分类号:TP392; ; ; 文献标识码:A文章编号:1009-3044(2019)25-0008-03Abstract: For fast-changing data, current databases cannot be processed quickly. For such a status quo, customers want a database that not only can quickly analyze data, but also can quickly modify, delete and randomize data. To this end, Cloudera refers to a paper published by Google on its distributed database [1] (wrench), and in 2012 began a secret high-speed distribution between HDFS [2] and HBase[3]. Storage database [4]. Kudu not only effectively combines the real-time nature of HBase, the high throughput of HDFS, and the SQL support of traditional databases, but it also makes more efficient use of the CPU and IO resources of modern hardware, reducing the mix. The complexity of the architecture system. Kudu as a real-time, offline storage system is hailed as an important part of the next-generation analytics platform, filling the gap between HDFS and HBase, and will further put Hadoop [5] The market is moving closer to the traditional data warehouse market.Key words: Kudu; fast real-time processing; distributed storage database; big Data1引言近幾年来,随着物联网、移动互联网、社会化网络的快速发展,企业的数据增长迅速,半结构化及非结构化的行业应用数据规模将成几何倍数增长。

分布式数据存储应用介绍

分布式数据存储应用介绍分布式数据存储应用是一种利用多台计算机或服务器来存储和管理数据的技术。

相比传统的集中式数据存储方式,分布式数据存储应用具有更高的可靠性、扩展性和性能优势。

本文将介绍分布式数据存储应用的基本概念、优势以及常见的应用场景。

分布式数据存储应用可以将数据分散存储在多台计算机或服务器上,每台计算机存储部分数据,这样可以有效地避免单点故障,提高数据的可靠性。

即使某台计算机发生故障,其他计算机上的数据仍然可以正常访问,不会导致数据丢失或服务中断。

分布式数据存储应用具有良好的扩展性。

随着数据量的增加,可以很容易地向系统中添加新的计算机或服务器,以扩展存储容量和提高性能。

这种横向扩展的方式可以根据实际需求灵活调整,使系统能够适应不断增长的数据量和访问压力。

分布式数据存储应用还具有较高的性能优势。

由于数据可以并行存储和访问,可以通过多台计算机同时处理数据请求,从而提高数据的读写速度和响应时间。

同时,分布式数据存储应用还可以根据负载情况动态调整数据的分布和复制策略,优化系统性能。

在实际应用中,分布式数据存储应用广泛应用于互联网企业、大型科研机构和金融机构等领域。

例如,云存储服务提供商利用分布式数据存储技术来存储和管理海量用户数据,保障数据的安全性和可靠性。

大型科研机构利用分布式数据存储应用来管理科学实验数据,实现数据共享和协作。

金融机构利用分布式数据存储应用来存储交易数据和客户信息,保障数据的一致性和可靠性。

总的来说,分布式数据存储应用是一种高效、可靠的数据管理技术,具有较高的可靠性、扩展性和性能优势。

在不断增长的数据量和复杂的应用场景下,分布式数据存储应用将发挥越来越重要的作用,为各行各业提供强大的数据支持和保障。

希望本文能够帮助读者更好地了解分布式数据存储应用的基本概念和优势,为其在实际应用中做出更好的决策和选择。

Google Megastore分布式存储技术全揭秘

Google Megastore分布式存储技术全揭秘导读:本文根据Google最新Megastore论文翻译而来,原作者为Google团队,团队人员包括:Jason Baker,Chris Bond,James C.Corbett,JJ Furman,Andrey Khorlin,James Larson,Jean-Michel Léon,Yawei Li,Alexander Lloyd,Vadim Yushprakh。

翻译者为国内知名IT人士。

在上个月举行的创新数据系统研讨会上(CIDR),Google公开了其Megastore分布式存储技术的白皮书。

Megastore是谷歌一个内部的存储系统,它的底层数据存储依赖Bigtable,也就是基于NoSql实现的,但是和传统的NoSql不同的是,它实现了类似RDBMS的数据模型(便捷性),同时提供数据的强一致性解决方案(同一个datacenter,基于MVCC的事务实现),并且将数据进行细颗粒度的分区(这里的分区是指在同一个datacenter,所有datacenter 都有相同的分区数据),然后将数据更新在机房间进行同步复制(这个保证所有datacenter 中的数据一致)。

Megastore的数据复制是通过paxos进行同步复制的,也就是如果更新一个数据,所有机房都会进行同步更新,因为使用paxos进行复制,所以不同机房针对同一条数据的更新复制到所有机房的更新顺序都是一致的,同步复制保证数据的实时可见性,采用paxos 算法则保证了所有机房更新的一致性,所以个人认为megastore的更新可能会比较慢,而所有读都是实时读(对于不同机房是一致的),因为部署有多个机房,并且数据总是最新。

为了达到高可用性,megastore实现了一个同步的,容错的,适合长距离连接的日志同步器为了达到高可扩展性,megastore将数据分区成一个个小的数据库,每一个数据库都有它们自己的日志,这些日志存储在NoSql中Megastore将数据分区为一个Entity Groups的集合,这里的Entity Groups相当于一个按id切分的分库,这个Entity Groups里面有多个Entity Group(相当于分库里面的表),而一个Entity Group有多个Entity(相当于表中的记录)在同一个Entity Group中(相当于单库)的多个Entity的更新事务采用single-phase ACID事务,而跨Entity Group(相当于跨库)的Entity更新事务采用two-phase ACID 事务(2段提交),但更多使用Megastore提供的高效异步消息实现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

从Google Spanner漫谈分布式存储与数据库技术文/曹伟Spanner 的设计反映了 Google 多年来在分布式存储系统领域上经验的积累和沉淀,它采用了 Megastore 的数据模型,Chubby 的数据复制和一致性算法,而在数据的可扩展性上使用了 BigTable 中的技术。

新颖之处在于,它使用高精度和可观测误差的本地时钟来判断分布式系统中事件的先后顺序。

Spanner 代表了分布式数据库领域的新趋势——NewSQL。

Spanner 是 Google 最近公开的新一代分布式数据库,它既具有 NoSQL 系统的可扩展性,也具有关系数据库的功能。

例如,它支持类似 SQL 的查询语言、支持表连接、支持事务(包括分布式事务)。

Spanner 可以将一份数据复制到全球范围的多个数据中心,并保证数据的一致性。

一套 Spanner 集群可以扩展到上百个数据中心、百万台服务器和上T条数据库记录的规模。

目前,Google 广告业务的后台(F1)已从 MySQL 分库分表方案迁移到了Spanner 上。

数据模型传统的 RDBMS(例如 MySQL)采用关系模型,有丰富的功能,支持 SQL 查询语句。

而NoSQL 数据库多是在 key-value 存储之上增加有限的功能,如列索引、范围查询等,但具有良好的可扩展性。

Spanner 继承了 Megastore 的设计,数据模型介于 RDBMS 和 NoSQL 之间,提供树形、层次化的数据库 schema,一方面支持类 SQL 的查询语言,提供表连接等关系数据库的特性,功能上类似于 RDBMS;另一方面整个数据库中的所有记录都存储在同一个key-value 大表中,实现上类似于 BigTable,具有 NoSQL 系统的可扩展性。

在 Spanner 中,应用可以在一个数据库里创建多个表,同时需要指定这些表之间的层次关系。

例如,图 1 中创建的两个表——用户表(Users)和相册表(Albums),并且指定用户表是相册表的父节点。

父节点和子节点间存在着一对多的关系,用户表中的一条记录(一个用户)对应着相册表中的多条记录(多个相册)。

此外,要求子节点的主键必须以父节点的主键作为前缀。

例如,用户表的主键(用户 ID)就是相册表主键(用户 ID+ 相册 ID)的前缀。

图 1 schema 示例,表之间的层次关系,记录排序后交错的存储显然所有表的主键都将根节点的主键作为前缀,Spanner 将根节点表中的一条记录,和以其主键作为前缀的其他表中的所有记录的集合称作一个 Directory。

例如,一个用户的记录及该用户所有相册的记录组成了一个 Directory。

Directory 是 Spanner 中对数据进行分区、复制和迁移的基本单位,应用可以指定一个 Directory 有多少个副本,分别存放在哪些机房中,例如把用户的 Directory 存放在这个用户所在地区附近的几个机房中。

这样的数据模型具有以下好处。

•一个 Directory 中所有记录的主键都具有相同前缀。

在存储到底层 key-value 大表时,会被分配到相邻的位置。

如果数据量不是非常大,会位于同一个节点上,这不仅提高了数据访问的局部性,也保证了在一个 Directory 中发生的事务都是单机的。

•Directory 还实现了从细粒度上对数据进行分区。

整个数据库被划分为百万个甚至更多个 Directory,每个 Directory 可以定义自己的复制策略。

这种Directory-based 的数据分区方式比 MySQL 分库分表时 Table-based 的粒度要细,而比 Yahoo!的 PNUTS 系统中 Row-based 的粒度要粗。

•Directory 提供了高效的表连接运算方式。

在一个 Directory 中,多张表上的记录按主键排序,交错(interleaved)地存储在一起,因此进行表连接运算时无需排序即可在表间直接进行归并。

复制和一致性Spanner 使用 Paxos 协议在多个副本间同步 redo 日志,从而保证数据在多个副本上是一致的。

Google 的工程师钟情于 Paxos 协议,Chubby、Megastore 和 Spanner 等一系列产品都是在 Paxos 协议的基础上实现一致性的。

Paxos 的基本协议很简单。

协议中有三个角色:Proposer、Acceptor 和 Learner,Learner 和 Proposer 分别是读者和写者,Acceptor 相当于存储节点。

整个协议描述的是,当系统中有多个 Proposer 和 Acceptor 时,每次 Proposer 写一个变量就会启动一轮决议过程(Paxos instance),如图 2 所示。

决议过程可以保证即使多个 Proposer 同时写,结果也不会在 Acceptor 节点上不一致。

确切地说,一旦某个 Proposer 提交的值被大多数Acceptor 接受,那么这个值就被选中,在整轮决议的过程中该变量就不会再被修改为其他值。

如果另一个 Proposer 要写入其他值,必须启动下一轮决议过程,而决议过程之间是串行(serializable)的。

图 2 Paxos 协议正常执行流程一轮决议过程分为两个阶段,即 prepare 阶段和 accept 阶段。

•第一阶段A:Proposer 向所有 Acceptor 节点广播 prepare 消息,消息中只包含一个序号——N。

Proposer 需要保证这个序号在这轮决议过程中是全局唯一的(这很容易做到,假如系统中有两个 Proposer,那么一个 Proposer 使用1,3,5,7,9,……,另一个 Proposer 则使用0,2,4,6,8,……)。

•第一阶段B:Acceptor 接收到 prepare 消息后,如果N是到目前为止见过的最大序号,就返回一个 promise 消息,承诺不会接受序号小于N的请求;如果已接受过其他 Proposer 提交的值,则会将这个值连同提交这个值的请求的序号一同返回。

•第二阶段A:当 Proposer 从大多数 Acceptor 节点收到了 promise 消息后,就可以选择接下来要向 Acceptor 提交的值了。

一般情况下,当然选原本打算写入的值,但如果从收到的 promise 消息中发现已经有其他值被 Acceptor 接受了,那么为了避免造成数据不一致的风险,这时 Proposer 就必须“大义灭亲”,放弃自己打算写入的值,从其他 Proposer 提交的序号中选择一个最大的值。

接下来 Proposer 向所有的 Acceptor 节点发送 accept 包,其中包含在第一阶段中挑选的序号N和刚才选择的值V。

•第二阶段B:Acceptor 收到 accept 包之后,如果N的大小不违反对其他Proposer 的承诺,就接受这个请求,记录下值V和序号N,返回一个 ack 消息。

反之,则返回一个 reject 消息。

如果 Proposer 从大多数 Acceptor 节点收到了 ack 消息,说明写操作成功。

而如果在写操作过程中失败,Proposer 可以增大序号,重新执行第一阶段。

基本的 Paxos 协议可以保证值一旦被选出后就一定不会改变,但不能保证一定会选出值来。

换句话说,这个投票算法不一定收敛。

有两个方法可以加速收敛的过程:一个是在出现冲突后通过随机延迟把机会让给其他 Proposer,另一个是尽量让系统中只有一个Proposer 去提交。

在 Chubby 和 Spanner 系统中这两种方法都用上了,先用随机延迟的方法通过一轮 Paxos 协议,在多个 Proposer 中选举出一个 leader 节点。

接下来所有的写操作都通过这个 leader 节点,而 leader 节点一般还是比较“长寿”的,在广域网环境下平均“任期”可以达到一天以上。

而 Megastore 系统中没有很好地解决这个问题,所有的Proposer 都可以发起写操作,这是 Megastore 写入性能不高的原因之一。

基本的 Paxos 协议还存在性能上的问题,一轮决议过程通常需要进行两个回合通信,而一次跨机房通信的代价为几十到一百毫秒不等,因此两个回合的通信就有点开销过高了。

不过幸运的是,绝大多数情况下,Paxos 协议可以优化到仅需一个回合通信。

决议过程的第一阶段是不需要指定值的,因此可以把 prepare/promise 的过程捎带在上一轮决议中完成,或者更进一步,在执行一轮决议的过程中隐式地涵盖接下来一轮或者几轮决议的第一阶段。

这样,当一轮决议完成之后,其他决议的第一阶段也已经完成了。

如此看来,只要 leader 不发生更替,Paxos 协议就可以在一个回合内完成。

为了支持实际的业务,Paxos 协议还需要支持并发,多轮决议过程可以并发执行,而代价是故障恢复会更加复杂。

因为 leader 节点上有最新的数据,而在其他节点上为了获取最新的数据来执行 Paxos 协议的第一阶段,需要一个回合的通信代价。

因此,Chubby 中的读写操作,以及 Spanner 中的读写事务都仅在 leader 节点上执行。

而为了提高读操作的性能,减轻 leader 节点的负载,Spanner 还提供了只读事务和本地读。

只读事务只在 leader 节点上获取时间戳信息,再用这个时间戳在其他节点上执行读操作;而本地读则读取节点上最新版本的数据。

与 Chubby、 Spanner 这种读写以 leader 节点为中心的设计相比,Megastore 体现了一定的“去中心化”设计。

每个客户端都可以发起 Paxos 写操作,而读操作则尽可能在本地执行。

如果客户端发现本地数据不是最新的,会启动 catchup 流程更新数据,再执行本地读操作返回给客户端。

最后,对比下其他系统中 replication 的实现。

在 BigTable 系统中每个 tablet 服务器是没有副本的,完全依赖底层 GFS 把数据存到多台机器上。

数据的读写都通过单个tablet 服务器,在 tablet 服务器出现故障的时需要 master 服务器将 tablet 指派到其他 tablet 服务器上才能恢复可用。

Dynamo 系统则贯彻了“去中心化”的思想,将数据保存在多个副本上,每个副本都可以写入(update everywhere)。

而不同副本同时写入的数据可能会存在不一致,则需要使用版本向量(version vector)记录不同的值和时间戳,由应用去解释或合并不一致的数据。

尽管 Dynamo 系统还提供了 NWR 的方式来支持有一致性保证的读写操作,但总的来说 Dynamo 为了高可用性牺牲了一致性。