基于统计的中文分词算法研究

基于统计语言模型的中文分词算法研究

基于统计语言模型的中文分词算法研究中文是世界上使用人数最多的语言之一,它的排列方式和英语等西方语言有很大的不同,因此分词是中文自然语言处理的重要一环。

中文分词的主要目标是将一段连续的中文文本切分成单个的词语。

目前,基于统计语言模型的中文分词算法是最为流行和使用广泛的算法。

本文将会探讨中文分词的基础知识,以及基于统计语言模型的中文分词算法的核心思想和实现方法。

一、中文分词的基础知识中文文本是由汉字组成的,中文词语并不像英语词汇那样有明显的边界。

因此,中文分词器需要解决的第一个问题就是识别出哪些汉字是组成词语的基本单元。

然后,再根据组合方式将词语划分出来。

中文分词可以分为基于规则的分词和基于统计的分词两种算法。

基于规则的分词算法是手动编写规则,根据这些规则来解决分词问题。

但是这种方法实现起来非常困难,因为包含规则的样本集必须足够大而且需要频繁更新。

而且,规则往往是比较复杂的,需要人工不断调整和改进。

基于统计的分词算法是通过分析一定量的语言样本集,建立起一个统计模型来解决分词问题。

这种方法不需要手动编写规则,而是通过分析大量的语言样本,了解自然语言的规律,然后再根据语言的规律来处理分词问题。

因此,基于统计的分词方法相对于基于规则的方法更加高效和精确。

二、基于统计语言模型的中文分词算法基于统计语言模型的中文分词算法并不是直接对每个汉字进行分词,而是在每个可能的词边界处赋予一个概率权重,然后取最大概率的词语作为对应的分词结果。

基于统计语言模型的分词算法包含三个主要组成部分:分词模型、特征提取和概率计算。

1. 分词模型分词模型是中文分词的核心模型,它可以对中文句子进行分词。

分词模型可以分为两种类型:基于统计的分词模型和基于规则的分词模型。

基于统计的分词模型通常基于最大概率模型或条件概率模型,常用的模型包括Hidden Markov Model (隐马尔可夫模型)和Conditional Random Fields(条件随机场)模型。

基于统计学习的中文分词算法研究与实现

基于统计学习的中文分词算法研究与实现1. 研究背景与意义中文自然语言处理一直是计算机科学领域研究热点之一,而中文分词作为中文自然语言处理的基础,对于中文信息处理的准确性和效率至关重要。

因此,如何实现中文分词算法成为了研究的重要方向之一。

而基于统计学习的中文分词算法由于其高效和准确的特点,近年来受到了学术界和工业界的广泛关注。

2. 统计学习原理统计学习是一种主要通过样本数据学习统计规律,进而进行模型预测和决策的机器学习方法。

在中文分词领域,统计学习方法主要包括条件随机场(Conditional Random Fields, CRF)算法和隐马尔可夫模型(Hidden Markov Model, HMM)算法。

2.1 CRF算法CRF算法是一种基于给定观测序列预测标签序列的判别式模型,相较于传统的隐马尔可夫模型,CRF算法不需要对序列进行假设,因此能更加准确地建立标签之间的依赖关系。

在中文分词中,CRF算法可以通过学习一系列特征函数和标签序列之间的联系来识别分词位置。

同时,CRF算法还可以应用于词性标注、命名实体识别等中文自然语言处理问题中。

2.2 HMM算法HMM算法是一种基于一定数目隐藏状态序列的概率模型,其主要思想是对一个观测序列建立一个与之对应的隐藏状态序列,再通过对两个序列之间的概率分布进行建模,从而得到概率最大的标签序列。

在中文分词领域,HMM算法通常基于字或者词的频率统计建立模型,并通过对模型参数的不断优化来提高分词准确率。

3. 中文分词算法实现3.1 数据预处理在进行中文分词算法实现前,首先需要进行数据预处理。

该步骤主要包括数据清洗、分词、标注等处理,以得到处理后的具有代表性的中文数据集。

3.2 特征选择特征选择是建立中文分词模型的关键步骤。

基于统计学习的中文分词算法主要通过选取能够有效区分不同中文词汇的特征来建立模型。

常用的特征选择方法包括:互信息、信息增益比、卡方检验、TF-IDF等。

基于统计方法从文本中抽取分词词典

基于统计方法从文本中抽取分词词典分词是中文文本处理中的一项重要任务,它将连续的中文字符序列划分为有意义的词语单元。

建立一个准确的中文分词词典对于自然语言处理任务至关重要,而基于统计方法的分词词典构建是一种常用的方法。

下面将介绍如何从文本中抽取分词词典。

1. 收集语料库:首先要准备一个大规模的中文语料库,该语料库应该包含各种类型的文本,如新闻、博客、微博等,以确保词库的广泛性和多样性。

2. 分词:使用一个成熟的分词工具对语料库进行分词处理,将每个文本划分为一个个分词单元。

常用的中文分词工具有结巴分词、哈工大LTP、清华大学THULAC等。

3. 统计词频:对分词后的语料进行词频统计,统计每个分词在语料库中出现的频率。

可以使用Python中的nltk库或者使用自定义的脚本实现。

4. 筛选高频词:根据词频统计结果,筛选出出现频率较高的词汇作为候选词。

可以根据需求设置一个阈值,例如选择频率排名前1000的词汇作为候选词。

5. 统计词组概率:对于连续出现的词汇组合,可以统计它们出现的频率,并计算它们出现的概率。

统计“自然语言处理”这个词组出现的频率和概率。

6. 去除停用词:从候选词中去除一些常见的停用词,例如“的”、“和”、“是”等,以保证词典的准确性和效果。

7. 人工审核:对生成的词典进行人工审核,去除一些不合适或错误的词汇,修正划分错误的词语等。

8. 扩展词典:可以在已有的分词词典基础上,通过人工添加新词或者从其他语料中提取新词来扩展分词词典。

总结:基于统计方法的分词词典抽取可以通过对语料库进行分词、词频统计、筛选高频词、统计词组概率等步骤来实现。

这样得到的分词词典可以作为分词模型的基础,提高分词的准确性和效果。

结巴分词原理

结巴分词原理结巴分词是一种基于Python语言开发的中文分词工具,它采用了基于统计的分词方法,能够有效地对中文文本进行分词处理。

结巴分词的原理主要包括三个方面,基于统计的分词算法、词典与HMM模型以及关键词提取与词性标注。

下面将对这三个方面进行详细介绍。

首先,结巴分词采用了基于统计的分词算法。

这种算法是通过分析大量的中文语料库,统计词语之间的搭配和频率,然后根据统计结果来确定词语之间的切分位置。

这种算法能够较好地处理一些新词、专有名词以及一些特殊的词语搭配,具有一定的鲁棒性和适应性。

其次,结巴分词还采用了词典与HMM模型相结合的方法。

词典是指结巴分词内置的一些常用词语和词语搭配,通过词典可以快速地判断出一些常见词语的切分位置。

而HMM模型则是一种隐马尔可夫模型,通过对词语的隐含状态进行建模,来确定最可能的切分位置。

这种方法能够有效地处理一些生僻词和歧义词,提高了分词的准确性。

最后,结巴分词还包括了关键词提取与词性标注功能。

关键词提取是指通过对文本进行分词和统计分析,得到文本中的关键词,从而帮助用户快速地了解文本的主题和重点内容。

而词性标注则是指对分词结果进行词性的标注,可以帮助用户进一步分析文本的语法结构和语义信息。

总的来说,结巴分词是一种基于统计的中文分词工具,它采用了多种方法来实现对中文文本的有效分词处理。

通过对大量语料的统计分析、词典与HMM模型的结合以及关键词提取与词性标注等功能,结巴分词能够较好地满足用户对中文分词的需求,具有一定的准确性和实用性。

结巴分词的原理虽然较为复杂,但是在实际应用中,用户只需要简单调用相应的接口,就可以快速地实现对中文文本的分词处理。

因此,结巴分词在自然语言处理、信息检索、文本挖掘等领域都有着广泛的应用前景,对于提高中文文本处理的效率和准确性具有重要意义。

希望本文对结巴分词的原理有所帮助,谢谢阅读。

基于新统计量mt的汉语自动分词方法研究

本操作 单元 。 中文 文本 不 同 于英 文文 本 , 书 面汉 在

语 中只有 字 的界 限 而无 词 的界 限 , 与 词 之 间 没有 词

分词 方法 , 表 的覆 盖范 围对 分词 结果 至关重 要 , 词 无

明显的切分标志( 如空格 ) 。因此 , 如何将 中文文本 正确地 分词 ( 即汉语 自动 分 词 ) 是 对 中文 文 本 进行 ,

ห้องสมุดไป่ตู้

St t t a — b s d Ap r a h t ie e W o d Se me t t n a i i l— a e p o c o Ch n s sc r g na i o

HU N i , H h n —Y , I i o g A G X n Z U Z e g u X E Q —H n

r s l s o e me tt n a c r c e c s8 1 % . h e me tt n i b t rc mp r d t sn t a e u t h wss g n a i c u a y r a h 0. 4 o T e s g n a i s et o a e u i g mu u l o e o

a tm ai al t o tu i g lg — s ae a n tt d c r s, i h i t e r a e c s . e e p rme al u o tc l wih u sn a e y c l n o ae opu wh c am o d c e s o t Th x e i nt

自动分 析 的第 一步 。汉 语 自动分词 是 句法 分析 等深 层 次处 理 的基 础 , 也是 机器 翻译 、 息 检索 和信 息抽 信 取 等应用 的重 要环 节 。 汉语 自动 分词 的研 究起 始 于 8 代初 , 0年 迄今 已

中文分词技术研究

分词算法一般有三类:基于字符串匹配、基于语义分析、基于统计。

复杂的分词程序会将各种算法结合起来以便提高准确率。

Lucene被很多公司用来提供站内搜索,但是Lucene本身并没有支持中文分词的组件,只是在Sandbox里面有两个组件支持中文分词:ChineseAnalyzer和CJKAnalyzer。

ChineseAnalyzer 采取一个字符一个字符切分的方法,例如"我想去北京天安门广场"用ChineseAnalyzer分词后结果为:我#想#去#北#京#天#安#门#广#场。

CJKAnalyzer 则是二元分词法,即将相邻的两个字当成一个词,同样前面那句用CJKAnalyzer 分词之后结果为:我想#想去#去北#北京#京天#天安#安门#门广#广场。

这两种分词方法都不支持中文和英文及数字混合的文本分词,例如:IBM T60HKU现在只要11000元就可以买到。

用上述两种分词方法建立索引,不管是搜索IBM还是11000都是没办法搜索到的。

另外,假如我们使用"服务器"作为关键字进行搜索时,只要文档包含"服务"和"器"就会出现在搜索结果中,但这显然是错误的。

因此,ChineseAnalyzer和CJKAnalyzer虽然能够简单实现中文的分词,但是在应用中仍然会感觉到诸多不便。

基于字符串匹配的分词算法用得很多的是正向最大匹配和逆向最大匹配。

其实这两种算法是大同小异的,只不过扫描的方向不同而已,但是逆向匹配的准确率会稍微高一些。

"我想去北京天安门广场"这句使用最大正向分词匹配分词结果:我#想去#北京#天安门广场。

这样分显然比ChineseAnalyzer和CJKAnalyzer来得准确,但是正向最大匹配是基于词典的,因此不同的词典对分词结果影响很大,比如有的词典里面会认为"北京天安门"是一个词,那么上面那句的分词结果则是:我#想去#北京天安门#广场。

基于统计方法从文本中抽取分词词典

基于统计方法从文本中抽取分词词典在自然语言处理领域,分词词典是非常重要的资源,它可以帮助计算机理解和处理人类语言。

从文本中抽取分词词典是一个关键的任务,可以通过统计方法来实现。

本文将介绍基于统计方法从文本中抽取分词词典的方法和技巧。

一、统计方法简介统计方法是指通过对大量数据进行统计分析,从而得到某种结论或者规律的方法。

在自然语言处理领域,统计方法被广泛应用于分词、词性标注、句法分析等任务中。

基于统计方法的分词词典抽取可以通过分析文本中词语的频率和共现关系来实现。

二、基于统计方法的分词词典抽取步骤1. 文本数据收集:首先需要收集大量的文本数据,可以是语料库、网络文本或者其他来源。

这些文本数据应该尽可能地涵盖不同领域和话题,以便更好地反映语言的使用情况。

2. 分词处理:对文本数据进行分词处理,将文本中的句子转化为词序列。

可以使用成熟的分词工具或者自己编写分词算法来实现这一步骤。

3. 统计词频:统计每个词在文本数据中出现的频率。

可以将词频按照一定的排序方式进行排列,以便后续的处理。

4. 统计共现关系:统计每个词与其相邻词的共现关系,可以采用词共现矩阵或者其他方式来表示词语之间的关联性。

5. 词语选择和过滤:根据词频和共现关系,可以选择一定阈值以上的词语作为候选词,并进行一定的过滤,例如去除停用词、低频词等。

6. 构建分词词典:将筛选和过滤后的词语组成分词词典,并保存为文本文件或者数据库,以备后续使用。

三、技巧和注意事项1. 数据预处理:在进行统计分析之前,需要对文本数据进行预处理,包括去除标点符号、数字、特殊符号等,以便更好地提取词语信息。

2. 词频统计:在统计词频时,可以采用TF-IDF等方法来对词语进行权重计算,以确保重要词语的优先选择。

3. 共现关系:在统计词语的共现关系时,可以考虑采用窗口大小等参数来控制相邻词语的范围,以获取更加准确的共现信息。

4. 负例过滤:在选择词语时,可以考虑对一定范围内的负例进行过滤,以提高分词词典的准确性。

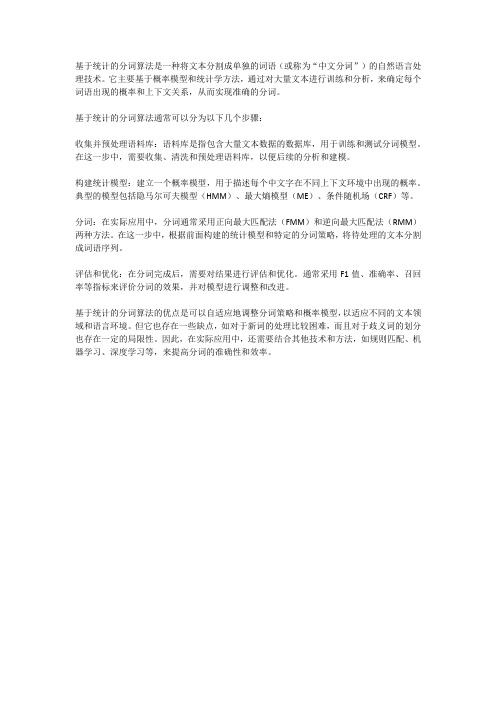

基于词频统计算法的中英文词频分布研究

㊀第35卷第1期㊀青岛大学学报(工程技术版)㊀V o l .35N o .1㊀2020年2月J O U R N A LO F Q I N G D A OU N I V E R S I T Y (E &T )F e b .2020文章编号:10069798(2020)01000105;D O I :10.13306/j.10069798.2020.01.001基于词频统计算法的中英文词频分布研究李㊀杰,孙仁诚(青岛大学计算机科学技术学院,山东青岛266071)摘要:针对幂律判断方式存在的问题,本文基于早期对幂律分布的研究,结合最大拟然拟合方法及词频统计算法,对中英文词频分布进行研究.给出了双对数坐标系下幂律分布的判断,并对词频统计与幂律分布进行拟合.研究结果表明,在双对数坐标系下,分布图像为近似直线是判断幂律分布的必要条件,而非充分条件;在自然语言的词频统计分布模型上,对观测数据进行幂律分布的拟合,得出的p Gv a l u e 分别为0 14和0 19,均大于0 1,且泊松分布㊁指数分布㊁广延指数分布的p Gv a l u e 值都为0,即可排除满足其他分布的假设,因此对观测数据拟合效果最好的是幂律分布.说明自然语言的词频分布满足幂律,且中英文同样适用.该研究对人们认识语言的发展过程具有重要意义.关键词:词频统计;幂律分布;最大似然估计;K S 统计量中图分类号:T P 312;C 81㊀文献标识码:A 收稿日期:20190620;修回日期:20191028基金项目:国家自然科学青年基金资助项目(41706198)作者简介:李杰(1994),男,硕士研究生,主要研究方向为数据挖掘与分析.通信作者:孙仁诚(1977),男,副教授,博士,主要研究方向为数据挖掘及人工智能.E m a i l :qd s u n s t a r @163.c o m ㊀㊀幂律分布[1]广泛存在于计算机科学㊁人口统计学与社会科学㊁物理学㊁经济学与金融学等众多领域中,且形式多样.实验证明,在自然界与日常生活中,包括地震规模大小的分布㊁月球表面上月坑直径的分布㊁行星间碎片大小的分布㊁太阳耀斑强度的分布㊁计算机文件大小的分布㊁战争规模的分布㊁人类语言中单词频率的分布㊁大多数国家姓氏的分布㊁科学家撰写的论文数的分布㊁论文被引用的次数的分布㊁网页被点击次数的分布[2]㊁书籍及唱片的销售册数或张数的分布㊁电力数据的分布[3]㊁甚至电影所获得的奥斯卡奖项数的分布等都是典型的幂律分布.但这一结果存在巨大缺陷,曾经被认为满足幂律分布的某些数据,只有在一定的条件范围内才是幂律,而在整体大量的数据集上是不纯的[4].20世纪中期,对于幂律分布的研究,一些研究者[56]分别在语言学和经济学的领域提出了著名的80/20定律.这一定律的基本形式即为简单的幂函数,是幂律分布的4种形式之一,其他形式的幂律分布有名次规模分布㊁规模概率分布等.直到21世纪初,A.L .B a r a b a s i 等人[78]提出了无标度理论,从复杂网络的角度探究了幂律分布的性质,即无标度网络的度分布就是幂律分布,为复杂网络的发展奠定了理论基础;C .A a r o n 等人[4]对幂律分布的判断标准进行了详尽的理论证明,推翻了前人通过双对数坐标系下是否构成一条近似直线判断幂律分布的方法,并证明了双对数坐标系下近似直线是幂律分布的必要条件.关于中英文词频分布的研究[911]一直是自然语言处理的重点.国内中文分词的算法主要集中在词典与统计相结合[12]的方式,但精度有待提升.2017年,麻省理工学院的S u n J u n y i 团队历时4年,完善了新的词频统计算法,与传统的基于统计的词频算法[13]不同,新的算法是基于前缀词典来实现词图扫描,构造有向无环图(d i r e c t e d a c y c l i c g r a p h ,D A G ),利用动态规划算法查找词频最大切合组,同时结合隐马尔可夫模型(h i d d e nm a r k o vm o d e l ,HMM )模型操作未登录词,大大提高了分词精度和分词效率.基于此,本文在最新词频统计算法基础上,构造私有的前缀词典及D A G ,同时采用最新的幂律分布研究方式,对中英文两种语言进行研究,完善了之前研究者们[1416]在词频统计精度及幂律分布判断方式上的不足之处,并进行了可视化的幂律拟合.该研究推动了人们对自然语言发展的认识.青岛大学学报(工程技术版)第35卷1㊀幂律分布的研究1.1㊀双对数坐标系下幂律分布的判断20世纪末,人们对幂律分布的研究是基于双对数坐标系下,数据分布的图像是否为一条近似的直线来判断.幂律分布特征及其在双对数坐标系下的拟合如图1所示.图1㊀幂律分布特征及其在双对数坐标系下的拟合㊀㊀其形式化的表达为:y =c x -r ,其中x ,y 表示正的随机变量;c ,r 为常数且均大于零.这种分布特征只有少数事件的规模比较大,而绝大多数事件的规模较小.对y -c x -r 两边取对数,可知l n y 与l n x 满足l n y =l n c -r l n x ,这是一种线性关系,即在双对数坐标系下,幂律分布可以通过一条斜率为负的幂指数的直线进行拟合,这一线性关系是判断给定的实例中随机变量是否满足幂律的依据.判断两个随机变量是否满足线性关系,可以求解两者之间的相关系数;利用一元线性回归模型和最小二乘法,可得l n y 对l n x 的线性回归方程,从而得到y 与x 之间的幂律关系式[1,4].对于在双对数坐标系下,线性关系判断数据是否满足幂律分布的说法不正确,因为双对数坐标系下的线性关系是数据满足幂律分布的必要条件,而不是充分条件.1.2㊀幂律分布的判断2007年,A a r o n c h a u s e t 等人[4]提出了判断幂律分布的一系列方法,其思想是将最大似然拟合方法与基于K o l m o g o r o v GS m i r n o v (K S )统计以及似然比的拟合优度检验相结合,判断观测数据是否满足幂律分布,过程主要分为以下几部分:1)㊀估计幂律模型的参数x m i n 和α.2)㊀计算数据与幂律之间的拟合优度,如果得到的p v a l u e 值大于0 1,则幂律分布是观测数据的似然假设,否则拒绝该假设.3)㊀通过似然比检验,将幂律与其他假设进行比较.对于每个备选方案,如果计算的似然比与零显著不同,则其符号表示该备选方案是否优于幂律模型.2㊀词频统计与幂律分布拟合关于自然语言中词汇的分布特征,早在20世纪中叶就有研究者进行过大量研究,直至20世纪末,有学者(幂律分布研究简史)通过双对数坐标系下图像近似一条直线的拟合方式,说明数据满足幂律分布,这种方式显然缺乏说服力.本文基于文献[4]提出的方法,首先基于词频统计算法对文本进行统计,然后结合最大似然拟合方法[17]与基于K o l m o g o r o v GS m i r n o v (K S )统计[18]以及似然比[19]的拟合优度检验方式,对自然语言进行幂律分布的拟合.关于数据的选择,本文选取了经典文学作品«飘»的中英文对照版本,分别对英文和中文进行词频统计,并拟合幂律分布.2㊀第1期㊀㊀李㊀杰,等:基于词频统计算法的中英文词频分布研究2.1㊀词频统计算法词频统计算法流程图如图2所示,词频统计算法整体分为3个部分,每个部分又可分为多个步骤,其描述如下:图2㊀词频统计算法流程图㊀㊀1)㊀基于T r i e 树结构实现高效的词图扫描,构造出有向无环图(D A G ),图中包括生成句子中汉字所有可能的成词情况.根据d i c t .t x t 生成t r i e 树,字典在生成t r i e 树的同时,也把每个词的出现次数转换为频率;对需要进行分词的句子,根据已经生成的t r i e 树,生成有向无环图(D A G ),简言之,就是将句子根据给定的词典进行查寻操作,生成多种可能的句子切分.2)㊀用动态规划算法查找最大概率路径,找到基于词频的最大切分组合.查找待分词句子中已经切分好的词语,即查找该词语出现的频率,如果查不到该词,就把该词的频率赋值为词典中出现频率最小的那个词语的频率;根据动态规划算法查找最大概率路径,即对句子从后往前反向计算最大概率,P (N o d e N )=1 0,P (N o d e N -1)=P (N o d e N )∗M a x (P (最后一个词)) 依次类推,得到最大概率路径,从而得到最大概率的切分组合.3)㊀对于词典中未录入的词,采用基于汉字成词能力的HMM 模型,同时使用v i t e r b i 算法.中文词汇按照B E M S 四个状态标记,B 代表b e g i n ,即开始位置,E 代表e n d ,即结束位置,M 代表m i d d l e ,表示中间位置,S 代表s i n g gl e ,是单独成词的位置,如山东可表示为B E ,即山/B ,是开始位置,东/E ,是结束位置;对语料库进行初步训练,得到3个概率表,并结合v i t e r b i 算法,可以得到一个概率最大的B E M S 序列,按照B 开始,E 结尾的方式,对分词的句子重新组合,就能得到最终的分词结果[14].对«飘»的中英文对照版词频进行统表1㊀«飘»的前5个高频词汇英文单词词频英文词语词频t h e 16119他们2631a n d 13037思嘉2458t o 9134没有2021o f7772一个1851h e r7318自己1639计,«飘»的前5个高频词汇如表1所示.由表1可以看出,中英文在表达同义内容时,所使用词汇差别巨大,并未出现高频词汇一致性的现象,这与语言的特点有关.同时,英文的代词和介词在使用率上远高于其他词汇,而中文则不同,除代词外,量词在文章中也高频出现.虽然有诸多的差别,但在分布情况上仍需进一步验证.2.2㊀幂律分布拟合本文通过将最大似然拟合方法与基于K o l m o g o r o v GS m i r n o v (K S )统计以及似然比的拟合优度检验相结合的方式,对自然语言进行了幂律分布拟合.中英文词频在双对3青岛大学学报(工程技术版)第35卷数坐标系下的幂律拟合如图3所示.图3中,英文词频x m i n =40,α=1 89;中文词频x m i n =38,α=2 1.图3㊀中英文词频在双对数坐标系下的幂律拟合㊀㊀由图3可以看出,在双对数坐标系下,中英文的词频分布均呈现一条近似的直线,说明存在幂律分布的可能性,但需要验证p Gv a l u e 是否大于0 1,如果大于0 1,就要进一步排除其他分布是否比幂律分布拟合效果更好,否则,可以直接判断不满足幂律分布.似然比的拟合优度L R 值和p Gv a l u e (p )值如表2所示.表2㊀似然比的拟合优度L R 值和p Gv a l u e (p)值㊀㊀由表2可以看出,对观测数据进行幂律分布的拟合,得出的p Gv a l u e 分别为0 14和0 19,均大于0 1,且泊松分布,指数分布,广延指数分布的p Gv a l u e 值都为0,即满足其他分布的假设可直接排除,因此对观测数据拟合效果最好的是幂律分布.3㊀结束语本文通过对中英文词频的统计分析,证明了自然语言中的词汇在日常生活中的使用频率是服从幂律分布的,即部分词汇会被大量使用,大部分词汇的使用频率较低,符合动力学中的省力原则,人们更倾向于用更少词汇的不同组合来表达不同的意思,对认识语言的发展过程具有重要意义.这一结论不仅仅出现在本文所研究的文献中,对于其他文献同样适用.文中词频统计算法和 最大似然拟合方法 ㊁ K S 统计以及似然比的拟合优度检验方法 的结合,使本结论的精确度更高,进一步补充了前人对于词频分布的研究与应用.在接下来的工作中,可以将重点放在对其他语言的研究上,在幂律分布的基础之上,探究是否有更加精确的拟合方式,进一步推动人们对于自然语言发展的认识.参考文献:[1]㊀胡海波,王林.幂律分布研究简史[J ].物理,2005,34(12):889896.[2]㊀A d a m i cL A ,H u b e r m a nBA ,B a r a b ás i AL ,e t a l .P o w e r Gl a wd i s t r i b u t i o n o f t h ew o r l dw i d ew e b [J ].S c i e n c e ,2000,287(5461):2115a .[3]㊀王冠男,邓春宇,赵悦,等.电力数据中的幂律分布特性[J ].电信科学,2013,29(11):109114,121.[4]㊀A a r o nC ,C o s m aRS ,N e w m a n M EJ .P o w e r Gl a wd i s t r i b u t i o n s i ne m pi r i c a l d a t a [J ].S i a m R e v i e w ,2009,0706(1062):661703.4㊀第1期㊀㊀李㊀杰,等:基于词频统计算法的中英文词频分布研究5[5]㊀严怡民.情报学概论[M].武汉:武汉大学出版社,1994.[6]㊀A r n o l dBC.P a r e t oD i s t r i b u t i o n[M]ʊE n c y c l o p e d i ao fS t a t i s t i c a lS c i e n c e s.U n i t e dS t a t e s:J o h n W i l e y&S o n s,I n c.,2006.[7]㊀B a r a b a s iAL,A l b e r tR.E m e r g e n c e o f s c a l i n g i n r a n d o mn e t w o r k s[J].S c i e n c e,1999,286(5439):509514.[8]㊀B a r a b a s iAL,B o n a b e a uE.S c a l eGf r e en e t w o r k s[J].S c i e n t i f i cA m e r i c a n,2003,288(5):60.[9]㊀张丹.中文分词算法综述[J].黑龙江科技信息,2012(8):206.[10]㊀张华平,刘群.基于N最短路径方法的中文词语粗分模型[J].中文信息学报,2002,16(5):17.[11]㊀费洪晓,康松林,朱小娟,等.基于词频统计的中文分词的研究[J].计算机工程与应用,2005,41(7):6768,100.[12]㊀秦赞.中文分词算法的研究与实现[D].长春:吉林大学,2016.[13]㊀祝永志,荆静.基于P y t h o n语言的中文分词技术的研究[J].通信技术,2019,52(7):16121619.[14]㊀G o l d s t e i nM L,M o r r i s SA,Y e nGG.F i t t i n g t o t h e p o w e rGl a wd i s t r i b u t i o n[J].T h eE u r o p e a nP h y s i c a l J o u r n a l BGC o nGd e n s e d M a t t e r a n dC o m p l e xS y s t e m s,2004,41(2):2004.[15]㊀F e r n h o l zRT.N o n p a r a m e t r i cm e t h o d s a n d l o c aGt i m eGb a s e de s t i m a t i o n f o r d y n a m i c p o w e r l a wd i s t r i b u t i o n s[J].J o u r n a l o fA p p l i e dE c o n o m e t r i c s,2016,32(7):12441260.[16]㊀M o n t e b r u n oP,B e n n e t tRJ,v a nL i e s h o u t C,e t a l.At a l e o f t w o t a i l s:D o p o w e r l a wa n d l o g n o r m a lm o d e l s f i t f i r mGs i z ed i s t r i b u t i o n s i n t h em i dGv i c t o r i a ne r a[J].P h y s i c aA:S t a t i s t i c a lM e c h a n i c s a n d i t sA p p l i c a t i o n s,2019,523:858875.[17]㊀胡德,郭刚正.最小二乘法㊁矩法和最大似然法的应用比较[J].统计与决策,2015(9):2024.[18]㊀L i l l i e f o r sH W.O n t h ek o l m o g o r o vGs m i r n o v t e s t f o r n o r m a l i t y w i t hm e a na n dv a r i a n c eu n k n o w n[J].J o u r n a l o f t h eAGm e r i c a nS t a t i s t i c a lA s s o c i a t i o n,1967,62(318):399402.[19]㊀成平.极大似然估计与似然比检验的几点注记[J].应用概率统计,2003,19(1):5559.R e s e a r c ho nC h i n e s e a n dE n g l i s h W o r dF r e q u e n c y D i s t r i b u t i o nB a s e d o n W o r dF r e q u e n c y S t a t i s t i c sA l g o r i t h mL I J i e,S U N R e n c h e n g(C o l l e g e o fC o m p u t e r S c i e n c e&T e c h n o l o g y,Q i n g d a oU n i v e r s i t y,Q i n g d a o266071,C h i n a)A b s t r a c t:A i m i n g a t t h e p r o b l e m s e x i s t i n g i n t h e p o w e r l a w j u d g m e n tm e t h o d,t h i s p a p e r s t u d i e s t h e f r eGq u e n c y d i s t r i b u t i o no fC h i n e s ea n dE n g l i s hw o r d sb a s e do nt h e p r e v i o u s r e s e a r c ho n p o w e r l a wd i s t r i b uGt i o n,c o m b i n e dw i t h t h em a x i m u ml i k e l i h o o d f i t t i n g m e t h o da n dw o r d f r e q u e n c y s t a t i s t i c s a l g o r i t h m.T h e j u d g m e n t o f p o w e r l a w d i s t r i b u t i o n i nd o u b l e l o g a r i t h m i cc o o r d i n a t es y s t e mi s g i v e n,a n dt h ew o r df r eGq u e n c y s t a t i s t i c s a n d p o w e r l a wd i s t r i b u t i o n a r e f i t t e d.T h e r e s u l t s s h o wt h a t i n t h e d o u b l e l o g a r i t h m i c c oGo r d i n a t e s y s t e m,t h e d i s t r i b u t i o n i m a g e b e i n g a n a p p r o x i m a t e s t r a i g h t l i n e i s a n e c e s s a r y c o n d i t i o n f o r j u dGg i n g t h e p o w e r l a wd i s t r i b u t i o n,b u t n o t a s u f f i c i e n t c o n d i t i o n.O n t h ew o r d f r e q u e n c y s t a t i s t i c a l d i s t r i b uGt i o nm o d e l o f n a t u r a l l a n g u a g e,t h e p o w e r l a wd i s t r i b u t i o no f t h e o b s e r v a t i o nd a t a i s p r o p o s e d.T h e pGv a lGu e s o b t a i n e d a r e0.14a n d0.19,r e s p e c t i v e l y,b o t h g r e a t e r t h a n0.1,a n d t h e pGv a l u e s o f t h eP o i s s o nd i s t r iGb u t i o n,t h e e x p o n e n t i a l d i s t r i b u t i o n,a n d t h e e x t e n s i v e e x p o n e n t i a l d i s t r i b u t i o na r e a l l0,t h a t i s,t h e a sGs u m p t i o n s s a t i s f y i n g o t h e rd i s t r i b u t i o n s c a nb ed i r e c t l y e x c l u d e d.T h eb e s t f i t f o r t h eo b s e r v a t i o nd a t a i s t h e p o w e r l a wd i s t r i b u t i o n.I t s h o w s t h a t t h ew o r d f r e q u e n c y d i s t r i b u t i o no f n a t u r a l l a n g u a g e s a t i s f i e s t h e p o w e r l a w,a n db o t hC h i n e s e a n dE n g l i s h a r e a p p l i c a b l e.T h i s r e s e a r c h i s o f g r e a t s i g n i f i c a n c e f o r p e o p l e t o u n d e r s t a n d t h e d e v e l o p m e n t p r o c e s s o f l a n g u a g e.K e y w o r d s:w o r d f r e q u e n c y s t a t i s t i c s;p o w e r l a wd i s t r i b u t i o n;m a x i m u ml i k e l i h o o d e s t i m a t i o n;K S s t a t i sGt i c s。

基于统计学习的中文分词技术研究

基于统计学习的中文分词技术研究随着互联网的快速发展,社交媒体、电子商务、在线新闻、搜索引擎等应用越来越多,对中文分词技术的需求也越来越迫切。

中文分词是指将一篇中文文本分成一个一个词汇的过程,是中文信息处理的基本工作之一。

例如,“这是一篇中文文章”应该被分成“这”、“是”、“一篇”、“中文”、“文章”五个词汇。

中文分词的技术路线有很多种,如机械分词、基于字典的分词、基于规则的分词、基于统计的分词等。

其中,基于统计学习的中文分词技术得到了广泛的应用和研究。

基于统计学习的中文分词技术主要是利用大规模中文语料库进行训练,在语料库中学习各种统计模型,并通过统计推断得出最优的分词结果。

常见的统计模型有隐马尔可夫模型(Hidden Markov Model,HMM)、条件随机场(Conditional Random Field,CRF)等。

隐马尔可夫模型是一种基于马尔可夫链的统计模型,它的主要思想是假设每个汉字只与其前面的几个汉字有关,而与整篇文章的其他内容无关。

隐马尔可夫模型可以用来描述“隐含状态”与“观测序列”的关系,将分词过程看作是观测序列的标注过程。

例如,对于“这是一篇中文文章”,将其分成“这/是/一篇/中文/文章”这五个词汇的过程可以被看作是一种序列标注任务,标注结果即为隐含状态。

条件随机场是一种基于概率图模型的统计模型,主要用于序列标注等任务。

它的主要思想是将标注过程看作是一个马尔可夫随机场,既考虑前后文的依赖关系,也考虑各标注状态之间的相互影响。

相比于隐马尔可夫模型,条件随机场能够更好地捕捉中文文本中的上下文信息,从而提高分词准确率。

除了隐马尔可夫模型和条件随机场,还有一些其他的基于统计学习的分词模型,如最大熵模型、朴素贝叶斯分类器等。

这些模型都被广泛应用于中文分词领域,并且已经取得了一定的效果。

尽管基于统计学习的中文分词技术已经得到了广泛的应用和研究,但是它仍具有一些局限性。

例如,当遇到未见过的词汇时,模型很难正确划分。

基于统计的分词算法

基于统计的分词算法是一种将文本分割成单独的词语(或称为“中文分词”)的自然语言处理技术。

它主要基于概率模型和统计学方法,通过对大量文本进行训练和分析,来确定每个词语出现的概率和上下文关系,从而实现准确的分词。

基于统计的分词算法通常可以分为以下几个步骤:

收集并预处理语料库:语料库是指包含大量文本数据的数据库,用于训练和测试分词模型。

在这一步中,需要收集、清洗和预处理语料库,以便后续的分析和建模。

构建统计模型:建立一个概率模型,用于描述每个中文字在不同上下文环境中出现的概率。

典型的模型包括隐马尔可夫模型(HMM)、最大熵模型(ME)、条件随机场(CRF)等。

分词:在实际应用中,分词通常采用正向最大匹配法(FMM)和逆向最大匹配法(RMM)两种方法。

在这一步中,根据前面构建的统计模型和特定的分词策略,将待处理的文本分割成词语序列。

评估和优化:在分词完成后,需要对结果进行评估和优化。

通常采用F1值、准确率、召回率等指标来评价分词的效果,并对模型进行调整和改进。

基于统计的分词算法的优点是可以自适应地调整分词策略和概率模型,以适应不同的文本领域和语言环境。

但它也存在一些缺点,如对于新词的处理比较困难,而且对于歧义词的划分也存在一定的局限性。

因此,在实际应用中,还需要结合其他技术和方法,如规则匹配、机器学习、深度学习等,来提高分词的准确性和效率。

分词方法详解

分词方法详解分词是自然语言处理中的一项基础任务,它的目标是将一段连续的文本切分成若干个最小的、有语义单位的词语。

对于中文分词来说,由于中文没有像英文那样用空格来明确标识单词的边界,所以需要借助特定的算法和规则进行分割。

本文将详细介绍几种常见的中文分词方法。

一、基于规则的中文分词方法基于规则的中文分词方法是最早被提出并得到广泛应用的方法之一。

它通过预先定义一系列的分词规则,例如根据词典进行匹配、利用词性标注等,来进行分词操作。

这种方法的优点是简单易懂,但缺点是对于新词的处理较为困难。

二、基于统计的中文分词方法基于统计的中文分词方法是使用机器学习算法,通过对大规模语料进行训练,学习词语出现的频率和上下文信息,从而进行自动分词。

常见的统计模型有隐马尔可夫模型(Hidden Markov Model,HMM)和条件随机场(Conditional Random Field,CRF)。

这种方法能够较好地处理未登录词和新词,但相应地需要大量的标注数据进行训练。

三、基于深度学习的中文分词方法随着深度学习的发展,基于神经网络的中文分词方法也逐渐兴起。

通常采用的网络结构是循环神经网络(Recurrent Neural Network,RNN)或其变体,如长短时记忆网络(Long Short-Term Memory,LSTM)。

这种方法利用神经网络对文本进行建模,能够有效地捕捉上下文信息,进而进行分词。

相比于传统的方法,基于深度学习的分词方法在分词效果上有一定的提升,但需要大量的训练数据和计算资源。

四、结合方法实际上,现实任务中往往需要结合多种方法来进行中文分词。

例如,可以使用基于规则的方法处理特定的领域词汇,再结合基于统计或深度学习的方法来处理其他部分。

这样既能够充分利用规则的优势,又能够发挥统计和深度学习方法的优势,为实际应用提供更好的分词结果。

五、评价指标对于中文分词任务的评价,常用的指标包括准确率、召回率和F1值等。

中文分词案例

中文分词案例中文分词是自然语言处理中的一个重要任务,其目的是将连续的中文文本切分成单个的词语。

中文分词在很多应用中都起到了关键作用,例如机器翻译、信息检索、文本分类等。

本文将以中文分词案例为题,介绍一些常用的中文分词方法和工具。

一、基于规则的中文分词方法1. 正向最大匹配法(Maximum Matching, MM):该方法从左到右扫描文本,从词典中找出最长的词进行匹配,然后将该词从文本中删除。

重复这个过程,直到文本被切分完毕。

2. 逆向最大匹配法(Reverse Maximum Matching, RMM):与正向最大匹配法相反,该方法从右到左扫描文本,从词典中找出最长的词进行匹配,然后将该词从文本中删除。

重复这个过程,直到文本被切分完毕。

3. 双向最大匹配法(Bidirectional Maximum Matching, BMM):该方法同时使用正向最大匹配和逆向最大匹配两种方法,然后选择切分结果最少的作为最终结果。

二、基于统计的中文分词方法1. 隐马尔可夫模型(Hidden Markov Model, HMM):该方法将中文分词问题转化为一个序列标注问题,通过训练一个隐马尔可夫模型来预测每个字的标签,进而切分文本。

2. 条件随机场(Conditional Random Fields, CRF):与隐马尔可夫模型类似,该方法也是通过训练一个条件随机场模型来预测每个字的标签,进而切分文本。

三、基于深度学习的中文分词方法1. 卷积神经网络(Convolutional Neural Network, CNN):该方法通过使用卷积层和池化层来提取文本特征,然后使用全连接层进行分类,从而实现中文分词。

2. 循环神经网络(Recurrent Neural Network, RNN):该方法通过使用循环层来捕捉文本的时序信息,从而实现中文分词。

四、中文分词工具1. 结巴分词:结巴分词是一个基于Python的中文分词工具,它采用了一种综合了基于规则和基于统计的分词方法,具有较高的准确性和速度。

中文分词技术算法的设计与实现

中文分词技术算法的设计与实现

中文分词技术是自然语言处理领域中的一个重要研究方向,其主要目的是将中文文本按照一定的规则切分成词语序列,为后续的文本处理和分析提供基础。

本文将介绍中文分词技术的算法设计与实现。

中文分词技术的算法设计主要包括基于规则的分词算法和基于统计的分词算法两种。

基于规则的分词算法是根据语言学规则和词汇库进行分词,其优点是准确性高,但缺点是需要大量的人工规则和词汇库,难以适应新词和新语言。

基于统计的分词算法则是通过对大量文本进行统计分析,学习词语的出现概率和上下文信息,从而实现自动分词,其优点是适应性强,但准确性相对较低。

在实现中文分词技术的算法时,需要考虑以下几个方面。

首先是分词的粒度问题,即如何确定分词的最小单位。

一般来说,中文分词的最小单位是单个汉字或者单个词语,具体取决于应用场景和需求。

其次是分词的歧义问题,即同一组汉字序列可能有多种不同的分词方式,如何选择最合适的分词方式是中文分词技术的难点之一。

最后是分词的效率问题,中文分词技术需要处理大量的文本数据,因此算法的效率和速度也是需要考虑的因素。

中文分词技术已经得到了广泛的应用,如搜索引擎、机器翻译、文本分类等领域。

随着人工智能技术的不断发展,中文分词技术也将不断地进行优化和改进,为自然语言处理领域的发展做出更大的贡献。

基于统计模型的中文分词方法

基于统计模型的中⽂分词⽅法统计分词:统计分词的主要思想是把每个词看做是由字组成的,如果相连的字在不同⽂本中出现的次数越多,就证明这段相连的字很有可能就是⼀个词。

统计分词⼀般做如下两步操作:1.建⽴统计语⾔模型(n-gram)2.对句⼦进⾏单词划分,然后对划分结果做概率计算,获取概率最⼤的分词⽅式。

这⾥就⽤到了统计学习算法,如隐马尔科夫模型(HMM),条件随机场(CRF)等语⾔模型:语⾔模型在信息检索,机器翻译,语⾳识别中承担着重要的任务。

这种模型结构简单,直接,但同时也因为数据缺乏⽽必须采取平滑算法。

这⾥主要介绍n元语⾔模型(n-gram)。

假设S表⽰长度为i,由(W1,W2,....,Wi)字序列组成的句⼦,则代表S的概率为:P(S) = P(W1,W2,...,Wi) = P(W1)*P(W2|W1)*P(W3|W2,W1)....P(Wi|W1,W2,...,Wi-1)即每个字的出现都与他之前出现过的字有关,最后整个句⼦S的概率为这些字概率的乘积。

但是这个计算量很⼤,所以在这⾥我们可以利⽤马尔科夫假设,即当前词只与最多前n-1个有限的词相关:当n=1时,即出现在第i位上的词Wi独⽴于历史时,⼀元⽂法被记作uni-gram,⼀元语⾔模型可以记作:uni-gram当n=2时,即出现在第i位上的词wi仅与它前⾯的⼀个历史词wi-1有关,⼆元⽂法模型被称为⼀阶马尔可夫链(Markov chain),记作bi-gram,⼆元语⾔模型可以记作:bi-gram当n=3时,即出现在第i位置上的词wi仅与它前⾯的两个历史词wi-2和wi-1有关,三元⽂法模型被称为⼆阶马尔可夫链,记作tri-gram,三元语⾔模型可以记作:tri-gram在实际应⽤中,⼀般使⽤频率计数的⽐例来计算n元条件概率。

基于HMM的分词:隐含马尔可夫模型(HMM)是将分词作为字在句⼦中的序列标注任务来实现的(关于HMM稍后会在另⼀篇⽂章中详细介绍)。

基于统计的分词技术

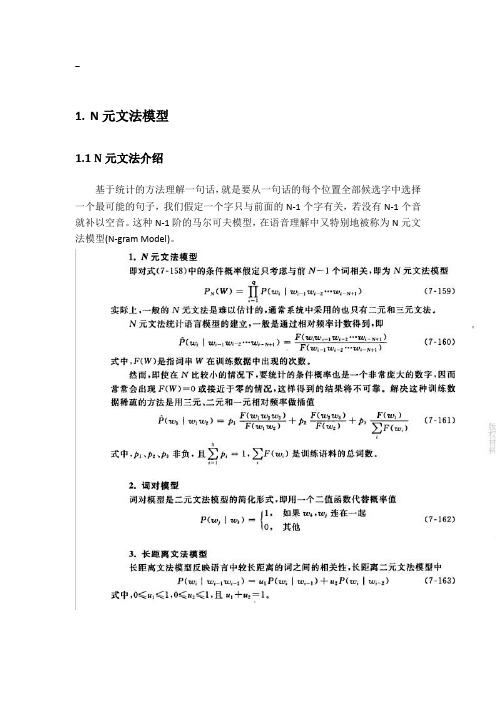

-1.N元文法模型1.1 N元文法介绍基于统计的方法理解一句话,就是要从一句话的每个位置全部候选字中选择一个最可能的句子,我们假定一个字只与前面的N-1个字有关,若没有N-1个音就补以空音。

这种N-1阶的马尔可夫模型,在语音理解中又特别地被称为N元文法模型(N-gram Model)。

N元统计计算语言模型的思想是:一个单词的出现与其上下文环境中出现的单词序列密切相关,第n个词的出现只与前面n-1个词相关,而与其它任何词都不相关。

1.2 利用N元文法来纠正中文文本错误n-gram 是常用的统计语言模型,其中尤以二元文法(Bigram)和三元文法(Trigram)的应用最多。

n-gram 模型统计各种语言的邻接共现规律,反映句子的局部范围是否符合语言规范,被广泛用于自动校对中的错误查找。

在英文的自动校对中使用了词和词的Trigram,把以字、词、词性为共现元素的Bigram 应用于了中文自动校对中,取得了较好的效果。

由于局部错误在文本的错误中占多数,所以选择合适的查找局部错误的方法对自动校对来说至关重要。

我们知道,对正确的语言现象,字词之间的邻接共现概率较高,对一些不符合语法规范的错误,字词之间的邻接共现概率较低。

所以,可应用反映字词之间邻接共现规律的n-gram 模型,对句子进行局部分析,查找文本中的局部错误。

例如:重要课题重要果题方法1:对训练语料先进行自动分词,然后统计二元词邻接共现的规律,相邻的两个词wiwi+1 记为一个词单元ui,下一单元ui+1= wi+1wi+2,该方法统计句子中词单元的绝对次数Count(ui),将其作为模型的参数;方法2:使用方法1 的训练数据,以相邻三个词wiwi+1 wi+2 作为一个词单元ui,然后统计三元词邻接共现的绝对次数Count(ui),扩大词共现的邻接范围方法3:由于三元词的共现存在很大程度的数据稀疏,这里,对方法2的统计结果进行平滑处理,采用的是插值平滑方法。

中文分词模型

中文分词模型中文分词是自然语言处理中的一个重要组成部分,它是将连续的汉字序列切分成有意义的词语序列的过程。

在中文处理中,分词往往是前置任务,也是后续任务的基础。

因此,中文分词模型的研究具有重要的理论和实践意义。

一、传统中文分词模型传统的中文分词模型主要有基于规则、基于统计和基于深度学习的三种。

1. 基于规则的中文分词模型基于规则的中文分词模型是以人工规则为基础的分词方法,它将中文文本按照一定规则进行切分。

这种方法的优点是切分准确率高,但缺点是需要大量的人工规则和专业知识,并且难以适应新的语言环境和文本类型。

2. 基于统计的中文分词模型基于统计的中文分词模型是利用机器学习算法从大规模的语料库中学习分词规则,然后根据这些规则对新的文本进行分词。

这种方法的优点是可以自动学习分词规则,适应性强,但缺点是对语料库的要求较高,且对于生僻字、未登录词等情况处理效果不佳。

3. 基于深度学习的中文分词模型基于深度学习的中文分词模型是利用神经网络模型从大规模的语料库中学习分词规则,然后根据这些规则对新的文本进行分词。

这种方法的优点是可以自动学习分词规则,且对于生僻字、未登录词等情况处理效果较好,但缺点是需要大量的训练数据和计算资源。

二、现有中文分词模型的发展趋势随着人工智能技术的不断发展,中文分词模型也在不断地更新迭代。

现有的中文分词模型主要有以下几个发展趋势:1. 模型结构更加深层随着深度学习技术的发展,中文分词模型的模型结构也越来越深层。

例如,BERT模型、XLNet模型等都采用了多层的神经网络结构,可以更好地学习文本的上下文信息。

2. 多任务学习多任务学习是指在一个模型中同时完成多个任务,例如中文分词、命名实体识别、情感分析等。

这种方法可以让模型学习到更多的语言知识,提高模型的泛化能力。

3. 预训练模型预训练模型是指在大规模的语料库上进行预训练,然后在具体任务上进行微调。

这种方法可以提高模型的泛化能力和效果。

中文分词的三种方法

中文分词的三种方法

中文分词是对汉字序列进行切分和标注的过程,是许多中文文本处理任务的基础。

目前常用的中文分词方法主要有基于词典的方法、基于统计的方法和基于深度学习的方法。

基于词典的方法是根据预先构建的词典对文本进行分词。

该方法将文本与词典中的词进行匹配,从而得到分词结果。

优点是准确率较高,但缺点是对新词或专业术语的处理效果不佳。

基于统计的方法是通过建立语言模型来实现分词。

该方法使用大量的标注语料训练模型,通过统计词语之间的频率和概率来确定分词结果。

优点是对新词的处理有一定的鲁棒性,但缺点是对歧义性词语的处理效果有限。

基于深度学习的方法是利用神经网络模型进行分词。

该方法通过训练模型学习词语与其上下文之间的依赖关系,从而实现分词。

优点是对新词的处理效果较好,且具有较强的泛化能力,但缺点是需要大量的训练数据和计算资源。

综上所述,中文分词的三种方法各自具有不同的优缺点。

在实际应用中,可以根据任务需求和资源条件选择合适的方法进行处理。

例如,在自然语言处理领域,基于深度学习的方法在大规模数据集的训练下可以取得较好的效果,可以应用于机器翻译、文本分类等任务。

而基于词典的方法可以适用于某些特定领域的文本,如医药领

域或法律领域,因为这些领域往往有丰富的专业词汇和术语。

基于统计的方法则可以在较为通用的文本处理任务中使用,如情感分析、信息抽取等。

总之,中文分词方法的选择应根据具体任务和数据特点进行灵活调整,以期获得更好的处理效果。

基于统计学习的文本分类方法研究

基于统计学习的文本分类方法研究随着大数据的普及和互联网的不断发展,文本数据已经成为了人们生产和生活中不可或缺的组成部分。

由此引发的文本分类问题也越来越受到人们的关注。

在无数算法中,基于统计学习的文本分类方法成为了一种重要的解决方案。

本文将介绍基于统计学习的文本分类方法的原理、发展历程以及现在的应用和未来的趋势。

一、基本原理基于统计学习的文本分类方法是建立在统计学习理论基础之上的,主要思想是从训练数据中学习一种映射关系,然后用这种映射关系将新的文本数据作出分类。

具体地说,基于统计学习的文本分类方法有以下几个基本步骤:1. 数据预处理对文本数据进行预处理是基于统计学习的文本分类方法的第一步。

预处理的步骤包括分词、去除停用词、词干提取、辞源归一化等。

预处理可以有效地提高算法的准确性和效率。

2. 特征提取在建立文本分类模型的过程中,需要将文本数据转化为可计算的向量表示。

基于统计学习的文本分类方法通常采用词袋模型,将文本数据表示为向量形式。

提取特征向量的具体方式可以是词频、TF-IDF、LSA、LDA等。

3. 模型训练基于统计学习的文本分类方法需要在训练样本上学习出一个分类器,常用的分类器有朴素贝叶斯分类器、支持向量机、逻辑回归、KNN等。

分类器的选择要根据问题的特性和数据的特点而定。

4. 模型评估模型评估是判断模型好坏的重要标准,常用的评估方法有准确率、F1值、AUC等。

在模型评估的过程中,可以使用交叉验证、留存法等方式来评估模型的性能。

同时,需要根据不同的应用场景进行模型的选择和调整。

二、发展历程基于统计学习的文本分类方法的研究始于20世纪90年代初,随着互联网的发展和文本数据的爆炸增长,这种方法得到了广泛的应用。

其中,朴素贝叶斯分类器是应用最广泛的方法之一,其原理简单,算法复杂度较低,适用于短文本分类等领域。

另外,支持向量机、KNN等分类器也被广泛使用。

近年来,随着深度学习的崛起,基于深度学习的文本分类方法也受到了广泛关注,比如卷积神经网络、循环神经网络等。

一种改进的基于二元统计的HMM分词算法

计 算 机 与 数 字 工 程

C mp tr& Diia En iern o ue gtl gn eig

Vo _ 9 No 1 l3 .

1 4

一

种 改进 的 基 于 二 元 统 计 的 HMM 分 词 算 法

田思虑 D 李德 华 潘 莹" ’

( n o ma in Ne wo k Ce t r I f r t t r n e ,Gu n x ie st 2 ,Na n n 5 0 0 ) o a g Un v r iy i n ig 3 0 4

Ab ta t s rc Chn s r e me tt n i a b scwo k frChn s no mainp o e sn .2Grm ie ewo ds g na i s a i o r o ie eif r t rc sig - a HMM lo i m o o ag rt f r h

最短路径法求出分词结果 。实验结果表明 , 该算法有效 的解决 了过分拆分的问题 , 分词效果 良好 。

关键词 中 文分 词 ;逆 向最 大 匹 配 ; 元 统 计 模 型 ;HMM 模 型 二 TP 1 31 中 图分 类 号

I p o e 一 r m m r v d 2 G a HM M g r t o Al o ihm f r Chi s o d S g e t to ne e W r e m n a i n

a oi m du t te ihs yte r n t dwod re a do tis h r emett nrs lw t e h r s l r h ajss h g t dl gha rs dr n ba e g t we b h wo e n o n t wodsg nai eut i t ot t o hh s e

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于统计的中文分词算法研究作者:邹佳伦文汉云王同喜

来源:《电脑知识与技术》2019年第04期

摘要:最近几年大数据、人工智能的迅猛发展,对数据的采集、加工、挖掘也得到了长足的发展,信息的价值逐渐凸显,智能推荐、语音识别等高价值的信息处理越来越多的改变生活。

如何从互联网上中文网页内容提取出有效的识别、提取出有价值的信息是当今信息研究的重要课程。

中文分词作为中文文本处理的重要组成部分,本文作者在对当前分词的基本问题,以及主要分词方法的优缺点进行思考和分析的基础上,重点分析了基于统计的分词方法,分析了基于统计的分词器的设计理念与算法思想。

文中涉及中文分词的难点分析,隐含马尔科夫模型的处理,维特比路径优化算法。

关键词:中文分词;隐马尔科夫模型;路径优化问题;维特比算法

中图分类号:TP311 文献标识码:A 文章编号:1009-3044(2019)04-0149-02

对于自然语言处理,词是最小的有意义的组成部分。

中文相对于英文在“词”上有明显的难度。

拉丁文语系,词与词之间是有明显的分隔符的存在,而这一點在中文是不存在的,中文词之间没有空格符,只能通过对于单个字符、句子、或语句段来划分。

但是中文文本的分析,必须转换为一个个的最小语义单位“词”才能进行。

因此中文的分词,不仅是中文自然语言处理中的重要环节,也是中文进行更高层次信息处理,如:语义,语句顺序等的基础。

1 中文分词发展历史和现状

中文分词早期方法,也是最简单的方法就是查字典。

这种方法最先由北京航空航天大学的

梁南元教授提出。

查字典的方法,就是建立一个字典,将句子从左向右扫描一次,将句子与词

典进行匹配,遇到字典里面包含的词语就标识出来。

遇到复合词,找最长的匹配词切割。

这个方法简单,可以在复杂度不高的前提下处理70%~80%的分词问题。

20世纪80年代,哈尔滨工业大学的王晓龙博士进一步将查字典的方法理论化,发展成为最少词数的分词理论。

就是将一句话分成数量最少的词串。

基于查字典的方法过于简单,不适用于稍稍复杂的问题,有一个无法避免的问题,即切分遇到二义性词就无能为力。

二十世纪九十年代之前,许多海内外学者试图用一些文法规则,来解决二义性问题,但最后都不是很成功。

直到1990年前后,清华大学的郭静博士用统计语言模型,成功地解决了分词的二义性问题,成功将中文分词的错误率降低了一个数量级。

基于词典的中文分词方法是该领域的主要研究方向,主要包括基于规则、统计、字标注三大类方法。

早期主要使用基于规则的方法,即根据中文的特点建立一些处理规则,计算机按照这些处理规则处理文本使之歧义消除。

二十一世纪以前,由于这种方法类似于语言学思维,基于规则的分词方法非常流行,占据了中文分词研究绝大部分。

但后来发现基于规则的分词方法效率低下,规则越来越庞大复杂,而且语言学家对词语的定义并不完全相同,这种方法并不能如人所愿。

于是基于统计的方法慢慢成为主流,其主要思想是使用某个数学模型作为工具,最常见的且比较成熟的有隐马尔科夫模型、最大熵模型、条件随机场模型等。

自从基于统计的分词方法提出来之后,切分速度和准确度都有了明显提高,明显优于基于规则的分词方法。

2002年,第一届SIGHAN研讨会上,第一篇基于字标注分词的文章发布,基于字标注分词的模型的产品接二连三的出现,技术也越来越成熟,其中比较出名的有Low开发的系统,以及Nianwcn Xuc的系统,它们都有不错的成果。

2 基于统计的中文分词的基本原理

由于分词满足隐马尔科夫数学模型,利用隐马尔科夫模型计算出各种分词后,句子出现的概率,再利用维特比算法求出最大值,最终找到最好的分词方法。

3 基于统计的中文分词的核心算法

3.1 基于隐含马尔科夫模型的数学模型

隐含马尔科夫模型是马尔科夫链的一个扩展,任何时刻t的状态St是不可见的,所以观察者没分通过观察一个序列s1,s2…st来推测转移概率等参数。

但是隐含马尔科夫模型每个时刻t都会输出一个符号ot,ot是和st相关且只和st相关的独立输出假设。

第二步:针对每一步Ti,计算这一步中的每一个可能分词的最佳路径

Best(wi,Tn)=max(Best(wj,Tn-1)P(wi|wj))

其中Best(wi|Tn)表示分词wi在Tn时与之前所得到得分词组成的联合概率中最佳概,即当前阶段所对应字串最可能的分词,对应图就是当前阶段最可能的分词所组成的最佳路径。

wj表示wi在最佳路径上的前向词,p(wi|wj)是转移概率,到最后时刻Tm时我们得到最后结果,即完整最佳分词的路径,结合图1,从T1进行到T6最后一步,就得到最后结果,最佳分词路径。

4 总结与展望

基于统计方法的中文分词方法,经过不断的改进中文分词的精度已经达到95%以上,已大体解决了中文分词的问题。

但并不是说中文分词已经非常完美了。

对于未登录词语的处理一直一个大问题,未登录词大致分为两类:(1)新出现的通用名词或专业术语(2)专有名词,如:人名、外国译名、地名、机构名等。

第一种情况的未登录词理论上虽然可以预期,可通过人工添加词表中,但是实际操作中并不容易做到。

后一种情况难度更大,完全不能预测,无论词库字典如何庞大,都不能概括。

松茂松等指出,未登录词对分词精度的影响超过了歧义切分,可见未登录词在分词系统中占有举足轻重的地位。

虽然孙茂松、吴立德、刘挺、邹嘉彦等做了大量的工作,在一定程度上提高了未登录词的分词效果,但效果仍然不很好。

后期仍可以做大量的研究。

参考文献:

[1] 孙茂松,邹嘉彦.汉语自动化分词研究评述[J].当代语言学,2001(1):22-32.

[2] 魏晓宇.基于隐马尔科夫模型的中文分词研究[J].计算机教育,2007(1):885-886.

[3] 董振东.汉语分词研究漫谈[J].语言文字应用,1997(1):107-112.

[4] 黄祥喜,书面汉语自动分词的“生成一测试”方法[J].中文信息学报,1989(4):42-49.

[5] 梁南元.书面汉语自动分词系统—CDWS[J].中文信息学报,1987(2):44-52.

[6] 刘开瑛.现代汉语自动分词评测技术研究[J].语言文字应用,1997(1):101-106.

[7] 刘源,梁南元.汉语处理的基础工程—现代汉语词频统计[J].中文信息学报,1986(1):17-25.

[8] 于江生.隐Markov 模型及其在自然语言处理中的应用[M].北京大学计算语言学研究所,1999.

[9] 陈桂林,王永成,等.一种改进的快速分词算法[M].计算机研究与发展,2000 .

[10] 苗夺谦,卫志华中文文本信息处理的原理与应用[M].清华大学出版社,2000.

【通联编辑:梁书】。