第二章 信源及信源熵

合集下载

第二章 信源熵 第1节

奈特

page10

Chapter 2 信源熵

$2.ቤተ መጻሕፍቲ ባይዱ 信息的度量

约定:由于二进制数字通信系统的普及,比特的应用 最为普遍。当不指明对数的底时( log1 p),均是 指以2为底。 计算机专业中的比特和信息量中的比特间的区别

计算机专业:例:存储容量=?字节 1字节=8比特 数据传输率 001111101111 比特/秒 思考:是否与0,1出现的概率有关?无关 信息论:比特与0,1出现的概率有关

定长变长编码定理chapter信源熵page321信息的度量211自信息量和互信息量自信息量的定义及性质联合自信息量条件自信息量的定义几种自信息量间的关系互信息量定义的引出物理意义性质212平均自信息量熵信源熵信息熵香农熵平均自信息量定义的引出联合熵和条件熵熵的主要性质及定理加权熵的概念及基本性质213平均互信息量交互熵平均互信息量定义的引出主要性质几种熵信源熵联合熵条件熵交互熵之间的关系chapter信源熵page421信息的度量211自信息量和互信息量一自信息量的定义问题

1 p( A) I ( A) log 5.17 比特 36 5 (2) B:XY={26, 35, 44, 53, 62}。 I ( B ) log 2.85 36 比特 2 (3) C:XY={34, 43}。 I (C ) log 4.17 比特 36

p ( x i ) 0 p ( xi )1

f [ p( AB )]

page6

Chapter 2 信源熵

$2.1 信息的度量

信息量是随机事件概率的函数 概率越小,信息量越大

定性认识: 概率趋近于0,信息量趋近于无穷大 确定性事件,信息量为0

两个独立事件,联合事件的信息量是 二者之和

信源及信源熵介绍

14

2.2.1 自信息量

2. 不确定度 定义:随机事件的不确定度在数量上等于它的 自信息量.

说明:

a. 两者的单位相同,但含义却不相同。 b. 具有某种概率分布的随机事件不管发生与否,都存在

不确定度,不确定度表征了该事件的特性,而自信息 量是在该事件发生后给予观察者的信息量。

15

2.2.1 自信息量

22

2) 因为X中各符号xi的不确定度I(xi)为非负值,p(xi)也 是非负值,且0 p(xi)1,故信源的平均不确定度H(X) 也是非负量。

3) 平均不确定度H(X)的定义公式与热力学中熵的表示形 式相同,所以又把H(X)称为信源X的熵。熵是在平均意 义上来表征信源的总体特性的,可以表征信源的平均不确 定度。

2

p(xi ) log 2 p(xi ) i 1

= 0.72比特/次 说明:

1) 自信息量I(x1)和I(x2)只是表征信源中各个 符号的不确定度,一个信源总是包含着多个符 号消息,各个符号消息又按概率空间的先验概 率分布,因而各个符号的自信息量就不同。所 以自信息量不能作为信源总体的信息量。

=3 × 105 × 3.32 比特/画面

25

有一篇千字文章,假定每字可从万字表中任选, 则共有不同的千字文 N=100001000=104000 篇 仍按等概率1/100001000计算,平均每篇千字文 可提供的信息量为 H(X)=log2N =4 × 103 × 3.32

1.3 × 104 比特/千字文

离散消息的信源,如文字、数字、数据等符号都是

离散消息。

{ 离散信源

离散无记忆信源 离散有记忆信源

{ {

5

发出单个符号的无记忆信源 发出符号序列的无记忆信源 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源

2.2.1 自信息量

2. 不确定度 定义:随机事件的不确定度在数量上等于它的 自信息量.

说明:

a. 两者的单位相同,但含义却不相同。 b. 具有某种概率分布的随机事件不管发生与否,都存在

不确定度,不确定度表征了该事件的特性,而自信息 量是在该事件发生后给予观察者的信息量。

15

2.2.1 自信息量

22

2) 因为X中各符号xi的不确定度I(xi)为非负值,p(xi)也 是非负值,且0 p(xi)1,故信源的平均不确定度H(X) 也是非负量。

3) 平均不确定度H(X)的定义公式与热力学中熵的表示形 式相同,所以又把H(X)称为信源X的熵。熵是在平均意 义上来表征信源的总体特性的,可以表征信源的平均不确 定度。

2

p(xi ) log 2 p(xi ) i 1

= 0.72比特/次 说明:

1) 自信息量I(x1)和I(x2)只是表征信源中各个 符号的不确定度,一个信源总是包含着多个符 号消息,各个符号消息又按概率空间的先验概 率分布,因而各个符号的自信息量就不同。所 以自信息量不能作为信源总体的信息量。

=3 × 105 × 3.32 比特/画面

25

有一篇千字文章,假定每字可从万字表中任选, 则共有不同的千字文 N=100001000=104000 篇 仍按等概率1/100001000计算,平均每篇千字文 可提供的信息量为 H(X)=log2N =4 × 103 × 3.32

1.3 × 104 比特/千字文

离散消息的信源,如文字、数字、数据等符号都是

离散消息。

{ 离散信源

离散无记忆信源 离散有记忆信源

{ {

5

发出单个符号的无记忆信源 发出符号序列的无记忆信源 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源

信息论与编码2-信源及信源熵

随机英文字母信源,其中每个英文字母出现的概率是固定的。

实例3

随机天气状况信源,其中晴天、雨天、雪天出现的概率分别是0.7、0.2、0.1。

实例1

随机二进制信源,其中每个二进制符号(0或1)出现的概率为0.5。

离散无记忆信源的实例

离散有记忆信源

03

离散有记忆信源是输出符号序列中符号与符号之间存在记忆关系的离散随机序列。

应用场景

广泛应用于网络通信、金融交易、军事通信等领域,保障信息安全和隐私。

加密通信

03

应用景

广泛应用于通信系统、数据存储等领域,如CD、DVD、硬盘等存储设备的纠错编码。

01

纠错原理

通过在数据中添加冗余信息,检测和纠正数据传输过程中的错误。

02

常见纠错编码

如奇偶校验码、海明码、循环冗余校验码等,这些编码利用数学原理对数据进行校验,确保数据的正确性。

纠错编码

THANKS

感谢观看

离散有记忆信源的输出符号之间存在统计依赖关系,这种关系会影响信息熵的计算。

定义

性质

离散有记忆信源的定义与性质

计算方法

条件熵

联合熵

离散有记忆信源熵的计算

离散有记忆信源熵是描述信源不确定性的度量,可以通过统计模型来计算。具体计算方法包括条件熵和联合熵等。

条件熵是在给定前一个或多个符号条件下,输出符号的熵。

应用场景

广泛应用于文件存储、网络传输、多媒体处理等领域,如JPEG图片压缩、MP3音频压缩等。

数据压缩原理

通过去除数据中的冗余信息,将数据压缩至更小的存储空间,提高存储和传输效率。

数据压缩

加密原理

通过特定的加密算法将明文转换为密文,确保信息在传输过程中的保密性。

实例3

随机天气状况信源,其中晴天、雨天、雪天出现的概率分别是0.7、0.2、0.1。

实例1

随机二进制信源,其中每个二进制符号(0或1)出现的概率为0.5。

离散无记忆信源的实例

离散有记忆信源

03

离散有记忆信源是输出符号序列中符号与符号之间存在记忆关系的离散随机序列。

应用场景

广泛应用于网络通信、金融交易、军事通信等领域,保障信息安全和隐私。

加密通信

03

应用景

广泛应用于通信系统、数据存储等领域,如CD、DVD、硬盘等存储设备的纠错编码。

01

纠错原理

通过在数据中添加冗余信息,检测和纠正数据传输过程中的错误。

02

常见纠错编码

如奇偶校验码、海明码、循环冗余校验码等,这些编码利用数学原理对数据进行校验,确保数据的正确性。

纠错编码

THANKS

感谢观看

离散有记忆信源的输出符号之间存在统计依赖关系,这种关系会影响信息熵的计算。

定义

性质

离散有记忆信源的定义与性质

计算方法

条件熵

联合熵

离散有记忆信源熵的计算

离散有记忆信源熵是描述信源不确定性的度量,可以通过统计模型来计算。具体计算方法包括条件熵和联合熵等。

条件熵是在给定前一个或多个符号条件下,输出符号的熵。

应用场景

广泛应用于文件存储、网络传输、多媒体处理等领域,如JPEG图片压缩、MP3音频压缩等。

数据压缩原理

通过去除数据中的冗余信息,将数据压缩至更小的存储空间,提高存储和传输效率。

数据压缩

加密原理

通过特定的加密算法将明文转换为密文,确保信息在传输过程中的保密性。

第2章信源与信息熵

香农辅助定理

H (p 1 ,p 2 ,p 3 ) p ilo p i g p ilo q i g

i

i

普通高等教育“十五”国家级规划教材《信息论与编码》

32

2.2离散信源熵与互信息

最大熵定理

H (X)H (1,1, 1)loM g

条件熵小于无条M 件M 熵 M

H(Y/X)H(Y)

普通高等教育“十五”国家级规划教材《信息论与编码》

第2章信源与信息熵

2.1信源的描述与分类

信源是产生消息(符号)、消息序列和连 续消息的来源。从数学上,由于消息的不 确定性,因此,信源是产生随机变量、随 机序列和随机过程的源

信源的基本特性是具有随机不确定性

普通高等教育“十五”国家级规划教材《信息论与编码》

2

2.1信源描述与分类

连续信源

p U (u ) (p a (,u b ))

离散信源条件熵 定义:对于给定离散概率空间表示的信源所定义 的随机变量I(x/y)在集合X上的数学期望为给定y 条件下信源的条件熵,单位为比特/序列

H ( X /y ) E [ I ( X /y ) ] p ( x i/y ) l o g p ( x i/y )

i

H ( X / Y ) E [ H ( X /y ) ] p ( y j ) p ( x i/y j ) l o g p ( x i/y j )

I Np( x1) I ( x1) Np( x2 ) I ( x2 ) (0.8 log2 0.8 0.2 log2 0.2) N 平均每次所获得的信息量为

I p( x1 ) I ( x1 ) p( x2 ) I ( x2 ) p( xi ) log p( xi )

i

普通高等教育“十五”国家级规划教材《信息论与编码》

H (p 1 ,p 2 ,p 3 ) p ilo p i g p ilo q i g

i

i

普通高等教育“十五”国家级规划教材《信息论与编码》

32

2.2离散信源熵与互信息

最大熵定理

H (X)H (1,1, 1)loM g

条件熵小于无条M 件M 熵 M

H(Y/X)H(Y)

普通高等教育“十五”国家级规划教材《信息论与编码》

第2章信源与信息熵

2.1信源的描述与分类

信源是产生消息(符号)、消息序列和连 续消息的来源。从数学上,由于消息的不 确定性,因此,信源是产生随机变量、随 机序列和随机过程的源

信源的基本特性是具有随机不确定性

普通高等教育“十五”国家级规划教材《信息论与编码》

2

2.1信源描述与分类

连续信源

p U (u ) (p a (,u b ))

离散信源条件熵 定义:对于给定离散概率空间表示的信源所定义 的随机变量I(x/y)在集合X上的数学期望为给定y 条件下信源的条件熵,单位为比特/序列

H ( X /y ) E [ I ( X /y ) ] p ( x i/y ) l o g p ( x i/y )

i

H ( X / Y ) E [ H ( X /y ) ] p ( y j ) p ( x i/y j ) l o g p ( x i/y j )

I Np( x1) I ( x1) Np( x2 ) I ( x2 ) (0.8 log2 0.8 0.2 log2 0.2) N 平均每次所获得的信息量为

I p( x1 ) I ( x1 ) p( x2 ) I ( x2 ) p( xi ) log p( xi )

i

普通高等教育“十五”国家级规划教材《信息论与编码》

信息论与编码第2章信源与熵

三个信息单位比特bit、奈特nat、哈特Hart之间的 转换关系如下:

1 nat log 2 e 1.433 bit 1 Hart log 210 3.322 bit 1 bit 0.693 nat 1 bit 0.301 Hart

21

对数及常用公式

y log10 x x 10

描述信源消息或对信源建模,随机过程是一个有效的工具, 通过随机过程的特性来描述信源的特性。

3

信源输出的描述

信源

Xi为

X1, X2, X3, ……

{a1, a2, a3, …am}或(a,b)

信源发出消息,消息载荷信息,而消息又具有不确 定性,所以可用随机变量或随机序列(矢量)来描述 信源输出的消息,或者说用概率空间来描述信源。信 源的输出被抽象为一个随机变量序列(随机过程)。

12

混合信源

按信源输出时间和取值划分: 时间连续,取值连续或随机的,称之为随机波 形信源,表示为X(t)。 输出既有连续分量又有离散分量,称之为混合 信源。

重点研究离散信源产生消息的不确定性,不研 究信源的内部结构和消息的如何产生。

13

信源的分类

随机 变量 连续信源:可能输出的消息数是无限的或不可数的

19

自信息量定义

定义 2.1.1 任意随机事件的自信息量定义为该事 件发生概率的对数的负值。

1 I ( xi ) log log p( xi ) p( xi )

自信息量的单位取决于对数选取的底。 单位:比特bit、奈特nat、哈特Hart。

当对数的底取2时,单位为比特bit 当以自然数e为底时,单位为奈特nat 当以10为底时,单位为哈特hart

信息论与编码 第2章 信源与信息熵

设 B1 , B2 , … 是一列互不相容的事件(B i B j = 0),

且有B1∪B2∪…=Ω(样本空间);

P(Bi)>0,i=1,2…,则对任一事件A,有:

p( A) p( Bi ) p( A | Bi ) p( ABi )

i i

2013-8-19

5

相 关 知 识 复 习

4)贝叶斯(Bayes)公式: 设B1,B2 , … 是一列互不相容的事件(B i B j = 0), 且有B1∪B2∪… =Ω(样本空间); p(Bi)>0 ,i=1,2,…,则对任一事件 A,有:

p( X1, X 2 ,, X l , X L ) p( X1 ) p( X 2 ) p( X L )

2013-8-19

9

2.1信源特性与分类

离散有记忆序列信源 布袋摸球实验,每次取出两个球,由两

个球的颜色组成的消息就是符号序列。 若先取出一个球,记下颜色不放回布袋, 再取另一个球。

2.1信源描述与分类

马尔可夫信源 定义:若齐次马尔可夫链对一切I,j存在

不依赖于I的极限,则称其具有遍历性, pj称为平稳分布

lim p p j k p j 0

(k ) ij i 0

p j pi pij

2013-8-19

p

j

j

1

22

2.1信源描述与分类

马尔可夫信源 定理:设有一齐次马尔可夫链,其状态

2.1 马尔可夫信源的定义

3. 【特殊说明】

① n阶马尔可夫信源只与前面发 出的n个符号有关,即关联长 度为n+1。

② 当n=1时,即任何时刻信源符 号发生的概率只与前面一个符 号有关,则称为一阶马尔可夫 信源。

且有B1∪B2∪…=Ω(样本空间);

P(Bi)>0,i=1,2…,则对任一事件A,有:

p( A) p( Bi ) p( A | Bi ) p( ABi )

i i

2013-8-19

5

相 关 知 识 复 习

4)贝叶斯(Bayes)公式: 设B1,B2 , … 是一列互不相容的事件(B i B j = 0), 且有B1∪B2∪… =Ω(样本空间); p(Bi)>0 ,i=1,2,…,则对任一事件 A,有:

p( X1, X 2 ,, X l , X L ) p( X1 ) p( X 2 ) p( X L )

2013-8-19

9

2.1信源特性与分类

离散有记忆序列信源 布袋摸球实验,每次取出两个球,由两

个球的颜色组成的消息就是符号序列。 若先取出一个球,记下颜色不放回布袋, 再取另一个球。

2.1信源描述与分类

马尔可夫信源 定义:若齐次马尔可夫链对一切I,j存在

不依赖于I的极限,则称其具有遍历性, pj称为平稳分布

lim p p j k p j 0

(k ) ij i 0

p j pi pij

2013-8-19

p

j

j

1

22

2.1信源描述与分类

马尔可夫信源 定理:设有一齐次马尔可夫链,其状态

2.1 马尔可夫信源的定义

3. 【特殊说明】

① n阶马尔可夫信源只与前面发 出的n个符号有关,即关联长 度为n+1。

② 当n=1时,即任何时刻信源符 号发生的概率只与前面一个符 号有关,则称为一阶马尔可夫 信源。

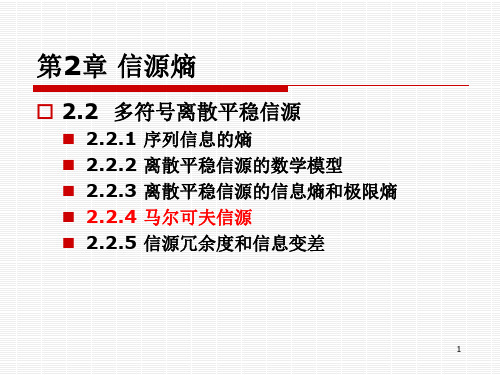

2-6 第2章 2.2.4-5 马尔可夫信源

信源输出的随机符号序列为X1 X 2 X l , X l X ( x1 , x2 , xn ), l 1, 2, 信源所处的状态序列为S1S 2 Sl , Sl S (e1 , e2 , eJ ), l 1, 2,

3

马尔可夫信源定义

定义 若信源输出的 符号序列 和 状态序列 满足下述条件则称此信源为马尔可夫信源 1、某一时刻l 信源的输出仅与信源的当前状态有关,即 p ( X l xk Sl e j , X l 1 xk1 , Sl 1 ei ,) p ( X l xk Sl e j ) 其中,xk、xk1 A;ei、e j S 2、信源的状态只由当前的输出符号和前一时刻信源状态 唯一确定,即 1 p ( Sl ei X l xk , Sl 1 e j ) 0

6

马尔可夫链状态转移图-例题

通常我们用马尔可夫 链的状态转移图来描 述马尔可夫信源。

例 一个二进制一阶马尔可夫信源, 信源符号集为X {0,1}, 条件概率为 p (0 0) 0.25, p(0 1) 0.5, p (1 0) 0.75, p(1 1) 0.5, q 2, m 1, 所以e1 0, e 2 1.

i j

其中p (e j )是马尔可夫链的平稳分布。 p (e j )为极限概率,满足方程组 p (e j ) p (ei ) p (e j / ei ) Nhomakorabeai 1 nm

( j 1, 2,..., n m )

及条件 p (e j ) 0,

p (e

j 1

nm

j

) 1

15

计算此马尔可夫信源熵-例题

N

H ( X m1 X 1 , X 2 ,, X m ) H m1 即m阶马尔可夫信源的极限 熵等于m阶条件熵。 13

第2章信源熵-概念及单符号离散信源熵

表示

x2 xn X x1 P(X) P(x ) P( x ) P( x ) 1 2 n

其中,0 P( x i ) 1, i 1,2,, n且 P( x i ) 1

i 1

n

例1

6 X 1 2 P(X) 1/ 6 1 / 6 1/ 6

I(x 4 ) log P(x 4 ) log( 1/ 8) log 8 3(bit )

信源熵

3、熵

定义

信源各消息自信息量的数学期望为该信源的熵, 也叫无条件熵,用H(X)表示。

表示

H(X) E[I( x i )] P( x i )I( x i ) P( x i ) log P( x i )

i 1 i 1

n

n

同理, (1 )P2 ( x i ) log[ P1 ( x i ) (1 )P2 ( x i )]

i 1

n

(1 )P2 ( x i ) log P2 ( x i )

i 1

n

信源熵

[P1 ( x i ) (1 )P2 ( x i )] log[ P1 ( x i ) (1 )P2 ( x i )]

信源熵

2、自信息量

假设单符号离散信源发出消息xi、xj 的概率 P(xi) < P(xj),那条消息具有更大的信 息量, xi 还是xj ?

信源熵

根据香农信息的概念,消息中具有不确定 性的成分才是信息,不确定性的成分越大, 或者说概率越小,信息量就越大,从这个 意义判断,消息xi 具有更大的信息量。

信源熵

离散信源又可以细分为: (1)离散无记忆信源:所发出的各 个符号之间是相互独立的,发出 的符号序列中的各个符号之间没 有统计关联性,各个符号的出现 概率是它自身的先验概率。 (2)离散有记忆信源:发出的各个 符号之间不是相互独立的,各个 符号出现的概率是有关联的。