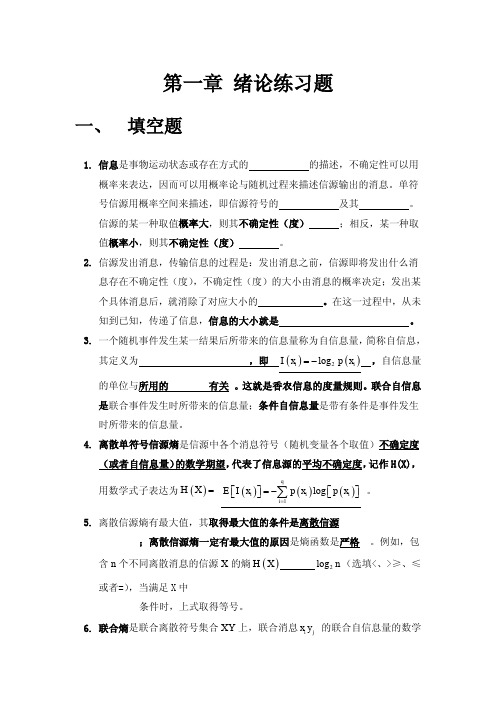

第二章信源熵-习题答案(精品文档)

信息编码习题答案或提示

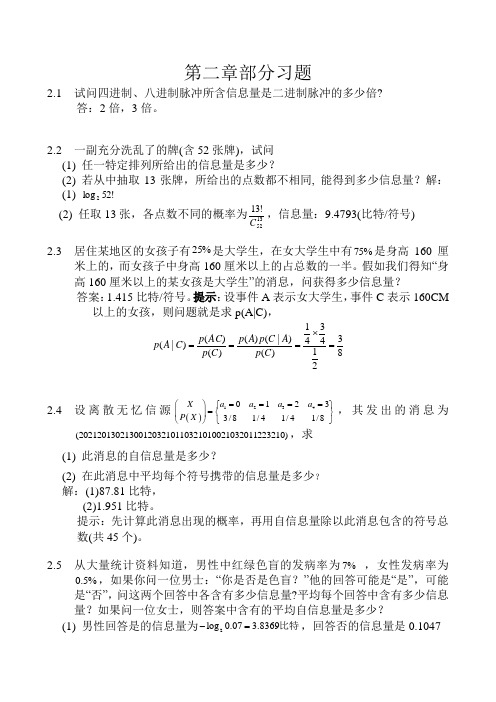

第二章部分习题2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?答:2倍,3倍。

2.2 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同, 能得到多少信息量?解:(1) !52log 2 (2) 任取13张,各点数不同的概率为1352!13C ,信息量:9.4793(比特/符号)2.3 居住某地区的女孩子有%25是大学生,在女大学生中有75%是身高160厘米上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 答案:1.415比特/符号。

提示:设事件A 表示女大学生,事件C 表示160CM 以上的女孩,则问题就是求p(A|C),83214341)()|()()()()|(=⨯===C p A C p A p C p AC p C A p2.4 设离散无忆信源()123401233/81/41/41/8X a a a a P X ====⎛⎫⎧⎫=⎨⎬ ⎪⎩⎭⎝⎭,其发出的消息为(202120130213001203210110321010021032011223210),求(1) 此消息的自信息量是多少?(2) 在此消息中平均每个符号携带的信息量是多少?解:(1)87.81比特,(2)1.951比特。

提示:先计算此消息出现的概率,再用自信息量除以此消息包含的符号总数(共45个)。

2.5 从大量统计资料知道,男性中红绿色盲的发病率为7% ,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含有多少信息量?平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?(1) 男性回答是的信息量为2log 0.07 3.8369-=比特,回答否的信息量是0.1047比特,平均每个回答含的信息量(即熵)是0.36596比特。

信息论与编码第二章答案

第二章 信息的度量2.1信源在何种分布时,熵值最大?又在何种分布时,熵值最小?答:信源在等概率分布时熵值最大;信源有一个为1,其余为0时熵值最小。

2.2平均互信息量I(X;Y)与信源概率分布q(x)有何关系?与p(y|x)又是什么关系?答:若信道给定,I(X;Y)是q(x)的上凸形函数;若信源给定,I(X;Y)是q(y|x)的下凸形函数。

2.3熵是对信源什么物理量的度量?答:平均信息量2.4设信道输入符号集为{x1,x2,……xk},则平均每个信道输入符号所能携带的最大信息量是多少?答:k k k xi q xi q X H ilog 1log 1)(log )()(=-=-=∑2.5根据平均互信息量的链规则,写出I(X;YZ)的表达式。

答:)|;();();(Y Z X I Y X I YZ X I +=2.6互信息量I(x;y)有时候取负值,是由于信道存在干扰或噪声的原因,这种说法对吗?答:互信息量,若互信息量取负值,即Q(xi|yj)<q(xi),说明事件yi 的出现告)()|(log );(xi q yj xi Q y x I =知的是xi 出现的可能性更小了。

从通信角度看,视xi 为发送符号,yi 为接收符号,Q(xi|yj)<q(xi),说明收到yi 后使发送是否为xi 的不确定性更大,这是由于信道干扰所引起的。

2.7一个马尔可夫信源如图所示,求稳态下各状态的概率分布和信源熵。

答:由图示可知:43)|(41)|(32)|(31)|(41)|(43)|(222111110201======s x p s x p s x p s x p s x p s x p 即:得:114)(113)(114)(210===s p s p s p 0.25(bit/符号)=+-+-+-=)]|(log )|()|(log )|()[()]|(log )|()|(log )|()[()]|(log )|()|(log )|()[(222220202121211111010100000s s p s s p s s p s s p s p s s p s s p s s p s s p s p s s p s s p s s p s s p s p H 2.8一个马尔可夫信源,已知:试画出它的0)2|2(,1)2|1(,31)1|2(,32)1|1(====x x p x x p x x p x x p 香农线图,并求出信源熵。

信息论与编码第二章答案

2—1、一阶马尔可夫链信源有3个符号{}123,,u u u ,转移概率为:1112()u p u=,2112()u p u =,31()0u p u =,1213()u p u = ,22()0u p u =,3223()u p u =,1313()u p u =,2323()u p u =,33()0u p u =。

画出状态图并求出各符号稳态概率。

解:由题可得状态概率矩阵为:1/21/20[(|)]1/302/31/32/30j i p s s ⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦状态转换图为:令各状态的稳态分布概率为1W ,2W ,3W ,则: 1W =121W +132W +133W , 2W =121W +233W , 3W =232W 且:1W +2W +3W =1 ∴稳态分布概率为:1W =25,2W =925,3W = 6252-2.由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:P (0|00)=0.8,P(0|11)=0.2,P (1|00)=0.2,P(1|11)=0.8,P (0|01)=0.5,p(0|10)=0。

5,p(1|01)=0。

5,p (1|10)=0。

5画出状态图,并计算各符号稳态概率。

解:状态转移概率矩阵为:令各状态的稳态分布概率为1w 、2w 、3w 、4w ,利用(2—1-17)可得方程组。

1111221331441132112222332442133113223333443244114224334444240.80.50.20.50.50.20.50.8w w p w p w p w p w w w w p w p w p w p w w w w p w p w p w p w w w w p w p w p w p w w =+++=+⎧⎪=+++=+⎪⎨=+++=+⎪⎪=+++=+⎩ 且12341w w w w +++=;0.8 0.2 0 00 0 0.5 0.5()0.5 0.5 0 00 0 0.2 0.8j i p s s ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦解方程组得:12345141717514w w w w ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩ 即:5(00)141(01)71(10)75(11)14p p p p ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2—3、同时掷两个正常的骰子,也就是各面呈现的概率都是16,求:(1)、“3和5同时出现”事件的自信息量;(2)、“两个1同时出现"事件的自信息量; (3)、两个点数的各种组合的熵或平均信息量; (4)、两个点数之和的熵; (5)、两个点数中至少有一个是1的自信息量。

信源熵 第二章(1)

2.3.2 离散有记忆信源的序列熵

• 若信源输出一个L长序列,则信源的序列熵为

H(X)H(X1X2XL) H(X1)H(X2|X1)H(XL|XL1X1)

L

H(Xl |Xl1)H(XL)

l

• 平均每个符号的熵为:

HL(X)L1H(XL)

• 若当信源退化为无记忆时: 若进一步又满足平稳性时

发出符号序列的马尔可夫信源

• 发出单个符号的信源

– 指信源每次只发出一个符号代表一个消息;

• 发出符号序列的信源

– 指信源每次发出一组含二个以上符号的符号 序列代表一个消息。 a

13

2.3.1 离散无记忆信源的序列熵

• 发出单个符号的信源

X 1 2 3 4 5 6 P1/61/61/61/61/61/6

• 信源的序列熵

H (X )H (XL)LH (X)

• 平均每个符号(消息)熵为

HL(X)L1H(X)aH(X) 17

例2-10:

有一个无记忆信源随机变量X∈(0,1),等概率分布, 若以单个符号出现为一事件,则此时的信源熵:

H (X)lo22 g1bi/符 t 号

– 即用 1比特就可表示该事件。 • 如果以两个符号出现(L=2的序列)为一事件,则

第二章—5

信源熵

内容

2.1 信源的描述和分类 2.2 单符号离散信源 2.3 多符号离散平稳信源 2.4 连续信源 2.5 冗余度

a 2

回顾——1.信源熵的基本性 质和定理

a 3

熵函数的性质

1. 非负性

H(X)=H(p1,p2,…,pn)≥0 – 式中等号只有在pi =1时成立。

2. 对称性

H(p1,p2,…,pn) = H(p2,p1,…,pn)

信息论与编码理论习题答案

第二章 信息量和熵2.2八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率.解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s2。

3 掷一对无偏骰子,告诉你得到的总的点数为:(a ) 7; (b) 12。

问各得到多少信息量.解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log =2。

585 bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log =5。

17 bit2.4 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a ) )(a p =!521信息量=)(1loga p =!52log =225.58 bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C =13。

208 bit2.9随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6=2.585 bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6 =3。

复习课资料与习题

n

n

n

n

n

n

= ∑ H (Xl )

l =1

L

30

2.3 离散序列信源的熵

z z

离散无记忆信源的序列熵 平均每个符号熵(消息熵)

1 H L ( X) = H ( X) L

7

2.2 离散信源熵与互信息

z

单符号离散信源熵 定义:对于给定离散概率空间表示的信 源所定义的随机变量I的数学期望为信源 的信息熵,单位为比特/符号

i

H ( X ) = E [ I ( x )] = − ∑ p ( x i ) log p ( x i )

8

2.2 离散信源熵与互信息

z

离散信源条件熵 定义:对于给定离散概率空间表示的信源所定 义的随机变量I(x/y)在集合X上的数学期望为 给定y条件下信源的条件熵,单位为比特/序列

离散无记忆序列信源 离散有记忆序列信源 马尔可夫信源 离散无记忆信源的序列熵 离散有记忆信源的序列熵

22

2.3 离散序列信源的熵

z

离散无记忆序列信源 布袋摸球实验,若每次取出两个球,由 两个球的颜色组成的消息就是符号序 列。若先取出一个球,记下颜色放回布 袋,再取另一个球。

p ( X 1 , X 2 ,L , X l ,L X L ) = p ( X 1 ) p ( X 2 ) L p ( X L )

1 I ( x i = a i ) = − log p( x i ) = log p( x i )

以2为底,单位为比特(bit) 以e为底,单位为奈特(nat) 1nat=1.433bit 以10为底,单位为笛特(det) 1det=3.322bit

5

2.2 离散信源熵与互信息

第二章 信源熵-习题答案

· 1 ·2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量?解:设随机变量X 代表女孩子学历X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75设随机变量Y 代表女孩子身高Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11=求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(11111111=⨯-=-=-=2.3 一副充分洗乱了的牌(含52张牌),试问(1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量?解:(1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:!521)(=i x p bit x p x I i i 581.225!52log )(log )(==-=(2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:· 2 ·bit C x p x I C x p i i i 208.134log)(log )(4)(135213135213=-=-==2.4 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-= (2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==2.5 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?解: 男士:sym bolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(2=+-=-==-=-===-=-==∑女士:symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2=+-=-=∑2.6 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) > log6不满足信源熵的极值性。

信源熵例题

物理与信息工程学院 郭里婷

10

2019/2/7

例2:随机变量X表示人的性别,X=0表示男性,X=1表示女性;随即变量Y表 示是否抽烟,Y=0表示抽烟,Y=1表示不抽烟。(X,Y)的联合分布分别如下3 种情况时,求抽到的是男性给抽烟这个事件提供多大的信息量。

物理与信息工程学院 郭里婷

11

2019/2/7

物理与信息工程学院 郭里婷

12

2019/2/7

例3:设信源发出8种消息(符号),各消息等概发送,各符号分别用3位二进 码元表示,并输出消息(事件),设8个消息按自然二进制进行编码,见 p23表2-3。通过对输出码元序列的观察来推测信源的输出。假设信源发出 的消息x4,用二进码011表示, 求依次接收0,01,011后,得到的关于x4 的信息量。

X x1 (红), x2 (白) P 0.8, 0.2

物理与信息工程学院 郭里婷

2

2019/2/7

单符号无记忆连续信源 例2:一节5V的干电池,测电压。电压可以看成单符号无记 忆连续信源。消息数无限多.

物理与信息工程学院 郭里婷

3

2019/2/7

信息论与编码

第二章 信源熵 例题

福州大学物理与信息工程学院 郭里婷

物理与信息工程学院 郭里婷

1

2019/2/7

第二章 第一节例题

单符号无记忆离散信源 例1:一个布袋中有100个球,其中80个红色,20个白色。随 机摸取一个球,看颜色。球的颜色可以看成单符号无记忆离 散信源。消息数量为2,红白消息的概率分别为0.8和0.2。

X x1 x1 , x1 x2 , x2 x1 , x2 x2 P 0.64, 0.16, 0.16, 0.04

第二章 信源熵

英文字母中“e”出现的概率为0.105,“c” 出现的概率为0.023,“o”出现的概率为 0.001,分别计算他们的自信息量。 答:I(e)=-logP(e)=-log0.105=3.25bit I(c)=-logP(c)=-log0.023=5.44bit I(o)=-logP(o)=-log0.001=9.97bit

②

公式:参考数学期望的性质,用各符号的自 信息量加权平均表示总体的不确定性。

H ( X ) E[ I ( X )] p( xi )I ( xi ) p( xi ) log p( xi )

i i

③

单位:比特/符号或比特/符号序列

④

I. II.

性质: 非负 与热力学熵相同形式,H(X)又被定义为信源 熵 两个特殊情况 符号 x i 的概率 pi 为零时,定义为pi log pi 0 当信源X只有一个符号,符号只有一个状态, p(x)=1,此时 H ( X ) 0 。

分析 {Xn,n=0,1,2,……}是一随机过程,其状态 空间为:I={0,1},且当Xn=i,i=0、1时, Xn+1所处的状态分布只与Xn=i有关,而与 时刻n以前所处的状态无关,综上所述。该 过程为一步转移的马尔可夫过程。 p, j i P i, j 0,1 一步转移的概率: P{ X j X i} q, j i 一步转移矩阵: p q

II.

III.

随机过程是随机函数的集合,若一随机系统的样本点数是 随机函数,则称此函数为样本函数。这一随机系统全部样 本函数的集合是一个随机过程。实际应用中,样本函数的 一般定义在时间域或者空间域。用{X(t),t Y }。 具有马尔可夫性的随机过程称为马尔可夫过程。

信息与编码理论习题-2006-1211

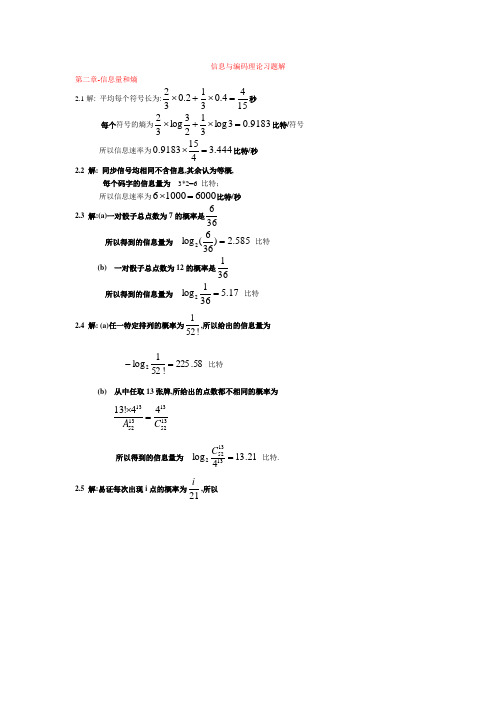

信息与编码理论习题解第二章-信息量和熵 2.1解: 平均每个符号长为:1544.0312.032=⨯+⨯秒每个符号的熵为9183.03log 3123log 32=⨯+⨯比特/符号所以信息速率为444.34159183.0=⨯比特/秒2.2 解: 同步信号均相同不含信息,其余认为等概,每个码字的信息量为 3*2=6 比特; 所以信息速率为600010006=⨯比特/秒2.3 解:(a)一对骰子总点数为7的概率是366所以得到的信息量为 585.2)366(l o g 2= 比特(b) 一对骰子总点数为12的概率是361所以得到的信息量为 17.5361log2= 比特2.4 解: (a)任一特定排列的概率为!521,所以给出的信息量为58.225!521log2=- 比特(b) 从中任取13张牌,所给出的点数都不相同的概率为13521313521344!13C A =⨯所以得到的信息量为 21.134log1313522=C 比特.2.5 解:易证每次出现i 点的概率为21i ,所以比特比特比特比特比特比特比特398.221log21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21log)(2612=-==============-==∑=ii X H x I x I x I x I x I x I i ii x I i2.6 解: 可能有的排列总数为27720!5!4!3!12=没有两棵梧桐树相邻的排列数可如下图求得,Y X Y X Y X Y X Y X Y X Y X Y图中X 表示白杨或白桦,它有⎪⎪⎭⎫ ⎝⎛37种排法,Y 表示梧桐树可以栽种的位置,它有⎪⎪⎭⎫⎝⎛58种排法,所以共有⎪⎪⎭⎫ ⎝⎛58*⎪⎪⎭⎫⎝⎛37=1960种排法保证没有两棵梧桐树相邻,因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为1960log 27720log22-=3.822 比特2.7 解: X=0表示未录取,X=1表示录取; Y=0表示本市,Y=1表示外地;Z=0表示学过英语,Z=1表示未学过英语,由此得比特比特比特比特6017.02log 21412log 2141910log1094310log 10143)11(log )11()1()10(log )10()1()01(log)01()0()00(log)00()0()(8113.04log 4134log43)()(02698.04110435log 104354310469log10469)1()01(log)01()0()00(log)00()0;(104352513/41)522121()0(/)1())11()1,10()10()1,00(()01(104692513/43)104109101()0(/)0())01()0,10()00()0,00(()00()(4512.04185log 854383log83)1()01(log)01()0()00(log)00()0;(8551/4121)0(/)1()10()01(8351/43101)0(/)0()00()00()(,251225131)1(,2513100405451)10()1()00()0()0(,54511)1(,51101432141)10()1()00()0()0(,41)1(,43)0(222222222222222222=⨯+⨯+⨯+⨯======+=====+=====+=======+==+======+========⨯⨯+========+=========⨯⨯+========+=========+======+========⨯=========⨯=========-===⨯+====+======-===⨯+⨯====+=========x y p x y p x p x y p x y p x p x y p x y p x p x y p x y p x p X Y H X H c x p z x p z x p x p z x p z x p z X I z p x p x y p x y z p x y p x y z p z x p z p x p x y p x y z p x y p x y z p z x p b x p y x p y x p x p y x p y x p y X I y p x p x y p y x p y p x p x y p y x p a z p y z p y p y z p y p z p y p x y p x p x y p x p y p x p x p2.8 解:令{}{}R F T Y B A X ,,,,==,则比特得令同理03645.0)()(5.0,02.03.0)2.05.0(log 2.0)()2.05.0(log )2.05.0()2.03.0(log )2.03.0(5.0log 5.03.0log 3.0)5log )1(2.02log )1(5.0log )1(3.05log 2.0log 3.02log 5.0(2.0log 2.0)2.05.0(log )2.05.0()2.03.0(log )2.03.0()()();()(2.0)(,2.05.0)(2.03.0)1(3.05.0)()()()()(5.0max 2'2222223102231022222==∴==+-=---++-+=-+-+-+++-----++-=-===-=+=-⨯+=+==p p I p I p p p p I p p p p p p p p p p p p p p X Y H Y H Y X I p I R P p F P p p p B P B T P A P A T P T P2.9 & 2.12解:令X=X 1,Y=X 1+X 2,Z=X 1+X 2+X 3, H(X 1)=H(X 2)=H(X 3)= 6log 2比特H(X)= H(X 1) = 6log2=2.585比特 H(Y)= H(X 2+X 3)=6log 61)536log365436log364336log363236log36236log 361(2222222+++++= 3.2744比特 H(Z)= H(X 1+X 2+X 3)=)27216log2162725216log2162521216log2162115216log2161510216log216106216log21663216log2163216log 2161(222222222++++++= 3.5993比特 所以H(Z/Y)= H(X 3)= 2.585 比特 H(Z/X) = H(X 2+X 3)= 3.2744比特 H(X/Y)=H(X)-H(Y)+H(Y/X)= 2.585-3.2744+2.585 =1.8955比特H(Z/XY)=H(Z/Y)= 2.585比特 H(XZ/Y)=H(X/Y)+H(Z/XY) =1.8955+2.585 =4.4805比特 I(Y ;Z)=H(Z)-H(Z/Y) =H(Z)- H(X 3)= 3.5993-2.585 =1.0143比特 I(X;Z)=H(Z)-H(Z/X)=3.5993- 3.2744 =0.3249比特 I(XY ;Z)=H(Z)-H(Z/XY) =H(Z)-H(Z/Y) =1.0143比特 I(Y ;Z/X)=H(Z/X)-H(Z/XY) = H(X 2+X 3)-H(X 3) =3.2744-2.585 =0.6894比特 I(X;Z/Y)=H(Z/Y)-H(Z/XY) =H(Z/Y)-H(Z/Y) =02.10 解:设系统输出10个数字X 等概,接收数字为Y ,显然101)(101)()()(919===∑∑==i j p i j p i Q j w i iH(Y)=log10比特奇奇奇奇偶18log 81101452log 211015)(log )()()(log )()(0)(log ),()(log ),()(22,2222=⨯⨯⨯⨯+⨯⨯⨯=--=--=∑∑∑∑∑∑∑≠====x y p x y p x p x x p x x p x p x y p y x p x y p y x p X Y H x y x i yx yx所以I(X;Y)= 3219.2110log 2=-比特2.11 解:(a )接收前一个数字为0的概率218)0()()0(==∑=ii iu p u q wbits p pw u p u I )1(log 11log)0()0(log)0;(2212121-+=-==(b )同理 418)00()()00(==∑=ii iu p u q wbits p p w u p u I )1(log 22)1(log)00()00(log)00;(24122121-+=-==(c )同理 818)000()()000(==∑=ii iu p u q wbits p p w u p u I )1(log 33)1(log)000()000(log)000;(28132121-+=-==(d )同理 ))1(6)1(()0000()()0000(4226818p p p p u p u q w i i i+-+-==∑=bitspp p p p p p p p p w u p u I 42264242268142121)1(6)1()1(8log ))1(6)1(()1(log)0000()0000(log)0000;(+-+--=+-+--==2.12 解:见2.9 2.13 解: (b))/()/()/(1log)()/(1log)()/()/(1log )()/(1log )()/(XY Z H X Y H xy z p xyz p x y p xyz p xy z p x y p xyz p x yz p xyz p X YZ H xyzxyzxyzxyz+=+===∑∑∑∑∑∑∑∑∑∑∑∑(c))/()/(1log)/()()/(1log)/()()/(X Z H x z p xy z p xy p xy z p xy z p xy p XY Z H xyzxyz=≤=∑∑∑∑∑∑(由第二基本不等式)或)1)/()/((log )/()()/()/(log)/()()/(1log)/()()/(1log)/()()/()/(=-⨯≤=-=-∑∑∑∑∑∑∑∑∑∑∑∑xy z p x z p e xy z p xy p xy z p x z p xy z p xy p x z p xy z p xy p xy z p xy z p xy p X Z H XY Z H xyzxyzxy zxyz(由第一基本不等式)所以)/()/(X Z H XY Z H ≤(a))/()/()/()/()/(X YZ H XY Z H X Y H X Z H X Y H =+≥+等号成立的条件为)/()/(x z p xy z p =,对所有Z z Y y X x ∈∈∈,,,即在给定X 条件下Y 与Z 相互独立。

信源熵的计算与理解习题3及详细解答

习题3-1(情况二:认为事件“0/0”“1/1”不会出现;)

解:设X={S1=“0”, S2=“1”}, (1) Y={ t1=“0” , t2=“1”};

H ( X ) H (Y ) [0.8 log2 0.8 0.2 log2 0.2] 0.72bit / 符号

序列熵: 而 即:

p(1) [a(1) d (1)] max [a(1) d min] max

由于 t (1) [a(1) d min],

(6 8) (6 8)

且d (1) a(1) t (1)为确定值

H ( X Y ) H ( X ) H (Y / X )

n 2 m2 i 1 j 1 n 2 m2 i 1 j 1

H (Y / X ) rij log2 (rij / p(s i )) rij log2 Pij

即:

[r11log2 P 11 r12 log2 P 21 r 21log2 P 12 r 22 log2 P 22 ]

n 2 m2 i 1 j 1 n 2 m2 i 1 j 1

H (Y / X ) rij log2 (rij / p(s i )) rij log2 Pij

即:

[r11log2 P 11 r12 log2 P 21 r 21log2 P 12 r 22 log2 P 22 ]

信源熵的计算与理解习题3及详细解答

公式:

习题3-1(?)

解:设X={S1=“0”, S2=“1”}, Y={ t1=“0” , t2=“1”};

(1)

H ( X ) H (Y ) [0.8 log2 0.8 0.2 log2 0.2] 0.72bit / 符号

第二章习题解答

第 二 章 基 本 信 息 论

习题解答

2.3 试求: 试求: (1) 在一付标准扑克牌中抽出一张牌的平均信息量; 在一付标准扑克牌中抽出一张牌的平均信息量; (2) 若扑克仅按它的等级鉴定而不问花色,重复上述计算。 若扑克仅按它的等级鉴定而不问花色,重复上述计算。 解 (1) 每张牌不同,共有 54 种状态且等概, p = 1 / 54, 每张牌不同, 种状态且等概, 平均信息量为: 平均信息量为: I = log 54 = 5.7549 ( bit ); (2) 只按等级,共有 14 种状态,其状态空间为: 只按等级, 种状态,其状态空间为: X p(x) A 2 3 …… J Q K 王 2 54 4 4 4 4 4 4 …… 54 54 54 54 54 54

首先求联合概率: 首先求联合概率: p ( i j ) = p( i ) p( j / i ) p( i j ) A B C A 0 16 / 54 2 / 54 j B 36 / 135 16 / 54 4 / 135 C 9 / 135 0 2 / 270 7

i

第 二 章 基 本 信 息 论

习题解答

所提供的信息量分别为: 消息 xB和 xC 所提供的信息量分别为:

I ( x B ) = − log p( x B ) = − log 0.2 = 2.3219 (bit ); I ( xC ) = − log p( xC ) = − log 0.3 = 1.737 (bit ).

可见, 消息x 所提供的信息量大一些 大一些。 可见,消息 xB比消息 C 所提供的信息量大一些。 3

i

1 1 4 4 2 2 H ( x / y3 ) = − log − log − log = 1.3788 ; 7 7 7 7 7 7 H ( x / y4 ) = −(1 / 3) log(1 / 3) − ( 2 / 3) log( 2 / 3) = 0.9138 .

信息论与编码第二章答案解析

2-1、一阶马尔可夫链信源有3个符号{}123,,u u u ,转移概率为:1112()u p u=,2112()u p u =,31()0u p u =,1213()u p u = ,22()0u p u =,3223()u p u =,1313()u p u =,2323()u p u =,33()0u p u =。

画出状态图并求出各符号稳态概率。

解:由题可得状态概率矩阵为:1/21/20[(|)]1/302/31/32/30j i p s s ⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦状态转换图为:令各状态的稳态分布概率为1W ,2W ,3W ,则: 1W =121W +132W +133W , 2W =121W +233W , 3W =232W 且:1W +2W +3W =1 ∴稳态分布概率为:1W =25,2W =925,3W = 6252-2.由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:P(0|00)=0.8,P(0|11)=0.2,P(1|00)=0.2,P(1|11)=0.8,P(0|01)=0.5,p(0|10)=0.5,p(1|01)=0.5,p(1|10)=0.5画出状态图,并计算各符号稳态概率。

解:状态转移概率矩阵为:令各状态的稳态分布概率为1w 、2w 、3w 、4w ,利用(2-1-17)可得方程组。

0.8 0.2 0 00 0 0.5 0.5()0.5 0.5 0 00 0 0.2 0.8j i p s s ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦1111221331441132112222332442133113223333443244114224334444240.80.50.20.50.50.20.50.8w w p w p w p w p w w w w p w p w p w p w w w w p w p w p w p w w w w p w p w p w p w w =+++=+⎧⎪=+++=+⎪⎨=+++=+⎪⎪=+++=+⎩ 且12341w w w w +++=;解方程组得:12345141717514w w w w ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩ 即:5(00)141(01)71(10)75(11)14p p p p ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2-3、同时掷两个正常的骰子,也就是各面呈现的概率都是16,求:(1)、“3和5同时出现”事件的自信息量; (2)、“两个1同时出现”事件的自信息量; (3)、两个点数的各种组合的熵或平均信息量; (4)、两个点数之和的熵;(5)、两个点数中至少有一个是1的自信息量。

1-4 信源熵-习题答案

600

1030 3408 2520

382

489 1808 859

3.137

3.1595 3.1415929 3.1795

利用蒙特卡罗(Monte Carlo)法进行计算机模拟. 取a 1, b 0.85. 单击图形播放/暂停 ESC键退出

二

概率的公理化定义

概率 P 是在事件域 上有定义的集合函数,它

§1.4

一

概率的公理化定义及概率的性质

几何概率 古典概型中试验结果是有限的,但许多问题试验

结果是无限的,一般的情况是不易解决的,下面考虑 所谓的“等可能性”问题. 在一个面积为 S 的区域 中,等可能地投点.这 里“等可能”的确切意义是:设在区域 中有任意一个 小区域 A ,如果它的面积为 S A,则点落入 A 中的可 能性大小与 S A成正比,而与 A 的位置和形状无关。

所以 1 P ( S ) P ( A A) P ( A) P ( A) . P ( A) 1 P ( A).

(6) ( 加法公式) 对于任意两事件 A, B 有 P ( A B ) P ( A) P ( B ) P ( AB ).

证明 由图可得

A B A ( B AB),

通常,在

代数 上有定义的非负、可列可加的

上

集函数称作是 上的测度.概率不过是事件域

的一个规范化的测度.

一般地描述一个随机试验的数学模型,应该有 三件东西: (1) 样本空间 (2) 事件域 (3) 概率(上的规范测度) P 三者写成 ( , , P) 并称它是一个概率空间.

会面问题

例7 甲、乙两人相约在 0 到 T 这段时间内, 在预 定地点会面. 先到的人等候另一个人, 经过时间 t ( t<T ) 后离去.设每人在0 到T 这段时间内各时刻

第二章 信源熵练习题

6、已知离散随机变量 X 和 Y,及相应的熵 H(X)、H(Y)、H(XY)、 H(X/Y)、H(Y/X)则,X 和 Y 之间的平均互信息 I(X;Y)=( )

A、 H(XY)-H(Y); B、 H(XY)-H(X); C、 H(X)-H(X/Y); D、 H(X)-H(Y/X)

7、已知离散随机变量 X 和 Y,及相应的熵 H(X)、H(Y)、H(XY)、 H(X/Y)、H(Y/X)则,X 和 Y 之间的平均互信息 I(X;Y)=( )

期望(或者概率统计/加权平均) ,在数学上表达为

H XY p( xi y j )I ( xi y j ) p( xi y j ) log p( xi y j ) 。

i 1 j 1 i 1 j 1

n

m

n

m

7. 条件熵是联合离散符号集合 XY 上,条件自信息量的的数学期望(或者概 率统计/加权平均) ,在数学上表达为

是互信息在对应联合概率空间上的数学期望(概率统计平均/概率加权平 均) ,也具有对称性 I (X; Y) I (Y; X) ,有三种表达形式:1)

I ( X; Y) H X H X / Y ;2) I (Y; X) H Y H Y / X ;3) I ( X; Y) H X H Y H XY 。

H X Y p ( xi y j )I ( xi y j ) p ( xi y j ) log p ( xi y j )

i 1 j 1 i 1 j 1

n

m

n

mቤተ መጻሕፍቲ ባይዱ

8. 平均符号熵是离散平稳信源输出 N 长的信源符号序列中平均每个信源符号 所携带的信息量称为平均符号熵,记为 H N X ,数学上表达为

《信息论、编码与密码学》课后习题答案

《信息论、编码与密码学》课后习题答案第1章信源编码1.1 考虑一个信源概率为{0.30 , 0.25 , 0.20 , 0.15 , 0.10}的DMS求信源嫡H (X)。

5解:信源嫡H(X) = -£P k log 2( P k)H(X)=-[0.30*(-1.737)+0.25*(-2)+0.2*(-2.322)+0.15*(-2.737)+0.1*(-3.322)]=[0.521+0.5+0.464+0.411+0.332]=2.228(bit)故得其信源嫡H(X)为2.228bit1.2 证明一个离散信源在它的输出符号等概率的情况下其嫡达到最大值。

解:若二元离散信源的统计特性为P+Q=1 H(X)=-[P*log(P)+(1-P)*log(1-P)]对H(X)求导求极值,由dH(X)/d(P)=0可得log可知当概率P=Q=1/2时,有信源嫡H (X)max = 1(bit)对丁三元离散信源,当概率R = P2 = P3 = 1/3时,信源嫡H (X )m a=x1 .5 8 (5bit ),此结论可以推广到N元的离散信源。

1.3证明不等式lnx^x—1。

画出曲线y〔=lnx和y2 = x — 1的平■面图以表明上述不等式的正确性。

证明:f (x) = ln x 「x 1(x - 0) f(x)=【x令f(x),=0, x =1 又有x 0. 0 :. x < 1 时f(x) 0 此时 f(x) fx =0 也即 In x _x -1当x _1时同理可得此时Inx _x -1综上可得lnx 笑x -1证毕 绘制图形说明如下 可以很明确说明上述 不等式的正确性。

1.4证明I(X;Y)芝0。

在什么条件下等号成立?n mI(X ; V =' ' P(x,y j )i(x, y j )i 目j 目n m =' P(x,y j )logi 注j T 当和相互独立时等号成立。

信源熵-习题答案

C

1 m1

C

2 m

2

+…+

C n1 m n 1

C n1 mn

P(A3)=

!! (

)!

[C

0 2

1

…

C 1

2

]

评注:

=

!! (

)!

C

1

1

=

如果把题中的“白球”、“黑球”换为“正品”、 “次品”或“甲物”、“乙物”等等,我们就可以得到各 种各样的“摸球模型”.

二. 古典概型的基本模型:分球入盒模型

排列.所以样本点总数为107.

(1)事件A1,要求所取的7个数是互不相同的,考虑到各 个数取出时有先后顺序之分,所以有利场合相当于从10个 相异元素里每次取出7个相异元素的排列.因此,A1所包含 的样本点数为 A170,于是

.

P(A1)=

A170 10 7

0.06048

(2)A2:不含10与1;

(1)杯子容量无限

问题1 把 4 个球放到 3个杯子中去,求第1、2个 杯子中各有两个球的概率, 其中假设每个杯子可 放任意多个球.

3

3

3

3

4个球放到3个杯子的所有放法 3 3 3 3 34种,

4种 2

2种 2

2个

2个

因此第1、2个杯子中各有两个球的概率为

p 4 2 34 2 .

个样本点,.这样

评注:

P(C)=

Cnm (N 1)nm Nn

Cnm

(

1 N

)m

(1

.

1 N

) nm

不难发现当n和N确定时P(C)只依赖于m.如果把 P(C)记作Pm,依二项式定理有

第2章 信源熵

最大熵值随平均功率 P的变化而变化。

2

1 1 1 log 2 2 log e log 2e 2 2 2 2

11

均值受限条件下的最大熵定理

定理3:若连续信源X输出非负信号的均值受限,则其 输出信号幅度呈指数分布时,连续信源X具有最大熵值。

证明:连续信源 X呈指数分布时的概率密 度函数为 1 m p( x ) e ( x 0 ),其它任意分布的概率密 度函数记为q( x ) m 由限制条件知:

... q( x) log

aN a1 N

bN

b1

p ( x) dx ... dx log e ... q ( x ) 1 dx1...dxN 1 N N aN a1 q ( x ) (bi ai ) 1

bN b1 i 1

log (bi ai ) (1 1) log e H c [ p ( x), X ]

R2 R2 R2

p( x ) dxdy p( x / y )

log x log e ln x, ln x x 1, x 0; p( x ) 0, p( x / y ) 0, 则x p( x ) I c ( X ;Y ) log e p( xy ) 1dxdy p( x / y ) R2 log e[ p( x ) p( y )dxdy p( xy )dxdy] 0

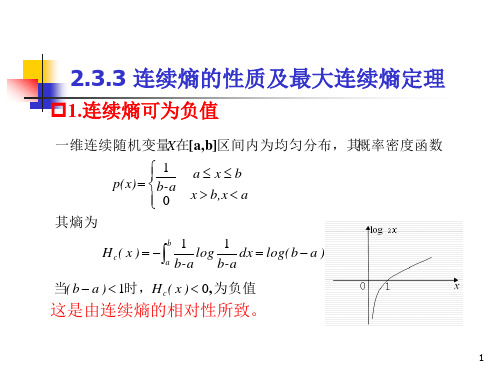

当( b a ) 1时,H c ( x ) 0, 为负值

这是由连续熵的相对性所致。

1

2.3.3 连续熵的性质及最大连续熵定理

2.可加性

H c ( XY ) H c ( X ) H c ( Y / X ) Hc( Y ) Hc( X / Y ) 证明: H c ( XY ) p( xy) log p( xy)dxdy

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

· 1 ·2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量?解:设随机变量X 代表女孩子学历X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75设随机变量Y 代表女孩子身高Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=⎪⎭⎫⎝⎛⨯-=⎥⎦⎤⎢⎣⎡-=-=2.3 一副充分洗乱了的牌(含52张牌),试问(1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量?解:(1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:bit x p x I i i 581.225!52log )(log )(2==-=(2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:bit C x p x I C x p i i i 208.134log )(log )(4)(13521322135213=-=-==· 2 ·2.4 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log 2=-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==2.5 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?解: 男士:symbolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(22222222=+-=-==-=-===-=-==∑女士:symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2222=+-=-=∑2.6 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) > log6不满足信源熵的极值性。

解:585.26log )(/ 657.2)17.0log 17.016.0log 16.017.0log 17.018.0log 18.019.0log 19.02.0log 2.0()(log )()(222222262=>=+++++-=-=∑X H symbol bit x p x p X H ii i 不满足极值性的原因是107.1)(6>=∑iix p 。

· 3 ·2.7 证明:H(X 3/X 1X 2) ≤ H(X 3/X 1),并说明当X 1, X 2, X 3是马氏链时等式成立。

证明:log 1)/()(log )()/()(log 1)/()/()()/()/(log)()/(log )()/(log )()/(log )()/(log )()/()/(2123132121233211231321123221313321123213133211231332112321332113133112321332113213=⎪⎪⎭⎫⎝⎛-⎥⎦⎤⎢⎣⎡=⎪⎭⎫⎝⎛-=⎪⎪⎭⎫ ⎝⎛-≤=+-=+-=-∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑e x x p x x p ex x x p x x p x x p e x x x p x x p x x x p x x x p x x p x x x p x x p x x x p x x x p x x x p x x p x x p x x x p x x x p X X H X X X H i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i氏链是马等式成立的条件是时等式成立当_,,)/()/()/()()/()/()()()/()/()()/()/(01)/()/()/()/(321132131232113121212131321213132131313213X X X x x x p x x p x x p x x x p x x p x x p x p x x p x x x p x x p x x p x x x p x x p x x x p x x p X X H X X X H i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i ∴=⇒=⇒=⇒=⇒=-≤∴2.8证明:H(X 1X 2 。

X n ) ≤ H(X 1) + H(X 2) + … + H(X n )。

证明:)(...)()()()...().../()(0)...;(...)/()(0);()/()(0);().../(...)/()/()()...(3212112112121332131221212121312121N N N N N N N N N N X H X H X H X H X X X H X X X X H X H X X X X I X X X H X H X X X I X X H X H X X I X X X X H X X X H X X H X H X X X H ++++≤∴≥⇒≥≥⇒≥≥⇒≥++++=---2.9 设有一个信源,它产生0,1序列的信息。

它在任意时间而且不论以前发生过什么符号,均按P(0) = 0.4,P(1) = 0.6的概率发出符号。

(1) 试问这个信源是否是平稳的? (2) 试计算H(X 2), H(X 3/X 1X 2)及H ∞;(3) 试计算H(X 4)并写出X 4信源中可能有的所有符号。

解: (1)这个信源是平稳无记忆信源。

因为有这些词语:“它在任意时间....而且不论以前发生过什么符号...........……”· 4 ·(2)symbolbit X H H symbol bit x p x p X H X X X H symbolbit X H X H ii i / 971.0)(/ 971.0)6.0log 6.04.0log 4.0()(log )()()/(/ 942.1)6.0log 6.04.0log 4.0(2)(2)(2223213222===+-=-===+⨯-==∞∑(3)1011111111101101110010101001100001110110010101000011001000010000的所有符号:/ 884.3)6.0log 6.04.0log 4.0(4)(4)(4224X symbol bit X H X H =+⨯-==2.10 一阶马尔可夫信源的状态图如下图所示。

信源X 的符号集为{0, 1, 2}。

(1) 求平稳后信源的概率分布; (2) 求信源的熵H ∞。

PP解: (1)⎪⎩⎪⎨⎧===⎩⎨⎧=++==⎪⎪⎩⎪⎪⎨⎧⋅+⋅=⋅+⋅=⋅+⋅=⎪⎩⎪⎨⎧+=+=+=3/1)(3/1)(3/1)(1)()()()()()()()()()()()()()()()/()()/()()()/()()/()()()/()()/()()(321321321133322211131333332322222121111e p e p e p e p e p e p e p e p e p e p p e p p e p e p p e p p e p e p p e p p e p e e p e p e e p e p e p e e p e p e e p e p e p e e p e p e e p e p e p· 5 ·⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡⎪⎪⎩⎪⎪⎨⎧=+=⋅+⋅=+==+=⋅+⋅=+==+=⋅+⋅=+=3/123/113/10)(3/13/)()()()/()()/()()(3/13/)()()()/()()/()()(3/13/)()()()/()()/()()(131313333323232222212121111X P X p p e p p e p p e x p e p e x p e p x p p p e p p e p p e x p e p e x p e p x p p p e p p e p p e x p e p e x p e p x p (2)()symbolbit p p p p p p p p p p p p p p p p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e p H iji j i j i / log log log 31log 31log 31log 31log 31log 31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/()(2222222233233322323123123223222222122113213122121121133⋅+⋅-=⎥⎦⎤⎢⎣⎡⋅⋅+⋅⋅+⋅⋅+⋅⋅+⋅+⋅⋅-=⎥⎦⎤++++++⎢⎣⎡++-=-=∑∑∞2.11黑白气象传真图的消息只有黑色和白色两种,即信源X ={黑,白}。