RethinkDB & TokuDB调研测试报告

金融支付清算系统术语大全(中英文对照)

⾦融⽀付清算系统术语⼤全(中英⽂对照)资料介绍:这⾥的词汇是在最合适的⼀致性基础上对本书中涉及到的 ( ⼗国集团和欧共体 ) 中央银⾏所使⽤的术语给出解。

它不打算对这些术语给出法律定义。

应该认识到,它在其他语⾔中未必能找到完全等同的术语。

咨询轧差( advisory netting) :见状态轧差。

受保⽀付系统 (assured payment system)(aps) :⼀种价值交换系统中的协议其中,及时完成⼀笔⽀付指令的结算,需要第三⽅ ( 主要是银⾏、银⾏⾟迪加或者清算所 ) 不可撤销的和⽆条件的承诺⽀持。

参见价值交换结算系统。

⾃动化清算所 (automated clearing house)(ach) :⼀种电⼦清算系统,在系统中⽀付指令,主要借助磁介质或者通过电信⽹络在⾦融机构之间进⾏交换并由数据处理中⼼处理。

参见清算。

⾃动柜员机 (automated teller machine)(ATM) :⼀种可以让已授权的⽤户,主要利⽤机器可读的塑料卡,从其帐户提取现⾦并可向⽤户提供不同种类的其他服务诸如余额查询、资⾦转帐和接收存款的机电设备。

ATM 可以以联机实时查询授权数据库或者脱机两种⽅式运⾏。

银⾏汇票 (bank draft) :在欧洲,该术语通常指⼀种由银⾏⾃⾝兑付的票据。

银⾏汇票由付⽅在银⾏购买并发送给收⽅,收⽅提交银⾏汇票给收⽅的开户银⾏,收⽅的开户银⾏对收⽅⽀付。

收⽅的开户银⾏再提交银⾏汇票给付⽅银⾏并由付⽅银⾏偿付。

在美国,该术语通常指由银⾏⾃⾝或者从其他银⾏兑付的汇票或者⽀票。

在银⾏本票中,银⾏既是出票⼈⼜是受票⼈。

在银⾏柜员⽀票中,⼀家银⾏是出票⼈,另⼀家银⾏是受票⼈。

银⾏汇票可能由银⾏按其⾃⼰的⽬的签发或者由客户购买并发送给收款⼈以清偿债。

批处理 (batch) :⼀组⽀付指令和 ( 或 ) 证券转让指令以⼀个集合在处理点以不连续的时间间隔发送或处理。

受益所有权/权益 (beneficial ownership/interest) :接收证券或其他⾦融票据的部分或全部所有权权益的权利 ( 如收⼊、选举、转帐权 ) 。

数据库分类,各种数据库的优势和使用场景

数据库分类,各种数据库的优势和使用场景数据库是计算机系统中用于存储和管理数据的一种技术。

根据不同的标准和特征,数据库可以分为多种分类。

本文将介绍常见的数据库分类,并探讨各种数据库的优势和使用场景。

1.关系型数据库(RDBMS)关系型数据库使用关系模型来组织和管理数据,数据存储在表中,表之间通过键值链接。

常见的关系型数据库有MySQL、Oracle和Microsoft SQL Server等。

关系型数据库的优势包括:-结构化数据存储:数据以表格的形式存储,有明确的结构和关系,容易理解和查询。

-支持SQL查询:通过SQL语言可以方便地查询和操作数据。

-支持事务处理:可以保持数据的一致性和完整性。

关系型数据库适用于需要对结构化数据进行复杂查询和事务处理的应用场景,例如金融系统、电子商务平台等。

2.非关系型数据库(NoSQL)非关系型数据库以键值对的形式存储数据,不使用结构化表格,是近年来数据库领域的新兴技术。

非关系型数据库的优势包括:-可扩展性:非关系型数据库可以水平扩展,适应大规模数据存储和高并发访问的需求。

-高性能:非关系型数据库使用数据分片和分布式架构,提供了更高的性能和储存效率。

-灵活的数据模型:非关系型数据库可以处理半结构化和非结构化数据,支持更灵活的数据模型。

非关系型数据库适用于需要大规模数据存储和高性能读写的场景,例如社交网络、物联网应用等。

常见的非关系型数据库有MongoDB、Cassandra和Redis等。

3.内存数据库(In-Memory Database)内存数据库是将数据存储在内存中的数据库系统,相比传统的硬盘存储数据库,具有更高的读写性能。

内存数据库的优势包括:-高速读写:内存数据库直接在内存中读写数据,不需要磁盘IO操作,具有更高的读写性能。

-实时性要求高:内存数据库适用于对数据实时性要求很高的应用场景,如实时分析、实时交易等。

-数据量有限:内存数据库的存储容量受限于内存大小,适合存储较小的数据集。

《大数据导论》复习资料

《大数据导论》课程期末复习资料《大数据导论》课程讲稿章节目录:第1章大数据概述(1)大数据的概念(2)大数据的特征(3)大数据的数据类型(4)大数据的技术(5)大数据的应用第2章大数据采集与预处理(1)大数据采集(2)大数据预处理概述(3)数据清洗(4)数据集成(5)数据变换(6)数据规约第3章大数据存储(1)大数据存储概述(2)数据存储介质(3)存储系统结构(4)云存储概述(5)云存储技术(6)新型数据存储系统(7)数据仓库第4章大数据计算平台(1)云计算概述(2)云计算平台(3)MapReduce平台(4)Hadoop平台(5)Spark平台第5章大数据分析与挖掘(1)大数据分析概述(2)大数据分析的类型及架构(3)大数据挖掘(4)大数据关联分析(5)大数据分类(6)大数据聚类(7)大数据分析工具第6章大数据可视化(1)大数据可视化概述(2)大数据可视化方法(3)大数据可视化工具第7章社交大数据(1)社交大数据(2)国内社交网络大数据的应用(3)国外社交网络大数据的应用第8章交通大数据(1)交通大数据概述(2)交通监测应用(3)预测人类移动行为应用第9章医疗大数据(1)医疗大数据简介(2)临床决策分析应用(3)医疗数据系统分析第10章大数据的挑战与发展趋势(1)大数据发展面临的挑战(2)大数据的发展趋势一、客观部分:(单项选择、多项选择)(一)、单项选择1.以下不是NoSQL数据库的是()A.MongoDBB.HBaseC.CassandraD.DB2★考核知识点:NoSQL与NewSQL主流系统参考讲稿章节:3.7附1.1.1(考核知识点解释):目前市场上主要的NoSQL数据存储工具有:BigTable、Dynamo 、Hbase、MongoDB、CouchDB、Hypertable还存在一些其他的开源的NoSQL数据库,Neo4j、Oracle Berkeley DB、Apache Cassandra等另外,NewSQL数据库。

rethinkdb 查询语句

rethinkdb 查询语句RethinkDB是一个开源的分布式数据库管理系统,它使用JSON格式来存储数据,并提供了类似于SQL的ReQL查询语言来操作数据。

以下是一些常见的RethinkDB查询语句示例:1. 插入数据:javascript.r.db('mydb').table('mytable').insert({。

id: 1,。

name: 'John Doe',。

age: 30。

})。

2. 查询数据:javascript.r.db('mydb').table('mytable').filter({ age: 30 })。

3. 更新数据:javascript.r.db('mydb').table('mytable').get(1).update({ age: 31 })。

4. 删除数据:javascript.r.db('mydb').table('mytable').get(1).delete()。

5. 聚合查询:javascript.r.db('mydb').table('mytable').group('age').count()。

6. 连接操作:javascript.r.db('mydb').table('table1').innerJoin(r.db('mydb').table(' table2'), function(row1, row2) {。

return row1('id').eq(row2('id'))。

}).zip()。

以上是一些基本的RethinkDB查询语句示例,它们涵盖了插入、查询、更新、删除、聚合和连接操作。

即时聊天解决方案

即时聊天解决方案即时聊天解决方案概述即时聊天已成为现代社交交流中不可或缺的一部分。

随着移动互联网的普及和技术的不断发展,用户对于更便捷、实时的聊天方式的需求不断增加。

在这个趋势下,即时聊天解决方案成为了商业和社交平台追求的重要目标。

本文将介绍即时聊天解决方案的基本原理、应用场景以及常见的技术实现方案,帮助开发人员了解如何构建高效可靠的即时聊天系统。

基本原理即时聊天解决方案的基本原理是建立一个实时的通讯管道,使得用户之间可以实时传递消息。

这个通讯管道通常基于网络协议,如TCP/IP、WebSocket等。

当用户发送消息时,消息将通过通讯管道发送给对方,对方收到消息后进行处理并作出相应的响应。

为了实现即时聊天,需要考虑以下几个关键因素:1. 实时性:即时聊天要求消息的传递和处理是实时的,不能有明显的延迟。

2. 可扩展性:即时聊天系统需要支持大量的用户同时在线,能够有效地处理高并发的消息传递。

3. 可靠性:即时聊天系统需要保证消息的可靠性,避免丢失或错乱的情况发生。

4. 安全性:即时聊天系统需要保证消息的机密性和完整性,防止信息泄露和篡改。

应用场景即时聊天解决方案广泛应用在各种场景中,包括但不限于:1. 社交应用:社交平台中的私信功能需要实时的聊天能力,用户可以随时与好友进行交流。

2. 在线客服:在线客服系统需要提供实时的聊天功能,客服人员能够及时回复用户的咨询和问题。

3. 多人协作:团队协作平台需要实时的聊天功能,成员之间可以方便地进行交流和讨论。

4. 游戏应用:多人在线游戏需要支持实时的聊天,玩家可以进行游戏内的交流和组队操作。

5. 电商平台:电商平台中的买家和卖家需要实时的聊天功能,方便交流商品的细节和交易的进展。

技术实现方案在实现即时聊天解决方案时,开发人员可以选择不同的技术方案来满足需求。

前端技术前端技术是实现即时聊天的关键。

以下是常见的前端技术方案:1. WebSocket:WebSocket是一种支持双向通信的协议,可以在网页和服务器之间建立实时的连接。

使用犀牛心得(精选4篇)

使用犀牛心得(精选4篇)使用犀牛心得篇1使用犀牛进行建模和设计可以是一个非常具有挑战性和创造性的过程。

以下是一些使用犀牛的心得:1.熟悉工具:犀牛是一款功能强大的建模软件,有很多工具和功能,因此需要熟悉这些工具和功能的使用方法。

在熟悉工具的过程中,可能需要花费一些时间,但是这是成功的关键。

2.创建基础模型:在创建复杂模型之前,建议先创建一些基础模型,例如立方体、球体等。

这些模型可以为你提供良好的基础,以便于你更好地理解和使用更复杂的工具和功能。

3.学习和应用建模技术:使用犀牛建模需要一些技术和方法。

因此,学习和应用这些技术和方法是非常重要的。

例如,你可以学习如何使用曲面建模、NURBS 建模、网格建模等技术。

4.调整细节:在建模过程中,你需要不断地调整细节,以使模型更加逼真和准确。

例如,你可以调整模型的纹理、颜色、光照等。

5.优化性能:使用犀牛进行建模需要大量的计算资源,因此优化性能是非常重要的。

例如,你可以优化模型的纹理和光照,以便于更快的渲染速度。

6.学习和分享:学习和分享是使用犀牛建模的重要方面。

你可以学习其他人的作品,并与他们分享你的作品和经验。

这样可以让你更好地提高自己的技能和水平。

希望这些心得能够帮助你更好地使用犀牛进行建模和设计。

使用犀牛心得篇2标题:使用犀牛:一种深入理解和探索的体验自从我接触计算机科学以来,我一直对人工智能和机器学习充满好奇。

我曾尝试使用各种机器学习框架,包括TensorFlow和Keras,但我对RethinkDB的喜爱尤为突出。

RethinkDB是一个高性能的键值存储,它提供了原生的分布式功能,使得构建可扩展的应用程序变得容易。

在我接触RethinkDB之后,我开始探索其强大的功能和易用性。

通过RethinkDB,我能够构建复杂的查询语言,将数据存储与计算逻辑融合,并且轻松地构建分布式系统。

这一切都让我对未来充满了期待。

使用犀牛的体验是充满挑战和收获的。

在我刚开始接触RethinkDB时,我遇到了很多问题。

八种用Python实现定时执行任务的方案,一定有你用得到的!

⼋种⽤Python实现定时执⾏任务的⽅案,⼀定有你⽤得到的!我们在⽇常⼯作中,常常会⽤到需要周期性执⾏的任务。

⼀种⽅式是采⽤ Linux 系统⾃带的 crond 结合命令⾏实现;⼀种⽅式是直接使⽤Python;于是我把常见的Python定时任务实现⽅法整理了⼀下,希望对⼤家有所帮助。

利⽤while True: + sleep()实现定时任务使⽤Timeloop库运⾏定时任务利⽤threading.Timer实现定时任务利⽤内置模块sched实现定时任务利⽤调度模块schedule实现定时任务利⽤任务框架APScheduler实现定时任务Job 作业Trigger 触发器Executor 执⾏器Jobstore 作业存储Event 事件调度器APScheduler中的重要概念Scheduler的⼯作流程使⽤分布式消息系统Celery实现定时任务使⽤数据流⼯具Apache Airflow实现定时任务Airflow 产⽣的背景Airflow 核⼼概念Airflow 的架构很多⼩伙伴在学习Python的过程中因为没⼈解答指导,或者没有好的学习资料导致⾃⼰学习坚持不下去,从⼊门到放弃,所以⼩编特地创了⼀个群,给⼤家准备了⼀份学习资料送给⼤家,有啥问题都可以在群⾥问,互相交流~ 包括但不限于: Python 环境、pycharm编辑器/永久激活/翻译插件 python 零基础视频教程 Python 界⾯开发实战教程 Python 爬⾍实战教程 Python 数据分析实战教程 python 游戏开发实战教程Python 电⼦书100本 Python 学习路线规划都可以在群⾥免费领取 Python 相关问题可解答 Python 相关外包需求可发布 Python 相关招聘需求可发布⼀、利⽤while True: + sleep()实现定时任务位于 time 模块中的 sleep(secs) 函数,可以实现令当前执⾏的线程暂停 secs 秒后再继续执⾏。

《大数据导论》复习资料教学内容

《大数据导论》课程期末复习资料《大数据导论》课程讲稿章节目录:第1章大数据概述(1)大数据的概念(2)大数据的特征(3)大数据的数据类型(4)大数据的技术(5)大数据的应用第2章大数据采集与预处理(1)大数据采集(2)大数据预处理概述(3)数据清洗(4)数据集成(5)数据变换(6)数据规约第3章大数据存储(1)大数据存储概述(2)数据存储介质(3)存储系统结构(4)云存储概述(5)云存储技术(6)新型数据存储系统(7)数据仓库第4章大数据计算平台(1)云计算概述(2)云计算平台(3)MapReduce平台(4)Hadoop平台(5)Spark平台第5章大数据分析与挖掘(1)大数据分析概述(2)大数据分析的类型及架构(3)大数据挖掘(4)大数据关联分析(5)大数据分类(6)大数据聚类(7)大数据分析工具第6章大数据可视化(1)大数据可视化概述(2)大数据可视化方法(3)大数据可视化工具第7章社交大数据(1)社交大数据(2)国内社交网络大数据的应用(3)国外社交网络大数据的应用第8章交通大数据(1)交通大数据概述(2)交通监测应用(3)预测人类移动行为应用第9章医疗大数据(1)医疗大数据简介(2)临床决策分析应用(3)医疗数据系统分析第10章大数据的挑战与发展趋势(1)大数据发展面临的挑战(2)大数据的发展趋势一、客观部分:(单项选择、多项选择)(一)、单项选择1.以下不是NoSQL数据库的是()A.MongoDBB.HBaseC.CassandraD.DB2★考核知识点:NoSQL与NewSQL主流系统参考讲稿章节:3.7附1.1.1(考核知识点解释):目前市场上主要的NoSQL数据存储工具有:BigTable、Dynamo 、Hbase、MongoDB、CouchDB、Hypertable还存在一些其他的开源的NoSQL数据库,Neo4j、Oracle Berkeley DB、Apache Cassandra等另外,NewSQL数据库。

大数据导论(通识课版)-第3章-大数据技术(2020年春季学期)

3.2.3 数据采集的数据源

3. 日志文件 数据的概念

日志文件数据一般由数据源系统产生,用于记录数据源的执行的各种操作活动,比如网络监控 的流量管理、金融应用的股票记账和Web服务器记录的用户访问行为。通过对这些日志信息 进行采集,然后进行数据分析,就可以从公司业务平台日志数据中,挖掘得到具有潜在价值的 信息,为公司决策和公司后台服务器平台性能评估,提供可靠的数据保证。系统日志采集系统 做的事情就是,收集日志数据,提供离线和在线的实时分析使用。

分布式文件系统分布式文件系统distributedfilesystem是一种通过网络实现文件在多台主机上进行分布式存储的文件系统主节点客户端客户端机架1机架n数据节点数据节点访问请求访问请求复制文件块分布式文件系统的整体结构大数据导论通识课版厦门大学计算机科学系林子雨ziyulinxmueducn332大数据时代的数据存储和管理技术2newsql和nosql数据库1newsql数据库?newsql是对各种新的可扩展高性能数据库的简称这类数据库不仅具有对海量数据的存储管理能力还保持了传统数据库支持acid和sql等特性?目前具有代表性的newsql数据库主要包括spannerclustrixgeniedbscalarcschoonervoltdbrethinkdbscaledbakibancodefuturesscalebasetranslatticenimbusdbdrizzletokutekjustonedb等大数据导论通识课版厦门大学计算机科学系林子雨ziyulinxmueducn332大数据时代的数据存储和管理技术2newsql和nosql数据库2nosql数据库?nosql是一种不同于关系数据库的数据库管理系统设计方式是对非关系型数据库的统称它所采用的数据模型并非传统关系数据库的关系模型而是类似键值列族文档等非关系模型?nosql数据库没有固定的表结构通常也不存在连接操作也没有严格遵守acid约束因此与关系数据库相比nosql具有灵活的水平可扩展性可以支持海量数据存储大数据导论通识课版厦门大学计算机科学系林子雨ziyulinxmueducn332大数据时代的数据存储和管理技术2newsql和nosql数据库2nosql数据库灵活的可扩展性灵活的数据模型与云计算紧密融合nosql优点大数据导论通识课版厦门大学计算机科学系林子雨ziyulinxmueducn332大数据时代的数据存储和管理技术2newsql和nosql数据库3大数据引发数据库架构变革oldsql分析事务互联网一种架构支持多类应用onesizefitsallnewsql分析oldsql事务nosql互联网大数据时代架构多元化多架构支持多类应用大数据引发数据处理架构变革大数据导论通识课版厦门大学计算机科学系林子雨ziyulinxmueducn34数据处理与分析341数据挖掘和机器学习算法342大数据处理与分析技术大数据导论通识课版厦门大学计算机科

《大数据导论》复习资料

《大数据导论》课程期末复习资料《大数据导论》课程讲稿章节目录:第1章大数据概述(1)大数据的概念(2)大数据的特征(3)大数据的数据类型(4)大数据的技术(5)大数据的应用第2章大数据采集与预处理(1)大数据采集(2)大数据预处理概述(3)数据清洗(4)数据集成(5)数据变换(6)数据规约第3章大数据存储(1)大数据存储概述(2)数据存储介质(3)存储系统结构(4)云存储概述(5)云存储技术(6)新型数据存储系统(7)数据仓库第4章大数据计算平台(1)云计算概述(2)云计算平台(3)MapReduce平台(4)Hadoop平台(5)Spark平台第5章大数据分析与挖掘(1)大数据分析概述(2)大数据分析的类型及架构(3)大数据挖掘(4)大数据关联分析(5)大数据分类(6)大数据聚类(7)大数据分析工具第6章大数据可视化(1)大数据可视化概述(2)大数据可视化方法(3)大数据可视化工具第7章社交大数据(1)社交大数据(2)国内社交网络大数据的应用(3)国外社交网络大数据的应用第8章交通大数据(1)交通大数据概述(2)交通监测应用(3)预测人类移动行为应用第9章医疗大数据(1)医疗大数据简介(2)临床决策分析应用(3)医疗数据系统分析第10章大数据的挑战与发展趋势(1)大数据发展面临的挑战(2)大数据的发展趋势一、客观部分:(单项选择、多项选择)(一)、单项选择1.以下不是NoSQL数据库的是()A.MongoDBB。

HBaseC.CassandraD。

DB2★考核知识点:NoSQL与NewSQL主流系统参考讲稿章节:3.7附1.1。

1(考核知识点解释):目前市场上主要的NoSQL数据存储工具有:BigTable、Dynamo 、Hbase、MongoDB、CouchDB、Hypertable还存在一些其他的开源的NoSQL数据库,Neo4j、Oracle Berkeley DB、Apache Cassandra等另外,NewSQL数据库。

史上最全《从0到1》读书笔记来了!

史上最全《从0到1》读书笔记来了!这几天刚到手当前炙手可热的来自PayPal创始人Peter Thiel的《Zero to One》,中文名《从0到1》。

因为到货时刚好有事情在忙,所以只能在周末才开始拜读。

废话少说,上笔记。

第一章”未来的挑战”第1记:把握潮流风向都是掌握在少数人手上的文章开始作者就说道:当我面试应聘者时,都会问这样一个问题:“在什么重要问题上你与其他人有不同的看法?“然后跟着一段描述应聘者通常的回答如下:它也挑战心理,因为每个努力去回答的人都必须说一些他们明知道不为总人认同的看法,者需要勇气。

出彩的回答很少,相对于智慧,这些想法缺少的更是勇气。

通常,我听到的回答都是这样的:“我们的教育体制存在弊端,亟待改革。

““美国是非凡的。

““世界上不存在上帝。

“…作者给出的回答如下:好的回答应该按照下面这种模式:“大多数人相信X,但事实确是X的对立面。

“这里有几点我个人的一些不成熟的见解。

第1点: 创业者应该敢于不走寻常路正如我在另外一篇文章《现在叫你声企业家,你敢答应吗?》中所说到的:“企业家有一个与生俱来的创新诉求,当碰到一条越少人走的路就会觉得这越是一条应该走下去的正确的道路,这比走寻常路打份工赚份人工来的更有意思。

“以及该文章中描述的企业家应该拥有的三个特质中的第2点:舍我其谁的自信:健康向上的自信心会让你更容易迈向成功,你将会面对一些将你的方案打击的体无完肤、尸骨无全、面目全非的恶毒的否定派。

请坚信你的产品就是这个世界所需要的,且你就是提供该产品的正确的人选。

第2点:创业者要洞察潮流的风向很多人说不出究竟有哪些重大事情你是有独特的看法的原因是你自己根本不知道哪些是“独特”的事情。

在在创业者的角度来说,就是你根本不知道创业潮流在往哪个方向流动。

你根本琢磨不透究竟下一波创业浪潮来自何处。

这样的话,你就充其量只能做从1到N的C2C(Copy to China)的量变的创业,永远跨不过从0到1的质变的创新。

ArcSight Investigate 2.20安装指南说明书

v1b – 12/11/2018Investigate 2.20 Build Guide PreSales Lab Build GuideContentsContents (2)Description (3)Versions (3)Physical Network (4)ArcSight Installer (4)Label the Nodes and Upload the Images (4)Deploy Investigate (4)CentOS install for Vertica nodes (5)Vertica Install (8)ArcSight Installer (11)Configure Investigate in the ArcSight Installer interface (11)Configure Investigate in the ArcSight Investigate interface (11)Micro Focus Trademark Information (12)Company Details (12)DescriptionThis guide shows how to install Investigate in a lab environment. This guide was created by the ArcSight PreSales Technical Enablement team as a resource for the ArcSight PreSales organization. This guide is not official documentation. Please read and refer to the official product documentation for additional information. Please see the ArcSight Event Broker 2.21 from the ground up build guide for instructions on installing the ArcSight Installer and Event Broker.1.Architecturea.Vertica on 3 nodesThis is an offline installation of Investigate. The CentOS install is a minimal install, adding the minimum number of required packages required for Vertica. The Vertica nodes are running CentOS 7.4.1708.Versions•ArcSight Installer 1.50.9o arcsight-installer-1.50.9.zip•Investigate 2.20o arcsight-investigate-2.20.9.taro arcsight-vertica-installer_2.20.0-1.tar.gz•Event Broker 2.21o arcsight-eventbroker-2.21.9.tar•SmartConnector 7.9.0.8084o ArcSight-7.9.0.8084.0-Connector-Win64.exePhysical NetworkAll nodes are on the same 1 GigE network segment. There are no firewalls between nodes and no Internet proxy.ArcSight InstallerLabel the Nodes and Upload the Images•Label the nodeso This can be done through the ArcSight Installer interface. Instructions on doing this by command line is shown below.▪The Master node will run Investigate. You need to use the node IP addresses in the command.•kubectl label --overwrite node 192.168.0.5 investigate=yes •Verify the labelso kubectl get nodes -L=investigate•Upload the offline images to o cd /opt/arcsight/kubernetes/scripts▪./uploadimages.sh -s investigate -d /root/investigateo If you specify the wrong directory for where the offline images have been extracted to you will see this message.Which suite do you want to upload? (ITSMA, DCA, OpsBridge or HCM)o You should see the following message indicating the upload was successful (6 images for Investigate).Upload completed in XXX seconds.Upload suite feature data completed.Upload-process successfully completed.Deploy Investigate•Deploy ArcSight Investigate in the ArcSight Installer interfaceo https://:5443/▪This is the HA Virtual IP (VIP) address DNS entryo Click Node Management▪Every node should be Ready and have a green check mark.o Click Deployment▪Click Deploy to the right of ArcSight Investigate and then select 2.20.o Verify deployment▪To verify deployment, check the ArcSight Installer interface. ArcSight Investigate should have a green check mark under Status.▪You can check the pod status with this command. The hercules-search pod will be in a CrashLoopBackOff or Error status; that is OK, it is in this status becausewe haven’t configured the Vertica host in the Installer interface.[root@eb1 ~]# watch kubectl get pods -n investigate1NAME READY STATUS RESTARTS AGEhercules-management-847cc7c7f8-fcprh 2/2 Running 0 5mhercules-rethinkdb-0 1/1 Running 0 5mhercules-search-869677c77d-pkqr6 2/3 CrashLoopBackOff 3 5mnginx-ingress-controller-gt589 1/1 Running 0 5msuite-reconf-pod-investigate-dnngw 2/2 Running 0 5m •Event Broker Transforming Stream Processoro With Investigate, you will need to go in to the ArcSight Installer interface and change the configuration of ArcSight Event Broker and enable the Transforming Stream Processor.▪Configuration -> ArcSight Event Broker -> Replicas•Change from 0 to 1o Once this has been changed, you will see the eb-c2av-processor pod.eventbroker1 eb-c2av-processor-0 1/1 Running 0 26mCentOS install for Vertica nodes•Install CentOSo Version▪CentOS 7.4•CentOS Linux release 7.4.1708 (Core)▪All nodes were a fresh Minimal Install.▪This guide assumes you have access to yum repositories.•Once the OS is installedo vi /etc/sysctl.conf## Increase number of incoming connectionsnet.core.somaxconn = 1024## Sets the send socket buffer maximum size in bytes.net.core.wmem_max = 16777216## Sets the receive socket buffer maximum size in bytes.net.core.rmem_max = 16777216## Sets the receive socket buffer default size in bytes.net.core.wmem_default = 262144## Sets the receive socket buffer maximum size in bytes.net.core.rmem_default = 262144## increase the length of the processor input queuedev_max_backlog = 100000net.ipv4.tcp_mem = 16777216 16777216 16777216net.ipv4.tcp_wmem = 8192 262144 8388608net.ipv4.tcp_rmem = 8192 262144 8388608net.ipv4.udp_mem = 16777216 16777216 16777216net.ipv4.udp_rmem_min = 16384net.ipv4.udp_wmem_min = 16384#### Increase the number of outstanding syn requests allowed.net.ipv4.tcp_max_syn_backlog = 4096#### Based on 128 GB of memorydirty_ratio = 8#### Resolve WARN (S0112)vm.swappiness = 1o vi /etc/rc.localecho deadline > /sys/block/sda/queue/scheduler/sbin/blockdev --setra 2048 /dev/sda/sbin/blockdev --setra 2048 /dev/sdbcpupower frequency-set --governor performanceo chmod +x /etc/rc.localo vi /etc/default/grub▪Append the GRUB_CMDLINE_LINUX line with the following:intel_idle.max_cstate=0 processor.max_cstate=1▪Here is an example from a fresh minimal install of CentOS 7.4:GRUB_CMDLINE_LINUX="crashkernel=auto rhgb quiet intel_idle.max_cstate=0processor.max_cstate=1"o vi /etc/sysconfig/selinuxSELinux=permissiveo firewalld▪iptables -F▪iptables -t nat -F▪iptables -t mangle -F▪iptables -X▪systemctl mask firewalld▪systemctl stop firewalld▪systemctl disable firewalldo vi /etc/security/limits.d/20-nproc.conf▪You will need to comment out the default soft nproc entry and add these entries * soft nproc 10240* hard nproc 10240* soft nofile 65536* hard nofile 65536* soft core unlimited* hard core unlimitedo yum▪yum install -y bind-utils java-1.8.0-openjdk gdb mcelog sysstat dialog chrony tzdatao Rebooto Check that SELinux is permissive and firewalld is disabled▪sestatusSELinux status: enabledSELinuxfs mount: /sys/fs/selinuxSELinux root directory: /etc/selinuxLoaded policy name: targetedCurrent mode: permissiveMode from config file: permissivePolicy MLS status: enabledPolicy deny_unknown status: allowedMax kernel policy version: 28▪systemctl list-unit-files | grep firewallfirewalld.service masked▪systemctl status firewalldfirewalld.serviceLoaded: masked (/dev/null; bad)Active: inactive (dead)o Check that 20-nproc.conf was properly modified▪ulimit -acore file size (blocks, -c) unlimiteddata seg size (kbytes, -d) unlimitedscheduling priority (-e) 0file size (blocks, -f) unlimitedpending signals (-i) 31152max locked memory (kbytes, -l) 64max memory size (kbytes, -m) unlimitedopen files (-n) 65536pipe size (512 bytes, -p) 8POSIX message queues (bytes, -q) 819200real-time priority (-r) 0stack size (kbytes, -s) 8192cpu time (seconds, -t) unlimitedmax user processes (-u) 10240virtual memory (kbytes, -v) unlimitedfile locks (-x) unlimited•Below are the DNS names and IP addresses I will be using in the VMs.o 192.168.0.11o 192.168.0.12o 192.168.0.13•ssho Next, we need to generate an ssh key on the node we are running the install from (). Select the default file and no passphrase.▪ssh-keygen -q -t rsao Once the ssh key is generated, we need to copy it to each of the nodes in the cluster.This also needs to be copied to the local system you’re installing from. Below are thecommands to run on .▪ssh-copy-id-i~/.ssh/**********************.0.11▪ssh-copy-id-i~/.ssh/**********************.0.12▪ssh-copy-id-i~/.ssh/**********************.0.13o To verify this was setup properly, use the following commands on each node. You should be able to login with no password.▪***************.0.11▪***************.0.12▪***************.0.13o At this point the nodes are ready for the Vertica install.Vertica Install•Upload your Vertica license to /root on o/root/vertica_license.dat•On o mkdir /root/install-vertica•Copy the Vertica installer to /root/install-vertica on o arcsight-vertica-installer_2.20.0-1.tar.gz•Change to the /root/install-vertica directory and extract the tar fileo tar xvfz ./arcsight-vertica-installer_2.20.0-1.tar.gz•vi /root/install-vertica/config/vertica_user.propertieshosts=192.168.0.11,192.168.0.12,192.168.0.13license=/root/vertica_license.datdb_retention_days=30•vi /root/install-vertica/vertica.propertieso Set the timezone to the appropriate setting.timezone="MDT"o If you want to change any settings in vertica.properties after you’ve installed Vertica, just re-run the ./vertica_installer install command again. This will uninstall and reinstallVertica.•Run the Vertica install from /root/install-verticao./vertica_installer install▪DB Admin user•dbadmin▪DB Admin user password•dbadminpw▪Search user•search▪Search user password•searchpw•Create the Investigate schemao./vertica_installer create-schema▪If successful, you should see this:# ========================================# STEP 1: create schema: investigation.events# ========================================# STEP 2: grant privileges on schema: investigation.events# ========================================# STEP 3: create table: investigation.version_metadata# ========================================# STEP 4: inserted in investigation.version_metadata: schemaVersion=4.4.0,installerVersion=2.20.0•Create the Kafka Schedulero./kafka_scheduler create 192.168.0.4:9092,192.168.0.5:9092,192.168.0.6:9092 ▪If successful, you should see this:Establishing a connection to kafka cluster ['192.168.0.4:9092', '192.168.0.5:9092', '192.168.0.6:9092'] ....Detected 6 partitions for topic 'eb-internal-avro'create scheduler under: investigation_schedulerscheduler: create target topicscheduler: create cluster for 192.168.0.4:9092,192.168.0.5:9092,192.168.0.6:9092scheduler: create source topic (eb-internal-avro) for192.168.0.4:9092,192.168.0.5:9092,192.168.0.6:9092scheduler: create microbatch (mbatch_192_168_0_4) for192.168.0.4:9092,192.168.0.5:9092,192.168.0.6:9092scheduler instance(s) added for 192.168.0.11scheduler instance(s) added for 192.168.0.12scheduler instance(s) added for 192.168.0.13•Check the Kafka Scheduler statuso./kafka_scheduler status•Check the Kafka Scheduler event-copy progresso./kafka_scheduler eventsIf the Kafka Scheduler is consuming events from Event Broker, you will see the events count increase when you check and re-check the status.•Check the Kafka Scheduler messageso./kafka_scheduler messages•You can see Vertica listed as a Consumer in the Event Broker interface. You will not see this under Consumers if you have no events from Producers in Event Broker.ArcSight InstallerConfigure Investigate in the ArcSight Installer interface•https://:5443/o This is the HA Virtual IP (VIP) address DNS entry•Click Configuration -> ArcSight Investigateo Vertica host▪192.168.0.11 192.168.0.12 192.168.0.13o Vertica user name▪searcho Vertica database▪investigateo Vertica password▪searchpw•Click Test Connectiono You should see Connection was successfully established!•Click Saveo This will redeploy and restart Investigate hercules-search pod.•If you specify the wrong Vertica host, user name, database, or password, the hercules-search pod will get in a looping Error and CrashLoopBackOff status. When you open the Investigateinterface, you will receive a 502 Bad Gateway message.investigate1 hercules-search-2613439649-cn6nt 2/3 Error 1 5minvestigate1 hercules-search-2613439649-cn6nt 2/3 CrashLoopBackOff 5 17mConfigure Investigate in the ArcSight Investigate interface•https:///o This is the HA Virtual IP (VIP) address DNS entry▪If you see a 502 error, wait a couple of minutes. If this happens for longer than a couple of minutes, check your Vertica configuration settings in the Investigate configuration.502 Bad Gatewaynginx/1.11.10▪Create System Admin•Complete this information with your own information▪LoginClick Search•Search on Last 30 minutes to see events in Vertica (events that Vertica hasconsumed from Event Broker).Micro Focus Trademark InformationMICRO FOCUS and the Micro Focus logo, among others, are trademarks or registered trademarks of Micro Focus (IP) Limited or its subsidiaries in the United Kingdom, United States and other countries. All other marks are the property of their respective owners.Company DetailsCompany name: Micro Focus International plcPlace of registration: England and WalesRegistered number: 5134647Registered address: The Lawn, 22-30 Old Bath Road, Berkshire, RG14 1Q。

returnaddress的意思

Returnaddress是一个英文词汇,直译为“返回位置区域”,在日常生活和商务信函中经常出现。

在邮政和快递领域,return address通常用于寄件人提供自己的位置区域信息,以便收件人在无法收到包裹或信件时能够退回寄件人处。

而在计算机科学领域,return address通常指的是在函数调用时用来记录函数返回位置区域的内存位置,用于在函数执行结束后返回到调用函数的位置。

在邮政和快递领域,return address的作用主要是为了解决邮件或包裹无法送达时的退回问题。

具体来说,return address通常包括寄件人的尊称、街道位置区域、城市、州或省、邮信码以及国家。

这些信息能够帮助快递公司或邮政部门在无法投递时将邮件或包裹退回给寄件人。

return address也能够帮助寄件人确认自己的位置区域信息是否正确,以免出现误投或丢失的情况。

在商务信函中,return address通常位于信封或信纸的信头部分,以便收件人在收到信件后能够知道寄件人的位置区域信息。

这不仅有利于寄件人和收件人之间的通联,也能够提高信件的安全性和可追溯性。

另外,对于一些重要的商务文件或合同,正确填写return address也是一种常规操作,以确保在通讯中出现问题时能够及时退回或通联到寄件人。

在计算机科学领域,return address通常指的是在函数调用时用来记录函数返回位置区域的内存位置。

在函数调用时,计算机会将函数的返回位置区域压栈,然后跳转到被调用函数执行。

当被调用函数执行结束后,计算机会从栈中弹出返回位置区域,然后跳转回调用函数的位置继续执行。

return address在程序的执行过程中起着关键作用,它保证了函数调用的顺利进行,同时也是实现函数返回的重要手段之一。

return address是一个跨领域的概念,在不同领域有着不同的含义和作用。

在邮政和快递领域,return address主要用于解决邮件或包裹无法投递时的退回问题;在商务信函中,return address则是用于确认寄件人的位置区域信息;而在计算机科学领域,return address则是实现函数调用和返回的重要机制。

atxserver2-rethinkdb的一些基础操作

611053请尝试刷新页面或更换浏览器重试

atxserver2-rethinkdb的 一 些 基 础 操 作

因为我只需要一些基础操作就好,所以在web端的 Data Explorer 操作,首先启动 rethinkdb.exe,然后登陆网页端,

下面是一些基础操作的语句,

一、创建表 r.db(‘atxserver2’).tableCreate(‘appManagement’) 二、删除表 r.db(‘atxserver2’).tableDrop(‘appManagement’) 三、插入数据 r.db(‘atxserver2’).table(“appManagement”).insert([ {id: 1,appName: “企业一家”,creator: “Mr Wang”}, {id: 2,appName: “老干部”,creator: “Mr Li”}, ]) 四、更改表数据 r.db(‘atxserver2’).table(“appManagement”).filter({id: 1}).update({appName: “企业e家”}) 注:若表中无此字段,则自动添加 五、删除指定行 r.db(‘atxserver2’).table(“appManagement”).filter({id: 1}).delete() 清空所有数据:r.db(‘stf’).table(“appManagement”).delete() 六、查询 1、查询所有数据库 r.dbList() 2、查询所有的表 r.db(‘atxserver2’).tableList() 3、查看表多行数据 r.db(‘atxserver2’).table(‘appManagement’).getAll(1,2) 4、filter查询(相当于where) r.db(‘atxserver2’).table(‘appManagement’).filter({appName:“老干部”’})

Raft协议介绍:Raft整体介绍

编号:________________ Raft协议介绍:Raft整体介绍甲方:________________乙方:________________时间:________________本文主要介绍“什么是Raft?“、“我们在什么场景下适合使用Raft?”、“业界使用Raft的一些项目”以及“Raft的局限性”。

一、什么是RaftRaft是一种共识算法(一致性算法),共识算法主要应用在分布式领域,字面意思就是让分布式集群中的各个节点对某些信息或状态达成共识。

如果我们在单机环境,是不会存在这个问题的,实际上共识算法也主要应用在分布式系统的高可用方面,即使发生了节点异常,共识算法也可以做到对分布式集群中各个有状态的节点进行状态同步,进而提高系统的整体可用性,让系统中的节点可以给外部上下游服务请求提供一致的反馈。

目前业界大部分共识算法都是基于Quorum机制的,也就是冗余副本选举机制,这个机制是发源于数学中的鸽巢理论,Raft协议、Paxos协议、Zookeeper使用的ZAB 协议、Hadoop使用的QJM协议等等,都是基于Quorum机制对不同的场景做出一些取舍而产生的变种,其中Lamport提出的Paxos被认为是分布式一致性复制协议的根本。

Raft协议是由斯坦福大学的Diego Ongaro和John Ousterhout提出,作为RAMCloud项目中的中心协调组件。

Raft是一种Leader-Based的Multi-Paxos变种,相比Paxos、Zab、View Stamped Replication等协议提供了更完整更清晰的协议描述,并提供了清晰的节点增删描述,也号称最容易理解的共识算法。

1、Raft的前提Raft其实是基于Paxos协议的一个简化版本,Raft算法的正确性也是基于以下几个前提的:(1)Strong Leader:原来的leader挂掉后,必须选出一个新的leader,日志复制的顺序也是确定的,必须从Leader流向Follower(2)日志复制:只接受Leader从客户端接收日志,并复制到整个集群中(3)安全性:在非拜占庭问题下(网络延时,网络分区,丢包,重复发包以及包乱序等),结果是正确的2、Raft节点以及状态机介绍(1)Follower:集群中的冗余节点,会对状态机进行冗余(2)Candidate:准备竞选Leader的节点,希望成为状态机的主理人(3)Leader:竞选成功的节点,状态机的主理人,处理会改变状态机的Client 的请求,在每个时刻只允许存在一个Leader在Raft协议中主要由Leader对状态机进行管理,并把状态机的信息通过日志复制的方式同步给冗余的Follower节点。

Python定时任务框架APScheduler详解

Python定时任务框架APScheduler详解APScheduler最近想写个任务调度程序,于是研究了下 Python 中的任务调度⼯具,⽐较有名的是:Celery,RQ,APScheduler。

Celery:⾮常强⼤的分布式任务调度框架RQ:基于Redis的作业队列⼯具APScheduler:⼀款强⼤的任务调度⼯具RQ 参考 Celery,据说要⽐ Celery 轻量级。

在我看来 Celery 和 RQ 太重量级了,需要单独启动进程,并且依赖第三⽅数据库或者缓存,适合嵌⼊到较⼤型的 python 项⽬中。

其次是 Celery 和 RQ ⽬前的最新版本都不⽀持动态的添加定时任务(celery 官⽅不⽀持,可以使⽤第三⽅的或者实现),所以对于⼀般的项⽬推荐⽤ APScheduler,简单⾼效。

Apscheduler是⼀个基于Quartz的python定时任务框架,相关的 api 接⼝调⽤起来⽐较⽅便,⽬前其提供了基于⽇期、固定时间间隔以及corntab类型的任务,并且可持久化任务;同时它提供了多种不同的调⽤器,⽅便开发者根据⾃⼰的需求进⾏使⽤,也⽅便与数据库等第三⽅的外部持久化储存机制进⾏协同⼯作,⾮常强⼤。

安装最简单的⽅法是使⽤ pip 安装:$ pip install apscheduler或者下载源码安装:$ python setup.py install⽬前版本:3.6.3基本概念APScheduler 具有四种组件:triggers(触发器)jobstores (job 存储)executors (执⾏器)schedulers (调度器)triggers:触发器管理着 job 的调度⽅式。

jobstores:⽤于 job 数据的持久化。

默认 job 存储在内存中,还可以存储在各种数据库中。

除了内存⽅式不需要序列化之外(⼀个例外是使⽤ ProcessPoolExecutor),其余都需要 job 函数参数可序列化。

Prometheus的优劣势与Zabbix的对比

Prometheus的优劣势与Zabbix的对⽐Prometheus简要介绍:Prometheus是⼀款警报⼯具包,它是⼀个独⽴的开源项⽬,并且独⽴于任何公司进⾏维护。

其完整的监控解决⽅案对传统监控系统对测试和告警模型进⾏了彻底对颠覆,形成了基于中央化的规则计算、统⼀分析和告警的新模型。

继Kubernetes之后,Prometheus是第⼆个加⼊Cloud Native Computing Foundation(云原⽣云计算基⾦会)托管的项⽬。

Prometheus的优点:1、强⼤的数据模型:Prometheus中有⼀个内置的时间序列数据库(TSDB),采集到的所有监控数据都会以⼀种指标的形式存储在⾥⾯。

除了储存了基本的名称外,还有描述每⼀个样本的标签。

指标名称和⼀组标签是判定每⼀条时间序列的唯⼀标识,且它按照时间的前后顺序去保存⼀系列的样本值。

关于维度的标签有两种来源⽅式:监控对象的状态或对于环境的定义。

基于这些Labels我们可以⽅便地对监控数据进⾏聚合,过滤,裁剪。

2、监控服务的内部运⾏状态:⽤户可以通过在应⽤程序中添加对Prometheus的⽀持,轻松的获取到服务和应⽤内部的真实运⾏状态,这点完全得益于Prometheus丰富的Client库。

3、管理⽅便:Prometheus唯⼀需要的就是⼀个本地磁盘,因为它的核⼼部分只有⼀个单独的⼆进制⽂件,没有像数据库,缓存等⼀系列的第三⽅依赖。

这⼀特性使它不会潜在级联故障的风险。

基于Pull模型的架构⽅式,Prometheus可以在本地电脑,测试环境等任何地⽅搭建监控系统;在遇到复杂的情况下,它的Service Discovery能⼒可以动态管理监控⽬标。

4、强⼤的查询语⾔PromQL:PromQL不仅可以轻松回答诸如:预测四⼩时之后,磁盘空间占⽤⼤致会是什么情况这⼀类的问题,还能实现对监控数据对查询与聚合。

5、⾼效率运作:⼤量对监控任务必然就会对应产⽣⼤量的数据。

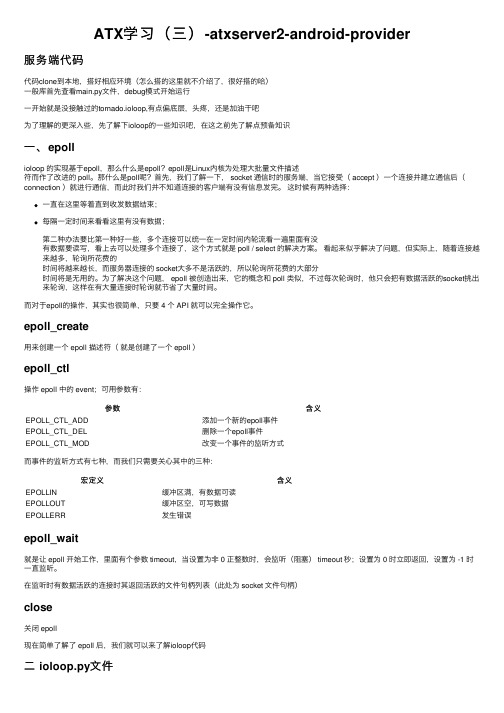

ATX学习(三)-atxserver2-android-provider

ATX学习(三)-atxserver2-android-provider服务端代码代码clone到本地,搭好相应环境(怎么搭的这⾥就不介绍了,很好搭的哈)⼀般库⾸先查看main.py⽂件,debug模式开始运⾏⼀开始就是没接触过的tornado.ioloop,有点偏底层,头疼,还是加油⼲吧为了理解的更深⼊些,先了解下ioloop的⼀些知识吧,在这之前先了解点预备知识⼀、epollioloop 的实现基于epoll,那么什么是epoll?epoll是Linux内核为处理⼤批量⽂件描述符⽽作了改进的 poll。

那什么是poll呢?⾸先,我们了解⼀下, socket 通信时的服务端,当它接受( accept )⼀个连接并建⽴通信后(connection )就进⾏通信,⽽此时我们并不知道连接的客户端有没有信息发完。

这时候有两种选择:⼀直在这⾥等着直到收发数据结束;每隔⼀定时间来看看这⾥有没有数据;第⼆种办法要⽐第⼀种好⼀些,多个连接可以统⼀在⼀定时间内轮流看⼀遍⾥⾯有没有数据要读写,看上去可以处理多个连接了,这个⽅式就是 poll / select 的解决⽅案。

看起来似乎解决了问题,但实际上,随着连接越来越多,轮询所花费的时间将越来越长,⽽服务器连接的 socket⼤多不是活跃的,所以轮询所花费的⼤部分时间将是⽆⽤的。

为了解决这个问题, epoll 被创造出来,它的概念和 poll 类似,不过每次轮询时,他只会把有数据活跃的socket挑出来轮询,这样在有⼤量连接时轮询就节省了⼤量时间。

⽽对于epoll的操作,其实也很简单,只要 4 个 API 就可以完全操作它。

epoll_create⽤来创建⼀个 epoll 描述符(就是创建了⼀个 epoll )epoll_ctl操作 epoll 中的 event;可⽤参数有:参数含义EPOLL_CTL_ADD添加⼀个新的epoll事件EPOLL_CTL_DEL删除⼀个epoll事件EPOLL_CTL_MOD改变⼀个事件的监听⽅式⽽事件的监听⽅式有七种,⽽我们只需要关⼼其中的三种:宏定义含义EPOLLIN缓冲区满,有数据可读EPOLLOUT缓冲区空,可写数据EPOLLERR发⽣错误epoll_wait就是让 epoll 开始⼯作,⾥⾯有个参数 timeout,当设置为⾮ 0 正整数时,会监听(阻塞) timeout 秒;设置为 0 时⽴即返回,设置为 -1 时⼀直监听。

Docker暴露2375端口导致服务器被攻击问题及解决方法

Docker暴露2375端⼝导致服务器被攻击问题及解决⽅法相信了解过docker remote API的同学对2375端⼝都不陌⽣了,2375是docker远程操控的默认端⼝,通过这个端⼝可以直接对远程的docker daemon进⾏操作。

当$HOST主机以docker daemon -H=0.0.0.0:2375⽅式启动daemon时,可以在外部机器对$HOST的docker daemon进⾏直接操作:docker -H tcp://$HOST:2375 ps好,说说如何“⼊侵”,怎么通过这个端⼝⼊侵宿主机呢?这个应该要从⼏个点说起吧:1. docker对user namespace没有做隔离,也就是说,容器内部的root⽤户就是宿主机的root⽤户,⼀旦挂载⽬录,就可以在容器内部以宿主机的root⽤户⾝份对挂载的⽂件系统随意修改了。

docker服务拥有很⾼的执⾏权利(相当于root),并且在docker⽤户组下的普通⽤户不需要任何其他验证就可以执⾏docker run等命令。

暴露的docker remote API端⼝如果没有启动ssl验证的话,任何能连通到这台docker宿主机的的机器都可以随意操作这台docker宿主机的docker daemon(docker run、docker ps、docker rm等等这些命令都不在话下)。

结合以上3点,就基本具备⼊侵docker宿主机的条件了讲得似乎有点悬,不多说,直接拿⼀个活鲜鲜的例⼦来讲吧:(请允许我⽤最近新学的⼀道菜将流程带过╮( ̄▽ ̄)╭ )秘制红烧⾁(docker版)材料:⼀整块⼀整块的“5花”IP段,越肥越好(⼩⽩⽤户越多越好)配料:nmap,dockerstep 1: 扫描2375端⼝怎么扫?我选⽤的是简单易⽤的⿊客必备神器nmap了。

扫哪⾥呢?我选的⽬标是aliyun的IP段,百度得知:42.96.128.0/17 Alibaba (Beijing) Technology Co., Ltd. China42.120.0.0/16 Aliyun Computing Co., LTD China42.121.0.0/16 Aliyun Computing Co., LTD China42.156.128.0/17 Aliyun Computing Co., LTD China110.75.0.0/16 Asia Pacific Network Information Centre China110.76.0.0/19 Ali Technology Co., Ltd China110.76.32.0/20 Aliyun Computing Co., LTD China110.173.192.0/20 HiChina Web Solutions (Beijing) Limited China110.173.208.0/20 HiChina Web Solutions (Beijing) Limited China112.124.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China112.127.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China114.215.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China115.28.0.0/16 HiChina Web Solutions (Beijing) Limited China115.29.0.0/16 HiChina Web Solutions (Beijing) Limited China115.124.16.0/22 Hangzhou Alibaba Advertising Co.,Ltd. China115.124.20.0/22 Hangzhou Alibaba Advertising Co.,Ltd. China115.124.24.0/21 Hangzhou Alibaba Advertising Co.,Ltd. China119.38.208.0/21 Hangzhou Alibaba Advertising Co.,Ltd. China119.38.216.0/21 Hangzhou Alibaba Advertising Co.,Ltd. China119.42.224.0/20 Alibaba (China) Technology Co., Ltd. China119.42.242.0/23 Hangzhou Alibaba Advertising Co.,Ltd. China119.42.244.0/22 Hangzhou Alibaba Advertising Co.,Ltd. China121.0.16.0/21 Hangzhou Alibaba Advertising Co.,Ltd. China121.0.24.0/22 Hangzhou Alibaba Advertising Co.,Ltd. China121.0.28.0/22 Hangzhou Alibaba Advertising Co.,Ltd. China121.196.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China121.197.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China121.198.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China121.199.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China140.205.0.0/16 Aliyun Computing Co., LTD China203.209.250.0/23 Hangzhou Alibaba Advertising Co.,Ltd. China218.244.128.0/19 Hangzhou Alibaba Advertising Co.,Ltd. China223.4.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China223.5.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China223.5.5.0/24 Hangzhou Alibaba Advertising Co.,Ltd. China223.6.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd. China223.6.6.0/24 Hangzhou Alibaba Advertising Co.,Ltd. China223.7.0.0/16 Hangzhou Alibaba Advertising Co.,Ltd.我不⽣产IP,我只是百度的搬运⼯,别问我这些IP从那来,我也想知道~ >.<将上⾯IP内容保存在⼀个⽂件中,如 aliyun.list开始扫描:cat aliyun.list| awk '{print $1}' | xargs -n 1 -I {} nmap -sT -p2375 {} --open# 简单解释⼀下命令:# awk 将第⼀列IP⽹段过滤出来# xargs 将过滤出来的IP⼀个⼀个的分次送给nmap,-I {} 是指使⽤{}来代替传送的参数# ...# Starting Nmap 7.01 ( https:// ) at 2016-06-05 09:57 CST# Nmap scan report for 42.96.MOSAIC.MOSAIC# Host is up (0.070s latency).# PORT STATE SERVICE# 2375/tcp open docker# ...不到两分钟,第⼀块42.96.MOSAIC.MOSAIC(五花⾁已打码) “五花⾁”选好了,来吧~step 2: 测试2375的直接控制权docker -H tcp://42.96.MOSAIC.MOSAIC:2375 ps# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS# 73aa690e7c92 imdjh/owncloud-with-ocdownloader "/entrypoint.sh" 9 days ago Up 3 days 0.0.0.0:9009->80# f57c56af0e29 rethinkdb:2.3.2 "rethinkdb --bind all" 9 days ago Up 3 days 8080/tcp, 28015/# 37c1401db593 gaomd/ikev2-vpn-server:0.3.0 "/bin/sh -c /usr/bin/" 10 days ago Up 3 days 0.0.0.0:500->500# af7338a5426d nginx:1.9-alpine "nginx -g 'daemon off" 3 weeks ago Up 3 days 443/tcp, 0.0.0.0# ...这个服务器的owner也太配合了(⊙ο⊙),ps直接看到内容,说明这个主机的2375是没有ssl验证的,基本满⾜⼊侵要求。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

TokuDB提供的特殊支持

• Hot Index Creation,TokuDB允许在已有table上创 建索引,同时在索引创建的过程中可以进行insert 和query操作。

- 需要设定服务器变量set tokudb_create_ieate index命令

• Hot Column Addition and Deletion(HCAD),TokuDB 允许在已有table上添加或者删除属性列,同时只 在很短的时间内阻塞update和query操作。

- HCAD会获取一个表锁,用于将脏页刷到外存,所以会暂 时阻塞其他操作

Fractal Tree的建立

创建临时存储

插入15

Fractal Tree的建立 (cont.)

插入7

Merge

Fractal Tree的建立 (cont.)

Merge

Fractal Tree上的查询

数组有序! 二分查找?

1)数组之间添加冗余元素 2)数组中的元素不必全满 3)横向和纵向指向冗余元素 4) Fractional Cascading

- 数据库本身就类似于一个事务日志 - 恢复时直接截断数据库文件到一个已知一致的事务

Append-Only的影响(cont.)

• 简单的主从复制(Easy Replication)。

- 机制与热备份相同 append-only带来的限制: 带来的限制: 带来的限制 在一个insert或者update很频繁的workload下,大 •1)无锁并发(Lock-Free Concurrency) 量数据很快就会过期; - 只需一个锁来保护最后一个事务完成后文件的offset 2) append-only消除了数据组织的数据局部性,虽然 - 读操作可以并发执行,写操作通过队列来管理 在SSD上随机读代价很小,但是仍旧是一个问题; 对于索引结构来说,每50MB的数据会生成2GB的 •3)在线模式修改(Live Schema Changes) 数据存储,需要有效地进行垃圾回收。 - 修改模式时可以无障碍进行读操作 - 在模式修改完成前每个写操作需要单独处理

Append-Only的影响

• 数据一致性(Data Consistency)。

- 所有更新追加到文件尾部,其他部分没有任何修改 - 文件的其余部分提供了一个完全一致的数据库

• 热备份(Hot Backups)。

- 在数据库文件被修改的同时可以拷贝一致数据 - 可简单地实现增量备份

• 及时恢复(Instantaneous Recovery)

- 插入性能加快20到80倍 - 压缩数据减少存储空间 - 数据量可扩展到几个TB - 不会产生索引碎片 - 支持Hot Column Addition, Hot Indexing和MVCC

TokuDB的安装和使用

• TokuDB安装有两种方式。

- 下载TokuDB的patch和MySQL源码,给MySQL打上patch之 后安装MySQL - 下载已经打上patch的MySQL源码,直接安装MySQL

RethinkDB的设计思想

• B树会产生大量的随机写操作,对闪存寿命的负面 影响很大。 • 闪存具有良好的随机读性能,所以B树和cluster index变得不再重要。 • 基于以上判断,RethinkDB采用append-only的方式 来管理数据和索引,消除闪存上的随机写操作。

append-only究竟带来了 什么?

• 使用MySQL sandboxes安装

- tar xzf tokufractaltreeindex-5.0.4-30712-linux-x86_64.tar.gz - export LD_LIBRARY_PATH=$PWD/tokufractaltreeindex-5.0.430712-linux-x86_64/lib - make_sandbox mysql-5.1.52-tokudb-5.0.4-30712-linuxx86_64-glibc23.tar.gz

大纲

• • • • • 闪存和磁盘 压力测试方法 RethinkDB简介及测试 TokuDB简介及测试 总结

RethinkDB是什么

• RethinkDB是一个完全支持Memcached协议、数据 可持久化的工业级key-value存储系统。 • RethinkDB的特点:

- 随CPU个数线程扩展 - SSD上速度快十倍 - 节省内存空间 - 断电后及时恢复 - 细化的持久性控制 - 支持上万的并发连接数 - 支持裸盘设备,多磁盘上自动数据分区

试 程 测 试

- 单独为线程生成测试数据 程 序 序 运 - 每启动一个测试线程之前先为其生成数据 运 行 行 一 生成 测试数据 测试线程启动之 前时 的 的 数据

CPU 利 用 率 CPU

•

数

。

不

利 用 率

- shell -

ulimit -n 32768

/etc/security/limits.conf

测试方法

• 测试工具+监测工具

获取测试配置参 数,设定测试线 程数,每个线程 执行的操作数, key的最小长度 和最大长度, value的最大长 度和最小长度 Tcprstat Socktop Nmon 获取配置参数

1) 对于key-value数据库,使用 libmemcached进行测试,生 成数据为字符串key和value; 2) 对于MySQL数据库,使用 libmysql进行测试,首先生 成字符串key和value,然后 将key和value并入到SQL语句 中。

闪存的使用寿命

闪存写寿命

350 300 250 200 150 100 50 0 Ideal Micron C200 60GB X 5000 =300TB

闪存的写寿命:闪存上 能够写的最大数据量

避免小的写以及随机写既能提高系 统性能又能延长闪存的使用寿命! 闪存上的数据天然就具有多个版 本! 40TB

闪存和磁盘

闪存和磁盘的差异

闪存: 闪存: 1)读/写/擦除三种操作 2)操作速度不一致(读 为10微秒级,写为100微 秒级,擦除为毫秒级) 3)覆盖写之前需要擦除 4)擦除次数有限 5)操作粒度不一致,读 和写以页为单位,擦除 以块为单位 优势: 优势: 1)更快的读写速度 2)尺寸小重量轻 3)抗震省电 磁盘: 磁盘: 1)读/写两种操作 2)读写速度基本一致 3)可原位覆盖写 4)写次数不限 5)读写粒度一致

SSD

new data 1 erased data 1 free erased data 2 free erased data 3 free free free free

RAM

data 2 free data 3 free free

block block

闪存的使用寿命

闪存写寿命

350 300 250 200 150 100 50 0 Ideal Micron C200 60GB X 5000 =300TB

闪存的写寿命:闪存上 能够写的最大数据量

Intel X-25M

闪存的使用寿命

闪存写寿命

350 300 250 200 150 100 50 0 Ideal Micron C200 40TB (60GB drive) 60GB X 5000 =300TB

闪存的写寿命:闪存上 能够写的最大数据量

Intel X-25M

RethinkDB & TokuDB调研测试报告

梁智超 liangzhichao.pt@

大纲

• • • • • 闪存和磁盘 压力测试方法 RethinkDB简介及测试 TokuDB简介及测试 总结

大纲

• • • • • 闪存和磁盘 压力测试方法 RethinkDB简介及测试 TokuDB简介及测试 总结

- 默认安装在/usr/bin/rethinkdb-1.0 - ./rethinkdb-1.0 -f /u01/rethinkdb_data - ./rethinkdb-1.0 -f /u01/rethinkdb_data -c 4 -p 11500 - ./rethinkdb-1.0 -f /u01/rethinkdb_data -f /u03/rethinkdb_data -c 4 -p 11500

生成加载数据 1) 对于key-value数据库,调用 接口memcached_set或者 memcached_get; 2) 对于MySQL数据库,调用接 口mysql_real_query。

创建测试线程开始测试

释放加载数据空间结束测试

测试程序中的问题

• 测试程序成了计算密集型而非IO密集型。 • 测 测试程序并发压力不够。

• Mysqlslap是MySQL服务器的压力测试工具,测试 过程包括三个部分。

- 创建Schema、Table以及其他存储程序或者数据(单客户端 连接) - 运行加载测试(多客户端连接) - 结束测试如关闭连接、删除Table(单客户端连接)

系统监测工具

• Socktop是由Systemtap提供的一个工具,位于/usr /share/doc/systemtap/examples/network目录下。 • Tcprstat是Percona提供的一个免费开源的TCP分析 工具,可以观测网络流量并计算网络请求和响应 之间的延迟。 • Nmon工具是IBM提供的免费监控AIX系统和Linux系 统资源的工具,它可将系统资源的耗用情况收集 起来并输出到一个特定的文件。

闪存的其他特性

• 闪存芯片主要分为三种:SLC、MLC和TLC,不同种 类的芯片也会展现出不同的特性。

闪存的劣势

• 因为特殊的硬件架构,闪存上的随机写和小的写 操作不仅会降低性能而且会缩短闪存的使用寿命。

磁盘

new data 1 data 1 free data 2 free new data 3 data 3 free data 4 free free free