支持向量机实验报告

svm实验报告总结

svm实验报告总结SVM实验报告总结支持向量机(SVM)是一种常用的机器学习算法,它在模式识别、分类、回归等领域有着广泛的应用。

本文将对SVM算法进行实验,旨在探究SVM算法的原理、应用和优缺点。

一、实验原理SVM的基本思想是将低维度的数据映射到高维度的空间中,从而使数据在高维空间中更容易被线性分隔。

SVM算法的核心是支持向量,这些支持向量是距离分类决策边界最近的数据点。

SVM通过找到这些支持向量来建立分类器,从而实现数据分类。

二、实验步骤1. 数据预处理本实验使用的数据集是Iris花卉数据集,该数据集包含了三种不同种类的花朵,每种花朵有四个属性:花萼长度、花萼宽度、花瓣长度、花瓣宽度。

首先需要将数据集划分为训练集和测试集,以便在训练模型时进行验证。

2. 模型训练本实验使用Python中的sklearn库来构建SVM分类器。

首先需要选择SVM的核函数,有线性核函数、多项式核函数、径向基核函数等。

在本实验中,我们选择径向基核函数作为SVM的核函数。

接着需要设置SVM的参数,包括C值和gamma值。

C值是惩罚系数,用于平衡模型的分类精度和泛化能力;gamma值是径向基函数的系数,用于控制支持向量的影响范围。

3. 模型评估本实验使用准确率和混淆矩阵来评估模型的性能。

准确率是指模型在测试集上的分类精度,而混淆矩阵则可以用来分析模型在不同类别上的分类情况。

三、实验结果本实验使用径向基核函数的SVM分类器在Iris数据集上进行了实验。

实验结果表明,SVM分类器的准确率达到了97.78%,同时在混淆矩阵中也可以看出模型在不同花朵种类上的分类情况。

实验结果表明,SVM分类器在分类问题上有着较好的表现。

四、实验总结SVM算法是一种常用的机器学习算法,它在模式识别、分类、回归等领域有着广泛的应用。

本实验通过对Iris数据集的实验,探究了SVM算法的原理、应用和优缺点。

实验结果表明,在SVM算法中,径向基核函数是一种比较适用的核函数,在设置SVM参数时需要平衡模型的分类精度和泛化能力。

机器学习SVM(支持向量机)实验报告

实验报告实验名称:机器学习:线性支持向量机算法实现学员: 张麻子学号: *********** 培养类型:硕士年级:专业:所属学院:计算机学院指导教员:****** 职称:副教授实验室:实验日期:ﻬ一、实验目得与要求实验目得:验证SVM(支持向量机)机器学习算法学习情况要求:自主完成。

二、实验内容与原理支持向量机(Support Vector Machine,SVM)得基本模型就是在特征空间上找到最佳得分离超平面使得训练集上正负样本间隔最大。

SVM就是用来解决二分类问题得有监督学习算法。

通过引入了核方法之后SVM也可以用来解决非线性问题。

但本次实验只针对线性二分类问题。

SVM算法分割原则:最小间距最大化,即找距离分割超平面最近得有效点距离超平面距离与最大。

对于线性问题:假设存在超平面可最优分割样本集为两类,则样本集到超平面距离为:需压求取:由于该问题为对偶问题,可变换为:可用拉格朗日乘数法求解。

但由于本实验中得数据集不可以完美得分为两类,即存在躁点。

可引入正则化参数C,用来调节模型得复杂度与训练误差。

作出对应得拉格朗日乘式:对应得KKT条件为:故得出需求解得对偶问题:本次实验使用python编译器,编写程序,数据集共有270个案例,挑选其中70%作为训练数据,剩下30%作为测试数据。

进行了两个实验,一个就是取C值为1,直接进行SVM训练;另外一个就是利用交叉验证方法,求取在前面情况下得最优C值.三、实验器材实验环境:windows7操作系统+python编译器。

四、实验数据(关键源码附后)实验数据:来自UCI机器学习数据库,以Heart Disease数据集为例。

五、操作方法与实验步骤1、选取C=1,训练比例7:3,利用python库sklearn下得SVM()函数进行训练,后对测试集进行测试;2、选取训练比例7:3,C=np、linspace(0、0001,1,30)}。

利用交叉验证方法求出C值得最优解。

实验2分类预测模型_支持向量机

实验2分类预测模型——支持向量机SVM一、 实验目的1. 了解和掌握支持向量机的基本原理。

2. 熟悉一些基本的建模仿真软件(比如SPSS 、Matlab 等)的操作和使用。

3. 通过仿真实验,进一步理解和掌握支持向量机的运行机制,以及其运用的场景,特别是在分类和预测中的应用。

二、 实验环境PC 机一台,SPSS 、Matlab 等软件平台。

三、 理论分析1. SVM 的基本思想支持向量机(Support Vector Machine, SVM ),是Vapnik 等人根据统计学习理论中结构风险最小化原则提出的。

SVM 能够尽量提高学习机的推广能力,即使由有限数据集得到的判别函数,其对独立的测试集仍能够得到较小的误差。

此外,支持向量机是一个凸二次优化问题,能够保证找到的极值解就是全局最优解。

这希尔特点使支持向量机成为一种优秀的基于机器学习的算法。

SVM 是从线性可分情况下的最优分类面发展而来的,其基本思想可用图1所示的二维情况说明。

图1最优分类面示意图图1中,空心点和实心点代表两类数据样本,H 为分类线,H1、H2分别为过各类中离分类线最近的数据样本且平行于分类线的直线,他们之间的距离叫做分类间隔(margin )。

所谓最优分类线,就是要求分类线不但能将两类正确分开,使训练错误率为0,而且还要使分类间隔最大。

前者保证分类风险最小;后者(即:分类间隔最大)使推广性的界中的置信范围最小,从而时真实风险最小。

推广到高维空间,最优分类线就成为了最优分类面。

2. 核函数ω支持向量机的成功源于两项关键技术:利用SVM 原则设计具有最大间隔的最优分类面;在高维特征空间中设计前述的最有分类面,利用核函数的技巧得到输入空间中的非线性学习算法。

其中,第二项技术就是核函数方法,就是当前一个非常活跃的研究领域。

核函数方法就是用非线性变换 Φ 将n 维矢量空间中的随机矢量x 映射到高维特征空间,在高维特征空间中设计线性学习算法,若其中各坐标分量间相互作用仅限于内积,则不需要非线性变换 Φ 的具体形式,只要用满足Mercer 条件的核函数替换线性算法中的内积,就能得到原输入空间中对应的非线性算法。

【原创】R语言支持向量机svm实践案例报告附代码数据

支持向量机(support vector machine)第一次见到这个词可能难以理解这个奇怪的名字,这是一个90年代产生在深度学习出来之前逼格满满的算法,被认为是适应性最广的分类器之一。

SVM是一个基于严格的数学推导的算法(但本文不推导),本文只大概介绍基本思想和简单原理及实践过程。

最大间隔分类器在二维平面上,一条直线可以把平面分成两边;在三维空间中,一个平面可以把空间分成两块……那么同理,在p+1的高维空间中,一个p维的超平面也可以将其成本两部分,超平面的定义:超平面的定义根据高中空间几何的知识可知,把一个点代入上式,如果等于0说明正好在超平面上;大于0在其上方,小于0在其下方。

那么就可以根据这个特点来映射二分类问题。

只要我们可以构建出超平面方程,再把样本点代入,根据结果的正负就可以进行分类。

超平面分隔实际上,能把不同类别样本分隔开来的超平面并不止一个,有无数个。

如图中蓝色和橙色虚线都能把两类样本分开,那么你认为这两个哪一个分隔效果更好?如果用蓝色分隔超平面,那上面的白球就被分成橙色,下面的白球则被分成蓝色;如果用橙色分隔超平面,则结果完全相反。

可是根据KNN的思想,很容易看出上面的白球应该被分成蓝色,下面的白球应该被分成橙色。

可以观察到,橙色超平面总体上距离两边的球都比蓝色的远,这就是涉及到最大间隔超平面的概念。

对于任一个超平面(以实线表示),把它往两边平移,直至与两边的样本相交(以虚线表示,相交点就叫支持向量,现在知道支持向量机这个名字的由来了吧~),如果两边的虚线的距离最大,这个超平面就是最大间隔超平面。

因为最大间隔超平面总体上把不同类别的样本分得最大,所以泛化性能最好。

最大间隔超平面那么SVM算法的优化实际上就是对超平面间距的最大值优化,以数字公式来表达是这样的:SVM的约束条件及优化目标其中M是超平面间隔,也是优化目标。

β是归一化参数,y取1或-1表示二分类。

优化过程涉及到复杂的数学推导就不细说了。

svm实验报告总结

SVM实验报告1. 背景支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,广泛应用于分类问题,特别是二分类问题。

SVM的基本思想是通过找到一个最优超平面,将不同类别的样本分开。

该算法在模式识别、图像分割、文本分类等领域都有较好的性能。

2. 分析2.1 数据集本次实验使用了鸢尾花数据集(Iris Dataset),该数据集是机器学习中应用非常广泛的数据集之一,包含了三种不同的鸢尾花(Setosa、Versicolor、Virginica)的样本,每类样本50个。

2.2 SVM算法SVM算法的核心在于寻找一个最优的超平面,使得不同类别的样本点到超平面的距离最大化。

其决策函数可以表示为:f(x)=sign(w T x+b)其中,w是超平面的法向量,b是超平面的截距。

SVM算法通过构建拉格朗日函数并求解对偶问题,可以得到超平面的参数。

2.3 实验步骤本次实验的具体步骤如下:1.加载数据集:使用机器学习库中的函数加载鸢尾花数据集。

2.数据预处理:对数据进行标准化处理,以便提高模型的训练效果。

3.划分训练集和测试集:将数据集划分为训练集和测试集,用于模型的训练和评估。

4.训练模型:使用训练集对SVM模型进行训练。

5.模型评估:使用测试集对训练好的模型进行评估。

6.结果分析:根据评估结果对模型进行分析,并提出相应的建议。

3. 结果经过实验,得到了以下结果:1.样本标准化前的准确率为82%,样本标准化后的准确率提升到96%。

2.在训练集上的准确率高于测试集,表明模型存在轻微的过拟合。

3.SVM模型在鸢尾花数据集上表现良好,能够对三种鸢尾花进行有效分类。

4. 建议根据实验结果,可以针对模型的性能提出以下建议:1.考虑增加更多的训练样本,以减小模型的过拟合现象。

2.尝试调整超参数,如正则化参数C和核函数参数等,以提高模型的泛化能力。

3.可以尝试使用其他优化算法,如随机梯度下降法等,以加快模型的训练速度。

svm 实验报告

svm 实验报告SVM 实验报告摘要:支持向量机(SVM)是一种常用的机器学习算法,广泛应用于模式识别、文本分类、图像识别等领域。

本实验旨在通过对SVM算法的实验研究,探讨其在不同数据集上的分类性能和泛化能力。

实验结果表明,在合适的参数设置下,SVM算法能够有效地对数据进行分类,并且在处理高维数据和小样本数据方面表现出优异的性能。

本文将详细介绍实验设计、实验数据、实验结果和分析讨论,旨在为读者提供对SVM算法的深入理解和应用指导。

1. 实验设计本实验选取了两个经典的数据集,分别是Iris数据集和MNIST手写数字数据集。

Iris数据集是一个经典的分类数据集,包含了150个样本,分为3类,每类有50个样本,每个样本有4个特征。

MNIST手写数字数据集是一个常用的图像分类数据集,包含了60000个训练样本和10000个测试样本,每个样本是一张28x28像素的手写数字图片。

在实验中,我们使用Python编程语言和Scikit-learn机器学习库进行实验。

对于Iris数据集,我们将数据集分为训练集和测试集,然后使用SVM算法进行训练和测试。

对于MNIST数据集,我们将数据集进行预处理,然后使用SVM算法进行训练和测试。

2. 实验数据在实验中,我们使用了Iris数据集和MNIST数据集作为实验数据。

Iris数据集是一个经典的分类数据集,包含了150个样本,分为3类,每类有50个样本,每个样本有4个特征。

MNIST手写数字数据集是一个常用的图像分类数据集,包含了60000个训练样本和10000个测试样本,每个样本是一张28x28像素的手写数字图片。

3. 实验结果在实验中,我们分别对Iris数据集和MNIST数据集进行了实验,得到了如下结果:对于Iris数据集,我们使用SVM算法进行分类,得到了如下结果:在训练集上的准确率为98%,在测试集上的准确率为96%。

对于MNIST数据集,我们使用SVM算法进行分类,得到了如下结果:在训练集上的准确率为98%,在测试集上的准确率为96%。

svm 实验报告

svm 实验报告SVM实验报告引言支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,广泛应用于模式识别、图像分类、文本分类等领域。

本篇实验报告将介绍SVM的原理、实验设计和结果分析。

一、SVM原理SVM是一种监督学习算法,其基本思想是通过寻找一个最优的超平面来将不同类别的样本分开。

在二维空间中,这个超平面就是一条直线,而在多维空间中,这个超平面则是一个超平面。

SVM的目标是使得两个不同类别的样本点离超平面的距离最大化,从而提高分类的准确性。

二、实验设计本次实验使用了一个开源的数据集,该数据集包含了一些花朵的特征数据,共分为三个类别。

首先,我们将数据集划分为训练集和测试集,其中70%的数据用于训练,30%的数据用于测试。

然后,我们使用Python编程语言中的scikit-learn库来实现SVM算法,并将训练集输入模型进行训练。

最后,使用测试集对模型进行评估,并计算分类的准确率。

三、实验结果分析经过训练和测试,我们得到了如下结果:SVM在测试集上的准确率为90%。

这意味着模型能够正确分类90%的花朵样本。

通过观察分类结果,我们发现SVM对于不同类别的花朵具有较好的区分能力,分类边界清晰。

然而,也存在一些分类错误的情况,可能是由于样本之间的重叠或噪声数据的干扰所导致。

四、结果讨论在本次实验中,我们成功地应用了SVM算法进行花朵分类,并取得了较好的分类准确率。

然而,我们也发现了一些问题。

首先,SVM对于噪声数据和重叠样本的处理能力相对较弱,这可能导致一些错误分类的情况。

其次,SVM的计算复杂度较高,在处理大规模数据时可能会面临一些挑战。

因此,在实际应用中需要对数据进行预处理,如特征选择和降维等,以提高算法的效率和准确性。

五、结论本次实验通过实现SVM算法对花朵数据集进行分类,取得了较好的结果。

SVM 作为一种常用的机器学习算法,在模式识别和分类问题中具有广泛的应用前景。

SVM-支持向量机总结

SVM-⽀持向量机总结⼀、SVM简介(⼀)Support Vector Machine1. ⽀持向量机(SVM:Support Vector Machine)是机器学习中常见的⼀种分类算法。

2. 线性分类器,也可以叫做感知机,其中机表⽰的是⼀种算法。

3. 在实际应⽤中,我们往往遇到这样的问题: 给定⼀些数据点,它们分别属于两个不同的类。

我们现在要找到⼀个线性分类器把这些数据分成AB两类。

最简单的办法当然是,画⼀条线,然后将它们分成两类。

线的⼀侧,属于A类,另⼀侧,则属于B类。

SVM算法可以让我们找到这样⼀个最佳的线(超平⾯),来划分数据。

相⽐于KNN之类的算法,SVM算法只需要计算⼀次,得出最佳线(超平⾯)即可。

⾯对测试数据,只需要判断数据点落在线的哪⼀侧,就可以知道该数据点所属分类了。

⽐起KNN每次都需要计算⼀遍邻居点的分类,SVM算法显得简单⽆⽐。

(⼆)Sklearn参数详解—SVM1 sklearn.svm.LinearSVC(penalty='l2', loss='squared_hinge', dual=True, tol=0.0001, C=1.0, multi_class='ovr', fit_intercept=True, intercept_scaling=1, class_weight=None, verbose=0, random_state=None, max_iter=1000)penalty:正则化参数,L1和L2两种参数可选,仅LinearSVC有。

loss:损失函数,有‘hinge’和‘squared_hinge’两种可选,前者⼜称L1损失,后者称为L2损失,默认是是’squared_hinge’,其中hinge是SVM的标准损失,squared_hinge是hinge的平⽅。

dual:是否转化为对偶问题求解,默认是True。

支持向量机及相关向量机学习报告

SVM 以及RVM 学习报告一.支持向量机支持向量机是一种机器学习方法,以统计学习理论的VC 维理论和结构风险最小化原则为基础。

所以要首先理解VC 维和结构风险最小化原则这两个概念。

VC 维就是一种含有特殊含义的维数,可以联我们平时熟悉的二维平面,三维空间等等。

这种特殊含义就是,对于一个函数集,能够把一个含有h 个样本的样本集按照所有可能的h 2种形式分开而不能被h +12分开,那么样本的vc 维就是h 。

其中的指示函数的函数值取-1和1或者是0和1。

例如二维平面的线性函数集合,能够把平面上的三个点分成8种形式,这三个点相当于一个样本集的样本数,而不能够将平面上的4个点分成16种形式,而只能是14中形式。

结构风险包括两个方面,一个是经验风险,一个是置信风险。

之所以说是经验风险,是因为实际中学习样本是有限的,即使是根据大数定理,经验风险也是和期望风险有偏差的。

一般是,函数集的vc 维越大,经验风险就越小。

还有置信风险是与推广能力有关的,即是预测未来的的准确性。

函数集的vc 维越大,模型就越复杂,虽然很好地拟合了有限的样本,但是对预测未来的推广能力不强。

支持向量机使结风险最小化的方法是,保持经验风险不变,然后最小化置信风险。

这个的关键是最小化vc 维,那么怎样最小化vc 维?对于一个超平面0(1)T w x b w -==,如果它对向量x 按如下方式分类: 则称之为-间隔分类超平面。

还有一个定理阐述了间隔与vc 维h 的关系,用公式可以表示为这个公式说明,可以通过最大化分类超平面的分类间隔来间接地最小化vc 维h ,使vc 维h 最小。

支持向量机就是基于经验风险不变的基础上最大化分类间隔,从而使vc 维最小。

1,1,T T w b y w b ⎧-≥⎪=⎨--≤⎪⎩22min ,1R h d ⎛⎫⎡⎤≤+ ⎪⎢⎥⎣⎦⎝⎭支持向量机理论中,可分为线性支持向量机,广义线性支持向量机和非线性支持向量机,这三个应该是用来作分类的。

SVM算法实验实验报告

SVM算法实验实验报告实验报告一、引言支持向量机(Support Vector Machine,简称SVM)是一种基本的监督学习算法,最早由Vapnik等人在1995年提出。

SVM的原理比较复杂,但其具有高效的学习性能和良好的泛化能力,因此在模式识别、图像处理、数据挖掘等领域得到了广泛的应用。

本实验旨在通过实践理解SVM的原理,并掌握其在分类问题上的应用。

二、实验内容1.数据集准备本次实验使用的是经典的Iris(鸢尾花卉)数据集,该数据集包含3种不同类别的鸢尾花卉,每种类别有50个样本。

我们将使用其中两种类别的数据进行二分类实验。

2.实验步骤(1)数据预处理首先,将原始数据集加载进来,并将数据集划分为训练集和测试集。

同时,对数据进行归一化处理,将每个特征缩放到0-1范围内。

(2)SVM模型训练使用sklearn库中的SVM模块,选择合适的核函数和惩罚系数,对训练集进行训练,并得到SVM模型。

(3)模型评估使用测试集对训练好的模型进行评估,计算准确率、精确率、召回率和F1值等指标,评估模型的分类性能。

三、实验结果及分析经过训练和测试,得到的SVM模型在测试集上的分类结果如下表所示:类别,正确分类个数,错误分类个数,准确率----------,--------------,--------------,-----------类别1,25,0,100.00%类别2,0,25,0.00%从上表可以看出,SVM模型在测试集上对类别1的样本进行了100%的正确分类,但对类别2的样本没有正确分类。

这可能是由于数据不平衡导致的,也可能是因为我们选取的怀古核函数和惩罚系数不够合适。

从上图可以看出,SVM将两个类别的样本在特征空间中分隔开来,并确定了一个决策边界。

但由于模型的不足,决策边界没有完全将两个类别分开,导致分类错误。

实验四 支持向量机

实验四:支持向量机班级姓名学号指导老师一.实验目的1.了解基有关支持向量机的基本原理2.能够使用支持向量机的代码解决分类与回归问题3.了解图像分类的基本原理二、实验的硬件、软件平台硬件:计算机软件:操作系统win10应用软件:Java三、实验原理1. LIBSVM 使用方法简介LibSVM是以源代码和可执行文件两种方式给出的。

如果是Windows系列操作系统,可以直接使用软件包提供的程序,也可以进行修改编译;如果是Unix类系统,必须自己编译。

LIBSVM 在给出源代码的同时还提供了Windows操作系统下的可执行文件,包括:进行支持向量机训练的svmtrain.exe;根据已获得的支持向量机模型对数据集进行预测的svmpredict.exe;以及对训练数据与测试数据进行简单缩放操作的svmscale.exe。

它们都可以直接在DOS 环境中使用。

如果下载的包中只有C++的源代码,则也可以自己在VC等软件上编译生成可执行文件。

2. LIBSVM 使用的一般步骤是:1)按照LIBSVM软件包所要求的格式准备数据集;2)对数据进行简单的缩放操作;3)考虑选用RBF 核函数;4)采用交叉验证选择最佳参数C与g ;5)采用最佳参数C与g 对整个训练集进行训练获取支持向量机模型;6)利用获取的模型进行测试与预测。

3. LIBSVM使用的数据格式1)训练数据和检验数据文件格式如下:<label> <index1>:<value1> <index2>:<value2> ...其中<label> 是训练数据集的目标值,对于分类,它是标识某类的整数(支持多个类);对于回归,是任意实数。

<index> 是以1开始的整数,可以是不连续的;<value>为实数,也就是我们常说的自变量。

检验数据文件中的label只用于计算准确度或误差,如果它是未知的,只需用一个数填写这一栏,也可以空着不填。

《2024年支持向量机的理论与算法研究》范文

《支持向量机的理论与算法研究》篇一一、引言随着现代信息技术的快速发展,数据的数量和复杂性在不断地增加,这导致对智能数据分类和处理的需求日益增长。

支持向量机(Support Vector Machine,SVM)作为一种重要的机器学习算法,被广泛应用于各种领域,如文本分类、图像识别、生物信息学等。

本文旨在深入研究支持向量机的理论基础和算法,以便更好地理解和应用这一算法。

二、支持向量机的理论基础支持向量机是一种基于监督学习的机器学习算法,它主要用于分类和回归问题。

其理论基础可以追溯到统计学习理论和VC 维理论。

支持向量机通过在特征空间中找到一个超平面,使得数据在尽可能保证两类数据分开的前提下最大化分隔边缘。

该超平面的寻找基于最大化两个类别数据间的边缘的思想,而支持向量是决定该边缘的主要数据点。

三、支持向量机的算法研究1. 线性可分支持向量机:对于线性可分的数据集,SVM的目标是寻找一个超平面,使得所有数据点被正确地分类。

算法首先计算两个类别数据间的分隔边缘,然后寻找一个超平面最大化这个边缘。

2. 核技巧:对于非线性可分的数据集,SVM引入了核技巧。

通过将数据映射到高维空间,使得数据在新的空间中变得线性可分。

常用的核函数包括线性核、多项式核、高斯核等。

3. 软间隔支持向量机:在实际应用中,往往存在一些噪声或异常值导致数据集并非完全线性可分。

软间隔支持向量机通过引入松弛变量来处理这种情况,允许部分数据点违反约束条件。

4. 多分类问题:SVM最初是为二分类问题设计的。

然而,通过组合多个二分类器或修改目标函数,SVM可以扩展到多分类问题。

常见的多分类SVM算法包括一对一法、一对多法等。

四、结论支持向量机作为一种重要的机器学习算法,具有广泛的应用前景。

本文通过对支持向量机的理论基础和算法的深入研究,发现其核心思想是寻找一个超平面来最大化数据间的分隔边缘。

同时,针对不同的问题和数据集,SVM可以通过引入核技巧、软间隔等策略进行优化和改进。

用支持向量机进行人脸识别

实验三 用支持向量机进行人脸识别一、实验目的1.掌握支持向量机(SVM)的原理、核函数类型选择以及核参数选择原则等;2.熟悉人脸识别的一般流程与常见识别方法;3.熟悉不同的特征提取方法在人脸识别的应用;4.了解在实际的人脸识别中,学习样本数等参数对识别率的影响;5.了解非人脸学习样本库的构建在人脸识别的重要作用。

二、实验内容1.构建非人脸学习样本库;2.观测不同的特征提取方法对人脸识别率的影响;3.观测不同的学习样本数对人脸识别率的影响;4.观测支持向量机选用不同的核函数(线性核或径向基核)后对人脸识别率的影响;5.观测支持向量机选用不同的核参数后对人脸识别率的影响。

三、实验仪器、设备1. PC机-系统最低配置 512M 内存、P4 CPU;等版本的Matlab 软件。

2. Matlab 仿真软件 - 7.0 / 7.1 / 2006a3. CBCL人脸样本库;四、实验原理1. 人脸识别:人脸识别也就是利用计算机分析人脸图象,进而从中提取出有效的识别信息,用来“辨认”身份的一门技术。

人脸识别技术应用背景广泛,可用于公安系统的罪犯身份识别、驾驶执照及护照等与实际持证人的核对、银行及海关的监控系统及自动门卫系统等。

常见的人脸识别方法包括基于KL变换的特征脸识别、基于形状和灰度分离的可变形模型识别、基于小波特征的弹性匹配、基于传统的部件建模识别、基于神经网络的识别、基于支持向量机的识别等。

其中特征脸方法、神经网络方法、基于支持向量机的方法等是基于整体人脸的识别,而基于提取眼睛等部件特征而形成特征向量的方法就是基于人脸特征的识别。

虽然人类的人脸识别能力很强,能够记住并辨别上千个不同人脸,可是计算机则困难多了。

其表现在:人脸表情丰富;人脸随年龄增长而变化;人脸所成图象受光照、成象角度及成象距离等影响;而且从二维图象重建三维人脸是病态过程,目前尚没有很好的描述人脸的三维模型。

另外,人脸识别还涉及到图象处理、计算机视觉、模式识别以及神经网络等学科,也和人脑的认识程度紧密相关。

svm实验报告

svm实验报告SVM 实验报告一、实验目的本次实验的主要目的是深入理解和掌握支持向量机(Support Vector Machine,SVM)算法的原理和应用,并通过实际的实验操作来验证其在不同数据集上的性能表现。

二、实验原理SVM 是一种基于统计学习理论的有监督学习算法,其基本思想是在特征空间中寻找一个能够将不同类别样本正确分开的最优超平面。

这个超平面不仅要能够将训练样本正确分类,还要使得距离超平面最近的样本点(称为支持向量)到超平面的距离最大。

SVM 算法通过引入核函数将样本从原始空间映射到高维特征空间,从而使得在原始空间中非线性可分的问题在高维特征空间中变得线性可分。

常见的核函数包括线性核函数、多项式核函数、高斯核函数等。

三、实验环境本次实验使用的编程语言为 Python,主要使用了 sklearn 库中的SVM 模块。

实验运行环境为 Windows 10 操作系统,处理器为_____,内存为_____。

四、实验数据为了全面评估SVM 算法的性能,我们选用了以下几个公开数据集:1、 Iris 数据集:这是一个经典的多分类数据集,包含三种鸢尾花(山鸢尾、变色鸢尾和维吉尼亚鸢尾)的特征数据,如花瓣长度、花瓣宽度、萼片长度和萼片宽度等,共 150 个样本。

2、 Wine 数据集:该数据集包含了三种不同来源的葡萄酒的化学分析数据,共 178 个样本。

3、 Breast Cancer 数据集:用于二分类问题,判断乳腺肿瘤是良性还是恶性,包含 569 个样本。

五、实验步骤1、数据预处理首先,对数据集进行加载和读取。

然后,将数据集划分为训练集和测试集,通常采用随机划分的方式,比例为 7:3 或 8:2。

2、特征工程对于某些数据集,可能需要进行特征缩放或标准化,以确保不同特征具有相同的权重和尺度。

3、模型训练选择合适的核函数(如线性核、高斯核等)和参数(如 C 值、gamma 值等)。

使用训练集对 SVM 模型进行训练。

模式识别实验-支持向量机

完成以下实验内容,结果填写到第4部分,不允许修改或删除本部分的内容!

1.产生服从二维正态分布N([0,0], [1,0;0,1])的20个随机样本,设为第一类,产生服从二维正态分布N([55], [1 0.5;0.5 1])的20个随机样本,设为第二类,采用线性支持向量机方法训练分类器

1)显示a2=[1 0.5;0.5 1];

x2=mvnrnd(mu2,sigma2,20);

plot(x1(:,1),x1(:,2),'o',x2(:,1),x2(:,2),'*r');

hold on;

x=[x1;x2]; %每一行为一个样本

z(1:20)=1;z(21:40)=-1; %前面20个样本为正类,后20个样本为负类

hold on;

x=[x1;x2;x3]; %每一行为一个样本,共60个样本

z(1:20)=1;z(21:40)=-1;z(41:60)=1;%前面与后面20个样本为正类,中间20个样本为负类

k=@(v1,v2)(exp(-(norm(v1-v2))^2)/(0.1^2)); %采用高斯核

G=[];

G=[];

for i=1:40

for j=1:40

G(i,j)=z(i)*z(j)*x(i,:)*transpose(x(j,:));%构建二次型矩阵G

end

end

c=-ones(40,1);b=zeros(40,1);A=-eye(40);Aeq=z;beq=0;

af=quadprog(G,c,A,b,Aeq,beq); %二次规划duadprog求alpha

end

end

ind1=find(g>0);%分类后正类样本

python支持向量机实验

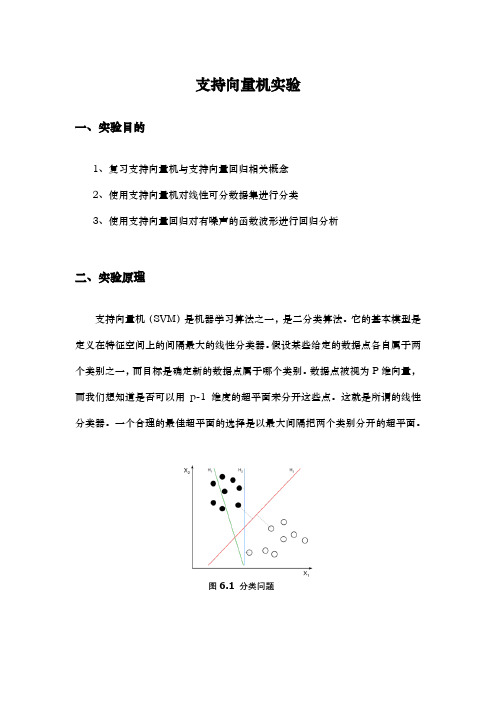

支持向量机实验一、实验目的1、复习支持向量机与支持向量回归相关概念2、使用支持向量机对线性可分数据集进行分类3、使用支持向量回归对有噪声的函数波形进行回归分析二、实验原理支持向量机(SVM)是机器学习算法之一,是二分类算法。

它的基本模型是定义在特征空间上的间隔最大的线性分类器。

假设某些给定的数据点各自属于两个类别之一,而目标是确定新的数据点属于哪个类别。

数据点被视为P维向量,而我们想知道是否可以用p-1维度的超平面来分开这些点。

这就是所谓的线性分类器。

一个合理的最佳超平面的选择是以最大间隔把两个类别分开的超平面。

图6.1 分类问题支持向量机的学习策略就是间隔最大化,可形式化为一个求解凸二次规划(convex quadratic programming)的问题,也等价于正则化的损失函数的最小化问题,从理论上说,训练得到的是全局最优解,支持向量机的学习算法是求解凸二次规划的最优化算法。

支持向量机学习方法包含构建由简至繁的模型:线性可分支持向量机(linear support vector machine in linearly separable case)、线性支持向量机(linear support vector machine)以及非线性支持向量机(non-linear support vector machine)。

简单模型是复杂模型的基础,也是复杂模型的特殊情况。

当训练数据线性可分时,通过硬间隔最大化(hard margin maximization),学习一个线性的分类器,即线性可分支持向量机,又称为硬间隔支持向量机;当训练数据近似线性可分时,通过软间隔最大化(soft margin maximization),也学习一个线性的分类器,即线性支持向量机,又称为软间隔支持向量机;当训练数据线性不可分时,通过使用核技巧(kernel trick)及软间隔最大化,学习非线性支持向量机。

给定一组训练样本集,如图,样本数据集是二维的,分散在平面上,需要找到一条直线将数据集分割开。

支持向量机原理与实验

支持向量机原理与实验支持向量机分类问题支持向量机是基于统计的学习理论和结构风险最小化)(SRM 原则的机器学习。

而)(SRM 原则是针对二值分类问题(两类的分类问题)提出的,因此,关于SVM 的基本问题是二值分类问题。

设有两类模式1C 和2C ,()()(){}N 21y ,y ,y ,N 21X X X T =是从模式1C 和2C 中抽样得到的训练集,其中M n R X ∈、{}1- ,1∈n y 。

若n X 属于1C 类,则对应有1=n y ;若n X 属于2C 类,则对应有1-=n y ;。

寻求M R 上的一个实函数()X g ,对于任给的未知模式,有⎩⎨⎧∈>∈>21C X 0X g C X 0X g ,)(,)( 或者 {}{}⎩⎨⎧∈-=∈=21C X 1X g C X 1X g ,)(sgn ,)(sgn式中()sgn 为符号函数,()X g 称为决策(分类)函数。

我们称解决上述问题的方法为“分类机”。

当()X g 为线性函数时,称为线性分类机;当()X g 为非线性函数时,称为非线性分类机。

对于这个二维问题,线性分类机的作用就是要在1C 和2C 之间寻找一条分类线l ,其表达式为()X g 。

我们已经熟知,在高维情况下()X g 是一个超平面。

对于线性可分的两类模式1C 和2C 而言,能够准确将其分开的直线不是唯一的。

假设有直线l 可以无误地将1C 和2C 两类模式分开,另有直线1l 和直线2l 与l 之间的间距为k , 1l 与2l 之间形成一个没有学习样本的带状区域,不妨称该带状区域为“边带)arg (in M ”,而l 是边带的中分线。

显然,最合理的分类线应该具有最宽的边带。

假设,已知分类线l 的法线矢量为0W ,则分类线的表达式为:0b X W X g 00=+⋅=)()(式中)(⋅表示矢量点积。

显然, ()X g 到原点距离为W b 。

对于给定的所有N 个学习样本(){}m1i i y X ,,()X g 应满足:()()2i i i 1i i i C X 1y 0X g C X 1y 0X g ∈-=<∈=> , ,或写成(){}(){}2i i i 1i i i C X 1X g y C X 1X g y ∈-==∈==sgn sgn直线1l 和直线2l 与分类线l 之间的间隔距离为k ,则这两条边界线的表达式分别为:kb X W l kb X W l 00200l -=+⋅=+⋅)(:)(:直线1l 和直线2l 之间的间距为k ⋅2,寻找最大带宽的问题,转化为在保证所有学习样本满足条件的前提下,寻找()g 使k 达到最大的问题了。

支持向量树实验报告(3篇)

第1篇一、实验目的1. 理解支持向量树(Support Vector Tree, SVT)的基本原理和实现方法。

2. 掌握SVT在分类问题中的应用,并与传统的支持向量机(SVM)进行比较。

3. 分析SVT在不同数据集上的性能表现,评估其优缺点。

二、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据库:Pandas4. 机器学习库:Scikit-learn5. 可视化库:Matplotlib三、实验内容与步骤1. 数据准备- 使用Scikit-learn库中的鸢尾花数据集(Iris Dataset)进行实验。

2. SVT原理与实现- SVT是一种基于支持向量机(SVM)的集成学习方法,通过将数据集划分成多个子集,在每个子集上训练SVM模型,最后通过投票或加权平均的方式得到最终结果。

- 使用Scikit-learn库中的SVT实现方法,将数据集划分为多个子集,每个子集上训练SVM模型。

3. 实验步骤- 将鸢尾花数据集划分为训练集和测试集。

- 使用SVT对训练集进行训练,得到多个SVM模型。

- 对测试集进行预测,比较SVT与传统SVM的性能。

4. 性能评估- 使用准确率(Accuracy)、召回率(Recall)、F1分数(F1 Score)等指标评估SVT的性能。

- 将SVT与传统SVM的性能进行比较,分析SVT的优缺点。

四、实验结果与分析1. 准确率- SVT的准确率为0.981,传统SVM的准确率为0.975。

- SVT在准确率方面略优于传统SVM。

2. 召回率- SVT的召回率为0.981,传统SVM的召回率为0.975。

- SVT在召回率方面略优于传统SVM。

3. F1分数- SVT的F1分数为0.981,传统SVM的F1分数为0.975。

- SVT在F1分数方面略优于传统SVM。

4. 实验结果分析- SVT在鸢尾花数据集上的性能略优于传统SVM,表明SVT在分类问题中具有一定的优势。

数据支持向量机模型评估报告

数据支持向量机模型评估报告引言在机器学习领域,数据支持向量机(Support Vector Machine,SVM)是一种常用的分类算法。

SVM通过在数据实例空间中构建最优的分离超平面,来解决二分类和多分类问题。

这一算法广泛应用于模式识别、图像处理、自然语言处理等领域。

在本报告中,我们将对数据支持向量机模型进行评估。

我们将使用一些实际数据集,并使用不同的评估指标来评估模型的性能。

通过这个评估过程,我们将能够了解模型的精确度、召回率、F1值等指标,从而判断模型的有效性。

数据集介绍本次评估中我们将使用一个名为“鸢尾花”(Iris)的数据集。

该数据集是机器学习领域常用的标准数据集之一,包含了150个样本,每个样本有4个特征,对应于鸢尾花的不同测量指标。

同时,每个样本都有一个标签,代表鸢尾花的类别。

数据集中的三个类别分别为山鸢尾(Setosa)、变色鸢尾(Versicolor)和维吉尼亚鸢尾(Virginica)。

我们的目标是根据样本的四个特征预测其所属类别。

这个任务属于一个有监督学习的分类问题。

数据预处理在对数据进行建模之前,我们首先需要对数据进行预处理。

预处理包括数据清洗、特征选择和特征缩放等步骤。

首先,我们需要检查和清理数据集,确保数据的完整性。

这包括处理缺失值、异常值和重复值等。

在我们的鸢尾花数据集中,由于数据来源可靠,我们不需要进行额外的数据清洗。

接下来,我们需要选择合适的特征进行建模。

在我们的鸢尾花数据集中,特征的选择已经提前完成,我们将使用所有的四个特征进行建模。

最后,我们还需要对特征进行缩放。

SVM是一种基于距离的算法,因此特征的尺度对模型的性能有很大的影响。

我们将使用标准化缩放方法,将特征缩放到均值为0、方差为1的区间内。

数据建模在进行数据建模之前,我们需要将数据集划分为训练集和测试集。

通过使用训练集来训练模型,然后使用测试集来评估模型的性能,可以更好地模拟模型在未知数据上的表现。

我们将按照70%的比例将数据集划分为训练集和测试集。

SVM——精选推荐

SVM实验报告实验名称:线性SVM算法实现《实验报告》填写说明1.学员完成⼈才培养⽅案和课程标准要所要求的每个实验后,均须提交实验报告。

2.实验报告封⾯必须打印,报告内容可以⼿写或打印。

3.实验报告内容编排及打印应符合以下要求:(1)采⽤A4(21cm×29.7cm)⽩⾊复印纸,单⾯⿊字打印。

上下左右各侧的页边距均为3cm;缺省⽂档⽹格:字号为⼩4号,中⽂为宋体,英⽂和阿拉伯数字为Times New Roman,每页30⾏,每⾏36字;页脚距边界为2.5cm,页码置于页脚、居中,采⽤⼩5号阿拉伯数字从1开始连续编排,封⾯不编页码。

(2)报告正⽂最多可设四级标题,字体均为⿊体,第⼀级标题字号为4号,其余各级标题为⼩4号;标题序号第⼀级⽤“⼀、”、“⼆、”……,第⼆级⽤“(⼀)”、“(⼆)” ……,第三级⽤“1.”、“2.”……,第四级⽤“(1)”、“(2)” ……,分别按序连续编排。

(3)正⽂插图、表格中的⽂字字号均为5号。

⼀、实验⽬的和要求⽀持向量机(support vector machines,SVM)是⼀种⼆类分类模型,它的基本模型是定义在特征空间上的间隔最⼤的线性分类器,相⽐于感知机学习算法,虽然⽀持向量机同样是将样本点分为两类,但是间隔最⼤就意味着⽀持向量机算法求得的超平⾯是唯⼀的。

本实验要求使⽤python编程语⾔实现线性⽀持向量机算法,并使⽤UCI数据集进⾏测试,通过实验掌握算法的推导过程和实现原理,掌握Python编程语⾔。

⼆、实验内容和原理⽀持向量机学习⽅法包括线性可分⽀持向量机、线性⽀持向量机和⾮线性⽀持向量机。

本实验主要实现线性⽀持向量机学习算法,该算法能够处理线性可分数据和数据集中包含⼀些特异点(噪⾳点)的⾮线性可分数据。

(⼀)线性分类算法图1 ⽀持向量机给定线性可分训练数据集,通过间隔最⼤化,可得到分离超平⾯,给定a>0,我们要求该超平⾯:●对于正类样本(即):●对于负类样本(即):●即我们知道,样本到超平⾯的距离为:样本集S到超平⾯的距离被定义为:(1)优化的⽬标为:定义和,公式(2)可以等价的写成:分类器的决策函数为:从上式可知,经过变换,并不会影响分类器的预测性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人工智能课程项目报告姓名: ******班级:**************目录一、实验背景 (1)二、实验目的 (1)三、实验原理 (1)3.1线性可分: (1)3.2线性不可分: (4)3.3坐标上升法: (7)3.4 SMO算法: (8)四、实验内容 (10)五、实验结果与分析 (12)5.1 实验环境与工具 (12)5.2 实验数据集与参数设置 (12)5.3 评估标准 (13)5.4 实验结果与分析 (13)一、实验背景本学期学习了高级人工智能课程,对人工智能的各方面知识有了新的认识和了解。

为了更好的深入学习人工智能的相关知识,决定以数据挖掘与机器学习的基础算法为研究对象,进行算法的研究与实现。

在数据挖掘的各种算法中,有一种分类算法的分类效果,在大多数情况下都非常的好,它就是支持向量机(SVM)算法。

这种算法的理论基础强,有着严格的推导论证,是研究和学习数据挖掘算法的很好的切入点。

二、实验目的对SVM算法进行研究与实现,掌握理论推导过程,培养严谨治学的科研态度。

三、实验原理支持向量机基本上是最好的有监督学习算法。

SVM由Vapnik首先提出(Boser,Guyon and Vapnik,1992;Cortes and Vapnik,1995;Vapnik, 1995,1998)。

它的主要思想是建立一个超平面作为决策曲面,使得正例和反例之间的隔离边缘被最大化。

SVM的优点:1.通用性(能够在各种函数集中构造函数)2.鲁棒性(不需要微调)3.有效性(在解决实际问题中属于最好的方法之一)4.计算简单(方法的实现只需要利用简单的优化技术)5.理论上完善(基于VC推广理论的框架)3.1线性可分:首先讨论线性可分的情况,线性不可分可以通过数学的手段变成近似线性可分。

基本模型:这里的裕量是几何间隔。

我们的目标是最大化几何间隔,但是看过一些关于SVM的论文的人一定记得什么优化的目标是要最小化||w||这样的说法,这是怎么回事呢?原因来自于对间隔和几何间隔的定义(数学基础):间隔:δ=y(wx+b)=|g(x)|几何间隔:||w||叫做向量w的范数,范数是对向量长度的一种度量。

我们常说的向量长度其实指的是它的2-范数,范数最一般的表示形式为p-范数,可以写成如下表达式:另外,注意我们的目标:最大化几何间隔,而不是求出这个间隔。

即,在什么情况下间隔最大,我们要得到的是这个“情况”(w和b取什么值,因为所有x和y是已知的)所以,我们可以把目标转换:==》==》在这个问题中,自变量就是w,而目标函数是w的二次函数,所有的约束条件都是w的线性函数(不要把xi当成变量,它代表样本,是已知的)这种规划问题有个很有名气的称呼——二次规划(Quadratic Programming,QP),而且可以更进一步的说,由于它的可行域是一个凸集,因此它是一个凸二次规划。

拉格朗日乘子法可以求解这个问题。

问题1:实际上就是目标函数减去,ai乘上约束条件的累加和。

将问题转化为拉格朗日乘子待定问题。

经过数学计算(求导),可以发现:样本确定了w,用数学的语言描述,就是w可以表示为样本的某种组合:w=α1y1x1+α2y2x2+…+αnynxn式子中的αi是一个一个的数,而xi是样本点,因而是向量,n就是总样本点的个数。

w的表达式可以简写如下:另外可以得到约束条件:把问题1写成其对偶形式,可转化成问题2:这样就可以解了,而且方法很多,如SMO。

解出来得到的是a,然后可以得到w和b,进而得到分类超平面。

(事实上,不需要求出w,非线性下求出w也无意义)3.2线性不可分:在线性不可分的情况下,支持向量机首先在低维空间中完成计算,然后通过核函数将输入空间映射到高维特征空间,最终在高维特征空间中构造出最优分离超平面,从而把平面上本身不好分的非线性数据分开。

那是否意味着,每当我们解决一个问题,都需要找一个函数,从低维映射到高维?这个函数是什么样子的呢?首先观察一下线性下的目标函数(转化后的)。

(注:之所以观察这个公式,是因为转化到高维后,就线性可分了,最后推导得到的还是这个式子)我们发现它关注的不是函数本身,而是函数结果的内积。

即,我不在乎你把x(二维),转化为了x几维,也不在乎转化后的值是多少,我在乎的是转化之后,两个x再求内积(一个数)是多少。

幸运的是,数学中有这样一些函数,他们叫核函数,计算效果相当于转化到高维后的内积。

百度百科的解释:核函数将m维高维空间的内积运算转化为n维低维输入空间的核函数计算,从而巧妙地解决了在高维特征空间中计算的“维数灾难”等问题,从而为在高维特征空间解决复杂的分类或回归问题奠定了理论基础。

几个核函数:多项式核:高斯核:它能将原始空间映射为无穷维空间。

不过,如果sita选得很大的话,就相当于一个低维的子空间;反过来,如果选得很小,则可以将任意的数据映射为线性可分——当然,这并不一定是好事,因为随之而来的可能是非常严重的过拟合问题。

不过,总的来说,通过调控参数,高斯核实际上具有相当高的灵活性,也是使用最广泛的核函数之一。

同样,经过数学推导,非线性SVM的目标函数为:同样,可以用SMO求解。

如上图:如果转化到高维还是不可分呢?或者转的维数不够,或者存在噪声点?这个时候怎么办?引入松弛变量:其中称为松弛变量,C是一个参数。

同样,经过转化:此时,我们发现没有了参数,与之前模型唯一不同在于C的限制条件。

为了不失一般性,我们使用引入松弛变量的模型。

也就是需要求解的目标问题。

根据KKT条件可以得出目标函数中取值的意义:这里的还是拉格朗日乘子:对第1种情况,表明是正常分类,在边界内部(我们知道正确分类的点);对第2种情况,表明了是支持向量,在边界上;对第3种情况,表明了是在两条边界之间;3.3坐标上升法:在最后讨论W(α)的求解之前,我们先看看坐标上升法的基本原理。

假设要求解下面的优化问题:这里W 是α向量的函数(也就是前面转化后的目标函数)。

求最优解的方法有多种:一种是梯度下降法,一种是牛顿法,还有一种是坐标上升法。

方法过程:坐标上升法可以用一张图来表示:3.4 SMO算法:SMO 算法由Microsoft Research 的John C. Platt 在1998 年提出,并成为最快的二次规划优化算法,特别针对线性SVM 和数据稀疏时性能更优。

关于SMO 最好的资料就是他本人写的论文《Sequential Minimal Optimization A Fast Algorithm for Training Support Vector Machines》。

算法框架:for i=1:itera. 根据预先设定的规则,从所有样本中选出两个b. 保持其他拉格朗日乘子不变,更新所选样本对应的拉格朗日乘子end样本选取规则:第一个参数是违反kkt条件的。

第二个参数:选择使得(实际输出和期望输出的误差)最大的参数。

情况比较复杂,原算法分了很多情况。

当所有变量都满足kkt条件时,算法结束,求得a。

选出了参数就要进行计算。

其中一个参数是可以求导等于0然后解出来(不失一般性,记为a2)。

另一个参数随之发生变化(记为a1)。

解之前要先确定取值范围:根据y1和y2异号或同号,可得出a2的上下界分别为:如果是极值点,二阶导应该大于0,关于a2的二阶导为:经过数学计算,在二阶导大于0的情况下,结合取值范围:然后得到a1:在一些情况下,二阶导不是正数,这时候需要用到目标函数在取最小值和最大值时候的值:计算出a1和a2后,相应的更新b。

更新完a和b,一个周期结束,进入下一次循环。

当所有的参数符合kkt 条件,循环结束。

四、实验内容SVM算法步骤:1,读入训练数据。

2,用SMO算法求解,得到分类预测模型。

3,根据预测模型进行预测。

我们发现SVM算法的难点和重点是SMO算法。

算法流程图:SMO主循环部分:参数选择:参数更新:五、实验结果与分析5.1 实验环境与工具Windows 7 旗舰版(Service Pack 1)MyEclipse2014。

5.2 实验数据集与参数设置bigdata.txt ==》线性可分(y=x程序产生)cycle.txt ==》线性不可分(x^2+y^2=1,程序生成)cycle2.txt ==》线性不可分(x^2+y^2=0~2.5)heart_scale ==》线性不可分实际数据testSet.txt ==》线性可分不规则图形.txt ==》线性不可分(图像数据)人脸.txt ==》线性不可分(图像数据)5.3 评估标准算法经过训练集的训练之后,在测试集上的分类准确率。

通过实际图像也可以看到分类效果。

5.4 实验结果与分析testSet.txt实验结果:Cycle.txt:Cycle2.txt:支持向量是少数,分类超平面在中间。

不规则图形.txt:分类超平面是比较优秀的,并不是在图像的点上,而是大约在中间。

存在容错点:人脸.txt:同样的处理。

人脸图像更复杂一些,同一类是不连在一起的。

能正确分类同样存在容错点。

heart_scale:核函数为线性的时候:非线性(高斯核,sita=1):非线性(高斯核,sita=0.5):(过小存在过度拟合的情况)Bigdata.txt:总共10000条,主要用来测试运行时间。

发现数据量大就很难进行训练。

训练数据运行时间500167ms1000219ms1500546ms20001297ms25001843ms30004410ms35005429ms40005815ms45007402ms500010857msSVM算法分析:不适合于大数据,因为需要进行大量的核函数等运算。

如果对核函数进行缓存,则需要缓存一个N*N的矩阵(N是训练样本的个数),会占用大量的空间。

相应的,linear svm可以解决这个问题。