Hadoop全分布式安装配置

最详细的Hadoop入门教程

最详细的Hadoop⼊门教程前⾔Hadoop 在⼤数据技术体系中的地位⾄关重要,Hadoop 是⼤数据技术的基础,对Hadoop基础知识的掌握的扎实程度,会决定在⼤数据技术道路上⾛多远。

这是⼀篇⼊门⽂章,Hadoop 的学习⽅法很多,⽹上也有很多学习路线图。

本⽂的思路是:以安装部署 Apache Hadoop2.x 版本为主线,来介绍 Hadoop2.x 的架构组成、各模块协同⼯作原理、技术细节。

安装不是⽬的,通过安装认识Hadoop才是⽬的。

本⽂分为五个部分、⼗三节、四⼗九步。

第⼀部分:Linux环境安装Hadoop是运⾏在Linux,虽然借助⼯具也可以运⾏在Windows上,但是建议还是运⾏在Linux系统上,第⼀部分介绍Linux环境的安装、配置、Java JDK安装等。

第⼆部分:Hadoop本地模式安装Hadoop 本地模式只是⽤于本地开发调试,或者快速安装体验 Hadoop,这部分做简单的介绍。

第三部分:Hadoop伪分布式模式安装学习 Hadoop ⼀般是在伪分布式模式下进⾏。

这种模式是在⼀台机器上各个进程上运⾏ Hadoop 的各个模块,伪分布式的意思是虽然各个模块是在各个进程上分开运⾏的,但是只是运⾏在⼀个操作系统上的,并不是真正的分布式。

第四部分:完全分布式安装完全分布式模式才是⽣产环境采⽤的模式,Hadoop 运⾏在服务器集群上,⽣产环境⼀般都会做HA,以实现⾼可⽤。

第五部分:Hadoop HA安装HA是指⾼可⽤,为了解决Hadoop单点故障问题,⽣产环境⼀般都做HA部署。

这部分介绍了如何配置Hadoop2.x的⾼可⽤,并简单介绍了HA的⼯作原理。

安装过程中,会穿插简单介绍涉及到的知识。

希望能对⼤家有所帮助。

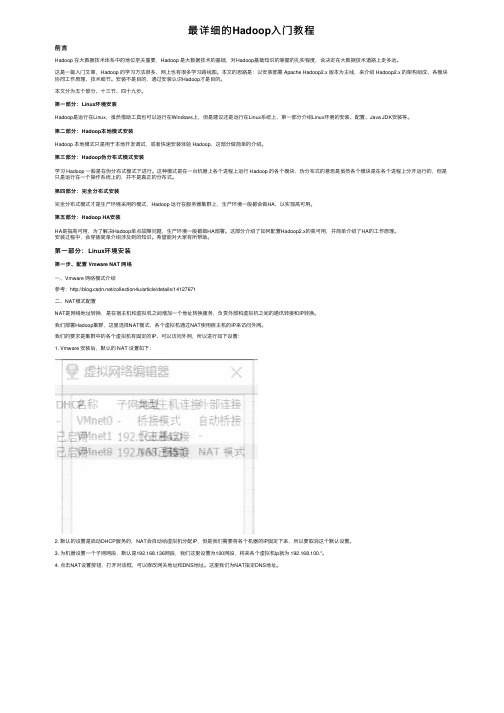

第⼀部分:Linux环境安装第⼀步、配置 Vmware NAT ⽹络⼀、Vmware ⽹络模式介绍参考:/collection4u/article/details/14127671⼆、NAT模式配置NAT是⽹络地址转换,是在宿主机和虚拟机之间增加⼀个地址转换服务,负责外部和虚拟机之间的通讯转接和IP转换。

Hadoop安装部署手册

1.1软件环境1)CentOS6.5x642)Jdk1.7x643)Hadoop2.6.2x644)Hbase-0.98.95)Zookeeper-3.4.61.2集群环境集群中包括 3个节点:1个Master, 2个Slave2安装前的准备2.1下载JDK2.2下载Hadoop2.3下载Zookeeper2.4下载Hbase3开始安装3.1 CentOS安装配置1)安装3台CentOS6.5x64 (使用BasicServer模式,其他使用默认配置,安装过程略)2)Master.Hadoop 配置a)配置网络修改为:保存,退出(esc+:wq+enter ),使配置生效b) 配置主机名修改为:c)配置 hosts修改为:修改为:在最后增加如下内容以上调整,需要重启系统才能生效g) 配置用户新建hadoop用户和组,设置 hadoop用户密码id_rsa.pub ,默认存储在"/home/hadoop/.ssh" 目录下。

a) 把id_rsa.pub 追加到授权的 key 里面去b) 修改.ssh 目录的权限以及 authorized_keys 的权限c) 用root 用户登录服务器修改SSH 配置文件"/etc/ssh/sshd_config"的下列内容3) Slavel.Hadoop 、Slavel.Hadoop 配置及用户密码等等操作3.2无密码登陆配置1)配置Master 无密码登录所有 Slave a)使用 hadoop 用户登陆 Master.Hadoopb)把公钥复制所有的 Slave 机器上。

使用下面的命令格式进行复制公钥2) 配置Slave 无密码登录Mastera) 使用hadoop 用户登陆Slaveb)把公钥复制Master 机器上。

使用下面的命令格式进行复制公钥id_rsa 和相同的方式配置 Slavel 和Slave2的IP 地址,主机名和 hosts 文件,新建hadoop 用户和组c) 在Master机器上将公钥追加到authorized_keys 中3.3安装JDK所有的机器上都要安装 JDK ,先在Master服务器安装,然后其他服务器按照步骤重复进行即可。

Hadoop的安装与配置

Hadoop的安装与配置建立一个三台电脑的群组,操作系统均为Ubuntu,三个主机名分别为wjs1、wjs2、wjs3。

1、环境准备:所需要的软件及我使用的版本分别为:Hadoop版本为0.19.2,JDK版本为jdk-6u13-linux-i586.bin。

由于Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

所以在三台主机上都设置一个用户名为“wjs”的账户,主目录为/home/wjs。

a、配置三台机器的网络文件分别在三台机器上执行:sudo gedit /etc/network/interfaceswjs1机器上执行:在文件尾添加:auto eth0iface eth0 inet staticaddress 192.168.137.2gateway 192.168.137.1netmask 255.255.255.0wjs2和wjs3机器上分别执行:在文件尾添加:auto eth1iface eth1 inet staticaddress 192.168.137.3(wjs3上是address 192.168.137.4)gateway 192.168.137.1netmask 255.255.255.0b、重启网络:sudo /etc/init.d/networking restart查看ip是否配置成功:ifconfig{注:为了便于“wjs”用户能够修改系统设置访问系统文件,最好把“wjs”用户设为sudoers(有root权限的用户),具体做法:用已有的sudoer登录系统,执行sudo visudo -f /etc/sudoers,并在此文件中添加以下一行:wjsALL=(ALL)ALL,保存并退出。

}c、修改三台机器的/etc/hosts,让彼此的主机名称和ip都能顺利解析,在/etc/hosts中添加:192.168.137.2 wjs1192.168.137.3 wjs2192.168.137.4 wjs3d、由于Hadoop需要通过ssh服务在各个节点之间登陆并运行服务,因此必须确保安装Hadoop的各个节点之间网络的畅通,网络畅通的标准是每台机器的主机名和IP地址能够被所有机器正确解析(包括它自己)。

hadoop安装实验总结

hadoop安装实验总结Hadoop安装实验总结Hadoop是一个开源的分布式计算框架,用于处理大规模数据集。

在本次实验中,我成功安装了Hadoop,并进行了相关的配置和测试。

以下是我对整个过程的总结和经验分享。

1. 环境准备在开始安装Hadoop之前,我们需要确保已经具备了以下几个环境条件:- 一台Linux操作系统的机器,推荐使用Ubuntu或CentOS。

- Java开发环境,Hadoop是基于Java开发的,因此需要安装JDK。

- SSH服务,Hadoop通过SSH协议进行节点之间的通信,因此需要确保SSH服务已启动。

2. 下载和安装Hadoop可以从Hadoop官方网站上下载最新的稳定版本。

下载完成后,解压缩到指定目录,并设置环境变量。

同时,还需要进行一些配置,包括修改配置文件和创建必要的目录。

3. 配置Hadoop集群Hadoop是一个分布式系统,通常会配置一个包含多个节点的集群。

在配置文件中,我们需要指定集群的各个节点的IP地址和端口号,并设置一些重要的参数,如数据存储路径、副本数量等。

此外,还可以根据实际需求调整其他配置参数,以优化集群性能。

4. 启动Hadoop集群在完成集群配置后,我们需要启动Hadoop集群。

这一过程需要先启动Hadoop的各个组件,包括NameNode、DataNode、ResourceManager和NodeManager等。

启动成功后,可以通过Web 界面查看集群的状态和运行情况。

5. 测试Hadoop集群为了验证Hadoop集群的正常运行,我们可以进行一些简单的测试。

例如,可以使用Hadoop提供的命令行工具上传和下载文件,查看文件的副本情况,或者运行一些MapReduce任务进行数据处理。

这些测试可以帮助我们了解集群的性能和可靠性。

6. 故障排除与优化在实际使用Hadoop时,可能会遇到一些故障和性能问题。

为了解决这些问题,我们可以通过查看日志文件或者使用Hadoop提供的工具进行故障排查。

hadoop安装以及配置启动命令

hadoop安装以及配置启动命令本次安装使⽤的Hadoop⽂件是badou学院的Hadoop1.2.1.tar.gz,以下步骤都是在此版本上进⾏。

1、安装,通过下载tar.gz⽂件安装到指定⽬录2、安装好后需要配置Hadoop集群配置信息: 在hadoop的conf路径中的masters中添加master(集群机器主的hostname)在slaves中添加集群的slave的hostname名称名称对应的是各⾃机器的hostname这样通过hosts⽂件中配置的域名地址映射可以直接找到对应的机器 a、core-site.xml 在xml⽂件中添加<property><name>hadoop.tmp.dir</name><value>/usr/local/src/hadoop.1.2.1/tmp</value></property> <property><name></name><value>hdfs://192.168.79.10:9000</value></property> c、hdfs-site.xml 在⽂件中添加<property><name>dfs.replication</name><value>3</value></property><!-- 复制节点数 --> d、hadoop-env.xml 在⽂件中添加export JAVA_HOME=/usr/local/src/jdk1.6.0_45 步骤2配置好后将当前hadoop⽂件夹复制到集群中其他机器上,只需要在对应机器上修改其对应的ip、port、jdk路径等信息即可搭建集群3、配置好Hadoop环境后需要测试环境是否可⽤: a、⾸先进⼊Hadoop的安装⽬录,进⼊bin⽬录下,先将Hadoop环境初始化,命令:./hadoop namenode -format b、初始化之后启动Hadoop,命令:./start_all.sh c、查看Hadoop根⽬录下的⽂件,命令:./hadoop fs -ls/ d、上传⽂件,命令:./hadoop fs -put ⽂件路径 e、查看⽂件内容,命令:./hadoopo fs -cat hadoop⽂件地址注意:在安装Hadoop环境时先安装好机器集群,使得⾄少3台以上(含3台)机器之间可以免密互相登录(可以查看上⼀篇的linux的ssh免密登录)执⾏Python⽂件时的部分配置/usr/local/src/hadoop-1.2.1/bin/hadoop/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar。

简述hadoop安装步骤

简述hadoop安装步骤简述hadoop安装步骤安装步骤:1、安装虚拟机系统,并进⾏准备⼯作(可安装- ⼀个然后克隆)2.修改各个虚拟机的hostname和host3.创建⽤户组和⽤户4、配置虚拟机⽹络,使虚拟机系统之间以及和host主机之间可以通过相互ping通。

5.安装jdk和配置环境变量,检查是否配置成功6、配置ssh,实现节点间的⽆密码登录ssh node1/2指令验证时候成功7、master 配置hadoop,并将hadoop⽂件传输到node节点8、配置环境变量,并启动hadoop, 检查是否安装成功,执⾏wordcount检查是否成功。

⼆.HDFS作⽤是什么Hadoop分布式⽂件系统(HDFS)是指被设计成适合运⾏在通⽤硬件(commodity hardware)上的分布式⽂件系统(Distributed File System)。

它和现有的分布式⽂件系统有很多共同点。

但同时,它和其他的分布式⽂件系统的区别也是很明显的。

HDFS是⼀个⾼度容错性的系统,适合部署在廉价的机器上。

HDFS能提供⾼吞吐量的数据访问,⾮常适合⼤规模数据集上的应⽤。

HDFS放宽了⼀部分POSIX约束,来实现流式读取⽂件系统数据的⽬的。

HDFS在最开始是作为Apache Nutch搜索引擎项⽬的基础架构⽽开发的。

HDFS是Apache Hadoop Core项⽬的⼀部分。

HDFS有着⾼容错性(fault-tolerant)的特点,并且设计⽤来部署在低廉的(low-cost)硬件上。

⽽且它提供⾼吞吐量(high throughput)来访问应⽤程序的数据,适合那些有着超⼤数据集(large data set)的应⽤程序。

HDFS放宽了(relax)POSIX的要求(requirements)这样可以实现流的形式访问(streaming access)⽂件系统中的数据。

三.常⽤的Hadoop FS Shell命令有哪些及其作⽤1.调⽤Hadoop的⽂件系统Shell(FileSystem Shell)的命令格式:语法:hadoop fs <args>:前提是位置位于hadoop/bin下,其中fs是参数,表⽰FS Shell,<args>是fs的⼦命令2.使⽤FS Shell命令⾏管理⽂件:mkdir -创建⽬录语法:hadoop fs -mkdir <paths>例⼦:hadoop fs -mkdir /user:在HDFS中创建"/user"⽬录hadoop fs -mkdir /user/hadoop:在HDFS中创建"/user/hadoop"⽬录hadoop fs -mkdir /user/hadoop/dir1 /user/hadoop/dir2:在HDFS中同时创建"/user/hadoop/dir1"和"/user/hadoop/dir2",⽬录ls -查看列表⽂件语法:hadoop fs -ls <args>如果是⽂件,则按照如下格式返回⽂件信息:⽂件名<副本数> ⽂件⼤⼩修改⽇期修改时间权限⽤户ID 组ID如果是⽬录,则返回它直接⼦⽂件的⼀个列表cat -查看⽂件语法:hadoop fs -cat URI <URI...>:输出路径指定⽂件的内容例⼦:hadoop fs -cat /input2/file1.txt /input2/file2.txt:在HDFS中查看input2⽬录下的file1.txt和file2.txt的⽂件内容put -从本地⽂件系统中复制⼀个或多个⽂件到HDFS(外部命令)语法:hadoop fs -put <localsrc>...<dst>其中localsrc只能是本地⽂件,dst只能是HDFS⽂件,且不受fs.defaultFS属性影响。

hadoop 操作手册

hadoop 操作手册Hadoop 是一个分布式计算框架,它使用 HDFS(Hadoop Distributed File System)存储大量数据,并通过 MapReduce 进行数据处理。

以下是一份简单的 Hadoop 操作手册,介绍了如何安装、配置和使用 Hadoop。

一、安装 Hadoop1. 下载 Hadoop 安装包,并解压到本地目录。

2. 配置 Hadoop 环境变量,将 Hadoop 安装目录添加到 PATH 中。

3. 配置 Hadoop 集群,包括 NameNode、DataNode 和 JobTracker 等节点的配置。

二、配置 Hadoop1. 配置 HDFS,包括 NameNode 和 DataNode 的配置。

2. 配置 MapReduce,包括 JobTracker 和 TaskTracker 的配置。

3. 配置 Hadoop 安全模式,如果需要的话。

三、使用 Hadoop1. 上传文件到 HDFS,使用命令 `hadoop fs -put local_file_path/hdfs_directory`。

2. 查看 HDFS 中的文件和目录信息,使用命令 `hadoop fs -ls /`。

3. 运行 MapReduce 作业,编写 MapReduce 程序,然后使用命令`hadoop jar my_` 运行程序。

4. 查看 MapReduce 作业的运行结果,使用命令 `hadoop fs -cat/output_directory/part-r-00000`。

5. 从 HDFS 中下载文件到本地,使用命令 `hadoop fs -get/hdfs_directory local_directory`。

6. 在 Web 控制台中查看 HDFS 集群信息,在浏览器中打开7. 在 Web 控制台中查看 MapReduce 作业运行情况,在浏览器中打开四、管理 Hadoop1. 启动和停止 Hadoop 集群,使用命令 `` 和 ``。

hadoop安装配置指南

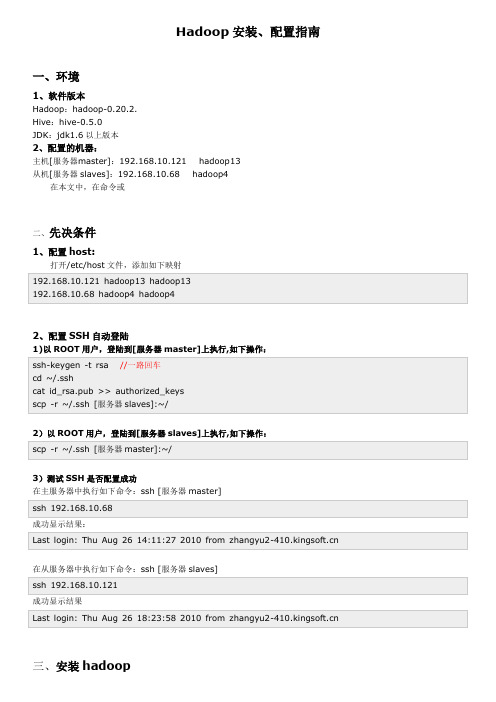

Hadoop安装、配置指南一、环境1、软件版本Hadoop:hadoop-0.20.2.Hive:hive-0.5.0JDK:jdk1.6以上版本2、配置的机器:主机[服务器master]:192.168.10.121 hadoop13从机[服务器slaves]:192.168.10.68 hadoop4在本文中,在命令或二、先决条件1、配置host:打开/etc/host文件,添加如下映射192.168.10.121 hadoop13 hadoop13192.168.10.68 hadoop4 hadoop42、配置SSH自动登陆1)以ROOT用户,登陆到[服务器master]上执行,如下操作:ssh-keygen -t rsa //一路回车cd ~/.sshcat id_rsa.pub >> authorized_keysscp -r ~/.ssh [服务器slaves]:~/2)以ROOT用户,登陆到[服务器slaves]上执行,如下操作:scp -r ~/.ssh [服务器master]:~/3)测试SSH是否配置成功在主服务器中执行如下命令:ssh [服务器master]ssh 192.168.10.68成功显示结果:Last login: Thu Aug 26 14:11:27 2010 from 在从服务器中执行如下命令:ssh [服务器slaves]ssh 192.168.10.121成功显示结果Last login: Thu Aug 26 18:23:58 2010 from 三、安装hadoop1、JDK安装,解压到/usr/local/jdk1.6.0_17,并配置/etc/profile环境export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jarJDK路径:/usr/local/jdk/jdk1.7.0export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jar/usr/local/jdk/jdk1.7.02、下载Hadoop 并解压到[服务器master]的/root/zwmhadoop目录下tar zxvf hadoop-0.20.2.tar.gz四、配置hadoop1.配置主机[服务器master]到zwm hadoop/hadoop-0.20.2/ hadoop 目录下,修改以下文件:1)配置conf/hadoop-env.sh文件,在文件中添加环境变量,增加以下内容:export JAVA_HOME=/usr/local/jdk1.6.0_17export HADOOP_HOME=/root/zwmhadoop/hadoop-0.20.2/2)配置conf/core-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name></name><value>hdfs://192.168.10.121:9000</value>//你的namenode的配置,机器名加端口<description>The nam e of the default file system. Either the literal string "local" o r a host:port for DFS.</description></property></configuration>3)配置conf/hdfs-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name>hadoop.t m p.dir</name><value>/root/zwmhadoop/t m p</value>//Hadoop的默认临时路径,这个最好配置,然后在新增节点或者其他情况下莫名其妙的DataNode启动不了,就删除此文件中的t mp目录即可。

Hadoop环境搭建--Docker完全分布式部署Hadoop环境(菜鸟采坑吐血整理)

Hadoop环境搭建--Docker完全分布式部署Hadoop环境(菜鸟采坑吐⾎整理)系统:Centos 7,内核版本3.10本⽂介绍如何从0利⽤Docker搭建Hadoop环境,制作的镜像⽂件已经分享,也可以直接使⽤制作好的镜像⽂件。

⼀、宿主机准备⼯作0、宿主机(Centos7)安装Java(⾮必须,这⾥是为了⽅便搭建⽤于调试的伪分布式环境)1、宿主机安装Docker并启动Docker服务安装:yum install -y docker启动:service docker start⼆、制作Hadoop镜像(本⽂制作的镜像⽂件已经上传,如果直接使⽤制作好的镜像,可以忽略本步,直接跳转⾄步骤三)1、从官⽅下载Centos镜像docker pull centos下载后查看镜像 docker images 可以看到刚刚拉取的Centos镜像2、为镜像安装Hadoop1)启动centos容器docker run -it centos2)容器内安装java下载java,根据需要选择合适版本,如果下载历史版本拉到页⾯底端,这⾥我安装了java8/usr下创建java⽂件夹,并将java安装包在java⽂件下解压tar -zxvf jdk-8u192-linux-x64.tar.gz解压后⽂件夹改名(⾮必需)mv jdk1.8.0_192 jdk1.8配置java环境变量vi ~/.bashrc ,添加内容,保存后退出export JAVA_HOME=/usr/java/jdk1.8export JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/libexport PATH=$PATH:${JAVA_HOME}/bin使环境变量⽣效 source ~/.bashrc验证安装结果 java -version这⾥注意,因为是在容器中安装,修改的是~/.bashrc⽽⾮我们使⽤更多的/etc/profile,否则再次启动容器的时候会环境变量会失效。

hadoop安装指南(非常详细,包成功)

➢3.10.2.进程➢JpsMaster节点:namenode/tasktracker(如果Master不兼做Slave, 不会出现datanode/TasktrackerSlave节点:datanode/Tasktracker说明:JobTracker 对应于NameNodeTaskTracker 对应于DataNodeDataNode 和NameNode 是针对数据存放来而言的JobTracker和TaskTracker是对于MapReduce执行而言的mapreduce中几个主要概念,mapreduce整体上可以分为这么几条执行线索:jobclient,JobTracker与TaskTracker。

1、JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,并把路径提交到Jobtracker,然后由JobTracker创建每个Task(即MapTask和ReduceTask)并将它们分发到各个TaskTracker服务中去执行2、JobTracker是一个master服务,软件启动之后JobTracker接收Job,负责调度Job的每一个子任务task运行于TaskTracker上,并监控它们,如果发现有失败的task就重新运行它。

一般情况应该把JobTracker部署在单独的机器上。

3、TaskTracker是运行在多个节点上的slaver服务。

TaskTracker主动与JobTracker通信,接收作业,并负责直接执行每一个任务。

TaskTracker都需要运行在HDFS的DataNode上3.10.3.文件系统HDFS⏹查看文件系统根目录:Hadoop fs–ls /。

Hadoop完全分布式详细安装过程

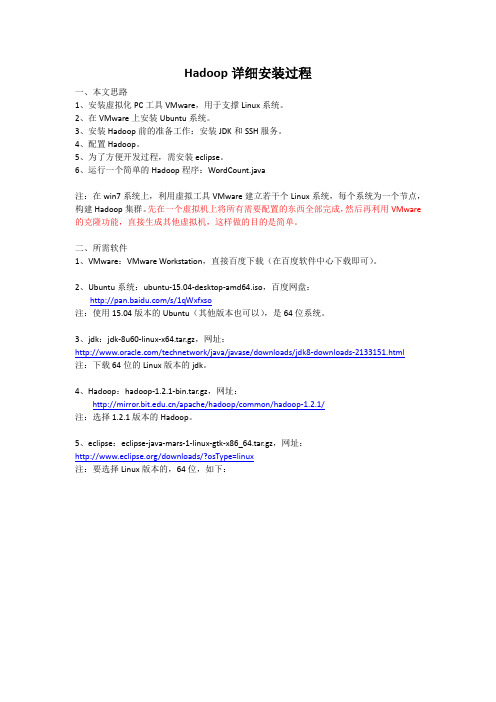

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

hadoop安装与配置总结与心得

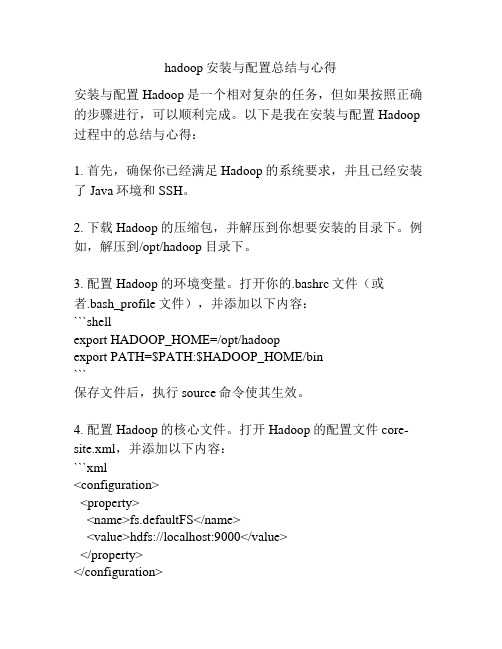

hadoop安装与配置总结与心得安装与配置Hadoop是一个相对复杂的任务,但如果按照正确的步骤进行,可以顺利完成。

以下是我在安装与配置Hadoop 过程中的总结与心得:1. 首先,确保你已经满足Hadoop的系统要求,并且已经安装了Java环境和SSH。

2. 下载Hadoop的压缩包,并解压到你想要安装的目录下。

例如,解压到/opt/hadoop目录下。

3. 配置Hadoop的环境变量。

打开你的.bashrc文件(或者.bash_profile文件),并添加以下内容:```shellexport HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行source命令使其生效。

4. 配置Hadoop的核心文件。

打开Hadoop的配置文件core-site.xml,并添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```5. 配置Hadoop的HDFS文件系统。

打开Hadoop的配置文件hdfs-site.xml,并添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```这里的dfs.replication属性指定了数据块的副本数量,可以根据实际情况进行调整。

6. 配置Hadoop的MapReduce框架。

Hadoop2.7.3+Hbase-1.2.6完全分布式安装部署

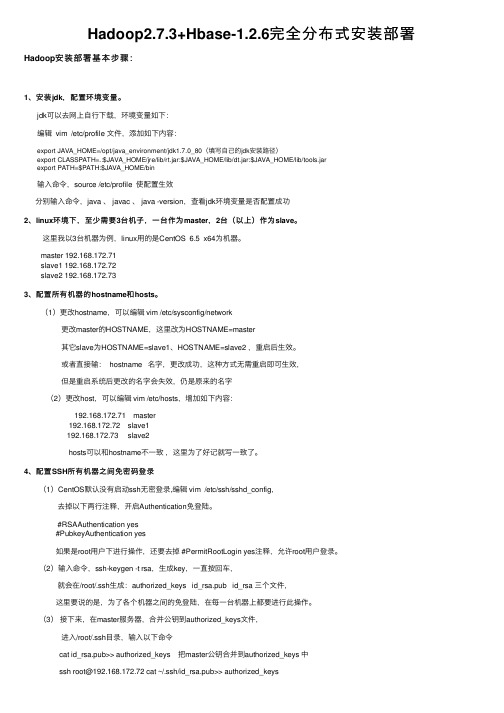

Hadoop2.7.3+Hbase-1.2.6完全分布式安装部署Hadoop安装部署基本步骤:1、安装jdk,配置环境变量。

jdk可以去⽹上⾃⾏下载,环境变量如下:编辑 vim /etc/profile ⽂件,添加如下内容:export JAVA_HOME=/opt/java_environment/jdk1.7.0_80(填写⾃⼰的jdk安装路径)export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport PATH=$PATH:$JAVA_HOME/bin输⼊命令,source /etc/profile 使配置⽣效分别输⼊命令,java 、 javac 、 java -version,查看jdk环境变量是否配置成功2、linux环境下,⾄少需要3台机⼦,⼀台作为master,2台(以上)作为slave。

这⾥我以3台机器为例,linux⽤的是CentOS 6.5 x64为机器。

master 192.168.172.71slave1 192.168.172.72slave2 192.168.172.733、配置所有机器的hostname和hosts。

(1)更改hostname,可以编辑 vim /etc/sysconfig/network 更改master的HOSTNAME,这⾥改为HOSTNAME=master 其它slave为HOSTNAME=slave1、HOSTNAME=slave2 ,重启后⽣效。

或者直接输: hostname 名字,更改成功,这种⽅式⽆需重启即可⽣效, 但是重启系统后更改的名字会失效,仍是原来的名字 (2)更改host,可以编辑 vim /etc/hosts,增加如下内容: 192.168.172.71 master 192.168.172.72 slave1 192.168.172.73 slave2 hosts可以和hostname不⼀致,这⾥为了好记就写⼀致了。

CDH5.1.0hadoop-2.3.( 2+3 )0完全分布式集群配置及HA配置

Hadoop-2.3.0-cdh5.1.0完全分布式集群配置及HA配置(冰峰)方式: 2个master + 3个slave hadoop-2.3.0-cdh5.1.0完全分布式集群配置HA配置重点说明:为了部署HA集群,应该准备以下事情:* NameNode服务器:运行NameNode的服务器应该有相同的硬件配置。

* JournalNode服务器:运行的JournalNode进程非常轻量,可以部署在其他的服务器上。

注意:必须允许至少3个节点。

当然可以运行更多,但是必须是奇数个,如3、5、7、9个等等。

当运行N个节点时,系统可以容忍至少(N-1)/2个节点失败而不影响正常运行。

一、安装前准备:操作系统:CentOS 6.5 64位操作系统环境:jdk1.7.0_45以上,本次采用jdk-7u72-linux-x64.tar.gzmaster1 192.168.100.151 namenode 节点master2 192.168.100.152 namenode 节点slave1 192.168.100.153 datanode 节点slave2 192.168.100.154 datanode 节点slave3: 192.168.100.155 datanode 节点注:Hadoop2.0以上采用的是jdk环境是1.7,Linux自带的jdk卸载掉,重新安装下载地址:/technetwork/java/javase/downloads/index.html软件版本:hadoop-2.3.0-cdh5.1.0.tar.gz, zookeeper-3.4.5-cdh5.1.0.tar.gz下载地址:/cdh5/cdh/5/开始安装:二、jdk安装1、检查是否自带jdkrpm -qa | grep jdkjava-1.6.0-openjdk-1.6.0.0-1.45.1.11.1.el6.i6862、卸载自带jdkyum -y remove java-1.6.0-openjdk-1.6.0.0-1.45.1.11.1.el6.i686安装jdk-7u72-linux-x64.tar.gz在usr/目录下创建文件夹java,在java文件夹下运行tar –zxvf jdk-7u72-linux-x64.tar.gz解压到java目录下[root@master01 java]# lsjdk1.7.0_72三、配置环境变量远行vi /etc/profile# /etc/profile# System wide environment and startup programs, for login setup# Functions and aliases go in /etc/bashrcexport JA VA_HOME=/usr/local/java/jdk1.7.0_65export JRE_HOME=/usr/local/java/jdk1.7.0_65/jreexport CLASSPATH=/usr/local/java/jdk1.7.0_65/libexport PATH=$JA V A_HOME/bin: $PA TH保存修改,运行source /etc/profile 重新加载环境变量运行java -version[root@master01 java]# java -versionjava version "1.7.0_72"Java(TM) SE Runtime Environment (build 1.7.0_72-b13)Java HotSpot(TM) 64-Bit Server VM (build 24.55-b03, mixed mode)Jdk配置成功四、系统配置预先准备5台机器,并配置IP,以下是我对这5台机器的角色分配。

标准hadoop集群配置

标准hadoop集群配置Hadoop是一个开源的分布式存储和计算框架,由Apache基金会开发。

它提供了一个可靠的、高性能的数据处理平台,可以在大规模的集群上进行数据存储和处理。

在实际应用中,搭建一个标准的Hadoop集群是非常重要的,本文将介绍如何进行标准的Hadoop集群配置。

1. 硬件要求。

在搭建Hadoop集群之前,首先需要考虑集群的硬件配置。

通常情况下,Hadoop集群包括主节点(NameNode、JobTracker)和从节点(DataNode、TaskTracker)。

对于主节点,建议配置至少16GB的内存和4核以上的CPU;对于从节点,建议配置至少8GB的内存和2核以上的CPU。

此外,建议使用至少3台服务器来搭建Hadoop集群,以确保高可用性和容错性。

2. 操作系统要求。

Hadoop可以在各种操作系统上运行,包括Linux、Windows和Mac OS。

然而,由于Hadoop是基于Java开发的,因此建议选择Linux作为Hadoop集群的操作系统。

在实际应用中,通常选择CentOS或者Ubuntu作为操作系统。

3. 网络配置。

在搭建Hadoop集群时,网络配置非常重要。

首先需要确保集群中的所有节点能够相互通信,建议使用静态IP地址来配置集群节点。

此外,还需要配置每台服务器的主机名和域名解析,以确保节点之间的通信畅通。

4. Hadoop安装和配置。

在硬件、操作系统和网络配置完成之后,接下来就是安装和配置Hadoop。

首先需要下载Hadoop的安装包,并解压到指定的目录。

然后,根据官方文档的指导,配置Hadoop的各项参数,包括HDFS、MapReduce、YARN等。

在配置完成后,需要对Hadoop集群进行测试,确保各项功能正常运行。

5. 高可用性和容错性配置。

为了确保Hadoop集群的高可用性和容错性,需要对Hadoop集群进行一些额外的配置。

例如,可以配置NameNode的热备份(Secondary NameNode)来确保NameNode的高可用性;可以配置JobTracker的热备份(JobTracker HA)来确保JobTracker的高可用性;可以配置DataNode和TaskTracker的故障转移(Failover)来确保从节点的容错性。

Hadoop分布式详细安装步骤

Hadoop分布式详细安装步骤版本:0.20.2准备工作:由于Hadoop要求所有主机上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

二台机器上是这样的:都有一个coole的帐户,主目录是/home/coole两台机器(内存应在512以上,否则可能会出现计算极度缓慢的情况):一台机器名:master IP:211.87.239.181一台机器名:slave IP:211.87.239.182每台都建coole用户如果是ubuntu,为了便于用coole帐号修改系统设置和访问系统文件,推荐把coole也设为sudoers(有root 权限的用户),具体做法是用已有的sudoer登录系统,执行sudo visudo –f /etc/sudoers,并在此文件中添加以下一行:mapred ALL=(ALL) ALL一、更改主机名:1、修改/etc/sysconfig/networkNETWORKING=yesHOSTNAME=yourname (在这修改hostname,把yourname换成你想用的名字)NISDOMAIN=修改后机器211.87.239.181中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=master修改后机器211.87.239.182中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=slave2、最后在终端下执行:# hostname ***** (*****为修改后的hostname,即你想用的名字)例如#hostname master特别提示:各处修改的名字要保持一致,否则会出现问题。

3、修改每台机器的/etc/hosts,保证每台机器间都可以通过机器名解析配置etc/hosts文件,以root 身份打开/etc/hosts文件。

Master/slave做同样修改。

2022高职 大数据技术与应用 任务书1(赛项赛题)

2022年全国职业院校技能大赛高职组“大数据技术与应用”赛项赛卷(1卷)任务书参赛队编号:背景描述大数据时代,电商经营模式发生很大改变。

在传统运营模式中,缺乏数据积累,人们在做出一些决策行为过程中,更多是凭借个人经验和直觉,发展路径比较自我封闭。

而大数据时代,为人们提供一种全新的思路,通过大量的数据分析得出的结果将更加现实和准确。

商家可以对客户的消费行为信息数据进行收集和整理,比如消费者购买产品的花费、选择产品的渠道、偏好产品的类型、产品回购周期、购买产品的目的、消费者家庭背景、工作和生活环境、个人消费观和价值观等。

通过数据追踪,知道顾客从哪儿来,是看了某网站投放的广告还是通过朋友推荐链接,是新访客还是老用户,喜欢浏览什么产品,购物车有无商品,是否清空,还有每一笔交易记录,精准锁定一定年龄、收入、对产品有兴趣的顾客,对顾客进行分组、标签化,通过不同标签组合运用,获得不同目标群体,以此开展精准推送。

因数据驱动的零售新时代已经到来,没有大数据,我们无法为消费者提供这些体验,为完成电商的大数据分析工作,你所在的小组将应用大数据技术,以Scala作为整个项目的基础开发语言,基于大数据平台综合利用Spark、Flink、Vue.js等技术,对数据进行处理、分析及可视化呈现,你们作为该小组的技术人员,请按照下面任务完成本次工作。

模块A:大数据平台搭建(容器环境)(15分)环境说明:任务一:Hadoop 完全分布式安装配置本环节需要使用root用户完成相关配置,安装Hadoop需要配置前置环境。

命令中要求使用绝对路径,具体要求如下:1、将Master节点JDK安装包解压并移动到/usr/java路径(若路径不存在,则需新建),将命令复制并粘贴至对应报告中;2、修改/root/profile文件,设置JDK环境变量,配置完毕后在Master节点分别执行“java”和“javac”命令,将命令行执行结果分别截图并粘贴至对应报告中;3、请完成host相关配置,将三个节点分别命名为master、slave1、slave2,并做免密登录,使用绝对路径从Master节点复制JDK解压后的安装文件到Slave1、Slave2节点,并配置相关环境变量,将全部复制命令复制并粘贴至对应报告中;4、在Master节点将Hadoop解压到/opt目录下,并将解压包分发至Slave1、Slave2节点中,配置好相关环境,初始化Hadoop环境namenode,将初始化命令及初始化结果复制粘贴至对应报告中;5、启动Hadoop集群,查看Master节点jps进程,将查看结果复制粘贴至对应报告中。

95 2023年云南省职业院校技能大赛(高职组)大数据应用开发赛项竞赛规程

2023年云南省职业院校技能大赛高职组“大数据应用开发”赛项规程一、赛项名称赛项名称:大数据应用开发赛项组别:高职组赛项归属产业:电子与信息大类二、竞赛目的为适应大数据产业对高素质技术技能型人才的职业需求,赛项以大数据应用开发为核心内容和工作基础,重点考查参赛选手基于Hadoop、Spark、Flink平台环境下,充分利用Spark Core、Spark SQL、Flume、Kafka、Flink、Hive、HBase、Redis、Maxwell、ClickHouse、MySQL等相关技术的特点,基于Scala、Java、JavaScript等开发语言,综合软件开发相关技术,解决实际问题的能力,激发学生对大数据相关知识和技术的学习兴趣,提升学生职业素养和职业技能,努力为中国大数据产业的发展储备及输送新鲜血液,提升大数据专业及其他相关专业毕业生能力素质,满足企业用人需求,促进校企合作协同育人,对接产业发展,实现行业资源、企业资源与教学资源的有机融合,使高职院校在专业建设、课程建设、人才培养方案和人才培养模式等方面,跟踪社会发展的最新需要,缩小人才培养与行业需求差距,引领职业院校专业建设与课程改革。

三、竞赛内容赛项以大数据应用开发为核心内容和工作基础,重点考查参赛选手基于Hadoop、Spark、Flink平台环境下,充分利用Spark Core、Spark SQL、Flume、Kafka、Flink、Hive、HBase、Redis、Maxwell、ClickHouse、MySQL等技术的特点,综合软件开发相关技术,解决实际问题的能力,具体包括:1.掌握Hadoop平台、基于Spark的离线分析平台、基于Flink的实时分析平台,在容器环境下,按照项目需求安装相关技术组件并按照需求进行合理配置;2.掌握基于Spark的离线数据采集方式方法,完成指定数据的抽取并写入Hive分区表中。

掌握基于Flume、Maxwell的实时数据采集,将数据写入Kafka中;3.综合利用Flink、Kafka、Hive、Redis、HBase、ClickHouse等技术,使用Java 开发语言,完成某电商系统的实时数据处理,包括使用Flink处理Kafka中的数据、实时数据仓库、将数据备份至HBase中、建立Hive外表、将数据处理结果存入Redis、ClickHouse中等操作;4.综合利用Spark、Hive、MySQL、HBase、ClickHouse等相关技术,使用Scala 开发语言,完成某电商系统的离线数据处理,包括Hive数据仓库、使用Spark处理离线数据、数据合并、去重、排序、数据类型转换、将数据处理结果存入MySQL、HBase、ClickHouse中等操作;5.综合运用HTML、CSS、JavaScript等开发语言,Vue.js前端技术,结合ECharts数据可视化组件,利用后端数据接口完成数据可视化;6.根据竞赛过程,完成综合分析报告的编写;7.竞赛时间6小时,竞赛连续进行。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop全分布式安装配置

一实验目的:

1、了解Hadoop的体系结构、组成;

2、熟练掌握Hadoop的配置、安装方法;

3、通过安装Hadoop了解Hadoop的原理;

二实验内容:

集群包含三个安装了Linux操作系统的节点。

将其中的一个节点作为NameNode,另外两个节点作为DataNode,安装之前先利用ping命令,确认三个节点之间的网络互通,即可以互相ping通。

假设三个节点IP地址如下,实际的集群节点IP地址可以不同。

NameNode:192.168.198.2 主机名:master

DataNode1:192.168.198.3 主机名:slaver1

DataNode2:192.168.198.4 主机名:slaver2

三实验环境:

在申请的虚拟服务器上安装了VMWare Workstation虚拟3个Ubuntu14.04系统。

四安装配置过程:

1、安装Vmware WorkStation软件

下载安装Vmware WorkStation12.0软件。

2、在虚拟机上安装linux操作系统

在Vmware WorkStation12.0中创建一个Ubuntu14.04系统。

拷贝镜像文件复制出三个系统。

分别为master、slaver1、slaver2。

3、配置hosts、hostname文件

在三台机器上配置相同的hosts文件

(1)修改hosts

sudo gedit /etc/hosts

192.168.198.200 master

192.168.198.199 slave1

192.168.198.198 slave2

(2)修改hostname

sudo gedit /etc/hostname

4、配置ip地址

配置ip:sudo gedit /etc/network/interfaces slave2

auto eth0

iface eth0 inet static

address 192.168.198.198

gateway 192.168.198.107

netmask 255.255.255.0

slave1

auto eth0

iface eth0 inet static

address 192.168.198.199

gateway 192.168.198.107

netmask 255.255.255.0

master

auto eth0

iface eth0 inet static

address 192.168.198.200

gateway 192.168.198.107

netmask 255.255.255.0 master节点配置如下:

slave1节点配置如下:

Slave2节点配置如下:

测试:配置完成后,三个系统可以相互ping通。

5、安装jdk1.8

(1)将jdk1.8安装包拷贝至home下

(2) 解压 sudo tar zxvf jdk-8u65-linux-i586.tar.gz

(3)安装

将解压后的文件夹改名jdk

sudo cd /usr/lib

sudo mkdir jvm

sudo cp -r jdk /usr/lib/jvm

(4)修改环境变量

sudo gedit /etc/profile

添加:

#set java environment

export JAVA_HOME=/usr/lib/jvm/jdk

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib export PATH=${JAVA_HOME}/bin:$PATH

(5)配置默认JDK版本

sudo update-alternatives --install /usr/bin/java java

/usr/lib/jvm/jdk/bin/java 300

sudo update-alternatives --install /usr/bin/javac javac

/usr/lib/jvm/jdk/bin/javac 300

sudo update-alternatives --config java

(6)测试java -version

6、安装openssh

(1) 安装SSH:

sudo apt-get install ssh

(2) 查看是否生成目录.ssh:

ls -al /home/hl/

(3)如果没有,手动创建目录.ssh:

mkdir /home/hl/.ssh

(4)生成公、私密钥:

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

或ssh-keygen -t rsa

(5)将公钥加到用于认证的公钥文件中:

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

或

cp ~/.ssh/id_rsa.pub ~/.ssh/authorized_keys

注:步骤(3)(4)(5)不要用sudo权限命令,否则生成的公钥不可用,配置将不成功(6)验证是否SSH安装成功:

ssh -version

(7)免密码登陆:

单机回环ssh免密码登录测试:ssh localhost

Master节点测试:

Slave1节点测试:

Slave2节点测试:

让主结点(master)能通过SSH免密码登录两个子结点(slave)注:第一次需要输入密码,第二次不用输入密码,直接连通,表示成功。

7、安装hadoop2.7.1

(1)将安装包拷贝至home下

(2) 解压 sudo tar zxvf hadoop-2.7.1.tar.gz (3)安装

解压后的文件夹改名hadoop

sudo cp -r hadoop /usr/local

(4)修改配置文件

●创建相关文件夹

cd /usr/local/hadoop

sudo mkdir tmp

sudo mkdir hdfs

sudo mkdir hdfs/name

sudo mkdir hdfs/data

●修改配置文件

cd /usr/local/hadoop/etc/hadoop

✧修改core-site.xml文件

sudo gedit core-site.xml

修改hdfs-site.xml文件sudo gedit hdfs-site.xml

✧修改mapred-site.xml文件

sudo gedit mapred-site.xml

✧修改yarn-site.xml文件

sudo gedit yarn-site.xml

✧修改hadoop-env.sh文件

sudo gedit hadoop-env.sh

export JAVA_HOME=/usr/lib/jvm/jdk ✧修改 yarn-env.sh文件

sudo gedit yarn-env.sh

export JAVA_HOME=/usr/lib/jvm/jdk ✧修改 slaves文件

sudo gedit slaves

slave1

slave2

8、更改hadoop目录jdk目录属主

sudo chown -R hl:hl hadoop

sudo chown -R hl:hl jdk

9、启动Hadoop(master节点操作)

先格式化namenode,然后依次启动hdfs和yarn。

bin/hadoop namenode -format

sbin/start-dfs.sh

sbin/start-yarn.sh

sbin/start-all.sh

10、用jps检验各后台进程是否成功启动

在主结点master上查看namenode,resourcemanager,secondarynamenode进程是否启动。

如果出现以上进程则表示正确。

在slave1和slave2结点了查看nodemanager和datanode进程是否启动。

先来slave1的情况:

下面是slave2的情况:

显示如上,进程都启动成功了。

11、浏览器中输入查询集群信息

(1)192.168.198.200:50070查询HDFS相关信息

(2)192.168.198.200:8088查看yarn的启动情况

12、关闭集群可以执行sbin/stop-all.sh。