Hadoop伪分布搭建

hadoop系统伪分布搭建

Mapreduce程序设计报告姓名:学号:题目:Hadoop系统伪分布搭建和运行1、实验环境联想pc机虚拟机:VM 10.0操作系统:Centos 6.4Hadoop版本:hadoop 1.2.1Jdk版本:jdk-7u252、系统安装步骤:2.1安装配置SSH在CentOs中,已经安装ssh与sshd,可用which命令查看打开终端,在终端中中键入:ssh -keygen -t rsa生成无密码密钥对,询问其保存路径时直接回车采用默认路径。

生成的密钥对:id_rsa和id_rsa.pub,默认存储在"/home/hadoop/.ssh"目录下。

接着将id_rsa.pub追加到授权的key里面去cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys2.2 安装JDK:打开终端,输入命令mkdir /usr/java //建立java文件夹//复制JDK文件夹包cd /usr/java //进入jdk文件夹tar –zxvf jdk-7u25-linux-x64.tar.gz //解压jdk文件mv jdk1.7.0_25 jdk //重新命名jdk文件夹rm –rf jdk-7u25-linux-x64.tar.gz //删除jkd压缩包2.3配置JDK环境变量使用root权限进行操作,输入命令:vim /etc/profile按i进入编辑,在文件的最后,添加环境变量语句:按esc,接着按:wq保存退出,执行命令source /etc/profile 使环境变量生效使用命令java -version检测环境变量是否配置成功。

要是出现以上情况,说明jdk配置成功。

2.4安装Hadoop打开终端,输入命令cp /home/tzj/hadoop/hadoop-1.2.1.tar /usr #复制hadoop安装包到usr目录cd /usr #进入"/usr"目录tar –zxvf hadoop-1.2.1.tar.gz #解压"hadoop-1.2.1.tar.gz"安装包mv hadoop-1.2.1 hadoop #将"hadoop-1.2.1"文件夹重命名"hadoop"mkdir /usr/hadoop/tmp #在hadoop文件夹下创建tmp文件夹chown –R tzj:tzj hadoop #将文件夹"hadoop"读权限分配给hadoop用户rm –rf hadoop-1.0.0.tar.gz #删除"hadoop-1.0.0.tar.gz"安装包2.5hadoop配置(1)使用root权限进行操作,输入命令:vim /etc/profile按i进入编辑,在文件的最后,添加环境变量语句:按esc,接着按:wq保存退出,执行命令source /etc/profile 使环境变量生效(2)配置hadoop-env.sh在文本最后添加# set java environmentexport JAVA_HOME=/jdk1.7.0_25(3)配置core-site.xml在文本最后添加:<configuration><property><name>hadoop.tmp.dir</name><value>/usr/hadoop/tmp</value>(备注:请先在/usr/hadoop 目录下建立tmp 文件夹)<description>A base for other temporary directories.</description> </property><!-- file system properties --><property><name></name></property></configuration>(4)配置hdfs-site.xml在文本最后添加:<configuration><property><name>dfs.replication</name><value>1</value>(备注:replication 是数据副本数量,默认为3,salve少于3台就会报错) </property><configuration>(5)配置mapred-site.xml在文本最后添加:<configuration><property><name>mapred.job.tracker</name></property></configuration>2.6启动hadoop和验证(1)格式化hdfs文件系统hadoop namenode -format(2)启动hadoop2.7启动hadoopstart-all.sh启动守护程序,使用以下方式进行验证:(1)使用自带的JPS验证启动情况。

Hadoop伪分布安装配置

学号: 201471030129 月 27 日

系别

计 算

专业

计算机 科学与

班级

14卓 越

机

技术

课程名 云计算 称

课程 选修 类型

实验名 Hadoop伪分布安装配置 称

2016 年 9

吴铠年 姓名

学时 4 数

实验目的பைடு நூலகம்要求:

一、Hadoop伪分布模式安装配置 二、HDFS Shell命令使用

<!-- Put site-specific property overrides in this file. -->

<configuration> <property> <name>dfs.replication</name> <value>2</value> </property>

</configuration> 3. 开启关闭 通过NameNode格式化HDFS文件系统 cd hadoop-0.20.2/conf hadoop namenode -format 开启hadoop cd hadoop-0.20.2/bin sh start-all.sh

通过jps命令检查期望的hadoop进程是否运行

关闭hadoop cd hadoop-0.20.2/bin sh stop-all.sh

错误分析: 实验总结: 成绩

批阅 教师

批阅日期

</property> </configuration> 文件:mapred-site.xml <?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

超详细解说Hadoop伪分布式搭建

超详细解说Hadoop伪分布式搭建单节点伪分布式Hadoop配置(声明:文档里面需要用户输入的均已斜体表示)第一步:安装JDK因为 Hadoop 运行必须安装 JDK 环境,因此在安装好 Linux 后进入系统的第一步便是安装 JDK ,安装过程和在 Windows 环境中的安装步骤很类似,首先去Oracle 官网去下载安装包,然后直接进行解压。

我自己解压在路径 /usr/jvm 下面,假如你的安装包现在已经下载在 jvm 文件夹下面,然后按 Ctrl+Alt+t 进去命令行,然后输入cd /usr/jvm进入到jvm文件夹下面,然后再输入如下命令进行解压:sudo tar -zxvf jdk-7u40-linux-i586.tar.gz第二步:配置环境变量解压结束以后,像在Windows 系统中一样,需要配置环境变量,在 Ubuntu 中设置环境变量的过程为打开文件 /etc/profile ,因为权限的问题,因此在命令行需要输入的是sudo gedit /etc/profile然后在根据提示输入用户密码即可,然后在文件最下面添加如下:export JAVA_HOME=/usr/jvm/jdk1.7.0_40export CLASSPATH=".:$JAVA_HOME/lib:$JAVA_HOME/jre/lib $CLASSPATH"export PATH="$JAVA_HOME/bin:$JAVA_HOME/jre/bin:/usr/ hadoop/hadoop-1.2.1/bin:$PATH"上面这三个以单词export 开始的三个语句就类似于我们在Windows 中的环境变量中设置一样,而且在这个里面和 Windows 中不同的是,在Windows 中使用“;” 号来表示分隔,但是在Ubuntu 中是以“:” 号来表示分隔。

还需要注意的是,上面的路径都是我自己配置的时候的路径,因为我的JDK 解压在/usr/jvm 中,所以我的 JAVA_HOME 设置的是那个路径,而且如果安装的 JDK 版本不同那么后面的也不一样。

hadoop环境配置以及hadoop伪分布式安装实训目的

Hadoop环境配置以及Hadoop伪分布式安装是用于学习和实践大数据处理和分析的重要步骤。

下面将详细解释配置Hadoop环境以及安装Hadoop伪分布式的目的。

一、Hadoop环境配置配置Hadoop环境是为了在实际的硬件或虚拟机环境中搭建Hadoop集群,包括安装和配置Hadoop的各个组件,如HDFS(Hadoop分布式文件系统)、MapReduce(一种编程模型和运行环境)等。

这个过程涉及到网络设置、操作系统配置、软件安装和配置等步骤。

通过这个过程,用户可以了解Hadoop的基本架构和工作原理,为后续的学习和实践打下基础。

二、Hadoop伪分布式安装Hadoop伪分布式安装是一种模拟分布式环境的方法,它可以在一台或多台机器上模拟多个节点,从而在单机上测试Hadoop的各个组件。

通过这种方式,用户可以更好地理解Hadoop 如何在多台机器上协同工作,以及如何处理大规模数据。

安装Hadoop伪分布式的主要目的如下:1. 理解Hadoop的工作原理:通过在单机上模拟多个节点,用户可以更好地理解Hadoop如何在多台机器上处理数据,以及如何使用MapReduce模型进行数据处理。

2. 练习Hadoop编程:通过在单机上模拟多个节点,用户可以编写和测试Hadoop的MapReduce程序,并理解这些程序如何在单机上运行,从而更好地理解和学习Hadoop编程模型。

3. 开发和调试Hadoop应用程序:通过在单机上模拟分布式环境,用户可以在没有真实数据的情况下开发和调试Hadoop应用程序,从而提高开发和调试效率。

4. 为真实环境做准备:一旦熟悉了Hadoop的伪分布式环境,用户就可以逐渐将知识应用到真实环境中,例如添加更多的实际节点,并开始处理实际的大规模数据。

总的来说,学习和实践Hadoop环境配置以及Hadoop伪分布式安装,对于学习和实践大数据处理和分析具有重要意义。

它可以帮助用户更好地理解和学习Hadoop的工作原理和编程模型,为将来在实际环境中应用和优化Hadoop打下坚实的基础。

hadoop搭建伪分布式集群步骤

hadoop搭建伪分布式集群步骤Hadoop是一个开源的分布式计算框架,可以处理大规模数据集的并行计算。

搭建伪分布式集群是学习Hadoop的第一步,本文将介绍搭建伪分布式集群的步骤。

步骤一:安装Java环境Hadoop是基于Java开发的,所以首先需要安装Java环境。

可以从Oracle官网下载最新版本的JDK,并按照官方文档进行安装。

步骤二:下载Hadoop在官方网站上下载Hadoop的稳定版本。

下载后解压缩到指定目录,我们假设解压缩后的目录为/home/hadoop/hadoop。

步骤三:配置Hadoop环境变量打开终端,运行以下命令编辑环境变量配置文件:```$ sudo nano ~/.bashrc```在文件末尾添加如下内容:```export HADOOP_HOME=/home/hadoop/hadoopexport PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin```保存并退出文件,然后运行以下命令使环境变量生效:```$ source ~/.bashrc```步骤四:配置Hadoop核心文件进入Hadoop的安装目录,找到conf目录下的hadoop-env.sh文件,使用文本编辑器打开该文件,并修改JAVA_HOME的值为Java的安装路径。

保存并退出文件。

步骤五:配置Hadoop的核心文件进入Hadoop的安装目录,找到conf目录下的core-site.xml文件,使用文本编辑器打开该文件,添加以下内容:```<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```保存并退出文件。

1.Hadoop简介以及伪分布式的搭建

1.Hadoop简介以及伪分布式的搭建Hadoop基本介绍 hadoop是⼀个框架: hadoop的本质其实就是⼀系列功能模块⼉组成的框架,每个模块分别负责hadoop的⼀些功能,如HDFS负责⼤数据的存储功能;Yarn,负责整个集群的资源调度;Common则负责Hadoop远程过程调⽤的实现以及提供序列化机制。

hadoop具有⾼容错性,以及⾼拓展性hadoop适合处理⼤数据数据Hadoop⽣态圈Centos7单机上搭建Hadoop(伪分布模式)这⾥我都放在/opt⽬录下,创建⼀个soft⽂件夹,将Hadoop解压放在下⾯的hadoop260⽂件夹中1、⾸先将Hadoop的压缩包传到/opt⽬录下2、依次在/opt⽬录下创建soft和hadoop260⽂件夹,并将hadoop的压缩包解压到这⾥,去掉⼀层⽬录[root@hadoopsingle opt]# mkdir -p soft/hadoop260[root@hadoopsingle opt]# tar -zxf hadoop-2.6.0-cdh5.14.2.tar.gz -C /opt/soft/hadoop260/ --strip-components 13、接下来修改6个配置⽂件⾸先进⼊到/opt/soft/hadoop260/etc/hadoop这个⽂件夹,在执⾏下⾯的修改 1.修改hadoop-env.sh⽂件,将jdk配置进去。

这个是hadoop启动时的环境脚本[root@hadoopsingle hadoop]# vim hadoop-env.sh在下⾯这个位置,将你jdk的路径填上# The java implementation to use.export JAVA_HOME=/opt/soft/jdk180 2.修改core-site.xml⽂件。

[root@hadoopsingle hadoop]# vim core-site.xml修改如下:汉字为解释记得删掉<!-- Put site-specific property overrides in this file. --><configuration> <property> ⽂件系统的对外接⼝,就填⼊该单机的IP地址,端⼝通⽤9000(⽐如以后Java连接时的接⼝) <name>fs.defaultFS</name> <value>hdfs://192.168.234.200:9000</value> </property> <property> 存储系统临时⽂件的地⽅ <name>hadoop.tmp.dir</name> <value>/opt/soft/hadoop260/tmp</value> </property> <property> 将来任何组都可以访问该hadoop系统,只要是root⽤户的 <name>hadoop.proxyuser.root.groups</name> <value>*</value> </property> <property> 远程访问权限,只要是root⽤户的 <name>hadoop.proxyuser.root.hosts</name> <value>*</value> </property> <property> 任何user都可登录,只要是root⽤户的 <name>ers</name> <value>*</value> </property></configuration>如果不是root⽤户,就必须到HDFS系统进⾏授权 3.修改hdfs-site.xml ⽂件[root@hadoopsingle hadoop]# vim hdfs-site.xml添加如下:<!-- Put site-specific property overrides in this file. --><configuration> <property> ⽂件存进来时,备份多少遍。

hadoop伪分布式搭建(2)

hadoop伪分布式搭建(2)需要hadoop安装包,xshell,Linux的jdk,百度搜索下载即可打开xshell,点击⽂件,新建名称随意,主机填写虚拟机的IP地址(虚拟机要先开机),协议选择ssh输⼊⽤户名密码之类的即可连接虚拟机。

之后可以通过是shell命令来对虚拟机进⾏操作先创建两个⽂件夹⼀个⽤来放压缩包⼀个⽤来放软件,代码:mkdir app (存放软件)mkdir soft(存放压缩包)再点击⽂件新建⼀个连接:这次上⾯选择SFTP(⽤于传⽂件)其他照着前⾯填就⾏通过cd命令进⼊soft⽬录,再将压缩包拖进来即可会到ssh协议建⽴的选项卡,通过cd命令进⼊soft⽬录通过ll命令查看,即可看到安装包通过tar命令将两个压缩包解压到同级⽬录app中这样,我们jdk和Hadoop就安装ok了,接下⾥的就是配置问题了。

通过命令sudo vim /etc/profile 配置环境变量如图配置JAVA_HOME,HADOOP_HOME填写⾃⼰安装的⽬录其他照着填即可最后是Hadoop的五个配置⽂件了,配置⽅法如下:先进⼊Hadoop的etc⽬录的hadoop⽬录下:通过ll命令即可查看⽂件我们需要配置五个⽂件:hadoop-env.shcore-site.xmlhdfs-site.xmlmapred-site.xmlyarn-site.xml1hadoop-env.shvim hadoop-env.shexport JAVA_HOME=/usr/java/jdk1.7.0_652core-site.xml<property><name>fs.defaultFS</name><value>hdfs://hadoop00:9000</value></property><!-- 指定hadoop运⾏时产⽣⽂件的存储⽬录 --> <property><name>hadoop.tmp.dir</name><value>/home/hadoop/hadoop-2.4.1/tmp</value> </property>3hdfs-site.xml<!-- 指定HDFS副本的数量 --><property><name>dfs.replication</name><value>1</value></property>4mapred-site.xmlmv mapred-site.xml.template mapred-site.xml vim mapred-site.xml<!-- 指定mr运⾏在yarn上 --><property><name></name><value>yarn</value></property>5yarn-site.xml<!-- 指定YARN的⽼⼤(ResourceManager)的地址 --><property><name>yarn.resourcemanager.hostname</name><value>hadoop00:9000</value></property><!-- reducer获取数据的⽅式 --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property>按照上⾯配置即可,通过vi命令进⼊⽂件,将对应的代码填在对应对接的<configrutation></configrutation>中即可.。

1.Hadoop集群搭建(单机伪分布式)

1.Hadoop集群搭建(单机伪分布式)>>>加磁盘1)⾸先先将虚拟机关机2)选中需要加硬盘的虚拟机:右键-->设置-->选中硬盘,点击添加-->默认选中硬盘,点击下⼀步-->默认硬盘类型SCSI(S),下⼀步-->默认创建新虚拟磁盘(V),下⼀步-->根据实际需求,指定磁盘容量(单个或多个⽂件⽆所谓,选哪个都⾏),下⼀步。

-->指定磁盘⽂件,选择浏览,找到现有虚拟机的位置(第⼀次出现.vmdk⽂件的⽂件夹),放到⼀起,便于管理。

点击完成。

-->点击确定。

3) 可以看到现在选中的虚拟机有两块硬盘,点击开启虚拟机。

这个加硬盘只是在VMWare中,实际⼯作中直接买了硬盘加上就可以了。

4)对/dev/sdb进⾏分区df -h 查看当前已⽤磁盘分区fdisk -l 查看所有磁盘情况磁盘利⽤情况,依次对磁盘命名的规范为,第⼀块磁盘sda,第⼆块为sdb,第三块为sdc。

可以看到下图的Disk /dev/sda以第⼀块磁盘为例,磁盘分区的命名规范依次为sda1,sda2,sda3。

同理也会有sdb1,sdb2,sdb3。

可以参照下图的/dev/sda1。

下⾯的含义代表sda盘有53.7GB,共分为6527个磁柱,每个磁柱单元Units的⼤⼩为16065*512=8225280 bytes。

sda1分区为1-26号磁柱,sda2分区为26-287号磁柱,sda3为287-6528号磁柱下⾯的图⽚可以看到,还未对sdb磁盘进⾏分区fdisk /dev/sdb 分区命令可以选择m查看帮助,显⽰命令列表p 显⽰磁盘分区,同fdisk -ln 新增分区d 删除分区w 写⼊并退出选w直接将分区表写⼊保存,并退出。

mkfs -t ext4 /dev/sdb1 格式化分区,ext4是⼀种格式mkdir /newdisk 在根⽬录下创建⼀个⽤于挂载的⽂件mount /dev/sdb1 /newdisk 挂载sdb1到/newdisk⽂件(这只是临时挂载的解决⽅案,重启机器就会发现失去挂载)blkid /dev/sdb1 通过blkid命令⽣成UUIDvi /etc/fstab 编辑fstab挂载⽂件,新建⼀⾏挂载记录,将上⾯⽣成的UUID替换muount -a 执⾏后⽴即⽣效,不然的话是重启以后才⽣效。

hadoop2.4.1伪分布式搭建

1.5重启Linux

reboot

2.安装JDK

2.1上传

2.2解压jdk

#创建文件夹

mkdir /usr/java

#解压

tar -zxvf jdk-7u55-linux-i586.tar.gz -C /usr/java/

2.3将java添加到环境变量中

再启动YARN

sbin/start-yarn.sh

3.5验证是否启动成功

使用jps命令验证

27408 NameNode

28218 Jps

27643 SecondaryNameNode

28066 NodeManager

27803 ResourceManager

第二种:修改配置文件方式(屌丝程序猿专用)

vim /etc/sysconfig/network-scripts/ifcfg-eth0

DEVICE="eth0"

BOOTPROTO="static" ###

HWADDR="00:0C:29:3C:BF:E7"

第二个:core-site.xml

<!-- 制定HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://itcast01:9000</value>

</prop/etc/proflie

export JAVA_HOME=/usr/java/jdk1.7.0_65

export HADOOP_HOME=/itcast/hadoop-2.4.1

Linux CentOS下Hadoop伪分布模式安装笔记

Linux CentOS下Hadoop伪分布模式安装笔记一. 概要经过几天的调试,终于在Linux Cent OS 5.0下成功搭建Hadoop测试环境。

本次测试在一台服务器上进行伪分布式搭建。

Hadoop 伪分布式模式是在单机上模拟 Hadoop 分布式,单机上的分布式并不是真正的伪分布式,而是使用线程模拟分布式。

Hadoop 本身是无法区分伪分布式和分布式的,两种配置也很相似,唯一不同的地方是伪分布式是在单机器上配置,数据节点和名字节点均是一个机器。

虽然Hadoop的安装步骤并不复杂,但是我在安装期间还是遇到了很多琐碎的问题,现将自己搭建Hadoop的详细过程和遇到的问题记录下来。

二. 环境搭建搭建测试环境所需的软件包括:jdk1.6.0_20、hadoop-0.20.2.tar.gz。

测试服务器操作系统Linux Cent OS 5.0。

1. SSH无密码验证配置Hadoop 需要使用SSH 协议,namenode 将使用SSH 协议启动 namenode和datanode 进程,伪分布式模式数据节点和名称节点均是本身,必须配置 SSH localhost无密码验证。

用root用户登录,在家目录下执行如下命令:ssh-keygen -t rsa[root@master ~]# ssh-keygen -t rsaGenerating public/private rsa key pair.Enter file in which to save the key (/root/.ssh/id_rsa): & 按回车默认路径 &Created directory '/root/.ssh'. &创建/root/.ssh目录&Enter passphrase (empty for no passphrase):Enter same passphrase again:Your identification has been saved in /root/.ssh/id_rsa.Your public key has been saved in /root/.ssh/id_rsa.pub.The key fingerprint is:c6:7e:57:59:0a:2d:85:49:23:cc:c4:58:ff:db:5b:38 root@master通过以上命令将在/root/.ssh/ 目录下生成id_rsa私钥和id_rsa.pub公钥。

hadoop深入浅出-伪分布式集群搭建

第一步:准备Linux环境

1.1修改主机名 vim /etc/sysconfig/network NETWORKING=yes HOSTNAME=hadoop01

1.2修改IP,两种方式,第一种:通过Linux图形界面进行修改(强烈 推荐)进入Linux图形界面 -> 右键点击右上方的两个小电脑 -> 点 击Edit connections -> 选中当前网络System eth0 -> 点击edit 按钮 -> 选择IPv4 -> method选择为manual -> 点击add按钮 > 添加IP:192.168.8.118 子网掩码:255.255.255.0 网关: 192.168.1.1 -> apply

16

+

14

Hadoop的特点

• 扩容能力(Scalable):能可靠地(reliably)存储和 处理千兆字节(PB)数据。 • 成本低(Economical):可以通过普通机器组成的服 务器群来分发以及处理数据。这些服务器群总计可达 数千个节点。 • 高效率(Efficient):通过分发数据,hadoop可以 在数据所在的节点上并行地(parallel)处理它们,这 使得处理非常的快速。 • 可靠性(Reliable):hadoop能自动地维护数据的多 份副本,并且在任务失败后能自动地重新部署 (redeploy)计算任务。

hadoop1.0和hadoop2.0的对比

Spark …

Storm

目录

Hadoop科普 Hadoop安装

Hadoop部署方式

• 本地模式—开发使用

Hadoop的默认配置即为本地模式,此时Hadoop使用本地文件系统而非分布式文件系统,而

Hadoop的伪分布式安装和部署的流程

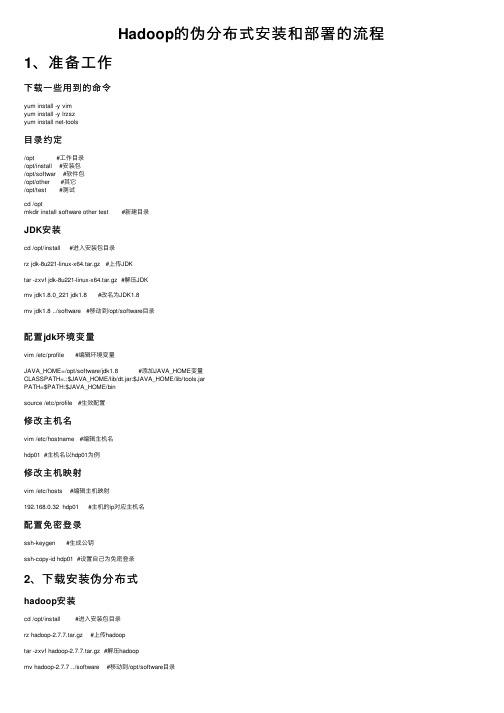

Hadoop的伪分布式安装和部署的流程1、准备⼯作下载⼀些⽤到的命令yum install -y vimyum install -y lrzszyum install net-tools⽬录约定/opt #⼯作⽬录/opt/install #安装包/opt/softwar #软件包/opt/other #其它/opt/test #测试cd /optmkdir install software other test #新建⽬录JDK安装cd /opt/install #进⼊安装包⽬录rz jdk-8u221-linux-x64.tar.gz #上传JDKtar -zxvf jdk-8u221-linux-x64.tar.gz #解压JDKmv jdk1.8.0_221 jdk1.8 #改名为JDK1.8mv jdk1.8 ../software #移动到/opt/software⽬录配置jdk环境变量vim /etc/profile #编辑环境变量JAVA_HOME=/opt/software/jdk1.8 #添加JAVA_HOME变量CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarPATH=$PATH:$JAVA_HOME/binsource /etc/profile #⽣效配置修改主机名vim /etc/hostname #编辑主机名hdp01 #主机名以hdp01为例修改主机映射vim /etc/hosts #编辑主机映射192.168.0.32 hdp01 #主机的ip对应主机名配置免密登录ssh-keygen #⽣成公钥ssh-copy-id hdp01 #设置⾃⼰为免密登录2、下载安装伪分布式hadoop安装cd /opt/install #进⼊安装包⽬录rz hadoop-2.7.7.tar.gz #上传hadooptar -zxvf hadoop-2.7.7.tar.gz #解压hadoopmv hadoop-2.7.7 ../software #移动到/opt/software⽬录修改hadoop的6个配置⽂件cd /opt/software/hadoop-2.7.7/etc/hadoop #进⼊配置⽂件⽬录hadoop-env.shvim hadoop-env.sh #编辑配置⽂件hadoop-env.shexport JAVA_HOME=/opt/software/jdk1.8 #修改25⾏export HADOOP_CONF_DIR=/opt/software/hadoop-2.7.7/etc/hadoop #修改33⾏core-site.xmlvim core-site.xml #编辑配置⽂件core-site.xml<configuration><property><name>fs.defaultFS</name><value>hdfs://hdp01:9000</value> #hdp01为主机名</property><property><name>hadoop.tmp.dir</name><value>/opt/software/hadoop-2.7.7/tmp</value></property></configuration>hdfs-site.xmlvim hdfs-site.xml #编辑配置⽂件hdfs-site.xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>mapred-site.xmlcp mapred-site.xml.template mapred-site.xml #拷贝例⼦vim mapred-site.xml #编辑配置⽂件mapred-site.xml<configuration><property><name></name><value>yarn</value></property></configuration>yarn-site.xmlvim yarn-site.xml #编辑配置⽂件yarn-site.xml<configuration><property><name>yarn.resourcemanager.hostname</name><value>hdp01</value> #hdp01为主机名</property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property></configuration>slavesvim slaves #编辑配置⽂件slaveshdp01 #主机名配置hadoop的环境变量vim /etc/profile #编辑环境变量JAVA_HOME=/opt/software/jdk1.8CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarHADOOP_HOME=/opt/software/hadoop-2.7.7PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin source /etc/profile #⽣效配置格式化⽂件系统hadoop namenode -format运⾏服务器start-all.sh #开启stop-all.sh #关闭查看系统端⼝netstat -nltup。

windows 下, Hadoop 伪分布式环境搭建

Hadoop 伪分布式环境搭建1、Hadoop 的起源我们生活在数据时代,随着计算机的飞速发展,磁盘存储量的快速增加,普通计算机TB级的硬盘都已经司空见惯。

TB、PB甚至更高的海量数据的处理对于一般计算机而言,意味着非常严峻甚至无法胜任的挑战。

因此,如何高效的分析和管理海量数据,已成为当前急需解决的问题。

2002年,Apache 开源组织创建了Nutch 项目,该项目是一个网页爬取工具和搜索引擎系统,但是该架构可扩展度不够,不能解决数十亿网页的搜索问题。

、而在之后的2003,谷歌公布了GFS(Google File System)、MapReduce等高可扩展、高性能的分布式海量数据处理框架,并证明了该框架在处理海量数据时的优越性。

受谷歌GFS的启发,2004年Apache开始着手创建一个开源的实现,即NDFS(Nutch的分布式文件系统)2005年初,该项目在Nutch 上得到了实现,并用MapReduce 和NDFS来运行2006年,Apache 将NDFS和MapReduce 移出Nutch,形成Lucene下的一个子项目,并命名为为Hadoop。

2008年4月,Hadoop在209秒内,完成了对1TB数据的排序,打破了世界纪录MapReduce:分布式计算(Map:任务的分解,Reduce:结果的汇总)2、下载搭建环境需要的软件1)Hadoop下载地址:/hadoop/common/我们这里使用的版本是稳定版1.0.42)Cygwin下载地址:/setup.exehadoop 环境需要搭建在Linux 操作系统下,Cygwin 是一款在windows平台上运行的Linux模拟环境,当然,如果直接使用Linux 或者用虚拟机搭建Linux 也可以,我们这里是以Cygwin 为例,如在Linux 下的搭建与此大同小异。

3、软件安装1)jdk安装方法:略,网上例子很多。

注:JDK 的安装路径禁止包含空格,因为Linux 下的路径对空格的处理很麻烦,所以,以下凡是涉及到路径的地方,建议最好不要使用空格。

Hadoop伪分布式集群搭建详细笔记

*]$ rm -rf 非空文件夹名 //删除非空文件夹

*]$ rm 文件名 //删除文件

*]$ rmdir 文件夹名 //不能删除非空文件夹

*]$ mv oldfilename newfilename //文件重命名

——————————————————————

3、虚拟机网络配置:有线(wired)添加新的配置(删除其他网络)——>取名(hadoop)——>配置IP

——>子网掩码、网关——>配置DNS(设置成虚拟机网关一致就可)

4、测试:上网、ping通主机、主机ping通内网、结束ping(ctrl+c)

注:如果默认端口改动,需要做端口映射,虚拟机才能与主机互连。

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

———————————————————————

5.3

]# vim mapred-site.xml

export CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:$CLASSPATH

—————————————————————————————

——————————方法二————————————————

export JAVA_HOME=/usr/java/jdk1.8.0_25

Hadoop2.x伪分布式环境搭建(一)

Hadoop2.x伪分布式环境搭建(⼀)1、安装hadoop环境,以hadoop-2.5.0版本为例,搭建伪分布式环境,所需要⼯具包提供⽹盘下载:2、上传所需要的⼯具包到linux相对就应的⽬录中3、接上篇(Linux基础环境的各项配置(三)中最后⼀部分,需卸载系统⾃带的jdk,以免后续安装的jdk产⽣冲突),卸载jdk完成后,安装jdk-7u67-linux-x64.tar.gz 版本,上述⼯具包可下载(1)、解压JDKtar -zxf jdk-7u67-linux-x64.tar.gz -C ../model/(2)、配置环境变量,在/etc/profile配置⽂件末尾加⼊如下内容(需要管理员权限才能操作此⽂件)##JAVA_HOMEexport JAVA_HOME=/opt/model/jdk1.7.0_67export PATH=$PATH:$JAVA_HOME/bin(3)、让⽂件⽣效执⾏如下命令source /etc/profile(4)、执⾏java -version命令,出现如下图所⽰则jdk配置成功4、hadoop-2.5.0安装与配置(1)、解压下载好的hadoop-2.5.0.tar.gz包tar -zxf hadoop-2.5.0.tar.gz -C ../model/(2)、进⼊hadoop-2.5.0⽬录,在当前路径的share⽬录下,有个doc⽬录,此⽬录存放的都是官⽅英⽂说明⽂档,基本没⽤且占⽤空间及⼤,建议删除此⽬录,为后续发送集群节点节省时间rm -rf share/doc(3)、修改/opt/model/hadoop-2.5.0/etc/hadoop⽬录下hadoop-env.sh、mapred-env.sh、yarn-env.sh这三个配置⽂件,设置JAVA_HOME安装⽬录,如下所⽰export JAVA_HOME=/opt/model/jdk1.7.0_67(4)、修改core-site.xml配置⽂件,内容如下<configuration><!--指定namenode主节点所在的位置以及交互端⼝号--><property><name>fs.defaultFS</name><value>hdfs://:8020</value></property><!--更改hadoop.tmp.dir的默认临时⽬录路径--><!-- /opt/model/hadoop-2.5.0/data/tmp 这个路径需⾃⼰先⾏创建 --><property><name>hadoop.tmp.dir</name><value>/opt/model/hadoop-2.5.0/data/tmp</value></property></configuration>(5)、修改slaves配置⽂件,内容修改如下#定义datanode从节点所在哪台机器,由于此次笔记是伪分布式安装,所有主从节点都在⼀台机器上,所以主机名都是⼀样(6)、修改hdfs-site.xml配置⽂件,内容如下<configuration><!--指定副本个数,默认值是3个--><property><name>dfs.replication</name><value>1</value></property></configuration>(7)、修改yarn-site.xml配置⽂件,内容如下<configuration><!-- 指定yarn上运⾏的是mapreduce程序 --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!--指定ResourceManager的位置--><property><name>yarn.resourcemanager.hostname</name><value></value></property></configuration>(8)、将mapred-site.xml.template⽂件重命名为mapred-site.xml,并修改其内容如下<configuration><!--指定MapReduce运⾏在YARN上--><property><name></name><value>yarn</value></property></configuration>(9)、对于NameNode进⾏格式化操作,命令如下(只需要⼀次格式化,多次格式化会出错):bin/hdfs namenode -format出现如下图所⽰,表⽰格式化成功,若格式化出现错误,则需要仔细查找⽇志信息,查找出错原因,再次格式之前,⼀定把/opt/model/hadoop-2.5.0/data/tmp⽬录下的⽂件删除⼲净5、hadoop-2.5.0上述步骤操作完毕后,即可启动相关进程sbin/hadoop-daemon.sh start namenodesbin/hadoop-daemon.sh start datanodesbin/yarn-daemon.sh start resourcemanagersbin/yarn-daemon.sh start nodemanager在web页⾯访问hdfs以及yarn信息页⾯,说明启动成功了,如下图所⽰6、继续开启⾃带历史服务器和⽇志聚集功能(1)、修改mapred-site.xml配置⽂件,配置历史服务器,添加如下内容<!-- 指定历史服务器的所在机器 --><property><name>mapreduce.jobhistory.address</name><value>:10020</value></property><!-- 指定历史服务器外部访问地址 --><property><name>mapreduce.jobhistory.webapp.address</name><value>:19888</value></property>(2)、修改yarn-site.xml配置⽂件,开启⽇志聚集功能,添加如下内容<!-- 指定是否开启⽇志聚集功能 --><property><name>yarn.log-aggregation-enable</name><value>true</value></property><!-- 设置⽇志在HDFS上保留的时间期限 --><property><name>yarn.log-aggregation.retain-seconds</name><value>106800</value></property>7、HDFS⽂件权限的修改(1)、修改hdfs-site.xml配置⽂件,设置不检查⽂件权限,添加如下内容<!--设置不启⽤HDFS⽂件系统的权限检查--><property><name>dfs.permissions.enabled</name><value>false</value></property>(2)、修改core-site.xml配置⽂件,设置不检查⽂件权限,添加如下内容<!--指定修改Hadoop静态⽤户名,建议设为hadoop启动⽤户--><property><name>er</name><value>dhong</value></property>8、重启上述6、7步修改过配置⽂件的相关进程,并运⾏程序测试,修改是否正确总结: 以上步骤是hadoop环境的基本配置,可以在上⾯跑wordcount程序了,由于是⽤伪分布式搭建的环境,配置⽐较简单,仅供搭建实验环境参考,在真实的⼯作当中,hadoop要配置的信息远不⽌这些,也为⾃⼰学习⼤数据记录⼀些简单的笔记。

基于hadoop的伪分布式系统搭建

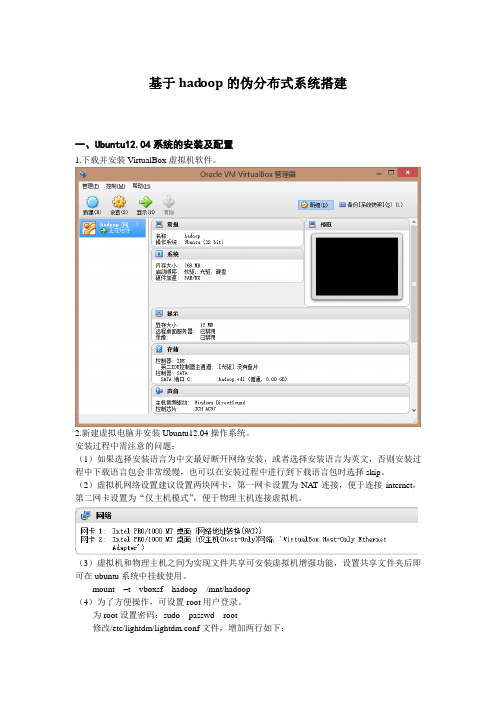

基于had oop的伪分布式系统搭建一、Ubuntu12.04系统的安装及配置1.下载并安装VirtualBox虚拟机软件。

2.新建虚拟电脑并安装Ubuntu12.04操作系统。

安装过程中需注意的问题:(1)如果选择安装语言为中文最好断开网络安装,或者选择安装语言为英文,否则安装过程中下载语言包会非常缓慢,也可以在安装过程中进行到下载语言包时选择skip。

(2)虚拟机网络设置建议设置两块网卡,第一网卡设置为NA T连接,便于连接internet,第二网卡设置为“仅主机模式”,便于物理主机连接虚拟机。

(3)虚拟机和物理主机之间为实现文件共享可安装虚拟机增强功能,设置共享文件夹后即可在ubuntu系统中挂载使用。

mount –t vboxsf hadoop /mnt/hadoop(4)为了方便操作,可设置root用户登录。

为root设置密码:sudo passwd root修改/etc/lightdm/lightdm.conf文件,增加两行如下:greeter-show-manual-login=trueallow-guest=false二、JDK和hadoop的安装及配置1.将jdk安装包解压到/usr/lib/jvm目录下,用gedit编辑/etc/profile文件,设置jdk环境变量,并设置为默认jdk。

2.解压hadoop安装包到/home/lvj/hadoop/hadoop目录下,并将解压得到的hadoop0.20.2重命名为hadoop,修改配置文件hadoop-env.sh添加环境变量。

export JA V A_HOME=/usr/lib/jvm/jdk1.7.03.安装ssh并配置ssh免密码登录。

apt-get install ssh4.分别修改/home/lvj/hadoop/hadoop/hadoop/conf目录下core-site.xml、hdfs-site.xml、mapred-site.xml文件。

hadoop伪分布式集群搭建步骤

hadoop伪分布式集群搭建步骤1. 关闭防⽕墙2. 安装JDK3. 修改主机名。

Hadoop要求主机名中不能出现-或者_vim /etc/sysconfig/network修改HOSTNAME保存退出,重新⽣效:source /etc/sysconfig/network4. 将主机名和IP进⾏映射vim /etc/hosts例如:10.42.169.138 hadoop1385. 重启:reboot6. 需要配置节点的免密互通(远程登录)ssh-keygenssh-copy-id root@hadoop138ssh hadoop1387.下载安装hadoop安装包wget 指定地址tar -xvf 压缩⽂件名8. 进⼊安装⽬录的⼦⽬录etc/hadoop下cd etc/hadoop9. 修改hadoop-env.sh(配置java和hadoop的环境变量)vim hadoop-env.sh修改JAVA_HOME以及HADOOP_CONF_DIR的值export JAVA_HOME=/home/presoftware/jdk1.8export HADOOP_CONF_DIR=/home/software/hadoop-2.7.1/etc/hadoop重新⽣效source hadoop-env.sh10. 修改core-site.xmlvim core-site.xml添加:<!-- ⽤于指定NameNode所在节点的 --><property><name>fs.defaultFS</name><value>hdfs://hadoop138:9000</value></property><!-- 指定数据的存储⽬录 --><property><name>hadoop.tmp.dir</name><value>/home/software/hadoop-2.7.1/tmp</value></property>11. 修改hdfs-site.xml(配置副本数量)vim hdfs-site.xml添加:<property><name>dfs.replication</name><value>1</value></property>12. 复制⽂件(为mapreduce配置yarn组件)cp mapred-site.xml.template mapred-site.xml修改mapred-site.xmlvim mapred-site.xml添加<property><name></name><value>yarn</value></property>13.为yarn组件配置主机名修改yarn-site.xml:vim yarn-site.xml添加:<property><name>yarn.resourcemanager.hostname</name><value>hadoop01</value></property><property><!--为nodemanager提供⾃⼰的服务--><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property>14. 修改slaves:vim slaves添加当前节点的主机名15. 修改环境变量:vim /etc/profile添加:export HADOOP_HOME=/home/software/hadoop-2.7.1export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin重新⽣效:source /etc/profile16. 第⼀次启动Hadoop需要进⾏⼀次格式化:hadoop namenode -format17. 启动Hadoop:start-all.sh如果启动成功,会出现6个进程:JpsNameNodeDataNodeSecondaryNameNodeResourceManagerNodeManagerHadoop在启动的时候,如果多次格式化,那么启动的时候⼀定会缺少NameNode或者DataNode中的⼀个--- 如果出现这个问题,那么删除hadoop安装⽬录下的tmp⽬录,然后重新格式化,重新启动登录到可视化界⾯:10.42.169.138:50070。

简述hadoop伪分布式环境搭建流程

Hadoop是一个能够处理大规模数据的分布式系统框架,它能够在集裙中运行并管理大量的数据。

在学习和使用Hadoop时,搭建一个伪分布式环境是非常有必要的。

伪分布式环境搭建流程如下:1. 准备环境在开始搭建Hadoop伪分布式环境之前,首先需要安装并配置好Java 环境。

Hadoop是基于Java开发的,所以Java环境是必不可少的。

2. 下载Hadoop首先在官全球信息站下载Hadoop的最新版本,然后解压到指定的目录。

解压后的目录就是Hadoop的安装目录。

3. 配置Hadoop环境变量在解压得到的Hadoop安装目录中,找到etc/hadoop目录,这是Hadoop的配置文件目录。

在该目录下,打开hadoop-env.sh文件,设置JAVA_HOME变量为你的Java安装路径。

4. 配置Hadoop的核心文件在etc/hadoop目录下,打开core-site.xml文件,设置Hadoop的核心配置信息。

包括Hadoop的基本参数、HDFS的URL位置区域等。

5. 配置Hadoop的HDFS文件系统同样在etc/hadoop目录下,打开hdfs-site.xml文件,设置Hadoop的HDFS配置信息。

包括数据的存储路径、副本数量等。

6. 配置Hadoop的MapReduce框架在etc/hadoop目录下,打开mapred-site.xml.template文件,设置Hadoop的MapReduce配置信息。

包括MapReduce框架的工作目录、框架的框架数据存储路径等。

7. 配置Hadoop的主节点和从节点在etc/hadoop目录下,打开slaves文件,配置Hadoop的主节点和从节点信息。

可以设置本地主机为主节点,也可以配置其他从节点的IP位置区域。

8. 格式化HDFS在命令行中输入命令:hdfs namenode -format,即可格式化HDFS 文件系统。

这一步是为了清空HDFS文件系统中的旧数据,重新初始化HDFS。

Hadoop(二)搭建伪分布式集群

Hadoop(⼆)搭建伪分布式集群前⾔ 前⾯只是⼤概介绍了⼀下Hadoop,现在就开始搭建集群了。

我们下尝试⼀下搭建⼀个最简单的集群。

之后为什么要这样搭建会慢慢的分享,先要看⼀下效果吧!⼀、Hadoop的三种运⾏模式(启动模式)1.1、单机模式(独⽴模式)(Local或Standalone Mode) -默认情况下,Hadoop即处于该模式,⽤于开发和调式。

-不对配置⽂件进⾏修改。

-使⽤本地⽂件系统,⽽不是分布式⽂件系统。

-Hadoop不会启动NameNode、DataNode、JobTracker、TaskTracker等守护进程,Map()和Reduce()任务作为同⼀个进程的不同部分来执⾏的。

-⽤于对MapReduce程序的逻辑进⾏调试,确保程序的正确。

1.2、伪分布式模式(Pseudo-Distrubuted Mode) -Hadoop的守护进程运⾏在本机机器,模拟⼀个⼩规模的集群 -在⼀台主机模拟多主机。

-Hadoop启动NameNode、DataNode、JobTracker、TaskTracker这些守护进程都在同⼀台机器上运⾏,是相互独⽴的Java进程。

-在这种模式下,Hadoop使⽤的是分布式⽂件系统,各个作业也是由JobTraker服务,来管理的独⽴进程。

在单机模式之上增加了代码调试功能,允许检查内存使⽤情况,HDFS输⼊输出, 以及其他的守护进程交互。

类似于完全分布式模式,因此,这种模式常⽤来开发测试Hadoop程序的执⾏是否正确。

-修改3个配置⽂件:core-site.xml(Hadoop集群的特性,作⽤于全部进程及客户端)、hdfs-site.xml(配置HDFS集群的⼯作属性)、mapred-site.xml(配置MapReduce集群的属性) -格式化⽂件系统1.3、全分布式集群模式(Full-Distributed Mode) -Hadoop的守护进程运⾏在⼀个集群上 -Hadoop的守护进程运⾏在由多台主机搭建的集群上,是真正的⽣产环境。

Hadoop 2.6.0伪分布式配置详解分享_光环大数据培训

Hadoop 2.6.0伪分布式配置详解分享_光环大数据培训首先先不看理论,搭建起环境之后再看;搭建伪分布式是为了模拟环境,调试方便。

电脑是Windows 10,用的虚拟机VMware Workstation 12 Pro,跑的Linux 系统是CentOS6.5 ,安装的hadoop2.6.0,jdk1.8;1.准备工作准备工作:把JDK和Hadoop安装包上传到linux系统(hadoop用户的根目录)系统环境:IP:192.168.80.99,linux用户:root/123456,hadoop/123456主机名:node把防火墙关闭,root执行:service iptables stop2.jdk安装1 .在 hadoop 用户的根目录, Jdk 解压,( hadoop 用户操作)tar -zxvfjdk-8u65-linux-x64.tar.gz 解压完成后,在 hadoop 用户的根目录有一个 jdk1.8.0_65目录2.配置环境变量,需要修改 /etc/profile 文件( root 用户操作)切到 root 用户,输入 su 命令 vi /etc/profile 进去编辑器后,输入 i ,进入 vi 编辑器的插入模式在 profile 文件最后添加JAVA_HOME=/home/hadoop/jdk1.8.0_65export PATH=$PATH:$JAVA_HOME/bin编辑完成后,按下 esc 退出插入模式输入:,这时在左下角有一个冒号的标识q 退出不保存wq 保存退出q! 强制退出3. 把修改的环境变量生效( hadoop用户操作)执行 source /etc/profile4.执行java -version 查看版本,如果成功证明jdk配置成功3.Hadoop 安装1.在 hadoop 用户的根目录,解压( hadoop 用户操作)tar -zxvf hadoop-2.6.0.tar.gz解压完成在 hadoop 用户的根目录下有一个 hadoop-2.6.0目录2.修改配置文件hadoop-2.6.0/etc/hadoop/hadoop-env.sh ( hadoop 用户操作)export JAVA_HOME=/home/hadoop/jdk1.8.0_653.修改配置文件hadoop-2.6.0/etc/hadoop/core-site.xml ,添加( hadoop 用户操作)<property><name>fs.defaultFS</name><value>hdfs://node:9000</value></property>4.修改配置文件hadoop-2.6.0/etc/hadoop/hdfs-site.xml ,添加( hadoop 用户操作)<property><name>dfs.replication</name><value>1</value></property>5.修改修改配置文件hadoop-2.6.0/etc/hadoop/mapred-site.xml ( hadoop 用户操作),这个文件没有,需要复制一份cp etc/hadoop/mapred-site.xml.template etc/hadoop/mapred-site.xml添加<property><name></name><value>yarn</value></property>6.修改配置文件hadoop-2.6.0/etc/hadoop/yarn-site.xml ,添加( hadoop 用户操作)<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property>7.修改主机名称(root 用户操作),重启生效vi /etc/sysconfig/network修改HOSTNAME 的值为用户名8.修改 /etc/hosts 文件( root 用户操作) , 添加: ip 主机名称192.168.44.199(用自己的ip,下边讲如何获得) node附:查看ip地址编辑-->虚拟网络编辑器net模式,选DHCP设置,得到ip地址起始net设置,得到网关点右边小电脑,选择VPN Connections-->Configue VPN选中eth0,点有右边edit选择IP Settings ,根据自己的ip按图修改,Address就是你的ip地址,在起始ip地址和结束ip地址之间选一个就行9. 格式化 HDFS ,在 hadoop 解压目录下,执行如下命令:( hadoop 用户操作)bin/hdfs namenode -format注意:格式化只能操作一次,如果因为某种原因,集群不能用,需要再次格式化,需要把上一次格式化的信息删除,在 /tmp 目录里执行 rm –rf *10. 启动集群,在 hadoop 解压目录下,执行如下命令:( hadoop 用户操作,截图用机后来改过,主机为gp )启动集群: sbin/start-all.sh 需要输入四次当前用户的密码 ( 通过配置 ssh 互信解决,截图用机已经配置过ssh不用输密码 )启动后,在命令行输入 jps 有以下输出关闭集群: sbin/stop-all.sh 需要输入四次当前用户的密码 ( 通过配置 ssh 互信解决,我的同上)4.SSH互信配置(hadoop用户操作)rsa加密方法,公钥和私钥1.生成公钥和私钥在命令行执行ssh-keygen,然后回车,然后会提示输入内容,什么都不用写,一路回车在hadoop用户根目录下,有一个.ssh目录id_rsa 私钥id_rsa.pub 公钥known_hosts 通过SSH链接到本主机,都会在这里有记录2.把公钥给信任的主机(本机)在命令行输入ssh-copy-id 主机名称ssh-copy-id hadoop复制的过程中需要输入信任主机的密码3.验证,在命令行输入:ssh 信任主机名称ssh hadoop如果没有提示输入密码,则配置成功为什么大家选择光环大数据!大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请专业的大数据领域知名讲师,确保教学的整体质量与教学水准。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

5、验证jdk安装是否成功 java -version

免密码ssh登陆设置

1、进入.ssh文件夹(即当前用户主目录/home/hadoop,.ssh是 隐藏的可以使用ls -a查看)

2、使用命令ssh-keygen -t rsa,由于不设置密码,所以就一直 回车就行(产生密钥)。 3、如果是root用户,默认生成文件在/root/.ssh中,进入该目录 中,使用命令cat id_rsa.put>>authorized_keys 把id_rsa.pub 追加到授权的 key 里面。

Hadoop 2.2.0 安装

2014年9月4号

Hadoop的运行方式

Hadoop运行方式分为三种,单机模式、伪分布式、 完全分布式

●单机模式:Hadoop无需配置,这种方式下,Hadoop被认为是一个单独的

java进程,该模式主要用于开发调试MapReduce程序的应用逻辑。

●伪分布式:看做只有一个节点的集群,在这个集群中,这个节点既是

4、重启ssh服务使其生效:service sshd restart 测试: 使用命令 ssh name,若不需要密码,则设置成功。

下载hadoop2.2.0并安装

1、下载地址为: /hadoop/common/hadoop-2.2.0/, 下载hadoop-2.2.0.tar.gz这个包,放在/usr目录下,使 用命令 tar -zxvf hadoop-2.2.0.tar.gz 解压即可。

如下为运行过程:

查看运行结果!

可能出现的问题

用缺省的32位native库(/usr/hadoop-2.2.0/lib/native)会出现下面的错误:

14/01/27 10:52:34 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable Starting namenodes on [Java HotSpot(TM) 64-Bit Server VM warning: You have loaded library /usr/hadoop-2.2.0/lib/native/libhadoop.so which might have disabled stack guard. The VM will try to fix the stack guard now. It's highly recommended that you fix the library with 'execstack -c ', or link it with '-z noexecstack'

2、配置HADOOP_HOME的环境变量 与JAVA_HOME类似,在/etc/profile最后添加 export HADOOP_HOME=/usr/hadoop-2.2.0

修改hadoop配置文件

修改的配置文件,在/usr/hadoop-2.2.0/etc/hadoop目录下, 跳转到该目录下,修改core-site.xml、hdfs-site.xml、mapred-site.xml、 yarn-site.xml 这四个配置文件。

主要是对namenode 和 datanode 存储路径的设置。

修改hadoop配置文件

3、vi mapred-site.xml

<configuration> <property> <name></name> <value>yarn</value> </property> <!-<property> <name>mapred.job.tracker</name> <value>http://127.0.0.1:9001</value> </property>--> </configuration>

2、vi hdfs-site.xml

<configuration> <property> <name>.dir</name> <value>/data/namenode</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/data/datanode</value> </property> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.permissions</name> <value>false</value> </property> </configuration>

Hadoop伪分布搭建步骤

一、环境准备 1、安装虚拟机,操作系统为RedHat企业版,64位 2、修改 hostname(可选) 3、安装JDK,须为64位,与操作系统相匹配,本次使用 jdk- 7u65-linux-x64.rpm 4、配置JAVA_HOME 在/etc/profile文件中添加 export JAVA_HOME=/*/java/jdk1.7.0_65等 5、使用命令java -version测试jdk安装是否成功。 二、免密码ssh登陆设置(可选) 三、下载hadoop2.2.0并解压安装 四、修改配置文件 1、core-site.xml 2、hdfs-site.xml 3、mapred-site.xml 4、yarn-site.xml 五、启动hadoop 六、测试运行

要想进一步了解Hadoop的最新情况,可登陆:

/

首先需要在hadoop-env.sh和yarn-env.sh这两个文件中添加: JAVA_HOME=/usr/java/jdk1.7.0_65

修改hadoop配置文件

1、vi core-site.xml

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property>

启动hadoop

命令在/usr/hadoop-2.2.0/bin下,启动文件在/usr/hadoop-2.2.0/sbin下 1、格式化namenode bin/hdfs namenode -format 2、启动sbin/start-dfs.sh 3、启动sbin/start-yarn.sh (也可用sbin/start-all.sh同时启动所有) 4、jps 查看进程(一般为五个) 4312 NameNode 4756 ResourceManager 4428 DataNode 4855 NodeManager 4576 SecondaryNameNode 5、如果没有单独配置yarn-site.xml中的yarn.resourcemanager.webapp.address, 默认的端口8088 访问http://127.0.0.1:8088/ 可以访问hadoop管理页面. 如果没有单独配置 hdfs-site.xml中的node.http-address,默认端口 50070,http://127.0.0.1:50070 可以访问namenode节点信息。

<property> <name>hadoop.tmp.dir</name> <value>/data/hadoop/tmp</value> </property> </configuration>

添加hdfs的指定URL路径,由于是伪分布模式,可为真实ip、 localhost。

修改hadoop配置文件

修改hadoop配置文件

4、vi yarn-site.xml

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

在/etc/profile中添加:

export HADOOP_COMMON_LIB_NATIVE_DIR=${HADOOP_HOME}/lib/native export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib .preferIPv4Stack=true"

将下载好的JDK复制到安装目录下,本次为/usr 使用命令~$rpm -ivh jdk-7u65-linux-x64.rpm解压安装,默认安装好的路径为 /usr/java/jdk1.7.0_65,即JAVA_HOME

4、配置JAVA_HOME 在/etc/profile文件中添加:(vi /etc/profile打开) export JAVA_HOME= /usr/java/jdk1.7.0_45 export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export PATH=$JAVA_HOME/bin:$PATH 使用命令source /etc/profile使变更生效。