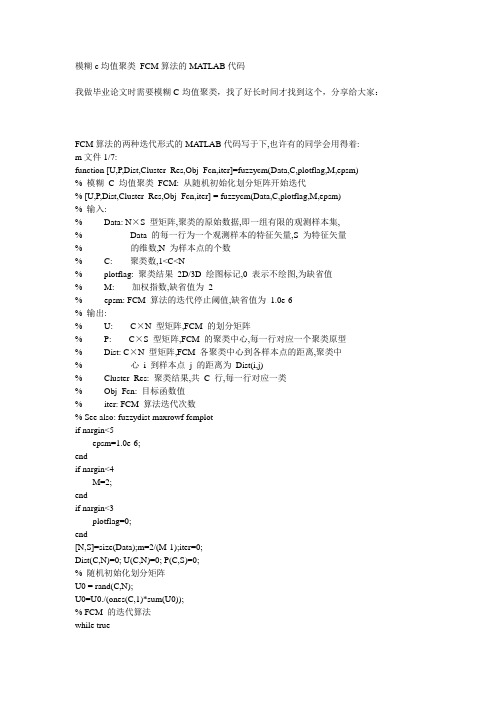

模糊c均值聚类 FCM算法的MATLAB代码

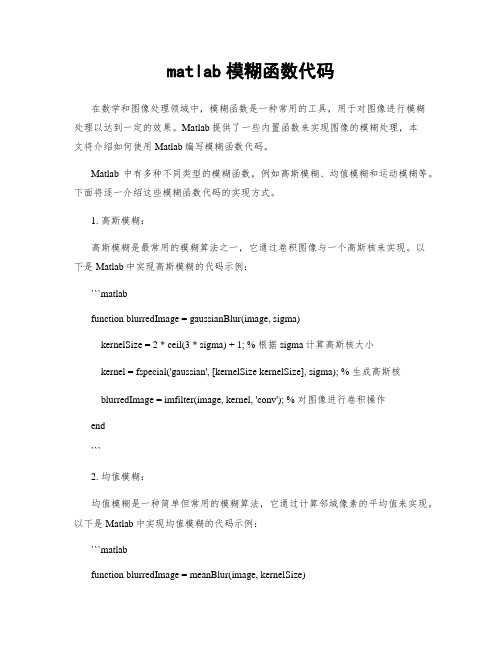

matlab模糊函数代码

matlab模糊函数代码在数学和图像处理领域中,模糊函数是一种常用的工具,用于对图像进行模糊处理以达到一定的效果。

Matlab提供了一些内置函数来实现图像的模糊处理,本文将介绍如何使用Matlab编写模糊函数代码。

Matlab中有多种不同类型的模糊函数,例如高斯模糊、均值模糊和运动模糊等。

下面将逐一介绍这些模糊函数代码的实现方式。

1. 高斯模糊:高斯模糊是最常用的模糊算法之一,它通过卷积图像与一个高斯核来实现。

以下是Matlab中实现高斯模糊的代码示例:```matlabfunction blurredImage = gaussianBlur(image, sigma)kernelSize = 2 * ceil(3 * sigma) + 1; % 根据sigma计算高斯核大小kernel = fspecial('gaussian', [kernelSize kernelSize], sigma); % 生成高斯核blurredImage = imfilter(image, kernel, 'conv'); % 对图像进行卷积操作end```2. 均值模糊:均值模糊是一种简单但常用的模糊算法,它通过计算邻域像素的平均值来实现。

以下是Matlab中实现均值模糊的代码示例:```matlabfunction blurredImage = meanBlur(image, kernelSize)kernel = ones(kernelSize) / (kernelSize^2); % 生成均值核blurredImage = imfilter(image, kernel, 'conv'); % 对图像进行卷积操作end```3. 运动模糊:运动模糊是一种模糊算法,它通过模拟相机快门打开时的移动效果来实现。

以下是Matlab中实现运动模糊的代码示例:```matlabfunction blurredImage = motionBlur(image, angle, distance)PSF = fspecial('motion', distance, angle); % 生成运动模糊核blurredImage = imfilter(image, PSF, 'conv'); % 对图像进行卷积操作end```以上是几种常见的模糊函数的Matlab代码实现。

MATLAB模糊c均值算法FCM分类全解复习课程

title('原图');

c=3;

%分类数

m=2;

%模糊度

e=0.0001; %阈值

A=double(img(:,:,1));

[n1,n2]=size(A);

A=reshape(A,n1*n2,1);

N=n1*n2;

%样本数

U0=rand(N,c);

U1=sum(U0,2 ); %求出每一行的元素总数

MATLAB模糊c均值算法FCM分 类全解

程序: %functio n [U,z,U1]=SARFCM %读入并显示图像 clear,clc

IMGN=input('Input Original Image Name: ','s');

img=imread(IMGN);

figure

imshow(img)

U2=repmat(U1,1,c);%将每一行总数复制成n*c矩阵

U=U0./U2;

clear U0 U1 U

while a

for j=1:c

V(j)=sum(U(:,j).^m.*A)/sum(U(:,j).^m); %求聚类中心

W(:,j)=abs(repmat(V(j),N,1)-A); %距离

a=0;

end

Z=Z+1

if Z>100

break

end

end

%输出图像

t=max(U,[],2); t=repmat(t,1,c); %最大值排成1*c U=double(t==U); for i=1:N

F(i)= find(U(i,:)==1); end F=reshape(F,n1,n2); map=[1,1,1;0,0,0;1,0,0;0,1,0;0,0,1] figure,imshow(uint8(F),map)

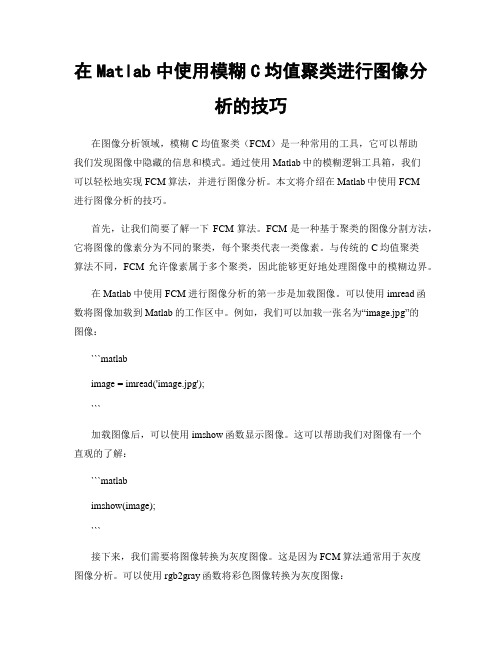

在Matlab中使用模糊C均值聚类进行图像分析的技巧

在Matlab中使用模糊C均值聚类进行图像分析的技巧在图像分析领域,模糊C均值聚类(FCM)是一种常用的工具,它可以帮助我们发现图像中隐藏的信息和模式。

通过使用Matlab中的模糊逻辑工具箱,我们可以轻松地实现FCM算法,并进行图像分析。

本文将介绍在Matlab中使用FCM进行图像分析的技巧。

首先,让我们简要了解一下FCM算法。

FCM是一种基于聚类的图像分割方法,它将图像的像素分为不同的聚类,每个聚类代表一类像素。

与传统的C均值聚类算法不同,FCM允许像素属于多个聚类,因此能够更好地处理图像中的模糊边界。

在Matlab中使用FCM进行图像分析的第一步是加载图像。

可以使用imread函数将图像加载到Matlab的工作区中。

例如,我们可以加载一张名为“image.jpg”的图像:```matlabimage = imread('image.jpg');```加载图像后,可以使用imshow函数显示图像。

这可以帮助我们对图像有一个直观的了解:```matlabimshow(image);```接下来,我们需要将图像转换为灰度图像。

这是因为FCM算法通常用于灰度图像分析。

可以使用rgb2gray函数将彩色图像转换为灰度图像:```matlabgrayImage = rgb2gray(image);```在使用FCM算法之前,我们需要对图像进行预处理。

预处理的目的是消除图像中的噪声和不必要的细节,从而更好地提取图像中的特征。

常用的图像预处理方法包括平滑、锐化和边缘检测等。

Matlab中提供了许多图像预处理函数。

例如,可以使用imnoise函数向图像中添加高斯噪声:```matlabnoisyImage = imnoise(grayImage, 'gaussian', 0, 0.01);```还可以使用imfilter函数对图像进行平滑处理。

常见的平滑方法包括均值滤波和高斯滤波:```matlabsmoothImage = imfilter(noisyImage, fspecial('average', 3));```一旦完成预处理步骤,我们就可以使用模糊逻辑工具箱中的fcm函数执行FCM算法。

模糊c均值聚类 FCM算法的MATLAB代码

模糊c均值聚类FCM算法的MATLAB代码我做毕业论文时需要模糊C-均值聚类,找了好长时间才找到这个,分享给大家:FCM算法的两种迭代形式的MA TLAB代码写于下,也许有的同学会用得着:m文件1/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm(Data,C,plotflag,M,epsm)% 模糊C 均值聚类FCM: 从随机初始化划分矩阵开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm(Data,C,plotflag,M,epsm)% 输入:% Data: N×S 型矩阵,聚类的原始数据,即一组有限的观测样本集,% Data 的每一行为一个观测样本的特征矢量,S 为特征矢量% 的维数,N 为样本点的个数% C: 聚类数,1<C<N% plotflag: 聚类结果2D/3D 绘图标记,0 表示不绘图,为缺省值% M: 加权指数,缺省值为2% epsm: FCM 算法的迭代停止阈值,缺省值为1.0e-6% 输出:% U: C×N 型矩阵,FCM 的划分矩阵% P: C×S 型矩阵,FCM 的聚类中心,每一行对应一个聚类原型% Dist: C×N 型矩阵,FCM 各聚类中心到各样本点的距离,聚类中% 心i 到样本点j 的距离为Dist(i,j)% Cluster_Res: 聚类结果,共C 行,每一行对应一类% Obj_Fcn: 目标函数值% iter: FCM 算法迭代次数% See also: fuzzydist maxrowf fcmplotif nargin<5epsm=1.0e-6;endif nargin<4M=2;endif nargin<3plotflag=0;end[N,S]=size(Data);m=2/(M-1);iter=0;Dist(C,N)=0; U(C,N)=0; P(C,S)=0;% 随机初始化划分矩阵U0 = rand(C,N);U0=U0./(ones(C,1)*sum(U0));% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新聚类中心PUm=U0.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(U-U0,Inf)<epsmbreakendU0=U;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);endm文件2/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm2(Data,P0,plotflag,M,epsm) % 模糊C 均值聚类FCM: 从指定初始聚类中心开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm2(Data,P0,plotflag,M,epsm)% 输入: Data,plotflag,M,epsm: 见fuzzycm.m% P0: 初始聚类中心% 输出: U,P,Dist,Cluster_Res,Obj_Fcn,iter: 见fuzzycm.m% See also: fuzzycmif nargin<5epsm=1.0e-6;if nargin<4M=2;endif nargin<3plotflag=0;end[N,S] = size(Data); m = 2/(M-1); iter = 0;C=size(P0,1);Dist(C,N)=0;U(C,N)=0;P(C,S)=0;% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P0(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 更新聚类中心PUm=U.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(P-P0,Inf)<epsmbreakendP0=P;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);m文件3/7:function fcmplot(Data,U,P,Obj_Fcn)% FCM 结果绘图函数% See also: fuzzycm maxrowf ellipse[C,S] = size(P); res = maxrowf(U);str = 'po*x+d^v><.h';% 目标函数绘图figure(1),plot(Obj_Fcn)title('目标函数值变化曲线','fontsize',8)% 2D 绘图if S==2figure(2),plot(P(:,1),P(:,2),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot(v(:,1),v(:,2),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2,'r:') endgrid on,title('2D 聚类结果图','fontsize',8),hold off end% 3D 绘图if S>2figure(2),plot3(P(:,1),P(:,2),P(:,3),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot3(v(:,1),v(:,2),v(:,3),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2, ...'r:',(max(v(:,3))+min(v(:,3)))/2) endgrid on,title('3D 聚类结果图','fontsize',8),hold off endm文件4/7:function D=fuzzydist(A,B)% 模糊聚类分析: 样本间的距离% D = fuzzydist(A,B)D=norm(A-B);m文件5/7:function mr=maxrowf(U,c)% 求矩阵U 每列第c 大元素所在行,c 的缺省值为1% 调用格式: mr = maxrowf(U,c)% See also: addrif nargin<2c=1;endN=size(U,2);mr(1,N)=0;for j=1:Naj=addr(U(:,j),'descend');mr(j)=aj(c);endm文件6/7:function ellipse(a,b,center,style,c_3d)% 绘制一个椭圆% 调用: ellipse(a,b,center,style,c_3d)% 输入:% a: 椭圆的轴长(平行于x 轴)% b: 椭圆的轴长(平行于y 轴)% center: 椭圆的中心[x0,y0],缺省值为[0,0]% style: 绘制的线型和颜色,缺省值为实线蓝色% c_3d: 椭圆的中心在3D 空间中的z 轴坐标,可缺省if nargin<4style='b';endif nargin<3 | isempty(center)center=[0,0];endt=1:360;x=a/2*cosd(t)+center(1);y=b/2*sind(t)+center(2);if nargin>4plot3(x,y,ones(1,360)*c_3d,style)elseplot(x,y,style)endm文件7/7:function f = addr(a,strsort)% 返回向量升序或降序排列后各分量在原始向量中的索引% 函数调用:f = addr(a,strsort)% strsort: 'ascend' or 'descend'% default is 'ascend'% -------- example --------% addr([ 4 5 1 2 ]) returns ans:% [ 3 4 1 2 ]if nargin==1strsort='ascend';endsa=sort(a); ca=a;la=length(a);f(la)=0;for i=1:laf(i)=find(ca==sa(i),1);ca(f(i))=NaN;endif strcmp(strsort,'descend') f=fliplr(f);end几天前我还在这里发帖求助,可是很幸运在其他地方找到了,在这里和大家分享一下!function [center, U, obj_fcn] = FCMClust(data, cluster_n, options)% FCMClust.m 采用模糊C均值对数据集data聚为cluster_n类%% 用法:% 1. [center,U,obj_fcn] = FCMClust(Data,N_cluster,options);% 2. [center,U,obj_fcn] = FCMClust(Data,N_cluster);%% 输入:% data ---- nxm矩阵,表示n个样本,每个样本具有m的维特征值% N_cluster ---- 标量,表示聚合中心数目,即类别数% options ---- 4x1矩阵,其中% options(1): 隶属度矩阵U的指数,>1 (缺省值: 2.0)% options(2): 最大迭代次数(缺省值: 100)% options(3): 隶属度最小变化量,迭代终止条件(缺省值: 1e-5)% options(4): 每次迭代是否输出信息标志 (缺省值: 1)% 输出:% center ---- 聚类中心% U ---- 隶属度矩阵% obj_fcn ---- 目标函数值% Example:% data = rand(100,2);% [center,U,obj_fcn] = FCMClust(data,2);% plot(data(:,1), data(:,2),'o');% hold on;% maxU = max(U);% index1 = find(U(1,:) == maxU);% index2 = find(U(2,:) == maxU);% line(data(index1,1),data(index1,2),'marker','*','color',' g');% line(data(index2,1),data(index2,2),'marker','*','color',' r');% plot([center([1 2],1)],[center([1 2],2)],'*','color','k') % hold off;if nargin ~= 2 & nargin ~= 3, %判断输入参数个数只能是2个或3个error('Too many or too few input arguments!');enddata_n = size(data, 1); % 求出data的第一维(rows)数,即样本个数in_n = size(data, 2); % 求出data的第二维(columns)数,即特征值长度% 默认操作参数default_options = [2; % 隶属度矩阵U的指数100; % 最大迭代次数1e-5; % 隶属度最小变化量,迭代终止条件1]; % 每次迭代是否输出信息标志if nargin == 2,options = default_options;else %分析有options做参数时候的情况% 如果输入参数个数是二那么就调用默认的option;if length(options) < 4, %如果用户给的opition数少于4个那么其他用默认值;tmp = default_options;tmp(1:length(options)) = options;options = tmp;end% 返回options中是数的值为0(如NaN),不是数时为1nan_index = find(isnan(options)==1);%将denfault_options中对应位置的参数赋值给options中不是数的位置.options(nan_index) = default_options(nan_index);if options(1) <= 1, %如果模糊矩阵的指数小于等于1error('The exponent should be greater than 1!');endend%将options 中的分量分别赋值给四个变量;expo = options(1); % 隶属度矩阵U的指数max_iter = options(2); % 最大迭代次数min_impro = options(3); % 隶属度最小变化量,迭代终止条件display = options(4); % 每次迭代是否输出信息标志obj_fcn = zeros(max_iter, 1); % 初始化输出参数obj_fcnU = initfcm(cluster_n, data_n); % 初始化模糊分配矩阵,使U满足列上相加为1,% Main loop 主要循环for i = 1:max_iter,%在第k步循环中改变聚类中心ceneter,和分配函数U的隶属度值;[U, center, obj_fcn(i)] = stepfcm(data, U, cluster_n, expo);if display,fprintf('FCM:Iteration count = %d, obj. fcn = %f\n', i, obj_fcn(i));end% 终止条件判别if i > 1,if abs(obj_fcn(i) - obj_fcn(i-1)) < min_impro,break;end,endenditer_n = i; % 实际迭代次数obj_fcn(iter_n+1:max_iter) = [];[center, U, obj_fcn] = FCMClust(Data,N_cluster,options)data=[94.4304 98 60 0 8592.8068 70 70 0 75.286.3522 100 75 24.87 91.580.5512 50 90 0 65.480.494 76 100 0 9888.1528 100 60 80 78.484.567 55 80 0 8587.722 30 60 0 4988.0056 95 70 46.459 45.885.948 100 60 0 55.683.9578 10 90 0 78.490.0822 5 60 0 58.876.7448 10 60 0 39.295.062 100 70 62.37 94.8];N_cluster=4;options(1)=[2];options(2)=[100];options(3)=[1e-5];options(4)=[1];。

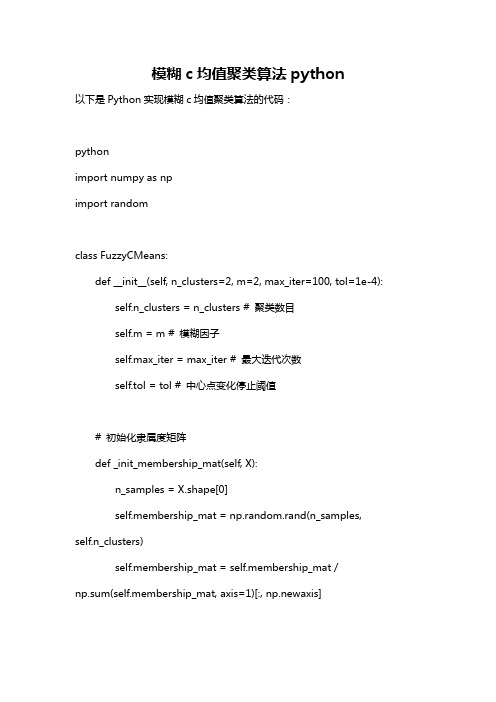

模糊c均值聚类算法python

模糊c均值聚类算法python以下是Python实现模糊c均值聚类算法的代码:pythonimport numpy as npimport randomclass FuzzyCMeans:def __init__(self, n_clusters=2, m=2, max_iter=100, tol=1e-4): self.n_clusters = n_clusters # 聚类数目self.m = m # 模糊因子self.max_iter = max_iter # 最大迭代次数self.tol = tol # 中心点变化停止阈值# 初始化隶属度矩阵def _init_membership_mat(self, X):n_samples = X.shape[0]self.membership_mat = np.random.rand(n_samples, self.n_clusters)self.membership_mat = self.membership_mat /np.sum(self.membership_mat, axis=1)[:, np.newaxis]# 更新聚类中心点def _update_centers(self, X):membership_mat_pow = np.power(self.membership_mat, self.m)self.centers = np.dot(X.T, membership_mat_pow) /np.sum(membership_mat_pow, axis=0)[:, np.newaxis]# 计算隶属度矩阵def _update_membership_mat(self, X):n_samples = X.shape[0]self.distances = np.zeros((n_samples, self.n_clusters))for j in range(self.n_clusters):self.distances[:, j] = np.linalg.norm(X-self.centers[j, :], axis=1) self.membership_mat = 1 / np.power(self.distances, 2/(self.m-1))self.membership_mat = self.membership_mat /np.sum(self.membership_mat, axis=1)[:, np.newaxis]# 判断是否满足停止迭代的条件def _check_stop_criteria(self):return np.sum(np.abs(self.centers - self.old_centers)) < self.tol # 聚类过程def fit(self, X):self._init_membership_mat(X)for i in range(self.max_iter):self.old_centers = self.centers.copy()self._update_centers(X)self._update_membership_mat(X)if self._check_stop_criteria():break# 预测样本所属的簇def predict(self, X):distances = np.zeros((X.shape[0], self.n_clusters))for j in range(self.n_clusters):distances[:, j] = np.linalg.norm(X-self.centers[j, :], axis=1) return np.argmin(distances, axis=1)使用方法:pythonfrom sklearn.datasets import make_blobsimport matplotlib.pyplot as pltX, y = make_blobs(n_samples=500, centers=3, random_state=42)fcm = FuzzyCMeans(n_clusters=3)fcm.fit(X)plt.scatter(X[:, 0], X[:, 1], c=fcm.predict(X))plt.show()。

c均值聚类matlab

c均值聚类matlab

在MATLAB中,使用c均值聚类(C-means clustering)可以通

过以下步骤实现:

1. 导入数据,首先,你需要准备你的数据集并将其导入MATLAB中。

你可以使用`csvread`或`xlsread`函数来从CSV文件或Excel文件中读取数据,或者直接创建一个数据矩阵。

2. 数据预处理,在进行聚类之前,通常需要对数据进行预处理,例如归一化或标准化,以确保各个特征对聚类结果的影响是均衡的。

3. 调用c均值聚类函数:MATLAB提供了`fcm`函数来实现c均

值聚类。

你可以使用以下语法来调用该函数:

[centers, U] = fcm(data, clusterNum);

其中,`data`是你的数据矩阵,`clusterNum`是你想要得到

的聚类中心的数量。

`centers`包含了每个聚类中心的坐标,`U`是

一个隶属度矩阵,描述了每个数据点属于每个聚类的概率。

4. 可视化结果,你可以使用MATLAB的绘图函数,如`scatter`或`plot`来可视化聚类结果,以及聚类中心的位置。

5. 结果分析,最后,对聚类结果进行分析和解释,可以使用各种统计工具和可视化手段来理解不同聚类之间的差异和相似性。

需要注意的是,c均值聚类的结果可能受初始聚类中心的选择和随机性影响,因此通常需要多次运行算法并比较结果,以确保得到稳健的聚类结果。

希望这些信息能够帮助到你在MATLAB中实现c 均值聚类。

matlab模糊c均值聚类算法

matlab模糊c均值聚类算法模糊C均值聚类算法是一种广泛应用于数据挖掘、图像分割等领域的聚类算法。

相比于传统的C均值聚类算法,模糊C均值聚类算法能够更好地处理噪声数据和模糊边界。

模糊C均值聚类算法的基本思想是将样本集合分为K个聚类集合,使得每个样本点属于某个聚类集合的概率最大。

同时,每个聚类集合的中心点被计算为该聚类集合中所有样本的均值。

具体实现中,模糊C均值聚类算法引入了模糊化权重向量来描述每个样本点属于各个聚类集合的程度。

这些权重值在每次迭代中被更新,直至达到预设的收敛精度为止。

模糊C均值聚类算法的目标函数可以表示为:J = ∑i∑j(wij)q||xi-cj||2其中,xi表示样本集合中的第i个样本,cj表示第j个聚类集合的中心点,wij表示第i个样本点属于第j个聚类集合的权重,q是模糊指数,通常取2。

不同于C均值聚类算法,模糊C均值聚类算法对每个样本点都考虑了其属于某个聚类集合的概率,因此能够更好地处理模糊边界和噪声数据。

同时,模糊C均值聚类算法可以自适应地确定聚类的数量,从而避免了事先设定聚类数量所带来的限制。

在MATLAB中,可以使用fcm函数实现模糊C均值聚类算法。

具体来说,fcm函数的使用方法如下:[idx,center] = fcm(data,k,[options]);其中,data表示样本矩阵,k表示聚类数量,options是一个包含算法参数的结构体。

fcm函数的输出包括聚类标签idx和聚类中心center。

MATLAB中的fcm函数还提供了其他参数和选项,例如模糊权重阈值、最大迭代次数和收敛精度等。

可以根据具体应用需求来设置这些参数和选项。

聚类——FCM的matlab程序

聚类——FCM的matlab程序聚类——FCM的matlab程序在⽂章中已介绍了FCM算法的理论知识,现在⽤matlab进⾏实现。

1.matlab程序FCM_main.mfunction [ave_acc_FCM,max_acc_FCM,min_acc_FCM,ave_iter_FCM,ave_run_time]=FCM_main(X,real_label,K)%输⼊K:聚的类,max_iter是最⼤迭代次数%输出ave_acc_FCM:迭代max_iter次之后的平均准确度t0=cputime;s=0;s_1=0;max_iter=20; %重复max_iter次accuracy=zeros(max_iter,1);iter_FCM_t=zeros(max_iter,1);%对data做最⼤-最⼩归⼀化处理% [data_num,~]=size(data);% X=(data-ones(data_num,1)*min(data))./(ones(data_num,1)*(max(data)-min(data)));for i=1:max_iter[label_1,~,iter_FCM]=My_FCM(X,K);iter_FCM_t(i)=iter_FCM;accuracy(i)=succeed(real_label,K,label_1);s=s+accuracy(i);s_1=s_1+iter_FCM_t(i);fprintf('第 %2d 次,FCM的迭代次数为:%2d,准确度为:%.8f\n', i, iter_FCM_t(i), accuracy(i));endave_iter_FCM=s_1/max_iter;ave_acc_FCM=s/max_iter;max_acc_FCM=max(accuracy);min_acc_FCM=min(accuracy);run_time=cputime-t0;ave_run_time=run_time/max_iter;My_FCM.mfunction [label_1,para_miu_new,iter]=My_FCM(X,K)%输⼊K:聚类数%输出:label_1:聚的类, para_miu_new:模糊聚类中⼼µ,responsivity:模糊⾪属度format longeps=1e-4; %定义迭代终⽌条件的epsalpha=2; %模糊加权指数,[1,+⽆穷)T=100; %最⼤迭代次数fitness=zeros(T,1);[X_num,X_dim]=size(X);count=zeros(X_num,1); %统计distant中每⼀⾏为0的个数%----------------------------------------------------------------------------------------------------%随机初始化K个聚类中⼼rand_array=randperm(X_num); %产⽣1~X_num之间整数的随机排列para_miu=X(rand_array(1:K),:); %随机排列取前K个数,在X矩阵中取这K⾏作为初始聚类中⼼responsivity=zeros(X_num,K);R_up=zeros(X_num,K);% ----------------------------------------------------------------------------------------------------% FCM算法for t=1:T%欧⽒距离,计算(X-para_miu)^2=X^2+para_miu^2-2*para_miu*X',矩阵⼤⼩为X_num*Kdistant=(sum(X.*X,2))*ones(1,K)+ones(X_num,1)*(sum(para_miu.*para_miu,2))'-2*X*para_miu';%更新⾪属度矩阵X_num*Kfor i=1:X_numcount(i)=sum(distant(i,:)==0);if count(i)>0for k=1:Kif distant(i,k)==0responsivity(i,k)=1./count(i);elseresponsivity(i,k)=0;endendelseR_up(i,:)=distant(i,:).^(-1/(alpha-1)); %⾪属度矩阵的分⼦部分responsivity(i,:)= R_up(i,:)./sum( R_up(i,:),2);endend%⽬标函数值fitness(t)=sum(sum(distant.*(responsivity.^(alpha))));%更新聚类中⼼K*X_dimmiu_up=(responsivity'.^(alpha))*X; %µ的分⼦部分para_miu=miu_up./((sum(responsivity.^(alpha)))'*ones(1,X_dim));if t>1if abs(fitness(t)-fitness(t-1))<epsbreak;endendendpara_miu_new=para_miu;iter=t; %实际迭代次数[~,label_1]=max(responsivity,[],2);succeed.mfunction accuracy=succeed(real_label,K,id)%输⼊K:聚的类,id:训练后的聚类结果,N*1的矩阵N=size(id,1); %样本个数p=perms(1:K); %全排列矩阵p_col=size(p,1); %全排列的⾏数new_label=zeros(N,p_col); %聚类结果的所有可能取值,N*p_colnum=zeros(1,p_col); %与真实聚类结果⼀样的个数%将训练结果全排列为N*p_col的矩阵,每⼀列为⼀种可能性for i=1:Nfor j=1:p_colfor k=1:Kif id(i)==knew_label(i,j)=p(j,k); %iris数据库,1 2 3endendendend%与真实结果⽐对,计算精确度for j=1:p_colfor i=1:Nif new_label(i,j)==real_label(i)num(j)=num(j)+1;endendendaccuracy=max(num)/N;2.在UCI数据库的iris上的运⾏结果>> data_load=dlmread('E:\My matlab\database\iris.data');data=data_load(:,1:4);real_label=data_load(:,5); >> [ave_acc_FCM,max_acc_FCM,min_acc_FCM,ave_iter_FCM,ave_run_time]=FCM_main(data,real_label,3)第 1 次,FCM的迭代次数为:33,准确度为:0.89333333第 2 次,FCM的迭代次数为:41,准确度为:0.89333333第 3 次,FCM的迭代次数为:14,准确度为:0.89333333第 4 次,FCM的迭代次数为:13,准确度为:0.89333333第 5 次,FCM的迭代次数为:16,准确度为:0.89333333第 6 次,FCM的迭代次数为:10,准确度为:0.89333333第 7 次,FCM的迭代次数为:21,准确度为:0.89333333第 8 次,FCM的迭代次数为:46,准确度为:0.89333333第 9 次,FCM的迭代次数为:19,准确度为:0.89333333第 10 次,FCM的迭代次数为:18,准确度为:0.89333333第 11 次,FCM的迭代次数为:17,准确度为:0.89333333第 12 次,FCM的迭代次数为:38,准确度为:0.89333333第 13 次,FCM的迭代次数为:37,准确度为:0.89333333第 14 次,FCM的迭代次数为:11,准确度为:0.89333333第 15 次,FCM的迭代次数为:22,准确度为:0.89333333第 16 次,FCM的迭代次数为:17,准确度为:0.89333333第 17 次,FCM的迭代次数为:13,准确度为:0.89333333第 18 次,FCM的迭代次数为: 8,准确度为:0.89333333第 19 次,FCM的迭代次数为:13,准确度为:0.89333333第 20 次,FCM的迭代次数为:20,准确度为:0.89333333ave_acc_FCM =0.893333333333333max_acc_FCM =0.893333333333333min_acc_FCM =0.893333333333333ave_iter_FCM =21.350000000000001ave_run_time =0.0359375000000003. iris.data 5.1,3.5,1.4,0.2,14.9,3.0,1.4,0.2,1 4.7,3.2,1.3,0.2,14.6,3.1,1.5,0.2,15.0,3.6,1.4,0.2,1 5.4,3.9,1.7,0.4,14.6,3.4,1.4,0.3,15.0,3.4,1.5,0.2,1 4.4,2.9,1.4,0.2,14.9,3.1,1.5,0.1,15.4,3.7,1.5,0.2,1 4.8,3.4,1.6,0.2,1 4.8,3.0,1.4,0.1,14.3,3.0,1.1,0.1,15.8,4.0,1.2,0.2,1 5.7,4.4,1.5,0.4,1 5.4,3.9,1.3,0.4,1 5.1,3.5,1.4,0.3,1 5.7,3.8,1.7,0.3,1 5.1,3.8,1.5,0.3,1 5.4,3.4,1.7,0.2,1 5.1,3.7,1.5,0.4,14.6,3.6,1.0,0.2,15.1,3.3,1.7,0.5,14.8,3.4,1.9,0.2,15.0,3.0,1.6,0.2,1 5.0,3.4,1.6,0.4,1 5.2,3.5,1.5,0.2,1 5.2,3.4,1.4,0.2,1 4.7,3.2,1.6,0.2,14.8,3.1,1.6,0.2,15.4,3.4,1.5,0.4,1 5.2,4.1,1.5,0.1,1 5.5,4.2,1.4,0.2,14.9,3.1,1.5,0.1,15.0,3.2,1.2,0.2,1 5.5,3.5,1.3,0.2,1 4.9,3.1,1.5,0.1,14.4,3.0,1.3,0.2,15.1,3.4,1.5,0.2,1 5.0,3.5,1.3,0.3,1 4.5,2.3,1.3,0.3,14.4,3.2,1.3,0.2,15.0,3.5,1.6,0.6,1 5.1,3.8,1.9,0.4,14.8,3.0,1.4,0.3,15.1,3.8,1.6,0.2,14.6,3.2,1.4,0.2,15.3,3.7,1.5,0.2,1 5.0,3.3,1.4,0.2,1 7.0,3.2,4.7,1.4,26.4,3.2,4.5,1.5,2 6.9,3.1,4.9,1.5,25.5,2.3,4.0,1.3,26.5,2.8,4.6,1.5,25.7,2.8,4.5,1.3,26.3,3.3,4.7,1.6,2 4.9,2.4,3.3,1.0,2 6.6,2.9,4.6,1.3,2 5.2,2.7,3.9,1.4,2 5.0,2.0,3.5,1.0,25.9,3.0,4.2,1.5,26.0,2.2,4.0,1.0,2 6.1,2.9,4.7,1.4,25.6,2.9,3.6,1.3,26.7,3.1,4.4,1.4,2 5.6,3.0,4.5,1.5,25.8,2.7,4.1,1.0,26.2,2.2,4.5,1.5,2 5.6,2.5,3.9,1.1,25.9,3.2,4.8,1.8,26.1,2.8,4.0,1.3,2 6.3,2.5,4.9,1.5,2 6.1,2.8,4.7,1.2,2 6.4,2.9,4.3,1.3,2 6.6,3.0,4.4,1.4,2 6.8,2.8,4.8,1.4,2 6.7,3.0,5.0,1.7,2 6.0,2.9,4.5,1.5,2 5.7,2.6,3.5,1.0,2 5.5,2.4,3.8,1.1,25.5,2.4,3.7,1.0,25.8,2.7,3.9,1.2,26.0,2.7,5.1,1.6,25.4,3.0,4.5,1.5,26.0,3.4,4.5,1.6,2 6.7,3.1,4.7,1.5,2 6.3,2.3,4.4,1.3,2 5.6,3.0,4.1,1.3,2 5.5,2.5,4.0,1.3,25.5,2.6,4.4,1.2,26.1,3.0,4.6,1.4,2 5.8,2.6,4.0,1.2,2 5.0,2.3,3.3,1.0,2 5.6,2.7,4.2,1.3,2 5.7,3.0,4.2,1.2,25.7,2.9,4.2,1.3,26.2,2.9,4.3,1.3,2 5.1,2.5,3.0,1.1,25.7,2.8,4.1,1.3,26.3,3.3,6.0,2.5,3 5.8,2.7,5.1,1.9,37.1,3.0,5.9,2.1,3 6.3,2.9,5.6,1.8,36.5,3.0,5.8,2.2,37.6,3.0,6.6,2.1,3 4.9,2.5,4.5,1.7,3 7.3,2.9,6.3,1.8,36.7,2.5,5.8,1.8,37.2,3.6,6.1,2.5,3 6.5,3.2,5.1,2.0,3 6.4,2.7,5.3,1.9,3 6.8,3.0,5.5,2.1,3 5.7,2.5,5.0,2.0,35.8,2.8,5.1,2.4,36.4,3.2,5.3,2.3,36.5,3.0,5.5,1.8,37.7,3.8,6.7,2.2,3 7.7,2.6,6.9,2.3,3 6.0,2.2,5.0,1.5,3 6.9,3.2,5.7,2.3,3 5.6,2.8,4.9,2.0,3 7.7,2.8,6.7,2.0,3 6.3,2.7,4.9,1.8,36.7,3.3,5.7,2.1,37.2,3.2,6.0,1.8,3 6.2,2.8,4.8,1.8,3 6.1,3.0,4.9,1.8,36.4,2.8,5.6,2.1,37.2,3.0,5.8,1.6,3 7.4,2.8,6.1,1.9,3 7.9,3.8,6.4,2.0,3 6.4,2.8,5.6,2.2,3 6.3,2.8,5.1,1.5,36.1,2.6,5.6,1.4,37.7,3.0,6.1,2.3,3 6.3,3.4,5.6,2.4,3 6.4,3.1,5.5,1.8,3 6.0,3.0,4.8,1.8,3 6.9,3.1,5.4,2.1,3 6.7,3.1,5.6,2.4,3 6.9,3.1,5.1,2.3,35.8,2.7,5.1,1.9,36.8,3.2,5.9,2.3,3 6.7,3.3,5.7,2.5,3 6.7,3.0,5.2,2.3,3 6.3,2.5,5.0,1.9,3 6.5,3.0,5.2,2.0,3 6.2,3.4,5.4,2.3,3 5.9,3.0,5.1,1.8,3。

如何在Matlab中进行模糊聚类分析

如何在Matlab中进行模糊聚类分析在数据分析领域,模糊聚类分析是一种常用的技术,它可以应用于各种领域的数据处理和模式识别问题。

而Matlab作为一种功能强大的数据分析工具,也提供了丰富的函数和工具箱,以支持模糊聚类分析的实施。

1. 引言模糊聚类分析是一种基于模糊集理论的聚类方法,与传统的硬聚类方法不同,它允许样本属于多个聚类中心。

这种方法的优势在于可以更好地应对数据中的不确定性和复杂性,对于某些模糊或模糊边界问题具有更好的解释能力。

2. 模糊聚类算法概述Matlab提供了多种模糊聚类算法的实现,其中最常用的是基于模糊C均值(Fuzzy C-Means,FCM)算法。

FCM算法的基本思想是通过最小化聚类后的模糊划分矩阵与原始数据之间的距离来确定每个样本所属的聚类中心。

3. 数据预处理与特征提取在进行模糊聚类分析之前,需要对原始数据进行预处理和特征提取。

预处理包括数据清洗、缺失值处理和异常值处理等;特征提取则是从原始数据中抽取出具有代表性和区分性的特征,用于模糊聚类分析。

4. 模糊聚类分析步骤在Matlab中,进行模糊聚类分析通常包括以下步骤:(1) 初始化聚类中心:通过随机选择或基于某种准则的方法初始化聚类中心。

(2) 计算模糊划分矩阵:根据当前的聚类中心,计算每个样本属于各个聚类中心的隶属度。

(3) 更新聚类中心:根据当前的模糊划分矩阵,更新聚类中心的位置。

(4) 判断终止条件:通过设置一定的终止条件,判断是否达到停止迭代的条件。

(5) 输出最终结果:得到最终的聚类结果和每个样本所属的隶属度。

5. 模糊聚类结果评估在进行模糊聚类分析后,需要对聚类结果进行评估以验证其有效性和可解释性。

常用的评估指标包括模糊划分矩阵的聚类有效性指标、外部指标和内部指标等。

通过这些指标的比较和分析,可以选择合适的模糊聚类算法和参数设置。

6. 模糊聚类的应用模糊聚类分析在诸多领域中都有广泛的应用。

例如,在图像处理中,可以利用模糊聚类方法对图像进行分割和识别;在生物信息学中,可以应用于基因表达数据的分类和模式识别等。

模糊C均值聚类-FCM算法

模糊C均值聚类-FCM算法FCM(fuzzy c-means)模糊c均值聚类融合了模糊理论的精髓。

相较于k-means的硬聚类,模糊c提供了更加灵活的聚类结果。

因为⼤部分情况下,数据集中的对象不能划分成为明显分离的簇,指派⼀个对象到⼀个特定的簇有些⽣硬,也可能会出错。

故,对每个对象和每个簇赋予⼀个权值,指明对象属于该簇的程度。

当然,基于概率的⽅法也可以给出这样的权值,但是有时候我们很难确定⼀个合适的统计模型,因此使⽤具有⾃然地、⾮概率特性的模糊c均值就是⼀个⽐较好的选择。

聚类损失函数:N个样本,分为C类。

C是聚类的簇数;i,j是标号;表⽰样本i 属于 j类的⾪属度。

xi表⽰第i个样本,xi是具有d维特征的⼀个样本。

cj是j簇的中⼼,也具有d维度。

||*||可以是任意表⽰距离的度量。

模糊c是⼀个不断迭代计算⾪属度和簇中⼼的过程,直到他们达到最优。

对于单个样本xi,它对于每个簇的⾪属度之和为1。

迭代的终⽌条件为:其中k是迭代步数,是误差阈值。

上式含义是,继续迭代下去,⾪属程度也不会发⽣较⼤的变化。

即认为⾪属度不变了,已经达到⽐较优(局部最优或全局最优)状态了。

该过程收敛于⽬标Jm的局部最⼩值或鞍点。

抛开复杂的算式,这个算法的意思就是:给每个样本赋予属于每个簇的⾪属度函数。

通过⾪属度值⼤⼩来将样本归类。

算法步骤:1、初始化2、计算质⼼FCM中的质⼼有别于传统质⼼的地⽅在于,它是以⾪属度为权重做⼀个加权平均。

3、更新⾪属度矩阵b⼀般取2。

【转载⾃】Fuzzy C-Means(模糊C均值聚类)算法原理详解与python实现 - Yancy的博客 - CSDN博客。

Matlab笔记——模糊聚类分析原理及实现023

23. 模糊聚类分析原理及实现聚类分析,就是用数学方法研究和处理所给定对象,按照事物间的相似性进行区分和分类的过程。

传统的聚类分析是一种硬划分,它把每个待识别的对象严格地划分到某个类中,具有非此即彼的性质,这种分类的类别界限是分明的。

随着模糊理论的建立,人们开始用模糊的方法来处理聚类问题,称为模糊聚类分析。

由于模糊聚类得到了样本数与各个类别的不确定性程度,表达了样本类属的中介性,即建立起了样本对于类别的不确定性的描述,能更客观地反映现实世界。

本篇先介绍传统的两种(适合数据量较小情形,及理解模糊聚类原理):基于择近原则、模糊等价关系的模糊聚类方法。

(一)预备知识一、模糊等价矩阵定义1设R=(r ij )n ×n 为模糊矩阵,I 为n 阶单位矩阵,若R 满足 i) 自反性:I ≤R (等价于r ii =1); ii) 对称性:R T =R;则称R 为模糊相似矩阵,若再满足iii) 传递性:R 2≤R (等价于1()nik kj ij k r r r =∨∧≤)则称R 为模糊等价矩阵。

定理1设R 为n 阶模糊相似矩阵,则存在一个最小的自然数k(k <n ), 使得R k 为模糊等价矩阵,且对一切大于k 的自然数l ,恒有R l =R k . R k 称为R 的传递闭包矩阵,记为t(R). 二、模糊矩阵的λ-截矩阵定义2设A =(a ij )n ×m 为模糊矩阵,对任意的λ∈[0,1], 作矩阵()()ij n mA a λλ⨯=其中,()1, 0, ij ijij a aa λλλ≥⎧=⎨<⎩称为模糊矩阵A 的λ-截矩阵。

显然,A λ为布尔矩阵,且其等价性与与A 一致。

意义:将模糊等价矩阵转化为等价的布尔矩阵,可以得到有限论域上的普通等价关系,而等价关系是可以分类的。

因此,当λ在[0,1]上变动时,由A λ得到不同的分类。

若λ1<λ2, 则A λ1≥A λ2, 从而由A λ2确定的分类是由A λ1确定的分类的加细。

模糊神经和模糊聚类的MATLAB实现

模糊神经和模糊聚类的MATLAB实现模糊神经网络(Fuzzy Neural Networks)是一种结合了模糊逻辑和神经网络的方法,用于处理不确定性和模糊性问题。

它具有模糊逻辑的灵活性和神经网络的学习和优化能力。

在MATLAB中,可以使用Fuzzy Logic Toolbox来实现模糊神经网络。

下面将介绍如何使用MATLAB实现模糊神经网络。

首先,我们需要定义输入和输出的模糊集合。

可以使用Fuzzy Logic Toolbox提供的各种方法来定义模糊集合的隶属函数,例如使用trimf定义三角隶属函数或者使用gaussmf定义高斯隶属函数。

```input1 = trimf(inputRange, [a1, b1, c1]);input2 = gaussmf(inputRange, [mean, sigma]);output = trapmf(outputRange, [d1, e1, f1, g1]);```接下来,可以使用FIS Editor界面来创建和训练模糊神经网络。

在MATLAB命令窗口中输入fuzzy命令即可打开FIS Editor界面。

在FIS Editor界面中,可以添加输入和输出变量,并设置它们的隶属函数。

然后,可以添加规则来定义输入与输出之间的关系。

规则的形式可以使用自然语言或者模糊规则表达式(Fuzzy Rule Expression)。

训练模糊神经网络可以使用基于模糊神经网络的系统识别方法。

在MATLAB中,可以使用anfis函数来进行自适应网络训练。

anfis函数可以根据训练数据自动调整隶属函数参数和规则权重,以优化模糊神经网络的性能。

```fis = anfis(trainingData);```使用trainfis命令可以将训练好的模糊神经网络应用于新的数据。

trainfis命令将输入数据映射到输出模糊集中,并使用模糊推理进行预测。

输出结果是一个模糊集,可以使用defuzz命令对其进行模糊化。

在Matlab中实现模糊聚类和模糊决策的方法

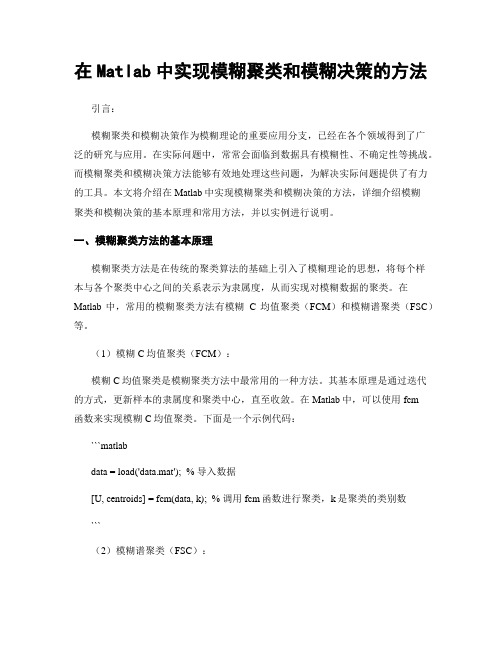

在Matlab中实现模糊聚类和模糊决策的方法引言:模糊聚类和模糊决策作为模糊理论的重要应用分支,已经在各个领域得到了广泛的研究与应用。

在实际问题中,常常会面临到数据具有模糊性、不确定性等挑战。

而模糊聚类和模糊决策方法能够有效地处理这些问题,为解决实际问题提供了有力的工具。

本文将介绍在Matlab中实现模糊聚类和模糊决策的方法,详细介绍模糊聚类和模糊决策的基本原理和常用方法,并以实例进行说明。

一、模糊聚类方法的基本原理模糊聚类方法是在传统的聚类算法的基础上引入了模糊理论的思想,将每个样本与各个聚类中心之间的关系表示为隶属度,从而实现对模糊数据的聚类。

在Matlab中,常用的模糊聚类方法有模糊C均值聚类(FCM)和模糊谱聚类(FSC)等。

(1)模糊C均值聚类(FCM):模糊C均值聚类是模糊聚类方法中最常用的一种方法。

其基本原理是通过迭代的方式,更新样本的隶属度和聚类中心,直至收敛。

在Matlab中,可以使用fcm函数来实现模糊C均值聚类。

下面是一个示例代码:```matlabdata = load('data.mat'); % 导入数据[U, centroids] = fcm(data, k); % 调用fcm函数进行聚类,k是聚类的类别数```(2)模糊谱聚类(FSC):模糊谱聚类是一种基于图论的聚类方法,它通过建立样本的相似度矩阵,然后通过对相似度矩阵进行模糊化处理,进而得到聚类结果。

在Matlab中,可以使用fuzzy_spectral_clustering函数来实现模糊谱聚类。

下面是一个示例代码:```matlabdata = load('data.mat'); % 导入数据[U, V] = fuzzy_spectral_clustering(data, k); % 调用fuzzy_spectral_clustering函数进行聚类,k是聚类的类别数```二、模糊决策方法的基本原理模糊决策方法是一种基于模糊理论的决策方法,它通过将问题中的模糊性和不确定性转化为数学上的隶属度,从而实现对决策问题的处理。

FCM聚类算法的实现

FCM聚类算法的实现FCM(Fuzzy C-means)聚类算法是一种基于概率论和模糊集理论的聚类分析方法。

与传统的硬聚类方法不同,FCM允许样本同时属于多个聚类,并给出每个聚类的隶属度。

它是一种非常常用的聚类算法,常应用于模式识别、数据挖掘、图像分割等领域。

1.初始化隶属度矩阵:-随机初始化每个样本对每个聚类的隶属度值,通常范围在[0,1]之间。

-随机初始化每个聚类的中心点。

2.根据隶属度矩阵计算聚类中心:-根据隶属度矩阵计算每个样本对每个聚类的隶属度的幂次方(通常取2)。

-根据幂次方后的隶属度矩阵计算每个聚类的中心点。

3.更新隶属度矩阵:-根据当前聚类中心计算每个样本对每个聚类的隶属度值。

-更新隶属度矩阵。

4.判断停止条件:-若当前聚类中心和隶属度矩阵与上一轮相比变化较小,则停止迭代,输出最终的聚类结果。

-否则,返回步骤2以下是FCM聚类算法的Python实现示例代码:```pythonimport numpy as npimport randomdef fcm(data, c, m, max_iter):n = len(data)d = len(data[0])centers = [[random.random( for _ in range(d)] for _ inrange(c)]u = np.zeros((n, c))iteration = 0while iteration < max_iter:for i in range(n):for j in range(c):u[i][j] = 1 / sum([(np.linalg.norm(data[i] - centers[j]) / np.linalg.norm(data[i] - centers[k])) ** (2 / (m - 1)) for k in range(c)])prev_centers = centers.copyfor j in range(c):centers[j] = sum([u[i][j] ** m * data[i] for i in range(n)]) / sum([u[i][j] ** m for i in range(n)])if np.linalg.norm(np.array(prev_centers) - np.array(centers)) < 1e-6:breakiteration += 1return centersdata = np.array([[1, 2], [2, 2], [3, 1], [6, 5], [7, 5], [8, 6]])c=2m=2max_iter = 100centers = fcm(data, c, m, max_iter)print("聚类中心:", centers)```上述代码演示了如何使用FCM聚类算法对一个简单的二维数据集进行聚类分析。

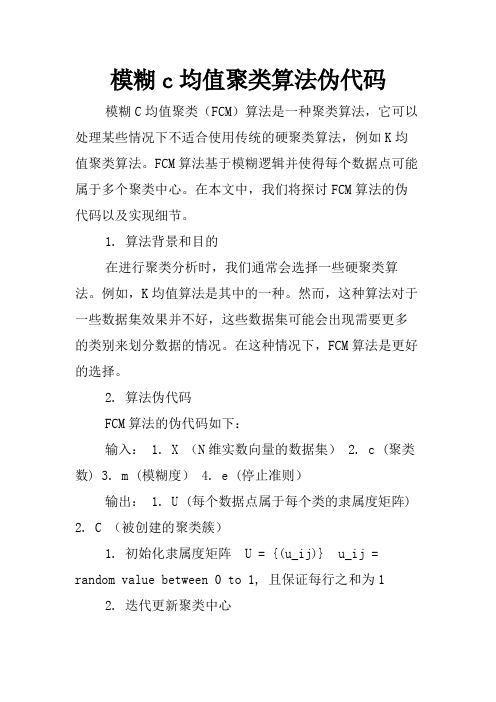

模糊c均值聚类算法伪代码

模糊c均值聚类算法伪代码模糊C均值聚类(FCM)算法是一种聚类算法,它可以处理某些情况下不适合使用传统的硬聚类算法,例如K均值聚类算法。

FCM算法基于模糊逻辑并使得每个数据点可能属于多个聚类中心。

在本文中,我们将探讨FCM算法的伪代码以及实现细节。

1. 算法背景和目的在进行聚类分析时,我们通常会选择一些硬聚类算法。

例如,K均值算法是其中的一种。

然而,这种算法对于一些数据集效果并不好,这些数据集可能会出现需要更多的类别来划分数据的情况。

在这种情况下,FCM算法是更好的选择。

2. 算法伪代码FCM算法的伪代码如下:输入: 1. X (N维实数向量的数据集) 2. c (聚类数) 3. m (模糊度) 4. e (停止准则)输出: 1. U (每个数据点属于每个类的隶属度矩阵) 2. C (被创建的聚类簇)1. 初始化隶属度矩阵 U = {(u_ij)} u_ij = random value between 0 to 1, 且保证每行之和为12. 迭代更新聚类中心while not converged: 2.1 对任意类心的计算C = {(c1, c2, ..., cn)} ci = sum_j (u_ij^m * x_j) / sum_j (u_ij^m)2.2 对任意数据点的隶属度矩阵的计算U = {(u_ij)} u_ij = [(sum_k { ||x_i - c_j||^2 / ||x_i - c_k||^2} ^ 1/(m-1))]^-12.3 判断是否收敛if ||U - U_last||< e: converged = True else: U_last = U3. 结束返回return (C, U)3. 算法实现细节在实现FCM算法的时候,我们需要注意以下几个细节:1. 初始化U矩阵在FCM算法中,我们需要初始化隶属度矩阵U。

对于每个数据点,在每个类中赋一个初始隶属度值。

每个隶属度值必须在0和1之间,并且每行之和必须为1。

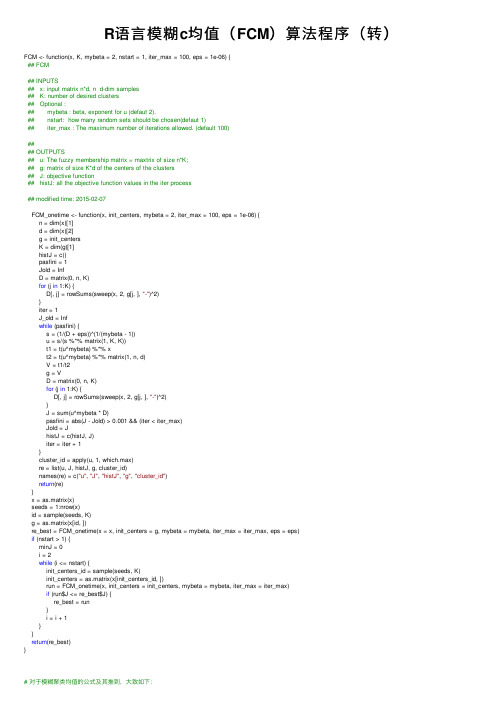

R语言模糊c均值(FCM)算法程序(转)

R语⾔模糊c均值(FCM)算法程序(转)FCM <- function(x, K, mybeta = 2, nstart = 1, iter_max = 100, eps = 1e-06) {## FCM## INPUTS## x: input matrix n*d, n d-dim samples## K: number of desired clusters## Optional :## mybeta : beta, exponent for u (defaut 2).## nstart: how many random sets should be chosen(defaut 1)## iter_max : The maximum number of iterations allowed. (default 100)#### OUTPUTS## u: The fuzzy membership matrix = maxtrix of size n*K;## g: matrix of size K*d of the centers of the clusters## J: objective function## histJ: all the objective function values in the iter process## modified time: 2015-02-07FCM_onetime <- function(x, init_centers, mybeta = 2, iter_max = 100, eps = 1e-06) {n = dim(x)[1]d = dim(x)[2]g = init_centersK = dim(g)[1]histJ = c()pasfini = 1Jold = InfD = matrix(0, n, K)for (j in 1:K) {D[, j] = rowSums(sweep(x, 2, g[j, ], "-")^2)}iter = 1J_old = Infwhile (pasfini) {s = (1/(D + eps))^(1/(mybeta - 1))u = s/(s %*% matrix(1, K, K))t1 = t(u^mybeta) %*% xt2 = t(u^mybeta) %*% matrix(1, n, d)V = t1/t2g = VD = matrix(0, n, K)for (j in 1:K) {D[, j] = rowSums(sweep(x, 2, g[j, ], "-")^2)}J = sum(u^mybeta * D)pasfini = abs(J - Jold) > 0.001 && (iter < iter_max)Jold = JhistJ = c(histJ, J)iter = iter + 1}cluster_id = apply(u, 1, which.max)re = list(u, J, histJ, g, cluster_id)names(re) = c("u", "J", "histJ", "g", "cluster_id")return(re)}x = as.matrix(x)seeds = 1:nrow(x)id = sample(seeds, K)g = as.matrix(x[id, ])re_best = FCM_onetime(x = x, init_centers = g, mybeta = mybeta, iter_max = iter_max, eps = eps)if (nstart > 1) {minJ = 0i = 2while (i <= nstart) {init_centers_id = sample(seeds, K)init_centers = as.matrix(x[init_centers_id, ])run = FCM_onetime(x, init_centers = init_centers, mybeta = mybeta, iter_max = iter_max)if (run$J <= re_best$J) {re_best = run}i = i + 1}}return(re_best)}# 对于模糊聚类均值的公式及其推到,⼤致如下:#主要代码参见下⾯:(其中使⽤kmeans作⽐较。

fcm聚类算法python实现

fcm聚类算法python实现Fuzzy C-means(FCM)聚类算法是一种常用的模糊聚类算法,它可以将数据集划分为多个模糊的聚类,并为每个数据点分配多个隶属度。

下面是一个使用Python实现FCM聚类算法的示例代码:```pythonimport numpy as npimport randomdef fcm(data, num_clusters, max_iters=100, m=2):# 初始化隶属度矩阵num_samples = data.shape[0]cluster_membership = np.zeros((num_samples, num_clusters))cluster_centers = []# 随机初始化聚类中心for _ in range(num_clusters):cluster_centers.append(random.uniform(np.min(data), np.max(data)))# 迭代更新聚类结果和聚类中心for _ in range(max_iters):# 更新隶属度矩阵for i in range(num_samples):distances = [abs(data[i] - c) for c in cluster_centers]for j in range(num_clusters):cluster_membership[i][j] = sum([(distances[j]/d)**(2/(m-1)) for d in distances])cluster_membership[i] = cluster_membership[i] / sum(cluster_membership[i])# 更新聚类中心for j in range(num_clusters):numerator = sum([(cluster_membership[i][j]**m) * data[i] for i in range(num_samples)])denominator = sum([(cluster_membership[i][j]**m) for i in range(num_samples)])cluster_centers[j] = numerator / denominatorreturn cluster_membership, cluster_centers# 示例使用data = np.array([1, 2, 3, 4, 5, 6, 7, 8, 9, 10])num_clusters = 2max_iters = 100m = 2cluster_membership, cluster_centers = fcm(data, num_clusters, max_iters, m)# 打印聚类结果for i in range(num_clusters):print(f"Cluster {i+1}:")for j in range(len(cluster_membership)):if cluster_membership[j][i] > 0.5:print(data[j])print("------")```以上代码实现了一个简单的FCM聚类算法。

MATLAB实现FCM 聚类算法

本文在阐述聚类分析方法的基础上重点研究FCM 聚类算法。

FCM 算法是一种基于划分的聚类算法,它的思想是使得被划分到同一簇的对象之间相似度最大,而不同簇之间的相似度最小。

最后基于MATLAB实现了对图像信息的聚类。

第 1 章概述聚类分析是数据挖掘的一项重要功能,而聚类算法是目前研究的核心,聚类分析就是使用聚类算法来发现有意义的聚类,即“物以类聚” 。

虽然聚类也可起到分类的作用,但和大多数分类或预测不同。

大多数分类方法都是演绎的,即人们事先确定某种事物分类的准则或各类别的标准,分类的过程就是比较分类的要素与各类别标准,然后将各要素划归于各类别中。

确定事物的分类准则或各类别的标准或多或少带有主观色彩。

为获得基于划分聚类分析的全局最优结果,则需要穷举所有可能的对象划分,为此大多数应用采用的常用启发方法包括:k-均值算法,算法中的每一个聚类均用相应聚类中对象的均值来表示;k-medoid 算法,算法中的每一个聚类均用相应聚类中离聚类中心最近的对象来表示。

这些启发聚类方法在分析中小规模数据集以发现圆形或球状聚类时工作得很好,但当分析处理大规模数据集或复杂数据类型时效果较差,需要对其进行扩展。

而模糊C均值(Fuzzy C-means, FCM)聚类方法,属于基于目标函数的模糊聚类算法的范畴。

模糊C均值聚类方法是基于目标函数的模糊聚类算法理论中最为完善、应用最为广泛的一种算法。

模糊c均值算法最早从硬聚类目标函数的优化中导出的。

为了借助目标函数法求解聚类问题,人们利用均方逼近理论构造了带约束的非线性规划函数,以此来求解聚类问题,从此类内平方误差和WGSS(Within-Groups Sum of Squared Error)成为聚类目标函数的普遍形式。

随着模糊划分概念的提出,Dunn [10] 首先将其推广到加权WGSS 函数,后来由Bezdek 扩展到加权WGSS 的无限族,形成了FCM 聚类算法的通用聚类准则。

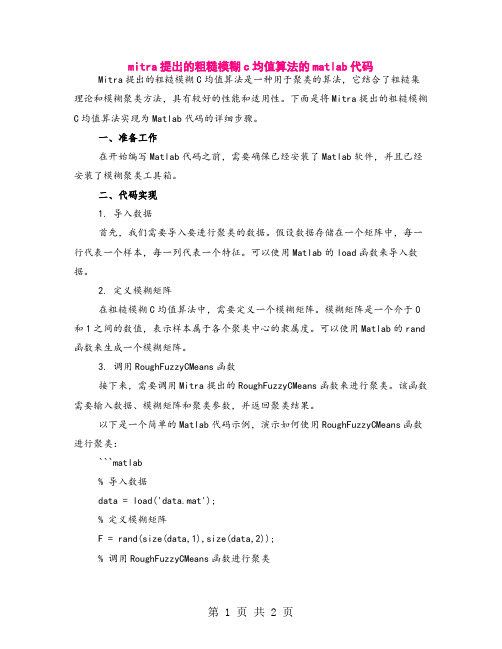

mitra提出的粗糙模糊c均值算法的matlab代码

mitra提出的粗糙模糊c均值算法的matlab代码Mitra提出的粗糙模糊C均值算法是一种用于聚类的算法,它结合了粗糙集理论和模糊聚类方法,具有较好的性能和适用性。

下面是将Mitra提出的粗糙模糊C均值算法实现为Matlab代码的详细步骤。

一、准备工作在开始编写Matlab代码之前,需要确保已经安装了Matlab软件,并且已经安装了模糊聚类工具箱。

二、代码实现1. 导入数据首先,我们需要导入要进行聚类的数据。

假设数据存储在一个矩阵中,每一行代表一个样本,每一列代表一个特征。

可以使用Matlab的load函数来导入数据。

2. 定义模糊矩阵在粗糙模糊C均值算法中,需要定义一个模糊矩阵。

模糊矩阵是一个介于0和1之间的数值,表示样本属于各个聚类中心的隶属度。

可以使用Matlab的rand函数来生成一个模糊矩阵。

3. 调用RoughFuzzyCMeans函数接下来,需要调用Mitra提出的RoughFuzzyCMeans函数来进行聚类。

该函数需要输入数据、模糊矩阵和聚类参数,并返回聚类结果。

以下是一个简单的Matlab代码示例,演示如何使用RoughFuzzyCMeans函数进行聚类:```matlab% 导入数据data = load('data.mat');% 定义模糊矩阵F = rand(size(data,1),size(data,2));% 调用RoughFuzzyCMeans函数进行聚类[U,C,D,T,V] =RoughFuzzyCMeans('Input',data,'FuzzyMatrix',F,'NumClusters',3,'Method',' maxclust');```在上面的代码中,'Input'参数是输入数据,'FuzzyMatrix'参数是模糊矩阵,'NumClusters'参数是聚类数目,'Method'参数是聚类方法。

图像模糊C均值聚类分割代码

图像模糊C均值聚类分割代码%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% 主函数%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% function mainima = imread('MR6.jpg');% 先设定FCM的⼏个初始参数options=[2; % FCM公式中的参数m100; % 最⼤迭代次数1e-5]; % ⽬标函数的最⼩误差class_number = 4; % 分为4类imt = ImageSegmentation(ima,class_number,options)subplot(1,2,1),imshow(ima),title('原图');subplot(1,2,2),imshow(imt); %显⽰⽣成的分割的图像kk = strcat('分割成',int2str(class_number),'类的输出图像');title(kk); %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% ImageSegmentation()函数:实现聚类分割图像% 输⼊:file为灰度图像⽂件 cluster_n为聚类类别个数 options为预设的初始参数% 输出分割后的图像%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% function imt = ImageSegmentation(file, cluster_n, options)ima = file;I = im2double(file);[x,y] = size(ima);number = x * y; % 图像的元素个数numel(I)data = reshape(I,number,1); %将矩阵元素转换为⼀列数据[center, U] = FCMprocess(data,cluster_n,options); %调⽤FCMData函数进⾏聚类% 对于每个元素对不同聚类中⼼的⾪属度,找出最⼤的那个⾪属度maxU = max(U); % 找出每⼀列的最⼤⾪属度temp = sort(center);for i = 1:cluster_n; % 按聚类结果分割图像% 前⾯求出每个元素的最⼤⾪属度,属于各聚类中⼼的元素坐标,并存放这些坐标% 调⽤eval函数将括号⾥的字符串转化为命令执⾏eval(['class_',int2str(i), '= find(U(', int2str(i), ',:) == maxU);']);%gray = round(255 * (i-1) / (cluster_n-1));index = find(temp == center(i));switch indexcase1gray = 0;case cluster_ngray = 255;otherwisegray = fix(255*(index-1)/(cluster_n-1));endeval(['I(class_',int2str(i), '(:))=', int2str(gray),';']);end;imt = mat2gray(I); %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% ⽤于计算聚类中⼼、⾪属度矩阵和⽬标函数%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% function [center, U] = FCMprocess(data, cluster_num, options)%data为聚类数据,cluster_num为类别数m = options(1); % 参数mmax_iteration = options(2); % 最终的迭代次数min_deviation = options(3); % 最⼩判别误差data_number = size(data, 1); % 元素个数obj_function = zeros(max_iteration, 1); % obj_function⽤于存放⽬标函数的值% ⽣成⾪属度矩阵UU = rand(cluster_num, data_number); % 随机⽣成⾪属度矩阵UsumU = sum(U,1); % 计算U中每列元素和for k = 1:data_numberU(:,k) = U(:,k) ./ sumU(k); % 对⾪属矩阵U进⾏归⼀化处理endfor i = 1:max_iteration[U, center, obj_function(i)] = FCMStep(data, U, cluster_num, m); %调⽤FCMStep函数进⾏迭代fprintf('第%d次迭代, ⽬标函数值为%f\n', i, obj_function(i));% 检查迭代终⽌条件if i > 1,if abs(obj_function(i) - obj_function(i-1)) < min_deviationbreak;endendend%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% % 该函数⽤于每次迭代过程function [newU,center,obj_function] = FCMStep(data, U, cluster_num, m)% data为被聚类数据,U为⾪属度矩阵,cluster_num为聚类类别数,m为FCM中的参数m% 函数调⽤后得到新的⾪属度矩阵newU,聚类中⼼center,⽬标函数值obj_function %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% % 以下是计算模糊⾪属度Ut[x,y] = size(U);A = ones(x,y);a = 0.85;Ut = abs(A - U -(A - (U).^a).^(1/a));Ud = U + Ut;[j,k,l] = size(data);pp = y;pai = (sum(Ut,2)) ./pp;obj = sum(pai.*exp(1-pai)); %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% Ud = U;% obj = 0;nf = Ud;mf = Ud.^m; % FMC中的U^m% center = nf*data./((ones(size(data, 2), 1)*sum(nf'))'); % 得到聚类中⼼data1 = zeros(x,y);data1(1,:) = data';data1(2,:) = data';data1(3,:) = data';data1(4,:) = data';% data1(5,:) = data';center = sum(nf.*data1,2)./sum(nf,2); % 得到聚类中⼼dist = Distance(center, data); % 调⽤myfcmdist函数计算聚类中⼼与被聚类数据的距离obj_function = sum(sum((dist.^2).*mf))+obj; % 得到⽬标函数值tmp = dist.^(-2/(m-1)); % 如果迭代次数不为1,计算新的⾪属度矩阵newU = tmp./(ones(cluster_num, 1)*sum(tmp)); % U_new为新的⾪属度矩阵%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% % Distance()函数⽤于计算聚类中⼼与被聚类数据的距离% center为聚类中⼼,data为被聚类数据,输出各元素到聚类中⼼的距离out %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% function out = Distance(center, data)data_number = size(data,1);class_number = size(center, 1);kk = ones(data_number,1); % 构造与数据⼤⼩相同的全1矩阵kkout = zeros(class_number, data_number);if size(center, 2) > 1, %若类别数⼤于1for k = 1:class_numberout(k, :) = sqrt(sum(((data - kk...*center(k,:)).^2)'));endelse % data为⼀维数据for k = 1:class_numberout(k, :) = abs(center(k) - data)';endend。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

模糊c均值聚类FCM算法的MATLAB代码我做毕业论文时需要模糊C-均值聚类,找了好长时间才找到这个,分享给大家:FCM算法的两种迭代形式的MA TLAB代码写于下,也许有的同学会用得着:m文件1/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm(Data,C,plotflag,M,epsm)% 模糊C 均值聚类FCM: 从随机初始化划分矩阵开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm(Data,C,plotflag,M,epsm)% 输入:% Data: N×S 型矩阵,聚类的原始数据,即一组有限的观测样本集,% Data 的每一行为一个观测样本的特征矢量,S 为特征矢量% 的维数,N 为样本点的个数% C: 聚类数,1<C<N% plotflag: 聚类结果2D/3D 绘图标记,0 表示不绘图,为缺省值% M: 加权指数,缺省值为2% epsm: FCM 算法的迭代停止阈值,缺省值为1.0e-6% 输出:% U: C×N 型矩阵,FCM 的划分矩阵% P: C×S 型矩阵,FCM 的聚类中心,每一行对应一个聚类原型% Dist: C×N 型矩阵,FCM 各聚类中心到各样本点的距离,聚类中% 心i 到样本点j 的距离为Dist(i,j)% Cluster_Res: 聚类结果,共C 行,每一行对应一类% Obj_Fcn: 目标函数值% iter: FCM 算法迭代次数% See also: fuzzydist maxrowf fcmplotif nargin<5epsm=1.0e-6;endif nargin<4M=2;endif nargin<3plotflag=0;end[N,S]=size(Data);m=2/(M-1);iter=0;Dist(C,N)=0; U(C,N)=0; P(C,S)=0;% 随机初始化划分矩阵U0 = rand(C,N);U0=U0./(ones(C,1)*sum(U0));% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新聚类中心PUm=U0.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(U-U0,Inf)<epsmbreakendU0=U;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);endm文件2/7:function [U,P,Dist,Cluster_Res,Obj_Fcn,iter]=fuzzycm2(Data,P0,plotflag,M,epsm) % 模糊C 均值聚类FCM: 从指定初始聚类中心开始迭代% [U,P,Dist,Cluster_Res,Obj_Fcn,iter] = fuzzycm2(Data,P0,plotflag,M,epsm)% 输入: Data,plotflag,M,epsm: 见fuzzycm.m% P0: 初始聚类中心% 输出: U,P,Dist,Cluster_Res,Obj_Fcn,iter: 见fuzzycm.m% See also: fuzzycmif nargin<5epsm=1.0e-6;if nargin<4M=2;endif nargin<3plotflag=0;end[N,S] = size(Data); m = 2/(M-1); iter = 0;C=size(P0,1);Dist(C,N)=0;U(C,N)=0;P(C,S)=0;% FCM 的迭代算法while true% 迭代计数器iter=iter+1;% 计算或更新划分矩阵Ufor i=1:Cfor j=1:NDist(i,j)=fuzzydist(P0(i,:),Data(j,:));endendU=1./(Dist.^m.*(ones(C,1)*sum(Dist.^(-m))));% 更新聚类中心PUm=U.^M;P=Um*Data./(ones(S,1)*sum(Um'))';% 目标函数值: 类内加权平方误差和if nargout>4 | plotflagObj_Fcn(iter)=sum(sum(Um.*Dist.^2));end% FCM 算法迭代停止条件if norm(P-P0,Inf)<epsmbreakendP0=P;end% 聚类结果if nargout > 3res = maxrowf(U);for c = 1:Cv = find(res==c);Cluster_Res(c,1:length(v))=v;endend% 绘图if plotflagfcmplot(Data,U,P,Obj_Fcn);m文件3/7:function fcmplot(Data,U,P,Obj_Fcn)% FCM 结果绘图函数% See also: fuzzycm maxrowf ellipse[C,S] = size(P); res = maxrowf(U);str = 'po*x+d^v><.h';% 目标函数绘图figure(1),plot(Obj_Fcn)title('目标函数值变化曲线','fontsize',8)% 2D 绘图if S==2figure(2),plot(P(:,1),P(:,2),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot(v(:,1),v(:,2),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2,'r:') endgrid on,title('2D 聚类结果图','fontsize',8),hold off end% 3D 绘图if S>2figure(2),plot3(P(:,1),P(:,2),P(:,3),'rs'),hold onfor i=1:Cv=Data(find(res==i),:);plot3(v(:,1),v(:,2),v(:,3),str(rem(i,12)+1))ellipse(max(v(:,1))-min(v(:,1)), ...max(v(:,2))-min(v(:,2)), ...[max(v(:,1))+min(v(:,1)), ...max(v(:,2))+min(v(:,2))]/2, ...'r:',(max(v(:,3))+min(v(:,3)))/2) endgrid on,title('3D 聚类结果图','fontsize',8),hold off endm文件4/7:function D=fuzzydist(A,B)% 模糊聚类分析: 样本间的距离% D = fuzzydist(A,B)D=norm(A-B);m文件5/7:function mr=maxrowf(U,c)% 求矩阵U 每列第c 大元素所在行,c 的缺省值为1% 调用格式: mr = maxrowf(U,c)% See also: addrif nargin<2c=1;endN=size(U,2);mr(1,N)=0;for j=1:Naj=addr(U(:,j),'descend');mr(j)=aj(c);endm文件6/7:function ellipse(a,b,center,style,c_3d)% 绘制一个椭圆% 调用: ellipse(a,b,center,style,c_3d)% 输入:% a: 椭圆的轴长(平行于x 轴)% b: 椭圆的轴长(平行于y 轴)% center: 椭圆的中心[x0,y0],缺省值为[0,0]% style: 绘制的线型和颜色,缺省值为实线蓝色% c_3d: 椭圆的中心在3D 空间中的z 轴坐标,可缺省if nargin<4style='b';endif nargin<3 | isempty(center)center=[0,0];endt=1:360;x=a/2*cosd(t)+center(1);y=b/2*sind(t)+center(2);if nargin>4plot3(x,y,ones(1,360)*c_3d,style)elseplot(x,y,style)endm文件7/7:function f = addr(a,strsort)% 返回向量升序或降序排列后各分量在原始向量中的索引% 函数调用:f = addr(a,strsort)% strsort: 'ascend' or 'descend'% default is 'ascend'% -------- example --------% addr([ 4 5 1 2 ]) returns ans:% [ 3 4 1 2 ]if nargin==1strsort='ascend';endsa=sort(a); ca=a;la=length(a);f(la)=0;for i=1:laf(i)=find(ca==sa(i),1);ca(f(i))=NaN;endif strcmp(strsort,'descend') f=fliplr(f);end几天前我还在这里发帖求助,可是很幸运在其他地方找到了,在这里和大家分享一下!function [center, U, obj_fcn] = FCMClust(data, cluster_n, options)% FCMClust.m 采用模糊C均值对数据集data聚为cluster_n类%% 用法:% 1. [center,U,obj_fcn] = FCMClust(Data,N_cluster,options);% 2. [center,U,obj_fcn] = FCMClust(Data,N_cluster);%% 输入:% data ---- nxm矩阵,表示n个样本,每个样本具有m的维特征值% N_cluster ---- 标量,表示聚合中心数目,即类别数% options ---- 4x1矩阵,其中% options(1): 隶属度矩阵U的指数,>1 (缺省值: 2.0)% options(2): 最大迭代次数(缺省值: 100)% options(3): 隶属度最小变化量,迭代终止条件(缺省值: 1e-5)% options(4): 每次迭代是否输出信息标志 (缺省值: 1)% 输出:% center ---- 聚类中心% U ---- 隶属度矩阵% obj_fcn ---- 目标函数值% Example:% data = rand(100,2);% [center,U,obj_fcn] = FCMClust(data,2);% plot(data(:,1), data(:,2),'o');% hold on;% maxU = max(U);% index1 = find(U(1,:) == maxU);% index2 = find(U(2,:) == maxU);% line(data(index1,1),data(index1,2),'marker','*','color',' g');% line(data(index2,1),data(index2,2),'marker','*','color',' r');% plot([center([1 2],1)],[center([1 2],2)],'*','color','k') % hold off;if nargin ~= 2 & nargin ~= 3, %判断输入参数个数只能是2个或3个error('Too many or too few input arguments!');enddata_n = size(data, 1); % 求出data的第一维(rows)数,即样本个数in_n = size(data, 2); % 求出data的第二维(columns)数,即特征值长度% 默认操作参数default_options = [2; % 隶属度矩阵U的指数100; % 最大迭代次数1e-5; % 隶属度最小变化量,迭代终止条件1]; % 每次迭代是否输出信息标志if nargin == 2,options = default_options;else %分析有options做参数时候的情况% 如果输入参数个数是二那么就调用默认的option;if length(options) < 4, %如果用户给的opition数少于4个那么其他用默认值;tmp = default_options;tmp(1:length(options)) = options;options = tmp;end% 返回options中是数的值为0(如NaN),不是数时为1nan_index = find(isnan(options)==1);%将denfault_options中对应位置的参数赋值给options中不是数的位置.options(nan_index) = default_options(nan_index);if options(1) <= 1, %如果模糊矩阵的指数小于等于1error('The exponent should be greater than 1!');endend%将options 中的分量分别赋值给四个变量;expo = options(1); % 隶属度矩阵U的指数max_iter = options(2); % 最大迭代次数min_impro = options(3); % 隶属度最小变化量,迭代终止条件display = options(4); % 每次迭代是否输出信息标志obj_fcn = zeros(max_iter, 1); % 初始化输出参数obj_fcnU = initfcm(cluster_n, data_n); % 初始化模糊分配矩阵,使U满足列上相加为1,% Main loop 主要循环for i = 1:max_iter,%在第k步循环中改变聚类中心ceneter,和分配函数U的隶属度值;[U, center, obj_fcn(i)] = stepfcm(data, U, cluster_n, expo);if display,fprintf('FCM:Iteration count = %d, obj. fcn = %f\n', i, obj_fcn(i));end% 终止条件判别if i > 1,if abs(obj_fcn(i) - obj_fcn(i-1)) < min_impro,break;end,endenditer_n = i; % 实际迭代次数obj_fcn(iter_n+1:max_iter) = [];[center, U, obj_fcn] = FCMClust(Data,N_cluster,options)data=[94.4304 98 60 0 8592.8068 70 70 0 75.286.3522 100 75 24.87 91.580.5512 50 90 0 65.480.494 76 100 0 9888.1528 100 60 80 78.484.567 55 80 0 8587.722 30 60 0 4988.0056 95 70 46.459 45.885.948 100 60 0 55.683.9578 10 90 0 78.490.0822 5 60 0 58.876.7448 10 60 0 39.295.062 100 70 62.37 94.8];N_cluster=4;options(1)=[2];options(2)=[100];options(3)=[1e-5];options(4)=[1];。