第二章 信源熵

合集下载

第2章信源熵

16

2.1.3 信源熵基本性质(续)

4. 扩展性: 信源含有的新增消息为小概率时, 熵不变 5. 确定性:某消息取值概率为1时,熵为0 6. 可加性: H(XY)=H(X)+H(Y/X)=H(Y)+H(X/Y) 7. 极值性: H n [ p( x1 ), p( x2 ),, p( xn )] p( xi ) log 2 p( xi )

信源 X

信道

信宿 Y

9

2.1.2 自信息和信源熵(续)

二 、互信息和条件互信息 p( xi / y j ) 1. 互信息 I ( xi ; y j ) log 2 (2.1.7) p( xi ) (1) yj对xi的互信息 I(xi;yj) 即: I(xi;yj)= I(xi)- I(xi/yj) (2.1.8) p(xi) ——先验概率:信源发xi的概率 p(xi/yj)——后验概率:信宿收到yj后, 推测信源发xi的概率 [含义] 互信息I(xi;yj) =自信息I(xi) - 条件自信息I(xi/yj) *I(xi) __信宿收到yj之前,对信源发xi的不确定度 * I(xi/yj) __信宿收到yj之后,对信源发xi的不确定度 * I(xi;yj) __收到yj而得到(关于xi )的互信息 =不确定度的减少量 10

20

2.1.5 平均互信息(续)

二、物理意义 1. 由(2.1.43) : I(X;Y)= H(X) – H(X/Y) (1) H(X)——信源熵:X的不确定度 H(X/Y)——已知Y时,对X仍剩的不确定度 [结论]―Y已知”使得对X的不确定度减小了, 即获得了I(X;Y) 的信息量 (2) H(X)——信源含有的平均信息量(总,有用) I(X/Y)——信宿收到的平均信息量(有用部分) [结论] H(X/Y)—因信道有扰而丢失的平均信息量, 21 故称损失熵

2.1.3 信源熵基本性质(续)

4. 扩展性: 信源含有的新增消息为小概率时, 熵不变 5. 确定性:某消息取值概率为1时,熵为0 6. 可加性: H(XY)=H(X)+H(Y/X)=H(Y)+H(X/Y) 7. 极值性: H n [ p( x1 ), p( x2 ),, p( xn )] p( xi ) log 2 p( xi )

信源 X

信道

信宿 Y

9

2.1.2 自信息和信源熵(续)

二 、互信息和条件互信息 p( xi / y j ) 1. 互信息 I ( xi ; y j ) log 2 (2.1.7) p( xi ) (1) yj对xi的互信息 I(xi;yj) 即: I(xi;yj)= I(xi)- I(xi/yj) (2.1.8) p(xi) ——先验概率:信源发xi的概率 p(xi/yj)——后验概率:信宿收到yj后, 推测信源发xi的概率 [含义] 互信息I(xi;yj) =自信息I(xi) - 条件自信息I(xi/yj) *I(xi) __信宿收到yj之前,对信源发xi的不确定度 * I(xi/yj) __信宿收到yj之后,对信源发xi的不确定度 * I(xi;yj) __收到yj而得到(关于xi )的互信息 =不确定度的减少量 10

20

2.1.5 平均互信息(续)

二、物理意义 1. 由(2.1.43) : I(X;Y)= H(X) – H(X/Y) (1) H(X)——信源熵:X的不确定度 H(X/Y)——已知Y时,对X仍剩的不确定度 [结论]―Y已知”使得对X的不确定度减小了, 即获得了I(X;Y) 的信息量 (2) H(X)——信源含有的平均信息量(总,有用) I(X/Y)——信宿收到的平均信息量(有用部分) [结论] H(X/Y)—因信道有扰而丢失的平均信息量, 21 故称损失熵

第二章 信源熵

I ( xi y j ) = log 2 p ( xi y j )

XY x1 y1 , , x1 ym , x2 y1 , , x2 ym , , xn y1 , xn ym P ( XY ) = p( x y ), p( x y ), p( x y ),, p( x y ) 1 1 1 m 2 1 n m 0 ≤ p ( xi y j ) ≤ 1, ∑∑ p ( xi y j ) = 1

信息论基础 第二章 信源熵

苗立刚 ligangmiao@ 实验楼417 实验楼 电话8048018 电话 东北大学秦皇岛分校自动化工程系 2009年 2009年3月

第二章 信源熵

本章主要讨论的问题: 本章主要讨论的问题:

2.1 单符号离散信源 2.2 多符号离散平稳信源 2.3 连续信源 2.4 离散无失真信源编码定理

Y y1 , y2 , , y j , , ym 信宿 = p ( y ), p( y ), , p ( y ), , p ( y ) , ∑ p( y j ) = 1 j 1 2 j m P(Y )

2.1单符号离散信源 2.1

–信源发出消息 xi 的概率 p ( xi ) 称为先验概率,信 信源发出消息 称为先验概率 先验概率, 的概率称为后验概 宿收到 y j 后推测信源发出 xi 的概率称为后验概 率 p ( xi / y j ) 。 –定义 xi 的后验概率与先验概率比值的对数为 y j 的后验概率与先验概 比值的对数为 先验概率 定义 互信息量, 表示, 对 xi 的互信息量,用 I ( x i ; y j ) 表示,即

2.1单符号离散信源 2.1

自信息量的单位 –自信息量的单位取决于对数的底; 自信息量的单位取决于对数的底; 自信息量的单位取决于对数的底 –底为2,单位为“比特(bit)”; 底为2 单位为“比特(bit) ; 底为 –底为e,单位为“奈特(nat)”; 底为e 单位为“奈特(nat) ; 底为 –底为10,单位为“哈特(hat)”; 底为10 底为10,单位为“哈特(hat)”; –1 nat = 1.44bit , 1 hat = 3.32 bit; bit; 1 例1:从26个英文字母中,随即选取一个字母,则该事件的自 26个英文字母中,随即选取一个字母, 个英文字母中 信息量为 I = -log2(1/26) = 4.7 比特 例2:设m比特的二进制数中的每一个是等概率出现的(这样的 比特的二进制数中的每一个是等概率出现的( 数共有2 则任何一个数出现的自信息为: 数共有2m个),则任何一个数出现的自信息为: 比特/ I = -log2(1/ 2m) = m 比特/符号

第二章基本信息论5信源冗余度

适当的冗余可提高抗干扰能力

信源编码:通过减少冗余来提高通信效率 信道编码:通过增加冗余来提高通信的抗干扰能力

E 0.103 N 0.057 W 0.018 F 0.021 O 0.063 X 0.001 G 0.015 P 0.015 Y 0.016

27

p(xi ) lb p( xi )

i 1

H 0.047 Q 0.001 Z 0.001

4.03比特/符号

I 0.058 R 0.048 空格 0.189

3)看成一阶马尔可夫信源,则信源熵: H2 ( X ) H11( X ) 3.32比特/符号

4)看成二阶马尔可夫信源,则信源熵: H3( X ) H21( X ) 3.1比特/符号

5)看成无穷阶马尔可夫信源,则信源熵: H ( X ) 1.4比特/符号

二、冗余的利用

消息的冗余为提高通信效率、压缩信号容量提供 了基础。

lb

1 27

英语 出现 英语 出现 英语 出现 字母 概率 字母 概率 字母 概率

4.75比特/符号

A 0.064 J 0.001 S 0.051 2)按实际概率分布,且 B 0.013 K 0.005 T 0.08 无相关性,则信源熵:

C 0.022 L 0.032 U 0.023

D 0.032 M 0.020 V 0.008 H1( X ) H01( X )

2

Hmax ( X ) p( xi ) lb p( xi )

i 1

2 1 lb 1 1比特/符号

i1 2 2

若发送12个符号,则12个符号含有的信息量为:

I12 12H max ( X ) 12比特

若信源符号间有相关性,则信源熵达不到最大熵。 若实际上为0.8比特/符号,则发送12个符号只能传 递12*0.8=9.6比特的信息量。

信源编码:通过减少冗余来提高通信效率 信道编码:通过增加冗余来提高通信的抗干扰能力

E 0.103 N 0.057 W 0.018 F 0.021 O 0.063 X 0.001 G 0.015 P 0.015 Y 0.016

27

p(xi ) lb p( xi )

i 1

H 0.047 Q 0.001 Z 0.001

4.03比特/符号

I 0.058 R 0.048 空格 0.189

3)看成一阶马尔可夫信源,则信源熵: H2 ( X ) H11( X ) 3.32比特/符号

4)看成二阶马尔可夫信源,则信源熵: H3( X ) H21( X ) 3.1比特/符号

5)看成无穷阶马尔可夫信源,则信源熵: H ( X ) 1.4比特/符号

二、冗余的利用

消息的冗余为提高通信效率、压缩信号容量提供 了基础。

lb

1 27

英语 出现 英语 出现 英语 出现 字母 概率 字母 概率 字母 概率

4.75比特/符号

A 0.064 J 0.001 S 0.051 2)按实际概率分布,且 B 0.013 K 0.005 T 0.08 无相关性,则信源熵:

C 0.022 L 0.032 U 0.023

D 0.032 M 0.020 V 0.008 H1( X ) H01( X )

2

Hmax ( X ) p( xi ) lb p( xi )

i 1

2 1 lb 1 1比特/符号

i1 2 2

若发送12个符号,则12个符号含有的信息量为:

I12 12H max ( X ) 12比特

若信源符号间有相关性,则信源熵达不到最大熵。 若实际上为0.8比特/符号,则发送12个符号只能传 递12*0.8=9.6比特的信息量。

4第二章3-熵的计算

q

q

(3)根据概率关系,可以得到联合熵与条件熵的关系: 根据概率关系,可以得到联合熵与条件熵的关系: 联合熵与条件熵的关系

H ( X1 X 2 ) = −∑∑ P(ai a j ) logP(ai a j )

i =1 j =1

q q

q

qபைடு நூலகம்

= −∑∑ P (ai a j ) log( P (ai )P (a j | ai ))

得:

H ( X ) = −∑ P(ai ) logP(ai ) = 1.542( Bit / Symbol)

i =1 3

H ( X 2 / X 1 ) = −∑∑ P(ai a j ) logP(a j / ai ) = 0.87(Bit / Symbol)

i =1 j =1 3

3

3

H ( X 1 X 2 ) = −∑∑ P(ai a j ) logP(ai a j ) = 2.41( Bit / Symbols)

0.71比特/符号

•

从另一角度(来研究信源X的信息熵的近似值) 从另一角度(来研究信源X的信息熵的近似值):

( 1 ) 由于信源 X 发出的符号序列中前后两个符号之间有依 由于信源X 赖性,可以先求出在已知前面一个符号X 已知前面一个符号 赖性, 可以先求出在已知前面一个符号Xl=ai时,信源输出 下一个符号的平均不确定性 的平均不确定性: 下一个符号的平均不确定性:

0.71比特/符号

二维平稳信源X:

条件熵H(X2|X1) 平均符号熵H2(X) 简单信源X符号熵H(X)

H(X2|X1) ≤H2(X) ≤H(X) H(X1X2)=H(X1)+H(X2|X1)=2H2(X)

有记忆平稳信源的联合熵、条件熵、 有记忆平稳信源的联合熵、条件熵、平均符号熵 与无记忆信源熵之间的定量关系。 与无记忆信源熵之间的定量关系。

2-2 第2章 信源熵及其基本性质和定理

1、信源熵;2、条件熵;3、联合熵 信源熵; 条件熵;

2.1.3 2.1.4 2.1.5 2.1.6

信源熵的基本性质和定理 加权熵的概念及基本性质 平均互信息量 各种熵之间的关系

1

自信息量不能作为信源的信息测度

自信息量 I ( xi ), i = 1,2,... 是指某一信源X发出某一信 息符号 x i 所含有的信息量。发出的信息符号不同, 它们所含有的信息量就不同。

晴 地域A 1/2 地域B 1/2 多云 1/4 1/8 雨 1/8 1/8 冰雹 1/8 1/4

H(A) = H(B) =1.75bit 1 1 2 = log 2 + log 4 + log 8 2 4 8

17

熵函数的性质—— 2. 非负性 熵函数的性质

非负性

H(X ) = H[ p(x1), p(x2 ),L, p(xn )] H(X ) = −∑p(xi ) log p(xi ) ≥ 0

信源熵与平均自信息量数值相等,含义不同

信源熵表征信源的平均不确定度; 平均自信息量是消除信源不确定度所需要的信 息的度量;

信源熵H(X)的三种物理含义:

表示信源输出后,每个离散消息所提供的平均 信息量; 表示信源输出前,信源的平均不确定度; 反映了变量X的随机性。

9

条件熵

定义 2.1.7 联合集XY上,条件自信息量I(x|y)的 概率加权平均值定义为条件熵。其定义式为

f α X 1 + (1 − α ) X 2 < α f ( X 1) + (1 − α ) f ( X 2) ( X 1 ≠ X 2)

则称f(X)为定义域上的下凸函数(Cup型函数)或严格下凸函数。 f(x)是上凸函数 是上凸函数, f(x)便是下凸函数 反过来也成立。 便是下凸函数, 若f(x)是上凸函数,则-f(x)便是下凸函数,反过来也成立。故, 通常只需研究上凸函数

2.1.3 2.1.4 2.1.5 2.1.6

信源熵的基本性质和定理 加权熵的概念及基本性质 平均互信息量 各种熵之间的关系

1

自信息量不能作为信源的信息测度

自信息量 I ( xi ), i = 1,2,... 是指某一信源X发出某一信 息符号 x i 所含有的信息量。发出的信息符号不同, 它们所含有的信息量就不同。

晴 地域A 1/2 地域B 1/2 多云 1/4 1/8 雨 1/8 1/8 冰雹 1/8 1/4

H(A) = H(B) =1.75bit 1 1 2 = log 2 + log 4 + log 8 2 4 8

17

熵函数的性质—— 2. 非负性 熵函数的性质

非负性

H(X ) = H[ p(x1), p(x2 ),L, p(xn )] H(X ) = −∑p(xi ) log p(xi ) ≥ 0

信源熵与平均自信息量数值相等,含义不同

信源熵表征信源的平均不确定度; 平均自信息量是消除信源不确定度所需要的信 息的度量;

信源熵H(X)的三种物理含义:

表示信源输出后,每个离散消息所提供的平均 信息量; 表示信源输出前,信源的平均不确定度; 反映了变量X的随机性。

9

条件熵

定义 2.1.7 联合集XY上,条件自信息量I(x|y)的 概率加权平均值定义为条件熵。其定义式为

f α X 1 + (1 − α ) X 2 < α f ( X 1) + (1 − α ) f ( X 2) ( X 1 ≠ X 2)

则称f(X)为定义域上的下凸函数(Cup型函数)或严格下凸函数。 f(x)是上凸函数 是上凸函数, f(x)便是下凸函数 反过来也成立。 便是下凸函数, 若f(x)是上凸函数,则-f(x)便是下凸函数,反过来也成立。故, 通常只需研究上凸函数

第二章基本信息论6_连续信源的熵

说明:相比放大前,信 号放大后无穷大项小了 1/ 4 1比特,相对熵大了1比 特,而绝对熵保持不变。 0

P( x )

1/ 2

1 dx1 3

0

x

P( x )

2 dx2

6 x

二、连续信源熵的性质

连续信源熵可正可负

H ( X )

1

p( x )log p( x )dx

1 1 lb dx 1比特/采样 3 2 2

2.6 连续信源的熵

一、连续信源熵的定义

连续信源:输出在时间和取值上都是连续的信源

连续信源

采样

离散信源

求信源熵

若连续信源的频带受限,为W,则根据采样定理, 只要采样频率大于2W,则连续信源经采样离散 后,不损失任何信息。 p( x ) 将连续信源离散化为离散 信源,其信源熵为:

p( xi )dx log p( xi )dx

1

3

x

H ( X ) p( x )log p( x )dx

P( x )

1 1 lb dx 2 4 4 2比特/采样

6

1/ 4

0

2

信息量放大了2倍?

6 x

dx2 2dx1

1 1 lb lb dx2 2dx1 1 1 lb lb 2 dx1 1 1 lb dx1

H max ( X ) ln 2 e ln 2 eP 奈特/采样

1.433lb 2 eP 比特/采样

3、输出幅度平均值受限的信源

连续信源X输出非负信号的平均值受限,当其输 出信号幅度为指数分布时,输出最大熵,最大熵 随着X的数学期望(均值)的增大而增大。

P( x )

1/ 2

1 dx1 3

0

x

P( x )

2 dx2

6 x

二、连续信源熵的性质

连续信源熵可正可负

H ( X )

1

p( x )log p( x )dx

1 1 lb dx 1比特/采样 3 2 2

2.6 连续信源的熵

一、连续信源熵的定义

连续信源:输出在时间和取值上都是连续的信源

连续信源

采样

离散信源

求信源熵

若连续信源的频带受限,为W,则根据采样定理, 只要采样频率大于2W,则连续信源经采样离散 后,不损失任何信息。 p( x ) 将连续信源离散化为离散 信源,其信源熵为:

p( xi )dx log p( xi )dx

1

3

x

H ( X ) p( x )log p( x )dx

P( x )

1 1 lb dx 2 4 4 2比特/采样

6

1/ 4

0

2

信息量放大了2倍?

6 x

dx2 2dx1

1 1 lb lb dx2 2dx1 1 1 lb lb 2 dx1 1 1 lb dx1

H max ( X ) ln 2 e ln 2 eP 奈特/采样

1.433lb 2 eP 比特/采样

3、输出幅度平均值受限的信源

连续信源X输出非负信号的平均值受限,当其输 出信号幅度为指数分布时,输出最大熵,最大熵 随着X的数学期望(均值)的增大而增大。

第2章信源熵-概念及单符号离散信源熵

表示

x2 xn X x1 P(X) P(x ) P( x ) P( x ) 1 2 n

其中,0 P( x i ) 1, i 1,2,, n且 P( x i ) 1

i 1

n

例1

6 X 1 2 P(X) 1/ 6 1 / 6 1/ 6

I(x 4 ) log P(x 4 ) log( 1/ 8) log 8 3(bit )

信源熵

3、熵

定义

信源各消息自信息量的数学期望为该信源的熵, 也叫无条件熵,用H(X)表示。

表示

H(X) E[I( x i )] P( x i )I( x i ) P( x i ) log P( x i )

i 1 i 1

n

n

同理, (1 )P2 ( x i ) log[ P1 ( x i ) (1 )P2 ( x i )]

i 1

n

(1 )P2 ( x i ) log P2 ( x i )

i 1

n

信源熵

[P1 ( x i ) (1 )P2 ( x i )] log[ P1 ( x i ) (1 )P2 ( x i )]

信源熵

2、自信息量

假设单符号离散信源发出消息xi、xj 的概率 P(xi) < P(xj),那条消息具有更大的信 息量, xi 还是xj ?

信源熵

根据香农信息的概念,消息中具有不确定 性的成分才是信息,不确定性的成分越大, 或者说概率越小,信息量就越大,从这个 意义判断,消息xi 具有更大的信息量。

信源熵

离散信源又可以细分为: (1)离散无记忆信源:所发出的各 个符号之间是相互独立的,发出 的符号序列中的各个符号之间没 有统计关联性,各个符号的出现 概率是它自身的先验概率。 (2)离散有记忆信源:发出的各个 符号之间不是相互独立的,各个 符号出现的概率是有关联的。

信息导论-第6讲-信源熵

第二章 信源熵

③举 例

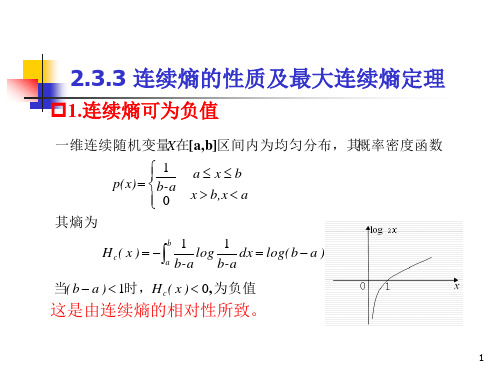

若连续信源的统计特性为均匀分布的概率密度函数

1 b−a p( x) = 0

a≤ x≤b x > b, x < a

1 a b−a

则

H c ( X ) = -∫

b b

log 2

1 b−a

dx = log 2 (b − a)

当(b-a)<1时,Hc(X)<0,为负值,即连续熵不具备 时 ,为负值, 非负性。 非负性。

第二章 信源熵

消息数是无限的。 消息数是无限的。输出的每个可能的消息是随机 过程{x(t)}中的一个样本函数。对于样本函数来说, 中的一个样本函数。 过程 中的一个样本函数 对于样本函数来说, 它是时间t的连续函数 的连续函数, 它是时间 的连续函数,时间的取值为不可数的无 限多个。另外,当固定某一瞬时t=t 限多个。另外,当固定某一瞬时 k时,信源的输 出是一个随机变量X, 的取值又是连续的 的取值又是连续的, 出是一个随机变量 ,X的取值又是连续的,为不 可数的无限多个值。 可数的无限多个值。因此连续信源可能有的消息 数为无限多个。 数为无限多个。 连续型信源,可用有限维概率密度函数族以及各 连续型信源,可用有限维概率密度函数族以及各 有限维概率密度函数族 维概率密度函数有关的统计量来描述。 维概率密度函数有关的统计量来描述。

H c ( X ) = − ∫ p( x) log 2 p( x)dx

R

上式定义的熵在形式上和离散信源相似, 上式定义的熵在形式上和离散信源相似,也满足离散熵 的主要特性,如可加性, 的主要特性,如可加性,但在概念上与离散熵有差异因 为它失去了离散熵的部分含义和性质。 为它失去了离散熵的部分含义和性质。

E ( xti ) = ∫ xp( x)dx

第2章 信源熵 第2讲 信源熵(平均自信息量)与 平均互信息量

• ① 观察者站在输出端 • I(X;Y) = H(X) – H(X/Y)

• H(X) — X 的先验不确定度。 • H(X/Y) — 疑义度(损失熵)。 表示已知Y 后,对X 仍然存在的不确 定度。代表了在信道中损失的信息。 • I(X;Y) — 已知Y 后关于X 的不确定度 减少的量。从Y 获得的关于X 的平均 信息量。

• 理解:已知 Y 时 X 的不确定度应小于一无所知时 X 的不 确定度。因为已知 Y 后,从 Y 或多或少可以得到一些关 于 X 的信息,从而使 X 的不确定度下降。

余 映 云南大学

19/38

熵的性质

• 证明:

• (利用了极值性)

余 映 云南大学

20/38

熵的性质

• (7) 可加性 H(XY) = H(X)+H(Y/X) H(XY) = H(Y)+H(X/Y)

余 映 云南大学 3/38

信源熵

• 举例

• 一布袋内放100个球,其中80个是黄色的,20个是白色的。 随便摸出一个球,猜测是什么颜色,其概率空间为

– x1:表示摸出的是黄球,x2:表示摸出的是白球

余 映 云南大学

4/38

信源熵与平均自信息量

• 信源熵和平均自信息量两者在数值上是相等的, 但含意并不相同。

余 映 云南大学

24/38

平均互信息量的定义

• 互信息量 I(xi; yj) 在联合概率空间 P(XY) 中的统 计平均值

称为 Y 对 X 的平均互信息量。 • X 对 Y 的平均互信息定义为

余 映 云南大学

25/38

平均互信息量的定义

• 平均互信息的第三种定义

• 平均互信息 I(X;Y) 克服了互信息量 I(xi;yj) 的随机 性,成为一个确定的量。

• H(X) — X 的先验不确定度。 • H(X/Y) — 疑义度(损失熵)。 表示已知Y 后,对X 仍然存在的不确 定度。代表了在信道中损失的信息。 • I(X;Y) — 已知Y 后关于X 的不确定度 减少的量。从Y 获得的关于X 的平均 信息量。

• 理解:已知 Y 时 X 的不确定度应小于一无所知时 X 的不 确定度。因为已知 Y 后,从 Y 或多或少可以得到一些关 于 X 的信息,从而使 X 的不确定度下降。

余 映 云南大学

19/38

熵的性质

• 证明:

• (利用了极值性)

余 映 云南大学

20/38

熵的性质

• (7) 可加性 H(XY) = H(X)+H(Y/X) H(XY) = H(Y)+H(X/Y)

余 映 云南大学 3/38

信源熵

• 举例

• 一布袋内放100个球,其中80个是黄色的,20个是白色的。 随便摸出一个球,猜测是什么颜色,其概率空间为

– x1:表示摸出的是黄球,x2:表示摸出的是白球

余 映 云南大学

4/38

信源熵与平均自信息量

• 信源熵和平均自信息量两者在数值上是相等的, 但含意并不相同。

余 映 云南大学

24/38

平均互信息量的定义

• 互信息量 I(xi; yj) 在联合概率空间 P(XY) 中的统 计平均值

称为 Y 对 X 的平均互信息量。 • X 对 Y 的平均互信息定义为

余 映 云南大学

25/38

平均互信息量的定义

• 平均互信息的第三种定义

• 平均互信息 I(X;Y) 克服了互信息量 I(xi;yj) 的随机 性,成为一个确定的量。

第2章信源熵--马尔科夫信源及极限熵

信源熵

定义

信源的m阶极限熵Hm+1与N-1阶极限熵H∞的相对差 为该信源的冗余度,也叫剩余度。

信源熵

0.2P(s1 ) 0.5P(s3 ) 0 0.2P(s1 ) P(s 2 ) 0.5P(s3 ) 0 0.5P(s 2 ) P(s3 ) 0.2P(s 4 ) 0 0.5P(s 2 ) 0.2P(s 4 ) 0

完备性

P(s1 ) P(s2 ) P(s3 ) P(s4 ) 1

状态转移图

信源熵

设状态s1=00、s2=01、s3=10、s4=11

P(0 / 00) P(00 / 00) P(s1 / s1 ) 0.8

0.8 s1

P(1 / 00) P(01 / 00) P(s 2 / s1 ) 0.2

P(0 / 01) P(10 / 01) P(s3 / s 2 ) 0.5

信源熵

强调m阶马尔科夫信源的长度特征,一般其极限熵 H∞记为Hm+1

H H m 1 P(si )P(s j / si ) log P(s j / si )

i 1 j 1 nm nm

例2

求极限熵

求m阶条件熵

图示二元二阶马尔科夫信源的极限熵

信源熵

遍历定理

P(s1 ) P(s1 )P(s1 / s1 ) P(s 2 )P(s1 / s 2 ) P(s3 )P(s1 / s3 ) P(s 4 )P(s1 / s 4 ) 0.8P(s1 ) 0.5P(s3 )

信源熵

P(a i ) P(x i m1 / x i1 x i 2 x i m ) P(x i 2 x i 3 x i m1 / x i1 x i 2 x i m ) P(x j1 x j2 x jm / x i1 x i 2 x i m ) P(s j / si )

第2章 信源熵

可用随机矢量来描述。 输出连续消息的信源。可用随 机过 连续信源 程来描述。

离 散 信 源

单符号

随机变量

信源

连 续 信 源

多符号

随机矢量 随机过程

信源分类

对于离散随机变量,取值于集合

a1

, a2 , , ai , , an

对任一 ai 记 p(ai ) P( X ai )

单符号离散信源的数学模型为

第2章:信源熵

统计度量、语义度量、语用度量、模 糊度量等等。最常用的方法是统计度 量。它用事件统计发生概率的对数描

信息度量的方法有:结构度量、

述事物的不确定性,得到消息的信息 量,建立熵的概念。熵概念是香农信 息论最基本最重要的概念。 举例:考研 从随机变量出发来研究信息,正是 香农信息论的基本假说

H ( X ) log n n n n 1 [ p (ai )] log e [ 1 p( ai )]log e 0 i 1 n i 1 n i 1

故有H ( X ) log n

1 式中 p(ai ) 1。当且仅当x 1, np(ai ) i 1 1 即p(ai ) 时,上式等号成立。 n

1 1 1 1 1 1 H ( X ) log log ( log ) 2 2 4 8 2 2 2 4 2 8 1.75(bit )

信源熵和平均自信息量两者在数 值上是相等的,但含义并不相同。信 源熵表征信源的平均不确定度,平均 自信息量是消除信源不确定度所需要 的信息的量度。信源一定,不管它是 否输出离散消息,只要这些离散消息 具有一定的概率特性,必有信源的熵 值,这熵值在总体平均的 意义上才有意义,因而是 一个确定值。

联合随机变量 XY 取值于集合

离 散 信 源

单符号

随机变量

信源

连 续 信 源

多符号

随机矢量 随机过程

信源分类

对于离散随机变量,取值于集合

a1

, a2 , , ai , , an

对任一 ai 记 p(ai ) P( X ai )

单符号离散信源的数学模型为

第2章:信源熵

统计度量、语义度量、语用度量、模 糊度量等等。最常用的方法是统计度 量。它用事件统计发生概率的对数描

信息度量的方法有:结构度量、

述事物的不确定性,得到消息的信息 量,建立熵的概念。熵概念是香农信 息论最基本最重要的概念。 举例:考研 从随机变量出发来研究信息,正是 香农信息论的基本假说

H ( X ) log n n n n 1 [ p (ai )] log e [ 1 p( ai )]log e 0 i 1 n i 1 n i 1

故有H ( X ) log n

1 式中 p(ai ) 1。当且仅当x 1, np(ai ) i 1 1 即p(ai ) 时,上式等号成立。 n

1 1 1 1 1 1 H ( X ) log log ( log ) 2 2 4 8 2 2 2 4 2 8 1.75(bit )

信源熵和平均自信息量两者在数 值上是相等的,但含义并不相同。信 源熵表征信源的平均不确定度,平均 自信息量是消除信源不确定度所需要 的信息的量度。信源一定,不管它是 否输出离散消息,只要这些离散消息 具有一定的概率特性,必有信源的熵 值,这熵值在总体平均的 意义上才有意义,因而是 一个确定值。

联合随机变量 XY 取值于集合

第二章 信源及信源熵

时间(空间) 取值 离散 离散 连续 连续

3

信源种类

举例 文字、数据、 离散化图像

数学描述 离散随机变量序列, 可列可数

离散信源 离散 (数字信源) 连续 连续信号

跳远比赛的结果、 连续随机变量序列, 语音信号抽样以后 可列可数 语音、音乐、热噪 一般用函数来表示, 声、图形、图像 可求导 不常见

波形信源 连续 (模拟信源) 离散

4

上海第二工业大学冯涛编写

17:18:25

实际信源分类

离散无记忆信源:H ( X) NH ( X) 记忆长度无限长: H 离散平稳信源 离散有记忆信源 平稳信源 记忆长度有限(马尔可夫信源): H m 1 连续平稳信源 非平稳信源

上海第二工业大学冯涛编写

17:18:25

分类2:根据各维随机变量的概率分布所对应的随机序列的 平稳性,即:是否随时间的推移而变化分: (1)平稳信源 (2)非平稳信源 分类3:根据随机变量间所对应的随机序列中随机变量前后 之间有无统计依赖关系,即:是否统计独立分: (1)有记忆信源 (2)无记忆信源 信源是产生消息(符号)、消息序列和连续消息的来源。 从数学上,由于消息的不确定性,因此,信源是产生随机变 量、随机序列和随机过程的源。 信源的基本特性是具有随机不确定性。

前若干个状态的影响。具有马尔可夫性质的随机过程称为马

尔可夫过程。

9

上海第二工业大学冯涛编写

17:18:25

3、谈谈一些基本概念 概率分布 概率论的基本概念之一,用以表述随机变量取值的概率 规律。 必然与随机 人们会观察到各种各样的现象,大体上分为两大类:一 类是可预言其结果的,即在保持条件不变的情况下,重复进 行试验,其结果总是确定的,必然发生(或必然不发生)。 例如:在标准大气压下,水加热到100℃必然沸腾等。这类现 象称为必然现象或确定性现象。另一类是事前不可预言其结 果的,即在保持条件不变的情况下,重复进行试验,其结果 未必相同(随机)。例如:掷一枚质地均匀对称的硬币,其 结果可能是出现正面,也可能出现反面,事前不可能断言其 结果。这类在个别试验中其结果呈现偶然性、不确定性现象, 称为随机现象或不确定性现象。

3

信源种类

举例 文字、数据、 离散化图像

数学描述 离散随机变量序列, 可列可数

离散信源 离散 (数字信源) 连续 连续信号

跳远比赛的结果、 连续随机变量序列, 语音信号抽样以后 可列可数 语音、音乐、热噪 一般用函数来表示, 声、图形、图像 可求导 不常见

波形信源 连续 (模拟信源) 离散

4

上海第二工业大学冯涛编写

17:18:25

实际信源分类

离散无记忆信源:H ( X) NH ( X) 记忆长度无限长: H 离散平稳信源 离散有记忆信源 平稳信源 记忆长度有限(马尔可夫信源): H m 1 连续平稳信源 非平稳信源

上海第二工业大学冯涛编写

17:18:25

分类2:根据各维随机变量的概率分布所对应的随机序列的 平稳性,即:是否随时间的推移而变化分: (1)平稳信源 (2)非平稳信源 分类3:根据随机变量间所对应的随机序列中随机变量前后 之间有无统计依赖关系,即:是否统计独立分: (1)有记忆信源 (2)无记忆信源 信源是产生消息(符号)、消息序列和连续消息的来源。 从数学上,由于消息的不确定性,因此,信源是产生随机变 量、随机序列和随机过程的源。 信源的基本特性是具有随机不确定性。

前若干个状态的影响。具有马尔可夫性质的随机过程称为马

尔可夫过程。

9

上海第二工业大学冯涛编写

17:18:25

3、谈谈一些基本概念 概率分布 概率论的基本概念之一,用以表述随机变量取值的概率 规律。 必然与随机 人们会观察到各种各样的现象,大体上分为两大类:一 类是可预言其结果的,即在保持条件不变的情况下,重复进 行试验,其结果总是确定的,必然发生(或必然不发生)。 例如:在标准大气压下,水加热到100℃必然沸腾等。这类现 象称为必然现象或确定性现象。另一类是事前不可预言其结 果的,即在保持条件不变的情况下,重复进行试验,其结果 未必相同(随机)。例如:掷一枚质地均匀对称的硬币,其 结果可能是出现正面,也可能出现反面,事前不可能断言其 结果。这类在个别试验中其结果呈现偶然性、不确定性现象, 称为随机现象或不确定性现象。

2信源熵

各种单位相互之间可以换算: 1奈特=1.433比特 1哈特=3.322比特

哈特的单位相对较大,适合用在信息量 较大的场合。

• 以e为底的自然对数形式经常用在公式推 导过程中,在信息论的一些证明过程中, log 2 x 写成 ln x log 2 e 经常要把 的形式,然后再利用不等式 ln x x 1 得出结果。

第二章 信源熵

• 本章讲述信息度量问题,建立信息论重要 的一步就是要确定一种度量信息的方法, 只有把信息量表达为数字,并在此基础上 用相应的数学工具进行研究,信息论才能 成为一门科学。 • 香农信息论采用统计度量的方法,认为事 件所含的信息量由它发生的概率决定,概 率大的所含信息量就小,概率小的所含信 息量就大。

解概率题的关键:把已知条件和待求问题 表示清楚。

信源熵

• 单符号离散信源的数学模型

x2 ... xi ... xn X x1 P( X ) P( x ) P( x ) ... P( x ) ... P( x ) 1 2 i n

其中

0 P xi 1

若

f x1 1 x2 f ( x1) 1 f ( x2 )

则称函数f(x)为上凸函数,上凸函数的 极值一定是极大值。

熵函数H(P)是严格上凸函数。

熵函数H(X)的自变量是概率分布,假设 P和Q是X的两种不同分布,那么H(X)的 上凸性是指:

• 极值性 两个符号数目相同的信源,X和Y,用X 的概率分布对Y的自信息加权求和,必大 于X本身的熵。

P xi log2 P yi H ( X )

i 1

n

最大离散熵定理是它的特例,当Y是均 匀分布时,即可得到。

• 递增性 若原信源中某一个符号划分成m个符号, 这m个符号概率之和等于原来那个符号 的概率,则由于符号个数增多而产生新 的不确定性,新信源的熵增加。

哈特的单位相对较大,适合用在信息量 较大的场合。

• 以e为底的自然对数形式经常用在公式推 导过程中,在信息论的一些证明过程中, log 2 x 写成 ln x log 2 e 经常要把 的形式,然后再利用不等式 ln x x 1 得出结果。

第二章 信源熵

• 本章讲述信息度量问题,建立信息论重要 的一步就是要确定一种度量信息的方法, 只有把信息量表达为数字,并在此基础上 用相应的数学工具进行研究,信息论才能 成为一门科学。 • 香农信息论采用统计度量的方法,认为事 件所含的信息量由它发生的概率决定,概 率大的所含信息量就小,概率小的所含信 息量就大。

解概率题的关键:把已知条件和待求问题 表示清楚。

信源熵

• 单符号离散信源的数学模型

x2 ... xi ... xn X x1 P( X ) P( x ) P( x ) ... P( x ) ... P( x ) 1 2 i n

其中

0 P xi 1

若

f x1 1 x2 f ( x1) 1 f ( x2 )

则称函数f(x)为上凸函数,上凸函数的 极值一定是极大值。

熵函数H(P)是严格上凸函数。

熵函数H(X)的自变量是概率分布,假设 P和Q是X的两种不同分布,那么H(X)的 上凸性是指:

• 极值性 两个符号数目相同的信源,X和Y,用X 的概率分布对Y的自信息加权求和,必大 于X本身的熵。

P xi log2 P yi H ( X )

i 1

n

最大离散熵定理是它的特例,当Y是均 匀分布时,即可得到。

• 递增性 若原信源中某一个符号划分成m个符号, 这m个符号概率之和等于原来那个符号 的概率,则由于符号个数增多而产生新 的不确定性,新信源的熵增加。

第2章 信源熵

2 2

最大熵值随平均功率 P的变化而变化。

2

1 1 1 log 2 2 log e log 2e 2 2 2 2

11

均值受限条件下的最大熵定理

定理3:若连续信源X输出非负信号的均值受限,则其 输出信号幅度呈指数分布时,连续信源X具有最大熵值。

证明:连续信源 X呈指数分布时的概率密 度函数为 1 m p( x ) e ( x 0 ),其它任意分布的概率密 度函数记为q( x ) m 由限制条件知:

... q( x) log

aN a1 N

bN

b1

p ( x) dx ... dx log e ... q ( x ) 1 dx1...dxN 1 N N aN a1 q ( x ) (bi ai ) 1

bN b1 i 1

log (bi ai ) (1 1) log e H c [ p ( x), X ]

R2 R2 R2

p( x ) dxdy p( x / y )

log x log e ln x, ln x x 1, x 0; p( x ) 0, p( x / y ) 0, 则x p( x ) I c ( X ;Y ) log e p( xy ) 1dxdy p( x / y ) R2 log e[ p( x ) p( y )dxdy p( xy )dxdy] 0

当( b a ) 1时,H c ( x ) 0, 为负值

这是由连续熵的相对性所致。

1

2.3.3 连续熵的性质及最大连续熵定理

2.可加性

H c ( XY ) H c ( X ) H c ( Y / X ) Hc( Y ) Hc( X / Y ) 证明: H c ( XY ) p( xy) log p( xy)dxdy

最大熵值随平均功率 P的变化而变化。

2

1 1 1 log 2 2 log e log 2e 2 2 2 2

11

均值受限条件下的最大熵定理

定理3:若连续信源X输出非负信号的均值受限,则其 输出信号幅度呈指数分布时,连续信源X具有最大熵值。

证明:连续信源 X呈指数分布时的概率密 度函数为 1 m p( x ) e ( x 0 ),其它任意分布的概率密 度函数记为q( x ) m 由限制条件知:

... q( x) log

aN a1 N

bN

b1

p ( x) dx ... dx log e ... q ( x ) 1 dx1...dxN 1 N N aN a1 q ( x ) (bi ai ) 1

bN b1 i 1

log (bi ai ) (1 1) log e H c [ p ( x), X ]

R2 R2 R2

p( x ) dxdy p( x / y )

log x log e ln x, ln x x 1, x 0; p( x ) 0, p( x / y ) 0, 则x p( x ) I c ( X ;Y ) log e p( xy ) 1dxdy p( x / y ) R2 log e[ p( x ) p( y )dxdy p( xy )dxdy] 0

当( b a ) 1时,H c ( x ) 0, 为负值

这是由连续熵的相对性所致。

1

2.3.3 连续熵的性质及最大连续熵定理

2.可加性

H c ( XY ) H c ( X ) H c ( Y / X ) Hc( Y ) Hc( X / Y ) 证明: H c ( XY ) p( xy) log p( xy)dxdy

第二章 信源熵

英文字母中“e”出现的概率为0.105,“c” 出现的概率为0.023,“o”出现的概率为 0.001,分别计算他们的自信息量。 答:I(e)=-logP(e)=-log0.105=3.25bit I(c)=-logP(c)=-log0.023=5.44bit I(o)=-logP(o)=-log0.001=9.97bit

H ( X | y j ) p( xi | y j )I ( xi | y j )

i

给定集合Y条件下,集合X的条件熵H(X|Y) 为: H ( X | Y ) p( y ) H ( X | y )

j

j

= p( y j ) p( xi | y j )I ( xi | y j )

I ( xi ) I ( y j )

性质:

非负值 当事件相互独立时,联合自信息量为各自信息量之 和

三 条件自信息

1 定义:条件概率对数的负数。 2 事件Xi以时间Yj发生为条件,其条件密度为 P(Xi|Yj),则其条件自信息量为 I(Xi|Yj)=-logP(Xi|Yj)。 3 性质:非负值

i 1 4

⑤

数学性质分析: 以二元信号源为例。信源分别以概率p,q输 出符号“0”,“1”,p+q=1。信源的概率空 间为: X 0 1 P p q

H ( X ) p( xi ) log p( xi ) p log p q log q

X a1 P p 1 a2 p2 ... ... aq pn

信息量:信息的定量表示 信源熵:

物理熵:无序程度的度量,描述系统特征,如 热力学熵。 信息熵:随机事件的不确定度,描述系统的统 计特征。 信源熵:信源发出消息的不确定度。

第二章信源及信源熵

为m阶马尔可夫信源:

p( xi | xi 2 xi 1 xi 1 xi 2 xi m x1 ) p( xi | xi 1 xi 2 xi m ) (i 1, 2, , N )

用概率空间来描述离散信源:

一个离散信源的数学模型就是离散型的概率空间:

X与Y相互独立,无法从Y中提取关于X的 信息。也可以看成信道噪声相当大,以至有

H(X/Y)=H(X) 。在这种情况下,能够传输的

平均信息量为0。称为全损离散信道。

一般情况下,X和Y既非互相独立,也不是一一对

应,那么从Y获得的X信息必在零与H(X)之间,即

常小于X的熵。

0 I ( X ;Y ) H ( X )

当 xi 和 y j 相互独立时,有 p( xi y j ) p( xi ) p( y j ) 于是有 I ( xi y j ) I ( xi ) I ( y j )

条件自信息量:当 xi 和 y j 相互联系时,在事件 y j 出现的条件下,xi 的自信息量称为条件自信息 量,定义为 :

j

/ xi )

H (Y / X ) p( xi ) p( y j | xi ) log p( y j | xi )

j 1 i 1 n

m

n

p( xi y j ) log p( y j | xi )

j 1 i 1

m

H ( X | Y ) - p ( xy ) log p ( x | y )

(2)当事件xi发生以后,表示事件xi所提供的信息量。

一点说明

自信息量的单位取决于对数的底;

底为2,单位为“比特(bit, binary unit)”; 底为e,单位为“奈特(nat, nature unit)”; 底为10,单位为“哈特(hat, Hartley)”或“det”; 根据换底公式得:

p( xi | xi 2 xi 1 xi 1 xi 2 xi m x1 ) p( xi | xi 1 xi 2 xi m ) (i 1, 2, , N )

用概率空间来描述离散信源:

一个离散信源的数学模型就是离散型的概率空间:

X与Y相互独立,无法从Y中提取关于X的 信息。也可以看成信道噪声相当大,以至有

H(X/Y)=H(X) 。在这种情况下,能够传输的

平均信息量为0。称为全损离散信道。

一般情况下,X和Y既非互相独立,也不是一一对

应,那么从Y获得的X信息必在零与H(X)之间,即

常小于X的熵。

0 I ( X ;Y ) H ( X )

当 xi 和 y j 相互独立时,有 p( xi y j ) p( xi ) p( y j ) 于是有 I ( xi y j ) I ( xi ) I ( y j )

条件自信息量:当 xi 和 y j 相互联系时,在事件 y j 出现的条件下,xi 的自信息量称为条件自信息 量,定义为 :

j

/ xi )

H (Y / X ) p( xi ) p( y j | xi ) log p( y j | xi )

j 1 i 1 n

m

n

p( xi y j ) log p( y j | xi )

j 1 i 1

m

H ( X | Y ) - p ( xy ) log p ( x | y )

(2)当事件xi发生以后,表示事件xi所提供的信息量。

一点说明

自信息量的单位取决于对数的底;

底为2,单位为“比特(bit, binary unit)”; 底为e,单位为“奈特(nat, nature unit)”; 底为10,单位为“哈特(hat, Hartley)”或“det”; 根据换底公式得:

信源熵

I ( xi ) I ( xi | y j ) 信宿收到 y j 前对消息 xi 的先验不确定度 信宿收到 y j 后对消息 xi 的后验不确定度

I ( xi ) I ( xi | y j ) 信宿收到 y j 后不确定度被消除的部分, 它是 y j 所获得的关于 xi 的部分信息量

互信息 先验不确定度 后验不确定度

信源的分类

信源输出以符号形式出现的具体消息,其分类如下: 按发送消息的时间和取值空间的分布 离散信源 单符号离散信源 连续信源 信源发出的 按发出符号之间的关系 消息是离散的、 无记忆信源 有限的或无限可 列的符号,且一 有记忆信源 个符号代表一条 按发送一条消息所需要的符号数 完整的消息 单个符号信源 符号序列信源

13

互信息量(续)

在输出端考查不确定度的变化

I ( xi ; y j ) I ( xi ) I ( xi | y j ) log p( xi ) log p( xi | y j )

log p( xi | y j ) p( xi )

后验概率 先验概率

在输入端考查不确定度的变化

后验不确定度 I ( xi y j ) log p( xi y j )

I ( xi ; y j ) I ( x i ) I ( y j ) I ( x i y j ) log[ p( xi ) p( y j )] log p( xi y j ) log

p( x i y j ) p( x i ) p( y j )

先验不确定度 I 先 ( xi y j ) log p( xi y j ) I ( xi ) I ( y j )

通信后,X 与 Y 之间由于信道的统计约束,存在关联关系 后验概率 p( xi y j ) p( xi ) p( y j | xi ) p( y j ) p( xi | y j )

I ( xi ) I ( xi | y j ) 信宿收到 y j 后不确定度被消除的部分, 它是 y j 所获得的关于 xi 的部分信息量

互信息 先验不确定度 后验不确定度

信源的分类

信源输出以符号形式出现的具体消息,其分类如下: 按发送消息的时间和取值空间的分布 离散信源 单符号离散信源 连续信源 信源发出的 按发出符号之间的关系 消息是离散的、 无记忆信源 有限的或无限可 列的符号,且一 有记忆信源 个符号代表一条 按发送一条消息所需要的符号数 完整的消息 单个符号信源 符号序列信源

13

互信息量(续)

在输出端考查不确定度的变化

I ( xi ; y j ) I ( xi ) I ( xi | y j ) log p( xi ) log p( xi | y j )

log p( xi | y j ) p( xi )

后验概率 先验概率

在输入端考查不确定度的变化

后验不确定度 I ( xi y j ) log p( xi y j )

I ( xi ; y j ) I ( x i ) I ( y j ) I ( x i y j ) log[ p( xi ) p( y j )] log p( xi y j ) log

p( x i y j ) p( x i ) p( y j )

先验不确定度 I 先 ( xi y j ) log p( xi y j ) I ( xi ) I ( y j )

通信后,X 与 Y 之间由于信道的统计约束,存在关联关系 后验概率 p( xi y j ) p( xi ) p( y j | xi ) p( y j ) p( xi | y j )

第2章 信源及其熵

熵的含义

熵----考虑的是整个集合的统计特性,它从平均意义上来 表征信源的总体特征。 在信源输出前,信息熵H(X) 表示信源的平均不确定性; 在信源输出后,信息熵H(X)表示每个消息提供的平均信 息量; 信息熵H(X) 表征了变量X的随机特性。 例如,有两信源X、Y,其概率空间分别为:

例如,语音信号{X(t)} 、热噪声信号{n(t)}

离散无记忆平稳信源

离散平稳信源的特例,信源发出的符号都相互统计独 立,即各随机变量Xi (i=1,2,…,N)之间统计独立 性质:

独立->p (X )= p (X1, X2, …,XN)= p1(X1) · 2(X2)· · N(XN) p ·p

问题:这样的信源能输出多少信息? 每个消息的出现携带多少信息量?

信息的测度

考虑:

信息的测度(信息量)和不确定性消除的程度有关, 消除的不确定性=获得的信息量; 不确定性就是随机性,可以用概率论和随机过程来测 度,概率小->不确定性大; 概率小 ->信息量大,即信息量是概率的单调递减函 数; 信息量应该具有可加性; 用香农信息量公式来计算。

(1)它应是先验概率p(ai)的单调递减函数,即当 p (a1) > p (a2) 时,有 f [ p (a1)] < f [ p (a2) ] ; (2)当p (ai) =1时, f [ p (ai)] = 0 (3)当p (ai) =0时, f [ p (ai)] = (4)两个独立事件的联合信息量应等于它们分别的信息量之 和,即统计独立信源的信息量等于它们分别的信息量之和。

描述的信源X的各输出Xi间统计独立、且取值同一 例如:A={1,2,3},N=2。则XN为: 符号集A,则X为离散无记忆信源,称该信源输出 {11,12,13,21,22,23,31,32,33 } 的N维随机矢量X 为离散无记忆信源X的N次扩展 信源

相关主题

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

相关知识复习

古典概率复习

事件运算的性质

设 A, B, C 为事件, 则有

1o 交换律

A B B A, AB BA.

( AB)C A( BC ).

2o 结合律 ( A B ) C A ( B C ),

3 分配律 ( A B ) C ( A C ) ( B C ) AC BC , ( A B ) C ( A C ) ( B C ) ( A C )( B C ).

(2)说明

1 pk 0, k 1,2,;

0

20

pk 1; k 1

x1 X ~ p1 x2 xn p2 pn

30 离散型随机变量的分布 律也可表为

X

pk

x1 p1

x2 xn p2 pn

两点分布

设随机变量 X 只可能取0与1两个值 , 它的分 布律为

20 规范性 : 对于必ቤተ መጻሕፍቲ ባይዱ事件 S , 有 P ( S ) 1;

30 可列可加性 : 设 A1 , A2 ,是两两互不相容的 事件,即对于i j , Ai A j , i , j 1,2,, 则有 P ( A1 A2 ) P ( A1 ) P ( A2 )

o

4o 德 摩根律 : A B A B, A B A B.

概率的定义

设 E 是随机试验, S 是它的样本空间. 对于 E的 每一事件 A 赋予一个实数, 记为 P ( A) , 称为事件 A 的概率, 如果集合函数 P ( ) 满足下列条件: 10 非负性 : 对于每一个事件 A, 有 P ( A) 0;

泊松分布

设随机变量所有可能取 的值为0,1,2,, 而取 各个值的概率为

k e P{ X k } , k 0,1,2,, k! 其中 0 是常数.则称 X 服从参数为 的泊松分 布, 记为 X ~ π( ).

随机变量的分布函数

(1)定义

设 X 是一个随机变量 x 是任意实数,函数 , F ( x ) P{ X x } 称为 X 的分布函数.

(3)三事件相互独立

设 A, B , C 是三个事件, 如果满足等式 P ( AB ) P ( A) P ( B ), P ( BC ) P ( B ) P (C ), P ( AC ) P ( A) P (C ), P ( ABC ) P ( A) P ( B ) P (C ), 则称事件 A, B , C 相互独立 . 注意

5 0 可加可列性 : 设 B1 , B2 ,是两两不相容的事件 , 则有

P Bi A P ( Bi A). i 1 i 1

乘法定理

设 P ( A) 0, 则有 P ( AB) P ( B A) P ( A).

设 A, B, C 为事件, 且 P ( AB) 0, 则有

则称 A1 , A2 ,, An 为相互独立的事件 .

n 个事件相互独立

n个事件两两相互独立

重要定理及结论

定理一

设 A, B 是两事件, 且 P ( A) 0.若 A, B相互独 立, 则 P ( B A) P ( B ). 反之亦然.

定理二

若 A, B 是相互独立的两个事件 则下列各对 , 事件, A 与 B, A 与 B , A 与 B 也相互独立.

全概率公式与贝叶斯公式

样本空间的划分 定义 设 S 为试验E的样本空间, B1 , B2 ,, Bn

为 E 的一组事件, 若 Bi B j , i , j 1,2,, n; 10 B1 B2 Bn S . 20 则称 B1 , B2 ,, Bn 为样本空间 S 的一个划分.

x

x

40 lim F ( x ) F ( x0 ), ( x0 );

x x0

即任一分布函数处处右连续.

(4)重要公式

P{a X b} F (b) F (a ),

P{ X a } 1 F (a ).

离散型随机变量的分布函数

F ( x ) P{ X x }

(2) 条件概率的性质

10 非负性 : P ( B A) 0; 20 规范性 : P ( S B ) 1, P ( B ) 0; 30 P ( A1 A2 B) P ( A1 B) P ( A2 B) P ( A1 A2 B);

4 0 P ( A B ) 1 P ( A B );

三个事件相互独立 三个事件两两相互独立

推广 设 A1 , A2 ,, An 是 n 个事件, 如果对于任 意 k (1 k n) , 任意1 i1 i 2 i k n , 具 有等式

P ( Ai1 Ai2 Aik ) P ( Ai1 ) P ( Ai2 ) P ( Aik ),

X pk

0 1 p

1 p

则称 X 服从(0-1)分布或两点分布.

二项分布

X 的分布律为

X pk

0 q

n

n n 1 n k n k p q pq 1 k ( k 0,1,2,, n, 0 p 1)

1

k

n p

n

称这样的分布为二项分布.记为 X ~ b( n, p). n1 两点分布 二项分布

(1)随机变量与普通的函数不同 随机变量是一个函数 ,但它与普通的函数有着 本质的差别 ,普通函数是定义在实数轴上的,而随机 变量是定义在样本空间上的 (样本空间的元素不一 定是实数).

(2)随机变量的取值具有一定的概率规律 随机变量随着试验的结果不同而取不同的值, 由于试验的各个结果的出现具有一定的概率,因此 随机变量的取值也有一定的概率规律. (3)随机变量与随机事件的关系 随机事件包容在随机变量这个范围更广的概 念之内.或者说 : 随机事件是从静态的观点来研究 随机现象,而随机变量则是从动态的观点来研究随 机现象.

i 1

P ( Ai Aj ) 1 i j n

1 i j k n

P ( Ai Aj Ak ) ( 1)n1 P ( A1 A2 An ).

条件概率

(1) 条件概率的定义

设 A, B 是两个事件, 且 P ( A) 0, 称 P ( AB ) P ( B A) P ( A) 为在事件 A 发生的条件下事件B 发生的条件概率. P ( AB) P( A B) , 同理可得 P( B) 为在事件 B 发生的条件下事件 A 发生的条件概率.

(2)三事件两两相互独立

设 A, B , C 是三个事件, 如果满足等式 P ( AB ) P ( A) P ( B ), P ( BC ) P ( B ) P (C ), P ( AC ) P ( A) P (C ), 则称事件 A, B , C 两两相互独立 .

x pk . x

i

连续型随机变量的概率密度

40 对于任一事件 A, P ( A) 1.

50 设 A 是 A 的对立事件, 则 P ( A) 1 P( A).

60 (加法公式) 对于任意两事件 A, B 有 P ( A B ) P ( A) P ( B ) P ( AB).

n 个事件和的情况

n

P ( A1 A2 An ) P ( Ai )

随机变量及分布复习

密 度 函 数 连 续 型 随机变量 均 匀 分 布 指 数 分 布 正 态 分 布 分 布 函 数

分 布 律

离 散 型 随机变量

随 机 变 量

随机变量 的函数的 分 布

定

义

两 点 分 布

二 项 分 布

泊 松 分 布

随机变量

定义 设 E 是随机试验, 它的样本空间是S {e }.如 果对于每一个e S , 有一个实数 X (e ) 与之对应, 这 样就得到一个定义在 上的单值实值函数 X (e ), 称 S 随机变量.

P ( ABC ) P (C AB ) P ( B A) P ( A).

推广 设 A1 , A2 ,, An 为 n 个事件, n 2,

且 P ( A1 A2 An1 ) 0, 则有

P ( A1 A2 An ) P ( An A1 A2 An1 ) P ( An1 A1 A2 An 2 ) P ( A2 A1 ) P ( A1 ).

(2)说明 分布函数主要研究随机变量在某一区间内取 值的概率情况.

分布函数 F ( x ) 是 x 的一个普通实函数 .

(3)性质

10 0 F ( x ) 1, (, );

2 F ( x1 ) F ( x2 ), ( x1 x2 );

0

3 0 F ( ) lim F ( x ) 0, F ( ) lim F ( x ) 1;

P( A B j )P(B j ) j 1

n

称此为贝叶斯公式.

事件的相互独立性

(1)两事件相互独立

设 A, B 是两事件 , 如果满足等式 P ( AB ) P ( A) P ( B ). 则称事件 A, B 相互独立, 简称 A, B 独立.

说明 事件 A 与 B 相互独立是指事件 A 的概率与事 件 B 是否出现无关.

B2

B3

B1

Bn1 Bn

S

全概率公式

定理 设试验E的样本空间为S , A为 E 的事件, B1 , B2 ,, Bn为S的一个划分, 且P ( Bi ) 0( i 1, 2,, n), 则 P ( A) P ( A B1 ) P ( B1 ) P ( A B2 ) P ( B2 ) P ( A Bn ) P ( Bn ) 称为全概率公式 .

古典概率复习

事件运算的性质

设 A, B, C 为事件, 则有

1o 交换律

A B B A, AB BA.

( AB)C A( BC ).

2o 结合律 ( A B ) C A ( B C ),

3 分配律 ( A B ) C ( A C ) ( B C ) AC BC , ( A B ) C ( A C ) ( B C ) ( A C )( B C ).

(2)说明

1 pk 0, k 1,2,;

0

20

pk 1; k 1

x1 X ~ p1 x2 xn p2 pn

30 离散型随机变量的分布 律也可表为

X

pk

x1 p1

x2 xn p2 pn

两点分布

设随机变量 X 只可能取0与1两个值 , 它的分 布律为

20 规范性 : 对于必ቤተ መጻሕፍቲ ባይዱ事件 S , 有 P ( S ) 1;

30 可列可加性 : 设 A1 , A2 ,是两两互不相容的 事件,即对于i j , Ai A j , i , j 1,2,, 则有 P ( A1 A2 ) P ( A1 ) P ( A2 )

o

4o 德 摩根律 : A B A B, A B A B.

概率的定义

设 E 是随机试验, S 是它的样本空间. 对于 E的 每一事件 A 赋予一个实数, 记为 P ( A) , 称为事件 A 的概率, 如果集合函数 P ( ) 满足下列条件: 10 非负性 : 对于每一个事件 A, 有 P ( A) 0;

泊松分布

设随机变量所有可能取 的值为0,1,2,, 而取 各个值的概率为

k e P{ X k } , k 0,1,2,, k! 其中 0 是常数.则称 X 服从参数为 的泊松分 布, 记为 X ~ π( ).

随机变量的分布函数

(1)定义

设 X 是一个随机变量 x 是任意实数,函数 , F ( x ) P{ X x } 称为 X 的分布函数.

(3)三事件相互独立

设 A, B , C 是三个事件, 如果满足等式 P ( AB ) P ( A) P ( B ), P ( BC ) P ( B ) P (C ), P ( AC ) P ( A) P (C ), P ( ABC ) P ( A) P ( B ) P (C ), 则称事件 A, B , C 相互独立 . 注意

5 0 可加可列性 : 设 B1 , B2 ,是两两不相容的事件 , 则有

P Bi A P ( Bi A). i 1 i 1

乘法定理

设 P ( A) 0, 则有 P ( AB) P ( B A) P ( A).

设 A, B, C 为事件, 且 P ( AB) 0, 则有

则称 A1 , A2 ,, An 为相互独立的事件 .

n 个事件相互独立

n个事件两两相互独立

重要定理及结论

定理一

设 A, B 是两事件, 且 P ( A) 0.若 A, B相互独 立, 则 P ( B A) P ( B ). 反之亦然.

定理二

若 A, B 是相互独立的两个事件 则下列各对 , 事件, A 与 B, A 与 B , A 与 B 也相互独立.

全概率公式与贝叶斯公式

样本空间的划分 定义 设 S 为试验E的样本空间, B1 , B2 ,, Bn

为 E 的一组事件, 若 Bi B j , i , j 1,2,, n; 10 B1 B2 Bn S . 20 则称 B1 , B2 ,, Bn 为样本空间 S 的一个划分.

x

x

40 lim F ( x ) F ( x0 ), ( x0 );

x x0

即任一分布函数处处右连续.

(4)重要公式

P{a X b} F (b) F (a ),

P{ X a } 1 F (a ).

离散型随机变量的分布函数

F ( x ) P{ X x }

(2) 条件概率的性质

10 非负性 : P ( B A) 0; 20 规范性 : P ( S B ) 1, P ( B ) 0; 30 P ( A1 A2 B) P ( A1 B) P ( A2 B) P ( A1 A2 B);

4 0 P ( A B ) 1 P ( A B );

三个事件相互独立 三个事件两两相互独立

推广 设 A1 , A2 ,, An 是 n 个事件, 如果对于任 意 k (1 k n) , 任意1 i1 i 2 i k n , 具 有等式

P ( Ai1 Ai2 Aik ) P ( Ai1 ) P ( Ai2 ) P ( Aik ),

X pk

0 1 p

1 p

则称 X 服从(0-1)分布或两点分布.

二项分布

X 的分布律为

X pk

0 q

n

n n 1 n k n k p q pq 1 k ( k 0,1,2,, n, 0 p 1)

1

k

n p

n

称这样的分布为二项分布.记为 X ~ b( n, p). n1 两点分布 二项分布

(1)随机变量与普通的函数不同 随机变量是一个函数 ,但它与普通的函数有着 本质的差别 ,普通函数是定义在实数轴上的,而随机 变量是定义在样本空间上的 (样本空间的元素不一 定是实数).

(2)随机变量的取值具有一定的概率规律 随机变量随着试验的结果不同而取不同的值, 由于试验的各个结果的出现具有一定的概率,因此 随机变量的取值也有一定的概率规律. (3)随机变量与随机事件的关系 随机事件包容在随机变量这个范围更广的概 念之内.或者说 : 随机事件是从静态的观点来研究 随机现象,而随机变量则是从动态的观点来研究随 机现象.

i 1

P ( Ai Aj ) 1 i j n

1 i j k n

P ( Ai Aj Ak ) ( 1)n1 P ( A1 A2 An ).

条件概率

(1) 条件概率的定义

设 A, B 是两个事件, 且 P ( A) 0, 称 P ( AB ) P ( B A) P ( A) 为在事件 A 发生的条件下事件B 发生的条件概率. P ( AB) P( A B) , 同理可得 P( B) 为在事件 B 发生的条件下事件 A 发生的条件概率.

(2)三事件两两相互独立

设 A, B , C 是三个事件, 如果满足等式 P ( AB ) P ( A) P ( B ), P ( BC ) P ( B ) P (C ), P ( AC ) P ( A) P (C ), 则称事件 A, B , C 两两相互独立 .

x pk . x

i

连续型随机变量的概率密度

40 对于任一事件 A, P ( A) 1.

50 设 A 是 A 的对立事件, 则 P ( A) 1 P( A).

60 (加法公式) 对于任意两事件 A, B 有 P ( A B ) P ( A) P ( B ) P ( AB).

n 个事件和的情况

n

P ( A1 A2 An ) P ( Ai )

随机变量及分布复习

密 度 函 数 连 续 型 随机变量 均 匀 分 布 指 数 分 布 正 态 分 布 分 布 函 数

分 布 律

离 散 型 随机变量

随 机 变 量

随机变量 的函数的 分 布

定

义

两 点 分 布

二 项 分 布

泊 松 分 布

随机变量

定义 设 E 是随机试验, 它的样本空间是S {e }.如 果对于每一个e S , 有一个实数 X (e ) 与之对应, 这 样就得到一个定义在 上的单值实值函数 X (e ), 称 S 随机变量.

P ( ABC ) P (C AB ) P ( B A) P ( A).

推广 设 A1 , A2 ,, An 为 n 个事件, n 2,

且 P ( A1 A2 An1 ) 0, 则有

P ( A1 A2 An ) P ( An A1 A2 An1 ) P ( An1 A1 A2 An 2 ) P ( A2 A1 ) P ( A1 ).

(2)说明 分布函数主要研究随机变量在某一区间内取 值的概率情况.

分布函数 F ( x ) 是 x 的一个普通实函数 .

(3)性质

10 0 F ( x ) 1, (, );

2 F ( x1 ) F ( x2 ), ( x1 x2 );

0

3 0 F ( ) lim F ( x ) 0, F ( ) lim F ( x ) 1;

P( A B j )P(B j ) j 1

n

称此为贝叶斯公式.

事件的相互独立性

(1)两事件相互独立

设 A, B 是两事件 , 如果满足等式 P ( AB ) P ( A) P ( B ). 则称事件 A, B 相互独立, 简称 A, B 独立.

说明 事件 A 与 B 相互独立是指事件 A 的概率与事 件 B 是否出现无关.

B2

B3

B1

Bn1 Bn

S

全概率公式

定理 设试验E的样本空间为S , A为 E 的事件, B1 , B2 ,, Bn为S的一个划分, 且P ( Bi ) 0( i 1, 2,, n), 则 P ( A) P ( A B1 ) P ( B1 ) P ( A B2 ) P ( B2 ) P ( A Bn ) P ( Bn ) 称为全概率公式 .