项目4 MapReduce分布式计算框架-任务4.3 MapReduce编程组件1

简述mapreduce的运行流程

简述mapreduce的运行流程MapReduce是一种用于在大规模数据集上并行计算的模型,它由Google 公司提出并应用于分布式计算领域。

MapReduce的核心思想是将计算任务拆分为多个阶段,并在多台计算机上进行并行计算,从而提高计算效率。

本文将从MapReduce的基本概念开始,逐步解释其运行流程。

一、MapReduce概述MapReduce模型将计算任务分为两个阶段:Map(映射)和Reduce(归约)。

Map阶段将输入数据集划分为多个子集,并为每个子集生成一组键-值对。

Reduce阶段将相同键的键-值对进行归约操作,生成最终结果。

在MapReduce中,计算任务的执行由一个主节点(称为JobTracker)和多个工作节点(称为TaskTracker)协同完成。

二、任务提交阶段1.生成任务:用户向计算集群提交一个MapReduce任务,并指定输入数据集的路径、Map函数、Reduce函数等信息。

提交任务后,JobTracker 为该任务生成一个唯一的任务ID,并将任务添加到待处理任务列表中。

2.任务划分:JobTracker根据输入数据的大小和计算资源的可用情况,将任务划分为若干个MapTask和ReduceTask,并将它们分配给相应的TaskTracker进行处理。

3.任务分配:JobTracker根据与各个TaskTracker之间的网络延迟和负载情况等因素,将MapTask和ReduceTask分配给合适的TaskTracker。

任务分配过程相对复杂,需要考虑多个因素,以实现负载均衡和最大化计算资源的利用率。

三、Map阶段1.数据划分:每个Map任务在启动时,首先从数据源中读取输入数据集。

输入数据集通常被划分为多个等大小的数据块,每个数据块由单独的Map 任务处理。

2.Map函数执行:每个Map任务将输入数据块作为输入,并根据用户定义的Map函数对数据进行处理。

Map函数将输入数据转换为一组键-值对,并将它们输出到本地磁盘上的临时输出文件中。

mapreduce基础编程

mapreduce基础编程MapReduce是一种用于大规模数据处理的编程模型和软件框架。

它可以将大数据集分成多个小数据集,并通过多个计算节点并行处理,最后汇总处理结果。

MapReduce将数据处理过程分成两个阶段:Map阶段和Reduce阶段。

在Map阶段中,数据被分成多个小数据集,每个小数据集上运行相同的计算任务,然后产生中间结果。

在Reduce阶段中,中间结果被合并,最终产生处理结果。

MapReduce的基础编程模型可以分为以下几个步骤:1. 输入数据的读取:输入数据可以来自于Hadoop Distributed File System (HDFS)、本地文件系统或其他数据源。

2. Map阶段的编写:开发者需要编写Map函数,该函数将输入数据切分成多个小数据集,并在每个小数据集上运行相同的计算任务,生成中间结果。

Map函数的输出通常是一个键值对(key-value pair),其中键表示中间结果的类型,值表示中间结果的值。

3. Reduce阶段的编写:开发者需要编写Reduce函数,该函数将中间结果根据键值进行合并,生成最终的处理结果。

Reduce函数的输出通常是一个键值对(key-value pair),其中键表示最终处理结果的类型,值表示最终处理结果的值。

4. 输出数据的写入:最终处理结果可以写入到HDFS或其他数据源中。

MapReduce程序的开发需要掌握Java或其他编程语言。

除了基础编程模型外,还需要了解MapReduce的一些高级编程技术,如Combiner、Partitioner、InputFormat、OutputFormat等。

通过这些技术,可以进一步提高MapReduce程序的性能和可扩展性。

总之,MapReduce是一种强大的大数据处理工具,掌握基础编程模型是进行大数据分析和处理的必要条件。

第4章大数据技术教程-MapReduce

第四章分布式计算框架MapReduce4.1初识MapReduceMapReduce是一种面向大规模数据并行处理的编程模型,也一种并行分布式计算框架。

在Hadoop流行之前,分布式框架虽然也有,但是实现比较复杂,基本都是大公司的专利,小公司没有能力和人力来实现分布式系统的开发。

Hadoop的出现,使用MapReduce框架让分布式编程变得简单。

如名称所示,MapReduce主要由两个处理阶段:Map阶段和Reduce 阶段,每个阶段都以键值对作为输入和输出,键值对类型可由用户定义。

程序员只需要实现Map和Reduce两个函数,便可实现分布式计算,而其余的部分,如分布式实现、资源协调、内部通信等,都是由平台底层实现,无需开发者关心。

基于Hadoop开发项目相对简单,小公司也可以轻松的开发分布式处理软件。

4.1.1 MapReduce基本过程MapReduce是一种编程模型,用户在这个模型框架下编写自己的Map函数和Reduce函数来实现分布式数据处理。

MapReduce程序的执行过程主要就是调用Map函数和Reduce函数,Hadoop把MapReduce程序的执行过程分为Map和Reduce两个大的阶段,如果细分可以为Map、Shuffle(洗牌)、Reduce三个阶段。

Map含义是映射,将要操作的每个元素映射成一对键和值,Reduce含义是归约,将要操作的元素按键做合并计算,Shuffle在第三节详细介绍。

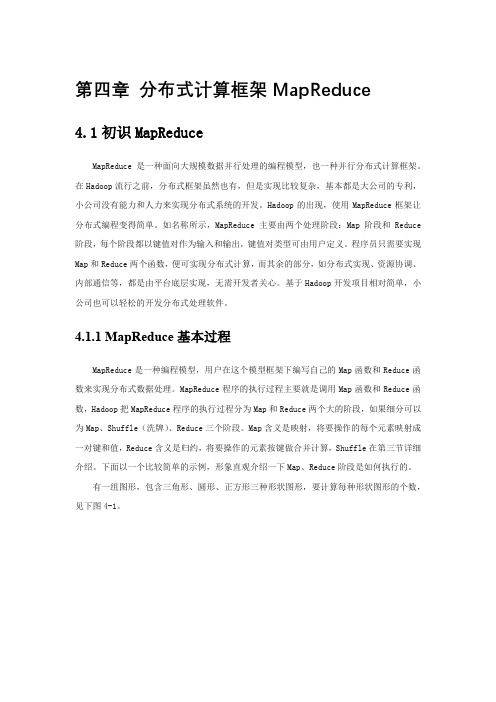

下面以一个比较简单的示例,形象直观介绍一下Map、Reduce阶段是如何执行的。

有一组图形,包含三角形、圆形、正方形三种形状图形,要计算每种形状图形的个数,见下图4-1。

图:4-1 map/reduce计算不同形状的过程在Map阶段,将每个图形映射成形状(键Key)和数量(值Value),每个形状图形的数量值是“1”;Shuffle阶段的Combine(合并),相同的形状做归类;在Reduce阶段,对相同形状的值做求和计算。

mapreduce编程实验报告心得

mapreduce编程实验报告心得【实验报告心得】总结:本次mapreduce编程实验通过实际操作,使我对mapreduce编程框架有了更深入的理解。

在实验过程中,我学会了如何编写map和reduce函数,并利用这些函数从大数据集中进行数据提取和聚合分析。

通过这个实验,我还掌握了如何调试和优化mapreduce任务,以提高数据处理效率和性能。

一、实验目的:本次实验的目的是掌握mapreduce编程框架的使用方法,理解其实现原理,并在实际编程中熟练运用map和reduce函数进行数据处理和分析。

二、实验环境和工具:本次实验使用Hadoop分布式计算框架进行mapreduce编程。

使用的工具包括Hadoop集群、HDFS分布式文件系统以及Java编程语言。

三、实验过程:1. 实验准备:在开始实验前,我首先了解了mapreduce的基本概念和特点,以及Hadoop集群的配置和使用方法。

2. 实验设计:根据实验要求,我选择了一个适当的数据集,并根据具体需求设计了相应的map和reduce函数。

在设计过程中,我充分考虑了数据的结构和处理逻辑,以保证mapreduce任务的高效完成。

3. 实验编码:在实验编码过程中,我使用Java编程语言来实现map 和reduce函数。

我按照mapreduce编程模型,利用输入键值对和中间结果键值对来进行数据处理。

在编码过程中,我注意了代码的规范性和可读性,并进行了适当的优化。

4. 实验测试:完成编码后,我在Hadoop集群上部署和运行了我的mapreduce任务。

通过对数据集进行分析和处理,我验证了自己编写的map和reduce函数的正确性和性能。

5. 实验总结:在实验结束后,我对本次实验进行了总结。

我分析了实验中遇到的问题和挑战,并提出了相应的解决方法。

我还对mapreduce编程框架的优缺点进行了评估,并给出了自己的观点和建议。

四、实验结果和观点:通过本次实验,我成功实现了对选定数据集的mapreduce处理。

简述mapreduce体系结构

MapReduce 体系结构简述

MapReduce 是一种用于处理海量数据的分布式计算框架,其核心思想是将数据处理过程分为两个阶段:Map 阶段和 Reduce 阶段。

在Map 阶段,数据被分成多个块,每个块都被映射到一个 Mapper 进程上进行处理;在 Reduce 阶段,多个 Mapper 进程的输出被聚合到一个 Reducer 进程上进行处理。

MapReduce 体系结构的基本组成部分包括:

1. MapTask:负责 Map 阶段的数据处理流程,接受输入数据块和 Map 函数,执行 Map 函数并将结果输出到本地磁盘。

2. ReduceTask:负责 Reduce 阶段的数据处理流程,接受来自多个 MapTask 的输出数据,执行 Reduce 函数并将结果输出到本地磁盘。

3. MRAppMaster:负责整个 MapReduce 程序的过程调度及状态协调,包括任务调度、进度监控、错误恢复等。

MapReduce 程序的运行过程如下:

1. 输入数据被分成多个数据块。

2. 每个数据块都被映射到一个 Mapper 进程上进行处理,Mapper 进程执行 Map 函数并将结果输出到本地磁盘。

3. 多个 Mapper 进程的输出数据被聚合到一个 Reducer 进程上进行处理,Reducer 进程执行 Reduce 函数并将结果输出到本地磁盘。

4. MRAppMaster 负责任务调度、进度监控、错误恢复等,确保

MapReduce 程序的正确性和可靠性。

MapReduce 体系结构的优点在于其高度并行化和可扩展性,能够处理海量数据并在分布式环境中实现高性能计算。

MapReduce(分布式计算框架)

MapReduce(分布式计算框架)MapReduce是⼀种计算模型,⽤于处理⼤数据量的计算,其计算过程可以分为两个阶段(实质上是三个阶段),即Map和Reduce.图2-3-1:MapReduce执⾏步骤其中Map将输⼊的原始数据集转化为Key-Value(键-值对),拆分给不同节点并⾏进⾏指定的计算操作(例如排序、聚集),形成中间结果,这个计算操作的过程称为Map shuffle;Reduce则并⾏地对⽣成的中间结果中相同的Key的所有Value进⾏规约合并汇总处理后,输出新的Key-Value得到最终结果,这个处理相同Key的过程称为Reduce shuffle. 可以看出,在Map和Reduce中间,其实还有⼀个过程,就是对Map的输出进⾏整理并交给Reduce,这个过程就是shuffle. Map和Reduce操作需要我们⾃⼰定义相应的Map类和Reduce类,⽽shuffle则是系统⾃动帮我们实现的。

简单点理解,可以将Map看作是拆分数据集给不同的节点进⾏并⾏计算操作,将Reduce看作是整合每个节点的计算结果以汇总出最终结果(即Map负责分的计算,Reduce负责合的计算)。

图2-3-2:MapReduce⼯作原理1. JobTracker和TaskTrackerMapReduce由两种主要的后台程序运⾏:JobTracker和TaskTracker.(1) JobTrackerJobTracker是master节点,⼀个集群中只有⼀个,负责管理所有作业、任务/作业的监控及错误处理等,并将任务分解成⼀系列任务,分派给TaskTracker.(2) TaskTrackerTaskTracker是slave节点,负责运⾏Map Task和Reduce Task,并通过周期性的⼼跳与JobTracker交互,通知JobTracker其当前的健康状态,每⼀次⼼跳包含了可⽤的Map和Reduce任务数⽬、占⽤的数⽬以及运⾏中的任务详细信息。

信息学科前沿1—邱强《大数据概述及空间大数据应用》教学大纲

信息学科前沿1—邱强《大数据概述及空间大数据应用》教学大纲一、课程编号:二、课程名称:信息学科前沿1三、先修课程: 选修四、课程的性质、目的和任务:本课程为选修课程。

大数据是工业界及学术界新兴的数据、技术和服务的集合体,是一门综合性较强的应用课程,可以作为计算机等相关专业专业选修课,或其他专业感兴趣同学的公共选修课。

本课程从大数据的基础概念出发,从技术的角度梳理了大数据相关技术体系,就关键技术展开描述,并以空间大数据应用为场景,介绍地图应用以及LBS服务,培养学生在具体行业应用中体会大数据概念和技术。

通过本课程的学习,培养学生加深对大数据相关概念的理解,掌握基础的大数据研发技能,并引导学生对具体的大数据技术进行深入的研究,为未来从事大数据相关科研和工程技术开发打好基础。

五、本课程讲授和实验学时本课程讲授总时数为36学时,学分。

六、本课程应掌握的基本概念、基本理论、基本技能通过本课程的学习,学生学会大数据存储、分析以及可视化相关概念。

熟悉当前常用的大数据开发框架Hadoop、Spark等,熟悉内存计算技术,掌握地图应用及LBS的基本概念和技术。

能够在实际应用案例中体会大数据技术特点。

七、教科书、参考书参考书《大数据技术原理与应用(第2版)》(林子雨)《大数据时代》((英)迈尔-舍恩伯格,(英)库克耶)八、课程内容与学时分配第一章大数据概念综述(3学时)●主要内容1.1什么是大数据1.2什么是空间大数据1.3大数据特征●教学目的与要求掌握大数据及空间大数据的基本概念,了解大数据发展过程。

通过典型应用案例了解大数据在行业中的应用价值。

掌握大数据4V特征,以及空间大数据独有的数据特征。

第二章大数据技术总览(3学时)●主要内容2.1大数据存储技术2.2大数据分析技术2.3大数据可视化技术●教学目的与要求了解大数据存储、分析以及可视化方面的技术概要,掌握大数据相关研究的技术体系,为后续章节详细学习具体技术点做准备。

mapreduce的map阶段和reduce阶段

mapreduce的map阶段和reduce阶段MapReduce是一个用于大数据处理的计算模型和编程框架,最初由Google公司开发并推出。

MapReduce的基本思想是利用并行计算和分布式存储的特点,将大规模的数据集分成若干个小部分,通过Map 函数将这些小部分独立地处理成一系列键值对,并通过Reduce函数合并这些键值对,形成最终的结果。

在MapReduce中,每个Map任务和Reduce任务都是独立的计算单元,可以在分布式计算集群中并行地执行,从而以极高的性能和可伸缩性处理海量数据。

MapReduce的Map阶段和Reduce阶段是这个计算模型的核心,下面分别进行详细的解释。

1. Map阶段在MapReduce中,Map阶段的主要作用是将原始数据抽象为一系列键值对,并输出到Reduce阶段进行处理。

在具体的实现中,Map函数会将输入的数据映射到一组中间结果中,并将这些结果输出到Reduce函数中处理。

Map函数的输入和输出都是键值对形式的数据,其中输入通常是一条记录,输出通常是若干个键值对。

Map函数的实现通常是通过编写一个Map任务,并将这个任务分发到MapReduce框架的计算节点中执行。

在Map任务中,会对每条输入数据进行处理,将它分解成若干个键值对,并输出到Reduce函数进行处理。

在具体的实现中,Map任务的输入可以来源于分布式文件系统中的一个或多个数据块,输出可以保存到分布式文件系统中的一个或多个文件中。

2. Reduce阶段在MapReduce中,Reduce阶段的主要作用是将Map阶段输出的中间结果进行合并,并输出最终的计算结果。

在具体的实现中,Reduce 函数会接收Map阶段输出的一组键值对,并将它们分组处理成一组新的键值对,形成最终的输出结果。

Reduce函数的实现通常是通过编写一个Reduce任务,并将这个任务分发到MapReduce框架的计算节点中执行。

在Reduce任务中,会对所有输入数据进行汇总和合并处理,并输出最终的结果。

mapreduce编程模型的原理

mapreduce编程模型的原理MapReduce编程模型是一种分布式计算模型,用于处理大规模数据集。

它的原理是将数据集划分成小的数据块,然后并行地在集群的多个节点上执行Map和Reduce操作,最终将结果合并起来形成最终结果。

MapReduce编程模型的主要原理可以归纳为以下几个方面:1. 数据划分MapReduce会将大规模数据集划分为小的数据块,每个数据块通常在64MB到1GB之间。

将数据划分为小的数据块可以方便地并行处理,也可以减少网络传输的数据量。

2. Map操作Map操作是MapReduce中的第一步。

Map操作会对数据块中的每个数据进行处理,其中Map会将每个数据转化为一个中间键-值对(key-value),key表示数据属性,value表示值。

Map操作通常包括以下步骤:(1)输入:从输入数据中读取数据块(2)映射:将输入数据转换为中间键-值对(3)缓存:将处理后的中间键-值对缓存在内存中3. Shuffle操作Shuffle操作是MapReduce中的第二步,Shuffle操作会将Map操作生成的中间键-值对重新组合,并按照key值将它们分组。

Shuffle操作通常包括以下步骤:(1)数据的拷贝:将Map输出的中间键-值对按照key值拷贝到Reduce操作的计算节点上(2)数据的排序:按照key值对中间键-值对进行排序,便于Reduce操作的处理(3)数据的分区:将排序后的中间键-值对分成多个分区,每个分区包含相同key值的中间键-值对4. Reduce操作Reduce操作是MapReduce中的第三步。

在Reduce操作中,Map操作生成的中间键-值对被分成多个分区,每个分区都包含相同key值的键值对。

在Reduce操作中,对每个分区中的中间键-值对进行处理,并生成一个输出结果。

Reduce操作通常包括以下步骤:(1)输入:从Map操作的输出获取中间键-值对分组信息(2)缓存:将Map操作输出的中间键-值对缓存到内存中(3)分组:将缓存中的中间键-值对按照key值分组(4)Reduce:对每个分组中的中间键-值对进行Reduce操作,并将结果输出5. 在Master节点上进行控制和协调MapReduce编程模型中,由Master节点来进行任务的分配、管理和协调。

mapreduce编程模型及三个步骤

MapReduce 编程模型及三个步骤概述MapReduce 是一种用于处理大规模数据集的并行计算模型,最初由 Google 提出并用于分布式数据处理中。

它底层基于分布式文件系统和集群计算框架,通过将计算任务分解为 Map 和 Reduce 两个阶段,以及一些可选的中间步骤,使得开发者能够简化并行计算的实现。

MapReduce 编程模型MapReduce 编程模型由以下三个关键组件组成: 1. 输入数据集 2. Map 函数 3. Reduce 函数MapReduce 模型简化了并行计算的复杂性,将大规模数据集的处理任务从开发者手中抽离,让其只需要关注如何定义 Map 和 Reduce 函数,而不用操心数据的切分、分发和结果的聚合等问题。

MapReduce 三个步骤MapReduce 模型由以下三个步骤组成,每个步骤都有其特定的目的和功能。

1. Map 阶段Map 阶段是 MapReduce 模型的第一个步骤,其功能是将输入数据切分为若干个独立的数据块,并为每个数据块调用 Map 函数进行处理。

在 Map 阶段中,数据会被划分为多个键值对,其中键表示数据项的标识,值表示数据项本身。

Map 函数以键值对为输入,根据需求对数据进行处理,并生成新的键值对作为输出。

Map 函数可以是任意计算逻辑,例如对数据项进行过滤、排序或统计等操作。

Map 阶段的目的是将原始数据转换为中间结果,用于后续的 Reduce 阶段进行处理。

2. Shuffle 阶段Shuffle 阶段是 MapReduce 模型的中间步骤,其功能是对 Map 阶段生成的中间结果进行排序和分组,以便将具有相同键的数据分配给同一个 Reduce 函数进行处理。

在 Shuffle 阶段中,系统会根据键值对的键进行排序,并将具有相同键的数据分组。

这样做的目的是为了在 Reduce 阶段中,能够将相同键的数据集中在一起,以便进行计算、聚合或其他操作。

mapreduce编程单词计数重点与难点

MapReduce编程单词计数重点与难点随着大数据技术的快速发展,MapReduce编程模型成为了处理大规模数据的重要工具之一。

在MapReduce编程中,单词计数是一个常见的任务,用来统计大规模文本数据中各个单词出现的次数。

本文将重点探讨MapReduce编程单词计数的重点与难点。

一、MapReduce编程概述1.1 MapReduce编程模型MapReduce是谷歌公司提出的一种用于大规模数据处理的编程模型。

它将数据处理过程分为两个阶段:Map阶段和Reduce阶段。

Map阶段负责将输入数据分割成若干个子问题,并由各个Map任务进行处理;Reduce阶段负责将Map任务的输出结果进行合并和整理,得到最终的输出结果。

1.2 MapReduce编程框架在实际的MapReduce编程中,通常会使用一些开源的MapReduce编程框架,如Hadoop、Spark等。

这些框架提供了一些API和工具,帮助开发者更加方便地实现MapReduce程序,并运行在分布式系统上。

二、单词计数的重点2.1 数据预处理在进行单词计数之前,需要对输入的文本数据进行预处理,包括分词、过滤停用词等操作。

这一步骤的准确性和效率将直接影响到最终的计数结果。

2.2 Map阶段在Map阶段,需要将文本数据转化为键值对的形式,其中键表示单词,值表示单词出现的次数。

在此阶段,需要考虑如何实现高效的分词和计数逻辑,处理不同格式的文本数据,以及处理文本中的特殊字符等问题。

2.3 Reduce阶段在Reduce阶段,需要将Map任务的输出结果进行整合,计算出各个单词的总出现次数。

在此阶段,需要考虑如何合并不同Map任务的输出结果,解决数据倾斜和大量小文件等问题,以及实现高效的Reduce 逻辑。

2.4 结果输出需要将最终的计数结果输出到指定的数据存储中,如HDFS、数据库等。

在此过程中,需要考虑如何实现数据的持久化和容错,以及结果的格式化和展示等问题。

mapreduce的实现机制

MapReduce是一种分布式计算框架,可以用于大规模数据处理,它的实现机制主要包括以下几个方面。

1. 数据分片在MapReduce中,数据会被分成多个数据块,并且这些数据块会被复制到不同的节点上。

这样做的目的是为了提高数据的可靠性,同时也可以避免单节点故障导致的数据丢失。

2. Map阶段在Map阶段中,每个节点会同时执行Map函数,将输入的数据块转换为键值对的形式。

Map函数的输出结果会被分配到不同的Reducer节点上,这里需要注意的是,Map函数的输出结果必须是无状态的,即输出结果只能依赖于输入参数,而不能依赖于其他状态信息。

3. Shuffle阶段在Shuffle阶段中,Map函数的输出结果按照键的哈希值进行排序,并将相同键的值归并到一起。

这个过程需要消耗大量的网络带宽和磁盘I/O,因此Shuffle阶段是整个MapReduce计算中的瓶颈之一。

4. Reduce阶段在Reduce阶段中,每个Reducer节点会对Map函数输出结果中相同键的数据进行聚合操作。

Reduce函数的输入参数由Map函数输出结果中相同键的数据组成,而Reduce函数的输出结果是最终结果,MapReduce框架会将所有Reducer节点的输出结果合并为一个最终结果。

5. 容错机制在分布式计算中,可能会出现节点故障、网络异常等问题,这些问题会导致数据丢失或者计算结果错误。

因此,MapReduce框架需要具备一定的容错机制,比如在Shuffle阶段中,如果某个节点的输出结果没有及时到达目标节点,MapReduce框架会自动重新发送数据。

6. 优化策略为了提高MapReduce计算的性能和效率,MapReduce框架还可以采用多种优化策略,比如合并小文件、增加Map和Reduce的任务并行度、调整数据分片大小等。

总的来说,MapReduce框架通过数据分片、Map函数、Shuffle 阶段、Reduce函数等组件的协同工作,实现了大规模数据的分布式处理。

阐述分布式计算框架mapreduce的主要步骤

阐述分布式计算框架mapreduce的主要步骤嘿,咱今儿就来唠唠这分布式计算框架 mapreduce 的主要步骤哈!你想啊,这 mapreduce 就像是一个超级大的团队在干活儿。

第一步呢,就是“map”啦,就好比是一群勤劳的小蜜蜂,各自在自己的那片花丛里忙碌着采集花粉。

每个小蜜蜂都专注于自己的任务,把那些杂乱无章的数据给初步处理一下,提取出有用的信息来。

然后呢,到了第二步“reduce”啦,这就像是把小蜜蜂们采集来的花粉都汇聚到一起,进行进一步的加工和整理。

把那些经过“map”处理后的小块信息,给整合成一个有意义的大结果。

你说这 mapreduce 厉害不厉害?就像是一场精彩的魔术表演!通过这两个步骤的完美配合,原本庞大复杂的数据就被驯服得服服帖帖啦!它能处理海量的数据,就像一个大力士能轻松举起千斤重担一样。

这就好像我们生活中的很多事情,得一步一步来,不能着急。

先把基础打好,就像“map”阶段把数据初步处理好,然后再进行深入的整合和归纳,就像“reduce”阶段一样。

你想想看,如果没有前面的精心准备,后面怎么能得出漂亮的结果呢?而且啊,这mapreduce 还特别灵活。

它可以根据不同的需求和场景,调整“map”和“reduce”的具体操作。

就像我们人一样,面对不同的情况会有不同的应对方法。

它能适应各种复杂多变的环境,这可真是太牛了!再看看我们周围的世界,很多事情不也是这样吗?一个大工程的完成,不就是由无数个小步骤组成的吗?一个团队的成功,不也是大家齐心协力,各自做好自己的那部分工作,最后汇聚成一个伟大的成果吗?总之啊,这分布式计算框架 mapreduce 的主要步骤,真的是非常重要,非常神奇!它让我们能轻松应对那些看似不可能完成的任务,让数据处理变得不再那么困难。

咱可得好好了解它,掌握它,让它为我们的工作和生活带来更多的便利和惊喜呀!。

mapreduce基础编程

mapreduce基础编程MapReduce是一种分布式计算模型,主要用于处理大规模数据集。

在大数据时代,MapReduce已经成为了大数据处理的重要工具之一。

本文将介绍MapReduce的基础编程,包括程序结构、Mapper、Reducer、Partitioner等概念。

1. MapReduce程序结构MapReduce程序由两个部分组成:Map函数和Reduce函数。

Map 函数将输入数据划分为若干个子集,每个子集进行单独处理并输出一个键值对;Reduce函数将Map函数输出的键值对进行合并,得到最终的结果。

2. MapperMapper是MapReduce程序中的一个重要组成部分。

Mapper将输入数据分块,每个分块生成一组键值对。

Mapper的主要任务是将输入数据处理为键值对,并将这些键值对传递给Reducer。

3. ReducerReducer是MapReduce程序中的另一个重要组成部分。

Reducer 将Mapper输出的键值对进行合并,得到最终的结果。

Reducer的主要任务是对Mapper输出的键值对进行合并和聚合操作。

4. PartitionerPartitioner是MapReduce程序中的另一个重要组成部分。

Partitioner将Reducer的输入键值对进行分组,将相同的键值对分配到同一个Reducer中。

Partitioner的主要任务是保证相同的键值对进入同一个Reducer中进行合并操作,从而保证MapReduce程序的正确性。

总之,MapReduce是一种分布式计算模型,主要用于处理大规模数据集。

MapReduce程序由Map函数和Reduce函数组成,Mapper将输入数据分块,每个分块生成一组键值对,Reducer将Mapper输出的键值对进行合并,得到最终的结果。

Partitioner将Reducer的输入键值对进行分组,保证相同的键值对进入同一个Reducer中进行合并操作。

mapreduce基础运用头歌

文章标题:深入探讨MapReduce的基础运用和原理一、引言MapReduce是一种用于处理和生成大规模数据集的分布式计算框架,它能够有效地处理海量数据,提高数据处理的效率和速度。

本文将深入探讨MapReduce的基础运用和原理,帮助读者更深入地理解和掌握这一重要的数据处理技术。

二、MapReduce的基本概念1. Map阶段:在MapReduce中,Map阶段是数据处理的第一步,它将输入的数据集合拆分成若干个独立的任务,并将这些任务分配给不同的计算节点进行并行处理。

在Map阶段,我们需要编写Map函数来对输入的数据进行处理,通常是将数据进行分割和映射。

2. Shuffle阶段:Shuffle阶段是MapReduce中非常重要的一部分,它负责将Map阶段输出的结果进行分区和排序,然后将相同key的数据进行分组,以便于后续Reduce阶段的处理。

3. Reduce阶段:Reduce阶段是MapReduce的最后一步,它接收Shuffle阶段输出的数据,并将具有相同key的数据进行合并和聚合,最终输出最终的处理结果。

三、MapReduce的基础运用1. 数据处理:MapReduce可以高效地处理海量数据,如日志文件、文本数据等,通过Map和Reduce两个阶段的处理,可以实现对数据的分析和计算,例如词频统计、数据过滤等。

2. 分布式计算:MapReduce能够将数据集分解成多个小的任务,分配给多个计算节点进行并行处理,因此可以充分利用集群的计算资源,提高数据处理的速度和效率。

3. 容错性:MapReduce具有很强的容错性,当集群中的某个计算节点发生故障时,系统能够自动将任务重新分配给其他正常的节点进行处理,保证任务的顺利完成。

四、MapReduce的原理分析1. 并行计算模型:MapReduce采用了流水线式的并行计算模型,将数据处理划分成不同的阶段,每个阶段都可以并行执行,从而充分利用集群的计算资源。

mapreduce初级编程实践

mapreduce初级编程实践MapReduce初级编程实践MapReduce是一种分布式计算框架,用于大规模数据处理。

它将输入数据划分为多个块,并在集群中并行处理这些块。

本文将介绍MapReduce的基本概念和编程实践。

一、MapReduce的基本概念1. Map阶段Map阶段是将输入数据转换为键值对的过程。

在此阶段中,每个输入记录都被映射到一个键值对。

这些键值对被传递给Reduce阶段进行进一步处理。

2. Reduce阶段Reduce阶段是对Map输出进行聚合的过程。

在此阶段中,每个键都被聚合为一个结果。

3. Shuffle和Sort过程Shuffle和Sort过程是将Map输出传递给Reduce任务的过程。

在此过程中,Map输出按照键进行排序,并将相同键的值分组在一起。

二、编写第一个MapReduce程序1. 环境设置要编写第一个MapReduce程序,需要安装Hadoop和Java开发环境。

可以使用Cloudera QuickStart VM或Hortonworks Sandbox 来获得一个预配置好的Hadoop环境。

2. 编写代码下面是一个简单的WordCount程序:```javaimport java.io.IOException;import java.util.StringTokenizer;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.Mapper;import org.apache.hadoop.mapreduce.Reducer;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; importorg.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class WordCount {public static class TokenizerMapperextends Mapper<Object, Text, Text, IntWritable>{private final static IntWritable one = new IntWritable(1);private Text word = new Text();public void map(Object key, Text value, Context context) throws IOException, InterruptedException {StringTokenizer itr = new StringTokenizer(value.toString()); while (itr.hasMoreTokens()) {word.set(itr.nextToken());context.write(word, one);}}}public static class IntSumReducerextends Reducer<Text,IntWritable,Text,IntWritable> { private IntWritable result = new IntWritable();public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}public static void main(String[] args) throws Exception {Configuration conf = new Configuration();Job job = Job.getInstance(conf, "word count");job.setJarByClass(WordCount.class);job.setMapperClass(TokenizerMapper.class);job.setCombinerClass(IntSumReducer.class);job.setReducerClass(IntSumReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0])); FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}}```3. 运行程序将上述代码保存为WordCount.java,并使用以下命令编译:```bashjavac -classpath `hadoop classpath` WordCount.java```然后,将编译后的代码打包成一个JAR文件:```bashjar cf wc.jar WordCount*.class```最后,运行程序:```bashhadoop jar wc.jar WordCount input output```其中,input是输入文件的路径,output是输出文件的路径。

简述 mapreduce的数据处理过程

简述 mapreduce的数据处理过程MapReduce是一种分布式计算模型,用于处理大规模数据集。

它的核心思想是将数据分成小块,然后在分布式系统中进行并行处理。

MapReduce通常由两个阶段组成:map和reduce。

本文将详细介绍MapReduce的数据处理过程。

一、Map阶段1.1 数据切片在MapReduce中,首先需要将输入数据切成小块。

每个小块称为一个Input Split。

这些Input Split通常具有相同的大小,并且可以在不同的节点上并行处理。

1.2 Map函数接下来,对于每个Input Split,都会调用一个Map函数。

Map函数通常由用户定义,并且它会对输入进行处理并生成一组键值对(key-value pairs)。

这些键值对将作为中间结果传递给Reduce函数。

1.3 Shuffle过程生成的键值对需要根据键(key)进行分组,以便在Reduce阶段进行聚合操作。

这个过程称为Shuffle过程。

二、Reduce阶段2.1 Reduce函数在Shuffle过程结束后,每个Reduce任务都会收到一组键值对,并且按照键进行排序。

然后,针对每个唯一的键调用一个Reduce函数,并将该键相关联的所有值传递给该函数。

2.2 输出结果最后,在Reduce函数中可以执行任意操作,并生成最终输出结果。

这些输出结果通常被写入到文件系统中。

三、MapReduce的优点3.1 可扩展性MapReduce可以处理大规模的数据集,并且可以轻松地添加更多的节点来扩展计算能力。

3.2 容错性由于MapReduce是分布式的,因此它具有容错性。

如果某个节点出现故障,系统可以自动将任务重新分配给其他节点。

3.3 灵活性用户可以自定义Map和Reduce函数,以便执行各种不同类型的数据处理任务。

四、总结在本文中,我们详细介绍了MapReduce的数据处理过程。

首先,在Map阶段中,输入数据被切成小块,并且对于每个Input Split都会调用一个用户定义的Map函数。

《Hadoop大数据开发基础》电子教案

第1章Hadoop介绍教案课程名称:Hadoop大数据开发基础课程类别:必修适用专业:大数据技术类相关专业总学时:64学时(其中理论28学时,实验36学时)总学分:4.0学分本章学时:2学时一、材料清单(1)《Hadoop大数据开发基础(第2版)》教材。

(2)配套PPT。

(3)引导性提问。

(4)探究性问题。

(5)拓展性问题。

二、教学目标与基本要求1.教学目标从理论方面介绍了Hadoop的概念,Hadoop的历史、特点,了解了Hadoop的主要思想,再通过介绍Hadoop的HDFS、MapReduce和YARN这3大主要的核心组件,深入了解Hadoop 的整体架构,最后简要介绍了Hadoop的生态系统和应用场景。

2.基本要求(1)了解Hadoop分布式框架及其发展历史、特点。

(2)了解Hadoop核心组件。

(3)了解Hadoop的生态系统组件。

(4)了解Hadoop的应用场景。

三、问题1.引导性提问引导性提问需要教师根据教材内容和学生实际水平,提出问题,启发引导学生去解决问题,提问,从而达到理解、掌握知识,发展各种能力和提高思想觉悟的目的。

(1)你听到过“大数据”这个概念吗?(2)你听到过“Hadoop”这个软件吗?(3)你知道Hadoop最主要的用处吗?(4)你觉得Hadoop更常用于哪方面?2.探究性问题探究性问题需要教师深入钻研教材的基础上精心设计,提问的角度或者在引导性提问的基础上,从重点、难点问题切入,进行插入式提问。

或者是对引导式提问中尚未涉及但在课文中又是重要的问题加以设问。

(1)Hadoop是一个什么样的软件?(2)Hadoop的核心组件有哪些?(3)Hadoop HDFS的架构中包括了哪些主要的组件?(4)能否通过WordCount程序简单描述一下Hadoop MapReduce?(5)Hadoop生态圈中有哪些软件?(6)Hadoop有哪些宕机处理方式?(7)Hadoop的主要特点有哪些?3.拓展性问题拓展性问题需要教师深刻理解教材的意义,学生的学习动态后,根据学生学习层次,提出切实可行的关乎实际的可操作问题。

mapreduce编程模型及三个步骤

mapreduce编程模型及三个步骤MapReduce编程模型是一种用于处理大规模数据集的分布式计算模型,它由Google公司提出并应用于其搜索引擎等大数据处理场景中。

该模型将计算任务划分为Map和Reduce两个阶段,并通过横向扩展多个计算节点来实现高效的并行计算。

一、MapReduce编程模型的基本思想MapReduce编程模型的基本思想是将大规模数据集拆分成多个小块,分发到不同的计算节点上进行并行处理,最终将结果合并输出。

其中,每个计算节点都具备独立的计算能力和存储空间,可以在不影响其他节点的情况下进行本地计算和存储。

具体来说,MapReduce编程模型包含三个核心组件:输入数据集、Map函数和Reduce函数。

输入数据集是指需要处理的原始数据集合,可以是文本、图像、音频等各种形式的数据。

Map函数则负责对输入数据集中每个元素进行映射操作,并输出一个键值对(key-value pair)。

最后,Reduce函数则根据Map函数输出的键值对对结果进行聚合操作,并输出最终结果。

二、MapReduce编程模型的三个步骤1. Map阶段在Map阶段中,输入数据集被切分成多个小块,并分发到不同的计算节点上。

每个计算节点都会执行相同的Map函数,对输入数据集中的每个元素进行映射操作,并输出一个键值对。

其中,键值对中的键表示元素的标识符,值则表示元素经过映射后得到的结果。

Map函数通常由用户自行定义,其输入参数包括输入数据元素和对应的标识符。

用户需要根据具体的业务需求编写相应的Map函数,并保证其具备高效、可扩展、容错等特性。

2. Shuffle阶段在Map阶段完成后,所有计算节点会将自己所产生的键值对按照键进行排序,并将相同键的值聚合在一起。

这个过程被称为Shuffle(洗牌)操作。

Shuffle操作是MapReduce编程模型中非常重要的一个步骤,它决定了Reduce阶段所需要处理的数据量和负载均衡情况。

分布式计算框架

分布式计算框架MapReduce简介概念⾯向批处理的分布式计算框架⼀种编程模型: MapReduce程序被分为Map(映射)和Reduce(化简)阶段核⼼思想分⽽治之, 并⾏计算移动计算⽽⾮移动数据特点MapReduce有⼏个特点:移动计算⽽不移动数据:分布式计算,计算跟着数据⾛,数据存放在哪就在哪⾥进⾏计算,极⼤的减少了IO的开销。

良好的扩展性:分布式计算框架拥有相当良好的扩展性,随着节点数量的增加,单个节点的计算量减⼩,整体的计算能⼒近乎线性的递增。

⾼容错性:计算任务失败,会⾃动恢复计算,拥有良好的容错性。

状态监控:提交任务之后,任务具体执⾏在哪个节点,具体执⾏到哪个阶段,在后台或者监控界⾯,我们都能实时的进⾏监控。

适合于海量数据的离线批处理:MapReduce在设计之初的⽬标就是⾯向离线批处理,特别是⼤吞吐量的离线处理场景,更适合于MapReduce。

降低了分布式编程的门槛:⼤部分操作MapReduce已经实现,我们仅仅需要在特定的部分编写我们⾃⼰的业务逻辑,极⼤的减少了⼯作量,同时也降低了编程的门槛。

MR原理1. 作业(job):作业是客户端提交请求执⾏的⼀个单元,它包括数据、计算框架以及⼀些配置信息等。

2. 任务(task):是作业细分之后的细分⼯作单元,如MapReduce中的Map Task和Reduce Task。

MapReduce划分为四个阶段,分别为:Split、Map、Shuffle、Reduce。

1. Split阶段,主要负责“分”,这个阶段会由MapReduce⾃动将⼀个⼤⽂件切分成多个⼩的split⽂件⽚段,split只是逻辑概念,仅包含如数据起始位置,长度,所在位置等描述信息。

2.x当中默认的切分规则,⼀个split刚好为⼀个block⼤⼩128M。

那么10TB的数据⽂件,此时就会划分为像图中⼀样多个⼩split⽚段,每⼀个split交由⼀个Map Task处理。

2. Map阶段,会处理经过Split阶段切分好的数据⽚段,每⼀个split将对应⼀个Map的任务,也就说像图中所画Split切分为三个⽚段,分别对应着三个Map Task任务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

PART02

Mapper组件

Mapper组件

Hadoop提供的Mapper类是实现Map任务的一个抽象基类,该基 类提供了一个map()方法。 默认情况下,Mapper类中的map()方法是没有做任何处理的。 如果想自定义map()方法,只需要继承Mapper类并重写map()方 法即可。接下来以词频统计为例,自定义一个map()方法,具体代 码如下:

Title Works About Help

Reducer组件

setup()方法一般会在reduce()方法之前执行,可以在setup() 方法中做一些初始化工作,如任务的一些配置信息。 cleanup()方法一般会在reduce()方法之后执行,可以在clean()方法 public class Reducer<KEYIN,VA中LU做EI一N,K些EY结O尾UT清,V理AL的UE工OU作T,> {如资源释放等。 如果想自定义reduce()方法,只需要继承Reducer类并重写reduce ()方法即可。以词频统计为例,自定义一个reduce()方法,代码 如下:

BITC

项目4 MapReduce分布式计算框架

任务4.3 pReduce编程组件1

ONE

理解MapReduce的 核心思想

学习目标

THREE

了解MapReduce的 优化策略

TWO

掌握MapReduce的编程 模型和工作原理

FOUR

掌握MapReduce常见 编程组件的使用

Title Works About Help

谢谢

主讲教师:马东波

public class Reducer<KEYIN,VALUEIN,KEYOUT,VALUEOUT> {

Title Works About Help

Reducer组件

public class Reducer<KEYIN,VALUEIN,KEYOUT,VALUEOUT> {

Title Works About Help

Title Works About Help

InputFormat组件

Hadoop自带了一个InputFormat接口,该接口的定义代码如下所 示:

Title Works About Help

InputFormat组件

接口定义了getSplits()和createRecordReader(): getSplit()方法主要实现了逻辑切片机制。其中,切片的大小splitSize是由3个值确定 的: 1.minSize:splitSize的最小值,mapred.min.split.size确定,在mapred-site.xml中 配置,默认为1MB 2.maxSize:splitSize的最大值,mapreduce.jobtracker.split.metainfo.maxsize确 定,在mapred-site.xml中设置,默认为10MB 3.blockSize:HDFS中文件存储块的大小,在hdfs-site.xml中进行设置,默认128MB

章节概要

MapReduce是Hadoop系统核心组件之一,它是一种可用于大数据并行处理的计算模型、 框架和平台,主要解决海量数据的计算,是目前分布式计算模型中应用较为广泛的一种。

本章通过对MapReduce原理、编程模型及案例进行深入讲 解。

CONTENTS

PART 01

InputFormat组件

Title Works About Help

Reducer组件

public class Reducer<KEYIN,VALUEIN,KEYOUT,VALUEOUT> {

Title Works About Help

总

结

Mapper组件

map() <k1,v1>→<k2,v2>

ONE

InputFormat组件

分片、格式化数据源 getSplits()和

createRecordReader(): <k1,v1>

TWO

THR

Reducer组件

setup() reduce() cleanup() <k2,v2>→<k3,v3>

Title Works About Help

Title Works About Help

Title Works About Help

Reducer组件

setup()方法一般会在reduce()方法之前执行,可以在setup() 方法中做一些初始化工作,如任务的一些配置信息。 cleanup()方法一般会在reduce()方法之后执行,可以在clean()方法 public class Reducer<KEYIN,VA中LU做EI一N,K些EY结O尾UT清,V理AL的UE工OU作T,> {如资源释放等。 如果想自定义reduce()方法,只需要继承Reducer类并重写reduce ()方法即可。以词频统计为例,自定义一个reduce()方法,代码 如下:

Title Works About Help

Mapper组件

Title Works About Help

PART03

Reducer组件

Reducer组件

Map过程输出的键值对,将由Reducer组件进行合并处理,最终 的某种形式的结果输出。 Hadoop提供了一个抽象类Reducer,该类代码如下:

PART 02

Mapper组件

PART 03

Reducer组件

PART01

InputFormat组 件

InputFormat组件

主要用于描述输入数据的格式,它提供两个功能,分别是数据切分 和为Mapper提供输入数据。 数据切分:按照某个策略将输入数据切片分成若干的分片(split), 以便确定MapTask个数以及对应的分片(split) 为Mapper提供输入数据:给定某个分片(split),将其解析成一 个一个的key/value键值对。

Reducer组件

上述代码中,当用户的应用程序调用Reducer类时,会直接调用 Reducer类里面的run()方法,该方法中定义了setup()、reduce()、 cleanup()三个方法的执行顺序:setup→reduce →cleanup. public class Reducer<KEYIN,VA其LU中EI,N,KseEYtuOpU(T),和VAcLleUaEnOuUpT>()方{ 法内部不做任何处理,也就是说 reduce()方法时处理数据的核心方法,该方法接收Map阶段输出 的键值对数据,对传入的键值对数据进行处理,并产生最终的某种 形式的结果输出。