数据挖掘上机实验

数据仓库与数据挖掘实验报告

一、上机目的及内容目的:1.理解数据挖掘的基本概念及其过程;2.理解数据挖掘与数据仓库、OLAP之间的关系3.理解基本的数据挖掘技术与方法的工作原理与过程,掌握数据挖掘相关工具的使用。

内容:将创建一个数据挖掘模型以训练销售数据,并使用“Microsoft 决策树”算法在客户群中找出购买自行车模式。

请将要挖掘的维度(事例维度)设置为客户,再将客户的属性设置为数据挖掘算法识别模式时要使用的信息。

然后算法将使用决策树从中确定模式。

下一步需要训练模型,以便能够浏览树视图并从中读取模式。

市场部将根据这些模式选择潜在的客户发送自行车促销信息。

要求:利用实验室和指导教师提供的实验软件,认真完成规定的实验内容,真实地记录实验中遇到的各种问题和解决的方法与过程,并根据实验案例绘出模型及操作过程。

实验完成后,应根据实验情况写出实验报告。

二、实验原理及基本技术路线图(方框原理图或程序流程图)关联分析:关联分析是从数据库中发现知识的一类重要方法。

时序模式:通过时间序列搜索出重复发生概率较高的模式。

分类:分类是在聚类的基础上对已确定的类找出该类别的概念描述,代表了这类数据的整体信息,既该类的内涵描述,一般用规则或决策树模式表示。

三、所用仪器、材料(设备名称、型号、规格等或使用软件)1台PC及Microsoft SQL Server套件四、实验方法、步骤(或:程序代码或操作过程)及实验过程原始记录( 测试数据、图表、计算等)创建 Analysis Services 项目1.打开 Business Intelligence Development Studio。

2.在“文件”菜单上,指向“新建”,然后选择“项目”。

3.确保已选中“模板”窗格中的“Analysis Services 项目”。

4.在“名称”框中,将新项目命名为 AdventureWorks。

5.单击“确定”。

更改存储数据挖掘对象的实例1.在 Business Intelligence Development Studio 的“项目”菜单中,选择“属性”。

数据挖掘实验报告

数据挖掘实验报告一、引言。

数据挖掘作为一种从大量数据中发现隐藏模式和信息的技术,已经被广泛应用于各个领域。

本实验旨在通过对给定数据集的分析和挖掘,探索其中潜在的规律和价值信息,为实际问题的决策提供支持和参考。

二、数据集描述。

本次实验使用的数据集包含了某电商平台上用户的购物记录,其中包括了用户的基本信息、购买商品的种类和数量、购买时间等多个维度的数据。

数据集共包括了10000条记录,涵盖了近一年的购物数据。

三、数据预处理。

在进行数据挖掘之前,我们首先对数据进行了预处理。

具体包括了数据清洗、缺失值处理、异常值处理等步骤。

通过对数据的清洗和处理,保证了后续挖掘分析的准确性和可靠性。

四、数据分析与挖掘。

1. 用户购买行为分析。

我们首先对用户的购买行为进行了分析,包括了用户购买的商品种类偏好、购买频次、购买金额分布等。

通过对用户购买行为的分析,我们发现了用户的购买偏好和消费习惯,为电商平台的商品推荐和营销策略提供了参考。

2. 商品关联规则挖掘。

通过关联规则挖掘,我们发现了一些商品之间的潜在关联关系。

例如,购买商品A的用户80%也会购买商品B,这为商品的搭配推荐和促销活动提供了依据。

3. 用户价值分析。

基于用户的购买金额、购买频次等指标,我们对用户的价值进行了分析和挖掘。

通过对用户价值的评估,可以针对不同价值的用户采取个性化的营销策略,提高用户忠诚度和购买转化率。

五、实验结果。

通过对数据的分析和挖掘,我们得到了一些有价值的实验结果和结论。

例如,发现了用户的购买偏好和消费习惯,发现了商品之间的关联规则,发现了用户的不同价值等。

这些结论为电商平台的运营和管理提供了一定的参考和决策支持。

六、结论与展望。

通过本次实验,我们对数据挖掘技术有了更深入的理解和应用。

同时,也发现了一些问题和不足,例如数据质量对挖掘结果的影响,挖掘算法的选择和优化等。

未来,我们将继续深入研究数据挖掘技术,不断提升数据挖掘的准确性和效率,为更多实际问题的决策提供更有力的支持。

实验三 数据挖掘

昆明理工大学信息工程与自动化学院学生实验报告( 2015 —2016 学年第 1 学期)课程名称:数据库仓库与数据挖掘开课实验室:信自楼444 2015年12月 22日一、上机目的1.理解数据挖掘的基本概念及其过程;2.理解数据挖掘与数据仓库、OLAP之间的关系3.理解基本的数据挖掘技术与方法的工作原理与过程,掌握数据挖掘相关工具的使用。

4. 创建一个数据挖掘模型以训练销售数据,并使用“Microsoft 决策树”算法在客户群中查找相关信息二、实验原理数据挖掘任务有六项:关联分析,时序模式、聚类、分类、偏差检测、预测。

利用实验室和指导教师提供的实验软件,认真完成规定的实验内容,真实地记录实验中遇到的各种问题和解决的方法与过程,并根据实验案例绘出多维数据组织模型及其OLAP操作过程。

实验完成后,应根据实验情况写出实验报告。

三、所用仪器、材料(设备名称、型号、规格等或使用软件)Windows 7 PC 和Microsoft SQL Server2008四、实验方法、步骤和截图(或:程序代码或操作过程)1.新建数据库并将数据“文山201207数据挖掘.txt”导入2.导入成功效果:3.新建数据源4.新建视图5.结构图6.分类矩阵7.依赖关系8.决策树五、实验结果、分析和结论通过这次的上机实验,不仅再次复习了SQL server2008的使用,而且最重要的是了解了关于数据挖掘的基本步骤,加深了关于数据挖掘的理论知识,通过动手做数据挖掘,更加深刻的理解了数据挖掘的内容。

了解了数据挖掘的方法,基本掌握了数据挖掘的原理,了解了数据仓库与数据挖掘的联系与区别。

在建立时出现了一些问题,但是在老师的指导和同学的帮助下解决了,在以后的学习和生活中会不断对数据仓库和数据挖掘进行探索。

数据挖掘实验报告结论(3篇)

第1篇一、实验概述本次数据挖掘实验以Apriori算法为核心,通过对GutenBerg和DBLP两个数据集进行关联规则挖掘,旨在探讨数据挖掘技术在知识发现中的应用。

实验过程中,我们遵循数据挖掘的一般流程,包括数据预处理、关联规则挖掘、结果分析和可视化等步骤。

二、实验结果分析1. 数据预处理在实验开始之前,我们对GutenBerg和DBLP数据集进行了预处理,包括数据清洗、数据集成和数据变换等。

通过对数据集的分析,我们发现了以下问题:(1)数据缺失:部分数据集存在缺失值,需要通过插补或删除缺失数据的方法进行处理。

(2)数据不一致:数据集中存在不同格式的数据,需要进行统一处理。

(3)数据噪声:数据集中存在一些异常值,需要通过滤波或聚类等方法进行处理。

2. 关联规则挖掘在数据预处理完成后,我们使用Apriori算法对数据集进行关联规则挖掘。

实验中,我们设置了不同的最小支持度和最小置信度阈值,以挖掘出不同粒度的关联规则。

以下是实验结果分析:(1)GutenBerg数据集在GutenBerg数据集中,我们以句子为篮子粒度,挖掘了林肯演讲集的关联规则。

通过分析挖掘结果,我们发现:- 单词“the”和“of”在句子中频繁出现,表明这两个词在林肯演讲中具有较高的出现频率。

- “and”和“to”等连接词也具有较高的出现频率,说明林肯演讲中句子结构较为复杂。

- 部分单词组合具有较高的置信度,如“war”和“soldier”,表明在林肯演讲中提到“war”时,很可能同时提到“soldier”。

(2)DBLP数据集在DBLP数据集中,我们以作者为单位,挖掘了作者之间的合作关系。

实验结果表明:- 部分作者之间存在较强的合作关系,如同一研究领域内的作者。

- 部分作者在多个研究领域均有合作关系,表明他们在不同领域具有一定的学术影响力。

3. 结果分析和可视化为了更好地展示实验结果,我们对挖掘出的关联规则进行了可视化处理。

通过可视化,我们可以直观地看出以下信息:(1)频繁项集的分布情况:通过柱状图展示频繁项集的分布情况,便于分析不同项集的出现频率。

数据挖掘上机作业

《数据挖掘》实验

实验要求:

一、所有选课的学生都必须提交上机实验报告;

二、实验报告应包括如下内容:

1)算法基本思想的描述

2)编程实现算法

3)输出运算结果

三、分类技术和凝聚技术的两个问题中,可以各选择一个题目,关联规

则挖掘的题目必选,即每个人至少选三个题目。

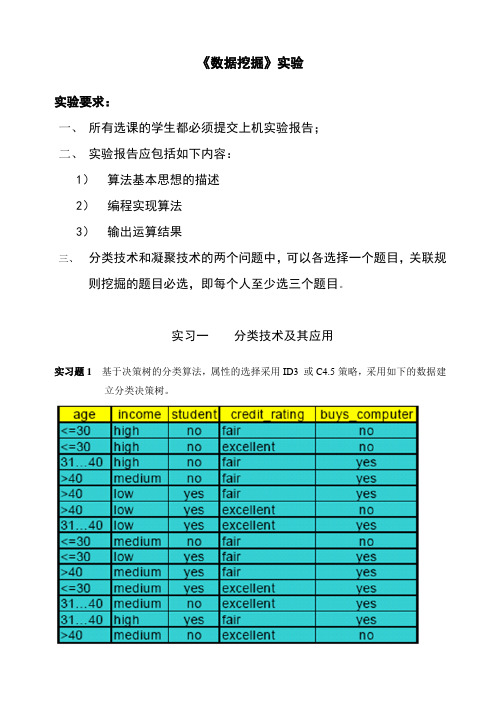

实习一分类技术及其应用

实习题1 基于决策树的分类算法,属性的选择采用ID3 或C4.5策略,采用如下的数据建立分类决策树。

实习题 2 基于线性回归模型拟合一个班学生的学习成绩,建立预测模型。

数据可由自己建立100个学生的学习成绩。

实习二聚类技术及其应用

实习题1 编程验证单连接凝聚聚类算法,实验数据可使用第五章表5.2 的数据进行。

要求输出层次聚类过程中每一步的聚类结果。

实习题2 利用K-均值聚类算法对如下数据进行聚类,其中输入K=3,数据集为{ 2,4,10,12,3,20,30,11,25,23,34,22} 。

要求输出每个类及其中的元素。

实习三关联规则挖掘及其应用

实习题:Apriori算法是一种最有影响的挖掘布尔关联规则频繁项集的算法。

它将关联规则挖掘算法的设计分解为两个子问题:(1)找到所有支持度大于最小支持度的项集,这些项集称被为频繁项集(Frequent Itemset)。

(2)使用第一步产生的频繁集产生期望的规则。

在图书馆管理系统中积累了大量的读者借还书的历史记录,基于Apriori算法挖掘最大频繁项目集,由此产生关联规则。

数据格式可参阅文献

参考文献:彭仪普,熊拥军: 关联挖掘在文献借阅历史数据分析中的应用.情报杂志. 2005年第8期。

数据挖掘实验报告

机器学习与数据挖掘实验报告一、第一部分: 实验综述二、实验工具介绍三、WEKA是新西兰怀卡托大学开发的开源项目, 全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis)。

WEKA是由JAVA编写的, 它的源代码可通过/ml/weka/得到, 是一款免费的, 非商业化的机器学习以及数据挖掘软件。

WEKA作为一个公开的数据挖掘工作平台, 集合了大量能承担数据挖掘任务的学习算法, 包括对数据进行预处理, 分类, 回归, 聚类, 关联规则以及在新的交互式界面上的可视化。

数据挖掘就是通过分析存在于数据库里的数据来解决问题, WEKA的出现使得数据挖掘无需编程即可轻松搞定。

四、实验环境搭建在PC机上面安装java运行环境即JDK环境, 然后安装WEKA。

三、实验目的(1)探索数据集大小与C4.5模型的精度之间的关系。

(2)探索属性的个数对数据集大小与C4.5模型精度之间关系的影响。

四、实验理论依据测试分类模型精度的方法依据如下表所示。

Accuracy=(a+d)/(a+b+c+d)五、实验思路(1)为探索数据集大小与C4.5模型精度之间的关系, 采用实例数据集的训练集进行测试。

对数据集进行多次筛选采样, 通过移除不同百分比的数据实例形成大小的训练集(wake设置为Filter.filters.unsupervised.instance.RemovePercentage), 在分类测试中采用use training set 方法进行测试, 并记录测试模型的精度, 在实验过程中不改变属性值得个数。

换用不同的数据集, 重复该实验过程, 并记录实验结果, 最后进行实验分析总结得出实验结论。

(2)为探索属性的个数对数据集大小与C4.5模型精度之间关系的影响, 使用一个数据集, 采用一个带筛选器的分类器。

对该数据集的属性进行随机抽样筛选, 并对处理后的训练集进行测试, 采用Cross-validation方法, 并记录测试结果。

数据挖掘实验报告

数据挖掘实验报告一、实验背景随着信息技术的飞速发展,数据呈爆炸式增长,如何从海量的数据中提取有价值的信息成为了一个重要的问题。

数据挖掘作为一种有效的数据分析手段,能够帮助我们发现数据中的隐藏模式、关系和趋势,为决策提供支持。

本次实验旨在通过实际操作,深入了解数据挖掘的基本原理和方法,并应用于具体的数据集进行分析。

二、实验目的1、熟悉数据挖掘的基本流程和常用技术。

2、掌握数据预处理、数据建模和模型评估的方法。

3、能够运用数据挖掘工具对实际数据集进行分析,并得出有意义的结论。

三、实验环境1、操作系统:Windows 102、数据挖掘工具:Python 中的 sklearn 库3、数据集:具体数据集名称四、实验步骤1、数据收集从数据源获取了实验所需的数据集,该数据集包含了数据的相关描述,如字段、记录数量等。

2、数据预处理数据清洗:检查数据中是否存在缺失值、异常值和重复值。

对于缺失值,根据数据特点采用了均值填充或删除的方法;对于异常值,通过数据可视化和统计分析进行识别,并进行了适当的处理;对于重复值,直接删除。

数据标准化:为了消除不同特征之间的量纲差异,对数据进行了标准化处理,使用了 sklearn 库中的 StandardScaler 类。

3、特征工程特征选择:通过相关性分析和特征重要性评估,选择了对目标变量有显著影响的特征。

特征提取:对于一些复杂的特征,采用了主成分分析(PCA)方法进行降维,减少了数据的维度,同时保留了主要的信息。

4、数据建模选择了具体的模型,如决策树、随机森林、逻辑回归等作为本次实验的建模方法。

使用训练集对模型进行训练,并调整模型的参数,以获得最佳的性能。

5、模型评估使用测试集对训练好的模型进行评估,采用了准确率、召回率、F1 值等指标来衡量模型的性能。

通过对不同模型的评估结果进行比较,选择性能最优的模型作为最终的模型。

五、实验结果与分析1、不同模型的性能比较列出了不同模型在测试集上的准确率、召回率和 F1 值,如下表所示:|模型|准确率|召回率|F1 值|||||||决策树|_____|_____|_____||随机森林|_____|_____|_____||逻辑回归|_____|_____|_____|从结果可以看出,随机森林模型在准确率和 F1 值上表现最优,因此选择随机森林模型作为最终的模型。

数据挖掘实例实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,数据挖掘技术逐渐成为各个行业的重要工具。

数据挖掘是指从大量数据中提取有价值的信息和知识的过程。

本实验旨在通过数据挖掘技术,对某个具体领域的数据进行挖掘,分析数据中的规律和趋势,为相关决策提供支持。

二、实验目标1. 熟悉数据挖掘的基本流程,包括数据预处理、特征选择、模型选择、模型训练和模型评估等步骤。

2. 掌握常用的数据挖掘算法,如决策树、支持向量机、聚类、关联规则等。

3. 应用数据挖掘技术解决实际问题,提高数据分析和处理能力。

4. 实验结束后,提交一份完整的实验报告,包括实验过程、结果分析及总结。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据挖掘库:pandas、numpy、scikit-learn、matplotlib四、实验数据本实验选取了某电商平台用户购买行为数据作为实验数据。

数据包括用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业等。

五、实验步骤1. 数据预处理(1)数据清洗:剔除缺失值、异常值等无效数据。

(2)数据转换:将分类变量转换为数值变量,如年龄、性别等。

(3)数据归一化:将不同特征的范围统一到相同的尺度,便于模型训练。

2. 特征选择(1)相关性分析:计算特征之间的相关系数,剔除冗余特征。

(2)信息增益:根据特征的信息增益选择特征。

3. 模型选择(1)决策树:采用CART决策树算法。

(2)支持向量机:采用线性核函数。

(3)聚类:采用K-Means算法。

(4)关联规则:采用Apriori算法。

4. 模型训练使用训练集对各个模型进行训练。

5. 模型评估使用测试集对各个模型进行评估,比较不同模型的性能。

六、实验结果与分析1. 数据预处理经过数据清洗,剔除缺失值和异常值后,剩余数据量为10000条。

2. 特征选择通过相关性分析和信息增益,选取以下特征:用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业。

数据挖掘6个实验实验报告

中南民族大学计算机科学学院《数据挖掘与知识发现》综合实验报告姓名年级专业软件工程指导教师学号序号实验类型综合型2016年12 月10 日一、使用Weka建立决策树模型1、准备数据:在记事本程序中编制ColdType-training.arff,ColdType-test.arff。

2、加载和预处理数据。

3、建立分类模型。

(选择C4.5决策树算法)4、分类未知实例二、使用Weka进行聚类1、准备数据:使用ColdType.csv文件作为数据集。

2、加载和预处理数据。

3、聚类(用简单K -均值算法)4、解释和评估聚类结果三、完成感冒类型的相关操作及相应处理结果1.加载了ColdType-training.arff文件后的Weka Explorer界面:2.感冒类型诊断分类模型输出结果:Sore-throat = Yes| Cooling-effect = Good: Viral (2.0)4.感冒类型诊断聚类结果:Cluster centroids:Cluster#Attribute Full Data 0 1(10) (5) (5) ================================================= Increased-lym Yes Yes No Leukocytosis Yes No Yes Fever Yes Yes Yes Acute-onset Yes Yes No Sore-throat Yes No Yes Cooling-effect Good Good Notgood Group Yes Yes NoTime taken to build model (full training data) : 0 seconds=== Model and evaluation on training set ===Clustered Instances0 5 ( 50%)1 5 ( 50%)Class attribute: Cold-typeClasses to Clusters:0 1 <-- assigned to cluster5 1 | Viral0 4 | BacterialCluster 0 <-- ViralCluster 1 <-- BacterialIncorrectly clustered instances : 1.010 %分析:由诊断聚类结果图可知,聚类中有两个簇Cluster0和Cluster1,分别对应Viral类和Bacterial类,但有一个实例被聚类到错误的簇,聚类错误率为10%。

weka数据挖掘实验报告

weka数据挖掘实验报告Weka数据挖掘实验报告。

一、实验目的。

本次实验旨在利用Weka软件进行数据挖掘实验,通过对给定数据集的分析和挖掘,探索数据之间的关系和规律,进而为实际应用提供决策支持和信息挖掘。

二、实验环境。

本次实验使用Weka软件进行数据挖掘实验,Weka是一款开源的数据挖掘软件,提供了丰富的数据挖掘和机器学习算法,并且具有直观的用户界面,方便用户进行数据挖掘实验。

三、实验步骤。

1. 数据导入,首先,我们将给定的数据集导入到Weka软件中,以便进行后续的数据挖掘分析。

2. 数据预处理,在导入数据后,我们需要对数据进行预处理,包括缺失值处理、异常值处理、数据平滑和数据变换等,以确保数据的质量和完整性。

3. 数据探索,接下来,我们对数据进行探索性分析,包括对数据的描述性统计分析、数据可视化和相关性分析,以了解数据的分布和特征之间的关系。

4. 数据建模,在完成数据探索后,我们将选择合适的数据挖掘算法,建立数据挖掘模型,并对模型进行训练和评估。

5. 模型评估,最后,我们将对建立的数据挖掘模型进行评估,包括模型的准确率、召回率、精确率和F1值等指标的评估,以确定模型的预测能力和泛化能力。

四、实验结果分析。

经过以上步骤的实验操作和分析,我们得到了如下的实验结果:1. 数据预处理,在数据预处理过程中,我们对数据进行了缺失值处理和异常值处理,确保了数据的完整性和准确性。

2. 数据探索,通过对数据的描述性统计分析和可视化分析,我们发现了数据之间的一些潜在关系和规律,为后续的数据建模提供了参考。

3. 数据建模,在选择了合适的数据挖掘算法后,我们建立了数据挖掘模型,并对模型进行了训练和评估,得到了较好的模型效果。

4. 模型评估,最后,我们对建立的数据挖掘模型进行了评估,得到了较高的准确率和召回率,表明模型具有较好的预测能力和泛化能力。

五、实验总结。

通过本次实验,我们深入学习了Weka软件的使用方法和数据挖掘的基本流程,掌握了数据挖掘的关键技术和方法。

数据挖掘实验二:实验报告

一、实验说明及目的1、使用真实数据进行数据挖掘实验,实验前进行数据的预处理。

2、训练一些不同类型的模型(具体类型可以讨论),与此同时分析哪些参数将对支持向量机(SVM)模型的性能产生影响。

3、通过实验来分析预测,将其他一些属性作为森林覆盖类型(Cover_Type 属性)的模型输入所产生的效果。

原始数据和数据的描述见网址/databases/covertype/covertype.html4、该实验将使学生理解完成一次真实数据预处理以及在数据挖掘过程中对属性、数据覆盖类型等方面的分析工程。

二、实验具体任务及其说明1、数据预处理工作(1)数据样本的生成:根据原始数据集生成统一的随机样本,样本数据量大约是原始数据量的10%,要求使用不重复抽样。

(任务1)(2)森林覆盖值的映射:变换不同种类的属性,将森林覆盖值2映射到0,将其他值所有森林覆盖值(1,3,4,5,6,7)映射到1。

(任务2)(3)数据预处理技巧:自行决定是否需要其他的数据预处理,注意某些Weka软件的使用技巧,如一些输入输出格式问题。

有时某些方法也做必要的调整,在某些情况下必须对数据有明确的预处理,做数据预处理时可以查看Weka软件针对该技巧或方法的描述。

(4)预处理说明:原始数据集非常大,具有7种类型的森林覆盖,检查整个数据集装载到Weka软件是发生的情况,如果机器内存耗尽,可以尽量增大堆的大小试试。

Weka使用指南对此有描述如何操作。

)2、模型训练工作(1)使用Weka分类器的评价工具进行预测。

使用Naïve Bayes 分类器对抽样样本进行训练以预测变换的森林覆盖类型(即是映射到种类0还是1),使用10层交叉验证来评估变换的模型,Weka软件中自带有对其分类器的表现评价器,使用自带的评价器来确定变换模型的精确度和变动率指标(ROC)。

(任务3)(2)对SVM模型进行训练:使用Weka软件的SMO分类器对支持向量机(SVM)模型进行训练,训练2种形式的SVM模型,一种是带多项式核函数的SVM模型,另一种是带径向基核函数(RBF Kernel)的SVM模型。

数据挖掘实验报告(两篇)2024

引言概述:数据挖掘是一项广泛应用于各个行业的技术,通过对大数据的处理和分析,可以发现隐藏在数据中的有价值信息。

本文是数据挖掘实验报告(二),将对具体的数据挖掘实验进行详细的阐述和分析。

本实验主要聚焦于数据预处理、特征选择、模型建立和评估等关键步骤,以增加对实验过程和结果的理解,提高实验的可靠性和准确性。

通过实验结果的分析和总结,可以帮助读者更好地理解数据挖掘的方法和技术,并为实际应用提供参考和指导。

正文内容:1. 数据预处理在进行数据挖掘之前,首先需要对原始数据进行预处理。

数据预处理的目的是清洗数据、处理缺失值和异常值等数据问题,以确保数据的质量和准确性。

在本实验中,我们采用了多种方法对数据进行预处理。

其中包括数据清洗、缺失值处理和异常值检测等。

具体的操作包括了数据去重、数据标准化、缺失值的填补和异常值的处理等。

2. 特征选择特征选择是数据挖掘的关键步骤之一,它的目的是从原始数据中选择出对问题解决有价值的特征。

在本实验中,我们通过使用相关性分析、方差选择和递归特征消除等方法,对原始数据进行特征选择。

通过分析特征与目标变量之间的关系,我们可以得出最有价值的特征,从而减少计算复杂度和提高模型准确性。

3. 模型建立模型建立是数据挖掘实验的核心步骤之一。

在本实验中,我们采用了多种模型进行建立,包括决策树、支持向量机、朴素贝叶斯等。

具体而言,我们使用了ID3决策树算法、支持向量机算法和朴素贝叶斯算法等进行建模,并通过交叉验证和网格搜索等方法选择最佳的模型参数。

4. 模型评估模型评估是对建立的模型进行准确性和可靠性评估的过程。

在本实验中,我们采用了多种评估指标进行模型评估,包括准确率、召回率、F1分数等。

通过对模型的评估,我们可以得出模型的准确性和可靠性,并进一步优化模型以达到更好的效果。

5. 结果分析与总结总结:本文是对数据挖掘实验进行详细阐述和分析的实验报告。

通过对数据预处理、特征选择、模型建立和评估等关键步骤的分析和总结,我们得出了对数据挖掘方法和技术的深入理解。

数据挖掘实验报告

数据挖掘实验报告一、实验背景数据挖掘作为一种从大量数据中发现未知、隐藏和有用信息的技术,正日益受到广泛关注。

在本次实验中,我们尝试运用数据挖掘方法对给定的数据集进行分析和挖掘,以期能够从中获取有益的知识和见解。

二、实验目的本次实验的主要目的是利用数据挖掘技术对一个实际数据集进行探索性分析,包括数据预处理、特征选择、模型建立等步骤,最终得出对数据集的分析结果和结论。

三、实验数据集本次实验使用的数据集为XXX数据集,包含了XXX个样本和XXX个特征。

数据集中涵盖了XXX方面的信息,包括但不限于XXX、XXX、XXX等。

四、实验步骤1. 数据预处理在数据挖掘过程中,数据预处理是至关重要的一步。

我们首先对原始数据进行清洗和处理,包括缺失值处理、异常值处理、数据转换等,以确保数据的准确性和可靠性。

2. 特征选择特征选择是指从所有特征中选择最具代表性和价值的特征,以提高模型的效果和准确性。

我们通过相关性分析、主成分分析等方法对特征进行筛选和优化,选取最具信息量的特征用于建模。

3. 模型建立在特征选择完成后,我们利用机器学习算法建立模型,对数据集进行训练和预测。

常用的模型包括决策树、支持向量机、神经网络等,我们根据实际情况选择合适的模型进行建模。

4. 模型评估建立模型后,我们需要对模型进行评估和验证,以确保模型的泛化能力和准确性。

我们采用交叉验证、ROC曲线、混淆矩阵等方法对模型进行评估,得出模型的性能指标和结果。

五、实验结果与分析经过一系列步骤的数据挖掘分析,我们得出了如下结论:XXX。

我们发现XXX,这表明XXX。

同时,我们还对模型的准确性和可靠性进行了评估,结果显示XXX,证明了我们建立的模型具有较好的预测能力和泛化能力。

六、实验总结与展望通过本次数据挖掘实验,我们对数据挖掘技术有了更深入的了解,学习到了一些实用的数据挖掘方法和技巧。

未来,我们将进一步探究数据挖掘领域的新技术和新方法,提高数据挖掘的应用能力和实践水平。

数据挖掘-决策树法-上机实验

某公司新推出一种理财产品,为了提高该产品的收益,围绕该产品是否会被购买,在人群中从年龄、收入、性别、结婚情况、理财能力、是否拥有房子、所在地区方面做分析。

步骤:

1.利用数据源中的“Excel”节点导入数据,并利用表格查看数据

2.用直方图体现所调查人群对该产品的响应度

从这个结果中看出将近85%的消费者不会购买该产品,为此必须对消费者进行针对性的销售。

3.随机的抽取80%的已调查人群,对他们的年龄、收入、性别、结婚情况、理财能力、

是否拥有房子、所在地区进行分析。

选择“类型”,并进行以下设置:

对这些特征做一个统计分析,选择“数据审核”节点,默认设置,执行。

4.利用“神经网络”节点来检测年龄、收入、性别、结婚情况、理财能力、是否拥有房

子、所在地区这些因素的重要性。

结果:

由着结果可知,地区分布、年龄和结婚情况是最重要的考察因素。

5.运用决策树法挖掘相关规则,选择C5.0节点,设置后执行

结果:

对该产品进行推销时主要围绕以下规则,有针对性地展开:在F区里,年龄在40岁左右的已婚中年人

6.分析所得规则的正确性,选取“分析”节点

结果:

整个实验的流程:。

数据挖掘实验四

班级:信管091 姓名:李洋威学号:090201125

指导老师:张冬丽实验类型:上机

实验四决策树模型分析三国武将特性

1. 实验目标

•使用SSAS进行决策树模型挖掘实验。

2. 实验内容

根据游戏三国志4武将数据,利用决策树分析,找出三国武将特性分布。

其中变量包含名称,统御、武力、智慧、政治、魅力、忠诚、国别,出身及身份。

(ch10-6.xls)

3. 实验步骤

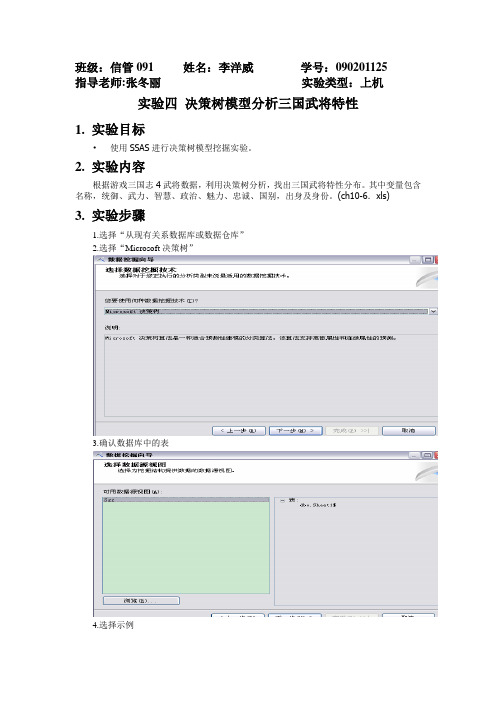

1.选择“从现有关系数据库或数据仓库”

2.选择“Microsoft决策树”

3.确认数据库中的表

4.选择示例

5.选择变量,其中分类变量为身份,而输入变量有统御、武力、智慧、政治、魅力、忠诚、国别、及出身。

6.确定变量的数据内容类型以及数据类型。

7.从数据模型查看器可以看到所生成的决策树模型,并可以从中看出重要影响变量,及其特征

8.根据分类矩阵生成预测值

4.实验思考

(1)对实验结果进行分析,并对预测结果的准确性进行评价

所建立的决策树模型所预测结果与实际分类的结果的预测正确率有65.33%,可见文官与军师在分割准则上具有一定程度的同质性。

(2)决策树方法的基本思想是什么?

对数据进行处理,利用归纳算法生成可读的规则和决策树,然后使用决策对新数据进行分析。

即通过一系列规则对数据进行分类的过程

5.实验心得

通过此次上机会使用SSAS对三国志武将特性进行决策树模型的分析,了解了决策树模型的基本用法。

上机实验报告

上机实验报告在大数据时代的今天,计算机科学和信息技术成为了无可忽视的领域。

为了更好地了解和掌握计算机和信息技术知识,我参加了一次上机实验。

本次实验主题是“数据挖掘算法在电子商务中的应用”。

实验首先让我们熟悉了解数据挖掘算法的基本概念和原理。

数据挖掘是一种通过自动或半自动的方式,在大规模的数据集中寻找有用的模式和信息的过程。

它可以帮助提取数据中的隐藏知识,对未来的决策和发展起到重要的指导作用。

在实验中,我们使用了常见的关联规则挖掘算法——Apriori算法。

这种算法可以用于识别不同属性之间的关联关系,从而发现隐藏在数据中的规律和规则。

我们通过编写代码,在给定的数据集中运行Apriori算法,探索其中的关联关系,并得出结论。

实验开始时,我先了解了数据集的内容和格式。

这个数据集包含了一个虚拟电子商务网站的销售记录,每条记录包括了顾客ID、购买日期和购买的商品列表。

我们的目标是找出在同一笔订单中经常一起购买的商品。

接下来,我编写了处理数据集的代码。

首先,我使用Python语言读取了数据集并将其转换成可操作的格式。

然后,我对购买记录进行了处理,筛选出满足条件的订单,即同时购买了多个商品的订单。

在实验过程中,我使用了Apriori算法的核心思想,即从频繁项集出发,逐步寻找更大的关联规则。

我通过迭代算法的方式,在数据集中不断寻找频繁项集,并记录它们的支持度(即出现的次数)。

然后,我根据设定的最小支持度阈值,筛选出高频的项集。

在寻找频繁项集后,我进一步进行规则挖掘。

具体来说,我计算了每个频繁项集的关联规则,并计算它们的置信度。

置信度表示了购买某个商品的顾客还会购买其他商品的概率。

通过设定最小置信度阈值,我找到了一些具有较高置信度的关联规则。

实验结果表明,该电子商务网站的顾客在购买时存在一定的购买习惯和偏好。

比如,购买了商品A的顾客有相当大的概率也会购买商品B。

这一发现对于电子商务企业来说是非常有益的,他们可以根据这些关联关系,调整营销策略、商品搭配等,以促进销售和提升用户体验。

数据挖掘实验报告实验原理

数据挖掘实验报告实验原理

数据挖掘是从大规模数据中挖掘出有价值的信息或知识的过程。

数据

挖掘的核心任务是基于数据发现隐藏在数据背后的模式、关联、趋势和异常,以便支持决策过程。

1.数据预处理:首先需要对原始数据进行清洗、去噪、去重和格式化

处理。

这一步骤的目的是为了减少数据的冗余性和噪声,提高数据的质量。

2.数据集划分:将清洗后的数据集划分为训练集和测试集。

训练集用

于构建数据挖掘模型,测试集用于评估模型的性能。

3.特征选择:选择最具有代表性和区分性的特征变量,以提高数据挖

掘算法的效果和效率。

特征选择可以通过统计方法、信息论方法和机器学

习方法来实现。

4.模型构建:根据实验任务的要求和数据的特点,选择合适的数据挖

掘算法来构建模型。

常用的数据挖掘算法包括聚类、分类、关联规则、异

常检测和预测等。

5.模型评估:通过评估模型在测试集上的性能指标来评估模型的质量。

常用的性能指标包括准确率、召回率、F1值和ROC曲线等。

6.结果分析:对挖掘结果进行解释和分析,以获取有用的信息和知识。

可以通过可视化工具和统计分析方法对挖掘结果进行展示和解释。

在实验过程中,需要选择合适的数据集、算法和评估指标,制定合理

的实验方案,并进行实验验证和结果分析。

同时,还需要掌握数据挖掘工

具和编程技巧,以便能够灵活地应用各种数据挖掘算法和方法。

总之,数据挖掘实验是通过实践应用数据挖掘技术,挖掘数据中隐藏的有用信息和知识的过程。

通过实验,可以深入理解数据挖掘的原理和方法,提高数据分析和解决实际问题的能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

数据挖掘上机实验1

实验内容:根据book1中数据(训练样本),用K-临近算法(k取5)建立分类模型,并验证分类效果,在此基础上,用所建立的模型对book2中的数据进行分类。

1、基本原理:测试数据点x分类为与它最接近的k个近邻中出现最多的那个类别。

K邻近算法从测试样本点x开始生长,不断的扩大区域,直到包含进k个训练样本点为止,并且把测试样本点x归为这最近的k个训练样本点中出现频率最大的类别。

2、算法步骤:a.依公式计算ltem与D1、D2……、Dj的相似度。

得到Sim(ltem,D1)、

Sim(ltem,D2)……、Sim(ltem,Dj)。

b.将Sim(ltem,D1)、Sim(ltem,D2)……、Sim(ltem,Dj)排序,

若是超过相似度门槛t则放入邻居案例集合NN。

c.自邻居案例集合NN中取出前k名,依多数决,得到ltem可能类别一.用K-临近算法(k取5)建立分类模型,验证分类效果

先建立分类模型,对建立的分类模型再用book1的数据进行验证,book1中含101个样品,32个属性,下列是比较结果表格:(其中样表示样品号,真表

从表格中可以得到,误判率=21/101=20.8%,此分类模型不是特别好

二.对book2的数据进行分类

用上文建立的分类模型,对book2中的数据进行分类,book2中共97个样品,32个属性,下列是比较结果表格:

误判率=25/9725.8%

附录:分类模型程序:Class[ones(78,1);ones(23,1)*2];

N1=size(a,1);

N2=size(b,1);

k=5;

for i=1:N2

for j=1:N1

d(i,j)=sqrt((b(i,:)-a(j,:))*(b(i,:)-a(j,:))'); end

end

for i=1:N2

class0=zeros(k,1);

[x,y]=sort(d(i,:));

c=y(1:k);

for ii=1:k

if class(c(ii))==1

class0(1)=class0(1)+1;

end

if class(c(ii))==2

class0(2)=class0(2)+1;

end

end

[u,v]=max(class0);

class_end(i)=v;

end。