DataStage Stage使用

DATASTAGE的介绍及基本操作

允许编辑和查看在ds中存储的内容。主要用于项目 管理或job的导入、导出、备份。

DataStage中的Administrator

默认使用Administator来指定常规的服务端,用来增加 或删除DataStage工程,并且可以设置工程的属性。 Administator也对于总库提供命令接口。

一,datastage的介绍

本章主要讲解ETL的概念,datastage的 介绍、组成及主要功能。

ETL概要

ETL包括数据抽取(Extract)、数据转换( Transform)以及数据加载(Load)3个阶 段。

一般而言,这三个过程中有二次落地( 生成中间文件)。

DS介绍:

• Ascential DataStage 是一套专门对多种操作数据源 的数据抽取、转换和维护过程进行简化和自动化, 并将其输入数据集市或数据仓库目标数据库的集成 工具。

• DataStage 能够处理多种数据源的数据,包括主机 系统的大型数据库、开放系统上的关系数据库和普 通的文件系统 。包括Oracle,Sybase,DB2,SQL Server,Teradata, FTP文件系统,文本文件等等。

• 数据清洗、转换、加载都可以在图形化工具里完成 ,同样可以灵活的被外部系统调度,提供专门的设 计工具来设计转换规则和清洗规则等,实现了增量 抽取、任务调度等多种复杂而实用的功能 。

本,datastage的很多版本都支持unix。

• DS Administrator

在服务端管理ds的项目和服务端操作。主要用于工 程的参数调整,变量设置,及command操作。

• DS Designer

建立ds的job并且编译执行的程序。主要用于job的 开发及编译。

datastage使用说明

用DataStage进行数据整合DataStage 的开发环境是基于C/S 模式的,通过DataStage Client 连接到DataStage Server 上进行开发。

这里有一点需要注意,DataStage Client 只能安装在Windows 平台上面。

而DataStage Server 则支持多种平台,比如Windows、Redhat Linux、AIX、HP-UNIX。

DataStage Client 有四种客户端工具。

分别是DataStage Administrator、DataStage Designer、DataStage Manager、DataStage Director。

接下来首先介绍这几种客户端工具在DataStage 架构中所处的位置以及它们如何协同工作来开发ETL Job 的,接着再分别详细介绍每个工具的功能。

图1 描述了IBM WebSphere DataStage 的整个系统架构。

DataStage 的客户端工具连接到DataStage Server 上进行ETL Job 的开发,DataStage Server 再与后台的数据库连接起来进行数据处理。

DataStage 的客户端工具之间的是一个相互合作的关系。

下面通过介绍ETL Job的开发过程来介绍他们之间的这种关系。

ETL Job开发流程1.用DataStage Administrator 新建一个项目;2.用DataStage Designer 连接到这个新建的项目上进行ETL Job的设计;3.用DataStage Director 对设计好的ETL Job设置运行的模式,比如多长时间运行一次ETL Job;4.用DataStage Manager 进行ETL Job的备份等。

图1:IBM WebSphere DataStage 架构图DataStage AdministratorDataStage Administrator 的主要功能有以下几个:1.设置客户端和服务器连接的最大时间。

datastage入门教程

简介DataStage 使用了Client-Server 架构,服务器端存储所有的项目和元数据,客户端DataStage Designer 为整个ETL 过程提供了一个图形化的开发环境,用所见即所得的方式设计数据的抽取清洗转换整合和加载的过程。

Datastage 的可运行单元是Datastage Job ,用户在Designer 中对Datastage Job 的进行设计和开发。

Datastage 中的Job 分为Server Job, Parallel Job 和Mainframe Job ,其中Mainframe Job 专供大型机上用,常用到的Job 为Server Job 和Parallel Job 。

本文将介绍如何使用Server Job 和Parallel Job 进行ETL 开发。

Server Job一个Job 就是一个Datastage 的可运行单元。

Server Job 是最简单常用的Job 类型,它使用拖拽的方式将基本的设计单元-Stage 拖拽到工作区中,并通过连线的方式代表数据的流向。

通过Server Job,可以实现以下功能。

1.定义数据如何抽取2.定义数据流程3.定义数据的集合4.定义数据的转换5.定义数据的约束条件6.定义数据的聚载7.定义数据的写入Parallel JobServer Job 简单而强大,适合快速开发ETL 流程。

Parallel Job 与Server Job 的不同点在于其提供了并行机制,在支持多节点的情况下可以迅速提高数据处理效率。

Parallel Job 中包含更多的Stage 并用于不同的需求,每种Stage 使用上的限制也往往大于Server Job。

Sequence JobSequence Job 用于Job 之间的协同控制,使用图形化的方式来将多个Job 汇集在一起,并指定了Job 之间的执行顺序,逻辑关系和出错处理等。

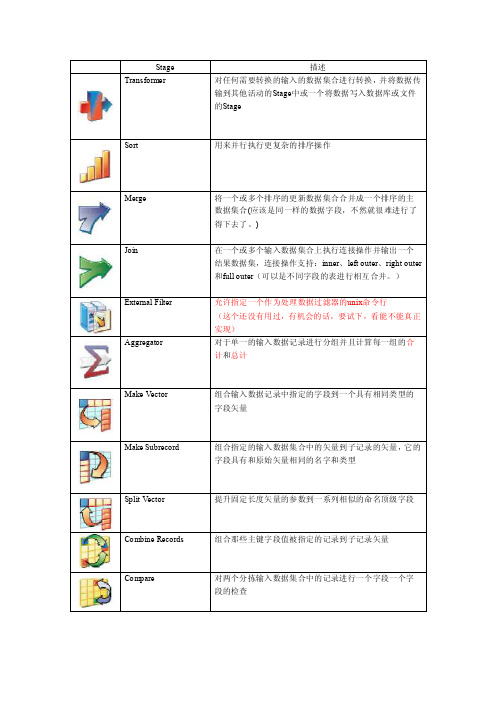

数据源的连接DataStage 能够直接连接非常多的数据源,应用范围非常大,可连接的数据源包括:•文本文件•XML 文件•企业应用程序,比如SAP 、PeopleSoft 、Siebel 、Oracle Application•几乎所有的数据库系统,比如DB2 、Oracle 、SQL Server 、Sybase ASE/IQ 、Teradata 、Informix 以及可通过ODBC 连接的数据库等•Web Services•SAS 、WebSphere MQServer JobServer Job 中的Stage 综述Stage 是构成Datastage Job 的基本元素,在Server Job 中,Stage 可分为以下五种:1.General2.Database3.File4.Processing5.Real Time本节中将介绍如何使用Datastage 开发一个Server Job。

DataStage客户端安装及使用文档

DataStage 客户端安装及使用文档1.客户端安装1.1 安装步骤解压客户端文件client_IA-suite.rar,完成后,进入目录,client_IA-suite,运行install.exe,会提示如下:选择英语,点击确定,安装时,最好关闭防火墙,选择要安装客户端的位置,点击NEXT:选择要安装的组件,点击NEXT:选择安装模式,点击NEXT:点击INSTALL后,开始安装:点击FINISH,安装完成。

安装完成后,在本机的HOSTS文件中需要配置一下:目录:C:\Windows\System32\drivers\etc在最后一行添加如下:# localhost name resolution is handled within DNS itself.# 127.0.0.1 localhost# ::1 localhost17.83.26.110(IP地址为服务器地址)ETL110(这个名字可以自己取)1.2 DataStage Client组件安装完成后有如下组件:1.Administrator Client用于创建DataStage 用户,创建,移动项目,设置清除标准的用户界面。

2.Director Client用来验证,计划时间,运行,监控DataStage 作业的用户界面。

3.Designer Client用来创建DataStage 应用(或作业)的设计接口。

每个作业都指定数据源,所需的转换和数据的目的地。

作业被编译成可执行的,由Director 计划,由Server 运行(主机作业被转移,在主机上运行)。

4.Datastage Manager用于存储和管理JOB 的元数据,使之可以在DataStage Designer 中再度被使用,包括库表定义、集中的转换程序等,并对工程备份和恢复。

2.组件使用2.1Administrator Client2.1.1登陆界面ETL110为刚刚我们在HOSTS中配置的名字,端口一般都是9080输入DOMAIN和账号密码完成后,点击DATASTAGE SERVER 右边的小三角,这时DATASTAGE会去验证用户名密码,成功后,会出来下拉框,这时证明已经联通了,选中一个SERVER,点击OK即可登陆2.1.2设置参数登陆成功后,界面如下:General页签:Projects页签:点击工程属性按钮后,显示界面如下:General 页签:Protect Projec t :设置项目为protected, 如果一个项目已经是protected,则按钮就显示为“Unprotect Project”Auto-purge of job log:每个Job 都对应一个log 文件,Job 的每一次运行都会产生新的log 附加到log 文件中,如果不及时清除无用的log,将会占用大量的空间,同时还会影响Job 的运行效率。

新教材DATASTAGE的介绍及基本操作.ppt

Datastage测试

• 问题一:

Datastage的Designer是用来建立和编译job、用来进行数据 的抽取、转换和加载即ETL。(Yes/No) 答案一: Yes,Designer使用拖拽的方式将设计元素(习惯上叫stage) 拖拽到设计区域中,经过建立和编译,Job就可以执行,用 来进行数据的抽取、转换和加载。

安装操作员版本的Datastage,需要有Datastage 的Director的许可。

一个工程关联着一个目录,这个工程目录用来存储jobs、 Datastage项目和元数据。在做任何操作前都要先打开这个 工程,即登录这个工程。

工程是自包含的很多的工程可以在同一时间被打开,在 各自单独的环境打开。可以在它们之间导入或导出项目。

多用户可以在同一时间使用一个工程中工作,但是 Datastage禁止在同一时间由多个用户访问同一个job。

• 3,到期时间。 • 4,授权代码。

在许可信息中,这个信息必须被正确输入 的。

课件

安装向导会指导通过以下步骤进行:

• 1,输入许可信息。 • 2,指定服务器的路径。 • 3,选择程序的文件夹。 • 4,创建一个新的工程或升级已经存在的工

程。

课件

安装Datastage

课件

首先安装Datastage Server端,鼠标点击 软件会自动安装,安装过

• 在Windows系统中安装Datastage服务端。 • 建立一个Datastage的工程。 • 安装Datastage的客户端。

课件

Datastage 的服务端要首先安装,之后才 可以安装Datastage 客户端,服务端能都安 装在WinNT、Windows2000或者UNIX系统中, 这个模块将介绍在Windows环境下进行安装。

DATASTAGE使用实用指南

DATESTAGE 使用实用指南1.DataStage官方文档学习笔记1.1通过右键添加link鼠标右键点击起始stage,按住右键移动鼠标到目标stage。

还有一种方法就是把鼠标放在起始stage的边缘等到变为一个小圆圈里面有一个叉的时候拖动鼠标到目标stage。

1.2DataStage中默认和隐式类型转换时注意的问题当从源向目标映射数据时,如果类型不一致,对于有些类型我们需要在modify或transfomer stage中通过函数进行转换,对于有些系统会自动完成类型转换,在类型转换过程中,注意以下几点:1 在变长到固定长度字符串的默认转换中,parallel jobs用null(ASCII 0)字符来填充剩余长度。

联系到前面做的一个parallel job,当目标是变长时(当时源也是变长,但是好像源的精度要小些),但是字符串实际的长度没有指定的变长那么长的话,系统会自动用空格(ASCII 20)来填充(具体在哪个stage 填充的不知),而且环境变量APT_STRING_PADCHAR的默认值也是空格(ASCII 20)。

2 通过环境变量APT_STRING_PADCHAR可以改变默认的填充字符null(ASCII 0)。

注:联系上面两点,感觉文档讲的与实际不符,难道我们项目的administrator改变了该环境变量的默认值?3 有个PadString 函数可以用来用指定的字符来填充一个变长的字符串到指定的长度。

这个函数的参数不能使固定长度字符串,如果是固定长度的先转化为变长。

1.3Copy Stage作为占位符在job开发中,当你暂时不知道该使用哪个stage时,可以使用copy stage作为占位符,注意不要把Force 属性设为True,在不把Force设为True时,复制将在运行时进行优化。

使用Schema file来指定meta data1 可以通过列定义和schema file两种方式来指定meta data,值得注意的一点是Note that, if you usea schema file, you should ensure that runtime column propagation is turned on. Otherwise the column definitions specified in the stage editor will always override any schema file.即,如果想通过schema file来指定meta data,必须勾上runtime column propagation,否则总是使用列定义来作为meta data。

Datastage介绍及示例

Datastage介绍及示例1 Datastage 简介Datastage包含四大部件:Administrator、Manager、Designer、Director。

1.用DataStage Administrator 新建或者删除项目,设置项目的公共属性,比如权限。

2.用DataStage Designer 连接到指定的项目上进行Job的设计;3.用DataStage Director 负责job的运行,监控等。

例如设置设计好的job的调度时间。

4.用DataStage Manager 进行Job的备份等job的管理工作。

2 设计一个JOB示例2.1 环境准备目标:将源表中数据调度到目标表中去。

1 数据库:posuser/posuser@WHORADB , ip: 192.168.100.882 源表:a_test_from3 目标表:a_test_to两者表结构一样,代码参考:create table A_TEST_FROM(ID INTEGER not null,CR_SHOP_NO CHAR(15),SHOP_NAME VARCHAR2(80),SHOP_TEL CHAR(20),YEAR_INCOME NUMBER(16,2),SHOP_CLOSE_DATE DATE,SHOP_OPEN_DATE DATE);alter table A_TEST_FROMadd constraint TEST primary key (ID);4. 示例数据:insert into A_TEST_FROM (ID, CR_SHOP_NO, SHOP_NAME, SHOP_TEL, YEAR_INCOME, SHOP_CLOSE_DATE, SHOP_OPEN_DATE)values (24402, '105420580990038', '宜昌市云集门诊部', '82714596 ', 1000, to_date('01-05-2008', 'dd-mm-yyyy'), to_date('01-06-2008', 'dd-mm-yyyy'));insert into A_TEST_FROM (ID, CR_SHOP_NO, SHOP_NAME, SHOP_TEL, YEAR_INCOME, SHOP_CLOSE_DATE, SHOP_OPEN_DATE)values (24403, '105420559982198', '于志良', '82714596 ', 2000, to_date('02-05-2008', 'dd-mm-yyyy'), to_date('02-06-2008', 'dd-mm-yyyy'));insert into A_TEST_FROM (ID, CR_SHOP_NO, SHOP_NAME, SHOP_TEL, YEAR_INCOME, SHOP_CLOSE_DATE, SHOP_OPEN_DATE)values (24404, '105420556410012', '阳光儿童广场', '82714596 ', 3000, to_date('03-05-2008', 'dd-mm-yyyy'), to_date('03-06-2008', 'dd-mm-yyyy'));insert into A_TEST_FROM (ID, CR_SHOP_NO, SHOP_NAME, SHOP_TEL, YEAR_INCOME, SHOP_CLOSE_DATE, SHOP_OPEN_DATE)values (24405, '105420580620033', '秭归县医疗中心', '82714596 ', 4000, to_date('04-05-2008', 'dd-mm-yyyy'), to_date('04-06-2008', 'dd-mm-yyyy'));insert into A_TEST_FROM (ID, CR_SHOP_NO, SHOP_NAME, SHOP_TEL, YEAR_INCOME, SHOP_CLOSE_DATE, SHOP_OPEN_DATE)values (24406, '105420559120063', '同德医药零售北门连锁店', '82714596 ', 5000, to_date('05-05-2008', 'dd-mm-yyyy'), to_date('05-06-2008', 'dd-mm-yyyy'));2.2 打开Designer任务:打开datastage designer,连接datastage服务器1.双击桌面datastage designer图标。

DATASTAGE的介绍及基本操作

DATASTAGE的介绍及基本操作DataStage的基本操作包括设计和开发数据集成任务、管理数据集成任务的执行、监控任务的运行状态和性能等。

下面将分别介绍DataStage 的设计和开发、任务管理和监控等方面的基本操作。

1.设计和开发数据集成任务:- 创建项目:在DataStage中创建一个新的项目,并指定项目的名称和存储位置。

-创建作业流:在项目中创建一个新的作业流,并指定作业流的名称和描述。

-添加源和目标:将源数据和目标数据的连接器添加到作业流中,并配置其连接属性。

-设计转换:使用图形化工具将数据转换逻辑以节点的方式添加到作业流中。

可以使用预定义的转换函数、过滤器和聚合函数,并自定义转换规则。

-配置作业参数:为作业流设置参数,例如源数据的路径、目标数据的路径等。

-配置作业调度:定义作业流的调度规则,例如每日、每周或每月执行一次。

2.任务管理:- 启动任务:在DataStage的用户界面中选择要执行的作业流,并单击启动按钮来启动任务。

-监控任务状态:查看任务的运行状态,例如正在运行、已完成或已失败。

-管理调度:可以根据需要修改任务的调度规则,例如修改任务的执行时间或频率。

-管理依赖关系:设置任务之间的依赖关系,例如一个任务的输出作为另一个任务的输入,确保任务按照正确的顺序执行。

3.监控任务:- 实时监控:在DataStage的用户界面中查看任务的实时执行情况,包括输入/输出数据的数量、处理速度、错误记录等。

-查看日志:查看任务执行的详细日志,包括每个节点的执行情况、输入/输出数据的详细信息、转换规则的执行结果等。

-分析性能:分析任务的性能指标,例如任务的执行时间、内存使用情况、CPU利用率等,以优化任务的运行效率。

DataStage还提供了其他高级功能,例如数据质量检查、数据变化捕获和增量加载等。

此外,DataStage与其他数据集成工具和平台的集成也是可能的,例如与大数据处理框架Hadoop、数据仓库工具Teradata等的集成。

Datastage 配置操作步骤

1部署软件环境DB服务器:22.4.8.7DB客户端:22.4.8.10,22.4.8.11,22.4.8.12,22.4.8.13DataStage主服务器:22.4.8.11DataStage备份服务器:22.4.8.13DataStage节点:22.5.8.10,22.5.8.122创建用户为每台机器创建dstage组和dsadm用户➢运行smit命令,启动管理界面➢在安装机器上创建dstage组设置ADMINISTRATIVE USER 选项为true设置GID设为300➢创建用户dsadm设置主属为dstage,设置ADMINISTRATIVE USER 选项为true;设置UID设为300;设置Primary GROUP,Group SET,ADMINISTRATIVE GROUPS:均为dstage;设置Soft FILE size [-1] (无限制)设置Hard FILE size [-1] (无限制)3修改系统参数调整每台机器的最大进程数查看用户进程最大数目:lsattr -El sys0|grep maxuproc如:修改用户进程最大数目:注意:要调整每个Datastage节点的最大进程数用root用户登陆,键入即可。

chdev -l sys0 -a maxuproc=40964 DataStage安装4.1上传DataStage介质到服务器上将介质拷贝到终端上,然后ftp到22.4.8.11和22.4.8.13上,将介质放在/Ascential.media 目录下,并赋上所有权限:chmod -R 777 /Ascential.media4.2安装DataStage4.2.1进入/Ascential.media,运行sh ./install.sh –admin dsadm,中间安装过程请参考上线文档,在安装过程中创建工程ETL_ODS.4.2.2配置dsadm用户.profile环境变量,增加如下内容22.4.8.11:# The following three lines have been added by IBM DB2 instance utilities.if [ -f /home/db2inst1/sqllib/db2profile ]; then. /home/db2inst1/sqllib/db2profilefi#ds envexport ETLPLUS_HOME=/home/dsadmexport DSHOME=/home/dsadm/Ascential/DataStage/DSEngineexport APT_ORCHHOME=/home/dsadm/Ascential/DataStage/PXEngineexport DB2HOME=/home/db2inst1/sqllibexportPATH=$PATH:$DSHOME/bin:$DB2HOME/include:/home/dsadm/Ascential/DataStage/ PXEngine.753.1/libexportLIBPATH=$LIBPATH:$DSHOME/lib:$APT_ORCHHOME/lib:/home/dsadm/Ascential/Dat aStage/PXEngine.753.1/lib. $DSHOME/dsenv22.4.8.13:# The following three lines have been added by IBM DB2 instance utilities.if [ -f /home/db2inst1/sqllib/db2profile ]; then. /home/db2inst1/sqllib/db2profilefi#ds envexport ETLPLUS_HOME=/home/dsadmexport DSHOME=/home/dsadm/Ascential/DataStage/DSEngineexport APT_ORCHHOME=/home/dsadm/Ascential/DataStage/PXEngineexport DB2HOME=/home/db2inst1/sqllibexportPATH=$PATH:$DSHOME/bin:$DB2HOME/include:/home/dsadm/Ascential/DataStage/ PXEngine.753.1/libexportLIBPATH=$LIBPATH:$DSHOME/lib:$APT_ORCHHOME/lib:/home/dsadm/Ascential/Dat aStage/PXEngine.753.1/lib. $DSHOME/dsenv22.4.8.10:export DSHOME=/home/dsadm/Ascential/DataStage/DSEngineexport APT_ORCHHOME=/home/dsadm/Ascential/DataStage/PXEngineexport DB2DIR=/opt/IBM/db2/V9.5export DB2INSTANCE=db2inst1export INSTHOME=/home/db2inst1exportPATH=$PATH:$INSTHOME/sqllib/bin:$INSTHOME/sqllib/adm:$INSTHOME/sqllib/mi sc:$APT_ORCHHOME/lib:$APT_ORCHHOME/binexportDB2PATH=$INSTHOME/sqllib/bin:$INSTHOME/sqllib/adm:$INSTHOME/sqllib/misc exportLIBPATH=$LIBPATH:$DB2DIR/lib:$INSTHOME/sqllib/lib:$APT_ORCHHOME/libexport ETLPLUS_HOME=/home/dsadm22.4.8.12:export DSHOME=/home/dsadm/Ascential/DataStage/DSEngineexport APT_ORCHHOME=/home/dsadm/Ascential/DataStage/PXEngineexport DB2DIR=/opt/IBM/db2/V9.5export DB2INSTANCE=db2inst1export INSTHOME=/home/db2inst1exportPATH=$PATH:$INSTHOME/sqllib/bin:$INSTHOME/sqllib/adm:$INSTHOME/sqllib/mi sc:$APT_ORCHHOME/lib:$APT_ORCHHOME/binexportDB2PATH=$INSTHOME/sqllib/bin:$INSTHOME/sqllib/adm:$INSTHOME/sqllib/misc exportLIBPATH=$LIBPATH:$DB2DIR/lib:$INSTHOME/sqllib/lib:$APT_ORCHHOME/libexport ETLPLUS_HOME=/home/dsadm22.4.8.7:# The following three lines have been added by IBM DB2 instance utilities. if [ -f /home/db2inst1/sqllib/db2profile ]; then. /home/db2inst1/sqllib/db2profilefiexport ETLPLUS_HOME=/progexport DSHOME=/home/dsadm/Ascential/DataStage/DSEngineexport APT_ORCHHOME=/home/dsadm/Ascential/DataStage/PXEngineexport DB2DIR=/opt/IBM/db2/V9.5export DB2INSTANCE=db2inst1export INSTHOME=/home/db2inst1exportPATH=$PATH:$INSTHOME/sqllib/bin:$INSTHOME/sqllib/adm:$INSTHOME/sqllib/mi sc:$APT_ORCHHOME/lib:$APT_ORCHHOME/binexportDB2PATH=$INSTHOME/sqllib/bin:$INSTHOME/sqllib/adm:$INSTHOME/sqllib/misc exportLIBPATH=$LIBPATH:$DB2DIR/lib:$INSTHOME/sqllib/lib:$APT_ORCHHOME/libexport DateInfoPath=/gpfsf/DateInfoPath5配置rsh环境。

Datastage产品开发使用指南

Datastage产品开发使用指南目录目录 (I)1. 引言 (1)2. 常用STAGE使用说明 (1)2.1.S EQUENTIAL F ILE S TAGE (1)2.2.A NNOTATION (4)2.3.C HANGE C APTURE S TAGE (5)2.4.C OPY S TAGE (7)2.5.F ILTER S TAGE (8)2.6.F UNNEL S TAGE (9)2.7.T ANSFORMER S TAGE (10)2.8.S ORT S TAGE (11)2.9.L OOK U P S TAGE (12)2.10.J OIN S TAGE (12)2.11.M ERGE S TAGE (14)2.12.M ODIFY S TAGE (15)2.13.D ATA S ET S TAGE (16)2.14.F ILE S ET S TAGE (17)2.15.L OOKUP F ILE S ET S TAGE (19)2.16.O RACLE E NTERPRISE S TAGE (21)2.17.A GGREGATOR S TAGE (22)2.18.R EMOVE D UPLICATES S TAGE (24)2.19.C OMPRESS S TAGE (25)2.20.E XPAND S TAGE (26)2.21.D IFFERENCE S TAGE (27)2.22.C OMPARE S TAGE (29)2.23.S WITCH S TAGE (30)2.24.C OLUMN I MPORT S TAGE (31)2.25.C OLUMN E XPORT S TAGE (33)3. DATASTAGE ADMINISTRATOR常用配置 (35)3.1.设置T IME O UT时间 (35)3.2.设置P ROJECT的属性 (36)3.3.更新D ATA S TAGE S ERVER的L ICENSE和本地C LIENT的L ICENSE (37)4. DATASTAGE MANAGER使用 (37)4.1.导入导出J OB及其它组件 (37)4.2.管理配置文件 (39)5. DATASTAGE DIRECTOR使用 (40)5.1.察看J OB的状态,运行已经编译好的J OB (40)5.2.将编译好的J OB加入计划任务 (43)5.3.监控J OB的运行情况 (44)1.引言DataStage EE的开发主要由DataStage Designer完成。

DataStage进行数据整合 第 2 部分

在本文中,您将看到一个同时处理多个数据源和目标的 ETL Job 的开发过程,并了解DataStage 中 Container 和 Job Sequence 的用法。

引言系列的第一部分介绍了 DataStage 的基本功能。

本文将从以下几个方面深入介绍 IBM WebSphere DataStage 在数据整合方面的强大功能。

1. Job Sequence 的用法2. DataStage Container 的用法3.开发一个同时处理多个数据源和目标的 ETL JobJob Sequence 的用法在用 IBM WebSphere DataStage 进行数据整合的过程中,我们一般会开发很多个单独的 ETL Job 去完成特定的逻辑功能,这些 ETL Job 之间的运行顺序往往是有限制的,那么我们如何处理 ETL Job 之间的这种依赖关系呢?IBM WebSphere DataStage 提供了处理这种问题的方法,那就是使用 Job Sequence。

使用 Job Sequence 可以方便的处理 ETL Job 之间的依赖以及运行顺序问题。

下面我们通过开发一个简单的 Job Sequence 来演示 Job Sequence 的用法。

开发一个 Job Sequence 和开发一个 ETL Job 的方法是类似的,都是用 DataStage Designer 来开发。

我们将要开发的这个 Job Sequence 的功能是实现两个 ETL Job 的顺序执行,并且在第一个 ETL Job 运行成功的情况下第二个 ETL Job 才开始执行。

因此我们必须先准备两个 ETL Job,这两个 ETL Job 的名字分别为 Job1 和 Job2。

开发步骤1.打开 DataStage Designer。

如下图所示,从下拉列表中选择 Job Sequence。

这样就会新建一个 Job Sequence;图 1:新建 Job Sequence2. 新建的 Job Sequence 如下图所示。

datastage教程

1、【第一章】datastage简介与工作原理1、简介数据中心(数据仓库)中的数据来自于多种业务数据源,这些数据源可能是不同硬件平台上,使用不同的操作系统,数据模型也相差很远,因而数据以不同的方式存在不同的数据库中。

如何获取并向数据中心(数据仓库)加载这些数据量大、种类多的数据,已成为建立数据中心(数据仓库)所面临的一个关键问题。

针对目前系统的数据来源复杂,而且分析应用尚未成型的现状,专业的数据抽取、转换和装载工具DataStage是最好的选择。

Websphere DataStage 是一套专门对多种操作数据源的数据抽取、转换和维护过程进行简化和自动化,并将其输入数据集市或数据中心(数据仓库)目标数据库的集成工具。

DataStage 能够处理多种数据源的数据,包括主机系统的大型数据库、开放系统上的关系数据库和普通的文件系统等,以下列出它所能处理的主要数据源:大型主机系统数据库:IMS,DB2,ADABAS,VSAM 等开放系统的关系数据库:Informix,Oracle,Sybase,DB2,Microsoft SQL Server等ERP 系统:SAP/R3,PeopleSoft系统等,普通文件和复杂文件系统,FTP 文件系统,XML等IIS,Netscape,Apache等Web服务器系统Outlook等Email系统。

DataStage 可以从多个不同的业务系统中,从多个平台的数据源中抽取数据,完成转换和清洗,装载到各种系统里面。

其中每步都可以在图形化工具里完成,同样可以灵活的被外部系统调度,提供专门的设计工具来设计转换规则和清洗规则等,实现了增量抽取、任务调度等多种复杂而实用的功能。

其中简单的数据转换可以通过在界面上拖拉操作和调用一些DataStage 预定义转换函数来实现,复杂转换可以通过编写脚本或结合其他语言的扩展来实现,并且DataStage 提供调试环境,可以极大提高开发和调试抽取、转换程序的效率。

DataStage Stage使用

Funnel阶段Funnel阶段是一个处理阶段。

它将多个输入数据集复制到单个数据集,该操作对于将单独数据集合并到单个大型数据集而言非常有用。

该阶段可以有众多输入链接和一个输出链接Funnel阶段能够以下列三种方式之一运行:1、连续传送以不可保证顺序合并输入数据的记录。

它依次从每个输入链接获取一条记录。

如果输入链接上的数据不可用,那么该阶段会跳至下一个链接,而不是等待。

2、排序传送按照一个或多个键列的值定义的顺序合并输入记录,输出记录的顺序由这绡排序键确定。

3、顺序将第一个输入数据集中的所有记录复制到输出数据集,然后将第二个输入数据集中的所有记录复制到输出数据集,依此类推。

对于所有方法,所有数据数据集的元数据都必须椒相同的。

排序传送方法对于其输入数据有一些特定要求。

所有输入数据集都必须根据Funnel操作的键列进行排序。

通常,排序传送操作的所有输入数据集在排序之前都是散列分区的(选择自动分区方法将确保完成这一操作).散列分区可确保具有相同键列值的所有记录都位于同一分区中,以便在同一个节点上处理。

如果在Funnel阶段之前在单独的阶段上执行排序和分区,那么必须保留该分区排序传送操作允许您设置一个主键和多个辅键以确定将输出的记录的顺序。

Funnel阶段:快速路径InfoSphere DataStage有许多缺省设置,这表示您能够载作业中轻松包含Funnel阶段。

本部分指定了要使Funnel阶段运行所需的最少步骤。

InfoSphere DataStage提供了多样化的用户界面,且提供了许多快捷方式供您达到特定目标,本部分描述了基本方法。

要使用Funnel阶段:1、在“阶段”页面的属性选项卡中,指定“传送类型”。

“连续传送”为缺省值,但也可以选择“顺序”或“排序传送”。

如果选择使用“排序传送”方法,则还需要指定对数据进行排序所依据的键。

可以重复使用键属性来指定组合键。

2、如果使用“顺序”方法,请在“阶段”页面的“链接排序”选项卡中,指定合并数据集的顺序。

datastage综合使用参考手册

Ascential DataStage Enterprise Edition 综合使用参考手册目录目录 (I)1. 引言 (1)1.1.编写目的 (1)1.2.帮助使用 (1)2. 产品概述 (2)2.1.A DVANCED D EVELOPMENT AND M AINTENANCE (2)2.2.C OMPLETE D EVELOPMENT E NVIRONMENT (3)2.3.H IGHLY S CALABLE A RCHITECTURE (6)2.4.E ND-TO-E ND E NTERPRISE M ETA D ATA (7)3. 安装 (8)3.1.S ERVER安装 (8)3.1.1. Server安装前准备 (8)3.1.2. Server安装步骤 (9)3.1.3. 验证DataStage的安装 (22)3.1.4. Server启动和停止 (23)3.2.C LIENT安装 (24)4. 常规应用 (24)4.1.常用组件使用方法 (24)4.1.1. Sequential file (24)4.1.2. Annotation (27)4.1.3. Change Capture Stage (29)4.1.4. Copy Stage (31)4.1.5. Filter Stage (32)4.1.6. Funnel Stage (33)4.1.7. Tansformer Stage (34)4.1.8. Sort Stage (35)4.1.9. LookUp Stage (36)4.1.10. Join Stage (36)4.1.11. LookUp Stage 和Join Stage的区别 (38)4.1.12. Merge Stage (38)4.1.13. Modify Stage (39)4.1.14. Data Set Stage (40)4.1.15. File Set Stage (41)4.1.16. Lookup File Set Stage (43)4.1.17. Oracle Enterprise Stage (45)4.1.18. Aggregator Stage (46)4.1.19. Remove Duplicates Stage (48)4.1.20. Compress Stage (49)4.1.21. Expand Stage (50)4.1.22. Difference Stage (51)4.1.23. Compare Stage (53)4.1.24. Switch Stage (54)4.1.25. Column Import Stage (55)4.1.26. Column Export Stage (57)4.2.常用数据库的连接 (59)4.2.1. Informix数据库连接 (59)4.2.2. Oracle数据库连接 (60)5. 高级应用 (62)5.1.D ATA S TAGE BASIC接口 (62)5.2.自定义S TAGE T YPE (62)5.2.1. Wrapped Stage (62)5.2.2. Build Stage (67)5.2.3. Custom Stage (75)5.3.性能调优 (75)5.3.1. 优化策略 (75)5.3.2. 关键问题分析 (79)5.3.3. 并行度 (80)5.3.4. 处理建议 (80)5.3.5. 其它 (80)5.3.6. 机器的对称性 (81)5.3.7. 并行调度测试说明: (81)6. 开发经验技巧汇总 (82)6.1.1. 问题 (82)1.引言1.1.编写目的IBM DataStage作为项目主要使用的ETL开发工具,在项目中得到了比较充分的应用,对IBM DataStage产品方方面面的功能,都有所涉及。

DataStage使用说明

目录1.安装 (2)2.DataStage Administrator (3)2.1对Project的管理 (3)2.2修改DataStage Server的License (5)3.DataStage Designer篇Job的定义 (5)3.1登录 (5)3.2建立Job (6)3.3界面说明 (6)3.4 ETL过程定义 (7)3.4.1数据库到数据库 (7)3.4.2 Job的调试 (17)3.4.3文件到数据库 (19)3.4.4远程数据抽取 (20)3.4.5多进程联合运行(Job Sequencer) (23)3.4.6数据聚合的处理 (25)3.4.7自定义程序 (27)4.DataStage Director篇Job的运行 (31)4.1登录 (31)4.2运行Job (31)4.3 Job的运行时间定义 (31)4.4日志的查看 (33)1.安装DataStage Server端的安装,如果在Windows操作系统上安装,需要NTFS格式的分区。

安装完毕将启动DataStage Engine Resource Service,DataStage Telnet Service两个服务。

DataStage Client在安装的过程中,会提示建立一个Project,建立了Project之后,Client就可以连接到此Project,当然也可用选择其他Server端的Project。

安装完毕,将产生4个各司其职的模块:DataStage Administrator,DataStage Director,DataStage Designer,DataStage Manager。

DataStage Adminstrator是对DataStage Server的一些参数、Project进行管理的模块。

DataStage Designer是一个界面性的设计平台,实现在创建执行数据集成任务“Job”的同时,对数据流和转换过程创建一个可视化的演示。

datastage给表字段添加注释

datastage给表字段添加注释DataStage是一种强大的数据集成工具,它可以帮助企业将数据从不同的源系统中提取、转换和加载到目标系统中。

在数据集成过程中,为表字段添加注释是一项非常重要的任务。

本文将介绍为什么需要为表字段添加注释以及如何使用DataStage来实现这一目标。

为表字段添加注释的重要性不言而喻。

首先,注释可以提供关于字段含义和用途的重要信息。

对于新加入团队的开发人员或数据分析师来说,这些注释可以帮助他们更好地理解数据模型和表结构。

此外,注释还可以提供关于字段的约束条件、数据类型和长度等详细信息,从而帮助开发人员编写更准确、高效的代码。

在DataStage中为表字段添加注释非常简单。

首先,我们需要打开DataStage设计工具,并选择要添加注释的作业或项目。

然后,在作业或项目中找到需要添加注释的表,并右键单击该表以打开其属性窗口。

在属性窗口中,我们可以看到该表的所有字段及其相关属性。

要为字段添加注释,只需在“描述”或“备注”栏中输入相应内容即可。

这些描述将会被保存在元数据中,并在后续使用该表时显示出来。

除了手动添加注释外,DataStage还提供了一种自动添加注释的功能。

在设计工具中,我们可以使用“元数据管理器”来导入和管理元数据。

通过导入源系统的元数据,DataStage可以自动为表字段添加注释。

这种自动化的方式不仅可以节省时间和精力,还可以确保注释的一致性和准确性。

在实际应用中,为表字段添加注释是一个持续的过程。

随着业务需求的变化和数据模型的演进,我们可能需要更新或修改字段的注释。

DataStage提供了灵活的元数据管理功能,使我们能够轻松地对表字段进行修改和更新。

总结起来,为表字段添加注释是一个非常重要且必要的任务。

通过使用DataStage,我们可以轻松地为表字段添加注释,并确保这些注释与实际数据模型保持一致。

这将帮助团队成员更好地理解数据结构,并编写更高效、准确的代码。

使用DataStageXMLStage转换XML

使用DataStage XML Stage 转换XML作为InfoSphere Information Server 8.5 版本的一部分,InfoSphere DataStage 通过称为XML Stage 的新层次转换功能进行了增强,其提供本机XML 架构支持以及强大的XML 转换功能。

这些功能都基于独一无二的最先进技术,该技术允许您从关系形式分析和编写任何复杂的XML 结构和将这些结构分析和编写为关系形式,以及分析和编写为不同的层次形式。

此新技术不同于其他已知的XML 工具,具有直观的分步用户界面和强大的执行能力,可以使用有限内存并行处理任何文件大小(进行了超过20GB 的测试)。

XML Stage 具有与市场上的其他工具不同的独特功能,例如控制和配置执行的验证级别的能力(范围从严格到最小程度的验证),以及并行解析单个大文件的能力。

XML Stage 不要求任何语言技能,例如XSLT 或XQuery,即便在其没有完成时也允许您即时调试并测试转换。

这些新的功能取代了以前的DataStage XML Stage:XML 输入、XML 输出以及XML 转换器。

在使用这些阶段的以前作业将继续运行时,您应该使用新的功能,因为其具有优越的生产率和性能。

XML Stage 文档提供了介绍性信息,同时还提供了简单示例,说明每个转换步骤的使用。

您应该使用该文档作为您了解工具并执行简单解析和转换的第一信息源。

本文是系列文章的第一篇,将会帮助您了解并利用IBM InfoSphere Datastage 8.5 中的新功能。

第 1 部分介绍了8.5 版中的新功能,而后演示了一些用于导入元数据、将XML 文档解析到关系数据以及从关系数据编写XML 文档并将它们插入DB2 pureXML 的几个基本方案。

方案一:将XML 架构文件导入InfoSphere Information Server将XML 架构文件导入Information Server 是创建XML 转换的先决条件。

DataStage 日志记录使用规范

DATASTAGE日志记录使用规范一、设计目的在以往的datastage开发过程中,通过oracle enterprise stage 进行数据入库的时候,因为是使用的datastage的入库技术,即直接使用insert语句插入数据,所以无法在数据库中记录插入的记录条数和reject的记录条数.在这种情况下,为了能够统计加载资料量,我们使用先调用shell命令统计job日志中的加载记录条数,再通过调用存储过程把记录条数记载入数据库的日志表的方式来实现统计加载记录条数的目的二、相关程序a)命令行程序名称:sp_log.sh功能:查询job日志中对应sequence下所有job的插入目标表的记录条数,并通过调用oracle存储过程把统计出的记录条数加加载数据库日志表;输入参数: DSPROJECT datastage项目名称DSJOBNAME datastage sequence job 名称WORKDA TE 加载日期,用于插入日志表WORK_DATE列DBNAME 加载数据库连接名称DBUSER 加载数据库用户名称DBPWD 加载数据库用户密码输出参数: OUTPUT 加载成功失败标志b)存储过程名称:sp_log功能:使用输入参数插入stat_error_log表,保存日志记录输入参数: in_work_date 加载日期,插入日志表WORK_DATE列in_proc_name 加载程序名称,插入日志表PROC_NAME列in_table_name 加载目标表名称,插入日志表TABLE_NAME列in_proc_type 加载程序类型,插入日志表PROC_TYPE列,0为存储过程,1为ds jobin_row_num 加载记录条数,插入日志表ROW_NUM列in_sql_code 加载SQL_CODE,插入日志表SQL_CODE列,本处只插入空值in_sql_errm 加载SQL_ERRM,插入日志表SQL_ERRM列,本处只插入空值in_execute_flag 加载标志,插入日志表EXECUGTE_FLAG列,0为成功,1为失败in_stat_time 加载结束日期,插入日志表STAT_TIME列in_begin_time 加载开始日期,插入日志表BEGIN_TIME列in_info 加载信息,插入日志表INFO列,本处插入执行周期和拒绝记录条数输出参数: out_sqlcode 加载标志,0为成功,非0值为失败out_sqlmsg 加载信息,记录正确结束信息或失败错误原因及出错位置三、使用规范a)封装sequence程序调整在原有job封装sequence程序的尾部添加一个Execute Command Stage,用这个Stage调用shell命令,如图:b)参数传递在Execute Command Stage 中,我们需要填写调用命令行的一些信息,如下: Command:/EDWETL/SH/sp_log.shParameters:P05_EDW test_ec #WORKDATE# #DBNAME# #DBUSER# #DBPWD#其中,Command字段填写的是命令行保持不变,除非开发规范发生变化;Parameters字段填写必须按照project名称+空格+seq名称+空格+#WORKDATE#+空格+#DBNAME#+空格+#DBUSER#+空格+#DBPWD#的方式填写,如图:c)运行前核查表i.确认sp_log.sh在/EDWETL/SH/下ii.确认该文件有执行权限iii.确认datastage执行用户具有/EDWETL/TMP文件夹的读写权限iv.确认目标数据库用户下有sp_log的存储过程,该过程有效并有执行权限d)范例程序具体的可执行范例程序在:10.201.64.13的P05_EDW\TMP下,SEQUENCE名称为test_ec。

DataStage控件说明

Tail

从一个输 入数据 集合分 区中选 择最后 一个 N条记 录并且 将

选择的记 录拷贝 的输出 数据集 合中

Write Range Map Encode

将数据写入range map;抓取排序或排序产生的数据集合, 并写入到 一个文 件用于 范围分 区方法(是 不是把 一个数 据 集分离成 一或多 个)

SAS

用于并行 执行部 分s as 应用

DB2

Orac le (这个是 最常用 的)

Informix XPS (听讲公 司用这 个还 是比较多 的)

IBM DB2 UDB访问 从DB2数据库读取数据或将数据写入DB2数据 库 顺序执行或并行执行 支持DB2的hash分区 支持write、upsert和load的写方法 支持表、自动产生SQL和用户定义SQL读方法

Change Apply Head

抓取变化 数据, 包括前 面或后 面数据 记录的 变化, 从 change capture stage并应用编码改变操作到前面数据集 合,计算 一个后 面数据 集合

从一个输 入数据 集合分 区中选 择第一 个N 条记录 并且将 选 择的记录 拷贝的 输出数 据集合 中

根据选择 器字段 的值 ,将一 个输入 记录分 配到一 个输出 的 lin k,支持128个output link和1个reject link。

Change Capture

抓取两个 输入数 据集合,表现为 前和后,并且获 取后面 的 数据路输 出一个 记录表 现已经 改变的 数据集 合到前 数据 集合

使用支持 的unix编码命 令对一 个数据 集合进 行编 码;将 一 个顺序数 据集合 转换到 没有处 理过的 二进制 数据流

Decode Co mpress Expand Diffe rence Colu mn Import

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Funnel阶段Funnel阶段是一个处理阶段。

它将多个输入数据集复制到单个数据集,该操作对于将单独数据集合并到单个大型数据集而言非常有用。

该阶段可以有众多输入链接和一个输出链接Funnel阶段能够以下列三种方式之一运行:1、连续传送以不可保证顺序合并输入数据的记录。

它依次从每个输入链接获取一条记录。

如果输入链接上的数据不可用,那么该阶段会跳至下一个链接,而不是等待。

2、排序传送按照一个或多个键列的值定义的顺序合并输入记录,输出记录的顺序由这绡排序键确定。

3、顺序将第一个输入数据集中的所有记录复制到输出数据集,然后将第二个输入数据集中的所有记录复制到输出数据集,依此类推。

对于所有方法,所有数据数据集的元数据都必须椒相同的。

排序传送方法对于其输入数据有一些特定要求。

所有输入数据集都必须根据Funnel操作的键列进行排序。

通常,排序传送操作的所有输入数据集在排序之前都是散列分区的(选择自动分区方法将确保完成这一操作).散列分区可确保具有相同键列值的所有记录都位于同一分区中,以便在同一个节点上处理。

如果在Funnel阶段之前在单独的阶段上执行排序和分区,那么必须保留该分区排序传送操作允许您设置一个主键和多个辅键以确定将输出的记录的顺序。

Funnel阶段:快速路径InfoSphere DataStage有许多缺省设置,这表示您能够载作业中轻松包含Funnel阶段。

本部分指定了要使Funnel阶段运行所需的最少步骤。

InfoSphere DataStage提供了多样化的用户界面,且提供了许多快捷方式供您达到特定目标,本部分描述了基本方法。

要使用Funnel阶段:1、在“阶段”页面的属性选项卡中,指定“传送类型”。

“连续传送”为缺省值,但也可以选择“顺序”或“排序传送”。

如果选择使用“排序传送”方法,则还需要指定对数据进行排序所依据的键。

可以重复使用键属性来指定组合键。

2、如果使用“顺序”方法,请在“阶段”页面的“链接排序”选项卡中,指定合并数据集的顺序。

3、在“输出”页面的“映射”选项卡中,指定如何派生输出列的方法,即将那些输入列映射到输出列,或如何生成这些输出列。

Funnel阶段:“属性”选项卡在“属性”选项卡中,可指定确定阶段实际执行那些操作的属性。

某些属性是必须的,尽管许多属性都有缺省设置。

无缺省设置的属性显示为警告色(缺省为红色),当你为其提供值后变为黑色。

Funnel阶段:“高级”选项卡1、执行方式。

阶段可以并行方式或顺序方式执行。

默认椒并行方式2、组合方式。

缺省情况下为“自动”方式。

该方式允许InfoSphereDataStage合并那些处于并行阶段底层的操作程序,以使他们能够在同一阶段尝试保留分区。

3、保留分区。

缺省值为传播。

也可以设置为设置或清除Funnel阶段:“链接排序”选项卡该选项卡允许您指定处理输入到Funnel阶段的链接顺序。

仅当选择了“顺序”funnel类型时才需要使用该选项卡。

Funnel阶段:输入页面输入页面主要包括常规选项卡(添加描述内容),分区选项卡(设置分区类型),键列,高级选项卡(设置缓冲方式)Funnel阶段:输出页面输入页面主要包括常规选项卡(添加描述内容),映射选项卡(设置分区类型),键列,高级选项卡(设置缓冲方式)Remove Duplicates阶段Remove Duplicates节点是一个处理阶段,该阶段可具有一个输入链接和一个输出链接。

Remove Duplicates阶段可将单个已排序数据集作为输入、除去所有的重复行并将结果定入输出数据集。

除去重复记录是一种在执行进一步处理前清理数据集的常用方法。

如果输入数据集内的相邻两行中存在相同的键列值,那么会将这两行视为重复行。

键列是被指定于确定是否相同的任意列。

输入Remove Duplicates阶段的数据集必须已进行过排序,以使所有具有相同键列值的处于相邻位置。

实现这一点,可以使用“输入页面”的分区选项卡上的阶段内排序工具或使用Sort阶段作为Remove Duplicates阶段的输入Remove Duplicates阶段:快速路径InfoSphere DataStage有许多缺省设置,这表示您能够在作业中轻松保护Remove Duplicates阶段。

本部分指定了要Remove Duplicates阶段运行所需的最少步骤。

InfoSphere DataStage提供了多样化的用户界面,且提供了许多快捷方式供您达到特定目标,本部分描述了基本方法。

要使Remove Duplicates阶段:1、在“阶段”页面的“属性”选项卡中,选择键列,将采用该列中相同的值来百事重复行,该阶段将除去这些行。

重复使用此属性可指定组合键。

2、在“输出”页面的“映射”选项卡中,指定如何派生输入列Remove Duplicates阶段:“属性”选项卡1、Keys that define Duplicates指定操作的键列。

可重复使用此属性来指定多个键列。

如果需要,可使用“列选择”对话框来一次选择若干个键。

“键”具有一下从属属性:(1)、以EBCDIC排序要按照EBCDIC字符集的规定进行排序,请选择True (2)、区分大小写使用此属性可指定每个键是否区分大小写,缺省情况下此属性设置为True。

2、Duplicates To Retion要保留的重复列指定要保留所遇到的重复列中的哪一列。

选择“第一列”或“最后一列”缺省情况下,此属性设置为“第一列”。

Compress阶段(压缩数据集)Compress阶段是一个处理,该阶段可具有一个输入和一个输出链接。

Compress阶段使用UNIX compress或GZIP实用程序压缩数据集。

它将数据集从记录序列转换成原始二进制数据流。

压缩的数据集类似于普通数据集,可通过Data Set阶段以持久格式存储,但是,压缩的数据集要在展开之后(即数据集行恢复正常格式)才能由许多阶段处理。

不执行基于列的处理或对行重新排序的阶段可以处理压缩的数据集。

例如,可以使用Copy阶段创建压缩数据集的副本。

由于压缩数据集会除去其正常的记录边界,因此在展开压缩数据集之前,不得对其重新分区。

Compress阶段:快速路径InfoSphere DataStage有许多缺省设置,这表示您能够在作业中轻松包含Compress阶段,本部分指定了要使Compress阶段运行所需的最少步骤。

InfoSphere DataStage提供了多样化的用户界面,且提供了许多快捷方式供您达到特定目标。

要使用Compress阶段:1、在“阶段”页面的“属性”选项卡中,选择要使用的压缩命令。

Compress是缺省值,但也可以选择gzip。

2、确保已为输入链接和输出链接定义了列元数据Compress阶段:“属性”选项卡在“属性”选项卡中,可指定确定阶段实际执行那些操作的属性,此阶段只有一个用于确定阶段是使用compress还是GZIP的属性。

指定阶段是使用压缩(缺省值)还是GXIPExpand阶段(展开数据集)Expand阶段是一个处理阶段,该阶段可具有一个输入链接和一个输出链接。

Expand阶段使用UNIX uncompress或GZIP实用程序来展开数据集,会将先前压缩的数据集从原始二进制数据流转换回一个记录序列。

Expand阶段与Compress阶段互补InfoSphere DataStage有许多缺省设置,这表示您能够在作业中轻松包含Expand阶段,本部分指定了要使Expand阶段运行所需的最少步骤。

InfoSphere DataStage提供了多样化的用户界面,且提供了许多快捷方式供您达到特定目标。

要使用Expand阶段:1、在“阶段”页面的“属性”选项卡,选择要使用的解压命令,缺省值为uncompress,但也可以选择gzip2、确保已输入链接和输出链接定义了列元数据Expand阶段:“属性”选项卡在“属性”选项卡中,可指定确定阶段实际执行哪些操作的属性,此阶段只有一个用于确定阶段是使用uncompress还是GZIP的属性。

Expand阶段:选项类别指定阶段是使用解压缩(缺省值)还是GZIPCopy阶段Copy阶段是一个处理阶段,此阶段可具有一个输入链接和任意数目的输出链接。

Copy阶段将单个输入数据集复制到多个数据集。

输入数据集的每条记录都被复制到每个输出数据集。

可以在不修改的情况下复制记录,或者可以删除或更改顺序。

复制允许您对磁盘上的数据集制作备份副本,同时对另一个副本执行操作。

当使用具有一个输入和一个输出的Copy阶段时,应该确保将阶段编辑器中的“强制”属性设置为True。

这可防止InfoSphere DataStage 判定“复制”操作过多并尽可能使之离开作业Copy阶段的属性相当简单。

唯一的属性为“强制”,因为正在复制到多个数据集(并且InfoSphere DataStage不会尝试在作业外优化该属性)。

您需要专注于为InfoSphere DataStage指定要删除每个输出链接上的哪些列。

完成操作的最简单方法是使用“输出”页面中“映射”选项卡,当针对链接打开该选项时,左侧窗格将显示输入列,您只需将保留的列拖放到右侧窗格中即可。

按以下步骤针对每表链接重复该操作。

Copy阶段:“属性”选项卡在“属性”选项卡中,可指定确定阶段实际执行那些操作属性。

Copy 阶段只有一个属性。

Force设置为True以指定当存在一个输入和输出时,InfoSphere DataStage不应尝试通过除去“复制”操作来尝试优化作业。

缺省情况下设置为FalseModify阶段Modify阶段是一个处理阶段。

该阶段可具有一个输入链接和一个输出链接。

Modify阶段用于改变其输入数据的记录模式。

然后,输出修改过的数据集。

您可以删除或保留模式中的列,或者更改列的类型虽然Modify阶段被归为处理阶段,但其运作方式不同于其他处理阶段。

在Director客户机的“监视器”窗口中,该阶段不显示处理行,也不会在Designer客户机中显示出站行计数。

Modify阶段用于删除列。

要执行此操作,请如下设置阶段属性:Specification=DROP 列名,列名通过指定要保留那些列(而不是要删除哪些列),可以实现相同的效果。

要在阶段属性中使用的必须规范如下:KEEP 列名,列名更改数据类型您还可以更改上个示例中一列或多列的数据类型。

如果希望将列从十进制转换为字符串,那么可以指定新列以采用转换之后的数据,并在阶段属性中指定转换:Specification = 新列名= 旧列名某些数据类型转换要求您使用某条变换命令,可以使用显示变换执行十进制到字符串的转换,在这种情况下,“属性”页面上的规范将如下所示:新列名:String = String_from_dicimal(旧列名)对于缺省类型转化,规范将采用以下形式:new_columnname = old_columnname例如:int8字段名= uint64字段名对于需要手动转换的情况,规范将采用一下形式:new_columnname:new_type=conversion_function(old_columnname)例如:day_column:int8=month_day_from_date(date_column)new_type 可以是从源字段进行转换所支持的任何目标类型(即在上表中标记为“m”的任何列)。