kl

骨关节炎kl分级标准

骨关节炎KL分级标准如下:

•KL零级:代表正常人群。

•KL一级:关节间隙疑似变窄,可能有骨赘(俗称骨质增生、骨刺)。

属比

较轻度的关节炎,只要使用药物治疗(如服用氨基葡萄糖等)、理疗(按摩、针灸等)这样的保守治疗手段活血化瘀,就能康复。

•KL二级:有明显骨赘,关节间隙疑似变窄。

这种需要注射治疗,临床使用

较多的办法是注射玻璃酸钠,也可以打封闭治疗。

•KL三级:中等量骨赘、关节间隙变窄较明确,关节会有明显的磨损。

这个

阶段主要采用关节镜微创手术治疗,严重的可以采用保膝手术。

•KL四级:有大量骨赘,关节间隙明显变窄,整个关节都损坏了。

此时主要

考虑全膝置换手术。

K-L距离(相对熵)

KL距离,是Kullback-Leibler差异(Kullback-Leibler Divergence)的简称,也叫做相对熵(Relative Entropy)。

它衡量的是相同事件空间里的两个概率分布的差异情况。

其物理意义是:在相同事件空间里,概率分布P(x)的事件空间,若用概率分布Q(x)编码时,平均每个基本事件(符号)编码长度增加了多少比特。

我们用D(P||Q)表示KL距离,计算公式如下:当两个概率分布完全相同时,即P(x)=Q(X),其相对熵为0 。

我们知道,概率分布P(X)的信息熵为:其表示,概率分布P(x)编码时,平均每个基本事件(符号)至少需要多少比特编码。

通过信息熵的学习,我们知道不存在其他比按照本身概率分布更好的编码方式了,所以D(P||Q)始终大于等于0的。

虽然KL被称为距离,但是其不满足距离定义的三个条件:1)非负性;2)对称性(不满足);3)三角不等式(不满足)。

我们以一个例子来说明,KL距离的含义。

假如一个字符发射器,随机发出0和1两种字符,真实发出概率分布为A,但实际不知道A的具体分布。

现在通过观察,得到概率分布B与C。

各个分布的具体情况如下:A(0)=1/2,A(1)=1/2B(0)=1/4,B(1)=3/4C(0)=1/8,C(1)=7/8那么,我们可以计算出得到如下:也即,这两种方式来进行编码,其结果都使得平均编码长度增加了。

我们也可以看出,按照概率分布B进行编码,要比按照C进行编码,平均每个符号增加的比特数目少。

从分布上也可以看出,实际上B要比C更接近实际分布。

如果实际分布为C,而我们用A分布来编码这个字符发射器的每个字符,那么同样我们可以得到如下:再次,我们进一步验证了这样的结论:对一个信息源编码,按照其本身的概率分布进行编码,每个字符的平均比特数目最少。

这就是信息熵的概念,衡量了信息源本身的不确定性。

另外,可以看出KL距离不满足对称性,即D(P||Q)不一定等于D(Q||P)。

kl散度的作用

kl散度的作用KL散度(Kullback-Leibler divergence)是一种用于衡量两个概率分布之间的距离的方法,也被称为信息散度(information divergence)或相对熵(relative entropy)。

在实际应用中,KL散度有着广泛的应用,本文将围绕KL散度的作用展开讨论。

一、KL散度的计算公式KL散度的计算公式为:$$D_{KL}(P||Q)=\sum_{i=1}^n P_i\log\frac{P_i}{Q_i}$$其中,$P$和$Q$分别是两个概率分布,$P_i$和$Q_i$分别是它们的概率密度函数(或质量函数)在第$i$个位置上的取值。

二、KL散度的作用1. 应用于模型拟合KL散度可以应用于模型拟合,通过比较模型与真实数据之间的距离,找到使KL散度最小的模型参数,从而实现模型的最优化。

例如,假设有两个分布$P$和$Q$,其中$P$是真实的概率分布,$Q$是拟合的概率分布。

我们可以通过调整$Q$的参数,使得两个分布的KL散度最小,这样就可以得到一个最优化的模型。

2. 应用于信息检索KL散度可以应用于信息检索,比如在搜索引擎中,当用户输入关键词进行搜索时,搜索引擎会根据相关度排序后返回搜索结果。

这个过程中,搜索引擎将用户输入的关键词看作一个概率分布,将网页内容看作另一个概率分布,然后计算它们之间的KL散度来衡量排序的相关度。

3. 应用于图像处理KL散度可以应用于图像处理,比如图像分割、图像去噪等。

例如,当要进行图像分割时,我们可以将目标区域和背景区域看作两个概率分布,然后计算它们之间的KL散度,从而得到最佳的分割结果。

4. 应用于机器学习KL散度在机器学习中也有着广泛的应用。

例如,在分类问题中,我们可以将每一类看作一个概率分布,然后计算它们之间的KL散度,从而判断两个类之间的相似程度。

这个过程中,KL散度的值越小,说明两个类之间的相似度越高。

三、总结综上所述,KL散度作为一种衡量两个概率分布之间距离的方法,在实际应用中有着广泛的应用,包括模型拟合、信息检索、图像处理、机器学习等领域。

负荷系数kl

负荷系数kl

负荷系数KL是用于描述电力负荷与区域总容量之间关系的指标。

在电力系统中,负荷系数是指实际电力负荷与系统发电容量之比。

通过负荷系数,可以了解电力系统的运行状态和负荷水平,从而为电力调度和能源管理提供重要的参考依据。

负荷系数KL的计算公式为:KL = (实际电力负荷/系统发电容量) × 100%。

其中,实际电力负荷是指某一时刻电力系统中的实际用电量,系统发电容量则是指电力系统的总发电能力。

负荷系数KL的大小直接反映了电力系统的负荷状况和运行状态。

当KL值较低时,说明电力系统的负荷较轻,系统有足够的发电容量来满足需求;而当KL值较高时,则说明电力系统的负荷较重,部分用户可能会面临电力短缺的风险。

在电力系统的管理中,通过对负荷系数的监测和分析,可以及时了解电力供需情况,预测未来的电力需求趋势,从而制定相应的调度计划和能源管理策略。

同时,负荷系数也是评估电力系统运行效率和经济效益的重要指标之一,可以为电力市场的运营和电价制定提供参考依据。

为了确保电力系统的稳定运行和满足用户的用电需求,需要根据负荷系数的变化及时调整发电容量的分配和调度策略。

同时,加强能源结构的优化和能源效率的提高也是降低负荷系数、提高电力系统运行效率的重要途径。

总之,负荷系数KL是描述电力负荷与发电容量之间关系的重要指标,对于电力系统的管理和能源政策的制定具有重要的指导意义。

建筑kl是什么意思

建筑kl是什么意思建筑KL这个名字,对于不熟悉建筑领域的人来说可能会感到陌生。

然而,对于热爱建筑的人来说,KL不只是一个简单的名字,它代表了一种特殊的建筑类型和风格。

KL在建筑中指的是“Kuala Lumpur”,是马来西亚首都吉隆坡的简称。

吉隆坡是一个多元文化的城市,融合了马来、华人、印度和其他族裔的文化和建筑风格。

因此,建筑KL这个术语被用来代表了吉隆坡独特的建筑景观。

吉隆坡的建筑风格很多元,融合了古老的传统和现代的创新。

你可以看到传统的马来屋顶和中式建筑,同时也有现代玻璃幕墙和创新的建筑设计。

这种多元文化的建筑风格使得吉隆坡成为了一个引人注目的建筑目的地。

在吉隆坡,你可以看到许多有着独特外观的建筑物。

例如,双子塔是吉隆坡的标志性建筑之一,是世界上最高的双塔之一。

这座塔楼结合了现代和传统元素,其圆形的造型代表了马来传统建筑中的穹顶。

另一个吉隆坡的著名建筑是国家清真寺,它是马来西亚最大的清真寺。

这座建筑结合了伊斯兰和莫卧儿建筑风格,其蓝色的圆顶和白色的墙壁给人一种宁静和祥和的感觉。

此外,吉隆坡还有许多其他有趣的建筑物,如国家宫殿、音乐厅和艺术博物馆等。

这些建筑代表了吉隆坡作为一个现代都市的一部分,展示了城市的独特魅力和文化。

除了独特的建筑外观,建筑KL也涉及了可持续发展和环境保护的概念。

吉隆坡的一些新建筑物采用了环保材料和节能设计,以减少对环境的影响。

例如,一些建筑物使用太阳能电池板来发电,减少对传统能源的依赖。

这些建筑展示了吉隆坡在建筑设计方面的创新和关注环境的意识。

总之,建筑KL代表了吉隆坡独特的建筑风格和文化。

这个名字不仅仅是一个简单的缩写,它承载着整个城市的历史、文化和多元化。

通过探索吉隆坡的建筑KL,我们可以更好地了解这座城市,并欣赏到其独特的魅力。

如果你对建筑有兴趣,不妨来吉隆坡一探究竟,欣赏这座城市的建筑之美。

kl散度 信息量

kl散度信息量KL散度是一种用于衡量两个概率分布之间相似度的指标,其全称为“Kullback-Leibler divergence”,也被称为“信息散度”、“信息距离”或“相对熵”。

在信息学、统计学和机器学习中被广泛使用,常常用于评估模型的表现、比较两个数据分布的差异、计算信息量等方面。

KL散度的计算公式如下:D(p||q)=Σ(pi log(pi/qi)),其中p和q是两个概率分布,pi和qi分别是p和q在某个事件上的概率。

在这个公式中,pi是观测到某个事件的概率,qi是模型预测该事件的概率。

因此,KL散度可以表示为真实分布p和预测分布q之间的差异程度。

当KL散度的值为0时,则表示p和q完全一致。

KL散度可以用于衡量模型预测和真实结果之间的差异,例如,用于评估分类问题中的模型性能。

对于一个二分类问题而言,我们可以将真实结果表示为1或0,预测结果也可以表示为1或0,从而创建一个2x2的混淆矩阵。

然后,我们可以通过计算KL散度来评估模型的性能,从而得到模型的准确性、召回率和精确度等指标。

KL散度还可以被用来计算信息量。

在信息论中,信息量表示某个事件所包含的信息量大小。

例如,如果某个事件具有较高的概率,则包含的信息量相对较小;相反,如果该事件的概率较小,则包含的信息量相对较大。

因此,KL散度可以被用来计算两个概率分布之间的信息量差异。

总之,KL散度是一种重要的信息学概念,可以用于评估模型预测和真实结果之间的差异、计算信息量等方面。

对于机器学习、模式识别等领域而言,KL散度是一个重要的指标,可以帮助人们更好地理解概率分布之间的差异,进而优化模型性能。

kl散度的取值范围

kl散度的取值范围KL散度是一种常用的信息论和监督学习的度量方法,它主要用于测量两个概率分布之间的差异。

这种方法可以用于比较分类算法的性能,以及应用数据挖掘中的多元特征的贡献程度。

其计算结果的取值范围是0到正无穷大,0意味着两个分布几乎完全一致,正无穷大指的是完全不相关。

本文将首先介绍KL散度概念,然后讨论KL散度取值范围。

KL散度(KullbackLeibler divergence)是一种度量两个概率分布P和Q之间的不同程度的度量方法,它也被称为相对熵。

它的定义为:D_KL(P || Q)=∫_X P(x) ln[P(x) / Q(x)] dx,其中X表示概率密度函数的空间。

D_KL(P||Q)计算的结果可以用来衡量P和Q之间的差异,并可以用作机器学习和数据挖掘任务中模型性能的评估指标。

KL散度取值范围为[0,+∞)。

当这两个概率分布P和Q相同时,KL散度取值为0;当P和Q完全不相关时,KL散度取值为正无穷大。

KL散度是一个非负定值,即它的取值不可能小于0,因此KL散度的取值范围是[0,+∞),其中0表示两个概率分布完全一致,正无穷大表示完全不相关。

KL散度可以用于比较两个概率分布之间的差异,以此来评价分类算法和模型在应用数据挖掘中的性能。

例如,可以使用KL散度对多元特征在数据挖掘任务中的贡献程度进行衡量。

KL散度的取值范围决定了它可以用来衡量P和Q之间的差异程度。

如果KL散度取值为0,则表示P和Q完全一致;如果KL散度取值为正无穷大,则表示P和Q完全不相关。

此外,KL散度也可以用于评估两个模型之间的性能,可以对多个模型之间进行比较,并可以检测模型之间的差距。

KL散度可以通过统计学习数据集上模型的准确率来评估,可以检验两个模型之间的准确率,从而衡量模型之间的差异。

KL散度是一种常用的信息论和监督学习的度量方法,它主要用于测量两个概率分布之间的差异。

它的取值范围是[0,+∞),0表示两个分布完全一致,正无穷大指的是完全不相关。

变分推断 正向kl散度

变分推断和正向KL散度是统计学和机器学习中常用的概念,常用于概率模型的参数估计和模型选择。

变分推断:变分推断是统计学中用于估计未知参数的一种方法,其基本思想是通过优化某个变分函数来逼近真实分布,从而得到未知参数的估计值。

变分推断的步骤通常包括建立概率模型、定义变分函数、选择优化算法、进行迭代优化等。

通过变分推断,可以解决许多复杂的问题,例如高维数据的降维、非参数贝叶斯推断等。

正向KL散度:正向KL散度是KL散度的一个特殊形式,其定义与KL散度类似,但是有一个正向的前缀。

正向KL散度的计算公式为:KL(p||q) = E_{x\sim p(x)}[\log \frac{p(x)}{q(x)}]。

对于任意的p(x)>0的点,如果q(x) \rightarrow 0,则KL散度会无限大,所以要避免这种情况,近似的结果就会尽量的平摊在整个区域上。

正向KL散度可以用于衡量两个概率分布之间的相似度,如果两个概率分布越相似,正向KL散度越小。

在机器学习中,正向KL散度常用于度量两个概率分布之间的差异,例如在生成对抗网络(GAN)中用于评估生成器生成的样本与真实样本之间的相似度。

总之,变分推断和正向KL散度都是重要的统计学和机器学习概念,它们在概率模型的参数估计和模型选择中发挥着重要的作用。

功率谱密度kl散度

功率谱密度kl散度功率谱密度KL散度(Kullback–Leibler divergence),也称为相对熵(relative entropy)或KL散度,是一种用于量化两个概率分布之间的差异的度量方法。

它由Kullback和Leibler在20世纪50年代提出,并在信息论、统计学和机器学习等领域得到了广泛应用。

KL散度定义如下:KL(P||Q) = Σ P(x) * log(P(x) / Q(x))其中P和Q是两个概率分布,x是概率空间中的一个事件。

KL散度描述了从真实分布P获得样本的经验分布Q相对于P的“代价”。

KL散度在信息论中是一个重要的概念,它衡量了从一个分布到另一个分布的信息损失。

KL散度的性质可以总结为以下几点:1. KL散度是非负的,即KL(P||Q) ≥ 0,当且仅当P和Q是相同的分布时,KL散度为0。

2. KL散度不满足对称性,即KL(P||Q) ≠ KL(Q||P),因此它不是一个度量方法。

3. KL散度不满足三角不等式,即K L(P||R) ≥ KL(P||Q) +KL(Q||R)。

在统计学中,KL散度的应用非常广泛。

例如,在密度估计中,KL 散度可以用来衡量两个概率密度函数之间的差异。

在假设检验中,KL 散度可以用来比较两个样本分布的差异,进而进行假设检验。

在模型选择和参数估计中,KL散度可以作为一个准则来选择最优模型或估计参数。

在机器学习中,KL散度也经常被用作优化目标或者评估指标。

在生成模型中,KL散度可以用来训练模型,使得生成的数据分布接近真实数据的分布。

在概率图模型中,KL散度可以用来衡量两个概率分布之间的条件依赖关系。

在强化学习中,KL散度可以用来衡量策略迭代算法中策略的变化。

KL散度也与信息论中的相对熵紧密相关。

相对熵描述了两个概率分布之间的信息差异,并可以用KL散度进行度量。

相对熵是KL散度的一个特例,当P和Q两个分布是离散分布时,相对熵等于KL散度。

需要注意的是,KL散度并不是一个对称的度量方法,它在衡量两个分布的差异时,强调了一种分布到另一种分布的“损失”。

kl散度拟合负数分布

kl散度拟合负数分布KL散度(Kullback-Leibler divergence),也称为相对熵,是度量两个概率分布之间差异的一个指标。

它被广泛应用于机器学习、信息论、统计学等领域。

KL散度可以用来衡量两个概率分布之间的相似度或者差异程度。

在统计学中,正数分布是一种常见的分布形式。

它可以描述很多实际现象,比如身高、体重等等。

然而,负数分布相对较少被研究和应用。

因此,这里我们来研究如何利用KL散度拟合负数分布。

首先,让我们来介绍一下负数分布。

负数分布是指具有负数值的概率分布。

它可以用来描述一些特殊的现象,比如亏损、损失等。

负数分布的特点是其概率密度函数(Probability Density Function, PDF)在负数区域有显著的非零取值。

为了拟合负数分布,我们可以利用KL散度来找到最佳的拟合分布。

首先,我们需要定义一个负数分布的理论模型。

在这个模型中,我们需要选择合适的概率密度函数来描述负数区域的分布情况。

常见的负数分布模型包括负二项分布(negative binomial distribution)、负多项分布(negative multinomial distribution)等等。

这些模型都有不同的性质和应用场景,我们需要根据具体问题选择适合的模型。

在选择了一个负数分布模型后,我们需要确定模型的参数。

这可以通过最大似然估计(Maximum Likelihood Estimation, MLE)等方法来完成。

最大似然估计是一种常用的参数估计方法,它可以通过优化损失函数来最大化模型与实际观察数据的拟合程度。

然后,我们可以利用KL散度来衡量拟合分布与真实分布之间的差异程度。

KL散度的定义如下:KL(P||Q) = ∑(x∈X) P(x) log(P(x)/Q(x))其中,P和Q分别为真实分布和拟合分布,X为所有可能的取值集合。

KL散度越小,代表两个分布之间的差异越小,拟合程度越好。

最后,我们可以进行参数调整和模型优化,以进一步改进拟合结果。

kl散度计算

kl散度计算K-L散度(Kullback-Leibler Divergence,简称KL散度)是一种在信息论中用来度量两个概率分布的差异的度量。

K-L散度有一定的拓展性,可以用于度量各类之间的差异和非标准分布形式的差异。

下面介绍K-L散度的具体概念及其计算。

一、定义K-L散度(Kullback-Leibler Divergence)是一种在信息论中用来度量两个概率分布的差异的度量,它衡量的是从概率分布P到概率分布Q的平均信息损失。

K-L散度定义为:D(P||Q) = \sum_{j=1}^m P(x_j) \log \left(\frac{P(x_j)}{Q(x_j)}\right)其中:D(P||Q)表示从概率分布P到概率分布Q的信息损失;P(x_j)、Q(x_j)分别表示概率P、概率Q划分后的分布情况;m为两个概率分布的划分数。

二、优点K-L散度有一定的拓展性,可以用于度量各类之间的差异,从而用来衡量不同的模型的拟合能力,比如假设检定,多元统计建模,图像处理等用途。

另外,K-L散度也可以用来衡量非标准分布形式的差异,特别是当两个分布形式类似时,K-L散度可以提供一种简便的情况来区分分布的异同。

三、计算(1)计算子节点的信息期望值在计算K-L散度之前,首先需要计算子节点的信息期望值,公式为:E(x_j) = P(x_j) \times \log P(x_j)若P(x_j)是叶子节点,则:E(x_j) = -\log P(x_j)(2)计算K-L散度在子节点信息期望值计算完成后,需要通过信息期望值和子节点概率来计算K-L散度,公式如下:D(P||Q) = \sum_{j=1}^m Q(x_j) \times E(x_j)其中:D(P||Q)表示从概率分布P到概率分布Q的信息损失,P(x_j)、Q(x_j)分别表示概率P、概率Q划分后的分布情况,m为两个概率分布的划分数,E(x_j)是子节点的信息期望值。

联合概率分布的kl散度

KL(Kullback-Leibler)散度(也称为相对熵)是衡量两个概率分布之间差异的一种度量方法。

对于联合概率分布的KL散度,我们需要有两个概率分布的函数形式。

设有两个联合概率分布P(X,Y)和Q(X,Y)。

它们可以表示为P(X=x,Y=y)和Q(X=x,Y=y),其中X和Y是两个相关的离散随机变量。

联合概率分布的KL散度D(P||Q)可以用以下公式计算:

D(P||Q) = Σ Σ P(x,y) * log [ P(x,y) / Q(x,y) ]

其中,Σ表示对所有可能的X和Y值进行求和操作。

KL散度的值越大,表示两个概率分布之间的差异越大。

当且仅当P(X,Y)和Q(X,Y)相等时,KL散度为0。

需要注意的是,KL散度不是对称的,即D(P||Q) ≠ D(Q||P)。

KL散度在许多领域中有广泛应用,包括信息论、统计学、机器学习等。

它常用于衡量一个概率分布对于另一个概率分布的逼近程度,或用于优化模型的训练过程中。

kl散度取值范围

kl散度取值范围

Kullback-Leibler(KL)散度可以用来衡量两个概率分布之间的差异。

它是一种相对于特定概率分布的所有可能变量的平均差异。

KL散度的取值范围从0到正无穷。

KL散度与其他常见度量(例如相关系数和均方差)不同,它可以用来比较不同概率分布之间的差异。

KL散度的取值范围取决于两个概率分布的差异程度。

如果两个概率分布完全一致,那么KL散度的取值将为0,这表明两个概率分布完全一致。

反之,如果两个概率分布完全不同,那么KL散度的取值将变得更大,最大值为正无穷。

KL散度取值范围在实际应用中可能会发挥重要作用。

例如,使用KL散度可以检测模型的效果,从而确定模型的准确性。

KL散度的取值范围可以帮助我们分析模型的准确性,从而使我们能够更好地改进和优化模型。

此外,KL散度的取值范围也可以用于发现和比较不同概率分布之间的差异。

使用KL散度可以比较不同概率分布之间的差异,从而更好地理解不同概率分布之间的差异。

总之,KL散度的取值范围从0到正无穷,它是衡量两个概率分布之间差异的一种有效方法。

它可以用于检测模型的效果,发现和比较不同概率分布之间的差异,以及更好地理解不同概率分布之间的

差异。

它是一种有效的度量,值得我们进一步研究和使用。

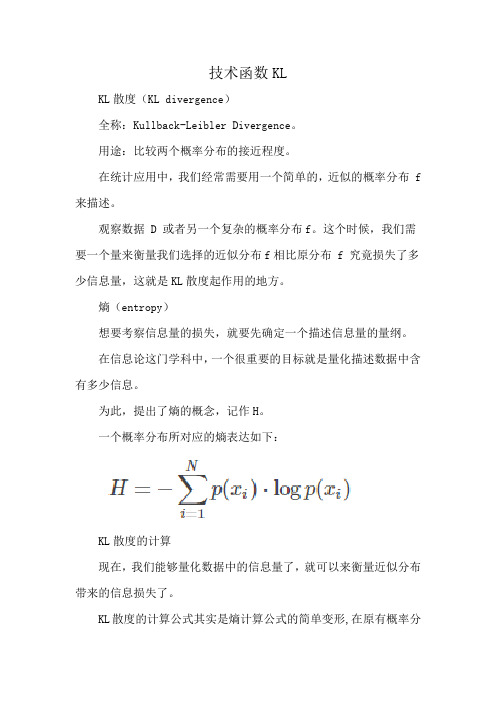

技术函数KL

技术函数KLKL散度(KL divergence)全称:Kullback-Leibler Divergence。

用途:比较两个概率分布的接近程度。

在统计应用中,我们经常需要用一个简单的,近似的概率分布 f 来描述。

观察数据 D 或者另一个复杂的概率分布f。

这个时候,我们需要一个量来衡量我们选择的近似分布f相比原分布 f 究竟损失了多少信息量,这就是KL散度起作用的地方。

熵(entropy)想要考察信息量的损失,就要先确定一个描述信息量的量纲。

在信息论这门学科中,一个很重要的目标就是量化描述数据中含有多少信息。

为此,提出了熵的概念,记作H。

一个概率分布所对应的熵表达如下:KL散度的计算现在,我们能够量化数据中的信息量了,就可以来衡量近似分布带来的信息损失了。

KL散度的计算公式其实是熵计算公式的简单变形,在原有概率分布 p 上,加入我们的近似概率分布 q ,计算他们的每个取值对应对数的差:换句话说,KL散度计算的就是数据的原分布与近似分布的概率的对数差的期望值。

在对数以2为底时, log2,可以理解为“我们损失了多少位的信息”。

写成期望形式:更常见的是以下形式:现在,我们就可以使用KL散度衡量我们选择的近似分布与数据原分布有多大差异了。

散度不是距离因为KL散度不具有交换性,所以不能理解为“距离”的概念,衡量的并不是两个分布在空间中的远近,更准确的理解还是衡量一个分布相比另一个分布的信息损失(information lost)。

使用KL散度进行优化通过不断改变预估分布的参数,我们可以得到不同的KL散度的值。

在某个变化范围内,KL散度取到最小值的时候,对应的参数是我们想要的最优参数。

这就是使用KL散度优化的过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

【我们的约定】

一、升国旗,要立正,唱国歌,要响亮。

二、上课时,要专心,爱动脑,勤发言。

三、做作业,要认真,不潦草,不马虎。

四、下课了,休息好,不乱跑,不乱叫。

五、吃饭时,守秩序,不挑食,不浪费。

六、要诚实,不说谎,知道错,就改正。

七、对师长,要尊敬,对同伴,要友好。

八、爱劳动,讲卫生,不怕脏,不怕累。

【我能做到】

一、教室阳台莫攀爬,遇见栏杆不倚靠。

二、走廊过道轻步行,上下楼梯不推闹。

三、放学不与生人走,路滑小心慢步绕。

四、文明守纪树良风,安全教育我记牢。

【我的进步看得见】学号+名字

【人人当干部,个个都自信】姓名+职务【教室后标语】:播种习惯收获命运【图书角】:郁郁书香,伴我成长。

【卫生角】:你我自觉,环境清洁。