人工智能导论 第08讲 神经网络II 决策树 示例

决策树示例

决策树示例%**************************************************************%* mex interface to Andy Liaw et al.'s C code (used in R package randomForest)%* Added by Abhishek Jaiantilal ( abhishek.jaiantilal@ )%* License: GPLv2%* Version: 0.02%% Calls Regression Random Forest% A wrapper matlab file that calls the mex file% This does training given the data and labels% Documentation copied from R-packages pdf% /web/packages/randomForest/randomForest.pdf% Tutorial on getting this working in tutorial_ClassRF.m%%**************************************************************% function model = classRF_train(X,Y,ntree,mtry, extra_options)%%___Options% requires 2 arguments and the rest 3 are optional% X: data matrix% Y: target values% ntree (optional): number of trees (default is 500). also if set to 0% will default to 500% mtry (default is floor(sqrt(size(X,2))) D=number of features in X). also if set to 0% will default to 500%%% Note: TRUE = 1 and FALSE = 0 below% extra_options represent a structure containing various misc. options to% control the RF% extra_options.replace = 0 or 1 (default is 1) sampling with or without% replacement% extra_options.strata = (not Implemented)% extra_options.sampsize = Size(s) of sample to draw. For classification,% if sampsize is a vector of the length the number of strata, then sampling is stratified by strata,% and the elements of sampsize indicate the numbers to be drawn from the strata. I don't yet know how this works.% extra_options.nodesize = Minimum size of terminal nodes. Setting this number larger causessmaller trees% to be grown (and thus take less time). Note that the default values are different% for classification (1) and regression (5).% extra_options.importance = Should importance of predictors be assessed?% extra_options.localImp = Should casewise importance measure be computed? (Setting this to TRUE will% override importance.)% extra_options.proximity = Should proximity measure among the rows be calculated?% extra_options.oob_prox = Should proximity be calculated only on 'out-of-bag' data?% extra_options.do_trace = If set to TRUE, give a more verbose output as randomForest is run. If set to% some integer, then running output is printed for every% do_trace trees.% extra_options.keep_inbag = Should an n by ntree matrix be returned that keeps track of which samples are% 'in-bag' in which trees (but not how many times, if sampling with replacement)% extra_options.corr_bias = which happens only for regression. perform bias correction for regression? Note: Experimental. Use at your own% risk.% extra_options.nPerm = Number of times the OOB data are permuted per tree for assessing variable% importance. Number larger than 1 gives slightly more stable estimate, but not% very effective. Currently only implemented for regression.%%%___Returns model which has% importance = a matrix with nclass + 2 (for classification) or two (for regression) columns.% For classification, the first nclass columns are the class-specific measures% computed as mean decrease in accuracy. The nclass + 1st column is the% mean decrease in accuracy over all classes. The last column is the mean decrease% in Gini index. For Regression, the first column is the mean decrease in% accuracy and the second the mean decrease in MSE. If importance=FALSE,% the last measure is still returned as a vector.% importanceSD = The ?standard errors? of the permutation-based importance measure. For classification,% a p by nclass + 1 matrix corresponding to the first nclass + 1% columns of the importance matrix. For regression, a length p vector.% localImp = a p by n matrix containing the casewise importance measures, the [i,j] element% of which is the importance of i-th variable on the j-th case. NULL if% localImp=FALSE.% ntree = number of trees grown.% mtry = number of predictors sampled for spliting at each node.% votes (classification only) a matrix with one row for each input data point and one% column for each class, giving the fraction or number of ?votes? from the random% forest.% oob_times number of times cases are 'out-of-bag' (and thus used in computing OOB error% estimate)% proximity if proximity=TRUE when randomForest is called, a matrix of proximity% measures among the input (based on the frequency that pairs of data points are% in the same terminal nodes).% errtr = first column is OOB Err rate, second is for class 1 and so on% mse =(regression only) vector of mean square errors: sum of squared residuals divided% by n.% rsq (regression only) 'pseudo R-squared': 1 - mse / Var(y).function model=regRF_train(X,Y,ntree,mtry, extra_options)%function model = regRF_predict(X,Y,ntree,mtry)%requires 2 arguments and the rest 2 are optional%X: data matrix%Y: target values%ntree (optional): number of trees (default is 500)%mtry (default is max(floor(D/3),1) D=number of features in X)DEBUG_ON=0;DEFAULTS_ON=0;TRUE=1;FALSE=0;if exist('extra_options','var')if isfield(extra_options,'DEBUG_ON'); DEBUG_ON = extra_options.DEBUG_ON; endif isfield(extra_options,'replace'); replace = extra_options.replace; endif isfield(extra_options,'classwt'); classwt = extra_options.classwt; endif isfield(extra_options,'cutoff'); cutoff = extra_options.cutoff; endif isfield(extra_options,'strata'); strata = extra_options.strata; endif isfield(extra_options,'sampsize'); sampsize = extra_options.sampsize; endif isfield(extra_options,'nodesize'); nodesize = extra_options.nodesize; endif isfield(extra_options,'importance'); importance = extra_options.importance; endif isfield(extra_options,'localImp'); localImp = extra_options.localImp; endif isfield(extra_options,'nPerm'); nPerm = extra_options.nPerm; endif isfield(extra_options,'proximity'); proximity = extra_options.proximity; endif isfield(extra_options,'oob_prox'); oob_prox = extra_options.oob_prox; end%if isfield(extra_options,'norm_votes'); norm_votes = extra_options.norm_votes; endif isfield(extra_options,'do_trace'); do_trace = extra_options.do_trace; endif isfield(extra_options,'corr_bias'); corr_bias = extra_options.corr_bias; endif isfield(extra_options,'keep_inbag'); keep_inbag = extra_options.keep_inbag; endend%set defaults if not already setif ~exist('DEBUG_ON','var') DEBUG_ON=FALSE; endif ~exist('replace','var'); replace = TRUE; end%if ~exist('classwt','var'); classwt = []; end %will handle these three later%if ~exist('cutoff','var'); cutoff = 1; end%if ~exist('strata','var'); strata = 1; endif ~exist('sampsize','var');if (replace)sampsize = size(X,1);elsesampsize = ceil(0.632*size(X,1));end;endif ~exist('nodesize','var'); nodesize = 5; end %classification=1, regression=5if ~exist('importance','var'); importance = FALSE; endif ~exist('localImp','var'); localImp = FALSE; endif ~exist('nPerm','var'); nPerm = 1; end%if ~exist('proximity','var'); proximity = 1; end %will handle these two later%if ~exist('oob_prox','var'); oob_prox = 1; end%if ~exist('norm_votes','var'); norm_votes = TRUE; endif ~exist('do_trace','var'); do_trace = FALSE; endif ~exist('corr_bias','var'); corr_bias = FALSE; endif ~exist('keep_inbag','var'); keep_inbag = FALSE; endif ~exist('ntree','var') | ntree<=0ntree=500;DEFAULTS_ON=1;endif ~exist('mtry','var') | mtry<0 | mtry> size(X,2)mtry = max(floor(size(X,2)/3),1);DEFAULTS_ON=1;endaddclass=0;[N D] = size(X);if length(unique(Y))<=5, warning('Do you want regression? there are just 5 or less unique values'); endif N==0, error('Data (X) has 0 rows'); endif mtry<1 || mtry>D , warning('Invalid mtry. reset to within valid range'); DEFAULTS_ON=1; endmtry = max(1, min(D,round(mtry)));if DEFAULTS_ONfprintf('\tSetting to defaults %d trees and mtry=%d\n',ntree,mtry);endif length(Y)~=N || length(Y)==0error('length of Y not the same as X or Y is null');endif ~isempty(find(isnan(X))); error('NaNs in X'); endif ~isempty(find(isnan(Y))); error('NaNs in Y'); end%now handle categories. Problem is that categories in R are more%enhanced. In this i ask the user to specify the column/features to%consider as categories, 1 if all the values are real values else%specify the number of categories hereif exist ('extra_options','var') && isfield(extra_options,'categories')ncat = extra_options.categories;elsencat = ones(1,D);endmaxcat = max(ncat);if maxcat>32error('Can not handle categorical predictors with more than 32 categories');end%classRF - line 88 in randomForest.default.Rnclass = length(unique(Y));addclass = FALSE;if ~exist('proximity','var')proximity = addclass;oob_prox = proximity;endif ~exist('oob_prox','var')oob_prox = proximity;end%i handle the below in the mex file% if proximity% prox = zeros(N,N);% proxts = 1;% else% prox = 1;% proxts = 1;% end%i handle the below in the mex fileif localImpimportance = TRUE;% impmat = zeors(D,N);else% impmat = 1;endif importanceif (nPerm<1)nPerm = int32(1);elsenPerm = int32(nPerm);end%regRF% impout = zeros(D,2);% impSD = zeros(D,1);else% impout = zeros(D,1);% impSD = 1;end%i handle the below in the mex file%somewhere near line 157 in randomForest.default.R if addclass% nsample = 2*n;else% nsample = n;endStratify = (length(sampsize)>1);if (~Stratify && sampsize>N)error('Sampsize too large')endif Stratifyerror('Sampsize should be of length one') end%i handle the below in the mex file% nrnodes = 2*floor(sampsize/max(1,nodesize-4))+1;% xtest = 1;% ytest = 1;% ntest = 1;% labelts = FALSE;% nt = ntree;Options = int32([importance,localImp,nPerm]);if DEBUG_ON%print the parameters that i am sending infprintf('size(x) %d\n',size(X));fprintf('size(y) %d\n',size(Y));fprintf('nclass %d\n',nclass);fprintf('size(ncat) %d\n',size(ncat));fprintf('maxcat %d\n',maxcat);fprintf('size(sampsize) %d\n',size(sampsize));fprintf('sampsize[0] %d\n',sampsize(1));fprintf('Stratify %d\n',Stratify);fprintf('Proximity %d\n',proximity);fprintf('oob_prox %d\n',oob_prox);fprintf('ntree %d\n',ntree);fprintf('mtry %d\n',mtry);fprintf('nodesize %f\n',nodesize);fprintf('replace %f\n',replace);end[ldau,rdau,nodestatus,nrnodes,upper,avnode,...mbest,ndtree,ypred,mse,impout,impmat,...impSD,prox,coef,oob_times,inbag]...= mexRF_train (X',Y,ntree,mtry,sampsize,nodesize,...int32(Options),int32(ncat),int32(maxcat),int32(do_trace), int32(proximity), int32(oob_prox), ...int32(corr_bias), keep_inbag, replace );%done in R file so doing it too.ypred(oob_times==0)=NaN;model.lDau=ldau;model.rDau=rdau;model.nodestatus=nodestatus;model.nrnodes=nrnodes;model.upper=upper;model.avnode=avnode;model.mbest=mbest;model.ndtree=ndtree;model.ntree = ntree;model.Y_hat = ypred;model.mse = mse;model.importance = impout;model.importanceSD = impSD;model.localImp = impmat;model.proximity = prox;model.coef = coef;model.oob_times = oob_times;model.inbag = inbag;model.nPerm = nPerm;model.biasCorr = corr_bias;model.rsq = 1 - mse / (var(Y) * (N-1) / N);clear mexRF_train。

人工智能之决策树ppt课件

连接节点之间的路径,代表不同 的决策路径。

决策树学习算法分类

ID3算法

基于信息增益进行特征选择,适用于离散型特征。

C4.5算法

在ID3算法基础上进行改进,支持连续型特征处理, 引入剪枝技术防止过拟合。

CART算法

既可用于分类也可用于回归任务,基于基尼指数 进行特征选择,生成二叉树结构。

应用场景举例

提高泛化能力

02

剪枝后的决策树更加简洁,能够更好地适应新数据,提高模型

的泛化能力。

减少计算资源消耗

03

简化决策树结构可以降低模型训练和预测的计算复杂度,节省

计算资源。

预剪枝策略及实现方法

设定决策树生长的最大深度

在决策树生长过程中,限制其最大深度,防止 过深导致过拟合。

设定叶节点最小样本数

当某个节点的样本数小于设定值时,停止对该 节点的划分,将其作为叶节点。

利用统计学方法进行剪枝

基于统计学原理,对决策树节点进行假设检验,判断是否需要继续划分。

后剪枝策略及实现方法

错误率降低剪枝(Reduced-Error Prun…

自下而上地对决策树进行剪枝,如果剪去某个子树后,整体错误率降低,则进行剪枝。

代价复杂度剪枝(Cost-Complexity Pr…

引入代价复杂度参数,通过最小化整体代价(错误率与复杂度之和)来进行剪枝。

THANKS

感谢观看

集成学习方法在决策树中应用

Bagging方法

通过自助采样法生成多个数据集, 分别训练决策树模型,再对多个 模型的结果进行投票或平均,降 低模型方差。

Boosting方法

通过迭代训练多个弱分类器,将 每个弱分类器的结果加权求和, 得到强分类器,提高模型性能。

人工智能决策树例题经典案例

人工智能决策树例题经典案例一、经典案例:天气预测决策树在天气预测中有广泛应用,下面是一个关于是否适宜进行户外运动的示例:1. 数据收集:- 温度:高(>30℃)/中(20℃-30℃)/低(<20℃)- 降水:是/否- 风力:高/中/低- 天气状况:晴朗/多云/阴天/雨/暴雨- 应该户外运动:是/否2. 构建决策树:- 根据温度将数据分为三个分支:高温、中温、低温- 在每个分支中,继续根据降水、风力和天气状况进行划分,最终得到是否适宜户外运动的决策3. 决策树示例:温度/ / \高温中温低温/ | | \ |降水无降水风力适宜/ \ | | / \是否高中低| |不适宜适宜- 如果温度是高温且有降水,则不适宜户外运动- 如果温度是高温且无降水,则根据风力判断,如果风力是高,则不适宜户外运动,如果风力是中或低,则适宜户外运动 - 如果温度是中温,则不论降水和风力如何,都适宜户外运动- 如果温度是低温,则需要考虑风力,如果风力是高,则适宜户外运动,如果风力是中或低,则不适宜户外运动4. 参考内容:决策树的构建和应用:决策树通过对输入特征进行划分,构建了一棵树形结构,用于解决分类或回归问题。

构建决策树主要包括数据预处理、特征选择、划分策略和停止条件等步骤。

特征选择可以使用信息增益、基尼指数等算法,划分策略可以使用二叉划分或多叉划分,停止条件可以是叶子节点纯度达到一定阈值或达到预定的树深度。

决策树的应用包括数据分类、特征选择和预测等任务。

天气预测案例中的决策树:将天气预测问题转化为分类问题,通过构建决策树,可以得到识别是否适宜户外运动的规则。

决策树的决策路径可以用流程图或树状图表示,帮助理解和解释决策过程。

决策树的节点表示特征值,分支表示判断条件,叶子节点表示分类结果。

决策树的生成算法可以基于启发式规则或数学模型,如ID3、C4.5、CART等。

决策树的优缺点:决策树具有可解释性强、易于理解和实现、能处理非线性关系等优点。

决策树在生活中的例子

决策树在生活中的例子决策树是一种常见的机器学习算法,它通过一系列的决策规则来对数据进行分类或预测。

这些决策规则可以用树状图形式表示,每个内部节点表示一个特征或属性,每个叶子节点表示一个类别或是一个预测的结果。

决策树的可解释性和易于理解的特点使得它在生活中有着广泛的应用。

以下是生活中常见的决策树的例子:1.疾病诊断决策树:医生在进行疾病诊断时,通常会根据患者的症状和检测结果,利用决策树来判断患者可能患有的疾病类型。

例如,医生可以通过询问患者是否有发烧、咳嗽等症状来进行初步判断,然后根据进一步的检测结果来确认疾病的类型。

2.贷款申请决策树:银行在进行贷款申请审核时,会根据申请人的个人信息(如年龄、工作年限、征信记录等)以及贷款金额等因素,利用决策树来判断该申请是否应该得到批准。

例如,银行可以根据申请人的年龄和工作年限来判断其信用等级,从而决定是否批准贷款申请。

3.产品推荐决策树:电商网站通常会根据用户的浏览历史、购买记录等信息,利用决策树来推荐相关产品给用户。

例如,当一个用户浏览了几个相似的产品时,网站可以根据用户的浏览记录和购买记录来推测该用户对其他相似产品的兴趣,从而向用户推荐相关的产品。

4.旅行路线决策树:当人们计划旅行时,他们通常会面临选择旅行目的地和路线的问题。

决策树可以帮助人们做出决策。

例如,当人们根据旅行偏好、时间和预算等因素,在一组候选目的地中进行选择时,决策树可以根据这些因素来帮助人们决定最佳的旅行目的地和路线。

5.个人理财决策树:当人们面临个人理财决策时,决策树可以作为辅助工具。

例如,当人们考虑是否购买其中一种投资产品时,决策树可以根据他们的风险偏好、投资目标和市场状况等因素来帮助他们决策。

决策树还可以帮助人们制定个人预算和理财计划。

决策树在生活中的应用不仅限于上述例子,而且还可以扩展到更多的领域,例如教育、市场营销、自然灾害预测等。

通过采用适当的特征选择和数据预处理方法,决策树能够提供准确和可解释的结果,使得人们能够更好地做出决策。

决策树例题经典案例python

决策树例题经典案例python摘要:1.决策树概述2.决策树例题:经典案例3.Python 在决策树中的应用4.决策树例题:Python 代码实现5.总结正文:1.决策树概述决策树是一种常见的机器学习方法,它通过一系列的问题来对数据进行分类或者预测。

决策树可以看作是一个问题树,每个内部节点表示一个特征,每个分支代表一个决策规则,每个叶子节点代表一个分类或预测结果。

2.决策树例题:经典案例假设我们有一个数据集,包含以下几个特征:性别、体重、是否购买运动鞋。

我们希望通过这些特征来预测一个人是否会购买运动鞋。

这就是一个典型的决策树应用场景。

3.Python 在决策树中的应用Python 中有很多库可以用来实现决策树,其中最常用的是scikit-learn。

scikit-learn 提供了决策树分类器(DecisionTreeClassifier)和决策树回归器(DecisionTreeRegressor)两种工具。

4.决策树例题:Python 代码实现下面我们通过一个简单的例子来展示如何使用Python 实现决策树。

首先,我们需要导入必要的库:```pythonimport numpy as npfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitfrom sklearn.tree import DecisionTreeClassifierfrom sklearn.metrics import accuracy_score```接下来,我们加载数据集并进行预处理:```pythoniris = load_iris()X = iris.datay = iris.target```然后,我们将数据集分为训练集和测试集:```pythonX_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)```接着,我们创建一个决策树分类器实例:```pythonclf = DecisionTreeClassifier()```最后,我们用训练集训练模型,并在测试集上进行预测:```pythonclf.fit(X_train, y_train)y_pred = clf.predict(X_test)```模型的准确率可以通过以下代码计算:```pythonaccuracy = accuracy_score(y_test, y_pred)print("Accuracy: {:.2f}%".format(accuracy * 100))```5.总结本篇文章通过一个简单的例子介绍了如何使用Python 实现决策树。

人工智能导论 第8章 人工神经网络及其应用(导论)1-47

x1

y

m 1

x2

y

m 2

x p1

y

m pm

35

8.2.2 BP学习算法

2. 学习算法

当yik

1 1 euik

时

x

d y wikj1

k k1 ij

d

m i

yim (1

yim)(

ym i

y) i

— —输出层连接权调整公式

d y y w d k i

k

i (1

k pk 1

i)

k 1 k1 li l

9

8.1 神经元与神经网络

1. 生物神经元的结构 2. 神经元数学模型 3. 神经网络的结构与工作方式

10

8.1.2 神经元数学模型

2. 人工神经元模型

1943年,麦克洛奇和皮兹提出M -P模型。

u1

(权重/突触)

wi1 (细胞体)

(神经冲动)

…

f ()

yi

un

win

激励函数

i (阈值)

-1

29

8.2 BP神经网络及其学习算法

1. BP神经网络的结构 2. BP学习算法 3. BP算法的实现

30

8.2.2 BP学习算法

▪ 两个问题:

(1)是否存在一个BP神经网络能够逼近给定的样本或者函数。

( 2)如何调整BP神经网络的连接权,使网络的输入与输出与 给定的样本相同。

1986年,鲁梅尔哈特(D. Rumelhart)等提出BP学习算法。

A {aij}NN

U u1 uM T

B {bik }N M

1 N T

V v1

T

vN

Y y1 yN T

决策树(完整)

无缺失值样本中在属性 上取值 的样本所占比例

ቤተ መጻሕፍቲ ባይዱ

谢谢大家!

举例:求解划分根结点的最优划分属性

根结点的信息熵:

用“色泽”将根结点划分后获得3个分支结点的信息熵分别为:

属性“色泽”的信息增益为:

若把“编号”也作为一个候选划分属性,则属性“编号”的信息增益为:

根结点的信息熵仍为:

用“编号”将根结点划分后获得17个分支结点的信息熵均为:

则“编号”的信息增益为:

三种度量结点“纯度”的指标:信息增益增益率基尼指数

1. 信息增益

香农提出了“信息熵”的概念,解决了对信息的量化度量问题。香农用“信息熵”的概念来描述信源的不确定性。

信息熵

信息增益

一般而言,信息增益越大,则意味着使用属性a来进行划分所获得的“纯度提升”越大。决策树算法第8行选择属性

著名的ID3决策树算法

远大于其他候选属性信息增益准则对可取值数目较多的属性有所偏好

2. 增益率

增益率准则对可取值数目较少的属性有所偏好著名的C4.5决策树算法综合了信息增益准则和信息率准则的特点:先从候选划分属性中找出信息增益高于平均水平的属性,再从中选择增益率最高的。

3. 基尼指数

基尼值

基尼指数

著名的CART决策树算法

过拟合:学习器学习能力过于强大,把训练样本自身的一些特点当作了所有潜在样本都会具有的一般性质,导致泛化性能下降。欠拟合:学习器学习能力低下,对训练样本的一般性质尚未学好。

过拟合无法彻底避免,只能做到“缓解”。

不足:基于“贪心”本质禁止某些分支展开,带来了欠拟合的风险

预剪枝使得决策树的很多分支都没有“展开”优点:降低过拟合的风险减少了训练时间开销和测试时间开销

决策树算法最经典应用案例

决策树算法最经典应用案例决策树算法是一种常用的机器学习算法,它可以应用于各种实际问题,帮助人们做出决策。

下面列举了决策树算法的十个经典应用案例。

1. 银行贷款风险评估银行可以使用决策树算法来评估客户的信用风险,根据客户的个人信息、收入情况、信用记录等特征,构建决策树模型,预测客户是否有偿还贷款的能力。

2. 电商推荐系统电商平台可以利用决策树算法根据用户的历史购买记录、浏览行为、个人偏好等信息,构建决策树模型,实现个性化的商品推荐,提高用户购买转化率。

3. 医学诊断医生可以使用决策树算法来辅助诊断疾病。

根据患者的症状、生理指标、病史等特征,构建决策树模型,帮助医生判断患者是否患有某种疾病,从而指导治疗方案。

4. 电影评分预测在线视频平台可以利用决策树算法根据用户的观看历史、评分记录、影片类型等信息,构建决策树模型,预测用户对未观看的电影的评分,从而为用户推荐感兴趣的电影。

5. 股票市场预测投资者可以使用决策树算法来预测股票市场的涨跌。

根据股票的历史交易数据、市场指标、财务数据等特征,构建决策树模型,预测股票的涨跌趋势,指导投资决策。

6. 人脸识别人脸识别系统可以利用决策树算法根据人脸图像的特征,构建决策树模型,识别出不同的人脸。

决策树的每个节点表示一个特征的判断,通过逐层判断,最终确定人脸的身份。

7. 自然语言处理自然语言处理任务中,如情感分析、文本分类等,可以使用决策树算法来构建模型,根据文本的词频、句法结构等特征,判断文本的情感倾向或类别。

8. 网络安全检测网络安全检测系统可以使用决策树算法来识别恶意攻击。

根据网络流量的特征、用户行为等信息,构建决策树模型,判断网络流量是否存在安全风险。

9. 智能交通智能交通系统可以利用决策树算法根据交通流量、车速、天气等信息,构建决策树模型,预测交通拥堵情况,为驾驶员提供最佳出行路线。

10. 疾病预测医疗领域可以利用决策树算法根据患者的基因、病史、生活习惯等特征,构建决策树模型,预测患者是否患有某种遗传性疾病,从而进行早期干预和治疗。

决策树例题经典案例280

决策树例题经典案例280决策树是一种常用的机器学习算法,它可以用于分类和回归任务。

决策树通过对数据集进行分割,构建一个树形结构,从而实现对数据的预测或分类。

在本文中,我们将通过经典案例来介绍决策树的应用和实现。

案例背景:假设我们有一个电商平台,我们希望通过用户的行为数据来预测用户是否会购买某种产品。

我们收集了一些用户的行为数据,包括浏览页面次数、点击广告次数、加入购物车次数等。

我们希望通过这些数据来构建一个决策树模型,从而预测用户的购买行为。

数据集:我们收集了1000个用户的行为数据,每个用户有以下特征:1. 浏览页面次数(0-100)。

2. 点击广告次数(0-10)。

3. 加入购物车次数(0-5)。

4. 是否购买(是/否)。

数据预处理:在构建决策树模型之前,我们需要对数据进行预处理。

首先,我们将数据集分为训练集和测试集,其中训练集占80%,测试集占20%。

然后,我们对特征进行归一化处理,将所有特征缩放到0-1之间,以便模型能够更好地学习特征之间的关系。

决策树模型构建:我们使用Python中的scikit-learn库来构建决策树模型。

首先,我们选择合适的决策树算法,比如ID3、CART等。

然后,我们通过训练集来训练模型,调整模型的参数,如最大深度、最小样本分割数等,以提高模型的准确性和泛化能力。

模型评估:在模型训练完成后,我们需要对模型进行评估。

我们使用测试集来评估模型的准确性、精确度、召回率等指标,以及绘制ROC曲线、混淆矩阵等来评估模型的性能。

模型预测:最后,我们使用训练好的决策树模型来对新的用户数据进行预测。

当有新的用户数据输入时,模型可以根据用户的行为特征来预测用户是否会购买产品,从而为电商平台提供决策支持。

总结:通过本案例的介绍,我们了解了决策树在电商平台中的应用。

决策树模型可以通过用户的行为数据来预测用户的购买行为,为电商平台提供决策支持。

同时,我们也学习了如何使用Python中的scikit-learn库来构建和评估决策树模型。

决策树原理和简单例子

决策树原理和简单例子决策树是一种常用的机器学习算法,它可以用于分类和回归问题。

决策树的原理是基于一系列的规则,通过对特征的判断来对样本进行分类或预测。

下面将通过原理和简单例子来介绍决策树。

1. 决策树的原理决策树的构建过程是一个递归的过程,它将样本集合按照特征的不同取值分割成不同的子集,然后对每个子集递归地构建决策树。

构建决策树的过程是通过对特征的选择来确定每个节点的划分条件,使得信息增益或信息增益比最大。

2. 决策树的构建假设有一个分类问题,样本集合包含n个样本,每个样本有m个特征。

决策树的构建过程如下:(1) 若样本集合中的样本都属于同一类别,则构建叶子节点,并将该类别作为叶子节点的类别标签。

(2) 若样本集合中的样本特征为空,或者样本特征在所有样本中取值相同,则构建叶子节点,并将该样本集合中出现次数最多的类别作为叶子节点的类别标签。

(3) 若样本集合中的样本特征不为空且有多个取值,则选择一个特征进行划分。

常用的划分方法有信息增益和信息增益比。

(4) 根据选择的特征的不同取值将样本集合划分成多个子集,对每个子集递归地构建决策树。

(5) 将选择的特征作为当前节点的判断条件,并将该节点加入决策树。

3. 决策树的例子假设有一个二分类问题,样本集合包含10个样本,每个样本有2个特征。

下面是一个简单的例子:样本集合:样本1:特征1=0,特征2=1,类别=1样本2:特征1=1,特征2=1,类别=1样本3:特征1=0,特征2=0,类别=0样本4:特征1=1,特征2=0,类别=0样本5:特征1=1,特征2=1,类别=1样本6:特征1=0,特征2=0,类别=0样本7:特征1=1,特征2=0,类别=0样本8:特征1=0,特征2=1,类别=1样本9:特征1=1,特征2=1,类别=1样本10:特征1=0,特征2=1,类别=1首先计算样本集合的信息熵,假设正样本和负样本的比例都是1:1,信息熵为1。

选择特征1进行划分,计算信息增益:对于特征1=0的样本,正样本有2个,负样本有2个,信息熵为1。

决策树例题经典案例

决策树例题经典案例决策树是一种常用的机器学习算法,它能够通过构建一棵树来对数据进行分类或者回归预测。

决策树通过对每个样本的特征进行划分,从而逐步构建树结构,最终得到一棵用于分类或者回归的决策树。

下面我们来看一个经典的决策树例题。

假设我们有一个数据集,包含了一些二分类问题的样本,每个样本有两个特征,特征1表示是否有房产(是/否),特征2表示是否有工作(是/否)。

我们的目标是通过这两个特征来预测样本的类别(是/否)。

我们可以根据这个问题构建一个决策树。

首先,我们需要选择一个特征来进行划分。

通常我们选择的划分特征是能够最大程度地将样本分开的特征。

在这个例子中,我们可以选择特征1作为划分特征。

然后,我们将特征1的取值分别为“是”和“否”的样本分成两个子集。

对于特征1取值为“是”的样本,我们可以看到它们的类别都为“是”,所以我们可以将其划分为一个叶子节点,并且将类别设为“是”。

对于特征1取值为“否”的样本,我们需要选择另一个特征来划分。

同样地,我们选择特征2作为划分特征。

对于特征2取值为“是”的样本,我们可以看到它们的类别有一部分为“是”,一部分为“否”,所以我们还需要继续划分。

我们选择特征1作为再次划分的特征。

对于特征2取值为“否”的样本,我们可以看到它们的类别都为“否”,所以我们可以将其划分为一个叶子节点,并且将类别设为“否”。

对于特征2取值为“是”,特征1取值为“否”的样本,我们可以看到它们的类别全部为“否”,所以我们可以将其划分为一个叶子节点,并且将类别设为“否”。

最后,我们得到的决策树如下:特征1是|--- 类别:是特征1否|--- 特征2是| |--- 类别:是||--- 特征2否|--- 类别:否通过这个决策树,我们可以根据样本的特征值来进行预测。

例如,对于一个样本,特征1为“是”,特征2为“否”,按照决策树的规则,我们可以预测该样本的类别为“否”。

决策树是一种直观、易于解释的机器学习算法,它能够根据数据集的特征进行分类或者预测,对于解决一些简单的二分类问题非常有效。

决策树算法例题

决策树算法例题

一、决策树基本概念与原理

决策树是一种基于树结构的分类与回归模型。

它通过一系列的问题对数据进行划分,最终得到叶子节点对应的分类结果或预测值。

决策树的构建过程通常采用自上而下、递归划分的方法。

二、决策树算法实例解析

以一个简单的决策树为例,假设我们要预测一个人是否喜欢户外运动。

已知特征:性别、年龄、是否喜欢晒太阳。

可以通过以下决策树划分:

1.根据性别划分,男性为喜欢户外运动,女性为不喜欢户外运动。

2.若性别为男性,再根据年龄划分,年龄小于30分为喜欢户外运动,大于30分为不喜欢户外运动。

3.若性别为女性,无论年龄如何,均分为喜欢户外运动。

通过这个决策树,我们可以预测一个人是否喜欢户外运动。

三、决策树算法应用场景及优缺点

1.应用场景:分类问题、回归问题、关联规则挖掘等。

2.优点:易于理解、可解释性强、泛化能力较好。

3.缺点:容易过拟合、对噪声敏感、构建过程耗时较长。

四、实战演练:构建决策树解决实际问题

假设我们要预测房价,已知特征:面积、卧室数量、卫生间数量、距市中心距离。

可以通过构建决策树进行预测:

1.选择特征:根据相关性分析,选择距市中心距离作为最佳划分特征。

2.划分数据集:将数据集划分为训练集和测试集。

3.构建决策树:采用递归划分方法,自上而下构建决策树。

4.模型评估:使用测试集评估决策树模型的预测性能。

通过以上步骤,我们可以运用决策树算法解决实际问题。

决策树计算方法例题讲解

决策树计算方法例题讲解决策树是一种常用的机器学习算法,用于分类和回归问题。

它通过构建一棵树形结构来进行决策,每个内部节点表示一个特征,每个叶子节点表示一个类别或一个数值。

下面我将通过一个具体的例题来详细讲解决策树的计算方法。

假设我们有一个数据集,其中包含了一些水果的特征(颜色、形状、纹理)以及对应的标签(是否为橙子)。

我们希望通过这些特征来构建一个决策树模型,能够根据水果的特征预测其是否为橙子。

首先,我们需要将数据集划分为训练集和测试集。

训练集用于构建决策树模型,测试集用于评估模型的性能。

1.特征选择在构建决策树之前,我们需要选择一个特征作为根节点。

常用的特征选择方法有信息增益、信息增益比、基尼指数等。

这里我们使用信息增益来选择特征。

信息增益衡量了在给定特征条件下,类别的不确定性减少的程度。

具体计算信息增益的步骤如下:-计算整个数据集的熵(entropy):-首先,统计每个类别的样本数量。

-然后,计算每个类别的概率,并求和。

-最后,根据概率计算整个数据集的熵。

-对于每个特征,计算其对应的信息增益:-首先,针对该特征的每个取值,将数据集划分为不同的子集。

-然后,计算每个子集的熵和权重,并求和。

-最后,用整个数据集的熵减去子集的熵和权重的乘积,得到信息增益。

选择具有最大信息增益的特征作为根节点。

2.构建决策树选择完根节点后,我们需要递归地构建决策树。

具体步骤如下:-对于每个内部节点,选择一个最佳的特征作为其子节点。

-将数据集根据该特征的不同取值划分为多个子集。

-对于每个子集,如果所有样本都属于同一类别,则将该子集设为叶子节点,并标记为该类别。

-否则,继续递归地构建决策树,直到满足停止条件(如达到预定深度或无法继续划分)。

3.决策树的剪枝构建完决策树后,我们需要进行剪枝操作,以避免过拟合现象。

剪枝可以通过预剪枝和后剪枝来实现。

-预剪枝:在构建决策树的过程中,在划分子集之前,先进行验证集的测试,如果测试结果不好,则停止划分,将当前节点设为叶子节点。

决策树公式和原理

决策树公式和原理宝子,今天咱来唠唠决策树这个超酷的东西。

决策树呢,就像是一棵倒着长的树,不过这棵树可神奇啦。

它有根节点、分支和叶节点。

根节点就是最开始的那个点,就像树的根一样,所有的决策都是从这儿开始发芽的呢。

比如说你在纠结今天是出去逛街还是在家看剧,这纠结的开始就是根节点啦。

那分支是啥呢?分支就像是从根节点伸出去的小树枝。

还是拿刚刚的例子说,如果你选择出去逛街,那关于去哪儿逛街,是去商场还是去小商业街,这不同的选择就像是不同的分支。

每个分支都代表着一种可能的决策方向。

叶节点就是这些树枝的尽头啦。

比如说你最后决定去商场逛街,然后在商场里选择了一家店,买了一件超好看的衣服,这个买衣服的结果就是一个叶节点。

它的原理其实就像是我们平时做决策的思路。

我们在生活中做决定的时候,也是一个一个问题去想的。

决策树就是把这个过程给整理得清清楚楚。

从数学公式的角度看,决策树主要是通过计算信息增益或者基尼指数这些东西来确定怎么分支的。

听起来有点复杂,咱简单说。

信息增益就像是在看哪个分支能够让我们对结果了解得更多。

比如说你有一堆水果,有苹果、香蕉和橙子。

你想把它们分类,那你可能会先看颜色这个属性,因为按照颜色来分,能让你更快地把这些水果分开,这个颜色属性就有比较大的信息增益。

基尼指数呢,也是类似的作用。

它是用来衡量一个节点里的数据有多“纯”。

如果一个节点里的数据都是一样的,那基尼指数就很小,就说明这个节点很“纯”啦。

就像一盒子里都是苹果,没有其他水果,那这个盒子里的数据就很“纯”。

决策树在好多地方都能用呢。

就像在预测天气的时候,如果我们要决定今天出门要不要带伞。

根节点可能就是看天气预报怎么说。

如果天气预报说可能有雨,那一个分支就是带伞出门,另一个分支就是不带伞赌一把。

然后再根据其他的因素,像是天空的云量啊,风的方向啊,继续分更多的分支。

最后得出一个比较靠谱的决策。

还有在商业里也很有用。

比如说一个公司要决定要不要推出一款新产品。

决策树简单案例

决策树简单案例

嘿,朋友们!今天来给你们讲个决策树的简单案例,保准让你们大开眼界!

比如说你要决定周末干啥,这就像是站在一棵决策树的根部。

你可能会想,哎呀,是在家宅着看剧呢,还是出去和朋友逛街呢?这就是决策树的两个分支呀!如果选择在家宅着看剧,那可能会很舒服自在,但也许会有点无聊;要是出去和朋友逛街呢,哇,那多有意思啊,可以看到好多新鲜玩意儿,还能和朋友嘻嘻哈哈,可就是有点累人。

再比如,你纠结要不要买一件很贵的衣服。

买吧,虽然穿起来会特别漂亮,让你自信心爆棚,哎呀,走在街上回头率肯定超高!但又想想那价格,真心肉疼啊!不买吧,又觉得有点不甘心,这么好看的衣服错过了多可惜呀!这是不是就像决策树又多了几个分支呀!

就像我有一次,面临着是去参加一个聚会还是自己安静待着的选择。

去聚会呢,说不定能认识很多新朋友,还能玩得很开心,可我又有点社恐,担心融入不进去会尴尬;自己待着呢,确实轻松自在,但又觉得会错失一些有趣的体验。

哎呀,这可真难抉择呀!

决策树就是这么神奇,它能让我们把各种可能的情况和后果都清楚地摆在眼前,就像帮我们打开了一个思维的地图。

所以啊,朋友们,决策树真的太有用啦!它能让我们在面对各种选择时更加理智,更清楚地看到每种选择的利弊。

下次当你犹豫不决的时候,不妨也试着画一棵决策树,说不定就能找到最好的答案呢!总之,决策树就是我们做决策的好帮手,能让我们少走弯路,何乐而不为呢!。

决策树的例子

决策树的例子1. 嘿,你知道吗?决策树就像我们人生路上的导航!比如说你在纠结午饭吃什么,是吃披萨呢还是汉堡呢?这就可以看成是一个决策树的节点呀,选择披萨可能会有美味的满足感,但可能会有点腻;选择汉堡呢,可能会比较方便快捷,但又好像没那么特别。

这是不是很有趣呢?2. 哇,决策树有时候就像玩游戏做选择一样!就好比你在玩冒险游戏,遇到一个分岔口,向左走还是向右走?这每个选择就是决策树上的分支呀,向左可能遇到宝藏,可也可能遇到怪物呀;向右也许是安全的,但也可能错过重要的东西,这种感觉太刺激啦,不是吗?3. 诶,决策树不就是帮我们做决定的好帮手嘛!比如你在考虑要不要去看电影,去看的话可能会度过一段愉快的时光,可也得花时间和钱呀;不去看呢好像又有点无聊,这不同的考虑因素不就是决策树上的不同路径嘛,真的很神奇呀!4. 你瞧,决策树简直就像一个聪明的军师!像是你面对一堆工作任务,先做这个呢还是那个呢?做这个可能更容易完成但没那么重要,做那个可能有挑战但对未来发展好,这就像是决策树上的各种策略分支,能帮你找到最佳路径呢,对吧?5. 哎呀,决策树就如同在迷雾中给我们指引的灯塔!比如说你纠结要不要去旅行,去呢可以增长见识但花费不少,不去呢又觉得生活有点平淡,这就是决策树上的不同走向呀,该怎么选呢,这可真让人纠结又兴奋呢!6. 嘿呀,决策树就像一个神秘的魔法图!像是在选择职业的时候,这个职业工资高但压力大,那个职业轻松但发展有限,这不就是决策树上的不同节点嘛,我们得好好思考该怎么走呢,是不是很有意思呀!7. 哇塞,决策树不就像走迷宫一样嘛!比如你在考虑要不要换个发型,换个新的可能很时尚但也可能不适合自己,不换呢又觉得没变化,这每一步的考虑都是决策树上的一个过程呀,让人又期待又紧张呢!8. 诶哟,决策树就像帮我们解决难题的好朋友!像在决定要不要投资的时候,投这个可能收益高但风险大,投那个可能稳妥但回报少,这就是决策树上的各种可能性呀,真的得好好斟酌呀!我觉得决策树真的太有用啦,能让我们更清晰地看到不同选择的后果,从而做出更好的决定!。

决策树模型案例实例

决策树模型案例实例决策树模型(DecisionTreeModel)是一种以单链接(即树的节点由每个分支的父节点连接)的方式组织属性的有归类类型的有监督学习模型。

它是由一系列决策(非线性)和条件定义一个树结构,其中每个内部节点表示一个属性,每个分支表示一个值,而叶节点表示一个类(分类)或值(回归)。

决策树模型的可视化形式是一棵树。

决策树模型的特点决策树模型是一种简单而有效的有监督学习模型,它具有以下几个特点:(1)决策树模型是可解释性强的,可以生成可视化的决策目录,结构清晰明确;(2)决策树模型能够处理不确定性、模糊性和多属性决策;(3)决策树模型可以在有限时间内进行查询,收集、存储和检索数据;(4)决策树模型可以准确地预测数据样本的标记,具有良好的学习性能。

决策树模型的应用决策树模型在实际应用中非常广泛,并能够帮助人们在实现复杂任务的情况下做出智能决策。

应用领域涵盖推荐系统、决策分析、数据挖掘、机器学习、搜索引擎、社会网络等等。

例如,决策树模型可以用于对客户消费行为进行分析,以洞察客户行为特征,帮助企业了解消费者的需求,并进行更有针对性的营销;再如,在推荐系统中,决策树模型也可以用于帮助企业为用户推荐更适合他们的产品或服务,提高客户满意度;再如,在机器学习领域,决策树模型可以用来对复杂的数据进行分类,这对于分析各种复杂数据是非常有用的。

决策树模型的建立建立决策树模型需要经过以下几个步骤:(1)数据集准备:首先,准备一个训练集和一个验证集,其中训练集用于构建决策树模型,而验证集用于测试决策树模型的性能;(2)特征选择:根据训练数据集,筛选出与结果有关的特征,并进行特征筛选;(3)构建决策树:根据前几步的准备工作,使用决策树算法进行训练,构建决策树模型;(4)模型评估:使用验证集,对构建的决策树模型进行评估,以确定模型的正确率和精度;(5)模型优化:根据模型评估的结果,进行模型优化,使模型的性能达到最佳。

人工智能决策树例题经典案例

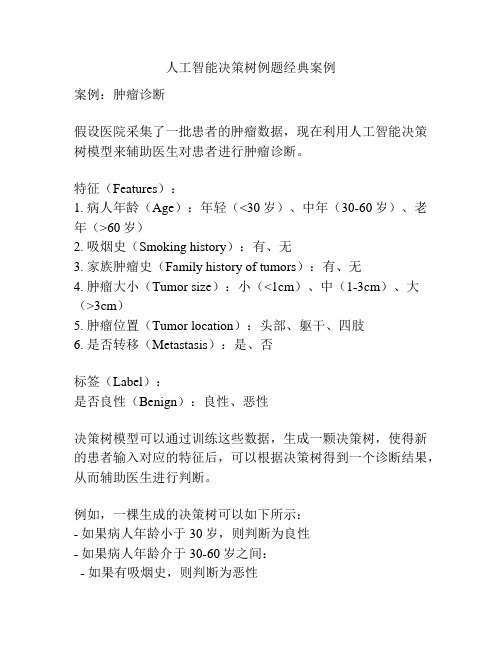

人工智能决策树例题经典案例案例:肿瘤诊断假设医院采集了一批患者的肿瘤数据,现在利用人工智能决策树模型来辅助医生对患者进行肿瘤诊断。

特征(Features):1. 病人年龄(Age):年轻(<30岁)、中年(30-60岁)、老年(>60岁)2. 吸烟史(Smoking history):有、无3. 家族肿瘤史(Family history of tumors):有、无4. 肿瘤大小(Tumor size):小(<1cm)、中(1-3cm)、大(>3cm)5. 肿瘤位置(Tumor location):头部、躯干、四肢6. 是否转移(Metastasis):是、否标签(Label):是否良性(Benign):良性、恶性决策树模型可以通过训练这些数据,生成一颗决策树,使得新的患者输入对应的特征后,可以根据决策树得到一个诊断结果,从而辅助医生进行判断。

例如,一棵生成的决策树可以如下所示:- 如果病人年龄小于30岁,则判断为良性- 如果病人年龄介于30-60岁之间:- 如果有吸烟史,则判断为恶性- 如果没有吸烟史:- 如果有家族肿瘤史,则判断为恶性- 如果没有家族肿瘤史:- 如果肿瘤大小为中或大,则判断为恶性- 如果肿瘤大小为小,且肿瘤位置为头部,则判断为恶性- 如果肿瘤大小为小,且肿瘤位置不在头部,则判断为良性- 如果病人年龄大于60岁,则判断为恶性利用这个决策树模型,当新的患者输入其特征时,比如一个40岁的病人,没有吸烟史,没有家族肿瘤史,肿瘤大小为小,位置在头部,没有转移,根据决策树的判断,该病人的肿瘤很可能是良性的。

通过人工智能决策树模型,可以减轻医生的负担,提供更加准确和快速的诊断结果,帮助医生做出适当的治疗决策。

决策树示例数据集

决策树示例数据集1.引言1.1 概述概述:决策树是一种常用的机器学习算法,它通过对数据集进行划分来构建一个树形结构的决策模型。

决策树简单直观,易于理解和解释,并且可以处理各种类型的数据,包括离散型和连续型。

决策树的构建过程是基于对数据集特征的不断划分,每个划分都根据一个特征和一个阈值来进行。

通过不断分割数据集,每一次分割都会使得子数据集纯度提高,即同一子数据集中的数据更加相似。

而不同子数据集之间的差异也会增大,使得最终的决策树能够更好地区分不同类别的数据。

在构建决策树的过程中,有几个重要的概念需要理解。

首先是根节点,也就是最开始的节点,它包含了整个数据集。

然后是内部节点,每个内部节点都代表一个特征,并包含了相应的阈值。

通过比较输入数据的特征值和阈值,可以确定下一步应该进入哪个子节点。

最后是叶节点,它代表了决策树的答案,也就是最终的分类结果。

决策树的构建过程可以通过不同的算法来实现,包括ID3、C4.5和CART等。

这些算法在选择最佳特征和阈值时会使用不同的评估准则,以达到构建最优决策树的目标。

常见的评估准则包括信息增益、增益率和基尼系数等。

决策树在实际应用中有广泛的用途。

例如,在医疗诊断中,决策树可以根据患者的病症和病史来做出诊断决策。

在金融领域,决策树可以根据客户的个人信息和信用记录来评估其信用风险。

此外,决策树还可以用于智能推荐系统、垃圾邮件过滤和文本分类等领域。

综上所述,决策树是一种强大且灵活的机器学习算法,它能够通过对数据集的划分来构建一个可解释性强且有效的决策模型。

在实际应用中,决策树可以帮助我们做出更准确、更快速的决策,提高工作效率并减少错误的发生。

1.2文章结构文章结构部分的内容可以包括以下内容:文章结构部分是对整篇文章的组织和框架进行介绍,主要是对各个章节以及它们之间的逻辑关系进行描述。

通过明确文章的结构,读者可以更好地理解文章的内容和脉络。

在本文中,文章结构部分可以包括以下内容。

决策树算法案例

决策树算法案例

咱来唠唠决策树算法的一个超有趣案例。

就说判断一个人今天会不会出门逛街这个事儿吧。

首先呢,我们看天气。

如果天气是大暴雨,狂风呼呼吹的那种,那这就是一个节点啦。

在这种天气下,大部分人可能就不想出门逛街了,直接就走向“不出门”这个分支。

但要是天气特别好,阳光明媚的,这又到了下一个判断节点。

接着我们看有没有钱。

要是钱包瘪瘪的,可能就只能走向“不出门”这一支,毕竟逛街可能就意味着花钱呀。

可要是有钱呢,那再看有没有小伙伴一起。

要是没有小伙伴陪着,有些人可能就觉得逛街没啥意思,还是选择“不出门”。

要是有小伙伴一起呢,哈哈,那基本就会走向“出门逛街”这个分支啦。

再比如说判断一个水果是苹果还是橙子。

我们先看形状。

如果形状是圆圆的,这就是一个节点。

然后再看颜色,如果是红色的,那很可能就是苹果这个分支啦。

要是颜色是橙色的呢,那再看看皮是不是光滑的。

如果皮光滑,那很可能就是橙子这个分支;要是皮有点粗糙,那还得再看看有没有果把儿之类的小特征,最后来确定到底是啥水果。

你看,决策树算法就像我们平时做决定一样,一步一步根据不同的条件来做出最后的判断,是不是很容易理解呢?。