Spider爬虫陷阱分析

搜索引擎spider爬虫(蜘蛛)原理

搜索引擎spider爬⾍(蜘蛛)原理做SEO的⼈应该要对搜索引擎的基本原理有⼀些了解,从搜索引擎发现⽹址到该页⾯拥有排名,以及后续更新整个过程中,搜索引擎到底是怎么⼯作的?你都需要了解。

对于专业的算法不必进⾏深⼊的研究,但是对于搜索引擎⼯作中的⽣命⼒和算法原理要有个简单的认知,这样才能更有效地开展SEO⼯作,知其然也要知其所以然;当然也有⼀些朋友不懂这些,照样做昨有声有⾊,但是有对搜索引擎⼯作原理,懂总⽐不懂好⼀点。

以往的SEO书藉中对这内容讲解都⽐较简单,希望在些能够尝试结合SEO实际⼯作和现象,更进⼀步剖析⼀下搜索引擎的⼯作原理,其实当你了解了搜索引擎的⼯作流程、策略和基本算法后,就可以在⼀定程序上避免因为不当操作⽽带来的不必要处罚,同也可以快速分析出很多搜索引擎搜索结果异常的原因。

有搜索⾏为的地⽅就有搜索引擎,站内搜索、全⽹搜索、垂直搜索等都⽤到搜索引擎;接下来,本⽂会根据从业认知,讨论⼀下全⽂搜索引擎的基本架构。

百度、⾕歌等综合搜索巨头肯定有着更为复杂的架构和检索技术,但宏观上基本原理都差不多的。

搜索引擎的⼤概架构如图2-1所⽰。

可以分成虚线左右两个部分:⼀部分是主动抓取⽹页进⾏⼀系列处理后建⽴索引,等待⽤户搜索;另⼀部分是分析⽤户搜索意图,展现⽤户所需要的搜索结果。

搜索引擎主动抓取⽹页,并进⾏内容处理、索引部分的流程和机制⼀般如下:1.派出spider按照⼀定策略把⽹页抓回到搜索引擎服务器;2.对抓回的⽹页进⾏链接抽离、内容处理,削除噪声、提取该页主题⽂本内容等;3.对⽹页的⽂本内容进⾏中⽂分词、去除停⽌词等;4.对⽹页内容进⾏分词后判断该页⾯内容与已索引⽹页是否有重复,剔除重复页,对剩余⽹页进⾏倒排索引,然后等待⽤户的检索。

当有⽤户进⾏查询后,搜索引擎⼯作的流程机制⼀般如下:1.先对⽤户所查询的关键词进⾏分词处理,并根据⽤户的地理位置和历史检索特征进⾏⽤户需求分析,以便使⽤地域性搜索结果和个性化搜索结果展⽰⽤户最需要的内容;2.查找缓存中是否有该关键词的查询结果,如果有,有为最快地呈现查询,搜索引擎会根据当下⽤户的各种信息判断其真正需求,对缓存中的结果进⾏微调或直接呈现给⽤户;3.如果⽤户所查询的关键词在缓存中不存在,那么就在索引库中的⽹页进⾏调取排名呈现,并将该关键词和对应的搜索结果加⼊到缓存中;4.⽹页排名是⽤户的搜索词和搜索需求,对索引库中⽹页进⾏相关性、重要性(链接权重分析)和⽤户体验的⾼低进⾏分析所得出的。

影响SEO的7个蜘蛛陷阱

影响SEO的7个蜘蛛陷阱在SEO工作中,网页被收录是基础工作,但对于搜索引擎来讲,极少情况会100%收录你网站的所有网页,搜索引擎的爬虫程序设计的再精巧,也难以逾越所谓的蜘蛛陷阱(蜘蛛陷进)。

蜘蛛陷阱是组织蜘蛛程序爬行网站的障碍物,通常是那些显示网页的技术方法,目前很多浏览器在设计的时候考虑过这些因素,所以可能网页界面看起来非常正常,但这些蜘蛛陷阱会对蜘蛛程序赞成障碍,如果消除这些蜘蛛陷阱,可以是蜘蛛程序收录更多的网页。

很对蜘蛛陷阱都是先进的技术方法,开发成本相对也较大,但是这些的确会影响搜索引擎对你网站的了解,甚至还可能被整个网站都不被搜索引擎收录,那么,当务之急,是消除这些蜘蛛陷阱,让搜索引擎收录你的更多网页,这才将有利于你的SEM营销计划的开展。

一、注意robots文件正确书写robots.txt文件看似一个简单的文本文件,放在网站的根目录下面,但它可以告诉搜索引擎的蜘蛛程序在服务器上的那些文件是可以被查看的,那些文件是私人文件将不被查看。

1、User agent(用户代理):User agent定义了下面的禁止命令使用于那个蜘蛛程序,如果对User agent定义为星号(*),则表示针对所有的蜘蛛程序。

User-agent:Baiduspider(百度蜘蛛)Disallow:/User-agent:*(所有蜘蛛)Disallow:/2、Disallow(禁止):禁止指明了具体那个文件蜘蛛程序不能查看,可以指定精确的文件名或者任意文件,甚至是目录名的一部分,比如:User-agent:*(所有蜘蛛)Disallow:/(所有文件被禁止查看)User-agent:Baiduspider(百度蜘蛛)Disallow:/admin(根目录下任何以admin开头的目录和文件)User-agent:*(所有蜘蛛)Disallow:/admin/(admin目录和该目录下的任何文件)意外的失误对网站带来的影响很普遍,在网站上线之前可能会对整个网站暂时屏蔽,但上线以后往往忙于其他事情而忘记该文件的更正,导致网站不能正常被搜索引擎收录。

菜鸟站长应如何巧妙避开蜘蛛陷阱

菜鸟站长应如何巧妙避开蜘蛛陷阱蜘蛛陷阱就是站长在设计网站时使用了一些搜索引擎不喜欢的,不利于搜索引擎日常工作的手法。

成功的避开搜索引擎的蜘蛛陷阱就要从每一个蜘蛛陷阱具体分析,来得出正确的方法。

最常见的蜘蛛陷阱如下:1、网站动态的URL很多动态的URL是由于自动调用数据库,使网站自动生成的掺杂很多参数的网址,一般来说,搜索引擎蜘蛛不喜欢动态的URL,因为动态的URL参数太多,搜索引擎蜘蛛的爬行工作效率将会大大受损,我们应该做好网站URL静态化的工作。

2、各种类型的跳转用户在访问站点的时候,会被无缘无故的跳转到其他的页面。

如果是按照用户的信息来跳转的话,那么还不会造成太大的影响,一旦是胡乱跳转的,那么就会造成大量的用户反感,从而流失有效客户。

常见的用户反感的跳转有:JS跳转、FLASH跳转、302跳转等,大家尽量不要使用这些跳转。

3、JS生成的导航很多网站之所以喜欢用JS,是因为JS可以给站点带来强大的视觉效果。

一些站点喜欢用JS生成的网站导航,这在搜索引擎看来是十分讨厌的,毕竟它目前还不能识别JS内部的链接,我们只有尽量让搜索引擎的爬行工作简单化,才能得到搜索引擎的青睐。

4、会员登陆功能有的网站内容会放在一些需要会员资格或者用户登陆后才能看到,这部分内容连搜索引擎都无法爬行和抓取。

大家知道搜索引擎蜘蛛不会去填写用户名和密码来访问该页面进而抓取其内容,这明显增加了蜘蛛工作的难度。

5、Frame(框架结构)如果一个新手站长不知道框架结构的话,那么你就可以放心了。

网站根据框架结构来设计的话就可以有效的维护更新页面。

搜索引擎访问一个框架结构设计的网站时,它只抓取HTML文件的代码,任何文字信息都不能被其抓取,那么搜索引擎也就不能识别该站点的内容。

别浪费时间等搜索引擎改变自己来适应你的站点,而是做到改变自己适应搜索引擎。

6、会话ID有的网站用户在访问时都会自动生成一个会话ID,存在于URL中。

搜索引擎每一次访问也会自动生成会话ID,那么就势必会造成同一个蜘蛛多次访问会产生不同的URL。

避免蜘蛛陷阱的技巧

避免蜘蛛陷阱的技巧避免蜘蛛陷阱的技巧“蜘蛛陷阱”是阻止蜘蛛程序爬行网站的障碍物,虽然网页界面看起来非常正常,但这些蜘蛛陷阱会对蜘蛛程序造成障碍。

哪些做法不利于蜘蛛爬行和抓取呢?怎么去避免这些蜘蛛陷阱呢?下面随店铺来了解一下!1、登录要求有些企业站和个人站设置一定要用户注册登录后,才能看到相关的文章内容,这种对蜘蛛不是很友好,因为蜘蛛无法提交注册,更无法输入用户名和密码登录查看内容。

对于蜘蛛来说,用户直接点击查看到的内容也是蜘蛛所能看到的内容。

如果你的网站有这种情况,请取消这一功能,但网站如果有VIP用户或部分资源,是可以这样设置的。

2、动态URL动态URL可以简单理解为在URL中加入过多的符号或者网址参数,虽然随着搜索引擎的技术发展,动态URL对于蜘蛛的抓取已经越来越不是问题了,但是从搜索引擎友好度上讲,静态哪陷是伪静态相对来说都比动态URL要好。

URL优化将在本章第6节中讨论。

/3、强制用Cookies强制用Cookies对于搜索引擎来说相当于直接禁用了Cookies,而有些网站为了实现某些功能。

会采取强制Cookies,例如跟踪用户访问路径,记住用户信息,甚至是盗取用户隐私等,如果用户访问这类站点时没有启用Cookies,所显示的页面就会不正常。

所以,对于蜘蛛来讲,同样的网页无法正常访问。

4、框架结构早期框架网页到处被泛滥使用,而现在很多网站已经很少使用了,一是因为现在随着各大CMS系统的开发问世,网站维护相对越来越简单了,早期网站使用框架是因为对网站页面的维护有一定的便利性,现在已经大可不必了,而且不利于搜索引擎收录也是框架越来越少被使用的`原因之一。

5、各种跳转对搜索引擎来说,只对301跳转相对来说比较友好,对其他形式的跳转都比较敏感。

如JavaScritp跳转、MetaRefresh跳转、Flash跳转、302跳转。

有些网站的做法很让人无奈,当打开网页后,会自动转向其他页面,如果打开的页面和你要找的页面丰体相关.+扫.笪讨很去,佃是很大部分的网站转向让你无任何理由和目的,这种转向不推荐大家使用,如果非要做转向,只推荐用301永久跳转,可以将权重进行传递,除此转向其他都不推荐,因为很多其他转向欺骗用户和搜索引擎,也是黑帽的一种手段,建议大家不要使用。

蜘蛛陷阱

致敬ቤተ መጻሕፍቲ ባይዱ

过渡页

~我来哇萌萌的分割面~

what

对蜘蛛不是很友好, 蜘蛛不会注册、也登陆要求 不会登陆。

Flash

各种无良小动 画,可惜蜘蛛 对此完全眼盲

动态URL不利于搜 索引擎蜘蛛的爬行动态URL 和抓取。

蜘蛛的 六大陷阱

各种跳转

跳来跳去,你 懂的

Cookies如果未开启, 则无法进行访问,这会 强制用 让蜘蛛无法进行访问。 Cookies

不要把flash当作首页

避免动态URL

尽管随着引擎技 术的发展对动态 url的抓取越来越 不成问题,但是 本着友好的原则, 静态,就算是伪 静态也比动态url 好太多

虽然首页弄个 flash很拉风,但 是蜘蛛无法抓取 flash,也不能点 击flash的超链接

致敬

禾本科(Poaceae)竹亚 科(Bambusoideae)高 大乔木状禾草类植物的 通称。植物学文献中记 载有75属以上,1,200 多种,但其中许多是同 物异名。

蜘蛛陷阱

网络信息素养结课报告 制作人:闫耀天

前 言

网页蜘蛛,又称网络爬虫,是一种按照一定的规则,自动的抓取万维网信息的程序 或者脚本。另外一些不常使用的名字还有蚂蚁,自动索引,模拟程序或者蠕虫。

它相当于搜索引擎的双手,其重要性不言而喻。

目 录

什么是“蜘蛛陷阱”

为什么避免“蜘蛛陷阱”

如何避免“蜘蛛陷阱”

框架结构

度娘的百科太 过深奥,无知 者无畏

why

为什么避免“蜘蛛陷阱”

辛辛苦苦 做了网站

希望打出 名气

如果不能 被检索到 亏死了就

网站管理 者要赚取 利益

然后才有 动力去做 网站的维 护

最常见的六大蜘蛛陷阱介绍

最常见的六大蜘蛛陷阱介绍无锡武警医院:/ 分享1、站内权重故意不分明有的站长为了把每一个页面都能提高权重,就故意把权重分散,甚至有的站长感觉自己的页面也可以与别人的首页做友情链接等傻帽想法,虽然理论是可以的,但是如果一个网站的权重分散严重,那么何谈百度排名?所以做排名还是要把网站权重分明化,这样对SEO优化很有帮助。

2、网站结构故意复杂有的朋友喜欢故意把网站结构搞的复杂,是因为想让蜘蛛多在网站逗留一会,可能会多收录一些页面,其实这样的想法是错误的,因为网站结构过于复杂,文件夹层级太多会影响蜘蛛爬行的,当蜘蛛感觉不安全的时候,蜘蛛会不管任何原因,直接退出网站,这样一来对网站收录影响很大,所以网站结构尽量简单最好。

3、flashflash是大部分网站都有的,因为flash可以生成很好的网站效果试图,所以有很多站长喜欢flash,但是flash当写入网页中是一大串乱码,所以如果你的网站是做SEO,那么蜘蛛爬行你的网站flash代码时,蜘蛛可能会被误导或者无法识别,所以蜘蛛最后感觉网站不安全,最后不信任退出,这样一来你的网站就有可能存在蜘蛛稀少爬行的后果,所以建议大家做动态图片用gif代替,不要用flash。

4、导航系统有很多朋友在设置导航系统的时候喜欢用js去写,这样一来在做SEO会带来很大的麻烦,因为大家都知道JS是蜘蛛无法识别的,并且里面的连接地址也不会去爬行,所以用JS写导航栏,最后的结果就是蜘蛛很少收录页面或不收录页面,给网站优化带来很大的问题。

5、用户体验度不高有很多网站会存在用户体验度不高的情况,比如浏览器兼容,或者功能问题,这样一来可能会影响蜘蛛爬行时收录到错误的信息,最后蜘蛛会感觉你的网站很差没有什么必要收录,最后对你的网站失去信心,所以提供用户体验尽可能的找到网站所有的bug,快速提高用户体验才是王道。

6、强制登陆论坛网站有很多都是必须登录后才能看网站信息,当蜘蛛爬行时,蜘蛛不会先注册然后再爬行网站的,所以强制登录只会给蜘蛛爬行时带来不便,这样一来蜘蛛爬行后会很不爽,因为不登录信息就现实不出来,这样一来蜘蛛会感觉你的网站是故意恶搞,最后网站有可能被K。

优化干货:网页设计中 那些急需避开的蜘蛛陷阱

优化干货:网页设计中那些急需避开的蜘蛛陷阱不论是新站,还是老站,从优化的角度而言,网站的页面一定要对搜索引擎友好,有利于蜘蛛爬行和抓取的页面是每一位SEO从业者不断努力地目标。

虽然说百度算法不断改革,将所谓的用户体验放在了首位,但SEOer们都清楚的一点是:网站不能为了更好的用户体验,将蜘蛛爬行和抓取的有力因素忽略,这样的网站也不能在搜索引擎中获得良好排名,又怎么能获得高流量呢?为了自身站点能够在良好用户体验的基础上,利于蜘蛛爬行和抓取,各位站长应该将那些不利因素尽可能的避开。

对于SEO从业者而言,将那些不利于蜘蛛爬行的网站设计技术称之为蜘蛛陷阱。

如果你想要拥有高质量的站点,那些蜘蛛陷阱应该尽量避免出现。

1、Flash不得不承认的是,Flash绝对会给用户带来很好的体验度,可它的存在对于搜索引擎而言是很不友好的,当然蜘蛛根本没有办法抓取Flash中的信息,所以大神总是会建议大家不要在站点里加入Flash。

如果仅仅是在网页的某个小部分中使用Flash,来增强用户的视觉效果还是可行的,如用Flash做成的广告、图标等。

因为这类小Flash仅仅是页面设计的很小部分,页面上存在更多的是其他以文字为主的内容,这样对搜索引擎和收录造成的影响也不会太大。

如果你想要让网站首页仅仅显示一个Flash文件,这就是所谓的蜘蛛陷阱,当然这样的设计是不被站长们接受的,因此Flash文件是优化站点时不被建议添加的内容。

2、Session ID可能很多人都不清楚Session ID到底是什么,其实它就是会话ID,有些站点会用它跟踪用户访问,每个用户访问网站时都会生成一个独特唯一的Session ID,加在URL上。

因此搜索引擎猪猪的每一次访问也会被当成一个新的用户,URL中会加上不同的Session ID,因此蜘蛛每次访问时的URL都会有所不同,但其网页内容并没有发生变化。

这样就形成了蜘蛛陷阱,对站点的优化是非常不利的,所以小编建议SEOer们不要使用这样的方式设计站点。

蜘蛛陷阱

蜘蛛陷阱大家都知道,百度也好、谷歌也好,先是由蜘蛛过来爬行,然后放入自己的数据库中,才能有排名等等。

而蜘蛛做为一项程序一些情况下不能对页面进行爬行和抓取的,我们要避免这些情况的发生,这样才能有利于网站被收录从而有排名,那么常见的蜘蛛的陷阱有哪些呢?这里做一些总结:1、Flash网页中的一小部分使用Flash来增强视觉效果是很正常的,比如Flash广告、图标等。

小的Flash和图片是一样的,只是HTML代码中很小的一部分,页面上还有其他以文字为主的内容,对搜索引擎并无抓取和收录无太大影响。

但对于一些网站而言,整个首页就是一个Flash构成,这就构成了蜘蛛陷阱。

搜索引擎抓取的HTML只有一个连向Flash文件的链接,没有其他内容。

搜索引擎是无法读取Flash 文件中的文字内容和链接的。

这类网站可能整体视觉比较好,但搜索引擎是看不到的。

不能索引出任何文字信息,更别说相关性了。

这就是一个纯Flash的网站首页:2、Session ID一些网站使用Session ID(会话ID)跟踪用户访问,每个用户访问网站时都会生成独特唯一的Session ID,加载URL中,蜘蛛的每一次访问也会被当成一个新的用户,URL中会加上一个不同的Session ID,这样蜘蛛每次来访问时所得的同一页面的URL是不一样的,后面带着一个不一样的Session ID,这也是最常见的蜘蛛陷阱之一。

3、各种跳转除了301重定向之外,搜索引擎对其他形式的跳转都比较敏感,比如302、JavaScript跳转、Flash、Meta Refresh跳转等。

一些用户访问首页的时候会自动被跳转到某个目录下面,一些常用的团购网站、生活类网站按照地理位置转向最适合的目录,这是无可厚非的。

但对于这种首页转向看不出任何理由和目的,这样的转向能免则免。

4、框架结构在网站诞生初七很流行,因为对网站的页面更新维护有一定的方便性,现在已经很少用的。

因为不利于搜索引擎抓取是框架越来越不流行的重要原因之一5、动态URL是数据库驱动的网站所生成的、带有问号、等号以及参数的网址。

常见的蜘蛛陷阱

常见的蜘蛛陷阱

蜘蛛陷阱:对搜索引擎来说很不友好并且不利于蜘蛛爬行和抓取的因素。

1、Flash 误区:为了使页面更加美观动感,页面大面积的使用Flash甚至整页都用Flash。

2、Session ID 每个用户访问网站时都会生成独特唯一的Session ID,这样蜘蛛访问的时候同一的页面,不同的URL,建议:跟踪用户可以使用cookies。

3、各种跳转搜索引擎会对各种形式的跳转都比较敏感。

如果确实需要进行跳转,301跳转是搜索引擎推荐的,其它跳转都对网站不利。

4、框架结构不要使用框架结构(frame),因为蜘蛛不认识。

5、动态URL 动态URL指的是数据库驱动的网站所生成的、带有问号的、等号及参数的网址。

影响蜘蛛抓取。

6、javascript链接用javascript可以创造出很多吸引人视觉的效果,很多人喜欢用javascript脚本生成很炫的导航系统。

这往往是蜘蛛不喜欢的。

所以不要使用。

7、要求登陆有些网站内容放在需要用户登陆之后才能看到的会员区域,这部分内容搜索引擎蜘蛛看不到,因为蜘蛛不会填写及注册。

常见的八个蜘蛛的陷阱

、各種跳轉

除了0'重定向之外,搜索引擎對其他形式的跳轉都比較敏感,比如0;、JavaScript跳轉、Flash、Meta Refresh跳轉等。

一些用戶訪問首頁的時候會自動被跳轉到某個目錄下面,一些常用的團購網站、生活類網站按照地理位置轉向最適合的目錄,這是無可厚非的。但對于這種首頁轉向看不出任何理由和目的,這樣的轉向能免則免。

;、Session ID

一些網站使用Session ID(會話ID)跟蹤用戶訪問,每個用戶訪問網站時都會生成獨特唯一的Session ID,加載URL中,蜘蛛的每一次訪問也會被當成一個新的用戶,URL中會加上一個不同的Session ID,這樣蜘蛛每次來訪問時所得的同一頁面的URL是不一樣的,後面帶著一個不一樣的Session ID,這也是最常見的蜘蛛陷阱之一。

常放入自己的數據庫中,才能有排名等等。而蜘蛛做爲一項程序一些情況下不能對頁面進行爬行和抓取的,我們要避免這些情況的發生,這樣才能有利于網站被收錄從而有排名,那麽常見的蜘蛛的陷阱有哪些呢?這裏做一些總結:

Байду номын сангаас

'、Flash

、框架結構

在網站誕生初七很流行,因爲對網站的頁面更新維護有一定的方便性,現在已經很少用的。因爲不利于搜索引擎抓取是框架越來越不流行的重要原因之一

、動態URL

是數據庫驅動的網站所生成的、帶有問號、等號以及參數的網址。一般來說動態URL不利于蜘蛛爬行,應該盡量去避免。對于動態URL的靜態化,相信有很多文章對其進行介紹。

網頁中的一小部分使用Flash來增強視覺效果是很正常的,比如Flash廣告、圖標等。小的Flash和圖片是一樣的,只是HTML代碼中很小的一部分,頁面上還有其他以文字爲主的內容,對搜索引擎並無抓取和收錄無太大影響。

网站优化常见蜘蛛陷阱分析

网站优化常见蜘蛛陷阱分析网站优化常见蜘蛛陷阱分析在网站优化中,不仅需要对网站进行站外优化和站内优化,还需要经常避免蜘蛛陷阱。

其实网站在制作之初就需要对后期网站的优化进行考虑,因为一些网站的制作对于搜索引擎很不友好,就导致不利于蜘蛛的爬行和抓取。

其实这样就构成了一个蜘蛛陷阱。

那么,网站优化常见蜘蛛陷阱有哪些?又该怎么去避免这些蜘蛛陷阱呢?文章将进行几点分析。

一、框架结构网站制作过程中,如果网站上使用框架结构,那么建议快速的取消掉。

虽说框架结构对网站的维护和更新有一定的方便性。

但是,它不利于搜索引擎蜘蛛抓取。

蜘蛛进入网站经常出现迷路等情况,会增加蜘蛛对网站的不友好程度。

二、Flash页面网站尽量使用静态页面,不能为了网站美观就使用很多Flash页面。

Flash页面是造成蜘蛛陷阱的一个重要原因。

因为搜索引擎蜘蛛抓取的只是HTML代码,只是一个连向Flash文件的链接,而没有文字内容。

网站不管做的多么好看,搜索引擎对此毫无兴趣,也就不能索引任何的文字信息,也就无从判断网站相关性。

所以应该尽量避免或者减少Flash的使用。

三、Javascript链接因为JS有很多惊人的各种效果,很多站长就用Javascript脚本做一些导航。

其实,Javascript同样也是比较严重的蜘蛛陷阱之一。

有的搜索引擎是可以获得Javascript上的链接,甚至可以执行脚本并跟踪链接。

但对于一些权重比较低的网站来说,还是大可不必浪费时间,不如多更新一些高质量的文章,多做几个外链。

四、Session ID如果网站使用Session ID跟踪用户访问,那么搜索引擎每一次访问网站页面时,就会出现一个不一样的Session ID,即使访问的'是同一个页面,也会出现不一样的ID,但是内容却是一样的,就形成了大量的重复性内容,这也就形成了一个蜘蛛陷阱,也不利于网站的优化。

那么通常建议使用cookies而不要生成Session ID。

SEO结构优化之蜘蛛陷阱

结构优化之蜘蛛陷阱

Flash跳转

描述: 使用Flash动画进行链接跳转 问题: 蜘蛛无法抓取Flash里面的内容 解决方法: 用css+div替换Flash,改成正常的HTML链接

结构优化之蜘蛛陷阱

js导航

描述: 使用JS制作的导航条 问题: 对于权重低的网站,蜘蛛觉得没必要抓取 解决方法: 将JS导航改成div+css导航,使用正常的HTML链接

蜘蛛陷阱有哪些?

蜘蛛陷阱:

1、sessionID 2、框架frame 3、302跳转 4、Flash跳转 5、js导航 6、要求登录 7、动态URL

结构优化之蜘蛛陷阱

sessionID

描述: 在线客服会话窗口 问题: 每次启动会话系统会自动生成一个ID,堆积ID太多会造成 网页信息冗余,蜘蛛会认为你的信息不够友好。 解决方法: 1.替换ID 2.用代码实现自动清除ID

结构优化之蜘蛛陷阱

蜘蛛陷阱又是什么?

“蜘蛛陷阱”是阻止蜘蛛程序爬行网站的障碍物,通常是那 些显示网页的技术方法,目前很多浏览器在设计的时候考虑过这 些因素,所以可能网页界面看起来非常正常,但这些蜘蛛陷阱会 对蜘蛛程 序造成障碍,如果消除这些蜘蛛陷阱,可以使蜘蛛程序 收录更多的网页。

结构优化之蜘蛛陷阱

结构优化之蜘蛛陷阱

框架frame

描述: 是一种用来布局页面的标签 问题: 使用frame来布局,会造成一个地址对应多个页面,而蜘 蛛只认为一个地址对应一个页面 解决方法: 使用DIV+CSS代替frame标签来布局

结构优化之蜘蛛陷阱

302跳转

描述: 一种把网页临时重定向到新地址的方法 问题: 可能被恶意临时重定向到不信任网页,且蜘蛛对于302表示 不友好 解决方法: 改用301永久性跳 根据参数使用PHP代码进行即时调用数据到页面显示 问题: 参数位置互换也可以正常访问,造成多个URL对应一个网页 解决方法: 1.静态化(可以向技术人员提要求) 2.伪静态(正则表达式)

SEM SEO专业名词术语解释大全(新手必看)

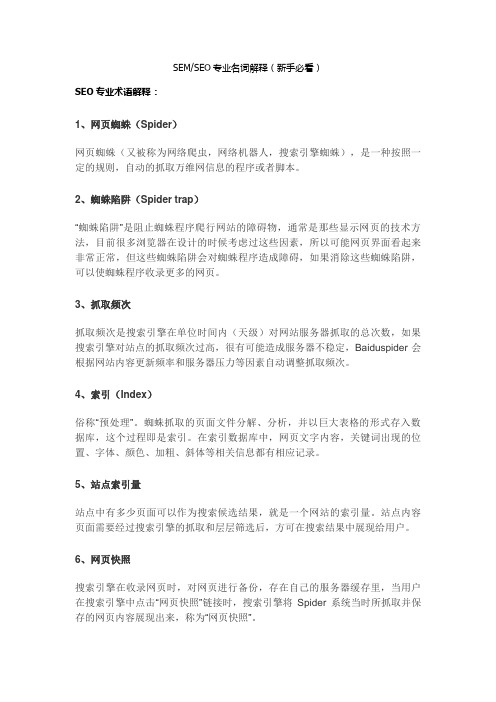

SEM/SEO专业名词解释(新手必看)SEO专业术语解释:1、网页蜘蛛(Spider)网页蜘蛛(又被称为网络爬虫,网络机器人,搜索引擎蜘蛛),是一种按照一定的规则,自动的抓取万维网信息的程序或者脚本。

2、蜘蛛陷阱(Spider trap)“蜘蛛陷阱”是阻止蜘蛛程序爬行网站的障碍物,通常是那些显示网页的技术方法,目前很多浏览器在设计的时候考虑过这些因素,所以可能网页界面看起来非常正常,但这些蜘蛛陷阱会对蜘蛛程序造成障碍,如果消除这些蜘蛛陷阱,可以使蜘蛛程序收录更多的网页。

3、抓取频次抓取频次是搜索引擎在单位时间内(天级)对网站服务器抓取的总次数,如果搜索引擎对站点的抓取频次过高,很有可能造成服务器不稳定,Baiduspider 会根据网站内容更新频率和服务器压力等因素自动调整抓取频次。

4、索引(Index)俗称“预处理”。

蜘蛛抓取的页面文件分解、分析,并以巨大表格的形式存入数据库,这个过程即是索引。

在索引数据库中,网页文字内容,关键词出现的位置、字体、颜色、加粗、斜体等相关信息都有相应记录。

5、站点索引量站点中有多少页面可以作为搜索候选结果,就是一个网站的索引量。

站点内容页面需要经过搜索引擎的抓取和层层筛选后,方可在搜索结果中展现给用户。

6、网页快照搜索引擎在收录网页时,对网页进行备份,存在自己的服务器缓存里,当用户在搜索引擎中点击“网页快照”链接时,搜索引擎将Spider 系统当时所抓取并保存的网页内容展现出来,称为“网页快照”。

7、网站权重(Page Strength)网站权重是指搜索引擎给网站(包括网页)赋予一定的权威值,对网站(含网页)权威的评估评价。

一个网站权重越高,在搜索引擎所占的份量越大,在搜索引擎排名就越好。

其中有几点需要注意:A、权重不等于排名B、权重对排名有着非常大的影响C、整站权重的提高有利于内页的排名。

8、网站降权(Rightdown)利用搜索引擎策略缺陷,以恶意手段获取与网页质量不符排名,而引发搜索结果和用户体验下降的行为都会被搜索引擎视为作弊行为,处罚原则:对用户体验及搜索结果质量影响不大的,去除作弊部分所获权值,对用户体验及搜索结果质量影响严重的,去除作弊部分所获权值并降低网站权重,直至彻底清理出搜索结果。

spiderflow爬虫踩过的坑,及注意事项

spiderflow爬⾍踩过的坑,及注意事项简介spider-flow 是⼀个爬⾍平台,以图形化⽅式定义爬⾍流程,⽆需代码即可实现⼀个爬⾍特性⽀持css选择器、正则提取⽀持JSON/XML格式⽀持Xpath/JsonPath提取⽀持多数据源、SQL select/insert/update/delete⽀持爬取JS动态渲染的页⾯⽀持代理⽀持⼆进制格式⽀持保存/读取⽂件(csv、xls、jpg等)常⽤字符串、⽇期、⽂件、加解密、随机等函数⽀持流程嵌套⽀持插件扩展(⾃定义执⾏器,⾃定义函数、⾃定义Controller、类型扩展等)⽀持HTTP接⼝插件redis插件mongodb插件IP代理池插件OSS插件OCR插件Selenium插件踩过的坑有些页⾯是通过ajax,异步加载再渲染的。

就需要⽤到,selenium插件。

但是每次执⾏都会打开⼀个测试的chrome浏览器。

如果是遍历⼏⼗或更多数据就会电脑卡死。

经过多⽅咨询了解到可以使⽤。

selenium的toUrl函数 ,使⽤⽅法在执⾏函数空间中写 ${resp.toUrl('')},这样做后,确实是在同⼀个浏览器跳转,节省的资源,以为问题解决了,我太年轻了,后⾯才发现,经过toUrl后resp只能存在新的⼀个,也就是说抓取了好⼏个页⾯但是最后输出都是相同的,是最后⼀个页⾯响应的值。

不死⼼再次尝试将每个页⾯的resp结果,放到⼀个数组中。

发现还是不⾏,经过咨询知道,只要通过了toUrl,resp就只存最后⼀个的值了,数组⾥存的值也是重复的数据,我再想这样要toUrl有何⽤。

最终解决⽅案使⽤selenium结合定时任务实现,这样⼀次抓⼏个页⾯,然后释放资源。

注意实现1. 循环变量:默认为item,与for(Object item : collections) 中的item意义相同,但是在没有地⽅配置次数或集合时为循环下标循环下标:当循环时,会产⽣下标(从0开始)以该值存⼊变量中,与for(int i =0; i < array.length;i++)中的i意义相同2. 定时任务,正常配置了cron,开了定时任务就应该定时执⾏才对, spiderflow在开了定时后还需要重新保存下cron才⽣效执⾏。

seo之不友好的网站结构-蜘蛛陷阱

seo之不友好的网站结构-蜘蛛陷阱

今天小编给大家分享的是seo之不友好的网站结构-蜘蛛陷阱,在这里详细的介绍了seo之不友好的网站结构-蜘蛛陷阱的相关知识,希望对大家有所帮助。

一些网站设计技术对搜索引擎说很不友好,不利于蜘蛛爬行和抓取,这些技术被称为蜘蛛陷阱。

常见的蜘蛛陷阱分为以下的几种:

常见一:JavaScript链接

示例:

常见二:在网页里穿插FLASH

示例:flashObject('index.swf')

常见三:Sesssion ID

示例:

百度推广官方网站

fengchao.baidu/nirvana/main.html?

userid=2473126#/manage/plan~_r=iwqk6gnq1y

fengchao.baidu/nirvana/main.html?

userid=2473126#/manage/plan~_r=3br2o0us12

其中,红色字体为Sesssion ID值

常见四:框架结构(iframe)

示例:百度MP3音乐盒

/* NOTE: remove when alb release。

避免蜘蛛陷阱的十大总结

避免蜘蛛陷阱的十大总结做SEO的童鞋都知道,网站被搜索引擎收录是关键,如果你的站点没有被搜索引擎收录,那么SEO就无从谈起。

所以要想网站能够被搜索引擎发现且网页能够被搜索引擎正常收录,那么首先就得使自己的站点便于蜘蛛的爬行。

搜索引擎爬取网页的工具被称之为蜘蛛或爬虫机器人,英文名即robot。

这些蜘蛛沿着超链接爬取我们的众多页面,但是有些页面是爬不到的,有的是因为网站自身存在一些不利于蜘蛛爬行,导致其对应的页面很难被搜索引擎收录,这样就形成了“蜘蛛陷阱”,一般指的是对搜索引擎不友好的网站制作技术,这些技术不利于蜘蛛爬取我们的页面,为了避免这种情况,小无名总结了如下因素,防止蜘蛛进入陷阱。

1:采用session id的页面,有的销售类站点为了分析用户的某些信息会采用会话ID来跟踪用户,访问站点的时候每个用户访问都会增加一次session id 而加入到URL中,同样蜘蛛的每一次访问也会被当做为一个新用户,每次蜘蛛来访问的URL中都会加入一个session id,这样就会产生了同一个页面但URL不同的情况,这种的一来会产生复制内容页面,造成了高度重复的内容页,同时也是最常见的蜘蛛陷阱之一。

比如说有的网站的为了提高销售业绩,而进行弹窗会话等,比如说您好来自XXX地的朋友等。

2:常识性的蜘蛛陷阱,采用强制注册或登录才能访问的页面,这种的对于蜘蛛来说就相当为难了,因为蜘蛛无法提交注册更无法输入用户名和密码登录查看内容,对于蜘蛛来说我们直接点击查看到的内容也是蜘蛛所能看到的内容。

3:喜欢采用flash的站点,之所以说是喜欢采用flash的站点是因为对于一些中小型企业来说,因为flash本身可以做很多种效果,尤其是放在导航上视觉效果强,所以不少企业站喜欢弄个flash来展示自己公司的实力,文化,产品等,甚至一些企业站点的网站首页就是一个flash,要么是在多长时间后通过flash跳转到另外一个页面,要么就是通过flash上的链接让用户自己点击后进入一个新的页面,但是对于蜘蛛来说一来是很难读取 flash中的内容,所以蜘蛛也很难点击flash上的链接。

爬虫网络安全问题探讨分析

摘要:随着新一代网络信息技术的应用和服务越来越多,网络信息安全事件频繁爆发,网络攻击、病毒入侵、信息泄密等事件层出不穷。

目前,大部分小型网站对于网络安全重视不足,网络安全风险意识比较薄弱,易引发一系列问题。

通过一个简单的网络爬虫案例测试某小型网站的安全性,通过网络爬虫技术分析、查找网络安全问题的原因,并就防范网络爬虫提出了一系列安全策略,提高网络风险意识。

关键词:网络爬虫;网络安全;安全策略1关于网络爬虫概念与“爬取”过程网络爬虫(WebSpider)又称“网络蜘蛛”,它能模拟正常用户的一些行为,按照一定的规则自动抓取网络中的各种信息。

搜索引擎也是网络爬虫的一种,但是不影响网站的正常运行,也没有任何恶意行为。

而一些恶意的网络爬虫常常通过短时间内大量访问等手段来消耗网络资源,使网站的正常运转出现问题,导致服务器崩溃等。

大部分爬虫程序通过预先设定一个队列存放URL,在进行网页爬取时,先从某一个或若干个URL开始,记录该URL,再从该网页上查找链接的其他URL放入队列,不断地从当前页面查找新的URL,如此循环往复,直到满足设定的停止条件。

2网络爬虫爬取某网站的案例与简单分析2.1预判某网站安全技术措施现在很多网站在一定程度上做了一些安全防护,但是由于成本以及技术原因等,大部分小型网站的网络安全策略比较薄弱,以一个爬虫案例来测试一下某网站网络安全问题。

首先找到一个某诗词网站上的内容,查看PC网站请求地址,https:///mingju/xx.aspx?p=2&t=&c=发现不同的页面只是p=xx不同,xx=当前页面值,当p<=30时,页面显示正常,但是当翻页超过30页时,系统返回了错误页面,提示“因服务器开支对本站造成巨大压力,请下载客户端进行访问”。

说明系统还是针对大量数据做了一些安全策略性的限制,当请求超过30页时提示使用手机APP 来访问。

于是尝试从APP上找破解方法,通过抓包工具PacketCapture 成功找到了数据请求接口。

Python网络爬虫的安全风险与防范措施

Python网络爬虫的安全风险与防范措施近年来,随着互联网的快速发展,网络爬虫技术的应用也日益广泛,而Python作为一种功能强大的编程语言,被广泛应用于网络爬虫开发中。

然而,网络爬虫的使用也带来了一系列的安全风险。

本文将从数据隐私泄露、网站压力增加和法律合规等方面探讨Python网络爬虫的安全风险,并提出相应的防范措施。

一、数据隐私泄露风险网络爬虫通过获取网站上的信息来实现其功能,然而,未经允许的数据获取和传输可能导致用户数据泄露的风险。

在使用Python网络爬虫时,应注意以下防范措施:1.合法的数据获取:应遵循网站的相关规定和政策,仅获取公开的、允许抓取的数据,并尽量避免获取用户敏感信息。

2.数据加密传输:使用HTTPS等加密传输协议,确保数据在传输过程中的安全性,提高数据的防护能力。

3.访问控制:设置访问频率限制,防止频繁访问导致对目标网站的压力增加,并且可以通过IP地址限制等措施,防止恶意用户的访问。

二、网站压力增加风险由于网络爬虫的特性,当大量爬虫同时访问一个网站时,会给网站带来巨大的压力,可能导致网站崩溃或响应延迟,给用户和网站运营商带来不便。

为了减少网站压力增加的风险,我们可以采取以下措施:1.合理的访问频率控制:通过设置访问频率限制,限制爬虫的访问速度,避免过于频繁的访问。

2.机器人协议遵守:遵守网站的机器人协议,了解网站对爬虫的访问规则和限制,避免对网站造成过大的负担。

3.分布式爬虫:将爬虫分布在多台机器上,避免单点压力过大,提高系统的承载能力。

三、法律合规风险在进行网络爬虫开发时,必须遵守相关的法律法规,尊重他人的合法权益,否则可能面临法律纠纷。

为了规避法律合规的风险,我们可以采取以下防范措施:1.充分了解法律法规:熟悉相关的法律法规,了解在进行网络爬虫开发和使用时需要遵守的规定。

2.尊重网站规则:遵守网站的规则和条款,不要进行未经授权的数据抓取和使用。

3.隐私政策保护:对于获取的用户数据,合理保护用户的隐私,严格按照隐私政策进行处理,避免泄露和滥用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

在闲逛时看到一篇关于数据的文章,有张图觉得挺有意思,特贴出一张来分享:

这张图形象的说明了搜索引擎的Spider在抓取网页时,一些不友好的元素会对其形成较坏的影响(说明:本人离开英文环境已半年,如有解释错误,勿怪):

1.Orphan Pages;Spider是根据链接抓取网页,没有链接的网页,自然使spider抓取困难。

2.Unfriendly seo-CMS System;CMS对seo不友好的话,会对spider形成一定的干扰,比如js、ajax、链接分布、frame结构等等。

3.Bad server Configuration;如阻止搜索引擎spider访问、302重定向、访问权限等等,以及服务器的稳定性,都有可能对spider造成致命的打击。

4.Cloaking;比如隐藏文字、没有任何内外链的网页,都会使spider出现问题。

5.Session Based Coding;URL根据访问者的cookie随机变换、html代码中大量的字符,这些session闯下的祸,对于一个不依赖seo的网站来说可能没什么,但是对于一个基于SEO 的网页来说可是致命的。

6.没有处理错误页面;如404跳转等。

本文转自【网人】详文参考:/SEO/65012.shtml。