南理工机器学习课件ml-chap2-Point

南理工机器学习课件ml-chap6-Boosting

CHAPTER 6: BoostingFighting the bias-variance tradeoffSimple (a.k.a. weak) learners are good e.g., naïve Bayes, logistic regression, decision stumps (or shallow decision trees)Low variance, don’t usually overfitSimple (a.k.a. weak) learners are bad High bias, can’t solve hard learning problems Can we make weak learners always good???No!!!But often yes…Voting (Ensemble Methods)Instead of learning a single (weak) classifier, learn many weak classifiers that are good at different parts of the input spaceOutput class:(Weighted) vote of each classifier Classifiers that are most “sure” will vote with more convictionClassifiers will be most “sure” about a particular part of the spaceOn average, do better than single classifier!But how do you ???force classifiers to learn about different parts of the input space?weigh the votes of different classifiers?Boosting [Schapire, 1989]Idea: given a weak learner, run it multiple times on (reweighted)training data, then let learned classifiers voteOn each iteration t:weight each training example by how incorrectly it was classifiedLearn a hypothesis –h tA strength for this hypothesis –αtFinal classifier:Practically usefulTheoretically interestingLearning from weighted data Sometimes not all data points are equalSome data points are more equal than othersConsider a weighted dataset D(i) –weight of i th training example (x i ,y i )Interpretations:i th training example counts as D(i) examplesIf I were to “resample” data, I would get more samples of “heavier” data pointsNow, in all calculations, whenever used, i th trainingexample counts as D(i) “examples”e.g., MLE for Naïve Bayes, redefine Count(Y=y) to be weighted countWhat αt to choose for hypothesis h t? [Schapire, 1989]Training error of final classifier is bounded by:What αt to choose for hypothesis h t?[Schapire, 1989]What αt to choose for hypothesis h t? [Schapire, 1989]If we minimize ∏t Z t , we minimize our training errorWe can tighten this bound greedily, by choosing αt and h t on each iteration to minimize Z t .What αt to choose for hypothesis h t? [Schapire, 1989] We can minimize this bound by choosing αt on each iteration to minimize ZtFor boolean target function, this is accomplished by[Freund & Schapire ’97]:Strong, weak classifiersIf each classifier is (at least slightly) better than randomεt< 0.5AdaBoost will achieve zero training error (exponentially fast):Is it hard to achieve better than random training error?Boosting results –Digit recognition [Schapire, 1989] Boosting oftenRobust to overfittingTest set error decreases even after training error is zeroBoosting generalization error bound[Freund & Schapire, 1996]T –number of boosting roundsd –VC dimension of weak learner, measures complexity of classifierm –number of training examplesBoosting generalization error bound[Freund & Schapire, 1996]T –number of boosting roundsd –VC dimension of weak learner, measures complexity ofclassifierm –number of training examplesBoosting and Logistic Regression Logistic regression assumes:And tries to maximize data likelihood:Equivalent to minimizing log lossBoosting and Logistic RegressionLogistic regression equivalent to minimizing log lossBoth smooth approximations of 0/1 loss!Logistic regression and BoostingWhat you need to know about BoostingCombine weak classifiers to obtain very strong classifierWeak classifier –slightly better than random on training dataResulting very strong classifier –can eventually provide zerotraining errorAdaBoost algorithmBoosting v. Logistic RegressionSimilar loss functionsSingle optimization (LR) v. Incrementally improving classification (B) Most popular application of Boosting:Boosted decision stumps!Very simple to implement, very effective classifier。

机器学习基础课件

模型诊断与改进策略

残差分析(Residual Analys…

通过检查模型的残差图,识别模型是否存在异方差性、非线性等问题。

特征重要性分析(Feature Impo…

通过分析模型中各个特征对预测结果的贡献程度,识别关键特征和冗 余特征。

案例五:使用神经网络进行手写数字识别

使用卷积神经网络等算法提取图像特 征,以便输入到神经网络模型中。

使用准确率、混淆矩阵等指标对模型 进行评估,调整模型参数以优化识别 性能。

数据准备

特征提取

模型训练

模型评估

收集手写数字图像数据集,包括训练 集和测试集,对数据进行预处理和增 强。

构建神经网络模型,对提取的特征进 行训练和学习,得到手写数字识别模 型。

遗传算法(Genetic Algorit…

模拟自然选择和遗传机制,在指定的超参数空间内进行搜索。

模型集成方法

装袋(Bagging)

通过自助采样法得到多个训练集,分别训练基模型,然后将基模型 的预测结果进行平均或投票得到最终预测结果。

提升(Boosting)

通过迭代地训练基模型,每次迭代时调整样本权重,使得之前被错 误分类的样本得到更多的关注。

决策树、神经网络、支持向量机等。

近年来,随着大数据和深度学习技术的快速发展,机 器学习在图像识别、语音识别、自然语言处理等领域

取得了突破性进展。

机器学习的应用领域

计算机视觉

通过训练图像识别模型,实现对图像中物体、 场景、文字等信息的自动识别和理解。

自然语言处理

利用机器学习技术,实现对文本数据的自动分析、 理解和生成,如情感分析、机器翻译等。

模型复杂度分析(Model Comple…

机器学习课件ppt

逻辑回归通过将输入变量映射到概率 值来工作,然后使用阈值将概率值转 换为二进制类别。它通常用于二元分 类问题,如点击率猜测或敲诈检测。

决策树

总结词

决策树是一种监督学习算法,它通过树形结构进行决策和分 类。

详细描写

决策树通过递归地将数据集划分为更小的子集来工作,直到 到达终止条件。每个内部节点表示一个特征的测试,每个分 支表示测试的一个结果,每个叶节点表示一个类标签。

深度学习的应用场景包括图像 辨认、语音辨认、自然语言处 理和推举系统等。

强化学习

01

强化学习是机器学习的一个分支 ,通过让智能体与环境交互来学 习最优的行为策略。

02

强化学习的特点是基于环境的反 馈来不断优化行为,以到达最终

的目标。

常见的强化学习算法包括Qlearning、SARSA和Deep Qnetwork等。

计算机视觉

机器学习在计算机视觉领域的应用包 括图像分类、目标检测、人脸辨认等 。

推举系统

机器学习在推举系统中的应用是通过 分析用户行为和偏好来推举相关的内 容或产品。

语音助手

机器学习在语音助手中的应用是通过 语音辨认和自然语言处理技术来理解 用户意图并作出相应回应。

02

机器学习基础

线性回归

总结词

线性回归是一种通过拟合数据点来猜测连续值的算法。

详细描写

线性回归通过找到最佳拟合直线来猜测因变量的值,该直线基于自变量和因变 量之间的关系。它使用最小二乘法来拟合数据,并输出一个线性方程,可以用 来进行猜测。

逻辑回归

总结词

逻辑回归是一种用于分类问题的算法 ,它将连续的输入变量转换为二进制 的输出变量。

数据清洗

去除特殊值、缺失值和重复数据,确保数据质量。

机器学习(PPT92页)

2. 2 激活转移函数

激活转移函数 f(Activation transfer function)简称激活函数,它是一个神经元 及神经网络的核心之一。神经网络解决问题 的能力与功效除了与网络结构有关外,在很 大程度上取决于网络激活函数。

线性函数、非线性斜面函数、阈值函数、 S形函数

人工神经网络

• 人工神经网络是对人类神经系统的一种模拟。尽管

然后,考察所得的每一个子类, 看其中的实例的结论 是否完全相同。如果完全相同, 则以这个相同的结论作 为相应分枝路径末端的叶子节点; 否则, 选取一个非父 节点的属性, 按这个属性的不同取值对该子集进行分类, 并以该属性作为节点, 以这个属性的诸取值作为节点的 分枝, 继续进行画树。 如此继续,直到所分的子集全都 满足: 实例结论完全相同, 而得到所有的叶子节点为止。 这样, 一棵决策树就被生成。下面我们进一步举例说明。

S1= {(3,C), (4,B), (7,C), (8,B), (11,B), (12,B)} S2={(1,C), (2,C), (5,A), (6,A), (9,A), (10,A)} 于是, 我们得到以性别作为根节点的部分决策树 (见图4(a))。

考察S1和S2,可以看出,在这两个子集中,各实 例的保险类别也不完全相同。这就是说,还需要对S1 和S2进行分类。对于子集S1,我们按“年龄段”将其 分类;同样,对于子集S2,也按“年龄段”对其进行 分类(注意:对于子集S2,也可按属性“婚状”分 类)。分别得到子集S11, S12, S13和S21, S22, S23。于 是,我们进一步得到含有两层节点的部分决策树(如

表1 汽车驾驶保险类别划分实例集

可以看出,该实例集中共有12个实例,实例中的性别、年 龄段和婚状为3个属性, 保险类别就是相应的决策项。 为表述方便起见, 我们将这个实例集简记为

机器学习入门课件

针对回归问题,解释这些指标的含义和计算方法,以及它 们在评估模型性能时的作用。

超参数调优策略分享

网格搜索

01

介绍网格搜索的原理和实现方法,以及如何使用网格

搜索进行超参数调优。

随机搜索

02 详细解释随机搜索的原理和实现过程,以及它在超参

数调优中的应用场景。

贝叶斯优化

03

分享贝叶斯优化的基本思想和实现方法,以及它在寻

要点三

应用场景

适用于分类和回归问题,如客户分群 、股票价格预测等。

03

无监督学习算法

K-means聚类分析

算法原理

通过迭代的方式将数据划分为K个簇,使得每个簇内部的数据点尽 可能相似,而不同簇之间的数据点尽可能不同。

应用场景

图像分割、文档聚类、客户分群等。

优缺点

简单易懂,收敛速度快,但需要预先指定K值,对初始质心敏感, 容易陷入局部最优解。

算法原理

通过训练一个神经网络来学习数据的 有效表示,使得输出尽可能接近输入

,从而得到数据的压缩表示。

应用场景

数据降维、异常检测、生成模型等。

优缺点

可以学习到数据的非线性表示,具有 较强的泛化能力,但需要大量的数据

进行训练,且容易过拟合。

04

强化学习与深度学习简介

强化学习原理及应用场景

强化学习原理

决策树与随机森林

要点一

定义

决策树是一种基于树形结构的监督学 习算法,通过对特征进行选择和划分 来构建决策树,从而实现对目标变量 的预测和分类。随机森林是一种集成 学习方法,通过构建多个决策树的集 成模型来提高预测的准确性和稳定性 。

要点二

原理

决策树通过选择最优特征进行划分, 使得每个叶子节点对应的目标变量具 有相似的取值。随机森林通过引入随 机性和集成学习的思想,降低了单个 决策树的过拟合风险,提高了预测的 准确性和稳定性。

machine-learning-机器学习PPT课件

两个可能的测试结果

1. + (阳性)

2. – (阴性)

先验知识

P(癌症) = 0.008 P(非癌) = 0.992 P(+|癌) = 0.98

P(-|癌) = 0.02 P(-|非癌) = 0.97 P(+|非癌) = 0.03

假定一个患者的测试结#43;) 和 P(ㄱcancer |+)

2021/3/12

21

P(vj) : 不同目标值的概率

P(Play Tennis = yes) = 9/14 = .64 P(Play Tennis = no) = 5/14 = .36

P(aj|vj) : 条件概率

P(Wind = strong | Play Tennis = yes) = 3/9 = .33 P(Wind = strong | Play Tennis = no) = 3/5 = .60 P(yes)P(sunny|yes)P(cool|yes)P(high|yes)P(strong|yes)=0.0053 P(no) P(sunny|no) P(cool|no) P(high|no) P(strong|no)= .0206 vNB = no

•P(+|cancer) P(cancer)=0.0078

•P(+|ㄱcancer) P(ㄱcancer)=0.0298

所以 hMAP = ㄱcancer

2021/3/12

17

最可能的分类结果是考虑各个假设的加权和,权重就 是他们各自的后验概率 最优分类器平均性能最好 当假设空间很大时,计算待价很大

2021/3/12

22

贝叶斯信任网络是一个概率图模型,通过一个有向无环图 表示一系列变量及其条件独立关系

南理工机器学习课件ml-chap4-Bayes

CHAPTER 4:Bayes optimal classifier Naïve BayesWhat’s learning, revisited2ClassificationOptimal classificationTheorem: Bayes classifier is optimal! That isProof:3B a y e sh ()(),()true Bayes true error h error h h x ≤∀How hard is it to learn the optimal classifier?Data =How do we represent these? How many parameters?Prior, P(Y):Suppose Y is composed of k classesLikelihood, P(X|Y):Suppose X is composed of n binary featuresComplex model →High variance with limited data!!!5Conditional IndependenceX is conditionally independent of Y given Z, if the probability distribution governing X is independent of the value of Y, given the value of Z e.g.,Equivalent to:6(,,)(|,)(|)i j k P X i Y J Z k P X i Z k ∀======(|,)(|)P Thunder Rain Lightning P Thunder Lightning =(,|)(|)(|)P X Y Z P X Z P Y Z =What if features are independent?Predict ThunderFrom two conditionally Independent features LighteningRain7MLE for the parameters of NBGiven datasetCount(A=a,B=b) ←number of examples where A=a andB=bMLE for NB, simply:Prior: P(Y=y) =Likelihood: P(X i=x i|Y=y) =10Subtleties of NB classifier 1 –Violating the NB assumption Usually, features are not conditionally independent:Actual probabilities P(Y|X ) often biased towards 0 or 1 Nonetheless, NB is the single most used classifier out thereNB often performs well, even when assumption is violated [Domingos & Pazzani ’96] discuss some conditions for good performance 111(,...,|)(|)n i iP X X Y P X Y ≠∏Subtleties of NB classifier 2 –Insufficient training dataWhat if you never see a training instance whereX1=a when Y=b?e.g., Y={SpamEmail}, X1={‘Enlargement’}P(X1=a | Y=b) = 0Thus, no matter what the values X2,…,X n take: P(Y=b | X1=a,X2,…,X n) = 0What now???12Bayesian learning for NB parameters –a.k.a. smoothingDataset of N examplesPrior“distribution” Q(X i,Y), Q(Y)m “virtual” examplesMAP estimateP(X i|Y)Now, even if you never observe a feature/class, posterior probability never zero14What if we have continuous X i?15Estimating Parameters:Y discrete, X i continuous16What you need to know about Naïve BayesOptimal decision using Bayes ClassifierNaïve Bayes classifierWhat’s the assumptionWhy we use itHow do we learn itWhy is Bayesian estimation importantGaussian NBFeatures are still conditionally independentEach feature has a Gaussian distribution given class17What’s (supervised) learning, more formallyGiven:Dataset : Instances e.g., Hypothesis space : He.g., polynomials of degree 8Loss function : measures quality of hypothesis e.g., squared error for regressionObtain:Learning algorithm: obtain h ∈H that minimizes loss functione.g., using matrix operations for regression Want to minimize prediction error, but can only minimize error in dataset 1811{;(),...,;()}N N x t x x T x <><>;()( 3.9,120,99);150i i x t x PGA IQ MLscore K <>=<===>h H ∈。

机器学习入门ppt课件

朴素贝叶斯分类器:假定模型的的各个特征变量都是概率独立的,根据训练数据和分类标记的的联合分布概率来判定新数据的分类和回归值。优点:对于在小数据集上有显著特征的相关对象,朴素贝叶斯方法可对其进行快速分类场景举例:情感分析、消费者分类

机器学习应用的场景

1. 风控征信系统2. 客户关系与精准营销3. 推荐系统4. 自动驾驶5. 辅助医疗6. 人脸识别7. 语音识别8. 图像识别9. 机器翻译量化交易智能客服商业智能BI

机器学习的通用步骤

选择数据:将你的数据分成三组:训练数据、验证数据和测试数据 (训练效果,验证效果,泛化效果)

数据建模:使用训练数据来构建使用相关特征的模型 (特征:对分类或者回归结果有影响的数据属性,例如,表的字段) 特征工程。

训练模型:使用你的特征数据接入你的算法模型,来确定算法模型的类型,参数等。

测试模型:使用你的测试数据检查被训练并验证的模型的表现 (模型的评价标准 准确率,精确率,召回率等)

使用模型:使用完全训练好的模型在新数据上做预测

调优模型:使用更多数据、不同的特征或调整过的参数来提升算法的性能表现

机器学习的位置

传统编程:软件工程师编写程序来解决问题。首先存在一些数据→为了解决一个问题,软件工程师编写一个流程来告诉机器应该怎样做→计算机遵照这一流程执行,然后得出结果统计学:分析并比较变量之间的关系

机器学习:数据科学家使用训练数据集来教计算机应该怎么做,然后系统执行该任务。该计算可学习识别数据中的关系、趋势和模式

智能应用:智能应用使用人工智能所得到的结果,如图是一个精准农业的应用案例示意,该应用基于无人机所收集到的数据

机器学习的分类

1、 监督式学习工作机制:用有正确答案的数据来训练算法进行机器学习。代表算法:回归、决策树、随机森林、K – 近邻算法、逻辑回归,支持向量机等。2、非监督式学习工作机制:训练数据没有标签或者答案,目的是找出数据内部的关联和模式,趋势。代表算法:关联算法和 K – 均值算法。3、强化学习工作机制:给予算法一个不断试错,并具有奖励机制的场景,最终使算法找到最佳路径或者策略。代表算法:马尔可夫决策过程,AlphaGo+Zero, 蒙特卡洛算法4. 半监督学习 工作机制: 训练数据一部分数据为生成数据,一部分数据为监督数据,算法分为生成器和判定器两部分, 生成器的目标是使判定器接受自己的数据,判别器是为了最大可能的区分生成数据和监督数据。通过不断的训练使两者都达到最佳性能。代表算法: GANs(生成式对抗网络算法)

机器学习ppt课件

最优策略求解

通过动态规划、蒙特卡洛方法或时间差分方 法等求解最优策略。

迁移学习应用场景及挑战

领域适应(Domain Adaptation)

将在一个领域(源领域)学到的知识迁移到另一个领域(目标领域)。

多任务学习(Multi-Task Learning)

多个相关任务共享知识,提高学习效率。

迁移学习应用场景及挑战

常见降维算法

主成分分析(PCA)、线性判别分析(LDA)、t分布邻域嵌入算法(t-SNE)等。

应用场景

图像处理、文本挖掘、生物信息学等。

异常检测

异常检测概念

识别出数据集中与大多数数据不同的离群点或 异常点。

常见异常检测算法

基于统计的方法、基于距离的方法、基于密度 的方法等。

应用场景

信用卡欺诈检测、网络入侵检测、医疗诊断等。

交叉验证

使用K折交叉验证等方法评估模型稳定性。

可视化展示

绘制ROC曲线、混淆矩阵等图表展示评估结果。

模型对比

将不同模型的结果进行对比分析,选择最优模型。

挑战与未来发展趋势

01

数据挑战

处理大规模、高维度、非结构化等 数据问题。

应用挑战

将机器学习技术应用到更多领域, 解决实际问题。

03

02

算法挑战

研究更加高效、稳定的算法模型, 提高泛化能力。

未来趋势

结合深度学习、强化学习等技术, 推动人工智能领域的发展。

04

THANKS

感谢观看

优化算法(如SGD、Adam、RMSprop等) 及其超参数调整

05 强化学习与迁移 学习

强化学习基本原理

智能体(Agent)与环境(Environment)…

机器学习.pptx

可解释性和公平性关注

提高机器学习模型的可解释性 ,确保决策公平合理,避免歧 视和偏见。

社会责任担当

积极承担社会责任,推动机器 学习技术为人类带来福祉,促 进社会进步。

THANKS FOR WATCHING

感谢您的观看

跨学科交叉研究

机器学习与生物学、医学、物理学等学科交叉,推动科学研究和应 用创新。

跨界合作推动产业变革

机器学习技术与各行业深度融合,推动产业升级和变革。

可持续发展和社会责任关注

数据隐私和安全保护

加强数据隐私保护,防止数据 泄露和滥用,保障用户权益。

环境可持续性考虑

在机器学习模型训练和部署过 程中考虑能源消耗、碳排放等 环境因素,推动绿色AI发展。

自训练算法

先用已标记数据训练一个初始分 类器,然后用这个分类器对未标 记数据进行预测,将预测结果作 为伪标签加入到训练集中,再重

新训练分类器。

生成模型算法

如半监督生成对抗网络(SGAN )等,通过生成模型来利用未标

记数据提高学习性能。

强化学习算法

价值迭代算法

通过不断更新状态值函数来寻找最优 策略,适用于环境模型已知的情况。

解决方法

03

通过调整模型复杂度、增加或减少特征、改变正则化参数等方

式来缓解过拟合或欠拟合问题。

模型选择与调优策略

01

模型选择

根据问题的特点和数据的性质,选择合适的模型进行建模。例如,对于

分类问题,可以选择逻辑回归、支持向量机、决策树等模型;对于回归

问题,可以选择线性回归、神经网络等模型。

02

参数调优

与统计学的关系

机器学习算法大量运用了 统计学的理论和方法,如 概率论、假设检验、回归 分析等。

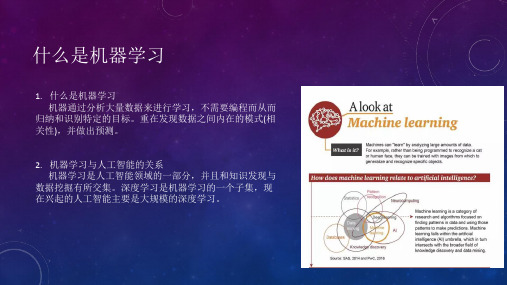

机器学习(完整版课件)

• 聚类模型评估指标:轮廓系数、CalinskiHarabasz指数等。

模型评估与选择

交叉验证

通过多次划分训练集和验证集来评估模型的性 能。

网格搜索

对不同的超参数组合进行穷举搜索,以找到最 优的模型参数。

随机搜索

在指定的超参数范围内进行随机采样,以找到较好的模型参数。

03

监督学习

线性回归与逻辑回归

励。

马尔可夫决策过程

强化学习任务通常建模为马尔可夫 决策过程(MDP),包括状态、 动作、转移概率和奖励等要素。

值函数与策略函数

强化学习通过估计值函数(状态值 函数或动作值函数)来评估不同行 为的好坏,并根据策略函数来选择 动作。

Q-learning与Sarsa算法

01

Q-learning算法

Q-learning是一种基于值迭代的强化学习算法,通过不断更新Q值表来

线性回归

一种通过最小化预测值与真实值之间的均方误差来拟合数据 的统计方法。它假设因变量和自变量之间存在线性关系,并 通过梯度下降等优化算法求解模型参数。

逻辑回归

一种用于解决二分类问题的广义线性模型。它使用sigmoid 函数将线性回归的输出映射到[0,1]区间,表示样本属于正类 的概率。逻辑回归通过最大似然估计求解模型参数,并使用 交叉熵作为损失函数。

• 嵌入法:在模型训练过程中进行特征选择。

特征选择与特征提取

根据领域知识提取有效特 征。

自定义特征提取

卷积神经网络等。

图像特征提取

词袋模型、TF-IDF等。

文本特征提取

模型评估与选择

分类模型评估指标

准确率、精确率、召回率、F1分数等 。

回归模型评估指标

均方误差、均方根误差、平均绝对误 差等。

《机器学习ch》课件

THANKS

感谢观看

无监督学习

总结词

无监督学习是指在没有标签数据的情况下,通过分析数据的内在结构和规律来发现模式 和关联性。

详细描述

无监督学习在数据挖掘、聚类、降维等领域有广泛应用。常见的无监督学习算法包括 K-均值聚类、层次聚类、主成分分析等。随着大数据时代的到来,无监督学习在处理

大规模数据集方面具有很大的潜力。

自监督学习与半监督学习

03

机器学习涵盖监督学习、无监督学习、半监督学习、强化 学习等多种学习方式,通过训练数据和无训练数据的学习 方式,让计算机系统能够自动地提取数据中的特征,并根 据这些特征进行分类、聚类、预测等任务。

机器学习的应用场景

金融风控

通过分析历史数据,预测信 贷违约、欺诈行为等风险, 提高金融机构的风险管理能 力。

《机器学习ch》ppt课件

目录

• 机器学习简介 • 机器学习的主要算法 • 机器学习的进阶知识 • 机器学习的未来发展

01

机器学习简介

机器学习的定义

01

机器学习是人工智能的一个子领域,旨在通过算法让计算 机从数据中学习并做出准确的预测或决策。

02

机器学习利用统计学、概率论、逼近论、凸分析、算法复 杂度理论等多学科知识,结合计算机硬件和软件技术,实 现计算机系统的智能化。

医疗诊断

利用机器学习算法对医学影 像、病理切片等数据进行自 动分析,辅助医生进行疾病 诊断。

推荐系统

根据用户的历史行为和喜好 ,自动推荐相关内容或产品 ,提高用户满意度和转化率 。

自然语言处理

通过机器学习算法对自然语 言文本进行自动分析、转换 和生成,实现人机交互和智 能问答等应用。

机器学习的基本原理

机器学习讲义2

Lagrange dual

• ‘≥’: weak duality • ‘=’: strong duality, true for QP if

• convex primal • feasible primal (true if Φ-separable) • linear constraints

—called constraint qualification

all αn≥0

min

b,w

1 2

wT

w

+

n=1

αn(1

−

yn(wT

zn

+

b))

L(b,w,α)

• inner problem ‘unconstrained’, at optimal:

∂L(b,w,α) ∂b

=0=

−

N n=1

αnyn

• no loss of optimality if solving with constraint

Solving Lagrange Dual: Simplifications (2/2)

max

all αn≥0, ynαn=0

N

min

b,w

1 2

wT

w

+

αn(1 − yn(wT zn))

n=1

• inner problem ‘unconstrained’, at optimal:

∂L(b,w,α) ∂wi

constraints now hidden in max

Dual Support Vector Machine

Motivation of Dual SVM

Fun Time

Consider two transformed examples (z1, +1) and (z2, −1) with z1 = z and z2 = −z. What is the Lagrange function L(b, w, α) of hard-margin SVM?

《机器学习简介》PPT课件

– Classification: discrete output

– Regression: continuous output

Bias-variance

.

7

Training and Validation Data

Full Data Set

Training Data Validation Data

Idea: train each model on the “training data”

and then test each model’s accuracy on the validation data

.

8

Underfitting & Overfitting

Predictive Error

Underfitting

.

17

Popular models

• Nearest neighbor

– Feature & distance

.

18

Popular models

• Support vector machine

.

19

Popular models

• Artificial neural network

.

20

Popular models

– Clustering

– Dimensionality reduction

– Factor analysis

.

10

Types of machine learning

• Semi-supervised learning

– Clustering or classification

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CHAPTER 2:

Point Estimation

Your first consulting job

A billionaire from the suburbs of Seattle asks you a question:

He says: I have thumbtack, if I flip it, what’s the

probability it will fall with the nail up?

You say: Please flip it a few times:

You say: The probability is:

He says: Why???

You say: Because…

2

Thumbtack –Binomial Distribution

P(Heads) = , P(Tails) = 1- Flips are i.i.d.:

Independent events

Identically distributed according to Binomial distribution Sequence D of Heads and Tails 3

θθ

H αT

α

Maximum Likelihood Estimation Data: Observed set D of Heads and Tails Hypothesis: Binomial distribution

Learning is an optimization problem What’s the objective function?

MLE: Choose q that maximizes the probability of observed data:

4

θ

H αT

α

Your first learning algorithm

Set derivative to zero:

5

How many flips do I need?

Billionaire says: I flipped 3 heads and 2 tails.

You say: q = 3/5, I can prove it!

He says: What if I flipped 30 heads and 20 tails?

You say: Same answer, I can prove it!

He says: What’s better?

You say: Humm… The more the merrier???

He says: Is this why I am paying you the big bucks???

6

PAC Learning

PAC: Probably Approximate Correct Billionaire says: I want to know the thumbtack parameter , within = 0.1, with probability at least 1-= 0.95. How many flips?8

θδε

Bayesian Learning

Use Bayes rule:

Or equivalently:

10

Likelihood function is simply Binomial: What about prior?

Beta prior distribution –P( )12

θ

Posterior distribution

13

Using Bayesian posterior

Posterior distribution:

Bayesian inference:

No longer single parameter:

Integral is often hard to compute

14

MAP: Maximum a posteriori approximation

As more data is observed, Beta is more certain

MAP: use most likely parameter:

15

MAP for Beta distribution

MAP: use most likely parameter:

Beta prior equivalent to extra thumbtack flips

As N →∞, prior is “forgotten”

But, for small sample size, prior is important!

16

What you need to know

Intro to probabilities

And, other related knowledge too

Point estimation:

MLE

Bayesian learning

MAP

17

What about continuous variables?

Billionaire says: If I am measuring a continuous variable, what can you do for me?

You say: Let me tell you about Gaussians…

18

Learning a Gaussian

Collect a bunch of data

Hopefully, i.i.d. samples

e.g., exam scores

Learn parameters

Mean

Variance

20

Log-likelihood of data:

MLE for variance

Again, set derivative to zero:

23

Bayesian learning of Gaussian parameters

Conjugate priors

Mean: Gaussian prior

Variance: Wishart Distribution

Prior for mean

25

MAP for mean of Gaussian

26。