MPI

MPI使用操作流程

MPI的编程语言与环境

总结词

MPI的编程语言与环境包括使用C/C、Fortran等编程语言编写MPI程序,以及使用MPI开发环境进行 调试和优化等操作。

详细描述

MPI是一种并行计算编程接口,支持多种编程语言,如C、C和Fortran等。在使用MPI进行并行程序设 计时,需要了解MPI提供的各种函数和库,以及相应的使用方法。同时,还需要掌握如何使用MPI开 发环境进行程序的调试和优化,以确保程序的正确性和性能。

数据分析

MPI还可以用于大规模数据 分析,如处上述领域,MPI还在金 融、医疗、图像处理等领域 得到了应用。

02

MPI的基本原理

MPI的通信方式

点对点通信

MPI允许两个进程之间直接发送和接收消息,实现同步通信。

广播和汇聚通信

MPI也支持广播和汇聚操作,让一个进程发送消息给所有其他进程或让所有进 程聚集到一个进程。

MPI将进一步推动标准化和开放性发展,促进不同厂商 和平台的互操作性和兼容性,以降低使用门槛和成本。

可扩展性和灵活性

MPI将进一步增强可扩展性和灵活性,支持更大规模和 不同类型的并行计算任务,以满足不断增长的计算需求 。

安全性与可靠性

MPI将进一步关注安全性与可靠性,确保并行计算过程 中的数据安全和系统稳定性,以满足重要应用的需求。

3

处理单元与通信单元分离

MPI将处理单元和通信单元分离,让程序员更 加专注于算法实现,而不需要过多考虑通信细 节。

03

MPI的使用方法

MPI的安装与配置

总结词

MPI的安装与配置是使用MPI进行并行计算的第一步 ,包括安装MPI运行时环境、设置环境变量和配置网 络等步骤。

详细描述

mpi规约

MPI规约1. 什么是MPIMPI(Message Passing Interface)是一种用于并行计算的通信协议和编程模型。

它定义了一组函数、常量和数据类型,用于在并行计算中进行进程间的通信和同步操作。

MPI的目标是提供一个标准化的并行编程接口,使得开发者可以方便地编写并行程序,并在不同的计算平台上进行移植。

MPI最初由一些高性能计算领域的研究人员发起,目前已成为广泛使用的并行编程框架之一。

MPI的设计理念是基于消息传递的分布式内存模型,它允许开发者在多个进程之间进行通信,通过发送和接收消息来共享数据和进行协作计算。

2. MPI的特点MPI具有以下几个特点:2.1 并行性MPI是一种并行编程模型,它允许开发者将计算任务划分为多个子任务,并在多个进程之间进行并行计算。

每个进程都可以独立地执行指定的计算任务,通过消息传递来交换数据和协调计算。

2.2 分布式内存模型MPI采用分布式内存模型,每个进程都拥有独立的内存空间。

进程之间通过消息传递来进行通信,而不需要共享内存。

这种模型使得MPI程序可以在分布式计算环境中运行,充分利用多台计算机的计算资源。

2.3 灵活性MPI提供了丰富的通信和同步操作函数,开发者可以根据具体需求选择合适的函数来实现进程间的通信和同步。

MPI支持点对点通信、广播、规约、散射、聚集等常见的通信模式,同时也支持自定义通信操作。

2.4 可移植性MPI的标准化设计使得开发者可以方便地编写可移植的并行程序。

只要目标计算平台支持MPI标准,就可以在该平台上运行MPI程序,而不需要对程序进行修改。

这种可移植性使得MPI成为并行计算领域的重要工具。

3. MPI的规约操作MPI规约操作(MPI Reduction)是一种在并行计算中常用的操作,用于将多个进程的数据合并为一个结果。

MPI规约操作可以用于求和、求积、求最大值、求最小值等各种聚合计算。

MPI规约操作的基本思想是将多个进程的数据按照指定的操作进行合并,然后将合并结果发送给指定的进程。

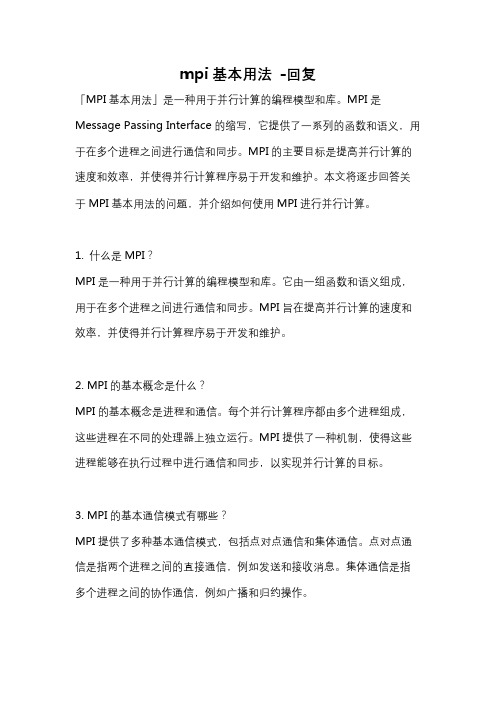

mpi基本用法 -回复

mpi基本用法-回复「MPI基本用法」是一种用于并行计算的编程模型和库。

MPI是Message Passing Interface的缩写,它提供了一系列的函数和语义,用于在多个进程之间进行通信和同步。

MPI的主要目标是提高并行计算的速度和效率,并使得并行计算程序易于开发和维护。

本文将逐步回答关于MPI基本用法的问题,并介绍如何使用MPI进行并行计算。

1. 什么是MPI?MPI是一种用于并行计算的编程模型和库。

它由一组函数和语义组成,用于在多个进程之间进行通信和同步。

MPI旨在提高并行计算的速度和效率,并使得并行计算程序易于开发和维护。

2. MPI的基本概念是什么?MPI的基本概念是进程和通信。

每个并行计算程序都由多个进程组成,这些进程在不同的处理器上独立运行。

MPI提供了一种机制,使得这些进程能够在执行过程中进行通信和同步,以实现并行计算的目标。

3. MPI的基本通信模式有哪些?MPI提供了多种基本通信模式,包括点对点通信和集体通信。

点对点通信是指两个进程之间的直接通信,例如发送和接收消息。

集体通信是指多个进程之间的协作通信,例如广播和归约操作。

4. 如何在MPI程序中发送和接收消息?MPI提供了一对发送和接收函数,用于在进程之间发送和接收消息。

发送函数将数据从一个进程发送给另一个进程,而接收函数用于接收来自其他进程的数据。

要发送消息,可以使用MPI_Send函数,而要接收消息,可以使用MPI_Recv函数。

5. MPI如何进行同步操作?MPI提供了多种同步操作,包括阻塞和非阻塞操作。

阻塞操作意味着进程将被阻塞,直到某个操作完成。

非阻塞操作允许进程在操作进行的同时执行其他操作。

要进行阻塞同步,可以使用MPI_Barrier函数;而要进行非阻塞同步,可以使用MPI_Ibarrier函数。

6. 如何在MPI程序中使用集体通信?MPI提供了一系列的集体通信函数,用于实现多个进程之间的协作通信。

其中,广播操作将一个进程的数据发送给所有其他进程,而归约操作将多个进程的数据合并为一个结果。

mpi用法

MPI(Message Passing Interface)是一种并行计算中的通信协议,用于在多个计算节点之间传递消息以实现数据共享和协同计算。

下面是关于MPI的基本用法的一些关键点:1. 安装MPI库:要使用MPI,您需要安装MPI库,这通常涉及到下载和安装适用于您的操作系统的特定版本的MPI库。

2. 创建进程组:在MPI中,进程组是一个包含多个进程的集合。

您可以使用MPI_Init和MPI_Init_thread等函数来初始化MPI环境并创建进程组。

3. 发送消息:您可以使用MPI_Send函数将消息发送到指定的进程。

发送消息时,您需要指定接收消息的进程的标识符以及要发送的数据。

4. 接收消息:您可以使用MPI_Recv函数从指定的进程接收消息。

接收消息时,您需要指定接收消息的进程的标识符以及用于存储接收数据的缓冲区。

5. 分发数据:您可以使用MPI_Scatter等函数将数据分布到多个进程中,以便在并行计算中共享数据。

6. 收集数据:您可以使用MPI_Gather等函数将多个进程中的数据收集到一个中央位置,以便进行进一步的处理。

7. 使用标签:在发送和接收消息时,您可以使用标签来指定要发送或接收的消息的标识符。

这有助于区分不同的消息并在多个消息之间进行区分。

8. 处理错误:在MPI中,您应该始终处理可能的错误情况,例如发送消息失败或接收消息超时等。

您可以使用MPI_Error_string等函数来获取有关错误的详细信息。

下面是一个简单的MPI程序的示例,用于在两个进程之间发送和接收整数数据:```c#include <mpi.h>#include <stdio.h>int main(int argc, char **argv) {int rank, size;int sendbuf, recvbuf;int host_rank;MPI_Init(&argc, &argv);MPI_Comm_rank(MPI_COMM_WORLD, &rank);MPI_Comm_size(MPI_COMM_WORLD, &size);if (rank == 0) {sendbuf = rank + 1;printf("Sender: sending value %d\n", sendbuf);MPI_Send(&sendbuf, 1, MPI_INT, 1, 0, MPI_COMM_WORLD);} else {MPI_Recv(&recvbuf, 1, MPI_INT, 0, 0, MPI_COMM_WORLD, MPI_STATUS_IGNORE);printf("Receiver: received value %d\n", recvbuf);}MPI_Finalize();return 0;}```在这个示例中,我们使用MPI_Send将整数发送到进程号为1的进程,并使用MPI_Recv从该进程接收整数。

mpi 同步通信 标准通信 效率

在高性能计算中,MPI(Message Passing Interface)是一种常用的并行编程模型,它提供了一套标准的通信接口和语义,以实现不同节点之间的数据交换和协同计算。

在MPI编程中,通信是至关重要的,而同步通信和标准通信则是其中两个重要的概念。

本文将着重介绍MPI中的同步通信、标准通信以及它们对通信效率的影响。

1. 同步通信在MPI中,同步通信是指发送和接收操作之间的同步关系。

当进程A调用发送操作将数据发送给进程B时,进程B需要调用接收操作接收数据。

在这个过程中,如果进程A和进程B没有达成一致的同步操作,就会导致通信错误或者数据丢失。

同步通信可以确保数据的完整性和可靠性。

在实际编程中,同步通信通常使用MPI_Send和MPI_Recv函数来实现。

当进程A调用MPI_Send发送数据时,进程A会被阻塞,直到进程B调用MPI_Recv接收数据为止。

这种同步模式保证了数据的正确传输,但也会造成一定的性能开销。

2. 标准通信标准通信是MPI中的另一个重要概念,它定义了进程之间的数据交换模式。

在标准通信中,数据的发送和接收操作是非阻塞的,进程可以在调用发送或接收操作后立即进行其他计算,而不必等待数据的实际传输完成。

这种方式可以提高通信的并行度和效率。

在MPI中,标准通信通常使用MPI_Isend和MPI_Irecv函数来实现。

这两个函数分别表示非阻塞发送和接收操作,它们会立即返回并允许进程进行其他计算,而不必等待数据的传输完成。

当数据实际传输完成后,可以通过MPI_Wait或MPI_Test函数来检查通信是否完成。

标准通信可以显著提高通信效率,尤其是在大规模并行计算中。

3. 效率在MPI编程中,同步通信和标准通信对通信效率都有着重要的影响。

同步通信可以确保数据的完整性和一致性,但其阻塞性会降低程序的并行性和性能。

在处理大量数据的高性能计算中,同步通信可能会成为性能瓶颈,因此需要合理地使用同步通信,避免过多的阻塞操作。

MPI使用操作流程

使用MPI实现实时图像处理

总结词

MPI还可以用于实时图像处理领域,如安防 监控、无人驾驶等。

详细描述

在实时图像处理过程中,MPI将图像数据分 配给多个处理节点,并行进行图像分析和处 理。这种方法能够提高处理效率和响应速度 ,对于安防监控、无人驾驶等领域具有广泛

应用前景。

使用MPI实现复杂网络分析

MPI的编程语言与环境

总结词

MPI的编程语言与环境包括使用C/C、Fortran等编程语言编写MPI程序,以及使用MPI开发环境进行 调试和优化等操作。

详细描述

MPI是一种并行计算编程接口,支持多种编程语言,如C、C和Fortran等。在使用MPI进行并行程序设 计时,需要了解MPI提供的各种函数和库,以及相应的使用方法。同时,还需要掌握如何使用MPI开 发环境进行程序的调试和优化,以确保程序的正确性和性能。

解决方案

可以采用文件锁机制或其他同步机制来确保文件读写操作 的正确性和一致性。同时,检查程序中是否有必要的文件 读写同步操作逻辑错误。

05

MPI的应用案例分析

使用MPI实现高性能计算

总结词

MPI(Message Passing Interface,消 息传递接口)是一种高效的并行计算技术 ,适用于高性能计算领域。

处理单元与通信单元分离

MPI将处理单元和通信单元分离,使得程序员可以专注于解决问 题本身,而不必过多关注通信细节。

03

MPI的使用方法

MPI的安装与配置

要点一

总结词

MPI的安装与配置是使用MPI进行并行计算的第一步, 包括安装MPI运行时环境、设置环境变量和配置网络等 步骤。

要点二

详细描述

MPI的安装与配置是使用MPI进行并行计算的基础步骤 。首先,需要从MPI的官方网站或相关渠道下载合适的 MPI运行时环境,并按照安装向导进行安装。安装完成 后,需要设置库文件。此外,还需要配置网络 ,确保各个节点之间的通信畅通无阻。

MPI简介

MPI简介MPI(Message Passing Interface)是消息传递并行程序设计的标准之一,当前通用的是MPI1.1规范。

正在制定的MPI2.0规范除支持消息传递外,还支持MPI的I/O规范和进程管理规范。

MPI正成为并行程序设计事实上的工业标准。

MPI的实现包括MPICH、LAM、IBM MPL等多个版本,最常用和稳定的是MPICH,曙光天潮系列的MPI以MPICH为基础进行了定制和优化。

MPICH含三层结构,最上层是MPI的API,基本是点到点通信,和在点到点通信基础上构造的集群通信(Collective Communication);中间层是ADI层(Abstract Device Interface),其中device可以简单地理解为某一种底层通信库,ADI就是对各种不同的底层通信库的不同接口的统一标准;底层是具体的底层通信库,例如工作站机群上的p4通信库、曙光1000上的NX库、曙光3000上的BCL通信库等。

MPICH的1.0.12版本以下都采用第一代ADI接口的实现方法,利用底层device提供的通信原语和有关服务函数实现所有的ADI接口,可以直接实现,也可以依靠一定的模板间接实现。

自1.0.13版本开始,MPICH采用第二代ADI接口。

我们将MPICH移植到曙光3000高效通信库BCL(Basic Communication Library)上(简称MPI_BCL)。

MPI_BCL的接口标准与MPICH版本1.1完全一致,满足MPI1.1标准。

同时,也支持ch_p4的通信库,即利用TCP/IP通信机制。

从网络硬件角度说,MPI_BCL针对系统网络,MPI_ch_p4针对高速以太网。

1.MPI的程序设计MPI1.1标准基于静态加载,即所有进程在加载完以后就全部确定,直至整个程序结束才终止,在程序运行期间没有进程的创建和结束。

一个MPI程序的所有进程形成一个缺省的组,这个组被MPI预先规定的Communicator MPI_COMM_WORLD所确定。

MPI的名词解释

MPI的名词解释MPI,全称为Message Passing Interface(消息传递接口),是一种基于消息传递机制的并行计算通信标准。

它由一系列函数和语法规则组成,用于在并行计算环境中实现进程间的通信与同步操作。

MPI的出现极大地推动了并行计算的发展,并成为当前科学计算领域中最为重要和广泛使用的编程模型之一。

一、MPI的产生与发展MPI最早由美国国家科学基金会(NSF)于20世纪80年代中期提出,并由一支由美国国家研究委员会(NRC)支持的工作组进行研发。

该工作组的目标是构建一个可跨不同型号和架构的计算机系统进行通信的标准接口。

经过多年的努力,MPI于1994年正式发布第一个版本,至今经过多次修订和升级,已经成为最新一代的MPI标准。

二、MPI的特点与优势1. 灵活性:MPI提供了一种抽象的通信模型,允许开发者在不同的并行计算平台上进行通信操作。

这使得并行计算应用能够灵活地适应不同的硬件和软件环境。

2. 高性能:MPI以高效的消息传递机制为基础,充分利用并行计算系统的硬件资源,实现高效的进程间通信和数据交互。

这使得MPI成为大规模科学计算和仿真模拟的重要工具。

3. 可扩展性:MPI适用于从单机多核到分布式集群的各种规模的并行系统。

无论是小型集群还是大型超级计算机,MPI都能够灵活地管理进程间通信,实现可扩展的分布式计算和通信。

4. 可移植性:MPI是一个标准化的接口,各个计算平台上的MPI实现都遵循相同的接口规范。

开发者可以编写与具体平台无关的MPI程序,实现代码的重用和平台的移植。

5. 易用性:MPI提供了一系列简单易用的函数调用和语法规则,方便开发者进行进程间通信的编程。

开发者无需关注底层通信的细节,只需调用相应的MPI函数即可完成通信操作。

三、MPI的基本概念与操作1. 进程:MPI程序由多个并行执行的进程组成,每个进程都有一个唯一的标识符(MPI Rank)。

进程通过发送和接收消息进行通信和同步操作。

MPI的认识

2.MPI的特性 的特性

標准性:MPI有固定的格式﹐得到大家認可﹐并有相應的表 單號。如PL MPI的表單號為:表QA-MPI-01A﹐它是一種標 准的文件 程序性:MPI的制做﹐核定﹐發行都有規定的流程﹐而且有 特定的對象與場所﹐并有特定的時間要求。 整體性:MPI所包含的內容要體現各方面的要求﹐如備料﹑ 操作﹑品質﹑標准工時等等 指導性:MPI體現了設計者的意圖與要求﹐便于規范操作者 的操作動作。 協調性:MPI要保持整個生產的節拍﹐動作的節拍﹐出貨的 節產量的需求

MPI的產生流程 的產生流程

MN MN MN D.C Approval IE PE;ME;QE;OQA;I PQA;PROD

New NB Phase in or update MPI

IE;LINE

6.MPI的制作要求 的制作要求

1.MPI的制作要考慮均衡生產原則﹐即每一工位有相的節拍﹐保持整體 的制作要考慮均衡生產原則﹐即每一工位有相的節拍﹐ 的制作要考慮均衡生產原則 的協調。 的協調。 2.MPI的制作要考慮動作經濟原則﹐減少多余動作﹐使搬運時間最短﹐ 的制作要考慮動作經濟原則﹐ 的制作要考慮動作經濟原則 減少多余動作﹐使搬運時間最短﹐ 操作最省力﹐操作時間最短等。 操作最省力﹐操作時間最短等。 3.MPI的制作要考慮圖文并茂原則﹐讓物有其用﹐物盡有其用﹐物有所 的制作要考慮圖文并茂原則﹐ 的制作要考慮圖文并茂原則 讓物有其用﹐物盡有其用﹐ 指。 4.MPI的制作要考慮涇渭分明原則﹐保持同一工位不要有相似難分的物 的制作要考慮涇渭分明原則﹐ 的制作要考慮涇渭分明原則 料﹐連續兩工位也不要有類似情形發生 5. 4.MPI的制作要考慮標准化原則﹐統一規格大小﹐顏色圖案﹐認真 的制作要考慮標准化原則﹐ 的制作要考慮標准化原則 統一規格大小﹐顏色圖案﹐ 標示等 6. 4.MPI的制作要考慮環境優化原則﹐體現人---機----環境和諧一致。 的制作要考慮環境優化原則﹐體現人 機 環境和諧一致。 的制作要考慮環境優化原則 環境和諧一致 7. 4.MPI的制作要考慮經渭合理原則﹐減少浪費﹐合理利用人力次 的制作要考慮經渭合理原則﹐ 的制作要考慮經渭合理原則 減少浪費﹐ 源﹐這也影響企業競爭力和生產績效的重要內容

多维压力量表MPI

多维压力量表MPI

多维压力量表(MPI)是一种常用的、用于评估个体面对压力的

心理测量工具,由美国心理学家Robert M. Mcgrath和Lawrence E. Keita于1984年发明。

该量表可以用于测量个体在不同领域面对的

压力水平,例如个人关系、工作、健康等。

MPI对于分析和评估压

力反应的多个方面具有广泛的应用,能够帮助我们更好地了解个体

在应对压力时可能面临的因素,进而更好地进行干预和辅导。

MPI测量了个体在共15个领域下的应对风格和对应的压力得分。

这些领域包括了银行账户、工作、性交往、家庭、保险等。

试

题采用李克特量表,每个量表将“应对风格”部分和“个人压力”部分

分别分成四个等级,被试者需要根据自身情况选择相应等级。

该量

表同时也包含一些“假设工人”问题,以检测被试者是否对测试认真

作答。

MPI已经成为当前常用的、稳定可靠的心理测量工具之一。

然而,需要注意的是,在使用MPI时,应该充分尊重被试者的知情同意权和隐私权,并选择恰当的场合和方法进行测试。

除了MPI之外,

还需要综合其他相关因素来分析和评估个体面对压力可能存在的问题和困境。

mpi常用函数 -回复

mpi常用函数-回复MPI(Message Passing Interface)是一种用于并行计算的通信协议。

它定义了一系列常用函数,用于在并行计算中进行进程之间的通信和同步操作。

本文将围绕MPI常用函数展开,一步一步解释其主要功能和使用方法。

一、MPI_Init和MPI_Finalize函数MPI_Init和MPI_Finalize函数是MPI通信库的入口和退出函数。

在使用MPI库函数之前,首先需要调用MPI_Init函数进行初始化;而在MPI程序执行完毕后,需要通过调用MPI_Finalize函数进行清理和释放资源。

这两个函数的基本使用方法如下:int MPI_Init(int *argc, char *argv);int MPI_Finalize();其中,函数MPI_Init的参数argc和argv是命令行参数的数量和参数值,通常情况下可以将其置为NULL。

MPI_Finalize函数不接受任何参数。

二、MPI_Comm_size和MPI_Comm_rank函数MPI_Comm_size和MPI_Comm_rank函数用于获取通信域中进程的数量和进程的标识符。

通信域是一个逻辑上的进程组,用于进程之间的通信和同步操作。

使用这两个函数可以得到当前进程在通信域中的编号。

这两个函数的具体用法如下:int MPI_Comm_size(MPI_Comm comm, int *size);int MPI_Comm_rank(MPI_Comm comm, int *rank);参数comm是一个通信域的句柄,用于标识一组进程。

参数size是一个指向整型变量的指针,用于存储通信域中进程的数量。

参数rank是一个指向整型变量的指针,用于存储当前进程的标识符。

三、MPI_Send和MPI_Recv函数MPI_Send和MPI_Recv函数用于发送和接收消息。

发送方使用MPI_Send函数发送消息给接收方,接收方使用MPI_Recv函数接收消息。

mpi在反贿赂和腐败工作中所认证的国际标准

mpi在反贿赂和腐败工作中所认证的国际标准MPI在反贿赂和腐败工作中主要参照以下几个国际标准:

1. **《联合国反腐败公约》**:这是由联合国大会于2003年10月31日通过的国际公约,旨在促进和加强国际合作,预防和打击腐败行为。

MPI的认证工作完全符合该公约的要求。

2. **《OECD反贿赂公约》**:经济合作与发展组织(OECD)于1997年签署的这项公约,旨在打击跨国商业贿赂行为,加强国际反腐败合作。

MPI的标准与该公约的精神和要求高度一致。

3. **《国际商会(ICC)反腐败规则》**:ICC制定的这套规则为企业提供了实施有效反腐败政策和程序的具体指南,与MPI的目标和原则相吻合。

此外,MPI还借鉴了诸如《国际商会(ICC)商业行为准则》等其他国际标准和最佳实践,以确保其认证过程和要求能够与国际公认的规范保持一致。

MPI 在反贿赂和腐败工作中的认证标准,是一个系统性的、涵盖多个方面的标准体系,其目标是提高企业行为的透明度,并促进整个行业的廉洁和诚信。

mpi简介——精选推荐

mpi简介1.MPI全称是message passing interface,即信息传递接⼝,是⽤于跨节点通讯的基础软件环境。

它提供让相关进程之间进⾏通信,同步等操作的API,可以说是并⾏计算居家出游必备的基础库。

⼀个 MPI 程序包含若⼲个进程。

每个 mpi 进程都运⾏⼀份相同的代码,进程的⾏为由通讯域(communication world)和该通讯域下的 id(rank id)所决定。

MPI的编程⽅式,是“⼀处代码,多处执⾏”。

编写过多线程的⼈应该能够理解,就是同样的代码,不同的进程执⾏不同的路径。

2.它是⼀个库,不是⼀门语⾔。

可以被fortran,c,c++等调⽤。

MPI允许静态任务调度,显⽰并⾏提供了良好的性能和移植性,⽤MPI编写的程序可直接在多核集群上运⾏。

在集群系统中,集群的各节点之间可以采⽤ MPI 编程模型进⾏程序设计,每个节点都有⾃⼰的内存,可以对本地的指令和数据直接进⾏访问,各节点之间通过互联⽹络进⾏消息传递,这样设计具有很好的可移植性,完备的异步通信功能,较强的可扩展性等优点。

3.MPI常⽤命令对于登录集群计算⽽⾔,我们只需要掌握两种mpi运⾏指令即可,它们分别是:mpirun、mpiexec。

简⽽⾔之mpirun和mpiexec均是MPI程序运⾏命令:mpirun:MPI程序快速执⾏命令,运⾏前不必运⾏mpdboot开启守护进程。

mpiexec:MPI程序运⾏命令,运⾏前必须开启mpd守护进程。

守护进程(daemon)是⼀类在后台运⾏的特殊进程,⽤于执⾏特定的系统任务。

很多守护进程在系统引导的时候启动,并且⼀直运⾏直到系统关闭。

另⼀些只在需要的时候才启动,完成任务后就⾃动结束。

简单来说,在服务器配置良好的情况下,绝⼤多数情况不需要考虑选项的配置,基本语句如下:mpirun -n 20 vasp_std //20核⼼并⾏vasp_std程序,vasp_std需要加⼊环境变量mpiexec.hydra -n 20 vasp_std //20核⼼并⾏vasp_std程序,vasp_std需要加⼊环境变量此时节点和核⼼的分配完全由PBS系统进⾏分配,跨节点运⾏时也会⾃动进⾏核⼼和节点的匹配另外,在实际操作过程中,我发现部分同学对于PBS和mpirun -np的作⽤可能不太理解,在这⾥想简单解释如下:1. PBS是作业分配系统,通过.pbs脚本像PBS作业管理软件申请相应的核⼼数量和节点数量。

MPI认识

Prepared By:Aty.xie

2002/4/1

1

1.什么是MPI

MPI(MANUFACTURING PROCESS INSTRUCTION):制 造業的過程、程序、步驟、方法的指示或指導.我們一 般稱其為作業指導書.首先它的范圍是制造業.其次它的 對象是過程,進行某項活動的所有動作.最后,它是一种指 示或指導.MPI有別于規章制度,MPI一般針對生產崗位 上的操作者,而規章制度則從行政上要求公司的所有人 或進入特定的場所所需要遵守的.

2

2.MPI的特性

標准性.MPI有固定的格式,得到大家認可,並有相應的表 單號.如COB MPI 的表單號為“表5400250A”.它是一 种標准的文件. 程序性.MPI的制作,核定,發行都有規定的流程,而且有特 定的對象与場所,并有特定的時間要求.

整体性.MPI所包含的內容要体現各方面的要求,如備料、 操作、品質、標准工時等等.

9

5.MPI的產生流程

MN IE Approval

MN

MN D.C

PROD

PE;ME;QE;OQA;IPQA;

New NB Phase in or update MPI

IE;LINE

10

6 MPI的制作要求

(1)MPI的制作要考慮均衡生產原則,即每一工位有相同的節拍.保持整 体的協調.

(2)MPI的制作要考慮動作經濟原則,減少多余動作,使搬運時間最短,操 作最省力,操作時間最短等.

13

THE END

Thank you

14

(3)MPI的制作要考慮圖文并茂原則.讓物有其用,物盡其用.物有所指.

(4)MPI的制作要考慮涇渭分明原則.保持同一工位不要有相似難分的物 料,連續兩工位也不要有類似情形發生. (5)MPI的制作要考慮標准化原則.統一規格大小,顏色圖案,認真標示等. (6)MPI的制作要考慮環境优化原則.体現人—机—環境和諧一致. (7)MPI的制作要考慮經濟合理原則.減少浪費,合理利用人力資源,這也 影響企業競爭力和生產績效的重要內容.

mpi与mpa的功能区别在哪里

MPA和MPI的区别MPA可以理解为"简易的快速的" MPI。

它包括了part advisers 和mold advisers两部分提供注塑成型过程中的分析。

可提供如下分析:产品结构是否合理、怎样选择合适的注塑材料、怎样确定合理的浇口位置、浇口位置自动优化、预测熔接痕位置、模具型腔是否充满、最终制品的质量如何、怎样选择合适的注塑机、缩痕分析、成本顾问。

MPI支持多种现有的多种塑料的成型分析。

如压注、注塑、气辅成型、芯片包裹、热固性材料成型等。

在分析结果上,不仅提供了各相与冷却相对应的分析还提供如翘曲变形量,分子取向、玻纤取向等众多对产品设计、模具设计、工艺等具有重要参考价值的数值。

MPI的模块:MPI/MIDPLANE:对于线框和表面造型,MPI可以直接读取任何CAD表面模型并进行分析。

在用户采用线框和表面造型文件时,MPI可以自动生成中型面网格并准确计算单元厚度,进行精确的分析。

MPI的中型面模块用于处理薄壁制件,节省了用户大量的CAE建模时间。

使他们致力于CAE分析和优化。

MPI/FUSION:对于薄壁实体,MPI的FUSION模块基于Moldflow的独家专利的Dual Domain分析技术,使用户可以直接进行薄壁实体模型分析。

这将原来需要几小时甚至几天的建模工作缩短为几分钟,无需进行中型面网格的生成和修改。

FUSION可以直接从塑件顾问中读取模型而进行进一步的分析。

MPI/3D:对于厚壁实体Moldflow的MPI/Flow3D、和MPI/Cool3D模块采用全三维的自适应网格进行全三维分析。

MPI/FLOW:注塑流动模拟MPI的流动分析模拟了塑料熔体在整个注塑过程中的流动情况,确保用户获得高质量的制件。

使用流动分析用户可以优化浇口位置和加工参数、预测制件可能出现的缺陷、自动确定取得流动平衡的流道系统尺寸。

MPI/COOL:冷却模拟注塑和保压过程得到了优化后,可以进行冷却系统造型:包括流道、模具外形、镶块等,并进行冷却分析。

mpi指标

mpi指标MPI指标全称为“多维贫困指数”(Multidimensional Poverty Index),是联合国开发计划署(UNDP)与牛津大学人类发展倡议共同研发的一种贫困测量指标。

它不仅考虑了贫困人口的收入状况,还综合了教育、健康、居住、安全等多个方面的因素,真正反映贫困人口生活的全面状况。

下面分步骤详细介绍一下MPI指标。

第一步是明确MPI指标的计算方式。

MPI指标采用了二元方法计算,即将人群中的每个个体视为一个二元变量,0表示不满足条件,1表示满足条件。

MPI指标涉及的指标要素包括:健康、教育、生活标准、住房、饮用水、卫生设施、电力、通讯等8个方面。

具体而言,先将一个国家或地区的贫困人口按照这些方面的指标要素进行分类,并确定每个贫困个体的贫困状态(是否满足条件)。

然后,将所有的贫困人口数除以总数,得到贫困人口占总人口的比例。

最后,将贫困人口占比乘以被考察国家的MPI权重系数,即可得到MPI指标的值。

第二步是比较MPI指标的优势。

和传统贫困指标相比,MPI指标有以下几个优势:1.综合性强。

MPI指标不仅关注贫困人群的收入状况,还考虑了教育、健康、居住、安全等多个因素,更全面反映了贫困人口的实际生活状况。

2.精准性高。

MPI指标将每个贫困人口的贫困状态作为一个个体进行测量,更贴近于实际情况,减少了错误估算带来的影响。

3.可操作性强。

MPI指标的计算方式简单明了,易于操作。

第三步是MPI指标在全球贫困治理中的应用。

MPI指标被广泛用于全球贫困治理中,已被多个国际机构以及发展中国家采用。

MPI指标可用于监测和评估贫困减少进展情况,也可作为政策实施的重要参考。

特别是在发展中国家的贫困治理中,MPI指标可帮助相关政策制定者识别并帮助最需要帮助的贫困人口,更好地促进贫困人口整体生活的改善。

综上所述,MPI指标是一种反映贫困人口全面生活状况的重要测量指标,它的应用不仅为全球贫困治理提供了有力支持,也更符合全球发展治理趋势的要求。

mpi应用实例 -回复

mpi应用实例-回复并解释什么是MPI以及如何使用它来解决特定的问题。

MPI(Message Passing Interface)是一种用于编写并行程序的通信协议。

它的目标是在多个计算节点之间实现高效的消息传递,并支持在分布式计算环境中进行并行计算。

本文将详细介绍MPI的概念、用途和应用实例,以及如何使用MPI来解决特定的问题。

首先,让我们先来了解一下MPI的概念。

MPI是一个由通信和同步操作组成的编程接口,它定义了一套用于在并行计算中传递消息的函数和语义。

MPI的设计目标是提供高效、可移植和灵活的编程模型,使得开发者能够轻松地编写并行程序。

MPI的主要特点之一是它的可移植性。

MPI被设计为一个平台无关的标准,并且在多种计算环境中得到了广泛的应用和支持。

无论是在超级计算机集群、多核处理器还是分布式计算机集群上,MPI都可以提供高效的消息传递机制,从而实现并行计算。

接下来,让我们看一些MPI的应用实例。

首先,MPI广泛应用于科学和工程计算中的并行算法,例如数值模拟、图像处理和大规模数据分析等。

通过将计算任务分解成多个子任务,并使用MPI进行通信和同步,可以大大加速这些计算任务的运行。

另一个重要的应用领域是并行模拟。

例如,对于气候模型、流体力学模拟和分子动力学模拟等大规模模拟任务,MPI提供了一种高效的通信机制,使得不同计算节点之间能够共享数据并进行并行计算。

这种并行模拟可以帮助科学家们更好地理解自然现象,加速研究进展。

除了科学计算和模拟,MPI还可以用于解决大规模数据处理和分布式机器学习等问题。

随着大数据时代的到来,需要处理海量数据的任务变得越来越常见。

使用MPI并行计算框架,可以将数据分发到不同的计算节点上,实现并行处理。

这样一来,可以显著减少计算时间,提高数据处理的效率。

现在,让我们来看一下如何使用MPI来解决特定的问题。

首先,需要选择一个合适的MPI实现,在市面上有多种可供选择的MPI实现,例如MPICH、Open MPI和Intel MPI等。

MPI的算法

关于MPIMPI(绩效指数):公司当期绩效指数这是一个很重要的数值,用来衡量公司在市场里的运营状况,他由RetErn(留存利润)、DemPot(需求潜力)、SupPot(供给潜力)、Pdty(生产负荷率)、MktShr(市场占有率)、Growth(增长率)6部分组成,即MPI = RetErn + DemPot + SupPot + Pdty + MktShr + Growth 。

其中:RetErn(留存利润):RetErn的绩效指数,一般为RetErn / A /(期数+B),A、B为整数。

例如,一个Echopen公司第一期RetErn为5600,RetErn的绩效指数为5600/28/(1+1)=100,其中常数A=28,B=1。

那么该公司第二期RetErn为12600,RetErn的绩效指数 =12600/28/(2+1)=150,常数A和B可能会不同,可根据行业报表推算得之。

DemPot(需求潜力):行业的DemPot的总和为公司数量10,公司的DemPot为该公司从第0期到当期投入的Marketing和R&D的总和占全行业从第0期到当期投入的Marketing和R&D 的总和的百分比行业的DemPot的总和(公司数量10),例如,一个公司从第0期到第3期投入的Marketing和R&D的总和为38000,而全行业从第0期到当期投入的Marketing和R&D 的总和130000,一共有5个公司,则该公司第3期的DemPot =38000/130000*5*10=15(四舍五入)SupPot(供给潜力):行业的SupPot的总和为公司数量10,公司的SupPot为该公司的Factory Size占Total Capacity的百分比行业的SupPot的总和(公司数量10),例如,一个公司的Factory Size为30000,而行业的Total Capacity总和190000,一共有5个公司,则该公司当期的SupPot =30000/190000*5*10=8注:假如一个公司在第二期的决策中投入了一定的Investment,它不会对第二期该公司的SupPot造成影响,而会影响第3期和第3期以后的SupPotPdty(生产负荷率):当公司的Capacity Utilization为80%时,Pdty为10,高于或低于80%都会导致Pdty低于10MktShr(市场占有率):行业的MktShr的总和为公司数量10,公司的MktShr为该公司的Sales Made占Total Sold的百分比行业的MktShr的总和(公司数量10),例如,一个公司的Sales Made为770,而Total Sold为 4500,一共有5个公司,则该公司当期的MktShr =770/4500*5*10=9Growth(增长率):Growth的上限为20,是一个公司当期的COGS / 上期的COGS / (当期的Industry Sales / 上期的Industry Sales)10。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

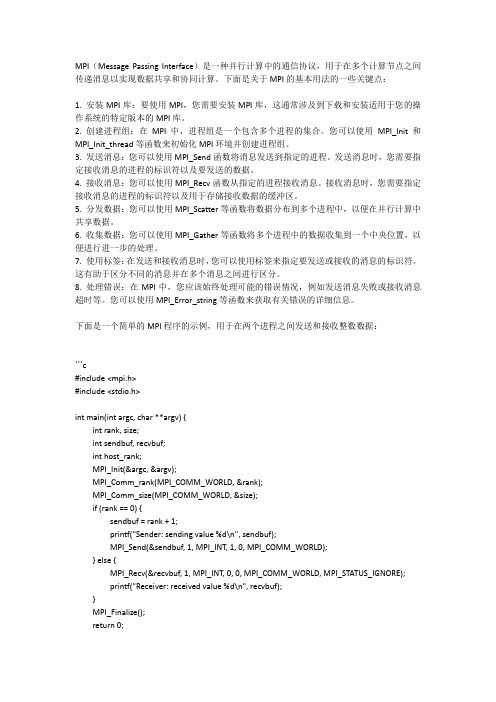

如图 在新建的项目上 点击右键,属性

因为 VC 的 IO 库与 MPI 头文 件中的宏定义有冲突,所以 需 要 预 定 义 一 个 MPICH_SKIP_MPICXX 宏, 使得编译时跳过MPICXX定 义。在C/C++中找到预处理 器 加 上 “MPICH_SKIP_MPICXX “, 如右图 如果不设置此步,也可在程 序中预定义此宏,如 “#define MPICH_SKIP_M PICXX”。不过还是设置的 比较好,因为不用自己每次 都定义一个宏了。

在左边找到“ VC++ 目录”,在右边找到 “包含目录”,在此 项的最后面(注意每 项以分号间隔)加上 MPICH2的安装路径 下的 include 文件的 路径,这里为: C:\Program Files (x86)\MPICH2\inclu de

在左边找到“ VC++ 目录”,在右边找到 “库目录”,在此项 的最后面(注意每项 以分号间隔)加上 MPICH2的安装路径 下的lib文件的路径; 这 里 为 : C:\Program Files (x86)\MPICH2\lib

设置运行库为多线程

添加连接库

链接器 - 输入 - 附加依 赖项-添加mpi.lib

MPICH2的配置

打开wmpiregister.exe (开始-MPICH2wmpiregister.exe或在 安装目录的bin文件中 找到wmpiregister.exe) 并注册如图 ( 此 处 的 用户名和密码就是你 锁屏时的用户名和密 码 ) 之 后 点 击 “Register”,当下面 出 现 “Password encrypte d into the Register” 后点击“OK”即可。

当安装完成并注册成 功 之 后 , 打开 wmpiconfig.exe(开 始-MPICH2wmpiconfig.exe或在 安装目录的bin文件 中找)当出现右上图 时说明 MPI 未配置成 功,如右下图时为配 置成功。

当未配置成功时运行会出现 右图错误,解决方法: 1、开始--所有程序--附件--找到cmd.exe文件,右键点 击 ----> 以管理员身份运行 2 、进入 MPICH2 的安装目 录,以我的为例 cd /d C:\Program Files (x86)\MPICH2\bin 3、输入命令smpd -install phrase behappy, behapp y 是安装时设置的 passphrase

当出现 右 上 图 错 误 时,控制面板 - 系统 和安全-管理工具-计 算机管理 - 本地用户 和组 - 用户,查看注 册用户 名 是 否 为 正 确

右图为配置成功运行 结果图