Haw To Recognize Globalization Properly

Kernel SHAP 0.4.1 说明书

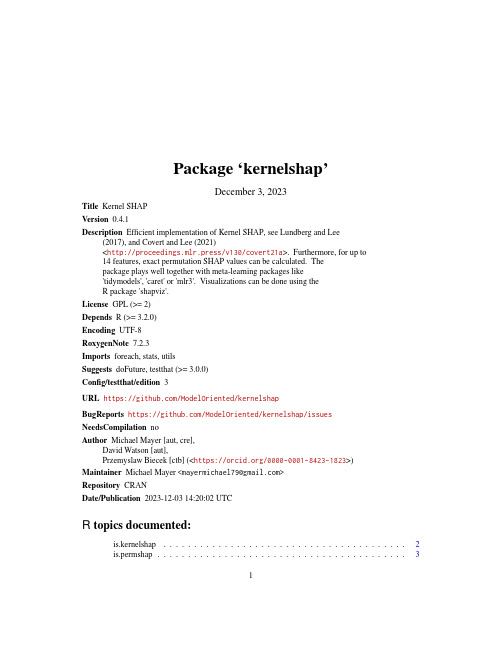

Package‘kernelshap’December3,2023Title Kernel SHAPVersion0.4.1Description Efficient implementation of Kernel SHAP,see Lundberg and Lee(2017),and Covert and Lee(2021)<http://proceedings.mlr.press/v130/covert21a>.Furthermore,for up to14features,exact permutation SHAP values can be calculated.Thepackage plays well together with meta-learning packages like'tidymodels','caret'or'mlr3'.Visualizations can be done using theR package'shapviz'.License GPL(>=2)Depends R(>=3.2.0)Encoding UTF-8RoxygenNote7.2.3Imports foreach,stats,utilsSuggests doFuture,testthat(>=3.0.0)Config/testthat/edition3URL https:///ModelOriented/kernelshapBugReports https:///ModelOriented/kernelshap/issuesNeedsCompilation noAuthor Michael Mayer[aut,cre],David Watson[aut],Przemyslaw Biecek[ctb](<https:///0000-0001-8423-1823>)Maintainer Michael Mayer<************************>Repository CRANDate/Publication2023-12-0314:20:02UTCR topics documented:is.kernelshap (2)is.permshap (3)12is.kernelshapkernelshap (3)permshap (9)print.kernelshap (11)print.permshap (12)summary.kernelshap (13)summary.permshap (14)Index15 is.kernelshap Check for kernelshapDescriptionIs object of class"kernelshap"?Usageis.kernelshap(object)Argumentsobject An R object.ValueTRUE if object is of class"kernelshap",and FALSE otherwise.See Alsokernelshap()Examplesfit<-lm(Sepal.Length~.,data=iris)s<-kernelshap(fit,iris[1:2,-1],bg_X=iris[,-1])is.kernelshap(s)is.kernelshap("a")is.permshap3 is.permshap Check for permshapDescriptionIs object of class"permshap"?Usageis.permshap(object)Argumentsobject An R object.ValueTRUE if object is of class"permshap",and FALSE otherwise.See Alsokernelshap()Examplesfit<-lm(Sepal.Length~.,data=iris)s<-permshap(fit,iris[1:2,-1],bg_X=iris[,-1])is.permshap(s)is.permshap("a")kernelshap Kernel SHAPDescriptionEfficient implementation of Kernel SHAP,see Lundberg and Lee(2017),and Covert and Lee (2021),abbreviated by CL21.For up to p=8features,the resulting Kernel SHAP values are exact regarding the selected background data.For larger p,an almost exact hybrid algorithm involving iterative sampling is used,see Details.Usagekernelshap(object,...)##Default S3method:kernelshap(object,X,bg_X,pred_fun=stats::predict,feature_names=colnames(X),bg_w=NULL,exact=length(feature_names)<=8L,hybrid_degree=1L+length(feature_names)%in%4:16,paired_sampling=TRUE,m=2L*length(feature_names)*(1L+3L*(hybrid_degree==0L)),tol=0.005,max_iter=100L,parallel=FALSE,parallel_args=NULL,verbose=TRUE,...)##S3method for class rangerkernelshap(object,X,bg_X,pred_fun=function(m,X,...)stats::predict(m,X,...)$predictions, feature_names=colnames(X),bg_w=NULL,exact=length(feature_names)<=8L,hybrid_degree=1L+length(feature_names)%in%4:16,paired_sampling=TRUE,m=2L*length(feature_names)*(1L+3L*(hybrid_degree==0L)),tol=0.005,max_iter=100L,parallel=FALSE,parallel_args=NULL,verbose=TRUE,...)##S3method for class Learnerkernelshap(object,X,bg_X,pred_fun =NULL,feature_names =colnames(X),bg_w =NULL,exact =length(feature_names)<=8L,hybrid_degree =1L +length(feature_names)%in%4:16,paired_sampling =TRUE,m =2L *length(feature_names)*(1L +3L *(hybrid_degree ==0L)),tol =0.005,max_iter =100L,parallel =FALSE,parallel_args =NULL,verbose =TRUE,...)Argumentsobject Fitted model object....Additional arguments passed to pred_fun(object,X,...).X(n ×p )matrix or data.frame with rows to be explained.The columns should only represent model features,not the response (but see feature_names on how to overrule this).bg_XBackground data used to integrate out "switched off"features,often a subset of the training data (typically 50to 500rows)It should contain the same columns as X .In cases with a natural "off"value (like MNIST digits),this can also be a single row with all values set to the off value.pred_funPrediction function of the form function(object,X,...),providing K ≥1predictions per row.Its first argument represents the model object ,its second argument a data structure like X .Additional (named)arguments are passed via ....The default,stats::predict(),will work in most cases.feature_names Optional vector of column names in X used to calculate SHAP values.By de-fault,this equals colnames(X).Not supported if X is a matrix.bg_w Optional vector of case weights for each row of bg_X .exactIf TRUE ,the algorithm will produce exact Kernel SHAP values with respect to the background data.In this case,the arguments hybrid_degree ,m ,paired_sampling ,tol ,and max_iter are ignored.The default is TRUE up to eight features,and FALSE otherwise.hybrid_degreeInteger controlling the exactness of the hybrid strategy.For 4≤p ≤16,the default is 2,otherwise it is 1.Ignored if exact =TRUE .•0:Pure sampling strategy not involving any exact part.It is strictly worse than the hybrid strategy and should therefore only be used for studying properties of the Kernel SHAP algorithm.•1:Uses all 2p on-off vectors z withz ∈{1,p −1}for the exact part,which covers at least 75%of the mass of the Kernel weight distribution.The remaining mass is covered by random sampling.•2:Uses all p (p +1)on-off vectors z withz ∈{1,2,p −2,p −1}.This covers at least 92%of the mass of the Kernel weight distribution.The remaining mass is covered by sampling.Convergence usually happens in the minimal possible number of iterations of two.•k>2:Uses all on-off vectors withz ∈{1,...,k,p −k,...,p −1}.paired_samplingLogical flag indicating whether to do the sampling in a paired manner.This means that with every on-off vector z ,also 1−z is considered.CL21shows its superiority compared to standard sampling,therefore the default (TRUE )should usually not be changed except for studying properties of Kernel SHAP algo-rithms.Ignored if exact =TRUE .m Even number of on-off vectors sampled during one iteration.The default is 2p ,except when hybrid_degree ==0.Then it is set to 8p .Ignored if exact =TRUE .tolTolerance determining when to stop.Following CL21,the algorithm keeps iter-ating until max (σn )/(max (βn )−min (βn ))<tol,where the βn are the SHAP values of a given observation,and σn their standard errors.For multidimen-sional predictions,the criterion must be satisfied for each dimension separately.The stopping criterion uses the fact that standard errors and SHAP values are all on the same scale.Ignored if exact =TRUE .max_iter If the stopping criterion (see tol )is not reached after max_iter iterations,the algorithm stops.Ignored if exact =TRUE .parallelIf TRUE ,use parallel foreach::foreach()to loop over rows to be explained.Must register backend beforehand,e.g.,via ’doFuture’package,see README for an example.Parallelization automatically disables the progress bar.parallel_argsNamed list of arguments passed to foreach::foreach().Ideally,this is NULL (default).Only relevant if parallel =TRUE .Example on Windows:if object is a GAM fitted with package ’mgcv’,then one might need to set parallel_args =list(.packages ="mgcv").verbose Set to FALSE to suppress messages and the progress bar.DetailsPure iterative Kernel SHAP sampling as in Covert and Lee (2021)works like this:1.A binary "on-off"vector z is drawn from {0,1}p such that its sum follows the SHAP Kernel weight distribution (normalized to the range {1,...,p −1}).2.For each j with z j =1,the j -th column of the original background data is replaced by the corresponding feature value x j of the observation to be explained.3.The average prediction v z on the data of Step 2is calculated,and the average prediction v 0on the background data is subtracted.4.Steps 1to 3are repeated m times.This produces a binary m ×p matrix Z (each row equals one of the z )and a vector v of shifted predictions.5.v is regressed onto Z under the constraint that the sum of the coefficients equals v 1−v 0,where v 1is the prediction of the observation to be explained.The resulting coefficients are the Kernel SHAP values.This is repeated multiple times until convergence,see CL21for details.A drawback of this strategy is that many (at least 75%)of the z vectors will havez ∈{1,p −1},producing many duplicates.Similarly,at least 92%of the mass will be used for the p (p +1)possible vectors withz ∈{1,2,p −2,p −1}.This inefficiency can be fixed by a hybrid strategy,combining exact calculations with sampling.The hybrid algorithm has two steps:1.Step 1(exact part):There are 2p different on-off vectors z withz ∈{1,p −1},covering a large proportion of the Kernel SHAP distribution.The degree 1hybrid will list those vectors and use them according to their weights in the upcoming calculations.Depending on p ,we can also go a step further to a degree 2hybrid by adding all p (p −1)vectors with z ∈{2,p −2}to the process etc.The necessary predictions are obtained along with other calculations similar to those described in CL21.2.Step 2(sampling part):The remaining weight is filled by sampling vectors z according to Kernel SHAP weights renormalized to the values not yet covered by Step 1.Together with the results from Step 1-correctly weighted -this now forms a complete iteration as in CL21.The difference is that most mass is covered by exact calculations.Afterwards,the algorithm iterates until convergence.The output of Step 1is reused in every iteration,leading to an extremely efficient strategy.If p is sufficiently small,all possible 2p −2on-off vectors z can be evaluated.In this case,no sampling is required and the algorithm returns exact Kernel SHAP values with respect to the given background data.Since kernelshap()calculates predictions on data with MN rows (N is the background data size and M the number of z vectors),p should not be much higher than 10for exact calculations.For similar reasons,degree 2hybrids should not use p much larger than 40.ValueAn object of class "kernelshap"with the following components:•S :(n ×p )matrix with SHAP values or,if the model output has dimension K >1,a list of K such matrices.•X :Same as input argument X .•baseline :Vector of length K representing the average prediction on the background data.•SE :Standard errors corresponding to S (and organized like S ).•n_iter :Integer vector of length n providing the number of iterations per row of X .•converged :Logical vector of length n indicating convergence per row of X .•m :Integer providing the effective number of sampled on-off vectors used per iteration.•m_exact :Integer providing the effective number of exact on-off vectors used per iteration.•prop_exact :Proportion of the Kernel SHAP weight distribution covered by exact calcula-tions.•exact :Logical flag indicating whether calculations are exact or not.•txt :Summary text.•predictions :(n ×K )matrix with predictions of X .Methods(by class)•kernelshap(default):Default Kernel SHAP method.•kernelshap(ranger):Kernel SHAP method for"ranger"models,see Readme for an exam-ple.•kernelshap(Learner):Kernel SHAP method for"mlr3"models,see Readme for an exam-ple.References1.Scott M.Lundberg and Su-In Lee.A unified approach to interpreting model predictions.Proceedings of the31st International Conference on Neural Information Processing Systems, 2017.2.Ian Covert and Su-In Lee.Improving KernelSHAP:Practical Shapley Value Estimation Us-ing Linear Regression.Proceedings of The24th International Conference on Artificial Intel-ligence and Statistics,PMLR130:3457-3465,2021.Examples#MODEL ONE:Linear regressionfit<-lm(Sepal.Length~.,data=iris)#Select rows to explain(only feature columns)X_explain<-iris[1:2,-1]#Select small background dataset(could use all rows here because iris is small)set.seed(1)bg_X<-iris[sample(nrow(iris),100),]#Calculate SHAP valuess<-kernelshap(fit,X_explain,bg_X=bg_X)s#MODEL TWO:Multi-response linear regressionfit<-lm(as.matrix(iris[,1:2])~Petal.Length+Petal.Width+Species,data=iris) s<-kernelshap(fit,iris[1:4,3:5],bg_X=bg_X)summary(s)#Non-feature columns can be dropped via feature_namess<-kernelshap(fit,iris[1:4,],bg_X=bg_X,feature_names=c("Petal.Length","Petal.Width","Species"))spermshap Permutation SHAPDescriptionExact permutation SHAP algorithm with respect to a background dataset,see Strumbelj and Kononenko.The function works for up to14features.Usagepermshap(object,...)##Default S3method:permshap(object,X,bg_X,pred_fun=stats::predict,feature_names=colnames(X),bg_w=NULL,parallel=FALSE,parallel_args=NULL,verbose=TRUE,...)##S3method for class rangerpermshap(object,X,bg_X,pred_fun=function(m,X,...)stats::predict(m,X,...)$predictions,feature_names=colnames(X),bg_w=NULL,parallel=FALSE,parallel_args=NULL,verbose=TRUE,...)##S3method for class Learnerpermshap(object,X,bg_X,pred_fun=NULL,feature_names=colnames(X),bg_w=NULL,parallel=FALSE,parallel_args=NULL,verbose=TRUE,...)Argumentsobject Fitted model object....Additional arguments passed to pred_fun(object,X,...).X(n×p)matrix or data.frame with rows to be explained.The columns should only represent model features,not the response(but see feature_names on howto overrule this).bg_X Background data used to integrate out"switched off"features,often a subset of the training data(typically50to500rows)It should contain the same columnsas X.In cases with a natural"off"value(like MNIST digits),this can also be asingle row with all values set to the off value.pred_fun Prediction function of the form function(object,X,...),providing K≥1 predictions per row.Itsfirst argument represents the model object,its secondargument a data structure like X.Additional(named)arguments are passed via....The default,stats::predict(),will work in most cases.feature_names Optional vector of column names in X used to calculate SHAP values.By de-fault,this equals colnames(X).Not supported if X is a matrix.bg_w Optional vector of case weights for each row of bg_X.parallel If TRUE,use parallel foreach::foreach()to loop over rows to be explained.Must register backend beforehand,e.g.,via’doFuture’package,see READMEfor an example.Parallelization automatically disables the progress bar.parallel_args Named list of arguments passed to foreach::foreach().Ideally,this is NULL (default).Only relevant if parallel=TRUE.Example on Windows:if object isa GAMfitted with package’mgcv’,then one might need to set parallel_args=list(.packages="mgcv").verbose Set to FALSE to suppress messages and the progress bar.ValueAn object of class"permshap"with the following components:•S:(n×p)matrix with SHAP values or,if the model output has dimension K>1,a list of K such matrices.•X:Same as input argument X.•baseline:Vector of length K representing the average prediction on the background data.•m_exact:Integer providing the effective number of exact on-off vectors used.•exact:Logicalflag indicating whether calculations are exact or not(currently TRUE).•txt:Summary text.•predictions:(n×K)matrix with predictions of X.print.kernelshap11Methods(by class)•permshap(default):Default permutation SHAP method.•permshap(ranger):Permutation SHAP method for"ranger"models,see Readme for an ex-ample.•permshap(Learner):Permutation SHAP method for"mlr3"models,see Readme for an ex-ample.References1.Erik Strumbelj and Igor Kononenko.Explaining prediction models and individual predictionswith feature contributions.Knowledge and Information Systems41,2014.Examples#MODEL ONE:Linear regressionfit<-lm(Sepal.Length~.,data=iris)#Select rows to explain(only feature columns)X_explain<-iris[1:2,-1]#Select small background dataset(could use all rows here because iris is small)set.seed(1)bg_X<-iris[sample(nrow(iris),100),]#Calculate SHAP valuess<-permshap(fit,X_explain,bg_X=bg_X)s#MODEL TWO:Multi-response linear regressionfit<-lm(as.matrix(iris[,1:2])~Petal.Length+Petal.Width+Species,data=iris) s<-permshap(fit,iris[1:4,3:5],bg_X=bg_X)s#Non-feature columns can be dropped via feature_namess<-permshap(fit,iris[1:4,],bg_X=bg_X,feature_names=c("Petal.Length","Petal.Width","Species"))sprint.kernelshap Prints"kernelshap"ObjectDescriptionPrints"kernelshap"Object12print.permshapUsage##S3method for class kernelshapprint(x,n=2L,...)Argumentsx An object of class"kernelshap".n Maximum number of rows of SHAP values to print....Further arguments passed from other methods.ValueInvisibly,the input is returned.See Alsokernelshap()Examplesfit<-lm(Sepal.Length~.,data=iris)s<-kernelshap(fit,iris[1:3,-1],bg_X=iris[,-1])sprint.permshap Prints"permshap"ObjectDescriptionPrints"permshap"ObjectUsage##S3method for class permshapprint(x,n=2L,...)Argumentsx An object of class"permshap".n Maximum number of rows of SHAP values to print....Further arguments passed from other methods.ValueInvisibly,the input is returned.summary.kernelshap13See Alsopermshap()Examplesfit<-lm(Sepal.Length~.,data=iris)s<-permshap(fit,iris[1:3,-1],bg_X=iris[,-1])ssummary.kernelshap Summarizes"kernelshap"ObjectDescriptionSummarizes"kernelshap"ObjectUsage##S3method for class kernelshapsummary(object,compact=FALSE,n=2L,...)Argumentsobject An object of class"kernelshap".compact Set to TRUE for a more compact summary.n Maximum number of rows of SHAP values etc.to print....Further arguments passed from other methods.ValueInvisibly,the input is returned.See Alsokernelshap()Examplesfit<-lm(Sepal.Length~.,data=iris)s<-kernelshap(fit,iris[1:3,-1],bg_X=iris[,-1])summary(s)14summary.permshap summary.permshap Summarizes"permshap"ObjectDescriptionSummarizes"permshap"ObjectUsage##S3method for class permshapsummary(object,compact=FALSE,n=2L,...)Argumentsobject An object of class"permshap".compact Set to TRUE for a more compact summary.n Maximum number of rows of SHAP values etc.to print....Further arguments passed from other methods.ValueInvisibly,the input is returned.See Alsopermshap()Examplesfit<-lm(Sepal.Length~.,data=iris)s<-permshap(fit,iris[1:3,-1],bg_X=iris[,-1])summary(s)Indexforeach::foreach(),6,10is.kernelshap,2is.permshap,3kernelshap,3kernelshap(),2,3,7,12,13permshap,9permshap(),13,14print.kernelshap,11print.permshap,12stats::predict(),5,10summary.kernelshap,13summary.permshap,1415。

glob.glob 正则表达式

文章标题:深入理解Python中的glob.glob和正则表达式1. 引言在Python编程中,我们经常会遇到需要对文件进行操作和处理的情况。

而glob.glob和正则表达式就是两种常用的方法,用来匹配文件路径和文件名。

本文将深入探讨glob.glob和正则表达式的使用方法,帮助读者更好地理解和应用这两种方法。

2. 对glob.glob的理解glob.glob是Python中用来查找文件路径和文件名的函数。

它的基本用法是通过传入一个路径和一个匹配模式来查找符合条件的文件路径和文件名。

使用glob.glob('/*.txt')可以查找当前目录下所有的txt文件,并返回一个包含文件路径的列表。

3. glob.glob的高级用法除了基本的匹配模式,glob.glob还支持一些高级的用法,比如使用通配符来匹配不同的文件名。

使用glob.glob('/*.[txt,pdf]')可以同时匹配txt和pdf格式的文件。

glob.glob还支持递归查找文件,即在子目录中进行匹配,以及匹配指定类型的文件等高级功能。

4. 正则表达式的基本概念正则表达式是一种用来描述字符串特征的方法,可以用来匹配、查找和替换字符串。

在Python中,可以使用re模块来操作正则表达式。

正则表达式的基本概念包括字符集、量词、分组、转义符等,通过这些概念可以构建出各种复杂的模式来匹配字符串。

5. 正则表达式在文件匹配中的应用在文件匹配中,正则表达式可以帮助我们更精确地匹配文件名。

使用re模块的match方法可以匹配文件名是否符合指定的模式,从而实现更加灵活和精确的文件匹配。

6. 综合应用:glob.glob结合正则表达式在实际项目中,我们经常会需要对文件进行更加复杂的匹配操作。

此时,可以结合使用glob.glob和正则表达式来实现更灵活和精确的文件匹配。

我们可以先使用glob.glob查找出符合条件的文件路径,然后再使用正则表达式来进一步筛选文件名,以实现精确的文件匹配操作。

Perl模块安装及cpan初始设置

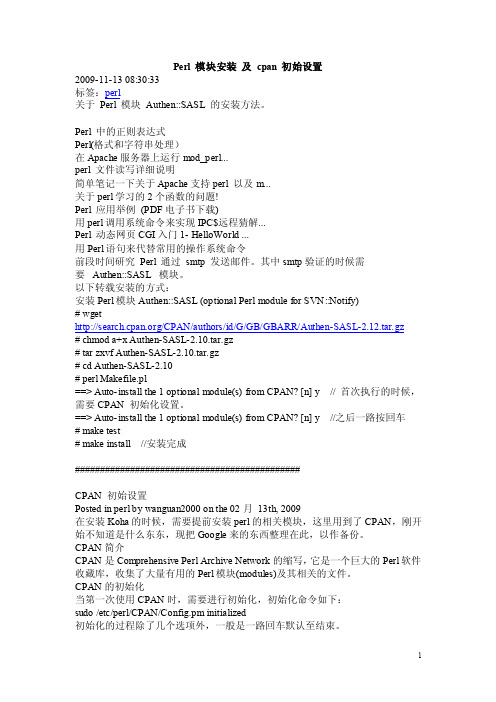

Perl 模块安装及cpan 初始设置2009-11-13 08:30:33标签:perl关于Perl 模块Authen::SASL 的安装方法。

Perl 中的正则表达式Perl(格式和字符串处理)在Apache服务器上运行mod_perl...perl 文件读写详细说明简单笔记一下关于Apache支持perl 以及m...关于perl学习的2个函数的问题!Perl 应用举例(PDF电子书下载)用perl调用系统命令来实现IPC$远程猜解...Perl 动态网页CGI入门1- HelloWorld ...用Perl语句来代替常用的操作系统命令前段时间研究Perl 通过smtp 发送邮件。

其中smtp验证的时候需要Authen::SASL 模块。

以下转载安装的方式:安装Perl模块Authen::SASL (optional Perl module for SVN::Notify)# wget/CPAN/authors/id/G/GB/GBARR/Authen-SASL-2.12.tar.gz# chmod a+x Authen-SASL-2.10.tar.gz# tar zxvf Authen-SASL-2.10.tar.gz# cd Authen-SASL-2.10# perl Makefile.pl==> Auto-install the 1 optional module(s) from CPAN? [n] y // 首次执行的时候,需要CPAN 初始化设置。

==> Auto-install the 1 optional module(s) from CPAN? [n] y //之后一路按回车# make test# make install //安装完成#############################################CPAN 初始设置Posted in perl by wanguan2000 on the 02月13th, 2009在安装Koha的时候,需要提前安装perl的相关模块,这里用到了CPAN,刚开始不知道是什么东东,现把Google来的东西整理在此,以作备份。

apollo perception protobuf解析文档 -回复

apollo perception protobuf解析文档-回复Apollo是一种开源的自动驾驶软件平台,为自动驾驶车辆提供了包括感知、决策、规划和控制在内的全套解决方案。

在Apollo系统中,感知模块负责通过车辆周围环境的传感器数据来识别和理解车辆所处的场景。

为了有效地管理感知模块产生的数据,Apollo使用了Protocol Buffers (protobuf)作为数据格式,并提供了相应的protobuf解析文档。

protobuf是一种轻巧高效的二进制数据序列化格式,由Google开发并广泛应用于各种场景。

在Apollo系统中,protobuf被用于描述和管理感知模块输出的数据,并确保数据的高效传输和使用。

下面将一步一步回答关于Apollo感知模块protobuf解析文档的问题。

1. 什么是Apollo感知模块protobuf解析文档?Apollo感知模块protobuf解析文档是一份技术文档,用于描述和解析Apollo感知模块输出的数据的protobuf格式。

它提供了详细的字段描述和数据结构,帮助开发人员理解和使用感知模块输出的数据。

2. protobuf解析文档的结构是怎样的?protobuf解析文档一般包括三个主要部分:文件描述、消息描述和字段描述。

文件描述是对整个protobuf文件的描述,包括文件名称、版本号等信息。

消息描述是对消息结构的描述,说明消息的字段和类型。

字段描述是对具体字段的描述,包括字段名称、类型、注释等信息。

3. protobuf解析文档的作用是什么?protobuf解析文档的主要作用是帮助开发人员理解和使用感知模块输出的数据。

通过阅读解析文档,开发人员可以了解每个字段的含义和数据类型,从而更加方便地处理和分析感知数据。

4. 如何使用protobuf解析文档进行数据解析?在使用protobuf解析文档进行数据解析时,开发人员可以根据文档提供的消息描述和字段描述,按照特定的顺序和方式访问和解析数据。

provParseR包用户指南说明书

Package‘provParseR’October14,2022Title Pulls Information from Prov.Json FilesVersion1.0Date2022-08-08Description R functions to access provenance information collected by'rdt'or'rdtLite'.The information is stored inside a'ProvInfo'object and can beaccessed through a collection of functions that will return the requesteddata.The exact format of the JSON created by'rdt'and'rdtLite'is describedin<https:///End-to-end-provenance/ExtendedProvJson>.Depends R(>=3.3)License GPL-3|file LICENSEEncoding UTF-8Imports jsonlite,methodsSuggests testthatURL https:///End-to-end-provenanceRoxygenNote7.2.0NeedsCompilation noAuthor Orenna Brand[aut],Joseph Wonsil[aut],Emery Boose[aut],Barbara Lerner[cre]Maintainer Barbara Lerner<*********************>Repository CRANDate/Publication2022-08-1522:20:05UTCR topics documented:get.environment (2)prov.parse (7)ProvInfo-class (7)Index91get.environment Provenance access functionsDescriptionThese functions extract information from a ProvInfo object created by the prov.parse function and return this information as a data frame.Usageget.environment(prov)get.libs(prov)(prov)get.args(prov)get.scripts(prov)get.saved.scripts(prov)get.proc.nodes(prov)get.data.nodes(prov)get.stdout.nodes(prov)get.error.nodes(prov)get.func.nodes(prov)get.proc.proc(prov)get.data.proc(prov)get.proc.data(prov)get.func.proc(prov)get.func.lib(prov)get.input.files(prov,only.files=FALSE)get.urls(prov)get.output.files(prov)get.preexisting(prov)get.variables.set(prov)ed(prov)d(prov,)get.val.type(prov,node.id=NULL)Argumentsprov a ProvInfo object created by calling prov.parse.only.files If true,the output of get.input.files contains justfiles.If false,it contains both files and URLs. a string containing the name of a variable used in the script the provenance is for node.id A vector of node id.ValueAll access functions return NULL if there is no parsed provenance.If parsed provenance exists,but there is no provenance for the type of information requested,such as no inputfiles,an empty data frame is returned.get.environment returns a data frame containing information about how the provenance was col-lected.The data frame has2columns:label and value.The labels are:•name-whose value will always be"environment"•architecture•operatingSystem•language•langVersion•script-the absolute path to the script executed•scriptTimeStamp-when the script was last modified•workingDirectory•provDirectory-where the provenance is stored•provTimeStamp-when the provenance was collected•hashAlgorithmget.libs returns a data frame describing the libraries used by the script.It contains3columns:id, name,and version. returns a data frame describing the tool that collected the provenance.It contains3 columns:,tool.version and json.version.get.args returns a named list describing the arguments that were passed to prov.run or prov.init when the provenance was collected.Each element is the value of an argument in its original type,each element name is the name of the arguemnt the value corresponds to.get.scripts returns a data frame identifying all the scripts executed.The main script will befirst, followed by all sourced scripts.The data frame contains2columns:name and timestamp(when the script was last modified).get.saved.scripts returns a data frame identifying the location of saved copies of all the scripts executed.The main script will befirst,followed by all sourced scripts.The data frame contains2 columns:name and timestamp(when the script was last modified).get.proc.nodes returns a data frame identifying all the procedural nodes executed.These are repre-sented in PROV-JSON as activities and include nodes corresponding to lines of code,start orfinish nodes that surround blocks of code,and nodes to represent the binding of function arguments to parameters.The data frame contains8columns:•id-a unique id•name-a description of what the node represents.Often this is a line of code from the script, perhaps shortened•type-one of Operation,Binding,Start,Finish,or Incomplete•elapsedTime-when this executed relative to the start of the script•scriptNum-a number identifing the script it comes from,with script1being the main script •startLine-the line in the script this corresponds to,which may be NA,and the following other position infofmation•startCol•endLine•endColget.data.nodes returns a data frame with an entry for each data node in the provenance.The data frame contains the following columns:•id-a unique id•name-the descriptive name for the node,which is generally a variable name,file name,or URL•value-either a text value(possible shortened)or the name of afile where the value is stored •valType-a description of the value’s type,including its container(such as list,vector,etc.), dimensions and member types(such as character,numeric,etc.)•type-the type of the node,one of Data,Snapshot,File,URL,Exception,Device,Standard-Output,or StandardOutputSnapshot•scope-a hex number identifying the scope.This is only used for node’s with type Data or Snapshot•fromEnv-a logical value.If true,it means the variable had a value before the script began execution•hash-the hash value for File nodes•timestamp-the time at which the node was created•location-forfile nodes,the absolute path to thefileget.stdout.nodes returns a data frame with an entry for each standard output node in the provenance. The data frame contains the following columns:•id-a unique id•value-either a text value(possible shortened)or the name of afile where the value is stored •timestamp-the time at which the node was createdget.error.nodes returns a data frame with an entry for each error node in the provenance.The data frame contains the following columns:•id-a unique id•value-either a text value(possible shortened)or the name of afile where the value is stored •timestamp-the time at which the node was createdget.func.nodes returns a data frame containing information about the functions used from other libraries within the script.The data frame has2columns:id(a unique id)and name(the name of the function called).get.proc.proc returns a data frame containing information about the edges that go between two procedural nodes.These edges indicate a control-flow relationship between the two activities.The data frame has3columns:id(a unique id),informant(the tail of the edge),and informed(the head of the edge).get.data.proc returns a data frame containing information about the edges that go from data nodes to procedural nodes.These edges indicate an input relationship where the data is used by the activity. The data frame has3columns:id(a unique id),entity(the input data),and activity(the procedural node that uses the data).get.proc.data returns a data frame containing information about the edges that go from procedural nodes to data nodes.These edges indicate an output relationship where the data is produed by the activity.The data frame has3columns:id(a unique id),entity(the output data),and activity(the procedural node that produces the data).get.proc.func returns a data frame containing information about where externally-defined functions are used in the script.The data frame has3columns:func_id(the id of the function node),activity (the procedural node that calls the function)and function(the function’s name).get.func.lib returns a data frame containing information about what libraries externally-defined functions come from.The data frame has3columns:func_id(the id of the function node),li-brary(a library node)and function(the name of a function).get.input.files returns a data frame containing a subset of the data nodes that correspond tofiles that are read by the script.If only.files is False,the data frame contains information about both input files and URLs.get.urls returns a data frame containing a subset of the data nodes that correspond to urls used in the script.get.output.files returns a data frame containing a subset of the data nodes that correspond tofiles that are written by the script.get.preexisting returns a data frame containing variables in the global environment that are used but not set by a script or a console session.get.variables.set returns a data frame containing a subset of the data nodes that correspond to vari-ables assigned to in the script.ed returns a data frame containing a subset of the data nodes that correspond to variables whose values are used in the script.d returns a data frame containing a subset of the data nodes that correspond to variables with the specified name.A data frame containing the valType of the specified data node,or the valTypes of all data nodes ifno data node is specified.Return NULL if there are no data nodes or if the specified data node is not found.If not NULL,the data frame will contain4columns in the following order:•id-The data node id.•container-The type for the data’s container,such as list,vector,etc.NA in cases such asenvironment and function where the original valType is not a json object.•dimension-The size of the data,represented as a string list when there are2or more dimen-sions.NA in cases such as environment and function where the original valType is not a jsonobject.•type-The type(s)contained within the container,represented as a string list in containers suchas data frames when there are multiple types.NA in cases like lists where the type of eachelement can be complex.See Alsoprov.parseExamplesprov<-prov.parse(system.file("testdata","prov.json",package="provParseR",mustWork=TRUE)) get.proc.nodes(prov)get.input.files(prov)get.urls(prov)get.output.files(prov)get.variables.set(prov)ed(prov)d(prov,"z")get.data.nodes(prov)get.error.nodes(prov)get.func.nodes(prov)get.proc.proc(prov)get.data.proc(prov)get.proc.data(prov)get.func.proc(prov)get.func.lib(prov)get.libs(prov)get.scripts(prov)get.environment(prov)get.val.type(prov,"d1")(prov)get.args(prov)get.stdout.nodes(prov)prov.parse7 prov.parse Provenance parserDescriptionThe prov.parse function parses the provenance collected by rdt or rdtLite.This provenance can be stored in a prov.jsonfile or passed to prov.parse as a string.The provParseR package also defines a number of functions that extract and return information from the parsed provenance.Usageprov.parse(prov.input,isFile=T)Argumentsprov.input A path to a jsonfile that has been created by rdt or rdtLite or a string that is inprov.json format.isFile A logical value that indicates whether the provenance information is stored in afile(isFile=T)or in a string(isFile=F).ValueA ProvInfo object that can be passed to the access functions provided by the provParseR package.See AlsoThe access functions,including get.environmentExamplesprov<-prov.parse(system.file("testdata","prov.json",package="provParseR",mustWork=TRUE)) ProvInfo-class Collection of information gathered from parsing a PROVfileDescriptionThis is the class that stores provenance information.It is created by prov.parse.Rather than access the slots directly,it is better to use the access functions the package provides.8ProvInfo-classSlotsproc.nodes the procedure nodesdata.nodes the data nodesfunc.nodes the function nodesproc.proc.edges controlflow edgesproc.data.edges output data edgesdata.proc.edges input data edgesfunc.proc.edges function use edgesfunc.lib.edges function library edgesagents tool that created the provenanceargs arguments passed when provenance was createdenvi environmental informationlibs librariesscripts scripts executedSee AlsoThe parse function,which creates the ProvInfo object,prov.parseThe access functions,including get.environmentIndexget.args(get.environment),2get.data.nodes(get.environment),2get.data.proc(get.environment),2get.environment,2,7,8get.error.nodes(get.environment),2get.func.lib(get.environment),2get.func.nodes(get.environment),2get.func.proc(get.environment),2get.input.files(get.environment),2get.libs(get.environment),2get.output.files(get.environment),2get.preexisting(get.environment),2get.proc.data(get.environment),2get.proc.nodes(get.environment),2get.proc.proc(get.environment),2get.saved.scripts(get.environment),2get.scripts(get.environment),2get.stdout.nodes(get.environment),2(get.environment),2get.urls(get.environment),2get.val.type(get.environment),2d(get.environment),2 get.variables.set(get.environment),2ed(get.environment),2 prov.parse,3,6,7,8ProvInfo(ProvInfo-class),7ProvInfo-class,79。

perl 使用方法

perl 使用方法Perl是一种高级编程语言,它被广泛应用于Web开发、系统管理、数据处理等领域。

本文将介绍Perl的使用方法,帮助读者快速上手。

一、Perl的安装与配置1. 下载Perl的最新版本,官方网站提供了多种操作系统的安装包。

2. 双击安装包,按照提示完成安装过程。

3. 配置环境变量,将Perl的安装路径添加到系统的PATH变量中。

二、Perl的基本语法1. 注释:在Perl中,以"#"开头的行表示注释,不会被解释执行。

2. 变量:Perl中的变量使用"$"符号进行标识,可以存储各种类型的数据。

3. 标量:标量变量存储单个值,可以是字符串、数字等。

4. 数组:数组变量存储一组值,使用"@"符号进行标识,可以通过下标访问其中的元素。

5. 哈希:哈希变量存储键值对,使用"%"符号进行标识,可以通过键访问对应的值。

6. 控制结构:Perl支持if-else、for、foreach、while等常见的控制结构,用于实现条件判断和循环操作。

三、Perl的字符串处理1. 字符串连接:使用"."符号可以将两个字符串连接起来。

2. 字符串截取:使用substr函数可以截取字符串的一部分。

3. 字符串替换:使用s///操作符可以替换字符串中的某个子串。

4. 字符串分割:使用split函数可以将一个字符串按照指定的分隔符拆分成多个子串。

5. 字符串匹配:使用正则表达式可以进行强大的字符串匹配操作。

四、Perl的文件操作1. 打开文件:使用open函数可以打开一个文件,并返回文件句柄。

2. 读取文件:使用<>操作符可以从文件句柄中读取一行内容。

3. 写入文件:使用print函数可以向文件句柄写入内容。

4. 关闭文件:使用close函数可以关闭文件句柄。

五、Perl的模块和包管理1. 模块安装:Perl的CPAN(Comprehensive Perl Archive Network)提供了大量的第三方模块,可以使用cpan命令安装。

vep用法

VEP是一款基于Perl编写的变异效应预测工具,用于对人类基因组变异进行分析和注释。

下面是一些常见的VEP用法:

1. 命令行使用:在终端输入以下命令:

vep [options] input_file.vcf [other_input_files]

其中,input_file.vcf是需要分析的VCF格式变异数据文件,other_input_files是其他输入文件,如SNP、INDEL数据库文件等。

options是可选参数,包括:

-a <file>:指定数据库文件,如SNP、INDEL、CNV等。

-c <file>:指定注释信息文件,如GRCh38、GRCh37、hg38等。

-f <file>:指定FASTA格式的转录本序列文件。

-m:启用基因型数据的过滤。

-o <file>:指定输出文件名。

-p:启用基因型数据的过滤。

-r <file>:指定参考基因组文件,如GRCh38、GRCh37、hg38等。

-s <file>:指定SV数据库文件。

-t <file>:指定SV类型数据库文件。

-v:启用基因型数据的过滤。

-w <file>:指定输出文件名。

2. 使用VEP API:可以使用VEP提供的API接口进行变异数据的分析和注释。

具体使用方法请参阅VEP官方文档。

总之,VEP是一款功能强大的变异效应预测工具,可用于对人类基因组变异进行分析和注释。

可以通过命令行或API接口进行使用。

mygpt用法-概述说明以及解释

mygpt用法-概述说明以及解释1.引言1.1 概述随着人工智能技术的不断发展,自然语言处理模型也在不断地进行改进和完善。

其中,mygpt是一种基于开放AI技术的自然语言处理模型,具有强大的语言生成能力和智能对话功能。

mygpt能够理解和分析人类语言,能够进行深入的对话和回答问题。

它的优势在于,能够根据上下文生成连贯的语言,为用户提供更加准确和智能的答复。

此外,mygpt可以适用于多种场景,包括聊天对话、文本生成、信息检索等领域。

本文将介绍mygpt的基本概念和原理,探讨其应用场景和使用方法,旨在帮助读者更好地了解和应用这一先进的自然语言处理技术。

1.2 文章结构文章结构部分主要包括以下几个方面:1. 引言部分:介绍文章的主题和目的,为读者提供一个整体的概念。

2. 正文部分:包括什么是mygpt、mygpt的应用场景、以及如何使用mygpt等内容。

通过这些内容,读者可以了解mygpt的基本信息和如何在实际应用中运用。

3. 结论部分:总结mygpt的优势,并展望其未来的发展。

同时,通过结束语部分为文章做一个圆满的结尾。

通过这样的文章结构,可以使得整篇文章的逻辑清晰,有条不紊地向读者呈现出mygpt的相关信息和潜在价值。

1.3 目的撰写这篇文章的目的在于介绍mygpt的用法,并帮助读者更好地了解如何利用这一工具。

通过详细解释mygpt的概念、应用场景以及具体的使用方法,读者可以更加深入地理解这一技术,并掌握如何在实际项目中应用它来提升工作效率和质量。

除此之外,本文还将总结mygpt的优势,并展望它未来的发展趋势,希望可以激发更多人对这一领域的兴趣,推动mygpt技术的进一步发展和应用。

在结尾,将用简短的话语表达对读者的感激之情,并希望他们能从本文中找到所需的帮助和启发。

2.正文2.1 什么是mygptmygpt是一种基于OpenAI的GPT模型的改进版,它具有更强大的生成能力和更智能的语言理解能力。

hyperscan与pcre正则表达式

hyperscan与pcre正则表达式Hyperscan与PCRE正则表达式正则表达式在文本处理和模式匹配中发挥着重要作用。

无论是在编程中还是在日常生活中,我们都会遇到需要查找、匹配或替换特定模式的情况。

Hyperscan和PCRE是两种常用的正则表达式引擎,本文将介绍它们的特点和用法。

一、Hyperscan正则表达式引擎Hyperscan是一款高性能的多模式匹配库,由Intel开发。

它采用了基于硬件加速的方法,能够快速有效地处理大规模的正则表达式匹配任务。

Hyperscan支持多种语言,包括C、C++、Go和Python等,并提供了易于使用的API接口。

Hyperscan的主要特点之一是支持高并发和多线程处理。

它利用并行处理和多核架构,能够在多个线程上同时执行正则表达式匹配,提高了处理速度和效率。

此外,Hyperscan还支持多种匹配模式,包括单模式、多模式和通配符匹配等,能够满足不同应用场景的需求。

Hyperscan的使用方式也相对简单。

用户可以通过定义正则表达式模式,并使用Hyperscan提供的API函数进行匹配操作。

Hyperscan会根据用户定义的模式,自动进行编译和优化,生成高效的匹配代码。

用户只需调用匹配函数,并传入待匹配的文本,即可完成匹配任务。

二、PCRE正则表达式引擎PCRE(Perl Compatible Regular Expressions)是一款功能强大的正则表达式库,兼容Perl语法。

PCRE支持多种编程语言,包括C、C++、Java和Python等,被广泛应用于各种软件开发和文本处理任务中。

PCRE的特点之一是支持Perl语法和扩展。

Perl语法非常灵活,能够表达复杂的匹配模式和替换规则。

PCRE支持Perl的全部语法特性,包括字符类、分组、重复和反向引用等,可以满足各种复杂的匹配需求。

PCRE的使用也相对简单。

用户可以通过定义正则表达式模式,并使用PCRE提供的API函数进行匹配操作。

NB-Designer软件操作手册(中文NB5和7适用).

Cat.No.NB 系列V106-CN5-01PNSPO!可编程终端NB-Designer用户手册1前言承蒙您惠购可编程终端NB 系列,谨致谢意。

NB 系列是指在FA 生产现场等地所产生的各种信息的可编程终端(PT)。

请在充分理解可编程终端的功能和性能等的基础上正确使用。

●读者对象本手册以下述人员为对象而编写。

具备电气知识(电气工程师或具备同等知识),且 y 负责引进FA 设备的人员; y 设计FA 系统的人员;y 安装、连接FA 设备的人员; y 管理FA 生产现场的人员。

●使用须知y 本手册除了对NB 系列的连接和设定进行说明之外,还介绍了其它必要的信息。

使用前请仔细阅读本手册,充分理解说明内容。

阅读后请妥善保管本手册,以便随时取阅。

●关于“使用时的承诺事项”1. 保修内容①保修期本公司产品的保修期为自购买之日或交付至指定场所之日起1年。

②保修范围在上述保修期内因本公司的责任而发生产品故障时,本公司将在产品购买地点免费予以更换或维修。

但当故障原因符合下列情况之一时,则不属于保修范围。

a)未按照产品目录或使用说明书等资料中说明的条件、环境、操作方法使用时; b)非本公司产品自身的原因时; c)未经本公司授权而改造或维修时; d)未按照本公司产品应有的方法使用时;e)以本公司产品出厂时的科技水平无法对故障进行预测时; f)因自然灾害等其它非本公司责任的不可抗力而导致故障时。

此外,以上的保修是指对本公司产品单件的保修,因本公司产品故障而造成的损失不属于保修对象。

2. 责任限制①因本公司产品而引起的特别损失、间接损失或消极损失,本公司概不负责。

②对于本公司的可编程产品,因非本公司人员编写的程序或由此而产生的后果,本公司概不负责。

23. 适用条件①将本公司产品与其它产品组合使用时,请确认适用的标准、法规或限制。

此外,请用户自行确认本公司的产品是否与您所使用的系统、机械和装置相兼容。

否则,本公司对自身产品的兼容性概不负责。

considered recognized identified -回复

considered recognized identified -回复问题:“为什么环境保护被视为全球性的挑战?”环境保护被认为是全球性的挑战,是因为在全球范围内都存在着共同的环境问题,这些问题不仅会对一个国家或地区产生长期的负面影响,而且会对整个地球造成潜在的灾难性后果。

本文将分步回答这个问题,以更深入地探讨环境保护被视为全球性挑战的原因。

第一步:考虑环境问题的普遍性和影响力。

首先,环境问题普遍存在于全球各地。

无论是发达国家还是发展中国家,都面临着同样的环境挑战,比如气候变化、空气污染、水资源短缺以及生物多样性丧失等。

这些问题不受国界限制,对所有生物和生态系统都具有普遍性的影响。

任何一个国家的环境恶化都可能对其他地区产生连锁反应。

其次,环境问题的影响力超越国家界限。

随着全球化的不断加深,各国之间的经济、政治和社会联系日益紧密。

环境破坏或污染在一个国家发生后,很容易通过贸易、旅游和移民等方式传播到其他地区。

例如,一个国家的水污染可能会对其邻国的渔业造成重大损失,一个国家的大气污染可能会导致邻国的健康问题增加。

因此,环境问题通常具有跨国界的性质,需要全球协作来解决。

第二步:认识到环境问题的复杂性和综合性。

环境问题往往是复杂而综合的,不仅涉及到自然系统,还涉及到人类社会和经济体系。

例如,气候变化是由大气中温室气体的排放导致的,这与工业、农业、交通等领域的活动密切相关。

解决气候变化问题需要全球各国共同减少温室气体排放,这涉及到技术创新、政策协调、经济转型等多方面的努力。

因此,环境问题不仅要求各国共同行动,还需要各领域的专业知识和合作。

第三步:确定环境保护的道德和伦理基础。

环境保护也被视为全球性的挑战,是因为保护环境已经成为全人类的共同责任和道德选择。

地球是人类共同的家园,环境问题不仅威胁到我们当前的生活质量,也会对我们的后代和未来世代造成巨大的影响。

保护环境是对我们自身生存和繁荣的负责,也是对其他物种和生态系统的尊重和保护。

perl glob 函数 匹配大小写

perl glob 函数匹配大小写

perl的glob函数在匹配文件时默认是不区分大小写的。

如果想要匹配时区分大小写,可以使用Perl的文件查找模块File::Glob提供的另外一个函数 bsd_glob。

bsd_glob函数具有多个参数,其中第一个参数是匹配的模式,后续参数是可选的参数设置。

通过设置参数可以实现区分大小写的匹配。

下面是一个示例代码,该代码使用bsd_glob函数进行大小写敏感的匹配:

```perl

use File::Glob ':glob';

print "$file\n";

```

在上述代码中,bsd_glob函数的第一个参数是匹配的模式 "某.t某t",该模式表示匹配所有以".t某t"结尾的文件名。

第二个参数

GLOB_CASE用于设置大小写敏感模式。

需要注意的是,要使用File::Glob模块,需要提前使用CPAN或者其他方式安装。

使用CPAN可以使用以下命令进行安装:

```

cpan File::Glob

```

这样就可以在Perl中使用bsd_glob函数进行大小写敏感的文件匹配了。

promql label_copy 用法

promql label_copy 用法1. 什么是promql?PromQL是Prometheus的查询语言,用于从Prometheus时间序列数据库中提取和处理数据。

Prometheus是一个开源的监控系统和时间序列数据库,用于记录和查询各种应用程序的指标数据。

2. label_copy的作用是什么?在PromQL中,label_copy函数用于复制或重命名时间序列的标签。

它可以在查询结果中创建新的标签,并将原始标签的值复制到新标签中。

这对于重命名标签或创建新的标识符非常有用。

3. label_copy函数的语法label_copy函数的语法如下:示例代码star:编程语言:label_copy(vector instant-vector, stringdestination_label, string source_label)示例代码end参数说明: - vector instant-vector:要复制标签的时间序列向量。

- string destination_label:目标标签的名称。

- string source_label:源标签的名称。

4. label_copy函数的示例下面是一些使用label_copy函数的示例:示例1:复制标签假设我们有一个名为http_requests_total的指标,它具有以下标签:job、instance和status_code。

我们想要复制status_code标签并将其重命名为code。

示例代码star:编程语言:promqllabel_copy(http_requests_total{job="api-server"}, "code", "status_code")示例代码end上述查询将返回一个新的时间序列向量,其中包含http_requests_total的所有标签,并且具有一个新的标签code,其值与原始标签status_code的值相同。

qcamera用法 -回复

qcamera用法-回复Apache Hadoop 3.x是一个开源的分布式计算框架,它提供了对大数据的存储和处理能力。

其中,Hadoop分布式文件系统(HDFS)是Hadoop 的核心组件之一,用于存储和管理大规模数据集。

本文将深入探讨Apache Hadoop 3.x中HDFS的数据写入流程。

HDFS的数据写入流程可以分为以下几个步骤:1. 客户端向NameNode发起写入请求:当一个应用程序需要将数据写入HDFS时,首先会与NameNode建立联系,向其发起写入请求。

NameNode是HDFS的主要控制节点,负责管理文件系统的元数据(如文件和目录的信息)。

2. NameNode检查写入请求:一旦收到写入请求,NameNode会检查文件是否存在以及权限是否满足要求。

如果文件不存在,NameNode会创建一个新的文件条目并将其相关信息记录下来。

否则,NameNode会更新文件的相关元数据。

3. 客户端与DataNode建立联系:在数据写入HDFS之前,客户端需要与DataNode节点建立联系。

DataNode是实际存储和管理数据块的节点,它们是HDFS的工作节点。

4. 客户端分割数据:在将数据写入HDFS之前,客户端会将数据分割为固定大小的数据块。

默认情况下,HDFS的数据块大小为128MB,但也可以根据需要进行配置。

分割数据的目的是为了能够更好地管理和分布数据。

5. 客户端向NameNode请求数据块位置:在向DataNode写入数据之前,客户端需要向NameNode请求每个数据块的位置信息。

NameNode收到请求后会返回一个包含DataNode地址的数据块位置列表。

6. 客户端与DataNode建立数据传输管道:客户端根据数据块位置列表,与所有的DataNode建立数据传输管道。

数据传输管道是一种用于将数据从客户端发送到DataNode的连接方式,它可以提高数据传输的效率。

7. 客户端向DataNode写入数据:一旦数据传输管道建立好,客户端就可以向DataNode写入数据了。

pol-tl custompolicy 正则 -回复

pol-tl custompolicy 正则-回复您的要求是使用中括号内的内容作为主题,写一篇1500-2000字的文章,并一步一步地回答问题。

在这篇文章中,我们将探讨"poltl custompolicy"的正则表达式。

下面是一步一步的回答和讨论。

首先,让我们来了解一下正则表达式的概念。

正则表达式是一种用于匹配、查找和操作字符串的模式。

它由各种字符和运算符组成,用于描述字符串的特定模式。

正则表达式通常用于字符串搜索、替换和验证。

现在让我们回到您提出的问题,"poltl custompolicy"的正则表达式。

第一步:确定匹配的基本模式。

根据您提供的内容,我们可以推断出,"poltl custompolicy"是由两个单词组成的短语。

它们之间可能有一个空格分隔。

所以,我们的基本模式可以是:\b\w+\b\s\b\w+\b在上述模式中,\b表示单词的边界,\w+表示一个或多个字母、数字或下划线字符,\s表示一个空白字符。

第二步:测试基本模式是否适用于所有情况。

在这一步中,我们将用一些示例数据来测试我们的正则表达式是否匹配所有可能的情况。

假设我们有以下示例数据:1. "poltl custompolicy"2. "poltlcustompolicy"3. "poltl_custompolicy"4. "custompolicy poltl"我们将基本模式应用于以上示例数据。

根据我们的正则表达式,第一和第四个示例数据将匹配成功,而第二和第三个示例数据将不匹配。

我们可以得出结论,基本模式并不适用于所有情况。

第三步:修改正则表达式以适应所有情况。

根据我们的测试结果,我们可以修改正则表达式以适应所有情况。

一种可能的修正是:\b[^ ]+\b\s\b[^ ]+\b在上述修正中,我们使用了[^ ]+来匹配至少一个非空格字符。

如何利用自然语言处理技术进行多语言翻译的结果验证

随着全球化的发展,多语言翻译在各个领域都变得越来越重要。

然而,由于不同语言之间的语法结构、词汇用法等差异,多语言翻译往往面临着巨大的挑战。

为了解决这一问题,自然语言处理(NLP)技术被广泛应用于多语言翻译中。

本文将探讨如何利用自然语言处理技术进行多语言翻译的结果验证。

一、文本对齐在进行多语言翻译的结果验证时,首先需要进行文本对齐。

文本对齐是指将源语言文本与目标语言文本进行对应,以便进行翻译结果的比对和验证。

自然语言处理技术可以帮助我们实现文本对齐,通过分析语言特征、词汇等信息,找出两种语言中相对应的部分,从而进行文本对齐。

二、语义分析在进行多语言翻译的结果验证时,语义分析起着至关重要的作用。

语义分析是指对语言中的意思和含义进行分析和理解。

在多语言翻译中,我们需要确保翻译结果不仅在词汇层面上相互对应,还要在语义层面上相互对应。

自然语言处理技术可以通过语义分析,帮助我们验证翻译结果是否准确、符合语境。

三、语法分析除了语义分析,语法分析也是多语言翻译结果验证的重要环节。

语法分析是指对语言中的句法结构、语法规则等进行分析和处理。

在多语言翻译中,语法分析可以帮助我们验证翻译结果在语法上是否合乎规范,是否符合目标语言的语法结构。

自然语言处理技术可以通过语法分析,帮助我们验证翻译结果的语法正确性。

四、语言模型在进行多语言翻译的结果验证时,语言模型是一个非常重要的环节。

语言模型是一个用来预测语言序列的概率模型,可以帮助我们评估翻译结果的流畅度和自然度。

自然语言处理技术可以通过语言模型,帮助我们验证翻译结果的流畅度和自然度,确保翻译结果符合目标语言的表达习惯和习惯用语。

五、文本生成最后一个环节是文本生成。

在进行多语言翻译的结果验证时,我们需要将验证结果进行汇总和总结,生成相应的文本报告。

自然语言处理技术可以帮助我们进行文本生成,通过自动化的方式生成翻译结果验证报告,使得验证结果更加清晰和直观。

总结利用自然语言处理技术进行多语言翻译的结果验证,可以帮助我们从多个角度对翻译结果进行全面的验证和评估。

Globals包的中文名称:R语言全局对象识别器说明书

Package‘globals’November21,2022Version0.16.2Depends R(>=3.1.2)Imports codetoolsTitle Identify Global Objects in R ExpressionsDescription Identifies global(``unknown''or``free'')objects in R expressionsby code inspection using various strategies(ordered,liberal,orconservative).The objective of this package is to make it as simple aspossible to identify global objects for the purpose of exporting them inparallel,distributed compute environments.License LGPL(>=2.1)LazyLoad TRUEByteCompile TRUEURL https://,https:///HenrikBengtsson/globalsBugReports https:///HenrikBengtsson/globals/issuesRoxygenNote7.2.2NeedsCompilation noAuthor Henrik Bengtsson[aut,cre,cph],Davis Vaughan[ctb]Maintainer Henrik Bengtsson<*****************>Repository CRANDate/Publication2022-11-2121:10:02UTCR topics documented:cleanup.Globals (2)findGlobals (2)Globals (4)globalsByName (5)packagesOf.Globals (5)Index61cleanup.Globals Drop certain types of globalsDescriptionDrop certain types of globalsUsage##S3method for class Globalscleanup(globals,drop=c("missing","base-packages","nativesymbolinfo"),...) Argumentsglobals A Globals object.drop A character vector specifying what type of globals to drop....Not usedfindGlobals Get all global objects of an expressionDescriptionGet all global objects of an expressionUsagefindGlobals(expr,envir=parent.frame(),...,attributes=TRUE,tweak=NULL,dotdotdot=c("warning","error","return","ignore"),method=c("ordered","conservative","liberal"),substitute=FALSE,unlist=TRUE,trace=FALSE)globalsOf(expr,envir=parent.frame(),...,method=c("ordered","conservative","liberal"),tweak=NULL,locals=NA,substitute=FALSE,mustExist=TRUE,unlist=TRUE,recursive=TRUE,skip=NULL)Argumentsexpr An R expression.envir The environment from where to search for globals....Not used.attributes If TRUE(default),attributes of‘expr‘are also searched.If FALSE,they are not.If a character vector,then attributes with matching names are searched.Note,the attributes of the attributes elements are not searched,that is,attributes are notsearched recursively.Also,attributes are searched with‘dotdotdot="ignore".tweak An optional function that takes an expression and returns a tweaked expression.dotdotdot TBD.method A character string specifying what type of search algorithm to use.substitute If TRUE,the expression is substitute():ed,otherwise not.unlist If TRUE,a list of unique objects is returned.If FALSE,a list of length(expr) sublists.trace TBD.locals Should globals part of any"local"environment of a function be included or not?mustExist If TRUE,an error is thrown if the object of the identified global cannot be lo-cated.Otherwise,the global is not returned.recursive If TRUE,globals that are closures(functions)and that exist outside of names-paces("packages"),will be recursively scanned for globals.skip(internal)A list of globals not to be searched for additional globals.Ignored unless recursive is TRUE.DetailsThere currently three strategies for identifying global objects.The method="ordered"search method identifies globals such that a global variable preceding a local variable with the same name is not dropped(which the"conservative"method would).The method="conservative"search method tries to keep the number of false positive to a mini-mum,i.e.the identified objects are most likely true global objects.At the same time,there is a risk that some true globals are not identified(see example).This search method returns the exact same result as the findGlobals()function of the codetools package.The method="liberal"search method tries to keep the true-positive ratio as high as possible,i.e.the true globals are most likely among the identified ones.At the same time,there is a risk that some false positives are also identified.With recursive=TRUE,globals part of locally defined functions will also be found,otherwise not.4GlobalsValuefindGlobals()returns a character vector.globalsOf()returns a Globals object.See AlsoInternally,the codetools package is utilized for code inspections.Examplesb<-2expr<-substitute({a<-b;b<-1})##Will_not_identify b (because it s also a local)globalsC<-globalsOf(expr,method="conservative")print(globalsC)##Will identify bglobalsL<-globalsOf(expr,method="liberal")print(globalsL)Globals A representation of a set of globalsDescriptionA representation of a set of globalsUsageGlobals(object,...)Argumentsobject A named list....Not used.ValueAn object of class Globals,which is a named list of the value of the globals,where the element names are the names of the globals.Attribute where is a named list of the same length and with the same names.See AlsoThe globalsOf()function identifies globals from an R expression and returns a Globals object.globalsByName5 globalsByName Locates and retrieves a set of global variables by their namesDescriptionLocates and retrieves a set of global variables by their namesUsageglobalsByName(names,envir=parent.frame(),mustExist=TRUE,...)Argumentsnames A character vector of global variable names.envir The environment from where to search for globals.mustExist If TRUE,an error is thrown if the object of the identified global cannot be lo-cated.Otherwise,the global is not returned....Not used.ValueA Globals object.packagesOf.Globals Identify the packages of the globalsDescriptionIdentify the packages of the globalsUsage##S3method for class GlobalspackagesOf(globals,...)Argumentsglobals A Globals object....Not used.ValueReturns a character vector of package names.Index[.Globals(Globals),4as.Globals(Globals),4cleanup(cleanup.Globals),2cleanup.Globals,2codetools,4findGlobals,2,3Globals,4,4,5globalsByName,5globalsOf,4globalsOf(findGlobals),2names(Globals),4packagesOf(packagesOf.Globals),5 packagesOf.Globals,56。

flink cep pattern字符串 aviator规则 -回复

flink cep pattern字符串aviator规则-回复Flink CEP(Complex Event Processing)是一种基于流数据的复杂事件处理技术,可以实时地从海量数据中识别出符合特定模式的事件。

而在Flink CEP中,模式的表达则采用了一种称为Aviator规则的字符串表示方法。

本文将详细地介绍Flink CEP模式字符串以及Aviator规则,以及它们如何在复杂事件处理中发挥作用。

首先,我们来了解一下Flink CEP模式字符串的基本概念和语法。

Flink CEP 模式字符串是一种用于描述事件序列模式的语言,通过定义一系列规则和约束条件来描述所需的事件模式。

一个模式字符串通常包含多个事件操作符和事件约束条件,用于指定事件的类型、顺序和时间窗口等。

这些操作符和条件可以组合使用,以灵活地定义复杂事件模式。

Aviator规则是一种在Flink CEP中使用的模式字符串语法,它借鉴了Aviator表达式解析引擎的设计思想。

Aviator规则允许在模式字符串中使用变量、常量、算术运算符、逻辑运算符和函数调用等,并支持复杂的逻辑判断和计算。

使用Aviator规则,可以更加灵活地定义事件模式,并根据需要进行定制化的计算和业务逻辑处理。

接下来,我们将一步一步地回答以下问题,以便更深入地理解Flink CEP 模式字符串和Aviator规则在复杂事件处理中的应用。

问题一:什么是Flink CEP模式字符串?Flink CEP模式字符串是一种用于描述事件序列模式的语言,通过定义规则和约束条件来确定所需的事件模式。

模式字符串可以指定事件的类型、顺序和时间窗口等,用于实现实时的复杂事件处理。

问题二:Aviator规则在Flink CEP中的作用是什么?Aviator规则在Flink CEP中用于定义和解析模式字符串,并提供了丰富的语法和运算符来支持复杂的逻辑判断和计算。

使用Aviator规则,可以更灵活地定义事件模式,并根据需要进行定制化的计算和业务逻辑处理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Haw To Recognize Globalization Properly 2008 Beijing Olimpic Game left so many excited and amazed memorise for people all of the world.From now on,the song is quite popular amone different national people,it is “You and Me”sung by Liuhuan and Sarah birqhtamn.

The song is telling us that globalization is more and more popular.With the science developing and economy increasing in every nations,globalization has been showed not only in economy but also culture and polity.

However,how do we recognize globalization properly? Coin has two sides.On the one hand,it purs labor and capital mobility between nations and some

countries’economy boom from it,especially developed ones.On the other hand,it enhances and increasese the poverty and inequality.Indeed,most countries are richer than last,but morden poverty and inequality means the income gap is wider between developing countries and the developed.What’s more,the wide gap doesn’t tell us the whole story,distribution becomes unequal.Take china for example,our country supply the

location and numerous labor to produce products for foreign enterprises,but the income is much lower than these enterprises.

In fact,globalization is a trend that none of us has ability to stop it.What we would do is take advantage it to push the economy to

develop.Especially,government should take some actions including reducing tax rates,attracting investment,increasing output and so on to adapt the trend positively.

王丽霞

学号:291069。