北邮郭军web搜索第五章

WebGoat 5.4课程

密级公开WebGoat 5.4课程北京知道创宇信息技术有限公司2012-9版本说明修订人修订内容修订时间版本号审阅人白河·愁初稿2011.11.8 0.1文档信息文档名称文档编号文档版本号保密级别扩散范围扩散批准人文档说明WebGoat的课程指导,自己根据网上搜集的资料整理(主要是胡晓斌2011年7月的WebGoat5.2使用说明)和自己的理解完成和半完成。

因能力有限,部分课程没有完成,希望有兴趣的人一起学习、补充。

版权声明可以随便修改目录1.WebGoat简介 (1)1.1.WebGoat安装 (1)1.2.WebGoat启动 (1)2.WebGoat课程 (3)2.1.Introduction(介绍) (3)2.1.1.HowtoworkwithWebGoat (3)2.1.2.HowToConfigureTomcat (4)efulTools(工具介绍) (6)2.1.4.CreateAWebGoatLesson (7)2.2.General(常规) (7)2.2.1.HTTPBasic (7)2.2.2.HTTPSplitting(HTTP拆分) (7)2.3.AccessControlFlaws(访问控制缺陷) (8)inganAccessControlMatrix (8)2.3.2.BypassaPathBasedAccessControlScheme (9)B:RoleBasedAccessControl(基于角色的访问控制测试) (11)2.4.AJAXSecurity (14)2.4.1.SameOriginPolicyProtection (14)B:DOM-Basedcross-sitescripting (15)B:ClientSideFiltering (18)2.4.4.DOMInjection (19)2.4.5.XMLInjection (20)2.4.6.JSONInjection (23)2.4.7.SilentTransactionsAttacks (25)2.4.8.DangerousUseofEval (26)2.4.9.InsecureClientStorage (26)2.5.AuthenticationFlaws(认证漏洞) (28)2.5.1.PasswordStrength (28)2.5.2.ForgotPassword (29)2.5.3.BasicAuthentication (29)2.5.4.MultiLevelLogin1 (32)2.5.5.MultiLevelLogin2 (34)2.6.BufferOverflows(缓冲区溢出) (35)2.6.1.Off-by-OneOverflows (35)2.7.CodeQuality(代码质量) (36)2.7.1.DiscoverCluesintheHTML (36)2.8.Concurrency(并发) (36)2.8.1.ThreadSafetyProblems (36)2.8.2.ShoppingCartConcurrencyFlaw (37)2.9.Cross-SiteScripting(XSS,跨站脚本) (39)2.9.1.PhishingwithXSS (39)B:CrossSiteScripting (40)2.9.3.StoredXSSAttacks (41)2.9.4.ReflectedXSSAttacks (42)2.9.5.CrossSiteRequestForgery(CSRF) (42)2.9.6.CSRFPromptBy-Pass (44)2.9.7.CSRFTokenBy-Pass (44)2.9.8.HTTPOnlyTest (44)2.9.9.CrossSiteTracing(XST)Attacks (45)2.10.ImproperErrorHandling(不正确的错误处理) (46)2.10.1.FailOpenAuthenticationScheme (46)2.11.InjectionFlaws(注入漏洞) (47)mandInjection (47)2.11.2.NumericSQLInjection (48)2.11.3.LogSpoofing (49)2.11.4.XPATHInjection (50)2.11.5.StringSQLInjection (51)B:SQLInjection (52)2.11.7.ModifyDatawithSQLInjection (54)2.11.8.AddDatawithSQLInjection (54)2.11.9.DatabaseBackdoors (55)2.11.10.Blind Numeric SQL Injection (74)2.12.Denial of Service(拒绝服务) (74)2.12.1.Denial of Service from Multiple Logins (74)2.13.Insecure Communication(不安全的通讯) (75)2.13.1.Insecure Login (75)2.14.Insecure Configuration(不安全配置) (76)2.14.1.Forced Browsing (76)2.15.Insecure Storage(不安全的存储) (77)2.15.1.Encoding Basics (77)2.16.Malicious Execution(恶意执行) (78)2.16.1.Malicious File Execution (78)2.17.Parameter Tampering(参数篡改) (79)2.17.1.Bypass HTML Field Restrictions (79)2.17.2.Exploit Hidden Fields (79)2.17.3.Exploit Unchecked Email (79)2.17.4.Bypass Client Side JavaScript Validation (81)2.18.Session Management Flaws(会话管理漏洞) (82)2.18.1.Hijack a Session (82)2.18.2.Spoof an Authentication Cookie (82)2.18.3.Session Fixation (84)2.19.Web Services (85)2.19.1.Create a SOAP Request (85)2.19.2.WSDL Scanning (86)2.19.3.Web Service SAX Injection (87)2.19.4.Web Service SQL Injection (88)2.20.Admin Functions(管理功能) (88)2.20.1.Report Card (88)2.21.Challenge (89)3.关于OWASP (89)4.问题 (89)1.WebGoat简介WebGoat是OWASP(OpenWebApplicationSecurityProject)开发的用于Web 漏洞演示与验证的平台。

北京邮电大学信息与通信工程学院介绍

北京邮电大学信息与通信工程学院介绍学院史话2008年,按照“学科归位”的改革措施,学校将原电信工程学院、原信息工程学院和原继续教育学院涉及“信息与通信工程”一级学科的资源重新整合为“信息与通信工程学院”,成为北邮规模最大的学院,也是目前国内规模最大、设施齐全、基础雄厚的信息通信专业人才培养基地之一,目标在于集中体现北邮最具优势的学科和专业,使北邮继续保持在信息通信领域的全国领先地位。

2008年10月15日,在北邮科学会堂举行了信息与通信工程学院成立大会,学校王亚杰书记和方滨兴校长亲自为信息与通信工程学院揭牌,标志着信息与通信工程学院正式成立。

信息与通信工程学院的前身是1955年学校建校初期的有线电工程系和无线电工程系,因此追溯她的历史,是与北邮同步成长和发展的。

在叶培大、周炯槃、蔡长年等老一辈教育家的带领下,经过五十多年的发展历程,她为祖国的邮电通信事业培养了大批优秀的人才,从共和国的部长到大学的校长,从著名的学者、教授到杰出的企业家、科技专家,从人类灵魂的工程师到通信行业的业务骨干,他们用辛勤开创了中国自己的电信事业,他们用智慧创造了先进的信息技术,他们用心血培养了一代代优秀的北邮人,他们正在用双手托起一个信息化的现代中国。

昔日的学子遍布祖国大江南北、世界各个大洲,一代代信通人薪火相传,奋斗不息,经过半个多世纪的文化传承,已是誉传内外,桃李芬芳。

截止到2008年,信息与通信工程学院共培养了30000多名本科毕业生、4000多名硕士毕业生、700多名博士毕业生以及工程硕士研究生400多名、各类专科毕业生6000多名,她们为祖国建设和经济发展做出了突出贡献,也为学院发展奠定了坚实基础。

历年专业设置1952年~1958年有线电工程系电报电话通信、通信自动控制(59)、有线制造(59)无线电工程系无线电通信及广播、电子电路(58、59)、无线制造(59)、微波通信(59)1960年有线电工程系电报电话通信、有线制造、邮机、长途电话专修科、线路专修科、电报专修科无线电工程系无线电通信及广播、无线制造、无线物理、无线电通信及广播专修科1961年~1965年有线电工程系电报电话通信、通信自动控制(61、62)、有线制造(61~63)、有线电设备(64、65)无线电工程系无线电通信及广播、无线物理、无线制造(61~63)、无线电技术(64、65)1966年~1970年停招1971年~1976年电信工程系数字通信(71~74、76)、载波通信、长话自动交换(72)、电子器件(72、73、76)、电子交换(73~76)、通信电力(76)无线电工程系微波通信、无线通信(73)、无线电技术(74~76)、电视(74~76)1977年~1985年电信工程系数字通信(77~79)、载波通信(77~79)、计算机通信(77~84)、电信工程(80~84)、通信工程(85)无线电工程系微波通信(77~80、82)、无线电技术(77~80)、电视(77、78、80)、无线电工程(81、83)、电磁场与微波技术(85)、无线电通信(85)、图像传输与处理(85)、无线电工程(80夜大)1986年~1996年电信工程系通信工程、光缆通信(91、92专科)、通信工程(93专科)、光纤通信(93~95专科)、程控交换(91、92、94专科)、96新疆班无线电工程系电磁场与微波技术、无线电通信(86~95)、图像传输与处理(86~95)、无线电技术(87~92、94~96夜大)、卫星通信(91专科)、数字微波(92专科)、移动通信(93~96专科)信息工程系信息工程、应用数学(86~93)、信息科学(94)、自动化(95~96)1997年~1999年电信工程学院通信工程、电子信息工程、通信工程(97~99夜大)信息工程系信息工程、信息科学、自动化2000年~2008年电信工程学院通信工程、电子信息工程信息工程学院信息工程、信息与计算科学、自动化、信息安全(02~08)、数字媒体艺术(04~08)、智能科学与技术(06~08)2009年开始信息与通信工程学院通信工程、信息工程、电子信息工程、数字媒体技术学院简介学院拥有一支以中国工程院院士周炯槃教授和刘韵洁教授为杰出代表、以多位国内外知名专家为学科带头人、以高水平的博士生导师、教授、副教授和具有博士学位的年轻教师组成的师资队伍。

2018北京邮电大学信息与通信工程考研复试通知复试时间复试分数线复试经验

2018北京邮电大学信息与通信工程考研复试通知复试时间复试分数线复试经验启道考研网快讯:2018年考研复试即将开始,启道教育小编根据根据考生需要,整理2017年北京邮电大学信息与通信工程学院081000信息与通信工程考研复试细则,仅供参考:一、复试科目(启道考研复试辅导班)件定义网络、网络人工智能李莉,姚海鹏,刘江,谢人超,张娇201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一07 高速宽带网络融合技术纪越峰,孙咏梅,王宏祥,李慧,黄治同,顾仁涛,杨大全,张佳玮①101思想政治理论②201英语一③301数学一④801通信原理08 移动互联网与空间通信张琳,苏驷希,吴晓非,刘雨,禹可,顾昕钰,朱①101思想政治理论②201英语一③301数学一④801通信原理⑤804信④⑤选一15 移动通信、网络智能化与数据挖掘纪红,高泽华,孙文生,李曦,张鹤立①101思想政治理论②201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一16 移动通信与无线网络数据分析啜钢,李广成,刘辛越,高伟东①101思想政治理论②201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一①101思想政治理论②处理④801通信原理⑤804信号与系统24 认知无线网络、多协议网络和移动互联网技术张陆勇,黄小军,陈佃军①101思想政治理论②201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一25 宽带移动通信与网络融合王晓湘,张鸿涛①101思想政治理论②201英语一③301数学一④801通信原理⑤804信④⑤选一32 下一代接入网与移动互联网寿国础,胡怡红①101思想政治理论②201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一33 数据挖掘、行为认知及智能应用胡铮,唐晓晟①101思想政治理论②201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一①101思想政治理论②40 5G移动通信王亚峰201英语一③301数学一④801通信原理41 )移动大数据袁超伟①101思想政治理论②201英语一③301数学一④801通信原理42 多媒体信息处理与传输别红霞①101思想政治理论②201英语一③301数学一④801通信原理⑤804信号与系统④⑤选一号与系统49 移动互联网与数据中心(IDC)新技术彭扬①101思想政治理论②201英语一③301数学一④801通信原理50 光传输系统与网络乔耀军①101思想政治理论②201英语一③301数学一④801通信原理①101思想政治理论②201英语一③301数学一二、复试通知(启道考研复试辅导班)考生参加复试流程1. 网上支付复试费支付时间:3月23日-3月25日;支付方式:网上支付特别提示:缴费成功后(在招生宣传咨询会上领取到免复试费证明的考生无须支付),打印《2017年报考攻读硕士学位研究生登记表》,仔细核对信息,确认无误后签字,在报到时提交,否则不予复试。

北邮考研复试班-北京邮电大学信息与通信工程学院信息与通信工程考研复试经验分享

北邮考研复试班-北京邮电大学信息与通信工程学院信息与通信工程考研复试经验分享北京邮电大学是教育部直属、工业和信息化部共建、首批进行“211工程”建设的全国重点大学,是“985优势学科创新平台”项目重点建设高校,是一所以信息科技为特色、工学门类为主体、工管文理协调发展的多科性、研究型大学,是我国信息科技人才的重要培养基地。

2017年,“信息网络科学与技术学科群”和“计算机科学与网络安全学科群”两个学科群进入一流学科建设行列。

学校坚持以习近平新时代中国特色社会主义思想为指导,坚持立德树人根本任务,扎根中国大地办好中国特色社会主义大学。

学校始终肩负“传邮万里国脉所系”的家国情怀。

自1955年建校以来,经过60多年的建设与发展,学校全日制教育已经形成了信息背景浓郁、专业特色鲜明、学科优势突出的办学格局。

学校现设有信息与通信工程学院、电子工程学院、计算机学院、自动化学院、软件学院、数字媒体与设计艺术学院、现代邮政学院、网络空间安全学院、光电信息学院、理学院、经济管理学院、人文学院、马克思主义学院、国际学院、网络教育学院、继续教育学院、民族教育学院、体育部等18个教学单位,以及网络技术、信息光子学与光通信、感知技术与产业3个研究院,可信网络通信2011协同创新中心,并设有研究生院。

目前,学科专业已经涵盖理学、工学、文学、法学、经济学、管理学、教育学、哲学、艺术学等9个学科门类,涉及22个一级学科。

学校信息与通信工程、计算机科学与技术以及电子科学与技术三个一级学科在教育部第四轮学科评估中被评为A类学科,其中信息与通信工程取得了A+的优异成绩。

专业介绍信息与通信工程是一级学科,下设通信与信息系统、信号与信息处理、电子与通信工程、集成电路工程、电路与系统、生物医学工程、新媒体等硕士点,通信工程、电子信息工程、广播电视工程、数字媒体技术、信息安全等本科二级专业。

该学科是一个基础知识面宽、应用领域广阔的综合性学科,涉及广播、电视、视频、电路、图像、电影、媒体、电磁场、信号处理、卫星移动视频等众多高技术领域。

北邮郭军web搜索第五章

基本方法

信息过滤系统中常用的分类器 Bayes分类器 向量距离分类器 k近邻分类器 SVM

系统性能评价

Bayes分类器

Bayes分类器将分类问题看作统计决策问题,以最小错 误率为目标进行分类

前提:事先获得各个类别的概率分布,决策时利用 Bayes公式计算给定样本特征值条件下各类别的后验 概率

SVM

SVM是一种以结构风险最小化为目标的二元分类器, 在寻找最优分类超平面时不但要求将两类数据隔离, 而且要求两类数据距超平面的平均距离最大

设线性可分数据集为 D {( xi , yi )}in1 x Rd y 1, 1

D维空间中线性判别函数的一般形式为

g(x) w x b

分类超平面方程为

w x b 0

系统性能评价

评价指标主要包括分类器的精度和速度 速度取决于分类器算法的复杂程度,在实际应用中 与计算机的硬件性能关系很大 精度通过与人工标注结果(ground truth)进行比较来 计算

对于二元分类问题,常用的精度指标有 准确率 召回率

F-measure break-even点

二元分类:一类是需要筛选出来的,一类是系统不关心 的

以模式分类为技术核心,高效高精度地处理数据流

IF的研究重点

分类器的选择 针对特定的应用环境选择分类器模型 目前研究较多的是朴素Bayes模型、向量相似度(模 板匹配)模型、SVM、k-NN等

分类器的学习及优化 生成式算法、区分式算法 计算效率,类别模型的增量学习和自动演进,半监 督学习、特征降维技术

对于多个词,如何判别?

似然比Rl

二元分类问题可以根据似然比Rl来决定t的归属

d

P(c1) P(t j | c1)

Rl

北京邮电大学信息与通信工程学院

此外,学院面向社会企事业单位培养“电子与通信工程领域”在职工程硕士专业学位研究生。

学院的毕业生以良好的专业素质、扎实的理论基础和踏实的工作态度颇受社会的青睐和好评。研究生就业率一直保持在100%,本科生就业率达到99%左右,本科生考取研究生及出国深造的比例为50%左右。毕业生遍布全国信息通信领域的各大运营商、制造商、公司、企事业单位、科研院所以及合资企业和外资企业,许多毕业生在单位担任领导职务、承担重要工作,为我国信息通信事业的发展做出了突出贡献。

信息工程系信息工程、应用数学(86~93)、信息科学(94)、自动化(95~96)

1997年~1999年

电信工程学院通信工程、电子信息工程、通信工程(97~99夜大)

信息工程系信息工程、信息科学、自动化

2000年~2008年

电信工程学院通信工程、电子信息工程

信息工程学院信息工程、信息与计算科学、自动化、信息安全(02~08)、数字媒体艺术(04~08)、智能科学与技术(06~08)

苗建松

泛网无线张平新一代无线通信基础理论与网络技术田辉、刘宝玲、陶小峰、

刘培植、康桂霞、王莹、

张建华、李立华、冯志勇、

崔琪楣、姜军、张治、

唐晓晟、陈佃军

周正短距离无线通信新技术蒋挺、黄小军、赵成林、

张陆勇、邹卫霞、陈萍

网络搜索郭军Web搜索理论与技术蔺志青、杨文川、张彬、

董远、张洪刚、刘刚、

徐蔚然、张闯、刘瑞芳、

学院以信息科技为特色,以突出的学科实力和明显的专业优势,在全国信息通信领域享有很高的声誉,重点建设的一级学科“信息与通信工程”是国家级重点学科。学院拥有“泛网无线通信”教育部重点实验室,以及多个信息产业部重点实验室;承担完成了大量国家自然科学基金、国家攻关、国家863计划、国家973计划和省部级等多项重点科研项目,也承担完成了大批横向科研任务,取得了丰硕的科研成果。

北京邮电大学复变函数第五章

(2) 如果 z0 为函数 f ( z ) 的极点 , 则

lim f ( z ) .

3z 2 , 例5 有理分式函数 f ( z ) 2 z ( z 2)

z z0

一阶极点又 称简单极点

z 0 是二阶极点, z 2 是一阶极点.

2)极点的判定方法

(3) 由有界性判断:

z0为f ( z)的可去奇点 f ( z)在z0的一个邻域内有界.

例3

sin z 1 2 1 4 1 z z 中不含负幂项, z 3! 5!

sin z z0 是 的可去奇点 . z

如果补充定义:

z 0 时,

sin z 1, z

sin z 那末 在 z 0 解析. z

那么孤立奇点 z0 称为 f ( z ) 的可去奇点.

说明: (1) z0若是f ( z )的孤立奇点 ,

f ( z ) c0 c1 ( z z0 ) cn ( z z0 )n .

( 0 z z0 )

其和函数 F ( z ) 为在 z0 解析的函数. (2) 无论 f ( z ) 在 z0 是否有定义,

f ( z ) 判断 . (3) 利用极限 lim z z

0

课堂练习

1 求 3 的奇点, 如果是极点, 指出它的 级数. 2 z z z 1

答案

1 1 由于 3 2, 2 z z z 1 ( z 1)( z 1)

所以 : z 1是函数的一级极点 , z 1是函数的二级极点 .

不存在 且不为

二、函数的零点与极点的关系

1.零点的定义

不恒等于零的解析函数 f ( z ) 如果

北邮郭军web搜索第七章第二讲

产业界的跟进

2012年11月,微软在天津公开演示了一个全自动的同声传译 系统,讲演者用英文演讲,后台的计算机一气呵成自动完成 语音识别、英中机器翻译和中文语音合成,效果非常流畅。所

对Deep Learning而言,设有输入I(如一批图像或文本)进入了 系统 S,通过调整系统参数,使得它的输出 O仍然是输入 I,那 么就可以自动地获取输入I的一系列层次特征,即S1,…, Sn

深度学习的基本思想

深度学习就是堆叠多个层,使当前层的输出作为下

一层的输入。通过这种方式实现对输入信息的分级 表达

初级(浅层)特征表示

他们提出的问题是,如何从这400个碎片中,选取一组 碎片S[k], 通过叠加的办法,合成出一个与T尽可能相 似的碎片,同时,S[k]的数量尽可能少。数学上:

Sum_k (a[k] * S[k]) T, 时的权重系数 其中 a[k] 是在叠加碎片 S[k]

这便引出了稀疏编码

Output Features

Decoder

Encoder

Input (Image/ Features)

非监督学习获取特征

在以往神经网络中,输入的样本是有标签的 ,即 (input, target),因而可根据当前输出和标签之间 的差去调整参数 如果只有无标签数据,那么误差如何得到呢?

非监督学习获取特征

还可以略微放松一下限制,即只要使输入与输出的 差别尽可能小即可,这个放松会导致另外一类不同 的Deep Learning方法

浅层学习和深度学习

浅层学习(Shallow Learning) 机器学习的第一次浪潮

深度学习(Deep Learning) 机器学习的第二次浪潮

北邮随机信号答案ch5

怎样的条件才能使

Z (t ) =

∑A e ω

j k =1 k

n

kt

是一个复平稳随机过程。 5.7 设有复随机过程

Z (t ) = ∑ (α i cos ω i t + jβ sin ω i t )

i =1

n

其中 α i 与 β k 是相互独立的随机变量, α i 与 α k 、 β i 与 β k (i ≠ k ) 是相互正交的,数学期 望和方差分别为 E[α i ] = E[ β i ] =0, 解:

πτ

= R0 (τ ) cos ω0τ

ˆ (τ ) = R (τ ) sin ω τ 是一个低频信号,所以 R n 0 0 πτ ˆ (τ ) sin ω τ = R (τ ) 所以 Rn (τ ) = Rn (τ ) = Rn (τ ) cos ω0τ + R n 0 0

由于 R0 (τ ) =

c s

=

1 2π

∫

∞

−∞

[2 X (ω − ω ′)U (ω − ω ′)][2 X (ω ′)U (ω ′)]d ω ′

Ω Ω ⎧ ω0 − ≤ ω ′ ≤ ω0 + ⎪ Ω Ω ⎪ 2 2 时亦不 由于有 ω0 − ≤ ω ≤ ω0 + 时 X (ω ) 不为零,因此有 ⎨ 2 2 ⎪ω − Ω ≤ ω − ω ′ ≤ ω + Ω 0 0 ⎪ 2 2 ⎩

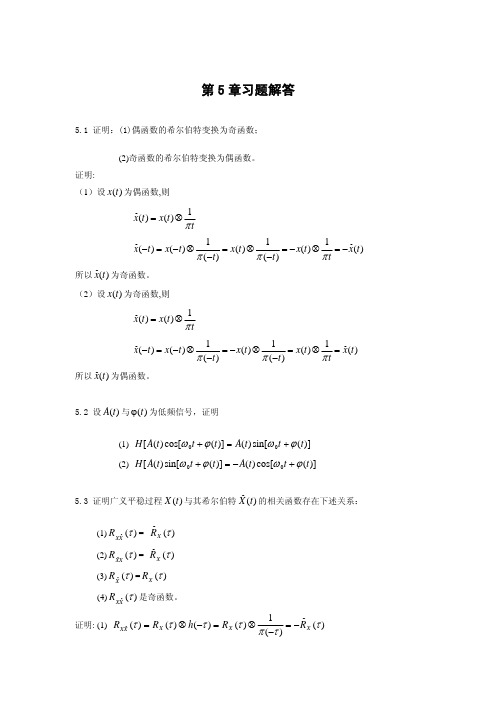

5.2 设 A(t ) 与 ϕ(t ) 为低频信号,证明 (1) H [ A(t ) cos[ω 0 t + ϕ (t )] = A(t ) sin[ω 0 t + ϕ (t )] (2) H [ A(t ) sin[ω 0 t + ϕ (t )] = − A(t ) cos[ω 0 t + ϕ (t )]

北邮郭军web搜索第三章

( i , j )D ( k ,l )

P{ui(,rj) | si(,rj) })

文本标注

图像I与一个图像类C的相似性通过由C的2DMHMM模型 产生I的对数似然度来估计

获得图像I属于各个图像类的似然度后,将其进行排序, 以找出似然度最高的k个图像类,k可以固定,也可以基 于似然度阈值选取 前k个类的描述词是图像I的候选标注词,如果希望用较 少的词标注图像,则需要一个筛选机制

根据以上假设

( r 1) ( r 1) P{si(,rj) : (i, j ) IN ( r ) | sk : ( k , l ) IN } ,l

( k ,l )IN( r 1)

( r 1) P{si(,rj) : (i, j ) D(k , l ) | sk ,l }

块中像素的3个平均彩色成分(在LUV亮度/色度空间计算)

小波变换中3个高频带中的纹理特征,每个特征对 应各自频带中小波系数二阶矩的平方根

以HL频带为例,设其系数为{ck,l,ck,l+1,ck+1,l,ck+1,l+1}, 则其纹理特征为:

1 f 2

2 c k i,l j i 0 j 0

P{s : (i, j ) IN } P{si(,rj) : (i, j ) IN ( r ) | sk( r,l1) : ( k , l ) IN ( r 1) }

(1) i, j (1) r 2 R

2DMHMM(2/3)

在给定状态下,特征向量条件独立于任何其他状态及其 特征向量,因此一幅图像所有粒度级所有图像块的状态 -特征联合概率(模型估计时要考虑各种状态-特征组合) P{si(,rj) , ui(,rj) : r R, (i, j ) IN ( r ) }

北邮考研复试班-北京邮电大学信息与通信工程学院电子与通信工程考研复试经验分享

北邮考研复试班-北京邮电大学电子与通信工程学院电子与通信工程考研复试经验分享北京邮电大学是教育部直属、工业和信息化部共建、首批进行“211工程”建设的全国重点大学,是“985优势学科创新平台”项目重点建设高校,是一所以信息科技为特色、工学门类为主体、工管文理协调发展的多科性、研究型大学,是我国信息科技人才的重要培养基地。

2017年,“信息网络科学与技术学科群”和“计算机科学与网络安全学科群”两个学科群进入一流学科建设行列。

学校坚持以习近平新时代中国特色社会主义思想为指导,坚持立德树人根本任务,扎根中国大地办好中国特色社会主义大学。

学校始终肩负“传邮万里国脉所系”的家国情怀。

自1955年建校以来,经过60多年的建设与发展,学校全日制教育已经形成了信息背景浓郁、专业特色鲜明、学科优势突出的办学格局。

学校现设有电子与通信工程学院、电子工程学院、计算机学院、自动化学院、软件学院、数字媒体与设计艺术学院、现代邮政学院、网络空间安全学院、光电信息学院、理学院、经济管理学院、人文学院、马克思主义学院、国际学院、网络教育学院、继续教育学院、民族教育学院、体育部等18个教学单位,以及网络技术、信息光子学与光通信、感知技术与产业3个研究院,可信网络通信2011协同创新中心,并设有研究生院。

目前,学科专业已经涵盖理学、工学、文学、法学、经济学、管理学、教育学、哲学、艺术学等9个学科门类,涉及22个一级学科。

学校电子与通信工程、计算机科学与技术以及电子科学与技术三个一级学科在教育部第四轮学科评估中被评为A类学科,其中电子与通信工程取得了A+的优异成绩。

专业介绍电子与通信工程是电子技术与信息技术相结合的构建现代信息社会的工程领域,电子技术是利用物理电子与光电子学、微电子学与固体电子学的基础理论解决电子元器件、集成电路、仪器仪表及计算机设计和制造等工程技术问题;信息技术研究信息传输、信息交换、信息处理、信号检测等理论与技术。

北京邮电大学郭军导师组

内

容

实验室概况 研究方向 学生情况

发展历程

2000年自主设立 2003年得到教育部实验室建设项目支持 2004年得到”211工程”实验室建设资金支持 2009年 信息内容安全技术国家工程实验室组成部分

人员情况

目前,实验室成员共120+人 教授2人 副教授8人 讲师10人 博士生15人 硕士生80多人

研究方向

Web搜索、多媒体搜索 模式识别理论 网络管理

Web搜索

• 搜索引擎相关技术研究

– – – – 网络信息获取(爬虫技术) 内容抽取 索引构建 查询扩展、查询反馈机制

• 文本过滤系统相关技术

– 图片过滤系统 – 短信过滤系统

• 舆情分析系统 • 多媒体移动搜索技术

模式识别

文字识别(汉字/英文,手写/印刷) 计算机视觉(视频中目标检测与跟踪,人脸 识别) 语音识别(孤立词识别、连续语音识别) 语音合成(基于韵律模型的高自然度合成) 说话人识别(文本依赖、文本独立) 智能机器人(看,听,说,运动)

PRIS奖学金

杰出研究生: 奖金11600元(1-2名) 优秀研究生: 奖金9600元(10-12名) 条件:1. 学术研究、科研项目方面成绩突出; 2. 实验室公益方面表现突出; 3. 学位课不能有不及格。

文体活动

每学期固定时间的羽毛球活动 各兴趣小组活动 年终总 故障关联分析 用户行为挖掘 新型网管协议验证平台

在研项目

无线重大专项,移动互联网网络与信息安全技术研究 4项国家自然基金青年基金项目 国家自然科学基金,广播语音声学建模中的主动学习研究 教育部项目“高校舆情分析系统” 国家项目“短信舆情分析系统”

Web应用系统测试有效性的研究与应用

北京邮电大学Web应用系统测试有效性的研究与应用图6-1LoadRunner工作示意图经过设置后,如图6—2选择”startscenario”来开始本次压力测试调度。

图6-2压力测试调度过程执行结果分析如图6-3所示北京邮电大学Web应用系统测试有效性的研究与应用图6-3测试结果施压时间为5分41秒,Vusers数量为i00,一共完成的Actions交易数量为5825笔,平均响应时间为5.561秒,TPS为17.08。

6.3.3安全测试Web服务器安全的测试是非常重要的内容,维护和测试Web服务器安全是信息安全中最不讨好的差事之一,测试人员对系统CGI(通用网关接口)进行了安全测试。

CGI是一个协议而不是一种编程语言,许多Web应用利用COl协议实现Web服务器与其他程序之间的通信,On—LineGateWay系统也不例外。

CGI很容易被发现并且在root权限下运行,黑客开发易受攻击的CGI程序来摧毁网页,盗取信用卡信息并且为将来的入侵设置后门。

测试人员创建~个短小的CGI程序,测试CGI程序集合继承的安全许可是否太多,然后将它上传到Web服务器接受测试。

这个CGI程序包括多个命令,完成一项应该被服务器的安全设置阻止的操作。

24北京邮电大学Web应用系统测试有效性的研究与应用6.3.5可用性测试图6—5IE浏览器选项图6—6IE浏览器设置Web应用系统可用性测试是通过收集用户与Web应用系统交互的信息来测试、评估Web应用系统的用户友好性和适宜性。

可用性测试包括:导航测试、整体界面测试、图形测试、内容测试、帮助系统测试、功能测试、整体效果测试及其他测试,因为已进行了功能性测试,所以进行可用性测试时,我们主要考虑的是整个软件的易用性。

在进行可用性测试时,项目组特邀请了客户一起参加。

下面分别论述:≯导航测试:导航描述了用户在一个页面内操作的方式,在不同的用户接口控制之间,例如按钮、对话框、列表和窗口等;或在不同的链接页面之间。

计算机网络管理

单击此处添加小标题

1

TMN采用了独立的数据通信网DCN传递管理信息,DCN与被管网络独立,避免了OSI系统管理中故障管理不能管理通信系统内部故障的缺点。

单击此处添加小标题

*

需要注意的是,虽然OSI管理是由ISO组织提出的,但真正的研究工作是由ISO组织与CCITT组织(ITV-T的前身)合作、共同进行的。两个标准组织合作产生了大量的研究成果,但其最初的研究出发点不同,ISO组织最初的目标是为数据通信网制定网络管理标准,ITU-T组织为电信管理网制定相关标准。

*

“OSI管理框架”主要有如下几个贡献: 提出了故障管理、配置管理、计费管理、性能管理和安全管理的五个管理功能域的概念,并明确了各管理功能域的管理功能; 提出了三种交换管理信息的方式,分别是系统管理(systems management)、应用管理(application management)和层管理(layer management); 提出了被管对象(managed object)、管理信息(management information)和管理信息库(MIB:Management Information Base)。

05

八、九讲 新型的网络管理模型和技术 (第6、12章)

06

十一讲 OSI网络管理的功能 (第7章)

07

第十二讲 安全管理与信息安全相关技术 (第11章)

*

第一讲 绪论

计算机网络

电话网

有线电视网

(通信/信息)网络 计算机网络与网络的概念上的联系与区别

*

1.1 网络管理是什么?

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

ln Rl ln P(c1 ) ln P(c2 ) lnP(t j | c1 ) lnP(t j | c2 )

j 1 j 1

d

对数似然比:

朴素Bayes分类器

向量距离分类器

向量距离分类器可以看作是Bayes分类器的简化,它用 各类别数据的均值向量、方差向量、协方差矩阵等参 数近似描述它们的分布特性,利用向量之间的各种距 离进行分类,常用的距离尺度有:

和对应的特征向量 a i ,并构成矩阵

y At ( x x )

称为x的PCA变换(也称K-L变换)

PCA的性质

PCA变换后的变量y是零均值的随机变量,其协方差矩阵为:

y At x A

由于A是列为 x 的特征向量的正交矩阵,所以 y 是对角阵且对角线元素为 x 的特征值,即:

精度指标

分类与标注对应关系的频次

标注 为L类 判别为L类 判别为非L类 a c

标注为 非L类 b d

i) 准确率(Precision)表示 所有被分类器分到类L的数 据中正确的所占的比例

ii) 召回率(Recall)表示 所有实际属于L的数据被 分类器分到L中的比例

P

R

a ab

a ac

iii) 平衡点BEP(Break-even Point): P和R值是互相影响的: P会随着R的升 高而降低,反之亦然。因此,为了更全面地反映分类器的性能,一种做法 是选取P和R相等时的值来表征系统性能,这个值叫BEP iv) F值 一种把准确率和召回率综合考虑的评价方法,定义如下:

g ( x) w x b

x R d y 1, 1

D维空间中线性判别函数的一般形式为 分类超平面方程为

w x b 0

系统性能评价

评价指标主要包括分类器的精度和速度 速度取决于分类器算法的复杂程度,在实际应用中 与计算机的硬件性能关系很大 精度通过与人工标注结果(ground truth)进行比较来 计算 对于二元分类问题,常用的精度指标有 准确率 召回率 F-measure break-even点

最大特点是不需要训练类别模型,而是按某种合理的 比例从各类别中抽取样本,用所有抽出的样本构成分

类器的总体特征样本

对于一个给定的样本t,首先按照某种距离测度找出与 其最接近的k个样本,然后根据这k个样本所属类别进

行投票

SVM

SVM是一种以结构风险最小化为目标的二元分类器, 在寻找最优分类超平面时不但要求将两类数据隔离, 而且要求两类数据距超平面的平均距离最大 设线性可分数据集为 D {( xi , yi )}in1

第二步,在 Sb , Sw 上运用LDA

LDA/GSVD

通过广义奇异值分解GSVD,用Hb和Hw代替Sb和Sw

根据GSVD理论,正交矩阵Y∈Rc*c,Z∈Rn*n,以及 非奇异矩阵X∈Rd*d满足如下关系:

YT H T b X [ Σ b , 0] Z H X [ Σ w , 0]

T T w

LDA/QR

对Hb进行QR分解,得到一个正交矩阵Q和一个上三角 矩阵R,然后在Q张成的低维子空间内进行鉴别分析 算法分两步完成:

第一步,对Hb进行QR分解,Hb = QR

Q R d rb 的正交列张成了Hb的秩空间 R R rb c 是上三角矩阵

然后定义:

Sb QT SbQ, Sw QT SwQ

因此,如果 S w 是非奇异矩阵,最优的投影方向 Wopt 就是使得样本在变换空间的类间散度矩阵和样本类 内散度矩阵的行列式比值最大的那些正交特征向量

LDA的定义(3/3)

定义如下的准则函数:

J ( Wopt ) arg max

W

Sb Sw

arg max

W

WT Sb W WT S w W

容易证明,使J(.)最大化的变换矩阵W的列向量由下列 等式中的最大特征值对应的特征向量组成:

S w Si

i 1

其中 Si

样本类间散度矩阵定义为:

xCi

d t , m 为第 i 类样本的均值, x R ( x m )( x m ) i i i

Sb ni (mi m )(mi m )t

i 1

c

其中 m 为样本集的总体均值向量

LDA的定义(2/3)

降维变换

需要进行学习的降维变换是指变换核(基函数)随被 处理数据集变化以获得最佳变换效果的变换(自适应变 换)

主成分分析PCA(Principal Component Analysis)

独立成分分析ICA(Independent Component Analysis) 线性鉴别分析LDA(Linear Discriminative Analysis) 希尔伯特—黄变换Hilbert-Huang 自适应变换也存在生成式和区分式之分

主要方法:

正则化LDA PCA+LDA

PCA+NULL空间

LDA/QR LDA/GSVD

正则化LDA(RLDA)

一种简单的解决Sw矩阵奇异的方法是利用正则化思想 在Sw上加一个扰动量,数学表达为

S w S w I

其中 0,I为一个单位矩阵 这种方法的主要问题在于扰动量的选取有难度。如 果扰动量太小可能不足以解决奇异问题,太大又会使 Sw内包含的判决信息丢失

b

I b

Db

Ob

w

I w

Dw

Ow

Db diag (rt rw 1,

,rb )

Dw diag (rt rw 1,

T T b b ww I

, rb )

i2 i2 1

在应用中常遇到类内分散度矩阵Sw奇异的问题

当数据维数很高时,能够获得的样本数常常相对 不足,使得独立的训练样本数N小于数据维数d, 而这将导致Sw为奇异矩阵 信息过滤所处理的文本、图像、音频等一般都是 在高维数据空间中表达的 解决LDA奇异性问题时,常先用某种生成式算法 对数据进行降维

LDA奇异性的解决

X的列向量就是矩阵对[Hb,Hw]对应的广义奇异向量, 因此有 并将其作为基于GSVD的鉴别特征子空间

RDM

RDM的特点主要有两方面 1)将LDA问题转化为同时对角化类内和类间散度 矩阵问题 2)通过能量适应准则来近似估计

对类内散度矩阵Sw进行对角化,得:

Sw ΦΛΦT , Λ diag{1, 2 ,

Sb wi iSwwi

(i 1, 2,…,c-1)

这是一个广义特征值问题,如果Sw是非奇异的,W的 1 列向量就是由矩阵 S w Sb 的特征向量组成 其中

1 S w Sb W W diag{1 , 2 ,

, c1}

LDA的奇异性

LDA是信息过滤中数据降维的核心算法之一

由于

y

1 y d 的非对角元素都是零,所以随机变量y的各维之间是不相关的

LDA

LDA的思想是找一个投影方向,使得投影后在低维空 间里样本的类间散度较大,类内散度较小

x1

x’

x2

LDA的定义(1/3)

设Ci为第i类样本的集合,共有c类样本,则样本类内散度矩 c 阵定义为:

IF的研究重点

分类器的选择

针对特定的应用环境选择分类器模型 目前研究较多的是朴素Bayes模型、向量相似度(模

板匹配)模型、SVM、k-NN等

分类器的学习及优化

生成式算法、区分式算法 计算效率,类别模型的增量学习和自动演进,半监 督学习、特征降维技术

基本方法

信息过滤系统中常用的分类器 Bayes分类器 向量距离分类器 k近邻分类器 SVM 系统性能评价

PCA

d 设随机变量 x R ,存在一个样本集 X { xi }iN1

,则其均值可估计如下:

1 N x xi N i 1

协方差矩阵可估计如下:

1 N x (xi x )(xi x )t N i 1

求解

x 按降序排列的d个特征值 i A {a1,..., ad } ,则式

, n}

在对角矩阵上加上一个小的扰动量进行正则化,即

Λ Λ I ( 0)

σ的选择

RDM将Sw的能量谱用作选择σ的标准

* m , 其中J (m) min m m

m

i i 1 E ( ) n i i 1

Web 搜索 郭 军

北京邮电大学

第5章 信息过滤

基本方法

模型学习

垃圾邮件及垃圾短信过滤

话题检测与追踪系统

引 言

IR IF

•被检索的文档相对稳定 •用户查询需求不同 •信息资源动态变化 •用户需求相对固定

信息过滤的本质是“流环境”下的二元分类 流环境:过滤系统处于信息持续新生的环境之中,新的 数据源源不断地流经过滤系统 二元分类:一类是需要筛选出来的,一类是系统不关心 的 以模式分类为技术核心,高效高精度地处理数据流

( 2 1) P R F 2 P R

F1

2 P R PR

模型学习

生成式学习 典型应用:利用EM算法对GMM的参数进行估计 共同特征:每个类模型只用本类的样本进行估计, 估计的准则是使模型产生训练样本的可能性最大( 最大似然) 早期的模型学习主要采用生成式算法 区分式学习 典型应用: SVM的学习 共同特征: 由需要相互区分的各类样本共同构成一 个模型,通过多类样本的“角力”形成不偏不依的 分类面