深度学习基础分享

深度学习的教师教学反思心得分享

深度学习的教师教学反思心得分享1.引言:深度学习作为一种先进的技术手段,正逐渐在教育领域得到广泛应用。

作为一名教师,我在教学中深入思考,并且通过反思和总结,不断提高自己的教学水平。

本文将分享我在深度学习教学中的心得体会。

2.教学目标的设定:在进行深度学习教学前,我首先明确教学目标,明确学生需要掌握的知识和技能。

通过设定明确的教学目标,我能更好地组织教学内容,创设合适的教学环境。

3.多样化的教学方法:针对不同学生的学习特点和能力差异,我采用多样化的教学方法。

例如,为了培养学生的自主学习能力,我引入项目驱动式教学,让学生通过实际项目的开展来学习深度学习知识和技能。

4.实践与理论相结合:深度学习是一门实践性很强的学科,我将理论与实践相结合,通过实际案例和实验操作来加深学生对深度学习技术的理解。

同时,也借助虚拟实验平台,提供实践机会,让学生在模拟环境中动手实践,巩固所学知识。

5.鼓励学生合作学习:在深度学习教学中,我注重培养学生的合作学习意识和能力。

通过小组讨论、项目合作等形式,鼓励学生互相交流、合作解决问题。

这样能够激发学生的思维激情,提高他们的学习效果。

6.个性化学习的引入:在课堂中,我充分考虑学生的个体差异,尊重每个学生的特点,采用个性化的学习方式和评价方法。

通过开展小组角色扮演、个体学习计划等活动,给予学生更多的自主学习空间。

7.激发学生的兴趣:兴趣是学习的最好助推器,我通过多媒体教学、案例分析等方式,激发学生对深度学习的兴趣。

在课堂中,我注重培养学生对科学问题的思考意识,让他们主动参与课堂讨论和实践。

8.及时反馈与调整:在教学过程中,我注重及时反馈,通过作业批改、小测验等形式及时了解学生的学习进展和困难。

在此基础上,我做出相应调整,采用个别辅导、错题讲解等方式,帮助学生解决学习困难。

9.建立良好的师生关系:良好的师生关系是学习的基石,我注重与学生建立亲密的联系,尊重学生、倾听学生的意见。

我经常与学生交流,关注他们的学习和生活情况,及时解答他们的问题。

为深度学习而教 读书分享 课件(共21张PPT) 初中班会

主讲:某某某

时间:202X-XX

目录

CONTENTS

01

02

书籍简介

Lorem Ipsum is simply dummy text of the printing

什么是深度 学习

Lorem Ipsum is simply

03

04

05

适宜的学习 环境

Lorem Ipsum is simply

深度学习基本 特征

注意(Attention),即教师在教学过程中要通过一定的策略和方法,引起学生的注意;

5、让学生明确评价的目的是为了促进学习,懂得要为自 己的学习负责,学会自我评价和反思;评价要体现知识之 间的关联性,并且要体现公平和一致性。

PART FOUR

深度学习基 本特征

TEACHING FOR DEEPER LEARNING

深度学习基本特征

深度学习可归纳为:一个中心、两个基本点、五项基本学习原则、问题导向下的 四类学习活动。

如何实施才能促成教与学的深度融合? 进而推进深度学习的教学实践转化。 本文将从以下四个方面展开解析。

PART.02

PART THREE

适宜的学习 环境

TEACHING FOR DEEPER LEARNING

适宜的学习环 境

适宜的学习环境

深度学习是一个主动的、活 跃的过程。为更好的促进自 然学习的发生,教师需创建 一个“强大且适宜的学习环 境”,以便能够培养学生更 为复杂和高阶的认知技能。

一个中心:以学生为中心。即:教师要从“教学设计师”的角色转变为“学习设 计师”,强调学生在学习过程中的对话、互动与参与,让学生真正成为学习的主 人。

两个基本点:全面发展学生的核心素养,充分利用智能技术的教学优势。

dip学习心得

dip学习心得dip(Deep Integrated Perception)是一种基于深度学习的综合感知技术,它通过对多源数据的融合与融通,实现对环境的全面、深度理解。

在我的学习过程中,我深刻领悟到dip的重要性和应用前景,下面我将分享我的学习心得。

一、初识dip在接触dip之前,我对人工智能和计算机视觉等领域有一定了解,而dip作为其中的一个分支领域,正逐渐引起了广泛的关注。

刚开始,我的学习重点集中在了对dip的定义及其背后的理论基础的学习,我学习了深度学习、卷积神经网络(CNN)等相关知识。

二、深度学习与dip深度学习是dip的核心技术,它以人工神经网络为基础,通过建立多层次、深层次的神经网络架构,从而实现对数据的学习和理解。

在学习过程中,我深入了解了深度学习的原理和算法,包括反向传播算法、梯度下降等。

三、dip的应用领域dip在很多领域都有广泛的应用,包括智能驾驶、安防监控、医学图像分析等。

我对这些领域的应用案例进行了深入学习和研究,了解了dip技术在这些领域的具体应用和取得的成果。

这让我对dip的前景有了更加清晰的认知。

四、dip的挑战与解决方案尽管dip在各个领域取得了很大的进展,但仍面临着一些挑战。

例如,在处理大规模数据时,算法的效率和数据的可靠性是需要考虑的问题。

为了解决这些挑战,我了解并学习了一些新的优化算法,例如并行计算和模型压缩等。

这些技术可以提高计算效率,同时减少因数据不完整或者噪声干扰导致的错误判断。

五、个人感悟与展望通过学习dip,我感受到了人工智能技术在未来的巨大潜力。

我相信dip将在更多的领域实现突破和应用,为我们的生活和工作带来更多便利和创新。

作为一名学习者和从业者,我将继续深入学习和研究dip 技术,不断提升自己的技能和能力,为社会发展做出自己的贡献。

结语通过本次dip学习,我对这一领域有了更加深入的认识和了解。

dip 作为一项新兴的技术,具有广泛的应用前景和发展空间。

深度学习算法的特征选择方法分享

深度学习算法的特征选择方法分享随着大数据时代的来临,数据的维度和规模不断增加,对特征选择的需求也日益迫切。

特征选择是从原始特征集中选择最有用的特征子集,以降低数据维度,提高模型性能和泛化能力。

在传统机器学习中,特征选择方法已经得到了广泛应用,但如何在深度学习中进行特征选择依然是一个热门的研究方向。

本文将分享一些常见的深度学习算法特征选择的方法,包括过滤方法、包装方法和嵌入方法。

这些方法在不同的场景下有着各自的优势,可以根据具体问题的特点选择合适的方法。

一、过滤方法过滤方法是一种基于特征的统计性质进行选择的方法。

常用的统计量包括互信息、相关系数和卡方检验等。

通过计算特征与输出之间的相关性,过滤方法可以迅速减少特征集的规模,过滤掉无关或冗余的特征。

以互信息为例,互信息衡量了特征和输出的相互依赖程度。

特征的互信息越大,说明它与输出的相关性越高,被选择的可能性也就越大。

可以通过计算特征与输出的互信息来进行特征排序,然后选择排名靠前的特征。

二、包装方法包装方法是一种基于特定模型评估性能进行选择的方法。

它通过在特征子集上训练模型,并根据模型的性能指标来选择特征。

常用的评估指标包括准确度、召回率和F1值等。

以递归特征消除为例,递归特征消除是一种迭代式的方法,通过反复训练模型,去除对模型性能贡献较小的特征,直到达到指定的特征数量或性能水平。

该方法适用于深度学习算法中的特征选择,可以通过循环迭代来选择最优的特征子集。

三、嵌入方法嵌入方法是一种将特征选择和模型训练过程统一进行的方法。

它通过将特征选择嵌入到模型中,通过优化模型的目标函数来选择特征。

常用的嵌入方法包括L1正则化、Dropout和自编码器等。

以L1正则化为例,L1正则化在目标函数中引入了特征的稀疏性惩罚项,使得模型更倾向于选择重要的特征。

通过调整惩罚项的参数,可以控制特征的选择程度,进而选择合适的特征子集。

需要注意的是,深度学习算法的特征选择需要在训练过程中进行,而不是在预处理阶段。

深度学习实习报告

实习报告:深度学习实习经历在过去几个月里,我有幸参加了一段时间的深度学习实习。

这次实习让我深入了解了深度学习领域的知识和技术,并在实践中提升了自己的技能。

在这篇报告中,我将分享我在实习期间的学习经历和收获。

首先,我了解了深度学习的基本概念和原理。

深度学习是一种机器学习技术,通过构建多层的神经网络来学习数据的特征和模式。

在实习中,我学习了各种深度学习模型的架构,如卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等。

我也了解了反向传播算法和优化器的作用,以及如何调整超参数来提高模型的性能。

其次,我掌握了深度学习框架的使用。

在实习中,我主要使用了TensorFlow和PyTorch这两个流行的深度学习框架。

通过实践,我学会了如何搭建神经网络模型、定义损失函数和优化器、进行模型训练和评估。

我也了解了如何使用这些框架进行模型的部署和应用,例如将模型部署到服务器上进行实时预测。

此外,我在实习中进行了多个深度学习项目的实践。

我参与了一个图像分类项目,通过训练CNN模型对图像进行分类,实现了对不同物体的识别和区分。

我还参与了一个自然语言处理项目,使用RNN模型对文本数据进行序列建模,实现了文本生成和情感分析等功能。

这些项目让我深入了解了深度学习在实际应用中的优势和局限性。

在实习过程中,我也学习了如何进行深度学习模型的调优和优化。

我了解了如何使用交叉验证和网格搜索等技术来选择最佳的模型和超参数。

我还学习了如何使用数据增强和正则化等技术来提高模型的泛化能力和鲁棒性。

最后,我在实习中与团队成员进行了紧密的合作。

我们共同解决问题、分享经验和交流想法。

在团队项目中,我学会了如何分工合作、协调进度和沟通结果。

这也培养了我的团队合作能力和解决问题的能力。

总结起来,这次深度学习实习让我获得了宝贵的知识和经验。

我深入了解了深度学习的基本原理和框架,掌握了模型训练和优化的技巧,并在实际项目中应用了深度学习技术。

深度学习心得范文

深度学习心得范文一、引言深度学习是一种基于神经网络的机器学习方法,近年来在图像识别、语音识别、自然语言处理等领域取得了巨大的突破和应用。

在我学习深度学习的过程中,我深刻认识到了深度学习的强大能力和广阔前景,也对深度学习领域的研究和应用产生了极大的兴趣。

在这篇心得中,我将结合自己的学习和实践经验,分享我对深度学习的认识和思考。

二、理论学习在深度学习的理论学习方面,我首先了解了神经网络的基本原理和结构。

神经网络是深度学习的基础,它由多个神经元层组成,每个神经元接收上一层神经元的输出作为输入,并进行加权求和和激活函数等操作,最后输出结果。

深度学习通过不断深化神经网络的层数,提高网络的表示能力,从而实现更复杂的任务。

我还学习了深度学习中常用的优化算法,如梯度下降、RMSProp 和Adam等。

这些优化算法能够帮助神经网络高效地学习和优化模型的参数。

同时,我也了解了深度学习的常见模型和架构,如卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等。

这些模型在图像分类、序列问题和生成任务等方面表现出色,广泛应用于实际场景中。

在深入学习理论的过程中,我深刻认识到深度学习的核心思想是从数据中学习,并且需要大量的数据和计算资源支持。

深度学习是一种端到端的机器学习方法,不需要人工提取特征,通过神经网络自动学习数据的特征,并从中进行高级表示和决策。

这种数据驱动的特点使得深度学习在处理大规模数据和复杂任务时具有巨大优势。

三、实践探索除了理论学习,我也进行了一些深度学习的实践探索。

我首先在图像分类问题上进行了实践,使用了深度学习库Keras和TensorFlow 来搭建和训练卷积神经网络模型。

通过对已有的图像数据集进行训练和测试,我深刻感受到了深度学习模型的高准确率和泛化能力。

在图像分类实践中,我还尝试了迁移学习的方法。

通过将预训练的卷积神经网络模型作为特征提取器,我可以在较小的数据集上进行训练,并获得较好的效果。

[鱼书笔记]深度学习入门:基于Python的理论与实现个人笔记分享

![[鱼书笔记]深度学习入门:基于Python的理论与实现个人笔记分享](https://img.taocdn.com/s3/m/0157d41d77c66137ee06eff9aef8941ea76e4be7.png)

[鱼书笔记]深度学习⼊门:基于Python的理论与实现个⼈笔记分享为了完成毕设, 最近开始⼊门深度学习.在此和⼤家分享⼀下本⼈阅读鱼书时的笔记,若有遗漏,欢迎斧正!若转载请注明出处!⼀、感知机感知机(perceptron)接收多个输⼊信号,输出⼀个信号。

如图感知机,其接受两个输⼊信号。

其中θ为阈值,超过阈值神经元就会被激活。

感知机的局限性在于,它只能表⽰由⼀条直线分割的空间,即线性空间。

多层感知机可以实现复杂功能。

⼆、神经⽹络神经⽹络由三部分组成:输⼊层、隐藏层、输出层1. 激活函数激活函数将输⼊信号的总和转换为输出信号,相当于对计算结果进⾏简单筛选和处理。

如图所⽰的激活函数为阶跃函数。

1) sigmoid 函数sigmoid函数是常⽤的神经⽹络激活函数。

其公式为:h(x)=11+e−x如图所⽰,其输出值在 0到 1 之间。

2) ReLU 函数ReLU(Rectified Linear Unit)函数是最近常⽤的激活函数。

3) tanh 函数2. 三层神经⽹络的实现该神经⽹络包括:输⼊层、2 个隐藏层和输出层。

def forward(network, x): # x为输⼊数据# 第1个隐藏层的处理,点乘加上偏置后传⾄激活函数a1 = np.dot(x, W1) + b1z1 = sigmoid(a1)# 第2个隐藏层的处理a2 = np.dot(z1, W2) + b2z2 = sigmoid(a2)#输出层处理 identidy_function原模原样输出a3a3 = np.dot(z2, W3) + b3y = identify_function(a3)return y # y为最终结果3. 输出层激活函数⼀般来说,回归问题选择恒等函数,分类问题选择softmax函数。

softmax函数的公式:y k=e a k ∑n i=1e a i假设输出层有n个神经元,计算第k个神经元的输出y k。

学习的方法分享

学习的方法分享学习是一个持续不断的过程,对于每个人来说都至关重要。

但是,每个人的学习方法可能不同,因此,了解一些有效的学习方法是十分有帮助的。

本文将分享一些提高学习效率的方法,希望能够给读者带来帮助。

1. 制定合理的学习计划学习计划是学习的基础。

在制定学习计划时,要注意合理安排时间,确保每个学科或任务都有足够的时间进行学习。

合理的学习计划可以提高学习效率,减少拖延症的发生。

同时,在学习计划中也要留出一些休息时间,保持好的精神状态。

2. 深度学习和练习深度学习是指通过彻底理解和分析所学知识,而不仅仅是死记硬背。

要进行深度学习,可以尝试将所学知识与自己的实际经验联系起来,进行思考和探索。

此外,要进行反复练习,通过实践来加深对知识的理解和记忆。

3. 制作学习笔记制作学习笔记是一种非常有效的学习方法。

通过将所学内容整理成笔记,可以帮助记忆和复习。

在制作学习笔记时,要注意简洁明了,重点突出。

可以使用不同的颜色、图表或关键词来帮助记忆。

4. 创造良好的学习环境学习环境对学习效果有着重要影响。

在学习时,要选择一个安静、整洁、舒适的地方,远离任何干扰和噪音。

此外,还可以根据自己的喜好,在学习环境中放置一些适合学习的物品,如温暖的灯光、舒适的座椅等,创造一个良好的学习氛围。

5. 寻求帮助和互助学习在学习中,遇到困难时不要害怕寻求帮助。

可以向老师、同学或亲友请教,寻求他们的意见和建议。

此外,互助学习也是一种非常有效的学习方法。

和同学们一起学习,可以相互交流,分享学习心得和经验,互相鼓励和督促。

6. 多种学习资源的利用现在有许多学习资源可以利用,如图书馆、网络、学习软件等。

在学习时,可以通过多种途径获取知识,选择合适的学习资源,提高学习效率和质量。

同时,要善于利用好搜索引擎,通过搜索问题或关键词,找到合适的学习资料和解决方案。

7. 健康的生活方式健康的生活方式有助于提高学习效果。

要保持良好的作息时间,保持充足的睡眠;合理饮食,保证身体所需营养;适度参加运动,保持良好的体能等。

《深度学习》读书心得

《深度学习》读书心得《深度学习》读书心得1一、在教学中设计引发学生深度学习的问题情境。

书中提出教师一定要根据学习内容的特点,教学目标的要求、学生思维的发展状况,适时创设能够促进深度学习的问题情境。

教师在教学设计的过程中可以以单元内容的整体分析和学生学习特征的分析为主体,着力于学生的最近发展区,设计出具有挑战性的问题情境,问题情境的设计围绕着教学的核心内容和符合学生现有的知识经验。

让学生愿意学,乐意学,参与到具体的情境之中。

二、在教学中激活数学思维,形成数学技能书中指出,核心素养中“数学思维品质”是最重要的.。

掌握学科的核心知识,理解学习过程,把握学科核心思想与方法,形成健康向上的情感、态度与价值观,成为既具独立性、批判性、创造性,又有合作精神、基础扎实的优秀学习者。

我们教师在课堂教学中,要根据教学的准备、新知和练习阶段分别进行激活、开放和深度加工,在这样的学习过程中激发学生的学习兴趣和动机,激活学生的数学思维,形成数学技能,提高小学生的数学素养。

三、在教学中强调学生发展,培养深度学习能力新课程下的小学数学课堂教学,强调学生的发展,注重调动学生的内在潜力,培养深度学习的能力。

学生的发展是一个动向的过程,基于对学情的分析,根据不同层次的学生,设立不同的学习目标,设计不同的问题情境。

针对学生学习能力的不同,使之个体的数学思维得到不同的发展。

真正的做到因材施教,让不同的学生在数学学习中,找到自己的学习方向。

让学生真正做到尽力学,可以学,学的好。

作为教师,在课堂教学的实践中,应不断积累有效组合的经验,形成一定的课堂教学模式,并在反思中不断改进和完善。

在所有的课堂教学资源中,教师与学生是最为关键的,在课堂教学中正确处理“教师的引导”和“学生为主体”的关系,是使这两种资源发挥最大效益的中心环节,也是获得课堂教学高效率、更深层次的突破口。

构建“学的课堂”,看起来主要是学生自学,但教师的引导也很重要,教师要给学生及时的引导、指正。

深度学习心得体会

深度学习心得体会

深度研究心得体会

由于新冠病毒肺炎疫情的影响,我们参加了几节“空中教

研活动”课程。

在这些课程中,我观摩了5位优秀老师的分享,从中获得了许多教学经验。

其中,XXX和XXX老师分享了“深度研究”的知识,让我们从不同的角度了解了深度研究的含

义和必要性。

另外3位老师则展现了不同的设计思路,但都展现了出色的教学能力和技巧。

他们毫不保留地分享了自己在教学中的经验和体会,让我受益匪浅。

以下是我在实际教学中的一些体会:

一、理解和掌握教材

要上好一节课,首先要正确理解和掌握教材。

只有深入理解教材,才能更加灵活地运用教学方式,让学生在最短的时间内获得最大的收获,提高课堂教学效率。

听了这几位优秀教师

的分享,我深刻地认识到,教师必须清楚掌握教材的重难点,选准切入点和教学方法,让学生成为研究的主动者。

二、善于思考

数学知识往往是一种规律,而思考规律背后的道理,会让我们变得更加聪明。

一个有追求、善于思考的老师不仅能传授课本知识,还能教给学生思考的能力。

一个优秀的教师必须善于思考、乐于思考,并将这种思考的惯传授给学生。

三、让学生成为课堂主体

这是新课标的重要特点,也是素质教育的要求。

在课堂上,只有学生清楚地知道自己应该做什么,才能更好地完成任务。

如果问题太难,学生会感到无从下手;如果问题太容易,学生会觉得无意义。

优秀的教师应该让学生通过动口、动手、动脑去解决问题,为学生提供自由发挥、处理问题的空间,并不断鼓励学生积极尝试,主动去探索问题。

这样,每个学生都有参与思考和发表意见的机会,成为数学研究的主人。

分享教育观下深度学习的教学模式

分享教育观下深度学习的教学模式教育观是指对于教育的基本认识和价值取向,而深度学习则是一种注重发展学生思维能力和终身学习能力的学习模式。

在教育观下,深度学习的教学模式可以分为以下几个方面。

1.强调学生主体性和自主学习。

深度学习的教学模式注重培养学生的主动学习能力,使学生成为学习的主体。

教师不再是传统的知识传授者,而是成为学生学习的指导者和合作伙伴。

学生根据自己的兴趣和需求设定学习目标,进行自主选择和安排学习内容,积极参与课堂讨论和项目实践,培养解决问题的能力和自我管理能力。

2.提倡综合性和跨学科学习。

深度学习的教学模式鼓励学科之间的融合和综合性学习。

在教学过程中,学生不仅仅学习知识,还学习学习方法和思维方式。

跨学科的学习能够拓宽学生的视野,培养学生的综合分析和解决问题的能力,使学生能够将不同学科的知识应用于实际问题中。

3.强调合作学习和团队合作。

深度学习的教学模式鼓励学生之间的合作学习和团队合作。

学生通过合作解决问题和完成任务,互相协助、共同学习。

合作学习能够培养学生的合作精神和团队意识,提高学生的沟通能力和解决问题的能力。

4.注重问题导向和项目实践。

深度学习的教学模式注重将知识应用于实践中。

学生通过分析和解决实际问题来学习知识,培养学生的实际操作能力和创新思维。

教师可以设计项目,引导学生进行实践探究,让学生在实践中学习和成长。

5.引导思维和创新能力培养。

深度学习的教学模式注重培养学生的思维能力和创新能力。

教师通过提问和引导学生思考来促进学生深入思考和理解知识。

学生通过思考和探究来构建新的知识和解决问题的能力。

在这样的教育观下,深度学习的教学模式更加强调学生的主体性和自主学习能力,注重培养学生的综合能力和解决问题的能力,而不仅仅是传授知识。

教学模式更加灵活和多样化,旨在培养学生的学习能力和终身学习的态度。

教师的角色也从传授知识者转变为学习的指导者和合作伙伴,与学生共同成长。

同时,教育机构也需要为深度学习提供相应的支持和资源,提供适当的学习环境和教育系统的,以促进学生的全面发展和成长。

机器视觉技术的深度学习模型训练方法分享

机器视觉技术的深度学习模型训练方法分享近年来,随着人工智能的快速发展,机器视觉技术越来越受到广泛关注。

在机器视觉领域,深度学习模型训练方法成为了研究热点。

本文将分享一些常见的机器视觉技术的深度学习模型训练方法,帮助读者更好地理解和应用这一领域的技术。

首先,让我们了解一下深度学习模型在机器视觉领域的应用。

机器视觉是指让计算机通过图像或视频来模仿人类的视觉系统。

深度学习模型是一种能够模拟人脑神经网络结构并进行高效学习的算法。

通过深度学习模型,计算机可以在图像和视频中识别物体、进行目标检测、图像分割等任务。

在机器视觉领域,深度学习模型的训练方法有很多种。

下面将介绍几种常见的方法,包括数据集准备、网络架构设计、优化算法选择等方面。

首先是数据集准备。

数据集是深度学习模型训练的基础,它包含了大量的图像或视频样本,用于训练模型。

为了获得高质量的数据集,我们首先需要对原始数据进行清洗和标注。

清洗数据的过程包括去除无效数据、修复数据错误等操作,而标注数据的过程可以通过人工标注或半自动标注的方式进行。

此外,还可以采用数据增强的技术来扩充数据集,如图像旋转、缩放、翻转等操作,以提高模型的泛化能力。

其次是网络架构设计。

网络架构是深度学习模型的核心组成部分,它决定了模型的复杂度和计算效率。

在机器视觉领域,常用的网络架构包括卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent Neural Network,RNN)等。

CNN主要用于图像处理任务,其特点是通过卷积层和池化层来提取图像的特征,并通过全连接层来进行分类或回归。

RNN主要用于序列数据处理任务,如视频分析、自然语言处理等。

在网络架构设计中,需要根据具体任务的特点和数据集的性质选择合适的网络模型,并进行调整和优化。

第三是优化算法选择。

优化算法是在训练过程中对模型参数进行调整的方法。

深度学习模型训练过程中最常用的优化算法是梯度下降算法。

深度学习中的生成对抗网络训练技巧分享

深度学习中的生成对抗网络训练技巧分享生成对抗网络(GANs)是一种强大的深度学习模型,可用于学习输入数据的概率分布。

GANs由一个生成器网络和一个判别器网络组成,通过二者相互对抗的训练方式使得生成器能够生成逼真的样本。

然而,GANs的训练过程并不是一件容易的事情,经常会遇到一些挑战和问题。

在本文中,我将分享一些深度学习中的生成对抗网络训练技巧,帮助您更好地理解和应用GANs。

1. 选择合适的损失函数在GANs的训练中,生成器和判别器网络需要通过最小化或最大化某种损失函数来进行优化。

常见的损失函数包括交叉熵损失函数、最小二乘损失函数等。

选择合适的损失函数对于训练的稳定性和效果至关重要。

不同的损失函数适用于不同的任务和数据集,在选择时需要根据实际情况进行调整。

2. 使用合适的优化算法深度学习中广泛使用的优化算法包括梯度下降、Adam、RMSprop等。

对于GANs的训练过程,选择合适的优化算法也十分重要。

不同的优化算法具有不同的优势和适用性,例如Adam算法在某些情况下可能比梯度下降算法表现更好。

因此,根据实际情况选择适合自己的优化算法是至关重要的。

3. 进行适当的正则化由于GANs的训练过程可能会导致模型过拟合的问题,因此进行适当的正则化操作是十分重要的。

常见的正则化方法包括L1正则化、L2正则化、dropout等。

通过合理地引入正则化项,可以有效地减少模型的过拟合现象,提升模型的泛化能力。

4. 数据预处理在深度学习任务中,数据预处理是至关重要的一步。

对于GANs的训练过程,数据预处理也同样重要。

数据预处理的目的是提高数据的质量,减少噪音和冗余信息的影响。

常见的数据预处理方法包括归一化、标准化、降噪等。

通过对数据进行适当的预处理,可以提高模型的训练效果和性能。

5. 增加噪音在GANs的训练过程中,增加一定的噪音可以提高模型的鲁棒性和生成样本的多样性。

噪音的引入可以使得模型更好地学习到数据的分布特征,从而生成更加真实的样本。

分享教育观下深度学习的教学模式

分享教育观下深度学习的教学模式一、深度学习含义所谓深度学习(deeplearning)指通过探究学习的共同体促进有条件的知识和元认知发展的学习。

它鼓励学习者积极地探索、反思和创造,而不是反复的记忆。

深度学习主要强调了学习者对于知识进行批判性的学习,把它们纳入原有的认知结构中,将已有的知识迁移到新的情境中,从而帮助决策、解决问题。

深度学习的特点有:第一,深度学习意味着理解与批判;第二,深度学习意味着联系与构建;第三,深度学习意味着迁移与应用。

这些表明在教学设计中,首先,应该设计出学习可以积极参与地学习活动,只有积极的主动性才是深度学习的最基本的保障。

还有就是在授课教学的过程中,对于教学设计与教学策略的选择,如采用基于问题的教学设计,不仅要设计好大的问题,更要设计相关的小问题,这样才能不断地激发学生深入地思考,并且注意时时的生成新的问题。

二、高中物理教学现状以及存有的问题1、教学模式落后。

只注重传统知识的传授和灌输,“背多分”作为获取成绩的主要途径,将学生作为一纯粹知识的载体或解题机器,忽视对学生创新能力的培养,如只知道一味地利用牛顿定律解题,而对牛顿定律的局限性不加任何怀疑和诠释,盲目地崇拜,机械地吸收。

2、忽略对学生对科学知识理解力的'把握住。

只著重自然科学关键规律的把握住,而忽略从整体上和本质上重新认识自然科学和物理学的主要现象和规律的内在联系,例如只晓得光的波动性和粒子性,不晓得其实事求是的统一,只晓得客观存在的电、磁的规律,不晓得其本质上的一致性等等。

3、过于重视课本。

只注重课本上纯学科知识的纵向挖掘和强化训练,而忽视学科的横向拓展、边缘渗透,尤其与其他学科、现代科技、人文科学及现实生活的交叉联系。

4、命题抽象化。

命题只著重过度的抽象化,牵强附会,生编硬造,而与实际情况两张皮,甚至发生故弄玄虚地搞出文字游戏式的“八股”题,忽略对学生各种思维的训练,无一使学生通过训练内化为他们自己的能力,这就是目前普遍存在的现象,任何一本资料都存有,不甚枚举,无须可知。

深度学习技术中的输入数据预处理技巧分享

深度学习技术中的输入数据预处理技巧分享深度学习技术在各个领域的应用日益广泛,它能够通过神经网络的训练和学习,实现对复杂数据模式的识别和分析。

然而,深度学习的性能很大程度上依赖于输入数据的质量和准确性。

为了确保深度学习模型的稳定性和高效性,数据预处理步骤尤为重要。

本文将分享一些在深度学习技术中常用的输入数据预处理技巧,以帮助读者提升模型的性能。

1. 数据清洗与去噪在深度学习中,输入数据通常不是完美的,可能包含一些噪声和错误。

因此,在进行模型训练之前,应首先进行数据清洗和去噪的处理。

一些常见的数据清洗技术包括删除重复数据、处理缺失值和异常值等。

对于图像数据,在处理之前可以先进行降噪处理,如使用图像滤波器进行平滑或者去除图像中的噪点。

2. 数据标准化与归一化深度学习模型对输入数据的尺度和分布很敏感,因此需要对数据进行标准化或归一化操作。

标准化可以将数据转化为均值为0、标准差为1的标准正态分布,而归一化则可以将数据缩放到0和1之间。

常用的数据标准化方法包括Z-score标准化和MinMaxScaler归一化等。

选择适当的标准化方法取决于数据的特征和分布。

3. 特征提取与降维在深度学习中,高维度的输入数据可能会导致训练时间过长和模型复杂度过高的问题。

因此,对于高维数据,可以使用特征提取和降维的方法来减少数据维度并提取最有用的特征。

常用的降维方法包括主成分分析(PCA)和线性判别分析(LDA)等。

这些方法可以帮助保留大部分信息的同时减少数据的维度,提高模型的效率和准确性。

4. 数据增强与扩充数据增强是一种通过对原始数据进行变换和处理,生成新的训练样本来扩充数据集的技术。

数据增强可以帮助模型更好地泛化和适应不同的场景。

对于图像数据,常用的数据增强方法包括旋转、平移、缩放、翻转和亮度调整等。

这些操作可以增加数据的多样性,提高模型的鲁棒性和泛化能力。

5. 数据划分与交叉验证在深度学习模型的训练中,数据划分和交叉验证是非常重要的步骤。

dip学习心得

dip学习心得深度学习(Deep Learning)是当今计算机科学领域的热门话题,而数字图像处理(Digital Image Processing,简称DIP)则是深度学习的重要基础。

通过学习DIP,我不仅加深了对图像处理技术的理解,还掌握了一些相关的实践技巧。

在本篇文章中,我将分享我的DIP学习心得,并总结其中所取得的收获。

首先,我意识到DIP的重要性和广泛应用。

从数字相机到医学影像,从人脸识别到自动驾驶,DIP无处不在。

通过学习DIP,我了解到图像处理在科学研究、工程应用以及日常生活中的重要性。

比如,通过图像增强可以改善图片质量;通过图像分割和目标检测可以帮助机器识别图像中的目标物体。

这些技术对于提高生活质量和工作效率都具有积极的影响。

其次,我深入学习了DIP的基本原理和常用算法。

DIP的核心是对图像进行数字化表示和处理。

通过学习数字图像的特点,如像素表示、颜色空间和数字滤波等,我了解到了各种图像处理技术的应用场景和原理。

从图像去噪到边缘检测,从图像修复到图像压缩,我掌握了一些常用的DIP算法,如均值滤波、Sobel算子和Canny算子等。

通过实践编程,我更加熟悉了这些算法的实现和使用。

除了基本原理和算法,我还学习了一些深入的DIP技术。

例如,我探索了基于神经网络的图像分类和图像生成方法。

通过使用深度学习框架,我学会了使用卷积神经网络(Convolutional Neural Network,简称CNN)进行图像分类和目标检测。

此外,我还研究了生成对抗网络(Generative Adversarial Network,简称GAN)的原理和应用。

这些技术的学习使我对DIP的未来发展有了更深入的认识。

通过DIP的学习,我也培养了一些重要的技能和能力。

首先是问题解决能力。

在学习过程中,我遇到了各种各样的问题,如图像处理算法的实现、代码的调试等。

通过不断钻研和思考,我学会了分析问题、寻找解决方案,并最终解决了许多难题。

深度学习理论

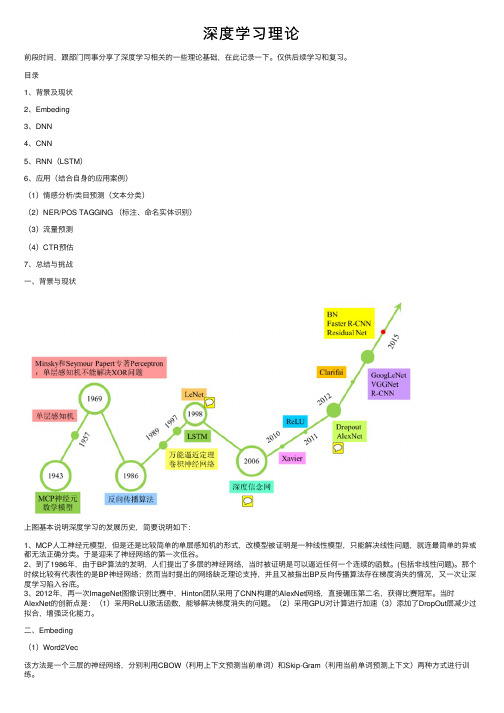

深度学习理论前段时间,跟部门同事分享了深度学习相关的⼀些理论基础,在此记录⼀下。

仅供后续学习和复习。

⽬录1、背景及现状2、Embeding3、DNN4、CNN5、RNN(LSTM)6、应⽤(结合⾃⾝的应⽤案例)(1)情感分析/类⽬预测(⽂本分类)(2)NER/POS TAGGING (标注、命名实体识别)(3)流量预测(4)CTR预估7、总结与挑战⼀、背景与现状上图基本说明深度学习的发展历史,简要说明如下:1、MCP⼈⼯神经元模型,但是还是⽐较简单的单层感知机的形式,改模型被证明是⼀种线性模型,只能解决线性问题,就连最简单的异或都⽆法正确分类。

于是迎来了神经⽹络的第⼀次低⾕。

2、到了1986年,由于BP算法的发明,⼈们提出了多层的神经⽹络,当时被证明是可以逼近任何⼀个连续的函数。

(包括⾮线性问题)。

那个时候⽐较有代表性的是BP神经⽹络;然⽽当时提出的⽹络缺乏理论⽀持,并且⼜被指出BP反向传播算法存在梯度消失的情况,⼜⼀次让深度学习陷⼊⾕底。

3、2012年,再⼀次ImageNet图像识别⽐赛中,Hinton团队采⽤了CNN构建的AlexNet⽹络,直接碾压第⼆名,获得⽐赛冠军。

当时AlexNet的创新点是:(1)采⽤ReLU激活函数,能够解决梯度消失的问题。

(2)采⽤GPU对计算进⾏加速(3)添加了DropOut层减少过拟合,增强泛化能⼒。

⼆、Embeding(1)Word2Vec该⽅法是⼀个三层的神经⽹络,分别利⽤CBOW(利⽤上下⽂预测当前单词)和Skip-Gram(利⽤当前单词预测上下⽂)两种⽅式进⾏训练。

CBOW:Skip-Gram:这⾥需要注意的是, 1)三层的神经⽹络结构。

其中输出层为了减少算法的复杂度,采⽤Huffman编码树的形式进⾏编码输出。

即输出⼀颗树型结构。

2)训练过程中,实际是需要两次遍历预料,第⼀次遍历构建输出的Huffman树和字典,第⼆次遍历进⾏训练。

(2)Paragraph2Vec、Doc2vec 该⽅法类似word2vec,只是在训练的过程中,增加了paragraph vector(段落向量)(3)Glove 该⽅法⽤的是词的共现矩阵通过矩阵分解得到全局的信息,并且得到每个词对应的全局词向量, 再根据CBOW的思想(利⽤上下⽂预测当前单词的概率,这⾥的概率就是共现矩阵中共现概率⽐值)进⾏优化全局词向量,进⽽得到最优的词向量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

8

i 1, 2,, m

输入样本集共计m个样本点,每个样本点有(n+1)维特征 1、拟合函数 h( x) (0 ,1 ,,n )( x0 , x1, xn )T 0 x0 1x1 n xn 2、目标函数:最小化误差平方和 1 m min J ( ) i 1 (h ( x i ) y i ) 2 +目标函数也可以添加正则化项 2 3、采用梯度下降法更新每个参数的值

Z3(3)

Z4(3) Z3(2) hW,b(x)

X4 X5

Z5(3) +1

Z6(3)

Layer L3

X6

+1

Layer L1

Layer L2

自编码器的结构

PA R T F I V E

0

5

限制玻尔兹曼机

限制玻尔兹曼机

h1 c1 h2 c2 h3 c3 ... hn cn wn×m b1 v1 b2 v2 b3 v3

14 引入训练样本的标签值

做整个网络的参数微调

Input Data X

Output Data X

Low-dimensional Representation Y

Decoder

无监督逐层学习得到深度网络的初始参数 结合训练样本的标签值可以进行微调(fine-tuning)使得网络参数最优化

PA R T

PA R T F O U R

0

4

自编码器

自编码器

X1 X2 X3

10

Z1(3) Z2(3)

(W , b) (W (1) , b(1) ,W (2) , b(2) )训练参数

z (2) W (1) x b (1) a (2) f ( z (2) ) z (3) W (2) a (2) b(2)

深度学习基础分享

李睿琪

目 录

CONTENT

01 | 深度学习简介

02 | 逐层学习

03 | 梯度下降法

04 | 自编码器

05 | 限制玻尔兹曼机

06 | 深度学习框架

07 | 硬件需求

PA R T O N E

0

1

深度学习简介

深度学习简介

• 深度学习中需要解决的问题

• • (1) 待训练的参数较多,需要大量的标记数据,容易导致过拟合 (2) 非凸优化导致局部极值问题

n

p(h j 1| v) (b j i 1 wij vi ) p(vi 1| h) (ci j 1 wij h j )

m

(1) (2)

可见部分结点值为实数变量

( x) 1/ (1 e x )

Sigmoid激活函数

补充说明

Encoder

0

6

深度学习框架

S I X

深度学习框架

• Caffe: C++ (加州伯克利分校)

• Theano: Python (蒙特利尔理工学院) -----> Blocks, Keras

16

• Torch: Lua (Facebook)

• Deeplearning4j: Java (创业公司Skymind) • DeepLearnToolbox: MATLAB

感谢您的聆听

输入 编码器 编码 解码器 重构 重构 误差

+1

Layer L1

Layer L2

自编码ห้องสมุดไป่ตู้的结构

目标函数:最小化重构误差

自编码器

X1 X2 X3

11

Z1(3) Z2(3)

Z1(2)

Z2(2)

(W , b) (W (1) , b(1) ,W (2) , b(2) )

网络参数的训练方法: 梯度下降法 反向传播算法(Back Propagation, BP): 用于计算参数的梯度

4

•

(3) 梯度弥散问题,隐藏层层数虽然多,但学习不到有效的信息

• 解决以上问题的策略

• • (1) 无监督的逐层学习,应用未标记数据构造自编码器:FNN、RBM (2) 减少待训练参数:CNN(卷积神经网络)

• 入门课程:UFLDL,unsupervised feature learning & deep learning

hW,b(x)

层次间的递推关系

Z1(2)

Z2(2)

Z3(3)

Z4(3) Z3(2)

X4 X5

hW ,b ( x) a (3) f ( z (3) ) f ( x) 1/ (1 e x )

Sigmoid激活函数

Z5(3) +1

Z6(3)

Layer L3

X6

hW ,b ( x) x

RBM的结构

13 训练参数

c wn×m b

目标函数:最小化重构误差 网络参数的训练方法: 梯度下降法 对比散度算法 (Contrastive Divergence, CD): 用于计算参数的梯度 默认结点取值为0/1 也可以推广到实数:

...

bm vm

层次间的递推关系(本质上属于多元概率分布, 网络结构为概率无向图模型)

PA R T T W O

0

2

逐层学习

逐层学习

• 逐层学习(预训练)原理图:

Encoder

6

Input Data X

Output Data X

Low-dimensional Representation Y

Decoder

PART THREE

0

3

梯度下降法

梯度下降法

以线性拟合函数回顾梯度下降法:训练参数 (0 ,1 ,,n )

j j

m J ( )= j i 1 (h ( x i ) y i ) x ij , j 0,1,, n j

求累加和体现了GD与SGD的区别

m i i i J ( ) ( h ( x ) y ) x 线性拟合函数中的梯度值为: j i 1 j

PART SEVEN

0

7

硬件需求

硬件需求

18

GPU:GTX 680 或者GTX 960 (价格优势); GTX 980 (表现最佳);GTX Titan (满足需要存储器的情况); GTX 970 (不支持卷积网络)。

CPU:每个GPU 2个线程;全套40 PCIe 线路和合适的PCIe 配件(和主板配套);时钟频率 > 2GHz;快速 缓冲储存区不做过多要求。 内存:使用异步mini-batch分配;时钟频率和内存时序不做过多要求;要求至少像GPU内存一样大的 CPU内存。 硬驱硬驱动/SSD:使用异步batch-file读取和压缩数据,主要针对图像或声音数据;如果不需要处理 带有高输入维度的32比特浮点数据组,普通硬驱即可满足计算要求。 PSU:GPU+CPU+(100-300)为所需的电源供应量;如果需要构建大的卷积网络,则需要配备能效级 别高的电源;确保有足够PCIe接头(6+8pin),足以支持未来可能新增的GPU的运行。 散热:如果运行单个GPU,需要在设置中设定「coolbits」flag;否则,更新BIOS和加快风扇转速就是 最便宜最简单的办法。 主板:选择PCIe 3.0,配备与未来预计所需GPU数量一样多的槽口(一个GPU需要两个槽口;每个系 统最多4个GPU)。