Python数据抓取 数据处理前的准备_光环大数据python培训

Python大数据处理与分析实战指南

Python大数据处理与分析实战指南第一章:引言随着大数据时代来临,数据处理与分析成为了各行业中的热门话题。

Python作为一种简洁而强大的编程语言,被广泛应用于大数据领域。

本指南将带领读者从零开始,掌握Python在大数据处理与分析中的实战技巧。

第二章:Python基础知识回顾在开始实战之前,我们先回顾一些Python的基础知识。

本章将介绍Python的数据类型、函数、条件语句以及循环结构等基本概念,为读者打下坚实的基础。

第三章:Python与数据获取数据获取是大数据处理与分析的第一步。

本章将介绍Python在数据获取方面的常用库和技巧,如网络爬虫、API调用等。

同时,我们还会介绍一些常见的数据获取场景,并给出相应的解决方案。

第四章:数据预处理与清洗在进行数据分析之前,数据预处理与清洗是必不可少的环节。

本章将介绍Python在数据预处理与清洗方面的一些常见技术,如数据去重、缺失值处理、异常值检测等。

此外,我们还会介绍一些常用的数据预处理工具和库。

第五章:数据可视化数据可视化是数据分析中非常重要的一环。

本章将介绍Python 在数据可视化方面的一些常用工具和库,如Matplotlib、Seaborn 等。

我们将学习如何使用这些工具来展示数据、发现数据中的规律,并给出相应的案例分析。

第六章:统计分析与机器学习统计分析与机器学习是数据分析的核心内容之一。

本章将介绍Python在统计分析与机器学习方面的一些常用库和算法,如NumPy、scikit-learn等。

我们将学习如何使用这些工具来进行数据分析、建立模型,并给出相应的实例分析。

第七章:大数据处理工具与技术对于大规模的数据处理与分析,Python需要借助一些大数据处理工具与技术来提高效率。

本章将介绍Python在大数据处理方面的一些常用工具和技术,如Hadoop、Spark等。

我们将学习如何使用这些工具来处理大规模的数据,并给出相应的实战案例。

第八章:实战项目:航班数据分析本章将以航班数据分析为例,展示Python在大数据处理与分析中的实战技巧。

使用Python进行大数据分析和处理

使用Python进行大数据分析和处理一、引言随着大数据时代的到来,数据分析和处理技术愈发重要。

Python作为一种简单易学、功能强大的编程语言,被广泛应用于数据科学领域。

本文将介绍如何使用Python进行大数据分析和处理,并分为以下几个部分:数据获取、数据清洗、数据分析、数据可视化和模型建立。

二、数据获取在进行大数据分析和处理之前,我们需要从各种数据源中获取数据。

Python提供了丰富的库和工具,可以轻松地从数据库、API、Web页面以及本地文件中获取数据。

比如,我们可以使用pandas库中的read_sql()函数从数据库中读取数据,使用requests库从API获取数据,使用beautifulsoup库从Web页面获取数据,使用csv库从本地CSV文件中获取数据。

三、数据清洗获取到原始数据之后,通常需要进行数据清洗。

数据清洗是指对数据进行预处理,包括处理缺失值、处理异常值、处理重复值、数据格式转换等。

Python提供了丰富的库和函数来帮助我们进行数据清洗,如pandas库中的dropna()函数用于处理缺失值,使用numpy库中的where()函数用于处理异常值,使用pandas库中的duplicated()函数用于处理重复值。

四、数据分析数据分析是大数据处理的核心环节之一。

Python提供了强大的库和工具来进行数据分析,如pandas库和numpy库。

使用这些库,我们可以进行数据聚合、数据筛选、数据排序、数据计算等。

例如,我们可以使用pandas库中的groupby()函数进行数据聚合,使用pandas库中的query()函数进行数据筛选,使用pandas库中的sort_values()函数进行数据排序,使用numpy库中的mean()函数进行数据计算。

五、数据可视化数据可视化是将数据以图形化的方式展现出来,帮助我们更好地理解数据的分布和趋势。

Python提供了多种库和工具来进行数据可视化,如matplotlib库和seaborn库。

用Python获取银行网站上的存贷款利率表_光环大数据Python培训

用Python获取银行网站上的存贷款利率表_光环大数据Python培训最近在做一个利率市场化咨询的项目,主要是协助银行搭建定价体系,提供定价策略,在充分考虑产品差异、顾客需求差异、时间差异、地点差异等因素基础上制定不同的存贷款定价方法。

在制定定价策略之前,我们通常会分析客户所处的内外部的环境。

外部环境分析可以分成宏观环境分析、行业环境分析等部分。

在行业分析(Industrial Analysis) 部分,我们会确定客户的存贷款利率价格在业内处于什么样的水平。

这就需要去采集各家银行的存贷款利率数据。

然而Wind上没有相关的数据源可供下载。

这就需要不怕脏不怕累的小朋友们去百度搜索各家银行的网站,然后再用肉眼寻找躲在银行主页角落的“存贷款利率”的连接,点击进入后将存贷款利率录入到Excel中。

这绝对是是对Junior 耐心、眼力的一个考验…这种没有什么附加值、重复性很强的工作,对于新人成长并没有什么帮助。

但是怎么才能让这种无聊的工作自动化呢?Life Is Short, Use Python这时候我们就要引出简单、易学、功能强大的编程语言 Python了。

我就在这里不赘述Python的优点了,只放一个一目了然的编程语言比较图:需求分析在这项任务中,我们需要的自动化的过程并不多,只需要遍历各大银行主页,搜索到存贷款页面连接并打印或储存下来即可。

我们当然也可以直接将数据直接也爬取下来存在Excel中,但因为各家银行网站架构设计各异,有些存贷款利率表甚至只是一张图片,页面分析的过程会比较耗时。

所以,我们暂时不将数据爬取转存这项功能放入我们的需求清单中。

爬取过程首先,我们先找到一个银行网址导航网站。

我选取的是360导航页面(/yinhanggengduo.html):并查看源代码:可以看出,银行网址都被放入了 a 这个标签中。

我们可以使用第三方库BeautifulSoup 美丽汤对该标签进行下载。

当然,不只是银行网址被放入了这个标签中,还有其他很多不相关的网站也是被放入了这个标签下。

使用Python进行数据挖掘的入门教程

使用Python进行数据挖掘的入门教程数据挖掘是一种通过分析大量数据来发现有用信息的技术。

随着互联网的发展和数据量的爆炸式增长,数据挖掘在各个领域的应用越来越广泛。

Python作为一种简单易学的编程语言,拥有丰富的数据挖掘工具和库,因此成为了数据挖掘的首选语言之一。

本文将介绍如何使用Python进行数据挖掘,并给出一些实例来帮助读者更好地理解和应用。

1. 数据准备在进行数据挖掘之前,首先需要准备好相关的数据。

数据可以来自于各种渠道,比如数据库、文件、API等。

Python提供了许多库来处理不同类型的数据源,例如pandas库用于处理结构化数据,numpy库用于处理数值计算,scikit-learn库用于机器学习等。

根据具体的数据源和需求,选择合适的库进行数据准备工作。

2. 数据清洗数据清洗是数据挖掘的重要步骤,它包括处理缺失值、异常值、重复值等。

Python提供了丰富的工具和库来进行数据清洗,例如pandas库中的dropna()函数可以删除包含缺失值的行或列,fillna()函数可以用特定的值填充缺失值。

此外,还可以使用numpy库中的函数来处理异常值,例如使用percentile()函数来识别和处理离群值。

3. 特征选择在进行数据挖掘之前,需要选择合适的特征来建立模型。

特征选择是从原始数据中选择最相关的特征,以提高模型的准确性和效果。

Python提供了许多库和方法来进行特征选择,例如scikit-learn库中的SelectKBest类可以根据统计学方法选择最好的K个特征,SelectFromModel类可以根据模型选择最重要的特征。

4. 模型建立选择好特征后,可以开始建立模型。

Python提供了丰富的机器学习库和算法,例如scikit-learn库中的DecisionTreeClassifier类可以建立决策树模型,LogisticRegression类可以建立逻辑回归模型,RandomForestClassifier类可以建立随机森林模型等。

C02 利用Python实现大数据分析与数据挖掘技术培训(5天)

Python 已经成为数据分析和数据挖掘的首选语言,作为除了 Java、C/C++/C# 外最受欢迎的语言。

本课程基于 Python 工具来实现大数据的数据分析和数据挖掘项目。

基于业务问题,在数据挖掘标准过程指导下,采用 Python 分析工具,实现数据挖掘项目的每一步操作,从数据预处理、数据建模、数据可视化,到最终数据挖掘结束,匡助学员掌握 Python 用于数据挖掘,提升学员的数据化运营及数据挖掘的能力。

通过本课程的学习,达到如下目的:1、全面掌握 Python 语言以及其编程思想。

2、掌握常用扩展库的使用,特殊是数据挖掘相关库的使用。

3、学会使用 Python 完成数据挖掘项目整个过程。

4、掌握利用 Python 实现可视化呈现。

5、掌握数据挖掘常见算法在 Python 中的实现。

5 天时间(全部模块讲完需要 5 天时间,可以根据时间需求拆份内容模块)。

业务支持部、 IT 系统部、大数据系统开辟部、大数据分析中心、网络运维部等相关技术人员。

课程为实战课程,要求:1、每一个学员自备一台便携机(必须)。

2、便携机中事先安装好 Excel 2022 版本及以上。

3、便携机中事先安装好 Python 3.6 版本及以上。

注:讲师现场提供开源的安装程序、扩展库,以及现场分析的数据源。

语言基础 +挖掘模型 +案例演练+开辟实践+可视化呈现采用互动式教学,环绕业务问题,展开数据分析过程,全过程演练操作,让学员在分析、分享、讲授、总结、自我实践过程中获得能力提升。

目的:掌握基本的 Python 编程思想与编程语句,熟悉常用数据结构的操作1、Python 简介2、开辟环境搭建Python 的安装扩展库的安装3、掌握 Python 的简单数据类型字符串的使用及操作整数、浮点数4、掌握基本语句:if、while、for、print 等基本运算:函数定义、参数传递、返回值5、掌握复杂的数据类型:列表/元组列表操作:访问、添加、修改、删除、排序列表切片、复制等列表相关的函数、方法元组的应用6、复杂数据类型:字典创建、访问、修改、删除、遍历字典函数和方法7、复杂数据类型:集合8、掌握面向对象编程思想创建类、继承类模块9、函数定义、参数传递、返回值10、标准库与扩展库的导入11、异常处理:try-except 块演练:基本的 Python 编程语句目的:掌握数据集结构及基本处理方法,进一步巩固 Python 语言1、数据挖掘常用扩展库介绍Numpy 数组处理支持Scipy 矩阵计算模块Matplotlib 数据可视化工具库Pandas 数据分析和探索工具StatsModels 统计建模库Scikit-Learn 机器学习库Keras 深度学习(神经网络)库Gensim 文本挖掘库2、数据集读取与操作:读取、写入读写文本文件读写 CSV 文件读写 Excel 文件从数据库获取数据集3、数据集的核心数据结构(Pandas 数据结构)DataFrame 对象及处理方法Series 对象及处理方法演练:用 Python 实现数据的基本统计分析功能目的:掌握作图扩展库,实现数据可视化1、常用的 Python 作图库Matplotlib 库Pygal 库2、实现分类汇总演练:按性别统计用户人数演练:按产品+日期统计各产品销售金额3、各种图形的画法直方图饼图折线图散点图4、绘图的美化技巧演练:用 Python 库作图来实现产品销量分析,并可视化目的:掌握数据挖掘标准流程1、数据挖掘概述2、数据挖掘的标准流程(CRISP-DM)商业理解数据准备数据理解模型建立模型评估模型应用3、数据挖掘常用任务与算法案例:用大数据实现精准营销的项目过程目的:掌握数据预处理的基本环节,以及 Python 的实现1、数据预处理异常值处理: 3σ准则, IQR 准则缺失值插补:均值、拉格朗日插补数据筛选/抽样数据的离散化处理变量变换、变量派生2、数据的基本分析相关分析:原理、公式、应用方差分析:原理、公式、应用卡方分析:原理、公式、应用主成份分析:降维案例:用 Python 实现数据预处理及数据准备1、常见分类预测的模型与算法2、如何评估分类预测模型的质量查准率查全率ROC 曲线3、逻辑回归分析模型逻辑回归的原理逻辑回归建模的步骤逻辑回归结果解读案例:用 sklearn 库实现银行贷款违约预测4、决策树模型决策树分类的原理决策树的三个关键问题决策树算法与实现案例:电力窃漏用户自动识别5、人工神经网络模型(ANN)神经网络概述神经元工作原理常见神经网络算法(BP、LM、RBF、FNN 等) 案例:神经网络预测产品销量6、支持向量机(SVM)SVM 基本原理维灾难与核心函数案例:基于水质图象的水质评价7、贝叶斯分析条件概率常见贝叶斯网络1、常用数值预测的模型通用预测模型:回归模型季节性预测模型:相加、相乘模型新产品预测模型:珀尔曲线与龚铂兹曲线2、回归分析概念3、常见回归分析类别1、客户细分常用方法2、聚类分析(Clustering)聚类方法原理介绍及合用场景常用聚类分析算法聚类算法的评价案例:使用 SKLearn 实现 K 均值聚类案例:使用 TSNE 实现聚类可视化3、RFM 模型分析RFM 模型,更深入了解你的客户价值 RFM 模型与市场策略案例:航空公司客户价值分析1、关联规则概述2、常用关联规则算法3、时间序列分析案例:使用 apriori 库实现关联分析案例:中医证型关联规则挖掘1、电商用户行为分析及服务推荐2、基于基站定位数据的商圈分析。

Python 多版本共存管理工具 Pyenv _光环大数据python培训

Python 多版本共存管理工具 Pyenv _光环大数据python培训经常遇到这样的情况:系统自带的Python 是2.6,自己需要Python 2.7 中的某些特性;系统自带的Python 是2.x,自己需要Python 3.x;此时需要在系统中安装多个Python,但又不能影响系统自带的Python,即需要实现Python 的多版本共存。

pyenv 就是这样一个Python 版本管理器。

安装pyenv在终端执行如下命令以安装pyenv 及其插件:$ curl -L https:///yyuu/pyenv-installer/master/bin/pyenv-installer | bash安装完成后,根据提示将如下语句加入到1~/.bashrc中:export PYENV_ROOT="$HOME/.pyenv"export PATH="$PYENV_ROOT/bin:$PATH"eval "$(pyenv init -)"eval "$(pyenv virtualenv-init -)" # 这句可以不加然后重启终端即可。

安装Python查看可安装的版本$ pyenv install --list该命令会列出可以用pyenv 安装的Python 版本。

列表很长,仅列举其中几个:2.7.8 # Python 2 最新版本3.4.1 # Python 3 最新版本anaconda2-4.1.0 # 支持Python 2.6 和2.7anaconda3-4.1.0 # 支持Python 3.3 和3.4其中2.7.8 和3.4.1 这种只有版本号的是Python 官方版本,其他的形如1anaconda2-4.1.0这种既有名称又有版本后的属于“衍生版”或发行版。

安装Python 的依赖包在编译Python 过程中会依赖一些其他库文件,因而需要首先安装这些库文件,已知的一些需要预先安装的库如下。

python爬虫案例之csdn数据采集_光环大数据Python培训

python爬虫案例之csdn数据采集_光环大数据Python培训python爬虫案例之csdn数据采集。

通过python实现csdn页面的内容采集是相对来说比较容易的,因为csdn 不需要登陆,不需要cookie,也不需要设置headerpython2.7下#coding:utf-8#本实例用于获取指定用户csdn的文章名称、连接、阅读数目importurllib2importrefrombs4importBeautifulSoup#csdn不需要登陆,也不需要cookie,也不需要设置headerprint('=======================csdn数据挖掘==========================')urlstr="/luanpeng825485697?viewmode=contents"host="/luanpeng825485697"#根目录alllink=[urlstr]#所有需要遍历的网址data={}defgetdata(html,reg):#从字符串中安装正则表达式获取值pattern=pile(reg)items=re.findall(pattern,html)foriteminitems:urlpath=urllib2.urlparse.urljoin(urlstr,item[0])#将相对地址,转化为绝对地址ifnothasattr(object,urlpath):data[urlpath]=itemprinturlpath,'',#print最后有个逗号,表示输出不换行printitem[2],'',printitem[1]#根据一个网址获取相关连接并添加到集合中defgetlink(url,html):soup=BeautifulSoup(html,'html.parser')#使用html5lib解析,所以需要提前安装好html5lib包fortaginsoup.find_all('a'):#从文档中找到所有标签的内容link=tag.get('href')newurl=urllib2.urlparse.urljoin(url,link)#在指定网址中的连接的绝对连接ifhostnotinnewurl:#如果是站外连接,则放弃continueifnewurlinalllink:#不添加已经存在的网址continueifnot"/luanpeng825485697/article/list"innewur l:#自定义添加一些链接限制continuealllink.append(newurl)#将地址添加到链接集合中#根据一个网址,获取该网址中符合指定正则表达式的内容defcraw(url):try:request=urllib2.Request(url)#创建一个请求response=urllib2.urlopen(request)#获取响应html=response.read()#读取返回html源码#reg=r'"link_title">\r\n/luanpeng825485697/ar ticle/details/(.*)\n.*'#只匹配文章地址和名称reg=r'"link_title">\r\n/luanpeng825485697/art icle/details/(.*)\r\n.*[\s\S]*?阅读\(/luanpeng825485697/article/details/(.*)\)'#匹配地址、名称、阅读数目getdata(html,reg)getlink(url,html)excepturllib2.URLError,e:ifhasattr(e,"code"):printe.codeifhasattr(e,"reason"):printe.reasonforurlinalllink:craw(url)为什么大家选择光环大数据!大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请专业的大数据领域知名讲师,确保教学的整体质量与教学水准。

数据爬取和处理的步骤

数据爬取和处理的步骤一、数据爬取数据爬取是指从互联网上获取所需数据的过程。

下面是数据爬取的步骤:1. 确定爬取目标:确定需要爬取的网站或数据源,明确需要获取的数据类型和范围。

2. 分析网页结构:通过查看网页源代码,分析网页的结构和数据的存放位置,确定需要抓取的数据所在的标签或元素。

3. 编写爬虫程序:使用编程语言(如Python)编写爬虫程序,通过发送HTTP请求获取网页内容,并使用正则表达式或解析库(如BeautifulSoup)提取所需数据。

4. 处理反爬机制:一些网站采取了反爬机制,如设置验证码、限制访问频率等。

需要根据具体情况采取相应的措施,如使用代理IP、模拟登录等。

5. 数据存储:将爬取到的数据存储到数据库、本地文件或其他数据存储介质中,以便后续处理和分析。

二、数据处理数据处理是对爬取到的数据进行清洗、转换和整理的过程。

下面是数据处理的步骤:1. 数据清洗:对爬取到的原始数据进行清洗,去除重复数据、空值、异常值等,保证数据的准确性和一致性。

2. 数据转换:根据需求将数据进行转换,如将日期字段转换为特定格式、将文本字段进行分词等。

3. 数据整合:将多个数据源的数据进行整合,合并为一个数据集,便于后续分析和建模。

4. 数据分析:对数据进行统计分析、挖掘和可视化,发现数据中的规律、趋势和异常,提取有用的信息。

5. 数据建模:根据业务需求,使用机器学习、统计模型等方法对数据进行建模和预测,为决策提供支持。

6. 数据应用:将处理后的数据应用于实际业务场景,如推荐系统、风控模型等,实现数据的商业价值。

总结:数据爬取和处理是数据分析的重要环节,通过合理的爬取和处理步骤,可以获取到准确、完整的数据,为后续的数据分析和决策提供支持。

在实际操作中,需要根据具体情况选择合适的爬取和处理方法,并注意数据的质量和安全性。

同时,要遵守网站的规定和法律法规,避免对他人权益造成损害。

金融量化交易分析利器-Tushare_光环大数据Python培训

金融量化交易分析利器-Tushare_光环大数据Python培训Dependenciespython 2.x/3.xpandasInstallation方式1:pip install tushare方式2:python setup.py install方式3:访问https:///pypi/tushare/下载安装Upgradepip install tushare --upgradeQuick StartExample 1. 获取个股历史交易数据(包括均线数据):import tushare as tsts.get_hist_data('600848') #一次性获取全部数据结果显示:日期,开盘价,最高价,收盘价,最低价,成交量,价格变动,涨跌幅,5日均价,10日均价,20日均价,5日均量,10日均量,20日均量,换手率open high close low volume p_changema5 /date 2012-01-11 6.880 7.380 7.060 6.880 14129.96 2.627.060 2012-01-12 7.050 7.100 6.980 6.900 7895.19-1.13 7.020 2012-01-13 6.950 7.000 6.700 6.690 6611.87-4.01 6.913 2012-01-16 6.680 6.750 6.510 6.480 2941.63-2.84 6.813 2012-01-17 6.660 6.880 6.860 6.460 8642.575.386.822 2012-01-187.000 7.300 6.890 6.880 13075.400.44 6.788 2012-01-19 6.690 6.950 6.890 6.680 6117.320.00 6.770 2012-01-20 6.870 7.080 7.010 6.870 6813.091.74 6.832 ma10 ma20 v_ma5 v_ma10v_ma20 turnover date 2012-01-11 7.060 7.060 14129.96 14129.96 14129.96 0.482012-01-12 7.020 7.020 11012.58 11012.58 11012.58 0.272012-01-13 6.913 6.913 9545.67 9545.67 9545.67 0.232012-01-16 6.813 6.813 7894.66 7894.66 7894.66 0.102012-01-17 6.822 6.822 8044.24 8044.24 8044.24 0.302012-01-18 6.833 6.833 7833.33 8882.77 8882.77 0.452012-01-19 6.841 6.841 7477.76 8487.71 8487.71 0.212012-01-20 6.863 6.863 7518.00 8278.38 8278.38 0.23 设定历史数据的时间:ts.get_hist_data('600848',start='2015-01-05',end='2015-01-09')open high close low volume p_change ma5 ma10 /date2015-01-05 11.160 11.390 11.260 10.890 46383.57 1.26 11.15611.212 2015-01-06 11.130 11.660 11.610 11.030 59199.933.11 11.182 11.155 2015-01-07 11.580 11.990 11.920 11.48086681.38 2.67 11.366 11.251 2015-01-08 11.700 11.92011.670 11.640 56845.71 -2.10 11.516 11.349 2015-01-0911.680 11.710 11.230 11.190 44851.56 -3.77 11.538 11.363 ma20 v_ma5 v_ma10 v_ma20 turnover date 2015-01-05 11.198 58648.75 68429.87 97141.81 1.592015-01-06 11.382 54854.38 63401.05 98686.98 2.032015-01-07 11.543 55049.74 61628.07 103010.58 2.972015-01-08 11.647 57268.99 61376.00 105823.50 1.952015-01-09 11.682 58792.43 60665.93 107924.27 1.54复权历史数据获取历史复权数据,分为前复权和后复权数据,接口提供股票上市以来所有历史数据,默认为前复权。

python培训内容

Python 培训内容概述随着 Python 在数据科学、人工智能、Web 开发等领域的广泛应用,越来越多的人选择学习 Python。

本文将介绍 Python 培训的主要内容,帮助大家更好地了解和学习 Python。

下面是本店铺为大家精心编写的5篇《Python 培训内容概述》,供大家借鉴与参考,希望对大家有所帮助。

《Python 培训内容概述》篇1一、Python 基础语法Python 培训的基础课程主要包括 Python 基础语法、数据类型、变量、运算符、控制结构等。

学员需要掌握 Python 的基本语法,为后续的编程学习打下坚实的基础。

二、Python 高级语法在掌握 Python 基础语法后,学员需要进一步学习 Python 的高级语法,如函数、模块、面向对象编程等。

这些内容对于编写复杂的Python 程序和项目至关重要。

三、Python 数据科学工具Python 在数据科学领域的应用非常广泛,如 NumPy、Pandas、Matplotlib 等。

Python 培训会涉及这些数据科学工具的使用,帮助学员更好地进行数据分析、可视化和处理。

四、Python Web 开发Python 在 Web 开发领域也有着广泛的应用,如 Django、Flask等框架。

Python 培训会教授如何使用这些框架进行 Web 开发,包括前端和后端的开发。

五、Python 机器学习与人工智能机器学习和人工智能是 Python 应用的另一个重要领域。

Python 培训会涉及相关的机器学习算法、深度学习框架等,如 Scikit-learn、TensorFlow 等。

六、Python 项目实战除了理论知识外,Python 培训还应包括项目实战环节,让学员通过实际项目来巩固所学知识,提高编程能力和解决实际问题的能力。

七、Python 编程规范与实践Python 培训还应包括编程规范与实践的内容,如代码风格、PEP8 规范、代码调试与测试等。

数据分析入门:用Python和SQL处理和分析数据

数据分析入门:用Python和SQL处理和分析数据数据分析是当下非常热门的技能之一,随着大数据时代的到来,越来越多的企业和组织意识到数据对于业务决策的重要性。

在进行数据分析时,Python和SQL 是两种非常常用的工具。

本文将介绍使用Python和SQL处理和分析数据的基本步骤和技巧,帮助初学者入门。

一、准备数据1. 定义分析目标:在开始之前,需要明确自己的分析目标,确定想要通过数据分析得到什么样的结论或洞察。

2. 收集数据:根据分析目标,收集相关的数据,可以通过记录、调查、爬虫等方式来收集数据。

3. 数据清洗:收集到的数据往往存在一些错误、缺失值等问题,需要进行数据清洗。

可以使用Python中的pandas库进行数据清洗工作。

二、数据处理与分析1. 数据导入:使用Python的pandas库将清洗后的数据导入到程序中,创建一个数据框(DataFrame)。

2. 数据预处理:对于导入的数据,需要进行一些预处理工作,例如更改数据类型、删除重复项、填充缺失值等操作。

3. 数据探索:使用Python的pandas和numpy库进行数据探索,包括计算统计量、绘制直方图和散点图等,以了解数据的基本情况和特征。

4. 数据可视化:使用Python的matplotlib、seaborn等库对数据进行可视化,例如绘制折线图、柱状图、饼图等来展示数据的分布和趋势。

5. 数据分析:针对分析目标,使用Python的pandas和numpy库进行数据分析,例如计算平均值、中位数、相关性等,并进行统计推断或建立模型。

三、使用SQL进行数据处理与分析1. 数据库连接:使用Python中的pymysql或sqlite3等库进行数据库连接,将数据存储在数据库中。

2. SQL查询:使用SQL语句进行数据查询,例如SELECT、WHERE、JOIN等操作,筛选出所需数据进行分析。

3. 数据处理:使用SQL语句对数据进行处理,例如聚合函数、排序、分组等操作,得到需要的结果。

Python与网络分析使用Python分析网络数据和行为

Python与网络分析使用Python分析网络数据和行为Python与网络分析Python作为一种强大且易于学习的编程语言,被广泛应用于网络数据和行为的分析。

通过利用Python的各种库和工具,我们能够有效地处理和分析大规模网络数据,揭示隐藏在数据背后的有价值信息。

本文将介绍一些常见的Python网络分析工具和技术,并探讨其在不同领域的应用。

一、数据采集与清洗在进行网络数据分析之前,首先需要获取数据。

Python提供了丰富的网络爬虫库,如Requests、Scrapy等,可以帮助我们方便地从网页上获取需要的数据。

通过设置合适的请求头、参数和URL,我们可以发起HTTP请求并解析网页内容,提取出所需的数据。

然而,爬取到的数据通常存在杂乱、重复和不完整等问题。

因此,在进行数据分析之前,我们需要对数据进行清洗和预处理。

Python提供了诸多数据处理和清洗工具,如Pandas、Numpy等,可以帮助我们去除重复数据、填充缺失值、转换数据格式等,使得数据符合分析需求。

二、网络数据可视化网络数据通常包含大量的节点和边,可视化是一种有效的方式来展示数据的结构和关系。

Python提供了多种图形库,如Matplotlib、NetworkX等,可以帮助我们生成各种图形化表达,从而更好地理解和分析网络数据。

Matplotlib是一种强大的绘图库,支持绘制各种统计图表,如柱状图、散点图、折线图等。

通过将节点和边与图表元素进行映射,我们可以将网络数据转化为直观、易于理解的图形。

NetworkX是一个专门用于网络分析的Python库,提供了丰富的图论算法和功能。

我们可以使用NetworkX构建、分析和可视化复杂网络结构,比如社交网络、物流网络等。

通过绘制网络图、计算节点中心性和社群划分等操作,我们可以深入探查网络的特征和行为。

三、网络分析与建模网络分析是研究网络结构、拓扑和特性的过程,旨在揭示网络的规律和机制。

Python提供了一些强大的网络分析工具,如Graph-tool、Gephi等,可以帮助我们进行网络特性的分析和建模。

python抓数据的方法

python抓数据的方法

Python有多种方法可以用来抓取数据,具体取决于你要抓取的

数据类型和来源。

以下是一些常见的方法:

1. 使用Requests库,Requests是Python中一个简单而优雅

的HTTP库,可以用来发送HTTP请求并获取数据。

你可以使用Requests库发送GET或POST请求来抓取网页数据,然后使用BeautifulSoup或其他解析库来提取所需的信息。

2. 使用Selenium库,如果你需要抓取动态生成的网页内容,

可以使用Selenium库来模拟浏览器行为,如点击按钮、填写表单等

操作,然后获取页面数据。

3. 使用API,许多网站提供API接口,允许你以编程方式获取

其数据。

你可以使用Python的requests库来发送API请求,并处

理返回的JSON或XML数据。

4. 使用Scrapy框架,Scrapy是一个强大的Python爬虫框架,它提供了许多功能来简化网页抓取的过程,包括自动处理页面解析、数据提取和存储等。

5. 使用第三方数据提供商的SDK,一些数据提供商提供了Python SDK,允许你通过他们的接口直接获取数据,而无需编写自己的抓取逻辑。

总之,Python具有丰富的库和框架,可以满足各种数据抓取需求。

选择合适的方法取决于你要抓取的数据类型、网站结构以及个人偏好。

在实际操作中,你可能需要结合多种方法来完成数据抓取任务。

python模型训练步骤

python模型训练步骤在Python中进行模型训练,主要包括以下六个步骤。

一、数据准备1.数据收集:从网络或本地文件中收集所需的数据。

数据可以是图像、文本或音频等,需根据所选模型类型进行相应处理。

2.数据预处理:对收集的数据进行清洗、格式化和归一化等操作,以便于模型训练。

例如,对于图像数据,可以进行缩放、归一化和数据增强等操作。

3.数据划分:将预处理后的数据分为训练集、验证集和测试集。

训练集用于训练模型,验证集用于调整模型参数,测试集用于评估模型性能。

二、模型选择与构建1.模型类型选择:根据任务需求,选择适合的模型类型,如卷积神经网络(CNN)用于图像识别,循环神经网络(RNN)用于文本生成等。

2.模型架构设计:在选定模型类型的基础上,设计网络架构,包括层数、激活函数、损失函数等。

3.参数调优:使用网格搜索或贝叶斯优化等方法,寻找模型参数的最佳组合,以提高模型性能。

三、模型训练1.训练参数设置:配置训练过程中的参数,如学习率、批大小、训练轮数等。

2.损失函数与优化器选择:根据任务需求,选择合适的损失函数(如交叉熵损失、均方误差损失等)和优化器(如Adam、SGD等)。

3.训练过程监控:使用回调函数或日志记录训练过程中的重要信息,如损失值、验证集性能等。

四、模型评估1.评估指标选择:根据任务需求,选择合适的评估指标,如准确率、F1值、均方根误差等。

2.评估方法:使用交叉验证、留出法等评估方法,对模型在测试集上的性能进行评估。

3.结果分析:分析评估结果,找出模型的优势和不足,为模型优化提供依据。

五、模型优化与调整1.超参数调整:根据评估结果,调整模型的超参数,如网络结构、学习率等。

2.网络结构优化:对模型架构进行调整,如增加层数、使用更复杂的激活函数等。

3.数据增强策略:采用数据增强方法,如旋转、翻转等,提高模型泛化能力。

六、模型部署与应用1.模型部署:将训练好的模型部署到实际应用场景中,如服务器、移动设备等。

python处理数据的方法

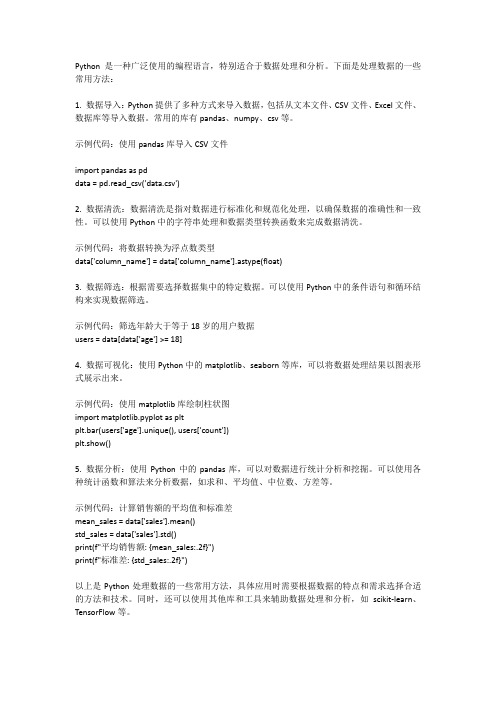

Python是一种广泛使用的编程语言,特别适合于数据处理和分析。

下面是处理数据的一些常用方法:1. 数据导入:Python提供了多种方式来导入数据,包括从文本文件、CSV文件、Excel文件、数据库等导入数据。

常用的库有pandas、numpy、csv等。

示例代码:使用pandas库导入CSV文件import pandas as pddata = pd.read_csv('data.csv')2. 数据清洗:数据清洗是指对数据进行标准化和规范化处理,以确保数据的准确性和一致性。

可以使用Python中的字符串处理和数据类型转换函数来完成数据清洗。

示例代码:将数据转换为浮点数类型data['column_name'] = data['column_name'].astype(float)3. 数据筛选:根据需要选择数据集中的特定数据。

可以使用Python中的条件语句和循环结构来实现数据筛选。

示例代码:筛选年龄大于等于18岁的用户数据users = data[data['age'] >= 18]4. 数据可视化:使用Python中的matplotlib、seaborn等库,可以将数据处理结果以图表形式展示出来。

示例代码:使用matplotlib库绘制柱状图import matplotlib.pyplot as pltplt.bar(users['age'].unique(), users['count'])plt.show()5. 数据分析:使用Python中的pandas库,可以对数据进行统计分析和挖掘。

可以使用各种统计函数和算法来分析数据,如求和、平均值、中位数、方差等。

示例代码:计算销售额的平均值和标准差mean_sales = data['sales'].mean()std_sales = data['sales'].std()print(f"平均销售额: {mean_sales:.2f}")print(f"标准差: {std_sales:.2f}")以上是Python处理数据的一些常用方法,具体应用时需要根据数据的特点和需求选择合适的方法和技术。

基于大数据的网络数据抓取方法

基于大数据的网络数据抓取方法一、引言随着互联网的快速发展和普及,网络数据的规模和复杂性不断增加。

为了从海量的网络数据中提取有价值的信息,研究人员和企业需要开发高效的网络数据抓取方法。

本文将介绍基于大数据的网络数据抓取方法,包括数据抓取的流程、技术工具和数据处理方法。

二、数据抓取的流程1. 目标确定:首先需要确定要抓取的目标数据,包括网页、社交媒体数据、电子商务数据等。

根据需求,确定抓取的范围和深度。

2. URL生成:根据目标确定的范围和深度,生成待抓取的URL列表。

可以通过搜索引擎、API接口等方式获取相关的URL。

3. 数据抓取:使用网络爬虫工具进行数据抓取。

网络爬虫是一种自动化程序,能够模拟人类浏览器行为,访问网页并提取所需数据。

常用的网络爬虫工具有Scrapy、BeautifulSoup等。

4. 数据存储:将抓取到的数据存储到数据库或者文件中。

可以使用关系型数据库、NoSQL数据库或者文件系统进行存储。

根据数据的结构和规模选择合适的存储方案。

5. 数据清洗:对抓取到的数据进行清洗和预处理。

清洗包括去除重复数据、去除噪声数据、修正错误数据等。

预处理包括数据格式转换、数据标准化等。

6. 数据分析:对清洗后的数据进行分析和挖掘。

可以使用数据分析工具和算法,如机器学习、自然语言处理等,从数据中提取有价值的信息和知识。

三、技术工具1. 网络爬虫工具:Scrapy是一个强大的Python网络爬虫框架,可以快速开发和部署爬虫程序。

BeautifulSoup是一个Python库,用于解析HTML和XML文档,提供了简单灵活的API接口。

2. 数据存储工具:MySQL是一个常用的关系型数据库,提供了高效可靠的数据存储和查询功能。

MongoDB是一个NoSQL数据库,适用于存储非结构化数据和大规模数据。

3. 数据清洗工具:Python的pandas库提供了丰富的数据清洗和处理功能,可以进行数据过滤、去重、缺失值处理等操作。

使用python抓取App数据

使⽤python抓取App数据使⽤python抓取App数据本⽂链接:App中的数据可以⽤⽹络爬⾍抓取么答案是完全肯定的:凡是可以看到的APP数据都可以抓取。

下⾯我就介绍下⾃⼰的学习经验和⼀些⽅法吧本篇适合有过web爬⾍基础的程序猿看没有的的话学的可能会吃⼒⼀些App接⼝爬取数据过程使⽤抓包⼯具⼿机使⽤代理,app所有请求通过抓包⼯具获得接⼝,分析接⼝反编译apk获取key突破反爬限制需要的⼯具:Pycharm实现过程⾸先下载夜神模拟器模拟⼿机也可以⽤真机,然后下载Fiddler抓取⼿机APP数据包,分析接⼝完成以后使⽤Python实现爬⾍程序Fiddler安装配置过程第⼀步:下载神器Fiddler下载完成之后,傻⽠式的安装⼀下!第⼆步:设置Fiddler打开Fiddler, Tools-> Fiddler Options (配置完后记得要重启Fiddler)选中"Decrpt HTTPS traffic", Fiddler就可以截获HTTPS请求选中"Allow remote computers to connect". 是允许别的机器把HTTP/HTTPS请求发送到Fiddler上来记住这个端⼝号是:8888夜神模拟器安装配置过程######第⼀步:下载安装下载完成之后,傻⽠式的安装⼀下!######第⼆步:配置桥接实现互通⾸先将当前⼿机⽹络桥接到本电脑⽹络实现互通安装完成桥接驱动后配置IP地址,要配成和本机互通的⽹段,配置完成后打开主机cmd终端ping通ok第三步:配置代理1. 打开主机cmd2. 输⼊ipconfig查看本机IP3. 配置代理进⼊夜神模拟器–打开设置–打开WLAN点击修改⽹络–配置代理如下图:配置完后保存到这⾥我们就设置好所有的值,下⾯就来测试⼀下,打开⼿机的超级课程表APP4. 在夜神模拟器上下载你想爬取得App使⽤Fiddler抓包分析api后使⽤python进⾏爬取就可以了####爬取充电⽹APP实例爬取部分内容截图:部分python代码分享:import requestsimport cityimport jsonimport jsonpathimport recity_list = city.jsonstags_list = city.Tagdef city_func(city_id):try:city = jsonpath.jsonpath(city_list, '$..sub[?(@.code=={})]'.format(int(city_id)))[0]["name"]except:city = jsonpath.jsonpath(city_list, '$[?(@.code=={})]'.format(int(city_id)))[0]["name"]return citydef tags_func(tags_id):tags_join = []if tags_id:for tags in tags_id:t = jsonpath.jsonpath(tags_list,'$..spotFilterTags[?(@.id=={})]'.format(int(tags)))tags_join.append(t[0]["title"])return ('-'.join(tags_join))def split_n(ags):return re.sub('\n',' ',ags)def request(page):print('开始下载第%d页'%page)url = 'https:///spot/searchSpot'two_url = "https:///spot/getSpotDetail?spotId={d}"head = {"device": "client=android&cityName=%E5%8C%97%E4%BA%AC%E5%B8%82&cityCode=110106&lng=116.32154281224254&device_id=8A261C9D60ACEBDED7CD3706C92DD68E&ver=3.7.7&lat=39.8950241 "appId": "20171010","timestamp": "1532342711477","signature": "36daaa33e7b0d5d29ac9c64a2ce6c4cf","forcecheck": "1","Content-Type": "application/x-www-form-urlencoded","Content-Length": "68","Host": "","Connection": "Keep-Alive","User-Agent": "okhttp/3.2.0"}data = {"userFilter[operateType]": 2,"cityCode": 110000,"sort": 1,"page": page,"limit": 10,}response = requests.post(url,data=data,headers=head)#获取数据data = response.json()for i in data['data']:c = []id = i['id']name = i["name"] #充电桩名phone = i["phone"] #⼿机号num = i['quantity'] #有⼏个充电桩city = city_func(i["provinceCode"]) #城市tags =tags_func(i["tags"].split(','))#标签message = c + [id,name,phone,num,city,tags]parse_info(two_url.format(d=id),message)def parse_info(url,message):#打开⽂件with open('car.csv','a',encoding='utf-8')as c:head = {"device": "client=android&cityName=&cityCode=&lng=116.32154281224254&device_id=8A261C9D60ACEBDED7CD3706C92DD68E&ver=3.7.7&lat=39.895024107858724&network=WIFI&os_version=19""TOKEN": "036c8e24266c9089db50899287a99e65dc3bf95f","appId": "20171010","timestamp": "1532357165598","signature": "734ecec249f86193d6e54449ec5e8ff6","forcecheck": "1","Host": "","Connection": "Keep-Alive","User-Agent": "okhttp/3.2.0",}#发起详情请求res = requests.get(url,headers=head)price = split_n(jsonpath.jsonpath(json.loads(res.text),'$..chargingFeeDesc')[0]) #价钱payType = jsonpath.jsonpath(json.loads(res.text),'$..payTypeDesc')[0] #⽀付⽅式businessTime =split_n(jsonpath.jsonpath(json.loads(res.text),'$..businessTime')[0]) #营业时间result = (message + [price,payType,businessTime])r = ','.join([str(i) for i in result])+',\n'c.write(r)def get_page():url = 'https:///spot/searchSpot'head = {"device": "client=android&cityName=%E5%8C%97%E4%BA%AC%E5%B8%82&cityCode=110106&lng=116.32154281224254&device_id=8A261C9D60ACEBDED7CD3706C92DD68E&ver=3.7.7&lat=39.8950241 "appId": "20171010","timestamp": "1532342711477","signature": "36daaa33e7b0d5d29ac9c64a2ce6c4cf","forcecheck": "1","Content-Type": "application/x-www-form-urlencoded","Content-Length": "68","Host": "","Connection": "Keep-Alive","User-Agent": "okhttp/3.2.0"}data = {"userFilter[operateType]": 2,"cityCode": 110000,"sort": 1,"page": 1,"limit": 10,}response = requests.post(url, data=data, headers=head)# 获取数据data = response.json()total = (data["pager"]["total"])page_Size = (data["pager"]["pageSize"])totalPage = (data['pager']["totalPage"])print('当前共有{total}个充电桩,每页展⽰{page_Size}个,共{totalPage}页'.format(total=total,page_Size=page_Size,totalPage=totalPage)) if __name__ == '__main__':get_page()start = int(input("亲,请输⼊您要获取的开始页:"))end = int(input("亲,请输⼊您要获取的结束页:"))for i in range(start,end+1):request(i)总结:app⾥的数据⽐web端更容易抓取,反爬⾍也没拿么强,⼤部分也都是http/https协议,返回的数据类型⼤多数为json。

python数据预处理步骤

python数据预处理步骤数据预处理是指在进行数据分析和建模之前的一系列数据处理步骤,旨在清洗、整理和转换原始数据,以使数据更加适用于后续的分析和建模工作。

下面是Python数据预处理的一般步骤和相关参考内容。

1. 导入必要的库和数据在Python中,可以使用pandas库导入数据,并通过read_csv()函数读取CSV文件、read_excel()函数读取Excel文件等方式导入数据。

2. 理解数据了解数据的结构、特征和规模是进行数据预处理的重要一步。

可以使用head()函数和info()函数查看数据的前几行和整体信息。

3. 处理缺失值缺失值是指数据中的空值或NaN值,缺失值的处理方法包括删除包含缺失值的行、用平均值或中位数填充缺失值、使用插值法填充缺失值等。

pandas库的fillna()函数可以用于填充缺失值。

4. 处理异常值异常值是指数据中的离群值,可以通过统计方法或可视化方法检测异常值,并采用删除、替换或插值等方法进行处理。

可以使用pandas库和matplotlib库进行异常值检测和处理。

5. 数据转换和特征选择对于不同类型的数据(数值型、分类型等),可以进行数据转换、重编码或独热编码等操作。

pandas库的get_dummies()函数可以用于独热编码。

特征选择是指选择对预测变量有重要影响的特征,通过分析特征的重要性、相关性等进行选择。

可以使用scikit-learn库的SelectKBest()函数、特征重要性评估等方式进行特征选择。

6. 数据归一化和标准化数据归一化是将数据缩放到某个特定范围内,例如将数据缩放到0-1之间;数据标准化是将数据按均值为0,标准差为1的分布进行缩放。

可以使用scikit-learn库的MinMaxScaler()函数和StandardScaler()函数进行归一化和标准化。

7. 数据平衡处理当数据集中不同类别的样本数量不平衡时,可以采用欠采样(删除多数类样本)、过采样(复制少数类样本)或生成合成样本等方法进行数据平衡。

Python函数的参数对应_光环大数据 Python培训机构

Python函数的参数对应_光环大数据 Python培训机构我们已经接触过函数(function)的参数(arguments)传递。

当时我们根据位置,传递对应的参数。

我们将接触更多的参数传递方式。

回忆一下位置传递:def f(a,b,c): return a+b+cprint(f(1,2,3))在调用f时,1,2,3根据位置分别传递给了a,b,c。

关键字传递有些情况下,用位置传递会感觉比较死板。

关键字(keyword)传递是根据每个参数的名字传递参数。

关键字并不用遵守位置的对应关系。

依然沿用上面f的定义,更改调用方式:print(f(c=3,b=2,a=1))关键字传递可以和位置传递混用。

但位置参数要出现在关键字参数之前:print(f(1,c=3,b=2))参数默认值在定义函数的时候,使用形如a=19的方式,可以给参数赋予默认值(default)。

如果该参数最终没有被传递值,将使用该默认值。

def f(a,b,c=10): return a+b+cprint(f(3,2))print(f(3,2,1))在第一次调用函数f时,我们并没有足够的值,c没有被赋值,c将使用默认值10.第二次调用函数的时候,c被赋值为1,不再使用默认值。

包裹传递在定义函数时,我们有时候并不知道调用的时候会传递多少个参数。

这时候,包裹(packing)位置参数,或者包裹关键字参数,来进行参数传递,会非常有用。

下面是包裹位置传递的例子:def func(*name): print type(name) printnamefunc(1,4,6)func(5,6,7,1,2,3)两次调用,尽管参数个数不同,都基于同一个func定义。

在func的参数表中,所有的参数被name收集,根据位置合并成一个元组(tuple),这就是包裹位置传递。

为了提醒Python参数,name是包裹位置传递所用的元组名,在定义func时,在name前加*号。

python模型训练步骤

python模型训练步骤摘要:一、Python 模型训练概述1.Python 在模型训练中的应用2.模型训练的基本流程二、数据准备1.数据收集与整理2.数据预处理3.数据划分与增强三、模型设计与优化1.选择合适的模型架构2.模型参数调整3.超参数优化四、模型训练1.训练数据的加载2.模型训练的迭代过程3.监控训练指标与日志记录五、模型评估与调优1.评估指标的选择2.模型性能评估3.模型调优策略六、模型部署与应用1.模型部署方式2.模型应用场景3.持续优化与更新正文:Python 作为一种广泛应用的编程语言,在模型训练领域具有重要作用。

本文将详细介绍Python 模型训练的各个步骤,帮助读者更好地理解和应用Python 进行模型训练。

首先,进行数据准备。

数据是模型训练的基础,因此数据的质量和数量对于模型的性能至关重要。

数据收集与整理的过程中需要注意数据的真实性、完整性和准确性。

数据预处理包括数据清洗、特征工程等操作,以提高数据质量。

数据划分与增强是为了避免模型过拟合,通过对训练数据进行划分和增强操作,可以提高模型的泛化能力。

接下来,进行模型设计与优化。

选择合适的模型架构是关键,需要根据实际问题和数据特点选择合适的模型。

模型参数调整是为了优化模型性能,通过调整模型参数可以提高模型的拟合能力。

超参数优化是模型训练过程中重要的一环,通过调整超参数可以进一步提高模型性能。

进入模型训练阶段,需要加载训练数据,并进行模型的迭代训练。

在此过程中,需要监控训练指标,例如损失函数值、准确率等,同时记录训练日志,以便于后续分析。

训练过程中可能遇到过拟合、欠拟合等问题,需要根据实际情况调整模型结构、参数和训练策略。

模型训练完成后,进行模型评估与调优。

评估指标的选择需要根据实际问题和需求进行,例如准确率、召回率、F1 值等。

模型性能评估的结果可以用来比较不同模型和优化策略的效果。

根据评估结果,可以对模型进行调优,例如调整超参数、模型结构等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Python数据抓取数据处理前的准备_光环大数据python培训

数据抓取概要

为什么要学会抓取网络数据?

对公司或对自己有价值的数据,80%都不在本地的数据库,它们都散落在广大的网络数据,这些数据通常都伴随着网页的形式呈现,这样的数据我们称为非结构化数据

如果我们能想出办法,把这些非结构化的数据转化为结构化的数据,在跟自己的本地数据库做匹配,做交叉分析,让它们关联起来,从而我们就能提炼出我们需要的有价值的数据。

如何将非结构化的数据转化为结构化的数据呢?

必须通过ETL的方法(数据抽取,转化、存储)

(二)抓取的逻辑—ETL

ETL是什么?

ETL是三个英文单词的缩写

E:Extract(数据抽取)

T:Transformation(数据转换)

L:Loading(数据储存)

(三)数据抓取前的准备

1.“网络爬虫”架构

网络爬虫概要

网络爬虫不是一个新技术,自从网络时代开始,就有大量的人来撰写网络爬虫来获取资讯,比如说我们熟知的搜索引擎百度、谷歌等,它们最原始的技术就是网络爬虫技术。

大数据时代,这个“古老”的技术,又被重新重视起来

网络爬虫构架

2、如何理解“网络爬虫”架构

对量化投资策略进行研究,第一步就是获取我们需要的数据,在工作实践中,比较实用的数据源就是新浪财经的数据,下面我们以新浪财经为例,为大家梳理下网络爬虫的构架

我们用谷歌Chrome浏览器,打开新浪财经的股票博客板块/lm/stock/,这个Chrome浏览器就是网页链接器,当我们初入网址的时候,我们就会发出一个请求到新浪财经股票博客的网页上,网页收到请求以后就会把回应回传回来

我们在细看股票博客的页面,是花花绿绿的,除了内容和文字,还有图片和广告,当我们按下链接以后,想知道到底发生了什么事,我们可以透过Chrome 的开发人员工具去观察这件事情。

3、以抓取一个网页的内容为目的,如何去观察一个网页

我们有新浪财经的股票博客信息,我们该如何把这些信息,包含标题和时间抓取出来?

(1)使用开发人员工具观察

开发人员工具在IE,在Chrome都有,这里jacky推荐功能更为齐全的Chrome;

点击所在网页的右键,选择检查,在开发人员工具下找到Network

如果Network里没有内容的话,可以点击网页重新加载

可以把Network当作一个网络窃听器,它可以监听我们送出什么请求,等到什么回应;

(2)观察Requests的构成

点击Filter(漏斗型)

本案例中,我们一共发出了106个requests,这些requests,包含XHR,JS,CSS,等

XML是什么?见下图

ajax是什么?ajax的全称是AsynchronousJavascript+XML;异步传输+js+xml;所谓异步,在这里简单地解释就是:向服务器发送请求的时候,我们不必等待结果,而是可以同时做其他的事情,等到有了结果我们可以再来处理这个

事。

直白地说,就是没用AJAX的网页,你点一个按钮就要刷新一下页面,尽管新页面上只有一行字和当前页面不一样,但你还是要无聊地等待页面刷新。

用了AJAX之后,你点击,然后页面上的一行字就变化了,页面本身不用刷。

AJAX只是一种技术,不是某种具体的东西。

不同的浏览器有自己实现AJAX的组件。

XHR:就是XMLHttpRequest对象,换句话说就是ajax功能实现所依赖的对象;

JS:让我们跟网页互动的程序;

CSS:网页的“化妆品”;

Img:载入的图片;

Media:影音数据;

Font:文字;

Doc:网页资料;

WS:websocket;

Manifest:宣告;

通常来讲,文章和新闻会放在Doc下,接下来我们要抓取的链接就藏在106个链接中的某个链接;

(3)观察HTTP请求与返回内容

我们可以在Document下找到文章与新闻类的内容,为什么呢?因为只要是上述类型内容的网页,它们都有被搜索引擎搜索到的需求,对于搜索引擎来讲,对Document的内容是最好的,所以绝大部分情况下,我们只要找到Document下的第一个链接,都可以准备的把文章与新闻类的内容爬取下来;只有极少部分才会看XHR还有其他的部分;下面,jacky(数据分析部落公众号:shujudata)分享一下实际的操作;

依次点击Network➡️Doc➡️stock/➡️Response

确定我们要抓取的内容在stock/链接下,而不是在其他链接里

首先快速浏览检查我们要抓取的内容在不在Response中,可以在网页的文章中比对关键词,如何网页内容巨大,可以把它们贴在txt中,使用查找比对;

确定网页的存取方法

我们可以把get的方法,想象成邮寄的信,网址的信息就写在“信封”上,

我们送出的http请求就像把信邮寄出去一样,当网页的链接器看到这封信,了解我们的来意以后,此时就可以把对应的回应回传回来;接下来,我们该怎样写一个程序去模拟我们的浏览器送出get请求的过程呢?这时我们就要用到python了,

在Headers中,我们看到网页是用get方法做存取的

什么是get方法?该如何理解get方法?

以上,我们观察网页后,我们会发现对应Response下的资料数据都放在html 的页面里面,html包含着网页的标签<div>,这些标签叙述着网页的行为,我们得到的回应是html,包含它的资料数据以及它的标签,这样的资料并不是结构化的资料,我们还需要进一步处理。

为什么大家选择光环大数据!

大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请专业的大数据领域知名讲师,确保教学的整体质量与教学水准。

讲师团及时掌握时代潮流技术,将前沿技能融入教学中,确保学生所学知识顺应时代所需。

通过深入浅出、通俗易懂的教学方式,指导学生更快的掌握技能知识,成就上万个高薪就业学子。

【报名方式、详情咨询】

光环大数据官方网站报名:

手机报名链接:http:// /mobile/。