Python3中urllib详细使用方法_光环大数据Python培训

python爬虫之urllib3的使用示例

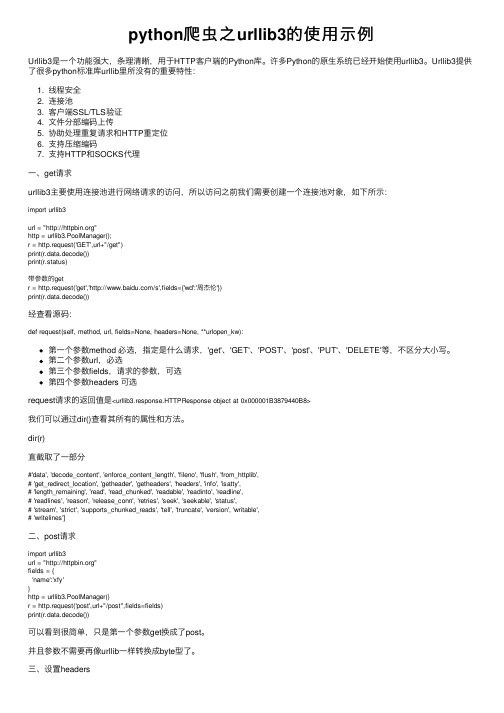

python爬⾍之urllib3的使⽤⽰例Urllib3是⼀个功能强⼤,条理清晰,⽤于HTTP客户端的Python库。

许多Python的原⽣系统已经开始使⽤urllib3。

Urllib3提供了很多python标准库urllib⾥所没有的重要特性:1. 线程安全2. 连接池3. 客户端SSL/TLS验证4. ⽂件分部编码上传5. 协助处理重复请求和HTTP重定位6. ⽀持压缩编码7. ⽀持HTTP和SOCKS代理⼀、get请求urllib3主要使⽤连接池进⾏⽹络请求的访问,所以访问之前我们需要创建⼀个连接池对象,如下所⽰:import urllib3url = ""http = urllib3.PoolManager();r = http.request('GET',url+"/get")print(r.data.decode())print(r.status)带参数的getr = http.request('get','/s',fields={'wd':'周杰伦'})print(r.data.decode())经查看源码:def request(self, method, url, fields=None, headers=None, **urlopen_kw):第⼀个参数method 必选,指定是什么请求,'get'、'GET'、'POST'、'post'、'PUT'、'DELETE'等,不区分⼤⼩写。

第⼆个参数url,必选第三个参数fields,请求的参数,可选第四个参数headers 可选request请求的返回值是<urllib3.response.HTTPResponse object at 0x000001B3879440B8>我们可以通过dir()查看其所有的属性和⽅法。

url在python中的用法

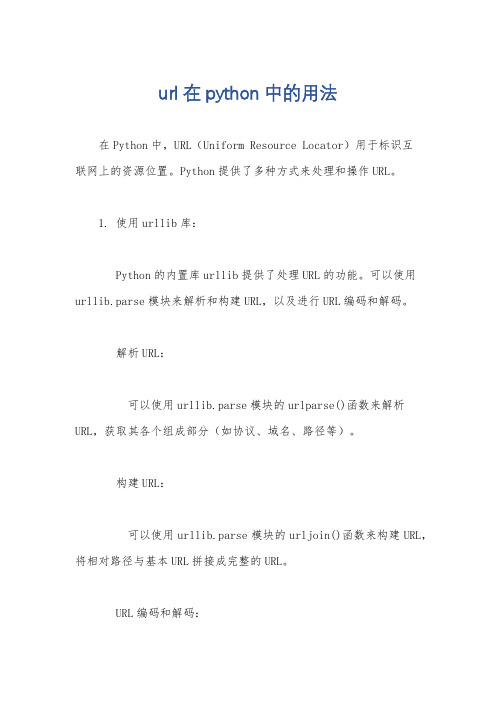

url在python中的用法在Python中,URL(Uniform Resource Locator)用于标识互联网上的资源位置。

Python提供了多种方式来处理和操作URL。

1. 使用urllib库:Python的内置库urllib提供了处理URL的功能。

可以使用urllib.parse模块来解析和构建URL,以及进行URL编码和解码。

解析URL:可以使用urllib.parse模块的urlparse()函数来解析URL,获取其各个组成部分(如协议、域名、路径等)。

构建URL:可以使用urllib.parse模块的urljoin()函数来构建URL,将相对路径与基本URL拼接成完整的URL。

URL编码和解码:可以使用urllib.parse模块的quote()函数进行URL编码,将特殊字符转换为%xx的形式;使用unquote()函数进行URL解码,将%xx形式的字符还原为特殊字符。

发送HTTP请求:可以使用urllib.request模块发送HTTP请求,获取URL对应的内容。

2. 使用requests库:requests是一个功能强大的第三方库,用于发送HTTP请求。

它提供了更简洁和方便的API,可以轻松处理URL相关的操作。

发送GET请求:使用requests.get()函数发送GET请求,获取URL对应的内容。

发送POST请求:使用requests.post()函数发送POST请求,向URL提交数据。

处理URL参数:可以使用requests库的params参数来传递URL参数,或使用params参数传递一个字典来构建URL参数。

处理URL路径:可以使用requests库的url参数来指定URL路径。

处理请求头:可以使用requests库的headers参数来设置请求头信息。

处理响应:请求返回的响应可以通过requests库提供的方法来获取响应头、响应内容等信息。

3. 使用其他第三方库:除了上述两个库,还有其他第三方库也提供了处理URL的功能,如httplib2、treq等。

Python3中使用urllib的方法详解(header,代理,超时,认证,异常处理)

Python3中使⽤urllib的⽅法详解(header,代理,超时,认证,异常处理)我们可以利⽤urllib来抓取远程的数据进⾏保存哦,以下是python3 抓取⽹页资源的多种⽅法,有需要的可以参考借鉴。

1、最简单import urllib.requestresponse = urllib.request.urlopen('/')html = response.read()2、使⽤ Requestimport urllib.requestreq = urllib.request.Request('/')response = urllib.request.urlopen(req)the_page = response.read()3、发送数据#! /usr/bin/env python3import urllib.parseimport urllib.requesturl = 'http://localhost/login.php'user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'values = {'act' : 'login','login[email]' : 'yzhang@','login[password]' : '123456'}data = urllib.parse.urlencode(values)req = urllib.request.Request(url, data)req.add_header('Referer', '/')response = urllib.request.urlopen(req)the_page = response.read()print(the_page.decode("utf8"))4、发送数据和header#! /usr/bin/env python3import urllib.parseimport urllib.requesturl = 'http://localhost/login.php'user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'values = {'act' : 'login','login[email]' : 'yzhang@','login[password]' : '123456'}headers = { 'User-Agent' : user_agent }data = urllib.parse.urlencode(values)req = urllib.request.Request(url, data, headers)response = urllib.request.urlopen(req)the_page = response.read()print(the_page.decode("utf8"))5、http 错误#! /usr/bin/env python3import urllib.requestreq = urllib.request.Request('https:// ')try:urllib.request.urlopen(req)except urllib.error.HTTPError as e:print(e.code)print(e.read().decode("utf8"))6、异常处理1#! /usr/bin/env python3from urllib.request import Request, urlopenfrom urllib.error import URLError, HTTPErrorreq = Request("https:// /")try:response = urlopen(req)except HTTPError as e:print('The server couldn't fulfill the request.')print('Error code: ', e.code)except URLError as e:print('We failed to reach a server.')print('Reason: ', e.reason)else:print("good!")print(response.read().decode("utf8"))7、异常处理2#! /usr/bin/env python3from urllib.request import Request, urlopenfrom urllib.error import URLErrorreq = Request("https:// /")try:response = urlopen(req)except URLError as e:if hasattr(e, 'reason'):print('We failed to reach a server.')print('Reason: ', e.reason)elif hasattr(e, 'code'):print('The server couldn't fulfill the request.')print('Error code: ', e.code)else:print("good!")print(response.read().decode("utf8"))8、HTTP 认证#! /usr/bin/env python3import urllib.request# create a password managerpassword_mgr = urllib.request.HTTPPasswordMgrWithDefaultRealm() # Add the username and password.# If we knew the realm, we could use it instead of None.top_level_url = "https:// /"password_mgr.add_password(None, top_level_url, 'rekfan', 'xxxxxx') handler = urllib.request.HTTPBasicAuthHandler(password_mgr)# create "opener" (OpenerDirector instance)opener = urllib.request.build_opener(handler)# use the opener to fetch a URLa_url = "https:// /"x = opener.open(a_url)print(x.read())# Install the opener.# Now all calls to urllib.request.urlopen use our opener.urllib.request.install_opener(opener)a = urllib.request.urlopen(a_url).read().decode('utf8')print(a)9、使⽤代理#! /usr/bin/env python3import urllib.requestproxy_support = urllib.request.ProxyHandler({'sock5': 'localhost:1080'}) opener = urllib.request.build_opener(proxy_support)urllib.request.install_opener(opener)a = urllib.request.urlopen("https:// ").read().decode("utf8") print(a)10、超时#! /usr/bin/env python3import socketimport urllib.request# timeout in secondstimeout = 2socket.setdefaulttimeout(timeout)# this call to urllib.request.urlopen now uses the default timeout# we have set in the socket modulereq = urllib.request.Request('https:// /')a = urllib.request.urlopen(req).read()print(a)总结以上就是这篇⽂章的全部内容,希望本⽂的内容对⼤家学习或使⽤python能有所帮助,如果有疑问⼤家可以留⾔交流。

光环大数据培训用三个案例透析大数据思维的核心

光环大数据培训用三个案例透析大数据思维的核心光环大数据培训机构了解到,逻辑推理能力是人类特有的本领,给出原因,我们能够通过逻辑推理得到结果。

在过去,我们一直非常强调因果关系,一方面是因为我们常常是先有原因,再有结果,另一方面是因为如果我们找不出原因,常常会觉得结果不是非常可信。

而大数据时代,大数据思维要求我们从探求因果联系到探索强相关关系。

以下三个案例分别来自药品研发、司法判决与广告投放,从三个不同的角度了解大数据思维的核心。

大数据与药品研发:寻找特效药的方法比如在过去,现代医学里新药的研制,就是典型的利用因果关系解决问题的例子。

青霉素的发明过程就非常具有代表性。

首先,在19世纪中期,奥匈帝国的塞麦尔维斯(Ignaz Philipp Semmelweis,1818—1865)a、法国的巴斯德等人发现微生物细菌会导致很多疾病,因此人们很容易想到杀死细菌就能治好疾病,这就是因果关系。

不过,后来弗莱明等人发现,把消毒剂涂抹在伤员伤口上并不管用,因此就要寻找能够从人体内杀菌的物质。

最终在1928年弗莱明发现了青霉素,但是他不知道青霉素杀菌的原理。

而牛津大学的科学家钱恩和亚伯拉罕搞清楚了青霉素中的一种物质—青霉烷—能够破坏细菌的细胞壁,才算搞清楚青霉素有效性的原因,到这时青霉素治疗疾病的因果关系才算完全找到,这时已经是1943年,离赛麦尔维斯发现细菌致病已经过去近一个世纪。

两年之后,女科学家多萝西·霍奇金(Dorothy Hodgkin)搞清楚了青霉烷的分子结构,并因此获得了诺贝尔奖,这样到了1957年终于可以人工合成青霉素。

当然,搞清楚青霉烷的分子结构,有利于人类通过改进它来发明新的抗生素,亚伯拉罕就因此而发明了头孢类抗生素。

在整个青霉素和其他抗生素的发明过程中,人类就是不断地分析原因,然后寻找答案(结果)。

当然,通过这种因果关系找到的答案非常让人信服。

其他新药的研制过程和青霉素很类似,科学家们通常需要分析疾病产生的原因,寻找能够消除这些原因的物质,然后合成新药。

urllib、urllib2、urllib3、request的详细区别

urllib、urllib2、urllib3、request的详细区别1、在python2.x版本中有 urllib库和 urllib2库;在python3.x版本中把 urllib库和urllib2 合成为⼀个 urllib库;urllib3库是在python3.x版本中新增的第三⽅扩展库。

2、urllib2 是python2.x的http访问库,是python内置标准库;urllib库同样是python的内置标准库;3、requests 是第三⽅http访问库,需要安装。

requests 友好度⾼⼀些,推荐使⽤ requests。

4、urllib3 是⼀个基于python3.x版本的功能强⼤,友好的HTTP访问库。

越来越多的python应⽤开始采⽤ urllib3库。

它提供了很多python标准库中没有的重要功能。

5、在python3.x版本中,urllib2 模块已经不在单独存在(也就是说当在程序中import urllib2 时,系统提⽰你没这个模块,会报错),urllib2被合并到了urllib中,叫做urllib.request 和 urllib.error 。

6、urllib库是⼀个⽤来处理⽹络请求的python标准库,它包含4个模块。

①urllib.request---请求模块,⽤于发起⽹络请求②urllib.parse---解析模块,⽤于解析URL:详见:③urllib.error---异常处理模块,⽤于处理request引起的异常④urllib.robotparser robots.tx---⽤于解析robots.txt⽂件⼩结:urllib、urllib2、urllib3库均能通过⽹络访问互联⽹上的资源⽂件,它们通过使⽤统⼀资源定位符(URL)并结合re模块完成很多意想不到的操作。

① urllib:Python2和Python3内置的⽹络请求库,Python3的 urllib库实际是Python2版本中 urllib2库和 urllib库的合并② urllib2:它只存在于Python2版本的内置库中,功能与urllib基本类似,主要上为 urllib库的增强③ urllib3:Python2和Python3均可以使⽤,但不是标准库,需要使⽤pip安装使⽤,urllib3提供了线程安全池和⽂件post等。

Python3直接爬取图片URL并保存示例

Python3直接爬取图⽚URL并保存⽰例有时候我们会需要从⽹络上爬取⼀些图⽚,来满⾜我们形形⾊⾊直⾄不可描述的需求。

⼀个典型的简单爬⾍项⽬步骤包括两步:获取⽹页地址和提取保存数据。

这⾥是⼀个简单的从图⽚url收集图⽚的例⼦,可以成为⼀个⼩⼩的开始。

获取地址这些图⽚的URL可能是连续变化的,如从001递增到099,这种情况可以在程序中将共同的前⾯部分截取,再在最后递增并字符串化后循环即可。

抑或是它们的URL都保存在某个⽂件中,这时可以读取到列表中:def getUrls(path):urls = []with open(path,'r') as f:for line in f:urls.append(line.strip('\n'))return(urls)保存图⽚在python3中,urllib提供了⼀系列⽤于操作URL的功能,其中的request模块可以⾮常⽅便地抓取URL内容,也就是发送⼀个GET请求到指定的页⾯,然后返回HTTP的响应。

具体细节请看注释:def requestImg(url, name, num_retries=3):img_src = url# print(img_src)header = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) \AppleWebKit/537.36 (KHTML, like Gecko) \Chrome/35.0.1916.114 Safari/537.36','Cookie': 'AspxAutoDetectCookieSupport=1'}# Request类可以使⽤给定的header访问URLreq = urllib.request.Request(url=img_src, headers=header)try:response = urllib.request.urlopen(req) # 得到访问的⽹址filename = name + '.jpg'with open(filename, "wb") as f:content = response.read() # 获得图⽚f.write(content) # 保存图⽚response.close()except HTTPError as e: # HTTP响应异常处理print(e.reason)except URLError as e: # ⼀定要放到HTTPError之后,因为它包含了前者print(e.reason)except IncompleteRead or RemoteDisconnected as e:if num_retries == 0: # 重连机制returnelse:requestImg(url, name, num_retries-1)其他捕获异常以下是批量爬取⽹页时可能需要捕获的异常,同时可以看出,urllib2库对应urllib库,⽽httplib库对应http.client:Python2Pyhton3urllib2.HTTPError urllib.error.HTTPErrorurllib2.URLError urllib.error.URLError (HTTPError被包含其中)httplib.IncompleteRead http.client.IncompleteRead httplib.RemoteDisconnected http.client.RemoteDisconnected重连机制在函数参数中设置⼀个参数num_retries并对其进⾏初始化,即默认参数。

urllib3 用法

urllib3 用法urllib3 用法1. 概述urllib3是一个功能强大的Python HTTP库,它提供了多种高级特性,包括连接池、请求重试、SSL验证等。

在Python /及更高版本中,urllib3已经作为Python标准库的一部分。

2. 安装使用pip命令可以轻松安装urllib3,命令如下:pip install urllib33. 导入库在使用urllib3之前,需要先导入库。

导入urllib3的方式如下:import urllib34. 创建连接池urllib3的一个主要特性是连接池。

连接池可以复用HTTP连接,提高请求的性能。

通过以下代码可以创建一个连接池:http = ()5. 发送GET请求使用连接池创建一个GET请求非常简单。

通过调用连接池的request()方法,并指定请求的方法(GET/POST/PUT/DELETE)、URL和其他选项,即可发送请求并获取响应。

示例代码如下:response = ('GET', 'print()print()6. 发送POST请求发送POST请求也非常简单。

除了请求方法('POST')和URL之外,还需要指定请求的body数据。

下面是一个发送POST请求的示例:data = {'key1': 'value1', 'key2': 'value2'}response = ('POST', ' fields=data)print()print()7. 请求重试urllib3提供了请求重试的功能,可以在请求失败时自动重试一定次数。

通过设置retries参数,可以指定重试次数。

下面的示例演示了如何使用请求重试:retry = (total=3, backoff_factor=)http = (retries=retry)response = ('GET', '8. SSL验证urllib3默认会验证SSL证书,确保连接的安全性。

解决python3urllib没有urlencode属性的问题

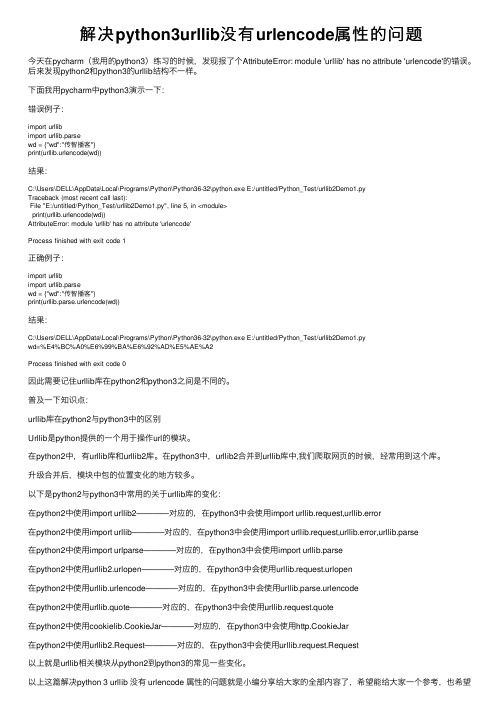

解决python3urllib没有urlencode属性的问题今天在pycharm(我⽤的python3)练习的时候,发现报了个AttributeError: module 'urllib' has no attribute 'urlencode'的错误。

后来发现python2和python3的urllib结构不⼀样。

下⾯我⽤pycharm中python3演⽰⼀下:错误例⼦:import urllibimport urllib.parsewd = {"wd":"传智播客"}print(urllib.urlencode(wd))结果:C:\Users\DELL\AppData\Local\Programs\Python\Python36-32\python.exe E:/untitled/Python_Test/urllib2Demo1.pyTraceback (most recent call last):File "E:/untitled/Python_Test/urllib2Demo1.py", line 5, in <module>print(urllib.urlencode(wd))AttributeError: module 'urllib' has no attribute 'urlencode'Process finished with exit code 1正确例⼦:import urllibimport urllib.parsewd = {"wd":"传智播客"}print(urllib.parse.urlencode(wd))结果:C:\Users\DELL\AppData\Local\Programs\Python\Python36-32\python.exe E:/untitled/Python_Test/urllib2Demo1.pywd=%E4%BC%A0%E6%99%BA%E6%92%AD%E5%AE%A2Process finished with exit code 0因此需要记住urllib库在python2和python3之间是不同的。

urllib3组件用法

urllib3组件用法urllib3是一个强大的HTTP库,用于发送HTTP请求和处理HTTP响应。

它是Python的内置库,在Python 2.7或更高版本中可以使用。

urllib3的目标是提供一个简单、灵活、可靠的HTTP客户端以及对HTTP 协议的全面支持。

1. 连接池管理:urllib3允许您创建和管理HTTP连接池,以便在多个请求之间重复使用连接。

这种机制可以降低连接的建立和销毁的开销,提高性能。

2. 连接重用:在发送请求之后,urllib3会自动将连接返回到连接池中,以便下次请求时可以重用。

这消除了每次请求都需要重新建立连接的开销。

3. 支持HTTPS:urllib3提供了对HTTPS的完全支持,包括SSL / TLS协议的正确处理和证书验证。

它使用Python的标准ssl模块来处理安全连接。

4. 重定向跟踪:当服务器返回重定向响应时,urllib3会自动跟踪这些重定向,并在必要时转发请求。

这让您可以方便地处理重定向,而无需手动编写代码。

5. 超时和重试:urllib3允许您设置超时时间,以确保在请求花费过长时间时不会无限期地等待。

它还提供了可配置的重试功能,以便在出现错误时自动重试请求。

下面是urllib3的一些常见用法:1.发送GET请求:```import urllib3print(response.data)```以上代码创建了一个`PoolManager`对象,并使用`request(`方法发送了一个GET请求。

返回的`response`对象包含请求的响应数据。

2.发送POST请求:```import urllib3print(response.data)```以上代码通过将参数作为`fields`参数传递给`request(`方法,发送了一个POST请求。

3.设置超时和重试:```import urllib3print(response.data)```以上代码创建了一个具有10秒超时和最多2次重试次数的`PoolManager`对象。

urllib3组件用法(一)

urllib3组件用法(一)urllib3组件用法详解urllib3是一个功能强大的Python HTTP库,它提供了许多高级特性以简化HTTP请求和响应的处理。

以下是urllib3组件的一些用法,帮助你更好地了解它的功能和用法。

安装urllib3在使用urllib3之前,你需要确保它已被正确安装。

可以使用以下命令安装urllib3:pip install urllib3创建HTTP连接urllib3可以帮助我们建立和管理HTTP连接。

下面是创建HTTP连接的步骤:1.导入urllib3库import urllib32.创建连接池http = ()3.发送请求response = ('GET', '4.获取响应内容print()发送GET请求使用urllib3发送GET请求非常简单,并且可以设置一些高级选项。

以下是发送GET请求的步骤:1.导入urllib3库import urllib32.创建连接池http = ()3.发送GET请求response = ('GET', '4.获取响应内容print()发送POST请求与发送GET请求类似,使用urllib3发送POST请求也是非常简单的。

以下是发送POST请求的步骤:1.导入urllib3库import urllib32.创建连接池http = ()3.发送POST请求response = ('POST', ' fields={'param1': 'value1', ' param2': 'value2'})4.获取响应内容print()设置请求头urllib3允许我们设置请求头,以便在发送请求时提供其他信息。

以下是设置请求头的步骤:1.导入urllib3库import urllib32.创建连接池http = ()3.设置请求头headers = {'User-Agent': 'Mozilla/ (Windows NT ; Win64; x64) AppleWebKit/ (KHTML, like Gecko) Chrome/ Safar i/'}4.发送请求response = ('GET', ' headers=headers)5.获取响应内容print()设置超时时间使用urllib3,我们可以设置请求的超时时间,以避免在请求时间过长时等待太久。

python3中apply函数和lambda函数的使用详解

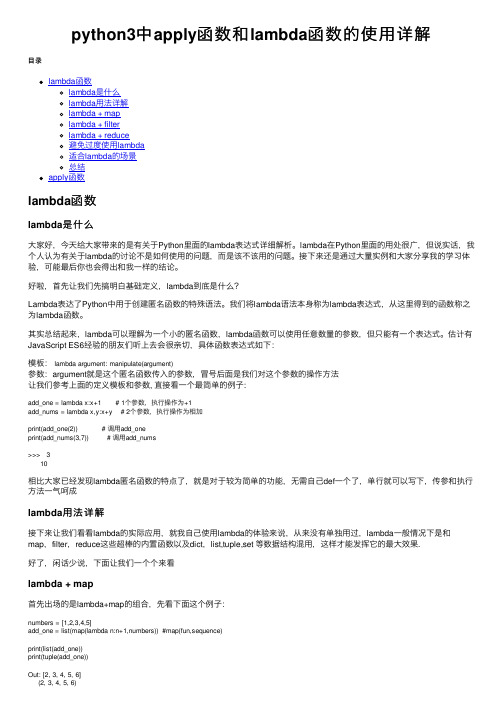

python3中apply函数和lambda函数的使⽤详解⽬录lambda函数lambda是什么lambda⽤法详解lambda + maplambda + filterlambda + reduce避免过度使⽤lambda适合lambda的场景总结apply函数lambda函数lambda是什么⼤家好,今天给⼤家带来的是有关于Python⾥⾯的lambda表达式详细解析。

lambda在Python⾥⾯的⽤处很⼴,但说实话,我个⼈认为有关于lambda的讨论不是如何使⽤的问题,⽽是该不该⽤的问题。

接下来还是通过⼤量实例和⼤家分享我的学习体验,可能最后你也会得出和我⼀样的结论。

好啦,⾸先让我们先搞明⽩基础定义,lambda到底是什么?Lambda表达了Python中⽤于创建匿名函数的特殊语法。

我们将lambda语法本⾝称为lambda表达式,从这⾥得到的函数称之为lambda函数。

其实总结起来,lambda可以理解为⼀个⼩的匿名函数,lambda函数可以使⽤任意数量的参数,但只能有⼀个表达式。

估计有JavaScript ES6经验的朋友们听上去会很亲切,具体函数表达式如下:模板:lambda argument: manipulate(argument)参数:argument就是这个匿名函数传⼊的参数,冒号后⾯是我们对这个参数的操作⽅法让我们参考上⾯的定义模板和参数, 直接看⼀个最简单的例⼦:add_one = lambda x:x+1 # 1个参数,执⾏操作为+1add_nums = lambda x,y:x+y # 2个参数,执⾏操作为相加print(add_one(2)) # 调⽤add_oneprint(add_nums(3,7)) # 调⽤add_nums>>> 310相⽐⼤家已经发现lambda匿名函数的特点了,就是对于较为简单的功能,⽆需⾃⼰def⼀个了,单⾏就可以写下,传参和执⾏⽅法⼀⽓呵成lambda⽤法详解接下来让我们看看lambda的实际应⽤,就我⾃⼰使⽤lambda的体验来说,从来没有单独⽤过,lambda⼀般情况下是和map,filter,reduce这些超棒的内置函数以及dict,list,tuple,set 等数据结构混⽤,这样才能发挥它的最⼤效果.好了,闲话少说,下⾯让我们⼀个个来看lambda + map⾸先出场的是lambda+map的组合,先看下⾯这个例⼦:numbers = [1,2,3,4,5]add_one = list(map(lambda n:n+1,numbers)) #map(fun,sequence)print(list(add_one))print(tuple(add_one))Out: [2, 3, 4, 5, 6](2, 3, 4, 5, 6)这个是我们上⼀期的例⼦,实现⼀个数组(元组)每个元素+1,让我们回忆⼀下map的⽤法map(fun,sequence),fun是传递的⽅法,sequence是⼀个可迭代的序列,这⾥我们的fun就是匿名函数lambda n:n+1,这⾥⾮常完美的解释了lambda的设计初衷,因为如果没有lambda,我们的解决⽅案是这样:def add(num):return num+1numbers = [1,2,3,4,5]add_one = list(map(add,numbers))print(add_one)print(tuple(add_one))显然易见,这⾥的add⽅法有点多余,所以⽤lambda代替是个好的选择。

Python解析、提取url关键字的实例详解

Python解析、提取url关键字的实例详解解析url⽤的类库:python2版本:from urlparse import urlparseimport urllibpython3版本:from urllib.parse import urlparseimport urllib.request研究了不同的url规则发现:只要在搜索关键字是⽤=嫁接的,查询的关键在解析后的query⾥如果不是⽤=嫁接,查询的关键在解析后的path⾥。

解析的规则都是⼀样的,正则如下:(6中不同情况的组合)另外host为‘'的url编码与其他不同要另做处理。

代码如下:有些⽹站的规则还不是很清楚,需要花⼤量时间找规则,规则越清晰,关键字就越清楚,如下规则已适合绝⼤部分⽹站,酌情参考。

# -*- coding:utf-8 -*-from urlparse import urlparseimport urllibimport re# urlsource_txt = "E:\\python_Anaconda_code\\url.txt"# 规则regular = r'(\w+(%\w\w)+\w+|(%\w\w)+\w+(%\w\w)+|\w+(%\w\w)+|(%\w\w)+\w+|(%\w\w)+|\w+)'# 存放关键字kw_list = list()# key为要研究⽹站的host,value为关键字的嫁接标识符dict = {"": "wd=","": "word=","": "query=","": "kw=","": "word=","": "k=","": "q=","": "list_","": "query=","": "weibo/"}def Main():with open(source_txt, 'r') as f_source_txt:for url in f_source_txt:host = url.split("//")[1].split("/")[0]if host in dict:flag = dict[host]if flag.find("=") != -1:query = urlparse(url).query.replace('+', '')kw = re.search(flag + regular, query, re.I) # .group(0)if kw:kw = urllib.unquote(kw.group(0).split(flag)[1])print(kw)else:path = urlparse(url).path.replace('+', '')kw = re.search(flag + regular, path.replace("%25", "%"), re.I)if kw:kw = urllib.unquote(kw.group(0).split(flag)[1])print(kw)if __name__ == '__main__':Main()url.txt的内容如下:https:///s?ie=utf-8&f=8&rsv_bp=0&rsv_idx=1&ch=&tn=baidu&bar=&wd=python&rn=&oq=&rsv_pq=ece0867c0002c793&rsv_t=edeaQq7DDvZnxq%2FZVra5K%2BEUanlTIUXhGIhvuTaqdfOECLuXR25XKDp%2Bi0I&rqlang=cn&rsv_enter=1&inputT https:///s?ie=utf-8&f=8&rsv_bp=1&rsv_idx=1&ch=&tn=baidu&bar=&wd=python%E9%87%8C%E7%9A%84%E5%AD%97%E5%85%B8dict&oq=python&rsv_pq=96c160e70003f332&rsv_t=0880NkOvMIr3TvOdDP1t8EbloD8qwr4yeP6CfPjQihQNN https:///s?ie=utf-8&f=8&rsv_bp=1&rsv_idx=1&ch=&tn=baidu&bar=&wd=python%E9%87%8C%E7%9A%84urlprese&oq=python%25E9%2587%258C%25E7%259A%2584re%25E9%2587%258C%25E7%259A%2584%257C%25E6%2580%258E% https:///s?ie=utf-8&f=8&rsv_bp=1&rsv_idx=1&ch=&tn=baidu&bar=&wd=python++wo+%E7%88%B1urlprese&oq=python%25E9%2587%258C%25E7%259A%2584urlprese&rsv_pq=eecf45e900033e87&rsv_t=1c70xAYhrvw5JOZA7lpVgt4pw%2BW /ns?word=%E8%B6%B3%E7%90%83&tn=news&from=news&cl=2&rn=20&ct=1/ns?ct=1&rn=20&ie=utf-8&bs=%E8%B6%B3%E7%90%83&rsv_bp=1&sr=0&cl=2&f=8&prevct=no&tn=news&word=++++++%E8%B6%B3++%E7%90%83+++++%E4%BD%A0%E5%A5%BD+%E5%98%9B%EF%BC%9F&rsv_sug3=14& /f?ie=utf-8&kw=%E7%BA%A2%E6%B5%B7%E8%A1%8C%E5%8A%A8&fr=search&red_tag=q022*******https:///web?query=ni+zai+%E6%88%91+%E5%BF%83li&_asf=&_ast=1520388441&w=01019900&p=40040100&ie=utf8&from=index-nologin&s_from=index&sut=9493&sst0=1520388440692&lkt=8%2C1520388431200%2C1520 https:///jobs/list_python%E5%A4%A7%E6%95%B0%E6%8D%AEmr?labelWords=&fromSearch=true&suginput=https:///pc/search/?query=%E6%85%A2%E6%80%A7%E4%B9%99%E8%82%9D%/weibo/%25E5%2594%2590%25E4%25BA%25BA%25E8%25A1%2597%25E6%258E%25A2%25E6%25A1%25882&Refer=index/weibo/%25E4%25BD%25A0%25E5%25A5%25BD123mm%2520%25E5%2597%25AF%2520mm11&Refer=STopic_box结果如下:如果要研究其他host,可以加到字典dict⾥。

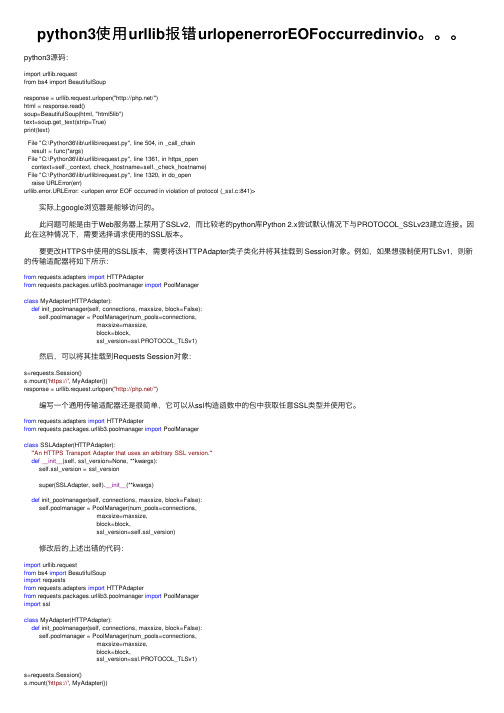

python3使用urllib报错urlopenerrorEOFoccurredinvio。。。

python3使⽤urllib报错urlopenerrorEOFoccurredinvio。

python3源码:import urllib.requestfrom bs4 import BeautifulSoupresponse = urllib.request.urlopen("/")html = response.read()soup=BeautifulSoup(html, "html5lib")text=soup.get_text(strip=True)print(text)File "C:\Python36\lib\urllib\request.py", line 504, in _call_chainresult = func(*args)File "C:\Python36\lib\urllib\request.py", line 1361, in https_opencontext=self._context, check_hostname=self._check_hostname)File "C:\Python36\lib\urllib\request.py", line 1320, in do_openraise URLError(err)urllib.error.URLError: <urlopen error EOF occurred in violation of protocol (_ssl.c:841)> 实际上google浏览器是能够访问的。

此问题可能是由于Web服务器上禁⽤了SSLv2,⽽⽐较⽼的python库Python 2.x尝试默认情况下与PROTOCOL_SSLv23建⽴连接。

因此在这种情况下,需要选择请求使⽤的SSL版本。

要更改HTTPS中使⽤的SSL版本,需要将该HTTPAdapter类⼦类化并将其挂载到 Session对象。

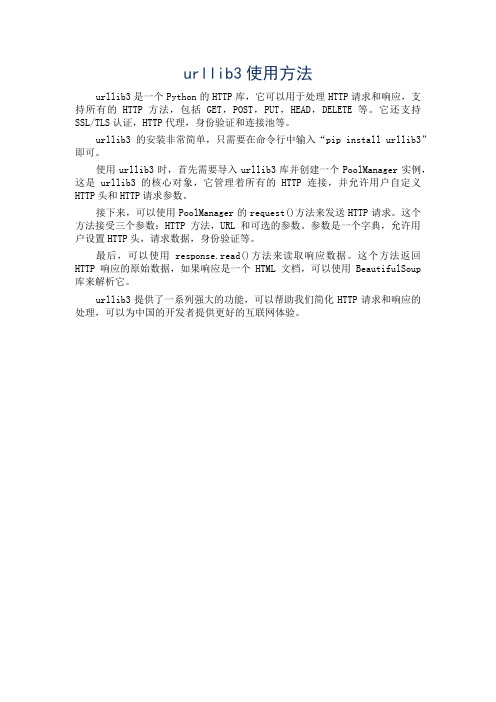

urllib3使用方法

urllib3使用方法

urllib3是一个Python的HTTP库,它可以用于处理HTTP请求和响应,支持所有的HTTP方法,包括GET,POST,PUT,HEAD,DELETE等。

它还支持SSL/TLS认证,HTTP代理,身份验证和连接池等。

urllib3的安装非常简单,只需要在命令行中输入“pip install urllib3”即可。

使用urllib3时,首先需要导入urllib3库并创建一个PoolManager实例,这是urllib3的核心对象,它管理着所有的HTTP连接,并允许用户自定义HTTP头和HTTP请求参数。

接下来,可以使用PoolManager的request()方法来发送HTTP请求。

这个方法接受三个参数:HTTP方法,URL和可选的参数。

参数是一个字典,允许用户设置HTTP头,请求数据,身份验证等。

最后,可以使用response.read()方法来读取响应数据。

这个方法返回HTTP响应的原始数据,如果响应是一个HTML文档,可以使用BeautifulSoup 库来解析它。

urllib3提供了一系列强大的功能,可以帮助我们简化HTTP请求和响应的处理,可以为中国的开发者提供更好的互联网体验。

pythonurl参数在python中添加url参数

pythonurl参数在python中添加url参数在Python中,我们可以通过各种方法来添加URL参数。

URL参数是指在URL中以键值对的形式出现的参数,用于向服务器传递额外的信息。

下面将介绍几种常见的方法来实现这个目标。

方法一:使用字符串拼接最简单的方法是使用字符串的拼接操作来添加URL参数。

我们可以将参数以键值对的形式添加到URL的末尾,并使用"?"符号分隔URL和参数。

不同的参数之间使用"&"符号进行分隔。

示例代码如下:```pythonparameters ="key1": "value1","key2": "value2"#构造URL字符串url_with_params = url + "?" + "&".join([f"{key}={value}" for key, value in parameters.items(])```这种方法简单直接,适用于URL和参数数量较少的情况。

然而,如果参数数量较大,拼接字符串的方式会显得冗长且容易出错。

方法二:使用urllib.parse库Python标准库中的urllib.parse模块提供了更专业的URL处理功能。

我们可以使用其中的urlencode(函数来将参数字典转换为URL编码格式。

然后,再将编码后的参数字符串追加到URL中即可。

示例代码如下:```pythonfrom urllib.parse import urlencodeparameters ="key1": "value1","key2": "value2"#构造URL字符串url_with_params = url + "?" + urlencode(parameters)```这种方法相较于字符串拼接更为高效和可靠,尤其是当参数数量较多时。

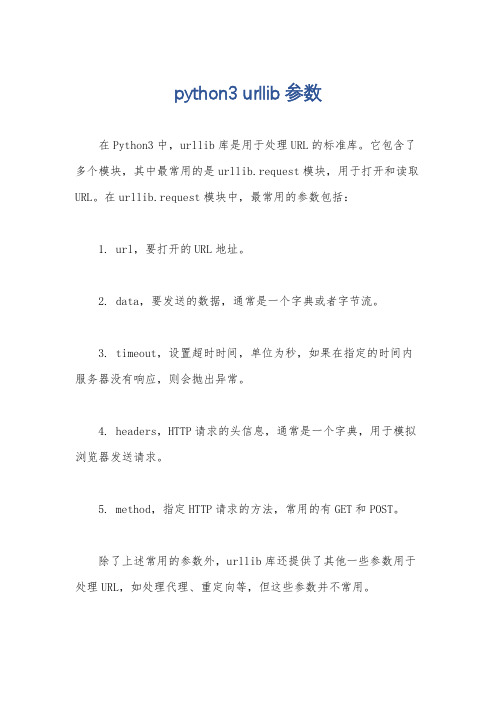

python3 urllib参数

python3 urllib参数

在Python3中,urllib库是用于处理URL的标准库。

它包含了多个模块,其中最常用的是urllib.request模块,用于打开和读取URL。

在urllib.request模块中,最常用的参数包括:

1. url,要打开的URL地址。

2. data,要发送的数据,通常是一个字典或者字节流。

3. timeout,设置超时时间,单位为秒,如果在指定的时间内服务器没有响应,则会抛出异常。

4. headers,HTTP请求的头信息,通常是一个字典,用于模拟浏览器发送请求。

5. method,指定HTTP请求的方法,常用的有GET和POST。

除了上述常用的参数外,urllib库还提供了其他一些参数用于处理URL,如处理代理、重定向等,但这些参数并不常用。

使用urllib库发送HTTP请求时,需要注意对参数进行适当的编码和处理,以确保数据的安全性和完整性。

另外,在使用urllib 发送请求时,也需要处理可能出现的异常,如网络连接问题、服务器错误等,以保证程序的稳定性和可靠性。

总之,urllib库提供了丰富的参数和功能,能够满足大部分的URL处理需求,同时也需要开发者根据具体的情况选择合适的参数和处理方式,以确保程序的正常运行和数据的安全传输。

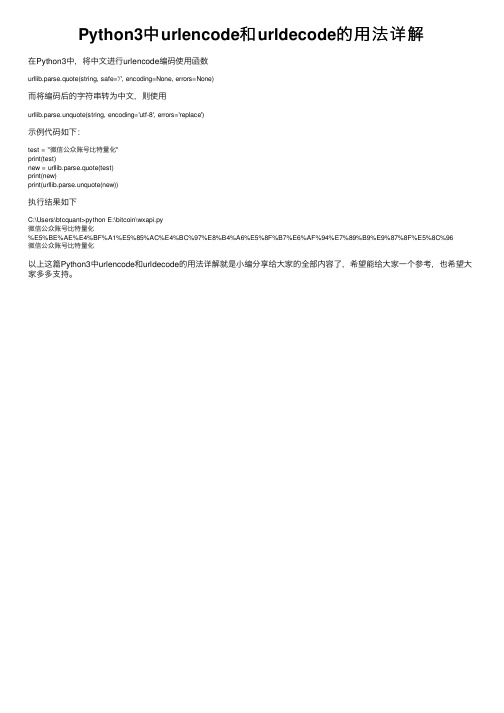

Python3中urlencode和urldecode的用法详解

urllib.parse.unquote(string, encoding='utf-8', errors='replace')

示例代码如下:

test = "微信公众账号比特量化" print(test) new = urllib.parse.quote(test) print(new) print(urllib.parse.unquote(new))

计算机中的变量是实际存在的数据或者说是存储器中存储数据的一块内存空间变量的值可以被读取和修改这是所有计算机和控制的基础下面详细内容需要的朋友可以参考一下

Python3中 urlencode和 urldecode的用法详解

在Python3中,将中文进行urlencode编码使用函数

urllib.parse.quote(string, safe='/', encoding=None, errors=None)

执行结果如下

C:\Users\btcquant>python E:\bitcoin\wxapi.py 微信公众账号比特量化 %E5%BE%AE%E4%BF%A1%E5%85%AC%E4%BC%97%E8%B4%A6%E5%8F%B7%E6%AF%94%E7%89%B9%E9%87%8F%E5%8C%96 微信公众账号比特量化

以上这篇Python3中urlencode和urldecode的用法详解就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大 家多

Pythonurllib3模块详解

Pythonurllib3模块详解Urllib3是⼀个功能强⼤,条理清晰,⽤于HTTP客户端的Python库,许多Python的原⽣系统已经开始使⽤urllib3。

Urllib3提供了很多python 标准库⾥所没有的重要特性: 1、线程安全 2、连接池 3、客户端SSL/TLS验证 4、⽂件分部编码上传 5、协助处理重复请求和HTTP重定位 6、⽀持压缩编码 7、⽀持HTTP和SOCKS代理 8、 100%测试覆盖率 Urllib3功能⾮常强⼤,但是⽤起来却⼗分简单:安装: Urllib3 能通过pip来安装: $pip install urllib3 你也可以在github上下载最新的源码,解压之后进⾏安装: $git clone git:///shazow/urllib3.git $python setup.py installurllib3的使⽤:⽣成请求(request): ⾸先,你必须导⼊urllib3模块: 然后你需要⼀个PoolManager实例来⽣成请求,由该实例对象处理与线程池的连接以及线程安全的所有细节,不需要任何⼈为操作: 通过request()⽅法创建⼀个请求: request()⽅法返回⼀个HTTPResponse对象。

你还可以通过request()⽅法向请求(request)中添加⼀些其他信息,如: 请求(request)中的数据项(request data)可包括:Headers: 在request()⽅法中,可以定义⼀个字典类型(dictionary),并作为headers参数传⼊:Query parameters: 对于GET、HEAD和DELETE请求,可以简单的通过定义⼀个字典类型作为fields参数传⼊即可: 对于POST和PUT请求(request),需要⼿动对传⼊数据进⾏编码,然后加在URL之后:Form data: 对于PUT和POST请求(request),urllib3会⾃动将字典类型的field参数编码成表格类型.JSON: 在发起请求时,可以通过定义body 参数并定义headers的Content-Type参数来发送⼀个已经过编译的JSON数据:Files & binary data: 使⽤multipart/form-data编码⽅式上传⽂件,可以使⽤和传⼊Form data数据⼀样的⽅法进⾏,并将⽂件定义为⼀个元组的形式 (file_name,file_data): ⽂件名(filename)的定义不是严格要求的,但是推荐使⽤,以使得表现得更像浏览器。

Python3实现抓取javascript动态生成的html网页功能示例

Python3实现抓取javascript动态⽣成的html⽹页功能⽰例本⽂实例讲述了Python3实现抓取javascript动态⽣成的html⽹页功能。

分享给⼤家供⼤家参考,具体如下:⽤urllib等抓取⽹页,只能读取⽹页的静态源⽂件,⽽抓不到由javascript⽣成的内容。

究其原因,是因为urllib是瞬时抓取,它不会等javascript的加载延迟,所以页⾯中由javascript⽣成的内容,urllib读取不到。

那由javascript⽣成的内容就真的没有办法读取了吗?⾮也!这⾥要介绍⼀个python库:selenium,本⽂使⽤的版本是 2.44.0先安装:pip install -U selenium下⾯⽤三个例⼦来说明其⽤法:【例0】打开⼀个Firefox浏览器载⼊所给url地址的页⾯from selenium import webdriverbrowser = webdriver.Firefox()browser.get('/')【例1】打开⼀个Firefox浏览器载⼊百度主页搜索 “seleniumhq”关闭浏览器from selenium import webdriverfrom mon.keys import Keysbrowser = webdriver.Firefox()browser.get('')assert '百度' in browser.titleelem = browser.find_element_by_name('p') # Find the search boxelem.send_keys('seleniumhq' + Keys.RETURN) # 模拟按键browser.quit()【例2】Selenium WebDriver 常⽤于⽹络程序的测试。

下⾯是⼀个使⽤Python标准库 unittest 的例⼦:import unittestclass BaiduTestCase(unittest.TestCase):def setUp(self):self.browser = webdriver.Firefox()self.addCleanup(self.browser.quit)def testPageTitle(self):self.browser.get('')self.assertIn('百度', self.browser.title)if __name__ == '__main__':unittest.main(verbosity=2)更多关于Python相关内容感兴趣的读者可查看本站专题:《》、《》、《》、《》、《》、《》及《》希望本⽂所述对⼤家Python程序设计有所帮助。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Python3中urllib详细使用方法_光环大数据Python培训python3 抓取网页资源的 N 种方法1、最简单import urllib.requestresponse = urllib.request.urlopen(‘/’)html = response.read()2、使用 Requestimport urllib.requestreq = urllib.request.Request(‘/’)response = urllib.request.urlopen(req)the_page = response.read()3、发送数据#! /usr/bin/env python3import urllib.parseimport urllib.requesturl = ‘http://localhost/login.php’user_agent = ‘Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)’values = {‘act’ : ‘login’,‘login[email]’ : ‘yzhang@’,‘login[password]’ : ‘123456’}data = urllib.parse.urlencode(values)req = urllib.request.Request(url, data)req.add_header(‘Referer’, ‘/’)response = urllib.request.urlopen(req)the_page = response.read()print(the_page.decode(“utf8”))4、发送数据和header#! /usr/bin/env python3import urllib.parseimport urllib.requesturl = ‘http://localhost/login.php’user_agent = ‘Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)’values = {‘act’ : ‘login’,‘login[email]’ : ‘yzhang@’,‘login[password]’ : ‘123456’}headers = { ‘User-Agent’ : user_agent }data = urllib.parse.urlencode(values)req = urllib.request.Request(url, data, headers)response = urllib.request.urlopen(req)the_page = response.read()print(the_page.decode(“utf8”))5、http 错误#! /usr/bin/env python3import urllib.requestreq = urlli b.request.Request(‘ ‘) try:urllib.request.urlopen(req)except urllib.error.HTTPError as e:print(e.code)print(e.read().decode(“utf8”))6、异常处理1#! /usr/bin/env python3from urllib.request import Request, urlopenfrom urllib.error import URLError, HTTPErrorreq = Request(“ /”)try:response = urlopen(req)except HTTPError as e:print(‘The server couldn’t fulfill the request.’) print(‘Error code: ‘, e.code)except URLError as e:print(‘We failed to reach a server.’)print(‘Reason: ‘, e.reason)else:print(“good!”)print(response.read().decode(“utf8”))7、异常处理2#! /usr/bin/env python3from urllib.request import Request, urlopenfrom urllib.error import URLErrorreq = Request(“ /”)try:response = urlopen(req)except URLError as e:if hasattr(e, ‘reason’):print(‘We failed to reach a server.’)print(‘Reason: ‘, e.reason)elif hasattr(e, ‘code’):print(‘The server couldn’t fulfill the request.’)print(‘Error code: ‘, e.code)else:print(“good!”)print(response.read().decode(“utf8”))8、HTTP 认证#! /usr/bin/env python3import urllib.request# create a password managerpassword_mgr = urllib.request.HTTPPasswordMgrWithDefaultRealm()# Add the username and password.# If we knew the realm, we could use it instead of None.top_level_url = “https:// /”password_mgr.add_password(None, top_level_url, ‘rekfan’, ‘xxxxxx’)handler = urllib.request.HTTPBasicAuthHandler(password_mgr)# create “opener” (OpenerDirector insta nce)opener = urllib.request.build_opener(handler)# use the opener to fetch a URLa_url = “https:// /”x = opener.open(a_url)print(x.read())# Install the opener.# Now all calls to urllib.request.urlopen use our opener.urllib.request.install_opener(opener)a = urllib.request.urlopen(a_url).read().decode(‘utf8’)print(a)9、使用代理#! /usr/bin/env python3import urllib.requestproxy_support = urllib.request.ProxyHandler({‘sock5’: ‘localhost:1080’})opener = urllib.request.build_opener(proxy_support)urllib.request.install_opener(opener)a = urllib.request.urlopen(“ “).read().decode(“utf8”)print(a)10、超时#! /usr/bin/env python3import socketimport urllib.request# timeout in secondstimeout = 2socket.setdefaulttimeout(timeout)# this call to urllib.request.urlopen now uses the default timeout # we have set in the socket modulereq = urllib.request.Request(‘ /’)a = urllib.request.urlopen(req).read()print(a)为什么大家选择光环大数据!大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请大数据领域具有多年经验的讲师,提高教学的整体质量与教学水准。

讲师团及时掌握时代的技术,将时新的技能融入教学中,让学生所学知识顺应时代所需。

通过深入浅出、通俗易懂的教学方式,指导学生较快的掌握技能知识,帮助莘莘学子实现就业梦想。

光环大数据启动了推进人工智能人才发展的“AI智客计划”。

光环大数据专注国内大数据和人工智能培训,将在人工智能和大数据领域深度合作。

未来三年,光环大数据将联合国内百所大学,通过“AI智客计划”,共同推动人工智能产业人才生态建设,培养和认证5-10万名AI大数据领域的人才。

参加“AI智客计划”,享2000元助学金!【报名方式、详情咨询】光环大数据网站报名:手机报名链接:http:// /mobile/。