什么是查准率和查全率(precision and recall) GooSeeker

机器学习算法在推荐系统中的效果评估方法

机器学习算法在推荐系统中的效果评估方法推荐系统是现代电商平台、社交媒体和音乐视频网站等各类在线应用中的重要组成部分。

推荐系统通过收集用户的历史行为数据和个人特征来学习用户的兴趣爱好,并根据这些信息为用户提供个性化的推荐内容。

机器学习算法在推荐系统中发挥着重要的作用,而评估机器学习算法在推荐系统中的效果是推荐系统设计和优化的关键一环。

评估推荐系统的效果是为了了解算法设计和改进的效果,验证模型的准确性和可靠性,并为优化推荐算法提供指导。

以下将介绍一些常见的机器学习算法在推荐系统中的效果评估方法。

1. 准确率和召回率(Precision & Recall)准确率和召回率是衡量推荐系统效果最常用的指标之一。

准确率(Precision)是指推荐的物品中用户感兴趣的物品的占比,即正确推荐的物品个数与总推荐的物品个数的比例;召回率(Recall)是指正确推荐的物品个数与用户感兴趣的物品个数的比例。

准确率和召回率都是关于推荐结果的。

2. 覆盖率(Coverage)覆盖率是指推荐系统能够推荐到的物品在总物品集合中的比例。

高覆盖率意味着推荐系统能够提供更全面和多样化的推荐结果,能够满足用户的不同兴趣。

3. 多样性(Diversity)多样性是指推荐结果的差异程度。

多样性高的推荐系统可以为用户提供更多样化和广泛的推荐内容,避免了重复和单一化的推荐结果。

4. 信任度(Trust)信任度是指推荐系统对用户喜好的理解程度。

推荐系统需要通过学习用户的历史行为和个人特征来准确地推测用户的兴趣爱好,以便提供符合用户偏好的推荐结果。

5. 实时性(Real-time)实时性是指推荐系统对用户行为及时响应的能力。

用户希望系统能够及时地提供个性化的推荐结果,降低用户等待时间。

在推荐系统中,以上评估方法可以单独或者综合使用。

一般来说,准确率和召回率被认为是最为重要的指标,因为它们直接衡量了推荐结果的正确性和覆盖范围。

为了准确评估机器学习算法在推荐系统中的效果,还需要使用一些评估工具和方法,例如交叉验证和A/B测试。

信息检索的查全率和查准率研究

信息检索的查全率和查准率摘要针对衡量文献信息检索效果的主要技术指标查全率与查准率,提出了以灵活运用算符为基础的提高查全率与查准率的文献信息检索方法。

关键词文献检索信息检索文献信息查全率查准率文献检索是科研的基本功,阅读文献是科研人员获取科研信息的重要途径。

评价文献检索质量的两个最重要的指标是查全率和查准率。

查全率指的是检出的相关文献量与系统文献库中相关文献总量的比率,它反映该系统文献库中实有的相关文献量在多大程度上被检索出来。

查全率 = 检出相关文献量 / 文献库内相关文献总量× 100% 。

查准率指的是是指检出的相关文献量与检出文献总量的比率,是衡量信息检索系统检出文献准确度的尺度。

查全率 = 检出的相关文献篇数/检出的全部文献篇数× 100%。

查全率与查准率在一定程度上是成反比关系的,为了提高查全率就要以牺牲部分查准率为代价,反之亦然。

在不同的情况下,对二者的要求也不同,有时文献的全面更为重要,这时就要以提高查全率为重点,有时希望找到的文献准确率更高,就以提高查准率为重点。

本文讨论的是怎样提高文献的查全率。

1 检索词的转换。

常见的转换是同义词、近义词、相关词、单复数及缩写形式,如果是动词还有可能有不同的时态。

每一个检索词都有可能有多种表达形式,如果是由英文翻译过来的还有可能有多种翻译方法,所以应该尽可能找全检索词的所有同义词、近义词。

相关词指的是与检索词不是同一个意思但是有关联的词。

如,META分析的同义词包括元分析、荟萃分析、meta-analysi s,近义词包括系统综述,相关词为循证医学。

前列腺癌的缩写可能是Pca等等。

值得注意的是,在检索中文文献的时候,有必要把英文的全称和缩写也作为检索词,因为有些中文文章中是直接用英文词汇表示的。

机器学习之常用的分类模型评价指标

机器学习之常用的分类模型评价指标常用的分类模型评价指标是衡量机器学习模型在分类问题上的性能的指标,用于评估模型的准确性和可靠性。

以下是常用的分类模型评价指标:1. 准确率(Accuracy):准确率是最简单直观的评价指标,表示模型正确预测样本的比例。

准确率定义为:准确率 = (正确预测的样本数)/ (总样本数)。

2. 精确度(Precision):精确度衡量模型预测为正样本的准确率,即在所有预测为正样本中,有多少是真正的正样本。

精确度定义为:精确度 = (真正的正样本数) / (预测的正样本数)。

3. 召回率(Recall):召回率衡量模型对正样本的识别能力,即在所有真正的正样本中,有多少被正确预测出来。

召回率定义为:召回率 = (真正的正样本数) / (真正的正样本数 + 假负样本数)。

4. F1分数(F1 Score):F1分数综合考虑了精确度和召回率,用于衡量模型的综合性能。

F1分数定义为:F1=2*(精确度*召回率)/(精确度+召回率)。

5. 特异度(Specificity):特异度衡量了模型对负样本的识别能力,即在所有真正的负样本中,有多少被正确预测出来。

特异度定义为:特异度 = (真正的负样本数) / (真正的负样本数+假正样本数)。

6. 假正例率(False Positive Rate,FPR):假正例率衡量了模型将负样本错误预测为正样本的能力。

FPR定义为:FPR = (假正样本数) / (真负样本数 + 假正样本数)。

7. AUC-ROC:AUC-ROC(Area Under the Receiver Operating Characteristic Curve)是ROC曲线下的面积,用于衡量模型分类准确性的整体能力。

AUC-ROC的取值范围为0.5到1,值越接近1表示模型性能越好。

8. 查准率-查全率曲线(Precision-Recall Curve):查准率-查全率曲线绘制了不同阈值下的查准率和查全率之间的关系。

数据分析模型评价常用指标

数据分析模型评价常用指标1. 精确度(Accuracy):精确度是指模型正确预测的样本数量与总样本数量的比例。

这是最常用的指标之一,但对于不平衡数据集可能不够准确。

例如,如果有95%的样本属于类别A,那么一个简单的模型可以将所有样本都预测为类别A,其精确度也将达到95%。

因此,对于不平衡数据集,其他指标会更有价值。

2. 召回率(Recall):召回率是正例被正确预测的比例。

它衡量了模型对正例样本的查找能力。

如果数据集中存在重要的正例,如欺诈行为检测或疾病预测,在这种情况下召回率是一个更重要的指标。

3. 准确率(Precision):准确率是样本被正确预测的比例。

它测量了模型预测为正例的样本中有多少是真正的正例。

准确率与召回率是一对相互矛盾的指标,因为提高准确率可能会导致召回率降低,反之亦然。

4. F1值(F1-Score):F1值是精确度和召回率的加权平均值。

它在查准率和查全率之间寻找折中点,并提供了模型整体性能的度量。

F1值是一个常用的指标,特别适用于不平衡数据集。

5. AUC-ROC:AUC-ROC是面积下ROC曲线的度量。

ROC曲线是以真正例率(True Positive Rate)为纵轴,以假正例率(False Positive Rate)为横轴的二维图形。

AUC-ROC度量了模型在不同阈值下的性能,数值范围从0到1,值越接近1,模型性能越好。

6. 平均绝对误差(Mean Absolute Error,MAE):MAE是实际值与预测值之间差异的平均绝对值。

MAE给出了模型预测误差的平均大小,它可以帮助分析师理解模型的鲁棒性和效果。

MAE的值越小,模型的性能越好。

7. 均方误差(Mean Squared Error,MSE):MSE是实际值与预测值之间差异的平方的平均值。

MSE比MAE更加敏感,这是因为它对预测误差较大的样本给予了更大的权重。

MSE的值越小,模型的性能越好。

8. R平方(R-squared):R平方是模型解释因变量方差的比例。

人脸识别算法的性能参数评估方法

人脸识别算法的性能参数评估方法人脸识别技术是一种利用计算机视觉和模式识别技术来对人脸图像进行检测、识别和验证的技术。

随着人工智能的发展,人脸识别算法得到了广泛应用,涉及到安全领域、人机交互、社交娱乐等方面。

为了对人脸识别算法进行有效评估,我们需要使用一系列的性能参数进行量化分析。

1. 准确率(Accuracy)准确率是评估人脸识别算法性能的最基本指标之一,它反映了算法在识别任务中的成功率。

准确率通常使用以下公式进行计算:准确率 = 正确识别的样本数 / 总的样本数其中,正确识别的样本数指的是算法成功将输入的人脸图像与数据库中的正确样本进行匹配的数量。

总的样本数是指测试集中的样本总数。

2. 误识率(False Acceptance Rate, FAR)和拒识率(False Rejection Rate, FRR)误识率和拒识率是人脸识别算法中判决阈值设置的重要参数。

误识率是指在非目标人员的人脸图像中被错误地识别为目标人员的概率。

而拒识率则是指目标人员的人脸图像被错误地拒绝识别的概率。

通常情况下,误识率和拒识率呈反向关系,即降低误识率会导致拒识率增加,降低拒识率会导致误识率增加。

3. 精确率(Precision)和召回率(Recall)精确率和召回率是评估人脸识别算法性能的重要指标之一,主要用于衡量算法的准确性和对未知样本的适应能力。

精确率是指被算法正确判定为目标人员的样本数量与算法判定为目标人员的样本总数之比。

召回率是指被算法正确识别的目标人员样本数量与实际目标人员样本总数之比。

精确率 = 正确识别的目标人员样本数 / 算法判定为目标人员的样本总数召回率 = 正确识别的目标人员样本数 / 实际目标人员样本总数4. 响应时间(Response Time)响应时间是指算法在进行人脸识别时所花费的时间。

响应时间需要尽可能地短,以满足实时应用的需求。

人脸识别算法的响应时间包括图像预处理时间、特征提取时间、匹配计算时间等几个方面。

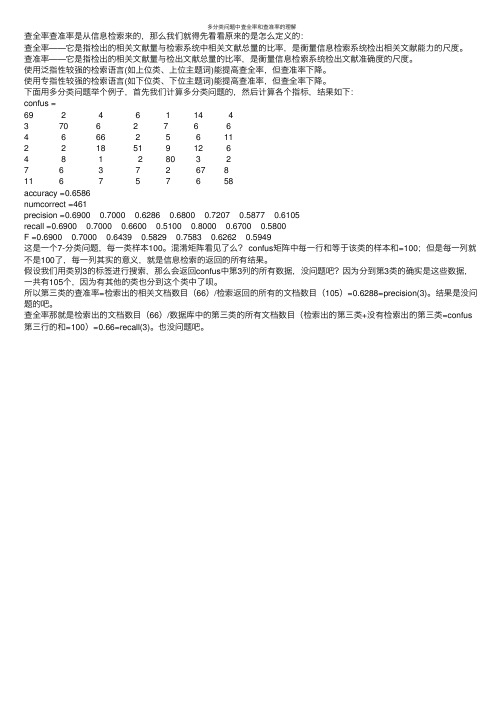

多分类问题中查全率和查准率的理解

多分类问题中查全率和查准率的理解查全率查准率是从信息检索来的,那么我们就得先看看原来的是怎么定义的:查全率——它是指检出的相关⽂献量与检索系统中相关⽂献总量的⽐率,是衡量信息检索系统检出相关⽂献能⼒的尺度。

查准率——它是指检出的相关⽂献量与检出⽂献总量的⽐率,是衡量信息检索系统检出⽂献准确度的尺度。

使⽤泛指性较强的检索语⾔(如上位类、上位主题词)能提⾼查全率,但查准率下降。

使⽤专指性较强的检索语⾔(如下位类、下位主题词)能提⾼查准率,但查全率下降。

下⾯⽤多分类问题举个例⼦,⾸先我们计算多分类问题的,然后计算各个指标,结果如下:confus =69 2 4 6 1 14 43 70 6 2 7 6 64 6 66 256 112 2 18 51 9 12 64 8 1 2 80 3 27 6 3 7 2 67 811 6 7 5 7 6 58accuracy =0.6586numcorrect =461precision =0.6900 0.7000 0.6286 0.6800 0.7207 0.5877 0.6105recall =0.6900 0.7000 0.6600 0.5100 0.8000 0.6700 0.5800F =0.6900 0.7000 0.6439 0.5829 0.7583 0.6262 0.5949这是⼀个7-分类问题,每⼀类样本100。

混淆矩阵看见了么? confus矩阵中每⼀⾏和等于该类的样本和=100;但是每⼀列就不是100了,每⼀列其实的意义,就是信息检索的返回的所有结果。

假设我们⽤类别3的标签进⾏搜索,那么会返回confus中第3列的所有数据,没问题吧?因为分到第3类的确实是这些数据,⼀共有105个,因为有其他的类也分到这个类中了呗。

所以第三类的查准率=检索出的相关⽂档数⽬(66)/检索返回的所有的⽂档数⽬(105)=0.6288=precision(3)。

精度评定中的准确率(Precision)和召回率(Recall)

精度评定中的准确率(Precision)和召回率(Recall)精度评定中的准确率(Precision)和召回率(Recall)在模式识别中,我们经常会使⽤到⼀些指标对⽬标识别或者影像分类的结果进⾏评价。

假设我们需要将⼀个样本集分类为苹果和⾮苹果两类,那么分类结果有四种情况:第⼀种情况:True Positive,本来就是苹果被分类成苹果;第⼆种情况:False Positive,本来不是苹果被分类成苹果;第三种情况:False Negative,本来是苹果被分类成⾮苹果;第四种情况:True Negative,本来不是苹果被分类成为⾮苹果。

True是指分类正确,False是指分类错误。

Positive是指被分类器分为苹果(正样本),Negative是指被分类器分为⾮苹果(负样本)。

这⾥我们引⼊三个指标来对分类器进⾏评价:(1)准确率(Precision),⼜称“精度”、“正确率”;(2)召回率(Recall),⼜称“查全率”;(3)F1-Score,准确率和召回率的综合指标。

⼀般来说,准确率和召回率反映了分类器性能的两个⽅⾯,单⼀依靠某个指标并不能较为全⾯地评价⼀个分类器的性能。

假如分类器只将苹果特征⼗分明显、是苹果的概率⾮常⾼的样本分为苹果,其余的样本分为⾮苹果,此时该分类器的准确率就会⾮常的⾼,但是它因为将所有疑似苹果都错误分为⾮苹果,召回率变得⾮常低。

假如分类器将所有可能为苹果的样本全部划分为苹果,其余的样本为⾮苹果,此时该分类器的召回率会⾮常之⾼,但是它因为将所有可能为苹果的样本分为苹果时引⼊了许多错误,准确率不可能⾼。

引⼊F1-Score作为综合指标,就是为了平衡准确率和召回率的影响,较为全⾯地评价⼀个分类器。

有时候考虑到不同的需求,可能会更看重准确率或者召回率。

这时我们可以引⼊F2-Score和F0.5-Score。

包括F1-Score,这三个指标都来⾃以下定义,只是参数不同。

其中,F1-Score是指准确率和召回率⼀样重要;F2-Score是指召回率⽐准确率重要⼀倍;F0.5-Score是指准确率⽐召回率重要⼀倍。

文献检索中查全率和查准率的定义

文献检索中查全率和查准率的定义

查全率(Recall ratio,也被称为召回率)和查准率(Precision ratio)是衡量信息检索系统中两个重要性能指标。

查全率是反映检索系统检出相关文献能力的一项指标,即从文献集合中成功检出的相关文献量占系统中全部相关文献总量的百分比。

其计算公式为:查全率=(检索出的相关信息量/系统中的相关信息总量)x100%。

查准率则是反映检索系统准确性的指标,它表示检出的相关文献数占所有检出文献总数的百分比。

换句话说,它是真实为正的样本中占预测为正的样本的比例。

其计算公式是:查准率=(检索出的相关信息量/检索出的信息总量)x100%。

这两个指标在实际应用中常常存在矛盾,一般来说,查准率高时,查全率往往偏低;反之,查全率高时,查准率往往偏低。

因此,在进行信息检索系统的性能评估时,需要同时考虑这两个指标,以实现更全面、准确的检索结果。

人工智能开发技术的模型评估指标解析

人工智能开发技术的模型评估指标解析在人工智能领域的快速发展中,各种算法模型被广泛应用于各种应用场景中。

然而,随着模型数量的不断增加,如何评估模型的好坏以及适用性成为了一个重要的问题。

为了解决这个问题,人们提出了各种模型评估指标。

本文将结合实际案例解析几个常见的模型评估指标。

一、准确率(Accuracy)准确率是最常见的模型评估指标之一。

它衡量了模型对于样本的分类准确度。

准确率的计算公式为:预测正确的样本数 / 总样本数。

然而,准确率并不是适用于所有场景的理想指标。

举个例子,假设我们有一个二分类问题,样本中正样本占比为95%,负样本占比为5%。

如果我们使用一个简单的模型,将所有样本都预测为正样本,那么准确率将达到95%。

但是,这样的模型明显是存在问题的,因为它无法对负样本进行准确预测。

因此,准确率并不能反映模型的真实性能。

二、精确率与召回率(Precision and Recall)精确率和召回率是在二分类问题中常用的模型评估指标。

精确率衡量了模型预测为正样本的样本中真正是正样本的比例,召回率衡量了模型正确预测为正样本的样本在所有真实正样本中的比例。

精确率的计算公式为:真正例 / 预测正例,召回率的计算公式为:真正例 / 所有正例。

当我们对某个问题更加关注准确预测正样本时,需要更加关注精确率;而当我们对于尽可能预测出真正正样本更感兴趣时,需要更加关注召回率。

三、F1值F1值是综合考虑精确率和召回率的指标。

它是精确率和召回率的调和平均数:2 * (精确率 * 召回率) / (精确率 + 召回率)。

F1值将精确率和召回率结合起来,可以在一定程度上反映模型的综合性能。

F1值越高,模型的性能越好。

四、ROC曲线和AUC值ROC曲线和AUC值是用于评估二分类模型的性能的常用方法。

ROC曲线是以模型真正例率(True Positive Rate)为纵轴,模型假正例率(False Positive Rate)为横轴,绘制的一条曲线。

什么是查准率和查全率(precisionandrecall)GooSeeker

什么是查准率和查全率(precisionandrecall)GooSeeker什么是查准率和查全率(precision and recall)查准率(Precision)和查全率(recall)应用在信息处理领域的多个子领域。

信息检索定义查准率和查全率用来衡量搜索引擎的性能查全率=(检索出的相关信息量/系统中的相关信息总量)*100% 查准率=(检索出的相关信息量/检索出的信息总量)*100%查全率是衡量检索系统和检索者检出相关信息的能力,查准率是衡量检索系统和检索者拒绝非相关信息的能力。

实验证明,在查全率和查准率之间存在着相反的相互依赖关系--如果提高输出的查全率,就会降低其查准率,反之亦然。

局限性查全率的局限性主要表现在:查全率是检索出的相关信息量与存储在检索系统中的全部相关信息量之比,但系统中相关信息量究竟有多少一般是不确知的,只能估计;另外,查全率或多或少具有“假设”的局限性,这种“假设”是指检索出的相关信息对用户具有同等价值,但实际并非如此,对于用户来说,信息的相关程度在某种意义上比它的数量重要得多。

查准率的局限性主要表现在:如果检索结果是题录式而非全文式,由于题录的内容简单,用户很难判断检索到的信息是否与课题密切相关,必须找到该题录的全文,才能正确判断出该信息是否符合检索课题的需要;同时,查准率中所讲的相关信息也具有“假设”的局限性。

信息提取查全率和查准率还可以应用到信息提取子领域,用于衡量信息提取器的性能。

查全率(Recall)是测量被正确提取的信息的比例,而查准率(Precision)用来测量提取出的信息中有多少是正确的。

计算公式如下(P是查准率,R是查全率):查准率 = 提取出的正确信息条数 / 提取出的信息条数查全率 = 提取出的正确信息条数 / 样本中的信息条数两者取值在0和1之间,数值越接近1,查全率或查准率就越高。

除此两指标以外,还有F值评价方法,是查全率和查准率的加权几何平均值:F = (b^2 + 1) * PR / b^2P + R其中:b 是一个预设值,是P和R的相对权重,b大于1时表示P 更重要,b小于1时表示R更重要。

Solr基础理论【排名检索、查准率、查全率】

Solr基础理论【排名检索、查准率、查全率】⼀.排名检索 搜索引擎代表了基于查询,返回优先⽂档的⼀种⽅法。

在关系型数据库的SQL查询中,表的⼀⾏要么匹配⼀个查询,要么不匹配,查询结果基于⼀列或多列排序。

搜索引擎根据⽂档与查询匹配的程度为⽂档打分,并按降序返回结果。

匹配程度的计算取决于多个因素,⼀般⽽⾔,⽂档得分越⾼意味着该⽂档与查询的相关性越强。

在Solr中会存在单独的字段保存相关性,那就是score字段。

在score字段的得分数值并⾮具有绝对意义,它在lucene内部仅作为相对排名,⽽且同⼀⽂档在不同的查询中的得分并⽆关系。

也就是说,与查询匹配的⽂档相关度得分仅适⽤于该查询。

返回的结果按照得分从低到⾼排序,⽂档得分越⾼。

说明与该查询越相关。

优点: 1.提供清晰的导航⽅式,把⽤户越需要的放在越靠前的位置。

2.智能化程度⾼,⽤户⽆需考虑排序问题。

⼆.查准率 查准率【Precision,精度性的度量】的具体定义如下:正确匹配的⽂档数量/返回的⽂档数量【介于0.0~1.0之间】,例如: 假设某次搜索返回的⽂档集合为⽂档1、2、3,那么该查询的查准率为1.0【3个正确匹配/3个全部匹配】,这是理想状态。

但是,如果返回全部6个结果,那么查准率仅为0.5,因为返回的结果中有⼀半是不相关的。

同样地,如果只返回⼀个相关⽂档【⽐如⽂档1】,那么查准率依然是1.0,因为返回的结果都是匹配的。

可见,查准率是衡量结果与查询是否相关的⼀个指标,但是它并不关注全⾯性,即使只返回了100个匹配⽂档中的1个,查准率依然为1.0【返回的⽂档中没有不匹配⽂档】。

由于查准率仅考虑了返回结果的整体精确性,⽽未考虑结果集的全⾯性,因此需要将查全率与查准率配合使⽤。

三.查全率 查全率【Recall,全⾯性的度量,也称召回率】衡量的是搜索结果的全⾯性。

定义如下:返回的正确匹配的⽂档数/全部正确匹配的⽂档数。

如果仅返回⼀个匹配⽂档,则查全率为1/3,因为没有找到其它两个应该匹配的⽂档【此时查准率为1.0】。

precision recall的定义

precision recall的定义Precision和Recall是在信息检索和机器学习中经常使用的两个指标,用于评估分类器的性能。

Precision(精确率)指的是分类器判断为正例的样本中,实际为正例的比例;而Recall(召回率)指的是实际为正例的样本中,被分类器正确判断为正例的比例。

在信息检索领域,Precision和Recall经常被用来评估搜索引擎的性能。

Precision表示搜索结果中相关文档的比例,Recall表示相关文档在所有相关文档中被搜索到的比例。

搜索引擎的目标是尽可能提高Precision的同时保持较高的Recall,以便用户能够快速找到相关的信息。

在机器学习中,Precision和Recall用于评估分类器在二分类问题中的性能。

在一个二分类问题中,通常会将某一类别定义为正例,另一类别定义为负例。

Precision表示分类器正确判断为正例的样本中,实际为正例的比例;Recall表示实际为正例的样本中,被分类器正确判断为正例的比例。

Precision和Recall的取值范围都是0到1之间,数值越高表示性能越好。

当Precision和Recall都较高时,表示分类器具有较好的准确性和召回性。

然而,Precision和Recall往往存在一种权衡关系。

当我们尝试提高Precision时,可能会导致Recall的降低;反之亦然。

这是因为在分类器判断为正例的样本中,有可能存在一些实际为负例的样本,这些样本被错误地判断为正例,从而降低了Precision;而在实际为正例的样本中,有可能存在一些被错误地判断为负例的样本,从而降低了Recall。

为了综合考虑Precision和Recall,在机器学习中通常会使用F1 Score来评估分类器的性能。

F1 Score是Precision和Recall的调和平均数,它的取值范围也是0到1之间,数值越高表示性能越好。

F1 Score的计算公式为:F1 Score = 2 * (Precision * Recall) / (Precision + Recall)。

衡量机器学习模型的三大指标:准确率、精度和召回率。

衡量机器学习模型的三⼤指标:准确率、精度和召回率。

连接来源: 倾向于使⽤准确率,是因为熟悉它的定义,⽽不是因为它是评估模型的最佳⼯具!精度(查准率)和召回率(查全率)等指标对衡量机器学习的模型性能是⾮常基本的,特别是在不平衡分布数据集的案例中,在周志华教授的「西⽠书」中就特别详细地介绍了这些概念。

什么是分布不平衡的数据集? 倘若某⼈声称创建了⼀个能够识别登上飞机的恐怖分⼦的模型,并且准确率(accuracy)⾼达 99%。

你相信吗?好了,有这么⼀个模型:将从美国机场起飞的所有乘客简单地标注为⾮恐怖分⼦。

已知美国全年平均有 8 亿⼈次的乘客,并且在 2000-2017 年间共发现了 19 名恐怖分⼦,这个模型达到了接近完美的准确率——99.9999999%。

尽管这个模型拥有接近完美的准确率,但是在这个问题中准确率显然不是⼀个合适的度量指标。

恐怖分⼦检测是⼀个不平衡的分类问题:我们需要鉴别的类别有两个——恐怖分⼦和⾮恐怖分⼦,其中⼀个类别代表了极⼤多数的数据点。

另⼀个不平衡分类问题出现在当疾病在公众中的发病率很低时的疾病监测。

在这两种情况下,正例类别——疾病或恐怖分⼦,远远少于负例类别的数量。

这种问题是数据科学中⽐较常见的例⼦,其中准确率并不是评估模型性能的很好的衡量标准。

直观地说,我们应该聚焦于正例(恐怖分⼦)的识别。

⼀、召回率 我们应该最⼤化的是统计学上称为召回率或查全率(recall)的衡量指标,或者是最⼤化模型找到数据集中所有相关案例的能⼒。

召回率=真正例/(真正例+假反例)。

也就是正确判为恐怖分⼦占实际所有恐怖分⼦的⽐例。

你可能注意到了这个等式中的⼀些细节:如果我们将所有的个体都预测为恐怖分⼦,那么模型的召回率就是 1.0!因为预测所有⼈都是恐怖分⼦,⾃然包括了恐怖分⼦。

分号上⾯terrorists correctly identified=全部恐怖分⼦数。

分母terrorists incorrectly labeled as not terrorists=0。

precision recall的定义

precision recall的定义Precision和Recall是在信息检索和机器学习领域常用的评估指标。

它们用于衡量分类模型的性能,并且在许多实际应用中都起着重要的作用。

本文将对Precision和Recall的定义和计算方法进行详细介绍,并探讨它们在实际应用中的意义和应用场景。

我们来定义Precision和Recall。

Precision(精确率)是指在所有被分类器判定为正例的样本中,实际为正例的样本所占的比例。

Recall(召回率)是指在所有实际为正例的样本中,分类器判定为正例的样本所占的比例。

换句话说,Precision衡量的是分类器判定为正例中的正确率,而Recall衡量的是所有实际为正例的样本中被正确判定为正例的比例。

接下来,我们来看一下Precision和Recall的计算方法。

假设有一个二分类模型,输出结果为正例或负例。

在测试集中,我们有以下四种情况:- True Positive(真正例):实际为正例的样本被正确判定为正例。

- False Positive(假正例):实际为负例的样本被错误地判定为正例。

- False Negative(假反例):实际为正例的样本被错误地判定为负例。

- True Negative(真反例):实际为负例的样本被正确判定为负例。

Precision的计算公式为:Precision = True Positive / (TruePositive + False Positive)。

它衡量的是分类器判定为正例中的正确率。

Recall的计算公式为:Recall = True Positive / (True Positive + False Negative)。

它衡量的是所有实际为正例的样本中被正确判定为正例的比例。

接下来,我们来探讨Precision和Recall在实际应用中的意义和应用场景。

Precision和Recall通常是相互关联的,改变一个指标的取值会影响另一个指标的取值。

查全率查准率的标准

查全率查准率的标准

查全率和查准率是评估分类模型性能的重要指标,尤其在信息检索、医学诊断和机器学习等领域中常被使用。

它们衡量了模型在识别正例和负例方面的表现。

- 查全率(Recall):也称为敏感度(Sensitivity)或真正例率(True Positive Rate)。

它衡量了模型正确识别出的正例(True Positive)占所有实际正例的比例。

TP(True Positive)是真正例数量,FN(False Negative)是假负例数量。

- 查准率(Precision):也称为准确率(Accuracy)或阳性预测值(Positive Predictive Value)。

它衡量了模型正确识别出的正例占所有被识别为正例的样本的比例。

其中,TP(True Positive)是真正例数量,FP(False Positive)是假正例数量。

这两个指标都是重要的,但在某些场景下,优化其中一个指标可能会影响另一个。

通常情况下,提高查全率可能会导致降低查准率,反之亦然。

因此,权衡这两个指标是很重要的。

标准并没有固定的值,它们的重要性取决于具体的应用和场景。

在某些情况下,更看重查全率,因为需要尽可能少地遗漏真正例;在另一些情况下,更看重查准率,因为需要确保被识别为正例的样本是尽可能准确的。

在实际应用中,人们可能会采用F1分数(F1 Score)来综合考虑查全率和查准率。

F1分数是查全率和查准率的调和平均数,它可以提供对两者的平衡考量。

排序 评估指标

排序评估指标主要有以下几种:

1. 查准率(Precision):查准率是指在一个排序列表中,真正相关的文档占所有被检索出来的文档的比例。

2. 查全率(Recall,也称为召回率):查全率是指在一个排序列表中,真正相关的文档被检索出来的比例。

3. F-Score:F-Score是查准率和查全率的调和平均值,用于综合考虑查准率和查全率。

4. AUC(Area Under Curve):当样本不平衡时,AUC通过对ROC曲线下各部分的面积求和而得,用于评估分类器的性能。

5. Precision@K:Precision@K是在排序列表中前K个结果中,真正相关的文档占K个文档的比例。

6. AP(Average Precision):AP是Precision@K的平均值,用于评估排序列表的整体性能。

7. MAP(Mean Average Precision):MAP是不同请求/query的AP的平均值,用于评估排序列表的整体性能。

8. MRR(Mean reciprocal rank):MRR是另一种对排序列表进行评价的指标,MRR定义为表示第i个查询第一个相关结果在列表中的位置。

9. DCG@K(Discounted cumulative gain):DCG@K是一种考虑了排序位置的评估指标,越靠前的结果得分越高。

这些指标可以单独或结合使用,以全面评估排序列表的性能。

查准率的概念

查准率的概念查准率(Precision)是指分类模型在预测为正例的样本中,真正例所占的比例。

在二分类问题中,查准率可以用以下公式表示:Precision = 真正例数/ (真正例数+ 假正例数)其中,真正例数表示模型正确预测为正例的样本数量,假正例数表示模型错误预测为正例的样本数量。

查准率是评估分类模型性能的重要指标之一,它衡量的是模型的准确性,即模型预测为正例的样本中,有多少是真正的正例。

较高的查准率意味着模型预测为正例的样本中,有较少的假正例,模型的误识别率较低,具有较高的可靠性。

例如,假设有一个二分类模型,它预测了100个样本为正例,其中有80个是真正的正例,而20个是假正例。

那么这个模型的查准率就是80%。

这意味着在模型预测为正例的样本中,有80%是真正的正例。

查准率与其他指标的关系:与查准率密切相关的有几个其他的指标,包括查全率(Recall)和F1分数(F1 Score)。

- 查全率是指分类模型在所有实际为正例的样本中,被模型正确预测为正例的比例。

查全率用以下公式表示:Recall = 真正例数/ (真正例数+ 假反例数)其中,假反例数表示模型错误预测为负例的样本数量。

查全率衡量的是模型对正例的覆盖程度,即模型能够发现多少真正的正例。

较高的查全率意味着模型能够更好地发现真正的正例,但可能会导致误判负例为正例,即假正例的数量较多。

- F1分数是查准率和查全率的综合评价指标,它是查准率和查全率的调和平均。

F1分数可以用以下公式表示:F1 Score = 2 * Precision * Recall / (Precision + Recall)F1分数综合考虑了查准率和查全率,既关注了模型对正例的准确预测,也关注了模型对正例的发现能力。

较高的F1分数表示模型具有较好的预测准确性和较强的正例发现能力。

在实际应用中,查准率的选择取决于具体的需求。

如果对模型的准确性较为重要,希望尽量减少假正例的数量,那么应该选择较高的查准率;如果对模型的敏感性较为重要,希望能够更好地发现正例,那么应该选择较高的查全率。

precision和recall曲线

precision和recall曲线precision和recall曲线是在信息检索领域中常用的评估指标之一。

它们可以帮助我们评估一个分类模型的性能,特别是在处理不平衡数据集时非常有用。

首先,让我们来了解一下precision和recall的概念。

Precision(精确率)是指模型预测为正例中真正为正例的比例,即预测为正例且真实为正例的样本数除以预测为正例的样本数。

而Recall(召回率)是指真正为正例中被模型预测为正例的比例,即预测为正例且真实为正例的样本数除以真实为正例的样本数。

在信息检索中,我们通常将预测为正例的样本称为检索结果,而真实为正例的样本称为相关文档。

Precision和recall曲线可以帮助我们在不同的阈值下观察模型的性能变化。

具体来说,我们可以通过改变分类模型的阈值来调整模型的预测结果,从而得到不同的precision和recall值。

在绘制precision和recall曲线时,我们通常将recall作为横轴,precision作为纵轴。

我们可以通过改变分类模型的阈值,计算出不同的precision和recall值,并将这些值绘制在坐标系中。

通过连接这些点,我们就可以得到precision和recall曲线。

在precision和recall曲线中,我们通常会关注两个重要的点:P点和R点。

P点是指当recall为1时的precision值,即模型能够找到所有相关文档的能力。

R点是指当precision为1时的recall值,即模型能够找到所有检索结果的能力。

通常情况下,我们希望模型能够同时具备较高的precision和recall值,即曲线能够尽可能地靠近左上角。

通过观察precision和recall曲线,我们可以得到一些有用的信息。

首先,我们可以根据曲线的形状来判断模型的性能。

如果曲线呈现出一个陡峭的下降趋势,说明模型在某个阈值下的性能较差,可能存在较多的误判。

相反,如果曲线呈现出一个平缓的下降趋势,说明模型在不同阈值下的性能相对稳定。

查全率名词解释

查全率名词解释

查全率名词解释 1

查准率(精度)是衡量某一检索系统的信号噪声比的一种指标,即检出的相关文献与检出的全部文献的百分比。

它的数值等于w/m,式中w是用户鉴别检出的m篇文献时,认为实际对口径的文献篇数。

这一指标最初是1956年由J.W.佩里、A.肯特等人提出的。

F.W.兰开斯特1979年在《情报检索系统──特性、试验与评价》(第二版)一书中将某一系统所拥有的文献总篇数表述为a+b+c+d之和,并列出2×2表格。

普遍表示为:查准率=(检索出的相关信息量/检索出的信息总量)x100%

查全率名词解释 2

准确性标志着检索系统在操作过程中拒绝无关文档和选择相关文档的能力,也是用户从被检查文档中进一步选择相关文档所需时间的间接度量。

为了达到同样的查全率,高查准率意味着用户识别检索结果只需花费较少的时间,但这种度量主要适用于评价信息工作者代替用户进行检索的情况。

查全率名词解释 3

查全率与查准率为互逆相关性,查全率一般为60%~70%,查准率约为40%~50%,当查全率超过70%时,若想再提高查全率就必然降低查准率。

使用通用检索语言(如上级类别、上级关键词)可以提高查全率,但查准率下降。

使用特定的搜索语言(如从属类别和从属关键词)可以提高查准率,但查全率下降。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

什么是查准率和查全率(precision and recall)GooSeeker

什么是查准率和查全率(precision and recall)

查准率(Precision)和查全率(recall)应用在信息处理领域的多个子领域。

信息检索定义

查准率和查全率用来衡量搜索引擎的性能

查全率=(检索出的相关信息量/系统中的相关信息总量)*100%

查准率=(检索出的相关信息量/检索出的信息总量)*100%

查全率是衡量检索系统和检索者检出相关信息的能力,查准率是衡量检索系统和检索者拒绝非相关信息的能力。

实验证明,在查全率和查准率之间存在着相反的相互依赖关系--如果提高输出的查全率,就会降低其查准率,反之亦然。

局限性

查全率的局限性主要表现在:查全率是检索出的相关信息量与存储在检索系统中的全部相关信息量之比,但系统中相关信息量究竟有多少一般是不确知的,只能估计;另外,查全率或多或少具有“假设”的局限性,这种“假设”是指检索出的相

关信息对用户具有同等价值,但实际并非如此,对于用户来说,信息的相关程度在某种意义上比它的数量重要得多。

查准率的局限性主要表现在:如果检索结果是题录式而非全文式,由于题录的内容简单,用户很难判断检索到的信息是否与课题密切相关,必须找到该题录的全文,才能正确判断出该信息是否符合检索课题的需要;同时,查准率中所讲的相关信息也具有“假设”的局限性。

信息提取

查全率和查准率还可以应用到信息提取子领域,用于衡量信息提取器的性能。

查全率(Recall)是测量被正确提取的信息的比例,而查准率(Precision)用来测量提取出的信息中有多少是正确的。

计算公式如下(P是查准率,R是查全率):

查准率= 提取出的正确信息条数/ 提取出的信息条数

查全率= 提取出的正确信息条数/ 样本中的信息条数

两者取值在0和1之间,数值越接近1,查全率或查准率就越高。

除此两指标以外,还有F值评价方法,是查全率和查准率的加权几何平均值:

F = (b^2 + 1) * PR / b^2P + R

其中:b 是一个预设值,是P和R的相对权重,b大于1时表示P更重要,b小于1时表示R更重要。

通常设定为1,表示二者同等重要。

这样用F一个数值就可看出系统的好坏,F值也是越接近1越好。

文本分类

在文本分类领域,查准率和查全率还可以用来衡量文本分类器的性能。

例如,在观点挖掘(opinion mining)领域,衡量分类器识别出正面观点(positive opinion)的性能:

查准率= 识别出的真正的正面观点数/ 所有的识别为正面观点的条数

查全率= 识别出的真正的正面观点数/ 样本中所有的真正正面观点的条数

详细解释可以参看维基百科条目:

In a statistical classification task, the Precision for a class is the number of true positives (i.e. the number of items correctly labeled as belonging to the positive class) divided by the total number of elements labeled as belonging to the positive class (i.e. the sum of true positives and false positives, which are items incorrectly labeled as belonging to the class). Recall in this context is defined as the number of true positives divided by the total number of

elements that actually belong to the positive class (i.e. the sum of true positives and false negatives, which are items which were not labeled as belonging to the positive class but should have been).

In a classification task, a Precision score of 1.0 for a class C means that every item labeled as belonging to class C does indeed belong to class C (but says nothing about the number of items from class C that were not labeled correctly) whereas a Recall of 1.0 means that every item from class C was labeled as belonging to class C (but says nothing about how many other items were incorrectly also labeled as belonging to class C).

在观点挖掘领域还有一个有趣的应用(参看Bing Liu, "Sentiment Analysis and Subjectivity")

One of the bottlenecks in applying supervised learning is the manual effort involved in annotating a large number of training examples. To save the manual labeling effort, a bootstrapping approach to label training data automatically is reported in [80, 81]. The algorithm works by first using two high precision classifiers (HP-Subj and HP-Obj) to automatically identify some subjective and objective sentences. The high-precision classifiers use lists of lexical

items (single words or n-grams) that are good subjectivity clues. HP-Subj classifies a sentence as subjective if it contains two or more strong subjective clues. HPObj classifies a sentence as objective if there are no strongly subjective clues. These classifiers will give very high precision but low recall. The extracted sentences are then added to the training data to learn patterns. The patterns (which form the subjectivity classifiers in the next iteration) are then used to automatically identify more subjective and objective sentences, which are then added to the training set, and the next iteration of the algorithm begins.。