OpenMP简易教程

openMP入门

OpenMP 入门阅读(17)评论(1)发表时间:2009年05月06日 21:31本文地址:/blog/55032144-1241616677OpenMP是一个业界的标准,很早以前就有了,只是近一段时间才逐渐热起来。

我们可以在C/C++和Fortran使用OpenMP、很容易的引入多线程。

下图是一个典型的OpenMP程序的示意图,我们可以看到它是由串行代码和并行代码交错组成的,并行代码的区域我们把它叫做“并行区”。

主线程一旦进入并行区,就自动产生出多个线程,来并行的执行。

怎样在我们的代码中使用OpenMP呢?很简单,拿我们常用的C/C++代码来说,只需要插入如下pragma,然后我们选择不同的construct就可以完成不同的功能。

首先,我们来看一下如何创建一个并行区:增加一行代码#pragma omp parallel,然后用花括号把你需要放在并行区内的语句括起来,并行区就创建好了。

并行区里每个线程都会去执行并行区中的代码。

下面我们将看一个最简单的OpenMP代码,看看并行区是怎样工作的。

我们来看一个最简单的OpenMP程序例子:===================================#include <stdio.h>int main() {#pragma omp parallel{int i;printf("Hello World\n");for(i=0;i <6;i++)printf("Iter:%d\n",i);}printf("GoodBye World\n");}===================================我们现在用Intel编译器来编译这个小程序,当然你也可以用VS2005来编译。

我们可以看到编译器在没有加 /Qopenmp 开关的时候,会忽略掉所有openmp pragma。

OpenMP简介

OpenMP提供了schedule子句来实现任务的调度。

schedule子句

schedule(type, size), 参数type是指调度的类型,可以取值为static,dynamic,guided三种值。 参数size表示每次调度的迭代数量,必须是整数。该参数是可选的。 2. 3. 动态调度 启发式调度 dynamic guided 1. 静态调度 static 采用启发式调度方法进行调度,每次分配给线程迭代次数不同,开始比较大, 动态调度依赖于运行时的状态动态确定线程所执行的迭代,也就是线程执行完 static在编译的时候就已经确定了,那些循环由哪些线程执行。 以后逐渐减小。 已经分配的任务后,会去领取还有的任务。由于线程启动和执行完的时间不确 当不使用size 时,将给每个线程分配┌N/t┐个迭代。当使用size时,将每 size 表示每次分配的迭代次数的最小值,由于每次分配的迭代次数会逐渐减少, 定,所以迭代被分配到哪个线程是无法事先知道的。 次给线程分配size次迭代。 少到 size时,将不再减少。如果不知道 size的大小,那么默认size 为1 ,即一直减少 当不使用 size 时,是将迭代逐个地分配到各个线程。当使用 size 时,逐个 到1 。具体采用哪一种启发式算法,需要参考具体的编译器和相关手册的信息。 分配 size 个迭代给各个线程。

用for语句来分摊是由系统自动进行,只要每次循环间没有时间 上的差距,那么分摊是很均匀的,使用section来划分线程是一种手 工划分线程的方式,最终并行性的好坏得依赖于程序员。

OpenMP中的线程任务调度

OpenMP中任务调度主要针对并行的for循环,当循环中每次迭代的计算量 不相等时,如果简单地给各个线程分配相同次数的迭代,则可能会造成各个线 程计算负载的不平衡,影响程序的整体性能。

OpenMP程序演示

17

6.2.2 并行区域编程

循环并行化实际上是并行区域编程的一个特例, 本节介绍非循环的并行区域编程 并行区域简单说就是通过循环并行化编译指导语 句使得一段代码能够在多个线程内部同时执行。 并行区域编译指导语句的格式 #pragma omp parallel [clause[clause]…]

程序段2

程序段2运行结果

循环嵌套比较(程序段3、4)

int i;int j #pragma omp parallel for private(j) for(i=0; i<2; i++) for(j=6; j<10; j++) printf(“ i=%d j=%d\n”, i, j); 执行结果: i=0 j=6 i=1 j=6 i=0 j=7 i=1 j=7 i=0 j=8 i=1 j=8 i=1 j=9 i=0 j=9 int i;int j; for(i=0; i<2; i++) #pragma omp parallel for for(j=6; j<10; j++) printf("i=%d j=%d \n", i, j); 执行结果: i=0 j=6 i=0 j=8 i=0 j=9 i=0 j=7 i=1 j=6 i=1 j=8 i=1 j=7 i=1 j=9

2

OMP_NUM_THREADS=4

OMP_NUM_THREADS=2

设置环境OMP_NUM_THREADS的值

5

数据相关的概念

实例:

x[0] = 0; y[0] = 1; #pragma omp parallel for private(k) for (k = 1; k < 100; k++){ x[k] = y[k-1] + 1; //S1 y[k] = x[k-1] + 2; //S2 }

简易的程式平行化方法-OpenMP

簡易的程式平行化方法-OpenMP(一)簡介本文原發表於:/blog/cns!E0070FB8ECF9015F!1018.entry嗯~首先,Heresy 也是最近才開始試著用 openMP 的,所以其是這篇與其說是教學或介紹,倒不如說是學習心得會更為恰當。

會不會繼續用?說實話也是未知數。

總之,看著辦囉~也希望有人對這東西有研究的話,能多多指教。

多執行緒的概念目前雙核心的 CPU 當道,AMD 的 Athlon64x2、Intel 的 Pentium-D、Core Duo,以及即將上市的Core 2 Duo,儼然將成為下一代電腦的主流(尤其是超低價的 Pentium D,絕對是現階段 C/P 值極高的雙核心 CPU)。

但是雙核心有什麼用呢?對於一般單一執行緒(single thread)的程式,多核心的處理器並沒有辦法提升它的處理效能;不過對於多執行緒(multi thread)的程式,就可以透過不同的核心同時計算,來達到加速的目的了!簡單的例子,以單執行緒的程式來說,一件事做一次要十秒的話,要做十次,都丟給同一顆核心做的話,自然就是 10 秒 * 10 次,也就是 100 秒了;但是以多執行緒的程式來說,它可以把這一件事,分給兩顆核心各自做,每顆核心各做 5 次,所以所需要的時間就只需要 50 秒!當然,多執行緒的程式實際上沒這麼簡單。

在工作的切割、結合上,也是要多花時間的,所以在現實中,即使最佳狀況,雙核心的效能也不會是 1 + 1 = 2 這樣的理想化。

除此之外,也不是所有工作都是可以切割的!很多工作是有關聯性的,這樣如果直接切割給不同的處理核心各自去平行運算,出來的結果是肯定有問題的。

而且,多執行緒的程式在編寫、維護上,也都比單一執行緒的程式複雜上不少。

不過,如果電腦本身是多處理器、多核心處理器,或是處理器擁有像Intel Hyper-Threading Technology這類的能在同一個時間處理多個執行緒的功能的話,那把各自獨立的工作由單一執行緒改成多執行緒,在執行的效率上,大多還是會有增進的!多執行緒的程式寫程式的時候該怎麼去寫多執行緒的程式呢?一般的方法,就是真的利用 thread 的控制,去實際在程式中去產生其他的 thread 來處理。

OpenMP编程

1 体系结构

共享内存多处理器

内存是共享的,某一个处理器写入内存的数据 会立刻被其它处理器访问到。

处理器 P0 P1 P2 Pn

共享内存

分布式内存

每一个处理器或者一组处理器有一个自己私有 的内存单元 共享或者不共享一个公用的内存单元

5

2 OpenMP编程基础

以线程为基础,通过编译指导语句来显式地指导 并行化,为编程人员提供对并行化的完整控制。 采用Fork-Join的执行模式

21:14 30

并行for循环制导:调度子句SCHEDULE

schedule (dynamic [, chunksize]) :

划分迭代空间为chunksize大小的区间,然后基于先来先服务方式分配给各线程; 当省略chunksize时,其默认值为1。

类似于DYNAMIC调度,但区间开始大,然后迭代区间越来越少,循环区间的 划分是基于类似下列公式完成的(不同的编译系统可能不同):

28

并行for循环制导:调度子句SCHEDULE

该子句给出迭代循环划分后的块大小和线程执行的块范围 C/C++: schedule (kind,[ chunksize])

其中:kind为STATIC, DYNAMIC或RUNTIME chunksize是一个整数表达式

21:14

29

子句说明 schedule (static[, chunksize]) :

省略chunksize,迭代空间被划分成(近似)相同大小 的区域,每个线程被分配一个 区域; 如果chunksize被指明,迭代空间被划分为chunksize 大小,然后被轮转的分配给各个线程

openMP(并行计算) 超简单快速上手

openMP(并行计算)超简单快速上手简介:•OpenMp是并已被广泛接受的,用于共享内存并行系统的多处理器程序设计的一套指导性的编译处理方案。

•OpenMP支持的编程语言包括C语言、C++和Fortran;•OpenMp提供了对并行算法的高层的抽象描述,程序员通过在源代码中加入专用的pragma来指明自己的意图,由此编译器可以自动将程序进行并行化,并在必要之处加入同步互斥以及通信。

当选择忽略这些pragma,或者编译器不支持OpenMp时,程序又可退化为通常的程序(一般为串行),代码仍然可以正常运作,只是不能利用多线程来加速程序执行。

openMP并行化for循环(只需三步)1.vs等编译器中开启openMP支持2.将 Project 的Properties中C/C++里Language的OpenMP Support开启(参数为 /openmp)3.4.包含头文件5.#include<omp.h>6.7.在需要并行化的for循环前加入pragma指令8.#pragma omp parallel for9.这就三步就够了,是不是非常简单啊,赶快用起来吧。

使用技巧1.2.不是给所有的for都加并行化就会变更快,如果for的次数不是很多,就没必要使用并行了,反而会变慢3.多层for循环的情况#pragma omp parallel for是放在内层还是外层要视情况而定,绝对不能一概而论。

•如果内层的计算复杂度很高,比如循环次数多,每次循环计算量也比较大,放在内层可能效果要大大地好于外层。

•如果内层访问的内存比较多,#pragma omp parallel for放在外层的话,可能导致cache命中率大大降低,计算速度可能会是几十倍的下降。

openmp用法

openmp用法OpenMP是一种支持共享内存多线程编程的标准API。

它提供了一种简单而有效的方法,用于在计算机系统中利用多核和多处理器资源。

本文将逐步介绍OpenMP的用法和基本概念,从简单的并行循环到复杂的并行任务。

让我们一步一步来学习OpenMP吧。

第一步:环境设置要开始使用OpenMP,我们首先需要一个支持OpenMP的编译器。

常见的编译器如GCC、Clang和Intel编译器都支持OpenMP。

我们需要确保在编译时启用OpenMP支持。

例如,在GCC中,可以使用以下命令来编译包含OpenMP指令的程序:gcc -fopenmp program.c -o program第二步:并行循环最简单的OpenMP并行化形式是并行循环。

在循环的前面加上`#pragma omp parallel for`指令,就可以让循环被多个线程并行执行。

例如,下面的代码演示了如何使用OpenMP并行化一个简单的for循环:c#include <stdio.h>#include <omp.h>int main() {int i;#pragma omp parallel forfor (i = 0; i < 10; i++) {printf("Thread d: d\n", omp_get_thread_num(), i);}return 0;}在上面的例子中,`#pragma omp parallel for`指令会告诉编译器将for 循环并行化。

`omp_get_thread_num()`函数可以获取当前线程的编号。

第三步:数据共享与私有变量在并行编程中,多个线程可能会同时访问和修改共享的数据。

为了避免数据竞争和不一致的结果,我们需要显式地指定哪些变量是共享的,哪些变量是私有的。

我们可以使用`shared`和`private`子句来指定。

`shared`子句指定某个变量为共享变量,对所有线程可见。

linux openmp 例子程序

linux openmp 例子程序标题:Linux OpenMP例子程序1. OpenMP简介OpenMP是一种并行编程模型,可以在共享内存系统上实现并行计算。

它使用指令集和编译器指示来将串行代码转换为并行代码,从而实现更高效的计算。

2. Hello World程序下面是一个简单的OpenMP程序,用于打印“Hello World”:```c#include <stdio.h>#include <omp.h>int main() {#pragma omp parallel{int thread_id = omp_get_thread_num();printf("Hello World from thread %d\n", thread_id);}return 0;}```该程序使用了`#pragma omp parallel`指令来创建线程,并使用`omp_get_thread_num()`函数获取线程ID。

3. 并行for循环OpenMP可以很方便地并行化for循环。

下面是一个计算数组元素和的例子:```c#include <stdio.h>#include <omp.h>int main() {int sum = 0;#pragma omp parallel for reduction(+:sum)for (int i = 0; i < 100; i++) {sum += i;}printf("Sum: %d\n", sum);return 0;}```在上述代码中,`#pragma omp parallel for`指令将for循环并行化,`reduction(+:sum)`指示OpenMP将每个线程的局部和累加到全局和`sum`中。

4. 并行化矩阵乘法OpenMP也可以用于并行化矩阵乘法。

下面是一个简单的矩阵乘法示例:```c#include <stdio.h>#include <omp.h>#define N 100void matrix_multiply(int A[N][N], int B[N][N], int C[N][N]) {#pragma omp parallel forfor (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {C[i][j] = 0;for (int k = 0; k < N; k++) {C[i][j] += A[i][k] * B[k][j];}}}}int main() {int A[N][N];int B[N][N];int C[N][N];// 初始化A和B矩阵matrix_multiply(A, B, C);// 打印结果return 0;}```在上述代码中,`#pragma omp parallel for`指令将外层循环并行化,从而加快矩阵乘法的计算速度。

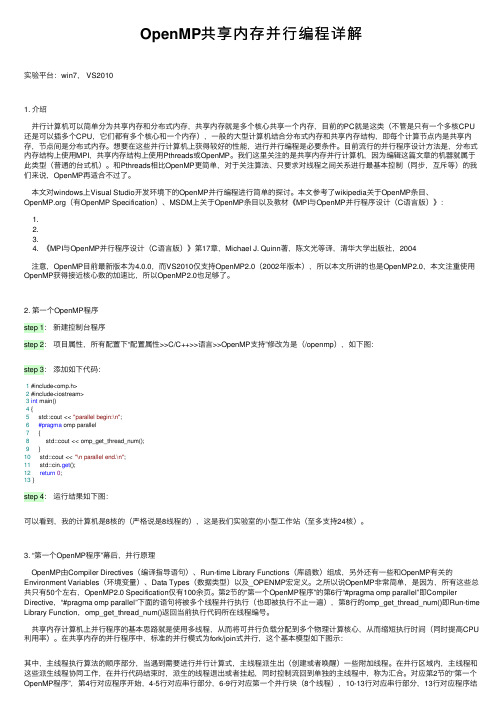

OpenMP共享内存并行编程详解

OpenMP共享内存并⾏编程详解实验平台:win7, VS20101. 介绍并⾏计算机可以简单分为共享内存和分布式内存,共享内存就是多个核⼼共享⼀个内存,⽬前的PC就是这类(不管是只有⼀个多核CPU 还是可以插多个CPU,它们都有多个核⼼和⼀个内存),⼀般的⼤型计算机结合分布式内存和共享内存结构,即每个计算节点内是共享内存,节点间是分布式内存。

想要在这些并⾏计算机上获得较好的性能,进⾏并⾏编程是必要条件。

⽬前流⾏的并⾏程序设计⽅法是,分布式内存结构上使⽤MPI,共享内存结构上使⽤Pthreads或OpenMP。

我们这⾥关注的是共享内存并⾏计算机,因为编辑这篇⽂章的机器就属于此类型(普通的台式机)。

和Pthreads相⽐OpenMP更简单,对于关注算法、只要求对线程之间关系进⾏最基本控制(同步,互斥等)的我们来说,OpenMP再适合不过了。

本⽂对windows上Visual Studio开发环境下的OpenMP并⾏编程进⾏简单的探讨。

本⽂参考了wikipedia关于OpenMP条⽬、(有OpenMP Specification)、MSDM上关于OpenMP条⽬以及教材《MPI与OpenMP并⾏程序设计(C语⾔版)》:1.2.3.4. 《MPI与OpenMP并⾏程序设计(C语⾔版)》第17章,Michael J. Quinn著,陈⽂光等译,清华⼤学出版社,2004注意,OpenMP⽬前最新版本为4.0.0,⽽VS2010仅⽀持OpenMP2.0(2002年版本),所以本⽂所讲的也是OpenMP2.0,本⽂注重使⽤OpenMP获得接近核⼼数的加速⽐,所以OpenMP2.0也⾜够了。

2. 第⼀个OpenMP程序step 1:新建控制台程序step 2:项⽬属性,所有配置下“配置属性>>C/C++>>语⾔>>OpenMP⽀持”修改为是(/openmp),如下图:step 3:添加如下代码:1 #include<omp.h>2 #include<iostream>3int main()4 {5 std::cout << "parallel begin:\n";6#pragma omp parallel7 {8 std::cout << omp_get_thread_num();9 }10 std::cout << "\n parallel end.\n";11 std::cin.get();12return0;13 }step 4:运⾏结果如下图:可以看到,我的计算机是8核的(严格说是8线程的),这是我们实验室的⼩型⼯作站(⾄多⽀持24核)。

OpenMP复习及程序演示

其他的编译指导语句及子句

Schedule子句: 静态调度(static):parallel for语句不带schedule子句,默认为静态调度方式。 动态调度(dynamic):没有size参数:将迭代逐个分配到各个线程;使用size参数:每次分配给线程的迭代次数为size次。 启发式自调度(guided):开始时每个线程会分配到较大的迭代块,之后分配到的迭代块会递减。迭代块的大小按指数级下降到指定的size大小。如果没有size参数,默认1。

1 循环并行化:使用OpenMP并行程序的重要部分

*

循环并行化语句工作原理

将for循环中的工作分配到一个线程组中,线程组中的每一个线程将完成循环中的一部分内容; for循环语句要紧跟在parallel for的编译指导语句后面,编译指导语句的功能区域一直延伸到for循环语句的结束; 编译指导语句后面的字句(clause)用来控制编译指导语句的具体行为。

OpenMP的编程模型以线程为基础,通过编译指导语句来显式地指导并行化,为编程人员提供对并行化的完整控制。 OpenMP多线程编程的基础知识 OpenMP程序的执行模型 OpenMP程序中涉及的编译指导语句和库函数 OpenMP程序的执行环境

6.1.2 OpenMP编程基础

OpenMP程序采用Fork-Join的执行模式

*

其他的编译指导语句及子句

Schedule子句: 格式:schedule(type[,size]) type参数:dynamic/guided/runtime/static size参数:表示循环迭代次数,必须为整数。 如果type参数为dynamic/guided/static,则size为可选参数 如果type参数为runtime,则不需要使用size参数。

MPI的搭建及OpenMP的配置实验指导书

MPI的搭建及OpenMP的配置实验指导书1.MPI简介消息传递接口(Message Passing Interface,MPI)是目前应用较广泛的一种并行计算软件环境,是在集群系统上实现并行计算的软件接口。

为了统一互不兼容的的用户界面,1992年成立了MPI委员会,负责制定MPI的新标准,支持最佳的可移植平台。

MPI不是一门新的语言,确切地说它是一个C和Fortran的函数库,用户通过调用这些函数接口并采用并行编译器编译源代码就可以生成可并行运行的代码。

MPI的目标是要开发一个广泛用于编写消息传递程序的标准,要求用户界面实用、可移植,并且高效、灵活,能广泛应用于各类并行机,特别是分布式存储的计算机。

每个计算机厂商都在开发标准平台上做了大量的工作,出现了一批可移植的消息传递环境。

MPI吸收了它们的经验,同时从句法和语法方面确定核心库函数,使之能适用于更多的并行机。

MPI在标准化过程中吸收了许多代表参加,包括研制并行计算机的大多数厂商,以及来自大学、实验室与工业界的研究人员。

1992年开始正式标准化MPI,1994年发布了MPI的定义与实验标准MPI 1,相应的MPI 2标准也已经发布。

MPI吸取了众多消息传递系统的优点,具有很好的可以执行、易用性和完备的异步通信功能等。

MPI事实上只是一个消息传递标准,并不是软件实现并行执行的具体实现,目前比较著名的MPI具体实现有MPICH、LAM MPI等,其中MPICH是目前使用最广泛的免费MPI系统,MPICH2是MPI 2标准的一个具体实现,它具有较好的兼容性和可扩展性,目前在高性能计算集群上使用非常广泛。

MPICH2的使用也非常简单,用户只需在并行程序中包含MPICH的头文件,然后调用一些MPICH2函数接口将计算任务分发到其他计算节点即可,MPICH2为并行计算用户提供了100多个C和Fortran函数接口,表1-1列出了一些常用的MPICH2的C语言函数接口,用户可以像调用普通函数一样,只需要做少量的代码改动就可以实现程序的并行运行,MPICH并行代码结构如图1-1所示。

OpenMP简易教程

2) 方便性问题

在多核编程时,要求计算均摊到各个 CPU 核上去,所有的程序都需要并行化执行,对计算的负载均衡有很高 要求。这就要求在同一个函数内戒同一个循环中,可能也需要将计算分摊到各个 CPU 核上,需要创建多个线 程。操作系统 API 创建线程时,需要线程入口函数,很难满足这个需求,除非将一个函数内的代码手工拆成多 个线程入口函数,这将大大增加程序员的工作量。使用 OpenMP 创建线程则丌需要入口函数,非常方便,可 以将同一函数内的代码分解成多个线程执行,也可以将一个 for 循环分解成多个线程执行。

OpenMP 创建线程中的锁及原子操作性能比较 ............................................................................................................... 21 OpenMP 程序设计的两个小技巧 ....................................................................................................................................... 25

目录openmp简易教程openmp并行程序设计一openmp并行程序设计二forkjoin并行执行模式的概念openmp指令和库函数介绍parallel指令的用法sections和section指令的用法28openmp中的数据处理子句private子句firstprivate子句lastprivate子句threadprivate子句shared子句default子句reduction子句copyin子句copyprivate子句15openmp中的任务调度schedule子句用法guided调度guidedruntime调度rumtime20openmp创建线程中的锁及原子操作性能比较21openmp程序设计的两个小技巧28openmp并行程序设计一openmp是一个支持共享存储并行设计的库特别适宜多核cpu上的并行程序设计

2024版并行程序设计导论之OpenMP编程指南

OpenMP编程指南•OpenMP 概述•OpenMP 基本原理•OpenMP 编程实践•并行算法设计与优化•多线程并发控制及同步机制•内存访问优化与缓存一致性维护•性能评价与调试技巧分享目录01 OpenMP概述并行计算与OpenMP并行计算定义并行计算是指同时使用多种计算资源解决计算问题的过程,其主要目的是快速解决大型且复杂的计算问题。

OpenMP简介OpenMP是一种用于共享内存并行编程的API,在C/C和Fortran中广泛使用。

它提供了一种简单、灵活的线程并行编程模型,支持多平台和多编译器。

OpenMP与并行计算关系OpenMP通过提供一套编程接口和运行时库,使得程序员能够方便地使用多线程进行并行计算,从而加速程序的执行速度。

OpenMP历史与发展OpenMP起源OpenMP起源于1997年,由一组计算机硬件和软件厂商共同发起,旨在创建一个开放的、标准的并行编程模型。

OpenMP版本演进自1998年发布第一个版本以来,OpenMP不断发展和完善,增加了对任务并行、加速器支持、原子操作、线程同步等功能的支持。

OpenMP现状与未来目前,OpenMP已成为并行编程领域的事实标准之一,广泛应用于科学计算、工程仿真、数据分析等领域。

未来,随着硬件技术的不断发展和应用需求的不断提高,OpenMP将继续发展并完善。

OpenMP 在科学计算领域有着广泛的应用,如天气预报、气候模拟、油藏模拟等。

科学计算在工程仿真领域,OpenMP 可用于加速有限元分析、流体动力学仿真等计算过程。

工程仿真在数据分析领域,OpenMP 可用于加速数据挖掘、机器学习等算法的执行速度。

数据分析此外,OpenMP 还可应用于图像处理、密码学、生物信息学等领域。

其他领域OpenMP 应用领域02 OpenMP基本原理共享内存模型OpenMP基于共享内存模型,多个线程可以访问和修改同一块内存空间,需要解决数据一致性和同步问题。

分布式内存模型与MPI等基于分布式内存的并行计算模型不同,OpenMP不需要显式地进行数据分发和收集。

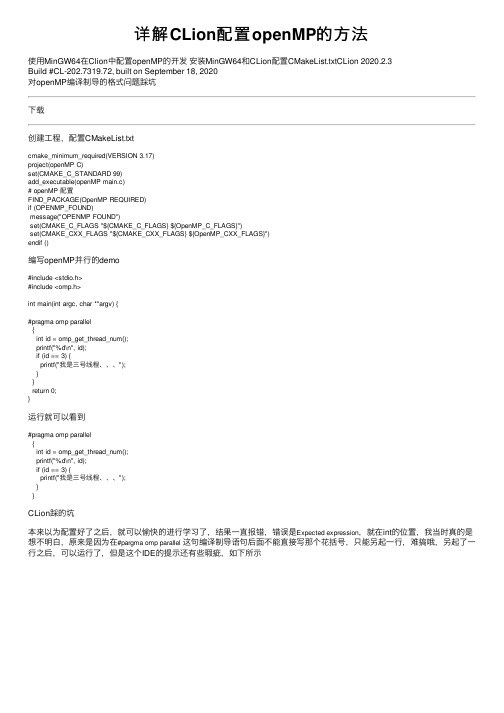

详解CLion配置openMP的方法

详解CLion配置openMP的⽅法使⽤MinGW64在Clion中配置openMP的开发安装MinGW64和CLion配置CMakeList.txtCLion 2020.2.3Build #CL-202.7319.72, built on September 18, 2020对openMP编译制导的格式问题踩坑下载创建⼯程,配置CMakeList.txtcmake_minimum_required(VERSION 3.17)project(openMP C)set(CMAKE_C_STANDARD 99)add_executable(openMP main.c)# openMP 配置FIND_PACKAGE(OpenMP REQUIRED)if (OPENMP_FOUND)message("OPENMP FOUND")set(CMAKE_C_FLAGS "${CMAKE_C_FLAGS} ${OpenMP_C_FLAGS}")set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} ${OpenMP_CXX_FLAGS}")endif ()编写openMP并⾏的demo#include <stdio.h>#include <omp.h>int main(int argc, char **argv) {#pragma omp parallel{int id = omp_get_thread_num();printf("%d\n", id);if (id == 3) {printf("我是三号线程、、、");}}return 0;}运⾏就可以看到#pragma omp parallel{int id = omp_get_thread_num();printf("%d\n", id);if (id == 3) {printf("我是三号线程、、、");}}CLion踩的坑本来以为配置好了之后,就可以愉快的进⾏学习了,结果⼀直报错,错误是Expected expression,就在int的位置,我当时真的是想不明⽩,原来是因为在#pargma omp parallel这句编译制导语句后⾯不能直接写那个花括号,只能另起⼀⾏,难搞哦,另起了⼀⾏之后,可以运⾏了,但是这个IDE的提⽰还有些瑕疵,如下所⽰浏览下⾯的相关⽂章希望⼤家以后多多⽀持!。

OpenMP的用法

在双重循环中怎样写OpenMP?那要分析你的外循环跟内循环有没有彼此依赖的关系unsigned int nCore = GetComputeCore();unsigned int nStep = IMAGETILEYSIZE / nCore;#pragma omp parallel for private(Level0_x, Level0_y, ChangeLevel0_x, ChangeLevel0_y, InterX1, InterX2, InterY1, InterY2)for (int k = 0; k < nCore; k++){int begin = k * nStep;int end = (k + 1) * nStep;for (int YOff = begin; YOff < end; YOff++){for (int XOff = 0; XOff < IMAGETILEXSIZE; XOff++){Level0_x = pPixelXBuf[YOff][XOff];Level0_y = pPixelYBuf[YOff][XOff];ChangeLevel0_x = Level0_x - XMin;ChangeLevel0_y = Level0_y - YMin;//寻找坐标在Level1Buf中对应的4个像素值InterX1 = (int)(ChangeLevel0_x);InterX2 = (int)(ChangeLevel0_x + 1);InterY1 = (int)(ChangeLevel0_y);InterY2 = (int)(ChangeLevel0_y + 1);//双线性插值对Level0_Buf赋值ZoomInterpolation(Level0Buf, Level1Buf, ChangeLevel0_x, ChangeLevel0_y, SamplesPerPixel, nXSize,nYSize, InterX1, InterX2, InterY1, InterY2, XOff, YOff);}}}我也想应该这样,可是如果nCore=1的时候,外循环只循环一次,线程是怎么分配的呢。

Intel_OpenMP白皮书

• 宣告循环内部的变量不含静态关键字,且位于并行 OpenMP 指令内部。 • 指定 OpenMP 指令上的私有子句。

由于变量 temp 为共享,所以下列循环无法正常运行。只有将它变为私有,循环才能正常运行。

// WRONG. Fails due to shared memory. // Variable temp is shared among all threads, so while one thread // is reading variable temp another thread might be writing to it #pragma omp parallel for for (i=0; i < 100; i++) {

#pragma omp parallel for for (i=0; i < numPixels; i++) {

pGrayScaleBitmap[i] = (unsigned BYTE) (pRGBBitmap[i].red * 0.299 + pRGBBitmap[i].green * 0.587 + pRGBBitmap[i].blue * 0.114);

的作用。

如果您省略命令行上的 /Qopenmp,则编译器将忽略 OpenMP 编译指令,为您提供一个十分简单的 方法,这样无需改变任何源代码即可生成单线程版本。此外,英特尔® C++ 编译器还支持 OpenMP 2.0 规范。如欲获得最新信息,请您务必查看与英特尔® C++ 编译器一道发布的版本说明和兼容性信息。 如欲获得完整的 OpenMP 规范,请访问:* 。

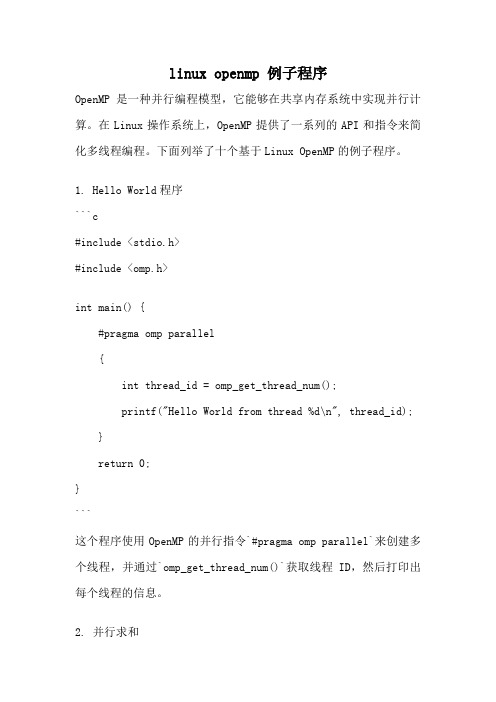

linux openmp 例子程序

linux openmp 例子程序OpenMP是一种并行编程模型,它能够在共享内存系统中实现并行计算。

在Linux操作系统上,OpenMP提供了一系列的API和指令来简化多线程编程。

下面列举了十个基于Linux OpenMP的例子程序。

1. Hello World程序```c#include <stdio.h>#include <omp.h>int main() {#pragma omp parallel{int thread_id = omp_get_thread_num();printf("Hello World from thread %d\n", thread_id); }return 0;}```这个程序使用OpenMP的并行指令`#pragma omp parallel`来创建多个线程,并通过`omp_get_thread_num()`获取线程ID,然后打印出每个线程的信息。

2. 并行求和```c#include <stdio.h>#include <omp.h>int main() {int sum = 0;#pragma omp parallel for reduction(+:sum)for (int i = 1; i <= 100; i++) {sum += i;}printf("Sum: %d\n", sum);return 0;}```这个程序使用OpenMP的`#pragma omp parallel for`指令将for循环并行化,每个线程负责一部分迭代计算,并且使用`reduction(+:sum)`指令将每个线程的局部和加到全局和中。

3. 并行矩阵乘法```c#include <stdio.h>#include <omp.h>#define N 100int main() {int A[N][N], B[N][N], C[N][N];#pragma omp parallel forfor (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {A[i][j] = i + j;B[i][j] = i - j;}}#pragma omp parallel forfor (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {C[i][j] = 0;for (int k = 0; k < N; k++) {C[i][j] += A[i][k] * B[k][j];}}}return 0;}```这个程序使用OpenMP的`#pragma omp parallel for`指令将两个嵌套的for循环并行化,其中第一个for循环用于初始化矩阵A和B,第二个for循环用于计算矩阵C的元素。