室内惯性_视觉组合导航地面图像分割算法

测绘技术中的室内导航技术介绍与使用方法

测绘技术中的室内导航技术介绍与使用方法随着科技的不断发展,室内导航技术在测绘领域中的应用日益广泛。

室内导航技术可以帮助人们准确快速地找到目标位置,解决了室内环境带来的迷失和迷惑问题。

本篇文章将介绍室内导航技术的原理和常见的使用方法。

室内导航技术是利用一系列高精度的传感器和定位系统来确定用户在室内的位置信息,并通过软件算法将用户定位与建筑物平面图进行关联,最终实现人们在室内环境中的导航和定位。

室内导航技术通常使用的传感器包括惯性导航系统、超宽带(UWB)技术、Wi-Fi定位、蓝牙低功耗(BLE)定位等。

惯性导航系统是一种基于加速度计和陀螺仪的定位技术。

经过一系列算法处理,惯性导航系统可以计算出用户的位置和方向信息。

超宽带技术是一种高精度的定位技术,它的工作原理是通过发送和接收短时宽带脉冲,利用时间差来计算用户的位置。

Wi-Fi定位是通过扫描周围的Wi-Fi信号,并与保存在数据库中的Wi-Fi信号强度进行比对,从而确定用户的位置。

蓝牙低功耗定位是通过扫描周围的蓝牙信号,并利用信号强度与距离之间的关系来定位用户。

在使用室内导航技术时,用户首先需要安装相应的导航应用程序。

这些应用程序通常提供用户界面,允许用户输入目标位置或选择特定的服务和设施。

一旦用户输入目标位置,导航应用程序就会利用室内导航技术来计算最佳的导航路径,并显示在用户的手机或电子设备上。

除了提供导航路径,室内导航应用程序还可以提供其他实用功能。

例如,它可以显示附近的服务和设施,如卫生间、商店、餐馆等。

用户可以根据自己的需求,选择停留在某个地点或继续导航到目标位置。

此外,室内导航应用程序还可以提供实时的导航指示,帮助用户更快地找到目标位置。

尽管室内导航技术在理论上是非常精确和可靠的,但在实际使用中仍然存在一些挑战。

首先,室内环境复杂多变,信号干扰和多路径效应可能会影响定位的精确性。

其次,室内导航技术需要与建筑物的平面图进行关联,而平面图的准确性和更新频率也是一个问题。

点云地面分割算法

点云地面分割算法

点云地面分割算法是计算机视觉中重要的算法之一,它可以将点云数据中的地面区域分割出来。

这个算法主要是针对激光雷达等各种传感器获取的点云数据进行处理,将点云数据中的地面点和非地面点分开,以便后续的处理和应用。

点云地面分割算法的实现方法可以有多种,比如基于滤波器、基于聚类、基于深度学习等。

其中,最常见的方法是基于滤波器的算法,它主要包括高斯滤波器、中值滤波器和平均滤波器等多种类型的滤波器。

这些滤波器可以将点云数据中的离散噪声进行平滑,同时保留地面点的特征,从而实现对点云数据的预处理。

在预处理完成后,点云地面分割算法的下一步就是对点云数据进行聚类。

聚类的目的是将点云数据中的地面点和非地面点分开,同时尽可能保留原始点云数据的特征。

常见的聚类算法包括基于欧氏距离的K-Means算法、基于密度的DBSCAN算法等。

除了基于滤波器和聚类的算法外,点云地面分割算法中还有一种比较新的方法,即基于深度学习的算法。

这种算法可以通过深度学习模型,对点云数据进行特征提取和分类,从而实现地面点和非地面点的分割。

相较于传统的算法,基于深度学习的算法具有更高的精度和更强的泛化能力。

总之,点云地面分割算法是计算机视觉领域中非常重要的算法之一,它可以提取出点云数据中的地面点,并将其与非地面点区分开来,为后续的处理和应用提供了有力的支持。

医学图像处理中的分割算法与性能评价指标比较分析

医学图像处理中的分割算法与性能评价指标比较分析医学图像处理在临床医学中起着重要的作用,可以辅助医生进行疾病诊断、治疗方案制定和手术导航等工作。

其中,图像分割是一项关键任务,旨在将医学图像中的特定结构或区域从背景中提取出来,以提供更准确的信息。

近年来,众多的图像分割算法被提出,但如何评价这些算法的性能仍然是一个挑战。

本文将对医学图像处理中的分割算法进行比较分析,并探讨常用的性能评价指标。

首先,我们将介绍几种常见的医学图像分割算法。

其中,阈值分割是最基础的方法之一,它根据图像中像素的灰度值与预设的阈值进行比较,将像素分类为目标和背景。

区域生长算法基于像素之间的相似性,将相似的像素组合成连通区域。

边缘检测算法通过检测图像中灰度值变化较大的区域来进行分割。

基于图割的分割算法则基于图论中的最小割原理,将图像分割成多个子图。

此外,还有基于聚类、基于图像的统计特征等算法。

针对这些算法,我们需要选择适当的性能评价指标来评估其优劣。

常见的性能评价指标包括准确率、召回率、F1值、Dice系数等。

准确率是评价分类模型预测准确性的指标,指分类正确的样本占总样本数的比例。

召回率是指分类正确的正样本占所有正样本的比例。

F1值是准确率和召回率的调和平均值,它更能综合评估分类模型的性能。

Dice系数则是一种衡量两个集合重叠程度的指标,它可以用于评估图像分割结果与真实标签的相似程度。

此外,我们还可以考虑其他一些比较全面的性能评价指标,如互信息、归一化互信息、兰德系数、调整兰德系数等。

互信息是一种衡量两个随机变量间相互依赖程度的指标,用于度量分割结果与真实标签之间的相关性。

归一化互信息是互信息的标准化形式,可以消除因维度不同而导致的偏差影响。

兰德系数和调整兰德系数是一种度量两个分割结果间一致性的指标,适用于无监督的分割算法评价。

在比较不同分割算法的性能时,我们需要考虑数据集的选择和评估方法的合理性。

合适的数据集应包含各种医学图像并具有真实的分割标签,这样可以更客观地评估算法的性能。

基于地面特征识别的室内机器人视觉导航

基于地面特征识别的室内机器人视觉导航

一、室内机器人视觉导航:

室内机器人视觉导航是一种非常先进的机器人导航技术,它通过摄像头捕捉室内环境的视觉信息,并根据这些信息,利用深度学习算法,构建一个室内室外的虚拟地图,指定室内机器人的行进路径,实现机器人自主导航。

室内机器人视觉导航主要分为两个步骤:1)室内环境模型;2)物体特征检测与识别。

二、基于地面特征识别的室内机器人视觉导航:

基于地面特征识别的室内机器人视觉导航,是一种通过检测室内环境中的地面特征,并利用地面特征来定位室内机器人的一种导航方式。

该技术使室内机器人能够避免障碍物,避免撞墙,而且能够实现自动驾驶,能够有效地提高机器人导航的准确性和安全性。

基于地面特征识别的室内机器人导航,主要包括两个步骤:首先是特征提取,通过摄像机拍摄室内环境,并产生特征地图。

然后是特征检测和识别,利用深度学习算法,从特征地图中识别出室内环境中的地面特征,如线条、标记等,从而实现机器人的自动导航。

需要指出的是,在基于地面特征识别的室内机器人视觉导航中,地面特征识别的准确率是非常重要的,如果地面特征识别不准确。

机器人导航算法在室内环境中的使用方法

机器人导航算法在室内环境中的使用方法引言:随着技术的不断进步与发展,机器人在各个领域都起到了重要的作用。

其中,机器人导航算法在室内环境中的应用,为我们的生活和工作带来了巨大的便利。

本文将介绍机器人导航算法在室内环境中的使用方法,并讨论其应用前景和未来发展方向。

一、机器人导航算法概述机器人导航算法是指通过对机器人感知周围环境、规划路径和执行导航等步骤的控制,使机器人能够准确、高效地在室内环境中进行移动和定位。

机器人导航算法的核心是如何处理环境信息、利用感知和定位技术实现机器人的自主导航。

二、机器人导航算法的使用方法1.环境建模:首先要对室内环境进行建模。

可以利用激光传感器、摄像头等感知设备,获取室内环境的地图信息。

然后,利用这些地图信息生成室内环境的模型,包括墙壁、家具、门窗等。

2.感知和定位:通过激光传感器、摄像头、雷达等感知设备,机器人能够获取周围环境的信息。

利用这些信息,机器人能够确定自身的位置和姿态,并确定目标位置。

3.路径规划:一旦机器人获得了环境地图和目标位置,就需要进行路径规划。

在室内环境中,常用的路径规划算法包括A*算法、Dijkstra 算法和快速随机树(RRT)等。

这些算法通过计算最短路径或最优路径来指导机器人的移动。

4.运动控制:机器人导航算法还需要考虑机器人的运动控制问题。

通过控制机器人的轮速或关节角度,使其按照规划路径进行移动。

运动控制算法可以考虑机器人的动力学特性,以实现更加稳定和精确的运动。

5.避障处理:在室内环境中,机器人需要处理避障问题。

当机器人遇到障碍物时,需要进行避障处理,以保证机器人的安全和导航的连续性。

常用的避障算法包括静态避障和动态避障等。

三、机器人导航算法的应用前景机器人导航算法在室内环境中的应用前景广阔。

它可以应用于家庭服务机器人、商业服务机器人、医疗护理机器人等多个领域。

通过机器人的导航,可以实现室内环境的清洁、物品的搬运、患者的护理等任务,提高工作和生活效率。

室内导航图像中反光区域的检测与分割算法

t h e e x p e ime r n t l a r e s u l t s s h o w t h a t t h e p e f r o r ma n c e o f lg a o it r h m i s r e a s o n a b l e .

Al g or i t hm o f i l l u mi na n t r e le f c t i o n d e t e c t i o n a nd s e g me nt a t i o n i n i nd o o r i ma g e f o r na v i g a t i o n

Ab s t r a c t :I n l i g h t i n g o f t h e p r o b l e m a b o u t i l l u mi n a n t r e l f e c t i o n r e g i o n s b e i n g f o u n d i n a b i r d v i e w i ma g e a n d i t l e a d i n g t o p e f r o r ma n c e d e g r a d a t i o n o f t h e n a v i g a t i o n s y s t e m, a n a l g o r i t h m o f i l l u mi n a n t r e l f e c t i o n d e t e c t i o n a n d

I t i s f o u n d t h a t t h e s a t u r a t i o n c o mp o n e n t s o f t h e i ma g e r e g i o n s a r e s ma l l w h i l e b n i g h t n e s s c o mp o n e n t s a r e l a r g e a n d b ig r h t n e s s v lu a e s d e c r e a s e f r o m c e n t r a l p o s i t i o n s t o ma r g i n a l p o s i t i o n s .An d t h e n i l l u mi n a n t r e l f e c t i o n i s d e t e c t e d a n d s e g me n t e d b a s e d o n t h e s e i ma g e f e a t u r e s . F i n a l l y, e x p e i r me n t s a r e r u n t o t e s t i f y t h e a l g o i r t h m ,a n d

室内导航定位系统中的路径规划算法研究

室内导航定位系统中的路径规划算法研究室内导航定位系统是一种利用无线通信技术和传感器技术来实现室内定位和导航的系统。

在室内环境中,由于GPS信号的无法穿透建筑物,传统的GPS导航系统失效,因此,研究和设计室内导航定位系统成为了一个重要的研究方向。

而路径规划算法作为室内导航定位系统的核心技术之一,对于提供有效的导航路径具有重要意义。

本篇文章将探讨室内导航定位系统中的路径规划算法研究。

路径规划算法是指在给定起始点和目标点的情况下,找到一条最优路径或者最短路径来连接两个点。

在室内导航定位系统中,路径规划算法主要有以下几种:1. Dijkstra算法:Dijkstra算法是一种广泛应用于寻找最短路径的算法。

该算法基于图论,将建筑物划分为一系列节点和边,通过计算起始节点到各个节点的最短距离来确定最优路径。

Dijkstra算法的优点是准确性高,能够找到最短路径,但是由于需要计算图中所有节点的距离,所以计算复杂度较高。

2.A*算法:A*算法是一种启发式算法,可以用于解决最短路径问题。

该算法通过估计每个节点到目标节点的距离,综合路径的实际代价和估计代价来选择最佳路径。

A*算法的优点是在找到解决方案的同时,能够有效降低的规模,提高了计算效率。

3. Floyd-Warshall算法:Floyd-Warshall算法是一种用于计算有向加权图中所有节点对之间最短路径的算法。

该算法基于动态规划的思想,通过比较各个中间节点的路径长度来更新所有节点之间的最短路径。

Floyd-Warshall算法的优点是能够找到所有节点对的最短路径,但是由于需要计算所有节点对之间的路径,算法的时间复杂度较高。

4.可视化导航算法:可视化导航算法是基于图像处理和计算机视觉技术的路径规划算法。

该算法通过分析建筑物内部的摄像头监控图像,提取出各个房间和通道的特征,然后通过图像匹配和目标识别来确定最佳路径。

可视化导航算法的优点是能够实现室内导航定位系统的实时更新和导航。

视觉与惯导组合的精确定位方法

视觉与惯导组合的精确定位方法

视觉与惯导组合的精确定位方法是将视觉信息与惯性导航系统(即惯性测量单元)的测量结果进行融合,以提高位置和姿态的精确度。

该方法的基本思想是利用视觉信息来校正惯导系统的误差,从而实现更准确的定位和导航。

具体而言,视觉与惯导组合的精确定位方法包括以下步骤:

1. 视觉图像获取:通过视觉传感器(如摄像头)获取场景图像。

2. 特征提取与匹配:从视觉图像中提取出有意义的特征点,并与已知地图或先前测量结果进行特征匹配,以获得相对位置和姿态信息。

3. 三维重建:利用特征点的视差(即在不同视图中的像素偏移量)和相机参数,将特征点从图像空间映射到三维空间,并重建出场景的三维结构。

4. 姿态估计:根据特征点的位置关系和三维结构,估计出相机的姿态(即旋转矩阵或四元数),包括方向和角度。

5. 运动估计:通过惯性导航系统获取相机的线性加速度和角速度信息,从而估计出相机的运动(即平移矩阵或速度向量)。

6. 视觉与惯导融合:通过滤波器(如卡尔曼滤波器)或优化算法(如扩展卡尔曼滤波器或粒子滤波器)将视觉测量结果和惯导测量结果进行融合,得到更准确的位置和姿态估计结果。

7. 循环更新:根据新的视觉测量数据和惯导测量数据,不断迭代更新位置和姿态估计结果,以实现实时精确定位。

视觉与惯导组合的精确定位方法可以应用于无人机、自动驾驶车辆、机器人等领域,能够在没有GPS定位或GPS不可用的环境下实现精确的定位和导航。

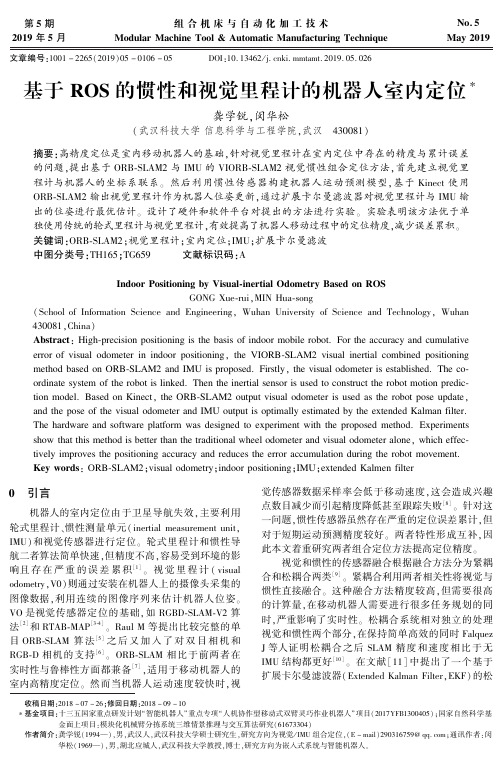

基于ROS的惯性和视觉里程计的机器人室内定位

第5期2019年5月组合机床与自动化加工技术ModularMachineTool&AutomaticManufacturingTechniqueNo.5May2019文章编号:1001-2265(2019)05-0106-05㊀㊀㊀㊀DOI:10.13462/j.cnki.mmtamt.2019.05.026收稿日期:2018-07-26ꎻ修回日期:2018-09-10㊀∗基金项目:十三五国家重点研发计划 智能机器人 重点专项 人机协作型移动式双臂灵巧作业机器人 项目(2017YFB1300405)ꎻ国家自然科学基金面上项目:模块化机械臂分拣系统三维情景推理与交互算法研究(61673304)作者简介:龚学锐(1994 )ꎬ男ꎬ武汉人ꎬ武汉科技大学硕士研究生ꎬ研究方向为视觉/IMU组合定位ꎬ(E-mail)290316759@qq.comꎻ通讯作者:闵华松(1969 )ꎬ男ꎬ湖北应城人ꎬ武汉科技大学教授ꎬ博士ꎬ研究方向为嵌入式系统与智能机器人ꎮ基于ROS的惯性和视觉里程计的机器人室内定位∗龚学锐ꎬ闵华松(武汉科技大学信息科学与工程学院ꎬ武汉㊀430081)摘要:高精度定位是室内移动机器人的基础ꎬ针对视觉里程计在室内定位中存在的精度与累计误差的问题ꎬ提出基于ORB ̄SLAM2与IMU的VIORB ̄SLAM2视觉惯性组合定位方法ꎬ首先建立视觉里程计与机器人的坐标系联系ꎮ然后利用惯性传感器构建机器人运动预测模型ꎬ基于Kinect使用ORB ̄SLAM2输出视觉里程计作为机器人位姿更新ꎬ通过扩展卡尔曼滤波器对视觉里程计与IMU输出的位姿进行最优估计ꎮ设计了硬件和软件平台对提出的方法进行实验ꎮ实验表明该方法优于单独使用传统的轮式里程计与视觉里程计ꎬ有效提高了机器人移动过程中的定位精度ꎬ减少误差累积ꎮ关键词:ORB ̄SLAM2ꎻ视觉里程计ꎻ室内定位ꎻIMUꎻ扩展卡尔曼滤波中图分类号:TH165ꎻTG659㊀㊀㊀文献标识码:AIndoorPositioningbyVisual ̄inertialOdometryBasedonROSGONGXue ̄ruiꎬMINHua ̄song(SchoolofInformationScienceandEngineeringꎬWuhanUniversityofScienceandTechnologyꎬWuhan430081ꎬChina)Abstract:High ̄precisionpositioningisthebasisofindoormobilerobot.FortheaccuracyandcumulativeerrorofvisualodometerinindoorpositioningꎬtheVIORB ̄SLAM2visualinertialcombinedpositioningmethodbasedonORB ̄SLAM2andIMUisproposed.Firstlyꎬthevisualodometerisestablished.Theco ̄ordinatesystemoftherobotislinked.Thentheinertialsensorisusedtoconstructtherobotmotionpredic ̄tionmodel.BasedonKinectꎬtheORB ̄SLAM2outputvisualodometerisusedastherobotposeupdateꎬandtheposeofthevisualodometerandIMUoutputisoptimallyestimatedbytheextendedKalmanfilter.Thehardwareandsoftwareplatformwasdesignedtoexperimentwiththeproposedmethod.Experimentsshowthatthismethodisbetterthanthetraditionalwheelodometerandvisualodometeraloneꎬwhicheffec ̄tivelyimprovesthepositioningaccuracyandreducestheerroraccumulationduringtherobotmovement.Keywords:ORB ̄SLAM2ꎻvisualodometryꎻindoorpositioningꎻIMUꎻextendedKalmenfilter0㊀引言机器人的室内定位由于卫星导航失效ꎬ主要利用轮式里程计㊁惯性测量单元(inertialmeasurementunitꎬIMU)和视觉传感器进行定位ꎮ轮式里程计和惯性导航二者算法简单快速ꎬ但精度不高ꎬ容易受到环境的影响且存在严重的误差累积[1]ꎮ视觉里程计(visualodometryꎬV0)则通过安装在机器人上的摄像头采集的图像数据ꎬ利用连续的图像序列来估计机器人位姿ꎮVO是视觉传感器定位的基础ꎬ如RGBD ̄SLAM ̄V2算法[2]和RTAB ̄MAP[3 ̄4]ꎮRaulM等提出比较完整的单目ORB ̄SLAM算法[5]之后又加入了对双目相机和RGB ̄D相机的支持[6]ꎮORB ̄SLAM相比于前两者在实时性与鲁棒性方面都兼备[7]ꎬ适用于移动机器人的室内高精度定位ꎮ然而当机器人运动速度较快时ꎬ视觉传感器数据采样率会低于移动速度ꎬ这会造成兴趣点数目减少而引起精度降低甚至跟踪失败[8]ꎮ针对这一问题ꎬ惯性传感器虽然存在严重的定位误差累计ꎬ但对于短期运动预测精度较好ꎮ两者特性形成互补ꎬ因此本文着重研究两者组合定位方法提高定位精度ꎮ视觉和惯性的传感器融合根据融合方法分为紧耦合和松耦合两类[9]ꎮ紧耦合利用两者相关性将视觉与惯性直接融合ꎮ这种融合方法精度较高ꎬ但需要很高的计算量ꎬ在移动机器人需要进行很多任务规划的同时ꎬ严重影响了实时性ꎮ松耦合系统相对独立的处理视觉和惯性两个部分ꎬ在保持简单高效的同时FalquezJ等人证明松耦合之后SLAM精度和速度相比于无IMU结构都更好[10]ꎮ在文献[11]中提出了一个基于扩展卡尔曼滤波器(ExtendedKalmanFilterꎬEKF)的松耦合算法ꎬ将视觉里程计作为独立部分处理后和惯性测量的结果进行融合ꎬ并成功与PTAM算法结合完成机器人定位ꎮ这种方法计算量较小ꎬ能应用于不同方法的视觉里程计算法ꎬ可移植性较强ꎮ因此ꎬ本文将惯性导航与视觉SLAM两种定位方法在基于EKF的松耦合结构下相互融合ꎬ构建具有较高定位精度的定位系统ꎮ采用ORB ̄SLAM2算法ꎬ使用Kinect作为视觉传感器与IMU进行组合定位与制图研究ꎮ首先完成了SLAM系统与机器人坐标系的构建ꎬ通过ORB ̄SLAM2的视觉里程计得到Kinect的位姿ꎬ从而计算出移动机器人的运动轨迹ꎮ并将视觉定位结果与IMU数据通过扩展卡尔曼滤波器进行融合ꎬ提高室内移动机器人的定位精度ꎮ1㊀基于Kinect的视觉里程计定位1.1㊀ORB ̄SLAM2算法ORB ̄SLAM2是基于单目ꎬ双目和RGB ̄D相机的一套完整的SLAM方案ꎮ它能够实现地图重用ꎬ回环检测和重新定位的功能ꎮ无论是在室内还是室外都能够在标准的CPU上进行实时工作ꎮ对于处理来自RGB ̄D传感器的图像ꎬORB ̄SLAM2后端采用光速法平差优化法来建立全局地图ꎬ能够长时间并且精确的完成全局定位ꎮORB ̄SLAM2的视觉里程计主要包含跟踪和局部地图构建两个线程ꎬ其中相机位姿的确定主要由跟踪部分负责ꎬ这一部分任务是通过对新一帧图像提取ORB特征点进行粗略估计相机初始位姿并对局部空间中的特征点以及相机位姿进行优化ꎬ通过跟踪局部地图ꎬ利用投影的方法和当前帧关联做联合优化来得到较为准确的相机位姿ꎮ其系统流程如图1所示ꎮ图1㊀ORB ̄SLAM2系统流程图1.2㊀机器人定位本文用6个参数来表示机器人的位移和姿态变化ꎬΔxꎬΔyꎬΔz代表机器人位置的变化ꎬΔαꎬΔβꎬΔγ表示机器人姿态变化ꎮ当机器人从点A[x1ꎬy1ꎬz1]移动到点B[x2ꎬy2ꎬz2]时ꎬ通过姿态变化可以得到一个3ˑ3的旋转矩阵Rꎬ通过位置变化得到平移向量t=[ΔxꎬΔyꎬΔz]ꎬ通过式(1)可以计算得到点B坐标ꎮ[x2ꎬy2ꎬz2]T=R[x1ꎬy1ꎬz1]T+t(1)ORB ̄SLAM2可以准确的估计相机的位移和姿态变化ꎬ由于在机器人移动过程中相机位置相对于机器人本体保持不变ꎬ因此相机的位姿变换就能转换成机器人的位姿变换ꎮ假如每两个相邻的机器人运动都能够精确地确定唯一的姿态变换ꎬ那么移动机器人的定位问题就解决了ꎮ2㊀视觉惯性组合定位单纯的视觉导航在长时间运行过程中会产生累计的误差ꎬ并且在机器人运动速度过快时效果不佳ꎬ所以需要引入其他导航系统进行修正ꎮ由于GPS信号在室内失效无法定位ꎬ因此本文采用视觉惯性组合的方法来减少视觉传感器产生的误差ꎬ使移动机器人在室内的定位精度得到提高ꎮ2.1㊀机器人坐标系构建ORB ̄SLAM2的视觉里程计的直接测量值是针对自身坐标系mapꎬ与机器人坐标系并不产生任何关联ꎮ本文希望将视觉里程计的map坐标系融入机器人坐标系中ꎬ因此在系统建模过程中需要通过坐标变换来实现ꎮORB ̄SLAM2输出的相机位姿是在自身map坐标系下的相机位姿ꎬ即ORB ̄SLAM2输出map ̄camera_rgb_optical_frame转换关系ꎬ而机器人坐标系的转换关系依据自身模型建立ꎬ输出形式为odom ̄base_link ̄others(camera_rgb_optical_frame等)ꎬ为使得SLAM系统与机器人坐标系建立关系ꎬ根据以上两个关系的融合ꎬ建立map ̄odom转换关系ꎮ我们可以得到已建立连接的两个坐标系之间的旋转和平移关系ꎬ因此设R为坐标系间的旋转矩阵ꎬT为平移矩阵ꎬP为相机在该坐标系下的坐标ꎮRmap_camera=Rmap_odom∗Rodom_camera(2)Rmap odom=Rmap camera∗Rodom camera-1(3)Pmap=Rmap_odom∗Podom+Tmap_odom(4)Pmap=Tmap_camera(5)Podom=Todom_camera(6)联立上式得:Tmap_odom=Tmap_camera-Rmap_odom∗Todom_camera(7)根据上面的推导过程可以得出map ̄odom的旋转关系和平移关系ꎬ建立ORB ̄SLAM2与机器人的坐标系关联ꎬ便于查询包括imu㊁kinect㊁机器人等在整个框架下的坐标ꎮ2.2㊀组合定位导航方案本文将ORB ̄SLAM2的视觉里程计与IMU数据在扩展卡尔曼滤波器中进行融合ꎬ形成松耦合的VIO框架ꎬ模块化的松耦合框架能够使整个视觉惯性系统在机器人运行中无缝的处理新增或丢失的传感器消息而不会导致整个系统的崩溃ꎬ使得机器人长期的任务中不会由于短暂的跟踪失败或IMU数据丢失导致对自身定位出现较大的飘移ꎮ扩展卡尔曼滤波器是一种高效率的递归滤波器ꎬ它能够从一系列的不完全包含噪声的测量中ꎬ估计动态系统的状态ꎮ由于其算法众所周知ꎬ在这里只详细的介绍本系统的实施步骤ꎮ整个EKF框架大体分为预测和更新两大步骤ꎮ使用IMU数据通过运动模型进行预测步骤然后再由SLAM输出的传感器位姿进行更新步骤ꎮ我们的目标是估计一个移动机器人的全三7012019年5月㊀㊀龚学锐ꎬ等:基于ROS的惯性和视觉里程计的机器人室内定位维姿态和速度ꎮ随着时间的推移ꎬ这个过程可以被描述为一个非线性的动态系统ꎮxk=f(xk-1)+wk-1(8)其中ꎬx为机器人的系统状态ꎬ它包括机器人的3D位姿以及各自的速度ꎬk表示所处时刻ꎬf是一个非线性状态转移函数ꎬw为假设为正态分布的过程噪声ꎮ另外测量数据我们表示为:zk=h(xk)+vk(9)其中ꎬz为测量量ꎬh是一种将状态映射到测量空间的非线性传感器模型ꎮv是正态分布的测量噪声ꎮ算法中的第一阶段ꎬ如等式(10)和式(11)所示ꎬ是执行预测当前时间状态估计和误差协方差时间的预测步骤ꎬ它主要是基于系统模型和IMU读数完成:xk=f(xꎬu)(10) Pk=FPk-1FT+Q(11)其中ꎬf是从牛顿力学导出的标准三维运动模型ꎬu为IMU测量数据ꎬP为估计协方差误差ꎬF为f的雅可比矩阵ꎬQ为扰动变量ꎬ是过程噪声协方差ꎮ之后通过式(12)~式(14)执行更新步骤ꎬ利用观测矩阵H和测量协方差R和估计协方差误差P来计算卡尔曼增益用于更新状态和协方差矩阵ꎮK= PKHT(H PKHT+R)-1(12)xk= xk+K(z-H xk)(13)Pk=(I-KH) Pk(I-KH)T+KRKT(14)考虑到室内移动机器人的特性ꎬ由于机器人本体在地面只会在x-y平面内进行运动ꎬZ方向的位姿估计只会对定位精度造成干扰ꎬ因此在融合过程中忽略各部分在Z轴方向的估计ꎮ在机器人平台上ꎬ将视觉里程计作为一盒黑匣子ꎬ独立的计算位姿并输出ꎮ扩展卡尔曼滤波器接受视觉里程计与惯性传感器的数据后ꎬ完成融合输出新的位姿ꎮ算法流程如图2所示ꎮ图2㊀算法流程图本文基于ROS操作系统建立各模块之间的通讯ꎬ节点框架如图3所示ꎮ在整个算法运行过程中ꎬ各部分通过TF建立坐标系之间的转换关系ꎮEKF节点订阅视觉里程计与惯性传感器发布的话题ꎬ在处理后进行位姿融合ꎮ图3㊀ROS节点框架图3㊀室内定位实验本实验所用电脑配置为:CPU为i5 ̄3210mꎬ主频为2.5GHzꎬ内存8Gꎬ不使用图形处理器(GPU)加速ꎬ系统为Ubuntu14.04ꎬROS版本为indigoꎮ使用TUM数据集将本文算法与ORB ̄SLAM2及RGBD ̄SLAM ̄V2进行对比ꎮ在实际测试中将KInect搭载在移动机器人上进行定位实验ꎬ在ROS仿真平台gazebo中完成仿真环境测试ꎮ图4㊀实验所用机器人平台表1为在本文所用电脑上TUM数据集中测试结果ꎬORB ̄SLAM2的测试结果各方面均优于RGBD ̄SLAM ̄V2ꎮ在TUM数据集中由于没有惯性数据ꎬ但本文算法也优于RGBD ̄SLAM ̄V2ꎬ与ORB ̄SLAM2相差不大ꎮ表1㊀fr1/desk数据集测试结果(单位:m)ORB ̄SLAM2RGBD ̄SLAM ̄V2本文算法rmse0.0098830.0141280.011965mean0.0082720.0125080.012325median0.0071510.0113520.011182std0.0054080.0065690.005476min0.0004340.0010280.001061max0.0360700.0403490.035716通过gazebo搭建机器人的仿真环境ꎬ在移动机器人平台上搭载Kinect对本系统进行仿真测试ꎮ图5㊀仿真环境运行界面表2~表4分别为机器人直线前进1m㊁2m㊁3m时本文算法与ORB ̄SLAM2和轮式里程计与IMU融合的机器人坐标与误差ꎮ为消除单次实验的偶然性ꎬ本文共做3次实验取平均值ꎬ其中实验一与实验二机器人速度设定为0.5m/sꎬ实验三中机器人速度设定为1m/sꎮ在直线定位中可以看出单纯的视觉里程计定位由于Z方向上带来的误差ꎬ随着距离的增加与目标点偏差越来越大ꎬ传统的轮式里程计与惯性定位表现较为稳定但误差仍然较大ꎮ而本文改进的视觉惯性系统定位精度高于ORB ̄SLAM2ꎮ证明了视觉惯性的松耦合系统的可行性ꎬ展现了两者传感器之间互补的良好特性ꎮ801 组合机床与自动化加工技术㊀第5期表2㊀直线行走1m实验结果(单位:m)实验一实验二实验三平均误差ORB ̄SLAM2(0.896ꎬ0.041ꎬ0.000)(0.897ꎬ0.039ꎬ0.000)(0.891ꎬ0.040ꎬ0.001)0.112678VIORB ̄SLAM2(0.903ꎬ-0.006ꎬ0.000)(0.901ꎬ-0.006ꎬ0.00)(0.907ꎬ-0.004ꎬ0.00)0.094026轮式里程计+IMU(0.861ꎬ-0.009ꎬ0.00)(0.863ꎬ-0.008ꎬ0.00)(0.864ꎬ-0.009ꎬ0.00)0.137581表3㊀直线行走2m实验结果(单位:m)实验一实验二实验三平均误差ORB ̄SLAM2(1.876ꎬ0.062ꎬ0.054)(1.888ꎬ0.039ꎬ0.038)(1.891ꎬ0.04ꎬ0.057)0.134220VIORB ̄SLAM2(1.937ꎬ-0.067ꎬ0.000)(1.934ꎬ-0.063ꎬ0.00)(1.936ꎬ-0.071ꎬ0.00)0.092931轮式里程计+IMU(1.855ꎬ0.044ꎬ0.000)(1.853ꎬ-0.038ꎬ0.00)(1.854ꎬ-0.042ꎬ0.00)0.151761表4㊀直线行走3m实验结果(单位:m)实验一实验二实验三平均误差ORB ̄SLAM2(2.878ꎬ0.068ꎬ0.062)(2.877ꎬ0.068ꎬ0.060)(2.881ꎬ0.060ꎬ0.051)0.149401VIORB ̄SLAM2(2.935ꎬ-0.032ꎬ0.000)(2.931ꎬ-0.030ꎬ0.000)(2.937ꎬ-0.034ꎬ0.000)0.073092轮式里程计+IMU(2.875ꎬ-0.061ꎬ0.000)(2.875ꎬ-0.058ꎬ0.000)(2.874ꎬ-0.059ꎬ0.000)0.138673图6与图7分别为机器人行走3mˑ3m正方形的轨迹测试ꎮ由于在水平地面移动ꎬ因此只考虑X-Y平面坐标ꎬ使用轮式里程计与IMU时ꎬ机器人最后位置为(0.0515ꎬ0.1374)ꎬ与初始点相差0.1467mꎬ在单独运行ORB ̄SLAM2时机器人最后位置为(0.0214ꎬ0.1051)ꎬ与初始点相差0.1072mꎮ运行视觉惯性时ꎬ最后机器人位置为(0.0177ꎬ0.0674)ꎬ与初始点相差0.0696mꎮ图6㊀传统室内定位轨迹比较(单位:m)图7㊀VIORB ̄SLAM2和视觉里程计定位轨迹比较(单位:m)㊀㊀图8㊁图9与表5㊁表6为机器人行走一段开环路线与闭环路线的轨迹输出及误差分析ꎮ上述两个实验表明无论是在开环路径或闭环路径下ꎬ在姿态变化很大时(连续转弯)融合之后的定位精度及稳定性均明显优于轮式里程计和ORB ̄SLAM2ꎬ与理论轨迹相差不大ꎮ㊀㊀㊀(a)ORB ̄SLAM2㊀㊀㊀㊀㊀㊀㊀㊀(b)VIORB ̄SLAM2㊀(c)轮式里程计图8㊀开环路线轨迹对比(单位:m)表5㊀开环路线轨迹对比(单位:m)ORB ̄SLAM2VIORB ̄SLAM2轮式里程计rmse0.0162890.0099880.021186mean0.0094680.0057450.018629median0.0049370.0021630.017312std0.0132550.0081710.010089min0.0001490.0003770.036750max0.1815120.0794060.522340㊀㊀(a)ORB ̄SLAM2㊀㊀㊀㊀㊀㊀㊀㊀㊀(b)VIORB ̄SLAM2㊀(c)轮式里程计图9㊀闭环路线轨迹对比(单位:m)表6㊀闭环路线轨迹对比(单位:m)ORB ̄SLAM2VIORB ̄SLAM2轮式里程计rmse0.0804380.0124620.855962mean0.0626030.0072730.762932median0.0517110.0032290.820976std0.0505080.0101190.388078min0.0009680.0002870.188909max0.1663500.0774371.6711099012019年5月㊀㊀龚学锐ꎬ等:基于ROS的惯性和视觉里程计的机器人室内定位4㊀结论本文针对视觉里程计与传统室内定位存在的精度不高和累计误差较大的问题ꎬ提出了一种基于Kinect和IMU的机器人室内定位算法ꎬ由于Kinect兼备了RGB摄像头与深度传感器的优点ꎬ因此本文方法性价比高ꎬ可移植性较强ꎮORB ̄SLAM2作为视觉里程计与IMU进行扩展卡尔曼滤波组合定位通过更新修正机器人轨迹降低了视觉传感器的累积误差从而提高了室内机器人定位精度ꎮ并设计实验对所提出算法进行了验证ꎮ实验结果表明在定位精度与累计误差方面均有所改进ꎮ本文目前提出的定位算法在视觉里程计或惯性传感器失效的情况下仍有较大误差ꎬ且在转动速度过快时产生的误差也比较大ꎮ因此下一步将开展深度组合算法研究ꎬ进一步提高精度与鲁棒性ꎬ并生成地图应用于实际导航中ꎮ[参考文献][1]夏凌楠ꎬ张波ꎬ王营冠ꎬ等.基于惯性传感器和视觉里程计的机器人定位[J].仪器仪表学报ꎬ2013ꎬ34(1):166-172.[2]EndresFꎬHessJꎬSturmJꎬetal.3-DMappingWithanRGB ̄DCamera[J].IEEETransactionsonRoboticsꎬ2017ꎬ30(1):177-187.[3]LabbéMꎬMichaudF.Appearance ̄BasedLoopClosureDe ̄tectionforOnlineLarge ̄ScaleandLong ̄TermOperation[J].IEEETransactionsonRoboticsꎬ2013ꎬ29(3):734-745.[4]HornungAꎬKaiMWꎬBennewitzMꎬetal.OctoMap:anefficientprobabilistic3Dmappingframeworkbasedonoc ̄trees[J].AutonomousRobotsꎬ2013ꎬ34(3):189-206. [5]Mur ̄ArtalRꎬMontielJMMꎬTardósJD.ORB ̄SLAM:AVersatileandAccurateMonocularSLAMSystem[J].IEEETransactionsonRoboticsꎬ2017ꎬ31(5):1147-1163. [6]Mur ̄ArtalRaulꎬJuanDTardós.Orb ̄slam2:Anopen ̄sourceslamsystemformonocularꎬstereoꎬandrgb ̄dcameras[J].IEEETransactionsonRoboticsꎬ2017ꎬ33(5):1255-1262. [7]付梦印ꎬ吕宪伟ꎬ刘彤ꎬ等.基于RGB ̄D数据的实时SLAM算法[J].机器人ꎬ2015ꎬ37(6):683-692. [8]韩晓东ꎬ刘冬ꎬ丛明.基于ORB特征和里程计信息的机器人视觉导航[J].组合机床与自动化加工技术ꎬ2017(1):109-111.[9]GuiJꎬGuDꎬWangSꎬetal.Areviewofvisualinertialodometryfromfilteringandoptimisationperspectives[J].AdvancedRoboticsꎬ2015ꎬ29(20):1289-1301. [10]FalquezJMꎬKasperMꎬSibleyG.Inertialaideddense&semi ̄densemethodsforrobustdirectvisualodometry[C]//Ieee/rsjInternationalConferenceonIntelligentRobotsandSystemsꎬIEEEꎬ2016:3601-3607.[11]WeissSꎬAchtelikMWꎬLynenSꎬetal.Real ̄timeon ̄boardvisual ̄inertialstateestimationandself ̄calibrationofmavsinunknownenvironments[C]//RoboticsandAutoma ̄tion(ICRA)ꎬ2012IEEEInternationalConferenceonIEEEꎬ2012:957-964.(编辑㊀李秀敏)(上接第105页)计算出左右圆弧的标准差分别是:SL=7.96ˑ103ꎻSR=5.43ˑ103可以看出ꎬ测量结果存在波动ꎬ但数据的完整性是很好的ꎬ其余的误差例如波动较大㊁同轴度不好㊁偏心误差等都可以通过设计机械结构和算法进行改善ꎮ该验证试验基本证明了激光三角法测量螺母内滚道型面的可行性与优越性ꎬ具有自动化快速测量的优点ꎬ同时具有非常高的测量精度ꎮ2㊀结论根据测量要求设计基于激光的非接触式滚珠螺母测量方法ꎬ分别是光谱共焦法㊁双频激光干涉法和改进型激光三角法ꎮ激光干涉法由于存在加工周期长㊁设计复杂㊁成本太高的缺点ꎬ且难以做验证试验ꎬ所以用于技术储备ꎻ光谱共焦法和激光三角法经过试验验证ꎬ都具有自动化快速测量的优越性ꎬ但是激光三角精度明显更高ꎬ达到了5μmꎬ符合现代化工厂测量的需求ꎻ因此激光三角法更适用于圆弧滚道的测量ꎮ[参考文献][1]刘红艳.滚珠螺母过行程故障分析及预防[J].金属加工(冷加工)冷加工ꎬ2016(5):65-66.[2]赵汉忠.机床数控化改造中滚珠丝杠副的选择[J].机械工程师ꎬ2016(4):207-208.[3]何东民.一种滚珠丝杠螺母中径测量仪的原理及误差分析[J].计量技术ꎬ1993(6):14-16.[4]杨凤歧ꎬ何东民.滚珠丝杠螺母内滚道牙形的测量[J].计量技术ꎬ1993(1):1-2.[5]RaoZꎬZhangY.Screwthreadparametermeasurementsys ̄tembasedonimageprocessingmethod[C].InternationalSymposiumonPhotoelectronicDetection&Imagingꎬ2013. [6]ZhuWBꎬZhongJꎬRen ̄YunMOꎬetal.DesignofSpectralConfocalChromaticDisplacementSensorObjective[J].Op ̄to ̄ElectronicEngineeringꎬ2010ꎬ37(8):62-66. [7]郝维娜ꎬ令锋超ꎬ刘志刚ꎬ等.轴承滚珠面型误差激光干涉测量系统的研究[J].西安交通大学学报ꎬ2016ꎬ50(6):83-89.[8]SchluchterCWꎬLeeHL.Heterodynelaserinterferometerwithporroprismsformeasuringstagedisplacement[P].美国专利:7355719ꎬ2008-04-08.[9]CafisoSꎬDᶄAgostinoCꎬDelfinoEꎬetal.Lasertriangula ̄tionmeasurementsystem:Applicationonrailwaytrack[C].TenthInternationalConferenceontheBearingCapacityofRoadsꎬRailwaysandAirfields.BcrraAthensꎬ2017. [10]Veitch ̄MichaelisJꎬTaoYꎬWaltonDꎬetal.CrackDetec ̄tionin"As ̄Cast"SteelUsingLaserTriangulationandMa ̄chineLearning[C].ComputerandRobotVisionꎬ2016.(编辑㊀李秀敏)011 组合机床与自动化加工技术㊀第5期。

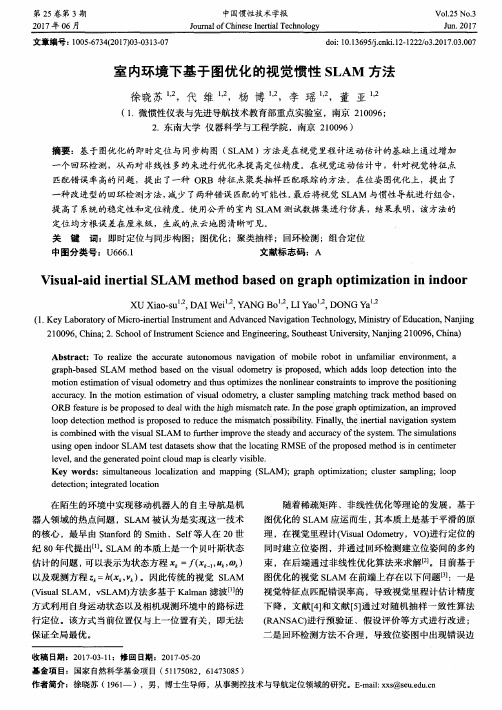

室内环境下基于图优化的视觉惯性SLAM方法

a c c u r a c y . I n t h e mo t i o n e s t i ma t i o n o f v i s u a l o d o me t r y , a c l u s t e r s a mp l i n g ma t c h i n g t r a c k me t h o d b a s e d o n OR B f e a t u r e i s b e p r o p o s e d t o d e a l wi h t t h e h i g h mi s ma t c h mt e . I n he t P o s e g r a p h o p t i mi z a t i o n , a n i mp r o v e d

( 1 . K e y L a b o r a t o r y o f Mi c r o - i n e r t i a l I n s t r u me n t a n d A d v a n c e d N a v i g a t i o n T e c h n o l o g y , Mi n i s t r y o f E d u c a t i o n , N a n j i n g

2 1 0 0 9 6 , C h i n a ; 2 . S c h o o l o f I n s t r u me n t S c i e n c e a n d E n g i n e e r i n g , S o u t h e a s t U n i v e r s i t y , Na n j i n g 2 1 0 0 9 6 , C h i n a )

( 1 . 微惯性仪 表与先进导航技术教育部重点实验室 ,南京 2 1 0 0 9 6 9 ・

地板分割算法

地板分割算法

地板分割算法是一种图像处理技术,主要用于将图像中的地板区域与非地板区域进行区分。

这种算法通常用于机器人导航、室内场景理解等领域。

以下是地板分割算法的常见方法:

1. 基于阈值的分割算法:该算法通过设定一个阈值,将图像中像素值大于阈值的部分认为是地面,小于阈值的部分认为是非地面。

这种方法简单快速,但对于复杂的地面场景效果不佳。

2. 基于区域生长的分割算法:该算法通过选择一个种子点,然后根据像素的相似性将周围的像素合并到种子点所在的区域中,直到整个地面区域被分割出来。

这种方法对于复杂的地面场景效果较好,但计算量较大。

地板分割算法的精度和效率取决于多种因素,如光照条件、地板材料的颜色和纹理等。

为了提高算法的性能,可以采用一些改进措施,例如使用多尺度分析、引入深度学习技术等。

以上信息仅供参考,如需了解更多信息,建议查阅相关文献或咨询专业人士。

基于图像识别的室内导航解决方案

基于图像识别的室内导航解决方案在当今快节奏的社会中,人们对于便捷、高效的室内导航需求日益增长。

无论是大型商场、医院、机场还是博物馆等复杂的室内环境,传统的导航方式往往存在诸多局限性,无法满足人们的精准导航需求。

而基于图像识别的室内导航技术作为一种创新的解决方案,正逐渐崭露头角,为人们带来更加智能、便捷的室内导航体验。

一、室内导航面临的挑战室内环境通常比室外环境更加复杂和多样化。

建筑物的结构、布局和装修风格各不相同,而且室内空间往往被分隔成多个区域,通道狭窄且曲折。

此外,室内信号的干扰和衰减也给传统的导航技术带来了很大的困难,例如 GPS 在室内的定位精度往往很低,甚至无法使用。

在传统的室内导航方法中,基于蓝牙、WiFi 等技术的定位方案虽然能够在一定程度上提供位置信息,但精度有限,而且需要大量的基础设施部署和维护。

另外,基于二维码或地标识别的导航方式则需要用户主动寻找特定的标识,操作不够便捷,用户体验也不够友好。

二、图像识别技术在室内导航中的应用原理图像识别技术是基于计算机视觉和机器学习的原理,通过对图像中的特征进行提取和分析,从而实现对物体或场景的识别和理解。

在室内导航中,图像识别技术主要通过以下几个步骤来实现导航功能:首先,需要对室内环境进行图像采集。

这可以通过安装在室内的摄像头或者用户使用移动设备拍摄的照片来完成。

采集到的图像包含了丰富的室内信息,如墙壁、门窗、楼梯、标志物等。

然后,利用图像识别算法对采集到的图像进行处理和分析。

算法会提取图像中的特征点,如边缘、角点、纹理等,并与预先建立的室内地图数据库中的特征进行匹配和比对。

通过特征匹配和比对,系统能够确定用户当前所在的位置和方向。

同时,结合室内地图和路径规划算法,为用户生成最优的导航路线,并以直观的方式展示在用户的移动设备上,如手机屏幕上的地图和箭头指示。

三、基于图像识别的室内导航系统的组成部分一个完整的基于图像识别的室内导航系统通常包括以下几个主要组成部分:图像采集设备:这可以是固定安装在室内的摄像头,也可以是用户携带的移动设备(如手机、平板电脑)上的摄像头。

基于图像处理与计算机视觉的室内导航与定位研究

基于图像处理与计算机视觉的室内导航与定位研究室内导航与定位是现代社会中一个重要且日益受关注的研究领域。

传统导航系统在室内环境中有很多限制,如卫星信号无法穿透建筑、信号干扰等。

因此,基于图像处理与计算机视觉的室内导航与定位成为一种可行且有效的解决方案。

本文将针对该主题进行综述,包括室内导航与定位的背景、现有研究方法和应用前景。

首先,我们先来了解室内导航与定位的背景。

室内环境与室外环境存在明显的差异,室内通常有限的视野和复杂的结构,同时导航与定位的需求也更加精准。

目前,人们对室内导航与定位的需求主要集中在以下几个方面:室内定位服务、室内导航和导览、室内运动追踪等。

传统的室内导航与定位方法主要依赖于无线信号传输和惯性导航,但由于各种限制,如无法穿透建筑、精度不高等,图像处理与计算机视觉技术成为一种新的解决方案。

基于图像处理与计算机视觉的室内导航与定位的核心是视觉信息的提取和处理。

它利用室内环境中的摄像头或激光扫描仪来获取图像数据并进行处理。

在图像处理方面,主要包括特征提取、特征匹配和图像拼接等技术。

特征提取是指从图像中提取出具有代表性的特征点或特征描述子,常用的方法有SIFT、SURF、ORB等。

特征匹配是指将两幅图像中的特征点进行匹配,从而确定它们之间的对应关系。

图像拼接是指将多个图像拼接成一个完整的地图或全景图,以提供更全面的导航和定位信息。

除了图像处理技术,计算机视觉也在室内导航与定位中起着关键作用。

计算机视觉是利用计算机对图像进行分析和理解的一门技术,其主要涉及目标检测、目标跟踪和场景识别等方面。

在室内导航与定位中,可以利用计算机视觉技术实现室内地标物识别、人体运动跟踪等功能。

例如,通过识别室内地标物,可以实现室内导航和路径规划;通过人体运动跟踪,可以实现室内行为分析和实时定位。

在现有研究方法方面,基于图像处理与计算机视觉的室内导航与定位已经取得了一些重要的进展。

研究人员提出了各种算法和模型,以解决室内导航与定位的问题。

基于球体坐标系地面分割方法

基于球体坐标系地面分割方法【原创版4篇】目录(篇1)1.引言2.球体坐标系的概述3.基于球体坐标系的地面分割方法3.1 球体坐标系的转换3.2 地面分割算法3.3 算法的优缺点分析4.结论正文(篇1)【引言】在计算机图形学中,地面分割是一个重要的研究领域。

基于球体坐标系的地面分割方法是一种较为新颖的方法,相较于传统的地面分割方法,它具有更高的计算效率和更好的视觉效果。

本文将对该方法进行详细的介绍和分析。

【球体坐标系的概述】球体坐标系是一种三维坐标系,以球体的球心为原点,球体的半径为坐标轴的尺度。

球体坐标系在地图表示、天体物理学等领域有着广泛的应用。

【基于球体坐标系的地面分割方法】【3.1 球体坐标系的转换】在实际应用中,通常需要将常用的笛卡尔坐标系或圆柱坐标系转换为球体坐标系。

这一步可以通过一系列的矩阵变换来实现。

【3.2 地面分割算法】基于球体坐标系的地面分割算法,主要采用地形高度作为输入数据,通过计算地形高度的梯度,确定地面的位置。

具体的算法步骤如下:1.根据地形高度数据,计算地形的高度梯度。

2.根据高度梯度,确定地面的法线。

3.根据地面的法线,对地形进行二值化处理,得到地面分割结果。

【3.3 算法的优缺点分析】该算法的优点有:1.计算效率高:该算法利用了球体坐标系的特性,减少了计算量。

2.视觉效果好:由于采用了球体坐标系,地面分割结果在视觉效果上更加自然。

缺点有:1.算法的适用性有限:该算法仅适用于球体坐标系,对于其他坐标系,需要进行额外的转换。

2.地形数据要求高:算法的效果受到地形数据的影响较大,需要高质量的地形数据支持。

【结论】基于球体坐标系的地面分割方法,具有高效率和好效果的优点,是一种有前景的地面分割方法。

目录(篇2)一、引言二、球体坐标系概述三、地面分割方法的必要性四、基于球体坐标系的地面分割方法1.球体坐标系的特点2.基于球体坐标系的分割方法3.算法实现与优化五、应用实例与效果分析六、总结与展望正文(篇2)一、引言在计算机图形学领域,地面分割是一个重要的研究方向。

机器人视觉导航技术使用教程与算法优化

机器人视觉导航技术使用教程与算法优化导语:机器人视觉导航技术的应用范围越来越广泛,无论是在工业自动化、智能家居还是服务机器人领域,都发挥着重要的作用。

本文将为您介绍机器人视觉导航技术的基础原理、使用教程以及算法优化方面的内容。

一、机器人视觉导航技术的基础原理1. 传感器选择与配置机器人视觉导航技术的基础是通过传感器收集环境信息,判断机器人当前位置和周围障碍物情况,以便规划最优路径。

常见的传感器包括激光雷达、摄像头和红外线传感器等,不同的传感器具有不同的测量范围和精度,在选择和配置传感器时需根据具体目标和环境需求进行考虑。

2. 室内定位算法基于机器人室内导航的视觉定位算法主要有激光定位、视觉里程计和基于地图的定位等。

其中,激光定位通过激光雷达扫描环境,并通过SLAM算法实时构建地图和估计位置;视觉里程计通过图像序列计算机器人运动的视觉里程,进而估计机器人的位置;基于地图的定位则是通过已知地图与机器人传感器数据的对比,估计机器人的位置。

根据实际需求和资源,选择合适的算法进行定位。

3. 路径规划与避障算法路径规划是机器人导航的关键环节之一,主要包括全局路径规划和局部路径规划。

全局路径规划通过地图信息进行规划,通常使用A*算法、Dijkstra算法等;而局部路径规划则通过实时感知环境信息,避免障碍物并引导机器人到达目标点,常见的算法有DWA(动态窗口方法)和RRT(快速随机树算法)等。

二、机器人视觉导航技术的使用教程1. 传感器配置与校准首先,根据实际需求选择合适的传感器,并在机器人上进行配置与校准。

例如,摄像头需进行角度校准和畸变矫正,激光雷达需进行坐标系转换和外参标定等。

2. 地图建立与导入在进行机器人视觉导航前,需要先构建环境地图。

可以利用激光雷达和SLAM算法实现实时地图构建;另外,也可以使用CAD软件绘制地图并通过特定格式导入。

3. 定位与路径规划选择合适的定位算法,并将定位数据与地图数据相融合,以提供准确的机器人位置信息。

基于RSSI和惯性导航的融合室内定位算法

基于RSSI和惯性导航的融合室内定位算法朱亚萍;夏玮玮;章跃跃;燕锋;左旭舟;沈连丰【摘要】To cater for the requirements of high-precision indoor localization algorithms,a hybrid indoor localization algorithm based on received signal strength identification (RSSI) and inertial navigation was proposed.This algorithm used fingerprint identification algorithm to localize the agents,based on the RSSI values of ZigBee nodes in wireless sensor network.The algorithm combined the inertial information provided by inertial measurement units (IMU),to correct the RSSI localization results.This algorithm used Kalman filter and adopted state equations to describe the dynamic change rules of agents' positions,thus it achieved a hybrid localization algorithm which relied WSN localization first and IMU last.Simulations evaluate that the proposed algorithm can improve the localization performances of algorithms which adopt RSSI localization and inertial navigation individually,and can greatly improve localization accuracy.%针对目前对高精度室内定位算法的需求,提出一种基于接收信号强度识别(RSSI)和惯性导航的融合室内定位算法.基于无线传感网中ZigBee节点的RSSI 值,采用位置指纹识别算法,对网络中的未知节点进行定位.结合惯性传感单元(IMU)提供的惯性数据,对RSSI定位结果进行融合修正.利用Kalman滤波器,采用状态方程描述待定位节点位置坐标的动态变化规律,从而实现一种以无线传感网络定位为主、IMU为辅的融合定位方法.仿真结果表明,提出的融合定位算法既能改善单独使用RSSI定位受环境干扰较大的问题,又能避免单独使用惯性导航带来的累积误差,极大地提高了定位精度.【期刊名称】《电信科学》【年(卷),期】2017(033)010【总页数】8页(P99-106)【关键词】高精度室内定位;接收信号强度识别;惯性导航;融合定位算法【作者】朱亚萍;夏玮玮;章跃跃;燕锋;左旭舟;沈连丰【作者单位】东南大学移动通信国家重点实验室,江苏南京210096;东南大学移动通信国家重点实验室,江苏南京210096;东南大学移动通信国家重点实验室,江苏南京210096;东南大学移动通信国家重点实验室,江苏南京210096;电子科技大学信息与软件工程学院,四川成都610054;东南大学移动通信国家重点实验室,江苏南京210096【正文语种】中文【中图分类】TP393近年来数据业务的快速增长促成了基于位置服务(location-based service,LBS)的蓬勃发展,也促使了人们对导航定位技术准确性、可靠性和连续性的要求更加迫切[1]。

基于视觉惯性SLAM的室内定位方法研究

基于视觉惯性SLAM的室内定位方法研究

蒋欣

【期刊名称】《测绘与空间地理信息》

【年(卷),期】2024(47)4

【摘要】针对纯视觉SLAM在光照变化明显、环境纹理较少及载体快速运动的室内场景中容易出现特征跟踪失败、定位精度下降等问题,本文提出了一种基于滑动窗口进行后端优化的视觉惯导紧耦合方法,融合了IMU信息以提高跟踪精度与系统的鲁棒性。

该方法利用IMU预积分误差与单目视觉SLAM的重投影误差构建新的损失函数来进行状态估计,采用基于滑动窗口的非线性优化方法进行运动估计,实时恢复组合系统位姿。

在实测数据集上的实验结果表明,本文方法在x轴方向上的均方根误差为0.124 m,y轴方向上的均方根误差为0.113 m,实现了厘米级精度的定位。

【总页数】4页(P221-224)

【作者】蒋欣

【作者单位】辽宁省自然资源事务服务中心

【正文语种】中文

【中图分类】P209

【相关文献】

1.基于视觉惯性里程计与语义信息的无人机SLAM方法研究

2.基于点线特征的改进视觉惯性SLAM方法

3.基于点线视觉/惯性SLAM和目标检测的测距方法

4.一

种基于点线融合的室内视觉惯性SLAM方法5.一种基于因子图消元优化的激光雷达视觉惯性融合SLAM方法

因版权原因,仅展示原文概要,查看原文内容请购买。

点云地面分割算法

点云地面分割算法随着三维激光扫描技术的发展,点云数据成为了三维数据处理领域的重要数据类型之一。

点云地面分割是点云处理中的一个重要问题,它的目的是将点云数据分为地面和非地面两部分。

本文将介绍点云地面分割算法的原理和实现方法。

一、点云地面分割算法原理点云地面分割算法的原理是基于地面和非地面点的特征差异。

在点云数据中,地面点通常具有以下特征:1. 高度较低:地面点的高度相对于传感器的高度较低。

2. 平坦性:地面点周围的点的高度变化较小,呈现出平坦的特征。

3. 稠密性:地面点的分布比较密集,且分布较为规则。

基于以上特征,点云地面分割算法可以分为以下两类:1. 基于高度阈值的分割算法:该算法将点云数据中高度低于一定阈值的点判定为地面点。

该算法简单易实现,但对于地面高度变化较大的情况,分割效果不佳。

2. 基于拟合平面的分割算法:该算法将点云数据拟合为一个平面,将点云数据中与平面距离较小的点判定为地面点。

该算法可以适应地面高度变化较大的情况,但对于非平面地形的情况,分割效果不佳。

二、点云地面分割算法实现方法1. 基于高度阈值的分割算法实现方法:(1)确定高度阈值:根据地面高度的分布情况,确定一个适当的高度阈值。

(2)计算点云数据中各点的高度:根据传感器高度和点云数据中各点的坐标,计算出各点的高度。

(3)判定地面点:将高度低于阈值的点判定为地面点。

(4)输出地面点云数据:将地面点云数据输出,即可完成点云地面分割。

2. 基于拟合平面的分割算法实现方法:(1)对点云数据进行滤波处理:为了减少噪点对拟合平面的影响,可以对点云数据进行滤波处理。

(2)拟合平面:利用点云数据拟合平面,得到平面方程。

(3)计算点云数据中各点到平面的距离:根据平面方程,计算点云数据中各点到平面的距离。

(4)判定地面点:将与平面距离小于一定值的点判定为地面点。

(5)输出地面点云数据:将地面点云数据输出,即可完成点云地面分割。

三、点云地面分割算法实例下面以一个点云地面分割的实例来说明算法的实现过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

的分割过程。但是这种方法存在的问题是需要人工参 与、算法的通用性差等问题。在不同的室内环境中, 如果地面区域的颜色、纹理等特征不同,则需要重新 设定地面特征信息; 同时, 即使是在同一室内环境中, 随着光照条件变化的影响, 也会使得地面区域的颜色、 纹理等特性发生较大的变化, 从而会降低算法的性能。

Floor segmentation algorithm for indoor vision/inertial integrated navigation

WANG Jian-ming1, WANG Xi1, WANG Sheng-bei1, LI Shi-xin2, LENG Yu3

(1. School of Electronics and Information Engineering,Tianjin Polytechnic University, Tianjin 300160, China; 2. Tianjin Navigation Instruments Research Institute, Tianjin 300131, China; 3. Suzhou Entry-Exit Inspection and Quarantine Bureau, Suzhou 215021, China) Abstract: Navigation is a key technology for autonomous robots, which makes them movable in an unknown environment. To tackle the difficulty of building indoor navigation map for inertial navigation systems, a new map building method for inertial/visual navigation is proposed. By limiting robot’s movement within the floor areas, the global navigation map is generated from a bird-view image. An algorithm of automatic floor segmentation is proposed, which employs principal component analysis to implement dimension reduction for local color features and adopts clustering analysis to realize floor segmentation automatically. Finally, an indoor bird-view image database is built to evaluate the algorithm. The algorithm gets the worst performance, 75% averaged accurate segmentation rate, on the fourth group images because illumination reflection is found in the images. Average accurate segmentation rates on other groups are around 85%. Thus, the preprocessing algorithms, such as illumination refection detection, can help to improve the performance of the algorithm. Keywords: indoor autonomous robot; integrated navigation; image segmentation; clustering analysis

ri , j

( j 1) L2 1 ( i 1) L1 1 k jL2

l iL1

I (k , l ,1) ,

gi , j

( j 1) L2 1 ( i 1) L1 1 k jL2

[2] [1]

案,把图像传感器固定在天花板上,实时拍摄室内的 俯视图像,如图 1 所示。 该导航方案的工作过程如下:首先利用图像传感 器获取室内环境的俯视图像,然后利用无线通信技术 实时地把图像数据传输给机器人;机器人根据接收到 的图像进行计算,以获取或更新当前室内环境的全局 导航地图;利用惯性传感器获取机器人的运动状态, 同时从俯视图像中获得机器人在全局地图的位置,通 过路径规划算法完成机器人的导航过程。 研究过程中采用如下假设: 假设 1: 机器人仅在室内环境中的地面区域活动, 其它区域都视为禁止机器人活动的障碍物区域; 假设 2:在室内环境的俯视图像中,地面区域所 占比例最大; 假设 3: 所有地面区域的颜色、 纹理特征是一致的。 基于以上假设,只要指定室内各标志性物体在俯 视图像中的位置,然后从俯视图像中分割出地面区域 作为机器人活动区域以实现障碍物自动躲避,就可以 很方便的建立全局导航地图。 本文主要研究俯视图像地面区域自动分割算法。

移动机器人需要在未知、复杂以及动态的环境中 自主移动,因此导航技术是移动仪器人的核心技术之

收稿日期:2011-08-26;修回日期:2011-09-20

一。移动机器人的导航方法有多种,如惯性导航、电 磁导航、GPS导航和视觉导航等等。其中惯性导航和

基金项目:天津市应用基础及前沿技术研究计划(项目名称:室内移动机器人视觉导航新方法研究(10JCYBJC26300) 作者简介:汪剑鸣(1974—) ,男,博士,教授,硕士生导师,主要从事机器人导航,计算机视觉与模式识别等方面的研究。 E-mail: wangjianming@

天

花

图像 传感 器

板

视野范围

导航组件 机器人

图1 Fig.1 图像采集方案示意图

Scheme of image acquis为了完成对俯视图像中地面区域的分割,可以首

先指定地面区域的颜色、纹理等特征,然后完成图像

1

惯性/视觉组合导航中的图像采集方案

在室内环境中,移动机器人一般是在地面区域行

(1. 天津工业大学 电子与信息工程学院,天津 300160;2. 天津航海仪器研究所,天津 300131; 3. 苏州出入境检验检疫局,苏州 215021)

摘要: 导航技术是机器人实现自主移动的关键技术之一。 针对惯性导航创建全局导航地图困难等问题, 提出一种新的惯性/视觉组合导航室内全局地图创建方法。规定机器人只能在地面区域中移动,并利 用室内俯视图像建立全局地图,提出一种俯视图像地面区域的自动分割算法。首先,利用主元分析算 法对图像的局部颜色特征进行降维;其次,利用聚类算法对地面区域进行自动分割;最后,建立了室 内俯视图像数据库并对算法的性能进行了验证。由于第四组图像中包含反光区域,算法的分割结果较 差,平均正确分辨率为 75%。算法在其他各组的平均正确分割率为 85%左右。为提高算法的性能,可 在应用本算法前利用反光区域检测算法对图像进行预处理。 关 键 词:室内移动机器人;组合导航;图像分割;聚类分析 文献标志码:A 中图分类号:U666.1

设彩色图像用 I 表示,为 M×N×3 的矩阵,划分 的图像块大小为 m×n,提取后的局部颜色特征集合为 F={fi,j|i=1,2……L1,j=1,2……L2} (1)

ri、 其中,fi 为三维向量,即 fi={ri,j, gi,j, bi,j}。L1、L2、 gi、 bi 分别按下式计算:

M N L1 , L2 , m n

第 19 卷第 5 期 2011 年 10 月 文章编号:1005-6734(2011)05-0553-06

中国惯性技术学报 Journal of Chinese Inertial Technology

Vol.19 No.5 Oct. 2011

室内惯性/视觉组合导航地面图像分割算法

汪剑鸣 1,王 曦 1,王胜蓓 1,李士心 2,冷 宇 3

走。如果能够获取室内的地面区域,则可以解决机器 人在移动过程中障碍物躲避、路径规划等问题,同时 也可以建立全局导航地图。为了获取室内环境的全局 图像,本文采用图像传感器与机器人相分离的设计方

第5期

汪剑鸣等: 室内惯性/视觉组合导航地面图像分割算法

555

针对上述问题,本文提出一种自适应地面分割算 法。该算法的基本思想如下:如果假设 2 成立,则在 俯视图像中地面区域的样本数最多。根据这个特点, 利用聚类算法对图像特征的样本点进行分析,认为在 聚类结果中样本数最多的一类即为地面区域样本。算 法主要步骤如下: 1) 利用图像局部特征提取算法, 得到图像特征的 样本数据; 2) 采用主元向量分析算法, 对图像的特征数据进 行降维; 3) 设计聚类算法,对样本数据进行自动分类; 4) 根据分类结果的样本数量, 判断地面区域样本 的类别完成地面区域的分割,并分割进行后处理。 2.1 特征提取 本文主要采用图像的局部颜色特征作为分割地面 的依据。 提取图像的局部颜色特征时, 可以直接把每个 象素点的颜色值作为一个特征向量,但存在如下不足: 1) 每个像素点都参与运算, 会使得计算量大大增 加,严重影响聚类算法的运算速度,从而影响到整个 系统的实时性; 2) 直接对单个像素点的颜色特征进行聚类分析, 易受噪声影响。 因此在提取颜色的局部信息时,首先对原始图像 进行分块处理, 然后对每个图像块提取平均颜色特征。 图像分块的实例如图 2(b)所示。

554

中国惯性技术学报

第 19 卷

视觉导航是最常用的两种导航方式,为了提高导航系 统的整体性能,实现两种导航方式的优势互补,惯性/ 视觉组合导航已经成为导航领域的又一个热点问题。 1997 年 Bosse 等人采用图像分析和惯性技术相 融合的方法研究了直升机降落时,需要进行平移速度 和旋转速度精确估计的问题。2003年Skaff 等人研究 了Hexapod机器人的导航问题,Hexapod机器人是一种 利用六条腿行走的机器人, 作者采用惯性/视觉相结合 的方式实现了机器人沿直线行走的导航。2007年南京 航空航天大学的熊智等[5],提出飞行器景象匹配辅助/ 惯性组合导航方案,通过机载图像传感器实时获取地 面景物图像并与计算机内预存二维数字图像进行匹 配,为惯性导航系统提供实时的位置修正信息。2008 年Carlo[3]等研究了利用立体视觉辅助惯性导航的方法 来解决室内有遮挡以及复杂市区环境中飞行机器人运 动状态精确估计的问题。 2010 年 Markus Kleinert 、 Sebastian Schleith[4],在室内GPS导航失效的情况下, 采用视觉同时定位与地图构建(即Visual SLAM)技 术辅助惯性导航的方法,实时建立了环境的增量式地 图,有效抑制了导航系统的误差积累。 惯性导航是指利用机器人的瞬时加速度和角加速 度等数据来完成机器人的导航过程。由于惯性导航所 需要的数据都来自于机器人系统的内部,因此具有不 依赖外界信息,不易受外界干扰影响等优点。 但存在的 问题是由于只利用内部数据实现导航,因而难以获取 环境的全局信息。为了解决在室内环境中惯性导航建 立全局导航地图困难的问题,本文提出了一种新的惯 性/视觉组合导航的全局地图创建方法, 首先通过安装 在天花板上的相机获取室内环境的俯视图像,然后从 中提取地面区域作为机器人移动的区域,从而实现机 器人移动过程中的自动避障并建立室内的环境的全局 导航地图。本文主要对俯视图像地面区域自动分割算 法进行了研究,基于PCA和聚类分析技术设计一种地 板区域自动分割算法,该算法具有不需要人工参与, 通用性好, 对光照等环境变化具有自适应能力等优点。