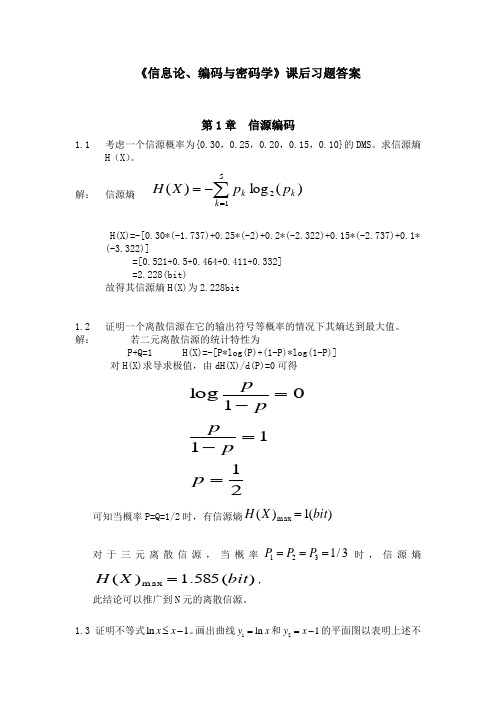

信息论--第四章·第七节 霍夫曼码与其他编码方法-文档资料

Huffman霍夫曼编码

霍夫曼编码的局限性

利用霍夫曼编码,每个符号的编码长度只能 为整数,所以如果源符号集的概率分布不是 2负n次方的形式,则无法达到熵极限。 输入符号数受限于可实现的码表尺寸 译码复杂 需要实现知道输入符号集的概率分布 没有错误保护功能

尾码为DIFF的B位

原码,若DIFF0 反码,若DIFF0

按此规则,当DIFF0时,尾码的最高位是“1”; 而当DIFF0时则为“0”。解码时则可借此来判断 DIFF的正负。 书中例4—9

自适应霍夫曼编码提出的目的和意义:

在静态霍夫曼编码中,要构造编码树必须提前统计 被编码对象中的符号出现概率,因此必须对输入符 号流进行两遍扫描,第一遍统计符号出现概率并构 造编码树,第二遍进行编码,这在很多实际应用的 场合中之不能接受的。其次,在存储和传送霍夫曼

i 1 i

n

单位:以2为底的对数时是比特/符号(bit/symbol); 以e为底的对数时是奈特/符号(nat/symbol); 以10为底的对数时是哈特/符号( hart/symbol) 其中 I(xi)=-logp(xi) 表示某个事件xi的信息量。

平均码长 编码效率

例:现有一个由5个不同符号组成的30个符号的字 符串:BABACACADADABBCBABEBEDDABEEEBB 计算 (1) 该字符串的霍夫曼码 (2) 该字符串的熵 (3) 该字符串的平均码长

霍夫曼(Huffman)编码是一种统计编码。 属于无损(lossless)压缩编码。 以霍夫曼树─即最优二叉树,带权路径长 度最小的二叉树,经常应用于数据压缩。 根据给定数据集中各元素所出现的频率来 压缩数据的一种统计压缩编码方法。这些 元素(如字母)出现的次数越多,其编码的 位数就越少。 广泛用在JPEG, MPEG, H.2X等各种信息编 码标准中。

Huffman编码原理简介

以下是Huffman编码原理简介:霍夫曼(Huffman)编码是1952年为文本文件而建立,是一种统计编码。

属于无损压缩编码。

霍夫曼编码的码长是变化的,对于出现频率高的信息,编码的长度较短;而对于出现频率低的信息,编码长度较长。

这样,处理全部信息的总码长一定小于实际信息的符号长度。

对于学多媒体的同学来说,需要知道Huffman编码过程的几个步骤:l)将信号源的符号按照出现概率递减的顺序排列。

(注意,一定要递减)2)将最下面的两个最小出现概率进行合并相加,得到的结果作为新符号的出现概率。

3)重复进行步骤1和2直到概率相加的结果等于1为止。

4)在合并运算时,概率大的符号用编码0表示,概率小的符号用编码1表示。

5)记录下概率为1处到当前信号源符号之间的0,l序列,从而得到每个符号的编码。

下面我举个简单例子:一串信号源S={s1,s2,s3,s4,s5}对应概率为p={40,30,15,10,5},(百分率)按照递减的格式排列概率后,根据第二步,会得到一个新的概率列表,依然按照递减排列,注意:如果遇到相同概率,合并后的概率放在下面!最后概率最大的编码为0,最小的编码为1。

如图所示:所以,编码结果为s1=1s2=00s3=010s4=0110s5=0111霍夫曼编码具有如下特点:1) 编出来的码都是异字头码,保证了码的唯一可译性。

2) 由于编码长度可变。

因此译码时间较长,使得霍夫曼编码的压缩与还原相当费时。

3) 编码长度不统一,硬件实现有难度。

4) 对不同信号源的编码效率不同,当信号源的符号概率为2的负幂次方时,达到100%的编码效率;若信号源符号的概率相等,则编码效率最低。

5) 由于0与1的指定是任意的,故由上述过程编出的最佳码不是唯一的,但其平均码长是一样的,故不影响编码效率与数据压缩性能。

霍夫曼编码的C语言实现#include <stdio.h>#include <malloc.h>#include <conio.h>#include <string.h>#include <stdlib.h>#define HuffmanTree HF#define HuffmanCode HMCtypedef struct{unsigned int weight;unsigned int parent,lchild,rchild;} HTNode,*HF;typedef char **HMC;typedef struct {unsigned int s1;unsigned int s2;} MinCode;void Error(char *message);HMC HuffmanCoding(HF HT,HMC HC,unsigned int *w,unsigned int n); MinCode Select(HF HT,unsigned int n);void Error(char *message){fprintf(stderr,"Error:%s\n",message);exit(1);}HMC HuffmanCoding(HF HT,HMC HC,unsigned int *w,unsigned int n) {unsigned int i,s1=0,s2=0;HF p;char *cd;unsigned int f,c,start,m;MinCode min;if(n<=1) Error("Code too small!");m=2*n-1;HT=(HF)malloc((m+1)*sizeof(HTNode));for(p=HT,i=0;i<=n;i++,p++,w++){p->weight=*w;p->parent=0;p->lchild=0;p->rchild=0;}for(;i<=m;i++,p++){p->weight=0;p->parent=0;p->lchild=0;p->rchild=0;}for(i=n+1;i<=m;i++){min=Select(HT,i-1);s1=min.s1;s2=min.s2;HT[s1].parent=i;HT[s2].parent=i;HT[i].rchild=s2;HT[i].weight=HT[s1].weight+HT[s2].weight;}printf("HT List:\n");printf("Number\t\tweight\t\tparent\t\tlchild\t\trchild\n"); for(i=1;i<=m;i++)printf("%d\t\t%d\t\t%d\t\t%d\t\t%d\n",i,HT[i].weight,HT[i].parent,HT[i].lchild,HT[i].rchild); HC=(HMC)malloc((n+1)*sizeof(char *));cd=(char *)malloc(n*sizeof(char *));cd[n-1]='\0';for(i=1;i<=n;i++){start=n-1;for(c=i,f=HT[i].parent;f!=0;c=f,f=HT[f].parent)if(HT[f].lchild==c) cd[--start]='0';else cd[--start]='1';HC[i]=(char *)malloc((n-start)*sizeof(char *));strcpy(HC[i],&cd[start]);}free(cd);return HC;}void main(){MinCode Select(HF HT,unsigned int n);HF HT=NULL;HuffmanCode HC=NULL;unsigned int *w=NULL;printf("请输入节点数n:");scanf("%d",&n);w=(unsigned int *)malloc((n+1)*sizeof(unsigned int *)); w[0]=0;printf("请输入权重:\n");for(i=1;i<=n;i++){printf("w[%d]=",i);scanf("%d",&w[i]);}HC=HuffmanCoding(HT,HC,w,n);printf("HMC:\n");printf("Number\t\tWeight\t\tCode\n");for(i=1;i<=n;i++)printf("%d\t\t%d\t\t%s\n",i,w[i],HC[i]);}MinCode Select(HF HT,unsigned int n){unsigned int min,secmin;unsigned int temp;unsigned int i,s1,s2,tempi;MinCode code;s1=1;s2=1;for(i=1;i<=n;i++)if(HT[i].parent==0){min=HT[i].weight;s1=i;break;}tempi=i++;for(;i<=n;i++)if(HT[i].weight<min&&HT[i].parent==0){min=HT[i].weight;s1=i;}for(i=tempi;i<=n;i++)if(HT[i].parent==0&&i!=s1){secmin=HT[i].weight;s2=i;break;}for(i=1;i<=n;i++)if(HT[i].weight<secmin&&i!=s1&&HT[i].parent==0) {secmin=HT[i].weight;s2=i;}if(s1>s2){temp=s1;s1=s2;s2=temp;}code.s1=s1;code.s2=s2;return code;}。

信息论基础——信源编码-文档资料

3.1 等长码 3.2 变长编码 3.3 哈夫曼码 3.4 算术码 3.5 通用信源编码 习题三

香农-费诺码 LZW算法

1

算术码—Shannon-Fano-Elias码

0.概述

是第一个能够找到的好的变长码.

原则:按照符号出现的概率从大到小排序,然后将 其分成两个出现概率相同或几乎相同的子集—一个 子集的编码均以0打头,另一个子集的编码均以1打 头;然后把每个子集再分成两个更小的子集,同样 确定所有码字的第二位,依次循环.

对该信源编二进制香农-费诺码. 其编码过程如下表示:

12

算术码—Shannon-Fano-Elias码

xi p(xi) x1 0.25 x2 0.25 x3 0.20 x4 0.15 x5 0.10 x6 0.05

pa(xj)

二进制香农编码 li 码字

0.125

3 001 (0.001)2

0.375

L 0 . 2 5 2 2 ( 0 . 2 0 . 1 5 ) 3 0 . 1 0 4 0 . 0 5 5 2 . 7 ( 比 特 / 符 号 )

若对上述信源采用等长编码,要做到无失真译码,每个符号至少要用3 个比特表示。相比较,香农编码对信源进行了压缩。

7

算术码—Shannon-Fano-Elias码

2.编码方法

1)将信源符号X={a1,a2,……,aq}依次排列(不要求以概率 大小排序);

2)计算各符号的修正累积分函数值

k1

1

F(xak)

i1

p(ai)2p(ak)

3)确定各信源符号所对应码字的码长

[x]代表不小 于x的整数

l(ak

由离散无记忆信源熵定义,可计算出:

信息论与编码课件(第四章)

• 信源编码基本思想:尽可能缩短出现概率大的信 源符号的码字

电气信息工程学院

4.1 编码器及码的分类

• 码的分类 • 二元码:若码符号集X={0,1},所得码字为一

些二元序列,则称二元码。[在二元信道中传输]

• 允许错误概率越小,编码效率要求越高,则信源 序列长度N就必须越长。

• 实际情况下,要实现几乎无失真的等长编码,N 需要非常大。

电气信息工程学院

4.4 等长信源编码定理

• 例 设离散无记忆信源

S P(s)

s1 3

4

, ,

s2 1 4

• 信源熵 H (S)1lo4 g3lo4g 0.81 (b1istym ) bol • 自信息方差 4 4 3

• 编码的意义: • 通信的基本问题:如何高速、高质地传送信息。 • 高速和高质=鱼和熊掌。 • 编码讨论的问题: • (1)质量一定,如何提高信息传输速度(提高

编码效率或压缩比)---- 信源编码(本章讨论 问题) • (2)信道传输速度一定,如何提高信息传输质 量(抗干扰能力)----信道编码(下一章讨论)

• 当进行二元编码时,r=2,则:

等长编码时平均每个 信源符号所需的二元 码符号的理论极限

l H(S)

N

信源等 概分布

l log q N

时

• 一般情况下,信源符号并非等概率分布,且符号

之间有很强的关联性,故信源的熵H(S)<<logq。

电气信息工程学院

4.4 等长信源编码定理

• 从定理4.3可知,在等长编码中每个信源符号平 均所需的二元码符号可大大减少,从而使编码效 率提高。

信息论与编码(第四章PPT)

变长编码

l p( si )li (码元 / 信源符号).

i 1

编码速率:编码后每个信源符号所能承载的的最大信 息量

R l log m(比特 / 码符号).

编码效率:

H(X ) H(X ) . R l log m

码的多余度(剩余度):

l H ( X ) / log m 1 . l

0级节点

0 1 1 2 2

1级节点

2 0 1 2

w1

0

0

w2 w3 w4 w8

w5

2

2级节点

1

0 1

3级节点

w6 w7

w9

w10

w11

26

4.3

r

变长编码

克拉夫不等式( L.G.Kraft, 1949) 长度为l1, l2,…,lr的m元 即时码存在的充分必要条件是:

li m 1 i 1

唯一可译码: 任意有限长的码元序列,只能被唯一地分割成一个一个的 码字,则称为唯一可译码,或单义可译码. 否则,就称为非 唯一可译码, 或非单义可译码. 例:码4是唯一可译码: 1000100 1000, 100 码3是非唯一可译码: 100010010, 00, 10, 0 或10, 0, 01, 00 或10, 0, 01, 00

麦克米伦定理(麦克米伦: B. McMillan, 1956). 长度为l1, l2,…,lr的m元唯一可译码存在的充分必要条件是:

li m 1 i 1 r

27

4.3

变长编码

例 对于码长序列1,2,2,2, 有 + + + = >1,

1 1 1 1 5 2 4 4 4 4 不存在这样码长序列的唯一可译码, 如码2,码3 1 1 1 1 15 对于码长序列1,2,3,4, 有 + + + = <1, 2 4 8 16 16 存在这样码长序列的唯一可译码! 码4与码5都是唯一可译码!码5是即时码,但码4不是即时码!

霍夫曼编码及其应用

毕业设计(论文)题目:霍夫曼编码及其应用学院:数理学院专业名称:信息与计算科学学号: 0741210246学生姓名:张浩指导教师:韩海清2011 年 4 月 20 日摘要本文首先对二元霍夫曼编码进行了细致研究,并对其算法进行扩展,得到了适用于多元霍夫曼编码的算法。

然后,对霍夫曼编码的前缀性,最优性进行了证明。

最后实现了霍夫曼编码在决策论中应用。

关键词码;熵;霍夫曼编码;决策树ABSTRACTThis paper first studied binary Huffman coding, and conducted a detailed study on its algorithm suitable for expansion, get multiple Huffman coding algorithm. Meanwhile, Huffman coding prefix sex, optimality proved. Finally realized Huffman coding applied in rigorous.KEYWORDSThe Coding; The Entropy; Huffman Coding; Decision tree目录第一章引言 (4)第二章主要概念 (5)2.1香农三大定理 (5)2.1.1香农第一定理(可变长无失真信源编码定理) (5)2.1.2香农第二定理(有噪信道编码定理) (5)2.1.3香农第三定理(保失真度准则下的有失真信源编码定理) (5)2.2霍夫曼编码 (6)第三章二元霍夫曼编码及其算法 (6)第四章一般霍夫曼编码及其算法 (8)第五章霍夫曼编码的性能分析 (12)5.1霍夫曼编码的前缀性 (12)5.2霍夫曼编码的最优性定理 (13)第六章霍夫曼编码的应用 (13)第七章总结与展望 (16)参考文献 (17)附录1 (18)致谢 (30)第一章引言1948年,美国数学家香农(C.E.Shannon)在《贝尔系统电话杂志》发表了题为“通信的数学理论”的长篇论文。

信息论--第四章·第七节 霍夫曼码与其他编码方法

4.7霍夫曼码和其他编码方法

Fano码

例

P ( S S ) 0 .s 2 1 00 .s 1 2 90 .s 1 3 80 .s 1 4 70 s .1 5 50 s .1 6 00 s .0 7 1

4.7霍夫曼码和其他编码方法

Fano码

解: 信源

符号

s1

s2 s3

s4 s5 s6 s7

符号 概率 0.20 0.19 0.18 0.17 0.15 0.10 0.01

第一次 第二次 第三次 第四次 分组 分组 分组 分组

0

0

1

0

1

1

0

1

0

1

0

1

码字

00 010 011 10 110 1110 1111

码长

2 3 3 2 3 4 4

4.7霍夫曼码和其他编码方法

它是满足Kraft不等式的一种直接的应用

例:一个离散信源S:{s1,s2,s3,s4} p(S):{1/2,1/4,1/8,1/8}

这时有:L1=log2=1; L2=log4=2; L3=L4=log8=3;

4.7霍夫曼码和其他编码方法

Shannon编码举例

利用码树图法可得到其编码

L1=1, L2=2, L3=L4=3;

i 1

编码效率为

2.6196.0%

2.72

4.7霍夫曼码和其他编码方法

Huffman码

注意:霍夫曼编码后的码字不是惟一的。

1)每次对缩减信源两个概率最小的符号分配“0”或“1”码元 是任意的,因此编码的结果是不唯一的;但0/1分配的上下顺 序在整个编码过程中应保持一致,否则不能构成唯一可译码。

霍夫曼编码简介

霍夫曼编码简介霍夫曼编码是一种被广泛应用而且非常有效的数据压缩技术,根据待压缩数据的特征,一个可压缩掉20%~90%。

这里考虑的数据指的是字符串序列。

要理解霍夫曼编码,先要理解霍夫曼树,即最优二叉树,是一类带权路径长度最短的树。

霍夫曼(Huffman)编码是1952年为文本文件而建立,是一种统计编码。

属于无损压缩编码。

霍夫曼编码的码长是变化的,对于出现频率高的信息,编码的长度较短;而对于出现频率低的信息,编码长度较长。

这样,处理全部信息的总码长一定小于实际信息的符号长度。

在计算机数据处理中,霍夫曼编码使用变长编码表对源符号(如文件中的一个字母)进行编码,其中变长编码表是通过一种评估来源符号出现机率的方法得到的,出现机率高的字母使用较短的编码,反之出现机率低的则使用较长的编码,这便使编码之后的字符串的平均长度、期望值降低,从而达到无损压缩数据的目的。

路径是指从树中一个结点到另一个结点之间的通路,路径上的分支数目称为路径长度。

树的路径长度是从树根到每一个叶子之间的路径长度之和。

结点的带权路径长度为从该结点到树根之间的路径长度与该结点权的乘积,树的带权路径长度为树中所有叶子结点的带权路径长度之和.霍夫曼树是指所有叶子结点的二叉树中带权路径长度最小的二叉树.当给定了n个叶子结点的权值后,构造出的最优二叉树的结点数目m就确定了,即m=2n-1,所以可用一维结构树组来存储最优二叉树霍夫曼(Huffman)编码属于码词长度可变的编码类,是霍夫曼在1952年提出的一种编码方法,即从下到上的编码方法。

同其他码词长度可变的编码一样,可区别的不同码词的生成是基于不同符号出现的不同概率。

生成霍夫曼编码算法基于一种称为“编码树”(coding tree)的技术。

算法步骤如下:(1)初始化,根据符号概率的大小按由大到小顺序对符号进行排序。

(2)把概率最小的两个符号组成一个新符号(节点),即新符号的概率等于这两个符号概率之和。

信息论 第4章(哈夫曼编码和游程编码)

游程编码的基本原理

很多信源产生的消息有一定相关性,往往 连续多次输出同样的消息,同一个消息连续输 出的个数称为游程(Run-Length).我们只需要 输出一个消息的样本和对应重复次数,就完全 可以恢复原来的消息系列.原始消息系列经过 这种方式编码后,就成为一个个编码单元(如下 图),其中标识码是一个能够和消息码区分的特 殊符号.

文件传真压缩方法具体流程

主要利用终止码和形成码(见书本P43-44), 一般A4的纸每行的像素为1728,具体编码规则 如下: (1)当游程长度小于64时,直接用一个对应 的终止码表示。 (2)当游程长度在64到1728之间时,用一个 形成码加一个终止码表示。 例如:白游程为662时用640形成码(白)加22终 止码(白)表示,即:01100111 0000011. 黑游程为256时用256形成码(黑)加0终止码(黑) 表示,即:000001011011 0000110111.

哈夫曼(Huffman) (3)哈夫曼(Huffman)编码

哈夫曼编码:将信源中的各个消息按概率排序, 不断将概率最小的两个消息进行合并,直到合 并为一个整体,然后根据合并的过程分配码字, 得到各个消息的编码。 该方法简单明了,并且可以保证最终的编 码方案一定是最优编码方案。

哈夫曼(Huffman) 哈夫曼(Huffman)编码的例子

香农编码的例子

《信息论与编码》PPT第四章

L

L

2)误差准则:

→ → e( f , g ) p ε 即P g f (uL ) ≠ uL p ε差准则: E [e ( f , g )] p ε 即E P g f (u ) ≠ u p ε ,

四、 密码 它是研究信息与通信系统在传输最安全的指标下, 系统中的信源和信宿,在什么样条件下能实现统计匹 配,即最优的加、解密密码存在; 反之,又在什么样条件下不能实现统计匹配,即 最优的加、解密密码不存在。

定理: 设掌握密钥的信宿V,它对应的系统传送的互信息 R=I(U,V,)不掌握密钥的信宿V’,它对应的系统传 送的互信息R’=I(U,V’),信源的信息熵为H(U)。 则:掌握密钥的信宿V,通过最优化的加、解密码 V (f2,g2),使得R=I(U,V)=H(U)。 反之,对不掌握密钥的信宿V’,几乎找不到最优化密钥 (f2,g2’)=(f2,g2),即R’=I(U,V’)→0. ——1949年,香农给出的密码学基本定理。 * 概率分布分析: P (ϕ ) = P (u L ).P (cm | sm ).P ( sm | cm ) ′ ′

定理:若系统要求达到的实际传输速率为R,无失真 信源的可用信息熵为H(U),则若R>H(U)时, 最有效的信源编、译码 ( f1 , g1 ) 存在,反之R< H(U)则不存在。——香农编码第一定理。 从另一角度来理解定理——用系统的概率分布函数

′ 由无失真准则,则 即 P ( sm | uL ) = P (vL | sm ) → → 所以 P(ϕ ) = p(uL ) f .g = p(uL ) 即系统与信源匹配。

•系统优化其物理实质: 就是要研究系统在某种优化指标下,上述两类 参数在满足什么条件时对应的编、译码存在; 又在什么条件下,对应的编、译码不存在。

信息论与编码理论-第4章无失真信源编码-习题解答-20071202

信息论与编码理论-第4章无失真信源编码-习题解答-20071202信息论与编码理论第4章无失真信源编码习题及其参考答案4-1 有一信源,它有六个可能的输出,其概率分布如下表所示,表中给出了对应的码A、B、C、D、E和F(1)求这些码中哪些是唯一可译码;(2)求哪些码是及时码;(3)对所有唯一可译码求出其平均码长。

?X??s14-2 设信源????p(s)P(X)???1s6?p(s2)?p(s6)???s2?p(s)?1。

对此次能源进行m元唯一ii?16可译编码,其对应的码长为(l1,l2,…,l6)=(1,1,2,3,2,3),求m值的最好下限。

(提示:用kraft不等式)?s?X??14-3设信源为??1??p(X)???2?(1)信源的符号熵;(2)这种码的编码效率;s214s3s411816s5132s6s7s8?,编成这样的码:(000,001,111???64128128?010,011,100,101,110,111)。

求(3)相应的仙农码和费诺码。

4-4求概率分布为(,11122信)源的二元霍夫曼编码。

讨论此码对于概率分布为355151511111(,,,,)的信源也是最佳二元码。

555554-5有两个信源X和Y如下:1信息论与编码理论s2s3s4s5s6s7??X??s1??p(X)??0.200.190.180.170.150.100.01?????s2s3s4s5s6s7s8s9??Y??s1??p(Y)??0.490.140.140.070.070.040.020.02 0.01?????(1)用二元霍夫曼编码、仙农编码以及费诺编码对信源X和Y进行编码,并计算其平均码长和编码效率;(2)从X,Y两种不同信源来比较三种编码方法的优缺点。

4-6设二元霍夫曼码为(00,01,10,11)和(0,10,110,111),求出可以编得这样霍夫曼码的信源的所有概率分布。

4-7设信源为?码。

《信息论与编码》课件

发展趋势与未来挑战

探讨信息论和编码学领域面临的未 来挑战。

介绍多媒体数字信号压缩和编码技术的发展和应用。

可靠的存储与传输控制技术

解释可靠存储和传输控制技术在信息论中的重要性。

生物信息学中的应用

探讨信息论在生物信息学领域的应用和突破。

总结与展望

信息论与编码的发展历程

回顾信息论和编码学的发展历程和 里程碑。

信息技术的应用前景

展望信息技术在未来的应用前景和 可能性。

介绍误码率和信噪比的定义和关系。

2

码率与修正码率的概念

解释码率和修正码率在信道编码中的重要性。

3

线性码的原理与性质

探讨线性码的原理、特点和应用。

4

编码与译码算法的实现

详细介绍信道编码和译码算法的实现方法。

第四章 信息论应用

无线通信中的信道编码应用

探索无线通信领域中信道编码的应用和进展。

多媒体数字信号的压缩与编码技术

《信息论与编码》T课 件

# 信息论与编码 PPT课件

第一章 信息的度量与表示

信息的概念与来源

介绍信息的定义,以及信息在各个领域中的来源和 应用。

香农信息熵的定义与性质

介绍香农信息熵的概念和其在信息论中的重要性。

信息量的度量方法

详细解释如何度量信息的数量和质量。

信息压缩的基本思路

探讨信息压缩的原理和常用方法。

第二章 信源编码

等长编码与不等长编码

讨论等长编码和不等长编码的特点 和应用领域。

霍夫曼编码的构造方法与 性质

详细介绍霍夫曼编码的构造和优越 性。

香农第一定理与香农第二 定理

解释香农第一定理和香农第二定理 在信源编码中的应用。

霍夫曼及香农-范诺编码方法

1.霍夫曼编码方法:先按出现的概率大小排队,把两个最小的概率相加,作为

新的概率和剩余的概率重新排队,再把最小的两个概率相加,再重新排队,直到最后变成1。

每次相加时都将“0”和“1”赋与相加的两个概率,读出时由该符号开始一直走到最后的”0”或者“1”,将路线上所遇到的“0”和“1”按最低位到最高位的顺序排好,就是该符号的霍夫曼编码。

低位高位

用霍夫曼编码所得的平均码长为:Σ(码长×出现概率)

上例为:

0.2×2+0.19×2+0.18×3+0.17×3+0.15×3+0.1×4+0.01×4=2.72 bit

可以算出本例的信源熵为2.61bit,二者已经是很接近了。

2.香农-范诺编码的目的是产生具有最小冗余的码词。

其基本思想是产生编码长度可变的码词。

估计码词长度的准则是符号出现的概率,符号出现的概率越大,其码词的长度越短。

香农-范诺编码方法:将符号从最大可能到最少可能排序,将排列好的信源符号分化为两大组,使两组的概率和近于相同,并各赋予一个二元码符号“0”和“1”。

只要组内有两个或两个以上符号,就以同样的方法重复以上分组,以此确定这些符号的连续编码数字。

依次下去,直至每一组只剩下一个信源符号为止。

香农-范诺编码算法步骤:

(1)按照符号出现的概率减少的顺序将待编码的符号排成序列。

(2)将符号分成两组,使这两组符号概率和相等或几乎相等。

(3)将第一组赋值为0,第二组赋值为1。

(4)对每一组,重复步骤2的操作,直至每一组只剩下一个信源符号为止。

信息论与编码第四章

界值,式中 必须为l正i 整数,每个 必须呈p现(si ) 的形式( 1 是 a i

实现无失真编码的条件:

1、信源符号与码字一一对应 2、任意一串有限长的码符号序列与信源s的符号序列也 是一一对应,即N次扩展后仍满足一一对应关系。 同时满足上述条件称为唯一可译码

s: s1 s2 s3 s4 w j c: 0 10 00 01

s 1 s 1s 1 s 2 s 1 s 3 s 1 s 4 s 2 s 1 s 2 s 2 s 2 s 3 s 2 s 4 s 3 s 1 s 3 s 2 s 3 s 3 s 3 s 4s4s1 s4s2 s4s3 s4s4 001 00 0 00 0 10 10 0 11 0 1 0 0 0 0 0 0 0 0 1 0 0 01 0 0 0 0 0 010 00 011 100) ]H (SN)N(H S)

E( x )x( Px) mH(s)

x

D [ I ( a i) N ][ I ( s i) D N ] { E [ I 2 ( s i) [ ] H ( s ) 2 ]N q pi(lopig)2q pilopgi2

i1

i1

( x - m ) 2 p x ( 2 p - 2 x ( x m ) x m 2 p p ) ( p ( x x - 2 x ( 2 2 m ) 2 x m ) )

有重码,非唯一可译码 等长非奇异码一定单义可译

等长编码条件: q r l ,满足此条件,才有可能无

重码(非奇异);扩展后:qN rl Nloqgllorg

l log q N log r

N 1 lloqg/lorg

l :平均每个信源符号所需要的码符号(元)个数 N 考虑到符号出现的概率以及符号之间的依赖性 。再去

霍夫曼编码

2.2.5霍夫曼编码霍夫曼(Huffman)编码是统计编码中的一种。

统计编码是根据消息出现概率的分布特性而进行工作的,它属于无损压缩编码。

这种编码的原理是,在消息和码字之间找到确切的对应关系,以便在能准确无误地恢复。

常用的统计编码除了霍夫曼编码外还有香农-范诺(Shannon-Fano)编码、算术编码等。

霍夫曼编码利用消息符号的统计特性设计的一种编码方法,较多地应用于数字图像处理中。

霍夫曼编码采用码词长度可变的编码方式,即基于不同符号出现的不同概率使用不同的编码位数。

其算法步骤如下:(1) 根据符号概率的大小按递减次序排列。

(2) 把概率最小的两个符号的概率相加,组成新符号的概率。

(3) 重复第(1)(2)步,直到最后两个符号为1为止。

(4) 从后往前进行编码。

每一步有两个数值(概率),各赋予一个二进制数:概率大的赋予0、概率小的赋予1。

也可以对概率大的赋予1、概率小的赋予0,但在编码过程中,赋值必须相同。

例如,字母A、B、C、D、E相应出现的概率为0.35、0.25、0.18、0.12、0.1,霍夫曼编码过程为:完成排序概率第1步第2步第3步第4步0.35 0.35 0.4 0.6 10.25 0.25 0.35 0.40.18 0.22 0.250.12 0.180.1编码(概率大的赋予0、概率小的赋予1)0.35 0.35 0.4 0.6:00.25 0.25 0.35:0 0.4:10.18 0.22:0 0.25:10.12:0 0.18:10.1:1霍夫曼编码为:概率霍夫曼编码码长0.35 00 20.25 01 20.18 11 20.12 100 30.1 101 4由此例可知,霍夫曼编码的长度和符号的概率大小相反,概率大的符号编码长度短,概率小的符号编码长度长。

《信息论、编码与密码学》课后习题答案资料

《信息论、编码与密码学》课后习题答案第1章 信源编码1.1考虑一个信源概率为{0.30,0.25,0.20,0.15,0.10}的DMS 。

求信源熵H (X )。

解: 信源熵 ∑=-=512)(log )(k k k p p X HH(X)=-[0.30*(-1.737)+0.25*(-2)+0.2*(-2.322)+0.15*(-2.737)+0.1*(-3.322)]=[0.521+0.5+0.464+0.411+0.332] =2.228(bit)故得其信源熵H(X)为2.228bit1.2 证明一个离散信源在它的输出符号等概率的情况下其熵达到最大值。

解: 若二元离散信源的统计特性为P+Q=1 H(X)=-[P*log(P)+(1-P)*log(1-P)] 对H(X)求导求极值,由dH(X)/d(P)=0可得211101log ==-=-p ppp p可知当概率P=Q=1/2时,有信源熵)(1)(max bit X H =对于三元离散信源,当概率3/1321===P P P 时,信源熵)(585.1)(m ax bit X H =,此结论可以推广到N 元的离散信源。

1.3 证明不等式ln 1x x ≤-。

画出曲线1ln y x =和21y x =-的平面图以表明上述不等式的正确性。

证明:max ()ln 1(0)1()()01001()0()0ln 11ln 1ln 1f x x x x f x xf x x x x f x f x f x x x x x x x =-+>'=''==>∴<≤>≤=≤-≥≤-≤-令,又有时此时也即当时同理可得此时综上可得证毕绘制图形说明如下 可以很明确说明上述 不等式的正确性。

1.4 证明(;)0I X Y ≥。

在什么条件下等号成立?1111(,)(,)(,)(,)log()()n mi j i j i j n mi j i j i j i j I P x y I x y P x y P x y P x P y =====∑∑∑∑(X ;Y )=当和相互独立时等号成立。

霍夫曼编码原理

霍夫曼编码四川大学计算机学院2009级戚辅光【关键字】霍夫曼编码原理霍夫曼译码原理霍夫曼树霍夫曼编码源代码霍夫曼编码分析霍夫曼编码的优化霍夫曼编码的应用【摘要】哈夫曼编码(Huffman Coding)是一种编码方式,哈夫曼编码是可变字长编码(VLC)的一种。

uffman于1952年提出一种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman 编码。

哈夫曼压缩是个无损的压缩算法,一般用来压缩文本和程序文件。

它属于可变代码长度算法一族。

意思是个体符号(例如,文本文件中的字符)用一个特定长度的位序列替代。

因此,在文件中出现频率高的符号,使用短的位序列,而那些很少出现的符号,则用较长的位序列。

【正文】引言哈夫曼编码(Huffman Coding)是一种编码方式,哈夫曼编码是可变字长编码(VLC)的一种。

uffman于1952年提出一种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman编码。

霍夫曼编码原理:霍夫曼编码的基本思想:输入一个待编码的串,首先统计串中各字符出现的次数,称之为频次,假设统计频次的数组为count[],则霍夫曼编码每次找出count数组中的值最小的两个分别作为左右孩子,建立他们的父节点,循环这个操作2*n-1-n(n是不同的字符数)次,这样就把霍夫曼树建好了。

建树的过程需要注意,首先把count数组里面的n个值初始化为霍夫曼树的n个叶子节点,他们的孩子节点的标号初始化为-1,父节点初始化为他本身的标号。

接下来是编码,每次从霍夫曼树的叶子节点出发,依次向上找,假设当前的节点标号是i,那么他的父节点必然是myHuffmantree[i].parent,如果i是myHuffmantree[i].parent 的左节点,则该节点的路径为0,如果是右节点,则该节点的路径为1。

霍夫曼编码PPT教案

第6页/共14页

具体过程是这样的,先将所有符号排成一行,构成8 个最底层 节点。首先将这些节点中最小两个概率值 相加:0.05+0.1=0.15, 得到新的 节点这时拥有的概 率值为0.2, 0.1, 0.1, 0.15, 0.15, 0.15, 0.15。

第7页/共14页

• 再将两个最小的概率值相加得到新的节点... ... 直到得到根节点概率为1.0为止。 相加时,对于概率值相等的多个节点,可以任意选取。除根节点外,设节点左边 分支为0,右边分支为1(也可以反过来)。这样,生成的霍夫曼树如下图所示:

创建霍夫曼表。

压缩编码时,将码值用码字代替。

第5页/共14页

(二)霍夫曼树的构建

霍夫曼编码实际上构造了一个码树,码树从最上层的端点

开始构造,直到树根结束。这里举个例子说明如何生成霍夫 曼树。假设对由a1、a2、a3、a4、a5、a6、a7、a8八个信源 符号组成的源信息字符串:“a1 a1 a2 a2 a3 a3 a3 a4 a4 a4 a4 a5 a5 a5 a6 a6 a6 a7 a7 a8”进行霍夫曼编码。首先应对信 息中各数字出现的次数进行统计如下:

把最末两个具有最小概率的元素之概率加起来;

最

把该概率之和同其余概率由大 小概率加起来,再排队;

到小排队

,然后再

把两个

重复步骤 (2) 、 (3), 直到概率和达到 1 为止 ;

在每次合并消息时,将被合并的消息赋以1和0或0和1;

寻找从每个信源符号到概率为1处的路径,记录下路径 上的1和0;

对每个符号写出"1"、"0"序列(从码数的根到终节 点)。

第10页/共14页

进行压缩编码时,只要将码值用码字代替即可。所以源符a1 a1 a2 a2 a3 a3 a3 a4 a4 a4 a4 a5 a5 a5 a6 a6 a6 a7 a7 a8 编码为:。

霍夫曼Huffman编解码

霍夫曼(Huffman)编解码1,概述为了减少信源输出符号序列中的剩余度、提高符号的平均信息量,对信源输出的符号序列所施行的变换。

具体说,就是针对信源输出符号序列的统计特性来寻找某种方法,把信源输出符号序列变换为最短的码字序列,使后者的各码元所载荷的平均信息量最大,同时又能保证无失真地恢复原来的符号序列。

信源编码的作用之一是设法减少码元数目和降低码元速率,即通常所说的数据压缩:作用之二是将信源的模拟信号转化成数字信号,以实现模拟信号的数字化传输。

最原始的信源编码就是莫尔斯电码,另外还有ASCII码和电报码都是信源编码。

但现代通信应用中常见的信源编码方式有:Huffman编码、算术编码、L-Z编码,这三种都是无损编码,另外还有一些有损的编码方式。

信源编码的目标就是使信源减少冗余,更加有效、经济地传输,最常见的应用形式就是压缩。

其中霍夫曼(Huffman)编码是常用的一种编码方式2,霍夫曼编码思想霍夫曼(Huffman)编码算法是满足前缀条件的平均二进制码长最短的编码算法。

其编码思想是将较长的编码码字分配给较小概率的信源输出符号,而将较短的编码码字分配给较大概率的信源输出。

算法是:在信源符号集合中,首先将两个最小概率的信源输出合并为新的输出,其概率是两个相应输出符号概率之和。

这一过程重复下去,直到只剩下一个合并输出为止,这个最后的合并输出符号的概率为1。

这样就得到了一张树图,从树根开始,将编码符号1 和0 分配在同一节点的任意两分支上,这一分配过程重复直到树叶。

从树根到树叶途经支路上的编码最后就构成了一组异前置码,就是Huffman 编码输出。

以下图为例:通过上表的对信源缩减合并过程,从而完成了对信源的霍夫曼编码。

3、程序设计思路分为两步,首先是码树形成过程:对信源概率进行合并形成编码码树。

然后是码树回溯过程:在码树上分配编码码字并最终得到Huffman 编码。

3.1、码树形成过程将信源概率按照从小到大顺序排序并建立相应的位置索引。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

改进方法

• 在6个信源符号的后面再加一个概率为0的 符号,记为s7’,同时有p(s7’)=0,这个符号 称为虚假符号。将信源按7个符号进行三元 编码

4.7霍夫曼码和其他编码方法

改进方法

w 1 1

s 1 : 0 . 24

0.24 0.54

0

1 0 1

w 2 00 s 2 : 0 . 20 w3 01 s 3 : 0 . 18 w 4 02 s 4 : 0 . 16 w 5 20 s 5 : 0 . 14 w6 21 s 6 : 0 . 08 w7 22 s 1 : 0 . 00

码符号/信源符号

4.7霍夫曼码和其他编码方法

Huffman码

讨论: 1) 两种方法平均码长相等。

2) 计算两种码的码长方差:

2 2 ps ( ) ( l L ) 1 . 3 6 i i 1 i 1

5 2 2 ps ( ) ( l L ) 0 . 1 6 i i 2 i 1

s1 : 0 .4 s 2 : 0 .2

0 1

0 .4

0 .2

0 .4

0 .4

0 1 0 1

0 .6

0 .4

0 1

w 3 11 s 3 : 0 . 2 w4 010 s 4 : 0 . 1 w5 011 s 5 : 0 . 1

q i 1

0 .2

0 .2

0 .2

Lp(si )li 2 .2

解:编码过程略,Huffman编码结果如下:

s s s s s 信 源 符 号 1 s 2 s 3 4 5 6 7 1 0 1 1 0 0 00 0 1 0 1 00 1 1 00 1 1 1 码 字

4.7霍夫曼码和其他编码方法

Huffman码

平均码长为

L p () sl 2 . 7 2 码 元 符 号 / 信 源 符 号 i i

Huffman码的特点

用概率匹配方法进行编码 • 概率大的符号对应于短码,概率小的符号 对应于长码,充分利用了短码 • 缩减信源的最后两个码字总是最后一位不 同,从而保证了Huffman码是即时码

定理4.10 霍夫曼码是紧致码

r元Huffman算法

• r=3,A:{0,1,2}

可知:平均码长为L=2 码元/信源符号

1)每次对缩减信源两个概率最小的符号分配“0”或“1”码元

是任意的,因此编码的结果是不唯一的;但0/1分配的上下顺

序在整个编码过程中应保持一致,否则不能构成唯一可译码。

2)缩减信源时,若合并后的概率与其他概率相等,这几个概率 的次序可任意排列,但得到的码字不相同,对应的码长也不相 同,但平均码长也不变。

2. 给两个概率最小的信源符号sn-1和sn各分配一个码元“0”和“1”,并将这两

个信源符号合并成一个新符号,并用这两个最小的概率之和作为新符号的 概率,结果得到一个只包含(n-1)个信源符号的新信源。称为信源的第一

次缩减信源,用S1表示。

3. 4. 将缩减信源S1的符号仍按概率从大到小顺序排列,重复步骤2,得到只含(n小,便于实现。

4.7霍夫曼码和其他编码方法

Huffman码

离散信源如下:

S s s s s s s s 1 2 3 4 5 6 7 P ( S ) 0 . 2 0 0 . 1 9 0 . 1 8 0 . 1 7 0 . 1 5 0 . 1 0 0 . 0 1

第4章 无失真信源编码

• 4.7 霍夫曼码和其他编码方法

教学要求

• 了解Shannon编码思想、Shannon-Fano 算法、香农-费诺-埃里斯编码算法; • 掌握Huffman编码方法。

4.7霍夫曼码和其他编码方法

Shannon算法

• Shannon编码思想 :按概率编码

1 Li log p ( si )

利用码树图法可得到其编码

这个例子其编码效率为1,即为最佳码。但这种方 法对于多数情况下是不能实现最佳码的,而且编 码效率比较低。

4.7霍夫曼码和其他编码方法

Huffman码

编码步骤如下:

1. 将信源符号按概率从大到小的顺序排列,令

p ( s ) p ( s ) p ( s ) 1 2 q

-2)个符号的缩减信源S2。

重复上述步骤,直至缩减信源只剩两个符号为止,此时所剩两个符号的概 率之和必为1。然后从最后一级缩减信源开始,依编码路径向前返回,就 得到各信源符号所对应的码字。

4.7霍夫曼码和其他编码方法

Huffman码

S : q

S1 : q ( r 1)

S末 : S2 : q 2( r 1) r

i 1

7

信源熵为

H ( S ) p () s o g p () s 2 . 6 1 比 特 / 信 源 符 号 il i

i 1 7

编码效率为

2 .6 1 9 6 .0 % 2 .7 2

4.7霍夫曼码和其他编码方法

Huffman码

注意:霍夫曼编码后的码字不是惟一的。

s1 : 0 .4 s 2 : 0 .2 s 3 : 0 .2 s 4 : 0 .1 s 5 : 0 .1

0 1

0 .4

0 .2

0 .4

0 .4

0 1 0 1

0 .6

0 .4

0 1

0 .2

0 .2

0 .2

q (r 1 ) r

4.7霍夫曼码和其他编码方法

Huffman码

w 1 1

w2 01 s 3 : 0 .2 w 3 000 w 4 0010s 4 : 0 . 1

它是满足Kraft不等式的一种直接的应用 例:一个离散信源S:{s1,s2,s3,s4} p(S):{1/2,1/4,1/8,1/8} 这时有:L1=log2=1; L2=log4=2; L3=L4=log8=3;

4.7霍夫曼码和其他编码方法

Shannon编码举例

L1=1, L2=2, L3=L4=3;

s1 : 0 .4 s 2 : 0 .2

0 .4

0 .2

0 .4

0 .4

0 0 1

0 .6

0 .4

0

1

0 .2

0 1

0 .2

0 .2

1

w5 0011s 5 : 0 . 1

q

Lp(si )li 2 .2

i 1

码符号/信源符号

4.7霍夫曼码和其他编码方法

Huffman码

w1 00 w2 10