IBM服务器boradcom双网卡绑定-负载均衡模式

双网卡绑定实现负载,冗余及内外网设置

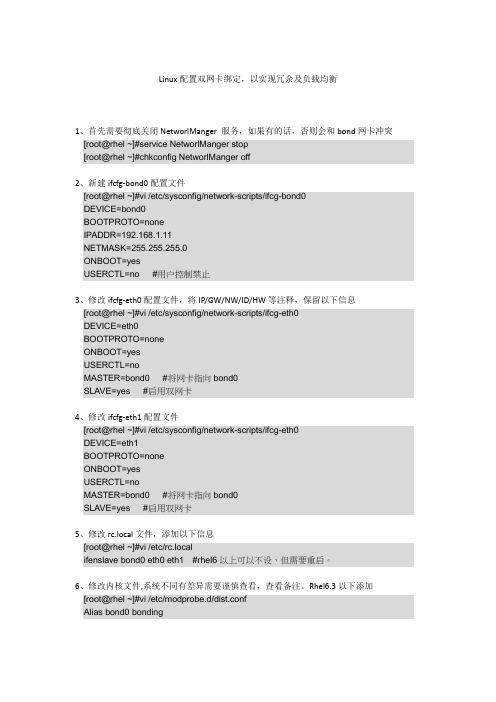

Linux配置双网卡绑定,以实现冗余及负载均衡1、首先需要彻底关闭NetworlManger 服务,如果有的话,否则会和bond网卡冲突[root@rhel ~]#service NetworlManger stop[root@rhel ~]#chkconfig NetworlManger off2、新建ifcfg-bond0配置文件[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-bond0DEVICE=bond0BOOTPROTO=noneIPADDR=192.168.1.11NETMASK=255.255.255.0ONBOOT=yesUSERCTL=no #用户控制禁止3、修改ifcfg-eth0配置文件,将IP/GW/NW/ID/HW等注释,保留以下信息[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-eth0DEVICE=eth0BOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0 #将网卡指向bond0SLAVE=yes #启用双网卡4、修改ifcfg-eth1配置文件[root@rhel ~]#vi /etc/sysconfig/network-scripts/ifcg-eth0DEVICE=eth1BOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0 #将网卡指向bond0SLAVE=yes #启用双网卡5、修改rc.local文件,添加以下信息[root@rhel ~]#vi /etc/rc.localifenslave bond0 eth0 eth1 #rhel6以上可以不设,但需要重启。

6、修改内核文件,系统不同有差异需要谨慎查看,查看备注。

Rhel6.3以下添加[root@rhel ~]#vi /etc/modprobe.d/dist.confAlias bond0 bondingOptions bond0 mode=1 miimon=50 #可在ifcfg-bond0中添加用BONDING_OPT=””连接。

双网卡均衡负载

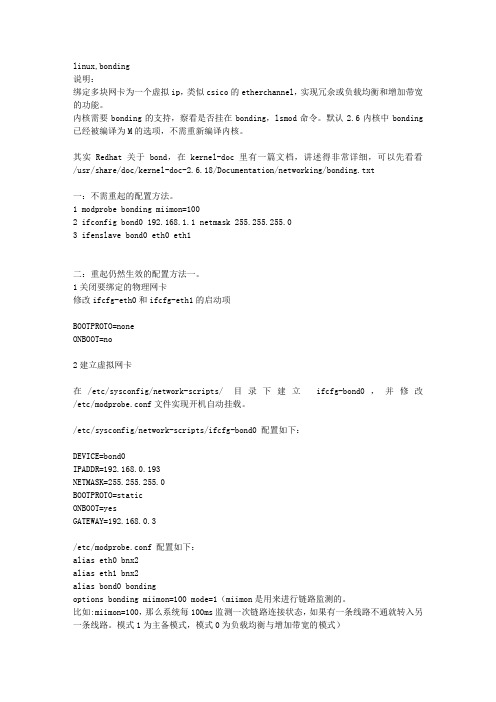

linux,bonding说明:绑定多块网卡为一个虚拟ip,类似csico的etherchannel,实现冗余或负载均衡和增加带宽的功能。

内核需要bonding的支持,察看是否挂在bonding,lsmod命令。

默认2.6内核中bonding 已经被编译为M的选项,不需重新编译内核。

其实Redhat关于bond,在kernel-doc里有一篇文档,讲述得非常详细,可以先看看/usr/share/doc/kernel-doc-2.6.18/Documentation/networking/bonding.txt一:不需重起的配置方法。

1 modprobe bonding miimon=1002 ifconfig bond0 192.168.1.1 netmask 255.255.255.03 ifenslave bond0 eth0 eth1二:重起仍然生效的配置方法一。

1关闭要绑定的物理网卡修改ifcfg-eth0和ifcfg-eth1的启动项BOOTPROTO=noneONBOOT=no2建立虚拟网卡在/etc/sysconfig/network-scripts/ 目录下建立ifcfg-bond0,并修改/etc/modprobe.conf文件实现开机自动挂载。

/etc/sysconfig/network-scripts/ifcfg-bond0 配置如下:DEVICE=bond0IPADDR=192.168.0.193NETMASK=255.255.255.0BOOTPROTO=staticONBOOT=yesGATEWAY=192.168.0.3/etc/modprobe.conf 配置如下:alias eth0 bnx2alias eth1 bnx2alias bond0 bondingoptions bonding miimon=100 mode=1(miimon是用来进行链路监测的。

比如:miimon=100,那么系统每100ms监测一次链路连接状态,如果有一条线路不通就转入另一条线路。

IBM服务器boradcom双网卡绑定-负载均衡模式.

Windows 32-64bit双网卡绑定软件下载地址:/support/fixcentral/systemx/quickorder?pare nt=ibm~Systemx3650M3&product=ibm/systemx/7945&&platform=All &function=fixId&fixids=brcm_sw_nic_vt6.2.4.1-cd_anyos_32-64&incl udeSupersedes=0&source=fc安装测试的环境为Windows2008 64位操作系统下载ISO格式的文件,用虚拟光驱打开,点击Launch,运行软件软件打开界面,点击MANAGEMENT APPLICATIONS下一步接受并下一步默认就可以了,下一安装安装过程大概十几秒点击确定点击完成确定后,软件已经开启,点击任务栏右下角的第一个图标,右键开启软件软件开启中软件打开界面,因为是测试,没有插网线,所以很多红色X ,点击橙色的Team Management,进入到建组界面看到还没有建组右击网络适配器,点击Create a TeamNext填写要建的组的名字,并Next点选第一项(默认),并Next出现服务器默认的两个Broadcom 网卡,选中要绑定的网卡,点击AddNext点选第一项(默认),此为不设置备用网卡,点击Next点击No,并Next跳过Vlan管理,并Next第一项(默认),点Finish点“是”开始配置双网卡,建组能看到自己建的Team1打开“网络链接”,看到多出的虚拟网卡,对其进行常规的配置就OK,至此,大功告成。

集成Broadcom网卡的服务器双网卡绑定配置

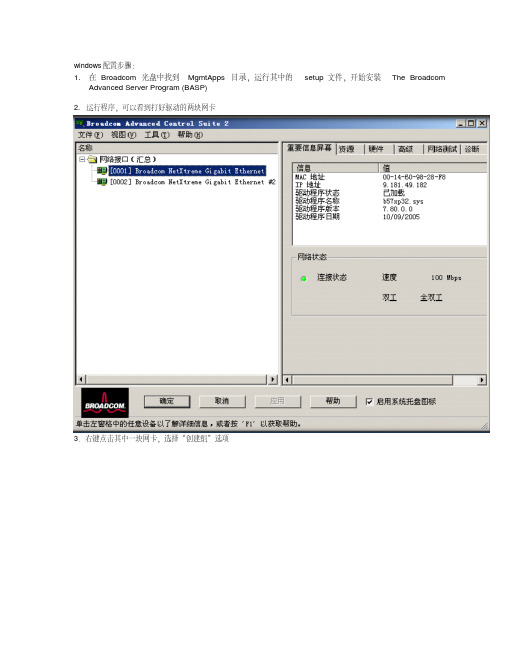

windows配置步骤:1.在Broadcom光盘中找到MgmtApps目录,运行其中的setup 文件,开始安装TheBroadcom AdvancedServer Program (BASP)2. 运行程序,可以看到打好驱动的两块网卡3.右键点击其中一块网卡,选择“创建组”选项4.标识新组名称,选择teaming方式(本文重点介绍“智能负载平衡和故障转移”teaming绑定方式)5.将可用网卡添加到新组中,点击应用,几分钟后绑定成功!待完成后,网络连接中出现一块虚拟网卡,可对其进行IP配置。

至此,teaming配置完成。

Linux 配置步骤:一、简介Broadcom公司不仅在Windows平台上提供了BASP工具来实现网卡的高可用性,同样,在Linux操作系统下,也提供了对应的工具来实现。

下面,就介绍一下如何在Linux下利用BASP来实现多块Broadcom 以太网卡的teaming。

首先,BASP是一个为2.4.x和2.6.x的内核设计的模块,通过由多个网卡创建的teaming,可以提供负载平衡(load-balancing),容错(fault-tolerance)和VLAN等功能。

一个teaming可以包括1到8块网卡,每块网卡都可以被指定为主(Primary)或者是热备(hot-standby,只适用于SLB teaming)。

teaming中所有的主网卡都会通过发送和接收全部网络流量的一部分来参与负载平衡的工作,而热备的网卡会在所有的主网卡失去连接时进行接管。

VLAN可以添加到teaming中,通过不同的VLAN ID来实现多个VLAN,每个VLAN都会创建一个虚拟设备。

二、安装通常,我们得到的BAS 的打包文件中包括两种格式的文件,一个是RPM包,一个是TAR格式的文档(在随机Broadcom光盘中的\Linux\BcmServ目录下)。

BASP以源码的形式提供了多种平台和内核下的安装:"basplnx-{version}.i386.tgz"是i386平台下的TAR文档"basplnx-{version}.x86_64.tgz"是AMD64平台下的TAR文档"basplnx-{version}.src.i386.rpm"是i386平台下的RPM包"basplnx-{version}.src.x86_64.rpm"是AMD64平台下的RPM包1.安装TAR文档解压并展开TAR文档% tar xzvf basplnx-{version}.{arch}.tgz(1) 创建内核模块"basp.o"或basp.ko(在2.6内核下)% make(2) 创建设备文件并复制文件% make install(3)更新模块信息% depmod -a(4) 加载驱动程序% insmod basp安装 RPM包(1) 安装RPM 的源文件包% rpm -i basplnx-{version}.src.{arch}.rpm(2) 进入 RPM 的路径并为内核创建驱动程序% cd /usr/src/redhat% rpm -bb SPECS/basplnx.spec注意:如果Linux的发行版本包含的是RPM v4.1或者更新版本,使用rpmbuild命令代替"rpm" (3) 安装刚刚创建的包% rpm -iRPMS/i386/basplnx-{version}.{arch}.rpm驱动程序和其它需要的文件会自动被安装。

在linu下双网卡负载均衡(lacp)

(一)linux 配置#cat/boot/config-kernel-version |grep -ibondingCONFIG_BONDING=m返回CONFIG_BONDING表示支持,否则需要编译内核使它支持bonding 也可以用:查看一下内核是否已经支持bonding :modinfo bonding第一步:创建一个ifcfg-bondX# touch/etc/sysconfig/network-scripts/ifcfg-bond0 新建一个bond0配置文件# cat/etc/sysconfig/network-scripts/ifcfg-bond0DEVICE=bond0BOOTPROTO=staticIPADDR=1.1.1.2NETMASK=255.255.255.0BROADCAST=1.1.1.255NETWORK=1.1.1.0GATEWAY=1.1.1.1ONBOOT=yesTYPE=Ethernet 编辑ifcfg-bond0 如上第二步:修改/etc/sysconfig/network-scripts/ifcfg-ethX 这个实验中把网卡 1 和 2 绑定,修改/etc/sysconfig/network-scripts/ifcfg-ethX 相应网卡配置如下:# cat/etc/sysconfig/network-scripts/ifcfg-eth1TYPE=EthernetDEVICE=eth1HWADDR=00:d0:f8:40:f1:a0 网卡1macBOOTPROTO=noneONBOOT=yesUSERCTL=no MASTER=bond0SLAVE=yes# cat /etc/sysconfig/network-scripts/ifcfg-eth2 TYPE=Ethernet DEVICE=eth2 HWADDR=00:d0:f8:00:0c:0c 网卡2mac BOOTPROTO=none ONBOOT=yesUSERCTL=no MASTER=bond0SLAVE=yes-r lacp 只要再加上下面两条配置 绑定 mode=4 是 lacp第三步: 配置/etc/modprobe.conf ,添加 alias bondO bonding# cat /etc/modprobe.conf alias ethO e1OO alias snd-card-O snd-intel8xOoptions snd-card-O index=O options snd-intel8xO index=O remove snd-intel8xO { /usr/sbin/alsactl store O >/dev/null 2>&1 || : ; }; /sbin/modprobe --ignore-remove snd-intel8xOalias eth1 8139too options 3c5O1 irq=3 alias eth2 tulip 上面是三网卡本身的配置如果要绑定和做 alias bondO bondingoptions bondO miimon=1OO mode=4第四步:配置 /etc/rc.d/rc.local ,添加需要绑定的网卡# cat /etc/rc.d/rc.localtouch /var/lock/subsys/local 配置本身就有这条命令ifenslave bondO eth1 eth2 这条命令是添加需要绑定的网卡 1 和 2到这里就完成 bonding 的配置了可以查看一下 第五步:重启网络服务和重启 pc#service network restart重启网络服务# shutdown -r now重启 pc重启后可以查看 bonding 情况:网卡 1 和 2 都绑定上了,模式为 8O2.3ad# cat /proc/net/bonding/bondOEthernet Channel Bonding Driver: v3.O.3 (March 23, 2OO6) Bonding Mode: IEEE 8O2.3ad Dynamic link aggregation Transmit Hash Policy: layer2 (O) MII Status: upMII Polling Interval (ms): 1OO Up Delay (ms): O Down Delay (ms): O8O2.3ad info LACP rate: slowActive Aggregator Info:Aggregator ID: 1 Number of ports: 2 Actor Key: 9 Partner Key: 1Partner Mac Address: 00:d0:f8:22:33:ba Slave Interface: eth1 MII Status: up Link Failure Count: 0Permanent HW addr: 00:d0:f8:40:f1:a0 Aggregator ID: 1 Slave Interface: eth2 MII Status: upLink Failure Count: 0Permanent HW addr: 00:d0:f8:00:0c:0cAggregator ID: 1接口配置信息:新增了bond0的配置信息,接口bondO和ethl , eth2,绑定后三个接口使用的mac 都是同一个:00:D0:F8:40:F1:A0# ifconfigbondO Link encap:Ethernet HWaddr OO:DO:F8:4O:F1:AOinet addr:1.1.1.2 Bcast:1.1.1.255 Mask:255.255.255.Oinet6 addr: fe8O::2dO:f8ff:fe4O:f1aO/64 Scope:LinkUP BROADCAST RUNNING MASTER MULTICASTMTU:15OO Metric:1RX packets:128 errors:O dropped:O overruns:O frame:OTX packets:259 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:ORX bytes:15466 (15.1 KiB) TX bytes:39679 (38.7 KiB)ethO Link encap:Ethernet HWaddr OO:11:11:EB:71:E2inet addr:192.168.18O.8 Bcast:192.168.18O.15 Mask:255.255.255.24Oinet6 addr: fe8O::211:11ff:feeb:71e2/64 Scope:LinkUP BROADCAST RUNNING MULTICASTMTU:15OO Metric:1RX packets:311 errors:O dropped:O overruns:O frame:OTX packets:228 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:1OOORX bytes:3O565 (29.8 KiB) TX bytes:35958 (35.1 KiB)eth1 Link encap:Ethernet HWaddr OO:DO:F8:4O:F1:AOinet6 addr: fe8O::2dO:f8ff:fe4O:f1aO/64 Scope:LinkUP BROADCAST RUNNING SLAVE MULTICASMTTU: 1 5OO Metric:1RX packets:54 errors:O dropped:O overruns:O frame:OTX packets:97 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:1OOORX bytes:6696 (6.5 KiB) TX bytes:13821 (13.4 KiB)Interrupt:2O9 Base address:Ox2eOOeth2 Link encap:Ethernet HWaddr OO:DO:F8:4O:F1:AO inet6 addr: fe8O::2dO:f8ff:fe4O:f1aO/64 Scope:LinkUP BROADCAST RUNNING SLAVE MULTICASMTTU: 1 5OO Metric:1RX packets:74 errors:O dropped:O overruns:O frame:OTX packets:162 errors:O dropped:O overruns:O carrier:Ocollisions:O txqueuelen:1OOOlacp system-priority 100 interface GigabitEthernet 0/23 no switchport lacp port-priority 100 port-group 1 mode active interface GigabitEthernet 0/24 no switchport lacp port-priority 100 port-group 1 mode active interface AggregatePort 1 全局配置lacp 优先级接口的lacp 优先级接口下开启lacp 主动模式RX bytes:8770 (8.5 KiB) TX bytes:25858 (25.2 KiB) Interrupt:201 Base address:0x2f00 lo Link encap:Local Loopbackinet addr:127.0.0.1 Mask:255.0.0.0 inet6 addr: ::1/128 Scope:Host UP LOOPBACKRUNNING MTU:16436 Metric:1RX packets:6283 errors:0 dropped:0 overruns:0 frame:0TX packets:6283 errors:0 dropped:0 overruns:0 carrier:0 collisions:0 txqueuelen:0RX bytes:9783674 (9.3 MiB) TX bytes:9783674 (9.3 MiB)二)锐捷交换机配置:no switchportno ip proxy-arpip address 1.1.1.1 255.255.255.0和linux 成功建立lacp 后状态信息如下:Show lacp summarySystem Id:100, 00d0.f822.33baFlags: S - Device is requesting Slow LACPDUs F - Device is requesting Fast LACPDUs.A - Device is in active mode. P - Device is in passive mode.Aggregate port 1:Local information:Port Flags StateLACP portPriorityOperKeyPortNumberPortStateGi0/23 SA bndl 100 0x1 0x17 0x3d Gi0/24 SA bndl 100 0x1 0x18 0x3d Partner information:PortLACP port OperKeyPortNumberPortState Flags Priority Dev IDGi0/23 SA 255 00d0.f840.f1a0 0x9 0x2 0x3d Gi0/24 SA 255 00d0.f840.f1a0 0x9 0x1 0x3d State 表示状态信息:bndl 表示lacp 建立成功,sup 表示不成功。

服务器负载均衡原理与配置技巧

服务器负载均衡原理与配置技巧随着互联网的快速发展,越来越多的网站和应用程序需要部署在服务器上,而服务器的负载也随之增加。

为了保证服务器的稳定性和性能,服务器负载均衡技术应运而生。

本文将介绍服务器负载均衡的原理和配置技巧,帮助您更好地理解和应用这一重要的技术。

一、负载均衡原理1.1 什么是负载均衡负载均衡(Load Balancing)是一种通过将网络请求分发到多个服务器上,以达到均衡服务器负载、提高网站性能和可靠性的技术。

通过负载均衡,可以有效地避免单点故障,提高系统的可用性和扩展性。

1.2 负载均衡的工作原理负载均衡器位于客户端和服务器之间,接收来自客户端的请求,然后根据一定的算法(如轮询、最小连接数、最少响应时间等)将请求分发给后端的多台服务器。

这样可以使每台服务器的负载相对均衡,提高整个系统的性能和稳定性。

1.3 负载均衡的优势- 提高系统的可用性:通过负载均衡,可以避免单点故障,当某台服务器发生故障时,负载均衡器会自动将请求转发给其他正常的服务器,保证系统的正常运行。

- 提高系统的性能:负载均衡可以根据服务器的负载情况动态调整请求的分发策略,使每台服务器的负载相对均衡,提高系统的整体性能。

- 提高系统的扩展性:通过增加服务器的数量,可以很容易地扩展系统的处理能力,应对日益增长的用户请求。

二、负载均衡的配置技巧2.1 选择合适的负载均衡算法在配置负载均衡时,需要根据实际情况选择合适的负载均衡算法。

常见的负载均衡算法包括轮询(Round Robin)、最小连接数(Least Connections)、最少响应时间(Least Response Time)等。

不同的算法适用于不同的场景,需要根据实际情况进行选择。

2.2 配置健康检查为了及时发现服务器的故障或异常,可以配置健康检查(Health Check)功能。

健康检查可以定期检测服务器的状态,当服务器出现故障时,负载均衡器会自动将其从服务器池中剔除,确保用户请求不会被发送到故障的服务器上。

双网卡绑定

大家好,我前几天在去联想玩的时候,看到他们工程师一台机装好几个网卡,速度还不错,我看一下,回到公司也到网上找了一些资料,双(多)网卡用一个IP的技术,对于各种内网服务器,和电脑、、、、很有用处,我把我在网上找到的资料整理了一下,大家看一看,也许对大家有好处!所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x 系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设臵将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡,多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

先下载一个软件ftp://218.20.254.252下载完软件,先不忙安装,咱们还是先准备好硬件。

第一部分:硬件安装虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。

双网卡绑定实现负载均衡 RAID10

内容提要:Linux软件RAID技术是Linux操作系统提供的能够在软件层实现RAID1、RAID5、RAID6、RAID10等RAID磁盘阵列的有效技术手段,通过该技术我们可以建立起一个大容量的、具有很强数据冗余能力以及很高数据安全性的数据存储应用设备,可以通过该存储应用设备在网络中建立起初级的储存区域网(Storage Area Network, 简称SAN),本文通过在Linux中使用6块廉价IDE硬盘盒组建一个RAID1+0设备,配合Linux中的VSFtp服务器为客户端提供了安全、稳定、高效数据存储方案,实现Linux软件RAID的关键技术包括双网卡负载均衡实现网络连接的高可用性及数据流量的大吞吐量,RAID10设备的有效创建方法和管理,RAID设备Shell统一服务启动和终止脚本的创建。

1 引言该应用方案通过使用一台普通的P4级的计算机以及6块移动硬盘,通过LINUX 提供的软件RAID方法实现了一个大容量的、具有很强数据冗余能力以及很高数据安全性的数据存储案例,该应用案例在建设完成后,目前已经平稳使用两年,对入门级的数据存储具有很强的现实意义。

2 案例关键技术具体实现方法2.1双网卡绑定实现负载均衡采用双网卡绑定技术实现服务器网络连接的高可用性及吞吐量。

1)效果:网卡eth0和eth1虚拟成设备bond0,并且向外公布一个虚拟IP地址(拓扑图如图1),并提供两倍的网络带宽。

其中一条链路或网卡出现故障时,系统应用不受故障影响。

2)配置方法:使用VI编辑器将标有//的内容添加到/etc/init.d/network中的相应位置。

(//不用输入,修改完后需要重启服务器操作系统)mode为网卡工作方式,“1”为互援式工作方式(热备份工作方式,当前工作链路或网卡出现故障时,备份网卡会自动接管网络链路),“0”为集群式工作方式(同时在线提供两倍带宽,一条链路或网卡故障时,网络带宽为工作网卡带宽,不需切换)。

网卡绑定(多网卡绑定成一个虚拟网卡负载均衡)

网卡绑定,就将两个或者更多的物理网卡绑定成一个虚拟网卡,以提供负载均衡或者冗余,能够起到增加带宽的作用;当网卡绑定之后,如果有一个网卡坏掉,网络会继续保持,不会中断,从而不会影响业务。

Windows下网卡绑定Windows 下进行网卡绑定,需要根据网卡的类型下载网卡驱动,通过网卡驱动进行网卡绑定。

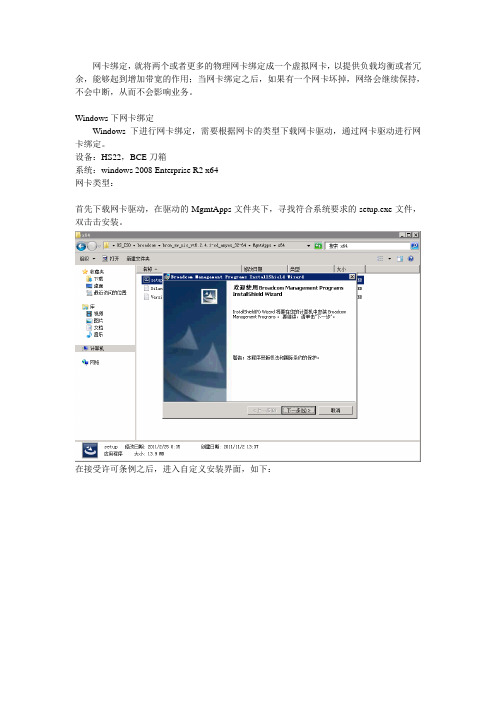

设备:HS22,BCE刀箱系统:windows 2008 Enterprise R2 x64网卡类型:首先下载网卡驱动,在驱动的MgmtApps文件夹下,寻找符合系统要求的setup.exe文件,双击击安装。

在接受许可条例之后,进入自定义安装界面,如下:我们这里只安装BASP,直接下一步。

安装结束后,会提醒你从控制面板中找到,这里,我们只要打开开始菜单就可以看见新安装的BACS软件了。

(注意,如果是intel的网卡,系统会默认图标显示在控制面板中。

)软件界面如下:界面左侧的Device Management,显示的是主机当前的网卡,Team Management是用来对网卡绑定进行操作和管理的。

右边是动态展示栏,可以展示每块网卡的信息(Information),可以通过自动ping网卡IP,诊断网卡当前状态(Diagnostics),还可以统计网卡活动状态(Statistics)。

网卡绑定,在实际操作中,是采用虚拟网卡组的概念,将现有网卡,绑定成一个虚拟网卡组。

因此在BACS中,我们打开Team Management来进行网卡绑定。

打开Team Management,左侧看到的是可以进行绑定的网卡状态。

我们打开上层菜单栏中的“Teams”,选择“Create a team”,就进入了网卡绑定的引导界面。

选择“Next”。

首先输入一个网卡绑定组的名字:选择“Next”进入类型界面。

Broadcom网卡绑定有三种类型,--Smart Load Balancing(TM)and Failover(SLB):智能负载均衡和故障转移。

Broadcom双网卡绑定

windows配置步骤:1. 在Broadcom 光盘中找到MgmtApps目录,运行其中的setup 文件,开始安装The BroadcomAdvanced Server Program (BASP)2. 运行程序,可以看到打好驱动的两块网卡3.右键点击其中一块网卡,选择“创建组”选项4.标识新组名称,选择teaming方式(本文重点介绍“智能负载平衡和故障转移”teaming绑定方式)5.将可用网卡添加到新组中,点击应用,几分钟后绑定成功!待完成后,网络连接中出现一块虚拟网卡,可对其进行IP配置。

至此,teaming配置完成。

Linux 配置步骤:一、简介Broadcom公司不仅在Windows平台上提供了BASP工具来实现网卡的高可用性,同样,在Linux操作系统下,也提供了对应的工具来实现。

下面,就介绍一下如何在Linux下利用BASP来实现多块Broadcom以太网卡的teaming。

首先,BASP是一个为 2.4.x和2.6.x的内核设计的模块,通过由多个网卡创建的teaming,可以提供负载平衡(load-balancing),容错(fault-tolerance)和VLAN等功能。

一个teaming可以包括1到8块网卡,每块网卡都可以被指定为主(Primary)或者是热备(hot-standby,只适用于SLB teaming)。

teaming中所有的主网卡都会通过发送和接收全部网络流量的一部分来参与负载平衡的工作,而热备的网卡会在所有的主网卡失去连接时进行接管。

VLAN可以添加到teaming中,通过不同的VLAN ID来实现多个VLAN,每个VLAN 都会创建一个虚拟设备。

二、安装通常,我们得到的BAS 的打包文件中包括两种格式的文件,一个是RPM包,一个是TAR格式的文档(在随机Broadcom光盘中的\Linux\BcmServ目录下)。

BASP以源码的形式提供了多种平台和内核下的安装:"basplnx-{version}.i386.tgz"是i386平台下的TAR文档"basplnx-{version}.x86_64.tgz"是AMD64平台下的TAR文档"basplnx-{version}.src.i386.rpm"是i386平台下的RPM包"basplnx-{version}.src.x86_64.rpm"是AMD64平台下的RPM包1.安装TAR文档解压并展开TAR文档% tar xzvf basplnx-{version}.{arch}.tgz(1) 创建内核模块"basp.o"或basp.ko(在2.6内核下)% make(2) 创建设备文件并复制文件% make install(3) 更新模块信息% depmod -a(4) 加载驱动程序% insmod basp安装 RPM 包(1) 安装 RPM 的源文件包% rpm -i basplnx-{version}.src.{arch}.rpm(2) 进入 RPM 的路径并为内核创建驱动程序% cd /usr/src/redhat% rpm -bb SPECS/basplnx.spec注意:如果Linux的发行版本包含的是RPM v4.1或者更新版本,使用rpmbuild命令代替"rpm"(3) 安装刚刚创建的包% rpm -i RPMS/i386/basplnx-{version}.{arch}.rpm驱动程序和其它需要的文件会自动被安装。

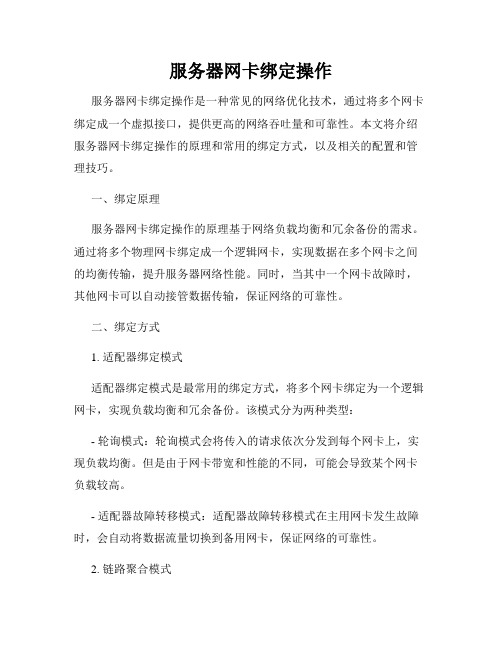

服务器网卡绑定操作

服务器网卡绑定操作服务器网卡绑定操作是一种常见的网络优化技术,通过将多个网卡绑定成一个虚拟接口,提供更高的网络吞吐量和可靠性。

本文将介绍服务器网卡绑定操作的原理和常用的绑定方式,以及相关的配置和管理技巧。

一、绑定原理服务器网卡绑定操作的原理基于网络负载均衡和冗余备份的需求。

通过将多个物理网卡绑定成一个逻辑网卡,实现数据在多个网卡之间的均衡传输,提升服务器网络性能。

同时,当其中一个网卡故障时,其他网卡可以自动接管数据传输,保证网络的可靠性。

二、绑定方式1. 适配器绑定模式适配器绑定模式是最常用的绑定方式,将多个网卡绑定为一个逻辑网卡,实现负载均衡和冗余备份。

该模式分为两种类型:- 轮询模式:轮询模式会将传入的请求依次分发到每个网卡上,实现负载均衡。

但是由于网卡带宽和性能的不同,可能会导致某个网卡负载较高。

- 适配器故障转移模式:适配器故障转移模式在主用网卡发生故障时,会自动将数据流量切换到备用网卡,保证网络的可靠性。

2. 链路聚合模式链路聚合模式将多个网卡绑定为一个逻辑网卡,并通过链路聚合控制协议(LACP)实现对网络流量的负载均衡和冗余备份。

该模式依赖于网络交换机的支持,通过交换机上的聚合组实现网卡的绑定和控制。

三、配置和管理服务器网卡绑定操作的配置和管理通常需要在服务器的操作系统中进行,以下是一些常用的配置和管理技巧:1. 操作系统支持首先要确保服务器的操作系统支持网卡绑定操作。

大部分现代操作系统,如Linux、Windows Server等,都提供了丰富的网络绑定功能和管理工具。

2. 硬件检查在进行网卡绑定操作之前,要确保服务器的硬件和网络环境满足要求。

检查网卡的型号和规格,以及交换机的配置和支持情况。

3. 配置文件修改根据服务器操作系统的不同,可以通过修改相应的配置文件来实现网卡绑定。

比如在Linux系统中,可以编辑网络配置文件(如/etc/network/interfaces)来指定绑定方式和参数。

打造双网卡负载均衡服务器

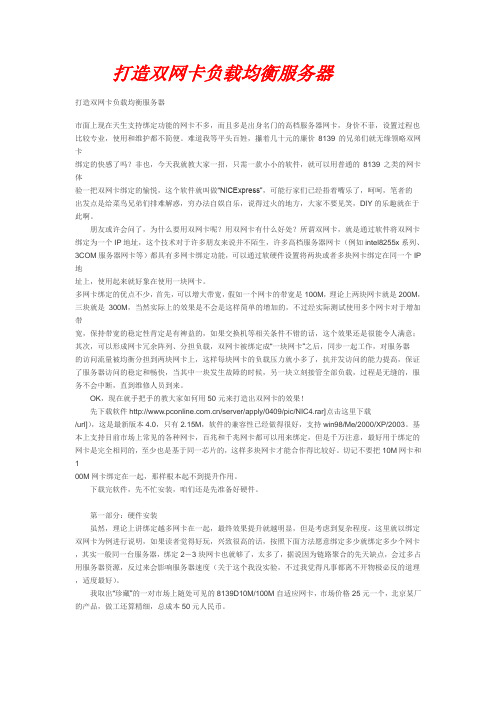

打造双网卡负载均衡服务器打造双网卡负载均衡服务器市面上现在天生支持绑定功能的网卡不多,而且多是出身名门的高档服务器网卡,身价不菲,设置过程也比较专业,使用和维护都不简便。

难道我等平头百姓,攥着几十元的廉价8139的兄弟们就无缘领略双网卡绑定的快感了吗?非也,今天我就教大家一招,只需一款小小的软件,就可以用普通的8139之类的网卡体验一把双网卡绑定的愉悦,这个软件就叫做“NICExpress”,可能行家们已经捂着嘴乐了,呵呵,笔者的出发点是给菜鸟兄弟们排难解惑,穷办法自娱自乐,说得过火的地方,大家不要见笑,DIY的乐趣就在于此啊。

朋友或许会问了,为什么要用双网卡呢?用双网卡有什么好处?所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP 地址上,使用起来就好象在使用一块网卡。

多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

OK,现在就手把手的教大家如何用50元来打造出双网卡的效果!先下载软件/server/apply/0409/pic/NIC4.rar]点击这里下载/url]),这是最新版本4.0,只有2.15M,软件的兼容性已经做得很好,支持win98/Me/2000/XP/2003。

IBM服务器双网卡绑定

环境:Xseries366Windows2003 sp1Broadcom v8.1.6 Drivers Software CD Release简单的讲,teaming可以使服务器里的多个网卡能同时工作,并分担网络中的数据流量。

配置步骤:1.安装Broadcom配套光盘中的BACS应用程序;2. 运行BACS程序,可以看到打好驱动的两块网卡3.右键点击其中一块网卡,选择“创建组”选项4.标识新组名称,选择teaming方式(本文重点介绍“智能负载平衡和故障转移”teaming 绑定方式)5.将可用网卡添加到新组中,点击应用,几分钟后绑定成功!待完成后,网络连接中出现一块虚拟网卡,可对其进行IP配置。

至此,teaming配置完成。

为了使服务器里的多个网卡能同时工作,并分担网络中的数据流量,可以对网卡做teaming的配置,不同的网卡芯片提供的teaming类型可能略有差别,下面就对Broadcom 厂商的网卡所实现的负载均衡的几种形式介绍如下:1.Smart Load Balancing™ and Failover这种模式是基于IP地址来做的负载均衡,它通过team中的多个网卡来来平衡通信中的数据流量。

在这种方式下,team中的每个网卡有自己的MAC地址,并且能够实现自动侦测;如果一个team中所有的网卡都出现了故障,那这种方式能够实现动态故障转移,使用其它team 中的网卡或者已有的一个备用网卡。

使用这种teaming方式时并不需要在交换机上作配置。

而且LiveLink 的功能只有在这种模式下可以使用。

2. Link Aggregation (802.3ad)该模式工作时遵循802.3ad(LACP)规范,能够实现动态配置虚拟网络中team里的网卡。

所有在team中的网卡都被配置成使用同一个MAC地址(这个地址是team中第一个网卡的MAC地址)接受数据报。

网络通信中输出数据时的负载均衡是有BASP的软件来决定的;而输入数据时的负载均衡是由网卡所连接的交换机来完成的。

linux 双网卡绑定(bonding)实现负载均衡或故障转移

linux 双网卡绑定(bonding)实现负载均衡或故障转移我们在这介绍的Linux双网卡绑定实现就是用法两块网卡虚拟成为一块网卡,这个聚合起来的设备看起来是一个单独的以太网接口设备,通俗点讲就是两块网卡具有相同的IP地址而并行链接聚合成一个规律链路工作。

其实这项技术在Sun和Cisco中早已存在,被称为Trunking 和Etherchannel 技术,在Linux的2.4.x的内核中也采纳这这种技术,被称为bonding。

bonding技术的最早应用是在 beowulf上,为了提高集群节点间的数据传输而设计的。

下面我们研究一下bonding 的原理,什么是bonding需要从网卡的混杂(promisc)模式说起。

我们知道,在正常状况下,网卡只接收目的硬件地址(MAC Aress)是自身Mac 的以太网帧,对于别的数据帧都滤掉,以减轻驱动程序的负担。

但是网卡也支持另外一种被称为混杂promisc的模式,可以接收网络上全部的帧,比如说mp.html' target='_blank'>tcp,就是运行在这个模式下。

bonding也运行在这个模式下,而且修改了驱动程序中的mac地址,将两块网卡的 Mac地址改成相同,可以接收特定mac的数据帧。

然后把相应的数据帧传送给bond驱动程序处理。

挺直给两块网卡设置同一IP地址是不行能的。

Kerne 2.4.12及以后的版本均供bonding模块,以前的版本可以通过实现。

一、编辑虚拟网络接口配置文件,指定网卡IP 假设eth0是对外服务的网卡,已经调试好网络;eth1是希翼与eth0同时对外提供服务的网卡。

/etc/sysconfig/network-scripts/ vi ifcfg-bond0 写入如下信息和本来 ifcfg-eth0 的配置其实差不多。

所以我建议执行如下语句,将ifcfg-eth0复制一份再改。

cp ifcfg-eth0ifcfg-bon0 复制代码将ifcfg-bon0的信息修改大致如下: DEVICE=bond0 BOOTPROTO=ic IPADDR=[IP] NETMASK=[MASK] BROADCAST=[BROADCAST] GATEWAY=[GATEWAY] ONBOOT=yes TYPE=Ethernet 二、配置真切网卡修改ifcfg-eth0如下:DEVICE=eth0 BOOTPROTO=none ONBOOT=yes MASTER=bond0第1页共2页。

AdaptiveLoadBalancing(负载平衡)与多网卡绑定

Adaptive Load Balancing(负载平衡)与多网卡绑定小知识:为什么要多网卡绑定?多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来在绑定之前是这样分组的步骤:这里选择负载平衡分组后的状态:分组前,单intel pro/100 ve下载指环王3-王者归来只有6K多/S,双网卡绑定后达到了60多K/S峰值.下载一个230M电影,6K/S要10个小时,如果一直是用绑定的速度,60K/S就一个多小时可以了,呵呵.至此大功告成,2张或以上的Intel Pro/100 S Server Adapter,都可以利用Adaptive Load Balancing的技术来玩玩Load Balancing....,也参阅下面的官方参考:Adaptive Load Balancing :/network/connectivity/solutions/server_bottlenecks/ bot_sol1.htmLink Aggregation & Fast EtherChannel :/network/connectivity/solutions/server_bottlenecks/bot_ sol2.htm多网卡绑定一个IP的方法,目前有三种:1、NICExpress2、D-Link570网卡随卡带的捆绑软件3、Intel的专用捆绑软件:PROSet Ⅱ(本站可下载)三种方法对比:用NICExpress及D-Link570网卡随卡带的捆绑软件进行捆绑,对网卡没有什么特别的要求。

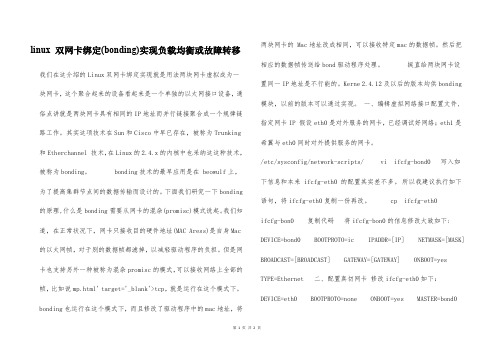

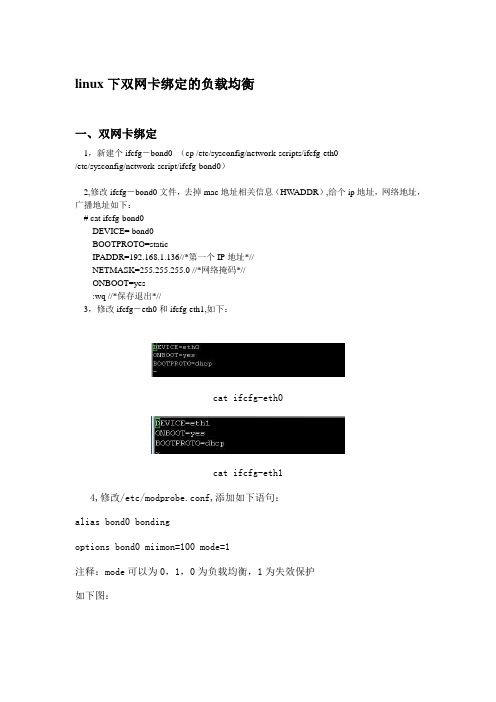

linux下双网卡绑定的负载均衡

linux下双网卡绑定的负载均衡一、双网卡绑定1,新建个ifcfg-bond0 (cp /etc/sysconfig/network-scripts/ifcfg-eth0/etc/sysconfig/network-script/ifcfg-bond0)2,修改ifcfg-bond0文件,去掉mac地址相关信息(HW ADDR),给个ip地址,网络地址,广播地址如下:# cat ifcfg-bond0DEVICE= bond0BOOTPROTO=staticIPADDR=192.168.1.136//*第一个IP地址*//NETMASK=255.255.255.0 //*网络掩码*//ONBOOT=yes:wq //*保存退出*//3,修改ifcfg-eth0和ifcfg-eth1,如下:cat ifcfg-eth0cat ifcfg-eth14,修改/etc/modprobe.conf,添加如下语句:alias bond0 bondingoptions bond0 miimon=100 mode=1注释:mode可以为0,1,0为负载均衡,1为失效保护如下图:5,修改/etc/rc.d/rc.local,添加如下内容:ifenslave bond0 eth0 eth1route add -net 192.168.1.255 netmask 255.255.255.0 bond0如下图:6,重启,看能否通过ssh登陆上服务器bond0得ip(192.168.1.136),如果成功登陆或者ping通了,再查看一下连接状态ifconfig,如下图:ifconfig查看连接状态7,尝试拔掉一根网线看是否能正常登陆上去(或ping得通),再查看一下更连接状态(cat /proc/net/bonding/bond0)如下图:8,尝试一下更换一下mode的值,再试一下。

我自己尝试了一下0和1,都成功了,当拔一根网线的时候,均能正常连接到服务器上,不同的是,当你用ifconfig查看连接状态的时候,你会发现当mode=0的时候双网卡是同时工作的,都有数据包传输,数据传输量几乎一样多(两块网卡同时在工作),用mode=1的时候,你会发现只有一个网卡存在数据传输,另一块网卡没有数据传输(只有一块网卡在工作)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Windows 32-64bit双网卡绑定软件下载地址:

/support/fixcentral/systemx/quickorder?pare nt=ibm~Systemx3650M3&product=ibm/systemx/7945&&platform=All &function=fixId&fixids=brcm_sw_nic_vt6.2.4.1-cd_anyos_32-64&incl udeSupersedes=0&source=fc

安装测试的环境为Windows2008 64位操作系统

下载ISO格式的文件,用虚拟光驱打开,点击Launch,运行软件

软件打开界面,点击MANAGEMENT APPLICATIONS

下一步

接受并下一步

默认就可以了,下一

安装

安装过程大概十几秒

点击确定

点击完成

确定后,软件已经开启,点击任务栏右下角的第一个图标,右键开启软件

软件开启中

软件打开界面,因为是测试,没有插网线,所以很多红色X ,点击橙色的Team Management,进入到建组界面

看到还没有建组

右击网络适配器,点击Create a Team

Next

填写要建的组的名字,并Next

点选第一项(默认),并Next

出现服务器默认的两个Broadcom 网卡,选中要绑定的网卡,点击Add

Next

点选第一项(默认),此为不设置备用网卡,点击Next

点击No,并Next

跳过Vlan管理,并Next

第一项(默认),点Finish

点“是”

开始配置双网卡,建组

能看到自己建的Team1

打开“网络链接”,看到多出的虚拟网卡,对其进行常规的配置就OK,至此,大功告成。