提高服务器高可用性的双网卡绑定聚合技术的应用

Linux下双网卡绑定(bonding技术)

Linux下双⽹卡绑定(bonding技术)2013-08-20 15:39:31现在很多服务器都⾃带双千兆⽹⼝,利⽤⽹卡绑定既能增加⽹络带宽,同时⼜能做相应的冗余,⽬前应⽤于很多的场景。

linux操作系统下⾃带的⽹卡绑定模式,Linux bonding驱动提供了⼀个把多个⽹络接⼝设备捆绑为单个⽹络接⼝设置来使⽤,⽤于⽹络负载均衡及⽹络冗余。

当然现在⽹卡产商也会出⼀些针对windows操作系统⽹卡管理软件来做⽹卡绑定(windows操作系统没有⽹卡绑定功能需要第三⽅⽀持)。

我们公司是做分布式⽂件系统的,很多项⽬都⽤到⽹卡绑定来提⾼性能。

在⽹络找了很多资料,也做了⼤量的测试,下⾯就⽹卡绑定谈⼀下⾃⼰的看法。

⼀、 Bonding的应⽤1、⽹络负载均衡对于bonding的⽹络负载均衡是我们在⽂件服务器中常⽤到的,⽐如把三块⽹卡,当做⼀块来⽤,解决⼀个IP地址,流量过⼤,服务器⽹络压⼒过⼤的问题。

如果在内⽹中,⽂件服务器为了管理和应⽤上的⽅便,⼤多是⽤同⼀个IP地址。

对于⼀个百M的本地⽹络来说,⽂件服务器在多个⽤户同时使⽤的情况下,⽹络压⼒是极⼤的,为了解决同⼀个IP地址,突破流量的限制,毕竟⽹线和⽹卡对数据的吞吐量是有限制的。

如果在有限的资源的情况下,实现⽹络负载均衡,最好的办法就是bonding 。

2、⽹络冗余对于服务器来说,⽹络设备的稳定也是⽐较重要的,特别是⽹卡。

⼤多通过硬件设备的冗余来提供服务器的可靠性和安全性,⽐如电源。

bonding 也能为⽹卡提供冗余的⽀持。

把⽹个⽹卡绑定到⼀个IP地址,当⼀块⽹卡发⽣物理性损坏的情况下,另⼀块⽹卡也能提供正常的服务。

⼆、 Bonding的原理什么是bonding需要从⽹卡的混杂(promisc)模式说起。

我们知道,在正常情况下,⽹卡只接收⽬的硬件地址(MAC Address)是⾃⾝Mac的以太⽹帧,对于别的数据帧都滤掉,以减轻驱动程序的负担。

但是⽹卡也⽀持另外⼀种被称为混杂promisc的模式,可以接收⽹络上所有的帧,⽐如说tcpdump,就是运⾏在这个模式下。

关于双网卡绑定与端口聚合

关于双网卡绑定与端口聚合.txt14热情是一种巨大的力量,从心灵内部迸发而出,激励我们发挥出无穷的智慧和活力;热情是一根强大的支柱,无论面临怎样的困境,总能催生我们乐观的斗志和顽强的毅力……没有热情,生命的天空就没的色彩。

关于双网卡绑定与端口聚合端口聚合(IEEE802.3ad Port Trunking)可将2至8个10/100Base-TX端口聚合成一条干路,在全双工工作模式下达到400Mbps-1.6Gbps的带宽。

端口聚合技术能充分利用现有设备实现高速数据传递,也可以通过千兆端口聚合技术实现千兆位链路的聚合,最多可以聚合4Gbps的链路带宽。

Linux双网卡绑定的实现就是使用两块网卡虚拟成为一块网卡,这个聚合起来的设备看起来是一个单独的以太网接口设备,通俗点讲就是两块网卡具有相同的 IP地址而并行链接聚合成一个逻辑链路工作。

其实这项技术在Sun和Cisco中早已存在,被称为Trunking和Etherchannel技术,在 Linux的2.4.x的内核中也采用这这种技术,被称为bonding。

bonding 技术的最早应用是在集群——beowulf上,为了提高集群节点间的数据传输而设计的。

下面我们讨论一下bonding 的原理,什么是bonding需要从网卡的混杂(promisc)模式说起。

我们知道,在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身Mac的以太网帧,对于别的数据帧都滤掉,以减轻驱动程序的负担。

但是网卡也支持另外一种被称为混杂promisc 的模式,可以接收网络上所有的帧,比如说tcpdump,就是运行在这个模式下。

bonding也运行在这个模式下,而且修改了驱动程序中的mac地址,将两块网卡的 Mac地址改成相同,可以接收特定mac的数据帧。

然后把相应的数据帧传送给bond驱动程序处理。

方案一具体配置示例如下:1、[root@storage6 network-scripts]# cat ifcfg-bond0# Intel Corporation 80003ES2LAN Gigabit Ethernet Controller (Copper)DEVICE=bond0BOOTPROTO=staticIPADDR=172.16.100.35NETMASK=255.255.255.0ONBOOT=yesGATEWAY=172.16.100.1BONDING_MASTER=yesTYPE=EthernetUSERCTL=no[root@storage6 network-scripts]# cat ifcfg-eth0# Intel Corporation 80003ES2LAN Gigabit Ethernet Controller (Copper)DEVICE=eth0BOOTPROTO=noneONBOOT=yesTYPE=EthernetMASTER=bond0SLAVE=yesUSERCTL=no[root@storage6 network-scripts]# cat ifcfg-eth1#IntelCorporation80003ES2LANGigabitEthernetController(Copper)DEVICE=eth1BOOTPROTO=noneONBOOT=yesTYPE=EthernetMASTER=bond0SLAVE=yesUSERCTL=no2、编辑 /etc/modprobe.conf 文件,加入如下一行内容,以使系统在启动时加载bonding 模块,对外虚拟网络接口设备为 bond0加入下列两行alias bond0 bondingoptions bond0 miimon=100 mode=0说明:miimon是用来进行链路监测的。

双网卡在现实中的应用

双网卡在现实中的应用双网卡在现实中的应用所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡,多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

先准备好硬件。

第一硬件安装虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度。

打开服务器机箱,把两块网卡拧在主板PCI插槽上。

第二设置调试下面要进行设置及调试了,也就是要将这两块8139D廉价网卡,如同高档服务器网卡那样绑定在一起,使用同一个IP地址,同时同步工作。

第三下载并安装软件下载NIC Express软件的安装包NIC4.rar,解压缩得到安装文件“NICExpressW2KEE.exe”,双击它启动安装程序,一路NEXT,软件提示输入unlock key(注册码),如果没有注册码,就只好点击Demo,选择试用,这样可以获得30天的免费试用期,在这30天里如果觉得不错,你可以想办法去弄一个注册码。

网卡链路聚合 简单设置实现双倍带宽解析

网卡链路聚合简单设置实现双倍带宽电脑爱好者 2016-02-19 09:01如今所有主板至少自带一个千兆以太网端口,有些高档主板带有两个端口。

很多用户都不知道家用环境下双网卡主板如何充分利用两个网口,其实使用链路聚合(Link aggregation)就是一个好思路。

双倍带宽的链路聚合链路聚合是指将两条或多条物理以太网链路聚合成一条逻辑链路。

所以,如果聚合两个1Gb/s端口,就能获得2GB/s的总聚合带宽(图1)。

聚合带宽和物理带宽并不完全相同,它是通过一种负载均衡方式来实现的。

在用户需要高性能局域网性能的时候很有帮助,而局域网内如果有NAS则更是如此。

比如说我们在原本千兆(1Gb/s)网络下PC和NAS之间的数据传输只能达到100MB/s左右,在链路聚合的方式下多任务传输速度可以突破200MB/s,这其实是一个倍增。

01链路聚合原本只是一种弹性网络,而不是改变了总的可用吞吐量。

比如说如果你通过一条2Gb聚合链路将文件从一台PC传输到另一台PC,就会发现总的最高传输速率最高为1Gb/s。

然而如果开始传输两个文件,会看到聚合带宽带来的好处。

简而言之链路聚合增加了带宽但并不提升最高速度,但如果你在使用有多个以太网端口的NAS,NAS就能支持链路聚合,速度的提升是显而易见的。

目前家用的局域网环境不论是线缆还是网卡多数都停留在1Gb/s的水平,如果你想要真正的更高吞吐量改用更高的带宽比如10Gb/s网卡,但对于大多数家庭用户万兆网卡是不太可能的。

就算我们使用普通单千兆网卡主板,通过安装外接网卡来增添一个网络端口就能实现效果。

链路聚合准备工作首先你的PC要有两个以太网端口,想要连接的任何设备同样要有至少两个端口。

除了双千兆(或一集成一独立)网卡的主板外,我们还需要一个支持链路聚合(LACP或802.1ad等)的路由器。

遗憾的是很多家用路由器不支持链路聚合,选择时要注意路由器具体参数,或者干脆选择一个支持链路聚合的交换机。

双网卡绑定

双网卡绑定

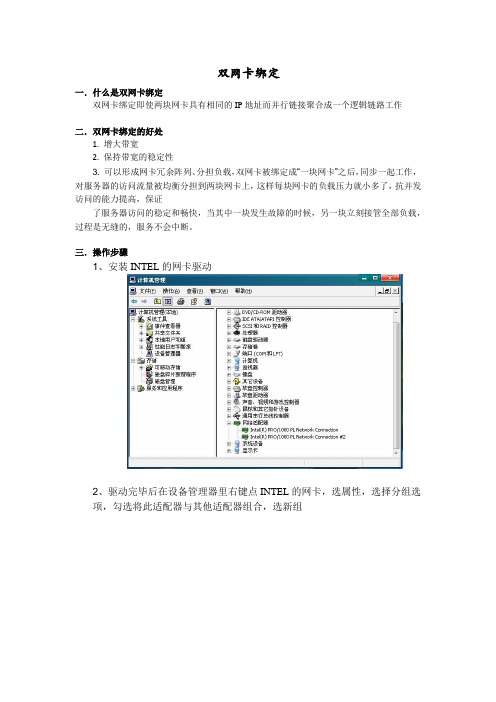

一.什么是双网卡绑定

双网卡绑定即使两块网卡具有相同的IP地址而并行链接聚合成一个逻辑链路工作

二.双网卡绑定的好处

1. 增大带宽

2. 保持带宽的稳定性

3. 可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证

了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断。

三.操作步骤

1、安装INTEL的网卡驱动

2、驱动完毕后在设备管理器里右键点INTEL的网卡,选属性,选择分组选

项,勾选将此适配器与其他适配器组合,选新组

3、添加组名(组名可以根据需要随意取)

4、单击下一步,选择组类型,此处选择适应性负载平衡。

5、下一步,勾选需要添加到组中的适配器

6、选择组模式,模式选适应性负载平衡,如果交换机支持链路聚合,选静态链路聚合也可以

7、设置组,选择主、从卡

8、在完成双网卡绑定以后在设备管理器中,网络适配器处会出现一个新的设备

“组:test”。

在本地连接中也将出现本地连接3。

四.遇到的问题以及解决方法

在绑定操作的最后一步中,单击完成后,系统则不再前进,无法完成绑定。

出现该问题的原因驱动版本过低,更新到最新版本的驱动程序后,问题解决。

Linux双网卡链路聚合

Linux双网卡链路聚合Linux双网卡链路聚合共有两种方式,bond模式与team模式。

1.bond链路聚合(英语:Link Aggregation)将多个物理端口汇聚在一起,形成一个逻辑端口,以实现出/入流量吞吐量在各成员端口的负荷分担。

网卡的链路聚合就是将多块网卡连接起来,当一块网卡损坏,网络依旧可以正常运行,可以有效的防止因为网卡损坏带来的损失,同时也可以提高网络访问速度。

网卡的链路聚合一般常用的有"bond"和"team"两种模式,"bond"模式最多可以添加两块网卡,"team"模式最多可以添加八块网卡。

bond的七种模式介绍:mode=0(balance-rr)(平衡抡循环策略)mode=1(active-backup)(主-备份策略)mode=2(balance-xor)(平衡策略)mode=3(broadcast)(广播策略)mode=4(802.3ad)(IEEE 802.3ad 动态链接聚合)mode=5(balance-tlb)(适配器传输负载均衡)mode=6(balance-alb)(适配器适应性负载均衡)bond模式介绍(支持多块网卡聚合)mode=0(balance-rr)交换机需要配置链路聚合表示负载分担,并且是轮询的方式,比如第一个包走eth0,第二个包走eth1,直到数据包发送完毕。

优点:流量提高一倍缺点:需要接入交换机做端口聚合,否则可能无法使用mode=1(active-backup)同时只有1块网卡在工作。

优点:冗余性高缺点:链路利用率低,两块网卡只有1块在工作mode=2(balance-xor)(平衡策略)交换机需要配置链路聚合表示XOR Hash负载分担,和交换机的聚合强制不协商方式配合。

(需要xmit_hash_policy,需要交换机配置port channel)特点:基于指定的传输HASH策略传输数据包。

双网卡应用方法详解

双网卡应用方法详解一、双网卡桥接(适用于不方便拉线到中继设备,且不用购买新的设备)在控制面板的网络属性里设置桥接,双网卡之前的ip配置全部失效,合成一个网桥,只需设置网桥的ip 即可二,双网卡让两个网段互联网络拓扑简图让双网互通的方法有,ics,路由nat(软路由),架设******roxy代理等。

1、ics的设置方法先打开ics的系统服务,开始——运行——services.msc然后设置adsl的连接属性,打开ics共享设置完成后,检查共享网卡的ip是否已经自动改为192.168.0.1,与之相连的那些客户端ip是否为192.16 8.0.x2、路由nat的设置方法,nat功能是只有服务器操作系统才有的功能,也就是双网卡主机系统应该是200 3之类的系统(下面用虚拟机给大家做个例子)猫——路由器拨号——网卡1桥接,虚拟2003系统一,网卡2vmnet2——网卡3vmnet2,虚拟2003系统二,网卡4vmnet3——网卡5vmnet3,虚拟客户机(截图只是让虚拟2003系统二可以访问interne t了)首先打开虚拟2003系统一的路由和远程服务(打开这个之前需要先关闭ics的),也就是2003的软路由功能接着是在路由器上设置静态路由然后是设置好ip地址,虚拟2003系统一的网卡2不设置网关,网卡1的网关指向路由器,虚拟2003系统二的网卡3的网关指向网卡2,(如果要让虚拟客户机三也要上网,还需要在路由器上再设置静态路由,并在两个2003上打开rip或其他路由协议)3、******roxy代理,只要在双网卡主机上运行******roxy,简单设置后,b网段机器就可以通过连接b网段网卡的ip来代理上网了三、使用双网卡,主机分别访问被隔开的两个网段。

网络拓扑简图引用阅读以下文章你需要懂得什么是IP地址和子网掩码的基础知识。

其他的词汇解释,需要你认真读完文章就能明白。

相关拓扑我就不画了,设想一下有这样的网络,一台PC机上面有2个网卡,各连接一个不同的网络(这里可以是单一网卡,设置了多个IP的情况)。

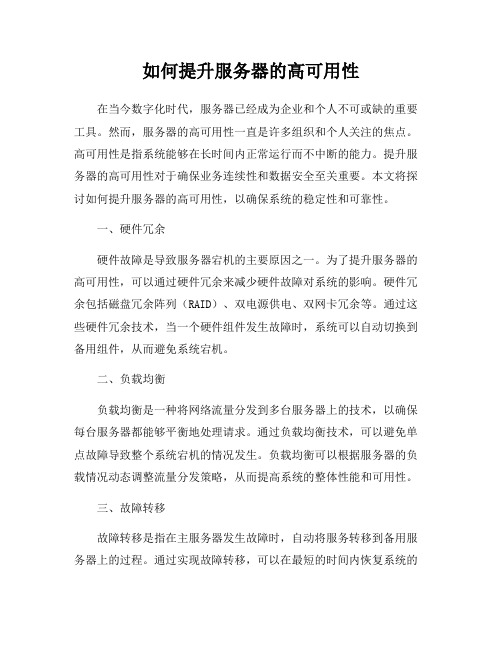

如何提升服务器的高可用性

如何提升服务器的高可用性在当今数字化时代,服务器已经成为企业和个人不可或缺的重要工具。

然而,服务器的高可用性一直是许多组织和个人关注的焦点。

高可用性是指系统能够在长时间内正常运行而不中断的能力。

提升服务器的高可用性对于确保业务连续性和数据安全至关重要。

本文将探讨如何提升服务器的高可用性,以确保系统的稳定性和可靠性。

一、硬件冗余硬件故障是导致服务器宕机的主要原因之一。

为了提升服务器的高可用性,可以通过硬件冗余来减少硬件故障对系统的影响。

硬件冗余包括磁盘冗余阵列(RAID)、双电源供电、双网卡冗余等。

通过这些硬件冗余技术,当一个硬件组件发生故障时,系统可以自动切换到备用组件,从而避免系统宕机。

二、负载均衡负载均衡是一种将网络流量分发到多台服务器上的技术,以确保每台服务器都能够平衡地处理请求。

通过负载均衡技术,可以避免单点故障导致整个系统宕机的情况发生。

负载均衡可以根据服务器的负载情况动态调整流量分发策略,从而提高系统的整体性能和可用性。

三、故障转移故障转移是指在主服务器发生故障时,自动将服务转移到备用服务器上的过程。

通过实现故障转移,可以在最短的时间内恢复系统的正常运行,减少业务中断时间。

故障转移可以通过软件实现,也可以通过硬件实现,如使用双机热备方案。

在设计故障转移方案时,需要考虑到数据同步、网络延迟等因素,确保故障转移过程的可靠性和稳定性。

四、数据备份与恢复数据备份是确保数据安全和业务连续性的重要手段。

定期对服务器上的数据进行备份,并将备份数据存储在安全可靠的地方。

在服务器发生故障时,可以通过备份数据快速恢复系统,减少数据丢失和业务中断的风险。

同时,需要定期测试备份数据的完整性和可恢复性,确保备份数据的有效性。

五、监控与预警监控是保障服务器高可用性的重要环节。

通过监控服务器的运行状态、性能指标和异常情况,可以及时发现问题并采取措施进行处理。

建立监控系统,并设置预警机制,当服务器出现异常时能够及时通知管理员进行处理。

双网卡的应用

双网卡,提高网速!精典技术]大家好,我前几天在去联想玩的时候,看到他们工程师一台机装好几个网卡,速度还不错,我看一下,回到公司也到网上找了一些资料,双(多)网卡用一个IP的技术,对于各种内网服务器,和电脑、、、、很有用处,我把我在网上找到的资料整理了一下,大家看一看,也许对大家有好处!所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡,多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

先下载一个软件NIC Express Enterprise V4.0/SoftView/SoftView_17845.html下载完软件,先不忙安装,咱们还是先准备好硬件。

第一部分:硬件安装虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。

服务器双网卡绑定

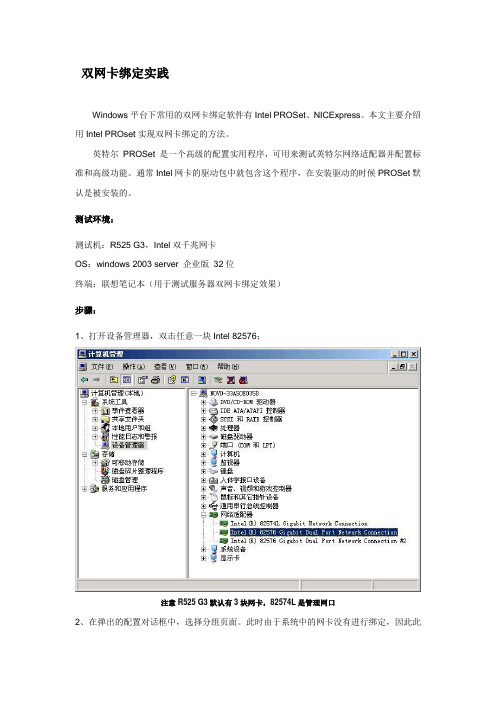

双网卡绑定实践Windows平台下常用的双网卡绑定软件有Intel PROSet、NICExpress。

本文主要介绍用Intel PROset实现双网卡绑定的方法。

英特尔PROSet 是一个高级的配置实用程序,可用来测试英特尔网络适配器并配置标准和高级功能。

通常Intel网卡的驱动包中就包含这个程序,在安装驱动的时候PROSet默认是被安装的。

测试环境:测试机:R525 G3,Intel双千兆网卡OS:windows 2003 server 企业版32位终端:联想笔记本(用于测试服务器双网卡绑定效果)步骤:1、打开设备管理器,双击任意一块Intel 82576;注意R525 G3默认有3块网卡,82574L是管理网口2、在弹出的配置对话框中,选择分组页面。

此时由于系统中的网卡没有进行绑定,因此此时组下拉列表框是灰色不可选的,单击“新组”;3、在弹出的“新组向导”对话框中,填写组的名称,下一步;4、钩选需要绑定的两个网卡,下一步;5、这里列出了可选择的网卡绑定的模式,常用的是容错和负载平衡。

这里我们选择容错,单击下一步;6、完成向导;7、此时我们可以看到刚才的分组页面中组的下拉列表中已经有team1;8、同时弹出的还有team1的属性对话框,单击设置页面,可以看到其中一块网卡状态为“活动”,另一块网卡装状态为“待命”。

在此界面中还可进行删除组和修改组的操作,单击“修改组”;9、在弹出的对话框中,可以设置双网卡的主从关系,如不进行设定,此关系是不固定的。

即:当断掉当前活动状态的主网口时,待命的网口将接替主网口的位置,对外提供服务,并成为主网口。

当之前断开的网口恢复后,主从关系不会改变,该网口变为待命状态。

10、固定主从关系,设置当前活动的网口为主适配器,待命网口为次适配器;11、此时在设备管理器中可以看到网络适配器下拉列表中出现了“组:team1”,而两块Intel 82576网卡作为team1的成员,其描述也有了变化。

双网卡绑定NCU软件的详细功能以及使用

NFT(Network Fault Tolerant):这种模式下一个网口处于Active状态,另外一个网口处于Standby状态,可以把2个网线连接到不同的交换机上面达到容错目的。

在NFT之外还有一种是Network Fault Tolerance with Preference Order模式,该模式为NFT的增强版。就是带有优先级的NFT模式,比如服务器分别连接到2台交换机上,一台交换机为千兆,一台交换机为百兆。那么连接千兆交换机的网口为Active状态,连接百兆交换机的网口为Standby状态。

目前VLAN 200中的笔记本是无法ping通的

在NCU工具中选中网口1,之后点击VLAN(802.1Q)按钮

出现如下窗口,点击ADD选项,添加VLAN

在VLAN Properties中添加本地网口接入的VLAN 2该VLAN默认为Native Vlan

添加笔记本所在的VLAN 100

可以看到网口1前面出现一个V的图标,说明已经设置网口跨VLAN。

双网卡绑定NCU软件的详细功能以及使用

———————————————————————————————— 作者:

———————————————————————————————— 日期:

NCU软件的详细功能以及使用

设备:DL380 G5 +HP ProCurve 2510交换机

Contents

NCU软件简介

由于交换机端默认开启的是被动协商,所以当设置802.3ad Dynamic模式后网络连接被断开

查看Team Utilization中可以看到RX和TX都为0bps

当手动将交换机上网卡接入的端口开启LACP主动协商模式后,网卡状态变成正常工作状态。

Linux双网卡绑定实现

Linux双网卡绑定实现就是使用两块网卡虚拟成为一块网卡,这个聚合起来的设备看起来是一个单独的以太网接口设备,通俗点讲就是两块网卡具有相同的IP地址而并行链接聚合成一个逻辑链路工作。

其实这项技术在Sun和Cisco中早已存在,被称为Trunking和Etherchannel技术,在Linux的2.4.x的内核中也采用这这种技术,被称为bonding。

bonding 技术的最早应用是在集群——beowulf上,为了提高集群节点间的数据传输而设计的。

下面我们讨论一下bonding 的原理,什么是bonding需要从网卡的混杂(promisc)模式说起。

我们知道,在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身Mac的以太网帧,对于别的数据帧都滤掉,以减轻驱动程序的负担。

但是网卡也支持另外一种被称为混杂promisc 的模式,可以接收网络上所有的帧,比如说tcpdump,就是运行在这个模式下。

bonding也运行在这个模式下,而且修改了驱动程序中的mac地址,将两块网卡的Mac地址改成相同,可以接收特定mac的数据帧。

然后把相应的数据帧传送给bond驱动程序处理。

说了半天理论,其实配置很简单,一共四个步骤:实验的操作系统是Redhat Linux Enterprise 3.0绑定的前提条件:芯片组型号相同,而且网卡应该具备自己独立的BIOS芯片。

1.编辑虚拟网络接口配置文件,指定网卡IPvi /etc/sysconfig/ network-scripts/ ifcfg-bond0[root@redflag root]# cp /etc/sysconfig/network-scripts/ifcfg-eth0 ifcfg-bond0 2 #vi ifcfg-bond0将第一行改成 DEVICE=bond0# cat ifcfg-bond0DEVICE=bond0BOOTPROTO=staticIPADDR=172.31.0.13NETMASK=255.255.252.0BROADCAST=172.31.3.254ONBOOT=yesTYPE=Ethernet这里要主意,不要指定单个网卡的IP 地址、子网掩码或网卡 ID。

mlag技术在数据中心双归属中的原理及应用

Network World •网络天地Electronic Technology & Software Engineering 电子技术与软件工程• 21【关键词】堆叠 跨设备链路聚合 链路汇聚控制协议 孤立端口1 引言随着网络规模的不断扩大,对网络设备可靠性的要求也在不断提高。

尤其是在数据中心的应用场景中,几乎所有的数据中心服务器都需要实现双归属,通过双网卡形成链路聚合,再分别双上联交换设备,以增强其可靠性。

当MLAG 技术在数据中心双归属中的原理及应用文/石瑞华任何一台上联交换机出问题,或者任何一个上联端口出问题,都能实现快速切换,业务上切换时间实现小于50ms ,丢包达到最小化。

要实现双归属,最常用的技术手段包括堆叠技术和MLAG 技术。

2 堆叠技术堆叠技术,即Stacking 技术,主要是将两台或者多台设备通过堆叠口按照一定的形式进行互联互通。

比如最常用的就是总线型组网和环型组网,复杂的还有星型组网等。

这些设备对外呈现出的是一台设备。

也就是说,这些设备互联之后,就组合成了一台大型设备,每台设备只相当于这一台大设备中的一块子线卡。

所有的设备都可以实现数据转发功能。

在这些设备中有一台主设备,主要负责控制层面的运算。

另外还有一台备设备,主要负责控制层面的备份,以应对主设备的意外故障。

除了上述主备两台设备之外,其他的设备都称为从设备,只负责数据转发,不负责任何控制层面的运算。

所有的配置信息都需要从主设备进行下发,下发到包括主设备、备设备和众多从设备在内的所有设备上。

总的来说,堆叠系统就是一主一备多从的设备,通过一定的互联互通方式,实现的设备虚拟化技术。

对于大部分数据中心的应用来说,高可靠性固然重要,但并不需要太多的设备来实现这样的可靠性。

一般来说,数据中心服务器只需要通过双网卡来实现聚合口双归属即可,并不需要能支持多台设备的堆叠技术。

而且,一般支持堆叠系统的设备实现复杂。

除了堆叠系统本身之外,所有模块还都需要支持HA (High Available ,高可用性集群),需要实现实时备份、批量备份和数据平滑。

多网卡绑定技术在服务器系统中的应用

多网卡绑定技术在服务器系统中的应用摘要:随着社会信息化进程的不断推进,各行业的服务器访问量越来越大,客户端连接的速度越来越慢,一块普通的百兆网卡已经不能满足气象业务应用的需要。

由于服务器在气象业务中的特殊地位,加上服务器的高可用性和安全性,也受到用户前所未有的重视,它已经成为气象网络信息环境的重要指标,其中最重要的一点是服务器网络连接的高可用性。

为了实现气象数据传输更加顺畅和公众对气象信息的访问更加快捷,我们在服务器中采用多网卡绑定技术使网卡之间能自动切换工作、自动分担负载。

本文介绍了多网卡绑定的提出背景和绑定模式,详细介绍了linux环境下的多网卡bonding技术实现过程,服务器端的配置方法。

研究表明,多网卡链路绑定解决方案可以明显增加系统整体网络接口的吞吐率和提供网络子系统的可用性。

关键词:多网卡绑定;负载均衡;网络带宽;服务器系统中图分类号:tp311.52 文献标识码:a 文章编号:1007-9599 (2013) 02-0000-021 网卡绑定技术的引入随着信息技术与存储技术的发展,各种应用对服务器数据的海量存储和高速存取提出了更新的要求,使得传统的存储体系逐渐不能满足用户需求,网络存储技术由此应运而生。

目前附网存储设备由于具有较高的性价比在网络存储市场上获得了广泛的接受。

它基于以太网构建,具有数据共享方便,可扩展性好,管理和维护的开销小等优点。

但其主要缺点是增加了网络负载。

随着客户对气象数据依赖性的增加,nas设备的网络吞吐率逐渐显得力不从心,成为制约整个系统性能的瓶颈。

如果单靠升级网络硬件(如千兆网卡及千兆交换机)来提高网络性能会对nas设备的搞性价比带来负面影响。

因此,在利用现有网络硬件设备的环境下,通过软件方式提高网络吞吐率已经成为nas及其它服务器亟待解决的问题。

为了更有效地利用服务器上的多个网络接口,可用将多块网卡虚拟成为一块网卡,其中每个物理网卡都具有相同的ip地址。

提高服务器高可用性的双网卡绑定聚合技术的应用

提高服务器可用性的多网卡绑定聚合技术的应用王和平摘要:通过NICExpress软件对服务器多网卡进行捆绑聚合,以实现增加带宽、负载均衡、故障自动转移等,从而达到服务器的高可靠性和高可用性。

关键词:网卡聚合;服务器;高可用性一、引言现今几乎各行各业内部都建立了自己的服务器,由于服务器的特殊地位,它的可靠性、可用性及其I/O速度就显得非常的重要,保持服务器的高可用性和安全性是企业IT环境的重要指标,其中最重要的一点是服务器网络连接的高可用性。

本文通过NICExpress软件,通过实际部署服务器多网卡,以提高服务器网络连接的可用性,配合实现构建高可靠性的网络环境。

二、网卡聚合绑定的特点网卡绑定聚合就是通过软件将多块网卡绑定为一个IP地址,使用起来就好象在使用一块网卡。

网卡是计算机和外部联系的主要通道。

个人计算机默认安装一块网卡,服务器基本配置应该安装两块网卡。

如果服务器上仅安装一块网卡,建议管理员至少增加一块网卡。

一块为主网卡,其他为备用网卡,然后再通过网线将对应的网卡连接到同一交换机上。

在服务器和交换机之间建立主连接和备用连接。

通过NICExpress虚拟网卡软件将多块网卡绑定为一块网卡,或称之为虚拟网卡组,然后为虚拟网卡组设置一个唯一的IP地址。

安装多块网卡后,通过多网卡并发方式传输数据,有利于提高网络传输效率,提高系统性能。

一旦网卡组中的任何一个物理连接断开,比如网卡出现故障或链路断开,系统软件将自动监测连接状态,出现故障的网卡将自动切换到其他网卡的物理连接上。

在服务器中部署多块网卡聚合绑定后,将具备如下特点:1.增加带宽。

假如网卡的带宽100Mbps,那么理论上两块网卡聚合绑定后的带宽就是200Mbps,三块网卡聚合绑定后的带宽就是300Mbps。

当然实际上的效果是不会这样简单相加的,不过经实际测试使用多个网卡绑定对于增加带宽,保持带宽的稳定性肯定是有益的。

经过实际测量,三块带宽为100Mbps的网卡绑定后传输总带宽可以达到260Mbps。

服务器网卡双网卡应用

服务器网卡高级网络服务(ANS) 组类型以一般的Intel/BroadCOM网卡为主,本文以Intel为例,BroadCOM或其他厂商高级服务器网卡也一般具有相同性能。

同时,NICexpress也是一款不错的软件,但是,从2004年后,NICexpress便没有了持续的支持,因此,在实际应用中,NICexpress已经没有实际应用价值,各种问题非常多,其只是支持“适应性负载平衡”类的应用,在单/双switch上的容错应用很容易引起系统蓝屏崩溃。

Windows平台和Linux/UNIX平台的应用问题:1、Windows平台,主要依靠网卡厂商提供的Intel PROset / BroadCOM BASP工具实现;2、Linux/UNIX平台,由于系统本身已具备此类特性,可依靠系统本身配置实现,也可依靠厂商Linux/UNIX版本的驱动程序来实现。

主要包括:-1、网卡容错-2、适应性负载平衡-3、静态链接聚合-4、IEEE 802.3ad 动态链接聚合-5、switch容错***注意:***(以Intel为例)每一类ANS 组需要至少一个英特尔PRO(R) 服务器网卡或英特尔集成连接。

将英特尔PRO/100 和英特尔PRO/10GbE 网卡混用不受支持。

并不是所有组类型在所有的操作系统上都可用。

ANS 分组不能与“速成分组”在多端口网卡上共存。

如果一个多端口网卡上的端口被组合入“速成组”,则该网卡上的所有端口将都不可用于ANS 分组。

1、网卡容错网卡容错(AFT) 在switch端口、电缆或网卡发生故障时,通过自动从活动网卡向待命网卡进行故障恢复转移来提供冗余。

活动网卡会选定一个网卡。

所有其他网卡的ASF 都为待命。

可以为组选择主网卡和次网卡,但不是必需的。

如果选择了主网卡,它便成为组的活动网卡。

如果选择了一个次网卡,则它成为待命网卡。

如果活动网卡发生故障,则次网卡取而代之,而其他所有网卡均仍为待命。

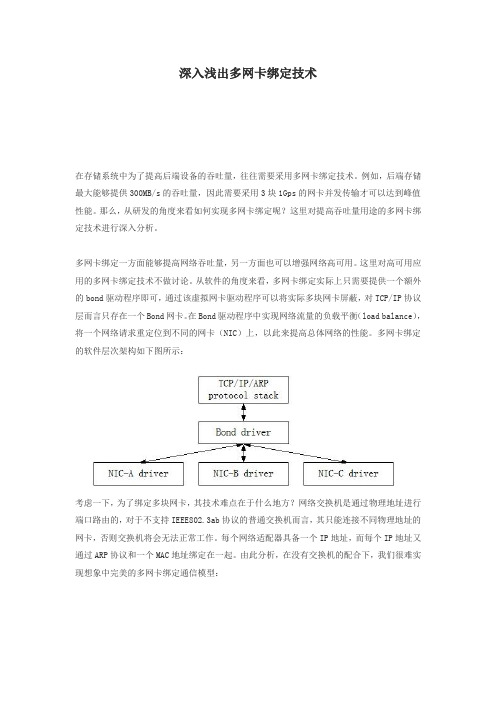

深入浅出多网卡绑定技术

深入浅出多网卡绑定技术在存储系统中为了提高后端设备的吞吐量,往往需要采用多网卡绑定技术。

例如,后端存储最大能够提供300MB/s的吞吐量,因此需要采用3块1Gps的网卡并发传输才可以达到峰值性能。

那么,从研发的角度来看如何实现多网卡绑定呢?这里对提高吞吐量用途的多网卡绑定技术进行深入分析。

多网卡绑定一方面能够提高网络吞吐量,另一方面也可以增强网络高可用。

这里对高可用应用的多网卡绑定技术不做讨论。

从软件的角度来看,多网卡绑定实际上只需要提供一个额外的bond驱动程序即可,通过该虚拟网卡驱动程序可以将实际多块网卡屏蔽,对TCP/IP协议层而言只存在一个Bond网卡。

在Bond驱动程序中实现网络流量的负载平衡(load balance),将一个网络请求重定位到不同的网卡(NIC)上,以此来提高总体网络的性能。

多网卡绑定的软件层次架构如下图所示:考虑一下,为了绑定多块网卡,其技术难点在于什么地方?网络交换机是通过物理地址进行端口路由的,对于不支持IEEE802.3ab协议的普通交换机而言,其只能连接不同物理地址的网卡,否则交换机将会无法正常工作。

每个网络适配器具备一个IP地址,而每个IP地址又通过ARP协议和一个MAC地址绑定在一起。

由此分析,在没有交换机的配合下,我们很难实现想象中完美的多网卡绑定通信模型:如果ARP协议能够支持将一个IP地址映射到多个MAC地址,那么在Bond驱动层我们完全可以实现上图所示的多网卡绑定通信模型。

在实际IP网络中,为了达到上述绑定效果,需要交换机的802.3ab协议支持,通过交换机实现round robin方式的网卡绑定,纯软件方法无法做到。

基于802.3ab协议的多网卡绑定如下图所示:在802.3ab的支持下,Server端所有网卡的MAC地址全部配置成一个,例如MAC-A,然后在交换机端将这些端口聚合起来。

交换机在接收到数据报文之后会轮询这些端口将数据报文发送给Bond驱动,Bond驱动想发送数据的时候同样通过轮询方法将数据报文交给不同网卡进行传输。

双网卡网卡冗余

用NICExpress打造双网卡负载均衡服务器为什么要用双网卡呢?用双网卡有什么好处?所谓双网卡,就是通过软件将双网卡绑定为一个IP地址,这个技术对于许多朋友来说并不陌生,许多高档服务器网卡(例如intel8255x系列、3COM服务器网卡等)都具有多网卡绑定功能,可以通过软硬件设置将两块或者多块网卡绑定在同一个IP地址上,使用起来就好象在使用一块网卡。

多网卡绑定的优点不少,首先,可以增大带宽,假如一个网卡的带宽是100M,理论上两块网卡就是200M,三块就是300M,当然实际上的效果是不会是这样简单的增加的,不过经实际测试使用多个网卡对于增加带宽,保持带宽的稳定性肯定是有裨益的,如果交换机等相关条件不错的话,这个效果还是很能令人满意;其次,可以形成网卡冗余阵列、分担负载,双网卡被绑定成“一块网卡”之后,同步一起工作,对服务器的访问流量被均衡分担到两块网卡上,这样每块网卡的负载压力就小多了,抗并发访问的能力提高,保证了服务器访问的稳定和畅快,当其中一块发生故障的时候,另一块立刻接管全部负载,过程是无缝的,服务不会中断,直到维修人员到来。

文件名称:NICExpress4.0注册版文件大小:2.48 MB文件版本:4.0授权方式:注册版文件类型:RAR发布时间:2008-03-19注册码:3KHMJ-DW7BX-77XHM-DFCW3-J4GHW(企业版)注册码:381567(个人版)下载地址:本地下载这是最新版本4.0,只有2.5M,软件的兼容性已经做得很好,支持win98/Me/2000/XP/2003。

基本上支持目前市场上常见的各种网卡,百兆和千兆网卡都可以用来绑定,但是千万注意,最好用于绑定的网卡是完全相同的,至少也是基于同一芯片的,这样多块网卡才能合作得比较好。

切记不要把10M网卡和100M 网卡绑定在一起,那样根本起不到提升作用。

下载完软件,先不忙安装,咱们还是先准备好硬件。

第一部分:硬件安装虽然,理论上讲绑定越多网卡在一起,最终效果提升就越明显,但是考虑到复杂程度,这里就以绑定双网卡为例进行说明,如果读者觉得好玩,兴致很高的话,按照下面方法愿意绑定多少就绑定多少个网卡,其实一般同一台服务器,绑定2-3块网卡也就够了,太多了,据说因为链路聚合的先天缺点,会过多占用服务器资源,反过来会影响服务器速度(关于这个我没实验,不过我觉得凡事都离不开物极必反的道理,适度最好)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

提高服务器可用性的多网卡绑定聚合技术的应用

王和平

摘要:通过NICExpress软件对服务器多网卡进行捆绑聚合,以实现增加带宽、负载均衡、故障自动转移等,从而达到服务器的高可靠性和高可用性。

关键词:网卡聚合;服务器;高可用性

一、引言

现今几乎各行各业内部都建立了自己的服务器,由于服务器的特殊地位,它的可靠性、可用性及其I/O速度就显得非常的重要,保持服务器的高可用性和安全性是企业IT环境的重要指标,其中最重要的一点是服务器网络连接的高可用性。

本文通过NICExpress软件,通过实际部署服务器多网卡,以提高服务器网络连接的可用性,配合实现构建高可靠性的网络环境。

二、网卡聚合绑定的特点

网卡绑定聚合就是通过软件将多块网卡绑定为一个IP地址,使用起来就好象在使用一块网卡。

网卡是计算机和外部联系的主要通道。

个人计算机默认安装一块网卡,服务器基本配置应该安装两块网卡。

如果服务器上仅安装一块网卡,建议管理员至少增加一块网卡。

一块为主网卡,其他为备用网卡,然后再通过网线将对应的网卡连接到同一交换机上。

在服务器和交换机之间建立主连接和备用连接。

通过NICExpress虚拟网卡软件将多块网卡绑定为一块网卡,或称之为虚拟网卡组,然后为虚拟网卡组设置一个唯一的IP地址。

安装多块网卡后,通过多网卡并发方式传输数据,有利于提高网络传输效率,提高系统性能。

一旦网卡组中的任何一个物理连接断开,比如网卡出现故障或链路断开,系统软件将自动监测连接状态,出现故障的网卡将自动切换到其他网卡的物理连接上。

在服务器中部署多块网卡聚合绑定后,将具备如下特点:

1.增加带宽。

假如网卡的带宽100Mbps,那么理论上两块网卡聚合绑定后的带宽就是200Mbps,三块网卡聚合绑定后的带宽就是300Mbps。

当然实际上的效果是不会这样简单相加的,不过经实际测试使用多个网卡绑定对于增加带宽,保持带宽的稳定性肯定是有益的。

经过实际测量,三块带宽为100Mbps的网卡绑定后传输总带宽可以达到260Mbps。

2.均衡负载。

多块网卡聚合绑定,可以形成网卡冗余阵列、分担负载。

多块网卡被聚合绑定成“一块网卡”之后,网卡之间同步工作,对服务器的访问流量被均衡分配到不同网卡上,从而减轻每块网卡的网络负载,增强服务器的并发访问能力,服务器性能。

3.故障自动切换。

如果服务器中的任一网卡出现故障,那么其他网卡将自动接管全部负载,过程是无缝的,数据传输不会中断。

服务器中的系统服务或者应用不会中断,增强服务器的可用性。

三、网卡绑定聚合的原则

在服务器中部署多块网卡绑定聚合应该遵循以下原则:

1.聚合绑定的网卡型号应该相同、性能指标要一致,否则运行过程中不稳定,容易出错甚至蓝屏。

2.最大网卡数量原则。

绑定的网卡越多,总带宽的增加效果似乎就越明显;但其实还应该考虑到网卡绑定聚合后在运行过程中会过多占用服务器资源,反过来会在一定程度影响服务器的运行速度。

所以,管理员可以参考计算机配置和管理软件所支持的最大网卡数量。

3.所有的网卡建议连接到同一台交换机上。

四、部署过程

下面以NICExpress软件实际部署为例,说明多网卡的绑定聚合过程。

1.通过正常途径获取NICExpress软件,双击启动程序进行安装,出现如图1所示安装界面。

图1 安装界面

2.经过检测后,弹出“Welcome to NIC Express Enterprise Editon Setup”对话框,如图2所示。

图2“Welcome to NIC Express Enterprise Editon Setup”对话框

3.单击“Next”按钮,显示“License Agreement”对话框,如图3所示。

图3 “License Agreement”对话框

4.单击“Yes”按钮,显示“Setup Type”对话框,如图4所示。

对话框中提示是否开启“Loading Balancing”功能,即负载均衡功能。

也就是当多块网卡被绑定聚合之后,当数据流量很大的时候,软件会自动调整,将数据流量负载均衡地分配到各个网卡上,以减轻单块网卡的压力,达到流畅的访问效果。

绑定多网卡,其中目的之一就是为了实现负载均衡,自然要开启这个功能。

当然,如果在这里选择错了也没关系,部署完后还可以通过NICExpress 软件管理界面开启此功能。

此处选择“Enabled”单选按钮,启用负载均衡功能。

图4 “Setup Type”对话框

5.单击“Next”按钮,显示“Choose Destination Location”对话框,如图5所示。

选择安装的目标文件夹。

图5 “Choose Destination Location”对话框

6.单击“Next”按钮,显示“Select Programe Folder”对话框,如图6所示。

设置NICExpress虚拟网卡软件在程序文件夹中的名称,此处选择默认的“NICExpress”即可。

图6 “Select Programe Folder”对话框

7.单击“Next”按钮,开始文件复制进程,显示“Setup Status”对话框,如图7所示。

图7 “Setup Status”对话框

8.文件复制完后将显示“Thank you for trying NICExpress”对话框,可以单击“Demo”按钮,显示虚拟网卡属性设置对话框,如图8所示。

图8 虚拟网卡属性设置对话框

对话框中有3个编辑区域:

●“Available”列表框:表示已经安装在服务器中所有的网卡设备。

●虚拟网卡名称设置文本编辑框:可以在其中设置绑定后网卡的名称,此名称将在

服务器的网络连接窗口中显示。

本实例中设为“network1”。

●“Assigned Adapters”列表框:进行绑定的网卡名称列表。

9.选择“Available”列表中需要添加到聚合绑定到网卡组“network1”中的网卡设备,单击“Add”按钮。

如果所选择的网卡设备设置IP地址,显示“Add Adapter”对话框,提示是否用当前网卡的IP地址作为绑定后虚拟网卡的IP地址,如图9所示。

图9 询问是否用当前网卡的IP地址作为绑定后虚拟网卡的IP地址

10.被选择的网卡设备将加入到“Assigned Adapter”列表中,如图10所示。

如果选择的网卡出现错误,则可在“Assigned Adapter”列表中选择目标网卡,单击“Remove”按钮,被选择的网卡将退回到“Available”列表中。

图10 第一块网卡被绑定

11.当其他网卡添加完成后,网卡名称会出现在“Assigned Adapter”列表中。

单击“OK”按钮,出现“Informatipn”信息提示框,如图11所示。

图11 “Informatipn”信息提示框

12.单击“确定”按钮,显示“NIC Express Enterprise Edition Cofiguration Setting”对话框,如图12所示,使用默认值即可,单击“OK”按钮,显示“Setup Complete”对话框,如图13所示,单击“Finish”按钮。

图12 “NIC Express Enterprise Edition Cofiguration Setting”对话框

图13 “Setup Complete”对话框

当部署完多网卡绑定后,在“网络连接”窗口,可以看到多了一个网卡连接图标,多出来的一个图标就是“NICExpress Virtual Adapter”,也就是绑定后的网卡组,这个网卡组的使用和单一网卡完全一样。

可以为这个“虚拟网卡”设定IP地址、子网掩码、网关、DNS服务器IP地址等。

使用NICExpress绑定多网卡,在计算机网络应用非常广泛的当今具有一定的实际意义。

当我们为服务器绑定多网卡形成阵列之后,不仅可以扩大服务器的网络带宽,而且可以有效均衡负载和提高容错能力,避免服务器出现传输瓶颈或者因某块网卡故障而停止服务。

参考文献

[1]王春海王淑江网管经验谈[M].北京:电子工业出版社,2010.

[2]52CTO网站:

作者简介:王和平(1968-)男,汉族,副教授、高级工程师。

研究方向:计算机网络。