SVM分类器原理

(陈思园)SVM原理及应用

原理支持向量机是一种基于分类边界的方法,其基本原理是(以二维数据为例):如果训练数据分布在二维平面上的点,它们按照分类聚集在不同的区域。

基于分类边界的分类算法的目标是,通过训练,找到这些分类的之间的边界(直线的一一称为线性化分,曲线的一一称为非线性划分)。

对于多维数据可以将他们视为N维空间的点,而分类边界就是N维空间中的面称为超面(超面比N维少一维),线性分类器使用超平面类型的边界,非线性分类器使用超曲面。

SVM是一个由分类超平面定义的判别的分类器。

也就是说给定一组带标签的训练样本,算法将会输出一个最优超平面对测试样本进行分类。

当数据是非线性的时候,支持向量机将低维空间中的点映射到高维空间,使他们成为线性可分的再使用线性划分的原理来判断分类边界。

在高维空间中,它是一种线性可分的,而在原有的数据空间中,它是一种非线性划分。

应用利用Hog特征和SVM分类器进行行人检测:(1)准备训练样本集合;包括正样本集和负样本集;根据机器学习的基础知识我们知道,要利用机器学习算法进行样本训练,从而得到一个性能优良的分类器,训练样本应该是无限多的,而且训练样本应该覆盖实际应用过程中可能发生的各种情况。

(很多朋友,用10来个正样本,10来个负样本进行训练,之后,就进行测试,发现效果没有想象中的那么好,就开始发牢骚,抱怨。

对于这些人,我只能抱歉的说,对于机器学习、模式识别的认识,你还处于没有入门的阶段);实际应用过程中,训练样本不可能无限多,但无论如何,三五千个正样本,三五千个负样本,应该不是什么难事吧?(如果连这个都做不到,建议你别搞机器学习,模式识别了;训练素材都没有,怎么让机器学习到足够的信息呢?)(2)收集到足够的训练样本之后,你需要手动裁剪样本。

例如,你想用Hog+SVM来对商业步行街的监控画面中进行行人检测,那么,你就应该用收集到的训练样本集合,手动裁剪画面中的行人(可以写个简单程序,只需要鼠标框选一下,就将框选区域保存下来)。

支持向量机(SVM)原理详解

⽀持向量机(SVM)原理详解SVM简介 ⽀持向量机(support vector machines, SVM)是⼀种⼆分类模型,它的基本模型是定义在特征空间上的间隔最⼤的线性分类器,间隔最⼤使它有别于感知机;SVM还包括核技巧,这使它成为实质上的⾮线性分类器。

SVM的的学习策略就是间隔最⼤化,可形式化为⼀个求解凸⼆次规划的问题,也等价于正则化的合页损失函数的最⼩化问题。

SVM的的学习算法就是求解凸⼆次规划的最优化算法。

⼀、⽀持向量与超平⾯在了解svm算法之前,我们⾸先需要了解⼀下线性分类器这个概念。

⽐如给定⼀系列的数据样本,每个样本都有对应的⼀个标签。

为了使得描述更加直观,我们采⽤⼆维平⾯进⾏解释,⾼维空间原理也是⼀样。

举个简单⼦:如下图所⽰是⼀个⼆维平⾯,平⾯上有两类不同的数据,分别⽤圆圈和⽅块表⽰。

我们可以很简单地找到⼀条直线使得两类数据正好能够完全分开。

但是能将据点完全划开直线不⽌⼀条,那么在如此众多的直线中我们应该选择哪⼀条呢?从直观感觉上看图中的⼏条直线,是不是要更好⼀些呢?是的,我们就是希望寻找到这样的直线,使得距离这条直线最近的点到这条直线的距离最短。

这读起来有些拗⼝,我们从如下右图直观来解释这⼀句话就是要求的两条外⾯的线之间的间隔最⼤。

这是可以理解的,因为假如数据样本是随机出现的,那么这样分割之后数据点落⼊到其类别⼀侧的概率越⾼那么最终预测的准确率也会越⾼。

在⾼维空间中这样的直线称之为超平⾯,因为当维数⼤于三的时候我们已经⽆法想象出这个平⾯的具体样⼦。

那些距离这个超平⾯最近的点就是所谓⽀持向量,实际上如果确定了⽀持向量也就确定了这个超平⾯,找到这些⽀持向量之后其他样本就不会起作⽤了。

⼆、SVM算法原理 2.1 点到超平⾯的距离公式既然这样的直线是存在的,那么我们怎样寻找出这样的直线呢?与⼆维空间类似,超平⾯的⽅程也可以写成⼀下形式:(1) 有了超平⾯的表达式之后之后,我们就可以计算样本点到平⾯的距离了。

SVM的原理和代码实现

SVM的原理和代码实现SVM(Support Vector Machine,支持向量机)是一种常用的机器学习算法,用于二分类和回归问题。

SVM的核心思想是找到一个最优的超平面,将不同类别的数据样本分开。

这个超平面由支持向量(样本)确定,使得支持向量到超平面的距离最大化。

本文将介绍SVM的原理及其代码实现。

一、SVM原理:1.线性可分情况:对于线性可分的数据集,SVM的目标是找到一个超平面,使得所有正例样本都位于超平面的一侧,负例样本都位于另一侧。

超平面的方程可以表示为:w^T*x+b=0,其中w是一个向量,表示法向量,b是偏置。

2.间隔最大化:SVM的关键是最大化两个不同类别样本之间的几何间隔。

间隔是沿着超平面的宽度,因此离分类超平面最近的实例点,即两个最靠近超平面的支持向量(x1和x2),满足w^T*x1+b=1和w^T*x2+b=-1、它们满足w^T*(x1-x2)=2/(,w,)。

因此,SVM的优化问题转化为求解最大化2/(,w,)的最小化问题。

也就是求解以下优化问题:minimize ,w,^2/2,其中y_i*(w^T*x_i + b) >= 13.引入松弛变量:当数据不是完全线性可分时,引入松弛变量xi,使得一些样本可以处于错误的一侧。

此时优化问题转化为:minimize ,w,^2/2 + C*Σξ_i,其中y_i*(w^T*x_i + b) >= 1 - ξ_i,ξ_i >= 0。

C是一个超参数,用于控制错误样本的惩罚程度。

当C越大,对错误样本的惩罚越重;C越小,则对错误样本的惩罚越轻。

4.对偶问题:为了方便求解SVM的优化问题,引入拉格朗日乘子,将SVM的原始问题转化为对偶问题。

通过求解对偶问题,可以得到最优解。

对偶问题如下:maximize Σα_i - 1/2*ΣΣ α_i*α_j*y_i*y_j*x_i*x_j,其中Σα_i*y_i = 0,0 <= α_i <= C。

数据分析知识:数据挖掘中的SVM分类器

数据分析知识:数据挖掘中的SVM分类器数据挖掘中SVM分类器SVM(Support Vector Machines)分类器是一种在数据挖掘中广泛应用的机器学习算法。

SVM最早是由Vapnik和Cortes在1995年提出的,SVM分类器在处理分类问题和回归问题中,具有良好的表现和精度。

1. SVM分类器的概述SVM分类器是一种基于特征空间中的最优超平面来完成分类的算法。

最优超平面是在特征空间中将不同类别的数据分开的超平面,具有良好的分类性能。

如图1所示,在二维空间中,最优超平面可以看作分开两个类别的直线,而在多维空间中,最优超平面可以看作分开多个类别的超平面。

图1 SVM分类器最优超平面2. SVM分类器的原理SVM分类器的原理是将样本映射到高维空间中,并在该空间内寻找最优超平面,从而实现数据分类。

在二维空间中,分类器可以找到一条直线来分开两个类别的数据,但是在高维空间中,不同的数据可能更加复杂,无法直接通过一条直线来分开。

因此,SVM分类器采用了核函数来将低维数据映射到高维空间,以便在高维空间中进行分类。

核函数是将低维空间中的数据映射到高维空间的函数,使得在高维空间中数据更容易分开。

常见的核函数有线性核函数、多项式核函数、径向基核函数等。

对于一个SVM分类器,其优化目标是找到一个最优超平面,使得该平面能够最大限度地将不同类别的数据分开,并且最小化分类错误率。

通常而言,SVM分类器采用硬间隔与软间隔的方法来找到最优超平面。

硬间隔指的是要求找到的超平面能够完全将训练数据分开,但是当训练数据过于复杂或者存在噪声时,该方法可能会出现过度拟合的情况。

软间隔则通过引入松弛变量来解决过度拟合问题,使得在一定程度上能够容忍一些分类错误。

3. SVM分类器的应用SVM分类器在数据挖掘中有广泛的应用。

例如,在图像识别中,SVM分类器可以识别特定的物体,比如人脸、汽车、动物等。

在文本分类中,SVM分类器可以对文本进行自动分类,实现新闻分类、垃圾邮件过滤、情感分析等功能。

简述svm算法原理

简述svm算法原理支持向量机(SupportVectorMachine,简称SVM)是一种基于统计学习理论的监督式二分类学习算法,它的主要思想是找到一个把两类数据最好的分隔开的虚拟分离超平面,超平面的选择由它们之间的最大距离来决定。

其基本原理类似于最小二乘,但它比最小二乘更强大,因为它可以处理非线性特征。

SVM算法的主要思想是构建一个模型,使其能以最大化距离的形式正确分类每一个样本。

按照这种思想,SVM算法采用几何学的碰撞检查和数学优化技术构建一个超平面,使其能够满足将样本点正确地分开的需求。

超平面的构建是基于极限状态的,一旦超平面被构建出来,就可以使用其分类新的样本点,而不需要再重新构建超平面。

SVM模型由特征空间,超平面,支持向量,间隔等几个部分组成。

特征空间是一个n维空间,n维空间中的每一个点对应一个实例,每一个实例对应一个类别。

超平面是将两个类别的实例分开的一维虚拟分类器。

超平面的构建是基于极限状态的,一旦超平面被构建出来,就可以使用其分类新的样本点,而不需要再重新构建超平面。

支持向量是超平面与每一个类别实例之间的最小距离,它是SVM算法的核心。

隔是超平面与最近实例之间的最大距离,它决定了超平面的准确性。

SVM算法是通过求解一类凸二次规划来构建超平面的,这个规划的求解可以通过一种名为拉格朗日乘子法来实现。

拉格朗日乘子法首先把规划转化为一个凸二次规划来求解,然后就可以使用最优化技术来解决。

求解凸二次规划的最终结果就是构建出最佳超平面,该超平面最大化了分类的准确率,同时也最大化了超平面与最近实例之间的距离。

SVM算法的优点在于强大的分类能力,它可以处理简单的线性分类,也可以处理复杂的非线性分类,更重要的是,它可以将原本分散的不同类别投射到一个高维空间中,因而能够很好地提高性能和提高准确率。

总之,支持向量机(SVM)是一种基于统计学习理论的监督式二分类学习算法,其主要思想是找到一个把两类数据最好的分隔开的虚拟分离超平面,超平面由支持向量决定,支持向量是超平面与每一个类别实例之间的最小距离,而间隔是超平面与最近实例之间的最大距离,即超平面与支持向量之间的距离。

SVM算法原理及SMO算法概述

SVM算法原理及SMO算法概述SVM (Support Vector Machine) 是一种广泛应用于分类和回归问题的机器学习算法。

它基于统计学习理论中的VC理论,使用间隔最大化的方法进行分类。

在SVM中,我们将训练数据集视为一个在高维空间中的点集。

SVM的目标是找到一个超平面,能够将不同类别的点分开,并且使其离超平面的距离最大化。

这个超平面被称为最优分隔超平面。

具体来说,SVM算法的原理如下:1.数据预处理:将训练样本映射到高维特征空间,使得样本点能够被线性分隔。

2.寻找最优超平面:在高维特征空间中,寻找能够将不同类别的点分开的超平面。

通常情况下,有多个超平面可以进行分类,而SVM的目标是找到使得间隔最大化的那个超平面。

3.使用支持向量进行分类:SVM找到了最优超平面后,它会选择离该超平面最近的一些点,这些点被称为支持向量。

分类时,SVM根据测试点和支持向量的关系进行判断。

SMO (Sequential Minimal Optimization) 是一种用来训练SVM的优化算法。

传统的SVM算法需要同时优化所有的模型参数,计算量较大。

而SMO算法则是一种序列化的简化方法,每次只优化两个模型参数。

SMO算法的主要思想如下:1.初始化模型参数:选择两个待优化的参数α1和α22.选择两个参数:基于一定的策略,选择两个不同的参数α进行优化。

3.通过求解两个参数的约束最优化问题,更新模型参数。

4.更新阈值和偏置:根据更新后的模型参数,计算出新的阈值和偏置。

5.判断终止条件:检查是否满足终止条件,如果满足则停止优化,否则返回第2步。

SMO算法的核心在于选择两个参数进行优化,并通过解决约束最优化问题来更新参数。

通过反复迭代这个过程,最终得到训练好的SVM模型。

SMO算法的优点是可以有效地处理大规模数据集,并且能够避免陷入局部最优解。

同时,SMO算法还可以引入核函数,使得SVM具有非线性分类和回归能力。

总结来说,SVM是一种基于统计学习理论的分类和回归算法,通过间隔最大化的方法寻找最优分隔超平面。

SVM原理简介

SVM原理简介SVM是我在做模式识别的时候⽤得最多的⼀种分类器。

以下是我通过学习后对SVM原理的理解与总结,记录下来以便⾃⼰复习。

1、SVM原理概述SVM是从线性可分情况下的最优分类⾯发展⽽来的,图⼀中三⾓形点和圆形点分别代表两类样本,假设:,i=1,...,n,我们要寻找⼀个分类超平⾯H:,使得:假设分别为过各类中离分类超平⾯最近的样本并且平⾏于分类超平⾯的超平⾯,它们之间的距离叫做分类间隔。

最优分类超平⾯要求不但能把两类样本正确分开,⽽且要求分类间隔最⼤。

易知分类间隔为2/||W||,使分类间隔最⼤,等价于与使||W||最⼩。

所以求最优分类超平⾯求解下例问题:H1,H2上的训练样本点就称作⽀持向量。

图⼀利⽤Lagrange优化⽅法可以把上述最优分类⾯问题转化为其对偶问题:其中αi为与每个样本对应的Lagrange乘⼦,容易证明解中有⼀部分(通常是少部分),若αi不为零,对应的样本就是⽀持向量。

解上述问题后得到的最优分类函数是:在线性不可分的情况下,可以增加⼀个松弛项,使求解最优分类超平⾯变为下述问题:即折衷考虑最少分错样本与最⼤分类间隔,得到⼴义最优分类超平⾯,其中C为惩罚系数。

对应的对偶问题变为:对于⾮线性问题,可以通过⾮线性变换转化为某个⾼维空间中的线性问题,在变换空间求解最优分类⾯。

在最优分类⾯中采⽤适当的内积函数K(x i,x j)就可以实现某⼀⾮线性变换后的线性分类:分类函数变为:这就是⽀持向量机。

总结起来,SVM的基本思想如图⼆所⽰:图⼆2、核函数⽬前研究最多的核函数主要有四类:通常来讲,RBF核函数可以作为⼀个SVM模型的最佳选择。

RBF核通过⾮线性映射将样本映射到⼀个⾼维空间中,因此,相较于线性核函数,它能很好地处理类别标签与属性之间为⾮线性关系的情况。

⽽且,线性核可以看做RBF核的⼀种特殊情况,在某些参数下,线性核具有与RBF核相同的表现。

另外,研究显⽰sigmoid核在某些参数下也与RBF核具有相同表现。

svm分类原理

svm分类原理支持向量机(SVM)分类是机器学习技术中最重要的算法之一。

它是简单、高效、易于使用的算法,它可以处理多种分类问题,并可用于实现非线性分类。

支持向量机是一种旨在求解两类分类问题的经典机器学习算法,它具有极高的分类准确率、低计算量、良好的泛化能力等优势。

SVM分类可以高效地解决复杂的二元分类问题,并可应用于多种分类问题。

SVM分类原理是:计算一个能够区分多种数据的超平面。

超平面是一种虚拟的概念,它可以把输入数据分为两组,即正例和反例。

超平面的间隔是用距离来衡量的,这样可以使得超平面的偏差尽可能的小,从而得到最优的分类结果。

SVM分类从样本空间中找到一条超平面,使得两类样本尽可能更远,这条超平面称为最大间隔超平面(Support Vector)。

在最大间隔超平面两侧的样本点被称之为支持向量(Support Vector),可以用来计算超平面的法向量并定义最大间隔超平面。

在训练中,SVM使用支持向量的信息来构建一个超平面,它可以有效地分类各种形状的数据集。

这种分类方法是通过求解一个凸二次规划问题,应用拉格朗日乘子法(Lagrange Multiplier Method)来找到指定间隔的最大值。

SVM分类也可以被用来求解非线性分类问题。

这种方法把同一类别的训练样本映射到一个更高维度空间中,最终得到一个非线性的超平面,从而实现对非线性分类问题的解决。

另外,SVM分类也可以用于多类分类任务。

它的原理是:先用它来分类一组单类数据,然后重复这个过程,直到分类完成。

这种方法可以有效地求解多类分类问题,因为它可以准确地分类训练数据中的各类元素。

总之,SVM分类是一种有效而简单的机器学习算法,准确率高,速度快,计算量小,并且具有良好的泛化能力,可以有效地实现对非线性分类问题和多类分类问题的求解。

svm 原理

svm 原理

SVM(支持向量机)是一种用于分类和回归分析的机器学习方法,其基本原理是寻找一个最优的超平面(在二维情况下是一条直线,多维情况下是一个高维平面),将不同类别的样本点有效地分开。

其思想是将样本点映射到高维空间中,使得样本点在高维空间中可以线性可分。

SVM的目标是找到一个最优的超平面,使得最靠近超平面的

样本点到该超平面的距离最大。

这些最靠近超平面的样本点被称为支持向量,因为它们对于决策超平面的位置起到了关键作用。

SVM通过最大化支持向量到决策边界的间隔,使得分类

边界更加稳健。

在学习阶段,SVM通过构建一个约束最优化问题来寻找最优

的超平面。

这个问题的目标是最小化模型误差和最大化间隔。

其中,模型误差基于不同类别样本点到超平面的距离计算,间隔则是支持向量到超平面的距离。

通过求解这个优化问题,可以得到一个优秀的分类超平面。

SVM的优点是可以处理高维度的数据和非线性的决策边界。

它在解决小样本、非线性和高维度的分类问题上表现出色。

然而,SVM也有一些缺点,例如对于大规模数据集的训练需要

较长的时间,并且对于噪声和异常值比较敏感。

总结来说,SVM基于找到一个最优的超平面,通过最大化支

持向量到决策边界的间隔来实现分类。

它是一种非常强大的机器学习方法,在不同领域的分类和回归问题中都有广泛的应用。

svm分类器的原理及应用

SVM分类器的原理及应用1. SVM(Support Vector Machine)分类器的原理SVM是一种常用的机器学习算法,用于分类和回归分析。

它基于统计学习理论中的结构风险最小化原理,通过寻找一个最优超平面,将不同类别的样本分开。

SVM的原理可以简要概括为以下几个关键步骤:1.1 特征空间映射SVM通过将原始数据映射到高维空间,使得数据在新的空间中可以更容易地被线性分隔开来。

这个过程称为特征空间的映射,可以使用核函数来实现。

1.2 构建最优超平面在高维空间中,SVM通过构建一个最优超平面来实现分类。

最优超平面可以使两个不同类别的样本之间的间隔最大化,从而达到最好的分类效果。

1.3 支持向量选择在构建最优超平面的过程中,SVM会选择一些样本作为支持向量,这些样本与最优超平面的距离最近,对最优超平面的确定有重要的影响。

1.4 分类决策函数最后,基于最优超平面和支持向量,SVM可以构建一个分类决策函数,用于对新的样本进行分类。

2. SVM分类器的应用SVM分类器具有广泛的应用领域,以下是一些常见的应用场景:2.1 文本分类SVM可用于对文本进行分类,例如将一篇文章分类为新闻、体育等不同的类别。

通过提取文本的特征,如词频、TF-IDF等,可以将文本转换为向量表示,然后使用SVM对向量进行分类。

2.2 图像识别图像识别是另一个SVM常用的应用领域。

通过将图像转换为特征向量,如颜色直方图、纹理特征等,然后使用SVM对特征向量进行分类,可以实现图像的自动识别和分类。

2.3 生物信息学在生物信息学领域,SVM可用于基因表达数据的分类和预测。

通过分析基因表达模式,可以使用SVM对不同的基因进行分类,从而帮助科学家更好地理解基因功能和研究疾病的发病机理。

2.4 金融风控SVM在金融风控领域也有广泛的应用。

通过分析客户的行为数据、信用数据等,可以建立一个SVM分类模型,用于预测客户的信用风险,从而帮助银行和金融机构做出准确的风险评估和决策。

svm分类器的基本原理

svm分类器的基本原理SVM分类器的基本原理SVM(Support Vector Machine,支持向量机)是一种常见的机器学习算法,被广泛应用于分类和回归问题中。

它的基本原理是通过寻找一个最优超平面来将不同类别的数据分开。

在本文中,我们将详细介绍SVM分类器的基本原理和工作流程。

我们需要了解什么是超平面。

在二维空间中,超平面可以简单地理解为一条直线,它可以将两类数据分隔开。

而在更高维度的空间中,超平面可以是一个超平面或者一个超曲面,其维度取决于数据的特征数量。

SVM的目标是找到一个最优超平面,使得两个不同类别的数据点到该超平面的距离最大化。

这个最大间隔被称为“间隔”。

SVM试图找到一个最优分类器,使得在该分类器下,所有的样本点都能够落在正确的一侧,并且最大化分类器的间隔。

在SVM中,支持向量是距离超平面最近的那些点。

这些点对于定义超平面是至关重要的,因为它们决定了超平面的位置和方向。

SVM分类器的目标是最大化间隔,因此只有支持向量对最终的分类结果起作用。

SVM分类器的工作流程可以分为以下几个步骤:1. 数据预处理:首先,我们需要对原始数据进行预处理,包括数据清洗、特征选择和特征缩放等。

这些步骤有助于提取有效的特征并减少噪声的影响。

2. 特征转换:在某些情况下,原始数据可能无法直接用于SVM分类器。

因此,我们需要将数据转换为合适的形式。

常用的方法包括多项式特征转换和核函数转换等。

3. 寻找最优超平面:在得到合适的数据表示后,我们需要通过优化算法来寻找最优超平面。

这通常涉及到求解一个凸优化问题,可以使用数值优化方法如梯度下降等。

4. 模型评估:在得到最优超平面后,我们需要对模型进行评估,以确定其性能。

常用的评估指标包括准确率、召回率、F1值等。

虽然SVM分类器的基本原理相对简单,但在实际应用中,还存在一些挑战和改进空间。

例如,当数据不是线性可分时,我们可以使用核函数将数据映射到高维空间,从而实现非线性分类。

svm 原理

svm 原理支持向量机(Support Vector Machine,简称SVM)是一种二分类模型,它的基本模型是定义在特征空间上的间隔最大的线性分类器。

SVM的基本原理是找到一个超平面,使得离该平面最近的样本点到该平面的距离尽可能远,从而实现对样本的最优分类。

在SVM中,我们首先要了解的是什么是支持向量。

支持向量是指离超平面最近的那些点,这些点在SVM中起着决定性作用。

因为超平面是由支持向量完全决定的,所以SVM的训练过程可以看作是求解支持向量的过程。

SVM的原理可以通过以下几个关键步骤来解释:1. 构建超平面,在SVM中,我们的目标是找到一个超平面,可以将不同类别的样本点分开。

这个超平面可以用一个线性方程来表示,即wx + b = 0,其中w是法向量,b是位移项,x是样本点的特征向量。

通过不断调整w和b的数值,我们可以找到一个最优的超平面,使得不同类别的样本点能够被最大化地分开。

2. 最大间隔,在构建超平面的过程中,SVM的目标是找到一个最大间隔超平面,即使得支持向量到超平面的距离最大化。

这样做的好处是可以使得模型对噪声数据具有很强的鲁棒性,同时也可以提高模型的泛化能力。

3. 引入核函数,在实际应用中,很多样本点并不是线性可分的,这时我们就需要引入核函数来将样本点映射到高维空间中,从而使得样本点在高维空间中线性可分。

常用的核函数有线性核、多项式核、高斯核等,通过选择不同的核函数,可以使得SVM模型适用于不同的数据集。

4. 求解最优化问题,在SVM中,我们需要求解一个凸优化问题来得到最优的超平面。

这个问题可以通过拉格朗日乘子法来进行求解,最终得到超平面的法向量w和位移项b。

总的来说,SVM的原理是基于最大间隔超平面的构建,通过求解最优化问题来得到最优的超平面参数,从而实现对样本的最优分类。

同时,通过引入核函数,SVM可以处理非线性可分的数据集,具有很强的泛化能力和鲁棒性。

在实际应用中,SVM作为一种强大的分类器被广泛应用于文本分类、图像识别、生物信息学等领域,取得了很好的效果。

svm向量机原理

svm向量机原理

SVM(支持向量机)是一种机器学习算法,主要用于分类问题。

SVM的原理基于线性可分和间隔最大化的思想,通过寻找一个超平面(在二维空间中就是一条直线)来将不同类别的数据分开。

这个超平

面被选择为可以最大程度地将不同类别的数据点分开,这就是所谓的

间隔最大化。

在介绍SVM原理之前,需要先了解一些相关概念。

首先是支持向量,指的是距离超平面最近的点。

其次是决策边界,就是超平面本身。

还有就是核函数,也就是把低维空间中的向量映射到高维空间中的函数,这个函数可以将低维空间无法分开的数据点分开。

SVM的训练过程可以简单概括为以下几个步骤:

1. 首先选取数据点中的一些作为支持向量,这些支持向量的特

点是距离超平面最近且最难分离。

2. 通过优化算法寻找最大间隔超平面,使得超平面与所有支持

向量之间的距离最大,同时确保所有数据点都被正确分类。

3. 如果数据是线性不可分的,则采用核函数将数据点映射到高

维空间,从而实现线性可分。

4. 训练完成后,将新数据点映射到超平面上,如果新数据点位

于超平面正面则判定为一类,如果位于超平面负面则判定为另一类。

由于SVM需要找到最大间隔超平面,因此它对数据的分割具有很

好的泛化能力,能够很好地处理高维数据。

但它也存在一些问题,如

对噪声和异常值敏感、复杂度较高等。

因此需要在实际应用中根据具

体情况进行合理选择和优化。

SVM分类器原理

SVM分类器原理支持向量机(Support Vector Machine,SVM)是一种常用的监督学习算法,主要用于二分类问题,但也可以扩展到多类别分类问题上。

SVM的目的是在数据集中找到一个超平面,将不同类别的样本分开,并且使得该超平面距离最近的样本点的距离最大化。

SVM的原理可以从线性可分和线性不可分两个方面进行阐述。

对于线性可分的情况,SVM的目标是找到一个超平面,使得所有训练样本点都满足以下约束条件:对于正类样本x,有w·x+b≥1;对于负类样本x,有w·x+b≤-1,其中w是超平面的法向量,b是偏置项。

这样的超平面可以确保所有样本点都能被正确分类,并且尽可能地远离超平面。

为了找到最优的超平面,我们可以最大化间隔(margin),即样本点到超平面的距离。

换句话说,我们要找出使得w权重最小时,满足上述约束条件的超平面。

在实际应用中,线性可分数据很少见,大多数情况下,样本点不可避免地要有一些噪声和重叠。

为了处理线性不可分的情况,SVM引入了软间隔(soft margin)的概念。

软间隔允许一些样本点出现在超平面的错误一侧,但是希望错误的样本点尽量少。

为了平衡间隔的大小和错误的数量,SVM引入了一个惩罚系数C,用于调节噪声点和间隔之间的权衡。

当C很大时,模型会更注重于减少分类错误;当C较小时,它更注重于使间隔尽可能大。

当数据不是线性可分的时候,SVM可以使用核函数(kernel function)将数据从原始特征空间映射到一个高维的特征空间中。

在高维空间中,数据可能更容易被线性分割。

常见的核函数有线性核、多项式核和径向基函数(RBF)核。

这个过程被称为核技巧(kernel trick),通过它,SVM可以处理非线性分类问题。

SVM的优点包括:1)在高维空间中进行分类,具有较好的泛化能力;2)只需少量支持向量参与训练,大大减少了内存消耗;3)对于小样本和高维文本数据处理效果较好。

SVM分类器原理

SVM分类器原理SVM定义⏹SVM是一种基于统计学习理论的机器学习方法,它是由Boser,Guyon, Vapnik在COLT-92上首次提出,从此迅速发展起来。

⏹Vapnik V N. 1995. The Nature of Statistical Learning Theory. Springer-Verlag, New York.⏹Vapnik V N. 1998. Statistical Learning Theory. Wiley-Interscience Publication, JohnWiley&Sons, Inc.⏹SVM在解决小样本、非线性及高维模式识别问题中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中.目前已经在许多智能信息获取与处理领域都取得了成功的应用。

SVM方法的特点⏹SVM 的最终决策函数只由少数的支持向量所确定,计算的复杂性取决于支持向量的数目,而不是样本空间的维数,这在某种意义上避免了“维数灾难”。

⏹少数支持向量决定了最终结果,这不但可以帮助我们抓住关键样本、“剔除”大量冗余样本,而且注定了该方法不但算法简单,而且具有较好的“鲁棒”性。

这种“鲁棒”性主要体现在:❑①增、删非支持向量样本对模型没有影响;❑②支持向量样本集具有一定的鲁棒性;❑③有些成功的应用中,SVM 方法对核的选取不敏感。

SVM 应用⏹近年来SVM 方法已经在图像识别、信号处理和基因图谱识别等方面得到了成功的应用,显示了它的优势。

⏹SVM 通过核函数实现到高维空间的非线性映射,所以适合于解决本质上非线性的分类、回归和密度函数估计等问题。

⏹支持向量方法也为样本分析、因子筛选、信息压缩、知识挖掘和数据修复等提供了新工具。

SVM训练算法⏹传统的利用标准二次型优化技术解决对偶问题的方法,是SVM训练算法慢及受到训练样本集规模制约的主要原因。

⏹目前已提出了许多解决方法和改进算法,主要是从如何处理大规模样本集的训练问题、提高训练算法收敛速度等方面改进。

svm 朴素贝叶斯 lda 分类

标题:SVM、朴素贝叶斯和LDA在分类中的应用一、SVM分类算法的原理及应用1. SVM分类算法原理支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,其基本原理是找到将数据进行线性分类的最佳超平面。

SVM分类算法的核心思想是将数据映射到高维空间,通过构建最大间隔超平面来进行分类,从而实现数据的有效分离。

2. SVM分类算法的应用SVM分类算法在文本分类、图像识别、生物信息学等领域有着广泛的应用。

在文本分类中,SVM可以通过特征向量对文本进行分类,提高分类的准确度。

在图像识别领域,SVM可以对图像进行二分类或多分类,识别图像中的物体或场景。

SVM还被广泛应用于生物信息学领域,用于基因序列分类、蛋白质结构预测等任务。

二、朴素贝叶斯分类算法的原理及应用1. 朴素贝叶斯分类算法原理朴素贝叶斯分类算法是基于贝叶斯定理和特征条件独立性假设的一种分类算法。

朴素贝叶斯分类算法通过学习样本数据中的特征和类别之间的关系,从而对未知样本进行分类。

其基本思想是通过已知的样本特征和类别信息来估计未知样本的类别概率,从而进行分类。

2. 朴素贝叶斯分类算法的应用朴素贝叶斯分类算法在文本分类、垃圾邮件过滤、情感分析等领域有着广泛的应用。

在文本分类中,朴素贝叶斯可以通过文档中的词频或词袋模型进行分类。

在垃圾邮件过滤领域,朴素贝叶斯可以通过邮件中的特征词来判断邮件是否为垃圾邮件。

朴素贝叶斯也被用于情感分析,可以通过文本中的情感特征对文本进行情感分类。

三、LDA分类算法的原理及应用1. LDA分类算法原理潜在狄利克雷分配(Latent Dirichlet Allocation,LDA)是一种基于概率图模型的文本分类算法,其基本原理是通过对文本主题的建模来实现文本的分类。

LDA分类算法通过对文本中的主题分布进行推断,从而实现对文本进行分类。

其核心思想是通过狄利克雷分布对文本的主题分布进行建模,从而找到文本中隐藏的主题信息。

svm分类器原理

svm分类器原理1、数据分类算法基本原理数据分类是数据挖掘中的一个重要题目。

数据分类是指在已有分类的训练数据的基础上,根据某种原理,经过训练形成一个分类器;然后使用分类器判断没有分类的数据的类别。

注意,数据都是以向量形式出现的,如<0.4, 0.123,0.323,…>。

支持向量机是一种基于分类边界的方法。

其基本原理是(以二维数据为例):如果训练数据分布在二维平面上的点,它们按照其分类聚集在不同的区域。

基于分类边界的分类算法的目标是,通过训练,找到这些分类之间的边界(直线的――称为线性划分,曲线的――称为非线性划分)。

对于多维数据(如N维),可以将它们视为N维空间中的点,而分类边界就是N维空间中的面,称为超面(超面比N维空间少一维)。

线性分类器使用超平面类型的边界,非线性分类器使用超曲面。

线性划分如下图:可以根据新的数据相对于分类边界的位置来判断其分类。

注意,我们一般首先讨论二分类问题,然后再拓展到多分类问题。

以下主要介绍二分类问题。

2、支持向量机分类的基本原理支持向量机是基于线性划分的。

但是可以想象,并非所有数据都可以线性划分。

如二维空间中的两个类别的点可能需要一条曲线来划分它们的边界。

支持向量机的原理是将低维空间中的点映射到高维空间中,使它们成为线性可分的。

再使用线性划分的原理来判断分类边界。

在高维空间中,它是一种线性划分,而在原有的数据空间中,它是一种非线性划分。

但是讨论支持向量机的算法时,并不是讨论如何定义低维到高维空间的映射算法(该算法隐含在其“核函数”中),而是从最优化问题(寻找某个目标的最优解)的角度来考虑的。

3、最优化问题我们解决一个问题时,如果将该问题表示为一个函数f(x),最优化问题就是求该函数的极小值。

通过高等数学知识可以知道,如果该函数连续可导,就可以通过求导,计算导数,0的点,来求出其极值。

但现实问题中,如果f(x)不是连续可导的,就不能用这种方法了。

最优化问题就是讨论这种情况。

支持向量分类机原理

(“w间x隔)”为b0

2

|| w ||

极大化“间隔”的思想导致求解下列对变量 和 的最优化问题

w

说明:只m 要i我n们求得该问1 题的||最w 优||解2, ,从而构造分划

超平面 w ,b

2 ,求出决策函数

。

上述方法s.对t.一般 上的分yi类(问(w 题也x 适i)用 . b)1,i1, ,l

b

原始问题

l

b*yj yiai((xi)(xj)) i1

f(x)sgn((w*(x))b*)

或

l

f(x)sgn( yiai((xi)(x))b*) i1

支持向量分类机原理

为此,引进函数

K(xi,xj) ((xixj)1)2

有 K(xi,xj)(([xi]1[xj]1[xi]2[xj]21)2

[xi]1 2[xj]1 2[xi]2 2[xj]2 212[xi]1[xj]1[xi]2[xj]2

i

支持向量分类机原理

不要求所有训练点都满足约束条件

,为此 yi wxib 1

对第 个训练点

引入松弛变量(Slack Variable)

,

i 把约束条件放松到

xi, yi 。

i 0

yi wxi bi1(即“软化” 约束条件)

, 体现了T训练集被错分的情况,可采用 作

1

l

l

i

是输入指标向量,或称输入,或称模式,其分

l

T { ( x ,y ) , ,( x ,y ) } ( x y ) 量称为特征,或属性,或输1 入指1 标;

ll

是输出指n标,或输出.

x xR 问题:对一个新的i 模式 ,推断它所对应的输出 是1还是-1.

SVM分类原理

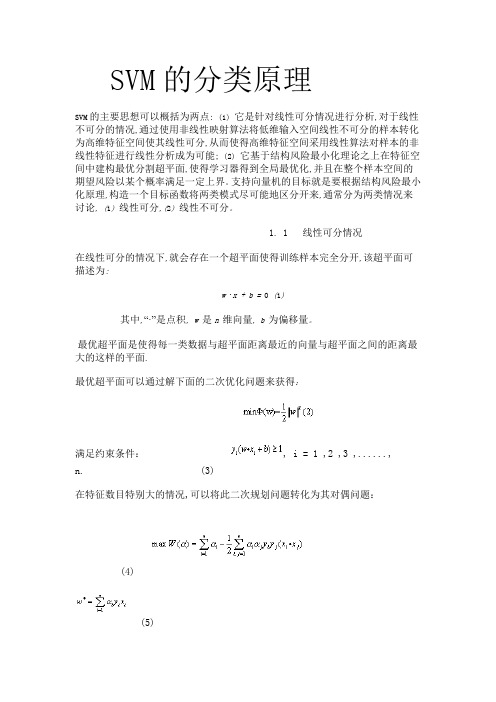

SVM的分类原理SVM的主要思想可以概括为两点: (1) 它是针对线性可分情况进行分析,对于线性不可分的情况,通过使用非线性映射算法将低维输入空间线性不可分的样本转化为高维特征空间使其线性可分,从而使得高维特征空间采用线性算法对样本的非线性特征进行线性分析成为可能; (2) 它基于结构风险最小化理论之上在特征空间中建构最优分割超平面,使得学习器得到全局最优化,并且在整个样本空间的期望风险以某个概率满足一定上界。

支持向量机的目标就是要根据结构风险最小化原理,构造一个目标函数将两类模式尽可能地区分开来,通常分为两类情况来讨论, (1) 线性可分,(2) 线性不可分。

1. 1 线性可分情况在线性可分的情况下,就会存在一个超平面使得训练样本完全分开,该超平面可描述为:w ·x + b = 0 (1)其中,“·”是点积, w 是n 维向量, b 为偏移量。

最优超平面是使得每一类数据与超平面距离最近的向量与超平面之间的距离最大的这样的平面.最优超平面可以通过解下面的二次优化问题来获得:满足约束条件:, i = 1 ,2 ,3 ,......,n. (3)在特征数目特别大的情况,可以将此二次规划问题转化为其对偶问题:(4)(5)(6)满足约束条件:(7)这里是Lagrange 乘子, 是最优超平面的法向量, 是最优超平面的偏移量,在这类优化问题的求解与分析中, KKT条件将起到很重要的作用,在(7) 式中,其解必须满足:(8)从式(5) 可知,那些 = 0 的样本对分类没有任何作用,只有那些 > 0 的样本才对分类起作用,这些样本称为支持向量,故最终的分类函数为:(9)根据f ( x) 的符号来确定X 的归属。

1. 2 线性不可分的情况对于线性不可分的情况,可以把样本X 映射到一个高维特征空间H,并在此空间中运用原空间的函数来实现内积运算,这样将非线性问题转换成另一空间的线性问题来获得一个样本的归属. 根据泛函的有关理论,只要一种核函数满足Mercer 条件,它就对应某一空间中的内积,因此只要在最优分类面上采用适当的内积函数就可以实现这种线性不可分的分类问题. 此时的目标函数为:(10)其相应的分类函数为: (11)1. 3 内积核函数目前有三类用的较多的内积核函数:第一类是(12)我们所能得到的是p阶多项式分类器,第二类是径向基函数(RBF),也称作高斯核函数:第三类是Sigmoid函数:这时SVM实现的就是包含一个隐层感知器,隐层结点数是由算法自动确定的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

追求卓越

“高性能机电传动技术及应用”团队

•4

超越自我

重庆理工大学

ChongQing University of Technology

模式识别基本概念:

模式类:一个模式类是由一个或多个特征组成。对给定的M个模式类 s1,s2,s3,· · · ,sm. 模式矢量:模式矢量x中,各分量的内容取决于用来描述物理上实际模式的 测量技术。在模式空间,一个模式矢量对应其中的一个点。 x=[x1,x2,•••,xn]T 决策函数:对应每个模式类,求出相应的判别函数。

得到结果:

w

N

t x

i 1 i i i i

N

i

t

i 1

0

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

支持向量机实例:

图像相位一致、纹理特征和灰度值作为构成特征向量的主要组成部分, 以便更加合理地描述图像中不同区域的特征,进而可以更有效地将图 像目标区域和非目标区域进行分类。 1)相位一致性及统计特征的提取:

重庆理工大学

•2016/5/24

ChongQing University of Technology

基于支持向量机的提取与识 别

汇报人:胡友呈 导 师:许洪斌教授

追求卓越

“高性能机电传动技术及应用”团队

•1

超越自我

重庆理工大学

•2016/5/24

ChongQing University of Technology

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

3)灰度特征向量提取. 图像灰度向量h=(k11,k12,...,kij).

步骤一. 将待分割图像分成W 个M×N的子图像块,每个子图像块构成一个特 征向量xi。i=1,2,3,…,W;p、q、h分别为描述的相位一致统 计特征向量、变换纹理特征向量、灰度特征向量。 步骤二.通过人工方法在xi中选取一部分能代表目标区域和非目标区域的特 征向量来作为训练特征向量,表示为(xj,yj),其中j∈{1,2,…, W}。 步骤三.通过选取的特征训练求得:方向矢量W和距离w0。 求得超平面:g(x)=(W*X+W0) 步骤四.将待分类的特征向量集xi(i=1,2,3,…,W)代入公式(1 0)中,如果g(xi)的值为1,那么相应的xi属于A类,否则xi属于B类.

3 2 1 0 -1 -2 -3 -3 -2 -1 0 1 2 3 4 5 6 7 8

通过对w和w0的归一化,得:

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

W T X w0 1 W T X w0 1

ChongQing University of Technology

模式识别过程:

[1]Ruiz—Ruiz G。G6mez—Gil J,Navas—Gracia L M.Testing difierent color spaces based on hue for the environmentally adaptive segmentation algorithm (EASA)[J].Computers and Electronics in Agriculture, 2009,68(1):88~96//贝叶斯分类sunflower [2]Song J.Image segmentation of eggplants in growing environment based on improved BP neural network[J] .Applied Mechanicsand Materials2011, 40~41:599 ~6. [3]Li P L,Lee S H,Hsu H Y.Study on citrus fruit image data separability by segmentati.Procedia Engineering,2011,23:408~416.//柑橘对比分析了基于色差的自动阈值法、FLDA、基于单层及多层感知器的超平 面结构、SOM4类图像分割方法的分割性能 [4]Bulanon D M ,Kataoka T,Okamoto H,et a1. Development of a real—time machine vision system for the apple harvesting robot[C]∥SICE Annual Conference in Sapporo,Hokkaido Institute of Tecnology,Japan2004, 1:595~598.//支持向量机

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

支持向量机数学模型:

C-SVC

线性分类器的设计就是要设计一个超平面:

g ( x) w X w0

T

8 7 6 5 4

从一个点到一个超平面的距离:

d g ( x) w

2)图像纹理特征提取 离散函数f(x,y)经离散傅里叶变换后 得频谱函数F(u,v)。 图像的变换纹理特征可以用以下几个参数来度量: 能量: 2

E F (u, v)

u v

u v

频域方向性:

D [ arctan(

I (u, v) )] / E R(u, v)

纹理度量用能量和频域方向性两个参数。从而组成一个特征向量:q (E, D)

E

PC ( x, y)

x 1 y 1

m

n

mn

同理得方差V,偏度SK,峰度BK,熵Ent. 将这五个特征组成一个模式 P ( E ,V , SK , BK , Ent )

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

最小距离分类器的模式识别:

每个模式类用一个均值矢量表示:

mj

决策函数:

1 Nj

X s j

X

j=1,2,•••,M

1 d j ( x) xT m j mT j mj 2

x s1 x s2

求超平面问题实际是求:W和W0; 对每个类Si记其标号为ti,其中ti=1,ti=-1. T 条件: ti W xi w0 1 i=1,2,...,N 求解最小化:

1 C w w 2

2

由拉格朗日乘法求极值点:

N 1 T L( w, w0 , ) W W i ti (W T xi w0 ) 1 2 i 1

汇报目录

•Ⅰ SVM 前期工作

•

•Ⅱ

•Ⅲ •Ⅵ

SVM原理介绍 向量机实例 后期计划

追求卓越

“高性能机电传动技术及应用”团队

•2

超越自我

重庆理工大学

ChongQing Un追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

•2016/5/24

一种结合多特征的SVM图像分割方法_邓晓飞

追求卓越

“高性能机电传动技术及应用”团队

超越自我

重庆理工大学

ChongQing University of Technology

后期工作计划:

1)分析libsvm分类器软件包的源代码。 2)使用二分类分出橘子。

追求卓越

“高性能机电传动技术及应用”团队

超越自我