一种基于局部排序PCA的线性鉴别算法

PCA算法在计算机视觉图像处理中的应用研究

PCA算法在计算机视觉图像处理中的应用研究随着计算机科学和技术的不断发展,计算机视觉技术在近年来取得了巨大的发展。

人们对计算机视觉的研究不断深入,不断涌现出各种新的算法和技术。

PCA 算法是其中一种重要的算法,广泛应用于计算机视觉图像处理中。

本文将从PCA 算法的原理和应用入手,探讨PCA算法在计算机视觉图像处理中的应用研究。

1. PCA算法原理PCA算法是主成分分析的缩写。

主成分分析是一种数学方法,可以通过将变量进行线性组合的方式来创建更高维度的特征向量。

PCA算法的主要思想是将原始数据集转换为一个新的高维度的数据集,使得数据集中的每个数据点在新的坐标系下尽可能分散。

在PCA算法中,将原始数据在不同的方向上进行投影,然后选择最大的投影方向作为主成分。

接着,将数据点绕着这个主成分旋转,在新的坐标系下,每个数据点的投影方差是最大。

2. PCA算法在计算机视觉图像处理中的应用2.1 降维由于图像数据通常具有高维度的特征空间,所以在计算机视觉图像处理中,使用PCA算法进行降维是非常有必要的。

PCA算法可以将原始的高维度特征空间转化为具有更低维度的特征空间,从而大大减小了计算量。

同时,PCA算法还能够去除数据中的噪声和冗余信息,提高数据的质量和准确性。

2.2 特征提取在计算机视觉图像处理中,特征提取是非常重要的一环。

特征提取的目的是从图像中提取出能够代表图像内容的关键信息。

因此,选择合适的特征提取算法非常关键。

PCA算法能够提取出图像中的主要特征,从而在图像检索和分类等领域中发挥巨大作用。

2.3 图像压缩图像压缩是计算机视觉图像处理中的一个重要应用领域。

由于图像数据具有较高的数据量和冗余信息,因此需要使用图像压缩算法来将图像数据压缩到更小的存储空间中。

PCA算法能够提取图像中的主要特征,并通过降维的方式将图像数据压缩到更小的存储空间中,从而实现图像压缩的目的。

3. 总结PCA算法是计算机视觉图像处理中非常关键的算法之一。

基于svd分解协方差矩阵实现pca算法

基于SVD分解协方差矩阵实现PCA算法介绍主成分分析(Principal Component Analysis,简称PCA)是一种常用的降维技术,用于从高维数据中提取出最重要的特征。

PCA通过线性变换将原始数据映射到一个新的坐标系中,使得映射后的数据具有最大的方差。

这样做可以减少数据维度,同时保留了大部分的信息。

在实际应用中,我们通常会使用协方差矩阵来描述原始数据之间的相关性。

而基于SVD(奇异值分解)来实现PCA算法,则是一种常见且高效的方法。

本文将详细介绍如何使用SVD分解协方差矩阵来实现PCA算法。

PCA算法步骤1.数据预处理:对原始数据进行标准化处理,使得每个特征具有零均值和单位方差。

2.计算协方差矩阵:根据标准化后的数据计算协方差矩阵。

3.SVD分解:对协方差矩阵进行奇异值分解,得到特征向量和特征值。

4.特征向量选择:根据特征值的大小选择前k个特征向量,这些特征向量对应的特征值较大,包含了数据中最重要的信息。

5.数据转换:将原始数据投影到选择的特征向量上,得到降维后的数据。

接下来,我们将逐步实现上述步骤。

数据预处理在进行PCA之前,需要对原始数据进行标准化处理。

标准化可以使得每个特征具有零均值和单位方差,消除了不同量纲带来的影响。

假设我们有一个m行n列的原始数据矩阵X,其中每一行表示一个样本,每一列表示一个特征。

我们可以通过以下公式对原始数据进行标准化处理:X−μσ其中X是原始数据矩阵,μ是每个特征的均值向量,σ是每个特征的标准差向量。

import numpy as npdef standardize(X):"""对原始数据进行标准化处理参数:X:原始数据矩阵返回值:X_std:标准化后的数据矩阵"""# 计算每个特征的均值和标准差mean = np.mean(X, axis=0)std = np.std(X, axis=0)# 标准化数据X_std = (X - mean) / stdreturn X_std计算协方差矩阵在进行PCA之前,我们需要计算原始数据的协方差矩阵。

基于PCA和Fisher线性判别技术的人脸识别算法

基于PCA和Fisher线性判别技术的人脸识别算法

方洁

【期刊名称】《软件导刊》

【年(卷),期】2015(014)012

【摘要】人脸识别技术是生物特征识别技术的一种,它根据人脸来识别人的身份.人脸识别技术具有准确、经济、可扩展性良好等特点,更重要的是,它比其它生物特征识别技术更加简便、直观、可靠.现在应用于人脸识别的算法有3种:基于PCA的人脸识别算法、基于Fisher线性判别的人脸识别算法、基于LBP特征的人脸识别算法.对前两种算法进行了深入研究,在人脸数据库上进行识别,取得了预期效果.【总页数】3页(P69-71)

【作者】方洁

【作者单位】武汉大学珞珈学院电子信息与机械工程学院,湖北武汉430064【正文语种】中文

【中图分类】TP312

【相关文献】

1.基于LLE与Fisher线性判别的人脸识别算法 [J], 马祥;王映卓;樊强

2.基于改进的PCA算法和Fisher线性判别的人脸识别技术 [J], 石跃祥;蔡自兴;王学武;B.Benhabib

3.基于PCA和Fisher线性判别技术的人脸识别算法 [J], 方洁

4.基于PCA算法的人脸识别技术研究 [J], 袁旭;迟耀丹;吴博琦;刘安琪;王佳祺

5.基于PCA算法的人脸识别技术研究 [J], 郭磊;周文杰;高少伟

因版权原因,仅展示原文概要,查看原文内容请购买。

pca算法和步骤

pca算法和步骤PCA算法简介PCA(Principal Component Analysis)是一种常用的数据降维方法,它可以将高维数据降到低维,并且保留原始数据的主要特征。

PCA算法最早由Karl Pearson在1901年提出,是一种基于线性变换的方法。

PCA算法的应用非常广泛,例如图像处理、语音识别、生物信息学等领域。

在机器学习领域中,PCA算法也被广泛应用于特征提取、数据压缩等方面。

PCA算法步骤1. 数据预处理在进行PCA算法之前,需要对数据进行预处理。

通常情况下,需要对数据进行标准化处理。

标准化处理可以使得不同特征之间具有相同的尺度,从而避免某些特征对结果产生过大的影响。

2. 计算协方差矩阵协方差矩阵是一个方阵,它描述了不同特征之间的相关性。

计算协方差矩阵是PCA算法中最重要的一步。

协方差矩阵可以通过以下公式计算:$$\Sigma = \frac{1}{m} \sum_{i=1}^{m}(x^{(i)}-\mu)(x^{(i)}-\mu)^T $$其中,$m$表示样本数,$x^{(i)}$表示第$i$个样本,$\mu$表示所有样本的均值。

3. 计算特征值和特征向量协方差矩阵有$m$个特征值和$m$个特征向量。

特征值描述了数据在某个方向上的方差,而特征向量描述了这个方向。

可以通过以下公式计算协方差矩阵的特征值和特征向量:$$\Sigma v = \lambda v$$其中,$\lambda$表示特征值,$v$表示对应的特征向量。

4. 选择主成分选择主成分是PCA算法中最重要的一步。

主成分是指协方差矩阵中具有最大特征值的对应的特征向量。

可以通过以下公式计算第$k$个主成分:$$z^{(i)} = x^{(i)}v_{k}$$其中,$z^{(i)}$表示第$i$个样本在第$k$个主成分上的投影,$v_{k}$表示第$k$个主成分。

5. 降维PCA算法最终目的是将高维数据降到低维,并且保留原始数据的主要特征。

改进的线性局部切空间排列算法

龙源期刊网

改进的线性局部切空间排列算法

作者:李文华

来源:《计算机应用》2011年第01期

摘要:线性局部切空间排列算法(LLTSA)是一种能很好地适用于识别问题的非线性降维方法,但LLTSA仅仅关注了数据的局部几何结构,而没有体现数据的整体信息。

提出了一种基于主成分分析(PCA)改进的线性局部切空间排列算法(),该算法在LLTSA的基础上,考虑了样本的全局结构,进而得到更好的降维效果。

在经典的三维流形和在MNIST图像库手写体识别的实验中,识别率较PCA、局部保持投影算法(LPP),LLTSA有明显提高,证实了该算法在识别问题中的有效性。

关键词:主成分分析;局部切空间;流形学习;算法;识别。

Pca与lda算法分析

PCA与LDA算法分析主成份分析(PCA)和线性判别分析(LDA)是两种常见的统计分析技术,它们在数据降维、特征提取和分类问题方面都有广泛的应用。

本篇文章将介绍PCA和LDA算法的基本原理和应用。

PCA算法PCA算法是一种常用的数据降维算法,它可以将高维数据转化为低维数据,而且保留了原数据的大部分信息。

PCA主要应用于数据压缩和数据可视化的处理过程中。

PCA算法的步骤1.数据的标准化:将数据的每个特征缩放至零均值和单位标准差的规模。

2.计算协方差矩阵:计算出数据的协方差矩阵。

3.求出协方差矩阵的特征向量和特征值:计算协方差矩阵的特征向量和特征值,选择特征值最大的前K个。

4.将原始数据转换到新的坐标系上:将原始数据投影到新的坐标轴上。

PCA算法的应用1.数据的可视化:PCA算法降低了数据的维度,可以将数据在二维或三维平面上可视化。

2.数据压缩:PCA算法可以对数据进行压缩,减少存储空间和计算开销。

3.模式识别:PCA算法可以用于模式识别问题,例如人脸识别。

LDA算法LDA算法是一种有监督的线性降维技术,它可以对数据进行分类和特征提取。

与PCA算法不同,LDA算法对数据标签进行了考虑,通过最大化类内距离和最小化类间距离,将样本映射到一个低维子空间中。

LDA算法的步骤1.计算各类别的均值向量:计算各类别的均值向量。

2.计算类内离散度矩阵:计算每个类别的样本离其均值向量的距离的协方差矩阵的和。

3.计算类间离散度矩阵:计算所有类别均值向量之间的协方差矩阵。

4.求出最大化的目标函数:该目标函数可以通过求解广义特征值问题获得。

5.投影样本到低维子空间上:通过选择最大的前K个特征向量,将数据映射到一个低维子空间中。

LDA算法的应用LDA算法在目标识别和分类问题中有广泛的应用,例如人脸识别、指纹识别以及语音识别。

PCA和LDA算法的比较PCA和LDA都可以用于数据降维和特征提取,但是两种算法的应用场景不同。

•PCA通常用于未标记的数据,它是一种非监督方法,只是纯粹的降维,不能进行分类。

PCA算法详解

主成分分析法主成分分析(Principal Component Analysis,简称PCA)方法是目前应用很广泛的一种代数特征提取方法,可以说是常用的一种基于变量协方差矩阵对样本中的信息进行处理、压缩和抽提的有效方法,主要通过K-L(Karhunen-Loeve)变换展开式从人脸数据库中提取人脸的主要特征[i],构成特征脸空间,在识别时将待测试的人脸图像投影到特征脸空间,得到一组投影系数,与数据库中各个人脸图像进行比对识别。

这种方法保留了原向量在与其协方差矩阵最大特征值相对应的特征向量方向上的投影,即主分量(Principal Components),因此被称为主成分分析。

由于PCA方法在进行降维处理和人脸特征提取方面的有效性,在人脸识别领域得到了广泛的应用。

它的核心思想是:利用较少数据的特征对样本进行描述以达到降低特征空间维数的目的,根据样本点在多维空间的位置分布,以样本点在空间中变化最大方向,即方差最大方向,作为差别矢量来实现数据的特征提取。

利用K-L变换抽取人脸的主要成分,利用特征脸法进行人脸识别的过程由训练阶段和识别阶段两个阶段组成。

3.1.1 K-L变换概述K-L变换是Karhunen-Loeve变换的简称,是一种特殊的正交变换。

它是建立在统计特性基础上的一种变换,它的突出优点是它能去相关性,而且是均方误差(Mean Square Error,MSE)意义下的最佳变换。

K-L变换的基本思想是在一个新的特征空间中将样本数据沿其特征矢量用对齐的方式进行旋转变换。

这个变换有效地克服了样本数据向量间的相关性,从而去除那些只带有较少信息的数据以达到降低特征空间维数的目的。

经过以上K-L 变换得到的特征是原图像向量的正交分解,其图像信息的总能量不变,不损失任何信息。

在这个互相正交、可测量的特征空间中进行图像的特征提取可以有效地利用图像之间的差异,提取有效信息。

K-L特征空间中,较大特征值所对应的特征向量体现原图像的总体趋势以及低频分量,较小特征值所对应特征向量体现原图像的细节变化以及高频分量所以人们用PCA法提取图像总体特征,其目的是用较少数量的特征对样本进行描述,同时又能保留所需要的识别信息。

人脸识别常用算法

人脸识别常用算法人脸识别是一种通过计算机视觉技术对图像或视频中的人脸进行检测、识别和验证的技术。

它在安防监控、人脸支付、人脸解锁等领域有着广泛的应用。

人脸识别的核心在于算法的设计与优化,下面将介绍几种常用的人脸识别算法。

一、特征提取算法特征提取算法是人脸识别的关键步骤,它通过对人脸图像进行分析和处理,提取出具有代表性的特征信息。

常用的特征提取算法有主成分分析(PCA)算法、线性判别分析(LDA)算法和局部二值模式(LBP)算法。

PCA算法通过对人脸图像进行降维,将高维的图像数据映射到低维的特征空间中,然后利用这些特征进行分类和识别。

LDA算法则是通过最大化类间距离和最小化类内距离的方式,寻找最优的投影方向,以实现人脸的区分和识别。

LBP算法则是一种局部特征描述算法,它通过对图像的每个像素点与其周围像素点进行比较,得到一个二进制编码,从而提取出人脸的纹理信息。

二、人脸检测算法人脸检测算法是人脸识别的前置步骤,它主要用于检测图像或视频中是否存在人脸,并将其位置标记出来。

常用的人脸检测算法有Viola-Jones算法、卷积神经网络(CNN)算法和级联分类器算法。

Viola-Jones算法是一种基于机器学习的人脸检测算法,它通过训练一个级联的强分类器来实现人脸的检测。

CNN算法则是一种深度学习算法,它通过构建多层的卷积神经网络来提取图像的特征,并通过分类器进行人脸检测。

级联分类器算法则是将多个分类器组合在一起,通过级联的方式进行人脸检测,以提高检测的准确率和速度。

三、人脸识别算法人脸识别算法是通过对提取的人脸特征进行匹配和比对,从而实现对人脸的识别和验证。

常用的人脸识别算法有支持向量机(SVM)算法、人工神经网络(ANN)算法和卷积神经网络(CNN)算法。

SVM算法是一种监督学习算法,它通过构建一个超平面来实现对不同类别的人脸进行分类和识别。

ANN算法则是一种模拟人脑神经元工作原理的算法,它通过构建多层的神经网络来实现对人脸的识别。

经典的PCA算法在数据分析中的应用

经典的PCA算法在数据分析中的应用主题:经典的PCA算法在数据分析中的应用数据分析是现代社会中极为重要的一个领域。

在从大量数据中提取信息、进行分析与决策方面,经典的PCA算法被广泛应用。

PCA是Principal Component Analysis的缩写,中文翻译为主成分分析方法。

本文将从两个层面解释PCA算法在数据分析中的应用,分别为:PCA算法原理以及PCA算法在实际应用中的运用。

PCA算法原理PCA算法其实是一种线性代数的分析方法,其本质是对数据的分解与表示。

在具体过程中,PCA首先对原始数据的协方差矩阵进行特征分解,然后将数据投影到新的坐标系上,使得投影后的数据各个维度之间相互独立,从而方便后续的分析与处理。

举例来说,假设我们有一些数据X={x1, x2, …, xn},其中xi表示第i条数据的各个维度特征。

我们首先需要计算X的协方差矩阵,其定义如下:其中E[X]表示X的期望,即X中各个维度特征的平均值。

Σ表示协方差矩阵,其中Σij表示第i个维度特征与第j个维度特征之间的协方差。

通过对Σ进行特征分解,我们可以获得其对应的特征值λi以及相应的特征向量vi。

PCA算法的核心思想是,将特征值较大的特征向量所构成的新坐标系作为目标空间,并将数据投影到该空间上,从而实现数据的降维与去噪的目的。

PCA算法在实际应用中的运用除了对原始数据进行降维与去噪之外,PCA算法在实际应用中还具有许多重要的作用。

下面分别从数据分析与机器学习的角度,介绍PCA在实际应用中的运用。

数据分析方面:PCA算法被广泛应用于数据可视化、异常检测、聚类分析等方面。

在数据可视化方面,PCA可以用于将高维数据投影到二维或三维空间中,使得研究者可以更加直观地分析数据的分布情况。

在异常检测方面,PCA可以用于检测数据中的异常点,例如在金融领域中,可以通过PCA算法检测某个交易记录是否异常。

在聚类分析方面,PCA可以用于降低数据的维度,使得数据更加易于聚类,从而方便后续的聚类分析。

pca 计算方法

pca 计算方法【原创实用版3篇】目录(篇1)1.引言2.PCA 的定义和原理3.PCA 的计算方法4.PCA 的应用5.结论正文(篇1)1.引言主成分分析(Principal Component Analysis,简称 PCA)是一种常用的数据降维方法,主要通过线性变换将原始数据映射到一个新的坐标系中,使得新坐标系中的各个方向与原始数据中的主要变异方向对应。

在实际应用中,PCA 可以有效地简化数据结构,减少计算量,同时保留尽可能多的原始数据信息。

本篇文章将介绍 PCA 的计算方法。

2.PCA 的定义和原理PCA 的主要目标是找到一个线性变换,将原始数据映射到一个新的坐标系中,使得新坐标系中的各个方向与原始数据中的主要变异方向对应。

设原始数据为 n 维变量 x = (x1, x2,..., xn),其均值为 0,即 E(x) = 0。

PCA 通过线性变换将原始数据映射到新的坐标系中,其中新的坐标系中的基向量是原始数据中的主成分,即数据的主要变异方向。

3.PCA 的计算方法PCA 的计算方法主要包括以下两个步骤:(1)计算协方差矩阵首先需要计算原始数据的协方差矩阵。

设原始数据为 n 维变量 x = (x1, x2,..., xn),其协方差矩阵为 R = E[(x - E(x)) * (x - E(x))^T],其中 E(x) 为原始数据的均值向量。

(2)计算主成分将协方差矩阵 R 进行对角化,得到对角矩阵 D。

对角矩阵 D 中的对角线元素为协方差矩阵 R 的主对角线元素,即原始数据的标准差。

对角矩阵 D 的基向量是原始数据的主成分,即数据的主要变异方向。

4.PCA 的应用PCA 在实际应用中具有广泛的应用,例如在图像处理、信号处理、数据挖掘等领域。

通过 PCA 降维,可以有效地简化数据结构,减少计算量,同时保留尽可能多的原始数据信息。

5.结论PCA 是一种有效的数据降维方法,其计算方法主要包括计算协方差矩阵和主成分。

机器学习--主成分分析(PCA)算法的原理及优缺点

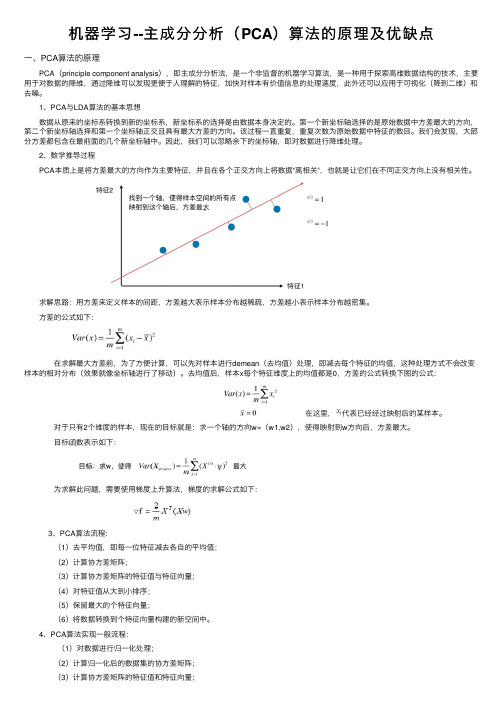

机器学习--主成分分析(PCA)算法的原理及优缺点⼀、PCA算法的原理 PCA(principle component analysis),即主成分分析法,是⼀个⾮监督的机器学习算法,是⼀种⽤于探索⾼维数据结构的技术,主要⽤于对数据的降维,通过降维可以发现更便于⼈理解的特征,加快对样本有价值信息的处理速度,此外还可以应⽤于可视化(降到⼆维)和去噪。

1、PCA与LDA算法的基本思想 数据从原来的坐标系转换到新的坐标系,新坐标系的选择是由数据本⾝决定的。

第⼀个新坐标轴选择的是原始数据中⽅差最⼤的⽅向,第⼆个新坐标轴选择和第⼀个坐标轴正交且具有最⼤⽅差的⽅向。

该过程⼀直重复,重复次数为原始数据中特征的数⽬。

我们会发现,⼤部分⽅差都包含在最前⾯的⼏个新坐标轴中。

因此,我们可以忽略余下的坐标轴,即对数据进⾏降维处理。

2、数学推导过程 PCA本质上是将⽅差最⼤的⽅向作为主要特征,并且在各个正交⽅向上将数据“离相关”,也就是让它们在不同正交⽅向上没有相关性。

求解思路:⽤⽅差来定义样本的间距,⽅差越⼤表⽰样本分布越稀疏,⽅差越⼩表⽰样本分布越密集。

⽅差的公式如下: 在求解最⼤⽅差前,为了⽅便计算,可以先对样本进⾏demean(去均值)处理,即减去每个特征的均值,这种处理⽅式不会改变样本的相对分布(效果就像坐标轴进⾏了移动)。

去均值后,样本x每个特征维度上的均值都是0,⽅差的公式转换下图的公式: 在这⾥,代表已经经过映射后的某样本。

对于只有2个维度的样本,现在的⽬标就是:求⼀个轴的⽅向w=(w1,w2),使得映射到w⽅向后,⽅差最⼤。

⽬标函数表⽰如下: 为求解此问题,需要使⽤梯度上升算法,梯度的求解公式如下: 3、PCA算法流程: (1)去平均值,即每⼀位特征减去各⾃的平均值; (2)计算协⽅差矩阵; (3)计算协⽅差矩阵的特征值与特征向量; (4)对特征值从⼤到⼩排序; (5)保留最⼤的个特征向量; (6)将数据转换到个特征向量构建的新空间中。

PCA算法的原理及其示例

PCA算法的原理及其示例PCA的原理:设有一组样本数据,其中每个样本有n个特征变量。

PCA的目标是通过线性变换,将原始数据映射到一组新的坐标轴上,使得映射后的数据具有最大的方差,即保留最多的信息,同时特征之间应该尽量无关,从而降低数据的维度。

步骤:1.对原始数据进行中心化处理,即将每个特征的均值减去该特征的平均值,使得数据的均值为0。

2. 计算协方差矩阵,即将中心化后的数据矩阵X的转置XT与自身相乘得到协方差矩阵Cov(X)。

3.对协方差矩阵进行特征值分解,得到特征值和特征向量。

4.对特征值进行排序,选择最大的k个特征值所对应的特征向量,组成一个新的特征向量矩阵W。

5.将原始数据矩阵X乘以特征向量矩阵W,得到一个降维后的数据矩阵Y。

示例:假设有一组包含m个二维样本数据的集合D={X1,X2,...,Xm},其中每个样本有两个特征变量。

我们希望将这些样本数据降维到一维,以便进行可视化或进一步分析。

Step 1: 中心化数据首先,计算出每个特征的均值,然后将每个特征值减去其均值,即可得到中心化的数据。

Step 2: 计算协方差矩阵将中心化后的数据矩阵X的转置XT与自身相乘,得到协方差矩阵Cov(X)。

协方差矩阵的元素Cov(Xij, Xi'j')表示第i个特征与第i'个特征之间的协方差。

Step 3: 特征值分解对协方差矩阵Cov(X)进行特征值分解,得到特征值λ1和λ2,以及对应的特征向量v1和v2、特征向量表示了数据在新坐标轴上的投影方向,而特征值则表示了数据在对应特征向量方向上的方差。

Step 4: 特征选择将特征值按照从大到小的顺序排序,选择最大的k个特征值及其对应的特征向量。

在本例中,我们选择最大的特征值λ1和对应的特征向量v1Step 5: 数据降维将原始数据矩阵X乘以特征向量矩阵W=[v1],即得到一个降维后的数据矩阵Y=X*W。

这样,我们就可以将原始的二维数据降到一维,从而减少了数据的维度。

融优学堂大数据技术导论(北京理工大学)章节测验答案

大数据技术导论(北京理工大学)解忧书店 JieYouBookshop2引论1.【单选题】科学研究第四范式数据思维采用()。

A科学归纳B模型推演C仿真模拟D关联分析正确答案:D 我的答案:A2.【单选题】大数据是一个什么领域的问题()。

A计算机领域B数学统计领域C业务领域D多学科综合领域正确答案:D 我的答案:B3.【多选题】大数据处理框架之流计算框架()。

A hadoopB Spark streamingC FlinkD STORM正确答案: B C D 我的答案: A4.【多选题】大数据处理框架之批处理框架()。

A hadoopB SparkC FlinkD jvm5.【多选题】大数据的优势包括()。

A数据体量大B收集时间短C数据类型丰富D价值密度高正确答案: A B C 我的答案: B3大数据感知与获取1.【单选题】下面科学研究的四个范式顺序正确的是()。

A经验范式-理论范式-模拟范式-数据密集型范式B理论范式-模拟范式-经验范式-数据密集型范式C理论范式-模拟范式-数据密集型范式-经验范式D理论范式-经验范式-数据密集型范式-模拟范式正确答案:A 我的答案:C2.【多选题】常见的分布式网络爬虫架构有()。

A Master-workerB Master-slaveC peer-peerD Mixed正确答案: B C D 我的答案: C3.【单选题】A M1-M2-M3-S4-M5-M6-M8-S7B M1-M2-M5- M8- M6-M3-S7-S4C M1-M2-M3-S4-M5-M6- S7 - M8D M1-M2-M5- M8- M6-M3- S4 - S74.【单选题】以数据考察为基础,联合理论、实验和模拟一体的数据密集计算的范式是以下哪个范式()。

A经验范式B理论范式C模拟范式D数据密集型范式正确答案:D 我的答案:C5.【单选题】在大数据生命周期的各个阶段中,工作最多的是哪个阶段()。

基于PCA和LDA改进算法的人脸识别技术研究

基于PCA和LDA改进算法的人脸识别技术研究人脸识别技术是一种通过计算机分析人脸图像的方法,来识别和验证特定人物身份。

随着人工智能和计算机视觉技术的发展,人脸识别技术已经成为了一种被广泛应用于各个领域的重要技术。

在人脸识别技术中,基于PCA(Principal Component Analysis,主成分分析)和LDA(Linear Discriminant Analysis,线性判别分析)的改进算法已经成为了当前的主流技术,能够在一定程度上提高人脸识别的准确性和稳定性。

一、 PCA和LDA的基本原理PCA是一种常用的数据降维技术,通过线性变换将原始数据映射到一个新的空间中,使得变换后的数据具有最大的方差。

在人脸识别中,通过对人脸图像进行PCA处理,可以得到一组主成分,这些主成分可以反映出人脸图像的最重要的特征。

通过对人脸图像进行降维处理,可以减少数据的维度,提高计算效率,同时可以有效地去除一些无关特征,减小数据的噪音。

LDA是一种用于特征提取的技术,它是一种监督学习的方法,通过最大化类内距离和最小化类间距离的方式对数据进行线性映射。

在人脸识别中,通过对人脸图像进行LDA处理,可以得到一组线性判别特征,这些特征可以最大程度地区分不同的人脸图像。

通过LDA处理,可以提取出最具有判别能力的特征,提高人脸识别的准确性和稳定性。

在传统的PCA和LDA方法中,存在一些局限性,比如对噪音敏感、对数据分布要求较高等问题。

为了克服这些问题,研究者们提出了一系列基于PCA和LDA的改进算法,通过引入一些新的思想和方法,提高了人脸识别技术的性能和稳定性。

1. 核化PCA(Kernel PCA)传统的PCA方法是采用线性变换的方式进行降维处理,但是在实际应用中,人脸图像的特征通常是非线性分布的。

为了解决这个问题,研究者们引入了核函数的思想,将非线性特征映射到一个高维的空间中,然后在该空间中进行线性变换。

核化PCA方法通过引入核函数,可以更好地处理非线性特征,提高了人脸识别的准确性和稳定性。

基于局部离散度的监督型线性判别分析及其应用

孙小丹1 ꎬ陈 文1

( 福州职业技术学院ꎬ福建福州 350108)

摘 要: 鉴于线性判别分析 ( Linear Discriminant Analysisꎬ LDA) 算法存在的弊端ꎬ本文提出了一种基于局部

离散度的监督型线性判别分析( Supervised Linear Discriminant Analysis based on Local Dispersionꎬ SLDALD) 算法 新

第一作者简介:孙小丹(1977- ) 女ꎬ 福建福州人ꎬ 副教授ꎬ 博士ꎬ 研究方向:遥感影像分析.

77

绵阳师范学院学报( 自然科学版)

综上ꎬ虽然关于 LDA 算法的应用和改进已取得了较多的研究成果ꎬ但是大部分成果是通过结合其它技

光谱特征数据降维 至今ꎬ国内外研究学者已从不同的角度对 LDA 算法加以应用或改进 如:谢欣芳等[7] 结合

线性判别分析 (LDA)算法和局部线性嵌入 (LLE)算法的思想ꎬ提出一种半监督局部判别分析算法ꎻLiu Z 等[8]

结合稀疏图理论改进 LDA 算法ꎬ提出了一种正交稀疏线性判别分析算法ꎻIbrahim W 等[9] 将 LDA 与深度核化极

sionꎬ SLDALD) 算法ꎬ以下简称 SLDALD 算法 最后ꎬ联合 World - View2 影像数据ꎬ通过对比实验ꎬ对新算法

的可行性和优越性加以验证

1 原理和方法

1.1 线性判别分析( Linear Discriminant AnalysisꎬLDA) 算法 [5]

LDA 算法的思想是:在影像包含的 n 维原始光谱特征数据中ꎬ采用正交变换方式ꎬ在保证信息损失最小

线性判别分析LDA与主成分分析PCA

第二部分 主成分分析(PCA)

2021/6/4

18

介绍

在实际问题中,我们经常会遇到研究多个变量的问 题,而且在多数情况下,多个变量之 间常常存在一 定的相关性。由于变量个数较多再加上变量之间的 相关性,势必增加了分析问 题的复杂性。如何从多 个变量中综合为少数几个代表性变量,既能够代表 原始变量的绝大多 数信息,又互不相关,并且在新 的综合变量基础上,可以进一步的统计分析,这时 就需要进行主成分分析。

19

基本思想

主成分分析所要做的就是设法将原来众多具有一定 相关性的变量,重新组合为一组新的相互无关的综 合变量来代替原来变量。通常,数学上的处理方法 就是将原来的变量做线性组合,作为新的综合变量 ,但是这种组合如果不加以限制,则可以有很多, 应该如何选择呢?

20

基本思想

如果将选取的第一个线性组合即第一个综合变量记 为F1 ,自然希望它尽可能多地反映原来变量的信息 ,这里“信息”用方差来测量,即希望Var(F1)越大 ,表示F1包含的信息越多。因此在所有的线性组合 中所选取的F1应该是方差最大的,故称F1为第一主成 分。如果第一主成分不足以代表原来p 个变量的信 息,再考虑选取F2即第二个线性组合,为了有效地 反映原来信息,F1已有的信息就不需要再出现在F2中 , 用数学语言表达就是要求Cov(F1 ,F2)=0,称F2为第 二主成分,依此类推可以构造出第三、四…第p 个主 成分。

30

LDA的一些限制

1、 LDA至多可生成C-1维子空间 LDA降维后的维度区 间在[1,C-1],与原始特征数n无关,对于二值分类, 最多投影到1维。 2、 LDA不适合对非高斯分布样本进行降维。

上图中红色区域表示一类样本,蓝色区域表示另一 类,由于是2类,所以最多投影到1维上。不管在直 线上怎么投影,都难使红色点和蓝色点内部凝聚, 类间分离。

PCA算法概念及作用

PCA算法概念及作⽤PCA(Principal Component Analysis,主成分分析)是⼀种常⽤的数据分析⽅法。

PCA通过线性变换将原始数据变换为⼀组各维度线性⽆关的表⽰,可⽤于提取数据的主要特征分量,常⽤于⾼维数据的降维。

⽹上关于PCA的⽂章有很多,但是⼤多数只描述了PCA的分析过程,⽽没有讲述其中的原理。

这篇⽂章的⽬的是介绍PCA的基本数学原理,帮助读者了解PCA的⼯作机制是什么。

当然我并不打算把⽂章写成纯数学⽂章,⽽是希望⽤直观和易懂的⽅式叙述PCA的数学原理,所以整个⽂章不会引⼊严格的数学推导。

希望读者在看完这篇⽂章后能更好的明⽩PCA的⼯作原理。

数据的向量表⽰及降维问题⼀般情况下,在数据挖掘和机器学习中,数据被表⽰为向量。

例如某个淘宝店2012年全年的流量及交易情况可以看成⼀组记录的集合,其中每⼀天的数据是⼀条记录,格式如下:(⽇期, 浏览量, 访客数, 下单数, 成交数, 成交⾦额)其中“⽇期”是⼀个记录标志⽽⾮度量值,⽽数据挖掘关⼼的⼤多是度量值,因此如果我们忽略⽇期这个字段后,我们得到⼀组记录,每条记录可以被表⽰为⼀个五维向量,其中⼀条看起来⼤约是这个样⼦:注意这⾥我⽤了转置,因为习惯上使⽤列向量表⽰⼀条记录(后⾯会看到原因),本⽂后⾯也会遵循这个准则。

不过为了⽅便有时我会省略转置符号,但我们说到向量默认都是指列向量。

我们当然可以对这⼀组五维向量进⾏分析和挖掘,不过我们知道,很多机器学习算法的复杂度和数据的维数有着密切关系,甚⾄与维数呈指数级关联。

当然,这⾥区区五维的数据,也许还⽆所谓,但是实际机器学习中处理成千上万甚⾄⼏⼗万维的情况也并不罕见,在这种情况下,机器学习的资源消耗是不可接受的,因此我们必须对数据进⾏降维。

降维当然意味着信息的丢失,不过鉴于实际数据本⾝常常存在的相关性,我们可以想办法在降维的同时将信息的损失尽量降低。

举个例⼦,假如某学籍数据有两列M和F,其中M列的取值是如何此学⽣为男性取值1,为⼥性取值0;⽽F列是学⽣为⼥性取值1,男性取值0。

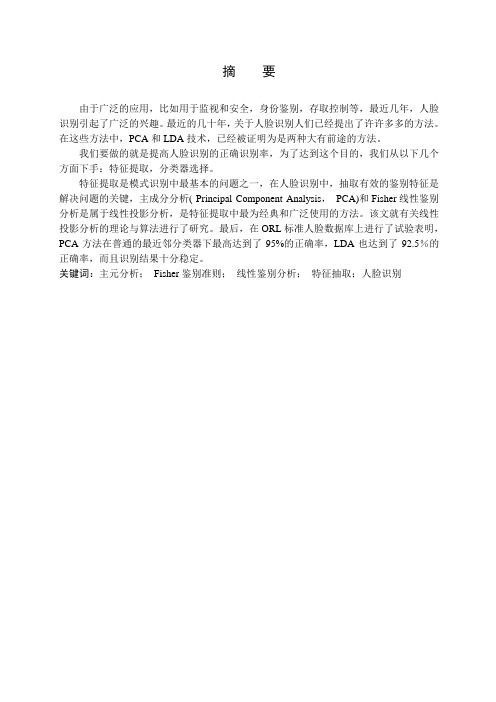

PCA-毕设论文

摘要由于广泛的应用,比如用于监视和安全,身份鉴别,存取控制等,最近几年,人脸识别引起了广泛的兴趣。

最近的几十年,关于人脸识别人们已经提出了许许多多的方法。

在这些方法中,PCA和LDA技术,已经被证明为是两种大有前途的方法。

我们要做的就是提高人脸识别的正确识别率,为了达到这个目的,我们从以下几个方面下手:特征提取,分类器选择。

特征提取是模式识别中最基本的问题之一,在人脸识别中,抽取有效的鉴别特征是解决问题的关键,主成分分析( Principal Component Analysis,PCA)和Fisher线性鉴别分析是属于线性投影分析,是特征提取中最为经典和广泛使用的方法。

该文就有关线性投影分析的理论与算法进行了研究。

最后,在ORL标准人脸数据库上进行了试验表明,PCA方法在普通的最近邻分类器下最高达到了95%的正确率,LDA也达到了92.5%的正确率,而且识别结果十分稳定。

关键词:主元分析;Fisher鉴别准则;线性鉴别分析;特征抽取;人脸识别ABSTRACTFace recognition has been of great interest in recent years because its wide range of application such as surveillance and security ,identity authentication and access control ,etc. Numerous methods have been proposed for face recognition in the last decade. Among all these approaches ,techniques based on PCA and LDA ,have been proved to be two promising approach.In order to enhance the accuracy of the recognition,the main goal of our research,we deal with the problems as follow:feature extraction,classifier selection.Feature extraction is one of the most fundamental problems. In face recognition,to extract the valid discriminating feature plays the key role to solve the problems. PCA and fisher are both the most typical methods that are based on linear projection analysis and widely used. This text does a further research on theories and algorithms of linear projection analysis. Finally,the PCA algorithm was test on ORL face database,and a recognition rate of 97% was achieved by using a common nearest neighbor classifier,while LDA is 97.2%,and the classification result is very robust.Keywords:PCA(principal component analysis);Fisher criterion;linear discriminate analysis;feature extraction;face recognition目录第一章绪论 (1)1.1 课题研究的背景 (1)1.2 模式识别系统 (1)1.3国内外生物特征技术的最新发展 (3)1.4 我国生物特征技术的发展与应用概述 (4)1.5 本文主要研究的内容 (4)第二章人脸图像的有效鉴别特征抽取 (5)2.1 引言 (5)2.2 人脸图像的代数特征 (5)2.2.1 奇异值特征 (5)2.2.2 最佳鉴别投影特征 (6)2.2.3 特征脸(K-L变换特征) (8)2.3 本章小结 (10)第三章主成分分析法(PCA) (11)3.1 引言 (11)3.2 主元分析发展的相关介绍 (11)3.3 主元分析(PCA)方法 (12)3.3.1 PCA思想与最优投影矩阵 (12)3.3.2 特征抽取 (13)3.3.3 分类 (13)3.4 主元分析(PCA)方法在人脸识别中的应用 (14)3.5 本章小节 (14)第四章线性鉴别分析(LDA) (15)4.1 引言 (15)4.2 线性鉴别分析方法的发展 (15)4.3 线性鉴别分析的基本原理 (16)4.4 Fisher线性鉴别法 (17)4.5 线性鉴别分析在人脸识别中的应用 (17)4.6 分类 (18)4.7 本章小节 (18)第五章实验结果 (19)5.1 实验数据库介绍 (19)5.2 ORL人脸库上的实验结果 (20)5.2.1 得到的特征图像 (20)5.2.2 不同训练样本下的识别率 (20)5.2.3 两种算法运行时间的比较 (21)5.2.4 不同方法的特征值分布情况 (21)5.3 眼睛数据库上的试验结果 (22)5.3.1 得到的特征图像 (22)5.3.2 不同训练样本下的识别率 (23)5.3.3 两种算法运行时间的比较 (24)5.3.4 不同方法的特征值分布情况 (24)5.4 实验结果分析 (25)5.5 本章小节 (26)结束语 (27)参考文献 (28)致谢 (29)附录一 PCA源程序 (30)附录二 LDA源程序 (39)第一章绪论1.1 课题研究的背景在高度信息化的现代社会,人们的身份鉴别已经渗透到日常生活的每一个方面。

局部稀疏表示的鲁棒PCA人脸识别

局部稀疏表示的鲁棒PCA人脸识别游春芝;崔建;丁伯伦【摘要】近来提出了一种基于误差分析的鲁棒PCA人脸识别算法,然而当字典增大时,低秩分解就变得很复杂.针对此问题提出了一种局部稀疏表示的鲁棒PCA人脸识别算法.根据稀疏表示系数之间的相似性,选取邻近样本组成新的字典,然后通过鲁棒PCA进行低秩人脸识别.通过Yale、ORL人脸数据的实验,表明该算法对光照、遮挡仍具有较好的鲁棒性,同时大大减少计算成本.另一方面也说明通过稀疏表示选取邻近样本的可行性.【期刊名称】《微型电脑应用》【年(卷),期】2019(035)004【总页数】4页(P23-26)【关键词】误差分析;局部稀疏表示;鲁棒性;邻近样本【作者】游春芝;崔建;丁伯伦【作者单位】山西医科大学汾阳学院基础医学部,吕梁032200;山西医科大学汾阳学院基础医学部,吕梁032200;安徽信息工程学院,芜湖241000【正文语种】中文【中图分类】TP3910 引言随着科技的发展,人脸识别在计算机视觉、图形识别等领域成为研究的热门。

在我们的实际生活当中也被广泛应用,如公共安全,信息检索等。

尽管人脸识别技术近年来取得巨大的进步,很多相关算法被提出,如矩阵分解[1],线性判别分析[2]等,但是这些算法对光照、遮挡、姿态变化等问题性能严重下降。

为此基于稀疏表示下的人脸识别算法被广泛应用,其中最为代表性的为稀疏表示分类方法(Sparse Representation based Classification,SRC)[3],线性回归方法(Linear Regression based Classification,LRC)[4],这些算法对连续遮挡中并不鲁棒。

而且对训练样本有一定的依赖性。

近年来一种对遮挡鲁棒的RPCA[5,6]算法被提出,实验表明RPCA在图像恢复、聚类等方面也效果显著。

在文献[6]中Luan等提出通过RPCA 将测试样本分解成低秩和误差人脸,最后分析误差人脸,构建平滑因子和稀疏因子用于人脸的识别。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

像矩 阵, 可 以避 免使 用奇异值 分解理论 , 从 而更加简便 。在 O R L人脸库上的 实验结果表明 , 所提 出的方法在 识别性能

上 明 显优 于 经典 的 P C A和P C A+ L D A方 法。

关键词 主成分分析 , 特征抽取 , 分块 P C A, 线性鉴 剐分析

中图法分 类号

Ab s t r a c t Pr i n c i p a l c o mp o n e n t a n a l y s i s i s a n i mp o r t a n t f e a t u r e e x t r a c t i o n me t h o d o f p a t t e r n r e c o g n i t i o n, a n d t h e ma i n f e a t u r e s o f t h e me t h o d a r e e x t r a c t e d f r o m t h e s a mp l e b y KL e x p a n s i o n . Th e r e f o r e , we p r o p o s e d a me t h o d o f f a c e r e og c — n i t i o n P CA e x p a n s i o n, c a l l e d mo d u l a r s o r t i n g PC A f a c e r e c o g n i t i o n me t h o d ( MS PC A) . MS P CA me t h o d f i r s t d i v i d e s t h e i ma g e ma t r i x i n t o b l o c k s . Th e f e a t u r e v e c t o r s , c o r r e s p o n d e d t o a l l t h e f e a t u r e v a l u e , a r e o b t a i n e d f r o m t h e s u b - i ma g e

ma t r i x o f a l l s u b b l o c k s b y u s i n g P CA me t h o d。 a n d t h e f e a t u r e v e c t o r s a r e i d e n t i f i e d . Th e n t h e me t h o d f i n d s o u t t h e f e a —

t u r e v e c t o r s , c o r r e s on p d e d t O k ma x i mu m f e a t u r e v a l u e o f a l l e i g e n v a l u e s . Th e s e f e a t u r e v e c t o r s a r e t a k e n t o e x t r a c t t h e

摘 要 主分量分析 ( P r i n c i p a l C o mp o n e n t A n a l y s i s , P C A) 是模 式识剐领域 中一种重要 的特 征抽取方 法, 该方法通过

K - L 展开式 来抽 取样本 的主要特 征。基 于此 , 提 出一种拓展 的 P C A人 脸识 别方法 , 即分块排序 P C A人脸 识别方 法 ( MS P C A) 。分块排序 P C A方法先对 图像 矩阵进行 分块 , 对所有分块得到的子 图像 矩阵利用 P C A方法求 出矩 阵的所

Tቤተ መጻሕፍቲ ባይዱ 3 9 1 . 4 1

文献标识码

A

D O I 1 0 . 1 1 8 9 6 / j . i s s n . 1 0 0 2 — 1 3 7 x 2 0 1 5 . 8 . 0 1 2

P CA F a c e Re c o g n i t i o n Al g o r i t h m B a s e d o n L o c a l F e a t u r e

P ANG Ch e n g GUO Zh i - b o DONG J i a n

( Co l l e g e o f I n f o r ma t i o n En g i n e e r i n g, Ya n g z h o u Un i v e r s i t y, Ya n gz h o u 2 2 5 0 02 , Chi n a )

第4 2 卷 第8 期 2 0 1 5 年 8月

一

计 算

机

科

学

Vo 1 . 4 2 No . 8

Au g 2 0 1 5

Co mp u t e r S c i e n c e

种基 于局 部 排 序 P C A 的 线 性鉴 别 算 法

庞 成 郭 志波 董 健

( 扬州大 学信 息工程 学 院 扬州 2 2 5 0 0 2 )

有特征值所对应 的特征 向量并加 以标识 ; 然后找 出这些所有的特征值 中 k个最大的特征值所 对应 的特征向量 , 用这些

特征 向量分别去抽取所属的予 图像的特征 ; 最后 , 在 MS P C A的基础上 , 将抽取子 图像所得到的特征矩 阵合 并 , 把 这个 合并后 的特征矩 阵作为新的样本进行 P C A+L D A。与 P C A和 P C A+L D A 方法相 比, 分块排序 P C A 由于使 用子 图