Nginx负载均衡配置实例详解

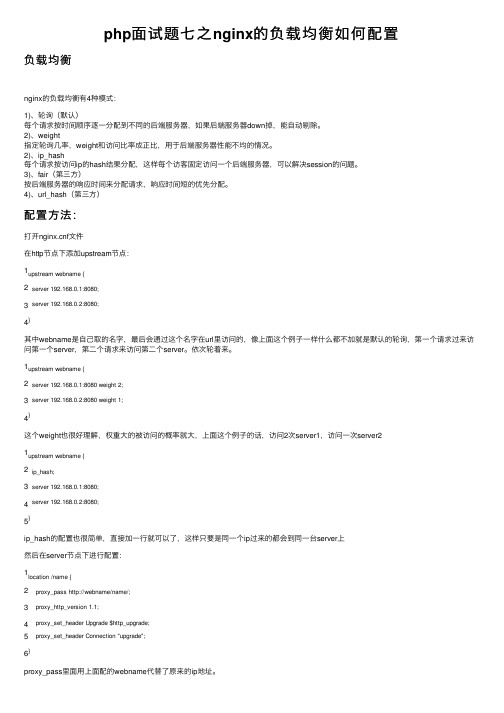

php面试题七之nginx的负载均衡如何配置

php⾯试题七之nginx的负载均衡如何配置负载均衡nginx的负载均衡有4种模式:1)、轮询(默认)每个请求按时间顺序逐⼀分配到不同的后端服务器,如果后端服务器down掉,能⾃动剔除。

2)、weight指定轮询⼏率,weight和访问⽐率成正⽐,⽤于后端服务器性能不均的情况。

2)、ip_hash每个请求按访问ip的hash结果分配,这样每个访客固定访问⼀个后端服务器,可以解决session的问题。

3)、fair(第三⽅)按后端服务器的响应时间来分配请求,响应时间短的优先分配。

4)、url_hash(第三⽅)配置⽅法:打开f⽂件在http节点下添加upstream节点:1 2 3 4upstream webname {server 192.168.0.1:8080; server 192.168.0.2:8080; }其中webname是⾃⼰取的名字,最后会通过这个名字在url⾥访问的,像上⾯这个例⼦⼀样什么都不加就是默认的轮询,第⼀个请求过来访问第⼀个server,第⼆个请求来访问第⼆个server。

依次轮着来。

1 2 3 4upstream webname {server 192.168.0.1:8080 weight 2; server 192.168.0.2:8080 weight 1; }这个weight也很好理解,权重⼤的被访问的概率就⼤,上⾯这个例⼦的话,访问2次server1,访问⼀次server21 2 3 4 5upstream webname {ip_hash;server 192.168.0.1:8080; server 192.168.0.2:8080; }ip_hash的配置也很简单,直接加⼀⾏就可以了,这样只要是同⼀个ip过来的都会到同⼀台server上然后在server节点下进⾏配置:12 34 56location /name {proxy_pass http://webname/name/;proxy_http_version 1.1;proxy_set_header Upgrade $http_upgrade; proxy_set_header Connection "upgrade"; }proxy_pass⾥⾯⽤上⾯配的webname代替了原来的ip地址。

一个完整的nginx配置文件范例参考(含负载均衡)

一个完整的nginx配置文件范例参考(含负载均衡)改配置文件 /usr/local/server/nginx/conf/nginx.conf以下是我的 nginx.conf 内容,仅供参考:#运行用户user nobody nobody;#启动进程worker_processes 2;#全局错误日志及PID文件error_log logs/error.log notice;pid logs/nginx.pid;#工作模式及连接数上限events {use epoll;worker_connections 1024;}#设定http服务器,利用它的反向代理功能提供负载均衡支持http {#设定mime类型include conf/mime.types;default_type application/octet-stream;#设定日志格式log_format main '$remote_addr - $remote_user [$time_local] ''"$request" $status $bytes_sent ''"$http_referer" "$http_user_agent" ''"$gzip_ratio"';log_format download '$remote_addr - $remote_user [$time_local] ''"$request" $status $bytes_sent ''"$http_referer" "$http_user_agent" ''"$http_range" "$sent_http_content_range"';#设定请求缓冲client_header_buffer_size 1k;large_client_header_buffers 4 4k;#开启gzip模块gzip on;gzip_min_length 1100;gzip_buffers 4 8k;gzip_types text/plain;output_buffers 1 32k;postpone_output 1460;#设定access logaccess_log logs/access.log main;client_header_timeout 3m;client_body_timeout 3m;send_timeout 3m;sendfile on;tcp_nopush on;tcp_nodelay on;keepalive_timeout 65;#设定负载均衡的服务器列表upstream mysvr {#weigth参数表示权值,权值越高被分配到的几率越大#本机上的Squid开启3128端口server 192.168.8.1:3128 weight=5;server 192.168.8.2:80 weight=1;server 192.168.8.3:80 weight=6;}#设定虚拟主机server {listen 80;server_name 192.168.8.1 ;charset gb2312;#设定本虚拟主机的访问日志access_log logs/.access.log main;#如果访问/img/*, /js/*, /css/* 资源,则直接取本地文件,不通过squid#如果这些文件较多,不推荐这种方式,因为通过squid的缓存效果更好location ~ ^/(img|js|css)/ {root /data3/Html;expires 24h;}#对 "/" 启用负载均衡location / {proxy_pass http://mysvr;proxy_redirect off;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;client_max_body_size 10m;client_body_buffer_size 128k;proxy_connect_timeout 90;proxy_send_timeout 90;proxy_read_timeout 90;proxy_buffer_size 4k;proxy_buffers 4 32k;proxy_busy_buffers_size 64k;proxy_temp_file_write_size 64k;}#设定查看Nginx状态的地址location /NginxStatus {stub_status on;access_log on;auth_basic "NginxStatus";auth_basic_user_file conf/htpasswd;}}}运行以下命令检测配置文件是否无误:如果没有报错,那么就可以开始运行Nginx了,执行以下命令即可:备注:conf/htpasswd 文件的内容用apache 提供的htpasswd 工具来产生即可,内容大致如下:3.) 查看 Nginx 运行状态输入地址http://192.168.8.1/NginxStatus/,输入验证帐号密码,即可看到类似如下内容:Active connections: 328server accepts handled requests9309 8982 28890Reading: 1 Writing: 3 Waiting: 324第一行表示目前活跃的连接数第三行的第三个数字表示Nginx运行到当前时间接受到的总请求数,如果快达到了上限,就需要加大上限值了。

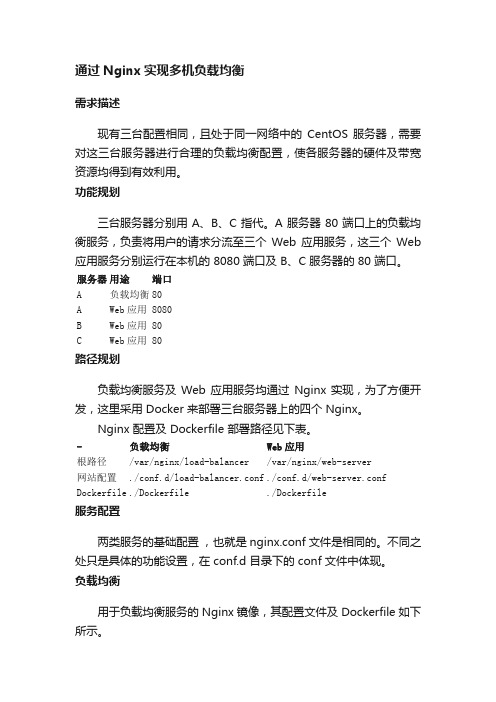

通过Nginx实现多机负载均衡

通过Nginx实现多机负载均衡需求描述现有三台配置相同,且处于同一网络中的CentOS 服务器,需要对这三台服务器进行合理的负载均衡配置,使各服务器的硬件及带宽资源均得到有效利用。

功能规划三台服务器分别用 A、B、C 指代。

A 服务器 80 端口上的负载均衡服务,负责将用户的请求分流至三个Web 应用服务,这三个Web 应用服务分别运行在本机的 8080 端口及 B、C 服务器的 80 端口。

服务器用途端口A 负载均衡80A Web应用 8080B Web应用 80C Web应用 80路径规划负载均衡服务及Web 应用服务均通过 Nginx 实现,为了方便开发,这里采用 Docker 来部署三台服务器上的四个 Nginx。

Nginx 配置及 Dockerfile 部署路径见下表。

- 负载均衡Web应用根路径/var/nginx/load-balancer /var/nginx/web-server网站配置./conf.d/load-balancer.conf ./conf.d/web-server.conf Dockerfile ./Dockerfile ./Dockerfile服务配置两类服务的基础配置,也就是 nginx.conf 文件是相同的。

不同之处只是具体的功能设置,在 conf.d 目录下的 conf 文件中体现。

负载均衡用于负载均衡服务的 Nginx 镜像,其配置文件及 Dockerfile 如下所示。

这里有一个关键点要注意,由于 A 服务器上将会运行两个 Nginx 容器,要想将负载均衡服务的请求导向同一服务器上的 Web 应用服务,就需要把请求发给 Web 应用服务用于 Docker 容器间通信的 IP,而不是 A 服务器的外网 IP 或者局域网 IP,因此这里 upstream 中为 A 服务器上的 Web 应用服务所设置的 IP 为 172.17.0.3。

# 负载均衡服务的配置文件# load-balancer.confupstream servers {server 172.17.0.3:8080; # Docker 容器间通信,需用此 IPserver B;server C;}server {listen 80;server\_name localhost;location / {proxy\_pass http://servers;}}# 负载均衡服务的 DockerfileFROM nginx:latestRUN rm /etc/nginx/nginx.confRUN rm /etc/nginx/conf.d/default.confCOPY ./nginx.conf /etc/nginx/nginx.confCOPY ./conf.d/load-balancer.conf /etc/nginx/conf.d/load-balancer.confWeb 应用用于 Web 应用服务的 Nginx 镜像,其配置文件及 Dockerfile 如下所示。

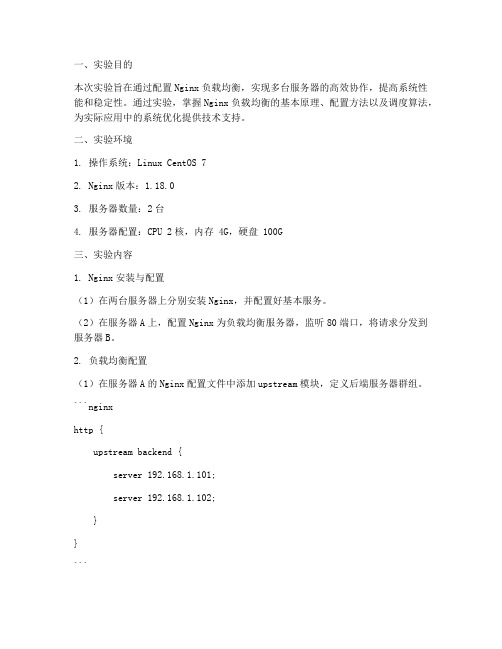

负载均衡配置实验报告

一、实验目的本次实验旨在通过配置Nginx负载均衡,实现多台服务器的高效协作,提高系统性能和稳定性。

通过实验,掌握Nginx负载均衡的基本原理、配置方法以及调度算法,为实际应用中的系统优化提供技术支持。

二、实验环境1. 操作系统:Linux CentOS 72. Nginx版本:1.18.03. 服务器数量:2台4. 服务器配置:CPU 2核,内存 4G,硬盘 100G三、实验内容1. Nginx安装与配置(1)在两台服务器上分别安装Nginx,并配置好基本服务。

(2)在服务器A上,配置Nginx为负载均衡服务器,监听80端口,将请求分发到服务器B。

2. 负载均衡配置(1)在服务器A的Nginx配置文件中添加upstream模块,定义后端服务器群组。

```nginxhttp {upstream backend {server 192.168.1.101;server 192.168.1.102;}}```(2)配置轮询负载均衡算法,将请求均匀分配到后端服务器。

```nginxserver {listen 80;server_name localhost;location / {proxy_pass http://backend;}}```(3)设置权重,调整请求分配比例。

```nginxupstream backend {server 192.168.1.101 weight=1;server 192.168.1.102 weight=2;}```3. 负载均衡测试(1)在客户端浏览器输入服务器A的IP地址,查看访问效果。

(2)使用压力测试工具(如ApacheBench)对服务器A进行压力测试,观察负载均衡效果。

4. 负载均衡优化(1)配置健康检查,确保请求分配给健康的后端服务器。

```nginxhttp {upstream backend {server 192.168.1.101 weight=1;server 192.168.1.102 weight=2;server 192.168.1.103 down;server 192.168.1.104 weight=1;}}```(2)配置连接超时,优化请求处理速度。

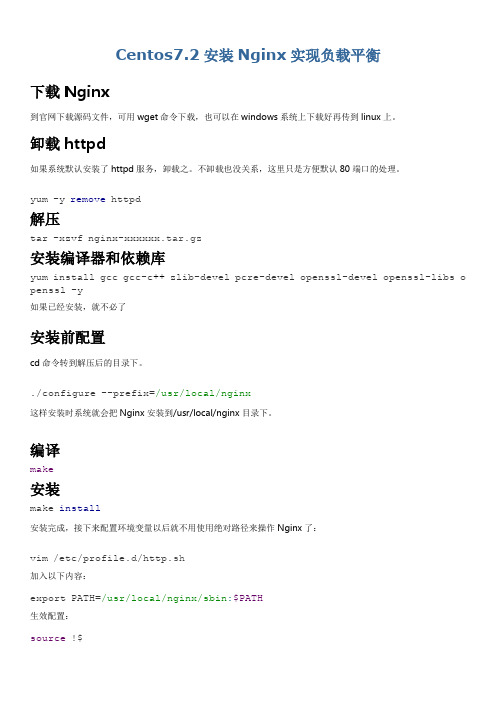

Centos7.2安装Nginx实现负载平衡

Centos7.2安装Nginx实现负载平衡下载Nginx到官网下载源码文件,可用wget命令下载,也可以在windows系统上下载好再传到linux上。

卸载httpd如果系统默认安装了httpd服务,卸载之。

不卸载也没关系,这里只是方便默认80端口的处理。

yum -y remove httpd解压tar -xzvf nginx-xxxxxx.tar.gz安装编译器和依赖库yum install gcc gcc-c++ zlib-devel pcre-devel openssl-devel openssl-libs o penssl -y如果已经安装,就不必了安装前配置cd命令转到解压后的目录下。

./configure --prefix=/usr/local/nginx这样安装时系统就会把Nginx安装到/usr/local/nginx目录下。

编译make安装make install安装完成,接下来配置环境变量以后就不用使用绝对路径来操作Nginx了:vim /etc/profile.d/http.sh加入以下内容:export PATH=/usr/local/nginx/sbin:$PATH生效配置:source !$启动Nginxnginxnginx -s 后跟stop、reload来关闭和重载nginx,直接运行nginx则启动服务。

如果启动时提示端口被占用,则需要找出被占用的进程,或者更改/usr/local/nginx/conf/nginx.conf文件里的侦听端口。

访问Nginx在浏览器上输入http://ip:port如果出现“Welcome to nginx!”字样,则证明安装成功。

如果访问不了,先确认防火墙是否禁止相应端口了。

负载平衡配置示例#user nobody;worker_processes 2;#error_log logs/error.log;#error_log logs/error.log notice;#error_log logs/error.log info;#pid logs/nginx.pid;events {accept_mutex on; #设置网路连接序列化,防止惊群现象发生,默认为onmulti_accept on; #设置一个进程是否同时接受多个网络连接,默认为offworker_connections 1024;#最大连接数}http {include mime.types;#文件扩展名与文件类型映射表,此映射表主要用于部署在本nginx上的静态资源default_type application/octet-stream;#日志格式log_format main '$remote_addr - $remote_user [$time_local] "$request" ''$status $body_bytes_sent "$http_referer" ''"$http_user_agent""$http_x_forwarded_for"';access_log logs/access.log main;sendfile on;#tcp_nopush on;keepalive_timeout 65;#连接超时时间gzip on;#反向代理#【配置1】此配置是[配置4]和[配置5]的结合#此配置将请求转发到两个WEB服务器,根据客户端IP分配目标主机,同时按权重分配流量upstream app1 {ip_hash;server 192.168.14.132:8080 weight=5;server 192.168.14.133:80 weight=3;}#【配置2】#默认负载平衡配置,nginx应用HTTP负载平衡来分发请求。

简单的NGINX负载均衡例子

简单的Nginx负载均衡

相好娃2016-12-02

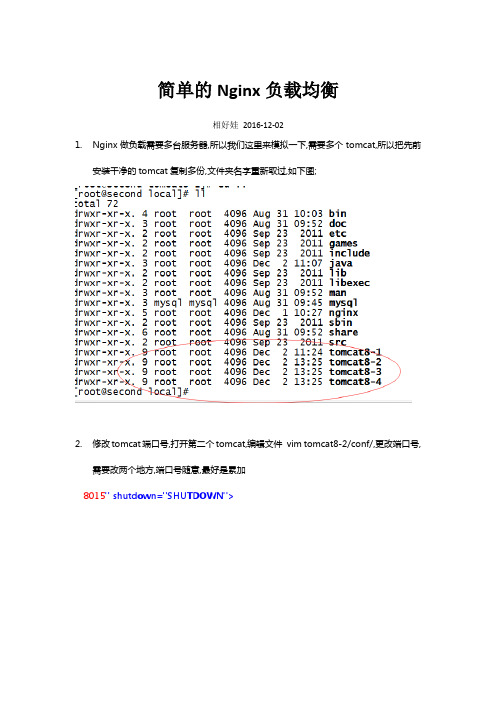

1.Nginx做负载需要多台服务器,所以我们这里来模拟一下,需要多个tomcat,所以把先前

安装干净的tomcat复制多份,文件夹名字重新取过,如下图;

2.修改tomcat端口号,打开第二个tomcat,编辑文件vim tomcat8-2/conf/,更改端口号,

需要改两个地方,端口号随意,最好是累加

8015" shutdown="SHUTDOWN">

/sbin/nginx -s reload

3.启动后,访问机器IP,不加端口默认访问80端口,也就是nginx,会被转到服务器组上;轮流

访问两台TOMCAT;刷新页面即可以看到效果;

TOMCAT1

TOMCAT2

到这里说明负载已经起作用了;下一篇会结合一个WEB应用对nginx的配置作进一步的了解;

END。

Nginx服务器之负载均衡策略(6种)

Nginx服务器之负载均衡策略(6种)⼀、关于Nginx的负载均衡 在服务器集群中,Nginx起到⼀个代理服务器的⾓⾊(即反向代理),为了避免单独⼀个服务器压⼒过⼤,将来⾃⽤户的请求转发给不同的服务器。

详情请查看我的。

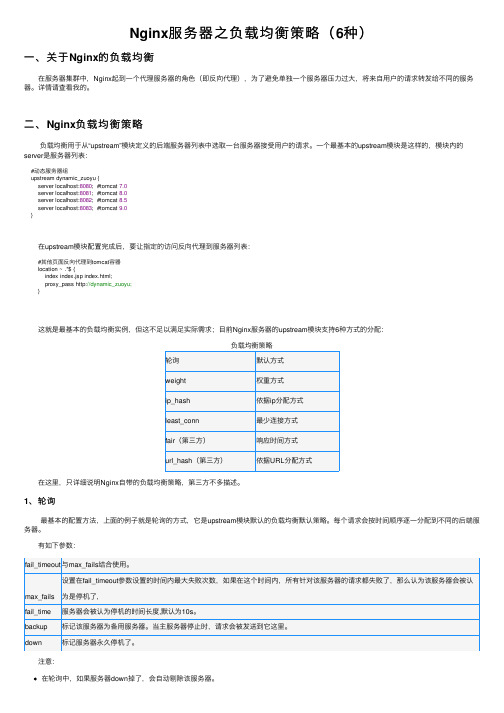

⼆、Nginx负载均衡策略 负载均衡⽤于从“upstream”模块定义的后端服务器列表中选取⼀台服务器接受⽤户的请求。

⼀个最基本的upstream模块是这样的,模块内的server是服务器列表:#动态服务器组upstream dynamic_zuoyu {server localhost:8080; #tomcat 7.0server localhost:8081; #tomcat 8.0server localhost:8082; #tomcat 8.5server localhost:8083; #tomcat 9.0} 在upstream模块配置完成后,要让指定的访问反向代理到服务器列表:#其他页⾯反向代理到tomcat容器location ~ .*$ {index index.jsp index.html;proxy_pass http://dynamic_zuoyu;} 这就是最基本的负载均衡实例,但这不⾜以满⾜实际需求;⽬前Nginx服务器的upstream模块⽀持6种⽅式的分配:负载均衡策略轮询默认⽅式weight权重⽅式ip_hash依据ip分配⽅式least_conn最少连接⽅式fair(第三⽅)响应时间⽅式url_hash(第三⽅)依据URL分配⽅式 在这⾥,只详细说明Nginx⾃带的负载均衡策略,第三⽅不多描述。

1、轮询 最基本的配置⽅法,上⾯的例⼦就是轮询的⽅式,它是upstream模块默认的负载均衡默认策略。

每个请求会按时间顺序逐⼀分配到不同的后端服务器。

有如下参数:fail_timeout与max_fails结合使⽤。

max_fails 设置在fail_timeout参数设置的时间内最⼤失败次数,如果在这个时间内,所有针对该服务器的请求都失败了,那么认为该服务器会被认为是停机了,fail_time服务器会被认为停机的时间长度,默认为10s。

Nginx负载均衡的详细配置及使用案例详解.

Nginx负载均衡的详细配置及使⽤案例详解.感谢看过这⼀些列博⽂和评论的⼩伙伴, 我把⾃⼰所看到的学到的拿到这⾥来分享是想和⼤家⼀起学习进步, 想听听园友给出的意见, 也是对⾃⼰学习过程的⼀个总结.技术⽆⽌境, 我们仍需努⼒!1,话不多说, 这⾥我们来说下很重要的负载均衡, 那么什么是负载均衡呢?由于⽬前现有⽹络的各个核⼼部分随着业务量的提⾼,访问量和数据流量的快速增长,其处理能⼒和计算强度也相应地增⼤,使得单⼀的服务器设备根本⽆法承担。

在此情况下,如果扔掉现有设备去做⼤量的硬件升级,这样将造成现有资源的浪费,⽽且如果再⾯临下⼀次业务量的提升时,这⼜将导致再⼀次硬件升级的⾼额成本投⼊,甚⾄性能再卓越的设备也不能满⾜当前业务量增长的需求。

针对此情况⽽衍⽣出来的⼀种廉价有效透明的⽅法以扩展现有⽹络设备和服务器的带宽、增加吞吐量、加强⽹络数据处理能⼒、提⾼⽹络的灵活性和可⽤性的技术就是负载均衡(Load Balance)。

2, 负载均衡的种类1)⼀种是通过硬件来进⾏解决,常见的硬件有NetScaler、F5、Radware和Array等商⽤的负载均衡器,但是它们是⽐较昂贵的2)⼀种是通过软件来进⾏解决的,常见的软件有LVS、Nginx、apache等,它们是基于Linux系统并且开源的负载均衡策略.3, 这⾥我们只来说Nginx(其他的⼤家有兴趣可以⾃⾏查阅相关⽂档)Nginx(发⾳同 engine x)是⼀款轻量级的Web 服务器/反向代理服务器及电⼦邮件(IMAP/POP3)代理服务器,并在⼀个BSD-like 协议下发⾏。

由俄罗斯的程序设计师Igor Sysoev(伊⼽尔·西索夫)所开发,供俄国⼤型的⼊⼝⽹站及搜索引擎Rambler(漫步者)(俄⽂:Рамблер)使⽤。

其特点是占有内存少,并发能⼒强,事实上nginx的并发能⼒确实在同类型的⽹页服务器中表现较好,中国⼤陆使⽤nginx⽹站⽤户有:新浪、⽹易、腾讯等。

nginx集群:nginx配置负载均衡集群(nginx1.18.0)

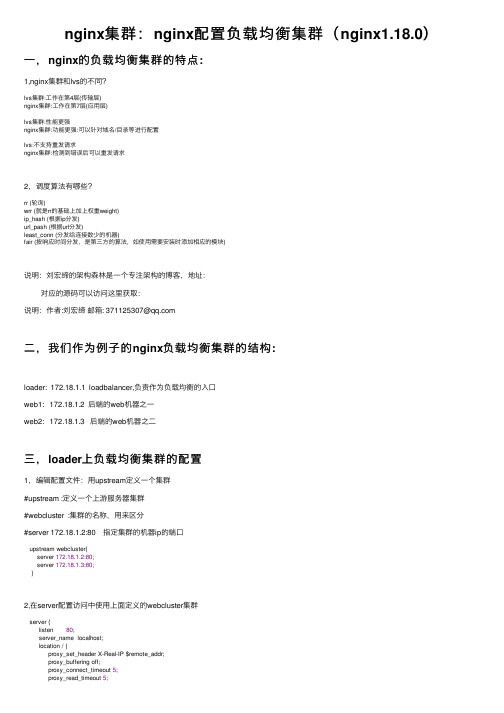

nginx集群:nginx配置负载均衡集群(nginx1.18.0)⼀,nginx的负载均衡集群的特点:1,nginx集群和lvs的不同?lvs集群:⼯作在第4层(传输层)nginx集群:⼯作在第7层(应⽤层)lvs集群:性能更强nginx集群:功能更强:可以针对域名/⽬录等进⾏配置lvs:不⽀持重发请求nginx集群:检测到错误后可以重发请求2,调度算法有哪些?rr (轮询)wrr (就是rr的基础上加上权重weight)ip_hash (根据ip分发)url_pash (根据url分发)least_conn (分发给连接数少的机器)fair (按响应时间分发,是第三⽅的算法,如使⽤需要安装时添加相应的模块)说明:刘宏缔的架构森林是⼀个专注架构的博客,地址:对应的源码可以访问这⾥获取:说明:作者:刘宏缔邮箱: 371125307@⼆,我们作为例⼦的nginx负载均衡集群的结构:loader: 172.18.1.1 loadbalancer,负责作为负载均衡的⼊⼝web1: 172.18.1.2 后端的web机器之⼀web2: 172.18.1.3 后端的web机器之⼆三,loader上负载均衡集群的配置1,编辑配置⽂件:⽤upstream定义⼀个集群#upstream :定义⼀个上游服务器集群#webcluster :集群的名称,⽤来区分#server 172.18.1.2:80 指定集群的机器ip的端⼝upstream webcluster{server 172.18.1.2:80;server 172.18.1.3:80;}2,在server配置访问中使⽤上⾯定义的webcluster集群server {listen 80;server_name localhost;location / {proxy_set_header X-Real-IP $remote_addr;proxy_buffering off;proxy_connect_timeout 5;proxy_read_timeout 5;proxy_send_timeout 5;proxy_pass http://webcluster;}}3,配置中各个指令的说明:proxy_pass将代理转发给上⽅ upstream 中配置的集群中的两台服务器去处理X-Real-IP⽤来得到真实ip,否则在后端看到的都是loader的ipproxy_set_header X-Real-IP $remote_addr;proxy_buffering默认值是on,这⾥我们把它关闭,off它负责开启从后端被代理服务器的响应body缓冲,我们需要从后端服务器按收实时的数据,所以关闭proxy_connect_timeout该指令设置与upstream server的连接超时时间,默认值60s,最⾼不能超过75秒注意这个不是等待后端返回页⾯的时间(那个时长是由proxy_read_timeout变量来定义)。

学习下nginx负载均衡--深入理解nginx

学习下nginx负载均衡--深⼊理解nginx作为代理服务器,⼀般都需要向上游服务器转发请求。

这⾥的负载均衡是指通过⼀种策略尽量把请求平均的分发都上游服务器1、upstream语法 upstream name {}配置快: http栗⼦(实验通过,每次请求均匀的分布在两台机器上)upstream backend { server 192.168.1.100:8080; server 192.168.1.101:8080;}server { location / { }}2.server语法 server name [params]配置块 upstream说明:server配置项指定了⼀台上游服务器的名字,这个名字可以是域名、ip端⼝、Unix句柄等参数说明:weight=number:设置上游服务器的转发权重,默认1max_fails=number:该选项与fail_timeout配合使⽤,指在fail_timeout时间段内,如果向上游服务器转发失败次数超过numer,则认为上游服务器不可⽤,fail_timeout时间内不会再向这台上游服务器进⾏转发,默认 1,如果设置成0,则表⽰不检测失败次数。

fail_timeout:它与向上游服务器简历连接的超时时间等完全⽆关,默认 10sdown:表⽰上游服务器永久下线,只有ip_hash配置项才有⽤backup:所在的上游服务器只是备份服务器,只有所有的⾮备份服务器都失效后才向其发送请求,ip_hash设置时不起作⽤栗⼦:upstream backend {server weight=5; server 127.0.0.1: 8080 max_fails=3 fail_timeout=30s; server unix:/tmp/backend;}。

学会使用Nginx进行Web服务器配置和负载均衡

学会使用Nginx进行Web服务器配置和负载均衡Nginx(发音为engine-x)是一个高性能的开源Web服务器。

它被广泛应用于构建高性能和可靠的网站,实现负载均衡,进行反向代理,以及提供动态内容的缓存。

本文将介绍如何使用Nginx 进行Web服务器配置和负载均衡。

第一章:Nginx简介Nginx是一款轻量级的服务器,它具有卓越的性能和可扩展性。

与传统的Web服务器相比,Nginx采用了事件驱动的架构,能够处理大量的并发请求,同时占用较少的系统资源。

此外,Nginx还支持高级功能如负载均衡、反向代理和HTTPS。

第二章:安装和配置Nginx安装Nginx非常简单。

在Linux系统中,可以通过包管理器(如apt-get或yum)进行安装。

一旦安装完成,我们需要对Nginx进行基本配置。

首先,我们需要编辑Nginx的主配置文件,通常位于/etc/nginx/nginx.conf。

在此文件中,我们可以配置Nginx的全局设置,如监听的端口、日志文件的位置等。

我们还可以创建一个新的配置文件,用于特定的虚拟主机。

第三章:配置虚拟主机Nginx支持多个虚拟主机配置,每个虚拟主机都可以有独立的设置和规则。

为了配置虚拟主机,我们需要在Nginx的配置文件中添加server块。

在server块中,我们可以指定虚拟主机的监听端口、域名以及其他相关设置。

此外,我们还可以使用location块来定义URL路径的匹配规则,并指定相应的动作。

例如,我们可以将所有以/api 开头的请求转发到后端API服务器。

第四章:负载均衡负载均衡是将请求分发到多个服务器上,以实现更好的性能和可用性。

Nginx提供了多种负载均衡策略,如轮询、加权轮询和IP哈希。

要配置负载均衡,我们需要在Nginx的配置文件中添加upstream块。

在upstream块中,我们可以列出多个后端服务器,并为每个服务器指定权重。

然后,我们将这个upstream块与虚拟主机的location块关联起来,以实现请求的负载均衡。

超细腻的nginx负载均衡设置全程奉献

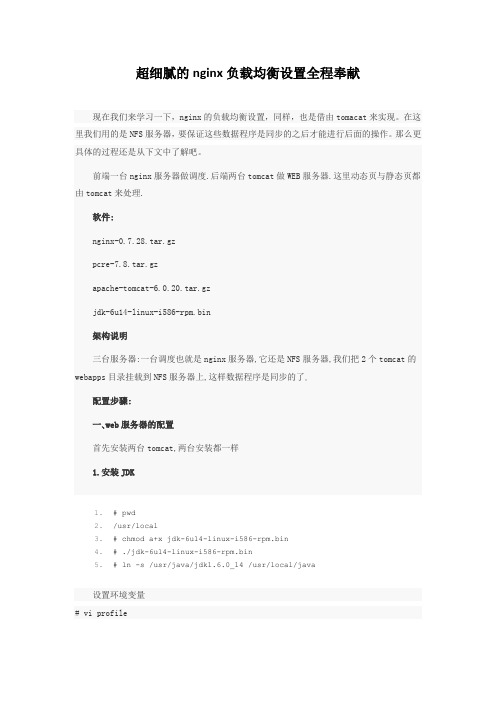

超细腻的nginx负载均衡设置全程奉献现在我们来学习一下,nginx的负载均衡设置,同样,也是借由tomacat来实现。

在这里我们用的是NFS服务器,要保证这些数据程序是同步的之后才能进行后面的操作。

那么更具体的过程还是从下文中了解吧。

前端一台nginx服务器做调度.后端两台tomcat做WEB服务器.这里动态页与静态页都由tomcat来处理.软件:nginx-0.7.28.tar.gzpcre-7.8.tar.gzapache-tomcat-6.0.20.tar.gzjdk-6u14-linux-i586-rpm.bin架构说明三台服务器:一台调度也就是nginx服务器,它还是NFS服务器,我们把2个tomcat的webapps目录挂载到NFS服务器上,这样数据程序是同步的了。配置步骤:一、web服务器的配置首先安装两台tomcat,两台安装都一样1.安装JDK1.# pwd2./usr/local3.# chmod a+x jdk-6u14-linux-i586-rpm.bin4.# ./jdk-6u14-linux-i586-rpm.bin5.# ln -s /usr/java/jdk1.6.0_14 /usr/local/java设置环境变量# vi profile末尾增加如下内容1.JAVA_HOME=/usr/java/jdk1.6.0_142.CLASSPATH=/usr/java/jdk1.6.0_14/lib/dt.jar:/usr/java/jdk1.6.0_14/lib/tools.jar3.PATH=/usr/java/jdk1.6.0_14/bin:$PATH4.export PATH JAVA_HOME CLASSPATH2.安装tomcat1.# cp apache-tomcat-6.0.20.tar.gz /usr/local/2.# cd /usr/local/3.# tar xzvf apache-tomcat-6.0.20.tar.gz4.# ln -s apache-tomcat-6.0.20 tomcat5.# vi /usr/local/tomcat/bin/catalina.sh加入一行:1.JAVA_HOME=/usr/java/jdk1.6.0_142.# /usr/local/tomcat/bin/startup.sh启动服务后访问本地的8080端口可以看到对应apache tomcat页面了把Tomcat加到自启动:# vi /etc/rc.d/rc.local在里面加入如下代码:1.export JDK_HOME=/usr/java/jdk1.6.0_142.export JAVA_HOME=/usr/java/jdk1.6.0_143./usr/local/tomcat/bin/startup.sh至此tomcat已安装成功了优化: tomcat 比如防止内存溢出; TCP/IP 比如time_wait与closed_wait等等二、安装 nginx、nfs 注意它们是一台服务器上1.安装 nginx在安装之前首先要安装pcre-7.9.tar.gz1.# tar zxvf pcre-7.9.tar.gz2.# cd pcre-7.93.# ./configure4.# make && make install安装nginx1.# tar zxvf nginx-0.7.61.tar.gz2.# cd nginx-0.7.613.# ./configure --with-http_stub_status_module --prefix=/usr/local/nginx4.# make && make install修改nginx的配置文件我这里是把原先的重命名然后新建了一个nginx.conf1.#vi nginx.confer nobody nobody;3.worker_processes 8;4.pid /usr/local/nginx/logs/nginx.pid;5.worker_rlimit_nofile 51200;6.events7.{e epoll;9.worker_connections 51200;10.}11.http{12.includemime.types;13.default_type application/octet-stream;14.server_names_hash_bucket_size 128;15.client_header_buffer_size 32k;rge_client_header_buffers 4 32k;17.client_max_body_size 8m;18.19.sendfile on;20.tcp_nopush on;21.keepalive_timeout 60;22.tcp_nodelay on;23.fastcgi_connect_timeout 300;24.fastcgi_send_timeout 300;25.fastcgi_read_timeout 300;26.fastcgi_buffer_size 64k;27.fastcgi_buffers 4 64k;28.fastcgi_busy_buffers_size 128k;29.fastcgi_temp_file_write_size 128k;30.gzip on;31.gzip_min_length 1k;32.gzip_buffers 4 16k;33.gzip_http_version 1.0;34.gzip_comp_level 2;35.gzip_typestext/plain application/x-javascript text/css application/xml;36.gzip_vary on;37.#设定负载均衡列表38.upstream backend39.{40.server 192.168.100.89:8080;41.server 192.168.100.90:8080;42.}43.#设定虚拟主机44.server {45.listen 80;46.server_name ;47.#对 / 所有做负载均衡 (本机nginx采用完全转发,所有请求都转发到后端的tomcat集群)48.location / {49.root /var/www ;50.index index.jsp index.htm index.html;51.proxy_redirect off;52.#保留用户真实信息53.proxy_set_header Host $host;54.proxy_set_header X-Real-IP $remote_addr;55.proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;56.proxy_pass http://backend;57.}58.59.#location /nginx {60.#access_log on;61.#auth_basic "NginxStatus";62.#auth_basic_user_file /usr/local/nginx/htpasswd;63.#}64.log_format access '$remote_addr - $remote_user [$time_local] "$request" '65.'$status $body_bytes_sent "$http_referer" '66.'"$http_user_agent" $http_x_forwarded_for';67.access_log /var/log/access.log access;68.}69.}检查nginx的配置文件# /usr/local/webserver/nginx/sbin/nginx -t启动nginx# /usr/local/webserver/nginx/sbin/nginx重启nginx# kill -HUP `cat /usr/local/nginx/logs/nginx.pid`(1)查看负载均衡信息location /nginx {stub_status on;access_log on;auth_basic "NginxStatus";auth_basic_user_file /usr/local/nginx/htpasswd;}其中/usr/local/nginx/htpasswd可以用apache自带的功能生成。最后在IE里访问:/nginx, 然后输入用户名密码就进入了。进入之后的说明输入地址/nginx/,输入验证帐号密码,即可看到类似如下内容:Active connections: 328server accepts handled requests9309 8982 28890Reading: 1 Writing: 3 Waiting: 324第一行表示目前活跃的连接数第三行的第三个数字表示Nginx运行到当前时间接受到的总请求数,如果快达到了上限,就需要加大上限值了。第四行是Nginx的队列状态(2)负载均衡upstream backend{server 192.168.100.89:8080;server 192.168.100.90:8080;}三、配置NFS需要安装rpm包portmap、nfs,1.# vi /etc/export2./var/www 192.168.100.89(rw,sync,no_root_squash),192.168.100.90(rw,sync,no_root_squash)3.# service portmap restart4.# service nfs start5.# exportfs -rv重新输出共享目录,# showmoun -e查看本机共享的目录然后tomcat的两台服务器挂载,# mount 192.168.100.88:/var/www /usr/local/tomcat/weapps然后我们要在两台tomcat的配置文件中即server.xml中做虚拟主机要与nginx.conf 里的一致才OK。

NGINX负载均衡实战教程

NGINX负载均衡实战教程nginx调度算法解析1、轮询(默认)每个请求按时间顺序逐⼀分配到不同的后端服务,如果后端某台服务器死机,⾃动剔除故障系统,使⽤户访问不受影响。

2、weight(轮询权值)weight的值越⼤分配到的访问概率越⾼,主要⽤于后端每台服务器性能不均衡的情况下。

或者仅仅为在主从的情况下设置不同的权值,达到合理有效的地利⽤主机资源。

注意:此算法为常⽤的算法3、ip_hash每个请求按访问IP的哈希结果分配,使来⾃同⼀个IP的访客固定访问⼀台后端服务器,并且可以有效解决动态⽹页存在的session共享问题。

4、fair⽐ weight、ip_hash更加智能的负载均衡算法,fair算法可以根据页⾯⼤⼩和加载时间长短智能地进⾏负载均衡,也就是根据后端服务器的响应时间来分配请求,响应时间短的优先分配。

Nginx本⾝不⽀持fair,如果需要这种调度算法,则必须安装upstream_fair模块5、url_hash按访问的URL的哈希结果来分配请求,使每个URL定向到⼀台后端服务器,可以进⼀步提⾼后端缓存服务器的效率。

Nginx本⾝不⽀持url_hash,如果需要这种调度算法,则必须安装Nginx的hash软件包。

实验环境说明:nginx/1.13.3 centos7-3.10.0-693.11.1.el7负载均衡服务器lb01:192.168.199.244节点服务器web01:192.168.100.238节点服务器web02:192.168.100.220节点服务器web03:192.168.100.221⼀、负载服务器配置1.nginx.c o nfuser nginx;worker_processes 1;pid /run/nginx.pid;include /etc/nginx/modules-enabled/*.conf;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;upstream default_pools { 负载均衡代理池01server 192.168.100.238:80 weight=1;}upstream static_pools { 负载均衡代理池02server 192.168.100.220:80 weight=1;}upstream upload_pools { 负载均衡代理池03server 192.168.100.221:80 weight=1;}server {autoindex on;server_name ;location / {proxy_pass http://default_pools;}location /static/ {proxy_pass http://static_pools;}location /upload/ {proxy_pass http://upload_pools;}}}2.ho sts解析192.168.199.244 ⼆、web01user nginx;worker_processes 1;pid /run/nginx.pid;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;server {listen 80;server_name localhost;root /usr/share/nginx/www;index proxy.html;}}在web01的站点⽬录/usr/share/nginx/www下新增proxy.html⽂件proxy.hmtl内容如下:192.168.100.238.default.html三、web02user nginx;worker_processes 1;pid /run/nginx.pid;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;server {listen 80;server_name localhost;root /usr/share/nginx/www;location /static/ {index proxy.html;}}}在web01的站点⽬录/usr/share/nginx/www下新增static⽬录,并在该⽬录下新增proxy.html⽂件proxy.hmtl内容如下:193.192.168.100.220-static.html四、web03user nginx;worker_processes 1;pid /run/nginx.pid;events {worker_connections 768;}http {include /etc/nginx/mime.types;default_type application/octet-stream;sendfile on;server {listen 80;server_name localhost;root /usr/share/nginx/www;location /upload/ {index proxy.html;}}}在web01的站点⽬录/usr/share/nginx/www下新增upload⽬录,并在该⽬录下新增proxy.html⽂件proxy.hmtl内容如下:192.168.100.221.upload.html五、实验结果192.168.199.244下执⾏curl 192.168.100.238.default.htmlcurl /upload/192.168.100.221.upload.htmlcurl /static/192.168.100.220-static.html注意点web节点在收到负载均衡服务器的请求时,会把节点下的第⼀个虚拟主机发给了反向代理,解决这个问题的办法就是在负载均衡服务器server标签内引⽤如下模块proxy_set_header Host $host⽇志格式中头部为负载均衡服务器的IP,想要设置为真实⽤户的IP,需要再负载均衡服务器server标签内引⽤如下模块,同时,节点服务器下的⽇志格式也要加⼊该⾏proxy_set_header X-Forwarded-For $remote_addr其他种类负载均衡本⽂中是根据URL⽬录的内容来实现转发;还有其他的,例如根据⽤户设备的种类来实现代理转发,这⾥可以引⽤http_user_agent模块来实现,这⾥就不举例说明了。

Nginx负载均衡如何进行配置-值得-博客园

Nginx负载均衡如何进行配置-值得-博客园Nginx负载均衡是一个很神奇的技术,很多人都不能很好的掌握这个技术,今天在这里我们向大家详细的介绍下有关Nginx负载均衡的问题。

今天小试了一下Nginx负载均衡,真是爽啊!Nginx是什么?Nginx (”engine x”) 是一个高性能的 HTTP 和反向代理服务器,也是一个 IMAP/POP3/SMTP 代理服务器。

Nginx 是由 Igor Sysoev 为俄罗斯访问量第二的 Rambler.ru 站点开发的,它已经在该站点运行超过两年半了。

Igor 将源代码以类BSD许可证的形式发布。

尽管还是测试版,但是,Nginx 已经因为它的稳定性、丰富的功能集、示例配置文件和低系统资源的消耗而闻名了。

首先是配置十分的简单,而且功能非常强大。

真是相见恨晚。

先来看看配置文件怎么写吧1.worker_processes 1;2.events {3.worker_connections 1024;4.}5.http{6.upstream myproject {7.#这里指定多个源服务器,ip:端口,80端口的话可写可不写8.server 192.168.43.158:80;9.server 192.168.41.167;10.}11.server {12.listen 8080;13.location / {14.proxy_pass http://myproject;15.}16.}17.}Nginx负载均衡有哪些功能呢?如果后面的服务器其中一台坏了,它能自动识别,更牛的是它好了之后Nginx可以马上识别服务器A和B,如果A的响应时间为3,B的响应时间为1,那么Nginx会自动调整访问B的概率是A的3倍,真正做到Nginx负载均衡好的,安装完成了。

我在make的时候报了个错,说HTTP Rewrite 模块有问题,我就./configure –without-http_rewrite_module然后再 make,make install就可以了。

Nginx高可用负载均衡部署文档V102

Nginx高可用负载均衡部署文档V102 Nginx高可用负载均衡部署文档V102

一、Nginx高可用+负载均衡部署概述

这里我们采用软硬混合方式,使用Nginx作为反向代理,HAProxy实现负载均衡,实现Nginx的高可用+负载均衡部署。

二、Nginx高可用+负载均衡实现原理

1、Nginx高可用+负载均衡,将客户端访问的请求先代理到HAProxy 服务器,HAProxy将请求通过负载均衡算法轮询分配给Nginx服务器,客户端经过HAProxy实现了负载均衡,同时使用Nginx实现反向代理进行高可用。

2、为了在Nginx服务器出现问题的时候能够第一时间被发现,可以使用健康检查工具,例如keepalived,实现Nginx服务器之间的健康检查,当有Nginx服务出现问题的时候,及时将其剔除出HAProxy的可用Nginx列表,实现Nginx的高可用。

三、Nginx高可用+负载均衡部署步骤

1、准备硬件

首先,准备一台安装HAProxy的负载均衡服务器,和若干台安装Nginx的web服务器,为了实现高可用,Nginx服务器最好是偶数台,奇数台。

使用nginx作HTTP负载均衡

使用nginx作HTTP负载均衡1. 介绍在许多应用中,负载平衡是一种常用的技术来优化利用资源最大化吞吐量,减少等待时间,并确保容错。

可以使用nginx的作为一种非常高效的HTTP负载平衡器,将流量分配到多个应用服务器上提高性能,可扩展性和高可用性。

2. 负载均衡方法nginx支持下面几种负载均衡机制:∙round-robin:轮询。

以轮询方式将请求分配到不同服务器上∙least-connected:最少连接数。

将下一个请求分配到连接数最少的那台服务器上∙ip-hash :基于客户端的IP地址。

散列函数被用于确定下一个请求分配到哪台服务器上3. 负载均衡默认配置nginx负载均衡最简单的配置如下:http {upstream myapp1 {server ;server ;server ;}server {listen 80;location / {proxy_pass http://myapp1;}}}在上面的例子中,srv1,srv2,srv3运行着相同的应用程序。

如果没有特别指定负载均衡方法默认是以轮询方式。

所有的请求被代理到服务组myapp1,然后nginx负载均衡的分发请求。

nginx反向代理实现包括下面这些负载均衡HTTP、HTTPS、FastCGI、uwsgi,SCGI 和memcached。

要配置HTTPS的负载均衡,只需使用“https”开头的协议。

当要设置FastCGI,uwsgi,SCGI,或者memcached的负载平衡,分别使用fastcgi_pass,uwsgi_pass,scgi_pass和memcached_pass指令。

4. 最少连接负载均衡在一些要求需要更长的时间才能完成的应用情况下,最少连接可以更公平地控制应用程序实例的负载。

使用最少连接负载均衡,nginx不会向负载繁忙的服务器上分发请求,而是将请求分发到负载低的服务器上。

配置如下:upstream myapp1 {least_conn;server ;server ;server ;}5. 会话持久性以轮询或最少连接的负载均衡算法,每个后续的客户端的请求,可以潜在地分配给不同的服务器上,并不能保证相同的客户端请求将总是指向同一服务器上。

Nginx负载均衡策略详解及应用场景

Nginx负载均衡策略详解及应用场景

nginx的负载均衡策略可以大致分为两大类:内置策略和扩展策略。

内置策略一般会直接编译进Nginx内核,常用的有轮询、加权轮询、最少连接平衡和ip_hash策略。

轮询策略是Nginx的默认策略,它将用户的请求按轮回的方式分配给各个服务器,保证了各个服务器接收到的用户请求均匀。

然而,在实际生产的过程中,每台服务器的性能和硬件配置可能会不同,如果采用该种方式,不论是性能较好的服务器还是性能较差的服务器都会承受相同的压力。

最少连接平衡策略则是根据服务器的已处理连接数来进行负载均衡,连接数少的服务器将优先接收到新的请求。

ip_hash策略则是根据客户端的IP地址进行哈希计算,然后根据哈希值将请求分配给特定的服务器。

这样可以保证同一客户端的请求始终被同一台服务器处理,对于需要保持会话一致性的应用场景非常适用。

扩展策略包括fair、url hash、Sticky等,这些策略默认不编译进nginx内核,需要额外配置。

例如,fair策略会根据服务器的处理能力进行负载均衡,性能好的服务器将优先接收到新的请求。

以上就是Nginx的负载均衡策略详解,不同的应用场景需要采用不同的策略,可以根据实际情况进行选择。

Nginx负载均衡配置

Nginx 负载均衡配置详解一、测试环境由于没有服务器,所以本次测试直接host指定域名(my.local)测试域名:my.localA服务器:172.16.10.181 (主服务器)B服务器:172.16.10.131C服务器:172.16.10.130二、域名解析由于不是真实环境,域名就随便使用一个my.local用作测试,所以my.local的解析只能在hosts文件设置。

打开:C:\Windows\System32\drivers\etc\hosts在末尾添加172.16.10.181 my.local保存退出,然后启动命令模式ping下看看是否已设置成功,如下图三、Nginx配置1)A服务器(主服务器)nginx.conf配置打开nginx.conf,文件位置在nginx安装目录的conf目录下。

在http段加入以下代码upstream my.local {ip_hash; #默认可以不加,加上此行则已ip_hash方式进行负载均衡 #weight为权重,数字越大权重越高server 172.16.10.131:80 weight=1;server 172.16.10.130:80 weight=1;}server{listen 80;server_name my.local;location / {proxy_pass http://my.local;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;}}保存重启nginx(/usr/local/nginx/sbin/nginx -s reload)2)B、C服务器nginx.conf设置打开nginx.conf,文件位置在nginx安装目录的conf目录下。

Nginx负载均衡的4种方案配置实例

Nginx负载均衡的4种⽅案配置实例1、轮询轮询即Round Robin,根据Nginx配置⽂件中的顺序,依次把客户端的Web请求分发到不同的后端服务器。

配置的例⼦如下:http{upstream sampleapp {server <<dns entry or IP Address(optional with port)>>;server <<another dns entry or IP Address(optional with port)>>;}....server{listen 80;...location / {proxy_pass http://sampleapp;}}上⾯只有1个DNS⼊⼝被插⼊到upstream节,即sampleapp,同样也在后⾯的proxy_pass节重新提到。

2、最少连接Web请求会被转发到连接数最少的服务器上。

配置的例⼦如下:http{upstream sampleapp {least_conn;server <<dns entry or IP Address(optional with port)>>;server <<another dns entry or IP Address(optional with port)>>;}....server{listen 80;...location / {proxy_pass http://sampleapp;}}上⾯的例⼦只是在upstream节添加了least_conn配置。

其它的配置同轮询配置。

3、IP地址哈希前述的两种负载均衡⽅案中,同⼀客户端连续的Web请求可能会被分发到不同的后端服务器进⾏处理,因此如果涉及到会话Session,那么会话会⽐较复杂。

常见的是基于数据库的会话持久化。

要克服上⾯的难题,可以使⽤基于IP地址哈希的负载均衡⽅案。

Nginx负载均衡配置说明

一.N ginx简述:1.概述Nginx是一款轻量级的网页服务器、反向代理器以及电子邮件代理服务器。

其将源代码以类BSD许可证的形式发布,因它的稳定性、丰富的功能集、示例配置文件和低系统资源的消耗而闻名。

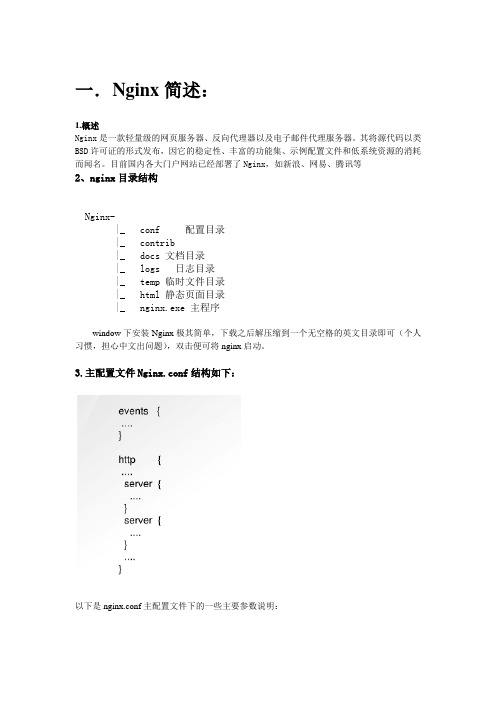

目前国内各大门户网站已经部署了Nginx,如新浪、网易、腾讯等2、nginx目录结构Nginx-|_ conf 配置目录|_ contrib|_ docs 文档目录|_ logs 日志目录|_ temp 临时文件目录|_ html 静态页面目录|_ nginx.exe 主程序window下安装Nginx极其简单,下载之后解压缩到一个无空格的英文目录即可(个人习惯,担心中文出问题),双击便可将nginx启动。

3.主配置文件Nginx.conf结构如下:以下是nginx.conf主配置文件下的一些主要参数说明:二.为什么选择NginxNginx 是一个很牛的高性能Web和反向代理服务器, 它具有有很多非常优越的特性:在高连接并发的情况下,Nginx是Apache服务器不错的替代品: Nginx在美国是做虚拟主机生意的老板们经常选择的软件平台之一. 能够支持高达50,000 个并发连接数的响应, 感谢Nginx为我们选择了epoll and kqueue作为开发模型.∙Nginx作为负载均衡服务器: Nginx 既可以在内部直接支持Rails和PHP程序对外进行服务, 也可以支持作为HTTP代理服务器对外进行服务. Nginx采用C进行编写, 不论是系统资源开销还是CPU使用效率都比Perlbal要好很多.∙作为邮件代理服务器: Nginx 同时也是一个非常优秀的邮件代理服务器(最早开发这个产品的目的之一也是作为邮件代理服务器), Last.fm描述了成功并且美妙的使用经验.三.Nginx反向代理与负载均衡配置:Nginx proxy反向代理是Nginx的王牌功能,它具有一些特色:1.功能强大,性能卓越,运行稳定2.配置简单灵活3.能够自动剔除工作不正常的后端服务器4.上传文件使用异步模式5.支持多种分配策略,可以分配权重,分配方式灵活反向代理配置,修改nginx主配置文件nginx.conf,在http全局配置部分加入以下内容:加入上内容后,还要在nginx主配置文件的server中找到location/配置部分做如下修改:Nginx的upstream目前支持5中方式的分配:1.轮询(默认:每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器down掉,能自动剔除。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

保存重启nginx

upstream {

server 192.168.5.150:80;

server 192.168.5.151:80;

}

server{

listen 80;

server_name ;

location / {

பைடு நூலகம்

二、多台服务器提供服务,但域名只解析到主服务器,而真正的服务器IP不会被ping下即可获得,增加一定安全性。

三、upstream里的IP不一定是内网,外网IP也可以。不过经典的案例是,局域网中某台IP暴露在外网下,域名直接解析到此IP。然后又这台主服务器转发到内网服务器IP中。

四、某台服务器宕机、不会影响网站正常运行,Nginx不会把请求转发到已宕机的IP上

既然能正常访问,那么我们就可以把主服务器添加到upstream中,但是端口要改一下,如下代码:

upstream {

server 192.168.5.126:80;

server 192.168.5.27:80;

server 127.0.0.1:8080;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

保存重启nginx

在192.168.5.150与192.168.5.151机器上设置nginx,打开nginx.conf在末尾添加以下代码:

C服务器IP :192.168.5.126

我们把域名解析到A服务器,然后由A服务器转发到B服务器与C服务器,那么A服务器只做一个转发功能,现在我们让A服务器也提供站点服务。

我们先来分析一下,如果添加主服务器到upstream中,那么可能会有以下两种情况发生:

1、主服务器转发到了其它IP上,其它IP服务器正常处理;

proxy_pass ;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

server{

listen 8080;

server_name ;

index index.html;

root /data0/htdocs/www;

}

重启nginx,在浏览器输入:8080试试看能不能访问。结果可以正常访问

server{

listen 80;

server_name ;

index index.html;

root /data0/htdocs/www;

}

保存重启nginx

完成以后步骤后即可实现的负载均衡配置。

主服务器不能提供服务吗?

B、C服务器nginx.conf设置

打开nginx.confi,在http段加入以下代码

server{

listen 80;

server_name ;

index index.html;

root /data0/htdocs/www;

}

2、主服务器转发到了自己IP上,然后又进到主服务器分配IP那里,假如一直分配到本机,则会造成一个死循环。

怎么解决这个问题呢?因为80端口已经用来监听负载均衡的处理,那么本服务器上就不能再使用80端口来处理的访问请求,得用一个新的。于是我们把主服务器的nginx.conf加入以下一段代码:

测试环境

由于没有服务器,所以本次测试直接host指定域名,然后在VMware里安装了三台CentOS。

测试域名 :

A服务器IP :192.168.5.149 (主)

B服务器IP :192.168.5.27

C服务器IP :192.168.5.126

部署思路

A服务器做为主服务器,域名直接解析到A服务器(192.168.5.149)上,由A服务器负载均衡到B服务器(192.168.5.27)与C服务器(192.168.5.126)上。

B服务器处理页面

C服务器处理页面

假如其中一台服务器宕机会怎样?

当某台服务器宕机了,是否会影响访问呢?

我们先来看看实例,根据以上例子,假设C服务器192.168.5.126这台机子宕机了(由于无法模拟宕机,所以我就把C服务器关机)然后再来访问看看。

访问结果:

我们发现,虽然C服务器(192.168.5.126)宕机了,但不影响网站访问。这样,就不会担心在负载均衡模式下因为某台机子宕机而拖累整个站点了。

域名解析

由于不是真实环境,域名就随便使用一个用作测试,所以的解析只能在hosts文件设置。

打开:C:WindowsSystem32driversetchosts

在末尾添加

192.168.5.149

保存退出,然后启动命令模式ping下看看是否已设置成功

server 192.168.5.27:80;

}

server{

listen 80;

server_name ;

location / {

proxy_pass ;

proxy_set_header Host $host;

}

由于这里可以添加主服务器IP192.168.5.149或者127.0.0.1均可以,都表示访问自己。

重启Nginx,然后再来访问看看会不会分配到主服务器上。

主服务器也能正常加入服务了。

最后

一、负载均衡不是nginx独有,著名鼎鼎的apache也有,但性能可能不如nginx。

以上例子中,我们都是应用到了主服务器负载均衡到其它服务器上,那么主服务器本身能不能也加在服务器列表中,这样就不会白白浪费拿一台服务器纯当做转发功能,而是也参与到提供服务中来。

如以上案例三台服务器:

A服务器IP :192.168.5.149 (主)

B服务器IP :192.168.5.27

保存重启nginx

测试

当访问的时候,为了区分是转向哪台服务器处理我分别在B、C服务器下写一个不同内容的index.html文件,以作区分。

打开浏览器访问结果,刷新会发现所有的请求均分别被主服务器(192.168.5.149)分配到B服务器(192.168.5.27)与C服务器(192.168.5.126)上,实现了负载均衡效果。

负载均衡是我们大流量网站要做的一个东西,下面我来给大家介绍在Nginx服务器上进行负载均衡配置方法,希望对有需要的同学有所帮助哦。

负载均衡

先来简单了解一下什么是负载均衡,单从字面上的意思来理解就可以解释N台服务器平均分担负载,不会因为某台服务器负载高宕机而某台服务器闲置的情况。那么负载均衡的前提就是要有多台服务器才能实现,也就是两台以上即可。

从截图上看已成功将解析到192.168.5.149IP

A服务器nginx.conf设置

打开nginx.conf,文件位置在nginx安装目录的conf目录下。

在http段加入以下代码

upstream {

server 192.168.5.126:80;

Nginx负载均衡配置实例详解

| 时间:2013-09-05 20:19:17 | 阅读数:784335

[导读] 负载均衡是我们大流量网站要做的一个东西,下面我来给大家介绍在Nginx服务器上进行负载均衡配置方法,希望对有需要的同学有所帮助哦。负载均衡先来简单了解一下什么是负载均衡,单从字面上的意思来理解就可以解

如果也要设置负载均衡怎么办?

很简单,跟设置一样。如下:

假设的主服务器IP是192.168.5.149,负载均衡到192.168.5.150和192.168.5.151机器上

现将域名解析到192.168.5.149IP上。

在主服务器(192.168.5.149)的nginx.conf加入以下代码: