并行计算10

并行计算课程报告

并行计算课程报告1.学习总结1.1并行计算简介并行计算是相对于串行计算来说的。

它是一种一次可执行多个指令的算法,目的是提高计算速度,及通过扩大问题求解规模,解决大型而复杂的计算问题。

所谓并行计算可分为时间上的并行和空间上的并行。

时间上的并行就是指流水线技术,而空间上的并行则是指用多个处理器并发的执行计算。

1.2并行计算机分类和并行机体系结构的特征按内存访问模型、微处理器和互联网络的不同,当前流行的并行机可分为对称多处理共享存储并行机(SMP:Symmetric Multi-Processing)、分布共享存储并行机(DSM:Distributed Shared Memory)、机群(cluster)、星群(constellation)和大规模并行机(MPP:Massively Parallel Processing)等五类。

SMP并行机有如下主要特征:对称共享存储、单一的操作系统映像、局部高速缓存cache 及其数据一致性、低通信延迟、共享总线带宽、支持消息传递、共享存储并行程序设计。

SMP 并行机具有如下缺点:欠可靠、可扩展性(scalability)较差。

DSM 并行机具有如下主要特征:并行机以结点为单位,每个结点包含一个或多个CPU,每个CPU 拥有自己的局部cache,并共享局部存储器和I/O设备,所有结点通过高性能互联网络相互连接;物理上分布存储;单一的内存地址空间;非一致内存访问(NUMA)模式;单一的操作系统映像;基于cache 的数据一致性;低通信延迟与高通信带宽;DSM 并行机可扩展到数百个结点,能提供每秒数千亿次的浮点运算性能;支持消息传递、共享存储并行程序设计。

机群(cluster)有三个明显的特征:①系统由商用结点构成,每个结点包含2-4 个商用微处理器,结点内部共享存储。

②采用商用机群交换机连接结点,结点间分布存储。

③在各个结点上,采用机群Linux 操作系统、GNU 编译系统和作业管理系统。

并行计算试题及答案

计算机学院研究生《并行计算》课程考试试题(2010级研究生,2011.1)1.(12分)定义图中节点u 和v 之间的距离为从u 到v 最短路径的长度。

已知一个d 维的超立方体,1)指定其中的一个源节点s ,问有多少个节点与s 的距离为i ,其中0≤i ≤d 。

证明你的结论。

2)证明如果在一个超立方体中节点u 与节点v 的距离为i ,则存在i !条从u 到v 的长度为i 的路径。

1)有id C 个节点与s 的距离为i 。

证明:由超立方体的性质知:一个d 维的超立方体的每个节点都可由d 位二进制来表示,则与某个节点的距离为i 的节点必定在这d 位二进制中有i 位与之不同,那么随机从d 位中选择i 位就有id C 种选择方式,即与s 的距离为i 得节点就有id C 个。

2)证明:由1)所述可知:节点u 与节点v 的距离为i 则分别表示u 、v 节点的二进制位数中有i 位是不同的。

设节点u 表示为:121D .........j j i j i d D D D D D +-+,节点v 表示为:''121D .........j j i j i dD D D D D +-+,则现在就是要求得从121D .........j j i j i d D D D D D +-+变换到''121D .........j j i j i d D D D D D +-+ 的途径有多少种。

那么利用组合理论知识可知共有*(1)*(2)*...*2*1i i i --即!i 中途径。

所以存在i !条从u 到v 的长度为i 的路径。

2.(18分)6个并行程序的执行时间,用I-VI 表示,在1-8个处理器上执行了测试。

下表表示了各程序达到的加速比。

对其中的每个程序,选出最适合描述其在16个处理器上性能的陈述。

a ) 在16个处理器上的加速比至少比8个处理器上的加速比高出40%。

b ) 由于程序中的串行程序比例很大,在16个处理器上的加速比不会比8个处理器上的加速比高出40%。

如何在Python中实现并行计算

如何在Python中实现并行计算在Python中实现并行计算可以通过多种方法,包括使用多线程、多进程和分布式计算等。

并行计算可以大大提高程序的运行效率和性能,特别是在需要处理大数据集或复杂计算任务时。

下面将介绍三种常见的并行计算方法和对应的Python库。

1.多线程并行计算:多线程是指在同一个程序中同时执行多个线程,每个线程执行不同的任务,可以共享内存空间。

Python中的`threading`库提供了创建和管理线程的功能。

以下是一个使用多线程进行并行计算的示例代码:```pythonimport threading#定义一个任务函数def task(x):result = x * xprint(result)#创建多个线程执行任务threads = []for i in range(10):t = threading.Thread(target=task, args=(i,))threads.append(t)t.start()#等待所有线程完成for t in threads:t.join()```上述代码中,创建了10个线程分别执行`task`函数,每个线程计算传入的参数的平方并打印结果。

使用多线程时需要注意线程安全问题,例如共享资源的同步访问。

2.多进程并行计算:多进程指的是同时执行多个独立的进程,每个进程有自己独立的内存空间。

Python中的`multiprocessing`库提供了多进程并行计算的功能。

以下是一个使用多进程进行并行计算的示例代码:```pythonimport multiprocessing#定义一个任务函数def task(x):result = x * xprint(result)#创建多个进程执行任务processes = []for i in range(10):p = multiprocessing.Process(target=task, args=(i,))processes.append(p)p.start()#等待所有进程完成for p in processes:p.join()```上述代码中,创建了10个进程分别执行`task`函数,每个进程计算传入的参数的平方并打印结果。

numeca并行计算培训教程xp

NUMECA FINE/Turbo™6.x 并行计算培训教程WINDOWS NT/2K/XP/2003操作系统并行计算前提条件1.为保证软件能够进行并行计算功能,需要在软件安装时安装并行计算功能(Parallel Computation)2.软件许可证需要包含并行计算特征(可电话咨询尤迈克公司进行许可证验证,以确认是否有并行计算功能。

多台PC分布式并行计算设定如果是单机多CPU并行计算设定,请跳至PageStep 1: 用户管理1. 添加用户在每一台并行机上创建一个相同的帐号及相同的密码。

例如,创建用户名numeca(也可是其它任意用户名),2. 为用户创建本地路径在用户属性中,添加本地路径,路径可为硬盘上任何已经存在的目录Step 2: 配置管理1. 编辑rhost.txt用文本编辑器打开c:\winnt\rhost.txt文件。

假设共有三台机器并行,主机名分别为PC1、PC2、PC3,则在rhost.txt文件中添加以下语句:PC1 numeca (注释:主机名用户名)PC2 numecaPC3 numeca2. 运行用户注册工具在NUMECA安装目录下(以FINE61-4版本为例),运行FINE61-4\bin\MPIRegister.exe,出现以下提示窗口:输入做并行的用户名,并连续输入两次用户登陆密码,“y”确认。

3. 重新启动计算机Step 3: pvm管理1.关闭所有用于并行机器上的正在运行的FINE软件2. 从任务管理器中删除pvm*.exe的进程,或者重新启动计算机3. 清除所有并行机器上c:\tmp目录下的pvm*.* 文件Step 4: 界面管理1.在主控机上以numeca用户登陆(其它机器可意任何帐户登录)2.启动FINE界面,并通过菜单Modules ÆTask Manager切换至Task Manager窗口,双击左侧的HOSTDEFINITION,进入HOSTS Definition页面3. 点击Add Host,在弹出是对话框中输入主机名、用户名以及操作系统Step 4: 界面管理(续) 4. Accept后弹出如下菜单系统完成主机添加,在HOSTNAME中会多出一计算机名。

并行计算(陈国良版)课后答案

第三章 互连网络3.1 对于一颗K 级二叉树(根为0级,叶为k-1级),共有N=2^k —1个节点,当推广至m —元树时(即每个非叶节点有m 个子节点)时,试写出总节点数N 的表达式。

答:推广至M 元树时,k 级M 元树总结点数N 的表达式为:N=1+m^1+m^2+。

.。

+m^(k —1)=(1—m^k)*1/(1-m);3.2二元胖树如图3.46所示,此时所有非根节点均有2个父节点.如果将图中的每个椭圆均视为单个节点,并且成对节点间的多条边视为一条边,则他实际上就是一个二叉树。

试问:如果不管椭圆,只把小方块视为节点,则他从叶到根形成什么样的多级互联网络? 答:8输入的完全混洗三级互联网络.3.3 四元胖树如图3.47所示,试问:每个内节点有几个子节点和几个父节点?你知道那个机器使用了此种形式的胖树?答:每个内节点有4个子节点,2个父节点。

CM —5使用了此类胖树结构.3.4 试构造一个N=64的立方环网络,并将其直径和节点度与N=64的超立方比较之,你的结论是什么?答:A N=64的立方环网络,为4立方环(将4维超立方每个顶点以4面体替代得到),直径d=9,节点度n=4B N=64的超立方网络,为六维超立方(将一个立方体分为8个小立方,以每个小立方作为简单立方体的节点,互联成6维超立方),直径d=6,节点度n=63.5 一个N=2^k 个节点的 de Bruijin 网络如图3。

48。

个节点的二进制表示,。

试问:该网络的直径和对剖宽度是多少?答:N=2^k 个节点的 de Bruijin 网络 直径d=k 对剖宽带w=2^(k-1)3.6 一个N=2^n 个节点的洗牌交换网络如图3.49所示.试问:此网络节点度==?网络直径==?网络对剖宽度==?答:N=2^n 个节点的洗牌交换网络,网络节点度为=2 ,网络直径=n —1 ,网络对剖宽度=43.7 一个N=(k+1)2^k 个节点的蝶形网络如图3.50所示.试问:此网络节点度=?网络直径=?网络对剖宽度=?答:N=(k+1)2^k 个节点的蝶形网络,网络节点度=4 ,网络直径=2*k ,网络对剖宽度=2^k3。

并行计算

第一部分:并行计算的概念(1)并行计算:是指在并行计算机上,将一个应用分解成多个任务,分配给不同的处理器,各个处理器之间相互协同,并行地执行子任务,从而达到加快求解速度,或者提高求解应用问题规模的目的。

(2)并行计算的主要研究目的:加快求解问题的速度;提高求解问题的规模(3)并行计算必须具备的基本条件:并行计算机;应用问题必须具有并行度;并行编程(4)并行计算的主要研究内容并行计算机的高性能特征抽取;并行算法的设计与分析;并行实现技术(消息传递平台MPI、共享存储平台OpenMP);并行应用(最终目的)(5)并行计算机的3要素:结点,互联网络,内存(6)并行计算机的访存模式:UMA均匀存储访问:内存模块与结点分离,分别位于互联网络的两侧,所有结点均匀共享,各结点访存机会均等,例如对称多处理共享存储并行机 SMPNUMA非均匀存储访问:内存模块局部在各个结点内部,所有局部内存模块构成并行机的全局内存模块,所有结点任意访问内存模块,但速度和时间不同,例如分布共享存储并行机 DSM分布访存模型:非均匀访存模型不同的是,各个结点的存储模块只能被局部CPU 访问,对其他结点的内存访问只能通过消息传递程序设计来实现混合访存模型COMA(Cache-Only Memory Access)模型是全高速缓存存储访问CC-NUMA(Coherent-Cache Nonuniform Memory Access)是高速缓存一致性非均匀存储访问模型(7)并行计算机的分类:1.根据指令流和数据流个数的不同,通常分为四类:单指令流单数据流(SISD),单指令流多数据流(SIMD),多指令流单数据流(MISD),多指令流多数据流(MIMD)2.按内存访问模型、微处理器和互联网络的不同,又分为:并行向量机(PVP,Parallel Vector Processor);对称多处理共享存储并行计算机(SMP,Symmetric Multiprocessor);大规模并行计算机(MPP,Massively Parallel Processor);机群(Cluster);分布式共享存储并行计算机(DSM,Distributied Shared Memory);(8)并行计算机的结构模型:内存模块与结点分离内存模块位于结点内部(9)并行编程环境:消息传递,共享存储,数据并行(10)MPI:MPI是一个库,而不是一门语言,它遵守所有对库函数/过程的调用规则,和一般的函数/过程没有什么区别;它是一种消息传递编程模型,它的最终目的是服务于进程间通信这一目标的(11)并行编程模式:主-从式,单程序多数据流,数据流水线,分治策略(12)并行算法的分类:根据运算基本对象的不同可分为数值并行算法:主要为数值计算方法而设计的并行算法;非数值并行算法,主要为符号运算而设计的并行算法根据并行进程间相互执行顺序关系的不同可分为:同步并行算法:进程间由于运算执行顺序而必须相互等待的并行算法;异步并行算法:进程间执行相对独立,不需要相互等待的一种算法;独立并行算法:进程间执行是完全独立的,计算的整个过程不需要任何通信根据各进程承担的计算任务粒度的不同,可分为:细粒度并行算法,通常指基于向量和循环级并行的算法;中粒度并行算法,通常指基于较大的循环级并行;大粒度并行算法,通常指基于子任务级并行的算法。

(2024年)并行计算第并行算法的设计ppt课件

运用并行计算技术加速基因序列的比对和分析,促进生物医学研究 的发展。

28

工程仿真领域

01

流体动力学仿真

通过并行算法模拟流体的运动状 态,以优化飞行器、汽车等交通 工具的设计。

02

03

结构力学仿真

电磁场仿真

利用并行计算技术对建筑物、桥 梁等结构进行力学分析和优化, 提高工程安全性。

运用并行算法模拟电磁场的分布 和传播,以改进电子设备和通信 系统的性能。

高速互联网络

用于连接处理器和存储器,提供高带宽和低延迟 的数据传输,保证并行计算的效率。

2024/3/26

5

并行计算的软件支持

并行编程模型

包括消息传递模型、数据并行模型和 共享内存模型等,为并行计算提供抽 象的编程接口。

并行编程语言

如MPI、OpenMP、CUDA等,这些 语言提供对并行硬件的直接支持,使 程序员能够方便地编写并行程序。

2024/3/26

并行最长公共子序列算法

通过并行处理多个子序列的比较和合并操作,加速 最长公共子序列的求解过程。

并行最短编辑距离算法

将编辑距离的计算过程拆分成多个步骤,每 个步骤可以在多个处理单元上并行执行,从 而加快计算速度。

18

04

现代并行算法设计

2024/3/26

19

分布式并行算法

2024/3/26

11

并行算法的性能评价

加速比

衡量并行算法相对于串行算法的速度提升程度。

效率

衡量并行算法在给定资源下的性能表现。

2024/3/26

12

并行算法的性能评价

• 可扩展性:衡量并行算法在增加处理单元 数量时的性能提升能力。

02_2并行计算机(系统结构)

P

M

P M

P M

...

P M

2019/2/23

23

构建并行机系统的不同存储结构

PVP (Cray

中央存储器 T90)

UMA SMP SGI

多处理机 ( 单地址 空间 共享 存储器 ) (Intel SHV,SunFire,DEC 8400, PowerChallenge,IBMR60,etc.) (KSR-1,DDM) (Stanford Dash, SGI Origin 2000,Sequent NUMA-Q, HP/Convex Exemplar) (Cray T3E)

2019/2/23 10

MPP(Massively Parallel Processor)

处理节点采用微处理器 系统中有物理上的分布式存储器 采用高通信带宽和低延迟的互连网络(专门设 计和定制的) 能扩展至成百上千乃至上万个处理器 异步MIMD,构成程序的多个进程有自己的地 址空间,进程间通信消息传递相互作用

16

Origin3000 与 Altix3000

Origin3000

2019/2/23

Altix3000

17

并行计算机内存访问模型

UMA / NUMA / COMA / CC-NUMA / NORMA

2019/2/23

18

并行计算机访存模型(1)

UMA(Uniform Memory Access)模型是均匀存储访问模型的 简称。其特点是:

节 点1 P / C 节 点N M e m P / C

… P/C

交 叉 开 关 总 线 或

…

I / O

…P/C

开 关 总 线 或 交 叉

并行计算与高性能计算考核试卷

(以下为答题纸区域,请考生在此区域作答,超出此区域作答无效。)

三、填空题(本题共10小题,每小题2分,共20分,请将正确答案填到题目空白处)

1.并行计算中,将一个大的任务分解成多个子任务的过程称为______。

2.在并行计算中,______是指使用多个处理器执行单个任务的不同部分。

3.高性能计算中,______是一种衡量计算机性能的指标,表示每秒能够执行的浮点运算次数。

C. CUDA

D. Java

5.并行计算中,任务分解与任务分配是()

A.相同的过程

B.互相独立的

C.相互依赖的

D.无关的

6.以下哪个部件不是并行计算机的主要组成部分?()

A.处理器

B.存储器

C.网络接口卡

D.显卡

7.高性能计算领域中,计算速度的主要指标是()

A. MIPS

B. MFLOPS

C. GHz

D. OpenCL

11.并行计算中,以下哪种通信方式开销最小?()

A.同步通信

B.异步通信

C.广播通信

D.全局通信

12.以下哪个术语不是高性能计算中的术语?()

A.性能

B.效能

C.并行度

D.带宽

13.并行计算中,以下哪种同步机制可能会导致死锁?()

A.互斥锁

B.条件变量

C.信号量

D.读写锁

14.以下哪个选项不属于并行计算中的数据依赖类型?()

3. MFLOPS

4.点对点

5.数据并行

6.可扩展性

7.图形处理单元

8.互斥锁

9. SRAM

10.并发

四、判断题

1. ×

2. ×

3. √

并行计算(陈国良版)课后答案解析

第三章互连网络3.1 对于一颗K级二叉树(根为0级,叶为k-1级),共有N=2^k-1个节点,当推广至m-元树时(即每个非叶节点有m个子节点)时,试写出总节点数N的表达式。

答:推广至M元树时,k级M元树总结点数N的表达式为:N=1+m^1+m^2+...+m^(k-1)=(1-m^k)*1/(1-m);3.2二元胖树如图3.46所示,此时所有非根节点均有2个父节点。

如果将图中的每个椭圆均视为单个节点,并且成对节点间的多条边视为一条边,则他实际上就是一个二叉树。

试问:如果不管椭圆,只把小方块视为节点,则他从叶到根形成什么样的多级互联网络?答:8输入的完全混洗三级互联网络。

3.3 四元胖树如图3.47所示,试问:每个内节点有几个子节点和几个父节点?你知道那个机器使用了此种形式的胖树?答:每个内节点有4个子节点,2个父节点。

CM-5使用了此类胖树结构。

3.4 试构造一个N=64的立方环网络,并将其直径和节点度与N=64的超立方比较之,你的结论是什么?答:A N=64的立方环网络,为4立方环(将4维超立方每个顶点以4面体替代得到),直径d=9,节点度n=4B N=64的超立方网络,为六维超立方(将一个立方体分为8个小立方,以每个小立方作为简单立方体的节点,互联成6维超立方),直径d=6,节点度n=63.5 一个N=2^k个节点的de Bruijin 网络如图3.48。

试问:该网络的直径和对剖宽度是多少?答:N=2^k个节点的de Bruijin网络直径d=k 对剖宽带w=2^(k-1)3.6 一个N=2^n个节点的洗牌交换网络如图3.49所示。

试问:此网络节点度==?网络直径==?网络对剖宽度==?答:N=2^n个节点的洗牌交换网络,网络节点度为=2 ,网络直径=n-1 ,网络对剖宽度=43.7 一个N=(k+1)2^k个节点的蝶形网络如图3.50所示。

试问:此网络节点度=?网络直径=?网络对剖宽度=?答:N=(k+1)2^k个节点的蝶形网络,网络节点度=4 ,网络直径=2*k ,网络对剖宽度=2^k3.9 对于如下列举的网络技术,用体系结构描述,速率范围,电缆长度等填充下表中的各项。

并行发展史

计算机发展]从20世纪40年代开始的现代计算机发展历程可以分为两个明显的发展时代:串行计算时代、并行计算时代。

每一个计算时代都从体系结构发展开始,接着是系统软件(特别是编译器与操作系统)、应用软件,最后随着问题求解环境的发展而达到顶峰。

并行计算机是由一组处理单元组成的。

这组处理单元通过相互之间的通信与协作,以更快的速度共同完成一项大规模的计算任务。

因此,并行计算机的两个最主要的组成部分是计算节点和节点间的通信与协作机制。

并行计算机体系结构的发展也主要体现在计算节点性能的提高以及节点间通信技术的改进两方面。

节点性能不断进步 20世纪60年代初期,由于晶体管以及磁芯存储器的出现,处理单元变得越来越小,存储器也更加小巧和廉价。

这些技术发展的结果导致了并行计算机的出现。

这一时期的并行计算机多是规模不大的共享存储多处理器系统,即所谓大型主机。

IBM 360是这一时期的典型代表。

到了20世纪60年代末期,同一个处理器开始设置多个功能相同的功能单元,流水线技术也出现了。

与单纯提高时钟频率相比,这些并行特性在处理器内部的应用大大提高了并行计算机系统的性能。

伊利诺依大学和Burroughs公司此时开始实施Illiac Ⅳ计划,研制一台64颗CPU的SIMD主机系统,它涉及到硬件技术、体系结构、I/O设备、操作系统、程序设计语言直至应用程序在内的众多研究课题。

不过,当一台规模大大缩小的原型系统(仅使用了16颗CPU)终于在1975年面世时,整个计算机界已经发生了巨大变化。

首先是存储系统概念的革新,提出虚拟存储和缓存的思想。

以IBM 360/85和IBM 360/91为例,两者是属于同一系列的两个机型,IBM 360/91的主频高于IBM 360/85,所选用的内存速度也较快,并且采用了动态调度的指令流水线。

但是,IBM 360/85的整体性能却高于IBM 360/91,惟一的原因就是前者采用了缓存技术,而后者则没有。

ANSYSCFX10并行计算全套攻略

7.这时候需要设置环境变量,你不需要知道什么是环境变量,只要按照我说的做就行了,将我的电脑选中点击右键选择属性-->选择高级-->环境变量,这时会看到什么用户变量和系统变量,不管谁了,选择一个点击新建,然后将ANSYSLMD_LICENSE_FILE添加到变量名处,将1055@host(这里的host是你的机器名也叫主机名,可别真的填入host)填入变量值处,然后点击确定,

window下:

1.解压:拿到软件是一些分块压缩软件包,如果是.rar格式的并且名字只有最后数字不同,那么解压缩任何一个都可以全部解压缩出来,加压后是一个bin文件和cue文件,那么用daemon或者相类似软件都可以将它们打开;

2.提出破解文件:文件中应该有magnitude文件目录或者crack目录等,将它们单独提出来,并且改变属性变成存档文件,(选中要改变文件点击右键属性,选中存档,取消只读);

Installation Root = e:\Program Files\Ansys Inc\CFX\CFX-%v

Host Architecture String = intel_pentium_winnt5.1

Relative Speed = 0.44

END # HOST DEFINITION hostname

3.运行安装文件中的whoid可执行文件,(这部是为了有多个网卡朋友准备的,因为不知道ansyscfx选择哪个为主要的网卡,)看到你机器里面的参数,若有多个网卡物理地址,那么记下第一个和你的主机名。打开刚才提出破解文件目录里面的ansys.dat文件(可以用记事本或者相同东西打开)将000000000000替换成你刚才记下的网卡物理地址,将host替换成你的机器名(主机名);

使用MySQL进行多线程和并行计算教程

使用MySQL进行多线程和并行计算教程在当今数据爆炸的时代,数据处理的效率成为了一个非常重要的问题。

为了提高数据处理的速度和效率,多线程和并行计算成为了一个热门的话题。

MySQL作为一种非常常用的关系型数据库,也支持多线程和并行计算。

本文将介绍如何使用MySQL进行多线程和并行计算,以提高数据处理的速度和效率。

第一部分:多线程计算多线程计算是指将一个程序拆分成多个线程,每个线程独立执行其中的一部分任务,以提高计算的速度和效率。

在MySQL中,可以使用存储过程和函数来实现多线程计算。

首先,我们需要创建一个存储过程或函数,并将需要进行计算的任务拆分成多个独立的部分。

接着,我们可以使用MySQL的线程特性,创建多个线程来并发执行这些任务。

每个线程独立执行其中的一部分任务,并将结果保存到临时表或变量中。

最后,我们可以使用合适的方法将多个线程的计算结果合并到一起,得到最终结果。

以下是一个简单的示例,演示了如何使用MySQL进行多线程计算:```sql-- 创建存储过程DELIMITER //CREATE PROCEDURE multi_thread_calculation()BEGINDECLARE task_number INT;DECLARE thread_id INT;DECLARE done INT DEFAULT FALSE;-- 创建临时表保存计算结果CREATE TEMPORARY TABLE IF NOT EXISTS result_table (result INT); -- 设置总任务数SET task_number = 1000;-- 分配任务给不同的线程SET thread_id = 1;WHILE thread_id <= 10 DOINSERT INTO calculation_task (thread_id, task_id)SELECT thread_id, task_id FROM (SELECT thread_id, task_id, @rownum := @rownum + 1 AS row_number FROM (SELECT thread_id, task_number % 10 + @rownum * 10 AS task_id FROM (SELECT @rownum := 0) r, (SELECT @rownum := 0) tWHERE @rownum <= task_number / 10) AS tmpWHERE task_id <= task_number) AS tmp2WHERE row_number % 10 = thread_id;SET thread_id = thread_id + 1;END WHILE;-- 启动多个线程并发执行任务CALL start_threads();-- 等待所有线程完成任务REPEATSELECT COUNT(*) INTO done FROM calculation_taskWHERE status = 'completed';IF done = 10 THENSET done = TRUE;ELSESET done = FALSE;-- 等待一段时间后再继续检查 CALL SLEEP(0.1);END IF;UNTIL done END REPEAT;-- 合并计算结果INSERT INTO result_table (result) SELECT SUM(result)FROM calculation_task;END //DELIMITER ;-- 启动多个线程DELIMITER //CREATE PROCEDURE start_threads()BEGINDECLARE thread_id INT;DECLARE done INT DEFAULT FALSE;SET thread_id = 1;WHILE thread_id <= 10 DO-- 创建线程并执行任务SET @stmt = CONCAT('CALL calculation_thread_', thread_id, '();'); PREPARE stmt FROM @stmt;EXECUTE stmt;DEALLOCATE PREPARE stmt;SET thread_id = thread_id + 1;END WHILE;END //DELIMITER ;-- 线程1的计算任务DELIMITER //CREATE PROCEDURE calculation_thread_1()BEGINDECLARE task_id INT;-- 获取任务IDSELECT MIN(task_id) INTO task_idFROM calculation_taskWHERE thread_id = 1 AND status = 'not_started'; while task_id IS NOT NULL DO-- 执行任务计算UPDATE calculation_taskSET result = task_id * 10, status = 'completed'WHERE thread_id = 1 AND task_id = task_id;-- 获取下一个任务IDSELECT MIN(task_id) INTO task_idFROM calculation_taskWHERE thread_id = 1 AND status = 'not_started'; END WHILE;END //DELIMITER ;-- 创建计算任务表CREATE TABLE IF NOT EXISTS calculation_task ( thread_id INT,task_id INT,result INT,status ENUM('not_started', 'completed') DEFAULT 'not_started');-- 调用多线程计算CALL multi_thread_calculation();```在上述示例中,我们首先创建了一个存储过程 multi_thread_calculation(),它用于实现多线程计算。

并行计算(中科大讲义)

▪ n,节点规模 w,数据宽度

国家高性能计算中心(合肥)

2021/4/12

22

标准互联网络(1)

▪ Myrinet:

▪ Myrinet是由Myricom公司设计的千兆位包交换网络,其目的 是为了构筑计算机机群,使系统互连成为一种商业产品。

▪ Myrinet是基于加州理工学院开发的多计算机和VLSI技术以及 在南加州大学开发的ATOMIC/LAN技术。Myrinet能假设任 意拓扑结构,不必限定为开关网孔或任何规则的结构。

▪ 多处理机总线系统的主要问题包括总线仲裁、中断处理、协议转换、 快速同步、高速缓存一致性协议、分事务、总线桥和层次总线扩展等

CPU板

LM

CPU

本地外围设备 (SCSI总线)

IOC

存储器板 存储器单元

本地总线

存储器总线

高速缓存

IF

IF

MC

系统总线

I/O板

IOP

IF

数据总线

缓冲

IF

(底板上)

通信板

IF

开关,在Ilinois大学的

Cedar[2]多处理机系统中采用了Ω网络

▪ Cray Y/MP多级网络,该网络用来支持8个向量处理器和256 个存储器模块之间的数据传输。网络能够避免8个处理器同时 进行存储器存取时的冲突。

国家高性能计算中心(合肥)

2021/4/12

21

动态互连网络比较

动态互连网络的复杂度和带宽性能一览表

▪ 一个交换开关模块有n个输入和n个输出,每个输入可连接到任 意输出端口,但只允许一对一或一对多的映射,不允许多对一 的映射,因为这将发生输出冲突

▪ 级间互连(Interstage Connection ):

并行计算综述

什么是并行计算并行计算(parallel computing)是指,在并行机上,将一个应用分解成多个子任务,分配给不同的处理器,各个处理器之间相互协同,并行地执行子任务,从而达到加速求解速度,或者增大求解应用问题规模的目的。

由此,为了成功开展并行计算,必须具备三个基本条件:(1) 并行机。

并行机至少包含两台或两台以上处理机,这些处理机通过互连网络相互连接,相互通信。

(2) 应用问题必须具有并行度。

也就是说,应用可以分解为多个子任务,这些子任务可以并行地执行。

将一个应用分解为多个子任务的过程,称为并行算法的设计。

(3) 并行编程。

在并行机提供的并行编程环境上,具体实现并行算法,编制并行程序,并运行该程序,从而达到并行求解应用问题的目的。

并行计算的主要研究目标和内容对于具体的应用问题,采用并行计算技术的主要目的在于两个方面:(1) 加速求解问题的速度。

(2) 提高求解问题的规模。

组成并行机的三个要素为:•结点(node)。

每个结点由多个处理器构成,可以直接输入输出(I/O)。

•互联网络(interconnect network)。

所有结点通过互联网络相互连接相互通信。

•内存(memory)。

内存由多个存储模块组成,这些模块可以与结点对称地分布在互联网络的两侧,或者位于各个结点的内部。

并行编程模型1.共享内存模型a)在共享编程模型中,任务间共享统一的可以异步读写的地址空间。

b)共享内存的访问控制机制可能使用锁或信号量。

c)这个模型的优点是对于程序员来说数据没有身份的区分,不需要特别清楚任务间的单数据通信。

程序开发也相应的得以简化。

d)在性能上有个很突出的缺点是很难理解和管理数据的本地性问题。

2.线程模型在并行编程的线程模型中,单个处理器可以有多个并行的执行路径。

3.消息传递模型消息传递模型有以下三个特征:1)计算时任务集可以用他们自己的内存。

多任务可以在相同的物理处理器上,同时可以访问任意数量的处理器。

并行计算的参考题目

并行计算的参考题目1、讨论某一种算法的可扩放性时,一般指什么?88答:讨论某一种算法的可扩放性时,实际上是指该算法针对某一特定机器结构的可扩放性2、使用“Do in Parallel”语句时,表示的是什么含义105答:表示算法的若干步要并行执行3、并行计算机的存储访问类型有哪几种?26答:存储访问类型有:UMA(均匀存储访问)、NUMA(非均匀存储访问)、COMA(全高速缓存存储访问)、CC-NUMA(高速缓存一致性非均匀存储访问)、NORMAl(非远程存储访问)4、什么是同步?它有什么作用?如何实现?107答:同步是在时间上强使各执行进程在某一点必须相互等待。

作用:确保个处理器的正确工作顺序以及对共享可写数据的正确访问(互斥访问)。

实现方法:用软件、硬件和固件的方法实现。

5 在并行加速比的计算中,常用的三种加速比定律分别是哪三种?(P83)答:常用的三种加速比定律分别是:适用于固定计算负载的Amdahl定律,适用于可扩放问题的Gustafson定律和受限于存储器的Sun和Ni定律。

6、试比较Amdahl定律、Gustafson定律、Sun和Ni定律三种加速定律的应用场合。

83 答:Amdahl定律适用于固定计算负载的问题Gustafson定律适用于可扩放性问题Sun和Ni定律适用于受限于存储器的问题。

7.并行算法的基本设计技术有哪些?它们的基本思想是什么?139答:(1)基本技术有:划分设计技术(又分为均匀划分技术、方根划分技术、对数划分技术和功能划分技术)、分治设计技术、平衡树设计技术、倍增设计技术、流水线设计技术等。

(2)基本思想分别如下:a.划分设计技术:(P139) 将一原始问题分成若干部分,然后各部分由相应的处理器同时执行。

b.分治设计技术:(P144)将一个大二复杂的问题分解成若干特性相同的子问题分而治之。

若所得的子问题规模仍嫌过大,可反复使用分治策略,直至很容易求解诸子问题为止。

白琰冰《数据科学并行计算》习题答案

白琰冰《数据科学并行计算》习题答案1、(黄冈市)下列发明创造与仿生学无关的是()。

[单选题] *A.锯子B.显微镜(正确答案)C.迷彩服2、在同一天内,探探第一次测得阳光下竹竿影长为300厘米,一小时后,测得的影长为200厘米,她两次测量竹竿影长的时间可能是()。

[单选题] *A.上午(正确答案)B.下午C.傍晚3、学校举行萝卜牙签搭高塔比赛,提供的材料有已经切好的胡萝卜颗粒和牙签。

要想搭得高而且稳,下列做法不合适的是( )。

[单选题] *A.把大的胡萝卜粒放在底层,小的放在上层B.塔身要尽量上下一样大(正确答案)C.牙签尽量组成三角形的形状4、把两棵生长状态良好的绿豆苗分别摆放在阴暗处和阳光下。

过几天,我们可以观察到放在阴暗处的绿豆苗比放在阳光下的绿豆苗()。

[单选题] *A.茎杆粗壮B.茎和叶的颜色深C.长得快,茎细长(正确答案)5、以下不可以作为小船动力装置的是()。

[单选题] *A.风帆B.风力推进装置C.船舵(正确答案)6、下面方法中,可以帮助我们获取真实信息的有()。

①观察②实验③调查④推想⑤案例分析[单选题] *A. ①②④B. ①②③⑤(正确答案)C. ②③④⑤7、白糖、碱、明矾、玻璃都是晶体。

( ) [判断题] *对错(正确答案)8、24.绿豆芽在生长时可以不需要阳光。

[判断题] *对错(正确答案)9、世界是由物质构成的,物质在不断地发生变化。

( ) [单选题]对(正确答案)错10、通过处理后的污水,虽然清激、但依然有可能存在一些有害物质。

[单选题] *A.对(正确答案)B.错11、工人师傅搬运杂乱的废钢铁很麻烦,用电磁起重机就省事多了。

电磁起重机搬运废钢铁时,主要是利用电磁铁()这一性质来工作的。

[单选题] *A.承重力强B.同性排斥,异性吸引C.通电产生磁性,断电磁性消失(正确答案)12、放大镜的特点是透明,中间薄边缘厚。

( ) [单选题]对错(正确答案)13、在制作晶体的实验中,使用较浓的食盐溶液更容易产生食盐晶体。

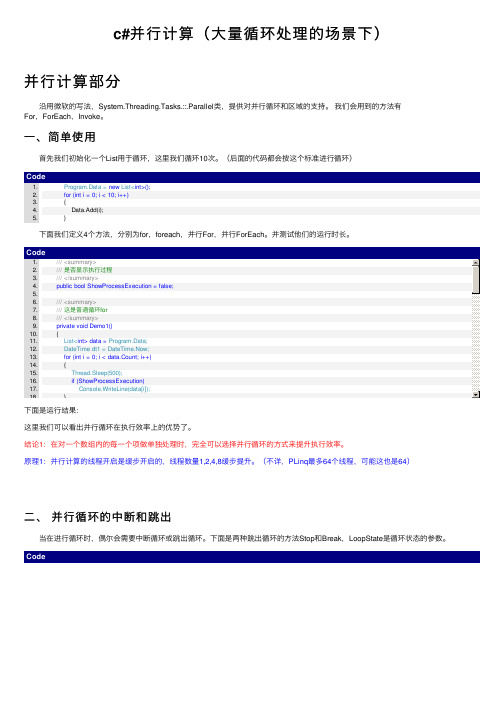

c#并行计算(大量循环处理的场景下)

c#并⾏计算(⼤量循环处理的场景下)并⾏计算部分沿⽤微软的写法,System.Threading.Tasks.::.Parallel类,提供对并⾏循环和区域的⽀持。

我们会⽤到的⽅法有For,ForEach,Invoke。

⼀、简单使⽤⾸先我们初始化⼀个List⽤于循环,这⾥我们循环10次。

(后⾯的代码都会按这个标准进⾏循环)Code1. Program.Data = new List<int>();2. for (int i = 0; i < 10; i++)3. {4. Data.Add(i);5. }下⾯我们定义4个⽅法,分别为for,foreach,并⾏For,并⾏ForEach。

并测试他们的运⾏时长。

么请继续看。

下⾯是我们⼀般会想到的写法:类说明BlockingCollection<T>为实现 IProducerConsumerCollection<T> 的线程安全集合提供阻⽌和限制功能。

ConcurrentBag<T>表⽰对象的线程安全的⽆序集合。

ConcurrentDictionary<TKey,TValue>表⽰可由多个线程同时访问的键值对的线程安全集合。

ConcurrentQueue<T>表⽰线程安全的先进先出 (FIFO) 集合。

ConcurrentStack<T>表⽰线程安全的后进先出 (LIFO) 集合。

OrderablePartitioner<TSource>表⽰将⼀个可排序数据源拆分成多个分区的特定⽅式。

Partitioner提供针对数组、列表和可枚举项的常见分区策略。

Partitioner<TSource>表⽰将⼀个数据源拆分成多个分区的特定⽅式。

那么我们上⾯的代码可以修改为,加了了ConcurrentQueue 和ConcurrentStack 的最基本的操作。

本人使用FEKO进行并行计算的经验总结

本人使用FEKO进行并行计算的经验总结(血泪史)作者:尘谖(站内联系TA)发布:2008-11-14 项目需要,老师考虑要购进一台高性能计算机。

有公司主动上门推荐我们试用他们的产品。

师兄们都忙,稀里糊涂地让我做了实验员。

说明白一点儿,我的任务就是拿着我们的模型,去人家的机子上面装软件,然后对模型进行计算,记下计算时间,拷回计算结果。

目的一是试试机子性能,二是帮我们快速计算,赶一下实验进度。

使用的高性能计算机是曙光公司的PHPC1005个节点,10个CPU每个CPU是8个核。

计算软件用的是FEKO5.2, 在网上下载的盗版,自行破解之后使用。

计算模型是几个不同情况的天线。

我自己虽然也做天线的仿真,但是我用的是HFSS至于FEKO我并没有用过。

师兄事无巨细地给我写了安装步骤,又手把手地教我操作了两遍。

我拿着师兄写的步骤记录和网上下载的安装过程,信心百倍的和公司的人一起去试用了。

呵呵,原来就在我们实验室的楼上,简单地说。

满以为半天就能搞定。

机子好大啊,近一米长,半米高,30公分厚,呼呼地散发着热风。

坐在它旁边就想打盹,因为无论从各个方面都感觉它像一个壁炉。

殊不知,装软件就出了各种各样的问题。

软件安装的时候,会弹出一个提示页面,让输入用户名和密码。

这时如果你是以管理员的身份进行计算的话,千万不能输入用户名,密码也不能胡乱输入。

用户名要默认,回车,密码也一定要是最初进入节点使用的初始密码。

公司的人也是一知半解,指示我随便输入一个用户名,随便设置一个密码,后来接了各电话干脆闪人了。

我一个人吭哧吭哧在那里装软件。

一上午终于装好了软件,下午开始计算,肯定搞不定啦。

到了人家的下班时间,才算了1%。

因为,只能在一个节点上串行计算,不能并行计算。

晚上去了之后,认识了那里实验室的一个研一小美女,开朗活泼,勤奋好学,着实招人喜欢。

看我操作,呵呵,还小小地崇拜了我一把,确切地说是盲目崇拜。

因为我在更换节点的时候,死活进不去了计算机了。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

4

int a[10],b[10],npes,myrank; MPI_Status status; … MPI_Comm_size(MPI_COMM_WORLD,&npes); MPI_Comm_rank(MPI_COMM_WORLD,&myrank); MPI_SendRecv(a,10,MPI_INT,(myrank+1)%npes, 1, b,10,MPI_INT,(myrank-1+npes)%npes, 1, MPI_COMM_WORLD, &status); …

5

Cannon's Matrix-Matrix Multiplication with MPI's Topologies

n The dimension of the matrices The parameters a, b, and c point to the locally stored portions of the matrices A, B, and C, respectively. The size of these arrays is , where p is the number of processes. This routine assumes that p is a perfect square and that n is a multiple of . The parameter comm stores the communicator describing the processes that call the MatrixMatrixMultiply function. MatrixMatrixMultiply(int n, double *a, double *b, double *c, MPI_Comm comm)

1 MatrixMatrixMultiply_NonBlocking(int n, double *a, double *b, double *c, MPI_Comm comm) 2 { 3 int i, j, nlocal, npes, dims[2], periods[2]; 4 int myrank, my2drank, mycoords[2]; 5 int uprank, downrank, leftrank, rightrank, coords[2]; 6 int shiftsrc, shiftdest; 7 double *a_buffers[2], *b_buffers[2]; 8 MPI_Status status; MPI_Comm comm_2d; 9 MPI_Request reqs[4]; 10 /* Get the communicator related information */ 11 MPI_Comm_size(comm, &npes); 12 MPI_Comm_rank(comm, &myrank); 13 /* Set up the Cartesian topology */ 14 dims[0] = dims[1] = sqrt(npes); 15 /* Set the periods for wraparound connections */ 16 periods[0] = periods[1] = 1; 17 /* Create the Cartesian topology, with rank reordering */ 18 MPI_Cart_create(comm, 2, dims, periods, 1, &comm_2d);

7

/* Get the rank and coordinates */ MPI_Comm_rank(comm_2d, &my2drank); MPI_Cart_coords(comm_2d, my2drank, 2, mycoords); /* Determine the dimension of the local matrix block */ nlocal = n/dims[0]; /* Setup the a_buffers and b_buffers array. */ a_buffers[0] = a; a_buffers[1]=(double *)malloc(nlocal*nlocal*sizeof(double)); b_buffers[0] = b; b_buffers[1]=(double *)malloc(nlocal*nlocal*sizeof(double)); /* Perform the initial matrix alignment. */ MPI_Cart_shift(comm_2d, 0, -mycoords[0], &shiftsrc &shiftdest); MPI_Sendrecv_replace(a_buffers[0], nlocal*nlocal,MPI_DOUBLE, shiftdest, 1, shiftsrc, 1, comm_2d, &status); MPI_Cart_shift(comm_2d, 1, -mycoords[1], &shiftsrc, &shiftdest); MPI_Sendrecv_replace(b_buffers[0], nlocal*nlocal,MPI_DOUBLE, shiftdest, 1, shiftsrc, 1, comm_2d, &status);

6

31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48

/* Get into the main computation loop */ for (i=0; i<dims[0]; i++) { MatrixMultiply(nlocal, a, b, c); /*c=c+a*b*/ /* Compute ranks of the up and left shifts */ MPI_Cart_shift(comm_2d, 0, -1, &rightrank, &leftrank); MPI_Cart_shift(comm_2d, 1, -1, &downrank, &uprank); /* Shift matrix a left by one */ MPI_Sendrecv_replace(a, nlocal*nlocal, MPI_DOUBLE, leftrank, 1, rightrank, 1, comm_2d, &status); /* Shift matrix b up by one */ MPI_Sendrecv_replace(b, nlocal*nlocal, MPI_DOUBLE, uprank, 1, downrank, 1, comm_2d, &status); } /* Restore the original distribution of a and b */ MPI_Cart_shift(comm_2d, 0, +mycoords[0], &shiftsrc, &shiftdest); MPI_Sendrecv_replace(a, nlocal*nlocal, MPI_DOUBLE, shiftdest, 1, shiftsrc, 1, comm_2d, &status);

49

MPI_Cart_shift(comm_2d, 1, +mycoords[1], &shiftsrc, &shiftdest); 50 MPI_Sendrecv_replace(b, nlocal*nlocal, MPI_DOUBLE, 51 shiftdest, 1, shiftsrc, 1, comm_2d, &status); 52 53 MPI_Comm_free(&comm_2d); /* Free up communicator */ 54 } 55 56 /* This function performs a serial matrix-matrix multiplication c = a*b */ 57 MatrixMultiply(int n, double *a, double *b, double *c) 58 { 59 int i, j, k; 60 61 for (i=0; i<n; i++) 62 for (j=0; j<n; j++) 63 for (k=0; k<n; k++) 64 c[i*n+j] += a[i*n+k]*b[k*n+j]; 65 }

第十四章 基于消息传递的并行编程

1

2

3

$ mpicc -o mpi_hello mpi_hello.c 在并行环境中的多台计算机上同时执行该程序,要将编译 好的程序复制到不同的机器上 $ mpirun -np 6 mpi_hello From process 0 out of 6, Hello World! From process 1 out of 6, Hello World! From process 3 out of 6, Hello World! From process 2 out of 6, Hello World! From process 4 out of 6, Hello World! From process 5 out of 6, Hello World!

1 MatrixMatrixMultiply(int n, double *a, double *b, 2 double *c, MPI_Comm comm) { 3 int i, nlocal, npes, dims[2], periods[2]; 4 int myrank, my2drank, mycoords[2]; 5 int uprank, downrank, leftrank, rightrank, coords[2]; 6 int shiftsrc, shiftdest; 7 MPI_Status status; 8 MPI_Comm comm_2d; 9 /* Get the communicator related information */ 10 MPI_Comm_size(comm, &npes); 11 MPI_Comm_rank(comm, &myrank); 12 /* Set up the Cartesian topology */ 13 dims[0] = dims[1] = sqrt(npes); 14 /* Set the periods for wraparound connections */ 15 periods[0] = periods[1] = 1; 16 /* Create the Cartesian topology, with rank reordering */ 17 MPI_Cart_create(comm, 2, dims, periods, 1, &comm_2d);