ClassdescMP Easy MPI programming in C++

并行计算_实验三_简单的MPI并行程序及性能分析

并行计算_实验三_简单的MPI并行程序及性能分析一、实验背景和目的MPI(Massive Parallel Interface,大规模并行接口)是一种用于进行并行计算的通信协议和编程模型。

它可以使不同进程在分布式计算机集群上进行通信和协同工作,实现并行计算的目的。

本实验将设计和实现一个简单的MPI并行程序,并通过性能分析来评估其并行计算的效果。

二、实验内容1.设计一个简单的MPI并行程序,并解决以下问题:a.将一个矩阵A进行分块存储,并将其均匀分配给不同的进程;b.将每个进程分别计算所分配的矩阵块的平均值,并将结果发送给主进程;c.主进程将收到的结果汇总计算出矩阵A的平均值。

2.运行该MPI程序,并记录下执行时间。

3.对程序的性能进行分析:a.利用不同规模的输入数据进行测试,观察程序的运行时间与输入规模的关系;b. 使用mpiexec命令调整进程数量,观察程序的运行时间与进程数量的关系。

三、实验步骤1.程序设计和实现:a.设计一个函数用于生成输入数据-矩阵A;b.编写MPI并行程序的代码,实现矩阵块的分配和计算;c.编写主函数,调用MPI相应函数,实现进程间的通信和数据汇总计算。

2.编译和运行程序:a.使用MPI编译器将MPI并行程序编译成可执行文件;b.在集群上运行程序,并记录下执行时间。

3.性能分析:a.对不同规模的输入数据运行程序,记录下不同规模下的运行时间;b. 使用mpiexec命令调整进程数量,对不同进程数量运行程序,记录下不同进程数量下的运行时间。

四、实验结果和分析执行实验后得到的结果:1.对不同规模的输入数据运行程序,记录下不同规模下的运行时间,得到如下结果:输入规模运行时间100x1002.345s200x2005.678s300x30011.234s...从结果可以看出,随着输入规模的增加,程序的运行时间也相应增加。

2. 使用mpiexec命令调整进程数量,对不同进程数量运行程序,记录下不同进程数量下的运行时间,得到如下结果:进程数量运行时间110.345s26.789s43.456s...从结果可以看出,随着进程数量的增加,程序的运行时间逐渐减少,但当进程数量超过一定限制后,进一步增加进程数量将不再显著减少运行时间。

openmpi多节点通信编程实例

openmpi多节点通信编程实例OpenMPI 是一个高性能的 MPI (Message Passing Interface) 实现,用于在多节点系统上进行并行计算。

以下是一个简单的 OpenMPI 多节点通信编程实例:首先,确保你已经正确安装了 OpenMPI。

然后,你可以使用以下的 C++ 代码来创建一个简单的 MPI 程序。

这个程序将使用 `MPI_Send` 和 `MPI_Recv` 来发送和接收消息。

```c++include <>include <iostream>include <string>int main(int argc, char argv) {// 初始化 MPI 环境MPI_Init(NULL, NULL);// 获取总的进程数和当前进程的 IDint world_size;int world_rank;MPI_Comm_size(MPI_COMM_WORLD, &world_size);MPI_Comm_rank(MPI_COMM_WORLD, &world_rank);// 检查命令行参数,查看是否有指定主机文件if (argc > 1) {MPI_Comm_set_errhandler(MPI_COMM_WORLD,MPI_ERRORS_RETURN);MPI_File file;MPI_File_open(MPI_COMM_WORLD, argv[1],MPI_MODE_RDONLY, MPI_INFO_NULL, &file);MPI_Status status;char host[MPI_MAX_PROCESSOR_NAME];int nameLen;MPI_File_read_at(file, 0, host, MPI_MAX_PROCESSOR_NAME, MPI_CHAR, &status);host[_OFF_SET] = '\0'; // NULL terminate the string.MPI_File_close(&file);if (world_rank == 0) std::cout << "Host name is: " << host << std::endl;MPI_Bcast(host, MPI_MAX_PROCESSOR_NAME, MPI_CHAR, 0, MPI_COMM_WORLD);} else {if (world_rank == 0) std::cout << "No host file specified." << std::endl;}// 使用 "Hello, World!" 消息进行通信std::string message = "Hello, World!";int dest = world_rank == 0 ? world_size - 1 : world_rank - 1; // 将消息发送给前一个进程int tag = 1234; // 可以是任何整数,用于区分不同的消息类型int sendbufsize = (); // 消息的大小(以字节为单位)char sendbuffer[sendbufsize]; // 消息的内容(以字节为单位)for (int i = 0; i < sendbufsize; ++i) { // 将字符串转换为字节数组sendbuffer[i] = message[i];}MPI_Send(sendbuffer, sendbufsize, MPI_CHAR, dest, tag,MPI_COMM_WORLD); // 将消息发送给指定的进程if (world_rank == world_size - 1) { // 只最后一个进程接收消息并打印出来char receivebuffer[sendbufsize]; // 用于接收消息的缓冲区MPI_Recv(receivebuffer, sendbufsize, MPI_CHAR,MPI_ANY_SOURCE, tag, MPI_COMM_WORLD, &status); // 从任何发送进程接收消息int source = _SOURCE; // 获取发送进程的 IDstd::cout << "Process " << world_rank << " received the following message from process " << source << ":" << std::endl;for (int i = 0; i < sendbufsize; ++i) { // 将字节数组转换回字符串,并打印出来std::cout << ((char) receivebuffer[i]);}std::cout << std::endl;} else if (world_rank > 0) { // 其他进程什么都不做,只是等待接收消息(这里可以加入其他并行任务)// ...(这里可以加入其他并行任务)...} else { // 第一个进程只发送消息,不接收(这里可以加入其他并行任务) // ...(这里可以加入其他并行任务)...}// 清理 MPI 环境并退出程序MPI_Finalize();return 0;}```这个程序使用了 `MPI_Send` 和 `MPI_Recv` 来发送和接收消息。

提交python程序到集群运行在HPC集群上使用python代码(mpi4py)提交作业

提交python程序到集群运行在HPC集群上使用python代码(mpi4py)提交作业在HPC(高性能计算)集群上使用Python代码(mpi4py)提交作业,是一种常见且高效的方式。

HPC集群是由多台计算机组成的集合,并且集群中的节点可以同时运行多个任务,从而实现高并发和高性能计算。

使用mpi4py库可以在HPC集群上进行并行计算。

mpi4py是Python的一个模块,它对MPI(Message Passing Interface)进行了封装,使得在多台计算机上进行并行计算变得更加容易。

MPI是一种用于并行计算的标准,它定义了一组函数和语法规则,允许在多个计算节点之间进行通信和数据交换。

下面是使用mpi4py提交Python程序到HPC集群运行的一般步骤:1. 编写Python程序:首先,你需要编写一个Python程序,使用mpi4py库进行并行计算。

这个程序应该包含一些需要并行计算的任务,并使用mpi4py提供的函数在不同计算节点之间进行通信。

```bash#!/bin/bash#PBS -l nodes=4:ppn=8#PBS -N myjobcd $PBS_O_WORKDIRmpiexec -np 32 python my_mpi_program.py```在这个提交脚本中,`#PBS`开头的注释行指定了作业的运行参数,例如使用的节点数和每个节点的进程数。

`cd $PBS_O_WORKDIR`用于切换到提交脚本所在的目录。

`mpiexec -np 32 python my_mpi_program.py`是实际运行作业的命令,其中`-np 32`指定了使用32个进程来运行Python 程序。

3.提交作业:使用提交脚本提交作业。

在终端中,你可以使用类似于以下的命令来提交作业:```bashqsub my_submit_script.sh```这个命令将根据提交脚本的规格和资源需求,将作业提交到HPC集群的调度系统中进行排队和调度。

simple方法

simple方法

SIMPLE算法全称为Semi-Implicit Method for Pressure-Linked Equations,意思是压力耦合方程组的半隐式方法,是一种计算流体力学中常用的数值方法,用于求解不可压缩流动的Navier-Stokes方程。

SIMPLE算法的原理是将动量方程和连续性方程分别离散化为矩阵形式,然后通过对角线分解和逆运算,得到压力泊松方程和速度修正方程。

通过迭代求解这两个方程,可以得到压力场和速度场。

SIMPLE算法自1972年问世以来在世界各国计算流体力学及计算传热学界得到了广泛的应用,这种算法提出不久很快就成为计算不可压流场的主要方法,随后这一算法以及其后的各种改进方案成功的推广到可压缩流场计算中,已成为一种可以计算任何流速的流动的数值方法。

SIMPLE算法讲解

SIMPLE算法讲解在计算机科学中,算法是一组解决问题的明确指令步骤。

算法可以用于执行各种复杂任务,从图像处理到数据排序。

而SIMPLE(The Symbolic Instruction Manipulation Program for Libraries and Education)算法是为了简化低级机器指令的编写而产生的一种高级编程语言。

本篇文章将简要介绍SIMPLE算法及其应用。

SIMPLE算法最初由美国化学家Daniel D. McCracken于1960年代开发,旨在为非计算机专业人士提供一种易于学习和使用的编程语言。

SIMPLE算法的语法类似于英语,因此非常易于理解和阅读。

它被广泛应用于教育领域,并被用作初学者编程课程的教学工具。

```BEGININPUTa,bc:=a+bOUTPUTcEND```上述代码的功能是输入两个数值a和b,然后将它们相加,并将结果输出。

通过这个简单的例子,我们可以看到SIMPLE算法注重指令的可读性和可理解性。

除了基本的输入输出操作,SIMPLE算法还提供了条件语句和循环语句等控制结构,使得编写复杂程序也变得相对容易。

例如,我们可以使用条件语句来实现一个简单的判断奇偶数的程序:```BEGININPUT numIF num % 2 = 0 THENOUTPUT "Even"ELSEOUTPUT "Odd"ENDIFEND```上述代码通过使用IF-ELSE语句对给定的数字进行判断,并输出相应的结果。

通过使用条件语句,我们可以根据不同的条件执行不同的指令,从而实现程序的分支控制。

SIMPLE算法还提供了多种数据类型和操作符,包括整型、字符型、浮点型、数组等。

这使得编写更复杂的程序成为可能。

同时,SIMPLE算法不仅可以用于简单的算术和逻辑操作,还可以进行文件读写、排序等更高级的计算操作。

尽管SIMPLE算法已经有一段时间没有被广泛使用,但它的原则和设计理念仍然对现代编程有一定的影响。

MPI编程指南

三、MPI消息 消息

• 一个消息好比一封信 • 消息的内容的内容即信的内容,在MPI中成为消息缓 消息的内容的内容即信的内容, 中成为消息缓 冲(Message Buffer) • 消息的接收发送者即信的地址,在MPI中成为消息封 消息的接收发送者即信的地址, 中成为消息封 装(Message Envelop)

MPI消息 数据类型 消息(数据类型 消息 数据类型)

表 2.1 M P I(C 语 言 绑 定 ) M P I_ B Y T E M P I_ C H A R M P I_ D O U B L E M P I_ F L O AT M P I _ IN T M P I_ L O N G M P I_ L O N G _ D O U B L E M P I_ PA C K E D M P I_ S H O R T M P I_ U N S IG N E D _ C H A R M P I_ U N S IG N E D M P I_ U N S IG N E D _ L O N G M P I_ U N S IG N E D _ S H O R T sh o rt u n s ig n e d c h a r u n s ig n e d in t u n s ig n e d lo n g u n s ig n e d s h o r t s ig n e d c h a r d o u b le f lo a t in t lo n g lo n g d o u b le M P I_ PA C K E D C MPI 中 预 定 义 的 数 据 类 型 M P I(F o r tr a n 语 言 绑 定 ) M P I_ B Y T E M P I_ C H A R A C T E R M P I_ C O M P L E X M P I_ D O U B L E _ P R E C IS IO N M P I_ R E A L M P I_ IN T E G E R M P I _ L O G IC A L CH ARA CTER CO M PLEX D O U B L E _ P R E C IS I O N REAL IN T E G E R L O G IC A L F o rtra n

MPI并行程序设计

为什么要用MPI?—优点

➢ 高可移植性:

MPI已在IBM PC机上、MS Windows上、所有主要 的Unix工作站上和所有主流的并行机上得到实 现。使用MPI作消息传递的C或Fortran并行程序 可不加改变地运行在IBM PC、MS Windows、 Unix工作站、以及各种并行机上。

➢MPI_Send操作指定的发送缓冲区是由count个类 型为datatype的连续数据空间组成,起始地址为 buf。注意:不是以字节计数,而是以数据类型 为单位指定消息的长度。

➢其中datatype数据类型:MPI的预定义类型或用 户自定义。通过使用不同的数据类型调用 MPI_Send,可以发送不同类型的数据。

➢ MPI有完备的异步通信:使得send,receive能与 计算重叠。

➢ 可以有效的在MPP上或Cluster上用MPI编程。

MPI+C 实现的“Hello World!”

#include <stdio.h> #include "mpi.h " main( int argc, char *argv[] ) {

更新的“Hello World!”

#include <stdio.h> #include "mpi.h" int main(int argc, char **argv){

int myid, numprocs; MPI_Init(&argc, &argv); MPI_Comm_size(MPI_COMM_WORLD, &size); MPI_Comm_rank(MPI_COMM_WORLD, &rank); printf(“Hello, World! I am %d of %d. /n, myid, numprocs); MPI_Finalize(); return 0; }

Python高性能并行计算之mpi4py

Python高性能并行计算之mpi4pympi4py是Python中的一个消息传递接口(MPI)的实现。

MPI是一种并行计算的标准,用于在多个计算节点之间进行通信和协调。

mpi4py允许开发者使用Python语言进行高性能并行计算,利用多台计算机上的多个处理器进行任务分配和执行。

MPI的并行计算模型基于消息传递,它允许不同计算节点之间通过发送和接收消息来交换数据和同步计算。

MPI提供了一套丰富的编程接口,包括进程管理、通信和同步操作等功能,可以满足各种类型的并行计算需求。

mpi4py是Python语言对MPI标准的实现,它包含了一系列的模块和类,用于管理MPI的进程和通信操作。

开发者可以创建MPI进程,发送和接收消息,进行同步操作,以及执行各种MPI操作。

mpi4py允许开发者通过简单的Python语法来编写并行计算程序。

开发者可以使用Python的标准语法来定义任务和数据,并使用mpi4py提供的函数和类来进行进程管理和通信操作。

mpi4py提供了一系列的函数和类,用于创建和管理MPI进程,发送和接收消息,以及进行同步操作。

使用mpi4py进行并行计算可以带来很多好处。

首先,mpi4py充分利用了多个计算节点上的多个处理器,可以显著提高计算速度和效率。

其次,mpi4py提供了丰富的并行计算功能和工具,可以简化程序的编写和调试过程。

最后,mpi4py是一个开源项目,拥有庞大的社区和用户群体,可以获取大量的支持和资源。

然而,使用mpi4py进行并行计算也存在一些挑战和限制。

首先,mpi4py需要在多个计算节点上安装和配置MPI软件,需要一定的专业知识和技能。

其次,mpi4py是一个底层的接口,需要开发者具有一定的并行计算经验和编程能力,否则可能会导致程序的性能和正确性问题。

另外,mpi4py并不适用于所有类型的并行计算应用,例如图形处理和深度学习等计算密集型任务。

总结来说,mpi4py是Python中高性能并行计算的一个重要工具,它基于MPI标准,提供了丰富的并行计算功能和接口。

mpi-program例子c++

n = sqrt(4.0/(3.0*eps)); h = 1.0/n; precision = n/np;

if(myid == 0) {

s = 2.0; xi = 0; is = 0;

ie = precision; } else if(myid == np-1) {

//Read the order of matrix if(iam == 0) {

printf("The order of matrix:"); scanf("%d", &m); } MPI_Bcast(&m, 1, MPI_INT, 0, comm);

k = m - 1; n = m; // npsr = np/2; npsr = sqrt(np + 0.5);

}

int main(int argc, char **argv) {

int iam, myid, np; int m, n, i, j, k; int npsr; int color, rcolor, rst, ccolor, key, ma, ka, kb, nb, mr, nr, kr, rowid, colid, kt, next, front; double a[lda][lda], b[ldb][ldb], c[ldc][ldc], t[ldt][ldt]; MPI_Status status; MPI_Comm comm, mycomm, rowcomm, colcomm;

ccolor = myid % npsr; MPI_Comm_split(mycomm, ccolor, key, &colcomm); MPI_Comm_rank(colcomm, &rowid);

mpi openmp 案例

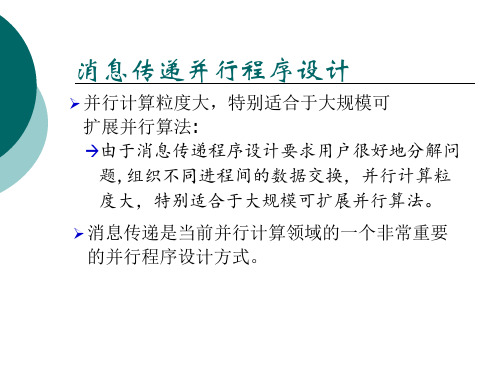

mpi openmp 案例MPI和OpenMP是并行计算中常用的编程模型,它们可以在多核和分布式系统中实现并行计算,提高计算效率。

本文将介绍一些MPI和OpenMP的案例,以展示它们在实际应用中的优势和用法。

引言概述:MPI和OpenMP是并行计算中常用的编程模型,它们分别适用于分布式和共享内存系统。

MPI(Message Passing Interface)是一种消息传递的并行编程模型,适用于分布式系统中的并行计算;而OpenMP是一种共享内存的并行编程模型,适用于多核系统中的并行计算。

下面将分别介绍它们在实际应用中的案例。

正文内容:1. MPI案例1.1 分布式矩阵乘法- 使用MPI实现矩阵乘法可以将计算任务分配给不同的进程,每个进程负责计算一部分矩阵乘法的结果。

- 使用MPI的消息传递机制,进程之间可以相互通信,将计算结果进行汇总,得到最终的矩阵乘法结果。

- 这种分布式矩阵乘法可以充分利用分布式系统的计算资源,提高计算效率。

1.2 并行排序算法- 使用MPI可以将排序任务分配给不同的进程,每个进程负责排序一部分数据。

- 进程之间可以通过消息传递机制交换数据,实现分布式的排序算法。

- 这种并行排序算法可以大大减少排序的时间复杂度,提高排序的效率。

2. OpenMP案例2.1 并行矩阵运算- 使用OpenMP可以将矩阵运算任务分配给不同的线程,每个线程负责计算一部分矩阵运算的结果。

- 多个线程可以共享内存,可以直接访问共享的数据,减少了数据的拷贝和通信开销。

- 这种并行矩阵运算可以充分利用多核系统的计算资源,提高计算效率。

2.2 并行图像处理- 使用OpenMP可以将图像处理任务分配给不同的线程,每个线程负责处理一部分图像数据。

- 多个线程可以并行地对图像进行处理,提高了图像处理的速度。

- 这种并行图像处理可以广泛应用于图像处理领域,如图像滤波、图像分割等。

总结:MPI和OpenMP是并行计算中常用的编程模型,它们分别适用于分布式和共享内存系统。

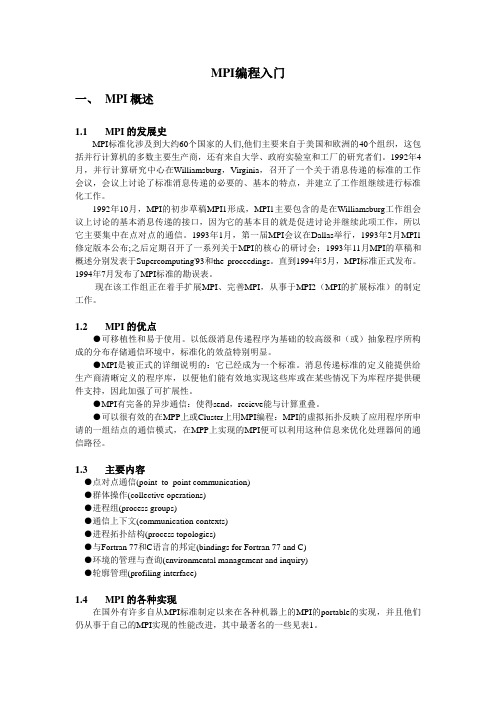

MPI编程入门&MPI编程进阶

MPI编程入门一、MPI概述1.1 MPI的发展史MPI标准化涉及到大约60个国家的人们,他们主要来自于美国和欧洲的40个组织,这包括并行计算机的多数主要生产商,还有来自大学、政府实验室和工厂的研究者们。

1992年4月,并行计算研究中心在Williamsburg,Virginia,召开了一个关于消息传递的标准的工作会议,会议上讨论了标准消息传递的必要的、基本的特点,并建立了工作组继续进行标准化工作。

1992年10月,MPI的初步草稿MPI1形成,MPI1主要包含的是在Williamsburg工作组会议上讨论的基本消息传递的接口,因为它的基本目的就是促进讨论并继续此项工作,所以它主要集中在点对点的通信。

1993年1月,第一届MPI会议在Dallas举行,1993年2月MPI1修定版本公布;之后定期召开了一系列关于MPI的核心的研讨会;1993年11月MPI的草稿和概述分别发表于Supercomputing'93和the proceedings。

直到1994年5月,MPI标准正式发布。

1994年7月发布了MPI标准的勘误表。

现在该工作组正在着手扩展MPI、完善MPI,从事于MPI2(MPI的扩展标准)的制定工作。

1.2 MPI的优点●可移植性和易于使用。

以低级消息传递程序为基础的较高级和(或)抽象程序所构成的分布存储通信环境中,标准化的效益特别明显。

●MPI是被正式的详细说明的:它已经成为一个标准。

消息传递标准的定义能提供给生产商清晰定义的程序库,以便他们能有效地实现这些库或在某些情况下为库程序提供硬件支持,因此加强了可扩展性。

●MPI有完备的异步通信:使得send,recieve能与计算重叠。

●可以很有效的在MPP上或Cluster上用MPI编程:MPI的虚拟拓扑反映了应用程序所申请的一组结点的通信模式,在MPP上实现的MPI便可以利用这种信息来优化处理器间的通信路径。

1.3 主要内容●点对点通信(point_to_point communication)●群体操作(collective operations)●进程组(process groups)●通信上下文(communication contexts)●进程拓扑结构(process topologies)●与Fortran 77和C语言的邦定(bindings for Fortran 77 and C)●环境的管理与查询(environmental management and inquiry)●轮廓管理(profiling interface)1.4 MPI的各种实现在国外有许多自从MPI标准制定以来在各种机器上的MPI的portable的实现,并且他们仍从事于自己的MPI实现的性能改进,其中最著名的一些见表1。

simple 算法、simplec 算法和 piso 算法

simple 算法、simplec 算法和 piso 算法简单算法是指实现相对简单的算法,通常是由少量的步骤组成,适用于解决基础性问题。

简单算法的特点是易于理解和实现,但可能在处理复杂问题时效率较低。

下面将介绍几种常见的简单算法:顺序查找、冒泡排序和线性插值搜索。

顺序查找(Sequential Search)是一种简单的搜索算法,它逐一比较列表中的元素,直到找到匹配的元素或遍历完整个列表。

这个算法的时间复杂度为O(n),其中n为列表的长度。

顺序查找适用于小型列表或未排序列表,但在大型数据集上,效率较低。

它的伪代码如下:```function sequentialSearch(list, target):for i from 0 to length(list) - 1 doif list[i] is equal to target thenreturn ireturn -1```冒泡排序(Bubble Sort)是一种简单的排序算法,它重复地比较相邻的两个元素,并交换它们直到整个列表排序完成。

冒泡排序的时间复杂度为O(n^2),其中n为列表的长度。

尽管冒泡排序的效率较低,但它实现简单,适用于小型数据集或基础排序需求。

它的伪代码如下:```function bubbleSort(list):for i from 0 to length(list) - 1 dofor j from 0 to length(list) - i - 1 doif list[j] > list[j+1] thenswap(list[j], list[j+1])```线性插值搜索(Linear Interpolation Search)是一种简单的搜索算法,用于在有序列表中寻找目标元素。

它利用目标元素与列表范围的线性关系进行搜索,从而提高搜索效率。

线性插值搜索的时间复杂度为O(log(log(n))),其中n为列表的长度。

SIMPLE算法介绍

SIMPLE算法介绍简单算法指的是解决问题的一种基础算法,它通常具有简单直观、易于理解和实现的特点。

本文将介绍几个常见的简单算法,包括递归算法、排序算法、算法和贪心算法。

一、递归算法递归算法是指一个函数调用自身的过程。

它将一个大型的问题拆分为一个或多个与原问题类似但规模较小的子问题,并通过递归调用解决这些子问题,最后组合子问题的结果来解决原问题。

递归算法通常有两个部分:基线条件和递归条件。

基线条件指的是递归停止的条件,递归条件指的是问题拆分为子问题的条件。

例如,计算阶乘的算法可以使用递归实现:```pythondef factorial(n):if n == 1:return 1else:return n * factorial(n-1)```递归算法可以解决一些复杂的问题,但是由于递归调用本身的开销较大,可能会导致性能问题和栈溢出等问题。

二、排序算法排序算法的目标是将一组数据按照一些规则进行排序。

常见的排序算法有冒泡排序、插入排序、选择排序、快速排序、归并排序等。

冒泡排序的思想是依次比较相邻的元素,如果顺序不对则交换它们的位置,直到全部元素都按照规则排序。

插入排序的思想是将每个元素插入到已经排好序的子序列中的适当位置。

选择排序的思想是每次选择最小的元素放到已经排好序的子序列的末尾。

快速排序的思想是选取一个基准值,将小于基准值的元素都放到基准值的左边,大于基准值的元素都放到基准值的右边,然后对左右两个子序列递归地进行快速排序。

归并排序的思想是将序列拆分成两个子序列,对两个子序列分别进行排序,然后将两个排好序的子序列合并成一个有序序列。

三、算法算法是指在给定的数据集中查找一些特定元素或满足其中一种条件的元素。

常见的算法有顺序、二分、深度优先和广度优先等。

顺序是逐个比较数据集中的元素,直到找到目标元素或遍历完整个数据集。

二分是在已经排好序的数据集中逐步缩小范围。

首先将数据集分成两半,然后判断目标元素在哪一半中,再递归地对目标半部分进行二分。

MPI并行编程系列二快速排序

MPI并行编程系列二快速排序阅读:63评论:0作者:飞得更高发表于2010-04-06 09:00原文链接在上一篇中对枚举排序的MPI并行算法进行了详细的描述和实现,算法相对简单,采用了并行编程模式中的单程序多数据流的并行编程模式。

在本篇中,将对快速排序进行并行化分析和实现。

本篇代码用到了上篇中的几个公用方法,在本篇中将不再做说明。

在本篇中,我们首先对快速排序算法进行描述和实现,并在此基础上分析此算法的并行性,确定并行编程模式,最后给出该算法的MPI实现。

一、快速排序算法说明快速排序时一种最基本的排序算法,效率相对较高。

其基本思想是:在当前无序数组R[1,n]中选取一个记录作为比较的"基准",即作为排序中的"轴"。

经过一趟排序后,当前无序数组R[1,n]就会以这个轴为核心划分为两个无序的子区r1[1,i-1],r2[i,n]。

其中左边的无序子区都会比"轴"小,右边的无序子区都会比"轴"大。

这样下一趟排序,我们就可以对这两个子区用同样的方法进行划分排序,知道所有的无序子区中的记录均排好为止。

根据算法的说明,快速排序时一个典型的递归算法,算法描述如下:无序数组R[1],R[2],.,R[n]quick_sort(R,start,end)if(start end)r=partion(R,start,end)quick_sort(R,start,r-1)quick_sort(R,r+1,end)endif end quick_sort方法partion的作用就是选取"轴",并将数组分为两个无序子区,并将该"轴"的最终位置返回,在这里我们选择数组的第一个元素为"轴",其算法描述为:partion(R,start,end)r=R[start]while(start end)while((R[end]=r)&&(start end))end--end ehile R[start]=R[end]while((R[start]r)&&(start end))start++end wile R[end]=R[start]end while R[start]=r return start end partion该排序算法的性能好坏主要取决于"轴"的选定,即无序数组的划分是否均衡。

消息传递编程接口

MPI 商业版本

一些厂商也提供商业版的 MPI 系统,许多是在 MPICH 的基础上优化产生的

MPI 下载与安装

MPICH 下载

/

MPICH 的安装

参考 MPICH Install Guide

MPICH 的使用

参考 MPICH User Guide

MPI 消息

进程号是在进程组或通信器被创建时赋予的 空进程:MPI_PROC_NULL

与空进程通信时不做任何操作

消息(message)

一个消息指进程间进行的一次数据交换 一个消息由通信器、源地址、目的地址、消息标签、 和数据构成

第一个 MPI Fortran 程序

program main include 'mpif.h' character * (MPI_MAX_PROCESSOR_NAME) proc_name integer myid, numprocs, namelen, rc, ierr

启动编译生成的可执行文件 hello

进程 0 MPI_INIT MPI_COMM_RANK myid=0 MPI_GET_PROCESSOR_NAME proc_name=c1 namelen=2 Write hello, I am proc. 0 of 4 on c1 MPI_FINALIZE 进程 1 进程 2 进程 3 MPI_INIT MPI_COMM_RANK myid=4 MPI_GET_PROCESSOR_NAME proc_name=c1 namelen=2 Write hello, I am proc. 3 of 4 on c1 MPI_FINALIZE

MPI 程序中进程间的通信必须通过通信器进行 通信器分为域内通信器(同一进程组内的通信)和域间 通信器(不同进程组的进程间的通信) MPI 程序启动时自动建立两个通信器: MPI_COMM_WORLD :包含程序中所有 MPI 进程 MPI_COMM_SELF :有单个进程独自构成,仅包含自己 MPI 程序中,一个 MPI 进程 由一个进程组和在该组中的进程号唯一确定;或 由一个通信器和在该通信器中的进程号唯一确定 进程号是相对进程组或通信器而言的,同一进程在不 同的进程组或通信器中可以有不同的进程号

programming python中文版

programming python中文版Python是一种高级编程语言,广泛应用于各种领域,包括软件开发、数据分析和机器学习等。

在编写Python代码时,函数和模块是非常重要的概念和工具。

本文将带你一步一步了解函数和模块在Python中的使用。

函数是一段可以重复使用的代码块,它能接受参数并返回一个结果。

我们可以使用函数来封装一段特定的功能,使得代码更容易理解和维护。

在Python中,定义函数非常简单。

我们可以使用关键字`def`加上函数名和一对圆括号来定义一个函数。

圆括号内可以包含函数参数。

函数体需要缩进,通常使用四个空格来缩进。

下面的例子是一个简单的函数,它将两个参数相加并返回结果:pythondef add_numbers(a, b):result = a + breturn result上述代码定义了一个名为`add_numbers`的函数,它接受两个参数`a`和`b`。

函数体内部将`a`和`b`相加,将结果赋值给`result`变量,然后使用`return`语句返回结果。

我们可以通过调用函数来使用它。

例如,我们可以将`add_numbers`函数应用到两个数上:pythonsum_result = add_numbers(3, 5)print(sum_result) # 输出结果为8在上述代码中,我们首先调用`add_numbers`函数,并将参数`3`和`5`传递给它。

函数执行后返回结果`8`,我们将其赋值给`sum_result`变量,并通过`print`语句打印结果。

除了通常的函数定义方式外,我们还可以使用匿名函数。

匿名函数是一种没有函数名的函数,通常使用`lambda`关键字定义。

我们可以直接在需要的地方定义匿名函数,并将其作为参数传递给其他函数。

下面的例子展示了如何使用匿名函数来对列表进行排序:pythonnumbers = [5, 2, 8, 1, 6]sorted_numbers = sorted(numbers, key=lambda x: x)print(sorted_numbers) # 输出结果为[1, 2, 5, 6, 8]在上述代码中,`lambda x: x`定义了一个匿名函数,它接受一个参数`x`并返回`x`本身。

MPI并行编程入门

MPI几个基本函数

• 获取处理器的名称 C:

int MPI_Get_processor_name(char *name, int *resultlen)

Fortran 77:

MPI_GET_PROCESSOR_NAME(NAME, RESULTLEN, IERR) CHARACTER *(*) NAME INTEGER RESULTLEN, IERROR • 在返回的name中存储所在处理器的名称 • resultlen存放返回名字所占字节 • 应提供参数name不少于MPI_MAX_PRCESSOR_NAME个字

MPI基础知识

• 进程与消息传递 • MPI重要概念 • MPI函数一般形式 • MPI原始数据类型 • MPI程序基本结构 • MPI几个基本函数 • 并行编程模式

进程与消息传递

• 单个进程(process) – 进程与程序相联,程序一旦在操作系统中运行即成为进程。 进程拥有独立的执行环境(内存、寄存器、程序计数器等) ,是操作系统中独立存在的可执行的基本程序单位 – 串行应用程序编译形成的可执行代码,分为“指令”和“数据”两 个部分,并在程序执行时“独立地申请和占有”内存空间,且 所有计算均局限于该内存空间。

MPI几个基本函数

• 得到通信器的进程数和进程在通信器中的标号 C:

int MPI_Comm_size(MPI_Comm comm, int *size) int MPI_Comm_rank(MPI_Comm comm, int *rank)

Fortran 77:

MPI_COMM_SIZE(COMM, SIZE, IERROR) INTEGER COMM, SIZE, IERROR

MPI重要概念

• 进程组(process group) 指MPI 程序的全部进程集合的一个有序

MPI基本函数

int MPI_Reduce(void *sendbuf,

void *recvbuf,

int count,

MPI_Datatype recvtype,

MPI_OP op,

int root,

MPI_Comm comm)

发送缓冲区地址

接收缓冲区地址

MPI_FLOAT float

int MPI_Recv(void *buf,

int count,

MPI_Datatype datatype,

int source,

int tag,

MPI_Coቤተ መጻሕፍቲ ባይዱm comm,

MPI_Status *status)

接收缓冲区(已装载)

缓冲区内最大项数

项的数据类型

源进程序号

消息标识

通信子

状态(返回的)

接收消息(锁定)

int MPI_Isend(void *buf,

int count,

MPI_Datatype datatype,

int dest,

int tag,

MPI_Comm comm,

MPI_Request *request)

发送缓冲区

缓冲区内消息项数

消息项的数据类型

MPI常用例程

初等例程

函数名

参数

动作

int MPI_Init(int *argc,

char **argv[])

来自main()的参数

来自main()的参数

初始化MPI环境

int MPI_Finalize(void)

终止MPI执行环境

int MPI_Comm_rank(MPI_Comm comm,

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

a rXiv:cs /04127v1[cs.D C]27Jan24ClassdescMP:Easy MPI programming in C++Russell K.Standish 12and Duraid Madina 21School of Mathematics 2High Performance Computing Support Unit University of New South Wales,Sydney,2052,Australia {R.Standish,duraid }@.au .au/classdesc Abstract.ClassdescMP is a distributed memory parallel programming system for use with C++and MPI.It uses the Classdesc reflection sys-tem to ease the task of building complicated messages to be sent between processes.It doesn’t hide the underlying MPI API,so it is an augmenta-tion of MPI ers can still call standard MPI function calls if needed for performance reasons.1Classdesc Reflection MPI is an application programming interface (API -in other words library of functions calls)for passing data from one unix process to another.The processes may be running on the same computer,or completely distinct computers,so this system provides a means of implementing distributed memory parallel processing .MPI has been used to great success in a variety of Engineering and Scientific codes where large arrays of the same type of data (eg floating point numbers)need to be exchanged between processes.However,with object oriented codes,one really needs to send objects (which may well be compound)between pro-cesses.MPI does provide the MPI_Type functionality,which allows the descrip-tion of compound structures to be built up,however this is difficult to use,and doesn’t handle the case where the structure contains references to other objects (eg pointers).Object reflection allows straightforward implementation of serialisation (i.e.the creation of binary data representing objects that can be stored and later reconstructed),binding of scripting languages or GUI objects to ‘worker’objects and remote method invocation.Serialisation,for example,requires knowledge of the detailed structure of the object.The member objects may be able to serialised (eg a dynamic array structure),but be implemented in terms of a pointer to a heap object.Also,one may be interested in serialising the object in a machine independent way,which requires knowledge of whether a particular bitfield is an integer or floating point variable.Languages such as Objective C give objects reflection by creating class ob-jects and implicitly including an isa pointer in objects of that class pointing to the class object.Java does much the same thing,providing all objects with thenative(i.e.non-Java)method getClass()which returns the object’s class at runtime,as maintained by the virtual machine.When using C++,on the other hand,at compile time most of the information about what exactly objects are is discarded.Standard C++does provide a run-time type enquiry mechanism,however this is only required to return a unique signature for each type used in the program.Not only is this signature be compiler dependent,it could be implemented by the compiler enumerating all types used in a particular compilation,and so the signature would differ from program to program!The solution to this problem lies(as it must)outside the C++language per se,in the form of a separate program(classdesc)[2,5]which parses an in-put program and emits function declarations that know about the structure of the objects inside.These are generically termed class descriptors.The class descriptor generator only needs to handle class,struct and union definitions. Anonymous structs used in typedefs are parsed as well.What is emitted in the object descriptor is a sequence of function calls for each base class and member, just as the compiler generated constructors and destructors are formed.Function overloading ensures that the correct sequence of actions is generated at compile time.Once a class definition has been parsed by classdesc,and the emitted class descriptors included into the original program,an object of that class can be serialised into a buffer object using the<<operator.The>>operator can be used to extract the value back.#include"foo.h"//foo class definition#include"foo.cd"//foo class descriptor...pack_t buf;foo a=...;bar b=...;foo c;buf<<a<<b;//serialise a into buffer.buf>>c;//unpack buffer into c.Now c==a.Once a buffer is packed,it can be saved to afile,or transferred over a network connection by using its public members data,which points to the data,and size which gives the number of bytes currently in the buffer.A variant of pack_t is the xdr_pack type,which uses the XDR library to rep-resent the objects in a machine independent form.This is needed if the receiver of the serialised object is of a different architecture(eg endianess,or wordsize) to the sender.The only real reason for using MPI_Type in MPI is to support messages of compound objects between differing processors in a heterogenous cluster. xdr_pack gives heterogenous cluster support“for free”.2MPIbufMPIbuf is a derived type which inherits from pack_t(or xdr_pack if the HETERO flag is set).Similar to the notion of manipulators with the standard iostream library,MPIbuf has manipulators,such as send():buf<<a<<b<<send(1);which sends a and b to process1.Process1can receive this message with:buf.get()>>a>>b;Other manipulators and methods of MPIbuf implement collective operations such as broadcast,gather and scatter:buf<<a<<b<<bcast(0)>>a>>b;suffices to broadcast the values of a and b to all processors.By default,an MPIbuf uses the MPI_COMM_WORLD communicator,which in-cludes all processes started by the MPI system.Collective operations can be restricted to subsets of processes by defining an MPI communicator object us-ing MPI_Comm_create and assigned to the Communicator member of the MPIbuf object.3MPISPMDAn MPI program requires a certain amount of structure to just to setup the processes,and tear them down at thefinish,before any real coding starts.A typical MPI program might do the following:main(int argc,char**argv){MPI_Init(&argc,&argv);MPI_Comm_size(&nprocs);MPI_Comm_rank(&myid);putation...MPI_Finalize();}One problem that frequently occurs is forgetting to call MPI_Finalize(), which needs to be called from all processes.This may occur because of an error condition,or otherwise abnormal exit from the program.This is a problem,as typical MPI implementations have resources such as shared memory segments that need freeing,and the slave processes need to be terminated.On a shared high performance computing system,stray processes consume CPU resources that may be better employed by other users.MPISPMD arranges for MPI_Finalize()to be called from its destructor.This has two advantages:MPI_Finalize()will be called as soon as the MPISPMD leaves its scope.Also,the destructor will be called if an exception is raised, leading to cleaner error handling.Unfortunately,if the program terminates froma conventional low level call to abort(),the cleanup will not take place.The above piece of code can be replaced by:main(int argc,char**argv){MPISPMD C(argc,argv);putation...}The number of processes and processor ID can be queried from MPISPMD::nprocs and MPISPMD::myid respectively.Note that you should not declare the MP-ISPMD object as a global variable,as some MPI implementations object to MPI_Finalize()being called after main()exits.If you need to refer to the MP-ISPMD object from global scope,declare a global pointer to MPISPMD,and initialise this from with main():MPISPMD*C;main(int argc,char**argv){MPISPMD comp(argc,argv);C=∁...4MPIslaveMPISPMD gives rather minimal support,as the SPMD programming model is already implicit in MPI.Another programming model which MPI is often putto is master-slave processing.Setting up the structure of a master-slave programis very tedious and error prone.The MPIslave class is designed to make master-slave algorithms simple to program.When a MPIslave object is instantiated,a slave“interpreter”object is in-stantiated on each process to receive messages from the master.As MPIslave needs to know the type of object to be instantiated on the slave processes,it is implemented as a template,with the type of slave object passed as the template parameter.A message sent to the slave process starts with a method pointer of type: void(S::*)(MPIbuf&)where S is the slave object type,followed by the argu-ments to be passed.That method of the slave object is then called,with the arguments passed through MPIbuf argument,and any return values also passed through MPIbuf argument:struct S{void foo(MPIbuf&args){int x,y,r;args>>x>>y;...args.reset()<<r;}};main(int argc,char**argv){MPIslave<S>C;MPIbuf buf;int x=1,y=2;buf<<&S::foo<<x<<y<<send(1);}When the MPIslave object is destroyed on the master process,it arranges for all the slave objects to be MPI_Finalized()and destroyed also.MPIslave also has features for managing a pool of idle slaves:MPIslave<S>C(argc,argv);vector<job>joblist;for(int p=1;p<C.nprocs&&p<joblist.size();p++)C.exec(C<<&S::do_job<<joblist[p]);while(p<joblist.size()){process_return(C.get_returnv());C.exec(C<<&S::do_job<<joblist[p++]);}while(!C.all_idle())process_return(C.get_returnv());5PerformanceSerialisation within classdesc is very efficient,as the relevant class descriptor functions are all inlined.The performance is comparable with that of simply copying the data into the buffer ing the MPIbuf mechanism incurs the overhead of copying into,and back out of an extra buffer,which is particularly wasteful if only one object is being sent.Clearly,within performance critical code,Classdesc MPIBuf operations may be replaced manually by an equivalent sequence of MPI_Send()s and MPI_Recv()s.As with any optimisation technique, this should be performed after profiling the code to ensure benefit.At the time of writing,Classdesc has only been deployed in one production code(Eco-Tierra)[4,3].Figure1shows the speedup curves on two machines: Napier,a28processor SGI Power Challenge,which is now a rather dated SMPnapier-0080aaanapier-0186aahFig.1.Speedup curves for Eco-Tierra single site entropy jobs.Two organisms (0080aaa and0186aah)were run on Napier,and one(0080aaa)on the APAC National Facility.architecture,and the APAC National Facility,a Compaq SC cluster,consisting of4processor nodes coupled by a Quadrics switch.0186aah is a larger job than0080aaa,so has more parallelism.It is still scaling linearly at24processors on Napier.The constant offset from linear scaling is due to the fact that the master thread does very little,if any computation.For some reason,the0186aah job is not running correctly on the APAC NF,so no benchmark results are available.With0080aaa,good scaling is obtained up to24processors,but on the APAC NF performance falls offafter that.This is most likely an effect of the master process being unable to keep slaves busy.However,the scaling discrepancy be-tween Napier and the APAC NF at lower process numbers indicates that network performance is partially limiting.It should be borne in mind though that at24 processes,the APAC NF is around6times faster than Napier!6DiscussionClassdesc was originally developed as part of the Eco Lab package to allow it to handle arbitrary agent-based models[5].It has been used in a project studying combinatorial spacetimes[1],and in several simulations using Graphcode,a C++ framework for agent-based simulation.Graphcode considers agents to be the ver-tices of arbitrary hypergraphs and is equipped with a graph partitioner to allowfor the efficient execution of agent-based simulations on parallel computers.To achieve this,Graphcode uses Classdesc internally,so that objects may be serial-ized for transmission between cooperating processes.ClassdescMP is a natural outgrowth of Classdesc,and has been successfully employed in the Eco-Tierra project[4,3].ClassdescMP is distributed as part of the Classdesc package,available from .au/classdesc.It should compile and be usable with any ANSI standard C++compiler.It has been tested on a variety of operating systems,including most Unices,Windows under Cygwin and Mac OS X. AcknowledgementsThe development of Classdesc and ClassdescMP was made possible with a grant from the Australian Partnership of Advanced Computing.Benchmark results were obtained on both APAC and ac3facilities.References1.Duraid Madina.Topology and complexity:From automata to agents.In Namatameet al.,editors,Complex Systems’02,pages141–147.Chuo University,September 2002.also to appear in Complexity International.2.Duraid Madina and Russell K.Standish.A system for reflection in C++.In Pro-ceedings of AUUG2001:Always on and Everywhere.Australian Unix Users Group, 2001.3.R.K.Standish.Open-ended artificial evolution.International Journal of Compu-tational Intelligence and Applications,2003.(accepted).4.Russell K.Standish.Some techniques for the measurement of complexity in Tierra.In Dario Floreano,Jean-Daniel Nicoud,and Francesco Mondada,editors,Advances in Artificial Life:5th European Conference,ECAL99,volume1674of Lecture Notes in Computer Science,page104,Berlin,1999.Springer.5.Russell plexity International,8,2001.。