基于知识的Agent强化学习算法分析与研究

基于强化学习的动态路径规划算法研究

基于强化学习的动态路径规划算法研究人类在日常生活中会遇到很多路径规划问题,例如规划行车路线、选择最短的步行路线等等。

而在机器人、智能控制等领域,路径规划算法更是不可或缺的一部分。

其中,强化学习作为人工智能中的重要研究方向之一,被广泛应用于路径规划问题中。

本文将探讨基于强化学习的动态路径规划算法,并阐述其研究进展和未来发展趋势。

一、强化学习简介强化学习(Reinforcement Learning)是机器学习中的一种方法,其描述了一个智能体(Agent)与环境(Environment)之间互动的过程。

智能体在环境中进行行动,每次行动会产生奖励或惩罚,从而逐步学习到一个最优的策略。

强化学习的核心在于智能体通过试错来进行学习,而不是事先给定数据或规则。

因此,强化学习可应用于许多领域,例如制造业、交通管理、游戏等等。

二、强化学习在路径规划中的应用路径规划问题是指在给定环境下,找到从起点到终点的最优路径。

而在强化学习中,路径规划问题一般被看作是一个马尔科夫决策过程(Markov Decision Process,MDP)。

在MDP中,一个智能体在当前状态下,根据其经验选择一个行动,进入到新的状态并得到奖励或惩罚。

智能体的目标就是在每一个状态下,选择最佳的行动,最终得到最优路径。

基于MDP的路径规划算法一般分为两类,一类是基于价值函数(Value Function)的算法,另一类是基于策略函数(Policy Function)的算法。

其中,基于价值函数的算法较为常见。

该类算法通过估计路径中每个状态的价值,最终选取路径最小的那个状态为最优状态。

三、动态路径规划算法的思路在实际场景中,往往会遇到环境随时间变化的情况,例如交通拥堵、路段封闭等。

这时,静态路径规划算法就无法满足需求,需要引入动态路径规划算法。

动态路径规划算法的基本思路是,在每个时间步中重新计算最优路径。

具体来说,算法需要考虑当前环境状态下的最优路径。

基于强化学习算法的群智能优化研究

基于强化学习算法的群智能优化研究群智能优化是指通过多个智能个体之间的协作和竞争,实现超越单一个体的优化目标。

随着计算机技术的发展,强化学习算法逐渐成为群智能优化的重要手段之一。

本文将对基于强化学习算法的群智能优化进行研究和探讨。

一、强化学习算法简介强化学习是机器学习的一种分支,其目的是通过智能体(agent)与环境的交互,不断学习和优化行为策略,从而使智能体在给定的任务中获得最大的奖励。

强化学习中的关键概念包括状态、行动、奖励和价值函数等。

强化学习算法包括Q学习、SARSA、深度强化学习等,这些算法在机器人控制、游戏设计等领域有广泛的应用。

二、群智能优化简介群智能优化是一种优化算法,其灵感来源于自然界中的生物群体行为。

在群智能优化中,每个个体代表一组参数或一个解,它们通过合作与竞争达到自我优化和全局优化的目的。

群智能优化包括遗传算法、蚁群算法、粒子群算法等。

与传统优化算法不同的是,群智能优化算法不需要问题的任何先验知识,通常适用于非线性、非凸、高维度的优化问题。

三、基于强化学习的群智能优化思路基于强化学习的群智能优化思路是将多个智能体看作一个整体,共同学习和优化,通过相互协作和竞争来提高优化效果。

具体而言,可以将群体中的每个智能体看作强化学习中的一个智能体,每个智能体学习和优化自己的行为策略,同时受到环境和其他智能体的影响。

在基于强化学习的群智能优化中,需要制定合适的奖励函数和惩罚函数,从而引导多个智能体朝着全局最优解收敛。

同时,还需要定义合适的状态空间、动作空间和价值函数等,从而实现对智能体行为的监督和优化。

相比于传统优化算法,基于强化学习的群智能优化能够更好地适应复杂的优化问题,并具有更高的优化效率和搜索能力。

四、基于强化学习的群智能优化应用案例基于强化学习的群智能优化已经被广泛应用于多个领域中,包括机器人控制、游戏设计和自然语言处理等。

以下是一些应用案例。

1. 机器人控制在机器人控制领域,基于强化学习的群智能优化能够帮助多个机器人协同完成任务,如协同搬运、协同建造等。

强化学习在飞行器控制中的应用研究

强化学习在飞行器控制中的应用研究引言强化学习(Reinforcement Learning)是一种机器学习的方法,通过在环境中进行试错,从而使机器能够通过反馈信号来调整自身的行为,以达到最优化的目标。

飞行器控制是一项复杂而关键的任务,对于确保飞行安全和提高性能至关重要。

强化学习在飞行器控制中的应用研究旨在通过训练智能体(agent)来自动调整和优化飞行器的控制策略,以提高其性能和适应不同环境条件。

一、强化学习基础1.1 强化学习原理强化学习是基于智能体与环境之间相互作用而建立起来的一种机器学习方法。

智能体通过观察环境状态,并根据当前状态采取相应的动作。

环境会根据智能体采取动作后反馈给予奖励或惩罚信号,以引导智能体调整其策略。

通过不断试错和优化,智能体逐渐形成最优策略。

1.2 强化学习算法强化学习算法主要包括Q-learning、Deep Q-Network(DQN)、Proximal Policy Optimization(PPO)等。

Q-learning是一种基于值函数的强化学习算法,通过学习价值函数的Q值来指导动作选择。

DQN 是一种基于深度神经网络的强化学习算法,通过将状态作为输入,输出每个动作的Q值来选择最优动作。

PPO是一种基于策略优化的强化学习算法,通过优化策略函数来提高智能体的性能。

二、飞行器控制中的应用研究2.1 自主飞行控制自主飞行控制是指飞行器在无人操作或协助下能够自主地进行起飞、导航、着陆等操作。

传统方法中,需要事先编写复杂的控制策略和规则来应对各种情况。

而利用强化学习方法可以让智能体在不同环境下自动调整和优化控制策略,从而提高自主飞行控制性能。

2.2 飞行路径规划飞行路径规划是指在给定起点和终点情况下,确定最佳路径以达到预定目标。

传统方法中常常使用启发式算法来进行路径规划,但难以应对复杂的环境和动态变化的条件。

利用强化学习方法,智能体可以通过不断试错和优化来学习最优路径规划策略,从而提高飞行路径规划的效率和准确性。

多Agent协作的强化学习模型和算法

本文所研究 的与 以上方法不同 , 注的是同时有多个 A 关

g n 共同学 习的问题 。在此基 础上 , 出 了一种基 于强化 学 et 提 习的多 Ag n 协 作学习模 型 , 过利用 其它 A e t et 通 g n 的经验和 知识 , 一个 学习 Ag n 可以更 快速地学习 , et 并且尽 可能地减少 错误 。Q学习是一个 有效 的无模 型的强化 学习算法 , 于单 对 A e t 习, gn 学 它是一个 集 中式 的、 效 的学 习算法 。但 是 , 有 对 于多 Ag n 学习来说 , et 由于状态 空间呈 指数增 长和 A e t g n 的 数量不断增多 , Q学 习算 法 的代 价过 于庞 大。本文提 出了一

维普资讯

计算机科学 2 0 Vo. 3 o 1 0 6 13 N . 2

多 A e t 作 的 强化 学 习模 型 和 算 法 gn 协

刘 菲 曾广周 宋言 伟

( 山东大学计算机科学与技术学院 济南 20 6 ) 50 1

摘 要 结合强化 学习技术讨论 了多 Ag n 协作 学习的过程 , et 构造 了一个新 的 多 A e t g n 协作 学 习模 型。在这个模 型

Ren o c me tL a n n o e n g rt m a e n M u t a e tCo p r t n i f r e n e r i g M d la d Al o ih B s d o l - g n o e a i i o

LI Fe Z U i ENG a g Z o S Gu n - h u ONG nW e Ya - i

ag r h p y ul te t n t li g n o p rtv e r igt g t e i utn i lo i m a sf l atn i omut— e tc o ea ielann o eh rsm la et t y o a y,S a a ee c g n r Oi c nm k s do h si t no t cin sln -i e r. Atls ee a td cso st et eb s iti a t oi a e n t ee t s o c mai n i a t ’ o g t o S o me rwa d a trlv n e iin ob h e t

人工智能中的强化学习理论研究及应用

人工智能中的强化学习理论研究及应用人工智能(AI) 是近年来备受瞩目的领域,其中强化学习(Reinforcement Learning, RL) 更是受到了广泛的关注。

本文将围绕强化学习的理论研究和应用展开论述。

一. 强化学习的定义和发展历程强化学习是一种从与环境的交互中学习做决策的机器学习方法。

强化学习中的智能体通过随时间的变化,在与环境交互的过程中,通过试错来学习行动和结果之间的关系,最终达到一个最优的决策策略。

强化学习的目标是学习如何做出使某个特定目标最有可能实现的动作序列,这与基于规则(Rule-based)、基于知识(Knowledge-based)和基于统计(Model-based)的机器学习方法不同。

在实际应用中,强化学习具有广泛的应用领域,如工业控制、游戏、金融、医疗保健等。

强化学习的发展历程也值得关注,早期的强化学习可以追溯到上世纪50年代,以应用心理学为基础。

1960年代到1980年代,强化学习从心理学领域走向计算机科学,随着计算机技术和算法的发展,强化学习逐渐成为一个研究热点。

但由于计算资源和理论框架上的限制,直到2010年左右,强化学习才开始进入大众视野。

2013年,Google DeepMind 团队利用深度神经网络结合强化学习算法,开创了“深度强化学习(Deep Reinforcement Learning, DRL)” 的新时代,引起了广泛的关注,并取得了一系列的突破性成果,如战胜人类围棋大师李世石的AlphaGo 等。

二. 强化学习的理论研究1. 基本概念强化学习的一个核心概念是 Markov 决策过程(Markov Decision Process, MDP),它主要用来描述强化学习的决策过程。

MDP 指的是随机环境、离散/连续状态、离散/连续动作、奖励信号等组成的一个数学模型。

MDP 中的智能体在不同的状态下采取不同的动作,得到不同的奖励,随着时间的推移,智能体的行为会逐渐趋于最优。

强化学习算法中的策略评估方法详解(Ⅰ)

强化学习算法中的策略评估方法详解强化学习是一种通过试错来学习最优决策的机器学习方法。

在强化学习中,一个主体(agent)根据环境的反馈不断调整自己的行为,以达到最优的目标。

而策略评估则是强化学习算法中非常重要的一环,它用来评价当前策略的好坏,为接下来的决策提供指导。

本文将对强化学习算法中的策略评估方法进行详细的探讨,希望能够为读者对强化学习算法有更深入的理解。

一、蒙特卡洛方法在强化学习中,蒙特卡洛方法是一种常用的策略评估方法。

它通过对策略进行多次模拟,并根据模拟结果来评估策略的好坏。

具体来说,蒙特卡洛方法会对每个状态-动作对进行多次模拟,然后根据这些模拟的结果来计算该状态-动作对的价值。

最后,根据这些价值来评估策略的优劣。

蒙特卡洛方法的优点在于它不需要对环境进行过多的假设,只需要通过模拟来获取策略的评估值。

然而,蒙特卡洛方法也有一定的局限性,比如需要进行大量的模拟才能得到可靠的评估结果,计算量较大,且对于连续状态空间的问题并不适用。

二、时序差分方法时序差分方法是另一种常用的策略评估方法。

它通过对策略进行单步模拟,并根据单步模拟的结果来逐步更新策略的价值。

具体来说,时序差分方法会根据每一步的奖励信号和下一步的价值估计来更新当前的价值估计。

这样,通过不断地迭代更新,最终可以得到策略的价值估计。

时序差分方法的优点在于它可以在每一步模拟之后就进行价值的更新,不需要等到整个模拟结束之后才进行评估。

这样可以大大减少计算量,提高评估效率。

然而,时序差分方法也有一定的局限性,比如对于噪音较大的环境会导致价值的不稳定更新。

三、脱机学习方法除了蒙特卡洛方法和时序差分方法,脱机学习方法也是一种常用的策略评估方法。

它通过离线的方式进行策略评估,即不需要与环境进行实时交互,而是根据历史数据进行策略的评估。

具体来说,脱机学习方法会利用已经收集到的数据来进行策略的评估,比如基于经验回放的方法。

脱机学习方法的优点在于它可以利用历史数据进行策略的评估,不需要实时与环境进行交互。

AI技术中的强化学习算法实现方法介绍

AI技术中的强化学习算法实现方法介绍强化学习是一种机器学习方法,通过智能体(Agent)在与环境进行交互的过程中,通过试错来寻找最优策略。

近年来,随着人工智能技术的不断发展和应用需求的增加,强化学习在各个领域中得到了广泛的关注和应用。

本文将介绍AI技术中常用的强化学习算法实现方法,包括价值迭代、策略梯度以及深度强化学习等。

一、价值迭代算法价值迭代是一种基于贝尔曼方程的强化学习算法,其核心思想是通过迭代计算Q值函数或V值函数来寻找最优策略。

在每个状态下,根据当前策略选择动作,并获得反馈奖励和下一个状态。

然后使用Bellman方程更新值函数,直至达到收敛条件。

1. 价值迭代算法过程(1)初始化价值函数:将所有状态的初始估计设置为0;(2)重复执行以下步骤直到收敛:a. 对于每个状态s,在当前策略下选择一个动作a;b. 执行动作a并观察下一个状态s'以及获得的奖励r;c. 根据Bellman方程更新当前状态的价值函数:V(s) = max_q(Q(s,a));(3)返回收敛后的价值函数。

2. 价值迭代算法的优缺点(1)优点:对于小规模问题,能够找到最优策略;(2)缺点:在大规模问题中,收敛速度较慢,并且需要对整个状态-动作空间进行遍历计算,计算复杂度高。

二、策略梯度算法策略梯度是一类直接优化策略参数的强化学习算法。

其核心思想是通过采样经验轨迹,并根据采样轨迹的回报来近似地估计策略梯度,从而不断改进策略参数以达到最优。

常用的策略梯度方法包括REINFORCE、Actor-Critic等。

1. REINFORCE算法REINFORCE是一种基于蒙特卡洛采样的策略梯度算法。

它通过不断采样经验轨迹,并根据回报来估计目标函数关于参数的梯度,以更新策略参数。

具体步骤如下:(1)初始化随机策略参数θ;(2)重复执行以下步骤直到收敛:a. 采样一条经验轨迹,并计算轨迹的回报;b. 根据回报计算目标函数关于参数的梯度∇_θ J(θ);c. 更新参数:θ = θ + α∇_θ J(θ),其中α是学习率。

强化学习算法中的随机策略方法详解(八)

强化学习是一种通过试错来学习最佳行为的机器学习方法,随机策略是其中的一种重要方法。

本文将详细探讨强化学习算法中的随机策略方法。

首先,我们需要了解什么是随机策略。

在强化学习中,策略是指智能体(agent)在特定状态下所采取的行为。

随机策略是指在每个状态下,智能体以一定的概率选择任何可能的行为,而不是根据某种确定的规则来选择行为。

相对而言,确定性策略则是在每个状态下选择一个确定的行为。

随机策略的引入可以增加探索的可能性,有助于发现更优的策略。

接下来,我们介绍几种常见的随机策略方法。

首先是ε-greedy策略,这是一种最简单的随机策略方法。

在ε-greedy策略中,智能体以概率1-ε选择当前最优的动作,以概率ε选择随机动作。

这样可以在一定程度上保证智能体在探索新的动作和利用已知的最优动作之间保持平衡。

ε-greedy策略是强化学习中最常用的随机策略之一。

另一种常见的随机策略是softmax策略,也称为Boltzmann策略。

在softmax策略中,每个动作的概率由动作值函数决定,概率与动作值成比例。

采用softmax策略时,概率较高的动作更容易被选择,而概率较低的动作也有一定的机会被选择,这有利于智能体发现更优的策略。

除了这两种常见的随机策略方法,还有一种较为特殊的方法叫做随机参数化策略。

在随机参数化策略中,策略本身是由一个概率分布参数化而成的,参数本身也是随机的。

智能体不仅要学习策略的具体形式,还需要学习分布参数的取值。

随机参数化策略方法在一些特定的强化学习问题中表现出了较好的性能。

了解了不同的随机策略方法,接下来我们将讨论随机策略方法在强化学习中的应用。

首先是探索与利用的平衡。

在强化学习中,智能体需要在探索未知的状态和动作空间,同时利用已有的知识来获取奖励。

随机策略方法可以帮助智能体在探索和利用之间取得平衡,从而更好地学习最优策略。

另外,随机策略方法还可以应用在多智能体博弈中。

在多智能体环境中,智能体需要根据其他智能体的策略来选择最优的行为。

强化学习中的探索与利用的平衡

强化学习中的探索与利用的平衡强化学习是一种机器学习方法,旨在通过与环境的交互学习如何做出最优决策。

其中一个核心问题是探索与利用的平衡,即在学习过程中,如何选择已有知识和尝试新行动之间的平衡点。

本文将探讨强化学习中这一关键问题的挑战和解决方法。

1. 强化学习简介强化学习是一种通过试错来学习的机器学习方法,其核心是智能体(Agent)与环境进行交互,通过观察环境的反馈来调整自己的行为。

在每个时间步,智能体基于当前状态采取行动,并获得环境返回的奖励信号。

智能体的目标是通过学习最优策略,最大化长期累计奖励。

2. 探索与利用的平衡问题在强化学习中,探索与利用是两个截然不同的行为。

利用是指基于当前已有的知识选择最优的行动,以获取即时的最大回报。

而探索是指尝试未知的行动,以便获取更多关于环境的信息。

这两者之间的平衡是非常关键的,如果选择过度探索,则会浪费时间和资源;而如果选择过度利用,则无法发现新的优化策略。

3. 挑战与解决方法在强化学习中,探索与利用的平衡是一个非常具有挑战性的问题。

以下是几种常见的解决方法:a) ε-Greedy策略ε-Greedy策略是一种简单而常用的方法,它以ε的概率进行探索,以1-ε的概率进行利用。

在每个时间步,智能体根据一个随机数与ε进行比较,如果小于ε,则进行探索,否则进行利用。

这种方法能够平衡探索和利用的需求,但是ε的取值需要合理选择,太高会导致过度探索,太低则会导致过度利用。

b) UCB算法UCB(Upper Confidence Bound)算法是一种采用置信上界的方法,在选择行动时平衡了探索和利用。

该算法基于一个原则,即未尝试过的行动可能是最有希望的,因此它会对每个行动添加一个置信上界的值,这个值与行动的历史回报和尝试次数有关。

通过选择具有最高置信上界的行动,UCB算法能够实现探索与利用的平衡。

c) Thompson抽样Thompson抽样是一种基于贝叶斯理论的方法,它通过对策略进行采样和更新来实现探索与利用的平衡。

基于知识的Agent强化学习算法分析与研究

从 A et 验 中学 习 ; 一 方 面 T gn 经 另 D算 法 和 动 态 规 划 一 样 , 利 用 估 计 的 值 函 数 进行 迭代 嗍 。

21 Q一 习算 法 的收 敛 性 分 析 网 . 学

一

些其 他 改 进 方 法 。 于值 函数 估 计 的常 用 算 法 主 要 有嘲 T 基 :D

算 法 、 一 习算 法 、aa 算 法 等 。 Q学 S rs

121 I[ 算 法 .. 1'

有更 大 的控 制力 。故 本节 将 要提 出 的基 于知识 的Q一 习 学 (n weg— ae—erigK Q ) K o ldeB sdL ann ,B L模型选用 习算法来研究。

一

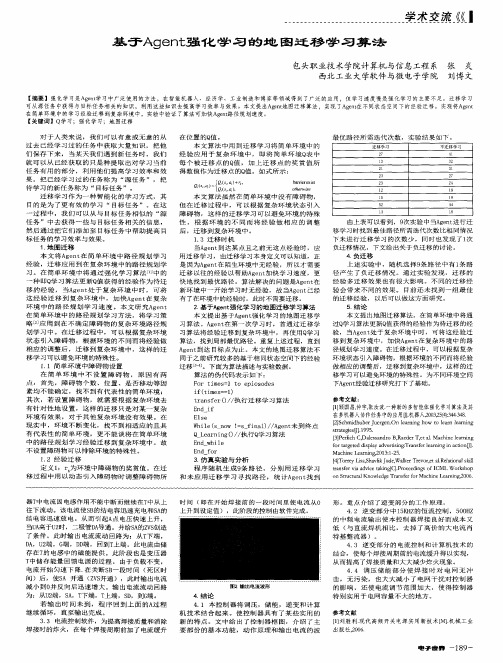

图 1 强 化 学 习 基 本 框 图

F g Ba i o k d a r m ft e r i f  ̄e n e r i g i .1 sc blc i g a o e n o me tl a n n h

般 地 .强 化 学 习 问题 可 以看 成 是 一个 Mak v决 策 过 ro

1 强化 学 习

强 化 学 习是 学 习 如 何 把 状 态 映 射 到 动 作 使 奖 赏 值 达 到 最 大 的学 习算 法 , gn 通 过 在 环 境 中 不 断 地 感 知 和 动 作 , A et 来 学 习选 择 最 优 的 动 作 以实 现 目标 任 务 , 化 学 习坚 实 的 理 论 强 基 础 和 诱 人 的 应 用 前 景 正 逐 渐 受 到 各 研 究 领 域 学 者 的 广 泛 重视 , 仅是研究 智能学 习的理论 工具 , 不 同时 又 是 实 际 应 用

强化学习方法教案

强化学习方法教案I. 引言强化学习(Reinforcement Learning)作为一种机器学习方法,在最近几年受到了广泛关注。

它以试错学习的思维方式,通过代理(Agent)与环境进行交互,不断采取行动以最大化累积回报。

本教案将介绍强化学习的基本概念、原理与算法,并提供相应的案例与实践活动,旨在帮助学生掌握强化学习方法。

II. 基础知识1. 强化学习定义强化学习是一种通过试错学习的方法,借助智能代理与环境的交互,通过学习最优策略来最大化累积回报的机器学习方法。

2. 核心概念- 状态(State):描述环境中的某个特定情景或特征。

- 动作(Action):代理在某个状态下可选的可执行行为。

- 奖励(Reward):环境向代理提供的反馈信号,用于判断代理行为的好坏。

- 策略(Policy):代理的行为策略,是从状态到动作的映射关系。

- 值函数(Value Function):用于评估状态或状态-动作对的价值,表示长期累积奖励的预期值。

III. 强化学习算法1. 蒙特卡洛方法蒙特卡洛方法基于通过采样经验回报来学习价值函数。

其核心思想是根据代理的轨迹样本,计算每个状态或状态-动作对的回报,并将其用于更新值函数。

2. 时序差分学习时序差分学习基于当前代理的预测值来逐步更新其值函数。

其核心思想是通过比较当前时刻估计的值与下一时刻真实的回报,来进行值函数的逐步更新。

3. Q-learningQ-learning是一种基于时序差分学习的强化学习算法。

它通过逐步更新状态-动作对的Q值函数来学习最优策略。

Q-learning算法中的贪婪策略使得代理能够在提供最大奖励的动作中进行选择。

IV. 案例与实践活动1.案例:强化学习在游戏中的应用以经典的游戏环境,如迷宫游戏或射击游戏为例,介绍强化学习在游戏中的应用。

学生可以通过实践编写强化学习算法并应用到游戏中,观察代理在不同情况下的学习过程与策略改进。

2. 实践活动:自主导航机器人学生可以通过搭建自主导航机器人,结合强化学习算法,让机器人能够自主感知环境并根据回报信号进行学习和决策。

基于强化学习的智能优化算法研究与应用

基于强化学习的智能优化算法研究与应用近年来,随着人工智能和机器学习领域的迅猛发展,基于强化学习的智能优化算法逐渐成为研究热点。

强化学习作为一种通过与环境互动学习最优策略的智能算法,已经在许多领域取得了显著的成果。

本文将探讨基于强化学习的智能优化算法在各个领域的应用,并展望其未来发展。

一、强化学习的基本原理强化学习是一种通过学习代理与环境互动的奖励信号,从而找到最优策略的智能算法。

其主要目标是使代理在未知环境下获得最大的累积奖励。

强化学习算法通常包括四个主要组成部分:状态(State)、动作(Action)、奖励(Reward)和策略(Policy)。

二、基于强化学习的智能优化算法研究1.强化学习在组合优化中的应用组合优化问题是强化学习的重要应用领域之一。

近年来,许多研究者将强化学习应用于旅行商问题(TSP)、背包问题(KP)等组合优化问题,并取得了良好的效果。

2.强化学习在机器学习中的应用强化学习在机器学习领域的应用也取得了显著成果。

例如,深度强化学习(DRL)已经被成功应用于图像识别、自然语言处理等领域。

通过与深度学习的结合,强化学习能够更好地解决复杂任务。

3.强化学习在控制工程中的应用控制工程是强化学习的另一个重要应用领域。

基于强化学习的自适应控制算法,如模型预测控制(MPC)和强化学习控制(RLC),在工业控制、自动驾驶等方面具有广泛的应用前景。

4.强化学习在自然语言处理中的应用强化学习在自然语言处理领域也取得了不少成果。

例如,通过强化学习,机器可以学会根据上下文生成合适的词语,从而提高机器翻译和文本生成的质量。

三、基于强化学习的智能优化算法挑战与发展尽管基于强化学习的智能优化算法已经在许多领域取得了显著成果,但仍面临一些挑战,如探索与利用的平衡、计算复杂性、模型泛化能力等。

为了应对这些挑战,研究者们提出了许多改进方法,如采用元学习、迁移学习等策略。

未来,基于强化学习的智能优化算法将在以下几个方面取得更多突破:1. 多智能体强化学习多智能体强化学习旨在解决多个代理在复杂环境中的协同与竞争问题。

基于深度强化学习的多Agent协作决策研究

基于深度强化学习的多Agent协作决策研究随着智能化技术的快速发展,人工智能领域也取得了快速的发展。

无论在学术研究还是工业应用上,深度学习等技术都获得了广泛的关注和应用。

而多智能体协作决策也成为了人工智能领域内一个热门的研究方向。

在此,我们介绍一种基于深度强化学习的多Agent协作决策研究。

1. 多Agent协作决策的难点与挑战在多Agent协作决策中,需要考虑各个Agent之间的相互影响,同时还需要协调不同Agent之间的决策。

这些因素极大地增加了决策难度,使得多Agent协作决策成为一个极具挑战性的问题。

2. 深度强化学习带来的突破深度强化学习作为一种新兴的技术,可以在多Agent协作决策中得到应用,因为它可以使智能体从环境中学习到经验,并且智能体还能利用协同决策来提高系统的整体效率。

在多Agent协作决策任务中,确定行动方案就是最终的利益最大化问题。

深度强化学习是一种能够有效解决此类问题的方法。

3. 基于深度强化学习的多Agent协作决策研究在基于深度强化学习的多Agent协作决策方面,有很多研究方向,其中包括策略联合学习、多智能体规划、分布式强化学习等等。

在多智能体联合学习中,需要考虑到各个Agent之间的交互和协同,同时还需要保持整体行为的一致性。

在多智能体规划方面,需要考虑到多个智能体的任务分配和合作。

在分布式强化学习方面,需要考虑到如何有效地利用合作策略,有效利用计算机资源等问题。

这些方面构成了基于深度强化学习的多Agent协作决策研究的研究方向。

4. 研究应用基于深度强化学习的多Agent协作决策方案在很多领域都能够应用。

例如,在自主车辆、智能家居等领域,这种技术可以成功地实现多Agent之间的协同决策,从而有效地提高系统的工作效率。

在机器人领域,多Agent协作技术可以用于机器人之间的协同工作,从而实现高效的生产过程。

在金融领域,这种技术可以用于智能投资决策,从而提高收益。

综上所述,基于深度强化学习的多Agent协作决策研究是人工智能领域内一个重要的研究方向。

网络安全攻防技术中的强化学习算法研究

网络安全攻防技术中的强化学习算法研究近年来,随着互联网的快速发展和普及,网络安全问题越来越受到人们的关注。

为了应对不断变化的网络威胁和攻击手段,网络安全领域提出了许多防御技术和方法。

其中,强化学习算法作为一种新的技术手段,正在逐渐应用于网络安全攻防技术中,并取得了一定的研究成果。

强化学习是一种机器学习的方法,主要通过智能体(agent)与环境的交互学习,从而使得智能体能够根据环境的反馈采取相应的行动。

在网络安全领域,强化学习算法可以被用于实现智能化的网络攻防系统,提高网络的安全性和防御能力。

首先,强化学习算法可以应用于网络入侵检测系统中。

网络入侵检测是指通过监控网络流量和行为,识别并阻止未经许可的访问和恶意攻击。

传统的入侵检测系统通常基于规则和特征的匹配,这种方法存在着规则库的不完善和特征变化的问题。

而强化学习算法可以通过自主探索和学习,动态地适应和优化网络入侵检测系统。

例如,可以利用强化学习算法训练智能体从网络流量中提取特征,并根据网络行为的差异化设计相应的动作策略,提高入侵检测的准确性和效率。

其次,强化学习算法还可以应用于网络安全漏洞的挖掘和修补。

网络安全漏洞是网络系统中存在的潜在威胁,黑客可以通过利用这些漏洞进行网络攻击。

传统的漏洞挖掘和修补方法往往需要人工分析和手动修复,效率低下且容易出现遗漏。

而强化学习算法可以通过学习和优化漏洞挖掘的策略,自动发现和修补网络漏洞。

例如,可以利用强化学习算法训练智能体从大量的漏洞数据中学习特征,并根据学习的结果自动生成修补方案,提高网络安全漏洞修补的效果和速度。

此外,强化学习算法还可以应用于网络入侵响应与处置系统中。

入侵响应与处置是指在发生网络入侵事件时,及时采取合适的措施进行应对和处置,以降低损失和恢复网络正常运行。

传统的入侵响应与处置方法往往需要人工干预和决策,且响应速度慢。

而强化学习算法可以通过自主学习和思考,优化响应和处置策略。

例如,可以利用强化学习算法训练智能体从历史入侵事件中学习和总结经验,根据不同的入侵情况自动选择最优的响应动作,提高网络入侵响应的效果和效率。

基于Agent强化学习的地图迁移学习算法

一

略 应 用 到 在 不 确 定 障 碍 物 的 复 杂 环 境 路 径 规 划 学 习 中 。在 迁 移 过 程 中 , 可 以根 据 复 杂 环 境 状 态 引 入 障 碍 物 ,根 据 环 境 的 不 同而 将 经 验 做 相 应 的 调 整 后 , 迁 移 到 复 杂 环 境 中 , 这 样 的 迁 移 学 习可 以避 免 环 境 的 特 殊 性 。 1 . 1 简 单环 境 中 障碍 物 设 置 在 简 单 环 境 中 不 设 置 障 碍 物 , 原 因 有 两 点 : 首 先 , 障 碍 物 个 数 、 位 置 、是 否 移 动 等 因 素 均 不 能 确 定 , 找 不 到 有代 表 性 的 简 单 环 境 ; 其 次 ,若 设 置 障 碍 物 , 就 需 要 根 据 复 杂 环 境 去 有 针 对 性 地 设置 ,这 样 的迁 移 只是 对 某 一 复 杂 环 境 有 效 果 , 对 于 其 他 复 杂 环 境 没 有 效 果 。在 现 实 中 ,环 境 不 断 变 化 ,找 不 到 相 适 应 的 且 具 有代 表性 的简单环境 ,更不能谈将在 简单环境 中 的 路 径 规 划 学 习 经 验 迁 移 到 复 杂 环 境 中 。故 不 设 置 障碍 物 可 以排 除 环 境 的 特 殊 性 。

1 . 2 经 验迁 移

本 文 算 法 虽 然 在 简 单 环 境 中 没 有 障碍 物 , 但 在 迁 移 过 程 中 , 可 以根 据 复 杂 环 境 状 态 引 入 障 碍 物 ,这 样 的 迁 移 学 习 可 以 避 免 环 境 的 特 殊 性 , 根 据 环 境 的 不 同 而 将 经 验 做 相 应 的 调 整 后,迁移到复杂环境中。 1 . 3迁 移 时 机 当A g e n t  ̄ ] 1 达 某 点 且 之 前 无 这 点 经 验 时 , 应 用迁 移 学 习 , 由迁 移 学 习本 身 定 义可 以知 道 , 正 是 因 为A g e n t 在 陌 生 环 境 中 无 经 验 , 所 以才 需 要 迁移 以 往 的经 验 以 帮助 A g e n t 力 口 快 学 习速 度 , 更 快 地 找 到 最 优 路径 。 算法 解 决 的 问题 是 A g e n t 在 新环 境 中 一 开 始学 习 时无 经 验 , 故 当A g e n t 已经 有 了在 环境 中的 经验 时 ,此 时 不 需要 迁移 。 2 基于 A g e n t 强 化学 习的地 图迁 移 学 习算 法 本 文 提 出 基 于A g e n t 强 化 学 习 的地 图迁 移 学 习 算法 。A g e n t 在 第 一 次 学 习 时 , 首通 过迁 移 学 习算 法 将 经 验 迁 移 到 复杂 环 境 中 ,再 使 用 Q 学 习

基于深度学习的强化学习技术研究

基于深度学习的强化学习技术研究随着科技的快速发展,机器学习和人工智能技术成为了热门话题。

在机器学习中,强化学习技术在实际应用中发挥着重要的作用。

而基于深度学习的强化学习技术更是成为研究热点,同时也是未来的发展趋势。

本文将介绍基于深度学习的强化学习技术的基本原理、应用场景以及未来的发展方向。

I. 基本原理强化学习是机器学习中的一种,它通过与环境交互来达到某个特定目标。

强化学习与其他机器学习技术的主要区别在于它需要学习算法自主选择一系列行为,同时可以从环境中获得奖励或惩罚。

简单来说,强化学习的目标是通过试错的方式,找到最佳的行为方式,并最大化收益或最小化损失。

基于深度学习的强化学习技术则是一种利用人工神经网络来实现强化学习的方法。

将深度学习技术应用到强化学习中,可以通过训练神经网络来实现更准确、更复杂的行为决策。

深度学习技术本身具有处理大量数据和学习非线性关系的能力,很好地解决了强化学习中高维状态空间和动作空间的问题。

II. 应用场景基于深度学习的强化学习技术已被广泛应用于许多领域,例如自动驾驶、智能机器人、语音识别、游戏等。

在自动驾驶领域,通过强化学习算法,汽车可以自主学习如何控制方向盘、制动和加速,最终实现自动驾驶。

在智能机器人领域,通过强化学习技术,机器人可以学习在不同场景中如何执行任务,例如导航和操作等。

强化学习技术还可以应用于语音识别和自然语言处理,通过学习用户的行为和反馈来改善识别和交互的准确性。

在游戏领域,强化学习技术已经在围棋、扑克和电子游戏中取得了显著的进展。

III. 发展方向随着基于深度学习的强化学习技术的不断发展,未来的发展方向也逐渐清晰。

首先,深度学习技术需要不断改进,以提高强化学习算法的性能和准确性。

其次,强化学习需要与其他领域的技术结合,例如语音识别、自然语言处理和计算机视觉等,在实际应用中发挥更大的作用。

此外,基于深度学习的强化学习技术需要进一步探索在更加复杂和多样化的环境下的适用性。

多智能体深度强化学习算法

多智能体深度强化学习算法深度强化学习(Deep Reinforcement Learning,DRL)是一种结合深度学习和强化学习的方法,用于训练智能体(Agent)在环境中进行决策和学习。

而多智能体深度强化学习算法是指在多智能体系统中应用深度强化学习方法来解决决策与协作问题的算法。

本文将介绍多智能体深度强化学习算法的基本原理、常见算法以及应用领域。

1. 多智能体强化学习基本原理多智能体强化学习是指存在多个智能体同时学习和决策的场景。

在这种环境下,智能体间的决策和行为将相互影响,因此需要考虑博弈和合作的问题。

多智能体强化学习的基本原理与单智能体强化学习相似,都是通过智能体与环境的交互来学习最优策略。

但在多智能体强化学习中,还需要考虑到其他智能体的行为对当前智能体的影响,以及协调与合作的问题。

2. 多智能体深度强化学习算法介绍(1)独立学习算法独立学习算法是最简单且常见的多智能体深度强化学习算法。

每个智能体都使用独立的神经网络进行训练,对环境进行感知和决策。

智能体之间不进行信息交流和合作,各自独立地学习策略。

这种算法简单直观,但存在信息不对称和协作能力受限的问题。

(2)集中训练和分布式执行集中训练和分布式执行算法通过集中训练来学习全局策略,并将策略分发给各个智能体进行执行。

智能体之间仍然是独立的,但通过全局策略的指导来实现协作和合作。

这种算法能够提高系统的整体性能,但在实际应用中可能受到计算和通信开销的限制。

(3)对抗性算法对抗性算法是一种特殊的多智能体深度强化学习算法,在这种算法中各个智能体被视为对手进行博弈。

智能体通过与对手对抗来学习最优策略,从而实现自我提升。

这种算法常用于竞技类的环境和游戏中,如围棋、扑克等。

对抗性算法的优势在于能够提供具有挑战性和鲁棒性的策略。

3. 多智能体深度强化学习应用领域多智能体深度强化学习广泛应用于各个领域,如机器人控制、协作任务、多智能体游戏等。

在机器人控制领域,多智能体深度强化学习可以实现多个机器人之间的协调与合作,更好地完成复杂任务。

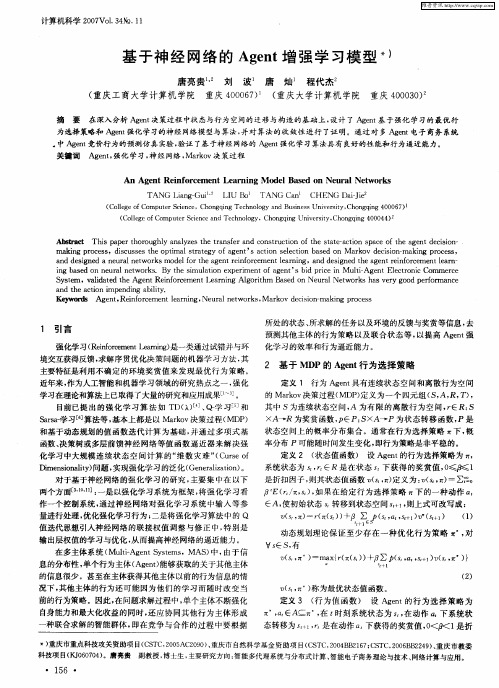

基于神经网络的Agent增强学习模型

1 引言

强化学 习( e fr m n _nn ) R i oc et . ri 是一类通过试错并与环 n e Ia g

所处 的状态 、 所求解 的任务 以及环境的反馈与奖赏等信息 , 去 预测其他 主体 的行为策 略以及联合状态 等 , 以提高 Agn 强 et

化 学 习 的效 率 和行 为 逼 近 能 力 。

An Ag ntRe n o c m e tLe r n o lBa e n Ne r lNew o k e i f r e n a ni g M de s d o u a t r s TANG a g Gu Lin — i LI B TANG n CHENG i i ’ U o Ca Da— e J

维普资讯

计算机科学 2 0 V 13 №. 0 7 o. 4 1 1

基 于 神 经 网 络 的 Agn 增 强 学 习模 型 ) et

唐 亮贵 刘 波 唐 。 灿 程代杰 。

( 重庆工 商大 学计算机 学院 重庆 406 ) ( 00 7 重庆 大学计 算机 学院 重庆 4 03 ) 0 00。

境交互获得反馈 , 求解序贯优化决策问题的机器学 习方法 , 其

主要特征是利用不确定 的环境奖赏值 来发现最 优行为策 略。 近年来 , 作为人工智能和机器学习领域的研究热点之一 , 强化 学习在理论和算法上已取得了大量的研究和应用成果_ 。 l j 目前已提 出的强 化学 习算 法 如 T )4、 学 习 ] D( l Q- ] 和 S ra 习[ 算法等 , as- 学 6 ] 基本上都是以 Makv决策过程( ro MDP ) 和基于动态规划 的值 函数迭代 计算为基 础 , 并通 过多项式 基

摘 要 在深入分析 A et gn 决策过程 中状 态与行为 空间的迁移与构造的基础上, 设计 了 A et gn 基于强化 学习的最优行

强化学习求解组合最优化问题的研究综述

强化学习求解组合最优化问题的研究综述强化学习求解组合最优化问题的研究综述引言组合最优化问题是数学与计算领域中一个重要的研究领域。

传统的解决方法往往依赖于启发式算法或者精确算法。

然而,随着人工智能领域的不断发展,强化学习作为一种新兴的算法模型,为求解组合最优化问题带来了新的可能性。

本文将对强化学习求解组合最优化问题的研究进行深入综述。

强化学习概述强化学习是一种机器学习的方法,通过试错的方式学习如何做出决策以最大化累积奖励。

在一个强化学习系统中,有一个智能体(agent)与环境(environment)进行交互,通过观察环境的状态和奖励信号来学习,目标是使智能体能够学会在给定环境下做出最佳决策。

组合最优化问题组合最优化问题是在一定的约束条件下,从一组可行解中选择出最好的解的问题。

其中,可行解是指满足所有约束条件的解,最好的解则依据特定的目标函数进行定义。

组合最优化问题在实际生活中有广泛的应用,如货物调度、路径规划、资源分配等等。

强化学习求解组合最优化问题的方法1. 基于价值函数的方法基于价值函数的方法是将组合最优化问题转化为强化学习问题,并通过价值函数来表示状态的价值。

常用的方法包括Q-learning算法、Deep Q Network(DQN)等。

例如,在路径规划问题中,智能体根据当前位置和可选动作来更新状态的价值函数,从而学习出最优路径。

2. 基于策略梯度的方法基于策略梯度的方法是直接学习策略函数,通过优化策略函数来达到最优解。

其中,策略函数是指智能体在给定状态下选择动作的概率分布。

常见的算法包括Actor-Critic算法、Proximal Policy Optimization(PPO)等。

这些算法在组合最优化问题的求解中展现了较好的效果。

3. 基于深度学习的方法近年来,深度学习技术的快速发展为求解组合优化问题提供了新的思路。

通过结合深度学习和强化学习,可以将大规模的组合优化问题转化为一个端到端的学习问题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

【2】胡山立,石纯一.Agent的意图模型叨.软件学报,2000,ll

’(7):96-97.

HU Shan-li,SHI hal

2.3邸QL的学习机制

KBQL的学习机制的基本思想就是搠:在学习中不断修正 由Agent的先验知识得到的错误决策。根据Agent的知识得 到一个SW或W的动作,但执行这个动作致使Agent撞墙。把 由Agent的知识直接得到一个错误决策(如撞墙)的状态直接 称为直接异常状态。用异常标志以)s=true表示。还有一些潜在 的异常状态不能马上识别.是通过学习机制来识别的。

state

learning algorithm

using

this

feature,the啪of

Agent prior

n枷w Agent learning

space,in order to accelerate the reinforcement learning

Convergence,while岫ing

model[J].Software。1999,10(12):268一”4. 【4】马光伟,徐晋晖。石纯一.Agent思维状态模型叨.软件学 报,1999,10(4):42-48.

MA

state

3带有启发式回报函数的assr(a幻学习算法)

强化学习是解决Markov决策问题的主要方法。但当 Markov决策过程具有大规模或连续的状态或行为空间时.强 化学习面临两个主要的难题旧,一个是存储与计算问题,第二

强化学习是学习如何把状态映射到动作使奖赏值达到 最大的学习算法,Agent通过在环境中不断地感知和动作,来 学习选择最优的动作以实现目标任务.强化学习坚实的理论 基础和诱人的应用前景正逐渐受到各研究领域学者的广泛 重视.不仅是研究智能学习的理论工具.同时又是实际应用 收稿日期:201l—03一18 稿件编号:201103101

㈤

潜在有用的动作都应被测试。即要对所有允许的状态一动作 对都应该经常探测(explore).足够的次数以满足收敛定理。因 此.在给定动作集的情况下。状态集的大小是影响Q一学习收 敛速度的最重要因素。

上式说明,如果一个状态:被多次访问,表明其对当前奖 赏值的贡献最大.然后其值函数通过式(3)迭代修改。 Q学习算法

lj2.1

法是离策略(o在poficy)学习方法。在策略学习方法中,要学 习的最优值函数依赖于学习过程中当前所采取的策略.学习 过程中选择的策略质量的好坏直接影响Agent要学习的最 优策略。在离策略学习方法中。要学习的最优策略与在学习 过程中采取的策略无关。这就使Agnet对学习策略的选择具 有更大的控制力。故本节将要提出的基于知识的Q一学习 (Knowledge-Based—Learning,KBQL)模型选用Q学习算法来研究。 下面首先对Q一学习算法的收敛性进行分析。在此基 础提出的KBQL算法并对Agent内部的学习机制进行详 细介绍。

学习是Agent适应复杂动态不确定环境的一项重要技 能,在现有的各种学习算法中。强化学习是一种能与环境进 行交互的、无需模型的在线学习算法,具有处理动态不确定 性环境的优势。因而使其成为机器学习研究中的一个重要 分支。 传统的强化学习算法研究没有考虑Agent的先验知识. 尽管在形式上提供了一个统一的算法框架.但在实际应用 中,这些没有启发知识的强化学习算法收敛速度都相当慢。 另外。标准强化学习算法的收敛性是建立在可以任意遍历状 态空间状态的前提下,但对于真实的物理环境(如机器人)。 这种方式是不现实的。而且在实际应用中。Agent总可以获取 各种形式的启发知识,因此将知识融入强化学习系统中,不 仅可以改善强化学习算法的收敛性。而且还充分利用系统的 资源(如专家知识等)。

-115-

万方数据

《电子设计工程)2011年第11期

1.2强化学习的基本算法 目前.强化学习主要有两大类算法:一类是值函数估计 法,这是强化学习领域研究最为广泛的方法;另一类是策略 空间直接搜索法。如遗传算法、遗传编程、模拟退火方法以及 一些其他改进方法。基于值函数估计的常用算法主要有网:TD 算法、O一学习算法、Saras算法等。

Sarsa算法阿 Sarsa算法是Rummery和Niranjan于1994年提出的一种

s礼‰},RL模块根据此经验知识更新Q值。

2)决策控制模块决策控制模块主要实现Q一学习算法 的动作选择机制。利用Agent的知识来指导Agent的探测行

基于模型算法,最初被称为改进的Q_学习算法。它仍然采用

的是Q值迭代,但sa瑚是一种在策略Tn学习(on-policy Tn)。 2基于知识的Q一学习算法

Chun-yi.Agent's intention model叨.Jour-

ofSoftware,2000,11(7):96.97.

【3】康小强,石纯一.一种理性Agent的BDI模叨.软件学报,

1999。lo(12):268—274.

KANG Xiao-qiang,SHI Chun-yi.A rational Agnet the BDI

the learning mechanism Agent overcome inaccuracy of their knowledge,thereby enhancing the learning algorithm robustness

and

adaptability.

Key words:reinforcement learning;KBQL;Agnet;robustness;adaptability

Abstract:Reinforcement has the

learning

advantage

is

a

of

interacting而tlI

the

environment.this

paper

presents

a

Байду номын сангаас

knowledge-based

knowledge

to

Q-learning algorithm(KBQL)Q

2.1

TD算法

TO(temporal di插erence)学习是强化学习技术中最主要的

学习技术之一.’ID学习是蒙特卡罗思想和动态规划思想的

结合。即一方面TO算法在不需要系统模型情况下可以直接 从Agent经验中学习;另一方面TO算法和动态规划一样。利

用估计的值函数进行迭代一。

Q-学习算法的收敛性分析m Watkins给出了在Markova决策环境下,Q一学习算法的

第19卷

V01.19

第ll期

No.1 1

电子设计工程

Electronic Design Engineering

2011年6月

Jun.201 1

基矛知识的Agent强彳匕学习算法分析与研究

殷锋社

(陕西工业职业技术学院陕西成阳712000) 摘要:强化学习具有与环境交互的优势,笔者提出的基于知识的Q一学习算法(KBQL)就是利用Q一学习算法的这个 特点,利用Agent的先验知识来缩小Agent学习的状态空阍,以加速强化学习的收敛性,同时采用Agent的学习机制 克服其知识的不精确性。从而提高学习算法的鲁棒性和适应性。 关键词:强化学习;KBQL;Agent;鲁棒性;适应性

产生的Q值序列l伽O,口)l以概率一收敛于最优值q(s,口)。

定理1

其中,e(s)定义为状态的资格迹(eligibilit徊e伪)。实际应

用中e(s)可以通过以下方法计算:

收敛定理:假设迭代公式中学习率参数4满

足条件。 根据收敛定理可知.在Q一学习中有一个附加要求:所有

出,=黜;+1

1.2.2

署献态

2.2

Q一学习算法由watl【ins提出的一种模型无关的强化学习 算法,也被称为离策略TD学习(o在policy TO)m,被誉为强化 学习算法发展中的一个重要里程碑。Q-学习是对状态一动作 对的值函数进行估计的学习策略.最简单的O学习算法是单 步Q学习,其口值的修正公式如下: Q(s,,珥)・—Q(以,珥)+珥r。I十”ⅨⅨ口(s。i,a)-Q(s。,玛)】 上式中参数d称为学习率(或学习步长),r为折扣率。 在单步Q一学习算法中,需要学习的状态一动作对值函数 。值是对最优状态一动作对的值函数的近似。并与所遵循的策 略无关。这一特点使算法的分析得到极大地简化。而且使收 敛性的证明得以实现。

(1)

其中S是有限的离散状态空间。A是有限的离散动作空 间;R是回报函数;P是状态转移函数,因此在已知状态转移 概率函数P和回报函数R的环境模型知识下.可以采用动态 规划技术求解最优策略。而强化学习着重研究在P函数和R 函数未知的情况下。Agent如何获得最优策略翻。

作者简介:殷锋社(19r7扣)。男.陕西乾县人。硕士研究生,副教授。研究方向:个性化仿真系统研究。

1.2.3

KBQL算法 标准Q一学习算法的收敛速度依赖于要学习的状态空

问大小。另外还与学习过程的动作选择机制有关。因此引 入Agent的知识库来缩小要学习的状态空间。并将动作选择 机制从强化学习模块中分离出来。提供一个更灵活的决策 机制.利用Agent的知识来指导探测状态空间。它主要包括 3个模块嘲,即RL模块、决策控制模块和知识库KB。 1)RL模块RL模块里采用离策略的Q一学习算法,但它 与标准的Q-学习算法模块有所不同,在标准Q一学习算法中, 其动作选择机制包含在算法模块中。而RL模块只实现状态一 动作对的值函数Q(s。a)的计算,即在每一个离散时刻t,由决 策控制模块确定一个动作aj,得到经验知识和训练样例k,喁,

● ●

艺a(n):∞并且艺矿(n)<∞

^=l ^-I

(3)

奖赏值可以向后回退任意步。称为TD(幻算法。TO(幻算法的

收敛速度有很大程度的提高。算法迭代公式可用下式表示:

当迭代步数n趋于无穷大时。假定所有的状态一动作对被无 限地经常访问,那么,对所有的状态一动作对(s,口)由Q-学习算法