图解 HACMP 5.4.1配置

在hacmp中配置用网线做心跳的时候用两种方法

在hacmp中配置用网线做心跳的时候用两种方法!hacmp, 网线1.就用四个boot地址去做心跳,不需要去增加其他的基如ip的网络去做心跳。

只需要在hacmp配置完成后,最后添加ip心跳的时候,进入到Extended Configuration > Extended Topology Configuration >Configure HACMP Networks> change a Network to the HACMP Cluster下的IP Address Offset for Heartbeating over IP Aliase一项中填入一个ip地址要求这个地址和其他ip地址都不在同一个网端内,当你输入hacmp会自动在四个bootip 上生成四个private的ip地址,做心跳用。

规则如下:当你输入10。

0。

0。

1,和其他的ip都不在同一个网段内。

机器会启动在a主机上 boot1生成10。

0。

0。

1,boot2上生成10。

0。

1。

1,备机上boot1生成10。

0。

0。

2,boot2生成10。

0。

1。

2。

这四个ip就是做心跳用的。

其他所有的选项都不动。

2.单独用其他的网卡做心跳。

如果要是两台机器的话,用一跟网线把两个端口直接连接起来,这样就和其他的四个boot ip都在不同的vlan内。

要是两个以上的话,就要用的交换机,但要将做心跳的所有主机的网口和boot ip放在不同的vlan内。

在第一步配ha的过程中,会自动探测到两个网络,一个网络里有四个bootip,一个网络里面是做心跳的端口,做心跳的端口不用去配置ip。

只需要去Extended Configuration > Extended Topology Configuration >Configure HACMP Networks> change a Network to the HACMP Cluste,在最后的一个选项中有一个网络的属性,默认的是public,选择做心跳的网络将其改为private即可,其他选项不变以上是在5。

Hacmp扩容详细

HACMP扩容基础目录HACMP扩容基础 (1)一、C-SPOC介绍 (2)二、创建PV (2)1、创建PV (2)2、检查PVID (3)三、使用C-SPOC功能扩展VG (3)1、进入C-SPOC (3)2、HACMP Logical Volume Management (4)3、Shared Volume Groups (4)4、Set Characteristics of a Shared Volume Group (4)5、Add a Volume to a Shared Volume Group (5)6、选择需要扩容的VG (5)7、回车,然后选择添加的硬盘 (5)8、确定无误后,回车继续 (5)9、检查两节点PV是否加入VG (5)四、使用C-SPOC功能扩展FS (6)1、进入System Management (C-SPOC) (6)2、HACMP Logical Volume Management (6)3、Shared File Systems (7)4、选择JFS2类型 (7)5、Change / Show Characteristics of a Shared JFS2 (7)6、选择需要扩容的文件系统 (8)7、输入文件系统大小 (8)8、修改LV属性以支持更多的LP (8)9、检查文件系统大小 (10)一、HACMP C-SPOC介绍为方便管理集群中的操作,HACMP 提供了一种方法,通过该方法可以在多个集群节点执行命令并维护要执行操作之间的协调。

一些集群维护操作可能影响HACMP 配置(拓扑和资源),但通过HACMP 系统管理工具(C-SPOC),无需停止关键作业即可执行这些任务(如添加或删除资源、用户和更改拓扑元素)。

注意:C-SPOC 使用一种新的集群通信守护进程(clcomdES) 在远程节点上执行命令。

如果此守护进程没有运行或者无法验证来自发起者节点的请求,将不会执行远程节点上的命令,因此C-SPOC 操作将会失败。

HACMP学习PPT

– –

21

HACMP5.1 concept and planning

2010-11-1

© 2003 IBM Corporation

IBM System and Technology Group

IP网络规划: IPAT via IP aliases(二)

设置 IPAT via IP aliases 功能 #smitty hacmp Extended Configuration > Extended Topology Configuration > Configure HACMP Networks > Change/Show a Network in the HACMP Cluster > Change/Show an IP-Based Network in the HACMP Cluster Change/Show an IP-Based Network in the HACMP Cluster Type or select values in entry fields. Press Enter AFTER making all desired changes. [Entry Fields] * Network Name net_ether_01 New Network Name [] * Network Type [ether] + * Netmask [255.255.255.0] + * Enable IP Address Takeover via IP Aliases [Yes] + IP Address Offset for Heartbeating over IP Aliases [] * Network Attribute public +

Hacmp_介绍

第一章介绍本章内容包括对IBM针对AIX产品线的高可用性集群多处理系统的介绍以及IBM高可用产品的概念本章将讨论以下主题:●什么是HACMP?●历史与发展●高可用性的概念●高可用性Vs容错1.1.什么是HACMP?在我们解释什么是HACMP以前,我们先来定义一下高可用性的概念。

High availability在当今复杂的环境下,成功实现IT应用的一个关键要素就是提供不间断的应用服务。

HA就是这样一个可以通过消除计划内/计划外宕机事件从而向客户应用提供不间断服务的部件,它能达到消除从硬件到软件的单点故障(SPOFs)。

一个高可用性解决方案可以保证方案中任何组件的失效(包括硬件、软件或系统管理)都不会造成客户无法访问应用和应用数据。

高可用性解决方案可以通过恰当的设计、计划、硬件选择、软件配置以及细心控制改变管理方法来消除单点故障。

Downtime停机时间是指应用程序不能为客户端提供服务的时间。

停机时间分为:➢计划内:-硬件升级-维修-软件更新/升级-备份(离线备份)-测试(对群集确认必须进行周期性测试)-发展➢计划外:-管理员过失-应用失效-硬件失效-其他不可抗力(天灾)IBM针对AIX的高可用性解决方案——HACMP给予饱经考验的IBM群集技术,它包括以下两个组件:➢高可用性:该进程保证应用在用户复制和/或共享资源时是可用的。

➢群集多处理:该进程提供在同一节点上多个应用共享或并发访问数据。

基于HACMP的高可用性解决方案提供自动失效检测、诊断、应用恢复和节点重新控制。

在恰当的应用中,HACMP还可以在并行应用处理中提供对数据的并发访问,从而提供更高的可扩展性。

标准的HACMP环境如图1-1。

1.1.1.历史与发展IBMHACMP最早可追溯至90年代。

HACMP在1990年开始为RS/6000机器上的应用提供高可用性解决方案。

我们不会提供关于更早版本的信息,原因在于这些版本要么已经不被支持或者已经不再使用,我们只提供近期一些版本的相关信息。

中间业务平台HACMP安装配置指南

一、HACMP 双机系统配置计划在配置中间业务平台HACMP环境之前首先要制定配置计划。

在IBM HACMP 的配置指南中推荐了一种配置计划表的方式(Planning Worksheet ),在进行配置考虑的时候将这些表格填完即可。

通常分行中间业务平台的HACMP环境大体都有相似的拓扑环境,两个Public 类型的网络,一个用于提供中间业务服务(使用IP alias方式),另一用于连接AS/400的SNA (必须使用IP replacement方式)Cluster WorksheetCluster Name:xxibp_clusterNode Name:xxMID_PRD,xxMID_BAK在主节点上配置拓扑结构然后同步到其他节点,网络拓扑如下:(1)Network概览Network Name Network Type Network Attribute Network Mask Node Namesnet_ibp Ether public 255.255.255.0 xxMID_PRD,xxMID_BAK net_sna Ether public 255.255.255.0 xxMID_PRD,xxMID_BAK net_rs232_01 RS-232 serial N/A xxMID_PRD,xxMID_BAK (2)Network内部结构Network net_ibpService地址:ibp_svc 10.1.7.33Boot地址:ibp_boot2 172.16.101.1ibp_boot1 172.16.100.1Network sna_netService地址:sna_svc 172.16.120.3Boot地址:sna_boot 172.16.120.1Standby地址:sna_stb 172.16.121.1SNA的网络配置IP(可以使用私有地址,如172网段的任何地址,但两块网卡要在同一网段),只是为了能够互相切换,平时的IP地址不用。

高可用集群软件(HACMP)的安装和使用

Using SMIT (information only)

选择:

Software Installation and Maintenance

屏幕显示软件安装和维护菜单:

选择:

Install and Update Software

屏幕显示软件安装和更新菜单:

选择:

Cluster Topology

Cluster Security

Cluster System Management

Cluster Recovery Aids

**NOTE: Cluster Manager MUST BE RESTARTED

HACMP软件的配置

北京地税大楼S70系统HACMP配置图如下,其中en0,en2为双网卡。S70a主机为业务主机,S70b主机为业务备机,另有7133磁盘阵列。

首先进行HACMP配置的准备工作:

1. 在两台主机上用VI建立 .rhosts文件,内容为:

ds01

ds02

ds01_serv

Configure Cluster

Configure Nodes

RAS Support

[Entry Fields]

* INPUT device / directory for software /dev/cd0

* SOFTWARE to install [_all_latest]

Software Installation and Maintenance

Software License Management

Devices

System Storage Management (Physical & Logical Storage)

HACMP配置

HACMP配置环境:OS:Aix 6.1P740两台,每台机器两个物理网卡.共享存储:IBM V7000操作系统:AIX 6.1HACMP版本:HACMP 5.3一.IP地址规划1.节点nodeA启动ip地址(nodeA_boot): en0 192.168.10.11 netmask:255.255.255.0 备用ip地址(nodeA_sta): en1 192.168.20.11 netmask:255.255.255.0 服务ip地址(nodeA_svc): 192.168.30.11永久ip地址(nodeA_per): 192.168.40.112.节点nodeB启动ip地址(nodeB_boot): en0 192.168.10.12 netmask:255.255.255.0 备用ip地址(nodeB_sta): en1 192.168.20.12 netmask:255.255.255.0 服务ip地址(nodeB_svc): 192.168.30.12永久ip地址(nodeB_per): 192.168.40.12二.安装HACMP5.3文件集1.安装HACMP5.3要求的操作系统文件集:bos.databos.adt.libbos.adt.libmbos.adt.syscalls.tcp.client.tcp.serverbos.rte.SRCbos.rte.libcbos.rte.libcfgbos.rte.libpthreadsbos.rte.odmbos.rte.lvmbos.clvm.enh(IBM aix5.3系统默认没有安装)2.要求的RSCT文件集pat.basic.hacmp 2.4.2.0pat.clients.hacmp 2.4.2.0rsct.core.sec 2.4.2.1rsct.basic.sp.2.4.2.0三.安装HACMP5.31.插入hacmp5.3光盘,除以下文件集外全部安装:cluster.es.pluginscluster.hativolicluster.haviewrsct.exp2.安装完成后重启AIX系统,并查看相关进程#lssrc -g cluster#ps -ef|grep cl*四、网络配置nodeA地址配置:#ifconfig en0 192.168.10.11 netmask 255.255.255.0#ifconfig en1 192.168.20.11 netmask 255.255.255.0nodeB地址配置:#ifconfig en0 192.168.10.12 netmask 255.255.255.0#ifconfig en1 192.168.20.12 netmask 255.255.255.0五.编写/etc/hosts文件(nodeA 和nodeB上都需要做相同添加)192.168.10.11 nodeA_boot nodeA192.168.20.11 nodeA_sta192.168.30.11 nodeA_svc192.168.40.11 nodeA_per192.168.10.12 nodeB_boot nodeB192.168.20.12 nodeB_sta192.168.30.12 nodeB_svc192.168.40.12 nodeB_per注:nodeA 和nodeB上配置完ip地址并且修改完hosts文件后,两台主机可以互相ping下,检测两边是否连通.六.修改网络参数#no -p -o nonlocsrcroute=1#no -p -o ipsrcrouterec=1#no -p -o routerevalidate=1七.编写/usr/es/sbin/cluster/etc/rhosts 文件(nodeA和nodeB上都需要相同修改),建立信任关系.192.168.10.11 //(nodeA的启动ip)192.168.20.11 //(nodeA的备用ip)192.168.10.12 //(nodeB的启动ip)192.168.20.12 //(nodeB的备用ip)八.编写/usr/es/sbin/cluster/netmon.cf文件(nodeA 和nodeB上各添加自己的启动ip和备用ip)nodeA上添加:192.168.10.11192.168.20.11nodeB上添加:192.168.10.12192.168.20.12九.创建程序服务的脚本启动文件(nodeA 和nodeB 上都做相同操作)#touch /etc/hastart1.sh#touch /etc/hastop1.sh#chmod -R /etc/hast*.sh十.验证串口设备的通信,以便于串口设置做HACMP心跳线nodeA上:#lsdev -c tty#cat < /dev/tty0nodeB上:#lsdev -c tty#cat /etc/hosts >/dev/tty0反之,将nodeA上查看的hosts文件信息重定向输出到nodeB的终端上.十一.共享存储配置SSA在节点nodeA上,配置SSA存储的raid#smiity ssaraid----> add an ssa raid array选择要创建的raid的类型添加创建raid所需要的磁盘查看命令:#lsdev -c disk 查看SSA logical disk drive#lspv 查看是否出现一个新的磁盘在nodeB上使用cfgmgr命令扫描硬件然后使用lspv命令查看是否能看到与nodeA上一样的一块新磁盘,如果nodeA和nodeB上都出现一块相同的的物理磁盘则证明共享存储SSA配置成功十二.共享卷组配置在节点nodeA上,使用共享磁盘创建卷组,并指定卷组的major号(主设备号),使用lspv查看共享磁盘为hdisk2.#mkvg -V 60 -y oravg hdisk2#lsvg -orootvgoravg修改卷组oravg属性,开机不自动启动#chvg -an oravg在新的卷组oravg上创建逻辑卷#mklv -t jfs2 -y halv oravg 5G在新的逻辑卷halv上创建文件系统 /hafs#crfs -v jfs2 -d halv -m /hafs在节点nodeA 上varyoffvg卷组#varyoffvg oravg在节点nodeB上为扫描出来的新共享磁盘hdisk2添加PVID#chdev -l hdisk2 -a pv=yes在几点nodeB上导入卷组,同时指定卷组的major号与节点nodeA上卷组的major 号相同#importvg -y oravg -V 60 hdisk2#lsvg -l oravg在节点nodeB上修改卷组的属性,使开机不自动激活并关闭卷组#chvg -an oravg#varyoffvg oravg#lspv十三.添加集群(以下操作需要在卷组所在的主机上操作,本篇中为nodeB)添加集群cluster1#smittyhacmp——>initialization and standard configuration ——>add nodes to an HACMP cluster指定cluster名:cluster1:选择nodeA和nodeB的启动ip地址十四.添加服务ip地址标签添加节点nodeA上的服务ip地址nodeA_svc#smitty hacmp——>initialization andstandard configuration——>configure resources to make highly available——>configure service ip labels/addresses——>add a service ip label/address选择nodeA的服务ip地址(该位置指定以后真正使用的服务ip地址)十五.添加应用服务#smitty hacmp——>initialization and standardconfiguration——>configure resources to make highlyavailable——>configure application servers——>add an application server添加如下:server name:appserverstart script: /etc/hastart1.shstop script: /etc/hastop1.sh十六.添加资源组添加新的资源组rsg1,参与的节点为nodeA和nodeB,且nodeA在前,表示节点nodeA的优先级最高#smitty hacmp——>initialization and standardconfiguration——>configure HACMP resource Groups——>add a resource group指定资源组名:rsg1;选择节点nodeA nodeB(备注:nodeA在前优先级高)十七.更改资源组更改资源组rsg1,将资源(服务ip,应用服务,卷组)加入资源组中#smitty hacmp——>initialization and standardconfiguration——>configure hacmp resource groups——>change/show resources for a resource group选择nodeA_svc,appserver1,oravg等资源十八.添加永久IP地址添加节点nodeA的永久ip地址(节点NodeA)#smitty hacmp——>extended configuration——>extended topologyconfiguration——>configure hacmp persistent node iplabel/address——>add a persistent node ip label/address选择节点nodeA上的永久ip地址:nodeA_per添加节点nodeB的永久ip地址(节点NodeB)#smitty hacmp——>extended configuration——>extended topology configuration——>configure hacmp persistent node iplabel/address——>add a persistent node ip label/address选择节点nodeB上的永久ip地址:nodeB_per十九.添加串口心跳网络和网络设备添加串口网络和设备#smitty hacmp——>extended configuration——>extended topology configuration——>configure hacmp communicationinterfaces/devices——>add communication interface/devices按F7键选中nodeA nodeB的串口心跳网络设备:>nodeA tty0 /dev/tty0>nodeB tty0 /dev/tty0二十.显示HACMP配置显示HACMP配置#smittyhacmp——>initialization and standard configuration——>display HACMP configuration二十一.验证并同步HACMP配置(将在nodeA上做的集群配置同步到nodeB上) smitty hacmp——>initialization and standard configuration——>verify and synchronize HACMP configuration同步成功表示集群配置成功!查看永久ip地址,可以看到没有启动hacmp服务时永久nodeA和nodeB的永久ip已经存在.nodeA#ifconfig -anodeB#ifconfig -a二十二.启动HACMP服务启动节点nodeA和节点nodeB的集群服务#smitty hacmp——>system management(C-SPOC)——>manage hacmp services——>start cluster services二十三.查看集群当前状态启动完成后,查看集群当前状态#smitty hacmp——>problem determination tools——>view current state 二十四.测试集群的高可用性1.服务ip地址在网卡间的漂移(服务ip地址nodeA_svc在nodeA的en0网卡上) nodeA#ifconfig en0 down 模拟en0网卡宕掉nodeA#ifconfig -dl 查看关闭的网卡nodeA#ifconfig -a 查看服务ip地址是否转移漂移到en1上nodeA#ifconfig en1 down 模拟en1网卡也宕掉了看服务ip地址是否漂移到nodeB主机上面2.服务ip地址主机间漂移#假设服务ip地址当前在nodeB主机上,通过reboot命令重启nodeB主机服务ip会自动漂移到nodeA主机上,当nodeA主机重启时服务ip地址会自动漂移到nodeB主机上;nodeB主机正常的关机,开机操作服务ip地址不会发生漂移,资源组中默认的是级联的漂移方式优先级高的优先获得服务ip地址.。

aix更改ip地址

aix更改ip地址环境:AIX 5LHACMP 5.2/5.3/5.4步骤:1.获取当前HACMP环境里配置的IP地址#/usr/sbin/cluster/utilities/cllsif > /tmp/cllsif.orig/tmp/cllsif.orig文件里就会包含HACMP网卡当前的IP地址2.停止所有节点的HACMP服务#smit clstop --> 选择HA的两个节点 --> 回车3.在两个节点上分别编辑/etc/hosts,将boot, standby, service更改成要求的IP地址4.在两个节点上分别用”smit chinet”更改boot和standby网卡的IP为要求的IP,需要和/etc/hosts中的IP对应一致5.在两个节点上互相ping对方的boot和standby的IP,确保能ping通6.在HACMP配置里更改IP6.1.更改Service IP第一步:删除原来的service IP label# smit hacmp --> Extended Configuration --> Extended Resource Configuration --> HACMP Extended ResourcesConfiguration --> Configure HACMP Service IP Labels/Addresses --> Remove Service IP Label(s)/Address(es) --> 选择IP标签 --> 回车第二步:添加新的Service IP Label# smit hacmp --> Extended Configuration --> Extended Resource Configuration --> HACMP Extended Resources Configuration --> Configure HACMP Service IP Labels/Addresses --> Add a Service IP Label/Address --> Configurable on Multiple Nodes --> 选择网络(比如net_ether_01) --> 在IP Label/Address处选择新的Server IP标签(列表中应该能看到更改后的server IP) --> 回车6.2.更改boot IP# smit hacmp --> Extended Configuration --> Extended Topology Configuration --> Configure HACMP Nodes --> Change/Show a Node in the HACMP Cluster --> 选择一个节点 --> 在Communication Path to Node处重新选择新的boot IP --> 回车执行。

AIX5300-08 HACMP5_4_1 ORACLE10204 RAC 安装

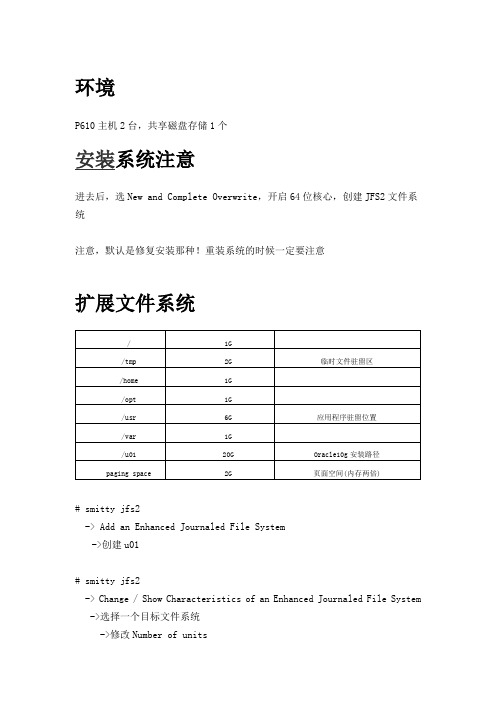

环境P610主机2台,共享磁盘存储1个安装系统注意进去后,选New and Complete Overwrite,开启64位核心,创建JFS2文件系统注意,默认是修复安装那种!重装系统的时候一定要注意扩展文件系统# smitty jfs2-> Add an Enhanced Journaled File System->创建u01# smitty jfs2-> Change / Show Characteristics of an Enhanced Journaled File System ->选择一个目标文件系统->修改Number of units升级系统维护级别# oslevel -r5300-01# instfix -i | grep MLAll filesets for 5.3.0.0_AIX_ML were found.All filesets for 5300-01_AIX_ML were found.Not all filesets for 5300-02_AIX_ML were found.Not all filesets for 5300-03_AIX_ML were found.Not all filesets for 5300-04_AIX_ML were found.Not all filesets for 5300-05_AIX_ML were found.Not all filesets for 5300-06_AIX_ML were found.Not all filesets for 5300-07_AIX_ML were found.Not all filesets for 5300-08_AIX_ML were found.从IBM网站下载相应的维护包/support/fixcentral/main/System+p/AIX执行命令inutoc创建.toc以便于update系统维护级别#inutoc /fix/aix_5200_07开始升级系统维护级别#smitty update_all选择升级所有软件包,在升级执行完成后,执行shutdown -Fr来重新启动一次主机.参见/eserver/support/fixes/fixcentral/pseriesinstal l/5300-09-00-0846创建用户# smit user创建ORACLE用户 USERID 601ORACLE用户的HOME文件夹指向/u01/app/oracle(该目录需要先创建)# smit group创建dba(701), oinstall(702), hagsuser(801)组,在USER list中,把ORACLE用户加进去mkgroup -'A' id='701' users='oracle' dbamkgroup -'A' id='702' users='oracle' oinstallmkgroup -'A' id='703' users='oracle' hagsuser设置oinstall为ORACLE的primary group# id oracleuid=601(oracle) gid=702(oinstall) groups=1(staff),701(dba),801(hagsuser)网络配置网卡绑定(待验证)irdb1和irdb2两台主机均有四块光纤网卡,两两做成EtherChannel模式,并对EtherChannel 的网卡ent4和ent5配置IP地址.将网卡做成EtherChannel模式,使用命令:#smitty etherchannel→Add An EtherChannel / Link Aggregation→按F7选择ent0和ent3做成通道ent4按F7选择ent1和ent2做成通道ent5修改主机名# smit hostname设置上面机器为P61A,下面机器为P61B修改IP# smit inet-> Change / Show Characteristics of a Network Interface ->选择一个网络接口,进行IP配置P61A en1 10.10.1.61 255.255.255.0en0 12.0.0.61 255.0.0.0P61B en1 10.10.1.62 255.255.255.0en0 12.0.0.62 255.0.0.0查看IP设置# ifconfig -a# netstat -in修改/etc/hosts127.0.0.1 loopback localhost10.10.1.61 P61A12.0.0.61 P61A_priv10.10.1.101 P61A_vip10.10.1.62 P61B12.0.0.62 P61B_priv10.10.1.102 P61B_vip修改/etc/hosts.equiv###### add by zhangqiaoc ######+ root+ oracle###### end by zhangqiaoc ######修改root oracle用户HOME目录下的.rhosts文件###### add by zhangqiaoc ######+###### end by zhangqiaoc ######测试:rsh P61A datersh P61B datercp tmp.txt P61A:/u01/app/oraclercp tmp.txt P61B:/u01/app/oracle配置NTP在server端:62bash-3.00# vi /etc/ntp.conf#broadcastclientserver 127.127.1.0driftfile /etc/ntp.drifttracefile /etc/ntp.trace"/etc/ntp.conf" 42 lines, 1017 charactersbash-3.00# startsrc -s xntpd0513-059 The xntpd Subsystem has been started. Subsystem PID is 274488.bash-3.00# lssrc -ls xntpdProgram name: /usr/sbin/xntpdVersion: 3Leap indicator: 11 (Leap indicator is insane.)Sys peer: no peer, system is insaneSys stratum: 16Sys precision: -16Debug/Tracing: DISABLEDRoot distance: 0.000000Root dispersion: 0.000000Reference ID: no refid, system is insaneReference time: no reftime, system is insaneBroadcast delay: 0.003906 (sec)Auth delay: 0.000122 (sec)System flags: pll monitor filegenSystem uptime: 17 (sec)Clock stability: 0.000000 (sec)Clock frequency: 0.000000 (sec)Peer: 127.127.1.0flags: (configured)(refclock)stratum: 3, version: 3our mode: client, his mode: serverSubsystem Group PID Statusxntpd tcpip 274488 activebash-3.00# lssrc -ls xntpd|grep "Sys peer"Sys peer: no peer, system is insanebash-3.00# lssrc -ls xntpd|grep "Sys peer"Sys peer: 127.127.1.0在client端: 61bash-3.00# vi /etc/ntp.confserver 10.10.1.62driftfile /etc/ntp.drifttracefile /etc/ntp.trace"/etc/ntp.conf" 42 lines, 1023 charactersbash-3.00# startsrc -s xntpd0513-059 The xntpd Subsystem has been started. Subsystem PID is 282860.bash-3.00# lssrc -ls xntpd|grep "Sys peer"Sys peer: P61B安装需要的Packages(Filesets)bos.adt.basebos.adt.libbos.adt.libmbos.adt.syscalls.tcp.client.tcp.serverbos.rte.SRCbos.rte.libcbos.rte.libcfgbos.rte.libcurbos.rte.libpthreadsbos.rte.odmbos.databos.content_listbos.dosutilbos.perf.gtoolsbos.cifs_fs.*bos.rte.lvmbos.clvm.enhrsct.basic.hacmppatrsct.basicrsct.exp.cimrmxlC.rte查看是否已经安装# lslpp -l bos.dataFileset Level State Description----------------------------------------------------------------------------Path: /usr/share/lib/objreposbos.data 5.3.0.0 COMMITTED Base Operating System Data 安装# smitty install_latest删除软件# smitty install_remove需要修改PREVIEW only? (remove operation will NOT occur)为NO打需要的APAR参见:METALINK 282036.1 169706.1 309769.1/eserver/support/fixes/fixcentral/main/pseries/ aix检查一个补丁是否已经安装# instfix -ik IX75893Not all filesets for IX75893 were found.使用SMIT安装单独的补丁#smitty instfix#smitty update_by_fix# instfix -k IX75893 -d /dev/cd0AIX 5.3需要的补丁(5308包含了这些补丁)●IY68989: “WRITE TO MMAPPED SPACE HANGS”●IY68874: An application that is run with mandatory large page data (LDR_CNTRL=LARGE_PAGE_DATA=M)may core-dump on the AIX V5.3 64-bit kernel in a LPAR environment.●IY70031: “CORRUPTION FROM SIMULTANEOUS CIO WRITES WITH O_DSYNC ON JFS2”If using the IBM Journal File System Version 2 (JFS2) for Oracle Database files.●NOTE: All Oracle 9i Database and Oracle 10g Database customers who are running on AIX 5L V5.3Technology Level 5 (TL 5300-05) must install the IBM AIX PTF for APAR IY89080. In addition, Oracle customers should contact Oracle support to obtain the fix for Oracle Bug 5496862.●IZ03260: LIO_LISTIO FAILS TO UPDATE AIO CONTROL BLOCKS ON ERROR APPLIES TO AIX 5300-06 (forAIX V5.3 TL06 customers ).●IZ03475: LIO_LISTIO FAILS TO UPDATE AIO CONTROL BLOCKS ON ERROR APPLIES TO AIX 5300-07 (forAIX V5.3 TL07 customers).JDK需要的补丁(参见METALINK309769.1,5308已经包含了)●SDK 1.4 64-bit 1.4.2.1 IY63533●SDK 1.4 32-bit 1.4.2.2 IY65305●SDK 1.3.1.16 32-bit IY58350验证其他信息Certify - Additional Info RAC for Unix Version 10gR2 64-bit On IBM AIX based Systems (RAC only)Operating System:IBM AIX based Systems (RAC only)Version5LRAC for Unix Version10gR2 64-bitHACMP Version5.4.1Status:CertifiedProduct Version Note:None available for this product.Certification Note:Use of HACMP 5.4 requires minimum service levels of the following:o AIX5L 5.3 TL 6 or later, specifically bos.rte.lvm must be at least 5.3.0.60o HACMP V5.4.1 (Available in media or APAR IZ02620)o RSCT (rsct.basic.rte)version 2.4.7.3 and ifix for APAR IZ01838 This APAR is integrated into V2.4.8.1Certified with AIX 5L 5.3 TL06 and above only∙Requires a minimum of Oracle 10.2.0.3 plus CRS bundle patch 6160398 (or newer)and rootpre.sh patch 6718715 is required when using HACMP5.4.1 with a fresh install of Oracle RAC clusterware or whenupgrading from Oracle 10gR1 to Oracle 10gR2∙Please review Metalink note404474.1for additional information修改ORACLE用户.profile文件为了使用bash,在/etc/shells和/etc/security/login.cfg中,将bash添加到可以使用的shell列表里,然后用smit user修改# User specific environment and startup programsalias cp='cp -i'alias l='ls -lA'alias ll='ls -l'alias mv='mv -i'alias rm='rm -i'exportAIXTHREAD_SCOPE=S########################################################################export ORACLE_SID=rac1########################################################################export ORACLE_BASE=/u01/app/oracleexport ORACLE_HOME=$ORACLE_BASE/product/10.2.0/db_1export ORA_CRS_HOME=$ORACLE_BASE/product/crsexport TNS_ADMIN=$ORACLE_HOME/network/adminexport BDUMP=$ORACLE_BASE/admin/$ORACLE_SID/bdumpexport UDUMP=$ORACLE_BASE/admin/$ORACLE_SID/udumpexport TEMP=/tmpexport TMP=/tmpexport TMPDIR=/tmpPATH=/usr/bin:/etc:/usr/sbin:/usr/ucb:$HOME/bin:/usr/bin/X11:/sbin PATH=$PATH:$ORACLE_HOME/bin:$ORACLE_HOME/bin:$ORA_CRS_HOME/binexport PATHexport LD_LIBRARY_PATH=$ORACLE_HOME/libexport LIBPATH=$ORACLE_HOME/libumask=022export PS1="[`whoami`@`hostname`:\$PWD]$"export NLS_LANG="AMERICAN_AMERICA.ZHS16GBK"export DISPLAY=10.10.1.128:0.0操作系统参数修改vi /etc/security/limits修改ORALCE用户下:oracle:fsize = -1data = -1stack = -1cpu = -1---------------------------------------------------# smit chgsys修改Maximum number of PROCESSES allowed per user的值,要求大于等于2048---------------------------------------------------修改VMM参数查询:vmo -a |grep -E "lru_file_repage|perm|client"vmo -a |grep -E "minfree|maxfree"ioo -a |grep -E "maxpgahead|j2_maxPageReadAhead"压缩文件系统使用的内存,保证数据库的内存使用lru_file_repage=0 在内存页面进行替换时,只替换文件使用的页面minperm%=5 为文件系统保留的至少5%的物理内存的大小maxperm%=20 普通日志文件系统最大可用的内存大小strict_maxperm=0 普通日志文件能最大使用的内存上线为软上限,如果有更多的,可以超过上限使用maxclient%=20 增强型日志文件系统最大使用的内存strict_maxclient=1 增强型日志文件系统的上限时硬上限maxfree minfree 内存页面替换的阀值,这两个值告诉LRUD合适开始/停止页面替换操作minfree = 120 * #logical CPUsmaxfree = minfree + (max(maxpgahead,j2_maxPageReadAhead) * #logical CPUs)vmo -p -o lru_file_repage=0vmo -p -o minperm%=5vmo -p -o maxclient%=20vmo -p -o maxperm%=20vmo -p -o strict_maxperm=0vmo -p -o maxclient%=20vmo -p -o strict_maxclient=1vmo -p -o minfree=120vmo -p -o maxfree=248为设置lock_sga=true,需要修改参数(ORACLE不建议设置,但我没设置这个,在9i 10g都遇到了很严重的内存泄漏,通过设置该参数解决)vmo -p -o v_pinshm=1---------------------------------------------------异步IO配置:lsdev -C -t aio 如果状态为defined那么mkdev -l aio0chdev -P -l aio0 -a autoconfig='available'如果无返回,需要安装bos.rte.aio# smit aio需要修改:minservers = 10* #CPUsmaxservers = 10*#disks/#cpusmaxreqs = 4096的倍数,该值要大于4*#disks*queue_depth典型设置:minservers=100,maxservers=100,maxreqs=16384数据库需要设置:disk_asynch_io=true,filesystemio_options=asynch---------------------------------------------------网络参数查询:# no -a |grep -E "sb_max|tcp_sendspace|tcp_recvspace|rfc1323"rfc1323 = 1sb_max >= 1MBtcp_sendspace >= 262144tcp_recvspace >= 262144udp_sendspace = max(db_block_size * db_file_multiblock_read_count,65536) udp_recvspace >= min(4* sendspace,sb_max)no -p -o rfc1323=1no -p -o sb_max=1048576no -p -o tcp_sendspace=262144no -p -o tcp_recvspace=262144no -p -o udp_sendspace=65536no -p -o udp_recvspace=262144---------------------------------------------------修改ncargs到128bash-3.00#chdev -l sys0 -ancargs=128bash-3.00# lsattr -El sys0 |grep carncargs 128 ARG/ENV list size in 4K byte blocks True 操作系统检查操作系统内存:# lsattr -El sys0 -a realmem硬件处理器是否为64位# getconf HARDWARE_BITMODE检查OS核心是否为64位#bootinfo -K检查用户最大进程数maxuproc是否大于等于2048# lsattr -El sys0 -a maxuproc检查网卡配置# ifconfig -a测试HOSTS是否正确# ping -c 1 P61A# ping -c 1 P61A_priv# ping -c 1 P61B# ping -c 1 P61B_priv查看ORACLE用户限制su - oracle[oracle@P61A:/u01/app/oracle]$ulimit -acore file size (blocks, -c) 1048575data seg size (kbytes, -d) unlimitedfile size (blocks, -f) unlimitedmax memory size (kbytes, -m) 32768open files (-n) 2000pipe size (512 bytes, -p) 64stack size (kbytes, -s) hardcpu time (seconds, -t) unlimitedmax user processes (-u) 2048virtual memory (kbytes, -v) unlimited检查用户的nofiles是否为2000,而不是-1# cat /etc/security/limits检查/tmp空间是否大于400M# df -m /tmphagsuser组是否创建# cat /etc/group确认每个系统中存在nobody用户$ id nobody检查是否存在默认路由bash-3.00# netstat -rnRouting tablesDestination Gateway Flags Refs Use If Exp GroupsRoute Tree for Protocol Family 2 (Internet):default 10.10.1.1 UG 0 0 en1 - - 10.10.1.0 10.10.1.62 UHSb 0 0 en1 - - => 10.10.1/24 10.10.1.62 U 4 1933858 en1 - -10.10.1.62 127.0.0.1 UGHS 0 43 lo0 - - 10.10.1.255 10.10.1.62 UHSb 0 4 en1 - - 12.0.0.0 12.0.0.62 UHSb 0 0 en0 - - => 12/8 12.0.0.62 U 0 12 en0 - - 12.0.0.62 127.0.0.1 UGHS 0 5 lo0 - - 12.255.255.255 12.0.0.62 UHSb 0 4 en0 - - 127/8 127.0.0.1 U 12 307 lo0 - -Route Tree for Protocol Family 24 (Internet v6):::1 ::1 UH 0 0 lo0 - -HACMP安装配置需要在2台机器上都进行HACMP安装,而且安装的文件集需要相同配置只需要在1台机器上进行,配置完成后进行同步操作安装软件# smit install_latest在SOFTWARE to install选择需要安装的软件包cluster.hativoli,cluster.haview不安装,其他都选修改ACCEPT new license agreements? 为YES安装完成后注意看日志,看最后是否标识全部成功了检查:lppchk -v和lppchk -c cluster*如果正确安装,应该无返回安装补丁包/webapp/set2/sas/f/hacmp/home.html由于我们使用的SCSI磁盘,需要修改HA脚本,否则HA启动无法挂载磁盘修改/usr/es/sbin/cluster/events/utils/cl_mode3281行,409行,STA TUS=0配置磁盘如果在重装系统前没有清除卷组,那么需要格式化磁盘格式化操作必须在存储连上机器30分钟后才能进行# diag-> Task Selection (Diagnostics, Advanced Diagnostics, Service Aids, etc.)-> Format Media也可以把该磁盘先exportvg,在把VG清除掉查看磁盘是否已经被识别,而且PVID相同# lspvhdisk0 0003c1be68e57349 rootvg activehdisk1 0052a6ee7ec6da95两台机器上分别运行,注意,hdisk0为内置磁盘,hdisk1为共享磁盘两台机器上显示的该磁盘应该同样命名为hdisk1,而且PVID(0052a6ee7ec6da95)必须是相同的创建VG( P61A上执行)# smit mkvg-> Add a Scalable V olume GroupAdd a Scalable V olume GroupType or select values in entry fields.Press Enter AFTER making all desired changes.[Entry Fields] VOLUME GROUP name [oravg]Physical partition SIZE in megabytes 128 +* PHYSICAL VOLUME names [hdisk1] + Force the creation of a volume group? no +Activate volume group AUTOMATICALLY no+ at system restart?V olume Group MAJOR NUMBER [] +# Create VG Concurrent Capable? enhanced concurrent+Max PPs per VG in units of 1024 32 +Max Logical V olumes 256 +创建LV( P61A上执行)varyonvg oravgmklv -y 'tcrs_ocr_01' -t 'raw' oravg 2mklv -y 'tcrs_vote_01' -t 'raw' oravg 2mklv -y 'trac_ctrl_1' -t 'raw' oravg 1mklv -y 'trac_ctrl_2' -t 'raw' oravg 1mklv -y 'trac_ctrl_3' -t 'raw' oravg 1mklv -y 'trac_redo1_11' -t 'raw' oravg 1mklv -y 'trac_redo1_21' -t 'raw' oravg 1mklv -y 'trac_redo2_11' -t 'raw' oravg 1mklv -y 'trac_redo2_21' -t 'raw' oravg 1mklv -y 'trac_spfile' -t 'raw' oravg 1mklv -y 'trac_pwdfile' -t 'raw' oravg 1mklv -y 'trac_indx_01' -t 'raw' oravg 5mklv -y 'trac_users_01' -t 'raw' oravg 5mklv -y 'trac_tools_01' -t 'raw' oravg 5mklv -y 'trac_system_01' -t 'raw' oravg 10mklv -y 'trac_sysaux_01' -t 'raw' oravg 10mklv -y 'trac_temp_01' -t 'raw' oravg 10mklv -y 'trac_undotbs_01' -t 'raw' oravg 10mklv -y 'trac_undotbs_02' -t 'raw' oravg 10检查bash-3.00# lsvg -l oravgoravg:LV NAME TYPE LPs PPs PVs LV STA TE MOUNT POINT tcrs_ocr_01 raw 2 2 1 closed/syncd N/Atcrs_vote_01 raw 2 2 1 closed/syncd N/Atrac_ctrl_1 raw 1 1 1 closed/syncd N/Atrac_ctrl_2 raw 1 1 1 closed/syncd N/Atrac_ctrl_3 raw 1 1 1 closed/syncd N/Atrac_redo1_11 raw 1 1 1 closed/syncd N/Atrac_redo1_21 raw 1 1 1 closed/syncd N/Atrac_redo2_11 raw 1 1 1 closed/syncd N/Atrac_redo2_21 raw 1 1 1 closed/syncd N/Atrac_spfile raw 1 1 1 closed/syncd N/Atrac_pwdfile raw 1 1 1 closed/syncd N/Atrac_indx_01 raw 5 5 1 closed/syncd N/Atrac_users_01 raw 5 5 1 closed/syncd N/Atrac_tools_01 raw 5 5 1 closed/syncd N/Atrac_system_01 raw 10 10 1 closed/syncd N/Atrac_sysaux_01 raw 10 10 1 closed/syncd N/Atrac_temp_01 raw 10 10 1 closed/syncd N/Atrac_undotbs_01 raw 10 10 1 closed/syncd N/Atrac_undotbs_02 raw 10 10 1 closed/syncd N/Aexport卷组( P61A上执行)# varyoffvg oravg# exportvg oravg在P61B上,import卷组# importvg -y oravg hdisk1在P61A上,import卷组# importvg -y oravg hdisk1现在在P61A,P61B上运行lspv,应该为如下:# lspvhdisk0 0003c1be68e57349 rootvg active hdisk1 0052a6ee7ec6da95 oravg现在在P61B上单独varyon oravg# varyonvg oravg在P61B上查看卷组属性,确保该卷组不是在机器启动时varyon# lsvg oravg|grep "AUTO ON"ACTIVE PVs: 22 AUTO ON: no在P61B上varyoff vg# varyoffvg oravg修改LV属主CRS文件/dev/rtcrs_ocr_01,/dev/rtcrs_vote_01的文件属主为oracle:oinstall其他数据库文件/dev/rtrac_*的文件属主为oracle:dbabash-3.00# chown oracle.oinstall /dev/rtcrs_*bash-3.00# chown oracle.dba /dev/rtrac_*bash-3.00# ls -l /dev |grep rtcrw-rw---- 1 oracle oinstall 51, 1 Apr 20 21:43 rtcrs_ocr_01 crw-rw---- 1 oracle oinstall 51, 2 Apr 20 21:43 rtcrs_vote_01 crw-rw---- 1 oracle dba 51, 3 Apr 20 21:43 rtrac_ctrl_1 crw-rw---- 1 oracle dba 51, 4 Apr 20 21:43 rtrac_ctrl_2 crw-rw---- 1 oracle dba 51, 5 Apr 20 21:43 rtrac_ctrl_3crw-rw---- 1 oracle dba 51, 12 Apr 20 21:43 rtrac_indx_01 crw-rw---- 1 oracle dba 51, 11 Apr 20 21:43 rtrac_pwdfile crw-rw---- 1 oracle dba 51, 6 Apr 20 21:43 rtrac_redo1_11 crw-rw---- 1 oracle dba 51, 7 Apr 20 21:43 rtrac_redo1_21 crw-rw---- 1 oracle dba 51, 8 Apr 20 21:43 rtrac_redo2_11 crw-rw---- 1 oracle dba 51, 9 Apr 20 21:43 rtrac_redo2_21 crw-rw---- 1 oracle dba 51, 10 Apr 20 21:43 rtrac_spfilecrw-rw---- 1 oracle dba 51, 16 Apr 20 21:43 rtrac_sysaux_01 crw-rw---- 1 oracle dba 51, 15 Apr 20 21:43 rtrac_system_01 crw-rw---- 1 oracle dba 51, 17 Apr 20 21:43 rtrac_temp_01 crw-rw---- 1 oracle dba 51, 14 Apr 20 21:43 rtrac_tools_01 crw-rw---- 1 oracle dba 51, 18 Apr 20 21:43 rtrac_undotbs_01 crw-rw---- 1 oracle dba 51, 19 Apr 20 21:43 rtrac_undotbs_02 crw-rw---- 1 oracle dba 51, 13 Apr 20 21:43 rtrac_users_01配置HACMP1.创建集群# smitty hacmpInitialization and Standard ConfigurationConfigure an HACMP Cluster and Nodes* Cluster Name [rac10g]New Nodes (via selected communication paths) [P61A P61B](节点名一定要和hostname命令返回值一样。

IBM 内部员工操作手册 AIX HACMP 安装配置详细文档

HACMP 5.4安装实用手册1.HACMP 5.4的安装步骤a)安装前提i.如果操作系统为AIX 5.2或者AIX 5.3时,需检查:AIX 5L Version RSCT Version RSCT FilesetsAIX 5L v.5.3 plus ML 1 2.4.2 pat.basic.hacmp 2.4.2.0pat.clients.hacmp 2.4.2.0rsct.core.sec 2.4.2.1rsct.core.rmc 2.4.2.1AIX 5L v.5.2 plus ML 5 2.3.6 pat.basic.hacmp 2.3.6.0pat.clients.hacmp 2.3.6.0rsct.core.sec 2.3.6.1rsct.core.rmc 2.3.6.1ii.此次安装的AIX 环境为AIX 5.3 ML6b)安装过程在安装HACMP的过程中,除HAview和HA Tivoli这两个安装包不装外,其他都正常安装c)安装HACMP补丁下载地址:/support/fixcentral/2.HACMP 5.4配置前的规划工作:Cluster Name Byh_clusterNode Name HA1 HA2IP Label HA1_boot HA1_svc HA1_stb HA2_boot HA2_svc HA2_stb IP Address 10.10.10.102 9.9.9.102 192.168.0.1 10.10.10.103 9.9.9.103 192.168.0.2 Persistent IP HA1_per:9.181.1.100 HA2_per:9.181.1.101HeartBeat Hb_HA1: /dev/hdisk1 Hb_HA2: /dev/hdisk2Res. Grp. Name Service IP Volume GroupApp NameByh_rg HA1_svcHA2_svcSharevg None3.HACMP5.4配置方法:a)配置两台机器的/etc/hosts文件:分别在/etc/hosts中加入:b)在HA1上,配置网路连接:i.配置HA1上boot IP----ent0上ii.配置HA1上stb IP----ent1上在HA2节点上也要将boot IP和stb IP也要提前配置好c)建立共享VG---sharevg和用于磁盘心跳的VG---convg这两个VG的* Activate volume group AUTOMATICALLY at system restart选项必须为No 建好convg后,在Node1上执行/usr/sbin/rsct/bin/dhb_read -p hdisk1 -r命令在Node2上执行/usr/sbin/rsct/bin/dhb_read -p hdisk1 -t命令,确认可以正常通讯。

hacmp 5.4.1安装过程

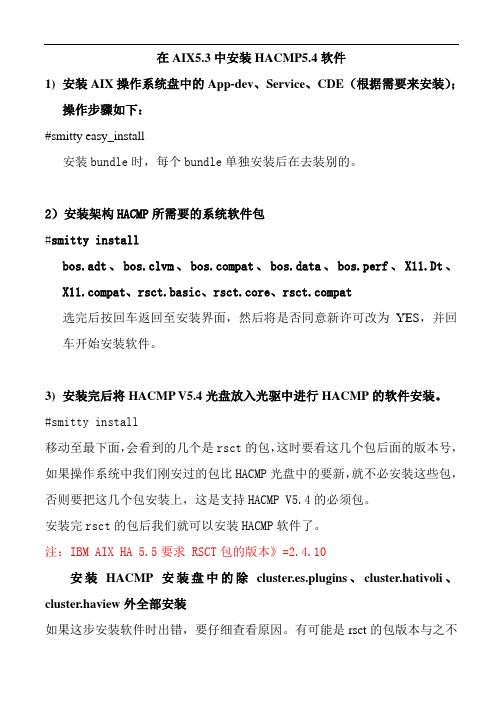

在AIX5.3中安装HACMP5.4软件1)安装AIX操作系统盘中的App-dev、Service、CDE(根据需要来安装);操作步骤如下:#smitty easy_install安装bundle时,每个bundle单独安装后在去装别的。

2)安装架构HACMP所需要的系统软件包#smitty installbos.adt、bos.clvm、pat、bos.data、bos.perf、X11.Dt、pat、rsct.basic、rsct.core、pat选完后按回车返回至安装界面,然后将是否同意新许可改为YES,并回车开始安装软件。

3) 安装完后将HACMP V5.4光盘放入光驱中进行HACMP的软件安装。

#smitty install移动至最下面,会看到的几个是rsct的包,这时要看这几个包后面的版本号,如果操作系统中我们刚安过的包比HACMP光盘中的要新,就不必安装这些包,否则要把这几个包安装上,这是支持HACMP V5.4的必须包。

安装完rsct的包后我们就可以安装HACMP软件了。

注:IBM AIX HA 5.5要求 RSCT包的版本》=2.4.10安装HACMP安装盘中的除cluster.es.plugins、cluster.hativoli、cluster.haview外全部安装如果这步安装软件时出错,要仔细查看原因。

有可能是rsct的包版本与之不匹配,要解决此问题可以去IBM网站下载rsct相关版本的软件包。

最后安装HACMP补丁上IBM网站下载HACMP V5.4的补丁包,然后传到服务里/tmp下建立一个文件夹,然后进入这个文件夹中执行:#smitty install然后在路径的位置输入./代表当前目录,然后在安装文件内容部分按F4列出所有软件包,然后再找出我们安装过的cluster相关的软件包选上并安装。

选完后按回车返回至安装界面,然后将是否同意新许可改为YES,并回车开始安装软件。

HACMP介绍

故障切换(FailOver)行为

当一个节点故障时资源组将表现出三种可能的行 为:

• Cascading

资源按照从高至低的顺序在节点间移动 重整时资源返回优先级高的节点 缺省情况下,资源只运行在优先级高的节点上

• Rotating:

资源按照一定的顺序自从一个节点移至下一个节点 资源将保留在所在的节点,除非此节点故障或系统管理者调用

RS/6000 NodeA

SCSI/FC

LAN

RS232 HeartBeat

Shared VG

en1

en0

IP2

STB SVC boot

SCSI/FC

RS/6000 NodeB

HACMP术语

集群(cluster):由2-8各运行HACMP的RS/6000和共同的IP网络 组成

节点(node):及群众的一台RS/6000 网络(network):用于集群内部通讯的TCP/IP和非IP网络 拓扑结构(topology):HACMP ODM对象类中的对节点、网络、网

高可用性集群

完善的HACMP集群设计没有单 点失败

完善的集群设计需要的基本 硬件要求:

• 2-8个节点均运行HACMP • 需要共享磁盘 • 可共享访问的TCP/IP网络 • 一个或更多的非IP网络 • 多个磁盘接口卡 • 多个网络适配器 • 多个TCP/IP网络

en0

en1

IP1

SVC STB boot

卡的逻辑描述 资源(resource):受到HACMP保护的逻辑体,包括:IP地址、文

件系统、卷组、应用等 资源组(resource group):与特定的应用相关的具有相同故障

接管行为的可管理的资源集合 应用服务器(application server):在HACMP控制下的用于启动

HACMP原理知识点

IP地址接管(IPAT):大多数应用程序都要求IP是高度可用的。为了确保这一点,我们把服务IP地址包含在资源组中,把服务IP地址从一个NIC转移到另一个上的过程称为IP地址接管。

实现(IPAT)的方式:通过别名实现:powerHA使用AIX IP别名特性,把服务IP地址添加到NIC中

通过替换实现:powerHA把接口IP地址替换为服务IP

什么是HACMP

1、系统可用性运行时间最大化

2、系统宕机时间最小化

3、不是容错机

4 避免单点故障spof

HACMP V5.x的特点

1、简化了HACMP Cluster的配置与管理

2、通过磁盘传输心跳信号

3、IPAT通过Alias实现

4、用户自定义的资源组

5、快递磁盘接管

故障恢复策略:决定资源组是否执行故障恢复

PowerHA的子系统

集群管理器clstrmgr是核心进程,包括拓扑管理器、资源管理器、事件管理器、时间脚本以及对故障做出反应的RSCT(守护进程)。主要作用是监视集群成员关系

clinfo进程提供用于在集群管理器和应用程序之间进行通信的APL。clinfo还提供远程监视功能,可以在集群状态发生变化时运行脚本。

配置HACMP的规划和考虑

硬件规划: 1、节点的配置要求(完全一致)

2、网络的配置要求(IP和Non-IP网络)

3、存储设备上的要求

软件的规划: 1、操作版本和补丁要求

2、HACMP的版本和补丁要求

3、所有应用程序的兼容性

HACMP的资源组的规划(主要是为了避免单点故障spof)

文件系统:许多应用程序需要挂载文件系统

卷组:许多应用程序需要高可用性的卷组

hacmpipalias方式的简单配置步骤

HACMP IP Alias方式的简单配置步骤环境:两台p550,各建一个全资源LPAR,主机名分别为zjdait01和zjdait02,共享存储为EMC,HACMP使用网络心跳和磁盘心跳,网络使用IP Alias 方式,主机各两块网卡绑成etherchannel,直接配固定ip,浮动ip通过/etc/hosts指定,不需要boot地址,网卡的冗余通过etherchannel 实现,这样配置的好处是日后维护简单,如果网卡发生故障,只要在etherchannel配置菜单将故障网卡从etherchannel中删除,即可通过Diag在线更换;磁盘心跳盘由盘柜建一个1G的小盘,建成concurrent vg,但不需要varyon1、确认AIX、HACMP文件集是否安装完整。

因为使用磁盘心跳,必须安装bos.clvm,如果安装hacmp53版本,安装hacmp时需要安装cluster.es.clvm,hacmp54没有这个区别2、配置两台机器的网卡每个节点用两块网卡做etherchannel,用于网卡冗余(如果系统需要跑oracle rac,oracle rac另需要两块单独的网卡做etherchannel,与系统网卡分开,且oracle和系统的网卡要分两个vlan。

)两个节点网卡做etherchannel:smitty etherchannel在网卡选择界面选择主卡,如ent0配置栏中mode选8023ad,在backup adapter处选择备卡,如ent1,配置完成系统增加一个etherchannel网卡,如ent8配置系统网络:smitty tcpipMinimum configuration & startup选择对应网卡,如ent8填入主机名、ip地址(固定ip)、子网掩码、网关,两个节点网络配完后ping网关检查网络是否正常,在ping的时候将各节点的主网卡(本例中为ent0)的光纤拔除,测试etherchannel的failover是否正常,将网线插回通过errpt检查recovery是否正常,如:vi /usr/es/sbin/cluster/netmon.cf,在文件中加入网关ip,netmon.cf文件起到HACMP网络监控作用,如果某个节点对该文件中保存的ip 访问异常,则HACMP认为该节点故障,HACMP发起资源切换动作。

UXIX短消息中心HACMP双机配置指导书-20030106-A2

HACMP双机配置指导书本文介绍HA CMP双机的配置。

1.1 概述在启动短消息系统之前,需要对双机系统进行配置,IBM-pSeries的双机控制软件称之为HACMP。

HACMP双机软件的配置过程分为两部分,分别为HA CMP基本配置(Cluster配置)和HACMP应用定制配置。

配置过程如下:在启动双机系统HA CMP之前,需要对两个独立的主机进行配置,以构成一个完整的双机系统,这些配置工作都将通过IBM的HACMP双机软件工具来完成,称为Cluster配置。

在Cluster配置正确完成之后,就可以结合具体的短消息系统对HACMP进行定制配置,也就是进行应用的监管配置,将短消息系统置于HACMP双机系统的监控管理之下。

说明:以下配置操作以root用户进行,每个步骤完成,可使用Esc+3 / F3 回退到上一步,使用Esc+4/F4进行配置项值列表选择,使用Esc+0/F10退出smitty 配置环境,Enter确认配置参数。

1.2 双机规划方案1.2.1以下为中山短消息系统的双机规划实例,供参考!表1-1Network Adapter Worksheet表1-2Share IP Address用户/组规划1.2.2 修改配置文件根据以上网络规划,修改相应的配置文件:1、以root用户修改主备小型机上/etc/security/limits文件:# cd /etc/security;切换到目录:/etc/security.# vi limits ;修改配置文件limits。

在文件中增加或修改root用户的参数如下:smc:fsize = -1core = 409600cpu = -1data = -1rss = -1stack =-1nofiles = 20002、修改hosts文件127.0.0.1 loopback localhost # loopback (lo0) name/address# zs_smc_smc1172.10.14.31 zs_smc_smc1_boot zs_smc_smc1192.168.14.31 zs_smc_smc1_stb zs_smc_smc1# zs_smc_smc2172.10.14.33 zs_smc_smc2_boot zs_smc_smc2192.168.14.33 zs_smc_smc2_stb zs_smc_smc2# service_ip172.10.14.30 service_ip#fix ip172.10.114.31 zs_smc_smc1172.10.114.33 zs_smc_smc2.rhosts文件zs_smc_smc1zs_smc_smc1_bootzs_smc_smc1_stbzs_smc_smc2zs_smc_smc2_bootzs_smc_smc2_stbservice_ip1.3 配置前提1.3.1 检查双机上正确安装了HACMP软件检查双机两台机器上是否都安装了HA CMP软件,详细安装步骤见附录二。

Hacmp_网络配置与存储配置

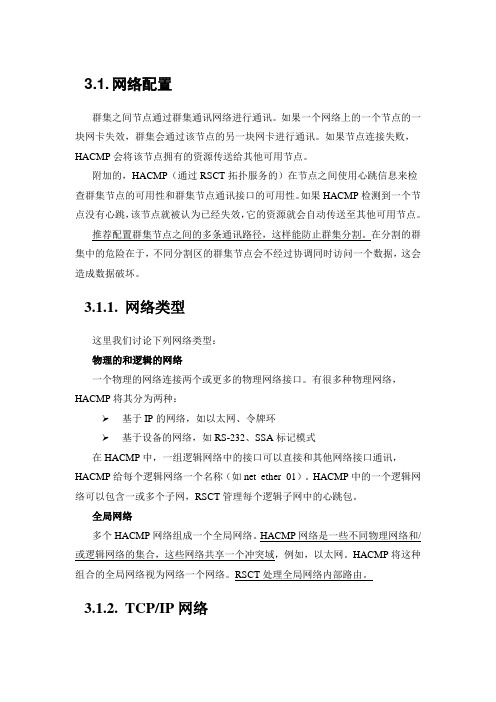

3.1.网络配置群集之间节点通过群集通讯网络进行通讯。

如果一个网络上的一个节点的一块网卡失效,群集会通过该节点的另一块网卡进行通讯。

如果节点连接失败,HACMP会将该节点拥有的资源传送给其他可用节点。

附加的,HACMP(通过RSCT拓扑服务的)在节点之间使用心跳信息来检查群集节点的可用性和群集节点通讯接口的可用性。

如果HACMP检测到一个节点没有心跳,该节点就被认为已经失效,它的资源就会自动传送至其他可用节点。

推荐配置群集节点之间的多条通讯路径,这样能防止群集分割。

在分割的群集中的危险在于,不同分割区的群集节点会不经过协调同时访问一个数据,这会造成数据破坏。

3.1.1.网络类型这里我们讨论下列网络类型:物理的和逻辑的网络一个物理的网络连接两个或更多的物理网络接口。

有很多种物理网络,HACMP将其分为两种:➢基于IP的网络,如以太网、令牌环➢基于设备的网络,如RS-232、SSA标记模式在HACMP中,一组逻辑网络中的接口可以直接和其他网络接口通讯,HACMP给每个逻辑网络一个名称(如net_ether_01)。

HACMP中的一个逻辑网络可以包含一或多个子网,RSCT管理每个逻辑子网中的心跳包。

全局网络多个HACMP网络组成一个全局网络。

HACMP网络是一些不同物理网络和/或逻辑网络的集合,这些网络共享一个冲突域,例如,以太网。

HACMP将这种组合的全局网络视为网络一个网络。

RSCT处理全局网络内部路由。

3.1.2.TCP/IP网络HACMP支持的基于IP的网络有:➢ether(以太网)➢atm(异步传输模式-ATM)➢fddi(光纤分布式数据接口-FDDI)➢hps(SP交换)➢token(令牌环)HACMP通过RSCT拓扑服务监视这些网络。

通过IP别名的心跳在HACMP中,你可以配置通过IP别名控制心跳。

在以前的HACMP版本中心跳只能通过服务/非服务IP地址/标签(基本或引导IP地址/标签)来进行交换。

IBM HACMP 配置

IBM HACMP 系列-- 安装和配置一规划是成功的实现的一半,就 HACMP 而言,如何强调正确规划的重要性都不过分。

如果规划做得不正确,您可能会在以后某个时候发现自己陷入种种限制之中,而要摆脱这些限制可能是非常痛苦的经历。

因此,请保持镇定从容,并使用产品附带的规划工作表;这些工作表对于任何迁移或问题确定情形或者对于为规划做文档记录都是非常有价值的。

一. HACMP 软件安装HACMP 软件提供了一系列可用于使应用程序高度可用的功能。

务必记住,并非所有的系统或应用程序组件都受到 HACMP 的保护。

例如,如果某个关键应用程序的所有数据都驻留在单个磁盘上,并且该磁盘发生了故障,则该磁盘就成了整个集群的单点故障,并且未受到 HACMP 的保护。

在此情况下,必须使用 AIX 逻辑卷管理器或存储子系统保护功能。

HACMP 仅在备份节点上提供磁盘接管,以使数据可继续使用。

这就是 HACMP 规划是如此重要的原因,因为整个规划过程中的主要目标是消除单点故障。

当关键集群功能由单个组件提供时,就存在单点故障。

如果该组件发生故障,集群没有提供该功能的其他途径,依赖该组件的应用程序或服务就会变得不可用。

还要记住,规划良好的集群非常容易安装,可提供更高的应用程序可用性,能够按预期执行,并且比规划不当的集群需要更少的维护。

1.1 检查先决条件在完成规划工作表以后,请验证您的系统是否满足 HACMP 所必需的要求;执行这项额外的工作可以消除许多潜在的错误。

HACMP V5.1 需要下列操作系统组件之一:(1)带 RSCT V2.2.1.30 或更高版本的 AIX 5L V5.1 ML5。

(2)带 RSCT V2.3.1.0 或更高版本(建议使用 2.3.1.1)的 AIX 5L V5.2 ML2。

(3)C-SPOC vpath 支持(需要 SDD 1.3.1.3 或更高版本)。

有关先决条件和 APAR 的最新信息,请参考产品附带的自述文件和以下 IBM 网站:/server/cluster/1.2 全新安装HACMP 支持网络安装管理(Network Installation Management,NIM)程序,包括“备选磁盘迁移”(Alternate Disk Migration) 选项。

HA常用心跳网络特点和配置

POWERHA 常用心跳网络特点和配置最近系统的复习了一下PowerHA,做了一些相关的试验,今天时间充裕,在博客里把有关于心跳方面的知识总结一下。

谈到PowerHA,不得不谈心跳。

记得拜读IBM官方网站上《浅谈HACMP 心跳》一文中,作者王荣说了一句颇幽默的话:“我们可以看出使用HACMP 集群,可谓玩的就是心跳。

”的确如此,在个人的学习和实施的过程中,发现心跳的确是要玩的,而且要玩好。

一、心跳作用及分类PowerHA通过以下三种手段,来监控节点是否运行正常:1、RSCT 监控网络接口和设备。

.2、AIX LVM 监控硬盘、逻辑卷、卷组状态。

3、PowerHA 应用监控应用状态。

PowerHA使用心跳keep alive (KA)包来监控网络接口、通信设备、和ip地址标签有效性。

在PowerHA中用基于IP网络和non-IP网络来交换心跳包。

其中基于IP网络包括:Ethernet (ether)、Token-ring (token)、Fiber Distributed Data Interface - FDDI (fddi)、 Asynchronous Transfer Mode- ATM and ATM LAN Emulation) (atm)、 EtherChannel (ether)、 IP Version 6 (IPV6)、InfiniBand,其中enther网络心跳比较常用。

基于设备的主要包括:目标模式SCSI (tmscsi) 、目标模式SSA (tmssa) 、磁盘心跳信号(diskhb)、串行RS232 。

磁盘心跳信号(diskhb)和串行RS232在实际环境中用到比较多(个人根据实施经验判断,不一定准确)。

二、常用心跳网络配置1、RS232串口心跳配置硬件配置建议配置专门用作心跳网络的异步卡。

异步卡及串口线的选择配置可以参考:PowerHA中异步卡和串口线的选择。

配置方法:添加tty设备:smitty device 中找到tty.测试tty通信是否正常:在连接串口线后,在一台设备上输入:cat /etc/hosts>/dev/tty0 另外一台输入:cat</dev/tty0。

更改HACMP环境里网卡的ip地址

更改HACMP环境里网卡的ip地址服务 IP 地址变更增加服务 IP 地址1.修改 /etc/hosts, 增加以下行10.66.201.1 host1_l2_svc210.66.201.2 host2_l2_svc2HACMP 新增服务 IPsmitty hacmp->Extended Configuration->HACMP Extended Resources Configuration ->Configure HACMP Service IP Labels/Addresses->Add a Service IP Label/Address->Configurable on Multiple Nodes选择网络Add a Service IP Label/Address configurable onMultiple Nodes (extended)Type or select values in entry fields.Press Enter AFTER making all desired changes.* IP Label/Address host1_svc2* Network Name net_ether_01Alternate HW Address to accompany IPLabel/Address []同样增加 host2_svc21.修正资源组smitty hacmp->Extended Configuration->Extended Resource Configuration->HACMP Extended Resource Group Configuration->Change/Show Resources and Attributes for a Resource Group->Change/Show All Resources and Attributes for a Resource Group Type or select values in entry fields.Press Enter AFTER making all desired changes.[Entry Fields]Resource Group Name eai1d0_RGParticipating Nodes (Default Node Priority)bgbcb11 bgbcb04Startup Policy Online On Home Node OnlyFallover Policy Fallover To Next PriorityNode In The ListFallback Policy Fallback To Higher PriorityNode In The ListFallback Timer Policy (empty is immediate) []Service IP Labels/Addresses [host1_svchost1_svc2]1.HACMP 同步需要同步,参见第 2 部分的“检查和同步 HACMP 配置”一节。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

HACMP配置

1修改HOSTS文件

vi /etc/hosts

添加如下内容:

172.16.1.70 p550_boot

172.16.1.80 p520_boot

172.16.2.88 p550_srv

10.1.1.1 p550_stdby

10.1.1.2 p520_stdby

2建立节点信任机制

1)、修改各节点/usr/es/sbin/cluster/etc/rhosts文件,添加如下内容:

p550_boot

p520_boot

p550_srv

p550_stdby

p520_stdby

2)、修改root用户主目录下.rhosts文件,添加如下内容:

p550_boot

p520_boot

p550_srv

p550_stdby

p520_stdby

3)、修改/etc/hosts.equiv文件,添加如下内容:

p550_boot

p520_boot

p550_srv

p550_stdby

p520_stdby

4)、分别在各节点测试

ping p550_boot

ping p520_boot

ping p550_stdby

ping p520_stdby

rlogin p550_boot

rlogin p520_boot

3配置HACMP 3.1创建集群节点

#smitty hacmp

创建一个名称为“hatest”的集群,以下将两个节点加入集群:

输入“p550”,把“p550”加入集群

输入“p520”,把“p520”加入集群

3.2创建网络

选择“ether”

按回车

创建成功

3.3配置网络接口

在“IP Label/Address”,按F4,选择P550,回车

在“Node Name”,按F4,选择P550

按回车

然后按上述步骤,分别添加“p550_stdby”,“p520”,“p520_stdby”到网络中,“p550_stdby”属于p550节点,“p520”,“p520_stdby”属于p520节点

3.4配置磁盘心跳

3.4.1创建并发VG

两个节点从共享存储上映射过来的名称是hdisk2 在p550节点上创建并发VG:

#mkvg -C -f -n -S -V 200 -y datavg hdisk2

#varyoffvg datavg

在p520节点上导入VG信息:

#importvg -V 200 -y datavg hdisk2

导入成功

3.4.2创建心跳网络

选择“diskhb”

3.4.3创建心跳设备

填写p550节点的“Device Name”名称为“p550diskhb”,“Device Path”路径为“/dev/hdisk2”,“Node Name”为p550

重复上述步骤,创建p520节点的磁盘心跳,内容如下图:

3.4.4测试磁盘心跳

在p550上执行:

#/usr/sbin/rsct/bin/dhb_read -p hdisk2 -r

在p520上执行:

#/usr/sbin/rsct/bin/dhb_read -p hdisk2 -t

如果从p550到p520的连接通畅,两个节点上均会显示下列信息:

Link operating normally.

3.4.5创建资源组

3.4.5.1添加Service IP

3.4.5.2添加应用程序启动和停止脚本

填写“Service Name”以及启动和停止脚本的绝对路径

3.4.5.3添加资源组

填写资源名称“hatestres”,选中两个节点,内容如下图

3.4.5.4修改资源组

修改内容如下图

同步集群配置信息

3.5启动HA。