vmware_esxi 虚拟机集群共享磁盘

VMware_虚拟机与主机间共享文件的七种方法

VMware 虚拟机与主机间共享文件的七种方法好多人都不清楚如何在本机和虚拟机间共享文件和数据,那么今天我就给大家分享下我所知道的方法。

测试环境:物理机:win Xp SP2 打全所有系统补丁;虚拟机版本:VMware workstation 6.5.1 Build-126130;虚拟机操作系统:windows 2003方法一:直接在物理机和虚拟机间拖拽文件这个不用多说,不过要注意的是,有些情况下拖拽会出错,用VMware workstation 6时,往虚拟机里面拖动拷贝文件/ 文件夹时,物理机上的源文件的全路径/源文件夹(及其子文件夹)的全路径名称中不能包含非标准ASCII码字符。

也就是说,源文件的全路径/源文件夹 (及其子文件夹)的全路径名称只能是英文字符,有中文的就会报错。

多拖动几次之后有时还会导致虚拟机的explorer进程挂掉或者报下面第三个提示,此时不能再往虚拟机里面拖动拷贝任何东西。

重启guest,依然不能拖动拷贝。

必须先关闭虚拟机再开启,才能复位。

如果源文件夹(及其子文件夹)的全路径名称中包含非标准ASCII码字符,会提示:“Cannot scan local directory. You may not have permission to perform the operation. Aborting the file copy operation.”(意思是:无法打开本地目录,你可能没有权限执行这个操作,在拷贝时异常退出)如果是源文件的全路径名称中包含非标准ASCII码字符,会提示:Cannot determine local file size. You may not have permission to perform the operation. Aborting the file copy operation.(意思是:无法检测目标文件的大小,你可能没有权限执行这个操作,在拷贝文件时异常退出)多拖动几次有时就会报这个提示:Cannot creat diretctory on virtual machine. Aborting the drag and drop operation.(意思是:无法在虚拟机上创建目录。

vmware ESXI5.1中配置虚拟共享磁盘

ESXI 5.1中创建windows clust共享磁盘MSCS故障转移群集是一组独立的计算机,这些计算机相互协作以提高应用程序和服务的可用性。

多台群集服务器(称为节点)通过物理电缆和软件连接。

如果其中一个群集节点出现故障,另外一个节点就会开始提供服务(该过程称为故障转移)。

从而使用户遭遇服务中断的次数降至最低。

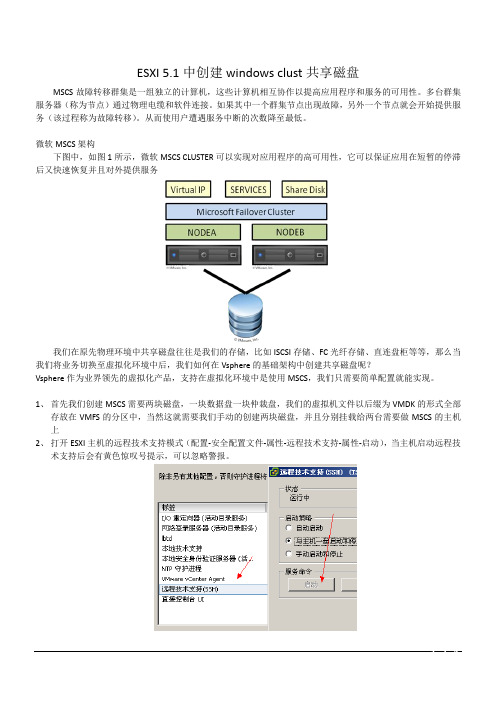

微软MSCS架构下图中,如图1所示,微软MSCS CLUSTER可以实现对应用程序的高可用性,它可以保证应用在短暂的停滞后又快速恢复并且对外提供服务我们在原先物理环境中共享磁盘往往是我们的存储,比如ISCSI存储、FC光纤存储、直连盘柜等等,那么当我们将业务切换至虚拟化环境中后,我们如何在Vsphere的基础架构中创建共享磁盘呢?Vsphere作为业界领先的虚拟化产品,支持在虚拟化环境中是使用MSCS,我们只需要简单配置就能实现。

1、首先我们创建MSCS需要两块磁盘,一块数据盘一块仲裁盘,我们的虚拟机文件以后缀为VMDK的形式全部存放在VMFS的分区中,当然这就需要我们手动的创建两块磁盘,并且分别挂载给两台需要做MSCS的主机上2、打开ESXI主机的远程技术支持模式(配置-安全配置文件-属性-远程技术支持-属性-启动),当主机启动远程技术支持后会有黄色惊叹号提示,可以忽略警报。

3、使用Putty工具以Root身份登录到打开远程技术支持的主机上。

4、进入共享磁盘所在的路径。

(例:cd /vmfs/volumes/datastore1)请将datastore1替换成对应的共享VMFS卷名称5、创建共享磁盘。

(例:vmkfstools -c 10000m -d eagerzeroedthick -a lsilogic /vmfs/volumes/datastore1/data.vmdk)(例:vmkfstools -c 1024m -d eagerzeroedthick -a lsilogic /vmfs/volumes/datastore1/quorum.vmdk)(例:vmkfstools -c 1024m -d eagerzeroedthick -a lsilogic /vmfs/volumes/datastore1/msdtc.vmdk)创建好后如下图所示一般仲裁盘和MSDTC盘为1G即1024MB,数据盘根据业务大小自由分配。

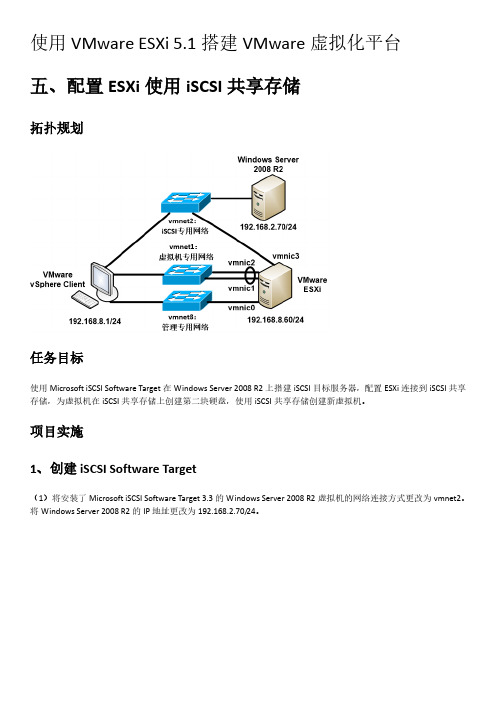

1.5.配置ESXi使用iSCSI共享存储

项目实施 1、创建 iSCSI Software Target

(1)将安装了 Microsoft iSCSI Software Target 3.3 的 Windows Server 2008 R2 虚拟机的网络连接方式更改为 vmnet2。 将 Windows Server 2008 R2 的 IP 地址更改为 192.168.2.70/24。

(8)可以看到 iSCSI 存储中新创建的硬盘文件。

(9)以后在创建新的虚拟机时,也可以在选择虚拟机文件的目标存储时,选中 iSCSI-Win2008R2 存储,从而将新虚 拟机放置在 iSCSI 共享存储中。

(10)以下为 iSCSI 存储中新创建的虚拟机文件。

(18)输入数据存储名称为 iSCSI-Win2008R2。

(19)使用最大可用空间。

(20)点击完成开始创建 VMFS 数据存储,以下是新添加的 iSCSI 共享存储。

3、使用 iSCSI 共享存储

(1)为 CentOS 6.6 x86_64 客户机添加第二块硬盘,该硬盘文件放置在 iSCSI 共享存储中。编辑 CentOS 6.6 x86_64 客户机的虚拟机设置,点击“添加” 。

(8)输入虚拟磁盘描述。

(9)设置可以访问此虚拟磁盘的 iSCSI 目标:点击添加,选择之前创建的 iSCSI 目标。

(10)以下为创建好的虚拟磁盘。

2、配置 ESXi 连接到 iSCSI 网络存储

(1)关闭 ESXi 主机,在 VMware Workstation 中为 ESXi 主机添加一块 vmnet2 模式的网卡。

使用 VMware ESXi 5.1 搭建 VMware 虚拟化平台 五、配置 ESXi 使用 iSCSI 共享存储

VMware虚拟化软件安装与配置教程

VMware虚拟化软件安装与配置教程第一章:VMware虚拟化软件概述VMware是一家知名的虚拟化软件公司,其产品提供了一种在物理硬件上运行多个虚拟操作系统的方法。

虚拟化技术在现代计算机系统中扮演着重要的角色,它可以帮助用户提高硬件资源的利用率,降低成本,并增强系统的可靠性和灵活性。

第二章:VMware虚拟化软件的安装准备要安装VMware虚拟化软件,首先需要准备一台合适的物理服务器或个人计算机。

服务器的配置应满足VMware的最低要求,包括适当的处理器、内存和硬盘空间。

另外,还需要准备虚拟化软件的安装介质,可以从VMware官方网站下载最新的安装包。

第三章:VMware虚拟化软件的安装步骤- 下载安装包并解压缩,运行安装程序。

- 在安装向导中选择合适的安装类型,如典型安装或自定义安装。

- 同意许可协议并选择安装路径。

- 配置网络设置,并选择网络适配器类型。

- 创建虚拟机所需的数据存储,并指定存储路径。

- 配置虚拟机的默认文件夹和相关选项。

- 设置VMware Update Manager(可选)以及其他组件。

- 完成安装并启动VMware虚拟化软件。

第四章:VMware虚拟机的创建与配置- 打开VMware虚拟化软件,点击"新建虚拟机"。

- 在向导中选择虚拟机的类型,如自定义虚拟机或虚拟机模板。

- 选择要安装的操作系统类型和版本。

- 配置虚拟机的硬件设置,包括处理器、内存、硬盘和网络适配器等。

- 根据需要添加其他设备、设置共享文件夹或配置虚拟机的高级选项。

- 根据提示完成虚拟机的配置。

第五章:VMware虚拟机的操作与管理- 启动虚拟机,选择所需的操作系统。

- 使用虚拟机控制台进行操作系统的安装和配置。

- 在虚拟机中安装所需的应用程序和驱动程序。

- 在需要时对虚拟机进行快照和恢复操作。

- 配置虚拟机的网络连接,包括NAT、桥接和主机模式等。

- 设置虚拟机的参数,如CPU和内存分配、磁盘容量和虚拟机版本等。

Esxi下虚拟机共享磁盘

技术文档

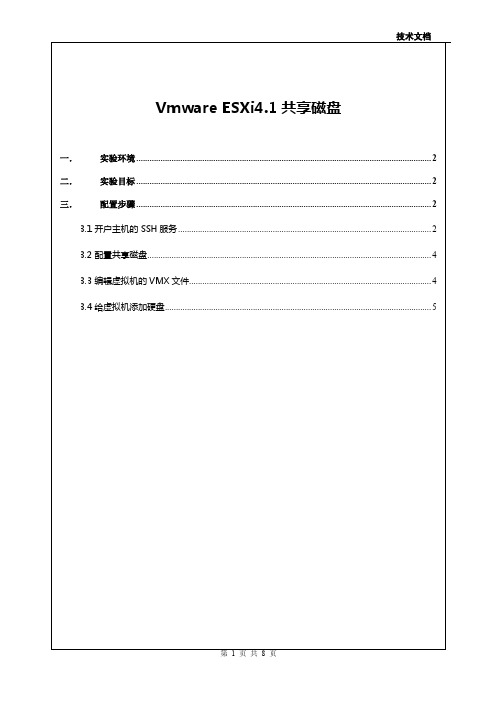

Vmware ESXi4.1 共享磁盘

一. 二. 三.

3.3 编辑虚拟机的 VMX 文件.............................................................................................................. 4

3.4 给虚拟机添加硬盘......................................................................................................................... 5

3.1 开户主机的 SSH 服务 ................................................................................................................... 2

3.2 配置共享磁盘................................................................................................................................. 4

使用 Vsphere Client 登录到主机,选中主机,选择右侧配置标签中的“配置”标签,再选择“安全配置文 件”,然后点击右上角的“属性”按钮,如图一。

使用一台测试2台ESXi5部署vSAN集群

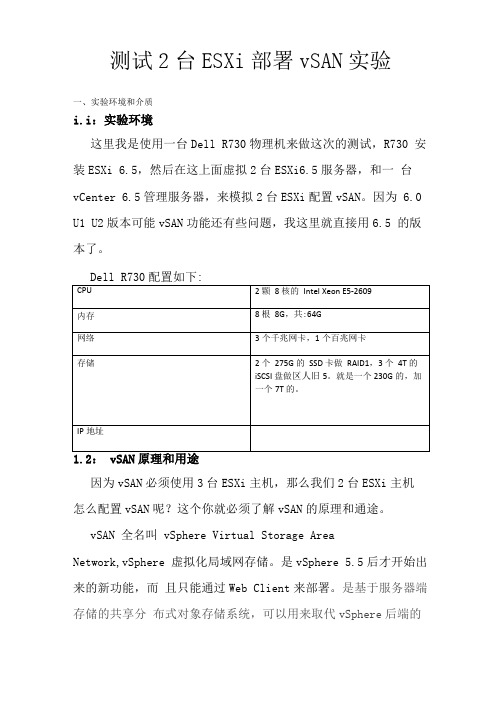

测试2台ESXi部署vSAN实验一、实验环境和介质i.i:实验环境这里我是使用一台Dell R730物理机来做这次的测试,R730 安装ESXi 6.5,然后在这上面虚拟2台ESXi6.5服务器,和一台vCenter 6.5管理服务器,来模拟2台ESXi配置vSAN。

因为 6.0 U1 U2版本可能vSAN功能还有些问题,我这里就直接用6.5 的版本了。

Dell R730配置如下:1.2: vSAN原理和用途因为vSAN必须使用3台ESXi主机,那么我们2台ESXi主机怎么配置vSAN呢?这个你就必须了解vSAN的原理和通途。

vSAN 全名叫 vSphere Virtual Storage AreaNetwork,vSphere 虚拟化局域网存储。

是vSphere 5.5后才开始出来的新功能,而且只能通过Web Client来部署。

是基于服务器端存储的共享分布式对象存储系统,可以用来取代vSphere后端的外置磁盘阵列。

vSAN就是一种分布式存储,其数据保护技术不是采用传统的RAID方式,而是叫分布式RAID。

VSAN在主机之间使用RAID来满足对系统中存储对象的可用性和可靠性的要求,虚拟机存储对象的镜像拷贝数量取决于虚拟机存储策略。

数据的副本都是存储在主机上的,当某台主机失效或宕机,就会出现类似脑裂问题,vSphere为了解决这个问题,引入了一个重要的组件一见证 (winess),类似于我们常说的仲裁盘。

由于见证只是一个逻辑组件,不保存数据,占用空间非常小,我们也就可以实现2台ESXi 主机的vSAN集群。

这个见证是一个模板,可以从官网直接下,免费的,安装这个模板,最好从vCenter web client添加,就可以省去2个CPU的许可,用client部署这个模板是看不到见证自带的许可的。

1.4:虚拟机规划vCenter6.5:ESXi6.5:Winess6.5:二、配置主机,安装虚拟机,安装vCenter2.1:配置主机因为要开启vSAN功能,虚拟机必须配置2块网卡,1块单独来处理vSAN流量,所以在安装ESXi的主机上最好配置2个交换机,1个交换机放正常的虚拟机的管理,另一个当2台ESXi虚拟机的vSAN 网卡的交换机。

vmware 分配磁盘空间方式

vmware 分配磁盘空间方式

VMware提供了几种分配磁盘空间的方式,具体取决于您使用

的是VMware Workstation还是VMware vSphere。

对于VMware Workstation:

1. 指定磁盘大小:您可以在创建新的虚拟机时指定虚拟磁盘的大小。

创建虚拟机向导会询问您要分配多少磁盘空间。

2. 分配动态增长磁盘:您可以选择分配一个动态增长的虚拟磁盘。

这种磁盘只会占用实际虚拟机磁盘所需的空间,并在需要时自动增长。

3. 分配固定磁盘:您也可以选择分配一个固定大小的虚拟磁盘。

这种磁盘会立即占用指定大小的物理磁盘空间。

对于VMware vSphere:

1. 分配粗粒度存储(Thick Provision):这种方式会一次性为

虚拟机分配足够的物理磁盘空间。

这样虚拟机可以立即使用分配的全部空间,但可能会浪费一些空间。

2. 分配粗粒度存储且懒惰增长(Thick Provision Lazy Zeroed):这种方式会一次性为虚拟机分配足够的物理磁盘空间,但是只有在实际使用时才会写入零值数据。

3. 分配精细粒度存储(Thin Provision):这种方式只为虚拟机

分配实际需要的物理磁盘空间。

这样虚拟机可以共享物理存储空间,但可能会出现存储不足的情况。

总体而言,选择哪种磁盘分配方式取决于您对存储空间的需求以及对资源的优化需求。

例如,如果您对存储空间有严格要求,可以考虑选择固定磁盘或粗粒度存储。

如果您更关注资源的最大化利用,可以选择动态增长磁盘或精细粒度存储。

VMware故障切换群集和 Microsoft 群集

故障切换群集和 Microsoft 群集服务的设置ESXi 5.5vCenter Server 5.5在本文档被更新的版本替代之前,本文档支持列出的每个产品的版本和所有后续版本。

要查看本文档的更新版本,请访问/cn/support/pubs。

ZH_CN-001251-01故障切换群集和 Microsoft 群集服务的设置2 VMware, Inc.最新的技术文档可以从VMware 网站下载:/cn/support/VMware 网站还提供最近的产品更新信息。

您如果对本文档有任何意见或建议,请把反馈信息提交至:docfeedback@版权所有 © 2006–2013 VMware, Inc. 保留所有权利。

本产品受美国和国际版权及知识产权法的保护。

VMware 产品受一项或多项专利保护,有关专利详情,请访问 /go/patents-cn 。

VMware 是 VMware, Inc. 在美国和/或其他法律辖区的注册商标或商标。

此处提到的所有其他商标和名称分别是其各自公司的商标。

VMware, Inc.3401 Hillview Ave.Palo Alto, CA 北京办公室北京市海淀区科学院南路2号融科资讯中心C 座南8层/cn 上海办公室上海市浦东新区浦东南路 999 号新梅联合广场 23 楼/cn 广州办公室广州市天河北路 233 号中信广场 7401 室/cn目录MSCS 的更新信息5故障切换群集和 Microsoft 群集服务的设置7MSCS 入门7对单个物理主机上的虚拟机进行群集13对不同物理主机上的虚拟机进行群集16对物理机和虚拟机进行群集19在 vSphere HA 和 vSphere DRS 环境中使用 MSCS22vSphere MSCS 设置对照表25索引29VMware, Inc. 3故障切换群集和 Microsoft 群集服务的设置4 VMware, Inc.MSCS 的更新信息本《故障切换群集和 Microsoft 群集服务的设置》随产品的版本更新或必要时进行更新。

VM虚拟机与宿主机文件共享的处理方法

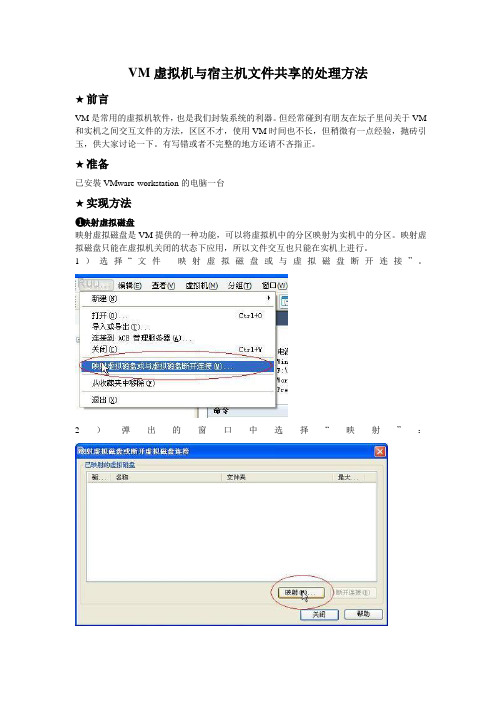

VM虚拟机与宿主机文件共享的处理方法★前言VM是常用的虚拟机软件,也是我们封装系统的利器。

但经常碰到有朋友在坛子里问关于VM 和实机之间交互文件的方法,区区不才,使用VM时间也不长,但稍微有一点经验,抛砖引玉,供大家讨论一下。

有写错或者不完整的地方还请不吝指正。

★准备已安裝VMware-workstation的电脑一台★实现方法❶映射虚拟磁盘映射虚拟磁盘是VM提供的一种功能,可以将虚拟机中的分区映射为实机中的分区。

映射虚拟磁盘只能在虚拟机关闭的状态下应用,所以文件交互也只能在实机上进行。

1)选择“文件--映射虚拟磁盘或与虚拟磁盘断开连接”。

2)弹出的窗口中选择“映射”:3)依次选择需要载入的虚拟机相关文件(.vmdk)、是否只读模式打开、和映射到实机的盘符:4)确定以后,即可在实机上操作虚拟机中的分区:※映射虚拟磁盘只能在虚拟机关闭的时候才能使用※如果需要更改虚拟机内的文件,别忘了去掉只读的勾勾。

※这个功能有时候好像不太稳定❷USB设备(U盘、移动硬盘)共享虚拟机可以接管实机上的USB设备,这样我们就可以用USB设备(U盘、移动硬盘)当中转来交换文件。

1)在虚拟机开机的状态下,插入新USB设备,VM会弹出安装VM专用的USB驱动安装界面:2)将驱动安装路径指向VM安装文件夹下的vmusb.sys驱动文件。

3)安装好驱动后在VM软件右下角的设备状态栏中就会出现USB设备相对应的图标,在图标上点击右键,选择连接。

虚拟机就会接管实机上的USB设备,同时实机上USB设备卸除:4)虚拟机使用完USB设备后,仍然右键点击右下角的USB设备图标,选择断开。

虚拟机就会卸除USB设备,同时实机接管USB设备。

※需要虚拟机有USB控制器的存在(默认有,没有的话可在编辑虚拟机设置中添加)。

※摄像头等USB设备也可以用此方法互动。

※彻底不需要USB设备时,只要在实机上点击卸除即可。

❸第三方软件:DISKGENDISKGEN(原名DISKMAN)是一款功能强大的国产磁盘分区及数据恢复软件。

ESXi5+VM+RHCS环境构筑时遇到的问题及解决方法

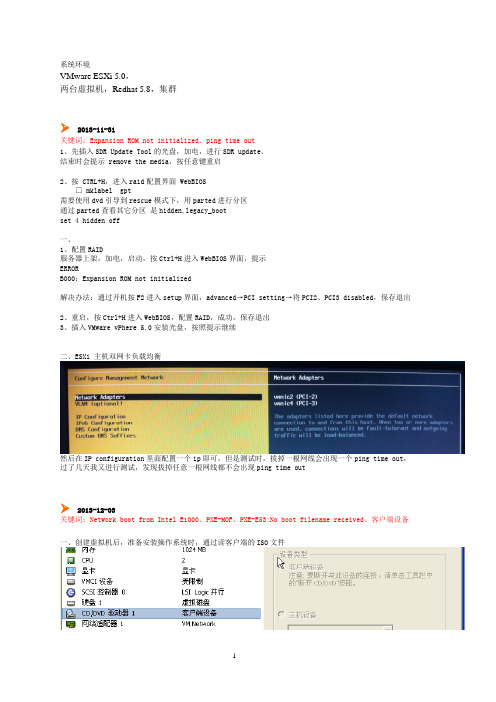

系统环境VMware ESXi 5.0,两台虚拟机,Redhat 5.8,集群2013-11-31关键词:Expansion ROM not initialized、ping time out1、先插入SDR Update Tool的光盘,加电,进行SDR update。

结束时会提示 remove the media,按任意键重启2、按 CTRL+H,进入raid配置界面 WebBIOS□ mklabel gpt需要使用dvd引导到rescue模式下,用parted进行分区通过parted查看其它分区是hidden,legacy_bootset 4 hidden off一、1、配置RAID服务器上架,加电,启动,按Ctrl+H进入WebBIOS界面,提示ERRORB000:Expansion ROM not initialized解决办法:通过开机按F2进入setup界面,advanced→PCI setting→将PCI2、PCI3 disabled,保存退出2、重启,按Ctrl+H进入WebBIOS,配置RAID,成功,保存退出3、插入VMware vPhere 5.0安装光盘,按照提示继续二、ESXi 主机双网卡负载均衡然后在IP configuration里面配置一个ip即可,但是测试时,拔掉一根网线会出现一个ping time out,过了几天我又进行测试,发现拔掉任意一根网线都不会出现ping time out2013-12-03关键词:Network boot from Intel E1000、PXE-MOF、PXE-E53:No boot filename received、客户端设备一、创建虚拟机后,准备安装操作系统时,通过读客户端的ISO文件启动时一直报下面的错误Network boot from Intel E1000PXE-MOFPXE-E53:No boot filename received解决方法如下:you need to click the "connected" and "connect at power on" in the right top corner in order to make the iso to mount properly.After you click "connect at power on", reboot the VM and it should boot from the iso.如果还出现上面提示时,点击回车,就会进入安装界面第二种解决方法,启动虚拟机后按F2进入BIOS设置,删除掉network boot选项,通过按+/-号将选项移到如下图位置如果还不行就把网卡全删了,等安装完之后再添加二、安装系统选择安装包后,会有一个Transferring的过程这种方式安装需要更久的时间,200分钟左右2013-12-04关键词:ESXi Shell、linux resuce模式分区、put: failed to upload ***.iso. Operation unsupported、Operating System not found一、开启ESXi Shell访问,将ISO文件先上传至ESXi 服务器,参考文档《[精]打开VMware ESXi 5.0 上的SSH 支持.org.htm》二、使用VMware Client端的ISO文件安装OS好慢啊啊啊啊三、先通过iso文件引导到linux resuce模式下进行硬盘分区,但是分完后exit,重新启动虚拟机,一直黑屏,没动静,如下图,试了两遍都是这样用这种读取ISO的方式也不行,最后把分区删了,重新安装,在安装过程中再进行分区四、通过sftp向ESXi服务器上传iso文件报错,其实已经上传成功sftp> cd /vmfs/volumes/datastore1sftp> lcd D:\03_software\01worksoft\linux_isosftp> put RRedhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.isorhel-server-5.7-i386-dvd.iso rhel-server-5.7-x86_64-dvd.isorhel-server-6.2-x86_64-dvd.isosftp> put Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.isoUploading Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso to /vmfs/volumes/529ca399-d0838ebe-bd5c-94de80e79249/Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso 100% 4028944KB 8777KB/s 00:07:39 put: failed to upload D:/03_software/01worksoft/linux_iso/Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso. Operation unsupported.sftp>sftp>五、通过编辑虚拟机设置,指定ISO路径,好像没有,在启动时仍然提示Operating System not found,需要在控制台重新指定,然后回车2013-12-05关键词:文件被锁定,无法访问、Unable to establish an SSL connection to TESTDB1:11111:ClientSocket(homename,port,timeout):connect()failed、Proposed updated config file does not have greate version number.、Error locking on node TESTDB2: Volume group for uuid not found、/boot: UNEXPECTED INCONSISTENCY一、TESTDB2新增了一块硬盘,使用已有的,指向TESTDB1的100GB硬盘,保存设置,启动TESTDB2时,提示如下正确的设置方法如下1、新增共享硬盘,命令如下cd /vmfs/volumes/datastore1/TESTDB-SHAREvmkfstools -c 102400m -a lsilogic -d eagerzeroedthick TESTDB_SHARE.vmdk2、将共享硬盘添加到2台虚拟机,按照文件《Esxi下虚拟机共享磁盘.pdf》添加3、修改TESTDB1.vmx和TESTDB2.vmx文件,追加以下内容sched.scsi1:0.shares="normal"disk.EnanbleUUID="true"disk.locking="false"diskLib.datacacheMaxSize="0"diskLib.datacacheMaxReadAheadSize="0"diskLib.datacacheMinReadAheadSize="0"diskLib.datacachePageSize="4096"diskLib.MaxUnsynceWrites="0"4、启动2台虚拟机,均可以正常启动二、节点与luci通信异常通过https://192.168.144.201:8084访问节点1,添加cluster时报错Unable to establish an SSL connection to TESTDB1:11111:ClientSocket(homename,port,timeout):connect()failed 原因分析This error occurs when the luci server cannot communicate with the ricci agent. Verify that ricci is installed and started on each node. Ensure that the firewall has been configured correctly, and that Security-Enhanced Linux (SELinux) is not the issue. Check /var/log/audit/audit.log for details on SELinux issues.安装了ricci后问题解决,前提是需要安装其他依赖包[root@TESTDB2 Server]# rpm -ivh oddjob*Preparing... ########################################### [100%]1:oddjob ########################################### [ 20%]2:oddjob-libs ########################################### [ 40%]3:oddjob-libs ########################################### [ 60%]4:oddjob-devel ########################################### [ 80%]5:oddjob-devel ########################################### [100%][root@TESTDB2 Server]#[root@TESTDB2 Server]#[root@TESTDB2 Server]# cd -/var/ftp/pub/Cluster[root@TESTDB2 Cluster]# rpm -ivh modcluster-0.12.1-7.el5.x86_64.rpmPreparing... ########################################### [100%]1:modcluster ########################################### [100%][root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]# rpm -ivh ricci-0.12.2-51.el5.x86_64.rpmPreparing... ########################################### [100%]1:ricci ########################################### [100%][root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]# service ricci statusricci is stopped[root@TESTDB2 Cluster]# service ricci startStarting oddjobd: [ OK ]generating SSL certificates... doneStarting ricci: [ OK ][root@TESTDB2 Cluster]#三、创建failover域时报错Proposed updated config file does not have greate version number.报错原因:之前通过system-config-cluster工具配置了cluster,并做了变更,导致cluster.conf文件中的version变成2,后来是把conf文件手工删除,通过luci的web界面进行配置的,导致报错,解决方法:手工将conf文件中的version由1改为2,在submi,正常结束四、在节点1,pvcreate,vgcreate正常,在lvcreate时报错[root@TESTDB1 23:20:29 by-id]# lvcreate -l +100%FREE -n lvdbdata vgdbdataError locking on node TESTDB2: Volume group for uuid not found: nbSOLD3XdROA1d08hvwvFOpNCFTywRyOnqSZpwxAQQ1N41PtxsjOLJ35Lye5NEGgFailed to activate new LV.原因待查五、重启服务器,在启动时TESTDB1报错:/boot: UNEXPECTED INCONSISTENCY用fsck /dev/sdb修复时报错后来改用fsck直接修复,按照提示输入y,一路回车,修复完毕,重启正常,但是shutdown后在startup时仍然报同样的错误,fsck修复后又能重启,再shutdown后在startup时还报错,删了/dev/sdb的其他分区,shutdown后在startup时正常,估计和分区有关系六、TESTDB2启动时有如下报错Scsi_reserve failed原因待查,未解决2013-12-06关键词:0x80070570、createrepo cannot access parent directories: No such file or directory安装windows报错,错误代码0x80070570、原因未知,换了一个iso文件,问题解决0x80070570使用windows2008自带的工具进行硬盘分区,均没有解决该报错问题,重新新建了一个虚拟机,换了一个英文版的iso文件,正常安装又换了一个中文版的介质,也能正常安装,有问题的介质是重新构筑DB服务器,从testap拷贝2个虚拟机一、建立分组文件[root@TEST-DB1 15:52:28 repodata]# createrepo -g /var/ftp/pub/Cluster/repodata/comps-rhel5-cluster.xml /var/ftp/pub/Clustershell-init: error retrieving current directory: getcwd: cannot access parent directories: No such file or directory Traceback (most recent call last):File "/usr/share/createrepo/genpkgmetadata.py", line 722, in ?main(sys.argv[1:])File "/usr/share/createrepo/genpkgmetadata.py", line 592, in maincmds, directories = parseArgs(args)File "/usr/share/createrepo/genpkgmetadata.py", line 431, in parseArgscmds['basedir'] = os.getcwd()OSError: [Errno 2] No such file or directory[root@TEST-DB1 15:53:47 repodata]#重新再执行一遍就没问题了二、rhcs组件安装完毕后,启动报错可以先无视,等创建完cluster后,报错消失,据说是少了cluster.conf文件三、需要先停止luci服务,执行luci_admin init,创建用户后,才能登陆https://192.168.144.201:8084/,luci只用在主节点配就可以了在luci界面create a cluster后,/etc/cluster下面会产生一个cluster.conf文件2013-12-09关键词:starting killall、在节点1上可以看到qdisk信息,在节点2上就看不到、WARNING: Falling back to local file-based lockingclurgmgrd: [6279]: <err> startFilesystem: Could not match /dev/mapper/vg_db-lv_db with a real device一、是系统关机时 hang在starting killall这里不动,只能强制关机原因:系统有一些服务器需要停止,解决办法,在脚本/etc/init.d/killall中添加红色字体三行,重新关机定位需要停止的服务[root@TEST-DB1 ~]# cat /etc/init.d/killall#! /bin/bash# Bring down all unneeded services that are still running (there shouldn't# be any, so this is just a sanity check)echo "Starting /etc/init.d/killall" > /var/log/killall.logcase "$1" in*start);;*)echo $"Usage: $0 {start}"exit 1;;esacfor i in /var/lock/subsys/* ; doecho "Found $i" >> /var/log/killall.log# Check if the script is there.[ -f "$i" ] || continue# Get the subsystem name.subsys=${i#/var/lock/subsys/}# Networking could be needed for NFS root.[ $subsys = network ] && continue# Bring the subsystem down.if [ -f /etc/init.d/$subsys.init ]; then/etc/init.d/$subsys.init stopelif [ -f /etc/init.d/$subsys ]; then/etc/init.d/$subsys stopelserm -f "$i"fidoneecho "Finished /etc/init.d/killall script" >> /var/log/killall.log在killall.log中记录了如下信息[root@TEST-DB1 log]# more killall.logStarting /etc/init.d/killallFound /var/lock/subsys/clvmd继续检查发现clvmd服务是开机启动,并且已经启动,由于此时还没有配置lvm,所以猜测是该原因导致,于是手工停止clvmd 服务,重新关机,可以正常关闭,问题解决[root@TEST-DB1 subsys]# /etc/init.d/clvmd statusclvmd (pid 2836) is running...Clustered Volume Groups: (none)Active clustered Logical Volumes: (none)二、之前添加qdisk,是从一块共享硬盘上分区出来的一块,在节点1上执行mkqdisk -c /dev/sdb1 -l myqdisk后,在节点1上可以看到qdisk信息,在节点2上就看不到解决办法:单独创建一块共享磁盘给2个节点作为qdisk使用节点1执行:mkqdisk -c /dev/sdc -l myqdisk节点1和2执行: mkqdisk -L三、创建共享文件系统Pvcreate时告警[root@TEST-DB1 16:30:29 ~]# pvcreate /dev/sdbconnect() failed on local socket: No such file or directoryInternal cluster locking initialisation failed.WARNING: Falling back to local file-based locking.Volume Groups with the clustered attribute will be inaccessible.Writing physical volume data to disk "/dev/sdb"Physical volume "/dev/sdb" successfully created[root@TEST-DB1 16:30:37 ~]#执行service clvmd start后,在重新创建,告警消失四、第一次创建gfs的资源,把device写成/dev/mapper/vg_db-lv_db,然后启动service时报错,Dec 9 17:51:17 TEST-DB1 kernel: dlm: connecting to 2Dec 9 17:51:17 TEST-DB1 kernel: dlm: got connection from 2Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Starting stopped service service:DB-ServiceDec 9 17:51:23 TEST-DB1 clurgmgrd: [6279]: <err> startFilesystem: Could not match /dev/mapper/vg_db-lv_db with a real deviceDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> start on fs "FS-DATA" returned 2 (invalid argument(s)) Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <warning> #68: Failed to start service:DB-Service; return value: 1 Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Stopping service service:DB-ServiceDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Service service:DB-Service is recoveringDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <warning> #71: Relocating failed service service:DB-ServiceDec 9 17:51:24 TEST-DB1 clurgmgrd[6279]: <notice> Service service:DB-Service is stopped解决办法:改成/dev/vg_db/lv_db,问题解决2013-12-10关键词:cluster资源组切换时共享文件系统不能自动umount、db2数据库状态Operable、一、clusvcadm -r DB-Service切换测试,资源组中的ip和nfs服务都能从一个节点切换到另一个节点,共享文件系统/dbdata从一个节点切到另一个节点后,原节点上不会自动umount,导致文档系统在2个节点上都mount原因分析:创建共享文件系统时只在节点1上执行了gfs_mkfs -p lock_dlm -t DB_Cluster:dbdata -j 2 /dev/vg_db/lv_db,在节点2上也执行了一些,但是问题没有解决补充一下,文件系统是GFS,在网上找的的资料《/uid-26931379-id-3558604.html》GFS是RHCS为集群系统提供的一个存储解决方案,它允许集群多个节点在块级别上共享存储,每个节点通过共享一个存储空间,保证了访问数据的一致性,更切实的说,GFS是RHCS提供的一个集群文件系统,多个节点同时挂载一个文件系统分区,而文件系统数据不受破坏,这是单一的文件系统,例如EXT3、EXT2所不能做到的。

使用Openfiler为VMware-ESXi设置一个免费的iSCSI或NAS储存

使用Openfiler为VMware ESXi设置一个免费的iSCSI或NAS储存系统VMware ESXi现在可以免费在这里下载/products/esxi/。

Openfiler NAS/iSCSI可以在这里免费下载/community/download/。

一切准备就绪,现在开始。

首先,我们使用Openfiler来设置一个iSCSI或NAS设备。

你可以从上面的连结来下载Openfiler,他的安装非常的简单。

以下是具体的步骤:OpenFiler的安装开始安装插入Openfiler盘到你的CD/DVD-ROM中并确认系统从CD/DVD-ROM启动。

Enter继续。

启动按Enter开始图形化安装模式安装现在出现在你面前的是初始安装画面。

按Next继续。

键盘设定选择适合你的键盘设定。

按Next继续。

磁盘分区我们需要在这里做手动设置。

选择’Manual partition with Disk Druid’。

在系统上建立3个分区来完成Openfiler的安装:‚/boot‛ - 系统及核心文件所在的启动分区‚swap‛ - 用于内存到磁盘的交换分区‚/‛ - 系统的主分区,所以的系统文件和库都将被安装到这里建立/boot分区单击’New’,在出现的对话框中输入分区挂接路径‛/boot‛及在所选的磁盘上建立该分区(确定该磁盘是你想要安装Openfiler的,不是要给ESX服务器使用的)建立boot分区所需填写的数据如下:1. Mount Point: /boot2. Filesystem Type: ext33. Allowable Drives: 就像之前说的,确定该硬盘是你想要安装Openfiler的。

4. Size(MB): 1005. Additional Size Options: 选择‘Fixed Size’6. Force to be a primary partition: 打勾(选择该选项把该分区建立为主分区)建立/(root)主分区单击’New’,在出现的对话框中输入分区挂接路径‘/’ 和大小:必须2048MB或最小1024MB.建立swap分区单击’New’,在出现的对话框中输入分区挂接路径’swap’。

Vmware ESXi共享存储配置

Vmware ESXi共享存储配置在小型VMware环境当中,错误配置共享存储的情况并不少见。

花费一些时间来纠正这些错误可以在ESXi主机超过负载或者宕机时避免很多问题。

一个成功的vSphere部署需要包含三个基本部分:多个相同的ESXi服务器、共享存储和vCenter。

任何具有多个ESXi服务器的数据中心都应该使用共享存储,并且对于所有服务器集群都保证一直可用。

对于一些vSphere核心技术来说,比如vMotion、分布式资源调度(DRS)和高可用性(HA),共享存储是一个前提条件。

vMotion可以在不产生宕机时间的情况下,将一个运行中的虚拟机从一台ESXi主机迁移到另一台上。

DRS利用vMotion技术将虚拟机移动到其他的ESXi主机上,以避免产生CPU和内存不足的情况。

如果一台ESXi服务器发生故障,vSphere HA会在集群中的其他ESXi 主机上重启正在运行的虚拟机。

DRS和HA只能用于存放在共享存储上的虚拟机;不论是HA还是DRS迁移,虚拟机在存储上的位置都不会发生改变。

为了最大限度地发挥HA和DRS的作用,虚拟机使用的所有存储都必须对集群中的每一台ESXi服务器保证可用。

连续的共享存储使用的配置取决于存储网络类型:光纤通道(FC)、iSCSI还是网络文件系统(NFS)。

对于FC和iSCSI 存储,需要确保存储阵列对于每个ESXi主机都使用相同的逻辑单元号(LUN)。

一些阵列通过使用分组可以轻松实现这个需求,但是其他阵列就需要你为每个主机都单独进行配置。

对于FC,你需要将FC交换机配置在一致的分区当中,以使得所有的主机都能够找到阵列。

如果使用的是iSCSI,那么ESXi主机需要使用同样的发现设定、同样的动态发现IP地址列表。

如果使用的是NFS,那么大部分的设定都可以在ESXi服务器上完成。

确保在每个ESXi主机上都使用相同的NFS服务器主机名和共享路径。

如果一个ESXi主机使用NFS服务器的IP地址,另外一个使用主机名,而第三台ESXi主机使用全限定名,那么vCenter将认为它们使用的是不同的数据存储。

VMwareESXi配置

TT 服务器技术专题之“主标题”

Page 11 of 72

随便在后面加个 1 辨认,这里有一个 BUG,输入完 IP 和 netmask 掩码之后,关闭设置 会出现错误。如图:

TT 服务器技术专题之“主标题”

Page 12 of 72

提示,比如我的 netmask 是 23 位 255.255.254.0,IP 是 192.168.1.11,但是网关设 置 192.168.0.254,它会报不属于同个网段的错误。不管他继续前进。添加好网卡之后回 到 configuration 界面的 networking,点击 properties 便可以继续设置网关。

Windows Server 2008 R2

TT 服务器技术专题之“主标题”

Page 4 of 72

Hyper-V Server 2008 和 ESXi 都是一种虚拟的主系统,并不是我们日常用的 VMware Workstation 或者 VPC。EXSi 和 Hyper-V 都是一个完整的系统,可以打个比方,VMware Workstation 等虚拟机只是操作系统的一个软件,提供的功能都是基于主系统(Linux 或 Windows),性能也是受到所在操作系统的影响。而 EXSi 和 Hyper-V 则是一个完整的宿主 系统,EXSi 是基于 Linux 修改而成,Hyper-V 是基于 Windows 修改而成。这两个系统只是 个宿主系统,无任何额外功能,都需要另一个管理系统来管理这两个宿主系统(这也是免 费产品的缺陷所在)。

我试验了一下,Hyper-V 很麻烦,它没有一个免费的像 VMware Infrastructure2.5 这 样的客户端工具来管理宿主系统。我在微软主页上找了几个小时,暂时只知道可以用 SCVMM2008 和 windows2008 X86-64 版自带的 Hyper-V 来远程管理(VISTA X86-64 版也可 以),SCVMM2008 提供了 180 天的测试期,我本来想只需用到远程虚拟机管理工具 VMM ADMINISTRATOR CONSOLE 来管理已经安装好 Hyper-V,但是它还需要加入域。

vm虚拟机创建共享磁盘

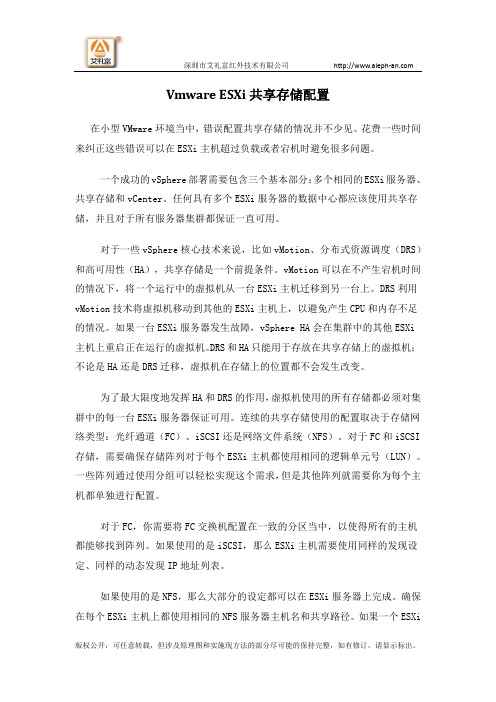

1. 创建共享磁盘柜在虚拟机软件的安装目录下,有个vmware-vdiskmanager.exe文件(老版本用plainmaker.exe),把它复制到共享磁盘柜目录下,创建共享磁盘(老版本共享磁盘文件的扩展名为.pln)F:\虚拟机\共享磁盘柜>vmware-vdiskmanager.exe -c -s 200Mb -a lsilogic -t 2 quorum.vmdkF:\虚拟机\共享磁盘柜>vmware-vdiskmanager.exe -c -s 4Gb -a lsilogic -t 0 sharedisk.vmdk-t 2的意思是预分配磁盘空间,可以用-t 0选项,这样就不会占用空间了,实际用多少就多少创建完毕后,目录下有四个新文件quorum-flat.vmdkquorum.vmdksharedisk-flat.vmdksharedisk.vmdk2. 配置虚拟机在虚拟机器界面选择“Edit virtual machine settings”à添加硬盘,选“Use a existing virtual disk”,分别添加quorum.vmdk、sharedisk.vmdk双击新加的磁盘,在弹出的磁盘属性窗选“advance”,为新加的硬盘选择虚拟设备节点:quorum.vmdk选订“SCSI 0:1”,sharedisk.vmdk选定“SCSI 1:1”。

如图所示:分别打开两台虚拟机目录中的vmx文件,在最后一行添加:disk.locking="FALSE"scsi0:1.SharedBus="Virtual"scsi1:1.SharedBus="Virtual"3. 配置Solaris10操作系统启动两台虚拟机(主机名分别为clustera,clusterb)a. 在clustera运行以下命令:clustera# devfsadmclustera# formatSearching for disks...doneAVAILABLE DISK SELECTIONS:0. c1t0d0 <DEFAULT cyl 4092 alt 2 hd 128 sec 32>/pci@0,0/pci1000,30@10/sd@0,01. c1t1d0 <DEFAULT cyl 196 alt 2 hd 64 sec 32>/pci@0,0/pci1000,30@10/sd@1,02. c2t1d0 <DEFAULT cyl 2044 alt 2 hd 128 sec 32>/pci@0,0/pci15ad,790@11/pci1000,30@2/sd@1,0对disk 1和disk 2分别执行fdisk操作,创建100% solaris分区。

VMwareWorkStation配置共享磁盘

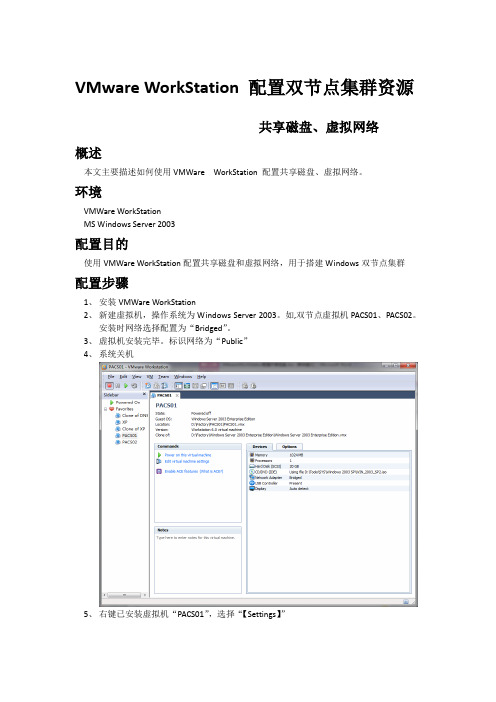

VMware WorkStation 配置双节点集群资源共享磁盘、虚拟网络概述本文主要描述如何使用VMWare WorkStation 配置共享磁盘、虚拟网络。

环境VMWare WorkStationMS Windows Server 2003配置目的使用VMWare WorkStation配置共享磁盘和虚拟网络,用于搭建Windows双节点集群配置步骤1、安装VMWare WorkStation2、新建虚拟机,操作系统为Windows Server 2003。

如,双节点虚拟机PACS01、PACS02。

安装时网络选择配置为“Bridged”。

3、虚拟机安装完毕。

标识网络为“Public”4、系统关机5、右键已安装虚拟机“PACS01”,选择“【Settings】”6、系统弹出虚拟机资源配置界面。

此界面可配置虚拟机内存。

单击【Add】7、弹出资源添加向导一、添加虚拟网卡1、单击选择“NetWork Adapter”,单击【Next】2、如下图所示操作。

选择网络模式为“Custom”。

单击【Finish】。

3、单击【OK】,完成创建。

此时启动PACS01,打开网络连接即可看到新建网卡,标识为“Private”。

二、添加虚拟磁盘1、单击选择“Hard Disk”,单击【Next】2、选择“Create a new Virtual disk”,单击【Next】3、默认磁盘类型为“SCSI”,单击【Next】4、输入磁盘大小,选择存储方式,单击【Next】5、输入虚拟磁盘文件存储位置和文件名(共享图像存储),单击【Finish】6、单击选择所新建的虚拟磁盘,单击【Advanced】7、选择虚拟磁盘节点为“SCSI 1:0”,单击【ok】8、重复1-7,创建虚拟磁盘“SCSI 1:1”DBSQL.vmdk(存放SQL数据文件) 20GB;“SCSI 1:2”Quorum.vmdk(群集仲裁盘) 1GB9、启动群集节点PACS02三、配置群集节点PACS021、右键虚拟机“PACS02”,选择“【Settings】”2、单击【Add】3、单击选择“Hard Disk”,单击【Next】4、选择“Use an existing virtual disk”,单击【Next】5、单击【Browe】,选择新建虚拟存储,单击【Finish】6、单击选择所新建的虚拟磁盘,单击【Advanced】7、选择虚拟磁盘节点为“SCSI 1:0”,单击【ok】8、重复1-7,创建虚拟磁盘“SCSI 1:1”DBSQL.vmdk(存放SQL数据文件) 20GB;“SCSI 1:2”Quorum.vmdk(群集仲裁盘) 1GB9、关闭VMWare WorkStation10、打开虚拟机PACS01配置文件所在存储11、单击选择PACS01.vmx,单击右键,选择打开方式为“记事本”,在文档最后添加一行“disk.locking= "FALSE"”保存并退出。

VMware vSphere 5.1 高可用性 ---- 群集、HA、DRS、FT

VMware vSphere 5.1 高可用性在本节中主要讲的是集群的一些功能和配置,相比5.0的设置,没有太大的变化。

VMware vSphere为虚拟机提供虚拟化的基础架构,将现有的物理资源转化成虚拟资源,将物理资源分成若干资源,为每个虚拟机提供包括CPU、内存等虚拟资源。

要想很好地分配这些资源,就必须要使用资源池。

资源池是灵活管理资源的逻辑抽象。

资源池可以分组为层次结构,用于对可用的CPU 和内存资源按层次结构进行分区。

群集中的资源池比单个ESXi主机上的还要重要,因为在群集中创建资源之后,整个资源池管理的就是所有的ESXi主机资源了。

所管理的资源是所有ESXi主机上的CPU和内存的资源总和。

高可用性和双机热备是VMware vSphere 5.1最重要的一部分,高可用并不是vSphere独有的,企业使用高可用就是为了服务的连续性和数据的安全性,HA是以一群ESXi服务器为主的群集功能,主要是目的是当虚拟机运行的主机发生故障时能及时转移主机,避免长时间的停机。

而FT双机热备则是保证虚拟机最长时间不停机,将虚拟机以双机热备的方式同时在两台主机运行,大大增强了业务的可连续性。

本节中主要讲的是讲的一下内容:一、建立群集二、设置HA高可用性三、测试HA高可用性四、设置DRS五、建立FT双机热备无论是计划停机时间还是非计划停机时间,都会带来相当大的成本。

但是,用于确保更高级别可用性的传统解决方案都需要较大开销,并且难以实施和管理。

VMware 软件可为重要应用程序提供更高级别的可用性,并且操作更简单,成本更低。

使用vSphere,组织可以轻松提高为所有应用程序提供的基准级别,并且以更低成本和更简单的操作来实现更高级别的可用性。

使用vSphere,可以独立于硬件、操作系统和应用程序提供更高可用性,减少常见维护操作的计划停机时间,在出现故障时提供自动恢复。

vSphere 可以减少计划的停机时间,防止出现非计划停机,并迅速从断电中恢复。

为虚拟机创建共享磁盘

配置时候需要用到共这可根据实际情况选虚拟机配置,规范文件,话框中设置计算机名称,■ 河北 王春海 赵艳磁盘。

创建共享磁盘具体配置下面介绍关键的配置步骤,本文以vSphere 6.5为图1 从模板部署虚拟机图2 设置计算机名称中做故障转移群集不需要仲“厚的虚拟默认情况下,列器”,用在下拉列表中SCSI使:“确定”虚控享”下拉列表中选择“虚拟”。

13.修改WS16R2-A2虚拟机的设置,添加硬盘选择“现有硬盘”,在“选择文件”对话框浏览选择WS16R2-A1虚拟机目录中的WS16R2-A1_1.vmdk虚拟硬盘文件,这是在WS16R2-A1虚拟机添加的大小为1GB的虚拟硬盘。

14.返回WS16R2-A2虚拟机设置对话框,添加了大小为1GB的现有硬盘文件,在“虚拟设备节点”选择“新SCSI控制器”“SCSI(1:0)”,为WS16R2-A2虚拟机添加现有硬盘,选择WS16R2-A1目录中的WS16R2-A1_2.vmdk文件。

15.返回WS16R2-A2虚拟机设置对话框,添加了大小为500GB的现有硬盘文件,在“虚拟设备节点”选择“新控制器”“SCSI(1:“SCSI控制器总线共享”控制器1”线共享”为“确定”按使用共享磁盘配置故障转移集群WS16R2-A2之后,实验。

本文以集为例”的盘管理”的磁盘个磁盘联机、使用地址,虚的拟IPC:\windows\图3 新添加的磁盘■ 河南 郭建伟让RemoteAPP动关联本地文件为了图1 配置分发程序包参数包复制到客户端,在客户端以域管理员身份安装该包。

这样,在客户端双击与之关联的程序,就可以打开该远5.在“验证警告”对话框单击“是”按钮,在“测试选项”对话框单击“运行所有测试”。

6.在“用于管理群集的访问点”对话框输入群集名称并设置群集的访问地址,在本示例中设置群集访问地址为172.18.96.57。

在“摘。

Vmware ESXi共享存储配置

Vmware ESXi共享存储配置在小型VMware环境当中,错误配置共享存储的情况并不少见。

花费一些时间来纠正这些错误可以在ESXi主机超过负载或者宕机时避免很多问题。

一个成功的vSphere部署需要包含三个基本部分:多个相同的ESXi服务器、共享存储和vCenter。

任何具有多个ESXi服务器的数据中心都应该使用共享存储,并且对于所有服务器集群都保证一直可用。

对于一些vSphere核心技术来说,比如vMotion、分布式资源调度(DRS)和高可用性(HA),共享存储是一个前提条件。

vMotion可以在不产生宕机时间的情况下,将一个运行中的虚拟机从一台ESXi主机迁移到另一台上。

DRS利用vMotion技术将虚拟机移动到其他的ESXi主机上,以避免产生CPU和内存不足的情况。

如果一台ESXi服务器发生故障,vSphere HA会在集群中的其他ESXi 主机上重启正在运行的虚拟机。

DRS和HA只能用于存放在共享存储上的虚拟机;不论是HA还是DRS迁移,虚拟机在存储上的位置都不会发生改变。

为了最大限度地发挥HA和DRS的作用,虚拟机使用的所有存储都必须对集群中的每一台ESXi服务器保证可用。

连续的共享存储使用的配置取决于存储网络类型:光纤通道(FC)、iSCSI还是网络文件系统(NFS)。

对于FC和iSCSI 存储,需要确保存储阵列对于每个ESXi主机都使用相同的逻辑单元号(LUN)。

一些阵列通过使用分组可以轻松实现这个需求,但是其他阵列就需要你为每个主机都单独进行配置。

对于FC,你需要将FC交换机配置在一致的分区当中,以使得所有的主机都能够找到阵列。

如果使用的是iSCSI,那么ESXi主机需要使用同样的发现设定、同样的动态发现IP地址列表。

如果使用的是NFS,那么大部分的设定都可以在ESXi服务器上完成。

确保在每个ESXi主机上都使用相同的NFS服务器主机名和共享路径。

如果一个ESXi主机使用NFS服务器的IP地址,另外一个使用主机名,而第三台ESXi主机使用全限定名,那么vCenter将认为它们使用的是不同的数据存储。

ESXI安装、硬盘扩容、U盘挂载

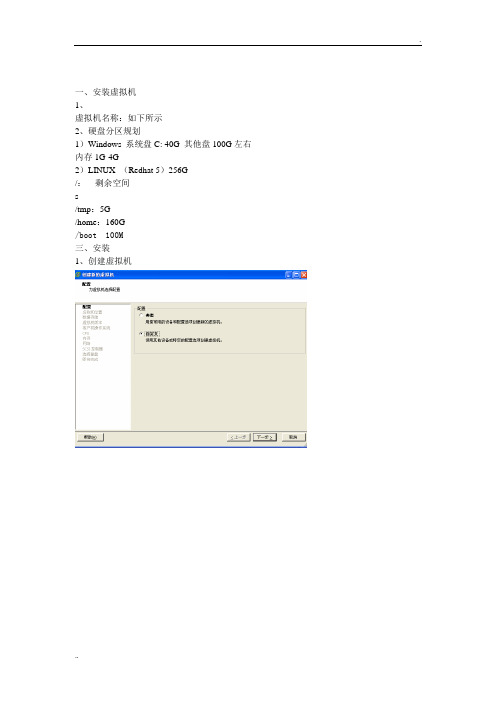

一、安装虚拟机1、虚拟机名称:如下所示2、硬盘分区规划1)Windows 系统盘C: 40G 其他盘100G左右内存1G-4G2)LINUX (Redhat 5)256G/:剩余空间s/tmp:5G/home:160G/boot 100M三、安装1、创建虚拟机2、安装windows操作系统挂在ISO镜像执行安装对系统资源进行划分,使用NTFS格式化后进行安装安装设备启动操作系统安装R2补丁配置IP地址、DNS后,查看远程连接是否已经打开,点击OK。

则配置完成。

Linux安装类似,不过需要设置分区,如上所示即可。

安装VMware tools在ESX4.1 的平台上安装Redhat5企业版,无论指定IP或者DHCP获得IP都不能ping通安装操作请看此人博客安装后现象为:可以ping通机器本身地址,但是无法ping通内网地址和网关。

解决方案如下:1、检查配置信息#ifconfig修改对应网卡的网关的配置文件# vi /etc/sysconfig/network-scripts/ifcfg-eth0检查hosts配置#vi /etc/hosts开机不启动防火强#Chkconfig iptables off重启网络服务#/etc/init.d/network restart(Stop Start)2、重装操作系统通过模板复制、单独安装,多次尝试后发现故障依然。

3、reboot系统最后尝试发现,在系统reboot后,ping本机地址(安装操作系统的时候配置好系统IP)的过程中发现,IP地址有一段时间是可以ping通的。

但是当xend服务启动后,则网络不通。

如下图所示:4、关闭xend服务修改启动设置,指定xen使用的console的方法如下:a)确定系统版本,以便找到需要修改的启动项:# uname -rLinux gic- 2.6.18-8.el5xen从上面的输出,我们可以看出,现在系统版本是2.6.18-8。

使用一台测试2台ESXi6.5部署vSAN集群

测试2台ESXi部署vSAN实验一、实验环境和介质1.1: 实验环境这里我是使用一台Dell R730物理机来做这次的测试,R730安装ESXi 6.5,然后在这上面虚拟2台ESXi6.5服务器,和一台vCenter 6.5管理服务器,来模拟2台ESXi 配置vSAN。

因为6.0 U1 U2版本可能vSAN功能还有些问题,我这里就直接用6.5的版本了。

Dell R730配置如下:1.2:vSAN原理和用途因为vSAN必须使用3台ESXi主机,那么我们2台ESXi 主机怎么配置vSAN呢?这个你就必须了解vSAN的原理和通途。

vSAN全名叫vSphere Virtual Storage Area Network,vSphere虚拟化局域网存储。

是vSphere 5.5后才开始出来的新功能,而且只能通过Web Client来部署。

是基于服务器端存储的共享分布式对象存储系统,可以用来取代vSphere 后端的外置磁盘阵列。

vSAN就是一种分布式存储,其数据保护技术不是采用传统的RAID方式,而是叫分布式RAID。

VSAN在主机之间使用RAID 来满足对系统中存储对象的可用性和可靠性的要求,虚拟机存储对象的镜像拷贝数量取决于虚拟机存储策略。

数据的副本都是存储在主机上的,当某台主机失效或宕机,就会出现类似脑裂问题,vSphere为了解决这个问题,引入了一个重要的组件—见证(winess),类似于我们常说的仲裁盘。

由于见证只是一个逻辑组件,不保存数据,占用空间非常小,我们也就可以实现2台ESXi 主机的vSAN集群。

这个见证是一个模板,可以从官网直接下,免费的,安装这个模板,最好从vCenter web client添加,就可以省去2个CPU的许可,用client部署这个模板是看不到见证自带的许可的。

1.4:虚拟机规划1.5:需要准备的介质vCenter6.5:VMware-VIM-all-6.5.0-4602587.isoESXi6.5:VMware-VMvisor-Installer-201701001-4887370.x86_64.iso Winess6.5:VMware-VirtualSAN-Witness-6.5.0-4564106.ova二、配置主机,安装虚拟机,安装vCenter2.1:配置主机因为要开启vSAN功能,虚拟机必须配置2块网卡,1块单独来处理vSAN流量,所以在安装ESXi的主机上最好配置2个交换机,1个交换机放正常的虚拟机的管理,另一个当2台ESXi 虚拟机的vSAN网卡的交换机。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

跨ESXi主机的裸磁盘映射(RDM)搭建MSCS群集

2011-11-30 23:26:11

标签:ESXiRDM裸磁盘映射MSCS跨主机

原创作品,允许转载,转载时请务必以超链接形式标明文章原始出处、作者信息和本声明。

否则将追究法律责任。

/1028350/730262

跨物理主机的虚拟机的群集(也称为跨机箱的群集)通过在单独 ESXi 主机上放置群集节点来防止在物理机上发生软件和硬件故障。

此配置需要使用光纤通道 SAN 上的共享存储器作为仲裁磁盘。

下图显示了跨机箱的群集的设置。

两个不同物理机(ESXi 主机)上的两个虚拟机运行群集软件。

虚拟机共享专用网络连接(用于专用检测信号)和公用网络连接。

每个虚拟机均连接到共享存储器,此存储器必须位于 SAN 上。

此设置可以显著降低硬件成本

可以扩展跨机箱的群集模型,并在多个物理机上放置多个虚拟机。

例如,可以将四个各包含两个物理机的群集与两个各具有四个虚拟机的物理机相整合。

下图显示如何将四个双节点群集从八个物理机移动到两个物理机。

言归正传,下面开始我们的测试

两个节点分别在两台不同的ESXi上,使用iSCSI存储,两台ESXi都能访问到。

Node01所在ESXi的网络配置如图:

Node02所在ESXi的网络配置如图:

Node01两块网卡配置和IP如图:

Node02的两块网卡的配置和IP,如图:

在Node01上添加硬盘,选择“裸机映射”

选择存放指针文件的存储位置(一定要共享的)

选择“物理”兼容性

节点不能使用SCSI0 ,必须使用SCSI 1 ,这里选择SCSI (1:0)

两块盘添加后,注意选择SCSI 1适配器,更改SCSI总线共享类型为“物理”

随后在Node02上添加硬盘,选择“使用现有虚拟磁盘”( 关闭虚拟机上面物理才可选 )))))))

找到Node01做RDM时生成的指针文件的路径

节点同样要使用SCSI 1

同样的方式添加两块硬盘后,记住要该SCSI 1控制器的总线共享为“物理”

随后在Node01上初始化两块盘并分配盘符,然后将硬盘“脱机”

启动Node02,发现自动挂上了那两块盘。

随后在Node01,Node02上安装故障转移群集功能。

然后验证群集测试:

测试成功!。