ABSTRACT A Tutorial on Logistic Regression

逻辑斯蒂回归在分类问题中的应用

逻辑斯蒂回归在分类问题中的应用逻辑斯蒂回归(Logistic Regression)是一种常用的分类算法,尤其在二分类问题中得到广泛应用。

逻辑斯蒂回归通过将线性回归模型的输出映射到一个概率范围内,从而实现对样本进行分类。

本文将介绍逻辑斯蒂回归的原理、优缺点以及在分类问题中的具体应用。

### 一、逻辑斯蒂回归原理逻辑斯蒂回归是一种广义线性回归模型,其模型形式为:$$P(y=1|x) = \frac{1}{1+e^{-(w^Tx+b)}}$$其中,$P(y=1|x)$表示在给定输入$x$的情况下,输出为类别1的概率;$w$和$b$分别为模型的参数,$w$为权重向量,$b$为偏置项;$e$为自然对数的底。

逻辑斯蒂回归通过对线性回归模型的输出进行Sigmoid函数的映射,将输出限制在0到1之间,表示样本属于某一类别的概率。

### 二、逻辑斯蒂回归优缺点1. 优点:- 实现简单,计算代价低;- 输出结果具有概率意义,便于理解和解释;- 可以处理非线性关系。

2. 缺点:- 容易受到异常值的影响;- 对特征工程要求较高;- 无法很好地处理多分类问题。

### 三、逻辑斯蒂回归在分类问题中的应用逻辑斯蒂回归在分类问题中有着广泛的应用,以下是一些常见的应用场景:1. 金融风控在金融领域,逻辑斯蒂回归常用于信用评分和风险控制。

通过构建逻辑斯蒂回归模型,可以根据客户的个人信息、财务状况等特征,预测其违约概率,从而制定相应的风险控制策略。

2. 医疗诊断在医疗领域,逻辑斯蒂回归可用于疾病诊断和预测。

通过医疗数据的特征提取和逻辑斯蒂回归模型的构建,可以帮助医生判断患者是否患有某种疾病,提前进行治疗和干预。

3. 市场营销在市场营销中,逻辑斯蒂回归可用于客户分类和营销策略制定。

通过分析客户的购买行为和偏好,构建逻辑斯蒂回归模型,可以预测客户的购买意向,从而制定个性化的营销方案。

4. 文本分类在自然语言处理领域,逻辑斯蒂回归可用于文本分类任务。

多层次logistic回归模型

多层次logistic回归模型英文回答:Logistic regression is a popular statistical model used for binary classification tasks. It is a type of generalized linear model that uses a logistic function to model the probability of a certain event occurring. The model is trained using a dataset with labeled examples, where each example consists of a set of input features and a corresponding binary label.The logistic regression model consists of multiple layers, each containing a set of weights and biases. These weights and biases are learned during the training process, where the model adjusts them to minimize the difference between the predicted probabilities and the true labels. The layers can be thought of as a hierarchy of features, where each layer learns to represent more complex and abstract features based on the input features from the previous layer.In the context of deep learning, logistic regression can be extended to have multiple hidden layers, resulting in a multi-layer logistic regression model. Each hidden layer introduces additional non-linear transformations to the input features, allowing the model to learn more complex representations. This makes the model more powerful and capable of capturing intricate patterns in the data.To train a multi-layer logistic regression model, we typically use a technique called backpropagation. This involves computing the gradient of the loss function with respect to the model parameters and updating the parameters using gradient descent. The backpropagation algorithm efficiently calculates these gradients by propagating the errors from the output layer back to the input layer.Multi-layer logistic regression models have been successfully applied to various domains, such as image classification, natural language processing, and speech recognition. For example, in image classification, a multi-layer logistic regression model can learn to recognizedifferent objects in images by extracting hierarchical features from the pixel values.中文回答:多层次logistic回归模型是一种常用的用于二分类任务的统计模型。

二元逻辑回归和有序逻辑回归r语言

一、概述逻辑回归是统计学中一种常用的回归分析方法,它主要用于解决二分变量的分类问题。

在实际的数据分析中,我们经常会遇到分类不仅仅是二元的情况,而是有多个有序的分类,这时有序逻辑回归就成为了一种重要的工具。

而R语言作为一种非常流行的统计计算和数据分析工具,自然而然地成为了实现逻辑回归的首选语言之一。

本文将从二元逻辑回归和有序逻辑回归两个方面,结合R语言进行详细介绍和案例分析。

二、二元逻辑回归1. 逻辑回归简介逻辑回归是一种广义线性回归模型,适用于因变量为二元变量的情况。

逻辑回归的主要思想是将线性回归的结果通过一个非线性函数映射到[0,1]区间,从而得到一个概率值,进而判断样本属于哪一类。

在R语言中,可以使用glm函数进行逻辑回归模型的拟合。

2. 二元逻辑回归的实现在R语言中,利用glm函数可以轻松实现二元逻辑回归。

首先需要准备好数据,然后使用glm函数拟合出模型,并通过summary函数查看模型的拟合结果和显著性检验。

R语言还提供了一系列的函数和包,如caret包和pROC包,可以用于模型的评估和预测。

3. 二元逻辑回归的案例分析以某医院病人的生存情况数据为例,我们可以用二元逻辑回归来探究各个属性对患者生存率的影响。

通过建立适当的模型,我们可以对不同因素的影响进行分析,并做出预测。

在R语言环境下,我们可以方便地进行数据清洗、变量选择、模型拟合和结果评估。

三、有序逻辑回归1. 有序逻辑回归简介有序逻辑回归是逻辑回归的一种推广形式,适用于因变量为有序多元变量的情况。

有序逻辑回归在分析有序分类变量时非常有用,它能够提供比普通分类更多的信息。

在R语言中,使用ordinal包可以很方便地实现有序逻辑回归。

2. 有序逻辑回归的实现在R语言中,使用ordinal包可以轻松实现有序逻辑回归。

首先需要对数据进行预处理,然后使用clm函数拟合出模型,通过summary 函数查看模型的拟合结果和显著性检验。

R语言还提供了一些可视化和评估的工具,如woe和pROC包,可以对模型进行更深入的分析和评估。

logistic regression原理(一)

logistic regression原理(一)Logistic Regression原理1. 介绍•Logistic Regression(逻辑回归)是一种用于处理分类问题的机器学习算法。

•它可以用于二分类问题,也可以通过扩展用于多分类问题。

2. 基本概念•Logistic Regression的基本原理是通过拟合一个逻辑函数来预测分类概率。

•逻辑函数是一个S形曲线,将输入映射到0到1之间的值。

3. Sigmoid函数•逻辑函数通常使用Sigmoid函数来表示,公式如下:[Sigmoid Function](其中,z是线性方程的输出。

4. 线性方程•Logistic Regression使用一个线性方程加权求和输入特征来预测分类概率。

•线性方程的表示为:[Linear Equation](其中,x是输入特征,β是线性方程的权重。

5. 模型训练•训练Logistic Regression模型的目标是找到最佳的权重值,使得模型的预测结果与实际情况最为接近。

•常用的方法是最大似然估计,根据已有的训练数据,最大化模型预测正确性的概率。

6. 损失函数•损失函数用于衡量模型预测结果与实际情况之间的差异。

•在Logistic Regression中,常用的损失函数是对数损失函数(Log Loss)。

7. 模型预测•模型训练完成后,可以使用它来进行分类预测。

•根据输入特征,通过线性方程和Sigmoid函数,得到分类的概率值。

•一般而言,当概率大于时,预测为正类;当概率小于等于时,预测为负类。

8. 优点和局限性•优点:–算法简单,易于理解和实现;–训练速度快;–可以处理大规模数据;–可以输出分类概率值。

•局限性:–对特征之间的相关性敏感;–很难处理非线性关系。

9. 应用领域•Logistic Regression在许多领域都有广泛应用,例如:–金融行业中的风险评估和信用评分;–医疗领域中的疾病诊断;–电子商务中的用户购买行为预测。

多元Logistic回归分析

多元Logistic 回归分析

Multiple Logistic Regression Analysis

1

主要内容

➢ Logistic 回归分析的基本概念 ➢ Logistic 回归分析的数学模型 ➢ Logistic 回归模型的建立和检验 ➢ Logistic 回归系数的解释 ➢ 配对病例-对照数据的logistic回归分析

• 二分类变量: o 生存与死亡 o 有病与无病 o 有效与无效 o 感染与未感染

• 多分类有序变量: o 疾病程度(轻度、中度、重度) o 治愈效果(治愈、显效、好转、无效)

• 多分类无序变量: o 手术方法(A、B、C) o 就诊医院(甲、乙、丙、丁)

4

医学研究者经常关心的问题

• 哪些因素导致了人群中有的人患胃癌而有的人不患胃癌? • 哪些因素导致了手术后有的人感染,而有的人不感染? • 哪些因素导致了某种治疗方法出现治愈、显效、好转、无

>

0 (≤

7

4163

46

25239

53

242

14

data eg7_1a; input y x wt @@; cards;

11 7 1 0 13 0 1 46 0 0 229 ; run; proc logistic descending ;

model y=x ; weight wt; run;

SAS程序

18

第四节 Logistic回归模型系数的解释

回忆流行病学研究中两个重要概念:

在logistic回归模型

令x=0和x=1,得到

19

a) 一元logistic回归模型系数β的意义解释: (1) x =1,0 变量

如果x=1,0,则 e b=OR 近似表示在x=1条件下的发病率与 在x=0 条件下发病率之比 (相对危险度),或者说, x=1条 件下的发病可能性比x=1条件下多或少(OR-1)*100%。

multinominal logistic 解读

multinominal logistic 解读多项式逻辑斯蒂回归(Multinomial Logistic Regression)是一种常用的分类算法,广泛应用于机器学习和统计分析中。

它是逻辑斯蒂回归在多分类问题中的扩展,能够预测多个离散的类别。

在多项式逻辑斯蒂回归中,目标变量可以有两个或多个离散的类别。

与二元逻辑斯蒂回归不同的是,多项式逻辑斯蒂回归使用了多个二元逻辑斯蒂回归模型来进行分类。

模型的输出是每个类别的概率。

具体地说,对于每个类别,模型计算一个线性函数的概率,然后对这些概率进行归一化,以确保它们的总和为1。

最终,模型将观测值分配给具有最高概率的类别。

多项式逻辑斯蒂回归可以使用最大似然估计方法来估计模型参数。

估计的参数可以用于预测新的观测值的类别。

在实际应用中,多项式逻辑斯蒂回归常用于文本分类、医疗诊断、人脸识别等领域。

例如,在文本分类任务中,可以使用多项式逻辑斯蒂回归将不同的文档分配到预定义的类别中。

在医疗诊断中,可以使用多项式逻辑斯蒂回归来预测一位患者属于哪个疾病类型。

在人脸识别任务中,多项式逻辑斯蒂回归可用于将人脸图像识别为不同的人物。

尽管多项式逻辑斯蒂回归在许多领域中表现出色,但它也有一些限制。

首先,它要求观测值之间是独立的。

其次,它假设观测值的分布是多项式的。

这意味着它对于连续变量的建模能力有限。

此外,多项式逻辑斯蒂回归也可能受到过度拟合的问题。

为了提高模型的性能,可以使用一些技术和方法。

例如,特征选择可以帮助排除一些不相关的特征,以减少模型的复杂度。

此外,交叉验证可以用于评估模型的性能和避免过拟合。

另外,通过增加训练样本量和调整模型的正则化参数,也可以提高模型的鲁棒性。

总结来说,多项式逻辑斯蒂回归是一种常用的多分类算法,在机器学习和统计分析中有着广泛的应用。

它适用于文本分类、医疗诊断、人脸识别等领域。

尽管存在一些局限性,但通过使用合适的技术和方法,可以提高模型的性能和稳定性。

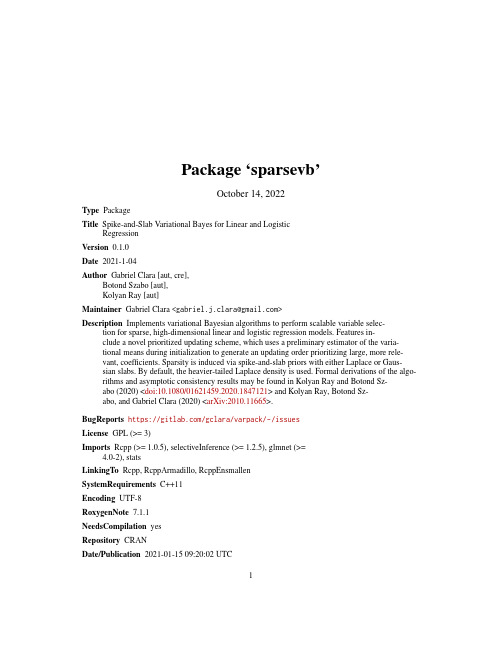

SparseVB:变分贝叶斯算法为线性和逻辑回归的稀疏高维回归模型的稀疏变量选择说明书

Package‘sparsevb’October14,2022Type PackageTitle Spike-and-Slab Variational Bayes for Linear and LogisticRegressionVersion0.1.0Date2021-1-04Author Gabriel Clara[aut,cre],Botond Szabo[aut],Kolyan Ray[aut]Maintainer Gabriel Clara<*************************>Description Implements variational Bayesian algorithms to perform scalable variable selec-tion for sparse,high-dimensional linear and logistic regression models.Features in-clude a novel prioritized updating scheme,which uses a preliminary estimator of the varia-tional means during initialization to generate an updating order prioritizing large,more rele-vant,coefficients.Sparsity is induced via spike-and-slab priors with either Laplace or Gaus-sian slabs.By default,the heavier-tailed Laplace density is used.Formal derivations of the algo-rithms and asymptotic consistency results may be found in Kolyan Ray and Botond Sz-abo(2020)<doi:10.1080/01621459.2020.1847121>and Kolyan Ray,Botond Sz-abo,and Gabriel Clara(2020)<arXiv:2010.11665>.BugReports https:///gclara/varpack/-/issuesLicense GPL(>=3)Imports Rcpp(>=1.0.5),selectiveInference(>=1.2.5),glmnet(>=4.0-2),statsLinkingTo Rcpp,RcppArmadillo,RcppEnsmallenSystemRequirements C++11Encoding UTF-8RoxygenNote7.1.1NeedsCompilation yesRepository CRANDate/Publication2021-01-1509:20:02UTC12sparsevb-package R topics documented:sparsevb-package (2)svb.fit (3)Index6 sparsevb-package sparsevb:Spike-and-Slab Variational Bayes for Linear and LogisticRegressionDescriptionImplements variational Bayesian algorithms to perform scalable variable selection for sparse,high-dimensional linear and logistic regression models.Features include a novel prioritized updating scheme,which uses a preliminary estimator of the variational means during initialization to generate an updating order prioritizing large,more relevant,coefficients.Sparsity is induced via spike-and-slab priors with either Laplace or Gaussian slabs.By default,the heavier-tailed Laplace density is used.Formal derivations of the algorithms and asymptotic consistency results may be found in Kolyan Ray and Botond Szabo(2020)<doi:10.1080/01621459.2020.1847121>and Kolyan Ray, Botond Szabo,and Gabriel Clara(2020)<arXiv:2010.11665>.DetailsFor details as they pertain to using the package,consult the svb.fit function help page.Detailed descriptions and derivations of the variational algorithms with Laplace slabs may be found in the references.Author(s)Maintainer:Gabriel Clara<*************************>Authors:•Botond Szabo•Kolyan RayReferences•Ray K.and Szabo B.Variational Bayes for high-dimensional linear regression with sparse priors.(2020).Journal of the American Statistical Association.•Ray K.,Szabo B.,and Clara G.Spike and slab variational Bayes for high dimensional logistic regression.(2020).Advances in Neural Information Processing Systems33.See AlsoUseful links:•Report bugs at https:///gclara/varpack/-/issuessvb.fit Fit Approximate Posteriors to Sparse Linear and Logistic ModelsDescriptionMain function of the sparsevb putes mean-field posterior approximations for both linear and logistic regression models,including variable selection via sparsity-inducing spike and slab priors.Usagesvb.fit(X,Y,family=c("linear","logistic"),slab=c("laplace","gaussian"),mu,sigma=rep(1,ncol(X)),gamma,alpha,beta,prior_scale=1,update_order,intercept=FALSE,noise_sd,max_iter=1000,tol=1e-05)ArgumentsX A numeric design matrix,each row of which represents a vector of covari-ates/independent variables/features.Though not required,it is recommendedto center and scale the columns to have norm sqrt(nrow(X)).Y An nrow(X)-dimensional response vector,numeric if family="linear"andbinary if family="logistic".family A character string selecting the regression model,either"linear"or"logistic".slab A character string specifying the prior slab density,either"laplace"or"gaussian".mu An ncol(X)-dimensional numeric vector,serving as initial guess for the varia-tional means.If omitted,mu will be estimated via ridge regression to initializethe coordinate ascent algorithm.sigma A positive ncol(X)-dimensional numeric vector,serving as initial guess for thevariational standard deviations.gamma An ncol(X)-dimensional vector of probabilities,serving as initial guess forthe variational inclusion probabilities.If omitted,gamma will be estimated viaLASSO regression to initialize the coordinate ascent algorithm.alpha A positive numeric value,parametrizing the beta hyper-prior on the inclusion probabilities.If omitted,alpha will be chosen empirically via LASSO regres-sion.beta A positive numeric value,parametrizing the beta hyper-prior on the inclusion probabilities.If omitted,beta will be chosen empirically via LASSO regres-sion.prior_scale A numeric value,controlling the scale parameter of the prior slab ed as the scale parameterλwhen prior="laplace",or as the standard deviationσif prior="gaussian".update_order A permutation of1:ncol(X),giving the update order of the coordinate-ascent algorithm.If omitted,a data driven updating order is used,see Ray and Szabo(2020)in Journal of the American Statistical Association for details.intercept A Boolean variable,controlling if an intercept should be included.NB:This feature is still experimental in logistic regression.noise_sd A positive numerical value,serving as estimate for the residual noise standard deviation in linear regression.If missing it will be estimated,see estimateSigmafrom the selectiveInference package for more details.Has no effect whenfamily="logistic".max_iter A positive integer,controlling the maximum number of iterations for the varia-tional update loop.tol A small,positive numerical value,controlling the termination criterion for max-imum absolute differences between binary entropies of successive iterates. DetailsSupposeθis the p-dimensional true parameter.The spike-and-slab prior forθmay be represented by the hierarchical schemew∼Beta(α,β),z j|w∼i.i.d.Bernoulli(w),θj|z j∼ind.(1−z j)δ0+z j g.Here,δ0represents the Dirac measure at0.The slab g may be taken either as a Laplace(0,λ)or N(0,σ2)density.The former has centered densityfλ(x)=λ2e−λ|x|.Givenαandβ,the beta hyper-prior has densityb(x|α,β)=xα−1(1−x)β−1 1tα−1(1−t)β−1d t.A straightforward integration shows that the prior inclusion probability of a coefficient isαα+β. ValueThe approximate mean-field posterior,given as a named list containing numeric vectors"mu", "sigma","gamma",and a value"intercept".The latter is set to NA in case intercept=FALSE.In mathematical terms,the conditional distribution of eachθj is given byθj|µj,σj,γj∼ind.γj N(µj,σ2)+(1−γj)δ0.Examples###Simulate a linear regression problem of size n times p,with sparsity level s### n<-250p<-500s<-5###Generate toy data###X<-matrix(rnorm(n*p),n,p)#standard Gaussian design matrixtheta<-numeric(p)theta[sample.int(p,s)]<-runif(s,-3,3)#sample non-zero coefficients in random locations pos_TR<-as.numeric(theta!=0)#true positivesY<-X%*%theta+rnorm(n)#add standard Gaussian noise###Run the algorithm in linear mode with Laplace prior and prioritized initialization### test<-svb.fit(X,Y,family="linear")posterior_mean<-test$mu*test$gamma#approximate posterior meanpos<-as.numeric(test$gamma>0.5)#significant coefficients###Assess the quality of the posterior estimates###TPR<-sum(pos[which(pos_TR==1)])/sum(pos_TR)#True positive rateFDR<-sum(pos[which(pos_TR!=1)])/max(sum(pos),1)#False discovery rateL2<-sqrt(sum((posterior_mean-theta)^2))#L_2-errorMSPE<-sqrt(sum((X%*%posterior_mean-Y)^2)/n)#Mean squared prediction errorIndexsparsevb,3sparsevb(sparsevb-package),2sparsevb-package,2svb.fit,2,36。

logisticregression简介

logisticregression简介Logistic Regression简介Logistic Regression(逻辑回归)是一种统计学习方法,用于解决分类问题。

它是由人们对线性回归模型的改进而来,通过引入逻辑函数将线性模型的输出限制在[0,1]之间,从而实现对二分类问题的建模。

Logistic Regression的基本原理是通过构建一个逻辑函数,将输入的特征与输出的概率联系起来。

逻辑函数一般采用Sigmoid函数,形式为:$$f(x) = \frac{1}{1+e^{-x}}$$其中,x为输入特征的线性组合。

Sigmoid函数具有将输入映射到[0,1]之间的特性,因此可以将输出解释为概率。

在Logistic Regression中,模型的参数是通过最大似然估计来求解的。

给定一个训练集,我们希望找到一组参数,使得模型对训练集的预测概率尽可能接近真实标签的概率。

具体来说,我们希望最大化似然函数:$$L(\theta) = \prod_{i=1}^{n}P(y^{(i)}|x^{(i)};\theta)$$其中,$y^{(i)}$为第i个样本的真实标签,$x^{(i)}$为其对应的特征向量,$\theta$为模型的参数。

对上式取对数,可以得到对数似然函数:$$l(\theta) = \sum_{i=1}^{n}\log P(y^{(i)}|x^{(i)};\theta)$$为了最大化对数似然函数,可以使用梯度上升法或者其他优化算法来求解。

Logistic Regression的优点之一是模型简单且易于解释。

由于模型的输出可以解释为概率,因此可以根据设定的阈值来进行分类预测。

此外,Logistic Regression对异常值和噪声有较好的鲁棒性,可以在一定程度上避免过拟合问题。

然而,Logistic Regression也有一些限制。

首先,它只能处理二分类问题,对于多分类问题需要进行扩展。

基于二元逻辑回归的考研动机影响因素分析

Statistics and Application 统计学与应用, 2023, 12(4), 998-1008 Published Online August 2023 in Hans. https:///journal/sa https:///10.12677/sa.2023.124103基于二元逻辑回归的考研动机影响因素分析赵雪娇北方工业大学理学院,北京收稿日期:2023年7月17日;录用日期:2023年8月7日;发布日期:2023年8月22日摘要近年来,关于“考研热”与“考研难”的话题频上热搜。

为了帮助有考研动机的学生认清考研前景、做出理性选择,本文运用问卷调查广泛调研收集数据,采用核主成分分析对数据进行降维,构建二元逻辑回归模型深入挖掘考研动机是否明确的影响因素。

研究结果表明,性别、疫情因素、提升就业竞争力三个因素对考研动机的影响最为显著。

最后,本文从学生自身、家庭层面、院校人才培养模式、相关部门等多个层面提出对策建议。

关键词考研动机,核主成分分析,二元逻辑回归,影响因素Analysis of Influencing Factors of Postgraduate Entrance Examination Motivation Based on Binary Logistic RegressionXuejiao ZhaoSchool of Science, North China University of Technology, BeijingReceived: Jul. 17th , 2023; accepted: Aug. 7th , 2023; published: Aug. 22nd, 2023AbstractIn recent years, the topic of “entrance examination hot” and “entrance examination difficult” has been frequently searched on the Internet. In order to help students with the motivation to get a clear understanding of the prospect of postgraduate entrance examination and make a rational赵雪娇choice, this paper extensively collects data through questionnaire survey, uses kernel principal component analysis to reduce the dimension of the data, and constructs a binary logistic regres-sion model to deeply explore the influencing factors of whether the motivation is clear or not. The results show that gender, epidemic factors and improving employment competitiveness have the most significant impact on the motivation for postgraduate entrance examination. Finally, this paper puts forward countermeasures and suggestions from the aspects of students themselves, family level, college talent training mode and relevant departments.KeywordsMotivation for Postgraduate Entrance Examination, Kernel Principal Component Analysis, Binary Logistic Regression, Influencing FactorThis work is licensed under the Creative Commons Attribution International License (CC BY 4.0)./licenses/by/4.0/1. 引言盲目追求高学历而引发的考研热,与教育的本质也是背道而驰的。

论文经典方法Logistic回归分析及其应用课堂PPT课件PPT40页

1967年Truelt J,Connifield J和Kannel W在《Journal of Chronic Disease》上发表了冠心病危险因素的研究,较早将Logistic回归用于医学研究。一般概念一元直线回归多元直线回归

.

第2页,共40页。

一元直线回归模型 y = a + b x + e多元直线回归模型 y = a + b1x1 + b2x2 + … + bkxk + e

.

第39页,共40页。

其他问题

logistic回归的局限性理论上的不足:自变量对疾病的影响是独立的,但实际情况及推导结果不同。模型有不合理性:“乘法模型”与一般希望的“相加模型”相矛盾。最大似然法估计参数的局限样本含量不宜太少:例数大于200例时才可不考虑参数估计的偏性。

.

第40页,共40页。

.

第30页,共40页。

非条件logistic回归

研究对象之间是否发生某事件是独立的。适用于:成组的病例-对照研究无分层的队列研究或横断面调查诊断性试验

.

第31页,共40页。

条件logistic回归

研究中有N个配比组,每组中n个病例配m个对照者。这时,各个研究对象发生某事件的概率即为条件概率。适用于配比设计的病例-对照研究精细分层设计的队列研究

value labelssex 1 '男' 2 '女'/hisc 1 '是' 0 '否' 9 '无法判断'/nsex 1 '正常' 0 '异常' 9 '未检'/demdx 1 '有' 0 '无'/addx 0 '无' 1 '危险性' 2 '可能' 3 '很可能'/edu 0 ‘文盲’ 1 ‘小学程度’ 2 ‘初中及以上'

倾向性评分法分析真实世界脉血康胶囊治疗创伤性疾病的疗效

的主要适应证之一。 真实世界研究(RealWorldStudy,RWS)是在临

床现实 医 疗 环 境 之 下 开 展 的,是 将 现 实 世 界 数 据 (RealWorldData,RWD)通过 RWS产生现实世界证 据(RealWorldEvidence,RWE)的 研 究[4]。 医 院 信 息管理系统 (HospitalInformationSystem,HIS)数据 库是医疗电子数据库的主要表现形式,是诊疗活动

抽象技术及其在蒙特卡洛树搜索中的应用研究综述

抽象技术及其在蒙特卡洛树搜索中的应用研究综述抽象技术及其在蒙特卡洛树搜索中的应用研究综述1. 引言随着计算机技术的发展,人工智能领域取得了长足的进步。

蒙特卡洛树搜索(Monte Carlo Tree Search,MCTS)作为一种强大的人工智能算法,广泛应用于各个领域,例如围棋、象棋、扑克等。

在MCTS算法的研究中,抽象技术起到了重要的作用。

本文旨在对抽象技术及其在MCTS中的应用进行综述,以期为深入理解MCTS算法的原理和应用提供参考。

2. 抽象技术概述抽象技术是通过将研究对象的某些细节或特征进行忽略,从而得到问题的简化描述或近似解的方法。

在蒙特卡洛树搜索中,抽象技术可以通过简化棋盘状态、减少搜索空间等方式来加快搜索速度,同时保持原问题的关键特征。

常用的抽象技术包括状态抽象、行动抽象和信息抽象。

3. 抽象技术在MCTS中的应用3.1 状态抽象状态抽象是指将复杂的游戏状态转化为简化的形式。

在MCTS 中,状态抽象可以用于减少搜索空间、去除冗余信息、降低计算复杂度等。

例如,在围棋中,可以将某些无关紧要的局面中的棋子合并为一个超级棋子。

这样可以大大减少搜索空间,提高MCTS的效率。

3.2 行动抽象行动抽象是指将具体的行动转化为抽象的行动。

在MCTS中,行动抽象可以用于减少搜索空间、合并相似的行动等。

例如,在象棋中,可以将某些相似的走法合并为一个抽象的走法,从而减少搜索的复杂度。

3.3 信息抽象信息抽象是指将游戏中的信息进行简化。

在MCTS中,信息抽象可以用于减少状态的表示维度、降低计算复杂度等。

例如,在扑克游戏中,可以将某些玩家的手牌信息进行抽象,只保留关键的信息,以减少搜索空间。

4. 抽象技术在不同领域的应用抽象技术在MCTS算法研究中有广泛的应用。

不同的领域可以利用不同的抽象技术进行问题简化。

以围棋为例,基于状态抽象的MCTS算法被广泛应用于AlphaGo等人工智能项目中。

通过精妙的状态抽象,AlphaGo在围棋领域取得了突破性的成果。

logistic回归分析LogisticRegression课件

基础

logistic回归基于概率论、统计学、最优化理论等学科领域的知识。它是广泛使用的分类方法 之一,也是深度学习模型中的核心组成之一。

logistic回归的应用场景

logistic回归分析 LogisticRegressionppt课件

欢迎来到本次PPT,我们将会介绍logistic回归分析,它在解决分类问题方面具 有广泛的应用。我们将从简介、原理与方法、模型评估、Python实现、实例 分析以及总结展望几方面来深入剖析该模型。

什么是logistic回归?

概念

logistic回归实例分析:应用于信用评估领域

模型名称

准确率

AUC

LR模型

0.74

0.79

GBDT模型

0.78

0.81

logistic回归分析-总结与展望

1 总结

2 展望

logistic回归模型可以实现二分类的预测问题, 具有广泛的应用场景。通过最大似然估计和 梯度下降等方法,可以对模型进行训练和评 估。

ROC曲线与AUC值

ROC曲线

ROC曲线是根据一系列不同的分类阈值绘制出的,可 以评估模型的分类能力。曲线下面积越大,表明模 型分类性能越好。

AUC值

AUC值是ROC曲线下的面积,该值越大,模型的分类 能力越强。

数据预处理

1

数据探索

通过boxplot,heatmap等图形并进行离群值处理和缺失值处理

未来,logistic回归模型将以更加自适应化、 多样化的方式应用于各个领域,比如基于深 度学习的模型等。

logisticregression函数参数

logisticregression函数参数LogisticRegression函数是Python中常用的机器学习算法之一,用于二分类问题的建模。

它的主要参数如下:1. penalty:惩罚项,默认为'l2'。

用于控制正则化项的类型,可以是'l1'、'l2'、'elasticnet'或'none'。

正则化是为了防止过拟合。

2. dual:对偶或原始问题,默认为False。

对于样本数小于特征数的问题,应该将此参数设置为True。

3. tol:停止求解的容差,默认为1e-4、用于控制损失函数的收敛程度,较小的值会导致更多的迭代次数,耗费更多的计算资源。

4.C:正则化强度的倒数,默认为 1.0。

较小的值表示更强的正则化,较大的值表示较弱的正则化。

5. fit_intercept:是否包含截距项,默认为True。

截距项是线性模型中常见的一个参数,用于平移模型的预测结果。

6. intercept_scaling:截距项缩放因子,默认为1、用于放大或缩小截距项的影响。

7. class_weight:类别权重,默认为None。

用于处理样本不平衡的问题,可以为各个类别指定不同的权重。

8. random_state:随机数种子,默认为None。

用于控制算法的随机性,保证每次运行结果一致。

9. solver:优化算法,默认为'lbfgs'。

可选的算法有'newton-cg'、'lbfgs'、'liblinear'、'sag'和'saga'。

不同的算法对数据的要求和性能有所不同。

10. max_iter:最大迭代次数,默认为100。

用于控制算法的运行时间,如果迭代次数超过了设定的值仍未收敛,则算法会提前停止。

11. multi_class:多类别处理方式,默认为'auto'。

托幼机构儿童视力现状及影响因素分析

DOI:10.16659/ki.1672-5654.2023.07.199托幼机构儿童视力现状及影响因素分析万杏花,赵彦红,高琳,郭岩上海市长宁区周家桥街道社区卫生服务中心,上海 200051[摘要] 目的了解长宁区周家桥社区儿童视力现状,提出学龄前儿童视力保健服务改进策略,提高服务能级。

方法根据儿童视力影响因素设计问卷并选取上海市周家桥街道社区内2019年入园的266名儿童为研究对象,对其家长进行问卷调查,根据调查结果,分为裸眼视力正常组(200名)和裸眼视力异常组(66例)。

采用Logistic回归分析法分析儿童视力现状及影响因素。

结果两组每晚入睡时间、晚上睡眠时间、接触电子产品时间、每天看电子产品时间、家庭采光情况、户外活动时间、是否使用视力矫正产品、看电视的距离、父母对儿童看书的坐姿关注等分布情况比较,差异有统计学意义(P<0.05)。

并针对以上因素进行多因素Logistic回归分析,结果显示黄疸抢救史、每晚入睡时间、晚上睡眠时间、晚上睡觉小夜灯使用情况、每天看电子产品时间、看书时间、家庭采光情况、家长对孩子看书的坐姿要求为影响学龄前儿童裸眼视力的独立危险因素(OR= 25.950、5.055、4.832、11.745、3.506、2.358、2.343、1.178,P<0.05)。

结论儿童视力保健需要学龄前儿童、家长、学校以及医务人员共同努力,需要从预防、宣教、治疗等方面联合协作,对儿童视力向良好的方向发展有一定的指导意义。

[关键词] 儿童保健;儿童视力;影响因素;预防措施[中图分类号] R175 [文献标识码] A [文章编号] 1672-5654(2023)04(a)-0199-05Analysis of Current Situation and Influencing Factors of Children's Vision in Nursery InstitutionsWAN Xinghua, ZHAO Yanhong, GAO Lin, GUO YanCommunity Health Service Center of Zhoujiaqiao Street, Changning District, Shanghai, 200051 China[Abstract]Objective To understand the status quo of children's vision in Zhoujiaqiao Community, Changning Dis⁃trict, and to propose strategies for improving vision care services for preschool children, so as to improve service lev⁃els. Methods According to the influencing factors of children's vision, a questionnaire was designed and 266 children who entered the kindergarten in 2019 in Zhoujiaqiao Neighborhood Community, Changning District, Shanghai were se⁃lected as the research objects, and their parents were surveyed. According to the survey results, they were divided into the normal naked eye vision group (200 people) and the abnormal naked eye vision group (66 cases). Logistic regres⁃sion analysis was used to analyze the status quo and influencing factors of children's visual acuity. Results The distri⁃bution of sleep time, sleep time at night, exposure time to electronic products, daily viewing time of electronic prod⁃ucts, home lighting conditions, outdoor activity time, whether to use vision correction products, distance to watch TV, and parents' attention to children's sitting posture while reading and writing between the two groups were compared, and the difference was statistically significant (P<0.05). Multiple logistic regression analysis was conducted based on the above factors, and the results showed that jaundice rescue history the time of falling asleep every night, the time of sleeping at night, the use of night lights at night, the time of watching electronic products every day, the time of read⁃ing, family lighting conditions, and parents' attitude towards children, the requirement of sitting posture for reading were independent risk factor affecting the uncorrected visual acuity of preschool children (OR=25.950, 5.055, 4.832, 11.745, 3.506, 2.358, 2.343, 1.178, P<0.05). Conclusion Children's vision care needs the joint efforts of preschool children, parents, schools and medical personnel, and needs joint cooperation from prevention, education, treatment and other aspects, which has certain guiding significance for the development of children's vision to a good direction.[Key words] Children's health care; Children's eyesight; Influencing factors; Preventive measures[作者简介]万杏花(1977-),女,硕士,主管医师,研究方向为公共卫生儿童保健。

logistic regression法

logistic regression法

(原创实用版)

目录

1.线性回归概述

2.Logistic 回归法的原理

3.Logistic 回归法的应用

4.Logistic 回归法的优缺点

正文

线性回归是一种常见的统计分析方法,主要用于研究因变量和自变量之间的关系。

在线性回归中,因变量通常是连续的,而自变量可以是连续的或离散的。

然而,当因变量为二分类或多分类时,线性回归就不再适用。

这时,Logistic 回归法就被引入了。

Logistic 回归法是一种用于解决分类问题的统计方法,其原理是基于逻辑斯蒂函数。

逻辑斯蒂函数是一种 S 型函数,其取值范围在 0 到 1 之间,可以用来表示一个事件发生的概率。

在 Logistic 回归法中,我们通过将自变量输入逻辑斯蒂函数,得到一个概率值,然后根据这个概率值来判断因变量所属的类别。

Logistic 回归法广泛应用于二分类和多分类问题中,例如信用风险评估、疾病预测、市场营销等。

在我国,Logistic 回归法也被广泛应用于各种领域,如金融、医疗、教育等。

Logistic 回归法虽然具有很多优点,但也存在一些缺点。

首先,Logistic 回归法对于自变量过多或者数据量过小的情况不太适用,因为这样容易导致过拟合。

其次,Logistic 回归法的计算过程比较复杂,需要用到特种数学知识,对计算资源的要求也比较高。

总的来说,Logistic 回归法是一种重要的分类方法,具有广泛的应

用前景。

下列关于logistic模型的说法中,错误的有

下列关于logistic模型的说法中,错误的有

原题目:

下列关于logistic回归的说法中,错误的是?

A.用于分类而非回归任务

B.支持不同类型的正则化

C.参数越大,正则化程度越高

D.对应于sklearn中linear_model.LogisticRegression的实现

答案解析

C

logistic回归又称logistic回归分析,主要在流行病学中应用较多,比较常用的情形是探索某疾病的危险因素,根据危险因素预测某疾病发生的概率,等等。

例如,想探讨胃癌发生的危险因素,可以选择两组人群,一组是胃癌组,一组是非胃癌组,两组人群肯定有不同的体征和生活方式等。

这里的因变量就是--是否胃癌,即“是”或“否”,为两分类变量,自变量就可以包括很多了,例如年龄、性别、饮食习惯、幽门螺杆菌感染等。

自变量既可以是连续的,也可以是离散的。

通过logistic回归分析,就可以大致了解到底哪些因素是胃癌的危险因素。

有序多分类logistic回归方程提取

有序多分类logistic回归方程提取

有序多分类logistic回归方程(ordinal logistic regression equation)是用于建模有序分类变量的一种回归模型。

该模型将有序分类变量视为一个连续变量,从而可以使用logistic回归模型对其进行预测。

假设有一个有序分类变量Y,其值可以是1、2、3、4等,表示不同的阶段。

同时,假设有一个自变量X,用来预测Y。

则有序多分类logistic回归方程可以表示为:

ln(p(Y≤k|X)) = αk + βX

其中,p(Y≤k|X)表示Y的取值不超过k的概率,αk表示截距参数,β表示自变量的系数。

该方程的解释如下:

假设Y的取值不超过k,则p(Y≤k|X)表示在给定X的条件下Y

的取值不超过k的概率。

该概率可以用logistic函数进行建模,即

p(Y≤k|X) = 1 / (1 + exp(-αk-βX))。

在有序多分类logistic回归中,我们可以将整个分类变量分为

k-1个二元变量(k为分类变量的总数),分别表示该变量的取值不大于1、不大于2、…不大于k-1。

因此,对于给定的X,我们可以计算出每个二元变量中Y的概率,然后根据这些概率计算出Y的实际概率分布。

需要注意的是,有序多分类logistic回归方程的参数估计可以使用最大似然估计法(MLE)来完成。

该方法基于已知数据,选择使得预测概率与实际概率最接近的参数值。

此外,还需要对模型的拟合度进行评估,以确定其准确性和可靠性。

逻辑斯蒂回归代码

逻辑斯蒂回归代码逻辑斯蒂回归是基于逻辑斯蒂函数的二分类算法,可以用于预测某个事件发生的概率。

而逻辑斯蒂回归的代码实现也并不复杂,下面就介绍一下逻辑斯蒂回归代码的实现方法。

1. 数据集的准备首先需要准备一个用于训练和测试的数据集,其中包含了特征和相应的分类标签。

可以使用Python中的Pandas库来处理数据集。

下面展示了一个简单的数据集的准备代码:``` pythonimport pandas as pddataset = pd.read_csv("dataset.csv")X = dataset.iloc[:, :-1].valuesy = dataset.iloc[:, -1].values```其中,X变量包含了特征信息,y变量则包含了分类标签。

这样就可以开始训练了。

2. 创建逻辑斯蒂回归模型使用Python中的Scikit-Learn库来训练逻辑斯蒂回归模型。

下面展示了基本的模型创建代码:``` pythonfrom sklearn.linear_model import LogisticRegressionclf = LogisticRegression()clf.fit(X_train, y_train)```其中,clf是逻辑斯蒂回归模型的对象。

使用fit()方法来对模型进行训练,传入的参数为训练数据集X_train和标签y_train。

3. 测试模型的准确性训练完模型之后,需要对模型进行测试,以检验模型的准确性。

下面是测试代码:``` pythony_pred = clf.predict(X_test)from sklearn.metrics import accuracy_scoreaccuracy = accuracy_score(y_test, y_pred)print("Accuracy:", accuracy)```其中,y_pred为模型对测试集进行预测的结果,accuracy_score()函数用于计算预测和实际分类之间的准确性比较得分。

有序logistic回归模型

有序logistic回归模型有序logistic回归模型是一种广泛应用于分类问题的统计模型。

它在机器学习和数据分析领域被广泛使用,特别是在二分类问题中。

在本文中,我们将介绍有序logistic回归模型的概念、原理和应用。

有序logistic回归模型是一种有序多项逻辑回归模型,用于处理有序分类问题。

在有序分类问题中,我们需要将样本分为多个有序的类别,而不是简单的二分类问题。

例如,我们可以将学生成绩划分为优秀、良好、及格和不及格四个等级。

有序logistic回归模型的原理基于logistic回归模型。

在logistic回归模型中,我们使用sigmoid函数将线性回归的输出转换为概率值,从而进行分类。

而有序logistic回归模型则通过引入多个sigmoid函数,将线性回归的输出与不同的阈值进行比较,从而实现多个有序分类。

在有序logistic回归模型中,我们首先需要确定多个阈值点,将样本划分为不同的类别。

然后,对于每个类别,我们使用一个sigmoid函数来计算样本属于该类别的概率。

最后,我们通过最大似然估计等方法,求解模型的参数,使得模型的预测值与实际观测值尽可能接近。

有序logistic回归模型的应用非常广泛。

在医学领域,它可以用于预测疾病的严重程度或预后情况。

在金融领域,它可以用于评估借款人的信用等级。

在市场营销领域,它可以用于预测消费者的购买意愿或忠诚度。

有序logistic回归模型的优点之一是可以处理有序分类问题,而不需要将其转化为多个二分类问题。

这样可以简化模型的构建和计算。

此外,有序logistic回归模型也可以通过引入更多的特征变量来提高模型的预测能力。

然而,有序logistic回归模型也有一些局限性。

首先,它假设各个类别之间的差异是相等的,这在某些情况下可能是不合理的。

其次,它对异常值比较敏感,可能会对模型的性能产生较大影响。

此外,有序logistic回归模型也需要满足一些假设条件,如线性关系、独立性和同方差性等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

A Tutorial on Logistic RegressionYing So,SAS Institute Inc.,Cary,NCABSTRACTMany procedures in SAS/STAT®can be used to perform lo-gistic regression analysis:CATMOD,GENMOD,LOGISTIC,and PROBIT.Each procedure has special features thatmake it useful for certain applications.For most applica-tions,PROC LOGISTIC is the preferred choice.It fits binaryresponse or proportional odds models,provides variousmodel-selection methods to identify important prognosticvariables from a large number of candidate variables,andcomputes regression diagnostic statistics.This tutorial dis-cusses some of the problems users encountered when theyused the LOGISTIC procedure.INTRODUCTIONPROC LOGISTIC can be used to analyze binary responseas well as ordinal response data.Binary ResponseThe response,Y,of a subject can take one of two possiblevalues,denoted by1and2(for example,Y=1if a disease ispresent;otherwise Y=2).Let1be the vectorof explanatory variables.The logistic regression model isused to explain the effects of the explanatory variables onthe binary response.Pr1logit Pr1logThe following example illustrates such situation.Consider the data set DATA1(Table 1)with 10observations.Y is the response and 1and 2are two explanatory variables.Table plete Separation Data (DATA1)Observation1129183331188532241730221932233Figure 1shows that the vector 621completely separates the observations into their response groups;that is,all observations of the same response lie on the same side of the line 2216.Figure 1.Scatterplot of Sample Points in DATA1The iterative history of fitting a logistic regression model to the given data is shown in Output 1.Note that the negative loglikehood decreases to 0---a perfect fit.Quasicomplete SeparationIf the data are not completely separated and there exists a vector such that0102with equality holds for at least one subject in each response group,there is a quasicomplete separation.The maximum likelihood estimate does not exist.The loglikelihood does not diminish to 0as in the case of complete separation,but the dispersion matrix becomes unbound.Output 1.Partial LOGISTIC Printout for DATA1Maximum Likelihood Iterative PhaseIter Step -2Log L INTERCPT X1X20INITIAL 13.86294401IRLS 4.691312-2.813220-0.0620420.0837612IRLS 2.280691-2.773158-0.1872590.1509423IRLS 0.964403-0.425345-0.4239770.2382024IRLS 0.361717 2.114730-0.6922020.3397635IRLS 0.133505 4.250789-0.9507530.4435186IRLS 0.049378 6.201510-1.2035050.5474907IRLS 0.0182878.079876-1.4544990.6518128IRLS 0.0067749.925139-1.7052840.7566109IRLS 0.00250911.748893-1.9563230.86191610IRLS 0.00092913.552650-2.2076660.96772711IRLS 0.00034415.334133-2.459215 1.07402412IRLS 0.00012717.089516-2.710811 1.18078413IRLS 0.00004703018.814237-2.962266 1.28798314IRLS 0.00001738420.503310-3.213375 1.39559415IRLS 0.00000642322.151492-3.463924 1.50359016IRLS 0.00000237223.753408-3.713693 1.61194317IRLS 0.00000087625.303703-3.962463 1.72062618IRLS 0.00000032326.797224-4.210021 1.82961019IRLS 0.00000011928.229241-4.456170 1.93886920IRLS 4.3956397E-829.595692-4.700735 2.04837721IRLS 1.620409E-830.893457-4.943572 2.15810922IRLS 5.9717453E-932.120599-5.184576 2.26804223IRLS 2.2002107E-933.276570-5.423689 2.37815324IRLS 8.10449E-1034.362317-5.660901 2.48842125IRLS2.984679E-1035.380281-5.8962522.598826WARNING:Convergence was not attained in 25iterations.Iteration control is available with the MAXITER and the CONVERGE options on the MODEL statement.You can modify DATA1to create a situation of quasicom-plete separation,for instance,change 244to 264in observation 6.Let the modified data set be DATA2.With421,the equality holds for observations 1,5,and 7,and the rest of the observations are separated into their response groups (Figure 2).It is easy to see that there is no straight line that can completely separate the two responsegroups.Figure 2.Scatterplot of Sample Points in DATA2The parameter estimates during the iterative phase are displayed in Output 2and the dispersion matrices for iter-ations 0,5,10,15,and 25are shown in Output 3.The log-likelihood approaches a nonzero constant .The seem-ingly large variances of pseudoestimates are typical of a quasicomplete separation of data.2Output2.Partial LOGISTIC Printout for DATA2Maximum Likelihood Iterative PhaseIter Step-2Log L INTERCPT X1X2 0INITIAL13.862944000 1IRLS 6.428374-4.6385060.0033870.077640 2IRLS 4.856439-7.539932-0.0110600.131865 3IRLS 4.190154-9.533783-0.0666380.190242 4IRLS 3.912968-11.081432-0.1469530.252400 5IRLS 3.800380-11.670780-0.2652810.316912 6IRLS 3.751126-11.666819-0.4179290.388135 7IRLS 3.727865-11.697310-0.5976410.472639 8IRLS 3.716764-11.923095-0.8063710.573891 9IRLS 3.711850-12.316216-1.0382540.688687 10IRLS 3.709877-12.788230-1.2818680.810247 11IRLS 3.709130-13.282112-1.5298900.934224 12IRLS 3.708852-13.780722-1.779320 1.058935 13IRLS 3.708750-14.280378-2.029162 1.183855 14IRLS 3.708712-14.780288-2.279118 1.308833 15IRLS 3.708698-15.280265-2.529107 1.433827 16IRLS 3.708693-15.780258-2.779104 1.558826 17IRLS 3.708691-16.280257-3.029103 1.683825 18IRLS 3.708691-16.780256-3.279103 1.808825 19IRLS 3.708690-17.280256-3.529103 1.933825 20IRLS 3.708690-17.780256-3.779103 2.058825 21IRLS 3.708690-18.280256-4.029102 2.183825 22IRLS 3.708690-18.780255-4.279102 2.308825 23IRLS 3.708690-19.280256-4.529102 2.433825 24IRLS 3.708690-19.780257-4.779103 2.558825 25IRLS 3.708690-20.280250-5.029099 2.683824 WARNING:Convergence was not attained in25iterations.Iteration control is available with the MAXITER and theCONVERGE options on the MODEL statement.Output3.Dispersion Matrices on Selected Iterations (DATA2)Iter=0-2Log L=13.862944Variable INTERCPT Z1Z2ESTIMATE INTERCPT269.05188212-8.42405441-0.1573802450Z1-8.424054410.26732397970.00326157250Z2-0.1573802450.00326157250.00097472280Iter=5-2Log L= 3.800380Variable INTERCPT Z1Z2ESTIMATE INTERCPT985.12006548-29.47104673-1.460819309-11.670780Z1-29.47104673 1.4922999204-0.242120428-0.265281Z2-1.460819309-0.2421204280.136********.316912Iter=10-2Log L= 3.709877Variable INTERCPT Z1Z2ESTIMATE INTERCPT1391.583624169.160036-100.9268654-12.788230Z1169.160036105.7305273-52.20138038-1.281868Z2-100.9268654-52.2013803826.0436664980.810247Iter=15-2Log L= 3.708698Variable INTERCPT Z1Z2ESTIMATE INTERCPT62940.29954130943.762505-15488.22021-15.280265Z130943.76250515493.136539-7745.900995-2.529107Z2-15488.22021-7745.9009953872.8917604 1.433827Iter=20-2Log L= 3.708690Variable INTERCPT Z1Z2ESTIMATE INTERCPT9197536.138********.6822-2299137.18-17.780256Z14598241.68222299142.0966-1149570.381-3.779103Z2-2299137.18-1149570.381574785.13177 2.058825Iter=25-2Log L= 3.708690Variable INTERCPT Z1Z2ESTIMATE INTERCPT502111231.75251055089.49-125527561.1-20.280250Z1251055089.49125527566-62763782.33-5.029099Z2-125527561.1-62763782.3331381891.107 2.683824OverlapIf neither complete nor quasicomplete separation exists in the sample points,there is an overlap of sample points.The maximum likelihood estimate exists and isunique.Figure3.Scatterplot of Sample Points in DATA3If you change244to274in observation6of DATA1,the modified data set(DATA3)has overlapped sample points.A scatterplot of the sample points in DATA3 is shown in Figure3.For every straight line on the drawn on the plot,there is always a sample point from each response group on same side of the line.The maximum likelihood estimates are finite(Output4).Output4.PROC LOGISTIC Printout for DATA3Maximum Likelihood Iterative PhaseIter Step-2Log L INTERCPT X1X20INITIAL13.8629440001IRLS7.192759-4.6657750.0111920.0732382IRLS 6.110729-7.3831160.0106210.1165493IRLS 5.847544-8.760124-0.0135380.1489424IRLS 5.816454-9.185086-0.0332760.1643995IRLS 5.815754-9.228343-0.0378480.1671256IRLS 5.815754-9.228973-0.0379870.1671977IRLS 5.815754-9.228973-0.0379870.167197 Last Change in-2Log L: 2.282619E-13Last Evaluation of GradientINTERCPT X1X2-1.109604E-7-3.519319E-6-3.163568E-6 Empirical Approach to Detect SeparationComplete separation and quasicomplete separation are problems typical for small sample.Although complete sep-aration can occur with any type of data,quasicomplete separation is not likely with truly continuous data.At the iteration,let be the vector of pseudoestimates.The probability of correct allocation based on is given byexp1exp23Stop at the iteration when the probability of correctallocation is1for all observations.There is a com-plete separation of data points.For DATA1,correctallocation of all data points is achieved at iteration13(Table2).At each iteration,look for the observation with thelargest probability of correct allocation.If this prob-ability has become extremely close to1,and anydiagonal element of the dispersion matrix becomesvery large,stop the iteration.It is very likely there isa quasicomplete separation in the data set.Table3displays the maximum probability of correct alloca-tion for DATA2.The dispersion matrix should beexamined after the5iteration.Table2.Percentage of Correct Allocation(DATA1)-2Log L1Allocation13.86290.000000 1-2.81320.083762.2807-0.187260 3-0.42530.238200.3617-0.6922010 5 4.25080.443520.0494-1.2035140 78.07990.651810.0068-1.7052850 911.74890.861920.0009-2.2076750 1115.3341 1.074020.0001-2.7108180 1318.8142 1.287980.0000-3.21338100 1522.1515 1.50359Maximum0200.00000.000006.42840.003390.87703 2-7.53990.131874.1902-0.066640.99574 4-11.08140.252403.8004-0.265280.99995 6-11.66680.388143.7279-0.59764 1.00000 8-11.92310.573893.7119-1.03825 1.00000 10-12.78820.810253.7091-1.52989 1.00000 12-13.7807 1.058943.7088-2.02916 1.00000 14-14.7803 1.308833.7087-2.52911 1.00000ORDERING OF THE BINARY RESPONSE LEV-ELSIf the binary response is0and1,PROC LOGISTIC,by default,models the probability of0instead of1;that is,logPr0xchanges from0to1,the probability of“no disease”de-creases.This is a less direct way of saying that the probability of“disease”increases with EXPOSURE.Sincelog Pr1Pr1the probability of response1is given bylogPr1x1exp vFor the1-1matching,the likelihood is reduced to1exp u1exp u v1Thus the likelihood is identical to that of the binary logis-tic model with1as covariates,no intercept,and a constant response.Therefore,you can“trick”PROCLOGISTIC to perform the conditional logistic regression for1-1matching(See Example5of the LOGISTIC documenta-tion).For1:n matching,it is more convenient to use PROCPHREG(see Example3of the PHREG documentation).5Bradley-Terry Model for Paired ComparisonThe Bradley-Terry Model is useful in establishing the over-all ranking of items through paired comparisons.For instance,it is difficult for a panelist to rate all9brands of beer at the same occasion;rather it is preferable to com-pare the brands in a pairwise manner.For a given pair of products,the panelist would state his preference after tasting them at the same occasion.Let12be re-gression coefficients associated with the items1, respectively.The probability that is preferred to isexp1expand,therefore,the likelihood function for the paired com-parison model is1where A is the sample collection of all the test pairs.For the pair of comparison,if is preferable to,let the vectorbe such that1110otherwiseThe likelihood for the Bradley-Terry model is identical to the binary logistic model with as covariates,no intercept, and a constant response.Multinormial Logit Choice ModelThe multinormial logit model is useful in investigating con-sumer choice behavior and has become increasingly pop-ular in marketing research.Let C be a set of choices, denoted by12.A subject is present with alter-natives in C and is asked to choose the most preferred alternative.Let be a covariate vector associated with the alternative.The multinomial logit model for the choice probabilities is given byexp xPr C。