R语言案例_机器学习的试验设计初探

RStudioR语言与统计分析实验报告

RStudioR语言与统计分析实验报告1. 实验目的本实验旨在介绍RStudio软件和R语言在统计分析中的应用。

通过本实验,可以了解RStudio的基本功能和操作,掌握R语言的基本语法和常用函数,并在实际数据分析中应用所学知识。

2. 实验环境与工具本实验使用RStudio软件进行实验操作。

RStudio是一个集成开发环境(IDE),专门用于R语言编程和统计分析。

它提供了代码编辑器、调试器、数据可视化工具等一系列功能,便于用户进行数据处理和分析。

3. 实验步骤本实验分为以下几个步骤:3.1 安装R和RStudio在开始实验之前,需要先安装R语言和RStudio软件。

R语言是一种统计分析和数据挖掘的编程语言,而RStudio是R语言的集成开发环境。

3.2 RStudio界面介绍在打开RStudio后,可以看到主要分为四个区域:代码编辑器、控制台、环境和帮助。

代码编辑器用于编写R语言代码,控制台用于执行和查看代码运行结果,环境用于查看和管理数据对象,帮助用于查阅R语言文档和函数说明。

3.3 R语言基础研究R语言的基本语法和常用函数是使用RStudio进行统计分析的基础。

实验中将介绍R语言的数据类型、赋值操作、条件语句、循环语句等基本概念,并演示常用函数的使用方法。

3.4 实际数据分析应用通过实际数据分析案例,将R语言和RStudio运用到实际问题中。

根据给定的数据,使用R语言进行数据处理、探索性分析和统计模型建立,并通过可视化工具展示分析结果。

4. 实验总结通过完成本实验,我们了解了RStudio软件和R语言在统计分析中的应用。

掌握了RStudio的基本功能和操作,熟悉了R语言的基本语法和常用函数。

通过实际数据分析案例的应用,提高了数据处理和统计分析能力。

5. 参考资料。

R语言实验二

R语⾔实验⼆实验2 R基础(⼆)⼀、实验⽬的:1.掌握数字与向量的运算;2.掌握对象及其模式与属性;3.掌握因⼦变量;4.掌握多维数组和矩阵的使⽤。

⼆、实验内容:1.完成教材例题;2.完成以下练习。

练习:要求:①完成练习并粘贴运⾏截图到⽂档相应位置(截图⽅法见下),并将所有⾃⼰输⼊⽂字的字体颜⾊设为红⾊(包括后⾯的思考及⼩结),②回答思考题,③简要书写实验⼩结。

④修改本⽂档名为“本⼈完整学号姓名1”,其中1表⽰第1次实验,以后更改为2,3,...。

如⽂件名为“1305543109张⽴1”,表⽰学号为1305543109的张⽴同学的第1次实验,注意⽂件名中没有空格及任何其它字符。

最后连同数据⽂件、源程序⽂件等(如果有的话),⼀起压缩打包发给课代表,压缩包的⽂件名同上。

截图⽅法:法1:调整需要截图的窗⼝⾄合适的⼤⼩,并使该窗⼝为当前激活窗⼝(即该窗⼝在屏幕最前⽅),按住键盘Alt键(空格键两侧各有⼀个)不放,再按键盘右上⾓的截图键(通常印有“印屏幕”或“Pr Scrn”等字符),即完成截图。

再粘贴到word⽂档的相应位置即可。

法2:利⽤QQ输⼊法的截屏⼯具。

点击QQ输⼊法⼯具条最右边的“扳⼿”图标,选择其中的“截屏”⼯具。

)1.⾃⾏完成教材P58页2.2-2.5节中的例题。

2.(习题2.1)建⽴⼀个R⽂件,在⽂件中输⼊变量x = (1,2,3)T,y = (4,5,6)T,并作以下运算(1)计算z = 2x + y + e,其中e = (1,1,1)T;(2)计算x与y的内积;(3)计算x与y的外积。

解:源代码:(1)x<-c(1,2,3)y<-c(4,5,6)e<-c(1,1,1)z=2*x+y+ez1=crossprod(x,y) #z1为x与y的内积或者x%*%yz2=tcrossprod(x,y) #z2为x与y的外积或者x%o%yz;z1;z2(2) x<-c(1,2,3)y<-c(4,5,6)e<-c(1,1,1)z=2*x+y+ez1= x%*%yz2=x%o%yz;z1;z2运⾏截图:3.(习题2.2)将1,2,…,20构成两个4×5阶的矩阵,其中矩阵A是按列输⼊,矩阵B是按⾏输⼊,并作如下运算(1)C = A + B;(相对应的数相加)(2) D = AB T;(3)E = (e ij )4×5,其中e ij = a ij·b ij;(相对应的数相乘)(4)F是由A的前3⾏和前3列构成的矩阵;(5)G是由矩阵B的各列构成的矩阵,但不含B的第3列。

R语言实验报告范文

R语言实验报告范文实验报告:基于R语言的数据分析摘要:本实验基于R语言进行数据分析,主要从数据类型、数据预处理、数据可视化以及数据分析四个方面进行了详细的探索和实践。

实验结果表明,R语言作为一种强大的数据分析工具,在数据处理和可视化方面具有较高的效率和灵活性。

一、引言数据分析在现代科学研究和商业决策中扮演着重要角色。

随着大数据时代的到来,数据分析的方法和工具也得到了极大发展。

R语言作为一种开源的数据分析工具,被广泛应用于数据科学领域。

本实验旨在通过使用R语言进行数据分析,展示R语言在数据处理和可视化方面的应用能力。

二、材料与方法1.数据集:本实验使用了一个包含学生身高、体重、年龄和成绩的数据集。

2.R语言版本:R语言版本为3.6.1三、结果与讨论1.数据类型处理在数据分析中,需要对数据进行适当的处理和转换。

R语言提供了丰富的数据类型和操作函数。

在本实验中,我们使用了R语言中的函数将数据从字符型转换为数值型,并进行了缺失值处理。

同时,我们还进行了数据类型的检查和转换。

2.数据预处理数据预处理是数据分析中的重要一步。

在本实验中,我们使用R语言中的函数处理了异常值、重复值和离群值。

通过计算均值、中位数和四分位数,我们对数据进行了描述性统计,并进行了异常值和离群值的检测和处理。

3.数据可视化数据可视化是数据分析的重要手段之一、R语言提供了丰富的绘图函数和包,可以用于生成各种类型的图表。

在本实验中,我们使用了ggplot2包绘制了散点图、直方图和箱线图等图表。

这些图表直观地展示了数据的分布情况和特点。

4.数据分析数据分析是数据分析的核心环节。

在本实验中,我们使用R语言中的函数进行了相关性分析和回归分析。

通过计算相关系数和回归系数,我们探索了数据之间的关系,并对学生成绩进行了预测。

四、结论本实验通过使用R语言进行数据分析,展示了R语言在数据处理和可视化方面的强大能力。

通过将数据从字符型转换为数值型、处理异常值和离群值,我们获取了可靠的数据集。

机器学习建模实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,机器学习技术在各个领域得到了广泛应用。

本实验旨在通过实际操作,掌握机器学习建模的基本流程,包括数据预处理、特征选择、模型选择、模型训练和模型评估等步骤。

通过实验,我们将深入理解不同机器学习算法的原理和应用,提高解决实际问题的能力。

二、实验目标1. 熟悉Python编程语言,掌握机器学习相关库的使用,如scikit-learn、pandas等。

2. 掌握数据预处理、特征选择、模型选择、模型训练和模型评估等机器学习建模的基本步骤。

3. 熟悉常见机器学习算法,如线性回归、逻辑回归、决策树、支持向量机、K最近邻等。

4. 能够根据实际问题选择合适的机器学习算法,并优化模型参数,提高模型性能。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3.83. 机器学习库:scikit-learn 0.24.2、pandas 1.3.4四、实验数据本实验使用鸢尾花数据集(Iris dataset),该数据集包含150个样本,每个样本有4个特征(花瓣长度、花瓣宽度、花萼长度、花萼宽度)和1个标签(类别),共有3个类别。

五、实验步骤1. 数据导入与预处理首先,使用pandas库导入鸢尾花数据集,并对数据进行初步查看。

然后,对数据进行标准化处理,将特征值缩放到[0, 1]范围内。

```pythonimport pandas as pdfrom sklearn import datasets导入鸢尾花数据集iris = datasets.load_iris()X = iris.datay = iris.target标准化处理from sklearn.preprocessing import StandardScalerscaler = StandardScaler()X = scaler.fit_transform(X)```2. 特征选择使用特征重要性方法进行特征选择,选择与标签相关性较高的特征。

r语言 的实际应用

r语言的实际应用R语言的实际应用R语言作为一种统计计算和数据可视化的开源编程语言,具有广泛的应用范围。

下面是几个常见的R语言实际应用的例子:数据分析和统计建模•数据探索和清洗:R语言提供了丰富的数据处理函数和包,可以对数据进行清洗、转换和探索。

•描述统计分析:通过R语言的统计函数,可以计算数据的均值、标准差、频率分布等统计指标。

•统计推断和假设检验:R语言包括了众多的统计推断方法和假设检验函数,可用于研究数据间的关系和差异。

•回归分析和预测建模:R语言提供了多种回归模型和预测算法,可用于解释变量之间的关系和预测未来趋势。

数据可视化•基本绘图:R语言内置的图形函数可以生成各种基本图形,如散点图、折线图、柱状图等。

•高级数据可视化:R语言的ggplot2包提供了强大的数据可视化功能,可以绘制高度美观且具有信息密度的图形。

•交互式可视化:R语言中的shiny包可以创建交互式数据可视化应用,用户可以与图形互动并进行自定义操作。

机器学习与深度学习•机器学习算法实现:R语言提供了多个机器学习包,如caret和MLR,可以实现各种分类、回归和聚类等算法。

•深度学习框架支持:通过R语言的keras和tensorflow包,可以使用现有的深度学习模型和进行模型训练与应用。

文本挖掘与自然语言处理•文本处理:R语言的tm包和stringr包提供了丰富的文本处理函数,如分词、词频统计、情感分析等。

•主题建模:通过R语言中的topicmodels包,可以进行文本主题建模和推断。

•情感分析:利用R语言的sentimentr包,可对文本情感进行分析和挖掘。

网络分析与社交网络分析•复杂网络分析:R语言的igraph包允许进行复杂网络的构建、分析和可视化。

•社交网络分析:通过R语言中的sna和statnet包,可以进行社交网络的分析和推断。

以上仅为R语言实际应用的部分例子,R语言具有丰富的扩展包和丰富的函数库,可以满足各种不同领域和应用的需求。

r语言与数据挖掘最佳实践和经典案例

r语言与数据挖掘最佳实践和经典案例R语言是一种功能强大的数据分析和数据挖掘工具,它具有丰富的数据处理函数和扩展包,为数据挖掘提供了许多优秀的实践和经典案例。

以下是一些R语言与数据挖掘的最佳实践和经典案例:1. 探索性数据分析(EDA):R语言提供了许多数据可视化函数和扩展包,可以帮助从数据中发现模式和趋势。

通过绘制直方图、散点图、箱线图等图形,可以以直观的方式展示数据的分布和关系。

2. 数据预处理:在进行数据挖掘之前,需要对原始数据进行清洗和转换。

R语言提供了许多函数和扩展包,如dplyr、tidyr 和reshape2,可以方便地进行数据清洗、缺失值处理、变量转换等操作。

3. 机器学习模型建立:R语言中有许多经典的机器学习算法的实现,如线性回归、逻辑回归、决策树、支持向量机、随机森林等。

可以使用caret扩展包进行模型的建立、交叉验证和模型选择。

4. 特征选择和降维:在处理大规模数据时,特征选择和降维是必不可少的步骤。

R语言提供了一些函数和扩展包,如stats 和caret,可以用于特征选择和降维,如主成分分析(PCA)和线性判别分析(LDA)。

5. 聚类分析:聚类分析是一种常用的无监督学习方法,用于将样本划分成若干个不同的簇。

R语言中有许多聚类算法的实现,如K均值聚类、层次聚类和DBSCAN。

可以使用cluster和fpc扩展包进行聚类分析。

6. 关联规则挖掘:关联规则挖掘用于发现数据中的关联关系,如市场篮子分析中的购买商品之间的关系。

R语言中有许多关联规则挖掘的函数和扩展包,如arules和arulesViz。

7. 时间序列分析:时间序列分析用于处理与时间相关的数据,如股票价格、天气数据等。

R语言中有许多时间序列分析的函数和扩展包,如stats和forecast。

可以进行时间序列的可视化、平稳性检验、模型拟合和预测等。

这些实践和经典案例展示了R语言在数据挖掘领域的广泛应用,对于学习和应用R语言进行数据挖掘具有很大的参考价值。

使用R进行数据挖掘和机器学习实战案例

使用R进行数据挖掘和机器学习实战案例引言在当今信息时代,大量的数据被生成和存储,这些数据蕴含了丰富的信息和价值。

然而,如何从这些海量数据中提取有用的信息仍然是一个具有挑战性的问题。

数据挖掘和机器学习技术的出现,为我们解决这个问题提供了一条可行的道路。

本文将使用R 语言为工具,介绍数据挖掘和机器学习的实战案例,并分为三个章节:数据预处理、数据挖掘和机器学习。

第一章:数据预处理在数据挖掘和机器学习之前,必须进行数据预处理,以清洗和准备数据,使其适合后续的分析和建模。

数据预处理步骤通常包括数据清洗、特征选择、特征缩放和数据转换等。

在R中,我们可以使用各种包和函数来处理数据。

例如,使用dplyr包可以对数据进行清洗和整理,使用tidyverse包可以进行特征选择,使用caret包可以进行特征缩放,使用reshape2包可以进行数据转换等。

通过这些功能强大的工具,我们可以在数据挖掘和机器学习之前对数据进行必要的预处理。

第二章:数据挖掘在数据预处理完成之后,接下来是数据挖掘的过程。

数据挖掘旨在发现数据背后的隐藏模式和关联规则,并提取有用的信息。

在R中,我们可以使用多种算法进行数据挖掘,如聚类分析、关联规则挖掘、时间序列分析等。

对于聚类分析,我们可以使用k-means算法、层次聚类算法等,在R中可以通过cluster包和stats包来实现。

关联规则挖掘可以使用Apriori算法和FP-Growth算法,在R中可以通过arules包和arulesSequences包来实现。

时间序列分析可以使用ARIMA模型和自回归平均滑动模型,在R中可以通过forecast包和stats包来实现。

通过这些算法和相应的R包,我们可以在数据中发现有用的模式和规律。

第三章:机器学习数据挖掘的结果往往是为了解决实际的问题或做出预测。

而机器学习就是通过利用数据的模式和规律来训练模型,并使用这些模型来做出预测或分类。

在R中,有许多机器学习算法和相应的包可以供我们选择。

R语言可视化案例分析报告 附代码数据

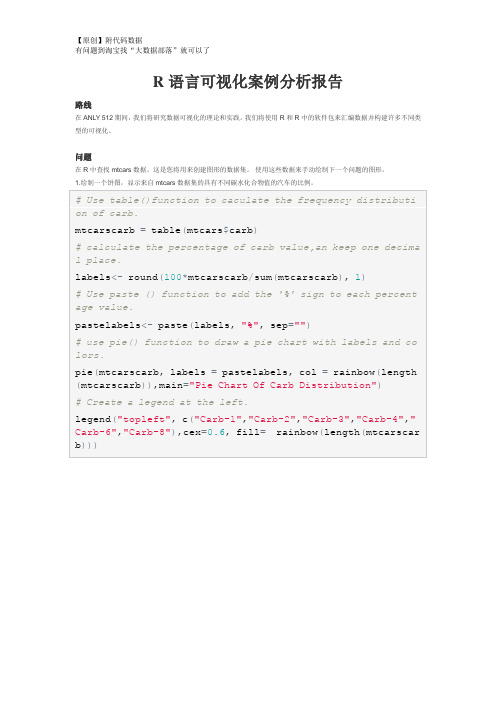

R语言可视化案例分析报告

路线

在ANLY 512期间,我们将研究数据可视化的理论和实践。

我们将使用R和R中的软件包来汇编数据并构建许多不同类型的可视化。

问题

在R中查找mtcars数据。

这是您将用来创建图形的数据集。

使用这些数据来手动绘制下一个问题的图形。

1.绘制一个饼图,显示来自mtcars数据集的具有不同碳水化合物值的汽车的比例。

2.

3. 结果显示,大部分汽车使用了化油器的数量1,2,4。

小汽车使用的数量是6或8。

2.绘制一个条形图,显示mtcars中每个齿轮类型的数量。

5.

结果表明wt和mpg具有负相关关系。

随着汽车重量的增加,每加仑的里程会减少。

5.使用数据设计您的选择的可视化。

The result shows the mpg mean of cars with manual transmission is greater than cars with automatic transmission.。

R语言进行机器学习方法及实例(一)

R语⾔进⾏机器学习⽅法及实例(⼀)版权声明:本⽂为博主原创⽂章,转载请注明出处 机器学习的研究领域是发明计算机算法,把数据转变为智能⾏为。

机器学习和数据挖掘的区别可能是机器学习侧重于执⾏⼀个已知的任务,⽽数据发掘是在⼤数据中寻找有价值的东西。

机器学习⼀般步骤收集数据,将数据转化为适合分析的电⼦数据探索和准备数据,机器学习中许多时间花费在数据探索中,它要学习更多的数据信息,识别它们的微⼩差异基于数据训练模型,根据你要学习什么的设想,选择你要使⽤的⼀种或多种算法评价模型的性能,需要依据⼀定的检验标准改进模型的性能,有时候需要利⽤更⾼级的⽅法,有时候需要更换模型机器学习算法有监督学习算法⽤于分类:k近邻,朴素贝叶斯,决策树,规则学习,神经⽹络,⽀持向量机⽤于数值预测:线性回归,回归树,模型树,神经⽹络,⽀持向量机⽆监督学习算法⽤于模式识别(数据之间联系的紧密性):关联规则⽤于聚类:k均值聚类R语⾔机器学习算法实现kNN(k-Nearest Neighbors,k近邻)原理:计算距离,找到测试数据的k个近邻,根据k个近邻的分类预测测试数据的分类应⽤k近邻需要将各个特征转换为⼀个标准的范围(归⼀化处理),可以应⽤min-max标准化(所有值落在0~1范围,新数据=(原数据-最⼩值)/(最⼤值-最⼩值)),也可以应⽤z-score 标准化(新数据=(原数据-均值)/标准差)。

对于名义变量(表⽰类别),可以进⾏哑变量编码,其中1表⽰⼀个类别,0表⽰其它类别,对于n个类别的名义变量,可以⽤n-1个特征进⾏哑变量编码,⽐如(⾼,中,低),可以⽤⾼、中两类的哑变量表⽰这三类(⾼:1是,0 其它,中:1是,0,其它)优点:简单且有效,对数据分布没有要求,训练阶段很快;缺点:不产⽣模型,在发现特征之间的关系上的能⼒有限,分类阶段很慢,需要⼤量的内存,名义变量和缺失数据需要额外处理R代码:使⽤class包的knn函数,对于测试数据中的每⼀个实例,该函数使⽤欧⽒距离标识k个近邻,然后选出k个近邻中⼤多数所属的那个类,如果票数相等,测试实例会被随机分配。

机器学习中的EM算法详解及R语言实例

机器学习中的EM算法详解及R语言实例EM算法(Expectation-Maximization Algorithm)是一种迭代优化算法,常用于机器学习中的聚类、分类和概率估计等问题。

它的主要思想是通过迭代的方式,同时估计模型参数和隐变量,以求得最优的模型拟合。

EM算法的基本流程如下:1.初始化模型参数。

通常可以通过启发式方法或者随机初始化来确定初始参数。

2. E步:根据当前参数和样本,计算每个样本属于每个类别的概率,或者计算隐变量的后验概率。

这一步被称为"Expectation"(期望)步骤。

3. M步:根据上一步得到的概率估计,更新模型参数。

这一步被称为"Maximization"(最大化)步骤。

4.重复第2步和第3步,直至收敛或达到预定的停止条件。

5.输出最优的模型参数或者隐变量的估计结果。

接下来以一个简单的高斯混合模型为例,使用R语言实现EM算法。

首先,我们需要导入必要的包,并生成一个高斯混合模型的样本数据。

```Rinstall.packages("mixtools")library(mixtools)#生成一个高斯混合模型的样本数据set.seed(123)n<-500#样本数量mu_true <- c(2, 5) # 真实的均值参数sigma_true <- c(1, 1) # 真实的标准差参数weight_true <- c(0.4, 0.6) # 真实的混合权重参数```接下来,我们可以使用EM算法来估计高斯混合模型的参数。

```R#初始化参数mu <- c(0, 0) # 均值参数的初始化sigma <- c(1, 1) # 标准差参数的初始化weight <- c(0.5, 0.5) # 混合权重参数的初始化#EM算法的迭代过程tolerance <- 1e-6 # 定义停止条件,当参数变化小于该值时停止迭代log_likelihood <- -Inf # 定义对数似然函数的初始值,用于判断是否收敛while (TRUE)#E步:计算每个样本属于每个类别的概率posterior <- dnorm(data, mean = mu[1], sd = sigma[1]) * weight[1] # 第一个组件posterior <- cbind(posterior, dnorm(data, mean = mu[2], sd = sigma[2]) * weight[2]) # 第二个组件posterior <- posterior / rowSums(posterior) # 归一化#M步:更新参数mu <- colSums(posterior * data) / colSums(posterior) # 更新均值参数sigma <- sqrt(colSums(posterior * (data - mu)^2) /colSums(posterior)) # 更新标准差参数weight <- colSums(posterior) / n # 更新混合权重参数#计算对数似然函数current_log_likelihood <- sum(log(apply(posterior, 1, sum))) #判断是否收敛if (current_log_likelihood - log_likelihood < tolerance)break # 达到停止条件,停止迭代}log_likelihood <- current_log_likelihood#输出结果cat("估计的均值参数:", mu, "\n")cat("估计的标准差参数:", sigma, "\n")cat("估计的混合权重参数:", weight, "\n")```通过运行上述代码,我们可以得到高斯混合模型的参数估计结果。

r语言与机器学习(分类算法)支持向量机+朴素贝叶斯算法

R语言与机器学习(分类算法)支持向量机说到支持向量机,必须要提到july大神的《支持向量机通俗导论》,个人感觉再怎么写也不可能写得比他更好的了。

这也正如青莲居士见到崔颢的黄鹤楼后也只能叹“此处有景道不得”。

不过我还是打算写写SVM 的基本想法与libSVM中R的接口。

一、SVM的想法回到我们最开始讨论的KNN算法,它占用的内存十分的大,而且需要的运算量也非常大。

那么我们有没有可能找到几个最有代表性的点(即保留较少的点)达到一个可比的效果呢?要回答这个问题,我们首先必须思考如何确定点的代表性?我想关于代表性至少满足这样一个条件:无论非代表性点存在多少,存在与否都不会影响我们的决策结果。

显然如果仍旧使用KNN算法的话,是不会存在训练集的点不是代表点的情况。

那么我们应该选择一个怎样的“距离”满足仅依靠代表点就能得到全体点一致的结果?我们先看下面一个例子:假设我们的训练集分为正例与反例两类,分别用红色的圆圈与蓝色的五角星表示,现在出现了两个未知的案例,也就是图中绿色的方块,我们如何去分类这两个例子呢?在KNN算法中我们考虑的是未知样例与已知的训练样例的平均距离,未知样例与正例和反例的“距离”谁更近,那么他就是对应的分类。

同样是利用距离,我们可以换一个方式去考虑:假设图中的红线是对正例与反例的分类标准(记为w ∙ x+b=0),那么我们的未知样例与红线的“距离”就成了一个表示分类信度的标准,而w ∙ y+b(y为未知样例的数据)的符号则可以看成是分类的标识。

但是遗憾的是我们不知道这样的一条分类标准(分类线)是什么,那么我们一个比较自然的想法就是从已知的分类数据(训练集)里找到离分割线最近的点,确保他们离分割面尽可能的远。

这样我们的分类器会更稳健一些。

从上面的例子来看,虚线穿过的样例便是离分割线最近的点,这样的点可能是不唯一的,因为分割线并不确定,下图中黑线穿过的训练样例也满足这个要求:所以“他们离分割面尽可能的远”这个要求就十分重要了,他告诉我们一个稳健的超平面是红线而不是看上去也能分离数据的黄线。

《R语言入门》课件

VS

详细描述

描述性统计分析包括计算数据的均值、中 位数、众数、标准差等统计指标,以及制 作数据的频数分布表和直方图等可视化图 表,帮助我们了解数据的分布情况和基本 特征。

推断性统计分析

总结词

推断性统计分析是通过样本数据来推断总体特征和规律的方法。

详细描述

推断性统计分析包括参数估计和假设检验等统计方法,通过样本数据来估计总体参数和检验假设,帮 助我们了解总体的情况和规律。

01

数据处理与可视化

数据导入与导

数据导入

R语言支持多种格式的数据导入, 包括CSV、Excel、SQL数据库等 。可以使用`readr`、`tidyverse` 等包来导入数据。

数据导出

R语言可以将处理后的数据导出为 多种格式,如CSV、Excel、PDF 等。可以使用`writexl`、`officer` 等包来实现数据的导出。

01

R语言基础

R语言的安装与配置

总结词

R语言的安装与配置是学习R语言的第一步,需要了解如何下载和安装R语言,以及如何 配置R语言的环境。

详细描述

首先,您需要从CRAN(Comprehensive R Archive Network)上下载适合您操作系 统的R语言安装程序。然后,按照安装向导的指示进行操作,并确保在安装过程中选择 正确的组件和设置。安装完成后,您需要配置环境变量,以便在命令行中运行R语言。

学习如何通过脚本调用外部程序和命令,以及如 何将外部程序的输出作为R的数据源。

3

数据转换和格式化

掌握如何在不同编程语言之间转换和格式化数据 ,以确保数据的一致性和可比较性。

感谢观看

THANKS

THE FIRST LESSON OF THE SCHOOL YEAR

r 语言入门与实践

r 语言入门与实践R语言是一种广泛应用于数据分析和统计建模的编程语言。

它的设计初衷是为了提供一个易于学习和使用的工具,以支持数据科学家和统计学家的工作。

本文将介绍R语言的入门知识和实践应用。

我们来了解一下R语言的基本特点和优势。

R语言是一种免费的开源软件,拥有庞大的社区支持和丰富的扩展包。

它可以在各种操作系统上运行,并且可以与其他编程语言(如Python和Java)进行交互。

由于R语言专注于数据分析和统计建模,它提供了许多强大的统计函数和图形绘制工具,使得数据分析变得更加简单和高效。

要使用R语言进行数据分析,首先需要了解基本的语法和数据结构。

R语言支持向量、矩阵、数组、列表和数据框等数据结构,可以方便地存储和操作数据。

此外,R语言还提供了丰富的数据处理和转换函数,使得数据的清洗和整理变得更加容易。

在R语言中,可以使用赋值操作符将数据存储在变量中,并使用逻辑运算符和条件语句进行数据筛选和处理。

在R语言中,数据可视化是一项重要的任务。

R语言提供了多种绘图函数和图形库,可以绘制各种类型的图表,如散点图、折线图、柱状图、饼图等。

通过数据可视化,可以直观地展示数据的分布、趋势和关系,帮助我们更好地理解数据和发现规律。

除了基本的数据分析和可视化功能,R语言还支持各种统计建模和机器学习算法。

R语言提供了许多统计函数和包,可以进行回归分析、分类和聚类等常见的统计任务。

此外,R语言还集成了机器学习库,如caret和mlr,可以进行复杂的机器学习模型训练和评估。

在实际应用中,R语言被广泛用于各个行业和领域。

例如,在金融领域,R语言可以用于风险管理、投资组合优化和金融模型建立。

在医疗领域,R语言可以用于临床试验分析和疾病预测。

在市场营销领域,R语言可以用于客户细分、推荐系统和营销模型构建。

总之,R语言的应用领域非常广泛,几乎涵盖了所有需要进行数据分析和建模的领域。

要学习和掌握R语言,可以通过多种途径。

首先,可以参考R语言的官方文档和教程,了解R语言的基本语法和函数。

利用R语言进行的机器学习算法实践与优化

利用R语言进行的机器学习算法实践与优化机器学习算法在当今信息时代发挥着越来越重要的作用,它们被广泛应用于各个领域,如金融、医疗、电商等。

R语言作为一种专门用于数据分析和可视化的编程语言,提供了丰富的机器学习算法库,使得我们可以利用R语言进行机器学习算法的实践与优化。

1. 机器学习算法概述机器学习算法可以分为监督学习、无监督学习和强化学习三大类。

监督学习是指从有标签数据中学习模型,常见的算法包括线性回归、逻辑回归、决策树、随机森林等;无监督学习是指从无标签数据中学习模型,常见的算法包括聚类、降维、关联规则等;强化学习是指智能体通过与环境的交互来学习最优策略,常见的算法包括Q-learning、Deep Q Network等。

2. R语言在机器学习中的应用R语言作为一种开源且功能强大的数据分析工具,拥有丰富的机器学习算法库,如caret、randomForest、xgboost等。

通过这些库,我们可以快速构建并优化各种机器学习模型。

2.1 监督学习在监督学习中,我们通常需要将数据集划分为训练集和测试集,并使用训练集训练模型,再通过测试集评估模型性能。

利用R语言中的caret包可以方便地实现这一过程,并通过交叉验证等方法选择最佳模型参数。

2.2 无监督学习无监督学习常用于聚类和降维任务。

在R语言中,我们可以使用cluster包进行K均值聚类、层次聚类等操作;使用factoextra包进行主成分分析(PCA)等降维操作。

2.3 强化学习强化学习在R语言中也有相应的实现,如RLearn包提供了Q-learning等经典强化学习算法的实现。

通过这些包,我们可以在R语言环境下进行强化学习模型的构建和优化。

3. 机器学习算法优化在实践过程中,我们常常需要对机器学习算法进行优化以提高模型性能。

常见的优化方法包括特征工程、超参数调优、模型融合等。

3.1 特征工程特征工程是指对原始数据进行处理以提取更有价值的特征。

在R语言中,我们可以使用dplyr和tidyr等包进行数据清洗和特征构建,提高模型对数据的表达能力。

r语言bootstrap案例

r语言bootstrap案例R语言中的bootstrap是一种统计学中常用的重抽样技术,它可以用来估计统计量的抽样分布或者用来进行假设检验。

下面我会从多个角度来介绍R语言中的bootstrap案例。

首先,让我们来看一个简单的R语言中的bootstrap案例。

假设我们有一组数据,我们想要估计这组数据的均值的置信区间。

我们可以使用bootstrap方法来实现这一点。

首先,我们可以使用boot包中的boot()函数来进行bootstrap抽样,然后计算均值,并最终得到置信区间。

其次,我们可以考虑一个更复杂的案例,比如在线性回归中使用bootstrap。

在这种情况下,我们可以使用boot包来进行自助法重抽样,然后在每个重抽样数据集上拟合线性回归模型,并获取回归系数的置信区间。

这可以帮助我们评估线性回归模型参数的不确定性。

此外,bootstrap方法还可以用于比较两组数据的差异。

例如,我们可以使用bootstrap方法来计算两组样本的均值差异的置信区间,从而进行假设检验,判断这两组数据的均值是否有显著差异。

另外一个常见的应用是在机器学习中,比如在随机森林算法中,bootstrap方法被用来生成不同的训练数据集,以训练多个决策树模型,然后汇总它们的预测结果来降低过拟合风险。

总之,R语言中的bootstrap方法可以在统计学、机器学习和数据分析等领域中得到广泛应用,通过对原始数据进行重抽样来估计统计量的抽样分布、参数的置信区间以及进行假设检验。

希望这些案例能够帮助你更好地理解R语言中bootstrap的应用。

R语言的特性及其在数学建模中的应用探究

R语言的特性及其在数学建模中的应用探究R语言是一种开源的编程语言和软件环境,主要用于统计分析、数据可视化和数据挖掘。

它具有丰富的数据处理和分析功能,同时还有一个强大的社区支持和活跃的开发者群体。

R语言被广泛应用于统计学、生物医学、金融和其他领域的数据分析和数学建模中。

本文将探讨R语言的特性以及它在数学建模中的应用。

R语言的特性R语言是一种功能强大的语言,具有许多特性使其成为数据分析和数学建模的首选工具。

以下是R语言的一些主要特性:1. 开源免费:R语言是开源的,用户可以免费获取和使用。

这使得R语言成为了许多学术研究和商业项目中的首选工具,因为用户可以自由地使用和修改R语言的代码。

2. 统计分析功能:R语言拥有丰富的数据处理和统计分析功能,包括线性回归、方差分析、非参数统计等。

这些功能使得R语言成为了统计学家和数据分析师的首选工具。

3. 数据可视化:R语言具有强大的数据可视化功能,用户可以通过绘制直方图、散点图、饼图等图表来展现数据的特征和分布。

这使得用户可以更直观地理解数据,从而更好地进行模型建模和分析。

4. 多种扩展包:R语言有丰富的扩展包(packages),用户可以通过安装这些扩展包来获得更多的功能和工具,比如文本挖掘、机器学习、生物信息学等。

5. 脚本编程:R语言可以通过编写脚本来进行数据分析和数学建模,用户可以通过编写脚本来批量处理数据、自动化分析过程以及搭建分析工作流程。

R语言在数学建模中的应用R语言由于其丰富的数据处理和统计分析功能,以及强大的数据可视化能力,被广泛应用于数学建模领域。

下面将介绍R语言在数学建模中的应用案例。

1. 线性回归分析线性回归是一种常见的统计分析方法,它用于研究因变量和自变量之间的线性关系。

R语言提供了丰富的线性回归分析功能,用户可以通过内置函数lm()来进行线性回归模型的拟合和参数估计,并通过绘制散点图、拟合直线等方法来展现回归模型的拟合效果。

2. 时间序列分析时间序列分析是研究时间序列数据的统计方法,用于分析时间序列数据的趋势、季节性、周期性等特征。

R语言机器学习交叉验证

R语⾔机器学习交叉验证在机器学习⾥,通常来说我们不能将全部⽤于数据训练模型,否则我们将没有数据集对该模型进⾏验证,从⽽评估我们的模型的预测效果。

为了解决这⼀问题,有如下常⽤的⽅法:1.The Validation Set Approach第⼀种是最简单的,也是很容易就想到的。

我们可以把整个数据集分成两部分,⼀部分⽤于训练,⼀部分⽤于验证,这也就是我们经常提到的训练集(training set)和测试集(test set)。

例如,如上图所⽰,我们可以将蓝⾊部分的数据作为训练集(包含7、22、13等数据),将右侧的数据作为测试集(包含91等),这样通过在蓝⾊的训练集上训练模型,在测试集上观察不同模型不同参数对应的MSE的⼤⼩,就可以合适选择模型和参数了。

不过,这个简单的⽅法存在两个弊端。

1.最终模型与参数的选取将极⼤程度依赖于你对训练集和测试集的划分⽅法。

什么意思呢?我们再看⼀张图:右边是⼗种不同的训练集和测试集划分⽅法得到的test MSE,可以看到,在不同的划分⽅法下,test MSE的变动是很⼤的,⽽且对应的最优degree也不⼀样。

所以如果我们的训练集和测试集的划分⽅法不够好,很有可能⽆法选择到最好的模型与参数。

2.该⽅法只⽤了部分数据进⾏模型的训练我们都知道,当⽤于模型训练的数据量越⼤时,训练出来的模型通常效果会越好。

所以训练集和测试集的划分意味着我们⽆法充分利⽤我们⼿头已有的数据,所以得到的模型效果也会受到⼀定的影响。

基于这样的背景,有⼈就提出了Cross-Validation⽅法,也就是交叉验证。

2.Cross-Validation2.1 LOOCV⾸先,我们先介绍LOOCV⽅法,即(Leave-one-out cross-validation)。

像Test set approach⼀样,LOOCV⽅法也包含将数据集分为训练集和测试集这⼀步骤。

但是不同的是,我们现在只⽤⼀个数据作为测试集,其他的数据都作为训练集,并将此步骤重复N次(N为数据集的数据数量)。

r语言二分类案例

在R语言中,二分类问题是非常常见的机器学习任务。

下面我将给出一个使用R语言进行二分类的案例。

假设我们有一个数据集,其中包含了一些观察值和对应的标签,标签只有两种可能的取值,即0和1。

我们的目标是训练一个模型,能够根据观察值预测出标签的取值。

首先,我们需要加载必要的R包,例如caret和e1071,这些包提供了一些用于二分类的算法和函数。

Rinstall.packages("caret")install.packages("e1071")library(caret)library(e1071)接下来,我们加载数据集。

这里我们使用read.csv函数从CSV文件中读取数据。

Rdata <- read.csv("your_data.csv")然后,我们将数据集分为训练集和测试集。

这里我们使用createDataPartition函数将数据随机分成两部分,其中70%用于训练,30%用于测试。

Rset.seed(123) # 设置随机数种子以确保结果可复现trainIndex <- createDataPartition(data$label, p = 0.7, list = FALSE) # 70%样本作为训练集trainData <- data[trainIndex, ] # 训练数据testData <- data[-trainIndex, ] # 测试数据现在我们可以开始训练模型了。

这里我们使用支持向量机(SVM)算法进行二分类。

svm函数来自e1071包,可以用于训练SVM模型。

Rset.seed(123) # 设置随机数种子以确保结果可复现svmModel <- svm(label ~ ., data = trainData, kernel = "linear", cost = 1, scale = FALSE) # 训练SVM模型训练完成后,我们可以使用测试集来评估模型的性能。

r语言 鸢尾花案例

r语言鸢尾花案例鸢尾花案例是一个经典的机器学习问题,也是R语言中常用的数据分析案例之一。

在本文中,我们将使用R语言对鸢尾花数据集进行分析和建模。

鸢尾花数据集包含了150个样本,每个样本有4个特征:花萼长度、花萼宽度、花瓣长度和花瓣宽度。

每个样本还有一个标签,表示鸢尾花的种类。

接下来,我们将按照以下步骤进行分析:1. 导入数据集:首先,我们需要导入鸢尾花数据集。

R语言提供了许多函数和包来导入数据集,例如使用`read.csv()`函数导入csv文件或使用`read.table()`函数导入文本文件。

2. 数据预处理:在进行数据分析之前,我们需要对数据进行预处理。

这包括数据清洗、缺失值处理、数据标准化等步骤。

在本例中,鸢尾花数据集已经经过了预处理,所以我们可以直接进行下一步。

3. 数据可视化:数据可视化是数据分析的重要环节。

通过绘制散点图、箱线图、直方图等,我们可以更好地理解数据的分布和特征之间的关系。

在本例中,我们可以绘制花萼长度和花萼宽度的散点图,以及花瓣长度和花瓣宽度的散点图,来观察不同种类的鸢尾花在这些特征上的分布情况。

4. 特征选择:特征选择是机器学习中的一个重要步骤,它可以帮助我们选择对目标变量有最大预测能力的特征。

常用的特征选择方法包括相关系数分析、方差分析、互信息等。

在本例中,我们可以使用相关系数分析来选择与鸢尾花种类相关性最高的特征。

5. 数据建模:在进行数据建模之前,我们需要将数据集划分为训练集和测试集。

常用的划分方法包括随机划分和交叉验证。

然后,我们可以使用机器学习算法对训练集进行训练,例如逻辑回归、决策树、支持向量机等。

最后,我们可以使用测试集评估模型的性能,并进行模型优化。

6. 模型评估:模型评估是判断模型好坏的重要指标。

常用的评估指标包括准确率、精确率、召回率、F1值等。

在本例中,我们可以使用混淆矩阵来计算这些评估指标。

7. 模型解释:在模型建立之后,我们可以对模型进行解释,以便更好地理解模型的预测能力。

r语言 鸢尾花案例

r语言鸢尾花案例鸢尾花案例是一个经典的数据集,常用于机器学习和数据分析的教学和实践中。

该数据集包含了150个样本,分为三类鸢尾花(Setosa、Versicolor和Virginica),每类鸢尾花各有50个样本。

每个样本有四个特征:花萼长度、花萼宽度、花瓣长度和花瓣宽度。

在R语言中,我们可以使用以下步骤对鸢尾花数据集进行分析和可视化:1. 导入数据集:使用`dataset <- iris`命令将鸢尾花数据集导入到R中。

2. 查看数据集:使用`head(dataset)`命令可以查看数据集的前几行,以了解数据的结构和内容。

3. 数据统计信息:使用`summary(dataset)`命令可以查看数据集的统计信息,包括每个特征的均值、标准差、最小值、最大值等。

4. 数据可视化:使用`ggplot2`包可以对数据集进行可视化。

例如,使用`ggplot(dataset, aes(x = Sepal.Length, y = Sepal.Width, color = Species)) + geom_point()`命令可以绘制花萼长度和花萼宽度之间的散点图,不同类别的鸢尾花用不同颜色表示。

5. 特征相关性:使用`cor(dataset[, 1:4])`命令可以计算数据集中各个特征之间的相关系数,进一步分析特征之间的关系。

6. 数据预处理:对于机器学习算法,通常需要对数据进行预处理。

例如,使用`scale(dataset[, 1:4])`命令可以对数据进行标准化处理,使每个特征的均值为0,标准差为1。

7. 数据划分:为了进行模型训练和测试,通常需要将数据集划分为训练集和测试集。

使用`createDataPartition(dataset$Species, p = 0.7, list = FALSE)`命令可以将数据集按照一定比例划分为训练集和测试集。

8. 模型建立:可以使用各种机器学习算法对鸢尾花数据集进行建模。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(4)

·‚BŒ±í Ñ

©Ù•µ

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

n

f (θ|Y ) ∝

i=1

e (wx1 +(1−w )x2 −µ)/σ 1 + e (wx1 +(1−w )x2 −µ)/σ 1 1 + e (wx1 +(1−w )x2 −µ)/σ

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

[~f

êâ )g©ÙF (x) = . x

)100‡‘Åê. ·‚ ½KŠα = 0.7, K÷vF (x) > α IP•aO1§ÄK IP•aO2.

exp( z−µ ) σ 1+exp( z−µ ) σ

\þÑlN(0, 0.1) ‘ÅØ

{0 [~f

~1 ~2

[(J

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

Deng, Lin and Qian (2012)

The Lasso (Tibshirani,1996) ÏÙ 5§´˜«š~61 C þÀJ•{. •ÄXe . Y = XTβ + ε (9) Ù¥X = (X1 , . . . , Xp )T ´˜‡p ‘‘Å•þ, Y ´•A, β ´£ 8Xê, ε Ñl"þŠ§• •σ 2 ©Ù ‘ÅØ . ‰ ½n × p O X Ú•AŠy, Lasso .‚KF)Œ± ¤µ ˆ β = arg minβ (y − Xβ)T (y − Xβ) + λ||β||l1 (10)

ü‡ÄuR

{0 [~f

ÅìÆS Á

OÐ&

China R Conference

Ïœð, HmŒÆ

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

1

{0 Á O{²0 Á OXÛA^ ÄuR [~f

ÅìÆS¥º

2

ü‡ÄuR ~1 ~2

[~f

China R Conference

{0 [~f

~1 ~2

Table: The summary of ν for Case 2 1st.Quant Median Mean 3rd.Quant IID RLHD NOLHD NOMLHD 0.2135 0.1458 0.0833 0.1354 0.3438 0.4638 0.1562 0.3104 0.1042 0.1778 0.2083 0.2083 0.7656 0.5052 0.2031 0.4688 max|ρij | 0.4595441 0.4853301 0.01195678 0.3153421

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

•{üP, -p = 2, ½Âz = wx1 + (1 − w )x2 , Ù¥w ´˜‡ Š[0, 1]ƒm ˜ -. dž§k F (x|θ) = e (z−µ)/σ , 1 + e (z−u)/σ ©a>.•: (2)

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

CþÀJ °(ÝŒ±^†ÀÇ5ïþ, P•ν. -A(β) = {j : βj = 0, j = 1, . . . , p}, K ˆ ¯ ˆ ¯ p × ν = {j : j ∈ A(β) but j ∈A(β)} + {j : j ∈ A(β) but j ∈A(β)} (11)

{0 [~f

~1 ~2

ALSD

3S“ng , ·‚®² OÑ5

ž ©a>.Xe: α )}, 1−α (7)

lα,n = {wn x1 + (1 − wn )x2 = µ + σ log( ˆ ˆ ˆ ˆ

Tkn = {(x 1 , Y1 ), . . . , (x n , Yn )}. e5§·‚F"3Tun ÀJe˜ ‡:˜\Ôö8. ·‚lTun ÀÑk0 ‡ê⊕ÿÀ§ù ÿÀ êâ À ±‚Clα,n •IO.

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

ƒcX Ñ´{ü‘ÅÄ . © Ä Œ±U? O°Ý´ ¯¤±• . McKay et al. (1979) .¶‡á•NÄ (LHS), Tü ÑŒ±ÀŠ3¤kCþþÓž?1© Ä .

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

Á O{²0 Á OXÛA^ ÄuR [~f

ÅìÆS¥º

rÅìÆSw¤‰Á

ÅìÆS¥¦^ êâ§

Ø´lÁ ¥

"

´§êâI‡©•Ôö8Úuÿ8" ·‚Œ±|^Á O5Ïé ˜‡•Ð Ôö8"XJ· ‚ O Ч@oÅìÆS•¬•k ½ö•O(" , §3éõ¢S œ¹e§Ôöêâ•AŠ ¼ Ñp[¤ " ´‡G

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

˜ k ·‚òù ÿÀ êâP•x 1 , . . . , x˜0 . , UìXe•{l¥ ÀJ˜‡êâ: ˆ x n+1 = arg maxx∈{x˜1 ,...,x˜0 } det(I (θn , x)) k ˆ Ù¥I (θ, x) ´3:x? Xê Fisher&E . (8)

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

Deng et al. (2009) JASA

-X = (X1 , . . . , Xp )T •Ïf•þ. •AP•Y . Y Ñl ‘© Ù. P(Y = 1|x0 ) = F (x0 ) ´x0 :? Y = 1 VÇ. ·‚Œ±½ ÂY²•α ©a>.: lα (x) = {x : F (x) = α} ·‚F"UÏLÔöêâ5 Olα . (1)

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

Á O{²0 Á OXÛA^ ÄuR [~f

ÅìÆS¥º

R¥' Ø% Á Package FrF2 Package rsm Package lhs

O •µ

Package AlgDesign

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

[(J

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

[(J

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

THANK YOU ANY QUESTION???

China R Conference

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

Á O{²0 Á OXÛA^ ÄuR [~f

ÅìÆS¥º

e5 Ü©§ò¦^ü‡ÄuR {" •Ÿo^Rº 3Rp§·Ué A ·¤I‡ š~a COSØ §4·Æ

[~f5

yþã Ž

Ü" éõ"

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

Á O{²0 Á OXÛA^ ÄuR [~f

ÅìÆS¥º

Ÿo´Á

O?

R. A. Fisher•Ð3àXÁ •¡ óŠC½ Ð.

Ïf O u

Ô §‘Xzó1’ uЧÁ O•×„uÐ"Ïm JÑ S0 OgŽ^±››Á êþ§±››¤ " ‘X£8 . uЧÄu . •` OÚ•A-¡ O •ÅìuÐå5" ‡ Ú O uЧ÷v ó’¥^ þÁ 5&¢lŒþ Ïf¥çÀ-‡Ïf I¦" OŽÅÁ uЧíÄ ˜mW¿ O£•)þ! OÚ .¶‡á•N O¤ uÐ"

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

I‡ •:numDeriv The complete code will not share here. If you are interested, you can contact me later.

China R Conference

China R Conference

ÅìÆS Á

OÐ&

ü‡ÄuR

{0 [~f

~1 ~2

¤I•: lars,lhs Gendex software is also needed Also refer to .hk/UniformDesign/