StorNext FS安装指南

stornext安装文档

区域服务部培训教材——文件系统StorNext FS系统项目支持部区域服务部2009年6月第1章StorNext FS概述第1节概述Stornext FS存储管理软件是公司在2006年引进并用于项目中。

主要用于满足大容量的存储管理和访问优化功能。

到目前此产品已使用3年多,已成为各个项目存储管理的必备软件。

其重要性可想而知,Stornext FS文件系统的产品特点、安装配置、性能优化和日常维护是每个项目实施人员必须掌握的技能。

第2节Stornext FS与IBM SANergy的对比在05年及之前的项目,公司一直采用IBM SANergy对存储进行管理,由于其自身的一些缺点不能满足日益增长的业务应用需求,因此退出了历史的舞台。

比较项目StorNext FS SANergy 备注产品本质独立的、跨平台SAN文件系统SAN文件系统外壳程序1.StorNext FS是完全为SAN网络环境设计的文件系统,不依赖于任何现有操作系统中附带的文件系统。

2.SANergy不是一个独立的文件系统,它基于现有文件系统处理硬件,所以它只是一个SAN文件系统外壳软件。

文件系统体系结构64位日志型文件系统,底层文件系统依赖传统的NTFS、UFS、EXT2等。

1.StorNext FS是64位文件系统,可以保证管理巨大的磁盘空间和文件数量,不同类型的主机可以同时以FC Direct I/O方式访问数据,中间不需要任何协议转换。

因此,StorNext FS可以充分利用和发挥SAN体系结构的所有优点,特别是在混合平台、大量主机并发工作环境中优势非常突出。

采用日志型文件系统的设计保证系统的可靠性、健壮性和快速恢复能力2.SANergy采用现有DAS文件系统管理硬件,视MDC主机平台而定(如是Windows就是NTFS、Solaris就是UFS、Linux就是EXT2等)技术依赖其他厂商,在混合平台之间共享数据需要采用NFS协议处理,不能满足混合平台、大量主机并发工作环境中的性能要求。

Stornext安装

FSS 'MediaData' start initiated.

FSS 'MediaData' started.

snadmin> activate MediaData

Activate FSM "MediaData"

Created : Tue Oct 14 05:06:55 2008

CvfsDisk_UNKNOWN /dev/sdb # host 1 lun 1 sectors 41936896 sector_size 512 inquiry [IBM DS400 S320 7.01] serial 0000D12680C3E85C

CvfsDisk_UNKNOWN /dev/sdc # host 1 lun 2 sectors 41936896 sector_size 512 inquiry [IBM DS400 S320 7.01] serial 0000D12680C3E85D

Writing Disk Information Block.

Writing Stripe Group Index "MetaFiles".

Writing Stripe Group Index "JournFiles".

Writing Stripe Group Index "MediaFiles".

/dev/sdc [IBM DS400 S320 7.01] SNFS "MD_MediaData" Sectors: 41936896. SectorSize: 512. Maximum sectors: 41936896.

/dev/sdd [IBM DS400 S320 7.01] SNFS "JR_MediaData" Sectors: 41936896. SectorSize: 512. Maximum sectors: 41936896.

MDS服务器StorNext文件系统标准安装文档资料

第1节文件系统1.1.1Stornext相关概念描述:StorNext中所指的一个文件系统反映在WINDOWS中就是“我的电脑”中看见的一个盘符(如X盘);一个StorNext文件系统由3部分组成:metadata(源数据)卷,journal(日志)卷,data(数据)卷。

每做一个文件系统就需要在盘塔上划分3个独立的卷,以此类推,如果要做两个文件系统(如X,Y)则需要在盘塔上划分6个独立的卷(包括X的data卷,X的metadata卷,X的journal 卷,和Y的data卷,Y的metadata卷,Y的journal卷。

)对于metadata卷的大小建议划为100GB,journal卷的建议大小为100MB,而对于data卷的大小这根据实际情况划分,没有限制。

每100万个数据文件需要配备10GB的Metadata卷空间,可按照这个原理来搭配某存储的metadata卷、journal卷的大小。

目前SOBEY公司平常配置如果metadata 卷和journal卷分配在一起,空间规划为200G左右。

1.1.1.1Windows在安装stornext文件系统之前,需要先把物理链路打通,使得MDS服务器上能够识别到存储的所有需要访问的磁盘。

如下所示:执行安装程序,选择install stornext选择“custom”安装,根据需要选择是否安装服务端与客户端软件,如果是MDS主机,需要同时安装服务端与客户端软件。

安装完成后,进行文件系统的配置。

点击“Configure StorNext”选择“Name Servers”进行文件系统服务端主机的指定把MDS主机或者Name server的IP地址填写进去。

选择“Label Disk Drives”进行存储磁盘的标签工作。

选择physicaDrive1(存储的LUN0),单击Label.根据扇区大小来区分存储磁盘的作用,例如下图所示,physicaDrive1我们想作为X卷存放素材使用,在new disk label处我们标识为data-x便于区分。

StorNext文件系统服务端安装文档(Windows系统Failover)

172.16.51.xx [primary server]

172.16.51.xy [secondary server]

第四步:编辑从服务器上的文件系统自动启动列表文件fslist,来指定文件系统在两台metadata上启动的优先级:

创建和运行文件系统时需要该文件所有的文件系统配置文件必须同时存在于两台mds上因为该配置文件中描述了故障切换时所需要访问的metadata所在的stripegroup的信息

StorNext文件系统服务端安装文档(Windows系统Failover)

StorNext for Windows安装(服务端)

许可协议文件(License文件)

两台metadata服务器上必须都有有效的license.dat文件。

下面是一个如何配置failover的例子

主服务器上(Primary server)

第一步:编辑主服务器上的fsnameservers文件:

# vi /usr/cvfs/config/fsnameservers

snfs1 . 0

该条目中的0表示snfs1这个文件系统缺省先在主服务器启动。The entry for the primary server is 0 by default (highest priority).

从服务器(Secondary Server )

第三步:编辑从服务器上的fsnameservers文件,该文件必须和主服务器上fsnameservers 文件相同:

和的2倍加10)

StorNext的双机(Failover)配置指南

配置双机实现故障切换(failover)功能,需要创建或/并编辑如下文件:

StorNext客户端访问多个MDS服务器的配置

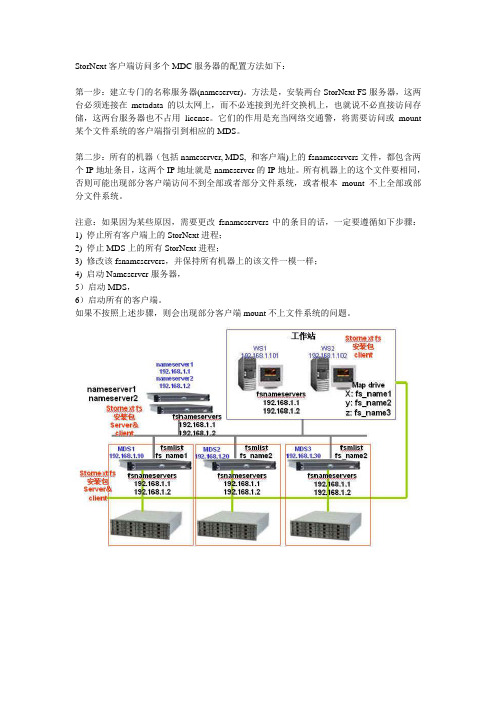

StorNext客户端访问多个MDC服务器的配置方法如下:

第一步:建立专门的名称服务器(nameserver)。

方法是,安装两台StorNext FS服务器,这两台必须连接在metadata的以太网上,而不必连接到光纤交换机上,也就说不必直接访问存储,这两台服务器也不占用license。

它们的作用是充当网络交通警,将需要访问或mount 某个文件系统的客户端指引到相应的MDS。

第二步:所有的机器(包括nameserver, MDS, 和客户端)上的fsnameservers文件,都包含两个IP地址条目,这两个IP地址就是nameserver的IP地址。

所有机器上的这个文件要相同,否则可能出现部分客户端访问不到全部或者部分文件系统,或者根本mount不上全部或部分文件系统。

注意:如果因为某些原因,需要更改fsnameservers中的条目的话,一定要遵循如下步骤:

1) 停止所有客户端上的StorNext进程;

2) 停止MDS上的所有StorNext进程;

3) 修改该fsnameservers,并保持所有机器上的该文件一模一样;

4) 启动Nameserver服务器,

5)启动MDS,

6)启动所有的客户端。

如果不按照上述步骤,则会出现部分客户端mount不上文件系统的问题。

StorNext文件系统客户端安装文档(WINDOWS系统)

StorNext文件系统客户端安装文档

(WINDOWS系统)

1,双击clientforwindows文件夹下的STORNEXT程序setup安装包,出现下图

2,点“next”出现下图

3,点“next”出现下图

4,点“yes”出现下图

5,点“next”出现下图

6,去掉“server files”的勾,点“next”出现下图

7,点“next”出现下图

8,点“next”出现下图

9,点“否”出现下图

10,打上勾点“next”出现下图

要输入,之间用“;”隔开,点“next”出现下图

12,点“next”出现下图

切记!!) 出现下图

14,点“是”出现下图

15,在“file system”下拉菜单中选择要map的文件系统,因为我们在MDS上只做了一个叫x的文件系统,因此处只有一个x,在driver处选择该文件MAP

到本机后所使用的盘符,我们也用X盘,点MAP,出现下图

16,点上面标签处的“mount options”出现下图

次map一个文件系统都要到此出来把勾打上,然后再点“确定”。

出现下图

重起后会在我的电脑中多出一个x盘,双击可以打开则表明正常。

StorNextFS实施环境准备

StorNext FS实施环境准备一、文件系统规划1.与客户讨论创建文件系统(或磁盘)的个数:a)建议每个文件系统包含三种类型的磁盘卷,Metadata卷、Journal卷、Data卷;如无法具备条件,则至少包含两种类型的磁盘卷,Metadata和Journal卷、Data卷。

使得每个文件系统推荐使用单独的Metadata卷和Journal卷用于分别存储Metadata元数据信息和Journal信息;Metadata卷和Journal卷也可以由同一个磁盘卷担当,同时存储Metadata和Journal信息。

2.一个文件系统,相当于一个Unix/Linux的挂载点,或者Windows的一个盘符。

3.在只有一个SNFS元数据服务器的环境中,建议的文件系统个数不超过4个,有两个SNFS元数据服务器中,文件系统个数最多不超过八个。

二、磁盘阵列规划1.规划出哪些文件系统使用哪些磁盘,这些磁盘在服务器中可识别为LUN。

在进行磁盘规划时,需确定哪些用于存储Metadata、Journal数据信息的磁盘LUN,哪些为存储数据Data的磁盘LUN。

根据经验,a)创建的Metadata磁盘LUN容量建议不小于100GB,Journal磁盘LUN容量不小于50GB。

(为提高Metadata和Journal的访问性能,也可创建多条LUN用于存储Metadata和Journal信息。

)b)在一个文件系统中,Data磁盘LUN的大小需是一致的。

c)用于存储数据的Data LUN需为二或四的倍数。

2.RAID组和LUN的划分,需要考虑到性能的负载,最好能分担到不同的磁盘柜或Loop环上。

3.所有的Metadata磁盘和Journal磁盘,必须保证是整个存储中性能最优、安全性最好的磁盘,建议使用Raid1+0实现Metadata数据和Journal数据的存储保护。

建议采用Raid 5实现Data磁盘的保护。

4.LUN的Segment Size确定后在创建LUN,因为会与性能相关。

StorNext FS一般管理指南(中文)

StorNext File System的一般管理本文介绍StorNext File System的一般管理,包括如何使用cvadmin管理控制台,常用的文件(包括配置文件、可执行文件、日志文件等),如何管理和申请license,以及出现问题之后如何联系ADIC的技术支持中心。

更详尽的管理指南,请参见ADIC官方的英文指南。

cvadmin管理控制台SNFS安装部署完毕之后,我们使用服务器上的cvadmin管理控制台对整个SNFS系统进行常规的管理和控制。

在Linux环境下,用户首先要以root身份登陆,运行/usr/cvfs/bin/cvadmin命令,便进入了cvadmin 管理控制台。

如下图:除了直接运行cvadmin命令之外,其后面还可以加上如下选项:-H FSMHostName该命令是连接到某台指定的StorNext FSM的服务器,这里FSMHostName是该服务器的名称或者IP地址。

缺省情况下,cvadmin会试图连接本机的FSM(注1)。

-F FileSystemName该选项自动的将指定的名称为FileSystemName的文件系统设置成active状态。

-f filename可以从文件中读取命令和选项-e command执行命令后退出我们下面介绍进入到cvadmin管理控制台之后,一般的管理命令。

select [<file_system_name> ]选择一个活动的(active)的FSM,之后进行监控或者修改的工作。

who查看被选择了的、活动的文件系统的客户端列表,将显示如下信息:SNFS ID Client identifierType Type of connectionLocation The client’s hostname of ID addressUp Time The time since the client connection was initiatedLicenseExpires The date that the current client license will expireshow [ <groupname> ] [ long ]显示该被选择了的文件系统,groupname选项是显示该文件系统下的某个stripe group组,long选项的意思是显示更为详细的信息。

StorNext FS安装指南知识分享

S t o r N e x t F S安装指南StorNext FS安装指南-1Tags: 存储安装配置, 共享软件, HBA, StorNext, 文件系统StorNext FS 配置(Red Hat Enterprise Linux/x86 AS 4 +win2K)一、环境描述:硬件描述:1. Brocade 39502. S2A 8000(本例中3个LUN,分别为MetaData(30GB)、Journal(100MB)、数据)3. DELL 2650 (内存 2G,建议4G)软件描述:1. Red Hat Enterprise Linux/x86 AS 4 update 1(2.6.9-11)2. StorNext FS Server/Client 软件二、StorNext FS系统配置1.准备工作1.1配置网络# vi /etc/hosts127.0.0.1 localhost.localdomain localhost10.0.5.25 mds1 //这里为两台MDS10.0.5.26 mds21.2 安装Emulex LP8000/982驱动和应用程序安装驱动程序 tar xzf lpfc-<driver version>.tar.gz //解压安装包如:#tar zxvf lpfc_2.6_driver_kit-8.0.16.17-2.tar.gz#cd lpfc_2.6_driver_kit-8.0.16.17-2#./lpfc-install //执行安装脚本#reboot //重起服务器注意:Red Hat Enterprise Linux/x86 4 updata 1 内核中已经加载EmulexLP8000/982驱动,可以不做这一步。

如果在安装驱动程序中,报IO和IRQ参数错,检查Firmware版本,升级为最新的版本。

安装emulex hbanyware应用程序#tar xvf elxlinuxapps-2.1a25-8.0.16.17-1-1.tar#./install //安装emulex hnanyware#/usr/sbin/hbanyware/hbanyware //运行emulex hnanyware,查看WWN,硬件信息。

StorNext安装配置及维护规范

StorNext共享文件系统安装配置及维护规范美国昆腾国际公司北京代表处二零零九年十二月目录1. StorNext共享文件系统实现基础架构及其工作原理 (3)1.1 基于SAN的StorNext共享文件系统架构部署 (3)1.2 基于SAN的StorNext共享文件系统工作原理 (5)1.3 基于SAN&NAS的StorNext共享文件系统架构部署 (7)2. StorNext共享文件系统常用术语 (10)3. StorNext共享文件系统实施规范 (13)3.1 SNFS系统实施规划 (13)3.2 SNFS系统软件安装 (17)3.3 SNFS系统软件配置 (17)4. StorNext共享文件系统运行维护 (19)4.1 SNFS共享文件系统日常维护 (19)4.2 SNFS共享文件系统故障处理 (22)4.2.1 SNFS共享文件系统常见故障 (22)4.2.2 SNFS共享文件系统故障检查及处理步骤 (23)4.2.3 SNFS共享文件系统故障售后处理步骤 (24)4.3 SNFS共享文件系统启动和停止 (25)4.4 SNFS共享文件系统日常维护常用命令 (27)附件1 SNFS标签丢失及修复 (29)附件2 使用cvfsck命令实现文件系统检测 (32)附件3 StorNext产品服务内容及步骤 (37)1. StorNext共享文件系统实现基础架构及共享文件系统实现基础架构及工作原理其工作原理美国昆腾公司的StorNext数据存储管理软件被广泛应用于广电、能源、科学计算、卫星勘测等领域,用于实现数据的虚拟化存储。

StorNext数据存储管理软件包括两部分,一是StorNex File System(StorNext共享文件系统,简称SNFS),用于实现异构SAN或LAN环境下共享文件系统;另一个是StorNext Storage Manager(简称SNSM)迁移管理软件。

StoreNext使用手册

StorNext使用方法说明:StorNext是一款通过打破瓶颈和降低消耗实现数据中心整体性能的提升,并最大限度的简化管理的软件,由客户端和服务端两部分组成;在一台服务器上布置服务端,通过在客户端机器上布置StorNext客户端与服务端相结合使用来管理文件;1 安装StorNext服务端安装步骤略;(目前公司服务端部署的机器IP为192.98.8.51);2 安装StorNext客户端安装步骤略;(由于该客户端版本比较低,本客户端目前只能在server2003、xp下安装部署;客户端地址:\\192.98.15.248\public\soft\StorNext3.5.1 windows客户端)3 开始使用StorNext1)安装完成后,在开始菜单中会创建一个系统程序;如下图:2)点击Name Servers;3)打开StorNext Name Servers界面,在下图1区域输入安装有StorNext服务端机器的IP;点击“Add”,将其添加到左侧窗体中;点击“OK”即可;(若不需要连接该服务端机器,选中IP点击Remove即可;目前公司使用的IP为192.98.8.51)4)在开始菜单中点击“Client Configuration”;5)打开Client Configuration界面;在配置完服务端IP,初次登录功能界面时,在左下方将出现寻找服务端的信息,稍等片刻便会在表格中列出服务端的划分的盘区;6)双击每个盘区,则会弹出让您选择盘符的窗口:7)选择你需要挂的盘符,将需要挂的盘符打对勾;8)然后在Distributed LAN中,选中Enable clie;9)点击“确定”;会弹出“Are you sure want to mount ’StornextN’”;点击“是”10)依次将列表中所有的节点做7、8、9步骤操作;11)然后点击“file>>exit”或者右上角关闭窗口即可;挂完盘后,在资源管理器界面将添加如下几个”盘”12)若不想连接某个节点;则选择某个节点,点击下图红框按钮即可;第一部分总体技术方案4 标题5 标题6 标题第二部分项目实施方案7 标题8 标题9 标题。

stornext安装使用手册

stornext安装使用手册——文件系统StorNext FS系统项目支持部区域服务部2009年6月第1章StorNext FS概述第1节概述Stornext FS存储管理软件是公司在2006年引进并用于项目中。

主要用于满足大容量的存储管理和访问优化功能。

到目前此产品已使用3年多,已成为各个项目存储管理的必备软件。

其重要性可想而知,Stornext FS文件系统的产品特点、安装配置、性能优化和日常维护是每个项目实施人员必须掌握的技能。

第2节Stornext FS与IBM SANergy的对比在05年及之前的项目,公司一直采用IBM SANergy对存储进行管理,由于其自身的一些缺点不能满足日益增长的业务应用需求,因此退出了历史的舞台。

第3节Stornext FS客户端访问文件系统过程在进行此部分的讲解之前,先了解2个名词。

名称服务器(NameServer)和元数据服务器(MDS)。

它们的作用是什么。

名称服务器(NameServer):其作用是充当网络交警,将需要访问或mount某个文件系统的客户端指引到相应的MDS。

它记录了元数据服务器和所管理的文件系统的对应关系。

元数据服务器(MDS):作用是进行文件系统的元数据管理,为SAN环境中每个客户端提供元数据服务的功能(在SAN环境中的客户端只有获取了文件系统正确的元数据信息,才能正常的访问到存放在存储内的数据,这个元数据从管理到提供服务器全是由MDS来完成的,在整个SAN环境中MDS起着至关重要的角色)。

下图为Stornext FS架构图根据上图我们可以很清晰的看到在一个Stornext FS系统中,包含了名称服务器(NameServer)、元数据服务器(MDS)和Stornext 客户端。

在其中名称服务器和元数据服务器可以部署在一起,如标准Nstar方案中,没有单独的名称服务器,MDS既充当了元数据服务器也担当名称服务器的角色。

名称服务器在一个系统中最多使用两台,且两台服务器热备功能,当其中一台出现故障,可以通过另外一台名称服务器提供服务。

Quantum StorNext QD6000 QD7000快速入门安装指南说明书

6-68488-01 Rev A*6-68488-01 Rev AStorNext QD6000/QD7000,Quick Start Setup Guide, 6-68488-01 Rev A, July 2016, Product of USA.©2016 All rights reserved. Quantum, the Quantum logo, DXi, Scalar and StorNext are registered trademarks of Quantum Corporation and its affiliates in the United States and/or other countries. All other trademarks are the property of their respective owners.ii Quick Start Setup GuideAbout this guide NOTE:The Lancaster firmware is used on the E5600, Titan RAID controller, only. Refer to the NetApp to Quantum Naming Decoder section for additional information.This section provides the following information:•Intended audience•Prerequisites•NetApp to Quantum Naming DecoderIntended audienceThis guide is intended for storage customers and technicians.PrerequisitesPrerequisites for installing and using this product include knowledge of:•Servers and computer networks•Network administration•Storage system installation and configuration•Storage area network (SAN) management and direct attach storage (DAS)•Fibre Channel (FC) and Ethernet protocolsAbout this guide iiiiv Quick Start Setup GuideNetApp to Quantum Naming DecoderUse Table 1 to correlate the NetApp product nomenclature to the equivalent Quantum-storage naming conventions.T able 1Product NomenclatureE-Series NetApp ProductQuantum-Storage DescriptionController-Drive Tray Base System Quantum uses Base System when referring to a drive tray with the RAID controllers.Drive TrayExpansion UnitQuantum uses Expansion Unit when referring to a drive tray with the environmental services modules (ESMs).E5600 (Code Name: Titan)RAID controller Four 16Gb/s FC SFP+ host ports E5500 (Code Name: Soyuz)RAID controller Four 16Gb/s FC SFP+ host ports E5400 (Code Name: Pikes Peak)RAID controller Four 8Gb/s FC SFP+ host ports DE6600 (Code Name: Wembley)4U 60-drive enclosure 60 3.5 inch disk drivesE5560 or E5660(DE6600 4U drive enclosure with E5500 or E5600 RAID controllers)Quantum StorNext QD7000E5460(DE6600 4U drive enclosure with E5400 RAID controllers)Quantum StorNext QD6000E5424(DE5600 24-drive 2U driveenclosure (Code Name: Camden) with E5400 RAID controllers)Quantum StorNext QS2400E5412(DE1600 12-drive 2U driveenclosure (Code Name: Ebbets) with E5400 RAID controllers)Quantum StorNext QS1200。

stornext for linux

Lightweight Linux Server Installation/Configuration

本次安装环境为:

一台虚拟机RedHat5

一块2G磁盘做元数据盘和日志盘

两块8G的数据盘

一、修改MDC服务器hosts文件

二、上传安装包文件到服务器上,进行解压

三、解压完毕后默认解压路径是/tmp/stornext,共计3个安装包,分别进行安装

先要安装snfs-common-4.3.3-32779.RedHat50AS.x86_64.rpm

四、在安装目录的config下创建fsnameservers文件,加入DNS的ip地址。

五、Cvlabel 磁盘,

六、通过cvlabel创建配置文件进行修改

七、修改配置文件

注意:系统共计四块磁盘,第一块为系统盘,不能做任何修改

第2、3、4块磁盘进行自定义修改,这里元数据盘是日志盘为同一磁盘

八、修改完毕配置文件后,进行label

九、Label完毕,启动cvfs服务

十、对cvfs文件系统进行配置,通过以下命令进行

这个配置文件是个模板,需要进行自定义修改。

十一、主要修改位置为,磁盘类型:disktype,

其中sectors和sectorsize大小要根据cvlabel的磁盘实际大小相同

以下为根据具体的环境进行的修改,参考如下:

十二、修改完配置文件,进行创建cvfs文件系统,通过以下命令操作

十三、编辑fsmlist文件,添加创建的文件系统

# vi /usr/cvfs/config/fsmlist

添加fs

十四、启动文件系统

十五、修改自动挂载配置

手动挂载、查看状态。

STORNEXT SNFS V4.7.2 安装配置手册

文档信息:目录1背景描述 (4)2SNFS4.7.2 的重要变更说明 (4)3安装环境 (4)4安装前的准备 (5)4.1软件准备 (5)4.2SNFS4.7.2MDS及客户端操作系统支持 (5)4.3关于FC和以太网络连接 (5)4.4关于多链路的问题 (5)4.5关于SNFS文件系统的结构说明 (6)4.6关于磁盘阵列划分 (6)4.7文件系统规划 (7)4.8操作系统的安装 (8)4.8.1MDS操作系统的安装 (8)4.8.2客户端操作系统的安装 (8)5安装流程 (9)6安装步骤 (9)6.1操作系统相关配置(必配) (9)6.2安装SNFS MDS端程序 (13)6.3创建文件系统 (19)6.3.1文件系统及Label信息规划 (19)6.3.2Label磁盘 (19)6.3.3新建文件系统 (22)6.3.4激活文件系统 (32)6.4配置MDS间的HA (37)6.5主备MDS的L ICENSE更新 (39)6.6安装SNFS SAN客户端程序 (42)6.6.1安装前提 (42)6.6.2安装软件 (42)6.6.3配置fsnameservers (45)6.6.4挂载文件系统 (47)6.6.5验证文件系统 (50)7系统维护 (51)7.1系统LABEL信息备份 (51)7.2系统管理 (51)7.2.1查看文件系统状态:cvadmin (51)7.2.2维护中需要查看哪些MDS日志 (53)7.2.3关于在SNFS客户端(Windows client)上增加日志输出的选项 (53)附录一:STORNEXT操作系统兼容列表 (55)1 背景描述在广播电视行业中,视音频存储网络往往采用SAN 架构。

在网络架构下,为了实现存储资源的共享使用,需要安装共享文件系统软件。

Quantum 公司的SNFS 软件产品就是一款性能出色,适合广电行业使用的SAN 共享文件系统产品。

SNFS 软件目前已经更新到了4.7的版本,软件界面和操作方法发生了部分变更,本文旨在规范大洋工程师在系统项目中对SNFS V4.7.x 的安装及维护等操作。

StorNext FS 3.1Windows(MDS and Client)安装与配置手册

StorNext File System 3.1For Windows MDS and Client(本版本服务器不支持Windows Server 2003以下操作系统)安装与配置手册北京中科大洋科技发展股份有限公司编写者:朱明俊广东08奥运项目组2008年7月目录1 安装前的准备 (3)2 安装SN MDS服务器(主备相同,不分先后) (4)3 配置SN MDS(主)服务器 (7)4 配置SN MDS(备)服务器 (17)5 主备SN MDS授权的更新 (18)6 站点安装SN CLIENT (19)6 使用Sanergy测速(本节危险,择情安装) (20)1 安装前的准备安装前,先简单介绍一下StorNext(以下简称SN)文件系统。

SN文件系统,是由多个某操作系统能识别的最大卷(对于32位的windows就是2TB,或者比较大的卷),组合成Stripe Group,再由实现不同功能的Stripe Group组合在一起的文件系统。

一个SN文件系统,对于SN的客户端来说,就是一块可以本地连接的本地硬盘。

一个SN 文件系统,需要由3种Stripe Group构成,分别是META、JOURNAL、DATA。

META Stripe Group最小应具备一个不小于100GB的LUN;JOURNAL Stripe Group最小应具备一个不小于50GB的LUN;DA TA Stripe Group所包含的LUN最好一样大,最好不大于2TB,且数目最好是2或4的倍数。

一般,一个SN文件系统将由1个META Stripe Group,1个JOURNAL Stripe Group和多个DATA Stripe Group构成。

可根据具体项目所需访问带宽,安全系数,维护难度等纬度来设计。

1.确保MDS及各站点已经能够访问磁盘阵列映射出的所有LUN(可在磁盘管理或者设备管理器的磁盘驱动器中仔细查验,如果是EMC2的阵列,由于其没有XP站点的PowerPath软件,所以要让XP的站点能够正常的看到双倍的LUN。

stornext实施规范

stornext实施规范Stornext实施文档目录Stornext实施文档 (1)1、功能描述: (1)2、典型实施环境: (2)2.1、拓扑结构图: (2)2.2、关于SNFS 文件系统的结构说明 (3)2.3、关于磁盘阵列的规划: (3)3、安装实施: (4)3.1、安装准备: (4)3.2、安装和配置snfs文件系统 (4)3.2.1、在MDC上安装stornext server软件 (4)3.2.2、Label磁盘 (8)3.2.3、创建文件系统 (9)3.2.4、激活文件系统 (13)3.2.5、挂载snfs文件系统 (14)5、一些简单的维护操作 (17)5.1、查看所有客户端情况: (17)5.2、license的导入: (17)1、功能描述:Quantum File System (简称SNFS)是一款高性能的共享文件系统,其可以实现SAN 网络架构下,多主机对同一文件系统的协同工作。

其他特点还有:1、支持异构平台:MS Windows ,Redhat Linux,Suse Linux ,SUN Solaris,IBM AIX;2、支持将多条LUN 绑定成一个大容量文件系统,单个文件系统容量可以超过2TB;3、DLC(Distributed LAN Client) 功能:支持将部分SAN 客户端升级成NAS 网关服务器,为部分站点提供NAS 方式的访问。

4、元数据服务器支持HA 高可用,并可调用脚本实现对服务器的关机和重启操作。

2、典型实施环境:2.1、拓扑结构图:2.2、关于SNFS 文件系统的结构说明文件系统要建立多个StripeGroup, Metadata 和Journal 可以合并为1个StripeGroup,一个StripeGroup 内部可以包含1 个或多个LUN,同一个StripeGroup 内相当于RAID0 的条带化,但该方案下的文件系统安全性较低,一旦某条LUN 损坏,整个文件系统的数据将丢失。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

StorNext FS安装指南-1Tags: 存储安装配置, 共享软件, HBA, StorNext, 文件系统StorNext FS 配置(Red Hat Enterprise Linux/x86 AS 4 +win2K)一、环境描述:硬件描述:1. Brocade 39502. S2A 8000(本例中3个LUN,分别为MetaData(30GB)、Journal(100MB)、数据)3. DELL 2650 (内存 2G,建议4G)软件描述:1. Red Hat Enterprise Linux/x86 AS 4 update 1(2.6.9-11)2. StorNext FS Server/Client 软件二、StorNext FS系统配置1.准备工作1.1配置网络# vi /etc/hosts127.0.0.1 localhost.localdomain localhost10.0.5.25 mds1 //这里为两台MDS10.0.5.26 mds21.2 安装Emulex LP8000/982驱动和应用程序安装驱动程序 tar xzf lpfc-<driver version>.tar.gz //解压安装包如:#tar zxvf lpfc_2.6_driver_kit-8.0.16.17-2.tar.gz#cd lpfc_2.6_driver_kit-8.0.16.17-2#./lpfc-install //执行安装脚本#reboot //重起服务器注意:Red Hat Enterprise Linux/x86 4 updata 1 内核中已经加载Emulex LP8000/982驱动,可以不做这一步。

如果在安装驱动程序中,报IO和IRQ参数错,检查Firmware版本,升级为最新的版本。

安装emulex hbanyware应用程序#tar xvf elxlinuxapps-2.1a25-8.0.16.17-1-1.tar#./install //安装emulex hnanyware#/usr/sbin/hbanyware/hbanyware //运行emulex hnanyware,查看WWN,硬件信息。

注意:需要使用emulex hnanyware时需要安装lpfc_2.6_driver_kit-8.0.16.17-2.tar.gz程序,而linux 系统自带的LPFC的驱动不能被emulex hnanyware所以识别。

1.3 效验HBA卡加载。

通过cat /proc/scsi/scsi 命令查看HBA卡检测到的磁盘信息如:# cat /proc/scsi/scsiHost: scsi0 Channel: 00 Id: 06 Lun: 00Vendor: PE/PV M odel: 1×5 SCSI BP Rev: 1.1Type: Processor ANSI SCSI revision: 02Host: scsi2 Channel: 00 Id: 00 Lun: 03Vendor: DDN Model: S2A 8000 Rev: 5.02Type: Direct-Access ANSI SCSI revision: 03Host: scsi2 Channel: 00 Id: 00 Lun: 08Vendor: DDN Model: S2A 8000 Rev: 5.02Type: Direct-Access ANSI SCSI revision: 031.4 效验SCSI、RAID、HBA卡加载顺序——–此步骤在redhat AS 4以后的版本中,不需要做。

下面的例子是redhat as 3 update4如果SCSI、RAID卡的加载在HBA卡后面。

不然在本地SCSI系统盘的SWAP分区,不可用。

如下#cat /etc/module.confalias scsi_hostadapter lpfc // Emulex HBAalias scsi_hostadapter1 aic7xxx //scsi卡alias usb-controller usb-ohcioptions scsi_mod max_scsi_luns=256 scsi_allow_ghost_devices=1需要将加载顺序改变,如alias scsi_hostadapter1 aic7xxx //scsi卡alias scsi_hostadapter2 lpfc // Emulex HBAalias usb-controller usb-ohcioptions scsi_mod max_scsi_luns=256 scsi_allow_ghost_devices=1重建内核# cd /boot# mv initrd-2.4.21-27.ELsmp.img initrd-2.4.21-27.ELsmp.img.ori# mkinitrd initrd-2.4.21-27.ELsmp.img 2.4.21-27.ELsmp# sync# reboot2.安装StorNext FS2.1以root用户登录Linux,插入StorNext FS CD#cd /mnt/cdrom如果CDROM没有被mounted,那么执行#mount /dev/cdrom /mnt# cd /mnt/cdrom/StorNextFS/linux //此路径根据实际情况而定#uname -a查看当前系统内核的版本。

如:uname -aLinux mds01 2.6.9-11.ELsmp #1 SMP Fri May 20 18:26:27 EDT 2005 i686 i686 i386 GNU/Linux# rpm -ivh snfs-server_RH_AS_4_269-2.6.3-32.i386.rpm# rpm –ivh snfs-client_RH_AS_4_269-2.6.3-32.i386.rpm注意,在linux上服务器上必须安装Server和client两个软件。

2.2 修改环境变量#vi /etc/profile# Path manipulationif [ `id -u` = 0 ]; thenpathmunge /usr/cvfs/binfiulimit -S -c 0 > /dev/null 2 > &1ulimit -c unlimited > /dev/null 2 >&1注销root用户,重新以root用户登陆系统,才能使环境变量起作用2.3 磁盘Label2.3.1 查看盘阵信息,执行fdisk -l如: # fdisk –lDisk /dev/sdc (Sun disk label): 0 heads, 0 sectors, 52221 cylindersUnits = cylinders of 1 * 512 bytesDevice Flag Start End Blocks Id System/dev/sdc3 u 0 -872571904 -436285952 5 Whole diskNote: sector size is 2048 (not 512)Disk /dev/sdg (Sun disk label): 0 heads, 0 sectors, 959 cylindersUnits = cylinders of 1 * 512 bytesDevice Flag Start End Blocks Id System/dev/sdg3 u 0 62902272 31451136 5 Whole diskDisk /dev/sdl (Sun disk label): 0 heads, 0 sectors, 2 cylindersUnits = cylinders of 1 * 512 bytesDevice Flag Start End Blocks Id System/dev/sdl3 u 0 192512 96256 5 Whole disk2.1查看disk Label#/usr/cvfs/bin/cvlabel –l/dev/sdc [DDN S2A 8000 5.02] CVFS ” unknown ” Sectors: 3422394368.SectorSize: 1024. Maximum sectors: 3422394368./dev/sdg [DDN S2A 8000 5.02] CVFS ” unknown ” Sectors: 62900224.SectorSize: 512. Maximum sectors: 62900224./dev/sdl [DDN S2A 8000 5.02] CVFS ” unknown ” Sectors: 190464. SectorSize: 512. Maximum sectors: 190464.2.2 编辑disk Label配置文件# /usr/cvfs/bin/cvlabel -c > /usr/cvfs/config/cvlabels//将cvlabel输出到cvlabels配置文件中# vi /usr/cvfs/config/cvlabels将unkown更改为H_Upload,MD_H_Upload, JR_H_Upload。

等,如本例中:H_Upload /dev/sdc # host 0 lun 0 sectors 3422394368 sector_size 1024 inquiry [DDN S2A 8000 5.02] serial 60001FF020021101030197FECD180000MD_H_Upload /dev/sdg # host 0 lun 4 sectors 62900224 sector_size 512 inquiry [DDN S2A 8000 5.02] serial 60001FF0200211010301932703C00400JR_H_Upload /dev/sdl # host 0 lun 9 sectors 190464 sector_size 512 inquiry [DDN S2A 8000 5.02] serial 60001FF020021101030194A7000309002.3 disk Label# /usr/cvfs/bin/cvlabel /usr/cvfs/config/cvlabels*WARNING* This program will over-write volume labels on thedevices specified in the file “/usr/cvfs/config/cvlabels”.After execution, the devices will only be usable by theCentraVision File System. You will have to re-partition thedevices to use them on a different file system.Do you want to proceed? (Y / N ) -> y/dev/sdc [DN S2A 8000 5.02] CVFS ” unknown ” Sectors: 3422394368.Do you want to label it SNFS - Name: H_Upload Sectors: 3422394368? (Y / N ) ->y New Volume Label -Device: /dev/sda SNFS Label: H_Upload Sectors: 3422394368./dev/sdg [DN S2A 8000 5.02] CVFS ” unknown ” Sectors: 62900224.Do you want to label it SNFS - Name: MD_H_Upload Sectors: 62900224? (Y / N ) ->yNew Volume Label -Device: /dev/sdb SNFS Label: MD_H_Upload Sectors: 62900224./dev/sdl [DN S2A 8000 5.02] CVFS ” unknown ” Sectors: 190464.Do you want to label it SNFS - Name: JR_H_Upload Sectors: 190464? (Y / N ) ->y New Volume Label -Device: /dev/sdb SNFS Label: JR_H_Upload Sectors: 190464.Done. 3 source lines. 3 labels.3. 配置StorNext FS3.1创建StorNext FS文件系统的配置文件,若查看参数信息,键入#man -M /usr/cvfs/man cvfs_config# cd /usr/cvfs/config#cp .. /examples/example.cfg ./H_Upload.cfg //例程中拷贝出文件系统的配置文件# vi /usr/cvfs/config/H_Upload.cfgGlobalSuperUser Yes ## Must be set to Yes for SNMS Managed File Systems ## WindowsSecurity NoQuotas NoFileLocks NoDataMigration No ## SNMS Managed File Systems Only ##InodeExpandMin 32KInodeExpandInc 128KInodeExpandMax 8MFsBlockSize 4KJournalSize 4MAllocationStrategy RoundMaxConnections 78 //该数为一般设为客户数加+10ForceStripeAlignment YesDebug 0×0MaxLogSize 4MMaxLogs 4## Globals DefaultedThreadPoolSize 32 # default 16, 512 KB memory per threadInodeCacheSize 32K # 800-1000 bytes each, default 8K# BufferCacheSize 64M # default 32MB# StripeAlignSize 2M # auto alignment, default MAX(StripeBreadth)# MaxMBPerClientReserve 50 # in MBs, default 100 MB reserved per client# OpHangLimitSecs 300 # default 180 secs# DataMigrationThreadPoolSize 128 # Managed only, default 8#************************************************************# A disktype section for defining disk hardware parameters.#************************************************************[DiskType MD_H_Upload] ##1+1 Raid 1 Mirrored Pair##Sectors 62900224 ## Sectors Per Disk From Command “cvlabel -l”SectorSize 512[DiskType JR_H_Upload] ##1+1 Raid 1 Mirrored Pair##Sectors 190464SectorSize 512[DiskType H_Upload] ##4+1 Raid 5 Lun for Regular Data##Sectors 3422394368SectorSize 1024 //这里的1024与盘塔上该LUN的Block Size 相一致。