RH436-6 Advanced RAID

HP服务器进行RAID设置具体方法详解

1、使用惠普服务器集成的Smart P410i控制器hp服务器中有一个集成的磁盘阵列控制器,通过它可以配置服务器中的磁盘组成RAID,使系统中存储的数据更安全可靠。

我们可以如下操作使RAID(关于raid什么意思可参考/tech/tech_354.html一文):卡可用。

首先在服务器启动过程中,出现“Press to enter SETUP”提示时,按F2键进入SETUP,修改服务器的BIOS设置。

在服务器的BIOS设置界面中,选择“User Preferences”项,确认“Integrated HP NetRAID”所对应的内容为“Enabled”,并且把它的下一级选项“Included SCSI_A Channel”设为“Yes”,即把磁盘阵列控制器设为可用,并把服务器上的SCSI A通道包括在磁盘阵列控制器中。

按F10键保存设置并退出BIOS,重新启动服务器。

接着在服务器重新启动过程中,出现“Option:Experienced users may press for HP NetRAID Express Tools Now.”时,按Ctrl+M组合键进入HP NetRAID快速配置工具。

在“Tools Management Menu”菜单下,选择“Configure → Clear Configuration”,清除原先的配置,如以前没有配置RAID,则会出现“No Existing Configuration to Clea r” 的提示;如系统配置了RAID,则提示“Clear Configuration?”,选择“Yes”清除配置。

按“Esc”键返回配置菜单,选择“New Configuration”,对“Proceed?” 回答“Yes”,服务器会开始查找磁盘,查找结束后,所有找到的磁盘会在“New Configuration-ARRAY SELECTION MENU”菜单下显示为“READY”就绪状态此时依次按空格键选中要添加到阵列中的磁盘,显示为“ONLIN”在线状态,选中所有的磁盘后,按回车键结束阵列的选择;再按回车键进入“Logical Drives Configured”菜单,选择RAID的级别,阵列容量的大小,以及修改“Advanced Menu”高级菜单中的条带容量(Stripe Size),写入策略(Write Policy),读取策略(Read Policy)和高速缓存策略(Cache Policy)选项,它们的默认值为“Stripe Size=64KB”,“Write Policy=WRTHRU”,“Read Policy=ADAPTIVE”和“Cache Policy=CachedIO”,用户可以根据所使用服务器的具体情况进行设置。

技嘉AMD RAID 安装指南说明书

AMD RAID Installation Guide1. AMD BIOS RAID Installation Guide (2)1.1 Introduction to RAID (2)1.2 RAID Configurations Precautions (4)1.3 UEFI RAID Configuration (6)2. AMD Windows RAID Installation Guide (19)2.1 Create a RAID volume under Windows (19)2.2 Delete a RAID array under Windows. (26)1.AMD BIOS RAID Installation GuideThe BIOS screenshots in this guide are for reference only and may differ from the exact settings for your motherboard. The actual setup options you will see shall depend on the motherboard youpurchase. Please refer to the product specification page of the model you are using for information on RAID support. Because the motherboard specifications and the BIOS software might be updated, the content of this documentation will be subject to change without notice.AMD BIOS RAID Installation Guide is an instruction for you to configure RAID functions by using the onboard FastBuild BIOS utility under BIOS environment. After you make a SATA driver diskette, press [F2] or [Del] to enter BIOS setup to set the option to RAID mode by following the detailed instruction of the “User Manual” in our support CD, then you can start to use the onboard RAID Option ROM Utility to configure RAID.1.1 Introduction to RAIDThe term “RAID” stands for “Redundant Array of Independent Disks”, which is a method combining two or more hard disk drives into one logical unit. For optimal performance, please install identical drives of the same model and capacity when creating a RAID set.RAID 0 (Data Striping)RAID 0 is called data striping that optimizes two identical hard disk drives to read and write data in parallel, interleaved stacks. It will improve data access and storage since it will double the data transfer rate of a single disk alone while the two hard disks perform the same work as a single drive but at a sustained data transfer rate.WARNING!!Although RAID 0 function can improve the access performance, it does not provide any fault tolerance. Hot-Plug any HDDs of the RAID 0 Disk will cause data damage or data loss.RAID 1 (Data Mirroring)RAID 1 is called data mirroring that copies and maintains an identical image of data from one drive to a second drive. It provides data protection and increases fault tolerance to the entire system since the disk array management software will direct all applications to the surviving drive as it contains a complete copy of the data in the other drive if one drive fails.3RAID 5 (Block Striping with Distributed Parity)RAID 5 stripes data and distributes parity information across the physical drives along with the data blocks. This organization increases performance by accessing multiple physical drives simultaneously for each operation, as well as fault tolerance by providing parity data. In the event of a physical drive failure, data can be re-calculated by the RAID system based on the remaining data and the parity information. RAID 5 makes efficient use of hard drives and is the most versatile RAID Level. It works well for file, database, application and web servers.RAID 10 (Stripe Mirroring) RAID 0 drives can be mirrored using RAID 1 techniques, resulting in a RAID 10 solution for improved performance plus resiliency. The controller combines the performance of data striping (RAID 0) and the fault tolerance of disk mirroring (RAID 1). Data is striped across multiple drives and duplicated on another set of drives.41.2 RAID Configurations Precautions1.Please use two new drives if you are creating a RAID 0 (striping) array for performance. It isrecommended to use two SATA drives of the same size. If you use two drives of different sizes, the smaller capacity hard disk will be the base storage size for each drive. For example, if one hard disk has an 80GB storage capacity and the other hard disk has 60GB, the maximum storage capacity for the 80GB-drive becomes 60GB, and the total storage capacity for this RAID 0 set is 120GB.2.You may use two new drives, or use an existing drive and a new drive to create a RAID 1 (mirroring)array for data protection (the new drive must be of the same size or larger than the existing drive). If you use two drives of different sizes, the smaller capacity hard disk will be the base storage size. For example, if one hard disk has an 80GB storage capacity and the other hard disk has 60GB, the maximum storage capacity for the RAID 1 set is 60GB.3.Please verify the status of your hard disks before you set up your new RAID array.WARNING!!Please backup your data first before you create RAID functions. In the process you create RAID, the system will ask if you want to “Clear Disk Data” or not. It is recommended to select “Yes”, and then your future data building will operate under a clean environment.1.3 UEFI RAID ConfigurationSetting up a RAID array using UEFI Setup Utility and installing WindowsSTEP 1: Set up UEFI and create a RAID array1.While the system is booting, press [F2] or [Del] key to enter UEFI setup utility.2.Go to Advanced\Storage Configuration.3.Set “SATA Controller(s)” to <RAID>.4.Go to Advanced\AMD PBS and set “NVMe RAID mode” to <Enabled >.5.Go to Boot\CSM and set “CSM” to <Disabled>.6.Press [F10] to save your changes and exit, and then enter the UEFI Setup again.7.After saving the previously changed settings via [F10] and rebooting the system, the “RAIDXpert2Configuration Utility” submenu becomes available.8.Go to Advanced\RAIDXpert2 Configuration Utility\Array Management, and then delete the existing diskarrays before creating a new array.Even if you have not configured any RAID array yet, you might have to use “Delete Array” first.9.Go to Advanced\RAIDXpert2 Configuration Utility\Array Management\Create Array9A. Select “RAID Level”9B. Select “Select Physical Disks”.9C. Change “Select Media Type” to “SSD” or leave at “BOTH”.9D. Select “Check All” or enable specific drives that you want to use in the array. Then select “Apply Changes”.9E. Select “Create Array”.10.Press [F10] to save to exit.*Please note that the UEFI screenshots shown in this installation guide are for reference only. Please refer to ASRock’s website for details about each model.https:///index.aspSTEP 2: Download driver from ASRock's websiteA.Please download the “SATA Floppy Image” driver from ASRock's website(https:///index.asp) and unzip the file to your USB flash drive.Normally you can also use the RAID driver offered via the AMD website.STEP 3: Windows installationInsert the USB drive with Windows 10 installation files. Then restart the system. While the system is booting, please press [F11] to open the boot menu that is shown in this picture. It should list the USB drive as a UEFI device. Please select this to boot from. If the system restarts at this point, then please open the [F11] boot menu again.1.When the disk selection page shows up during the Windows installation process, please click <LoadDriver>. Do not try to delete or create any partition at this point.2.Click <Browse> to find the driver on your USB flash drive. Three drivers must be loaded. This is the first.The folder names might look different depending on the driver package that you are using.3.Select “AMD-RAID Bottom Device” and then click <Next>.4.Load the second driver.5.Select “AMD-RAID Controller” and then click <Next>.6.After the second driver is loaded, the RAID disk will show up. Please do not forget to load the thirddriver.7.Select “AMD-RAID Config Device” and then click <Next>.8.Select unallocated space and then click <Next>.9.Please follow the Windows installation instructions to finish the process.10.After the Windows installation is finished, please install the drivers from ASRock’s website.https:///index.asp11.Go to Boot menu and set “Boot Option #1” to <Windows Boot Manager (AMD-RAID)>.2. AMD Windows RAID Installation GuideCaution:This chapter describes how to configure a RAID volume under Windows. You can use for the following scenarios:1.Windows is installed on a2.5” or3.5” SATA SSD or HDD. You want to configure a RAID volume withNVMe M.2 SSDs.2.Windows is installed on an NVMe M.2 SSD. You want to configure a RAID volume with 2.5” or3.5”SATA SSDs or HDDs.2.1 Create a RAID volume under Windows1.Enter the UEFI Setup Utility by pressing <F2> or <Del> right after you power on the computer.2.Set the “SATA Controller(s)” option to <RAID>. (If you are using NVMe SSDs for RAID configuration,please skip this step)3.Go to Advanced\AMD PBS and set “NVMe RAID mode” to <Enabled >. (If you are using 2.5” or 3.5” SATAdrives for RAID configuration, please skip this step)4.Press “F10” to save the setting and reboot to Windows.5.Install the “AMD RAID Installer” from the AMD website:https:///en/supportSelect “Chipsets”, select your socket and chipset, and click “Submit”.Please find “AMD RAID Installer”.6.After installing the “AMD RAID Installer”, please launch “RAIDXpert2” as administrator.57.Find “Array” in the menu and click on “Create”.8.Select the RAID type, the disks which would like to use for RAID, volume capacity and then create theRAID array.9.In Windows open “Disk Management”. You will be prompted to initialize the disk. Please select “GPT”and click “OK”.10.Right click at the “Unallocated” section of the disk and create a new simple volume.11.Follow the “New Simple Volume Wizard” to create a new volume.12.Wait a bit for the system to create the volume.13.After creating the volume the RAID is available to use.2.2 Delete a RAID array under Windows.1.Select the array which you would like to delete.2.Find “Array” in the menu and click on “Delete”.3.Click “Yes” to confirm.。

解析RAID6:最新的冗余技术

解析RAID6:最新的冗余技术【简介】即使是通过三块以上硬盘建立的RAID5磁盘阵列也不能百分之百的保证数据的安全,当同时有两块硬盘出现问题时部分数据还是会损坏的。

因此为了进一步提高数据的安全级别,保证工作硬盘在同时损坏两块的情况下还可以保证数据不丢失,RAID6这种技术应运而生,而今天我们也将为各位IT168的读者介绍RAID6的一些基本情况并给大家推荐几款不错的RAID6存储产品。

第 2 页第 3 页众所周知服务器上的数据是珍贵的,而这些宝贵数据的保护工作是通过硬盘的冗余技术实现的,在以往的配置过程中我们依据数据的安全级别和当前服务器硬件配置两个条件来选择冗余技术的级别,从最简单的RAID0到RAID1,从中级冗余技术RAID3到RAID5。

然而即使是通过三块以上硬盘建立的RAID5磁盘阵列也不能百分之百的保证数据的安全,当同时有两块硬盘出现问题时部分数据还是会损坏的。

因此为了进一步提高数据的安全级别,保证工作硬盘在同时损坏两块的情况下还可以保证数据不丢失,RAID6这种技术应运而生,而今天我们也将为各位IT168的读者介绍RAID6的一些基本情况并给大家推荐几款不错的RAID6存储产品。

一、RAID6的前世今生:RAID6属于RAID磁盘冗余技术的最新标准。

在了解他之前首先要对RAID家族中的其他成员信息有所掌握。

RAID将普通硬盘组成一个磁盘阵列,在主机写入数据,RAID控制器把主机要写入的数据分解为多个数据块,然后并行写入磁盘阵列;主机读取数据时,RAID控制器并行读取分散在磁盘阵列中各个硬盘上的数据,把它们重新组合后提供给主机。

由于采用并行读写操作,从而提高了存储系统的存取系统的存取速度。

另外这种将数据平均分配在各个磁盘上的方法也避免了数据的大量损坏,再结合校验和冗余技术就可以保证一定的数据安全性。

RAID可分为级别0到级别6,通常称为RAID0,RAID1,RAID2,RAID3,RAID4,RAID5,RAID6。

AMD RAID 安裝指南说明书

AMD RAID 安裝指南1. AMD BIOS RAID 安裝指南 (2)1.1 RAID 簡介 (2)1.2 RAID 組態預防措施 (4)1.3 傳統 RAID ROM 組態(適用於 AMD X470、B450、X370、B350及 A320 晶片組) (5)1.4 UEFI RAID 組態(適用於 AMD X399、X470、B450、X370、B350及 A320 晶片組) (11)2. AMD Windows RAID 安裝指南 (16)1. AMD BIOS RAID 安裝指南AMD BIOS RAID 安裝指南係在說明如何藉由使用板載FastBuild BIOS utility,在 BIOS 環境下設定 RAID 功能。

製作 SATA 驅動程式磁片後,按下<F2> 或 <Del>進入BIOS設定,然後依照支援光碟所含「使用手冊」的詳細說明進行,之後即可開始使用板載 RAID 選項 ROM 公用程式設定 RAID。

1.1 RAID 簡介「RAID」是「獨立磁碟容錯陣列」的縮寫,是一種將兩顆以上硬碟組成一個邏輯單元的方法。

為達到最佳效能,請在建立 RAID 磁碟組時,安裝相同型號與容量的硬碟。

RAID 0(資料等量分配)RAID 0 是一資料等量分配技術,可最佳化兩顆相同的硬碟,以讀寫平行、交錯式堆疊中的資料。

此作法將可使單一磁碟的資料傳輸速率加倍,同時兩硬碟還可作為單一磁碟機,以持續的資料傳輸速率運作,進而提升資料存取及儲存效能。

警告!儘管 RAID 0 功能可提升存取效能,但並未提供任何容錯機制。

若熱插拔任何 RAID 0 磁碟的硬碟,將導致資料損壞或遺失。

RAID 1(資料映射)RAID 1 為資料映射技術,可將一顆磁碟機的資料映像複製至第二顆磁碟機,並維持相同的資料映像。

由於正常運行的磁碟機包含另一顆磁碟機內完整的資料複本,因此,若有一顆磁碟機故障,磁碟陣列管理軟體就會將所有應用程式引導至正常運行的磁碟機,因而提供了資料保護功能,並增進整部系統的容錯機制。

RH436-1数据管理、存储及集群技术概述

数据管理、存储及集群技术概述一、数据1.数据的分类1.1.用户数据:用户数据的保护比系统数据更具有挑战性,用户数据的丢失或泄露则是致命的,比如银行业务1.2.系统数据:系统数据丢失了并不会造成企业真正的损失1.3.应用数据:应用数据在企业中是最不能轻视的,大量攻击都是通过系统上应用的漏洞来开展的2.数据可用性2.1.哪些数据必需保证高可用2.2.注意数据的生命周期:分类存储(打包归档还是直接存储)2.3.数据的访问方法和频率:是只读的还是可读写的?是应用程序的数据,还是可以直接访问的数据?是一个网络配置文件,还是为为了安全的配置?2.4.应用程序的“data starved”数据饥饿:不应该是数据跟不上来,而应该是程序跟不上2.5.所有的一切都要防止单点故障(SPOF:single points of failur)3.规划设计3.1. 数据越少要求越小3.2. 减小复杂性3.3. 增加灵活性3.4. 保证数据的完整性二、集群集群是有一组计算机来共同完成一件比较复杂的事情。

1.集群的目标1.1. HPC(High Performance):高性能集群,追求性能,大型的运算,1.2. HA(High Availability):高可用,追求稳定,主要是为了防止单点故障,为了实现的是24小时不间断的工作,并不要求有多快1.3. LBC(Load Balancing):负载均衡集群,基本不用(现大多数利用硬件LBC设备)2.redhat的cluster products2.1. RHCS(Redhat cluster suite):红帽集群套件,在RHEL5的AP版自带的2.2. GFS(Global File system):全局文件系统,GFS支持并发写入。

是一个集群级的文件系统。

2.3. CLVM (Clusterd logical volume manager):集群级的逻辑卷,的LVM只是单机版的逻辑卷,在一个节点做了LVM,只能在这个节点看到。

RH436-5 devicemapper和多路径

Device Mapper1.用于生成一个逻辑设备到物理设备的映射平台2.支持将多个存储设备组合成一个虚拟设备3.使用Device Mapper的应用程序:LVM2Multipathing4.管理mapper设备:create,remove5.利用mapping tables生成设备文件6.可在线调整7.通过block设备生成DM设备8.支持堆积(如:raid10)9.DM模块是可动态加载的模块:(device-mapper.rpm安装包后会自动加载该模块)DM-multipath的功能:1.故障的切换和恢复2.IO流量的负载均衡3.磁盘的虚拟化DM Table1.通过DM table来生成逻辑设备2.描述了物理设备到逻辑设备的每一个扇区映射的关系3.DM Table的行格式1.逻辑设备的起始扇区2.逻辑设备的扇区数(size)3.创建逻辑设备的类型4.创建逻辑设备的参数mapping table实例:1. 0 1024 linear /dev/sda 204 1024 512 linear /dev/sdb 766 1536 128 linear /dev/sdc 0#将逻辑设备0~1023扇区、1024~1535扇区以及1536~1663三个地址范围分别以线形映射的方式映射到/dev/sda设备第204号扇区、/dev/sdb设备第766号扇区和/dev/sdc设备的第0号扇区开始的区域2. 0 2048 striped 2 64 /dev/sda 1024 /dev/sdb 0#将逻辑设备从0号扇区开始的,长度为2048个扇区的段以条带的方式映射的到/dev/sda设备的第1024号扇区以及/dev/sdb设备的第0号扇区开始的区域。

同时告诉内核这个条带类型的target driver存在2个条带设备与逻辑设备做映射,并且条带的大小是64个扇区,使得驱动可以该值来拆分跨设备的IO请求。

3. 0 4711 mirror core 2 64 nosync 2 /dev/sda 2048 /dev/sdb 1024#将逻辑设备从0号扇区开始的,长度为4711个扇区的段以镜像的方式映射到/dev/sda设备的第2048个扇区以及/dev/sdb设备的第1024号扇区开始的区域。

图解硬盘阵列的软配置

图解硬盘阵列的软配置磁盘阵列是服务器存储的常用技术之一。

在服务器栏目以往的专题中,我们详细描述过服务器磁盘阵列的各种级别的概念(《RAID完全手册》),也介绍过各种专业的磁盘阵列产品及其厂商(《RAID产品大阅兵》),也介绍过对于磁盘阵列的各种模式可靠度的定量计算方法(《磁盘阵列可靠度的计算》及其《补遗》)。

在这篇文章里,我们以HP服务器为例,详细的图解在HP 服务器上配置磁盘阵列的过程。

具体涉及到的问题有:•选择磁盘配置方式,阵列或非阵列•配置阵列(以四个硬盘做Raid 5为例)•更改 RAID 配置•RAID 10,30,50 配置•手动Rebuild(重建)•再线扩容希望以上介绍可以作为对磁盘阵列配置不太熟的网管人员的一个STEP BY STEP的例程,也希望能让大家了解RAID管理大概包含的一些常规工作任务。

文中提到的产品可在下面找到相关资料连接。

•HP NetRaid卡•HP LH3/LH4服务器•HP LH6000服务器•HP LH3000服务器RAID完全手册RAID是“独立磁盘冗余阵列”(最初为“廉价磁盘冗余阵列”)的缩略语,1987年由Patterson,Gibson和Katz在加州大学伯克利分院的一篇文章中定义。

RAID阵列技术允许将一系列磁盘分组,以实现提高可用性的目的,并提供为实现数据保护而必需的数据冗余,有时还有改善性能的作用。

随着计算机技术的快速发展,RAID已经从高端服务器市场日益步入寻常百姓家。

但当我们接触到RAID的时候,常会被RAID的各种级别搞得眼花?乱。

各种RAID级别有什么特殊的含义?我们怎样选择RAID级别?请关注以下的文章……RAID级别可以通过软件或硬件实现。

许多但不是全部网络操作系统支持的RAID级别至少要达到5级,RAID 10、30和50只有在磁盘阵列控制器控制下才能实现。

基于软件的RAID需要使用主机CPU周期和系统内存,从而增加了系统开销,直接影响系统的性能。

万全服务器的RAID组建步骤全服务器+板载RAID配置方

万全服务器板载RAID(集成LSI MEGA RAID )配置方法适用于以下机型的板载sata RAID 配置:在系统POST(自检)过程中,当出现“Press Ctrl-M to run LSI Logic Embedded SATA RAID Setup Utility”时按Ctrl+M(部分机型为 Ctrl+E)进入SATA RAID经管工具界面注: 如果自检时没有该提示,可以在进bios下main 或boot 菜单中的找到quiet boot,将其设置为disabled,禁用开机lenovo logo 查看。

Configure-(配置阵列)注意:对阵列以及硬盘操作可能会导致数据丢失,请在做任何操作之前,确认您的数据已经妥善备份!new configuration.(新建配置)-:选此项创建阵列时,将删除原先存在的阵列信息,配置时可以选择阵列级别、容量和条带大小view/add Configuration(查看或添加阵列):显示、调整已有阵列配置,或增加阵列。

clear configuration(清除阵列):清除现存阵列Specify Boot Drive(选择阵列启动顺序):设置阵列的引导顺序这里我们推荐使用view/add Configuration,选择此项按回车键后出现以下配置界面,这里,我们以创建raid 1为例:选择两块显示为ready 硬盘,分别敲击空格后,可以看到两块ready的硬盘已经变成ONLIN 的状态,见下图:接下来连续敲击两下回车键,弹出跨度选择的对话框:敲击一下空格,出现span-1按f10弹出raid配置选择菜单此时光标处已经为RAID= 1,如果要创建其他raid级别,可以在此处敲击回车选择,在RAID菜单的下面, Size 为阵列容量选择项,默认为最大值。

在选择完阵列级别和容量后,将光标移动到Accept后,敲击两下回车键,提示Save Configuration,选择Yes回车保存,至此RAID 1阵列创建完成。

曙光服务器硬盘阵列

曙光服务器硬盘阵列配置文档一、配置任务:将曙光服务器的6块硬盘(每块大小为300G)做成阵列RAID5二、配置结果:配置完RAID5后磁盘大小为三、详细参数产品名称:曙光L840-G10详细配置:E5-4607V2*4 4颗型号为E5-4670的Inter至强CPU16G DDR3 1600*8 8根频率为1600MHZ的DDR3内存条300G_10K_6G*3 3块传输速度为6Gb/s、接口类型为SAS、容量为300G、10000转速为10000转/min、大小为3英寸的硬盘S E 1G RAID 8PD 阵列卡SLIM DVDRW_SATA SATA接口的可读写光驱参数信息:基本参数产品类型企业级产品类别机架式产品结构4U处理器CPU类型Intel 至强E5-4600CPU型号Xeon E5-4607CPU频率标配CPU数量4颗最大CPU数量4颗制程工艺32nm三级缓存12MBCPU核心六核(Sandy Bridge-EP)CPU线程数12线程主板芯片组Intel C602扩展槽4×PCI-E x16内存类型DDR3 1600MHz内存容量32GB内存插槽数量32最大内存容量1TB硬盘接口类型SAS标配硬盘容量300GB硬盘描述8块英寸SAS硬盘内部硬盘架数最大支持8块寸SAS/SATA硬盘RAID模式RAID 0,1,5,6散热系统3组(6个)热拔插冗余风扇模块系统支持Windows Server 2008 R2 SP1 64bitRedHat Enterprise Linux 6U2 64bit SUSE Linux Enterprise Server 11 SP2 64bit电源性能电源类型单电源电源数量4个电源电压220V/50Hz电源功率1000W外观特征产品尺寸712×448×176mm产品重量50kg适用环境工作温度10℃-35℃工作湿度35%-80% RH储存温度-40℃-55℃储存湿度20%-93% RH四、服务器阵列设置:1、在启动服务器时当自检到如下界面时,按CTRL+H进入WEBBIOS2、进入WEBBIOS界面,选择Configuration Wizard(配置向导)选项,查看硬盘信息3、进入硬盘配置向导选项,点击Clear Configuration(清除所有配置)4、点击Next(下一步),系统提示‘你确定要清除配置吗’点击yes,清除所有配置5、界面跳转回配置向导选项中,点击New Configuration(新的配置),点击Next6、系统提示,‘你确定清除配置吗’点击yes,清除并新建配置7、点击Manual Configuration(手动配置)选项,然后Next8、查看并选择驱动组所需要的磁盘9、点击ADD To Array选择所有驱动器到磁盘驱动组中,点击Next10、选择array with free space(自由空间列阵)项中的’Drive Group:,0,Hole:0,R0,R1,R5,’点击Next11、确认选择,点击Next12、点击Next13、所选阵列为RAID 5 在Select Size项中输入所选阵列磁盘大小,输入,单位TB,点击Next14、系统提示‘你确定你要选择直写模式’点击yes15、系统跳转到RAID5配置界面,点击Next16、查看磁盘与虚拟光驱,点击Accept(接受)17、提示‘是否保存这些配置’,选择yes18、系统提示,‘在新的虚拟硬盘上所有的数据都将丢失,是否初始化’选择yes,初始化硬盘19、配置成功,跳转设置完成界面四、硬盘阵列RAID5的作用RAID5:将奇偶校验位平均分布在各个磁盘中,若任意损坏一张磁盘,可通过奇偶校验位和其他磁盘数据将其算出优点:浪费空间小利用率高、建设成本低缺点:读取数据的速度比对单个磁盘进行写入稍慢,只允许一块硬盘容错实用范围:数据库服务器、WEB、Email、域网服务器RAID1:一种镜像磁盘阵列,将一块硬盘数据以相同位置指向另一块硬盘位置,最大限度的保证用户数据的可用性和可修复性。

曙光DS800-G35系列磁盘阵列用户手册V1.0

3

分支电路负载过高在某些情况下可能导致火灾和电击危险。为避免这些危险,请确保系统电气要求未超出分支电路 保护要求。请参阅设备随附的信息以了解电气规范。

在通电的服务器内部进行操作

服务器通电时,释放到服务器内部组件的静电可能导致服务器异常中止,这可能会造成数据丢失。要避免出现这一 潜在问题,在通电的服务器内部进行操作时,请始终使用静电释放腕带或其他接地系统。服务器(某些型号)支持 热插拔设备,并且设计为在服务器开启及外盖卸下时可安全运行。对开启的服务器内部进行操作时,请遵守以下准 则。

对于您在本产品之外使用本产品随机提供的软件,或在本产品上使用非随机软件或经曙光公司认证推荐使用的专用 软件之外的其他软件,曙光公司对其可靠性不做任何保证。

曙光公司已经对本手册进行了仔细的校勘和核对, 但不能保证本手册完全没有任何错误和疏漏。 为更好地提供服务, 曙光公司可能会对本手册中描述的产品软件和硬件及本手册的内容随时进行改进或更改,恕不另行通知。如果您在 使用过程中发现本产品的实际情况与本手册有不一致之处,或您想得到最新的信息或有任何问题和想法,欢迎致电 400-810-0466 或登录曙光公司服务网站 垂询。

2

【

】

本产品为 A 级产品。在生活环境中,该产品可能会造成无线电干扰。在这种情况下,可能需要用户对干扰采取切实 可行的措施。

电源、电话和通信电缆中的电流具有危险性。为避免电击危险: 请勿在雷电期间连接或断开本产品的任何电缆,也不要安装、维护或重新配置本产品。 将所有电源线连接至正确接线且妥善接地的电源插座。 将所有要连接到本产品的设备连接到正确接线的插座。 尽可能仅使用单手连接信号电缆或断开信号电缆的连接。 切勿在有火灾、水灾或房屋倒塌迹象时开启任何设备。 除非在安装和配置过程中另有说明,否则请在打开设备外盖之前断开已连接的电源线、远程通信系统、网络和调 制解调器。

ServeRAID 适配器快速参考 - System x 服务器参考信息说明书

ServeRAID Adapter Quick Reference for System x ServersReference InformationWhether you are protecting your storage network, enterprise databases, or application network, the ServeRAID family of SAS/SATA Controllers and Host Bus Adapters delivers benefits to fit your requirements. Combining these controllers with internal disk drives or external storage expansion unit increases storage capabilities.Table 1. Adapter positioningHost Bus Adapters Basic RAID (emphasis on cost)Enterprise RAID (emphasis onperformance)12 Gbps SAS N2215N2225N2226ServeRAID M1215ServeRAID M5225-2GBServeRAID M5210ServeRAID M5210e6 Gbps SAS N2125N2115IBM 6Gb PerformanceOptimized HBAIBM 6Gb SAS HBA ServeRAID M1115ServeRAID H1135ServeRAID H1110ServeRAID M1015ServeRAID M5120ServeRAID M5115ServeRAID M5110ServeRAID M5110eServeRAID M5025ServeRAID M5016ServeRAID M5015ServeRAID M50143 Gbps SAS ServeRAID BR10il v2 3 Gbps SATA ServeRAID C105ServeRAID C100Figure 1. ServeRAID M5225-2GB SAS/SATA ControllerFigure 2. ServeRAID M5210 SAS/SATA Controller (with an optional cache installed)Feature upgrade matrix for M5200 SeriesThe following table shows feature upgrade matrix for ServeRAID M5200 Series SAS/SATA controllers.Table 4. Feature upgrade matrix for ServeRAID M5200 Series SAS/SATA controllersFeature RAIDController Description Part number Type M5210M5210e Zero Cache RAID 5 and SED UpgradesServeRAID M5200 Series Zero Cache/RAID 5 Upgrade47C8708FoD Yes Cache, RAID 5 and SED Upgrades with no backupServeRAID M5200 Series 1GB Cache/RAID 5 Upgrade47C8656HW Yes Cache, RAID 5 and SED Upgrades with flash backupServeRAID M5200 Series 1GB Flash/RAID 5 Upgrade47C8660HW Yes ServeRAID M5200 Series 2GB Flash/RAID 5 Upgrade47C8664HW Yes ServeRAID M5200 Series 4GB Flash/RAID 5 Upgrade47C8668HW Yes Advanced Upgrades*ServeRAID M5200 Series RAID 6 Upgrade47C8706FoD Yes ServeRAID M5200 Series SSD Performance Accelerator47C8710FoD Yes ServeRAID M5200 Series SSD Caching Enabler47C8712FoD Yes* Advanced Upgrade requires cache upgradeFigure 3. ServeRAID M1215 SAS/SATA ControllerFigure 4. ServeRAID M5120 SAS/SATA Controller (with flash module)Figure 5. ServeRAID M5110 SAS/SATA Controller (with flash module)Figure 6. ServeRAID M1115 SAS/SATA ControllerFigure 7. ServeRAID H1110 SAS/SATA ControllerFigure 8. ServeRAID M5025 SAS/SATA ControllerFigure 9. ServeRAID M5016 SAS/SATA Controller (with flash module)Figure 10. ServeRAID M5015 SAS/SATA Controller with the battery backup unit attachedFigure 11. ServeRAID M5000 Series Advanced Feature Key attached to the ServeRAID M5015 ControllerFigure 12. ServeRAID M5014 SAS/SATA ControllerFigure 13. ServeRAID M1015 SAS/SATA ControllerFigure 15. ServeRAID-BR10il SAS/SATA Controller v2 (BR10il v2)ServeRAID C100 and C105The ServeRAID C100 and ServeRAID C105 are integrated SATA controllers with software RAID capabilities. They are a cost-effective way to provide reliability, performance, and fault-tolerant disk subsystem management to help safeguard your valuable data and enhance availability.The following figure shows a screenshot from the configuration utility for ServeRAID C100/C105 that displays information about the controller.Figure 16. ServeRAID C100/C105 configuration utility: Controller informationThe ServeRAID C100 and C105 are integrated SATA controllers that come standard with supported servers and cannot be ordered separately. The following table provides the ordering part numbers and feature codes for the additional options.Table 17. Ordering part numbers and feature codesDescription Part number Feature code ServeRAID C100Onboard Onboard ServeRAID C105Onboard Onboard ServeRAID C100 Series RAID 5 Upgrade-FoD*81Y4406A17U8-Pack ServeRAID C105 Controller Enabler**90Y4349A2V7* An FoD upgrade for ServeRAID C100 that enables support for RAID 5.** An FoD upgrade for ServeRAID C105 that enables support for up to eight SATA HDDs.ServeRAID C100 and C105 specificationsThe following table lists specifications for the ServeRAID C100 and C105 controllers.Figure 17. N2225 (left) and N2226 (right) SAS/SATA HBAsFigure 18. N2215 SAS/SATA HBAFigure 19. N2125 SAS/SATA HBAFigure 20. N2115 SAS/SATA HBAFigure 21. 6Gb SAS Host Bus Adapter with the PCIe slot bracket removedFigure 22. 6Gb Performance Optimized HBASupported serversThe following table lists supported System x servers.Table 28. Supported System x servers (Part 1)Serverx3100 M4Y N Y Y Y Y N N N Y Y x3100 M5N N N N N N N N Y Y N x3200 M2N N N N N N N N N Y N x3200 M3Y N Y Y Y Y N N N Y N x3250 M2N N N N N N N N N Y N x3250 M3Y N Y Y Y Y N N N Y N x3250 M4Y N Y Y Y Y N N N Y Y x3250 M5N N N N N N N Y Y N N x3300 M4N N N N N N N N N Y Y x3400 M2Y N Y Y Y Y N N N Y N x3400 M3Y N Y Y Y Y N N N Y N x3500 M2Y N Y Y Y N N N N Y N x3500 M3Y N Y Y Y N N N Y Y N x3500 M4N N N N N N Y*Y*Y Y Y x3530 M4N N N N N N N Y*N Y Y x3550 M2Y N Y Y Y N N N N Y Y x3550 M3Y Y Y Y Y Y N N N Y Y x3550 M4N N N N N N N Y*Y Y Y x3550 M5N N N N N N Y Y N N N x3620 M3N N Y Y Y Y N N N Y N x3630 M3N N Y Y Y N N N N Y N x3630 M4N N N N N N Y*Y*Y Y Y x3650 M2Y N Y Y Y N N N N Y Y x3650 M3Y Y Y Y Y Y N N N Y Y x3650 M4N N N N N N Y*Y*Y Y Y x3650 M4 BD N N N N N N Y Y Y N N x3650 M4 HD N N N N N N Y Y N N N x3650 M5N N N N N N Y Y N N N x3690 X5Y Y**Y Y Y N N N N Y Y x3750 M4 (8722)N N N N N N N N Y Y Y x3750 M4 (8752)N N N N N N N N Y N N x3755 M3N N Y Y Y N N N N Y N x3850 M2/x3950 M2N N N N N N N N N Y Y x3850 X5/x3950 X5Y Y**Y Y Y N N N Y Y Y x3850 X6/x3950 X6N N N N N N N Y Y N N* Supported with Intel Xeon v2 processors.** Supported with Intel Xeon E7 family-based eX5 servers, requires optional M5016 Battery Tray (88Y5874).Table 28. Supported System x servers (Part 2)Server x3100 M4N N N N N N N N Y N Y N N x3100 M5N N N N Y Y N Y Y N Y N Y x3200 M2N N N N N N N N N N N N N x3200 M3N N N N N N N N Y N N N N x3250 M2N N N N N N N N N N N N N x3250 M3N N N N N N N N Y N N N N x3250 M4N N N N N N N N Y N Y N N x3250 M5N N N N Y Y N Y Y N Y N Y x3300 M4N N N N Y Y N Y Y Y N N N x3400 M2N N N N N N N N N N N N N x3400 M3N N N N N N N N Y N N N N x3500 M2N N N N N N N N N N N N N x3500 M3N N N N N N N N Y N N N N x3500 M4N Y N Y Y Y N Y N N N Y Y x3530 M4N N N N Y Y N Y Y Y N N N x3550 M2N N N N N N N N N N N N N x3550 M3N N N N N N N N Y N N N N x3550 M4N Y N Y Y Y N Y N N N Y Y x3550 M5Y Y N Y N N N N N N N Y N x3620 M3N N N N N N N N Y N N N N x3630 M3N N N N N N N N N N N N N x3630 M4N N N N Y Y N Y Y Y N N Y x3650 M2N N N N N N N N N N N N N x3650 M3N N N N N N N N Y N N N N x3650 M4N Y N N Y Y Y N N N N Y Y x3650 M4 BD N Y N Y Y Y N Y Y N N Y Y x3650 M4 HD N Y Y N N N N N Y N N Y N x3650 M5Y Y N Y N N N N N N N Y N x3690 X5N N N N N N N N N N N N Y x3750 M4 (8722)N N N N Y Y Y Y Y N N N Y x3750 M4 (8752)N Y Y Y Y N N N N N N Y N x3755 M3N N N N N N N N N N N N N x3850 M2/x3950 M2N N N N N N N N N N N N N x3850 X5/x3950 X5N N N N N N N N N N N N Y x3850 X6/x3950 X6NYNNYNNNNNNYNThe following table lists supported iDataPlex and NeXtScale servers.Table 29. Supported iDataPlex and NeXtScale servers (Part 1)Server dx320N N N N N N N N N N N N dx340N N N N N N N N N N N N dx360N N N N N N N N N N N N dx360 M2N N N N N N N N N N N N dx360 M3N N Y N Y N N N N N Y N dx360 M4N N N N N N Y N N N Y Y nx360 M4N N N N N N N Y Y Y N N nx360 M5NNNNNNNNNNNNTable 29. Supported iDataPlex and NeXtScale servers (Part 2)Server dx320N N N N N N N N N N N N N dx340N N N N N N N N N N N N N dx360N N N N N N N N N N N N N dx360 M2N N N N N N N N N N N N N dx360 M3N N N N N N N N Y N N N N dx360 M4N Y N N Y N N Y Y N N N N nx360 M4N N N N Y Y N Y Y N Y N Y nx360 M5NYNYNNNNNNNYNThe following table lists supported BladeCenter servers.Table 30. Supported BladeCenter serversServer HS12 (8028)N N N HS22 (7870)N N N HS22V (7871)N N N HS23 (7875)N N N HS23E (8038)N Y Y HX5 (7872)N N N HX5 (7873)NNNThe following table lists supported Flex System servers.Table 31. Supported Flex System serversServerx220Y Y Y N x222N N N Y x240Y N N N x240 M5N N N N x440Y N N N x280/x480/x880 X6N N N NFeature comparisonThe following tables compare features of the storage controllers.Table 32. Feature comparison: Controllers for System x, iDataPlex, and NeXtScale servers (Part 1)FeaturePort interface SAS SAS SAS SAS SAS SAS SAS SAS SAS SAS SAS Port speed, Gbps6666631212666 Number of ports888884168888 PCIe spec 2.0 2.0 2.0 2.0 2.0 1.0 3.0 3.0 3.0 2.0 2.0 PCIe lanes x8x8x8x8x8x4x8x8x8x8x8 Int. connectors022******** Ext. connectors20000042210 SAS controller LSISAS2108LSISAS2208LSISAS2108LSISAS2108LSISAS2008LSISAS1064LSISAS3008LSISAS3008LSISAS2308LSISAS2008LSISAS2008 Cache (MB)#5121024512256None None None None None None None Battery backup Y N Y Opt N N N N N N N Flash backup N Y N N N N N N N N N Data encryption Opt Y Opt Opt Opt N N N N N N Max stripe size (KB) (F=fixed)10241024102410246464-F N/A N/A N/A N/A N/A Mixing SAS & SATA‡Y Y Y Y Y Y N/A N/A N/A N/A N/A SSD support Y Y Y Y Y Y Y Y N N Y Tape support N N N N N N N N N Y N Max volumes64646464162N/A N/A N/A N/A N/A Max volume size64TB64TB64TB64TB64TB Y N/A N/A N/A N/A N/A UEFI support Y Y Y Y Y Y Y Y Y Y Y Patrol read (data scrubbing)Y Y Y Y Y Y N/A N/A N/A N/A N/A Consistency check Y Y Y Y Y N/A N/A N/A N/A N/A Online RAID Level Migration†Y Y Y Y Y N/A N/A N/A N/A N/A Online Capacity Expansion Y Y Y Y Y N/A N/A N/A N/A N/A AutoSync (auto-rebuild)Y Y Y Y Y Y N/A N/A N/A N/A N/A Copyback§Y Y Y Y N N N/A N/A N/A N/A N/A FastPath Opt N Opt Opt N N N/A N/A N/A N/A N/A CacheCade Opt N Opt Opt N N N/A N/A N/A N/A N/A RAID-0Y Y Y Y Y Y N/A N/A N/A N/A N/A RAID-1Y Y Y Y Y Y N/A N/A N/A N/A N/A RAID-1E N N N N N Y N/A N/A N/A N/A N/A RAID-5Y Y Y Y Opt N N/A N/A N/A N/A N/A RAID-6Opt Y Opt Opt N N N/A N/A N/A N/A N/A RAID-10Y Y Y Y Y N N/A N/A N/A N/A N/A RAID-50Y Y Y Y Opt N N/A N/A N/A N/A N/A RAID-60Opt Y Opt Opt N N N/A N/A N/A N/A N/A# Opt=optional‡ Requires that the server also supports the mixing of SAS & SATA drives.† Online RAID Level Migration (RLM) is also known as Logical Drive Migration (LDM).§ Copyback is also known as Revertible Hot Spare.Table 32. Feature comparison: Controllers for System x, iDataPlex, and NeXtScale servers (Part 2)FeaturePort interface SAS SAS SAS SAS SAS SAS SAS SATA SATA SAS SAS Port speed, Gbps121212666633126 Number of ports88888848Up to688 PCIe spec 3.0 3.0 3.0 3.0 3.0 2.0 2.0N/A N/A 3.0 3.0 PCIe lanes x8x8x8x8x8x8x4N/A N/A x8x8 Int. connectors02202222Up to622 Ext. connectors20020000000 SAS controller LSISAS3108LSISAS3108LSISAS3008LSISAS2208LSISAS2208LSISAS2008LSISAS2004None None LSISAS3008LSISAS2308 Cache (MB)# 2 GB Opt N Opt Opt N N N N N N Battery backup N N N Opt Opt N N N N N N Flash backup Yes Opt N Opt Opt N N N N N N Data encryption Yes Opt Opt Opt Opt Opt N N N N N Max stripe size (KB) (F=fixed)1024102464-F1024102464-F64-F64-F64-F N/A N/A Mixing SAS & SATA‡Y Y Y Y Y Y Y N N Y Y SSD support Y Y Y Y Y Y Y N N Y Y Tape support N N N N N N N N Y N N Max volumes646432646416288N/A N/A Max volume size64TB64TB>2TB64TB64TB64TB16TB>2TB>2TB N/A N/A UEFI support Y Y Y Y Y Y Y Y Y Y Y Patrol read (data scrubbing)Y Y Y Y Y Y N N N N/A N/A Consistency check Y Y Y Y Y Y Y Y Y N/A N/A Online RAID Level Migration†Y Y Y Y Y Y N N N N/A N/A Online Capacity Expansion Y Y Y Y Y Y Y N N N/A N/A AutoSync (auto-rebuild)Y Y Y Y Y Y Y Y Y N/A N/A Copyback§Y Y Y Y Y Y N N N N/A N/A FastPath Opt Opt N Opt Opt N N N N N/A N/A CacheCade Opt Opt N Opt Opt N N N N N/A N/A RAID-0Y Y Y Y Y Y Y Y Y N/A N/A RAID-1Y Y Y Y Y Y Y Y Y N/A N/A RAID-1E N N N N N N Y N N N/A N/A RAID-5Y Opt Opt Opt Opt Opt N N N N/A N/ARAID-6Opt OptNOptOpt NN NN N/AN/ARAID-10Y Y Y Y Y Y Y Y Y N/A N/A RAID-50Y Opt Opt Opt Opt Opt N N N N/A N/A RAID-60Opt Opt N Opt Opt N N N N N/A N/A Feature# Opt=optional‡ Requires that the server also supports the mixing of SAS & SATA drives.† Online RAID Level Migration (RLM) is also known as Logical Drive Migration (LDM).§ Copyback is also known as Revertible Hot Spare.Table 33. Feature comparison: ServeRAID controllers for BladeCenter and Flex System servers。

技嘉AMD RAID 安装指南说明书

AMD RAID 安装指南1. AMD BIOS RAID 安装指南 (2)1.1 RAID 介绍 (2)1.2 RAID 配置注意事项 (4)1.3 旧版RAID ROM 配置(适用于AMD X570、X470、B450、X370、B350A320和A300芯片集) (5)1.4 UEFI RAID 配置(适用于AMD X399、X570、X470、B450、X370、B350A320和A300芯片集) (11)2. AMD Windows RAID 安装指南 (21)1. AMD BIOS RAID 安装指南AMD BIOS RAID 安装指南介绍如何在BIOS 环境中使用板载FastBuild BIOS 实用程序配置RAID 功能。

制作SATA 驱动程序磁盘后,按<F2> 或<Del> 进入BIOS 设置,然后按照支持光盘上“用户手册”的详细说明进行操作,之后即可开始使用板载RAID Option ROM 实用程序配置RAID。

1.1 RAID 介绍“RAID”是“独立磁盘冗余阵列”的缩写,是一种将两个或更多硬盘组成一个逻辑单元的方法。

为达到最佳性能,请在创建RAID 集时,安装相同型号与容量的硬盘。

RAID 0(数据等量分配)RAID 0 是一项数据等量分割技术,可优化两个相同的硬盘,以读写平行、交错式堆栈中的数据。

这一技术可使单一磁盘的数据传输速率加倍,同时两个硬盘还可作为单一磁盘驱动器,以持续的数据传输速率工作,进而提升数据访问及存储性能。

警告!尽管RAID 0 功能可提升访问性能,但并未提供任何容错机制。

如果热插拔任何RAID 0 磁盘的硬盘,将导致数据损坏或丢失。

RAID 1(数据镜像)RAID 1 为数据镜像技术,可将一个磁盘驱动器的数据映像复制至第二个磁盘驱动器,并维持相同的数据镜像。

由于正常运行的磁盘驱动器包含另一个磁盘驱动器内完整的数据副本,因此,若有一个磁盘驱动器故障,磁盘阵列管理软件就会将所有应用程序引导至正常运行的磁盘驱动器,因而提供了数据保护功能,并增加整个系统的容错性能。

AMD RAID 安装指南说明书

AMD RAID 安装指南AMD RAID 安装指南 (1)1. AMD BIOS RAID 安装指南 (2)1.1 RAID 简介 (2)1.2 RAID 配置的注意事项 (5)1.3 UEFI RAID 配置 (6)2. AMD Windows RAID 安装指南 (19)2.1 在Windows 下创建RAID 卷 (19)2.2 在Windows 下删除RAID 阵列 (26)该指南中的BIOS 截图仅供参考,可能与您主板的实际设置画面有所不同。

您看到的实际设置画面根据您所购买的主板而定。

请参考产品规格页面了解RAID支持信息。

由于主板规格及BIOS 软件可能会更新,此文档的内容可能会受影响,恕不另行通知。

1.AMD BIOS RAID 安装指南AMD BIOS RAID 安装指南介绍如何在BIOS 环境下使用板载FastBuild BIOS 实用程序配置RAID 功能。

装入SATA 驱动器软盘后,按[F2] 或[Del] 进入BIOS 安装程序,按照支持CD 中“用户手册”的具体说明设置进入RAID 模式的选项,随后开始使用板载RAID Option ROM 实用程序配置RAID。

1.1 RAID 简介“RAID”这一术语表示“独立磁盘冗余阵列”(Redundant Array of Independent Disks),是一种将两个或多个硬盘驱动器合并为一个逻辑单元的方法。

为达到最佳性能,创建RAID 组时,请安装型号相同、容量相同的驱动器。

RAID 0(数据分条)RAID 0 称为数据分条,可对两个完全相同的硬盘驱动器进行优化,在并行、交错的堆栈中读取和写入数据。

RAID 0 将使单一磁盘的数据传输速率倍增,同时两个硬盘以一个硬盘的形式执行相同操作,但数据传输速率保持不变,因此可提高数据访问和存储性能。

警告!!虽然RAID 0 功能可提高访问性能,但不具备任何容错能力。

对RAID 0 磁盘的任何硬盘驱动器进行热插拔都将导致数据损坏或丢失。

51CTO下载-RHCE和RHCA下载地址

RH033--Red Hat Linux EssentialsRH033-1 /file/aqvbpbl5RH033-2 /file/dn3sacd1RH033-3 /file/cljvis2fRH033-4 /file/dn3sa0isRH033-5 /file/aqvbpazsRH033-6 /file/e6e2cva4RH033-7-1 /f ile/aqvbp605RH033-7-2 /f ile/cljvijthRH033-8 /file/e6e2ca1wRH033-9 /file/cljviyhfRH033-10 /file/aq vbp5tbRH033-11(12) /file/dn3sae71RH033-13 /file/e6e20zipRH033-14 /file/cljvwbxsRH033-15 /file/cljvwby6RH033-16 /file/dn3sa6gzRH033-17(18) /file/cljviqwmRH133--Red Hat Linux System AdministrationRH133-1 /file/aqvpmrc wRH133-2 /file/cljipitsRH133-3 /file/aqvpm28rRH133-4 /file/aqvpmbqgRH133-5 /file/dn3a71qqRH133-6 /file/aqvpdx25RH133-7 /file/bhy1xrt7RH133-8(上) /file/bhy1xgd3RH133-8(下) /file/dn3adxkeRH133-9(上) /file/aqvpi4dbRH133-9(下) /file/cljiumd8RH133-10(上) /file/cljiu4c0RH133-10(下) /file/dn3ad29qRH133-11(上) /file/aq vpqswwRH133-11(下) /file/bhy1h2ppRH253--Red Hat Enterpris e Linux Network Servic es and Security Administration RH253-1 /file/aqyr9p4jRH253-2(上)/file/aqyr99thRH253-2(下)/file/dn0ullg9RH253-3 /file/aqyr9j2pRH253-4(上)/file/clt64911RH253-4(下)/file/dn0uldffRH253-5(上)/file/e6vxf61cRH253-5(中)/file/dn0ulbs6RH253-5(下)/file/bhfvljlwRH253-6(上)/file/e6vx6q5zRH253-6(下)/file/clt62vazRH253-7(上)/file/dn0uu5t9RH253-7(中)/file/e6vx0evsRH253-7(下)/file/aqyr8o8nRH253-8(上)/file/bhfvab20RH253-8(中)/file/dn0u6968RH253-8(下)/file/e6vxyl1cRH253-DHCP /f ile/dn0uhfikRH333课程目标及内容掌握基础服务的安全、理解密码学、记录系统活动。

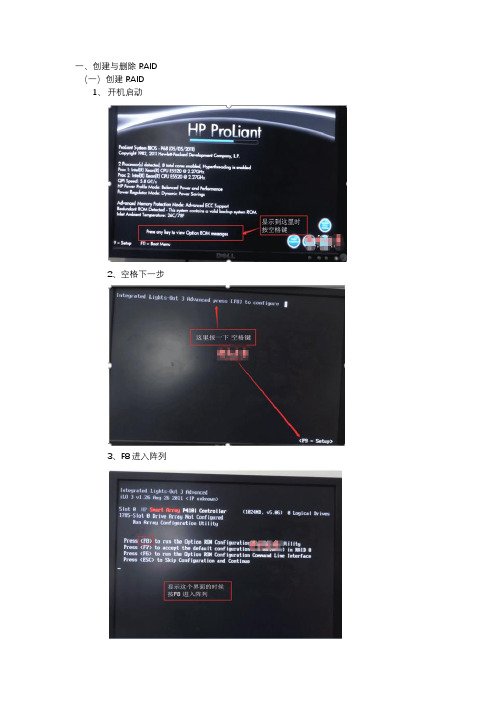

HP老版本服务器RAID设置和安装系统

一、创建与删除RAID (一)创建RAID

1、开机启动

2、空格下一步

3、F8进入阵列

4、选择创建阵列模式

5、TAB切换选择RAID模式

6、设置好RAID后保存配置

7、回车确认保存

8、回到主界面,ESC退出

(二)删除阵列

1、开机启动

2、按空格继续

3、F8设置进入阵列模式

4、选择删除阵列

5、F8选中要删除的阵列

6、F3确认一下

7、回车确定

8、回到主界面,在重新创建RAID

(三)安装Centos7系统

1、进入安装界面

2、跳过检测继续安装

3、等待一会儿进入安装配置界面

4、选择安装界面语言

5、需要配置的选项

6、设置时区、时间和日期

7、添加中文语言包

8、选择自定义设置分区

9、添加分区

10、主要设置的分区类型

11、确认改变分区

12、设置最小化安装

13、关闭KDUMP

14、以上设置好后,点击开始安装

15、设置root密码

16、密码设置界面

17、完成安装后Reboot重启

18、重启完成后输入用户名和密码进入。

AMD RAID 安裝指南说明书

AMD RAID 安裝指南1. AMD BIOS RAID 安裝指南 (2)簡介 (2)1.1 RAID設定注意事項 (3)1.2 RAID1.3 安裝配備 RAID 功能的 Windows® 7/7 64 位元/Vista TM/Vista TM 64 位元/XP/XP 64 位元 (4)1.3.1 安裝配備 RAID 功能的 Windows® 7/7 64 位元/Vista TM/Vista TM 64 位元 (4)1.3.2 安裝配備 RAID 功能的 Windows® XP / XP 64 位元 (5)1.4 建立磁碟陣列 (6)2. AMD Windows RAID 安裝指南 (10)安裝軟體元件 (10)2.1 RAIDXpert2.2 瀏覽器支援 (10)2.3 安裝 RAIDXpert (10)2.4 登入 RAIDXpert (13)2.5 一般連線 (13)2.6 安全連線 (14)2.7 建立新的邏輯磁碟機 (14)2.8 透過網際網路連線至 RAIDXpert (17)2.9 在不使用網路連線的情況下執行 RAIDXpert (17)1. AMD BIOS RAID 安裝指南AMD BIOS RAID 安裝指南可指導您在 BIOS 環境中使用主機板內建的 FastBuild BIOS 公用程式設定 RAID 功能。

製作SATA3 驅動程式磁片後,請按下 <F2> 或 <Del> 鍵進入 BIOS Setup,依照支援光碟中「User Manual (使用手冊)」或「Quick Installation Guide (快速安裝指南)」的詳細指示設定 RAID 模式的選項,設定完成後,即可開始使用主機板內建的 RAID Option ROM 公用程式設定 RAID。

1.1 RAID 簡介「RAID」一詞是指「獨立磁碟備援陣列(Redundant Array of Independent Disks」,是將兩台以上的硬碟機結合在一個邏輯裝置中的方法。

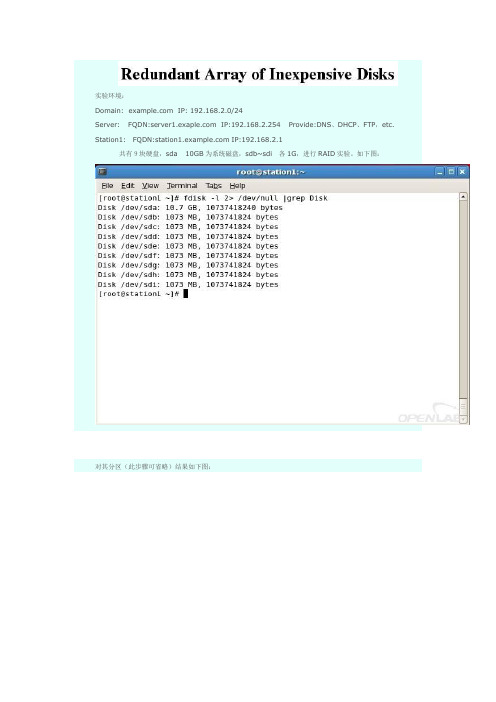

RHCA课程实验记录——RH436 高级的RAID管理

实验环境:Domain: IP: 192.168.2.0/24Server: FQDN: IP:192.168.2.254 Provide:DNS、DHCP、FTP,etc. Station1:FQDN: IP:192.168.2.1共有9块硬盘,sda 10GB为系统磁盘,sdb~sdi各1G,进行RAID实验。

如下图:对其分区(此步骤可省略)结果如下图:Station2:FQDN: IP:192.168.2.2下面的部分实验将会把Station1的RAID硬盘迁移到Station2中组装。

实验一:本地的RAID组装描述:在/etc/mdadm.conf文件损坏或丢失的情况下,并已知原raid的类型及所组成的硬盘名,来进行组装,使其正常运行。

步骤:1st: 首先创建一个RAID5.将sdb1,sdc1,scd1,sdf1组装一个包含一个热备盘的RAID5。

2ed: 使用命令查看RAID的状态。

3rd:生成/etc/mdadm.conf文件。

4th:手动停掉md0,再尝试启动。

成功启动。

5th:再次停掉md0,并将/etc/mdadm.conf改名,尝试启动6th:无法启动,因为已知RAID名为md0,且组成的硬盘为sdb1,sdc1,scd1,sdf1故可进行重新组装。

如下图:查看状态实验成功。

实验二:事件通知。

描述:当RAID出现问题时,发送邮件给指定帐户,这里我们将实验1中的RAID5损坏一块硬盘进行测试。

步骤:1st: 将邮件通知的命令写入/etc/mdadm.conf2ed:强制损坏/dev/sdc1实验成功。

如果RAID没有损坏,也可以测试邮件通知是否成功。

如下图:实验三:在线拉伸RAID。

描述:通常在实际生产环境中,随着数据量的不断增加,原有的RAID设备空间不足,所以要进行扩展,而又要保证服务器的正常运行,所以要在不中断服务器运行的情况下对RAID设备进行在线的拉伸。

同样在实验一的环境下进行,将该RAID5的大小由2GB扩大到3GB。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

生产环境中常用RAID:0、1、5、6、10#存储一般使用10raid功能:1.保证数据的完整性(冗余)2.硬盘容错3.提高性能mdadm1.创建raid(设备文件:/dev/md0,/dev/md1...)2.配置文件:/etc/mdadm.conf3.创建raid时一定要添加“-a yes”选项,保证自动创建/dev/md1或/dev/mdN 设备文件。

RAID0:条带化1.无奇偶校验2.数据是分段的3.循环写入数据到多个硬盘4.提供大的吞吐量(写性能优秀)5.无容错机制,存储概率为100%(即存储容量=硬盘总容量)6.可以设定chunk size7.磁盘数愈多坏的可能性越大,一块盘损坏会导致所有数据的损坏。

Chunk size和stribe (RAID0,RAID5,RAID6有这个概念)1. 一个数据包的大小称之为chunk size:RAID里面每个成员一次写入的数据量。

当一次写入的量不到chunk size设定的大小的时候是不会写入下一个成员盘。

chunk size的值必须是多个page size的大小,在X86架构下一个page size 的大小是4KB即chunk size的大小必须是2的N次方 n大于1 必须是4的倍数。

stride是每次写入raid成员的block数,即64KB的数据要写多少次。

stride 等于 chunk size / filesystem block size,创建文件系统时指定。

2. chunksize=(avgrq-sz × 512)/(raid磁盘数× 1024)=2的N次方KBim/diskstride=chunksize/filesystemblocksize实例:[root@iscsi-server ~]# iostat -x /dev/sdbLinux 2.6.18-194.el5 (iscsi-server) 2011年08月12日avg-cpu: %user %nice %system %iowait %steal %idle0.05 0.02 0.09 0.07 0.00 99.77Device: rrqm/s wrqm/s r/s w/s rsec/s wsec/s avgrq-szavgqu-sz await svctm %utilsdb 2.41 1.17 0.40 0.03 19.07 9.55 65.17 0.00 4 .75 0.85 0.04#查询磁盘的avgrq-sz,avgrq-sz是扇区数,每个扇区512BitChunksize=(65.17×512)/(3×1024)=10.86=8KBit/diskStribe=(8KBit/disk)/(4KBit)=23.指定chunk size和stribe#mdadm -C /dev/md0 -a -yes -l 0 -n 2 --chunk=64 /dev/sda1 /dev/sdb1 #mkfs.ext3 -b 4096 -E stribe=16 /dev/md0RAID1:镜像卷1.全镜像,2.数据复制,提升了大的容错能力,3.提高了读性能4.至少两块盘5.存储概率:(100/N)%(N=硬盘数)6.创建:#mdadm -C /dev/md0 -a yes -l 1 -n 2 /dev/sda1 /dev/sdb1RAID5:通过奇偶校验的条带(平均分布的奇偶校验)1.通过奇偶校验的条带化2.提高性能和容错能力3.对于修改数据性能很差(每修改一次数据要对数据重新做一次奇偶校验,当数据的修改量大于25%的时候不建议使用RAID5)修改数据时会做4次I/O操作3.1.读取数据3.2.更新数据,写回到磁盘,奇偶校验不正确3.3.读raid的所有磁盘,重新做奇偶校验检查3.4.更新数据和奇偶校验。

4.至少3快硬盘5.存储效率:100(1-1/N)%6.一旦有raid设备损坏,RAID立即进入降级模式,支持热备盘。

7.支持四种奇偶校验布局(--layout=<type>):Left Asymmetric、Right Asymmetric、Left Symmetric(默认布局)、Right symmetricLeft Asymmetric Right Asymmetricsda1 sdb1 sdc1 sde1 sda1 sdb1 sdc1 sde1D0 D1 D2 P P D0 D1 D2D3 D4 P D5 D3 P D4 D5D6 P D7 D8 D6 D7 P D8P D9 D10 D11 D9 D10 D11 PD12 D13 D14 P P D12 D13 D14... ...Left Symmetric Right Symmetricsda1 sdb1 sdc1 sde1 sda1 sdb1 sdc1 sde1D0 D1 D2 P P D0 D1 D2D4 D5 P D3 D5 P D3 D4D8 P D6 D7 D7 D8 P D6P D9 D10 D11 D9 D10 D11 PD12 D13 D14 P P D12 D13 D148.创建raid5:#mdadm -C /dev/md0 -a yes -l 5 -n 3 /dev/sd[abc]1RAID6(5+1)1.两份奇偶校验的条带化2.奇偶校验比RAID5更慢,数据开销更大,提供更多容错3.两块盘损坏时进入降级模式4.至少4块磁盘5.存储效率:100(1-2/N)%6.创建RAID6#mdadm -C /dev/md0 -a yes -l 6 -n 4 /dev/sd[abcd]1RAID10(1+0)1.带镜像的条带化2.提高性能和容错能力3.至少4块盘4.存储效率:(100/N)%5.创建RAID10mdadm -C /dev/md0 -a yes -l 10 -n 4 /dev/sd[abcd]1查看RAID状态(/proc/mdstat)1.mdadm --scan2.watch -n .5 'cat /proc/mdstat'3.mdadm -D /dev/md0或mdadm --detail /dev/md04.SYSFS Interface:/sys/block/mdX/md/etc/mdadm.conf1.管理和配置RAID架构2.允许分组为多RAID提高热备盘3.为已存在raid创建配置文件:#mdadm --examine --scan#mdadm -D -s #-s:扫描eg:[root@station3 ~]#mdadm -D -s > /etc/mdadm.conf[root@station3 ~]#vim /etc/mdadm.confARRAY /dev/md0 level=raid5 num-devices=3 spares=1UUID=90efacda:657cee38:87172dab:543d8c23devices=/dev/sda1,/dev/sdb1,/dev/sdc1 auto=yes#如果设备是/dev/md1或以上的话,必须加上auto=yes#一行开头为空格表示该行接上一行。

事件通知1.要求email工作正常2./etc/mdadm.conf #当raid出现故障时,可发送邮件或执行脚本MAILADDR root@ #邮件接收者MAILFROM root@ #邮件发送者PROGRAM /usr/sbin/my-RAID-script #执行脚本3.测试工具:mdadm --monitor --scan --oneshot --testmdadm -Fs1t4.要求启动mdmonitor服务 #默认该服务是无法启动,必须在/etc/mdadm.conf 中添加MAILADDR等故障告知处理RAID调整重新做raid、重新条带化、重新改变raid的布局1.调整设备数量2.调整chunksize大小3.改变数据布局4.改变校验的位置和类型在做RAID调整时必须备份关键区拉伸磁盘到raid5中[root@station3 ~]#mdadm /dev/md0 -a /dev/sda8[root@station3 ~]#mdadm /dev/md0 -a /dev/sda9[root@station3 ~]#mdadm -G /dev/md0 -n 4 --backup-file=/tmp/md0.bu #指定将关键区备份到文件,如果拉伸成功时,系统会自动删除该文件[root@station3 ~]#mdadm --assemble /dev/md0 --backup-file=/tmp/md0.bu /dev/sda[56789] #恢复[root@station3 ~]#watch -n 1 'cat /proc/mdstat'[root@station3 ~]#resize2fs /dev/md0 #调整文件系统共享热备盘(热备盘漂移)1.至少有一个raid有热备盘2.将raid信息写入/etc/mdadm.conf中3.建立共享热备盘组:share14:为每个Raid 指定其共享的热备盘组:spare-group=share1e.g:[root@station3 ~]# mdadm -C /dev/md1 -a yes -l 1 -n 2 /dev/sda{10,11} [root@station3 ~]# mdadm -D -s >> /etc/mdadm.conf[root@station3 ~]# vim /etc/mdadm.confMAILADDR root@ARRAY /dev/md0 level=raid5 num-devices=4 spares=1UUID=e1755b3f:13093e23:619799f8:2b921ce2 auto=yesspare-group=share #共享组名可自定义ARRAY /dev/md1 level=raid1 num-devices=2UUID=d3cf69c6:a5c19ae7:f2f87e8b:8021e1b9 auto=yesspare-group=share[root@station3 ~]# service mdmonitor restart #要求重启mdmonitor服务[root@station3 ~]# mdadm -D /dev/md0...Number Major Minor RaidDevice State0 8 5 0 active sync /dev/sda51 8 6 1 active sync /dev/sda62 8 7 2 active sync /dev/sda73 8 8 3 active sync /dev/sda84 8 9 - spare /dev/sda9#热备盘为/dev/md0中/dev/sd9[root@station3 ~]# mdadm -D /dev/md1...Number Major Minor RaidDevice State0 8 10 0 active sync /dev/sda101 8 11 1 active sync /dev/sda11 [root@station3 ~]# mdadm /dev/md1 -f /dev/sda11[root@station3 ~]# mdadm -D /dev/md1...Number Major Minor RaidDevice State0 8 10 0 active sync /dev/sda101 8 9 1 active sync /dev/sda92 8 11 - faulty spare /dev/sda11#md1中/dev/sda11出现故障后,热备盘/dev/sda9自动漂移到md1中了[root@station3 ~]# mdadm /dev/md1 -r /dev/sda11[root@station3 ~]# mdadm /dev/md1 -a /dev/sda11[root@station3 ~]# mdadm -D /dev/md1...Number Major Minor RaidDevice State0 8 10 0 active sync /dev/sda101 8 9 1 active sync /dev/sda92 8 11 - spare /dev/sda11#md1更换硬盘后,新加硬盘会再次变成热备盘重命名RAID1.移动一个raid到移到一个新系统2./dev/md0等设备被新系统占用。