GreenPlum数据库详细安装过程

greenplum单机安装

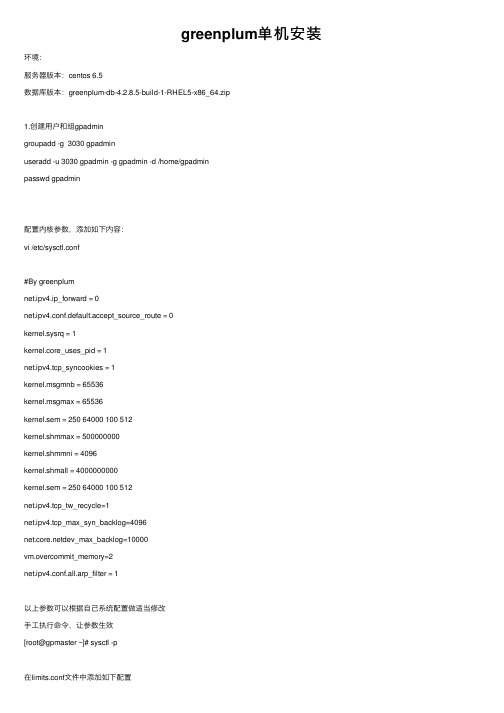

greenplum单机安装环境:服务器版本:centos 6.5数据库版本:greenplum-db-4.2.8.5-build-1-RHEL5-x86_64.zip1.创建⽤户和组gpadmingroupadd -g 3030 gpadminuseradd -u 3030 gpadmin -g gpadmin -d /home/gpadminpasswd gpadmin配置内核参数,添加如下内容:vi /etc/sysctl.conf#By greenplumnet.ipv4.ip_forward = 0net.ipv4.conf.default.accept_source_route = 0kernel.sysrq = 1kernel.core_uses_pid = 1net.ipv4.tcp_syncookies = 1kernel.msgmnb = 65536kernel.msgmax = 65536kernel.sem = 250 64000 100 512kernel.shmmax = 500000000kernel.shmmni = 4096kernel.shmall = 4000000000kernel.sem = 250 64000 100 512net.ipv4.tcp_tw_recycle=1net.ipv4.tcp_max_syn_backlog=4096dev_max_backlog=10000vm.overcommit_memory=2net.ipv4.conf.all.arp_filter = 1以上参数可以根据⾃⼰系统配置做适当修改⼿⼯执⾏命令,让参数⽣效[root@gpmaster ~]# sysctl -p在limits.conf⽂件中添加如下配置[root@gpmaster ~]# vi /etc/security/limits.conf# End of file* soft nofile 65536* hard nofile 65536* soft nproc 131072* hard nproc 131072配置⽤户ssh⽤户⽆密码登录,单机也得配置[root@gpmaster ~]# su - gpadmin[gpadmin@gpmaster ~]$ mkdir ~/.ssh[gpadmin@gpmaster ~]$ chmod 700 ~/.ssh[gpadmin@gpmaster ~]$ cd .ssh/[gpadmin@gpmaster .ssh]$ ssh-keygen -t rsa[gpadmin@gpmaster .ssh]$ ssh gpmaster cat /home/gpadmin/.ssh/id_rsa.pub >>authorized_keys [gpadmin@gpmaster .ssh]$chmod 600 authorized_keys[gpadmin@gpmaster .ssh]$ ssh gpmaster date2.安装GP软件⽅式⼀:[root@gpmaster ~]# unzip greenplum-db-4.2.8.5-build-1-RHEL5-x86_64.zip[root@gpmaster ~]# ./greenplum-db-4.2.8.5-build-1-RHEL5-x86_64.bin⽅式⼆:[root@gpmaster ~]# rpm -ivh greenplum-db-4.2....创建instance需要的⽬录[root@gpmaster ~]# mkdir -p /app/master[root@gpmaster ~]# mkdir -p /app/data/gp1[root@gpmaster ~]# mkdir -p /app/data/gp2[root@gpmaster ~]# mkdir -p /app/data/gp3[root@gpmaster ~]# mkdir -p /app/data/gp4修改⽬录属主:[root@gpmaster ~]# chown -R gpadmin:gpadmin /usr/local/greenplum-db*[root@gpmaster ~]# chown -R gpadmin:gpadmin /app/master[root@gpmaster ~]# chown -R gpadmin:gpadmin /app/data/gp1[root@gpmaster ~]# chown -R gpadmin:gpadmin /app/data/gp2[root@gpmaster ~]# chown -R gpadmin:gpadmin /app/data/gp3[root@gpmaster ~]# chown -R gpadmin:gpadmin /app/data/gp4修改gpadmin⽤户环境配置:[root@gpmaster ~]# su - gpadmin[gpadmin@gpmaster ~]$ vi .bash_profilesource /usr/local/greenplum-db/greenplum_path.shexport MASTER_DATA_DIRECTORY=/app/master/gpseg-1export PGPORT=5432export PGUSER=gpadminexport PGDATABASE=gpmaster⽣效:[gpadmin@gpmaster ~]$ source .bash_profile编辑all_hosts_file⽂件,添加如下内容:[gpadmin@gpmaster ~]$ vi all_hosts_filegpmaster执⾏如下命令验证⽤户等效性[gpadmin@gpmaster ~]$ gpssh-exkeys -f all_hosts_file3.初始化系统:编辑系统初始化的参数⽂件,这个⽂件的编辑可以使⽤模版,模板⽂件所在⽬录如下:[gpadmin@gpmaster ~]$ cp /usr/local/greenplum-db/docs/cli_help/gpconfigs/gpinitsystem_config /home/gpadmin/编辑gp参数⽂件,修改如下配置:[gpadmin@gpmaster ~]$ vi gpinitsystem_configdeclare -a DATA_DIRECTORY=(/app/data/gp1 /app/data/gp2 /app/data/gp3 /app/data/gp4)MASTER_HOSTNAME=gpmasterMASTER_DIRECTORY=/app/masterDATABASE_NAME=gpmaster编辑seg_hosts_file⽂件[gpadmin@gpmaster ~]$ vi seg_hosts_filegpmaster执⾏初始化系统命令:[gpadmin@gpmaster ~]$ gpinitsystem -c gpinitsystem_config -h seg_hosts_file系统开始初始化,之后会看到如下提⽰:Continue with Greenplum creation Yy/Nn>输⼊ Y ,按回车,系统会初始化完成安装结束可以连接GP数据库了:[gpadmin@gpmaster ~]$ psql -d gpmasterpsql (8.2.15)Type "help" for help.gpmaster=#创建数据库[gpadmin@gpmaster ~]$ createdb testDB -E utf-8给数据库权限[gpadmin@gpmaster ~]$ psql -d gpmasterpsql (8.2.15)Type "help" for help.gpmaster=# \c testDBYou are now connected to database "testDB" as user "gpadmin".testDB=# alter role gpadmin with password 'gpadmin';远程权限[gpadmin@gpmaster ~]$ cd $MASTER_DATA_DIRECTORY/[gpadmin@gpmaster gpseg-1]$ lsbase pg_distributedlog pg_stat_tmp pg_xlogglobal pg_distributedxidmap pg_subtrans postgresql.confgp_dbid pg_hba.conf pg_tblspc postmaster.opts gpperfmon pg_ident.conf pg_twophase postmaster.pidpg_changetracking pg_log pg_utilitymodedtmredopg_clog pg_multixact PG_VERSION[gpadmin@gpmaster gpseg-1]$[gpadmin@gpmaster gpseg-1]$ vi pg_hba.confhost testDB gpadmin 192.168.96.1/32 md5通过gpstop -u命令使配置⽣效[gpadmin@gpmaster gpseg-1]$ gpstop -u通过其他机器登录数据库$ psql -h192.168.96.128 -p5432 -d testDB -Ugpadmin。

【PG】Greenplum-db-6.2.1的安装部署

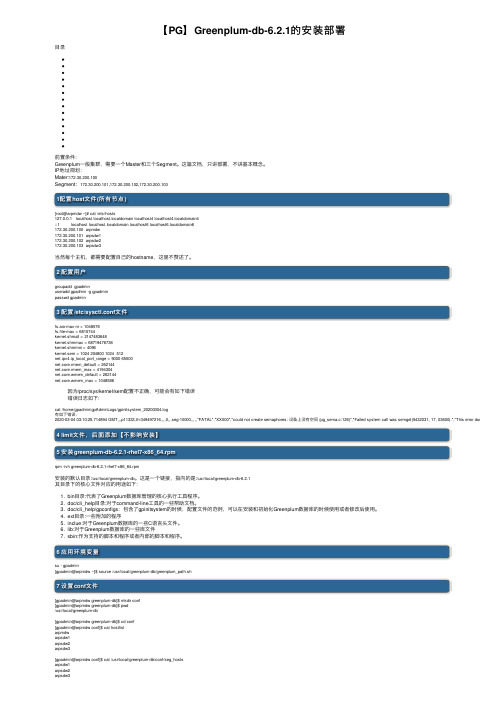

【PG】Greenplum-db-6.2.1的安装部署⽬录前置条件:Greenplum⼀般集群,需要⼀个Master和三个Segment。

这篇⽂档,只讲部署,不讲基本概念。

IP地址规划:Mater:172.30.200.100Segment:172.30.200.101,172.30.200.102,172.30.200.1031配置host⽂件(所有节点)[root@arpmdw ~]# cat /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain6172.30.200.100 arpmdw172.30.200.101 arpsdw1172.30.200.102 arpsdw2172.30.200.103 arpsdw3当然每个主机,都需要配置⾃⼰的hostname,这⾥不赘述了。

2 配置⽤户groupadd gpadminuseradd gpadmin -g gpadminpasswd gpadmin3 配置/etc/sysctl.conf⽂件fs.aio-max-nr = 1048576fs.file-max = 6815744kernel.shmall = 2147483648kernel.shmmax = 68719476736kernel.shmmni = 4096kernel.sem = 1024 204800 1024 512net.ipv4.ip_local_port_range = 9000 65500net.core.rmem_default = 262144net.core.rmem_max = 4194304net.core.wmem_default = 262144net.core.wmem_max = 1048586因为/proc/sys/kernel/sem配置不正确,可能会有如下错误错误⽇志如下:cat /home/gpadmin/gpAdminLogs/gpinitsystem_20200304.log有如下错误:2020-03-04 03:10:25.714894 GMT,,,p11333,th-349497216,,,,0,,,seg-10000,,,,,"FATAL","XX000","could not create semaphores: 设备上没有空间 (pg_sema.c:126)","Failed system call was semget(5432031, 17, 03600).","This error does *not* mean4 limit⽂件,后⾯添加【不影响安装】5 安装greenplum-db-6.2.1-rhel7-x86_64.rpmrpm -ivh greenplum-db-6.2.1-rhel7-x86_64.rpm安装的默认⽬录:/usr/local/greenplum-db。

GreenPlum数据库详细安装过程

目录1.1.GreenPlum数据库概述........................................1.2.GreenPlum数据库架构原理....................................2.SUSELinuxEnterprise1164-bit操作系统安装过程.....................2.1.初始化阶段 .................................................2.2.系统分区 ...................................................2.3.软件选择和系统任务 .........................................2.4.语言选择 ...................................................2.5.Kdump设置..................................................2.6.安装过程 ...................................................3.配置网卡IP......................................................4.GreenPlum中Master配置过程......................................4.1.建立gpadmin用户 ...........................................4.2.关闭防火墙 .................................................4.3.启动FTP....................................................4.4.使用FlashXP上传GreenPlum数据 .............................4.5.使用putty.exe工具配置GreenPlum数据库 .....................4.6.GreenPlum数据库配置详情....................................GrennPlum数据库的初始化...............................修改GreenPlum数据库账户的权限........................附录A...............................................................附录B...............................................................1.概述1.1.GreenPlum数据库概述1.2.GreenPlum数据库架构原理本系统中GreenPlum由一个主节点(master)和四个从节点(segment)构成,主节点和从节点由一台千兆交换机进行连接。

GreenPlum 数据库集群安装说明及使用手册v1.0

GreenPlum数据库集群安装说明及使用手册开心十二月总结****年**月**日目录1体系结构介绍 (4)2安装 (10)2.1安装 (10)2.1.1安装准备 (10)2.1.2安装gp-db (11)2.1.3配置通讯 (13)2.1.4建立数据存储池 (17)2.1.5同步系统时间 (17)2.1.6验证安装是否成功 (17)2.1.7初始化 (17)2.1.8数据库的启停 (18)2.2Master双机热备 (19)2.3Segment节点互备 (20)3GP数据库的使用 (22)3.1pgAdminIII工具 (22)3.1.1安装和第一次使用pgAdminIII (22)3.1.2主窗体 (23)3.1.3导航菜单 (23)3.1.4工具栏介绍 (24)3.1.5数据库与表的创建 (25)3.1.6使用pgAdminIII备份数据库 (25)3.2JDBC配置 (26)3.3GP数据库两个重要概念 (27)3.3.1什么是Schema (27)3.3.2数据分布存储 (28)3.4GP的SQL语法 (28)3.4.1数据加载 (28)3.4.2SQL并行查询 (32)3.4.3聚合函数 (32)3.4.4索引 (32)3.4.5分区 (34)3.4.6函数 (35)4维护数据库 (39)4.1数据库启动gpstart (39)4.2数据库停止gpstop (41)4.3查看实例配置和状态 (41)4.4查看数据库运行状态gpstate (42)4.5查看用户会话和提交的查询等信息 (43)4.6查看数据库、表占用空间 (43)4.7查看数据分布情况 (44)4.8实例恢复gprecoverseg (44)4.9查看锁信息 (44)4.10数据库的备份与恢复 (44)5调优、排错 (44)6附件 (44)6.1DBA常用命令 (44)7Q&A (45)7.1不支持触发器 (45)7.2更新操作中的若干问题 (45)1体系结构介绍Greenplum数据库产品——下一代数据仓库引擎和分析方法Greenplum公司是企业数据云计算解决方案的创始人,为客户提供灵活的数据商业智能和分析方法。

greenplum gdfdist使用手册

greenplum gdfdist使用手册Greenplum GDFDist 使用手册概述Greenplum GDFDist 是一个用于在 Greenplum 数据库集群中进行分布式数据传输和加载的工具。

它提供了高效、可靠和并行的数据传输功能,能够加速数据导入和导出的过程。

本手册将向您介绍 GDFDist 的安装和配置方法,并提供一些常见的使用示例。

安装和配置1. 安装 GDFDistGDFDist 是作为 Greenplum 数据库分发功能的一部分提供的。

在安装 Greenplum 数据库时,GDFDist 已经被自动包括在内。

确保已正确安装 Greenplum 数据库版本来使用 GDFDist。

2. 配置 GDFDist在开始使用 GDFDist 之前,需要进行一些配置。

打开 Greenplum 数据库配置文件(通常位于 `$MASTER_DATA_DIRECTORY/gpseg-1/postgresql.conf`),找到以下配置项,并根据需要进行修改: - `gp_external_enable`:确保该配置项的值为 `on`,以启用外部表和 GDFDist 功能。

- `gp_external_max_segs`:根据您的集群规模和性能需求,适当调整此配置项的值。

它控制了能使用 GDFDist 进行数据传输的并行进程数量。

完成配置后,重新加载Greenplum 数据库配置文件以使更改生效。

使用示例以下是一些常见的 GDFDist 使用示例,展示了不同场景下如何高效地使用数据传输功能。

1. 从本地文件导入数据到 Greenplum 数据库使用 `COPY` 命令结合 GDFDist,可以将本地文件中的数据快速导入到 Greenplum 数据库中。

示例命令如下:```COPY my_table FROM PROGRAM 'gdfdist -F text -b my_file.txt' WITH (FORMAT CSV, HEADER);```在上述命令中,`my_table` 是指目标表的名称,`my_file.txt` 是指本地文件的路径名。

gpload装载流程

gpload装载流程以gpload装载流程为标题,我们来介绍一下gpload的装载流程。

一、什么是gpload?gpload是Greenplum数据库中用于数据导入的工具。

它能够以高速、高效的方式将数据加载到Greenplum数据库中,是一个十分方便的数据导入工具。

二、gpload的基本原理gpload的基本原理是通过解析一个特定格式的配置文件,将数据从外部文件加载到Greenplum数据库中。

配置文件中包含了数据源、目标表、字段映射关系等信息,通过解析配置文件,gpload可以自动完成数据导入的过程。

三、gpload的装载流程1. 创建配置文件我们需要创建一个配置文件,该文件包含了数据源、目标表、字段映射关系等信息。

在配置文件中,我们需要指定数据源的位置、数据源的格式、目标表的名称以及字段映射关系等。

2. 配置文件解析gpload会读取配置文件,并解析其中的内容。

它会根据配置文件中的信息,确定数据源的位置、数据源的格式以及目标表的名称等。

3. 数据读取gpload会根据配置文件中指定的数据源位置和数据源格式,读取数据源中的数据。

它可以支持各种常见的数据格式,例如CSV、文本文件等。

4. 数据转换在将数据加载到目标表之前,gpload会对数据进行转换。

它会根据配置文件中指定的字段映射关系,将数据源中的数据转换成目标表中对应字段的格式。

5. 数据加载gpload将转换后的数据加载到目标表中。

它会根据配置文件中指定的目标表名称和字段映射关系,将数据写入到相应的字段中。

四、gpload的优势1. 高速gpload使用并行加载的方式,能够大大提高数据导入的速度。

它可以同时加载多个数据块,充分利用Greenplum数据库的并行处理能力。

2. 灵活gpload支持各种常见的数据格式,可以加载来自不同数据源的数据。

同时,它也支持自定义的字段映射关系,可以根据实际需求进行灵活配置。

3. 易用gpload的配置文件简单明了,易于理解和使用。

Greenplum详细安装

Greenplum安装一、环境准备VMWARE6.5虚拟机上Redhat5(虚拟两个32位的redhatOS)每个虚拟OS的配置512M内存,8G硬盘容量二、LINUX准备过程1.查看OS的位数,确定GP的版本#getconf LONG_BIT#322.官网上下载32位的Greenplum安装文件greenplum-db-3[1].3.6.1-build-1-RHEL5-i386.zip,大小44M,解压后也差不多44M,里面包含两个文件:一个是安装文件,一个是安装指导3.解压命令:# unzip greenplum-db-3[1].3.6.1-build-1-RHEL5-i386.zip在各台GP主机上编辑/etc/sysctl.conf文件,替换或新增以下参数,重启:kernel.shmmax = 500000000kernel.shmmni = 4096kernel.shmall = 4000000000kernel.sem = 250 64000 100 512net.ipv4.tcp_tw_recycle=1net.ipv4.tcp_max_syn_backlog=4096dev_max_backlog=10000vm.overcommit_memory=2net.ipv4.ip_local_port_range = 1025 65535--文档上没有,新增的在各台主机上同样编辑/etc/security/limits.conf* soft nofile 65536* hard nofile 65536* soft nproc 131072* hard nproc 131072三、软件安装及准备配置1.将master主机改名为local_master,segment主机改名为local_segment;分别修改/etc/hosts为:Local_master:127.0.0.1 localhost.localdomain localhost192.168.224.128 local_masterLocal_segment:127.0.0.1 localhost.localdomain localhost192.168.224.131 local_segment/etc/sysconfig/network为:Local_master:NETWORKING=yesNETWORKING_IPV6=no#HOSTNAME=localhost.localdomainHOSTNAME=local_masterLocal_segment:NETWORKING=yesNETWORKING_IPV6=no#HOSTNAME=localhost.localdomainHOSTNAME=local_segment改完后生效:#service network restart改完后查看:#hostname2.在master安装GP软件:#/bin/bash greenplum-db-3.3.6.1-build-1-RHEL5-i386.bin然后lience accept yes,安装GP路径:/opt/greenplum-db-3.3.6.1安装好了文件夹greenplum-db-3.3.6.1里面会出现以下文件:bin demo docs etc ext greenplum_path.sh include lib LICENSE sbin share 另外外部还会出现一个软链接:[root@local_master opt]# ls -ltotal 12lrwxrwxrwx 1 root root 22 Apr 19 18:52 greenplum-db -> ./greenplum-db-3.3.6.1 drwxr-xr-x 11 root root 4096 Apr 19 18:52 greenplum-db-3.3.6.1四、Master主机配置1.新增Greenplum用户并指定密码,在root用户下执行# useradd gpadmin# passwd gpadmin# New password: gpadmin# Retype new password: gpadmin2.创建用户组,把gpadmin用户放入组gpadmin中# groupadd gpadmin# usermod -g gpadmin gpadmin3.更改所有者,将创建的Greenplum文件用户更换为gpadminchown -R gpadmin greenplum-db-3.3.6.1chgrp -R gpadmin greenplum-db-3.3.6.1chown -R gpadmin greenplum-dbchgrp -R gpadmin greenplum-db4.配置环境变量greenplum_path.sh这个文件是用来配置环境变量和安装路径的,具体内容:# cat /opt/greenplum-db/greenplum_path.shGPHOME=/opt/greenplum-db-3.3.6.1# Replace with symlink path if it is present and correctif [ -h ${GPHOME}/../greenplum-db ]; thenGPHOME_BY_SYMLINK=`(cd ${GPHOME}/../greenplum-db/ && pwd -P)`if [ x"${GPHOME_BY_SYMLINK}" = x"${GPHOME}" ]; thenGPHOME=`(cd ${GPHOME}/../greenplum-db/ && pwd -L)`/.fiunset GPHOME_BY_SYMLINKfiPATH=$GPHOME/bin:$GPHOME/ext/python/bin:$PATHLD_LIBRARY_PATH=$GPHOME/lib:$GPHOME/ext/python/lib:$LD_LIBRARY_PA THPYTHONPATH=$GPHOME/lib/pythonPYTHONHOME=$GPHOME/ext/pythonexport GPHOMEexport PATHexport LD_LIBRARY_PATHexport PYTHONPATHexport PYTHONHOME切换到gpadmin用户下,修改.bash_profile文件为#su – gpadmin#cat .bash_profile# .bash_profile# Get the aliases and functionsif [ -f ~/.bashrc ]; then. ~/.bashrcfi# User specific environment and startup programsGPHOME=/opt/Greenplum# Replace with symlink path if it is present and correctif [ -h ${GPHOME}/../greenplum-db ]; thenGPHOME_BY_SYMLINK=`(cd ${GPHOME}/../greenplum-db/ && pwd -P)`if [ x"${GPHOME_BY_SYMLINK}" = x"${GPHOME}" ]; thenGPHOME=`(cd ${GPHOME}/../greenplum-db/ && pwd -L)`/.fiunset GPHOME_BY_SYMLINKfiPATH=$GPHOME/bin:$GPHOME/ext/python/bin:$PATHLD_LIBRARY_PATH=$GPHOME/lib:$GPHOME/ext/python/lib:$LD_LIBRARY_PA THPYTHONPATH=$GPHOME/lib/pythonPYTHONHOME=$GPHOME/ext/pythonexport GPHOMEexport PATHexport LD_LIBRARY_PATHexport PYTHONPATHexport PYTHONHOME初始化(gpadmin下)source ./bash_profile5.创建master数据文件以root用户创建master的数据存放路径,该目录只存放系统数据,不会存放其他用户数据,并更改所有者#mkdir /opt/master_database#chown gpadmin /opt/ master_database#chgrp gpadmin /opt/ master_database五、Segment主机配置1.建立主机文件阵列以root用户先在master上建立一个包含所有(master,segment,backup master)主机名的文件如下:[root@local_master ~]# cat /etc/all_hostslocal_masterlocal_segment2.修改master的hosts文件分别查看虚拟机OS的ip地址,并加入master(选其中的一台)#ifconfig -ainet addr:192.168.224.128 --masterinet addr:192.168.224.131 --segment以128作为master,修改/etc/hosts文件为# Do not remove the following line, or various programs# that require network functionality will fail.127.0.0.1 localhost.localdomain localhost192.168.224.128 local_master192.168.224.131 local_segment建立信任的主机环境,在master上以root用户登录,初始化参数#source /opt/greenplum-db-3.3.6.1/greenplum_path.sh测试master与segment的连接,采用Gp自带的包,测试过程如下:[root@local_master ~]# gpssh-exkeys -f /etc/all_hosts[STEP 1 of 5] create local ID and authorize on local host... /root/.ssh/id_rsa file exists ... key generation skipped[STEP 2 of 5] keyscan all hosts and update known_hosts file[STEP 3 of 5] authorize current user on remote hosts... send to local_segment****** Enter password for local_segment:[STEP 4 of 5] determine common authentication file content[STEP 5 of 5] copy authentication files to all remote hosts... finished key exchange with local_segment[INFO] completed successfully期间会要求输入segment端root用户的密码,该过程主要是check远程的segment主机以及验证两个主机间的通信顺畅。

GREENPLUM安装(总结+注释)

GREENPLUM安装(总结+注释)2013-05-05 12:07 2592人阅读评论(0) 收藏举报分类:greenplum(24)原文:/25548387/viewspace-690174GREENPLUM的安装,应该说是极其简单的。

大致的过程可以分成四大部分。

1、准备硬件2、准备操作系统3、安装GP软件4、初始化系统。

1.硬件环境的准备(如果只是构建测试平台,不考虑性能,这部分内容可以忽略)首先就是硬件准备。

GREENPLUM本身只能运行X86架构的服务器上。

因此甭管是普通的PC机还是PC SERVER,甚至是虚拟机都可以运行GREENPLUM。

唯一的差别就是效率。

按照官方文档的说法,主要是针对生产环境,构造一个标准的GREENPLUM系统需要三台PC服务器。

根据实际使用经验,这些服务器至少应该是XEON以上的CPU,1,MASTER节点需要16GB内存,如果使用千兆网卡构建内联环境,至少5块千兆网卡,其中四块千兆网卡用来构建系统的INTERCONNECT,一块用来作为连接系统的PUBLIC 网卡。

当然如果有条件的话,内联可以用万兆网卡或者IB,效率会更高。

MASTER的存储没有什么特殊要求。

2,SEGMENT节点(分节点)需要32G内存。

如果使用千兆网卡构建内联环境,至少4块千兆网卡,不需要外联网卡。

数据存储可以使用PC SERVER内置硬盘,也可以使用外置存储阵列方式(取决于成本和性能的平衡),总数据量不超过可用存储的70%既可。

GP提供了一个叫做gpcheckperf的工具可以帮助你检测当前硬件配置的性能情况,并给出报告。

为了获取准确的测试数据,建议多运行几次,取平均值。

总体而言,与专用设备和系统相比,构建GREENPLUM的生产环境的硬件成本是很低廉的。

2.操作系统的准备支持GREENPLUM运行的操作系统平台主要包括LINUX(REDHAT 5.4 orlater/CENTOS 5.4 or later/SUSE 10.2 or later) 32bit/64bit,solaris x86 64bit,以及MAC OS 64bit。

Greenplum安装手册(多节点)

Greenplum数据库安装手册目录第一章文档概述 (4)1.1适用范围 (4)1.2文档说明 (4)第二章安装介质 (5)2.1R EDHAT (5)2.1.1系统补丁 (5)2.1.2Greenplum安装介质(参考) (7)2.1.3操作系统建议 (8)第三章安装前准备 (9)3.1网络规划 (9)3.2存储空间规划 (9)3.3数据库实例规划 (10)第四章操作系统准备 (11)4.1修改主机名 (11)4.2修改/ETC/HOSTS文件 (11)4.3关闭相关服务 (13)4.4修改系统参数(R EDHAT) (13)4.4.1修改系统参数/etc/sysctl.conf (13)4.4.2修改系统参数/etc/security/limits.conf (14)4.4.3修改磁盘预读参数 (14)4.4.4修改配置/boot/grub/menu.lst (14)4.4.5修改配置/etc/sysconfig/language (15)4.5修改系统参数(S OLARIS) (15)4.6启动IPMI服务 (15)4.7修改启动配置 (15)4.8关闭非必要的服务 (15)5.1L INUX系统采用XFS文件系统 (17)5.1.1Master 和Standby Master主机 (17)5.1.2Segment 主机 (17)5.2S OLARIS系统采用ZFS文件系统 (17)第六章MASTER安装GREENPLUM (19)6.1运行安装文件 (19)6.2配置HOSTNAME文件(用于建立多机信任) (19)第七章建立多机信任 (23)7.1ROOT用户建立多机信任 (23)7.2建立用户和组 (23)7.3修改GPADMIN用户配置 (23)7.4GPADMIN用户建立多机信任 (24)第八章时钟同步 (25)第九章其他机器安装GREENPLUM (27)9.1方法一(4.0版本以上支持,推荐使用) (27)9.2方法二(4.0版本一下使用) (27)第十章系统检查 (28)10.1参数配置检查 (28)10.2性能检查 (28)10.2.1网络性能检查 (28)10.2.2磁盘性能检查 (28)第十一章初始化数据库 (29)11.1配置文件 (29)11.1.1Greenplum4.x版本 (29)11.1.2Greenplum3.x版本 (30)11.3修改访问权限 (31)第十二章安装PERFORMANCE MONITOR (32)12.1安装P ERFORMANCE M ONITOR数据收集A GENT (32)12.2安装P ERFORMANCE M ONITOR控制台 (32)第十三章附录 (35)13.1多次初始化 (35)13.2安装后修改数据库参数(非必要) (35)13.3安装后数据测试 (36)第一章文档概述1.1 适用范围1、本安装手册描述适用于Greenplum4.0以上版本的安装操作,4.0以下版本安装步骤存在差异。

Linux下安装Greenplum实录

Linux下安装Greenplum实录一、配置系统环境A. 以root用户登录系统B. 编辑/etc/sysctl.conf,添加以下内容:kernel.shmmax = 500000000kernel.shmmin = 4096kernel.shmall = 4000000000kernel.sem = 250 64000 100 512net.ipv4.tcp_tw_recycle=1net.ipv4.tcp_max_syn_backlog=4096dev_max_backlog=10000net.ipv4.conf.default.arp_filter=1net.ipv4.conf.all.arp_filter=1vm.overcommit_memory=2C. 编辑/etc/security/limits.conf,添加以下内容:* soft nofile 65536* hard nofile 65536* soft nproc 131072* hard nproc 131072D. 下载并安装greenplum-db。

wgethttp://192.168.47.2:8080/greenplum-db-3.3.6.1-build-1-RHEL5-i386.zip unzip greenplum-db-3.3.6.1-build-1-RHEL5-i386.ziprm -rf greenplum-db-3.3.6.1-build-1-RHEL5-i386.zip./greenplum-db-3.3.6.1-build-1-RHEL5-i386.binrm -rf greenplum-db-3.3.6.1-build-1-RHEL5-i386.bincd /usr/local/greenplum-dbE. 修改/etc/sysconfig/network以修改本机名,修改以下内容:HOSTNAME=mdwF. 修改/etc/sysconfig/network-scripts/ifcfg-eth0使用固定IP(192.168.47.155),添加以下内容:NAME=eth0BOOTPROTO=staticIPADDR=192.168.47.155NETMASK=255.255.255.0//USERCONTROL=noUSERCTL=noG. 修改/etc/hosts以使segment节点也指向本机,(本机固定为192.168.47.155,sdw1和sdw2是两个segment节点,因为实验性质,而同样指向本机,)修改及添加以下内容:192.168.47.155 mdw.localdomain mdw127.0.0.1 localhost.localdomain localhost127.0.0.1 sdw1.localdomain sdw1127.0.0.1 sdw2.localdomain sdw2H. 重启系统以使IP配置生效。

Greenplum环境安装配置步骤

Greenplum环境安装配置步骤分类:Greenplum 2021-03-10 10:23 1145人阅读评论(0) 收藏举报hadoop数据库emcgreenplumdatabase1、环境准备服务器分配192.168.100.101--mdw 192.168.100.11--smdw 192.168.100.12--sdw1192.168.100.13--sdw2ms1与ms2之间的心跳ip配置 10.10.10.1--mdw 10.10.10.2--smdw2、修改hosts文件(所有主机hosts文件必须全部修改)vi /etc/hosts192.168.100.101 mdw 192.168.100.11 smdw 192.168.100.12 sdw1 192.168.100.13 sdw23、关闭iptables和selinux[root@mdw ~]# serviceiptables stop [root@mdw ~]# [root@mdw ~]# [root@mdw ~]# [root@mdw ~]#[root@mdw ~]# chkconfigiptables --listiptables 0:��抽�� 1:��抽�� 2:��抽��3:��抽�� [root@mdw ~]# export LANG=zh_CN [root@mdw ~]# chkconfigiptables --listiptables 0:关闭 1:关闭 2:关闭 3:关闭 4:关闭 5:关闭 6:关闭[root@mdw ~]# cat /etc/selinux/config# This file controls the state of SELinux on the system. # SELINUX= can take one of these three values:4:��抽��5:��抽�� 6:��抽�� # enforcing - SELinux security policy is enforced.# permissive - SELinux prints warnings instead of enforcing. # disabled - No SELinux policy is loaded. SELINUX=disabled# SELINUXTYPE= can take one of these two values: # targeted - Targeted processes are protected, # mls - Multi Level Security protection. SELINUXTYPE=targeted[root@mdw ~]# setenforce 04、修改系统参数 1)vi /etc/sysctl.conf [root@mdw ~]# sysctl -pnet.ipv4.ip_forward = 0net.ipv4.conf.default.rp_filter = 1net.ipv4.conf.default.accept_source_route = 0 kernel.sysrq = 1kernel.core_uses_pid = 1 net.ipv4.tcp_syncookies = 1error: \error: \error: \kernel.msgmnb = 65536 kernel.msgmax = 65536 kernel.shmmax = 68719476736 kernel.shmall = 4294967296error: \vm.overcommit_memory = 2error: \net.ipv4.tcp_max_syn_backlog = 4096 net.ipv4.conf.all.arp_filter = 1error: \dev_max_backlog = 10000 error: \kernel.shmmni = 4096kernel.sem = 250 512000 100 2048 net.ipv4.tcp_tw_recycle = 1net.ipv4.conf.default.arp_filter = 1kernel.msgmni = 20482) vi /etc/security/limits.conf* softnofile 65536 * hardnofile 65536 * softnproc 131072 * hardnproc 131072在RHEL6.x版本需要修改文件 /etc/security/limits.d/90-nproc.conf,增加如下内容: * softnproc 131072 * hardnproc 1310724、修改完系统参数后重启服务器5、创建gpadmin用户 useraddgpadmin6、安装GP1) 上传安装文件解压缩 2)执行安装文件[root@mdw GPDB]# ./greenplum-db-4.2.6.3-build-2-RHEL5-x86_64.binI HAVE READ AND AGREE TO THE TERMS OF THE ABOVE EMC SOFTWARE LICENSE AGREEMENT.****************************************************************************** ** Do you accept the EMC Database license agreement? [yes|no]****************************************************************************** ** yes****************************************************************************** ** Provide the installation path for Greenplum Database or press ENTER to accept the default installation path: /usr/local/greenplum-db-4.2.6.3****************************************************************************** **/home/gpadmin/GPDB/install****************************************************************************** ** Install Greenplum Database into ? [yes|no]****************************************************************************** ** yes****************************************************************************** ** [Optional] Provide the path to a previous installation of Greenplum Database, or press ENTER to skip this step. e.g. /usr/local/greenplum-db-4.1.1.3This installation step will migrate any Greenplum Database extensions from the provided path to the version currently being installed. This step is optional and can be run later with:gppkg --migrate /home/gpadmin/GPDB/install****************************************************************************** **Extracting product to /home/gpadmin/GPDB/installSkipping migration of Greenplum Database extensions...******************************************************************************** Installation complete.Greenplum Database is installed in /home/gpadmin/GPDB/installGreenplum Database documentation is available for download at.****************************************************************************** ** [root@mdw GPDB]#[root@mdw install]# source greenplum_path.sh [root@mdw install]#3)准备allnotes文件 [root@mdw install]# pwd /home/gpadmin/GPDB/install [root@mdw install]# [root@mdw install]# [root@mdw install]# [root@mdwinstall]# lsallnotes bin demo docs etc ext GPDB-LICENSE.txt greenplum_path.sh include lib LICENSE.thirdparty sbin share[root@mdw install]# catallnotes sdw1 sdw2 smdw4)建立多机互信[root@mdw install]# gpssh-exkeys -f allnotes[STEP 1 of 5] create local ID and authorize on local host .../root/.ssh/id_rsa file exists ... key generation skipped[STEP 2 of 5] keyscan all hosts and update known_hosts file[STEP 3 of 5] authorize current user on remote hosts ... send tosdw1 ... send to sdw2 ****** Enter password for sdw2: ... send to smdw[STEP 4 of 5] determine common authentication file content[STEP 5 of 5] copy authentication files to all remote hosts ... finished key exchange with sdw1[ERROR] unable to copy authentication files to sdw2 lost connection[ERROR] unable to copy authentication files to smdw lost connection上述报错解决办法:删除mdw /root/.ssh/目录下的内容重新执行gpssh-exkeys -f allnotes5)创建存放数据的目录[root@mdw GPDB]# mkdir data [root@mdw GPDB]# mkdir data/master[root@mdw GPDB]# chowngpadmin:gpadmin data -R [root@mdw GPDB]#感谢您的阅读,祝您生活愉快。

Greenplum-数据库安装方案

XX移动Greenplum数据库安装修改记录目录1物理环境部署31.1Greenplum物理架构设计错误!未定义书签。

1.2磁盘硬件RAID设计51.3网络IP规划52软件环境安装配置72.1操作系统安装配置72.2操作系统参数设置112.3操作系统安全配置142.4操作系统用户组和用户162.5网络配置162.6集群NTP服务时钟同步配置173数据库系统安装配置173.1Greenplum软件安装173.2数据库初始化214数据库参数224.1数据库参数设置224.2调整连接控制参数245Command center安装241物理环境部署1.1Greenplum物理架构概述Greenplum是一种基于postgresql(开源数据库)的分布式数据库。

其采用shared nothing架构(MPP),主机,操作系统,内存,存储都是自我控制的,不存在共享。

主要由master host(master管理节点),segment host(segment 数据节点),interconnect(网络)三大组件组成,segment host又包括primary segment(主segment实例)与mirror segment(镜像segment实例)。

如下图所示:其中各组件功能如下:➢Master host (master管理节点)主要负责接收并分配查询等任务,是Greenplum环境与外界通信的入口。

并且,master管理节点不存储任何业务数据,只负责对各Segment数据节点抽取出的业务数据进行汇总,反馈给用户。

➢Standby master(Standbymaster管理节点)主要作为master管理节点的热备份节点,当master管理节点宕机时Standby master则扮演master 管理节点角色。

➢Node/segment host(Segment数据节点)主要负责运行Segmentinstances(Segment实例)的服务进程,支撑多少个Segment 实例取决于Segment数据节点CPU核数。

Greenplum源码安装教程——以CentOS平台为例

Greenplum源码安装教程——以CentOS平台为例Greenplum 源码安装教程作者:Arthur_Qin ⽲众Greenplum 主体以及orca ( 新⼀代优化器 ) 的代码以可以从上下载。

如果不打算查看代码,想下载编译好的⼆进制版可以访问其母公司下载,具体配置安装流程可以参考。

正⽂由此开始:⽬录1 Greenplum 介绍Greenplum is built on PostgreSQL and operates as a data warehouse and uses a shared-nothing, massively parallel processing (MPP) architecture, available under the terms of the GNU General Public License, owned by Pivotal. ——本⽂主要记录 Greenplum 的源码安装过程,对 Greenplum 架构和历史感兴趣的推荐阅读 ,以及我的另⼀篇博⽂。

2 安装环境及软件版本参数版本主机数量3台虚拟机,单核1.5G内存 (1台作为 master, 2台作为 slave),能联⽹主机系统Centos6.7Greenplum 版本201609 Github 版 (4.3.X)如果使⽤远程服务器安装,且远程服务器不能直接联⽹的,可通过同⽹段下其他主机代理联⽹。

详情可搜索关键字ccproxy 代理。

这⾥使⽤1个master,2个slave,ip为10.77.100.12110.77.100.12210.77.100.123其中10.77.100.121为master,其余为segment。

可以使⽤的内⽹ ip ,也可以使⽤外⽹ ip ,能相互ping通就可以。

(虚拟机上⽹的话其实是可以与主机共享⽹络的,可以把⽹络连接的⽹络共享给vmware虚拟机⽹络,请参考或者,然后在 Greenplum 的配置⽂件中使⽤ 192开头的 ip 即可)3 安装准备⼯作3.1 修改hosts(所有机器)这⾥主要是为之后Greenplum能够在各个节点之间相互通信做准备[root@dw-greenplum-1 conf]# vi /etc/hosts127.0.0.1 localhost localhost.localdomain10.77.100.121 dw-greenplum-1 mdw10.77.100.122 dw-greenplum-2 sdw110.77.100.123 dw-greenplum-3 sdw2这⼀定要⽤⾃⼰的 ip 啊,不要直接复制粘贴上⾯的。

GreenPlum安装笔记-图文

GreenPlum安装笔记-图文2022/6/1322:51GP架构_1与GreenPlum类似的产品:IBMNITIZA(国内没人用)Terndata2007年被EMC收购MPP架构:海量并行处理MaivelyParallelProceingharenothing模式,每一个节点不进行资源共享,集群中每个节点有独立的CPU、内存、存储、总线等。

SMP架构:ymmetricmaproceing对称多处理系统:耦合的多处理系统,共享总线、内存、IO资源,传统的ORCKLE,DB2是非常典型的产品ORACLE_RAC处于半共享状态,各节点连接共享存储,所以不能算MPP GP增加BI和数据仓库的支持:A、外部表、并行加载(优势明显)B、资源队列管理的优化,对角色、用户、组进行资源优化分配,管理。

C、GP在查询优化器的增强、分布支持、分区表、执行计划的优化、空间回收、数据分析,简化调优,架构时对称、数据分布均匀的话,可以免去调优GP体系架构SegmentHotLANSegmentHotClientSegmentHotInterconnect-GigabitEthernetSwitchMaterHotSegmentHotMaterHot:访问系统的入口,所有请求都需要从MaterHot访问,正常来讲,管理员也不可以直接访问SegmentHot,系统中只允许直接访问MaterHot,单独操作SegmentHot影响一致性和完整性。

数据监听进程(PotGre):监听用户请求。

处理所有用户连接。

建立执行计划,通过网络层分发给SegmentHot。

协调整个处理过程,保证SegmentHot处理结果侧一致和同步。

只存储GP系统自身的数据,MaterHot的数据是很小的,存储架构信息、配置信息。

不包含任何用户数据。

SegmentHot数据节点一些银行使用了60egmentHot节点,一天的交易数据,分布在不同的SegHot中,分布的逻辑由,我们建立数据仓库的时候指定的,比如:随机的、指定分布键,每个SegmentHot存储一部分用户数据。

Greenplum的安装

Greenplum的安装Geenplum是一款基于postgresql开发的mpp数据库,适合于数据仓库数据存储,是对hadoop无法有效处理结构化数据的一个很好的补充。

五年前曾经使用过greenplum,那时的版本还是3.6,现在已经更新到4.3.5了,有消息称今年将开源。

和以前的相比,安装方式也有了一些小变化,简记如下,如要更详细的说明,还是得看官方文档。

一、测试环境CentOS 6.5 8台虚机Greenplum 4.3.5 二、环境准备1.修改系统参数编辑/etc/sysctl.conf ,以下是最小配置kernel.shmmax = 500000000kernel.shmmni = 4096kernel.shmall = 4000000000kernel.sem = 250 512000 100 2048kernel.sysrq = 1kernel.core_uses_pid = 1kernel.msgmnb = 65536kernel.msgmax = 65536kernel.msgmni = 2048net.ipv4.tcp_syncookies = 1net.ipv4.ip_forward = 0net.ipv4.conf.default.accept_source_route = 0net.ipv4.tcp_tw_recycle = 1net.ipv4.tcp_max_syn_backlog = 4096net.ipv4.conf.all.arp_filter = 1net.ipv4.ip_local_port_range = 1025 65535dev_max_backlog = 10000net.core.rmem_max = 2097152net.core.wmem_max = 2097152vm.overcommit_memory = 2 2.修改文件打开数等限制编辑/etc/security/limits.conf* soft nofile 65536* hard nofile 65536* soft nproc 131072* hard nproc 131072编辑/etc/security/limits.d/90-nproc.conf* soft nofile 65536* hard nofile 65536* soft nproc 131072* hard nproc 1310723.修改scheduler编辑scheduler,原先默认是cfqecho deadline > /sys/block/vda/queue/scheduler [root@bigdata03 ~]# more/sys/block/vda/queue/schedulernoop anticipatory [deadline] cfq 4.编辑/boot/grub/grub.conf 新增elevator=deadline[root @bigdata03 ~]# more /boot/grub/grub.conf...elevator=deadline crashkernel=auto ...5.编辑设备块大小[root@bigdata03 ~]# /sbin/blockdev --setra 16384 /dev/vda [root@bigdata03 ~]# /sbin/blockdev --getra /dev/vda 163846.配置hosts文件编辑/etc/hosts,添加,选中203作为master,其他为segment,偷懒没改,直接加了层别名172.30.13.203 bigdata03.rdchz mdw172.30.13.204 bigdata04.rdchz sdw1172.30.13.205 bigdata05.rdchz sdw2172.30.13.206 bigdata06.rdchz sdw3172.30.13.207 bigdata07.rdchz sdw4172.30.13.208 bigdata08.rdchz sdw5172.30.13.209 bigdata09.rdchz sdw6172.30.13.210 bigdata10.rdchz sdw77.分别创建各数据节点文件(一个含master,一个不含)[root@bigdata03 ~]# more /tmp/hostfile_exkeysmdwsdw1sdw2sdw3sdw4sdw5sdw6sdw7[root@bigdata03 data]# more /tmp/hostfile_segments sdw1sdw2sdw3sdw4sdw5sdw6sdw7三、集群安装1.软件下载,上传、解压缩下载地址:https://network.pivotal.io/products/pivotal-gpdb unzip greenplum-db-4.3.5.2-build-1-RHEL5-x86_64.zip/bin/bash greenplum-db-4.3.5.2-build-1-RHEL5-x86_64.bin 输入yes同意aggrement输入安装路径,比如/usr/local/gpmaster最后安装完后,结果是这样的:[root@bigdata03 gpmaster]# lltotal 284drwxr-xr-x 3 gpadmin gpadmin 4096 Jun 24 12:29 bindrwxr-xr-x 2 gpadmin goadmin 4096 Jun 24 12:09 demo drwxr-xr-x 5 gpadmin gpadmin 4096 Jun 24 12:09 docs drwxr-xr-x 2 gpadmin gpadmin 4096 Jun 24 12:09 etc drwxr-xr-x 3 gpadmin gpadmin 4096 Jun 24 12:09 ext-rw-r--r-- 1 gpadmin gpadmin 43025 Jun 24 12:29 GPDB-LICENSE.txt-rw-r--r-- 1 gpadmin gpadmin 664 Jul 28 14:51 greenplum_path.shdrwxr-xr-x 6 gpadmin gpadmin 4096 Jun 24 12:09 includedrwxr-xr-x 9 gpadmin gpadmin 12288 Jun 24 12:09 lib-rw-r--r-- 1 gpadmin gpadmin 193083 Jun 24 12:29 LICENSE.thirdpartydrwxr-xr-x 2 gpadmin gpadmin 4096 Jun 24 12:29 sbin drwxr-xr-x 3 gpadmin gpadmin 4096 Jun 24 11:57 share2.建立master与各节点的信任关系[root@bigdata03 ~]# source/usr/local/greenplum-db/greenplum_path.sh[root@bigdata03 ~]# gpssh-exkeys -f /tmp/hostfile_exkeys [STEP 1 of 5] create local ID and authorize on local host [STEP 2 of 5] keyscan all hosts and update known_hosts file[STEP 3 of 5] authorize current user on remote hosts ... send to sdw1****** Enter password for sdw1:... send to sdw2... send to sdw3... send to sdw4... send to sdw5... send to sdw6... send to sdw7[STEP 4 of 5] determine common authentication file content[STEP 5 of 5] copy authentication files to all remote hosts ... finished key exchange with sdw1... finished key exchange with sdw2... finished key exchange with sdw3... finished key exchange with sdw4... finished key exchange with sdw5... finished key exchange with sdw6... finished key exchange with sdw7[INFO] completed successfully实质就是master与各个节点创建了个ssh的信任关系,信任的key存放在/root/.ssh/authorized_keys里--测试是否无需密码登陆,ok[root@bigdata03 ~]# ssh root@172.30.13.204Last login: Wed Jul 29 08:45:58 2015 from 172.30.11.31 [root@bigdata04 ~]# exitlogoutConnection to 172.30.13.204 closed.[root@bigdata03 ~]#[root@bigdata03 ~]# ssh root@sdw7Last login: Wed Jul 29 08:49:20 2015 from 172.30.11.31 [root@bigdata10 ~]# exitlogoutConnection to sdw7 closed.[root@bigdata03 ~]#3.安装各个节点准备首先把包传送到各个节点上,并解压缩以及创建用户,组等[root@bigdata03 ~]# gpseginstall -f /tmp/hostfile_exkeys -u gpadmin -p 12345620150729:09:20:20:029326gpseginstall:bigdata03:root-[INFO]:-Installation Info:link_name greenplum-dbbinary_path /usr/local/gpmasterbinary_dir_location /usr/localbinary_dir_name gpmaster20150729:09:20:20:029326gpseginstall:bigdata03:root-[INFO]:-check cluster password access20150729:09:20:22:029326gpseginstall:bigdata03:root-[INFO]:-de-duplicate hostnames20150729:09:20:22:029326gpseginstall:bigdata03:root-[INFO]:-master hostname: bigdata03.rdchz20150729:09:20:23:029326gpseginstall:bigdata03:root-[INFO]:-check for user gpadmin on cluster20150729:09:20:24:029326gpseginstall:bigdata03:root-[INFO]:-add user gpadmin on master20150729:09:20:24:029326gpseginstall:bigdata03:root-[INFO]:-add user gpadmin on cluster20150729:09:20:24:029326gpseginstall:bigdata03:root-[INFO]:-chown -R gpadmin:gpadmin /usr/local/greenplum-db20150729:09:20:24:029326gpseginstall:bigdata03:root-[INFO]:-chown -Rgpadmin:gpadmin /usr/local/gpmaster20150729:09:20:25:029326gpseginstall:bigdata03:root-[INFO]:-rm -f/usr/local/gpmaster.tar; rm -f /usr/local/gpmaster.tar.gz 20150729:09:20:25:029326gpseginstall:bigdata03:root-[INFO]:-cd /usr/local; tar cf gpmaster.tar gpmaster20150729:09:20:27:029326gpseginstall:bigdata03:root-[INFO]:-gzip/usr/local/gpmaster.tar20150729:09:20:54:029326gpseginstall:bigdata03:root-[INFO]:-remote command: mkdir -p /usr/local20150729:09:20:55:029326gpseginstall:bigdata03:root-[INFO]:-remote command: rm -rf /usr/local/gpmaster20150729:09:20:56:029326gpseginstall:bigdata03:root-[INFO]:-scp software to remote location20150729:09:21:00:029326gpseginstall:bigdata03:root-[INFO]:-remote command: gzip -f -d /usr/local/gpmaster.tar.gz20150729:09:21:06:029326gpseginstall:bigdata03:root-[INFO]:-md5 check on remote location20150729:09:21:09:029326gpseginstall:bigdata03:root-[INFO]:-remote command: cd /usr/local; tar xf gpmaster.tar20150729:09:21:11:029326gpseginstall:bigdata03:root-[INFO]:-remote command: rm -f /usr/local/gpmaster.tar20150729:09:21:12:029326gpseginstall:bigdata03:root-[INFO]:-remote command: cd /usr/local; rm -f greenplum-db; ln -fs gpmaster greenplum-db20150729:09:21:13:029326gpseginstall:bigdata03:root-[INFO]:-remote command: chown -R gpadmin:gpadmin /usr/local/greenplum-db 20150729:09:21:14:029326gpseginstall:bigdata03:root-[INFO]:-remote command: chown -R gpadmin:gpadmin /usr/local/gpmaster 20150729:09:21:15:029326gpseginstall:bigdata03:root-[INFO]:-rm -f/usr/local/gpmaster.tar.gz20150729:09:21:15:029326gpseginstall:bigdata03:root-[INFO]:-Changing system passwords ...20150729:09:21:17:029326gpseginstall:bigdata03:root-[INFO]:-exchange ssh keys for user root20150729:09:21:22:029326gpseginstall:bigdata03:root-[INFO]:-exchange ssh keys for user gpadmin20150729:09:21:30:029326gpseginstall:bigdata03:root-[INFO]:-/usr/local/greenplum-d b/./sbin/gpfixuserlimts -f /etc/security/limits.conf -u gpadmin20150729:09:21:30:029326gpseginstall:bigdata03:root-[INFO]:-remote command: ./usr/local/greenplum-db/./greenplum_path.sh;/usr/local/greenplum-db/./sbin/gpfixuserlimts -f/etc/security/limits.conf -u gpadmin20150729:09:21:31:029326gpseginstall:bigdata03:root-[INFO]:-version string onmaster: gpssh version 4.3.5.2 build 120150729:09:21:31:029326gpseginstall:bigdata03:root-[INFO]:-remote command: ./usr/local/greenplum-db/./greenplum_path.sh;/usr/local/greenplum-db/./bin/gpssh --version 20150729:09:21:32:029326gpseginstall:bigdata03:root-[INFO]:-remote command: ./usr/local/gpmaster/greenplum_path.sh;/usr/local/gpmaster/bin/gpssh --version20150729:09:21:38:029326gpseginstall:bigdata03:root-[INFO]:-SUCCESS -- Requested commands completed[root@bigdata03 ~]#--或者用gp自带的工具包测试能否无密码登陆已经安装包是否已经被解压到各节点上面,正常情况下会显示出各个节点的gphome信息[root@bigdata03 ~]# gpssh -f hostfile_exkeys -e ls -l $GPHOME4.创建各个节点的数据文件夹,并授权,保证数据文件夹是干净的[root@bigdata03 data]# gpssh -f /tmp/hostfile_segments -e 'mkdir -p /data/primary'[sdw4] mkdir -p /data/primary[sdw3] mkdir -p /data/primary[sdw5] mkdir -p /data/primary[sdw1] mkdir -p /data/primary[sdw6] mkdir -p /data/primary[sdw2] mkdir -p /data/primary[sdw7] mkdir -p /data/primary[root@bigdata03 data]# gpssh -f /tmp/hostfile_segments -e 'chown gpadmin /data/primary'[sdw4] chown gpadmin /data/primary[sdw3] chown gpadmin /data/primary[sdw5] chown gpadmin /data/primary[sdw1] chown gpadmin /data/primary[sdw6] chown gpadmin /data/primary[sdw2] chown gpadmin /data/primary[sdw7] chown gpadmin /data/primary【注意:这里只是在segs上创建了数据文件夹,需要在master 上也要创建文件夹并授权mkdir -p /data/masterchown gpadmin /data/master】5.时钟同步[root@bigdata03 ~]# vi /etc/ntp.confserver 172.30.11.8【在每个节点上都要安装ntp服务:yum install ntpservice ntpd startchkconfig ntpd on】各个节点上的时钟以master为准,如04节点,需要改在第一行[root@bigdata04 ~]# vi /etc/ntp.confserver mdw[root@bigdata03 ~]# gpssh -f/tmp/hostfile_exkeys -v -e 'ntpd'[Reset ...][INFO] login sdw4[INFO] login sdw3[INFO] login mdw[INFO] login sdw5[INFO] login sdw1[INFO] login sdw6[INFO] login sdw2[INFO] login sdw7[sdw4] ntpd[sdw3] ntpd[ mdw] ntpd[sdw5] ntpd[sdw1] ntpd[sdw6] ntpd[sdw2] ntpd[sdw7] ntpd[INFO] completed successfully[Cleanup...][root@bigdata03 ~]#6.检查参数设置检查参数设置,正常情况是这样的[root@bigdata03 ~]# gpcheck -f /tmp/hostfile_exkeys -m mdw -s sdw120150729:11:18:20:001805gpcheck:bigdata03:root-[INFO]:-dedupe hostnames 20150729:11:18:20:001805gpcheck:bigdata03:root-[INFO]:-Detected platform: Generic Linux Cluster20150729:11:18:20:001805gpcheck:bigdata03:root-[INFO]:-generate data on servers 20150729:11:18:20:001805gpcheck:bigdata03:root-[INFO]:-copy data files fromservers20150729:11:18:21:001805gpcheck:bigdata03:root-[INFO]:-delete remote tmp files 20150729:11:18:21:001805gpcheck:bigdata03:root-[INFO]:-Using gpcheck config file: /usr/local/greenplum-db/./etc/f20150729:11:18:21:001805gpcheck:bigdata03:root-[INFO]:-GPCHECK_NORMAL 20150729:11:18:21:001805gpcheck:bigdata03:root-[INFO]:-gpcheck completing... [root@bigdata03 ~]#【[ERROR]:-GPCHECK_ERROR host(GPMaster): on device (sr0) IO scheduler 'cfq' does not match expected value'deadline'-[ERROR]:-GPCHECK_ERROR host(GPMaster): on device (/dev/sda1) blockdev readahead value '256' does not match expected value '16384'等等错误可以根据具体要求修改:# /sbin/blockdev --getra /dev/sda256# /sbin/blockdev --getra /dev/sda1256# /sbin/blockdev --setra 16385 /dev/sda# /sbin/blockdev --setra 16385 /dev/sda1# /sbin/blockdev --setra 16385 /dev/sda2# service ntpd start# chkconfig ntpd on# echo deadline > /sys/block/sda/queue/scheduler# echo deadline > /sys/block/sr0/queue/scheduler还可以参见:Greenplum数据库扩容实务(上)-准备工作在CentOS6.5x86_64下安装配置GreenPlum】7.检查网络千兆的交换机,只能用千兆的网卡,网络吞吐一般[root@bigdata03 ~]# gpcheckperf -f/tmp/hostfile_segments -r n -d /tmp >test.out[root@bigdata03 ~]# more test.out/usr/local/greenplum-db/./bin/gpcheckperf -f/tmp/hostfile_segments -r n -d /tmp--------------------- NETPERF TEST-------------------====================== RESULT====================Netperf bisection bandwidth testsdw1 -> sdw2 = 845.140000sdw2 -> sdw1 = 762.840000sdw3 -> sdw4 = 932.170000sdw4 -> sdw3 = 1021.450000sdw5 -> sdw6 = 701.030000sdw6 -> sdw5 = 806.280000sdw7 -> sdw1 = 927.360000sdw1 -> sdw7 = 1097.420000Summary:sum = 7093.69 MB/secmin = 701.03 MB/secmax = 1097.42 MB/secavg = 886.71 MB/secmedian = 927.36 MB/sec[Warning] connection between sdw1 and sdw2 is no good[Warning] connection between sdw2 and sdw1 is no good [Warning] connection between sdw3 and sdw4 is no good [Warning] connection between sdw5 and sdw6 is no good [Warning] connection between sdw6 and sdw5 is no good [Warning] connection between sdw7 and sdw1 is no good [root@bigdata03 ~]#8.检查io可以选其中几个节点测试,它会创建几个大文件来测试[root@bigdata03 .ssh]# more /tmp/hostfile_2sdw1sdw2sdw3[root@bigdata03 ~]# gpcheckperf -f /tmp/hostfile_2 -r ds -D -d /data/primary/ -d /data/primary/ -d /data/primary//usr/local/greenplum-db/./bin/gpcheckperf -f /tmp/hostfile_2 -r ds -D -d /data/primary/ -d /data/primary/ -d/data/primary/---------------------- DISK WRITE TEST------------------------------------------ DISK READ TEST------------------------------------------ STREAM TEST--------------------====================== RESULT==================== disk write avg time (sec): 1573.83disk write tot bytes: 379920384000disk write tot bandwidth (MB/s): 233.53disk write min bandwidth (MB/s): 65.47 [sdw2]disk write max bandwidth (MB/s): 86.37 [sdw1]-- per host bandwidth --disk write bandwidth (MB/s): 86.37 [sdw1]disk write bandwidth (MB/s): 65.47 [sdw2]disk write bandwidth (MB/s): 81.69 [sdw3] disk read avg time (sec): 17.75disk read tot bytes: 379920384000disk read tot bandwidth (MB/s): 20440.61disk read min bandwidth (MB/s): 6588.84 [sdw2]disk read max bandwidth (MB/s): 7142.13 [sdw3]-- per host bandwidth --disk read bandwidth (MB/s): 6709.64 [sdw1]disk read bandwidth (MB/s): 6588.84 [sdw2]disk read bandwidth (MB/s): 7142.13 [sdw3] stream tot bandwidth (MB/s): 12247.97stream min bandwidth (MB/s): 3392.68 [sdw3]stream max bandwidth (MB/s): 5069.60 [sdw2]-- per host bandwidth --stream bandwidth (MB/s): 3785.69 [sdw1]stream bandwidth (MB/s): 5069.60 [sdw2]stream bandwidth (MB/s): 3392.68 [sdw3]四、集群初始化【初始化之前每个接待你都要装ed:yum install ed;否则会报错初始化不成功】做了那么多的铺垫准备后,进入真正的安装环节在master上以gpadmin用户登陆[root@bigdata03 ~]# su - gpadmin[gpadmin@bigdata03 ~]$ source/usr/local/gpmaster/greenplum_path.sh[gpadmin@bigdata03 ~]$ mkdir gpconfigs[gpadmin@bigdata03 ~]$ cp$GPHOME/docs/cli_help/gpconfigs/gpinitsystem_config/home/gpadmin/gpconfigs/gpinitsystem_config配置gpinitsystem_config文件,每个segment上1个数据文件夹,因为只有1块网卡,没有配置镜像declare -a DATA_DIRECTORY=(/data/primary)MASTER_PORT=1949CHECK_POINT_SEGMENTS=64ENCODING=UTF8【配置gpinitsystem_config文件时,因为我的hosts主机名不是mdw:MASTER_HOSTNAME=hadoop2;如果初始化失败需要删除/data/master /data/primary里面的所有文件】初始化[gpadmin@bigdata03 gpconfigs]$ gpinitsystem -c gpconfigs/gpinitsystem_config -h /tmp/hostfile_segments 20150729:15:41:27:030870gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking configuration parameters, please wait...20150729:15:41:27:gpinitsystem:bigdata03:gpadmin-[FAT AL]:-Configuration file gpconfigs/gpinitsystem_config does not exist. Script Exiting![gpadmin@bigdata03 gpconfigs]$ cd ..[gpadmin@bigdata03 ~]$ gpinitsystem -cgpconfigs/gpinitsystem_config -h /tmp/hostfile_segments 20150730:16:52:55:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking configuration parameters, please wait...20150730:16:52:55:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Reading Greenplum configuration filegpconfigs/gpinitsystem_config20150730:16:52:55:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Locale has not been set in gpconfigs/gpinitsystem_config, will set to default valuegpinitsystem:bigdata03:gpadmin-[INFO]:-Locale set toen_US.utf820150730:16:52:55:031413gpinitsystem:bigdata03:gpadmin-[WARN]:-Master hostname mdw does not match hostname output 20150730:16:52:55:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking to see if mdw can be resolved on this host20150730:16:52:56:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Can resolve mdw to this host20150730:16:52:56:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-NoDATABASE_NAME set, will exit following template1 updates20150730:16:52:56:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-MASTER_MAX_ CONNECT not set, will set to default value 250 20150730:16:52:56:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking configuration parameters, Completedgpinitsystem:bigdata03:gpadmin-[INFO]:-Commencing multi-home checks, please wait..........20150730:16:52:58:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Configuring build for standard array20150730:16:52:58:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Commencing multi-home checks, Completed20150730:16:52:58:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Building primary segment instance array, please wait..........20150730:16:53:03:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking Master host20150730:16:53:03:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking new segment hosts, please wait..........20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checking new segment hosts, Completed20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Greenplum Database Creation Parameters20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:---------------------------------------20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master Configuration20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:---------------------------------------20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master instance name = EMC Greenplum DW20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master hostname = mdw20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master port= 194920150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master instance dir = /data/master/gpseg-120150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master LOCALE = en_US.utf820150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Greenplum segment prefix = gpseg20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master Database =20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master connections = 25020150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master buffers= 128000kB20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Segment connections = 75020150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Segment buffers = 128000kB20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Checkpoint segments = 6420150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Encoding= UTF820150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Postgres param file = Off20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Initdb to be used = /usr/local/greenplum-db/bin/initdb20150730:16:53:19:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-GP_LIBRARY_P ATH is = /usr/local/greenplum-db/lib 20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Ulimit check= Passed20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Array host connect type = Single hostname per node 20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master IP address [1] = ::120150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master IP address [2] = 172.30.13.20320150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Master IP address [3] = fe80::5054:ff:fec7:b4f520150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Standby Master = Not Configured20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Primary segment # = 120150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Total Database segments = 720150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Trusted shell= ssh20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Number segment hosts = 720150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Mirroring config = OFF20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:----------------------------------------20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Greenplum Primary Segment Configuration20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:----------------------------------------20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw1/data/primary/gpseg0 40000 2 020150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw2/data/primary/gpseg1 40000 3 120150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw3 /data/primary/gpseg2 40000 4 2 20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw4 /data/primary/gpseg3 40000 5 3 20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw5 /data/primary/gpseg4 40000 6 4 20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw6 /data/primary/gpseg5 40000 7 5 20150730:16:53:20:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-sdw7 /data/primary/gpseg6 40000 8 6Continue with Greenplum creation Yy/Nn>y20150730:16:53:29:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Building the Master instance database, please wait... 20150730:16:54:21:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Starting theMaster in admin mode20150730:16:54:32:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Commencing parallel build of primary segment instances20150730:16:54:32:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Spawning parallel processes batch [1], please wait... .......20150730:16:54:32:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Waiting for parallel processes batch [1], please wait... ............................................................................................. ...................20150730:16:56:25:031413gpinitsystem:bigdata03:gpadmin-[INFO]:------------------------------------------------20150730:16:56:25:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Parallel process exit status20150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:------------------------------------------------20150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Total processes marked as completed = 720150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Total processes marked as killed = 020150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Total processes marked as failed = 020150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:------------------------------------------------20150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Deleting distributed backout files20150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Removing back out file20150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-No errors generated from parallel processes20150730:16:56:26:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Restarting the Greenplum instance in production mode20150730:16:56:26:022809gpstop:bigdata03:gpadmin-[INFO]:-Starting gpstop with args: -a -i -m -d /data/master/gpseg-120150730:16:56:26:022809gpstop:bigdata03:gpadmin-[INFO]:-Gathering information and validating the environment...20150730:16:56:26:022809gpstop:bigdata03:gpadmin-[INFO]:-Obtaining Greenplum Master catalog information20150730:16:56:26:022809gpstop:bigdata03:gpadmin-[INFO]:-Obtaining Segment details from master...20150730:16:56:26:022809gpstop:bigdata03:gpadmin-[INFO]:-Greenplum Version: 'postgres (Greenplum Database) 4.3.5.2 build 1' 20150730:16:56:27:022809gpstop:bigdata03:gpadmin-[INFO]:-There are 0 connections to the database20150730:16:56:27:022809gpstop:bigdata03:gpadmin-[INFO]:-Commencing Masterinstance shutdown with mode='immediate'20150730:16:56:27:022809gpstop:bigdata03:gpadmin-[INFO]:-Masterhost=bigdata03.rdchz20150730:16:56:27:022809gpstop:bigdata03:gpadmin-[INFO]:-Commencing Master instance shutdown with mode=immediate20150730:16:56:27:022809gpstop:bigdata03:gpadmin-[INFO]:-Master segment instance directory=/data/master/gpseg-120150730:16:56:28:022809gpstop:bigdata03:gpadmin-[INFO]:-Attempting forceful termination of any leftover master process20150730:16:56:28:022809gpstop:bigdata03:gpadmin-[INFO]:-Terminating processes for segment /data/master/gpseg-120150730:16:56:28:022899gpstart:bigdata03:gpadmin-[INFO]:-Starting gpstart with args: -a -d /data/master/gpseg-120150730:16:56:28:022899gpstart:bigdata03:gpadmin-[INFO]:-Gathering information and validating the environment...20150730:16:56:28:022899gpstart:bigdata03:gpadmin-[INFO]:-Greenplum Binary Version: 'postgres (Greenplum Database) 4.3.5.2 build 1' 20150730:16:56:28:022899gpstart:bigdata03:gpadmin-[INFO]:-Greenplum Catalog Version: '201310150'20150730:16:56:28:022899gpstart:bigdata03:gpadmin-[INFO]:-Starting Master instance in admin mode20150730:16:56:29:022899gpstart:bigdata03:gpadmin-[INFO]:-Obtaining Greenplum Master catalog information20150730:16:56:29:022899gpstart:bigdata03:gpadmin-[INFO]:-Obtaining Segment details from master...20150730:16:56:29:022899gpstart:bigdata03:gpadmin-[INFO]:-Setting new master era 20150730:16:56:29:022899gpstart:bigdata03:gpadmin-[INFO]:-Master Started... 20150730:16:56:29:022899gpstart:bigdata03:gpadmin-[INFO]:-Shutting down master 20150730:16:56:31:022899gpstart:bigdata03:gpadmin-[INFO]:-Commencing parallel segment instance startup, please wait......20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-Process results... 20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-----------------------------------------------------20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:- Successful segment starts= 720150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:- Failed segment starts= 020150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:- Skipped segment starts (segments are marked down in configuration) = 0 20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-----------------------------------------------------20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-Successfully started 7 of 7 segment instances20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-----------------------------------------------------20150730:16:56:34:022899gpstart:bigdata03:gpadmin-[INFO]:-Starting Master instance bigdata03.rdchz directory /data/master/gpseg-1 20150730:16:56:35:022899gpstart:bigdata03:gpadmin-[INFO]:-Command pg_ctl reports Master bigdata03.rdchz instance active 20150730:16:56:35:022899gpstart:bigdata03:gpadmin-[INFO]:-No standby master configured. skipping...20150730:16:56:35:022899gpstart:bigdata03:gpadmin-[INFO]:-Database successfully started20150730:16:56:35:031413gpinitsystem:bigdata03:gpadmin-[INFO]:-Completed。

greenplum部署方案

Greenplum部署方案概述Greenplum是一种高可扩展的并行数据库管理系统,特别适用于大规模数据仓库和分析应用。

本文将介绍Greenplum的部署方案,包括硬件需求、软件安装、配置和管理。

硬件需求Greenplum对硬件的要求主要包括以下几个方面:1.主服务器:用于协调整个集群的工作,需要足够的内存和处理能力。

2.从服务器:用于存储和计算数据,数量根据数据量和并行度而定。

3.网络:主服务器和从服务器之间需要高速的网络连接,建议使用千兆以太网。

4.磁盘:存储数据的磁盘应具有高速读写能力,并提供足够的容量。

软件安装以下是Greenplum的软件安装步骤:1.操作系统:根据Greenplum的要求安装支持的操作系统版本,如CentOS 7.6。

2.安装前准备:创建一个用于安装Greenplum的用户,并为其设置密码和权限。

3.下载安装包:从Greenplum官方网站下载适合您操作系统的安装包。

4.安装:解压安装包并运行安装脚本,按照提示完成安装过程。

5.配置环境变量:将Greenplum的安装目录添加到系统的PATH变量中。

配置和管理配置和管理Greenplum主要包括以下几个方面:集群初始化在部署Greenplum之前,需要进行集群初始化的操作。

这包括设置主服务器和从服务器的网络连接、创建数据库用户、设置密码等。

数据库创建在Greenplum中,可以创建多个数据库。

使用相关命令或图形界面工具可以创建数据库、设置权限、管理数据表等。

数据加载将数据加载到Greenplum中的步骤大致如下:1.创建外部表:定义数据来源和格式的元数据。

2.使用COPY命令或其他ETL工具将数据加载到外部表中。

3.执行INSERT INTO SELECT语句将数据从外部表导入到内部表中。

查询优化查询优化是提高Greenplum性能的重要环节。

以下是一些优化的建议:1.设计合适的数据模型,包括表的分布、索引和分区方式。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目录.GreenPlum数据库概述.........................................GreenPlum数据库架构原理....................................2.SUSELinuxEnterprise1164-bit操作系统安装过程......................初始化阶段 ..................................................系统分区 ....................................................软件选择和系统任务 ..........................................语言选择 ....................................................Kdump设置...................................................安装过程 ...................................................3.配置网卡IP......................................................4.GreenPlum中Master配置过程.......................................建立gpadmin用户 ............................................关闭防火墙 ..................................................启动FTP.....................................................使用FlashXP上传GreenPlum数据 ..............................使用工具配置GreenPlum数据库 ................................GreenPlum数据库配置详情....................................GrennPlum数据库的初始化...............................修改GreenPlum数据库账户的权限........................附录A...............................................................附录B...............................................................1.概述1.1.GreenPlum数据库概述1.2.GreenPlum数据库架构原理本系统中GreenPlum由一个主节点(master)和四个从节点(segment)构成,主节点和从节点由一台千兆交换机进行连接。

客户端(Client)发送的命令通过主节点的主控作用,然后分发到从节点;从节点将用户需要的结果汇总到主节点,由主节点进行整合然后再将结果返回给客户端。

主节点与从节点的链接规则是保证每台服务器中网口的IP地址不是互联互通的,但是与其他的服务器之间可以通信。

换句换说保障同一台服务器中的IP 地址不是处于同一网段,但是不同服务器中的相同网口属于同一网段。

在此需要特别提醒用户Master中一共拥有五块网卡,第五块网卡是与client进行连接的网口。

负责外部用户的访问和数据传输。

2.SUSELinuxEnterprise1164-bit操作系统安装过程安装GreenPlum数据库的服务器,在安装SUSELinuxEnterprise11操作系统之前首先需要进行磁盘阵列的设置。

本系统的GP数据库中磁盘阵列选择Raid5的方式(未完待续…)。

在主节点服务器的安装过程中尤其需要注意:主节点比从节点多一块网卡,在服务器的外面可以很容易的看到主节点的网口为5个,其余从节点的网口为4个。

2.1.初始化阶段服务器的磁盘阵列做完之后,进入服务器的BIOS将服务器的硬盘分Raid5,Raid5做好后设置BIOS的启动项为光驱启动。

然后将SUSE系统安装光盘放入服务器的光驱进入系统安装界面,选择第二项“Installation”,然后按回车键。

接收许可协议如下图中的红色框内,点击下一步校验光盘系统完整性,完成后,点击下一步选择安装模式“NewInstallation”,点击下一步选择时区与时钟,Region选择“亚洲”(Asia),Time_Zone选择“北京”(Beijing)。

注意:此处需要将左下角的“HardWareclockSettoUTC”去掉勾选。

然后点击下一步2.2.系统分区本系统需要分成4个分区,其中数据分区(/data)要求容量最大,其余的分区在满足系统正常运行的前提下保证使用的容量最小。

本系统中每个节点的硬盘为八块1T,做完磁盘阵列后,系统硬盘的总容量大约为7T。

系统分区建议表在安装设置中选择“Expert”主菜单在Expert菜单内选择“Partitioning”选择“CustomPartitioning(forExpert)”,点击下一步在左侧的树状结构中选择“HardDisks”中的sda;然后点击页面下端的“Add”按钮,界面跳转。

选择“Primary”,点击下一步设置“CustomSize”为1GB,然后点击下一步设置“FormatPartition”文件系统的格式为“EXT3”;MountPartition选择“/boot”目录;然后点击“完成”再一次点击“Add”按钮,界面跳转选择“PrimaryPartition”,点击下一步设置“CustomSize”为5GB,点击下一步设置“FormatPartition”为“Swap”,“MountPartition”为“swap”,点击完成第三次点击“Add”按钮,界面跳转选择“PrimaryPartition”,然后点击下一步设置“CustomSize”为5GB,点击下一步设置“FormatPartition”格式为“Ext3”,“MountPartition”格式为“/”,点击完成最后一次点击“Add”按钮,界面跳转。

选择“PrimaryPartition”,点击下一步设置“CustomSize”为剩余的所有容量,点击下一步设置“FormatPartition”文件系统格式为“XFS”,“MountPartition”为“/data”,注意:此处的“/data”需要用户手动输入。

点击完成在“ExpertPartitioner”主界面右下角点击“Accept”按钮。

界面跳转回“InstallationSetting”界面2.3.软件选择和系统任务在“InstallationSetting”主界面选择“Expert”中的“Software”,界面跳转,按照下图进行勾选勾选完成后,点击界面左下角的“Details…”按钮,界面跳转在“Search”输入框内输入“VSFTP”,点击“Search”按钮,将查询的结果勾选,然后点击“Accept”按钮。

界面弹出提示框,请点击“Continue”按钮。

界面将跳转回“InstallationSetting”界面2.4.语言选择在“InstallationSetting”界面,选择“Expert”主菜单中的“Language”,界面跳转在语言栏选择“SimpledChinese”然后点击“Accept”弹出提示框,点击“OK”按钮,界面将跳转回“InstallationSetting”界面2.5.Kdump设置在“InstallationSetting”界面,选择“Expert”主菜单中的“Kdump”,界面跳转在服务器的安装过程中,Kdump中默认选中“enable_Kdump”,我们需要将Kdump更改为“Disable_Kdump”。

然后点击“OK”按钮,界面将跳转回“InstallationSetting”界面2.6.安装过程直接点击右下角“Install”按钮弹出提示框,点击“Install”界面将跳转到安装进度界面开始安装系统,(大约25~40分钟)。

安装结束后,系统会自动重启进入到配置root用户、密码页面。

将密码修改为“root”之后,点击下一步3.配置网卡IP主节点的用户名为:mdw;从节点的用户名为:sdw1/sdw2/sdw3…。

进入网卡配置界面,选择“NetworkInterface”。

(注意:关闭防火墙功能)要求配置的网段IP地址使数据库内部实现完全不共享的架构,并且支持多路数据并发。

例如:下面以mdw主节点为例演示网卡的配置过程。

其他三个子节点的网卡配置过程与主节点网卡配置的过程相似,只是子节点中不存在“”段的网卡,详细的配置请参考“服务器中网卡IP地址配置规则”。

选择第一块网卡,然后点击“Edit”按钮按下图填写网卡IP,然后点击下一步。

注意此处的IP地址是GP数据库对外连接是使用的IP,请用户记好。

选择第二块网卡,然后点击“Edit”按钮按下图填写网卡IP地址,点击下一步选择第三块网卡,点击“Edit”按钮按下图填写网卡的IP,点击“下一步”选择第四块网卡,点击“Edit”按钮按下图填写网卡IP地址,点击下一步选择最后一块网卡,点击“Edit”按下图填写网卡IP,点击“下一步”网卡配置结束,点击右下角“OK”按钮点击“下一步”选择“”,然后点击“下一步”按钮选择“UseFollowingConfiguration”,点击“下一步”按钮直接点击“下一步”按钮弹出提示框,选择“Yes”继续直接点击“下一步”按钮点击“完成”按钮系统重新启动输入用户名:root,然后按“回车”键输入密码:root,然后按“回车”键4.GreenPlum中Master配置过程SUSELinuxEnterprise11操作系统安装完成之后,在Master服务器中进行操作。

首先,在Master节点中新建一个用户(用户名:gpadmin,密码:gpadmin),并且将系统的防火墙关闭、启动FTP服务;然后使用FlashXP将GreenPlum数据库配置所需要的文件上传到指定文件夹;最后使用工具配置GreenPlum数据库中的相关参数。

4.1.建立gpadmin用户登录系统成功后,点击左下角“Computer”,选择“YaST”在“Filter”中输入“user”,然后选择“UserandGroupManage…”点击左下角“Add”按钮新建一个用户,用户名:gpadmin,密码:gpadmin点击“Detail”按钮,在“UserID(uid)”中数据“3030”,然后点击下一步4.2.关闭防火墙在Suse系统中选择“Computer”,点击“YaST”在“Filter”中输入“Firewall”命令,然后选右侧“Firewall”将防火墙关闭,否则使用“FlashXP”工具连接“”时,无法连接成功4.3.启动FTP在Suse系统中选择“Computer”,点击“YaST”在“Filter”中输入“ftp”,然后点击右侧的“FTPServer”按照下图设置“FTPStart-Up”设置完成后,点击“StartFTPNow”按钮,然后点击“finish”按钮4.4.使用FlashXP上传GreenPlum数据使用root用户名和密码登录到SUSE系统,然后logout然后使用FlashXP软件上传所需文件注意此处的IP地址是安装系统时,设置的第一块网卡的IP地址4.5.使用工具配置GreenPlum数据库输入密码:root时用户不可见,数据完成之后回车查看home/gpadmin/Desktop目录下的文件是否存在,按回车键ll命令显示所有的文件夹,按回车键输入下图中划红线的命令,然后按“回车”键一直按空格键直到显示如下图所示输入“yes”同意许可条件按回车键输入yes输入命令“chown–Rgpadmin/user/local/greenplum-db”数据命令“chown–Rgpadmin”输入命令“chown-Rgpadmin/data/”安装greenPlum软件vi/etc/hosts,编辑etc目录下的hosts文件在键盘上按“insert”键,或者直接输入“insert”命令,使用上下左右键进行选择,将这一行删除,删除时请按DEL键在mdwmdw后面回车然后按照下图输入,从“mdwmdw”开始输入修改环境变量注意:其余的子节(sdw1,sdw2,sdw3…)请参考MDW节点进行配置。