Hadoop源代码分析

hadoop技术、方法以及原理的理解

hadoop技术、方法以及原理的理解Hadoop技术、方法以及原理的理解Hadoop是一个开源的分布式计算框架,它能够存储和处理海量的数据。

它由Apache基金会开发和维护,是目前最流行的大数据处理解决方案之一。

Hadoop的技术、方法以及原理是构成Hadoop 的核心部分,下面我们将对其进行详细的解析。

一、Hadoop的技术1. HDFSHadoop分布式文件系统(HDFS)是Hadoop的核心组件之一。

它是一种高度容错的分布式文件系统,具有高可靠性和高可用性。

该文件系统将海量数据分散存储在多个节点上,以实现快速访问和处理。

2. MapReduceMapReduce是Hadoop的另一个核心组件,它是一种编程模型和处理数据的方式。

MapReduce将数据分成小的块,然后在分布式计算机集群上处理这些块。

MapReduce将任务分为Map和Reduce两个阶段。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce阶段,计算的结果被合并起来并输出。

3. YARNHadoop资源管理器(YARN)是另一个重要的组件,它是一个分布式的集群管理系统,用于管理Hadoop集群中的资源。

YARN允许多个应用程序同时运行在同一个Hadoop集群上,通过动态管理资源来提高集群的使用效率。

二、Hadoop的方法1. 大数据存储Hadoop通过HDFS实现对海量数据的存储和管理。

HDFS的设计目标是支持大型数据集的分布式处理,它通过多个节点存储数据,提供高可靠性和高可用性。

2. 数据处理Hadoop通过MapReduce实现对海量数据的处理。

MapReduce 将数据分成小的块,然后在分布式计算机集群上处理这些块。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce 阶段,计算的结果被合并起来并输出。

3. 数据分析Hadoop通过Hive、Pig和Spark等工具实现数据分析。

这些工具提供了高级查询和数据分析功能,可以通过SQL和其他编程语言来处理海量数据。

Hadoop源代码分析_之hadoop配置及启动(1)-----classpath与配置文件

* strings. If no such property is specified, then <code>null</code> * is returned. Values are whitespace or comma delimted. */ public String[] getStrings(String name) {

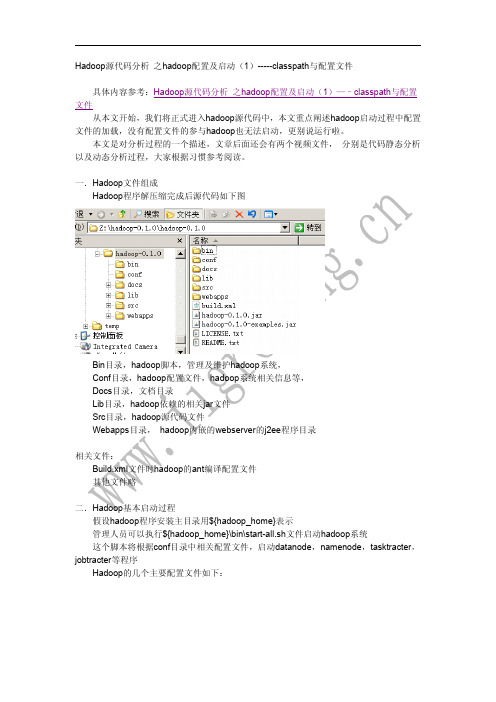

我们打开hadoop的源代码项目(eclipse的java项目)

如下图,我们打开如上目录及java源代码文件

双击左侧 main函数的节点, 然后右面显示相关源代码, 然后在 “runAndWait(new Configuration());”函数调用处,右击鼠标,弹出相关对话框,选择“open Declaration” 选项, 可以直接使用快捷方式 F3按键,可以快速到达相关源代码处 代码如下: private static void runAndWait(Configuration conf) throws IOException {

String valueString = get(name); // 重点语句,负责初始化相关代码,我们需要跟踪进入相 关代码

if (valueString == null) return null;

StringTokenizer tokenizer = new StringTokenizer (valueString,", \t\n\r\f"); List values = new ArrayList(); while (tokenizer.hasMoreTokens()) {

Java大数据处理使用Hadoop和Spark进行数据分析

Java大数据处理使用Hadoop和Spark进行数据分析随着信息技术的迅速发展,海量数据的产生已经成为了一种普遍现象。

在这背景下,大数据处理技术逐渐崭露头角,并发挥着越来越重要的作用。

作为大数据处理的两个重要工具,Hadoop和Spark已经成为了众多企业和研究机构的首选。

本文将对Java大数据处理使用Hadoop和Spark进行数据分析进行探讨,旨在帮助读者更好地理解和应用这两种技术。

一、Hadoop介绍及使用1. Hadoop概述Hadoop是一个开源的、基于Java的大数据处理框架。

它的核心思想是将大数据分布式处理,通过搭建集群实现数据的存储和并行计算。

Hadoop包含了HDFS(Hadoop分布式文件系统)和MapReduce(分布式计算模型)两个核心组件。

2. Hadoop的安装和配置在使用Hadoop进行数据分析之前,我们首先需要完成Hadoop 的安装和配置。

这包括下载Hadoop压缩包、解压缩、配置环境变量和核心配置文件等步骤。

通过正确配置,我们可以保证Hadoop的正常运行和数据处理的准确性。

3. Hadoop与Java的结合由于Hadoop是基于Java的,因此我们可以利用Java语言编写Hadoop程序。

Java提供了丰富的类库和API,使得我们可以方便地开发和调试Hadoop应用。

在Java程序中,我们可以通过Hadoop的API实现数据的输入、输出、计算和结果的保存等功能。

二、Spark介绍及使用1. Spark概述Spark是一个快速、通用、可扩展的大数据处理引擎。

与Hadoop的MapReduce相比,Spark的优势在于其内存计算和任务调度的高效性。

Spark提供了丰富的编程接口,包括Java、Scala和Python等,使得开发者可以根据自己的需求选择最适合的语言进行编码。

2. Spark的安装和配置与Hadoop类似,我们在使用Spark之前也需要进行安装和配置工作。

Hadoop源代码分析(完整版)

关键字: 分布式云计算Google的核心竞争技术是它的计算平台。

Google的大牛们用了下面5篇文章,介绍了它们的计算设施。

GoogleCluster: /archive/googlecluster.htmlChubby:/papers/chubby.htmlGFS:/papers/gfs.htmlBigTable:/papers/bigtable.htmlMapReduce:/papers/mapreduce.html很快,Apache上就出现了一个类似的解决方案,目前它们都属于Apache的Hadoop项目,对应的分别是:Chubby-->ZooKeeperGFS-->HDFSBigTable-->HBaseMapReduce-->Hadoop目前,基于类似思想的Open Source项目还很多,如Facebook用于用户分析的Hive。

HDFS作为一个分布式文件系统,是所有这些项目的基础。

分析好HDFS,有利于了解其他系统。

由于Hadoop的HDFS和MapReduce 是同一个项目,我们就把他们放在一块,进行分析。

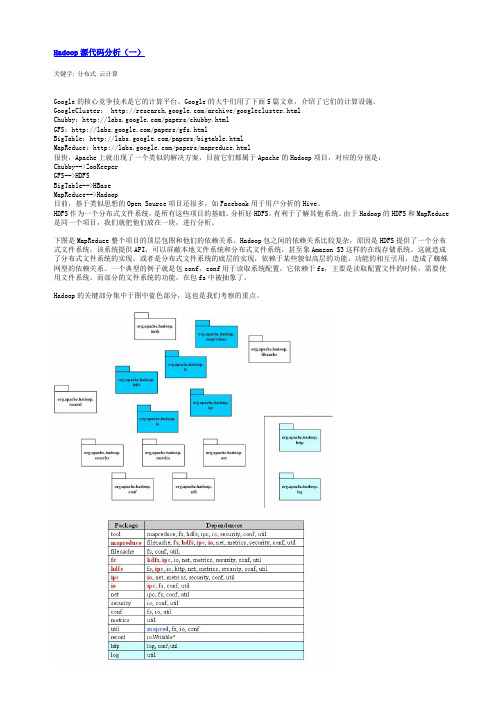

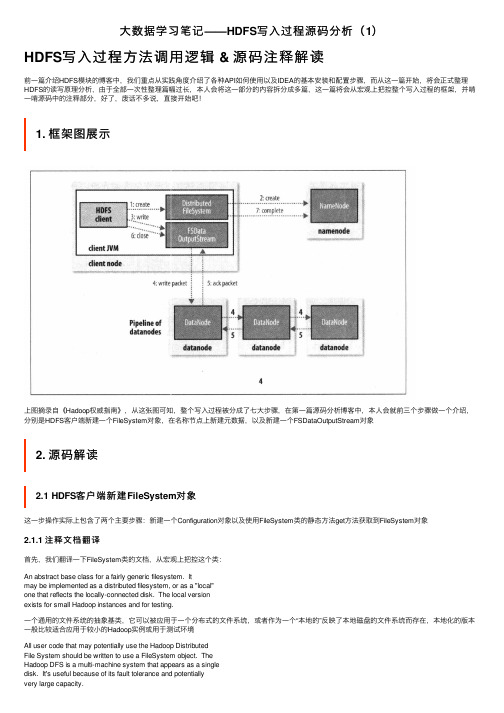

下图是MapReduce整个项目的顶层包图和他们的依赖关系。

Hadoop包之间的依赖关系比较复杂,原因是HDFS提供了一个分布式文件系统,该系统提供API,可以屏蔽本地文件系统和分布式文件系统,甚至象Amazon S3这样的在线存储系统。

这就造成了分布式文件系统的实现,或者是分布式文件系统的底层的实现,依赖于某些貌似高层的功能。

功能的相互引用,造成了蜘蛛网型的依赖关系。

一个典型的例子就是包conf,conf用于读取系统配置,它依赖于fs,主要是读取配置文件的时候,需要使用文件系统,而部分的文件系统的功能,在包fs中被抽象了。

Hadoop的关键部分集中于图中蓝色部分,这也是我们考察的重点。

下面给出了Hadoop的包的功能分析。

Hadoop源代码分析(三)由于Hadoop的MapReduce和HDFS都有通信的需求,需要对通信的对象进行序列化。

Hadoop生态中的大数据处理与分析

Hadoop生态中的大数据处理与分析第一章介绍Hadoop生态Hadoop是由Apache基金会开发的一个开源Java框架,用于处理大数据。

Hadoop生态系统是由许多不同的组件组成的,包括Hadoop文件系统(HDFS)、MapReduce、Hive、Pig、HBase等。

每个组件都有不同的目的和特点。

Hadoop生态系统为大数据处理提供了一整套完备的工具。

在Hadoop生态系统中,MapReduce是最常用的一项工具,它提供了分布式的数据处理功能。

在大数据处理中,MapReduce通常用于将大量数据分解为不同的小块,并在不同的节点间并行运算和处理。

第二章大数据的处理与分析大数据处理和分析是指处理大量数据并提取有用信息的过程。

大数据处理和分析可以帮助企业了解其业务、排除风险和改进业务决策。

但是,对于大数据的处理和分析来说,非结构化数据和半结构化数据是一个巨大的挑战。

这时候Hadoop生态系统可以帮助企业解决这个问题。

Hadoop生态系统的组件,如Hive、Pig、Spark和Storm等可以处理非常大的数据集,并提供高效的并行计算。

这些工具可以从海量的数据中提取有用的信息。

Hive和Pig可以将非结构化数据转换成结构化数据,并通过SQL查询进行分析。

Spark和Storm可以通过Stream Processing技术进行数据分析和处理。

Hadoop生态系统可以帮助企业在分析和处理大数据时提高效率并节省成本。

第三章 Hadoop生态系统的组件1. Hadoop文件系统(HDFS)HDFS是Hadoop生态系统中的核心组件,用于存储和管理大量数据。

在HDFS中,数据被分解为多个块,并分布在不同的服务器上,使得数据存储和处理更加高效。

HDFS提供了高可靠性、高可用性和高扩展性。

HDFS可以容错处理所有的节点故障,同时支持横向扩展。

2. MapReduceMapReduce是Hadoop生态系统中最常用的一项组件,用于分布式计算。

hadoop大数据技术基础 python版

Hadoop大数据技术基础 python版随着互联网技术的不断发展和数据量的爆炸式增长,大数据技术成为了当前互联网行业的热门话题之一。

Hadoop作为一种开源的大数据处理评台,其在大数据领域的应用日益广泛。

而Python作为一种简洁、易读、易学的编程语言,也在大数据分析与处理中扮演着不可或缺的角色。

本文将介绍Hadoop大数据技术的基础知识,并结合Python编程语言,分析其在大数据处理中的应用。

一、Hadoop大数据技术基础1. Hadoop简介Hadoop是一种用于存储和处理大规模数据的开源框架,它主要包括Hadoop分布式文件系统(HDFS)和MapReduce计算框架。

Hadoop分布式文件系统用于存储大规模数据,而MapReduce计算框架则用于分布式数据处理。

2. Hadoop生态系统除了HDFS和MapReduce之外,Hadoop生态系统还包括了许多其他组件,例如HBase、Hive、Pig、ZooKeeper等。

这些组件形成了一个完整的大数据处理评台,能够满足各种不同的大数据处理需求。

3. Hadoop集群Hadoop通过在多台服务器上构建集群来实现数据的存储和处理。

集群中的各个计算节点共同参与数据的存储和计算,从而实现了大规模数据的分布式处理。

二、Python在Hadoop大数据处理中的应用1. Hadoop StreamingHadoop Streaming是Hadoop提供的一个用于在MapReduce中使用任意编程语言的工具。

通过Hadoop Streaming,用户可以借助Python编写Map和Reduce的程序,从而实现对大规模数据的处理和分析。

2. Hadoop连接Python除了Hadoop Streaming外,Python还可以通过Hadoop提供的第三方库和接口来连接Hadoop集群,实现对Hadoop集群中数据的读取、存储和计算。

这为Python程序员在大数据处理领域提供了更多的可能性。

Hadoop实战应用与详解

Hadoop实战应用与详解Hadoop是一个由Apache软件基金会开发的开放源代码框架。

它能够存储和处理大量的数据集,这将是未来几年内的重要趋势之一。

Hadoop能够自动处理数据,将它们分布在跨越多个服务器的群集上,然后在群集上执行计算任务。

Hadoop已经被广泛应用于各大行业,包括政府、金融、医疗、广告、媒体、教育等,已经成为大数据时代的重要基础设施。

一、概述Hadoop主要有两个组成部分:HDFS和MapReduce。

HDFS是一个分布式文件系统,它将大文件切分成小块,然后分散在多台机器上,可以很好地解决文件系统容量的问题。

MapReduce则是一种计算模型,它基于分布式处理,并且能够优化数据的处理,MapReduce对非常大的数据集的处理非常有效。

Hadoop本身是使用Java语言书写的,因此需要在Java环境下使用。

然而,通过一些第三方开源工具,可以使Hadoop更灵活,更容易使用。

例如,有些工具可以在Hadoop上运行SQL查询,有些工具可以将数据从关系数据库移动到Hadoop中,有些工具可以轻松地使用Hadoop分析海量的日志数据。

二、Hadoop工具的使用1. SqoopSqoop是一种用于将数据从一个关系数据库中移动到Hadoop中的工具。

Sqoop可以与MySQL、PostgreSQL、Oracle等数据库共同使用。

使用Sqoop,您可以轻松地将数据从关系数据库中提取,然后将其放入HDFS文件系统中,以便MapReduce处理。

Sqoop是Hadoop中一大工具,日常使用中必不可缺的。

2. Hive和PigHive和Pig是两种比较流行的Hadoop上的数据分析工具。

Hive基于SQL-like查询语言,使得它与关系数据库非常相似。

其查询语言HiveQL 可以与Hadoop上的HDFS、Hbase、Amazon S3和其他存储系统上的数据交互。

Pig则可与Hadoop集成,用于生成数据流处理代码,可在Hadoop环境中进行数据加工和分析。

hadoop 实验报告

hadoop 实验报告Hadoop 实验报告引言Hadoop是一个开源的分布式存储和计算框架,被广泛应用于大数据处理和分析领域。

本实验旨在通过搭建Hadoop集群,进行数据处理和分析,以验证Hadoop在大数据环境下的性能和可靠性。

实验环境本次实验使用了3台虚拟机,每台虚拟机配置了4核CPU和8GB内存。

其中一台作为NameNode和ResourceManager,其余两台作为DataNode和NodeManager。

所有虚拟机运行的操作系统为CentOS 7.0。

实验步骤1. 安装Hadoop首先在每台虚拟机上安装Hadoop,并配置好环境变量和相关参数。

然后在NameNode上配置HDFS和YARN,并在DataNode上配置HDFS和NodeManager。

2. 启动集群依次启动NameNode、DataNode和ResourceManager、NodeManager,确保集群正常运行。

3. 数据处理将一份大数据文件上传至HDFS,并通过MapReduce程序对数据进行处理和分析,例如统计单词频率或计算数据的平均值等。

4. 性能测试通过在集群上运行不同规模的数据处理任务,记录下任务的运行时间和资源利用率,评估Hadoop的性能和扩展性。

实验结果经过实验,我们得出了以下结论:1. Hadoop集群的搭建和配置相对复杂,需要对Hadoop的各个组件有深入的了解和掌握。

2. Hadoop集群在处理大规模数据时表现出了良好的性能和扩展性,能够有效地利用集群资源进行并行计算。

3. Hadoop的容错机制能够保证集群在节点故障时的稳定运行,数据的可靠性得到了保障。

结论通过本次实验,我们深入了解了Hadoop的工作原理和性能特点,验证了Hadoop在大数据环境下的可靠性和高效性。

同时也发现了Hadoop在搭建和配置上的一些难点和挑战,这需要我们在实际应用中不断摸索和实践。

相信随着大数据技术的不断发展,Hadoop将会在各个领域发挥越来越重要的作用。

如何在Hadoop中使用MapReduce进行数据分析

如何在Hadoop中使用MapReduce进行数据分析在当今信息爆炸的时代,数据分析已经成为了企业和组织决策的重要工具。

而Hadoop作为一个开源的分布式计算框架,提供了强大的数据处理和分析能力,其中的MapReduce就是其核心组件之一。

本文将介绍如何在Hadoop中使用MapReduce进行数据分析。

首先,我们需要了解MapReduce的基本原理。

MapReduce是一种分布式计算模型,它将大规模的数据集划分成若干个小的数据块,然后通过Map和Reduce两个阶段进行并行处理。

在Map阶段,数据集会被分割成若干个键值对,每个键值对由一个键和一个值组成。

然后,Map函数会对每个键值对进行处理,生成一个新的键值对。

在Reduce阶段,相同键的值会被分组在一起,然后Reduce函数会对每个键的值进行聚合和处理,最终生成最终的结果。

在Hadoop中使用MapReduce进行数据分析的第一步是编写Map和Reduce函数。

在编写Map函数时,我们需要根据具体的数据分析任务来定义键值对的格式和生成方式。

例如,如果我们要统计某个网站的访问量,那么键可以是网站的URL,值可以是1,表示一次访问。

在Reduce函数中,我们需要根据具体的需求来定义对键的值进行聚合和处理的方式。

例如,如果我们要统计每个网站的总访问量,那么Reduce函数可以将所有的值相加得到最终的结果。

编写好Map和Reduce函数后,我们需要将数据加载到Hadoop中进行分析。

在Hadoop中,数据通常以HDFS(Hadoop Distributed File System)的形式存储。

我们可以使用Hadoop提供的命令行工具或者编写Java程序来将数据加载到HDFS 中。

加载完成后,我们就可以使用Hadoop提供的MapReduce框架来进行数据分析了。

在运行MapReduce任务之前,我们需要编写一个驱动程序来配置和提交任务。

在驱动程序中,我们需要指定Map和Reduce函数的类名、输入数据的路径、输出数据的路径等信息。

尚学堂Hadoop入门教程(一)如何使用Hadoop分析数据

北京尚学堂提供Hadoop从这里开始!和我一起学习下使用Hadoop的基本知识,下文将以Hadoop Tutorial为主体带大家走一遍如何使用Hadoop分析数据!这个专题将描述用户在使用Hadoop MapReduce(下文缩写成MR)框架过程中面对的最重要的东西。

Mapreduce由client APIs和运行时(runtime)环境组成。

其中client APIs用来编写MR程序,运行时环境提供MR运行的环境。

API有2个版本,也就是我们通常说的老api和新api。

运行时有两个版本:MRv1和MRv2。

该教程将会基于老api和MRv1。

其中:老api在org.apache.hadoop.mapred包中,新api在 org.apache.hadoop.mapreduce中。

前提首先请确认已经正确安装、配置了CDH,并且正常运行。

MR概览Hadoop MapReduce 是一个开源的计算框架,运行在其上的应用通常可在拥有几千个节点的集群上并行处理海量数据(可以使P级的数据集)。

MR作业通常将数据集切分为独立的chunk,这些chunk以并行的方式被map tasks处理。

MR框架对map的输出进行排序,然后将这些输出作为输入给reduce tasks处理。

典型的方式是作业的输入和最终输出都存储在分布式文件系统(HDFS)上。

通常部署时计算节点也是存储节点,MR框架和HDFS运行在同一个集群上。

这样的配置允许框架在集群的节点上有效的调度任务,当然待分析的数据已经在集群上存在,这也导致了集群内部会产生高聚合带宽现象(通常我们在集群规划部署时就需要注意这样一个特点)。

MapReduce框架由一个Jobracker(通常简称JT)和数个TaskTracker(TT)组成(在cdh4中如果使用了Jobtracker HA特性,则会有2个Jobtracer,其中只有一个为active,另一个作为standby处于inactive状态)。

熟悉常用的linux操作和hadoop操作实验报告

熟悉常用的linux操作和hadoop操作实验报告通过本次实验,熟悉常用的Linux操作和Hadoop操作,掌握基本的Linux命令和Hadoop命令,了解Hadoop的安装和配置,以及Hadoop集群的搭建和使用。

实验步骤:1. Linux操作1.1 Linux系统介绍Linux是一种自由和开放源代码的类Unix操作系统。

它是一个基于POSIX和UNIX的多用户、多任务、支持多线程和多处理器的操作系统。

1.2 常用Linux命令在Linux系统中有很多常用的命令,例如ls、cd、cat、grep等,这些命令常常用于查看文件和目录、移动和复制文件、编辑文件、搜索文件和文件夹等。

2. Hadoop操作2.1 Hadoop介绍Hadoop是一个开源的分布式计算系统,它可以处理大规模数据的存储和处理。

Hadoop包括两个主要的组件:HDFS和MapReduce。

2.2 Hadoop安装和配置Hadoop的安装和配置需要进行以下步骤:1)下载Hadoop软件包并解压缩2)设置Hadoop的环境变量3)配置Hadoop的主机名和IP地址4)配置Hadoop的核心配置文件5)启动Hadoop服务2.3 Hadoop集群的搭建和使用Hadoop集群的搭建需要进行以下步骤:1)配置每个节点的主机名和IP地址2)在每个节点上安装Hadoop软件包并解压缩3)配置Hadoop的核心配置文件4)启动Hadoop服务在Hadoop集群中,可以使用Hadoop的命令行工具来进行数据的上传和下载、数据的处理和分析等操作。

实验结论:通过本次实验,我们掌握了基本的Linux命令和Hadoop命令,了解了Hadoop的安装和配置,以及Hadoop集群的搭建和使用。

这些知识将有助于我们更好地理解和应用Hadoop分布式计算系统,提高我们的数据处理和分析能力。

Hadoop技术内幕:深入解析YARN架构设计与实现原理

当天下 午 1 5 : 0 0 左右 上空 出现 强雷 阵 雨天 气 ,有连续 两

个 滚雷落 在 3 5 k V开关 室外 的 #3 0 5 间隔 出线上 ,3 5 k V母 线

电压异 常 ,出现异 常声 响 。 由于雷 击位 置较 近 ,且 直击 雷 电冲击 电压 、电流 都较 大 ,加 上该 站 位于 山 区 ,地 质 为沙 土 结 构 ,全站 接 地 电阻较 大 ,3 5 k V 开 关 室 的 接 地 电 阻达 2 . 1 9 2 Q ,无法 及时 将雷 击过 电压 泄去 。这样 ,雷 电冲 击 电 压 过 后 ,首先 将 c 4 , H 避 雷 器 的 引线 打断 ,造 成 c , H 接地 故 障 ,同时 ,持续 的 工频 短路 电流 ( 6 8 0 0 A)会 沿着 雷 电放 电通 道起 弧 燃烧 ,将避 雷 器 的硅 橡胶 引燃, 引起3 0 5 出线 三 相 短 路故 障 。1 5 : 0 0 : 0 9 ,3 0 5 开关 保 护正 确 动作 ,3 0 5 开 关 跳闸 。由于避 雷 器 已着火 燃烧 ,火势 由下 向上迅 速蔓 延 , 并将 母 线 连 接 排 外 的绝 缘 护 套 引燃 , 大量 的烟 雾 充 斥 整 个 母 线 仓 ,最终 造 成 3 5 k V I I 段母 线 三 相短 路 ,l 5 : 0 1 : 0 9 , 3 0 2 开关 、3 0 0 开 关保 护 正 确动 作 ,3 5 k VI I 段母 线 失 电 。开 关 柜 内的火 势 遇到 二次 电缆 、环氧 树 脂的 绝缘 套管 、绝 缘 支 柱 、流变 越 烧越 大 ,不 断快 速蔓 延 ,虽 然现 场岳 西变 工 作 人 员 及时 扑 救 ,但 仍 造 成3 0 5 开关 柜 、开 关 附 柜 、压 变 柜 烧毁 ,其 它开 关柜部 分损 毁的 严重故 障 。

hadoop实验报告

hadoop实验报告一、引言Hadoop是一个开源的分布式系统框架,用于存储和处理大规模数据集。

本实验旨在通过使用Hadoop框架,实践分布式存储和处理数据的能力,并深入了解HDFS和MapReduce的工作原理。

本报告将详细描述实验的步骤、结果和分析,以及洞察到的有关Hadoop的相关知识。

二、实验环境在本次实验中,我们使用以下环境:- 操作系统:Ubuntu 18.04- Hadoop版本:2.7.3- Java版本:1.8.0_181三、实验步骤1. 安装和配置Hadoop首先,需要下载合适版本的Hadoop并进行安装。

在安装完成后,需要进行相关的配置。

通过编辑hadoop-env.sh和core-site.xml文件,设置Java路径和Hadoop的基本配置。

接着,配置hdfs-site.xml文件以指定Hadoop分布式文件系统(HDFS)的副本数量。

最后,修改mapred-site.xml文件以设定MapReduce的配置。

2. 启动Hadoop集群在完成Hadoop的安装和配置后,需要启动Hadoop集群。

运行start-all.sh脚本,该脚本将启动Hadoop的各个组件,包括NameNode、SecondaryNameNode、DataNode和ResourceManager。

通过运行JPS命令,可以检查各个组件是否成功启动。

3. 创建HDFS文件夹并上传数据使用Hadoop的命令行工具,例如Hadoop fs命令,可以在HDFS上创建文件夹和上传数据。

首先,创建一个文件夹用于存储实验数据。

然后,使用put命令将本地文件上传到HDFS上的指定位置。

4. 编写MapReduce程序为了进行数据处理,需要编写一个MapReduce程序。

MapReduce是Hadoop的核心组件,用于高效地处理大规模数据。

编写MapReduce程序需要实现Mapper和Reducer类,并根据需求定义map()和reduce()方法。

hadoop 实验报告

hadoop 实验报告Hadoop 实验报告Hadoop 是一个开源的分布式计算框架,能够高效地处理大规模数据集。

本次实验旨在通过搭建 Hadoop 环境,并运行一些简单的任务,来探索 Hadoop 的特性和功能。

一、Hadoop 环境搭建为了搭建 Hadoop 环境,我们需要准备一台运行 Linux 操作系统的计算机,并安装 Java 开发环境。

接下来,我们下载 Hadoop 的二进制文件,并解压到指定的目录。

然后,我们需要对 Hadoop 进行一些配置,如指定数据存储路径、设置集群节点等。

最后,我们启动 Hadoop,验证环境是否搭建成功。

二、Hadoop 的基本概念在开始运行任务之前,我们需要了解一些 Hadoop 的基本概念。

首先是Hadoop 的核心组件,包括 Hadoop 分布式文件系统(HDFS)和 Hadoop 资源调度器(YARN)。

HDFS 负责将数据分布式存储在集群中的各个节点上,而YARN 则负责管理集群资源和任务调度。

另外,Hadoop 还提供了一个用于编写和运行分布式计算任务的编程模型,即 MapReduce。

三、运行 MapReduce 任务为了熟悉 Hadoop 的编程模型,我们编写了一个简单的 MapReduce 任务。

该任务的目标是统计一篇文档中各个单词的出现次数。

在编写任务之前,我们需要先将文档拆分成多个小块,并将这些小块分发到集群中的各个节点上。

然后,我们定义 Map 函数和 Reduce 函数,分别用于处理每个小块的数据和最终的汇总。

最后,我们运行任务,并查看结果。

四、Hadoop 的优势和应用场景Hadoop 的优势主要体现在处理大规模数据集时的高效性和可靠性。

由于数据被分布式存储和处理,Hadoop 能够充分利用集群中的各个节点,实现高并发和高吞吐量。

此外,Hadoop 还具有容错性,即使某个节点出现故障,任务仍然可以继续执行。

因此,Hadoop 在大数据分析、机器学习和日志处理等领域得到了广泛的应用。

教学大纲《云计算与大数据分析》

教学大纲《云计算与大数据分析》《云计算与大数据分析》教学大纲开课学期:春季学期开课单位:计算机科学与技术学院课程中文名称:云计算与大数据分析课程英文名称:IntroductiontoModernSytemEngineering主讲教师:刘志明教授总学时:32,其中:理论24学时实验:8学时学分:2学分课程性质:非学位课考核方式:考查先修课程:操作系统、数据库原理、面向对象程序设计一、课程教学目的(说明本课程与专业培养目标、研究方向、培养要求)与要求(限300字):云计算和大数据正在引发全球范围内深刻的技术和商业变革,已经成为IT行业主流技术。

云计算通过分布式操作系统、虚拟化、并行计算、弹性计算、效用计算等关键技术,为大数据提供了基础物理平台,大数据是落地的云,技术涵盖了从数据的海量存储、处理到应用多方面的技术,包括数据采集、海量数据存储、非关系型数据管理、数据挖掘、数据可视化以及智能分析技术如模式识别、自然语言理解、应用知识库等。

本课程为计算机、软件工程硕士生开设的一门专业选修课程,主要学习云计算和大数据处理的相关原理和技术,结合核、医应用,与实际工程应用相结合,构建相应的云计算和大数据分析与应用平台。

本课程采取研讨式教学模式,教师主讲技术体系和结构原理,技术细节分为理论、实践、应用等专题,由学生自主选择专题进行自主钻研,阅读文献,搭建软件平台并实际运行,上台讲解,提交论文和实验报告,充分培养学生的自主学习和科研能力。

二、课程内容简介(限200字):(1)云计算与大数据概况了解云计算的特点及技术分类;了解大数据概念;了解大数据的产生、应用和作用;了解大数据与云计算、物联网之间的关系(2)云计算关键技术--虚拟化技术了解服务器虚拟化、存储虚拟化、网络虚拟化、桌面虚拟化的基本概念;熟悉常用的VMware虚拟机软件;了解OpenStack开源虚拟化平台(3)云架构及主流云服务和仿真平台掌握云服务的类型;了解常用的云服务平台Google、Amazon、WindowAzure、云计算仿真器CloudSim (4)Hadoop2.0主流开源云架构理解Hadoop的功能与作用;了解Hadoop的应用现状和发展趋势;掌握Hadoop项目及其结构;掌握Hadoop的体系结构;掌握分布式文件系统HDFS的体系结构;掌握分布式数据处理MapReduce、掌握分布式结构数据表Hbae;相关组件(Zookeeper、Yarn等)(5)大数据处理的关键技术了解数据采集、数据存储与管理、数据分析与挖掘、数据可视化的流程;掌握非关系型数据库NoSQL (MongoDB)、云储存、数据仓库Hive、实时流框架Storm等;了解内存计算框架Spark等(7)学生所选专题理论专题1(普适计算、并行计算、服务计算、社会计算、流计算…);理论专题2(云计算核心算法Pa某o算法、DHT算法、Goip协议…);实践专题1(分布式操作系统Yarn、分布式文件系统HDFS、云数据库MongoDB、MapReduce、Hbae、CloudSim…);实践专题2(Hadoop组件ZooKeeper、Pig、Hive、Oozie、Flume、Mahout…);实践专题3(OpenStack计算服务Nova、对象存储服务Swift、镜像服务Glance)三、教学进度章节内容云计算与大数据分析概况云计算关键技术--虚拟化技术云架构及主流云服务平台大数据处理的关键技术大数据分析挖掘与可视化学生所选理论专题1(普适计算、并行计算、服务计算、社会计算、流计算…);学生所选理论专题2(云计算核心算法Pa某o算法、DHT算法、Goip协议…);学生所选实践专题1(分布式操作系统Yarn、分布式文件系统HDFS、云数据库MongoDB、MapReduce、Hbae、CloudSim…);学生所选实践专题2(Hadoop组件ZooKeeper、Pig、Hive、Oozie、Flume、Mahout…)授课或实验授课或实验教师刘志明刘志明刘志明刘志明刘志明学时安排授课授课授课授课授课2(学时)2(学时)3(学时)2(学时)3(学时)授课刘志明2(学时)授课刘志明2(学时)授课刘志明2(学时)授课刘志明2(学时)2(1)《云计算(第三版)》刘鹏主编,电子工业出版社,2022.8(2)《大数据搜索与挖掘》张华平著,科学出版社,2022.52、主要参考书:(1)云计算与大数据技术.王鹏等编著.人民邮电出版社.2022.5月(2)VMware虚拟化与云计算应用案例详解.王春海编著.中国铁道出版社.2022.11(3)深入云计算:Hadoop源代码分析.张鑫著.中国铁道出版社.2022.6(4)大数据思维与决策.[美]伊恩·艾瑞斯(IanAyre)著.人民邮电出版社.2022.10(5)R与Hadoop大数据分析实战.(印)普贾帕提(VignehPrajapati)著,李明等译.机械工业出版社.2022.11(6)Hadoop大数据分析与挖掘实战.张良均樊哲李成华刘丽君等.机械工业出版社.2022.123、主要参考网站:3课程负责人:刘志明主管院长:学院盖章:2022年1月20日注:本表一式二份,由编制教师填写,并报送学院研究生教学秘书处,由教学秘书汇总电子版和纸质版各一份交研究生处培养办公室备案。

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案第一章:Hadoop概述1.1 Hadoop简介了解Hadoop的发展历程理解Hadoop的核心价值观:可靠性、可扩展性、容错性1.2 Hadoop生态系统掌握Hadoop的主要组件:HDFS、MapReduce、YARN理解Hadoop生态系统中的其他重要组件:HBase、Hive、Pig等1.3 Hadoop安装与配置掌握Hadoop单机模式安装与配置掌握Hadoop伪分布式模式安装与配置第二章:HDFS文件系统2.1 HDFS简介理解HDFS的设计理念:大数据存储、高可靠、高吞吐掌握HDFS的基本架构:NameNode、DataNode2.2 HDFS操作命令掌握HDFS的基本操作命令:mkdir、put、get、dfsadmin等2.3 HDFS客户端编程掌握HDFS客户端API:Configuration、FileSystem、Path等第三章:MapReduce编程模型3.1 MapReduce简介理解MapReduce的设计理念:将大数据处理分解为简单的任务进行分布式计算掌握MapReduce的基本概念:Map、Shuffle、Reduce3.2 MapReduce编程步骤掌握MapReduce编程的四大步骤:编写Map函数、编写Reduce函数、设置输入输出格式、设置其他参数3.3 典型MapReduce应用掌握WordCount案例的编写与运行掌握其他典型MapReduce应用:排序、求和、最大值等第四章:YARN资源管理器4.1 YARN简介理解YARN的设计理念:高效、灵活、可扩展的资源管理掌握YARN的基本概念:ResourceManager、NodeManager、ApplicationMaster等4.2 YARN运行流程掌握YARN的运行流程:ApplicationMaster申请资源、ResourceManager 分配资源、NodeManager执行任务4.3 YARN案例实战掌握使用YARN运行WordCount案例掌握YARN调优参数设置第五章:Hadoop生态系统扩展5.1 HBase数据库理解HBase的设计理念:分布式、可扩展、高可靠的大数据存储掌握HBase的基本概念:表结构、Region、Zookeeper等5.2 Hive数据仓库理解Hive的设计理念:将SQL查询转换为MapReduce任务进行分布式计算掌握Hive的基本操作:建表、查询、数据导入导出等5.3 Pig脚本语言理解Pig的设计理念:简化MapReduce编程的复杂度掌握Pig的基本语法:LOAD、FOREACH、STORE等第六章:Hadoop生态系统工具6.1 Hadoop命令行工具掌握Hadoop命令行工具的使用:hdfs dfs, yarn命令等理解命令行工具在Hadoop生态系统中的作用6.2 Hadoop Web界面熟悉Hadoop各个组件的Web界面:NameNode, JobTracker, ResourceManager等理解Web界面在Hadoop生态系统中的作用6.3 Hadoop生态系统其他工具掌握Hadoop生态系统中的其他工具:Azkaban, Sqoop, Flume等理解这些工具在Hadoop生态系统中的作用第七章:MapReduce高级编程7.1 二次排序理解二次排序的概念和应用场景掌握MapReduce实现二次排序的编程方法7.2 数据去重理解数据去重的重要性掌握MapReduce实现数据去重的编程方法7.3 自定义分区理解自定义分区的概念和应用场景掌握MapReduce实现自定义分区的编程方法第八章:Hadoop性能优化8.1 Hadoop性能调优概述理解Hadoop性能调优的重要性掌握Hadoop性能调优的基本方法8.2 HDFS性能优化掌握HDFS性能优化的方法:数据块大小,副本系数等8.3 MapReduce性能优化掌握MapReduce性能优化的方法:JVM设置,Shuffle优化等第九章:Hadoop实战案例9.1 数据分析案例掌握使用Hadoop进行数据分析的实战案例理解案例中涉及的技术和解决问题的方法9.2 数据处理案例掌握使用Hadoop进行数据处理的实战案例理解案例中涉及的技术和解决问题的方法9.3 数据挖掘案例掌握使用Hadoop进行数据挖掘的实战案例理解案例中涉及的技术和解决问题的方法第十章:Hadoop项目实战10.1 Hadoop项目实战概述理解Hadoop项目实战的意义掌握Hadoop项目实战的基本流程10.2 Hadoop项目实战案例掌握一个完整的Hadoop项目实战案例理解案例中涉及的技术和解决问题的方法展望Hadoop在未来的发展和应用前景重点和难点解析重点环节1:Hadoop的设计理念和核心价值观需要重点关注Hadoop的设计理念和核心价值观,因为这是理解Hadoop生态系统的基础。

实验二 Hadoop环境下MapReduce并行编程

实验二Hadoop环境下MapReduce并行编程一. 实验目的1.学习MapReduce编程模型,理解MapReduce的编程思想。

会用MapReduce框架编写简单的并行程序。

2.熟悉使用eclipse编写、调试和运行MapReduce并行程序。

二. 实验内容1.登录Openstack云平台,进入搭建好Hadoop的虚拟机,按照实验指导说明,在终端启动hadoop、启动eclipse。

2.用MapReduce编程思想,修改hadoop自带的例子程序WordCount,实现如下功能:统计给定文件data.dat中出现频率最多的三个单词,并输出这三个单词和出现的次数。

(注:这里不区分字母大小写,如he与He当做是同一个单词计数)三. 实验指导1.进入虚拟机,打开终端,切换为root用户,命令使用:su root输入密码2.进入hadoop安装目录,本实验中hadoop安装目录为:/usr/local/hadoop-2.6.0/,使用ls命令查看该目录中的文件:3.所有与hadoop启动/关闭有关的脚本位于sbin目录下,所以继续进入sbin目录。

其中,hadoop2.X版本的启动命令主要用到start-dfs.sh和start-yarn.sh。

关闭hadoop主要用到stop-dfs.sh和stop-yarn.sh。

执行start-dfs.sh,然后使用jps命令查看启动项,保证NameNode和DataNode 已启动,否则启动出错:执行start-yarn.sh,jps查看时,保证以下6个启动项已启动:4.打开eclipse,在右上角进入Map/Reduce模式,建立eclispe-hadoop连接5.连接成功后,能够在(1)这个文件夹下再创建文件夹(创建后需refresh)6.建立wordcount项目,如下步骤:7.next,项目名任意(如wordcount),finish。

将WordCount.java文件复制到wordcount项目下src文件中,双击打开。

大数据学习笔记——HDFS写入过程源码分析(1)

⼤数据学习笔记——HDFS写⼊过程源码分析(1)HDFS写⼊过程⽅法调⽤逻辑 & 源码注释解读前⼀篇介绍HDFS模块的博客中,我们重点从实践⾓度介绍了各种API如何使⽤以及IDEA的基本安装和配置步骤,⽽从这⼀篇开始,将会正式整理HDFS的读写原理分析,由于全部⼀次性整理篇幅过长,本⼈会将这⼀部分的内容拆分成多篇,这⼀篇将会从宏观上把控整个写⼊过程的框架,并啃⼀啃源码中的注释部分,好了,废话不多说,直接开始吧!1. 框架图展⽰上图摘录⾃《Hadoop权威指南》,从这张图可知,整个写⼊过程被分成了七⼤步骤,在第⼀篇源码分析博客中,本⼈会就前三个步骤做⼀个介绍,分别是HDFS客户端新建⼀个FileSystem对象,在名称节点上新建元数据,以及新建⼀个FSDataOutputStream对象2. 源码解读2.1 HDFS客户端新建FileSystem对象这⼀步操作实际上包含了两个主要步骤:新建⼀个Configuration对象以及使⽤FileSystem类的静态⽅法get⽅法获取到FileSystem对象2.1.1 注释⽂档翻译⾸先,我们翻译⼀下FileSystem类的⽂档,从宏观上把控这个类:An abstract base class for a fairly generic filesystem. Itmay be implemented as a distributed filesystem, or as a "local"one that reflects the locally-connected disk. The local versionexists for small Hadoop instances and for testing.⼀个通⽤的⽂件系统的抽象基类,它可以被应⽤于⼀个分布式的⽂件系统,或者作为⼀个“本地的”反映了本地磁盘的⽂件系统⽽存在,本地化的版本⼀般⽐较适合应⽤于较⼩的Hadoop实例或⽤于测试环境All user code that may potentially use the Hadoop DistributedFile System should be written to use a FileSystem object. TheHadoop DFS is a multi-machine system that appears as a singledisk. It's useful because of its fault tolerance and potentiallyvery large capacity.所有的可能会使⽤到HDFS的⽤户代码在进⾏编写时都应该使⽤FileSystem对象,HDFS⽂件系统是⼀个跨机器的系统,并且是⼀个单独的磁盘(即根⽬录)的形式出现的,这样的⽅式⾮常有⽤,是因为它的容错机制和海量的容量2.1.2 新建Configuration对象我们将断点打到下图为⽌,进⾏调试,来看看新建Configuration对象时究竟发⽣了些什么关键代码如下:static{//print deprecation warning if hadoop-site.xml is found in classpathClassLoader cL = Thread.currentThread().getContextClassLoader();if (cL == null) {cL = Configuration.class.getClassLoader();}if(cL.getResource("hadoop-site.xml")!=null) {LOG.warn("DEPRECATED: hadoop-site.xml found in the classpath. " +"Usage of hadoop-site.xml is deprecated. Instead use core-site.xml, "+ "mapred-site.xml and hdfs-site.xml to override properties of " +"core-default.xml, mapred-default.xml and hdfs-default.xml " +"respectively");}addDefaultResource("core-default.xml");addDefaultResource("core-site.xml");}由此可见,Configuration对象会加⼊两个默认的配置⽂件,core-default.xml以及core-site.xml2.1.3 获取FileSystem对象现在我们将断点打到下图位置:经过⽅法的层层调⽤,我们最终找到了FileSystem对象是通过调⽤getInternal⽅法得到的⾸先在getInternal⽅法中调⽤了createFileSystem⽅法进⼊createFileSystem⽅法,关键的来了!private static FileSystem createFileSystem(URI uri, Configuration conf) throws IOException {Class<?> clazz = getFileSystemClass(uri.getScheme(), conf);FileSystem fs = (FileSystem)ReflectionUtils.newInstance(clazz, conf);fs.initialize(uri, conf);return fs;}原来,FileSystem实例是通过反射的⽅式获得的,具体实现是通过调⽤反射⼯具类ReflectionUtils的newInstance⽅法并将class对象以及Configuration 对象作为参数传⼊最终得到了FileSystem实例2.2 在名称节点上新建元数据2.2.1 注释⽂档翻译此步骤⼀共涉及到这⼏个类,DistributedFileSystem,DFSClient以及DFSOutputStreamDistributedFileSystem类Implementation of the abstract FileSystem for the DFS system.This object is the way end-user code interacts with a HadoopDistributedFileSystem.在分布式⽂件系统上,抽象的FileSystem类的实现⼦类,这个对象是末端的⽤户代码⽤来与Hadoop分布式⽂件系统进⾏交互的⼀种⽅式DFSClient类DFSClient can connect to a Hadoop Filesystem andperform basic file tasks. It uses the ClientProtocolto communicate with a NameNode daemon, and connectsdirectly to DataNodes to read/write block data.Hadoop DFS users should obtain an instance ofDistributedFileSystem, which uses DFSClient to handlefilesystem tasks.DFSClient类可以连接到Hadoop⽂件系统并执⾏基本的⽂件任务,它使⽤ClientProtocal来与⼀个NameNode进程通讯,并且直接连接到DataNodes上来读取或者写⼊块数据,HDFS的使⽤者应该要获得⼀个DistributedFileSystem的实例,使⽤DFSClient来处理⽂件系统任务DFSOutputStream类DFSOutputStream creates files from a stream of bytes.DFSOutputStream从字节流中创建⽂件The client application writes data that is cached internally bythis stream. Data is broken up into packets, each packet istypically 64K in size. A packet comprises of chunks. Each chunkis typically 512 bytes and has an associated checksum with it.客户端写被这个流缓存在内部的数据,数据被切分成packets的单位,每⼀个packet⼤⼩是64K,⼀个packet是由chunks组成的,每⼀个chunk为512字节⼤⼩并且伴随⼀个校验和When a client application fills up the currentPacket, it isenqueued into dataQueue. The DataStreamer thread picks uppackets from the dataQueue, sends it to the first datanode inthe pipeline and moves it from the dataQueue to the ackQueue.The ResponseProcessor receives acks from the datanodes. When asuccessful ack for a packet is received from all datanodes, theResponseProcessor removes the corresponding packet from theackQueue.当⼀个客户端进程填满了当前的包时,它就会被排⼊数据队列(dataQueue),DataStreamer线程从数据队列中获取包并在管线将它发送到第⼀个datanode中去,然后把它从数据队列移动⾄确认队列(ackQueue),响应处理器(ResponseProcessor)从datanodes中接收确认回执,当⼀个包成功确认的回执被从所有的datanodes接收到时,响应处理器就会从确认队列中移除相应的数据包In case of error, all outstanding packets are moved fromackQueue. A new pipeline is setup by eliminating the baddatanode from the original pipeline. The DataStreamer nowstarts sending packets from the dataQueue.如果出现错误,所有未完成的包都会从确认队列中移除(同时会将packet移动到数据队列的末尾),通过从原始的管线中消除坏掉的datanode,⼀个新的管线被重新架设起来,DataStreamer开始从数据队列中发送数据包2.2.2 新建元数据源码解读先将断点打到下图位置,然后debug第⼀步调试,我们⾸先进⼊到的是FileSystem类,经过create⽅法的层层调⽤,最终我们找到了出⼝public FSDataOutputStream create(Path f,boolean overwrite,int bufferSize,short replication,long blockSize,Progressable progress) throws IOException {return this.create(f, FsPermission.getFileDefault().applyUMask(FsPermission.getUMask(getConf())), overwrite, bufferSize,replication, blockSize, progress);}继续调试,我们发现FSDataOutputStream是⼀个包装类,它是通过调⽤DistributedFileSystem类的create⽅法返回的,⽽查看代码可知,这个包装类所包装的,正是DFSOutputStream于是乎,第⼆个出⼝也被我们找到了@Overridepublic FSDataOutputStream create(final Path f, final FsPermission permission,final EnumSet<CreateFlag> cflags, final int bufferSize,final short replication, final long blockSize, final Progressable progress,final ChecksumOpt checksumOpt) throws IOException {statistics.incrementWriteOps(1);Path absF = fixRelativePart(f);return new FileSystemLinkResolver<FSDataOutputStream>() {@Overridepublic FSDataOutputStream doCall(final Path p)throws IOException, UnresolvedLinkException {final DFSOutputStream dfsos = dfs.create(getPathName(p), permission,cflags, replication, blockSize, progress, bufferSize,checksumOpt);return dfs.createWrappedOutputStream(dfsos, statistics);}继续调试,我们发现这个DFSOutputStream是从DFSClient类的create⽅法中返回过来的public DFSOutputStream create(String src,FsPermission permission,EnumSet<CreateFlag> flag,boolean createParent,short replication,long blockSize,Progressable progress,int buffersize,ChecksumOpt checksumOpt,InetSocketAddress[] favoredNodes) throws IOException {checkOpen();if (permission == null) {permission = FsPermission.getFileDefault();}FsPermission masked = permission.applyUMask(dfsClientConf.uMask);if(LOG.isDebugEnabled()) {LOG.debug(src + ": masked=" + masked);}final DFSOutputStream result = DFSOutputStream.newStreamForCreate(this,src, masked, flag, createParent, replication, blockSize, progress,buffersize, dfsClientConf.createChecksum(checksumOpt),getFavoredNodesStr(favoredNodes));beginFileLease(result.getFileId(), result);return result;}查看已标记了的关键代码,我们⼜发现,DFSClient类中的DFSOutputStream实例对象是通过调⽤DFSOutputStream类的的newStreamForCreate⽅法产⽣的,于是乎,我们单步进⼊这个⽅法,⼀探究竟,终于,我们找到了新建元数据的关键代码static DFSOutputStream newStreamForCreate(DFSClient dfsClient, String src,FsPermission masked, EnumSet<CreateFlag> flag, boolean createParent,short replication, long blockSize, Progressable progress, int buffersize,DataChecksum checksum, String[] favoredNodes) throws IOException {TraceScope scope =dfsClient.getPathTraceScope("newStreamForCreate", src);try {HdfsFileStatus stat = null;// Retry the create if we get a RetryStartFileException up to a maximum// number of timesboolean shouldRetry = true;int retryCount = CREATE_RETRY_COUNT;while (shouldRetry) {shouldRetry = false;try {stat = node.create(src, masked, dfsClient.clientName,new EnumSetWritable<CreateFlag>(flag), createParent, replication,blockSize, SUPPORTED_CRYPTO_VERSIONS);break;} catch (RemoteException re) {IOException e = re.unwrapRemoteException(AccessControlException.class,DSQuotaExceededException.class,FileAlreadyExistsException.class,FileNotFoundException.class,ParentNotDirectoryException.class,NSQuotaExceededException.class,RetryStartFileException.class,SafeModeException.class,UnresolvedPathException.class,SnapshotAccessControlException.class,UnknownCryptoProtocolVersionException.class);if (e instanceof RetryStartFileException) {if (retryCount > 0) {shouldRetry = true;retryCount--;} else {throw new IOException("Too many retries because of encryption" +" zone operations", e);}} else {throw e;}}}Preconditions.checkNotNull(stat, "HdfsFileStatus should not be null!");final DFSOutputStream out = new DFSOutputStream(dfsClient, src, stat,flag, progress, checksum, favoredNodes);out.start();return out;} finally {scope.close();}}查看关键代码,我们发现这个stat对象是调⽤namenode的create⽅法产⽣的,⽽ctrl + 左键点击namenode后发现namenode正是之前注释⾥⾯提到的ClientProtocal的⼀个实例对象,⽽ClientProtocal是⼀个接⼝,它的⼀个实现⼦类名字叫做ClientNamenodeProtocalTranslatorPB就是我们想要的,我们找寻这个类的⽅法,最终发现了create⽅法⽽返回值是通过调⽤rpcProxy的create⽅法实现的,这⾥⽤到的是Google的Protobuf序列化技术@Overridepublic HdfsFileStatus create(String src, FsPermission masked,String clientName, EnumSetWritable<CreateFlag> flag,boolean createParent, short replication, long blockSize,CryptoProtocolVersion[] supportedVersions)throws AccessControlException, AlreadyBeingCreatedException,DSQuotaExceededException, FileAlreadyExistsException,FileNotFoundException, NSQuotaExceededException,ParentNotDirectoryException, SafeModeException, UnresolvedLinkException,IOException {CreateRequestProto.Builder builder = CreateRequestProto.newBuilder().setSrc(src).setMasked(PBHelper.convert(masked)).setClientName(clientName).setCreateFlag(PBHelper.convertCreateFlag(flag)).setCreateParent(createParent).setReplication(replication).setBlockSize(blockSize);builder.addAllCryptoProtocolVersion(PBHelper.convert(supportedVersions));CreateRequestProto req = builder.build();try {CreateResponseProto res = rpcProxy.create(null, req);return res.hasFs() ? PBHelper.convert(res.getFs()) : null;} catch (ServiceException e) {throw ProtobufHelper.getRemoteException(e);}}2.3 新建FSDataOutputStream对象之前讲解的是新建元数据的代码,⽽事实上,整个过程并未结束,还需要新建⼀个DFSOutputStream对象才⾏,同样在之前的newStreamForCreate ⽅法中,我们发现了以下⼏⾏代码,最终返回的是这个out对象,并且在返回之前,调⽤了out对象的start⽅法final DFSOutputStream out = new DFSOutputStream(dfsClient, src, stat,flag, progress, checksum, favoredNodes);out.start();return out;点进start⽅法,发现调⽤的是streamer对象的start⽅法private synchronized void start() {streamer.start();}点进streamer对象,发现它是DataStreamer类的⼀个实例,并且DataStreamer类是DFSOutputSteam的⼀个内部类,在这个类中,有⼀个⽅法叫做run⽅法,数据写⼊的关键代码就在这个run⽅法中实现@Overridepublic void run() {long lastPacket = Time.monotonicNow();TraceScope scope = NullScope.INSTANCE;while (!streamerClosed && dfsClient.clientRunning) {// if the Responder encountered an error, shutdown Responderif (hasError && response != null) {try {response.close();response.join();response = null;} catch (InterruptedException e) {DFSClient.LOG.warn("Caught exception ", e);}}DFSPacket one;try {// process datanode IO errors if anyboolean doSleep = false;if (hasError && (errorIndex >= 0 || restartingNodeIndex.get() >= 0)) {doSleep = processDatanodeError();}synchronized (dataQueue) {// wait for a packet to be sent.long now = Time.monotonicNow();while ((!streamerClosed && !hasError && dfsClient.clientRunning&& dataQueue.size() == 0 &&(stage != BlockConstructionStage.DATA_STREAMING ||stage == BlockConstructionStage.DATA_STREAMING &&now - lastPacket < dfsClient.getConf().socketTimeout/2)) || doSleep ) { long timeout = dfsClient.getConf().socketTimeout/2 - (now-lastPacket); timeout = timeout <= 0 ? 1000 : timeout;timeout = (stage == BlockConstructionStage.DATA_STREAMING)?timeout : 1000;try {dataQueue.wait(timeout);} catch (InterruptedException e) {DFSClient.LOG.warn("Caught exception ", e);}doSleep = false;now = Time.monotonicNow();}if (streamerClosed || hasError || !dfsClient.clientRunning) {continue;}// get packet to be sent.if (dataQueue.isEmpty()) {one = createHeartbeatPacket();assert one != null;} else {one = dataQueue.getFirst(); // regular data packetlong parents[] = one.getTraceParents();if (parents.length > 0) {scope = Trace.startSpan("dataStreamer", new TraceInfo(0, parents[0]));// TODO: use setParents API once it's available from HTrace 3.2// scope = Trace.startSpan("dataStreamer", Sampler.ALWAYS);// scope.getSpan().setParents(parents);}}}// get new block from namenode.if (stage == BlockConstructionStage.PIPELINE_SETUP_CREATE) {if(DFSClient.LOG.isDebugEnabled()) {DFSClient.LOG.debug("Allocating new block");}setPipeline(nextBlockOutputStream());initDataStreaming();} else if (stage == BlockConstructionStage.PIPELINE_SETUP_APPEND) { if(DFSClient.LOG.isDebugEnabled()) {DFSClient.LOG.debug("Append to block " + block);}setupPipelineForAppendOrRecovery();initDataStreaming();}long lastByteOffsetInBlock = one.getLastByteOffsetBlock();if (lastByteOffsetInBlock > blockSize) {throw new IOException("BlockSize " + blockSize +" is smaller than data size. " +" Offset of packet in block " +lastByteOffsetInBlock +" Aborting file " + src);}if (one.isLastPacketInBlock()) {// wait for all data packets have been successfully ackedsynchronized (dataQueue) {while (!streamerClosed && !hasError &&ackQueue.size() != 0 && dfsClient.clientRunning) {try {// wait for acks to arrive from datanodesdataQueue.wait(1000);} catch (InterruptedException e) {DFSClient.LOG.warn("Caught exception ", e);}}}if (streamerClosed || hasError || !dfsClient.clientRunning) {continue;}stage = BlockConstructionStage.PIPELINE_CLOSE;}// send the packetSpan span = null;synchronized (dataQueue) {// move packet from dataQueue to ackQueueif (!one.isHeartbeatPacket()) {span = scope.detach();one.setTraceSpan(span);dataQueue.removeFirst();ackQueue.addLast(one);dataQueue.notifyAll();}}if (DFSClient.LOG.isDebugEnabled()) {DFSClient.LOG.debug("DataStreamer block " + block +" sending packet " + one);}// write out data to remote datanodeTraceScope writeScope = Trace.startSpan("writeTo", span);try {one.writeTo(blockStream);blockStream.flush();} catch (IOException e) {// HDFS-3398 treat primary DN is down since client is unable to // write to primary DN. If a failed or restarting node has already // been recorded by the responder, the following call will have no // effect. Pipeline recovery can handle only one node error at a // time. If the primary node fails again during the recovery, it// will be taken out then.tryMarkPrimaryDatanodeFailed();throw e;} finally {writeScope.close();}lastPacket = Time.monotonicNow();// update bytesSentlong tmpBytesSent = one.getLastByteOffsetBlock();if (bytesSent < tmpBytesSent) {bytesSent = tmpBytesSent;}if (streamerClosed || hasError || !dfsClient.clientRunning) {continue;}// Is this block full?if (one.isLastPacketInBlock()) {// wait for the close packet has been ackedsynchronized (dataQueue) {while (!streamerClosed && !hasError &&ackQueue.size() != 0 && dfsClient.clientRunning) {dataQueue.wait(1000);// wait for acks to arrive from datanodes }}if (streamerClosed || hasError || !dfsClient.clientRunning) {continue;}endBlock();}if (progress != null) { progress.progress(); }// This is used by unit test to trigger race conditions.if (artificialSlowdown != 0 && dfsClient.clientRunning) {Thread.sleep(artificialSlowdown);}} catch (Throwable e) {// Log warning if there was a real error.if (restartingNodeIndex.get() == -1) {DFSClient.LOG.warn("DataStreamer Exception", e);}if (e instanceof IOException) {setLastException((IOException)e);} else {setLastException(new IOException("DataStreamer Exception: ",e)); }hasError = true;if (errorIndex == -1 && restartingNodeIndex.get() == -1) {// Not a datanode issuestreamerClosed = true;}} finally {scope.close();}}closeInternal();}private void closeInternal() {closeResponder(); // close and joincloseStream();streamerClosed = true;setClosed();synchronized (dataQueue) {dataQueue.notifyAll();}}。

大数据实例代码

大数据实例代码

一、大数据概述

随着互联网和物联网的快速发展,数据量呈现出爆炸式增长,大数据作为一种新兴产业,已经成为各行各业关注的焦点。

大数据的核心价值在于数据分析与挖掘,从而为决策提供有力支持。

本文将通过一个实例代码,简要介绍如何实现大数据的处理与分析。

二、大数据实例代码介绍

本文选取的实例代码是基于Hadoop框架实现的,主要包括以下几个部分:

1.数据收集:通过Flume等工具将数据从不同来源收集到Hadoop分布式系统中。

2.数据存储:将收集到的数据存储在Hadoop的HDFS中,以便进行后续处理。

3.数据处理:采用MapReduce编程模型,实现对数据的分布式处理。

本文实例代码涉及的数据处理包括数据清洗、统计分析等。

4.数据可视化:将处理结果通过JavaScript、HTML等前端技术展示在前端页面,便于用户查看与分析。

hudi源码解读

hudi源码解读Hudi(Hadoop Upserts Deletes and Incrementals)是Apache开源生态系统的一部分,它是一个用于管理大型分析工作负载的数据湖工具。

它提供了一种以增量、更新和删除为基础的数据管理技术,使数据分析与挖掘更加高效。

Hudi的源代码包含了多个模块和组件,提供了完整的数据湖管理解决方案。

以下是对Hudi各个模块的简要解读:1. hudi-client:这个模块是Hudi的客户端库,其中包含了与Hudi进行交互的核心API。

它提供了一系列用于写入、合并、查询和删除数据的方法。

2. hudi-common:这个模块包含了与Hudi相关的通用工具类和方法。

它定义了一些常用的数据结构和配置文件,并提供了一些工具类,用于处理文件和流等常见操作。

3. hudi-spark:这个模块是基于Apache Spark的Hudi的核心组件,它提供了与Spark集成的功能。

它包括了一些Spark任务的封装,用于管理和操作Hudi数据集。

4. hudi-hadoop-mr:这个模块是基于Apache Hadoop MapReduce的Hudi组件,它提供了与MapReduce集成的功能。

它允许用户使用MapReduce作业读取、写入和处理Hudi数据集。

5. hudi-utilities:这个模块包含了一些用于辅助Hudi工具的实用程序和脚本。

它提供了一些用于管理和维护Hudi数据集的命令行工具。

以上是对Hudi源码各个模块的简要解读。

Hudi源码具体的实现细节涉及到各种算法和数据结构,在实际的代码中会有更多的细节。

如果你对特定的模块或功能有具体的问题,可以提供更多的信息以便更详细地解答。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop源代码分析(一)关键字: 分布式云计算Google的核心竞争技术是它的计算平台。

Google的大牛们用了下面5篇文章,介绍了它们的计算设施。

GoogleCluster:/archive/googlecluster.htmlChubby:/papers/chubby.htmlGFS:/papers/gfs.htmlBigTable:/papers/bigtable.htmlMapReduce:/papers/mapreduce.html很快,Apache上就出现了一个类似的解决方案,目前它们都属于Apache的Hadoop项目,对应的分别是:Chubby-->ZooKeeperGFS-->HDFSBigTable-->HBaseMapReduce-->Hadoop目前,基于类似思想的Open Source项目还很多,如Facebook用于用户分析的Hive。

HDFS作为一个分布式文件系统,是所有这些项目的基础。

分析好HDFS,有利于了解其他系统。

由于Hadoop的HDFS和MapReduce是同一个项目,我们就把他们放在一块,进行分析。

下图是MapReduce整个项目的顶层包图和他们的依赖关系。

Hadoop包之间的依赖关系比较复杂,原因是HDFS提供了一个分布式文件系统,该系统提供API,可以屏蔽本地文件系统和分布式文件系统,甚至象Amazon S3这样的在线存储系统。

这就造成了分布式文件系统的实现,或者是分布式文件系统的底层的实现,依赖于某些貌似高层的功能。

功能的相互引用,造成了蜘蛛网型的依赖关系。

一个典型的例子就是包conf,conf用于读取系统配置,它依赖于fs,主要是读取配置文件的时候,需要使用文件系统,而部分的文件系统的功能,在包fs中被抽象了。

Hadoop的关键部分集中于图中蓝色部分,这也是我们考察的重点。

∙∙大小: 78.3 KBHadoop源代码分析(二)下面给出了Hadoop的包的功能分析。

1. public class MyWritable implements Writable {2. // Some data3. private int counter;4. private long timestamp;5.6. public void write(DataOutput out) throws IOException {7. out.writeInt(counter);8. out.writeLong(timestamp);9. }10.11. public void readFields(DataInput in) throws IOException {12. counter = in.readInt();13. timestamp = in.readLong();14. }15.16. public static MyWritable read(DataInput in) throws IOException {17. MyWritable w = new MyWritable();18. w.readFields(in);19. return w;20. }21. }public class MyWritable implements Writable {// Some dataprivate int counter;private long timestamp;public void write(DataOutput out) throws IOException {out.writeInt(counter);out.writeLong(timestamp);}public void readFields(DataInput in) throws IOException {counter = in.readInt();timestamp = in.readLong();}public static MyWritable read(DataInput in) throws IOException { MyWritable w = new MyWritable();w.readFields(in);return w;}}其中的write和readFields分别实现了把对象序列化和反序列化的功能,是Writable接口定义的两个方法。

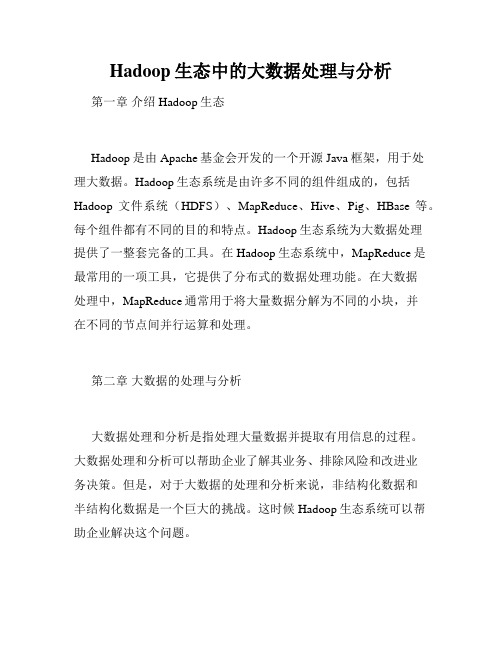

下图给出了庞大的org.apache.hadoop.io中对象的关系。

这里,我把ObjectWritable标为红色,是因为相对于其他对象,它有不同的地位。

当我们讨论Hadoop的RPC时,我们会提到RPC上交换的信息,必须是Java的基本类型,String和Writable接口的实现类,以及元素为以上类型的数组。

ObjectWritable对象保存了一个可以在RPC上传输的对象和对象的类型信息。

这样,我们就有了一个万能的,可以用于客户端/服务器间传输的Writable对象。

例如,我们要把上面例子中的对象作为RPC请求,需要根据MyWritable创建一个ObjectWritable,ObjectWritable往流里会写如下信息对象类名长度,对象类名,对象自己的串行化结果这样,到了对端,ObjectWritable可以根据对象类名创建对应的对象,并解串行。

应该注意到,ObjectWritable依赖于WritableFactories,那存储了Writable子类对应的工厂。

我们需要把MyWritable的工厂,保存在WritableFactories中(通过WritableFactories.setFactory)。

Hadoop源代码分析(五)介绍完org.apache.hadoop.io以后,我们开始来分析org.apache.hadoop.rpc。

RPC采用客户机/服务器模式。

请求程序就是一个客户机,而服务提供程序就是一个服务器。

当我们讨论HDFS的,通信可能发生在:∙Client-NameNode之间,其中NameNode是服务器∙Client-DataNode之间,其中DataNode是服务器∙DataNode-NameNode之间,其中NameNode是服务器∙DataNode-DateNode之间,其中某一个DateNode是服务器,另一个是客户端如果我们考虑Hadoop的Map/Reduce以后,这些系统间的通信就更复杂了。

为了解决这些客户机/服务器之间的通信,Hadoop引入了一个RPC框架。

该RPC框架利用的Java的反射能力,避免了某些RPC解决方案中需要根据某种接口语言(如CORBA的IDL)生成存根和框架的问题。

但是,该RPC 框架要求调用的参数和返回结果必须是Java的基本类型,String和Writable接口的实现类,以及元素为以上类型的数组。

同时,接口方法应该只抛出IOException异常。

(参考自/blog/86306)既然是RPC,当然就有客户端和服务器,当然,org.apache.hadoop.rpc也就有了类Client和类Server。

但是类Server是一个抽象类,类RPC封装了Server,利用反射,把某个对象的方法开放出来,变成RPC中的服务器。

下图是org.apache.hadoop.rpc的类图。

∙∙大小: 130.3 KBHadoop源代码分析(六)既然是RPC,自然就有客户端和服务器,当然,org.apache.hadoop.rpc也就有了类Client和类Server。

在这里我们来仔细考察org.apache.hadoop.rpc.Client。

下面的图包含了org.apache.hadoop.rpc.Client中的关键类和关键方法。

由于Client可能和多个Server通信,典型的一次HDFS读,需要和NameNode打交道,也需要和某个/某些DataNode通信。

这就意味着某一个Client需要维护多个连接。

同时,为了减少不必要的连接,现在Client的做法是拿ConnectionId(图中最右侧)来做为Connection的ID。

ConnectionId包括一个InetSocketAddress(IP地址+端口号或主机名+端口号)对象和一个用户信息对象。

这就是说,同一个用户到同一个InetSocketAddress的通信将共享同一个连接。

连接被封装在类Client.Connection中,所有的RPC调用,都是通过Connection,进行通信。

一个RPC调用,自然有输入参数,输出参数和可能的异常,同时,为了区分在同一个Connection上的不同调用,每个调用都有唯一的id。

调用是否结束也需要一个标记,所有的这些都体现在对象Client.Call中。

Connection对象通过一个Hash表,维护在这个连接上的所有Call:Java代码1. private Hashtable<Integer, Call> calls = new Hashtable<Integer, Call>();private Hashtable<Integer, Call> calls = new Hashtable<Integer, Call>();一个RPC调用通过addCall,把请求加到Connection里。

为了能够在这个框架上传输Java的基本类型,String和Writable接口的实现类,以及元素为以上类型的数组,我们一般把Call需要的参数打包成为ObjectWritable对象。

Client.Connection会通过socket连接服务器,连接成功后回校验客户端/服务器的版本号(Client.ConnectionwriteHeader()方法),校验成功后就可以通过Writable对象来进行请求的发送/应答了。

注意,每个Client.Connection会起一个线程,不断去读取socket,并将收到的结果解包,找出对应的Call,设置Call并通知结果已经获取。

Call使用Obejct的wait和notify,把RPC上的异步消息交互转成同步调用。

还有一点需要注意,一个Client会有多个Client.Connection,这是一个很自然的结果。

Hadoop源代码分析(七)聊完了Client聊Server,按惯例,先把类图贴出来。

需要注意的是,这里的Server类是个抽象类,唯一抽象的地方,就是Java代码1. public abstract Writable call(Writable param, long receiveTime) throws IOException;public abstract Writable call(Writable param, long receiveTime) throws IOException;这表明,Server提供了一个架子,Server的具体功能,需要具体类来完成。