基于密度的最佳聚类数确定方法.

dbscan聚类方法

dbscan聚类方法【原创版3篇】目录(篇1)1.DBSCAN 聚类方法的概述2.DBSCAN 聚类方法的基本原理3.DBSCAN 聚类方法的算法流程4.DBSCAN 聚类方法的应用案例5.DBSCAN 聚类方法的优缺点正文(篇1)1.DBSCAN 聚类方法的概述DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类方法,该方法由 Rosenfeld 和 Eidelman 于 1995 年提出。

它主要通过计算数据点之间的密度来确定聚类,可以发现任意形状的聚类结构,并且对噪声数据具有较强的鲁棒性。

2.DBSCAN 聚类方法的基本原理DBSCAN 方法的基本原理是基于数据点的密度分布。

该方法将数据空间中的点分为核心点、边界点和噪声点三类。

其中,核心点是指其邻域内的点数量大于等于指定阈值的点;边界点是指其邻域内的点数量小于阈值且邻域内的点又与其他核心点相邻的点;噪声点是指其邻域内的点数量小于阈值且邻域内的点不与其他核心点相邻的点。

通过将核心点之间的连接关系形成聚类,可以得到最终的聚类结果。

3.DBSCAN 聚类方法的算法流程DBSCAN 聚类方法的算法流程主要包括两个步骤:(1)确定核心点:遍历数据集中的每一个点,计算其邻域内的点数量,将数量大于等于阈值的点标记为核心点。

(2)形成聚类:对于核心点,将其邻域内的点也标记为为核心点,并将这些核心点之间的连接关系形成聚类。

4.DBSCAN 聚类方法的应用案例DBSCAN 聚类方法在许多领域都有广泛应用,例如数据挖掘、生物信息学、图像处理等。

以图像处理为例,通过对图像像素进行密度划分,可以识别出图像中的目标物体,从而实现目标检测和识别。

5.DBSCAN 聚类方法的优缺点优点:(1)可以发现任意形状的聚类结构;(2)对噪声数据具有较强的鲁棒性;(3)算法具有较强的可扩展性,可以处理大规模数据集。

dbscan聚类算法参数估计

dbscan聚类算法参数估计

DBSCAN(Density-Based Spatial Clustering of

Applications with Noise)是一种基于密度的聚类算法,它使用两

个参数来进行聚类,邻域半径(epsilon)和最小样本数(minPts)。

邻域半径(epsilon)是指在进行密度可达性判断时所使用的距离

阈值。

该参数的选择直接影响着最终聚类的效果。

如果选择的值过小,可能会导致大部分数据点都成为噪声点;而如果选择的值过大,可能会导致所有的点都被归为同一个簇。

因此,通常需要根据具体

的数据集特点和领域知识来进行调参,可以通过尝试不同的值来进

行交叉验证或者使用基于密度的可视化方法来估计合适的邻域半径。

最小样本数(minPts)是指用来判断核心对象的邻域内最少样本

点数目。

这个参数的选择也是十分重要的,它影响着最终聚类的簇

的个数和噪声点的数量。

通常情况下,minPts的选择要考虑数据集

的特点,一般来说,对于高维数据集,minPts可以选择相对较大的值,而对于低维数据集,可以选择较小的值。

同样,可以通过交叉

验证或者基于密度的可视化方法来估计合适的最小样本数。

除了这两个主要的参数外,还有一些其他的参数可以对DBSCAN

进行调优,比如距离度量的选择、核心对象的定义等。

总的来说,参数估计是DBSCAN算法中非常重要的一部分,需要结合具体的数据集和领域知识来进行调参,以获得最佳的聚类效果。

ticc多元时间序列聚类算法的过程和原理

ticc多元时间序列聚类算法的过程和原理一、引言ticc多元时间序列聚类算法是一种广泛应用于数据挖掘和机器学习领域的聚类算法,旨在将具有相似性的多元时间序列数据分组,以便更好地理解和分析数据。

本文将详细介绍ticc多元时间序列聚类算法的过程和原理。

二、算法概述ticc多元时间序列聚类算法是一种基于密度的聚类算法,通过不断地迭代优化,将具有相似性的多元时间序列数据分组,并形成稳定的聚类结构。

该算法的核心思想是将相似的多元时间序列数据分配给同一聚类,从而揭示数据间的内在关系和模式。

三、过程详解1.预处理:首先对多元时间序列数据进行预处理,包括清洗数据、缺失值填补、时间序列重构等操作,确保数据的准确性和完整性。

2.特征提取:根据多元时间序列数据的特性,提取出相关的特征,如均值、方差、周期性等,以便后续的聚类分析。

3.相似性计算:采用适当的相似性度量方法,如欧几里得距离、余弦相似性等,计算多元时间序列数据之间的相似性。

4.划分聚类:将数据划分为多个聚类,每个聚类包含一组相似性较高的多元时间序列数据。

5.调整聚类:根据划分的聚类结果,调整聚类数目和聚类位置,以获得最佳的聚类效果。

6.输出结果:将最终的聚类结果输出,以便进一步的分析和利用。

四、原理阐述1.密度感知:ticc多元时间序列聚类算法不仅考虑距离,还考虑数据的密度。

通过计算每个数据点周围的邻居数量和密度,可以更好地发现局部聚集的结构。

2.动态规划:ticc多元时间序列聚类算法采用动态规划的思想,通过逐步优化聚类结果,避免全局搜索的复杂性,提高算法的效率和准确性。

3.多样性考虑:ticc多元时间序列聚类算法不仅关注聚类的数量,还关注聚类的多样性。

通过评估聚类的内部相似性和差异性,可以获得更丰富、更真实的聚类结果。

4.适应性调整:ticc多元时间序列聚类算法具有一定的适应性,可以根据不同的数据集和需求,调整算法的参数和策略,以获得最佳的聚类效果。

五、总结ticc多元时间序列聚类算法是一种高效、准确的时间序列聚类算法,适用于大规模、复杂的数据集。

基于密度的聚类方法

基于密度的聚类方法

基于密度的聚类方法是一种以数据点的密度为目标的聚类算法,

其目的是将使得数据中出现某些较为明显的簇或类的数据点聚集起来,而较少的或者稀少的簇则被分到一起,可以说是识别低密度区间、检

测复杂形态的簇的一种聚类算法。

其主要特点:首先,假设数据集中

存在着显著的聚集簇以及稀疏分布的点,对数据集进行预处理;其次,根据给定的阈值,找到每一个簇的局部密度高的点,将这些点判定为

核心点;然后,搜索局部密度很小的点,将其邻域内的点归入簇;最后,根据阈值确定簇的边缘以及簇的边界,以此来最终判定数据集中

存在的聚集簇。

基于层次划分的最佳聚类数确定方法

ISSN 1000-9825, CODEN RUXUEW E-mail: jos@Journal of Software, Vol.19, No.1, January 2008, pp.62−72 DOI: 10.3724/SP.J.1001.2008.00062 Tel/Fax: +86-10-62562563© 2008 by Journal of Software. All rights reserved.∗基于层次划分的最佳聚类数确定方法陈黎飞1, 姜青山2+, 王声瑞31(厦门大学计算机科学系,福建厦门 361005)2(厦门大学软件学院,福建厦门 361005)3(Department of Computer Science, University of Sherbooke, J1K 2R1, Canada)A Hierarchical Method for Determining the Number of ClustersCHEN Li-Fei1, JIANG Qing-Shan2+, WANG Sheng-Rui31(Department of Computer Science, Xiamen University, Xiamen 361005, China)2(School of Software, Xiamen University, Xiamen 361005, China)3(Department of Computer Science, University of Sherbooke, J1K 2R1, Canada)+ Corresponding author: Phn: +86-592-2186707, E-mail: qjiang@, /View/shizi/jqs.htmChen LF, Jiang QS, Wang SR. A hierarchical method for determining the number of clusters. Journal ofSoftware, 2008,19(1):62−72. /1000-9825/19/62.htmAbstract: A fundamental and difficult problem in cluster analysis is the determination of the “true” number ofclusters in a dataset. The common trail-and-error method generally depends on certain clustering algorithms and isinefficient when processing large datasets. In this paper, a hierarchical method is proposed to get rid of repeatedlyclustering on large datasets. The method firstly obtains the CF (clustering feature) via scanning the dataset andagglomerative generates the hierarchical partitions of dataset, then a curve of the clustering quality w.r.t the varyingpartitions is incrementally constructed. The partitions corresponding to the extremum of the curve is used toestimate the number of clusters finally. A new validity index is also presented to quantify the clustering quality,which is independent of clustering algorithm and emphasis on the geometric features of clusters, handlingefficiently the noisy data and arbitrary shaped clusters. Experimental results on both real world and synthesisdatasets demonstrate that the new method outperforms the recently published approaches, while the efficiency issignificantly improved.Key words: clustering; clustering validity index; statistics; number of cluster; hierarchically clustering摘要: 确定数据集的聚类数目是聚类分析中一项基础性的难题.常用的trail-and-error方法通常依赖于特定的聚类算法,且在大型数据集上计算效率欠佳.提出一种基于层次思想的计算方法,不需要对数据集进行反复聚类,它首先扫描数据集获得CF(clustering feature,聚类特征)统计值,然后自底向上地生成不同层次的数据集划分,增量地构建一条关于不同层次划分的聚类质量曲线;曲线极值点所对应的划分用于估计最佳的聚类数目.另外,还提出一种新的∗ Supported by the National Natural Science Foundation of China under Grant No.10771176 (国家自然科学基金); the National 985Project of China under Grant No.0000-X07204 (985工程二期平台基金); the Scientific Research Foundation of Xiamen University ofChina under Grant No.0630-X01117 (厦门大学科研基金)Received 2007-04-01; Accepted 2007-10-09陈黎飞等:基于层次划分的最佳聚类数确定方法63聚类有效性指标用于衡量不同划分的聚类质量.该指标着重于簇的几何结构且独立于具体的聚类算法,能够识别噪声和复杂形状的簇.在实际数据和合成数据上的实验结果表明,新方法的性能优于新近提出的其他指标,同时大幅度提高了计算效率.关键词: 聚类;聚类有效性指标;统计指标;聚类数;层次聚类中图法分类号: TP18文献标识码: A聚类是数据挖掘研究中重要的分析手段.迄今,研究者已提出了多种聚类算法[1],在商务智能、Web挖掘等领域中得到了广泛的应用.然而,许多聚类算法需要用户给定聚类数,在实际应用中,这通常需要用户根据经验或具备相关领域的背景知识.确定数据集的聚类数问题目前仍是聚类分析研究中的一项基础性难题[2−4].现有的研究[2−13]是通过以下过程(一种迭代的trial-and-error过程[9])来确定数据集最佳聚类数的,如图1所示.在给定的数据集或通过随机抽样得到的数据子集上,使用不同的参数(通常是聚类数k)运行特定的聚类算法对数据集进行不同的划分,计算每种划分的统计指标值,最后比较分析各个指标值的大小或变化情况,符合预定条件的指标值所对应的算法参数k被认为是最佳的聚类数k*.k*Fig.1 A typical process for determining the number of clusters in a dataset图1 典型的确定数据集最佳聚类数的计算过程各种类型的统计指标从不同角度出发衡量数据集划分的聚类质量.聚类有效性指标(cluster validity index,简称CVI)是一类常见的指标,在为数众多的CVI[6−13]中,基于数据集几何结构的指标函数具有代表意义,它们考虑了聚类的基本特征,即一个“好”的聚类结果应使得k个簇的簇内数据点是“紧凑”的,而不同簇的点之间是尽可能“分离”的,指标量化聚类的簇内紧凑度和簇间分离度并组合二者[6,7],代表性的指标包括Xie-Beni指标[8]V xie 和S.Wang-H.Sun-Q.Jiang指标[9]V wsj等.对应于最大或最小指标值的k被认为是最佳聚类数k*.其他类型的统计指标包括Gap statistic[2]、信息熵[3]和IGP(in-group proportion)[4]等,其中,IGP是一种新近提出的指标,它使用簇内数据点的in-group比例来衡量聚类结果的质量,取得了优于现有其他指标的性能[4].然而,现有的工作[2−13]多集中在对统计指标的改进上,而忽略了对计算过程的研究.图1所示的计算过程存在两个问题:首先,由于需要多次地对整个数据集进行聚类,其效率显然与所选用聚类算法本身的效率密切相关,且将随着数据集的增大而显著下降.尽管可以通过减少聚类次数来提高效率,然而估计准确的k min和k max也是不容易的[14];其次,指标被特定的聚类算法联系在一起.例如,实际中许多CVI[6−12]是与FCM(fuzzy C-mean)算法(或融合GA(genetic algorithm)算法[13])结合在一起的,上述的其他指标出于计算的需要总要选择以聚类数k 为参数的算法,如k-means或层次型聚类算法[2−4].这导致了指标性能依赖于聚类算法的问题.例如,FCM和k-means算法存在不能有效识别噪声和只能发现凸形簇的局限性,使得这些指标自然地存在同样的缺陷.本文提出的新方法COPS(clusters optimization on preprocessing stage)采用与图1完全不同的两阶段计算方案,首先通过扫描一遍数据集一次性地构造出数据集所有合理的划分组合,进而生成一条关于不同划分的聚类质量曲线;在第2阶段抽取出对应曲线极小值点的划分来估计数据集的最佳聚类数目,从而避免了对大型数据集的反复聚类,且不依赖于特定的聚类算法,能够有效识别数据集中可能包含的噪声和复杂形状的簇.在实际数据和合成数据上的测试结果表明,COPS的性能优于IGP,同时大幅度提高了计算效率.本文第1节给出COPS方法.第2节提出和分析COPS使用的聚类有效性新指标.第3节进行实验验证和分析.最后在第4节作出总结.64Journal of Software 软件学报 V ol.19, No.1, January 20081 COPS 方法给定d 维数据集DB ={X 1,X 2,…,X n },X ={x 1,x 2,…,x d }为一个数据点,n 为数据点数目.一个硬划分聚类算法[1]将DB 划分为k (k >1)个子集的集合C k ={C 1,C 2,…,C k },且∀j ≠l ,1≤j ,l ≤k ,C j ∩C l =Φ,C j 称为DB 的簇.常用的trail-and- error 方法为产生C k (k =k min ,…,k max )需要对数据集进行k max −k min +1次聚类,这影响了算法效率,尤其当数据量较大时;另一方面,不恰当的k min 和k max 设置也会影响计算结果的准确性.因此,若能根据数据集的几何结构一次性地生成所有合理的划分,同时评估它们的聚类质量,就可以在很大程度上提高计算效率和结果的准确性.COPS 借鉴层次聚类的思想来达到这个目的.其原理是,首先将每个数据点看作单独的簇,然后在自底向上层次式的簇合并过程中生成所有合理的划分,同时计算它们的聚类质量,保存具有最优聚类质量的划分为C *,最后根据C *的有关统计信息来估计聚类数k *.这里使用新的聚类有效指标性指标函数Q (C )来评估划分C 的聚类质量,其最小值对应最优的质量.COPS 计算过程的形式化表示如下:12***{,,...,}arg min (), ()k n k C C C C C Q C k C θ∈==.COPS 的处理对象是可能包含噪声和复杂形状(非凸形)簇的数据集,这样的数据在实际应用中是常见的,如空间数据和一些高维度的数据.过程θ剔除噪声的影响,识别C *中有意义的簇的数目.1.1 算法原理下面,首先结合距离和维度投票(dimension voting)[15]思想提出数据点间相似度的定义,以此为基础给出确定DB 最优划分C *的计算过程.定义1(点的相似维度[15]). 给定一个阈值t j ≥0,1≤j ≤d ,若|x j −y j |≤t j ,则称点X 和Y 是关于t j 第j 维相似的. 根据定义1,可以定义相似的数据点.定义2(相似点). 给定一个阈值向量T ={t 1,t 2,…,t d },若点X 和Y 在所有数据维度上都是关于t j (j =1,2,…,d )相似的,则称数据点X 和Y 是关于T 相似的.彼此相似的数据点组成DB 的簇.若T 的各分量相等,则||T ||相当于基于密度聚类算法[16]中点的邻域半径.这里,我们允许T 的各分量不相等,它反映了数据集各维度属性值分布的差异.显然,T 的取值“大小”决定了簇结构.鉴于T 是一个向量,定义3用于比较不同T 之间的相对关系.定义3(T 的比较). 给定两个阈值向量12{,,...,}a a a a d T t t t =和12{,,...,}b b b b d T t t t =,称T a >T b 若满足:(1) ,ab j j t t ≥j =1,2,…,d ;(2) 至少存在一个j ∈[1,d ],使得ab j j t t >.给定数据集DB ,根据定义2和定义3,一个很小的T 令大多数数据点不相似,极端情形是每个数据点(设DB 中没有相同的数据点)都构成单独的“簇”,此时,DB 的划分数目达到最大值,k =n ;记这样的T 为T 0.相反地,一个足够大的T 将使得所有数据点彼此相似而组成一个大簇,此时,k 达到最小值,k =1;用T m 表示使得k =1的最小的T .至此,可以把确定数据集DB 最优划分C *的问题转换为求解最优阈值向量T *(T 0<T *<T m )的问题,T *是使得Q 在T 从T 0开始增大到T m 过程中取得最小值的阈值向量.由此可以给出COPS 的计算过程,如图2所示.Fig.2 Flowchar of the COPS图2 COPS 的计算流程图计算从T =T 0(每个分量值为0)开始,每个步骤T 增大一个量Δ(Δ={Δ1,Δ2,…,Δd }),根据定义2,此时将有部分原本属于不同子集的点变得相似,这些子集被合并,生成了新的划分;对每个划分计算其Q 的值,直到T 增长到所有陈黎飞 等:基于层次划分的最佳聚类数确定方法 65点被划分到同一个集合为止.这里子集的合并,也就是簇的合并,以类似single link 的方式[1]进行.图3给出一个例子,说明图2的计算过程如何自底向上地进行簇的合并.图3给出了COPS 在一个2维数据集上若干步骤的结果,该数据集包含2个簇和1个噪声点,其中一个簇是非凸形的.如初始状态图3(a)所示,所有的数据点均构成独立的簇;随T 的增大数据点被逐渐合并,假设在某个步骤形成了图3(b)所示的椭圆形区域所代表的若干个小簇;当T 进一步增大使得两个分属于不同簇的点(如图3(b)中分属于簇A 和B 的两个标志为‘x ’的点)变得相似时,两个原本为凸形的簇被合并.基于这样的策略可以生成任意形状的簇,如图3(c)所示,最终合并成了一个banana 型的非凸形簇.图3中,3个阶段的簇结构组成聚类树的3个层次(实际的聚类树可能不止这3个层次,作为一个例子,这里只给出其中的3层).对于每个层次上的簇集合,分别计算它们的Q 值,抽取出其中使得Q取值最小的层次,识别其中的噪声点.考虑图3(c)所示的簇集合,位于下方只包含一个数据点的“簇”被识别为噪声,这样就得到了该数据集的最佳聚类数目为2.以上簇的合并方法与single link [1]的区别是,传统的single link 方式以全空间的欧氏距离为基础,而COPS 依据定义2来衡量簇间的相似度.Single link 已被证明可以识别数据集中非凸形的簇结构[1],我们在此基础上增加考虑了数据集各维度属性值分布的差异因素,这种差异在具有较高维度的实际应用数据中是常见的[17].Δ的选取以及随T 的变化如何快速地生成新的划分和计算Q 值是影响算法性能的重要环节,以下章节将分别阐述.(a) (b) (c)Fig.3 An example of the working flow of the COPS图3 COPS 计算过程示例1.2 算法过程和参数设置COPS 的计算过程类似于凝聚型层次聚类算法中层次聚类树[17]的构建过程.然而,一个典型的层次聚类算法具有O (n 2)的计算复杂度[1].性能的瓶颈在于为每个数据点X 查找与其相似点的集合Neighbors (X ),这是range queries 问题[18],通常这需要遍历整个数据集,一些改进方法可参见文献[18].基于定义2可以简化查找相似点的过程.首先将数据点按照每个维度的属性值大小进行排序(每个维度j 有一个排序的序列A j );根据定义1,通过顺序扫描A j 可以得到所有与点X 第j 维相似的点Y ,扫描范围局限在符合|x j −y j |≤t j 条件的有限区间内.当t j 增加Δj 时,只需在原有范围的基础上扩展扫描区间t j <|x j −y j |≤ t j +Δj 即可.基于此优化方法的COPS 伪代码如图4所示.其中MergePartitions 的功能是在C k +1的基础上合并两个相似点X 和Y 所在的子集生成新的划分C k ;UpdateQ 在Q (C k +1)的基础上根据X 和Y 所在子集的统计信息计算得到新的值Q (C k ).第2节将阐述基于CF 的子集合并和Q (C )的计算方法.算法参数Δ的选取与T 的一个隐含性质有关.考察定义2,T 可以看作是聚类数据集的分辨率(clustering resolution)[19],而分辨率可以被想象为一个看待数据点是否构成簇的“望远镜”.由此可知,T 的各分量间应成一定的比例关系,这个比例与数据点投影到各维度上时点的分布密度有关.同理,Δ的各分量间也应具有这个性质.定义4通过度量维度的稀疏度来量化这种比例关系.定义4(维度稀疏度). 数据集DB 在第j 维的分布稀疏度为λj ,j λ其中,ij x ′是数据点X i 第j 维属性的[0,1]规范化值,μj 表示第j 维的中心,即66Journal of Software 软件学报 V ol.19, No.1, January 20081,...,11,...,1,...,min {}1, max{}min {}n ij lj l nij j ij i lj lj l n l n x x x x x x n μ====−′′==−∑.λj 实际上是数据集第j 维规范化的标准偏差.在高维数据的投影聚类[20]中,正是以标准偏差为基础度量维度与簇之间的相关程度.λj 值越大,表明第j 维属性值分布得越稀疏,与其相关的簇也可能就越多.COPS 利用这些维度上属性值的变化来揭示数据集潜在的簇结构,因此可用以下公式来确定算法的参数Δ:12max{,,...,}d j jλλλΔελ=×, 其中,ε(ε>0)是给定的一个具有很小的数值的算法参数,用于控制计算Q 序列的精度.显然,ε越小,COPS 在每个维度上的搜索步数(即每个维度被分割成的用于计算的区间数)就越多,因而也就扩大了算法搜索数据集最优划分的搜索空间,其结果也就越有可能是最优的结果.另一方面,ε越小,将使得算法的时间开销越大,因而需要在这两者之间取一个平衡点.经过实验环节的反复验证,我们设定ε=0.01.1.3 确定k *的值|C *|是候选的聚类数k *,但由于噪声的影响,k *=|C *|并不完全成立.在COPS 中,噪声数据点也是C *的组成部份,其特点是这些子集所包含的数据点数目较少[19].设|C *|>2,过程θ采用基于MDL(minimal description length)的剪枝方法[21]识别出C *中“有意义”的子集.MDL 的基本思想是,对输入的数据进行编码,进而选择具有最短编码长度的编码方案.在COPS 中,其输入的数据是各个子集包含的数据点数目,簇的重要性由其包含数据点的数目来决定.令****12{,,...,}k C C C C =,*||i C 为*i C 包含的数据点数目.首先按照*||i C 从大到小排序生成一个新的序列C 1,C 2,…,C k ;然后将这个序列以C p (1<p <k )为界分为两个部分:S L (p )={C 1,C 2,…,C p }和S R (p )={C p +1,C p +2,…,C k },求得数据的编码长度CL (p ).CL (p )的定义[21]为2()2()2()2()11()log ()log (||||)log ()log (||||)L L R R S p j S p S p j S p j p p j k CL p C C μμμμ≤≤+≤≤=+−++−∑∑,其中,()()11||, ||)L R S p j S p j j p p j k C p C k p μμ≤≤+≤≤⎡⎤⎡⎤==−⎢⎥⎢⎥∑∑.上式的第1项和第3项分别表示以p 为界的两个Algorithm . COPS (DB ,Δ). begin k =n ,T =T 0,C n ={{X 1},{X 2},…,{X n }},Q n =Q (C n )For each dimension j ∈[1,d ] doA j =Points sorted on the values of j th-attributes {1. Generating Q -sequence} Repeat For each dimension j ∈[1,d ] do For each point X ∈Aj do For each point Y ∈Neighbors (X ,A j ,t j ,t j +Δj )begin Flag X and Y are j th-similar If X and Y are full-dimensional similar begink =k −1 C k =MergePartitions (C k +1,X ,Y ) Q k =UpdateQ (Q k +1,X ,Y )end; end; {for Y ∈Neighbors ()} T =T +Δ Until k =1 {2. Computing k *} C *=Partitions having the minimum of Q -sequence Return k *=θ(C *) end; Fig.4 The pseudocodes of the COPS 图4 COPS 的伪代码陈黎飞 等:基于层次划分的最佳聚类数确定方法 67 序列的平均编码长度;其余两项衡量|C j |与平均数据点数之间的差异.实际计算中若出现()||L j S p C μ=或()||R j S p C μ=而使得log 函数没有定义,则直接忽略该子集,即设定此时的差异为0 bit.最短的编码长度CL (p )对应的分割位置p 被看作数据序列的最优分割点,根据MDL(minimal description length)剪枝方法的思想,此时S L (p )所包含的数据点可以认为代表了对DB 的覆盖[21].在COPS 中,S R (p )所包含的数据点就识别为噪声.至此,我们得到了数据集的最佳聚类数,k *=p .1.4 算法复杂度最坏情况下,COPS 的空间复杂度为O (n 2),实际中采用以下策略降低算法的空间使用量:对任意两个不相似的数据点X i 和X j ,若X i 和X j 至少在一个维度上是相似的,则通过一个hash 函数映射到一个线性表中的单元HASH (i ,j ),HASH (i ,j )记录X i 和X j 的维度相似情况.算法开始时,该表的所有单元为空(未被使用),随着T 的增大,一些点对变得相似时,其映射在线性表中的单元亦被释放,从而有效降低了算法的实际空间占有量.采用快速排序(quicksort)方法对数据点进行排序的时间复杂度为O (dn log n ).生成Q 序列部分算法的时间复 杂度为()O kdnN ,其中,k 为外层循环的执行次数,是一个与n 无关的量,在数值上,k <<n .这是因为随着T 的增 大,越来越多的点变得相似,k 在内层循环中将迅速减少,其数值只与数据点的分布和ε的取值有关;N 是数据点在Δ邻域内的平均相似点数目,在数值上N <<n ,它也只与数据点分布和ε有关.计算初始值Q (C n )的复杂度为 O (dn )(参见第2.3节分析),MDL 剪枝方法的复杂度为O (k 2).综上,COPS 的时间复杂度为O (dn log n ).2 COPS 的聚类有效性指标COPS 用有效性指标Q (C )评估DB 被划分为C 时的聚类质量.本节提出的指标Q (C )主要考虑数据集的几何结构,即通过衡量簇内数据点分布的紧凑度以及簇间的分离度,并保持二者之间的平衡.Q (C )不依赖于具体的聚类算法.2.1 新的有效性指标设||X −Y||表示点X 和Y 之间的欧氏距离,给定DB 的一个划分C k ={C 1,C 2,…,C k },Scat (C k )衡量C k 的簇内紧凑度, Sep (C k )对应C k 的簇间分离度.具体地,21,()||||i k k i X Y C Scat C X Y =∈=−∑∑ (1) 211,,1()||||||||i l k k k i l l i X C Y C i l Sep C X Y C C ==≠∈∈⎛⎞=−⎜⎟⎜⎟⋅⎝⎠∑∑∑ (2) 以上两式的定义原理如下:Scat 是簇内任意两个数据点之间距离的平方和;Sep 的原理是将每个簇看作是一个大“数据点”,大“数据点”间的“距离”通过簇间点对的平均距离来衡量.这样,Scat 和Sep 保持了度量上的一致性.另一方面,Scat 和Sep 基于“点对”的平均距离定义,可用于度量非凸形簇结构的聚类质量.传统的基于几何结构的聚类有效性指标(如V xie [8])通常基于簇质心(centroids)使用簇的平均半径和质心之间的距离来定义Scat 和Sep ,这样的指标往往只对球(超球)形的簇结构有效[7].代入欧氏距离公式再做简单的变换,Scat (C k )和Sep (C k )可分别表示为211()2(||)d kk i ij ij j i Scat C C SS LS ===−∑∑,2221111()2(1)||||||dk k k ij ij ij k j i i i i i i SS LS LS Sep C k C C C ====⎛⎞⎛⎞⎜⎟=−−+⎜⎟⎜⎟⎝⎠⎝⎠∑∑∑∑, 其中,2, i iij j ij j X C X C SS x LS x ∈∈==∑∑.直观上,Scat 的值越小,表明簇越紧凑;Sep 的值越大,表明簇间的分离性越 好.在下式中使用线性组合平衡二者,β(β>0)为组合参数,用于平衡Scat 和Sep 取值范围上的差异:Q 1(C )=Scat (C )+β⋅Sep (C ).68Journal of Software 软件学报 V ol.19, No.1, January 2008这里将数据集的划分C 看作一个变量,其定义域为{C 1,C 2,…,C n }.根据定理1可以推定β=1.定理1. 给定数据集DB ,Scat (C )和Sep (C )具有相同的值域范围.证明:在初始状态k =n ,C n ={{X 1},{X 2},…,{X n }},由公式(1)可知Scat (C n )=0;根据公式(2)有()()221()2)d n j j j X DB X DB Sep C n x x M =∈∈=⋅−=∑∑∑ (3)设在某个步骤C u 和C v (u ,v ∈[1,k ],u ≠v ,k >1)合并:22111122||||()()2(2)||||(||||)|||||||||| 2(||||)||||||d d k uj vj v uj u vj ij k k j j i u v v u u v i v uj u vj ij i v u u v i LS LS C SS C SS SS Sep C Sep C k C C C C C C C C LS C LS LS C C C C C −===⎛⎞+−=−−−+−⎜⎟⎜⎟+⎝⎠++∑∑∑11,,0d k j i u v ==≠⎛⎞<⎜⎟⎜⎟⎝⎠∑∑ (4)11()()2(||||2)0dk k u vj v uj uj vj j Scat C Scat C C SS C SS LS LS −=−=++>∑ (5)因此,Scat (C )是单调递增函数,而Sep (C )为单调递减函数.当k =1时,C 1={{X 1,X 2,…,X n }},容易求得Sep (C 1)=0和Scat (C 1)=M . □ 根据定理1,COPS 使用的聚类有效性指标函数Q (C )取以下形式: 1()(()())Q C Scat C Sep C M=+ (6) 2.2 指标分析最优的聚类质量对应于簇内紧凑度和簇间分离度的平衡点[9,10],在数值上反映为指标函数Q (C )取得最小值.定理2表明,对于大多数(一种特例除外,见定理条件)数据集Q (C )存在(0,1)区间的最小值.定理2. 给定数据集DB ={X 1,X 2,…,X n },若n >2且至少存在一个i ∈[2,n −1]使得||X i −1−X i ||≠||X i −X i +1||,则Q (C )存在小于1的极小值.证明:考虑在COPS 的初始状态k =n ,C n ={{X 1},{X 2},…,{X n }}.令t j =min l =1,2,…,n −1{x lj −x (l +1)j },j =1,2,…,d ,若满足定理条件,根据定义1,∃u ,v ∈[1,n ],u ≠v ,使得X u 和X v 是相似的,且(X i −1,X i )和(X i ,X i +1)中至少有1对是不相似的,后者确保对所有相似点做合并处理后k >1.考虑点X u 和X v 合并后Q 的变化,根据公式(3)~公式(6)有1111,,1,,21()1()()02d dn n n uj vj ij uj vj ij j j i i u v i i u v n Q C SS SS SS LS LS LS M M −===≠=≠⎛⎞⎛⎞−−=−+−++<⎜⎟⎜⎟⎜⎟⎝⎠⎝⎠∑∑∑∑. 定理1已经证明Q (C 1)=Q (C n )=1,这意味着若满足定理条件,则Q (C )存在小于1的极小值. □ 定理2给出了Q (C )无法取得(0,1)区间极小值的一种特殊结构的数据集,其直观情形是所有数据点均匀地分布在空间等分网格的节点上.对这样的数据集,COPS 将输出k *=n .这是合理的,因为此时,合理的k *取值为1或n ,而聚类算法通常要求k *>1.2.3 指标计算根据公式(3)~公式(6)可以进行Q (C k )的增量计算(UpdateQ 过程).为了得到Q (C k ),只需在Q (C k +1)的基础上使用公式(4)和公式(5)计算其增量即可.为此,在算法中为每个C i (i =1,2,…,k )保存一个结构: CF i =(|C i |,〈SS i 1,LS i 1〉,〈SS i 2,LS i 2〉,…,〈SS id ,LS id 〉). 这正是BIRCH 算法提出的聚类特征(clustering feature)[17].基于此,合并数据集划分的操作(MergePartitions 过程)可以转化成为相应的|C i |,SS ij 和LS ij 数值之间简单的加法运算.在计算初始值M 时,需获得每个数据点的CF 结构,再按照公式(3)计算,其时间复杂度为O (dn ).一条典型的Q (C )曲线例子如图5所示.图中,在最小值之后Q值出1.00.80.60.40.20.0 Fig.5 An example of a Q (C ) curve图5 Q (C )曲线的一个例子陈黎飞等:基于层次划分的最佳聚类数确定方法69现大幅跳变,这意味着若合并最优划分的一些子集将使得聚类质量急剧下降.利用这个特点,此时加大T的增量Δ可以进一步提高COPS的性能.具体地,当数据集较大时(比如n>1000),计算过程中若Q大于已出现的最小值,我们设定ε=ε×2.3 实验与分析实验验证包括算法有效性和算法效率两方面.在众多的聚类有效性指标[6−13]里,选用基于几何结构的V xie[8]和V wsj[9]这两种有代表意义的指标作为对比对象,其中,V xie是首个采用“紧凑度”和“分离度”概念的经典指标; V wsj改进了线性组合方法的稳定性,可以有效地处理包含有重叠的簇和噪声的数据集[9,12].两种指标都基于FCM 算法,实验设定FCM算法的模糊因子w=2.在其他类型方法中,选用Gap statistic[2]和IGP[4]作比较.Gap statistic 的特点是通过检测聚类质量的“突变(dramatic change)”确定最佳的k值;IGP是新近提出的一个指标,使用in- group比例衡量聚类的质量,其性能已被验证优于现有的其他统计指标[4].根据文献[2,4]的建议,使用k-means作为它们的基本算法,取参数R=5;IGP使用的Cutoff阈值设置为0.90.使用Greedy技术[9]选择FCM/k-means的初始簇中心点以提高算法的收敛速度.实验在CPU 2.6GHz,RAM 512MB的计算机上进行,操作系统为Microsoft Windows 2000.3.1 实验数据实验分别采用了真实数据和人工合成数据.以下报告6个有代表性的数据集上的实验结果,数据集的参数汇总见表1.为比较起见,选取的前2个数据集DS1和DS2是常被类似研究引用的真实数据X30和IRIS数据[3,7−9,12].DS3和DS4是两个具有较高维度的实际应用数据.DS3来源于Vowel Recognition(deterding data) (/~mlearn/databases/undocumented/connectionist-bench/vowel/),包含有10个说话人、11个英语元音的发音数据,用于语音识别研究;DS4来源于Wisconsin Breast Cancer Database(/ databases/breast-cancer-wisconsin/),是患者肺部FNA测试的临床数据,用于医疗诊断.Table 1Summarized parameters of datasets表1测试数据参数汇总表DB Description of the dataset Dimension (d)Size(n)True number of clustersDS1 X30 230 3150 3 DS2 IRIS 4DS3 Vowel recognition (deterding data)10 528 11DS4 Wisconsin breast cancer database9 699 2DS5 Synthetic dataset 3 4 000 660008DS6 t5.8k 2为测试各种方法处理大型数据集的性能,根据文献[17]提供的方法(在原方法基础上改进为随机簇中心)合成了含4 000个数据点的3维数据集DS5.DS5同时还包含少量的噪声,这些噪声模糊了簇的边界,其中两个簇存在明显的重叠.第6个数据集DS6包含有8 000个数据点,是命名为“t5.8k”的公用数据集,其特点是包含有大量的噪声和复杂形状的簇(其6个簇呈‘GEOAGE’字母形状).更为重要的是,我们通过实验发现,在适当的参数配置下,即指定了正确的聚类数,FCM和k-means算法可以很好地区分出这6个簇.以此验证基于FCM或k-means 算法的其他4种方法以及COPS识别复杂形状簇的性能.3.2 有效性实验COPS在6个数据集上都得到了正确的聚类数,实验结果如图6所示.对DS1和DS2,COPS检测出在聚类数从最优数目3变为2时聚类质量大幅度下降.DS2包含有两个重叠的簇[12],图6(b)表明,COPS能够有效区分重叠的簇.受噪声影响,DS5中有两个边界模糊的簇,图6(e)显示,对应于聚类数6和5的聚类质量只存在很小的差异,尽管如此,COPS还是完成了准确的区分,得到最优聚类数6,这说明COPS可以有效地识别噪声并区分簇间的密度差异.对DS3~DS6这4个较为复杂的数据,COPS没有检测到连续变化的k值,例如在图6(f)中,k从18跳变到最优数6.这是因为COPS采用了与其他方法不同的做法,它不是通过设定一个k的区间反复运行聚类算法来。

密度峰聚类算法

密度峰聚类算法密度峰聚类算法是一种基于密度的聚类方法,它通过寻找数据集中的密度峰值来进行聚类。

相比于传统的基于距离的聚类方法,密度峰聚类算法在处理不规则形状的数据集时具有更好的效果。

密度峰聚类算法的核心思想是通过计算数据点的局部密度和局部距离来找到密度峰值。

在算法开始时,首先需要确定两个参数:邻域半径和最小密度。

邻域半径表示一个数据点周围的范围,最小密度表示在该范围内的数据点的数量。

算法的步骤如下:1. 计算每个数据点与其他数据点的距离,并将距离按升序排列。

2. 根据设定的邻域半径,确定每个数据点的邻域内的数据点数量,即局部密度。

3. 根据设定的最小密度,确定每个数据点的核心点。

核心点的局部密度必须大于最小密度。

4. 根据核心点之间的距离,确定每个核心点的可达距离。

可达距离是指从一个核心点到另一个核心点的最小距离。

5. 根据核心点之间的可达距离,确定每个核心点的密度峰值。

密度峰值是指在可达距离中最大的距离。

6. 将密度峰值大于其他核心点的数据点作为聚类中心,将相应的数据点归类到该聚类中心下。

7. 将密度峰值小于其他核心点的数据点作为噪声数据,不进行归类。

密度峰聚类算法的优点在于可以不受数据形状的限制,能够有效地识别不规则形状的聚类。

同时,该算法还具有较好的鲁棒性和可扩展性,在处理大规模数据集时也能取得良好的效果。

然而,密度峰聚类算法也存在一些限制。

首先,该算法对参数的选择比较敏感,不同的参数组合可能导致聚类结果的差异。

其次,当数据集的密度分布较为均匀时,算法的效果可能较差。

此外,密度峰聚类算法对于噪声数据的处理也较为有限,可能将一些噪声数据误判为聚类中心。

密度峰聚类算法是一种基于密度的聚类方法,能够有效地识别不规则形状的聚类。

虽然该算法存在一些限制,但在实际应用中仍具有一定的价值。

未来的研究可以进一步探索如何优化密度峰聚类算法的参数选择和噪声数据处理,以提高算法的准确性和鲁棒性。

密度峰值聚类算法

密度峰值聚类算法

GPCL算法(Generalized peak clustering algorithm)是一种基于密度峰值进行核聚类分析的数据挖掘技术,该算法由季宾浩等人提出。

通过分析样本空间中的密度峰值,从而把一系列的样本特征变量聚类,根据簇的形状进行划分类,也可认为是一个基于密度的聚类技术。

GPCL算法的围绕着核,将输入空间分裂成相互独立的子空间,当它们包含少量元素时,可以确定空间内遍布分布。

该算法通过以下步骤实现聚类:

(1)从输入空间中的每个点开始,启动一对对象的密度峰值搜索,记为“密度峰值对”;

(2)为每一密度峰值对建立有限的核区域;

(3)把输入空间的每个点分配给一个核,输入空间被分成多个含有有限元素的独立块;

(4)计算所有核区域的压缩度,并确定重叠阈值;

(5)将空间分为不重叠的K个核。

GPCL算法属于局部密度聚类,主要作用是在一定范围内(采用核标准化后)按

照某种逻辑搜索数据的分布特征,从而使得聚类的过程结果更准确,适用于在大数据集中搜索分类数据近似相同的点。

此外,GPCL算法可以用于考察海量数据中点到点之间的“密封”密度关系,可以更好地捕获异常点。

基于密度峰值及肘方法的类数目确定

DOI: 10.11991/yykj.202011010基于密度峰值及肘方法的类数目确定王赢己,董红斌哈尔滨工程大学 计算机科学与技术学院,黑龙江 哈尔滨 150001摘 要:为确定数据集真实类数目,降低参数对于密度峰值算法的影响,本文基于自然邻居思想提出了密度峰值(DP)算法的新内核,以摆脱参数的限制,实现真正的自适应聚类。

将密度峰值算法与肘方法联合,提出了自然密度峰(NDP)指标。

此外,通过减而治之的思想,改进了自然邻居的搜索算法。

新的指标和方法可以适用于多种类型的数据集(例如线形、流形、环形和凸形数据集)求得最优类簇数目。

经理论研究和实验结果分析可以证实所提出的指标和算法的有效性。

关键词:聚类算法;密度峰值;自然邻居;自适应;肘方法;类数目;减而治之;新内核中图分类号:TP181 文献标志码:A 文章编号:1009−671X(2021)02−0074−06Determination of the number of classes based on densitypeak and elbow methodWANG Yingji, DONG HongbinCollege of Computer Science and Technology, Harbin Engineering University, Harbin 150001, ChinaAbstract : In order to determine the number of real classes in the data set, and reduce the influence of parameters on the density peak (DP) algorithm, this paper first proposes a new kernel of the density peak algorithm based on the idea of natural neighbors to get rid of the limitation of parameters and realize true adaptive clustering. Then, a new clustering effectiveness index of natural density peak (NDP) is proposed by combining the density peak algorithm with the elbow method. In addition, the search algorithm for natural neighbors is improved through the idea of reducing and conquering.The new indicators and methods can be applied to multiple types of data sets, such as linear, manifold, circular and convex data sets, to find the optimal number of clusters. The theoretical research and analysis of the experimental results can prove the effectiveness of the proposed index and algorithm.Keywords: clustering algorithm; peak density; natural neighbor; adaptive; elbow method; number of clusters;dichotomy method; new kernel伴随着时代的发展与进步,大数据技术已深入到人们的生活中,比如在视频广告、交易平台和视频终端,每天产生海量的数据,如果将这些数据加以利用,就可以化“数字”为“神奇”,创造无穷价值,因此“数据挖掘”技术被广泛运用。

聚类的评价标准

聚类的评价标准聚类是一种常见的数据分析方法,它将数据集中的对象按照相似性分成若干个类别。

在聚类分析中,评价标准是非常重要的,因为它可以帮助我们确定聚类的质量和效果。

本文将从不同的角度介绍聚类的评价标准。

一、基于距离的评价标准距离是聚类分析中最基本的概念之一,因此基于距离的评价标准是最常见的。

其中,最常用的评价标准是簇内平均距离和簇间最小距离。

簇内平均距离是指同一簇内所有对象之间的距离的平均值,而簇间最小距离是指不同簇之间最近的两个对象之间的距离。

这两种评价标准都可以用来衡量聚类的紧密度和分离度。

二、基于密度的评价标准密度是指在一个区域内包含的对象数量,基于密度的评价标准主要用于密度聚类。

其中,最常用的评价标准是DBSCAN算法中的最小密度和最大距离。

最小密度是指在一个区域内至少包含多少个对象才能被认为是一个簇,而最大距离是指在一个簇内任意两个对象之间的距离不能超过这个值。

三、基于连通性的评价标准连通性是指在一个簇内所有对象之间都存在一定的联系,基于连通性的评价标准主要用于层次聚类。

其中,最常用的评价标准是平均连通度和最小连通度。

平均连通度是指同一簇内所有对象之间的平均连通度,而最小连通度是指同一簇内任意两个对象之间的最小连通度。

四、基于聚类效果的评价标准除了以上三种基于数据本身的评价标准外,还有一些基于聚类效果的评价标准。

其中,最常用的评价标准是轮廓系数和Davies-Bouldin指数。

轮廓系数是一种衡量聚类效果的指标,它可以用来评估每个对象在自己所在簇内的紧密度和与其他簇之间的分离度。

而Davies-Bouldin指数是一种衡量聚类效果的指标,它可以用来评估不同簇之间的分离度和同一簇内的紧密度。

综上所述,聚类的评价标准是非常重要的,它可以帮助我们确定聚类的质量和效果。

在选择评价标准时,需要根据不同的聚类算法和数据特征来选择合适的评价标准。

同时,需要注意评价标准的局限性,不能仅仅依靠一个评价标准来确定聚类的质量和效果。

密度聚类算法详解

密度聚类算法详解

密度聚类算法是一种基于密度的聚类方法,其主要思路是根据数据点

的密度来划分聚类簇。

与其他聚类算法相比,密度聚类不需要预先指定聚

类簇的数量,能够自动识别不同形状和大小的聚类簇。

下面将详细介绍密

度聚类算法的原理和步骤。

密度聚类算法最重要的概念是核心对象和直达密度。

核心对象是指在

给定半径ε内具有一定密度(即在该半径内至少存在MinPts个数据点)

的数据点。

直达密度是指如果一个数据点在核心对象的半径ε内,那么

该数据点就是直达密度。

1. 初始化参数:选择邻域半径ε和最小邻域数目MinPts。

2.计算密度:对于数据集中的每个数据点,计算它的ε-邻域内的数

据点数目。

3. 标记核心对象:将密度大于等于MinPts的数据点标记为核心对象。

4.扩展聚类簇:从一个未访问的核心对象出发,找到所有直达密度的

数据点,将它们添加到聚类簇中,并标记为已访问。

5.重复步骤4,直到所有核心对象都被访问。

6.将未访问的数据点标记为噪音。

密度聚类算法的核心思想是通过核心对象进行聚类的扩展,从而找到

相同密度的数据点,并将它们划分为一个聚类簇。

具体步骤中,通过计算

数据点的ε-邻域数据点数目可以判断是否为核心对象,然后从核心对象

开始不断扩展聚类簇,直到找不到新的直达密度数据点为止。

总结起来,密度聚类算法是一种基于密度的聚类方法,通过核心对象和直达密度来划分聚类簇。

该算法不需要预先指定聚类簇的数量,能够自动适应不同密度和形状的数据集。

但是参数选择对算法性能有较大影响,且对密度分布敏感。

基于密度的聚类算法

基于密度的聚类算法

密度聚类算法是一种基于数据密度的聚类方法,主要特点是将数据点结合成聚类,旨在从数据集中查找最相近的点。

不同于传统的聚类算法,它更加侧重于计算空间内点的密度,而不是向量空间的距离。

密度聚类有很多类型,其中著名的算法有:DBSCAN(支持度基因聚类)、OPTICS(离散点优化视觉)以及DENCLUE (离散时间处理)等。

DBSCAN算法是一种基于密度的算法,它建立在空间数据点分布上,结合两个参数即半径(eps)和聚类最小数目(minPoints)来形成聚类。

它做的是,首先通过设定一个半径eps,将不同的点连接起来,组成相互之间距离小于eps的点构成一个新的聚类簇,然后将这些特征点的聚类扩大,直到形成一个稳定的聚类。

这就是DBSCAN算法。

而OPTICS算法则是基于密度的另一种聚类算法,它能够通过使用一个可变的半径来构建密度梯度,将离散点根据密度进行排序,并计算点间的可达距离。

根据密度梯度,它可以更好地分割空间中的离散点,并捕获出数据集中斑点和噪音的细节,从而得到比DBSCAN更具有有效性的结果。

最后,DENCLUE算法的主要思想是将数据由时间轴上的离散分布抽象出来,使用一个可变的高斯函数来计算每个点的密度,该可变半径适应于空间密度的可变程度,能够选择合适的结构来描述每个离散点,从而获取更好的聚类效果。

总而言之,基于密度的聚类算法是一种比较精准的聚类方法,通过设定半径和点的最小数目来形成聚类,从而使得空间中的点更加清晰准确的被整合在一起。

聚类算法方法归纳

聚类算法方法归纳

1. K-Means 聚类:这是一种最常见的聚类算法,它通过确定 k 个初始中心点,并将每个数据点分配给最近的中心点,然后不断更新中心点的位置,直到达到最优的聚类结果。

2. 层次聚类:这种方法通过构建一棵树来表示数据的层次结构,从而实现聚类。

它可以是凝聚的(自下而上)或分裂的(自上而下)。

3. DBSCAN 聚类:基于密度的空间聚类应用程序和噪声(DBSCAN)是一种基于密度的聚类算法,它通过计算样本点之间的距离来判断样本点的密度,将样本点分为不同的簇。

4. 高斯混合模型(GMM):GMM 是一种概率模型,它假设数据是由多个高斯分布混合而成的。

通过最大化似然函数来估计模型参数,从而实现聚类。

5. OPTICS 聚类:这是一种基于密度的聚类算法,它通过计算样本点之间的距离来判断样本点的密度,将样本点分为不同的簇。

6. Agglomerative 聚类:这种方法通过不断合并最相似的两个簇来构建聚类层次结构。

7. 模型-based 聚类:这种方法使用统计模型(如混合模型、隐马尔可夫模型等)来描述数据的分布,并通过最大化模型的对数似然来确定最佳的聚类数量和成员。

这些是聚类算法的一些常见方法,每种方法都有其优缺点,适用于不同类型的数据和应用场景。

在选择聚类算法时,需要考虑数据的特征、聚类的目标以及计算效率等因素。

gmm聚类方法

gmm聚类方法

GMM(Gaussian Mixture Model,高斯混合模型)是一种聚类方法,它假设数据是由多个高斯分布的混合体生成的。

GMM试图找到这些分布的参数以及每个数据点的标签,以便将数据点分配给相应的分布。

GMM的聚类方法基于概率密度函数,通过最大化每个数据点的概率来拟合模型。

GMM的目标是找到最佳的模型参数,以便在给定数据的情况下,能够最好地表示数据的生成过程。

在实现上,GMM通常采用EM(Expectation Maximization)算法进行迭代优化。

EM算法通过反复迭代来最大化对数似然函数的值,以找到模型参数的最佳估计值。

然而,GMM也有一些局限性。

首先,它需要事先指定聚类的数量,这可能是一个主观的决策。

其次,GMM假设数据是静态的,并且每个高斯分布是静态的,这可能不适用于具有动态特性的数据集。

此外,GMM对异常值比较敏感,因为异常值可能会对模型参数的估计产生较大影响。

尽管存在这些局限性,GMM仍然是一种非常有效的聚类方法,在许多领域中得到了广泛应用。

它能够处理复杂的、非线性的数据分布,并且能够自动

确定最佳的聚类数量。

此外,GMM还可以与其他机器学习算法结合使用,以进一步提高聚类的准确性和稳定性。

基于密度方法的聚类.

层次聚类优缺点 层次聚类方法是不可逆的,也就是说,当通过凝聚式的方 法将两组合并后,无法通过分裂式的办法再将其分离到之 前的状态,反之亦然。 另外,层次聚类过程中调查者必须决定聚类在什么时候停 止,以得到某个数量的分类。 在不必要的情况下应该小心使用层次聚类方法。

DBSCAN聚类过程

第4步,在数据库中选择一点4,由于在以它为圆心的,以1为半径的 圆内包含5个点,因此它是核心点,寻找从它出发可达的点(直接可 达4个,间接可达3个),聚出的新类{1,3,4,5,9,10,12},选择 下一个点。

密度聚类方法

划分聚类方法

层次聚类方法 密度聚类方法 :基于密度的聚类方法以数据集在空间分布上的稠 密程度为依据进行聚类,无需预先设定簇的数量,因此特别适合对 于未知内容的数据集进行聚类。 网格聚类方法 模型聚类方法

基于密度方法的聚类- DBSCAN

DBSCAN(Density-Based Spatial Clustering of Applications with Noise)一 个比较有代表性的基于密度的聚类算法。与层次聚类方法不同,它将 簇定义为密度相连的点的最大集合,能够把具有足够高密度的区域划 分为簇,并可在有“噪声”的空间数据库中发现任意形状的聚类。

k-means 算法

k-means 算法基本步骤

1. 从 n个数据对象任意选择 k 个对象作为初始聚类中心; 2. 根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离; 并根据最小距离重新对相应对象进行划分; 3. 重新计算每个(有变化)聚类的均值(中心对象); 4. 计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条 件不满足则回到步骤2。

基于密度的最佳聚类数确定方法

D B指标首先计算每个类 中各点与类 中心 的平均距

3 Q| C N MAN G ME T I O M I N Z I Hl A A E N NF R AT O IATON

包括确定 数据集的聚类趋势 、 确定 正确 的类个数 、 聚 何 指 标 。 将 用 内部指标来评估聚类有效性 , 获取数据集最佳划 类分析结果与已知 的客观结果 比较等 , 本文主要研究其

中的最佳聚类数 的确定 。

分或最佳聚类数 的过程一般分 为以下 4步 : 第一步 : 出一系列用来对数据集进行 聚类 的聚类 给 算法 : 第二步 : 于每一 种聚类算法 , 别使用不 同的输 对 分 人参数 以获得不 同的聚类结果 ;

[ 中图分类号T 3 1 [ P 9 文献标识码】A

[ 文章编号]1 7 — 1 42 1 )9 0 3 - 4 6 3 0 9 (0 10 - 0 0 0

0 引 言

来评估数据集划分的有效性 , 这些指标称为聚类有效性

Cut i l t nI i ) en V d o n e 用于评估 聚类是数据挖掘研究 中重要 的分析手段 .其 目的 指标 ( ls r g aiai dcs。一般地 , 是将数据集 中对象聚集成类 , 得同一类 中的对象是相 聚类 的各方面的评估度量指标可分成 以下两类 。 使 () 1 外部指 标 ( x ra id x : 聚类分 析的评 价 E t n ln e )指 e 似的 , 而不同类 中的对象是不同的。迄今研究者 已经提

I H I — _类I r1理— 估1果 数 — 处_ 据_ r 集_ 斗 预— 评_结 f H _

图 1 聚 类 分 析 流 程 图

第三步 : 于第二 步 中得到 的不 同聚类结果 , 对 计算 通常最佳 聚类数 的确定是通过 以下计算过程来 确 定 的。 在给定 的数据集上 , 通过使用不同的输入参数 ( 如 其 内部指标并得到相应的取值 : 第四步 : 根据 内部指标所要求 的规则选择最佳分割 聚类数 N 运行 特定 的聚类算 法 , C) 对数 据集进 行不 同 的划分 , 计算每种划 分的聚类有效性 指标 , 最后 比较各 或最佳 聚类数 。

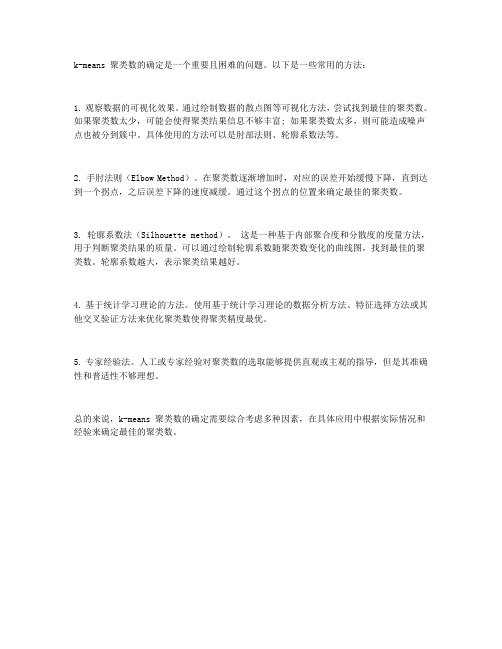

k-means聚类数的确定方法

k-means 聚类数的确定是一个重要且困难的问题。

以下是一些常用的方法:

1. 观察数据的可视化效果。

通过绘制数据的散点图等可视化方法,尝试找到最佳的聚类数。

如果聚类数太少,可能会使得聚类结果信息不够丰富; 如果聚类数太多,则可能造成噪声点也被分到簇中。

具体使用的方法可以是肘部法则、轮廓系数法等。

2. 手肘法则(Elbow Method)。

在聚类数逐渐增加时,对应的误差开始缓慢下降,直到达到一个拐点,之后误差下降的速度减缓。

通过这个拐点的位置来确定最佳的聚类数。

3. 轮廓系数法(Silhouette method)。

这是一种基于内部聚合度和分散度的度量方法,用于判断聚类结果的质量。

可以通过绘制轮廓系数随聚类数变化的曲线图,找到最佳的聚类数。

轮廓系数越大,表示聚类结果越好。

4. 基于统计学习理论的方法。

使用基于统计学习理论的数据分析方法、特征选择方法或其他交叉验证方法来优化聚类数使得聚类精度最优。

5. 专家经验法。

人工或专家经验对聚类数的选取能够提供直观或主观的指导,但是其准确性和普适性不够理想。

总的来说,k-means 聚类数的确定需要综合考虑多种因素,在具体应用中根据实际情况和经验来确定最佳的聚类数。

确定最佳聚类数的方法

确定最佳聚类数的方法嘿,咱今儿就来聊聊确定最佳聚类数这个事儿。

你说这聚类数咋确定呢?就好像你去挑苹果,你得知道挑几个才合适呀!咱先来说说直观观察法。

你就盯着那些数据,像欣赏一幅画似的,看看能不能看出个大概的分组来。

要是能,那这组数不就有点眉目啦?这就好比你看天上的星星,有时候你一眼就能看出哪些星星好像聚在一起呢。

还有个方法叫手肘法。

这名字是不是挺有意思?就像你的手肘弯起来有个转折点一样,数据也会有那么一个点,让你感觉再增加聚类数好像也没啥大变化了。

你想想,是不是有时候做一件事,做到某个程度就感觉差不多了,再使劲儿也没啥太大效果啦?再说说轮廓系数法。

这就好像给每个聚类都打个分,看看哪个分数最高,那对应的聚类数不就是比较好的嘛。

就跟咱上学考试似的,谁分数高谁厉害呀。

那怎么知道哪个方法最好呢?这可没有绝对的答案哟!不同的情况可能适合不同的方法。

就像你去不同的地方旅游,得根据当地的情况选择合适的交通工具一样。

有时候直观观察法就挺好用,一眼就看出来了;有时候就得靠手肘法或者轮廓系数法来仔细琢磨琢磨。

比如说,你要是面对的数据比较简单,那可能直观观察法就能搞定。

但要是数据复杂得像一团乱麻,那你就得用更精细的方法啦。

这就好比你解一道很难的数学题,简单的方法不行,就得用更复杂的公式和技巧呀。

而且呀,确定最佳聚类数可不能马虎。

要是随便定一个,那结果可能就差之千里咯!就像你走路,方向错了,那可就越走越远啦。

所以得认真对待,多试试几种方法,找到最适合的那个数。

咱再想想,要是在实际工作或者研究中,确定不好聚类数,那会咋样呢?那得出的结果可能就不准确,就像盖房子根基没打好一样,后面可就麻烦啦。

总之呢,确定最佳聚类数这事儿啊,可得花心思。

别嫌麻烦,多试试几种方法,就像给自己挑一件最合适的衣服一样,得精挑细选呀!咱可不能在这上面马虎,不然可得后悔哟!你说是不是这个理儿呢?。

确定类数目的聚类方法

确定类数目的聚类方法聚类是一种无监督学习方法,它通过将相似的数据点分组来发现数据的内在结构。

在聚类中,确定类数目是一个非常重要的问题,因为类数目的选择会直接影响聚类结果的质量。

因此,确定类数目的聚类方法是聚类研究中的一个重要问题。

目前,确定类数目的聚类方法主要有以下几种:1. 基于经验的方法基于经验的方法是一种简单而直观的方法,它通常基于数据的特征和领域知识来确定类数目。

例如,如果我们要对一组学生进行聚类,我们可以根据学生的年龄、性别、学科成绩等特征来确定类数目。

这种方法的优点是简单易行,但缺点是可能会忽略一些重要的特征和数据结构。

2. 基于统计学的方法基于统计学的方法是一种常用的确定类数目的聚类方法。

它通常基于数据的分布和模型来确定类数目。

例如,我们可以使用高斯混合模型来对数据进行建模,并使用信息准则(如AIC、BIC)来确定最优的类数目。

这种方法的优点是可以考虑数据的分布和模型,但缺点是需要对数据进行假设和建模,可能会受到模型假设的限制。

3. 基于层次聚类的方法基于层次聚类的方法是一种自底向上的聚类方法,它可以通过构建聚类树来确定类数目。

例如,我们可以使用凝聚层次聚类算法来构建聚类树,并使用树的剪枝来确定最优的类数目。

这种方法的优点是可以考虑数据的层次结构,但缺点是计算复杂度较高,可能会受到噪声和异常值的影响。

4. 基于密度的方法基于密度的方法是一种基于数据密度的聚类方法,它可以通过确定密度峰值来确定类数目。

例如,我们可以使用DBSCAN算法来确定密度峰值,并使用密度峰值的数量来确定最优的类数目。

这种方法的优点是可以考虑数据的密度分布,但缺点是可能会受到参数的选择和数据的噪声影响。

综上所述,确定类数目的聚类方法有多种选择,每种方法都有其优缺点。

在实际应用中,我们应该根据数据的特点和需求选择合适的方法,并结合领域知识和经验来确定最优的类数目。

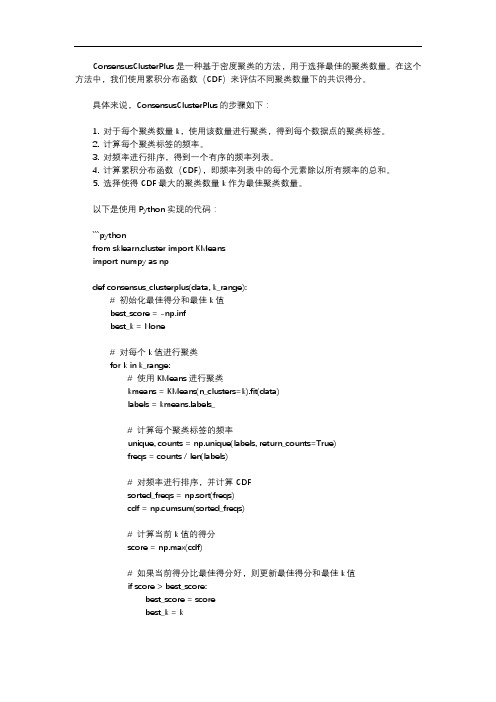

consensusclusterplus cdf 选择k数 cdf曲线的共识得分

ConsensusClusterPlus是一种基于密度聚类的方法,用于选择最佳的聚类数量。

在这个方法中,我们使用累积分布函数(CDF)来评估不同聚类数量下的共识得分。

具体来说,ConsensusClusterPlus的步骤如下:1. 对于每个聚类数量k,使用该数量进行聚类,得到每个数据点的聚类标签。

2. 计算每个聚类标签的频率。

3. 对频率进行排序,得到一个有序的频率列表。

4. 计算累积分布函数(CDF),即频率列表中的每个元素除以所有频率的总和。

5. 选择使得CDF最大的聚类数量k作为最佳聚类数量。

以下是使用Python实现的代码:```pythonfrom sklearn.cluster import KMeansimport numpy as npdef consensus_clusterplus(data, k_range):# 初始化最佳得分和最佳k值best_score = -np.infbest_k = None# 对每个k值进行聚类for k in k_range:# 使用KMeans进行聚类kmeans = KMeans(n_clusters=k).fit(data)labels = bels_# 计算每个聚类标签的频率unique, counts = np.unique(labels, return_counts=True)freqs = counts / len(labels)# 对频率进行排序,并计算CDFsorted_freqs = np.sort(freqs)cdf = np.cumsum(sorted_freqs)# 计算当前k值的得分score = np.max(cdf)# 如果当前得分比最佳得分好,则更新最佳得分和最佳k值if score > best_score:best_score = scorebest_k = kreturn best_k, best_score```在这个函数中,`data`是输入的数据,`k_range`是一个包含要尝试的聚类数量的列表。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于密度的最佳聚类数确定方法[关键字]聚类评估,聚类数,聚类有效性指标0 引言聚类是数据挖掘研究中重要的分析手段,其目的是将数据集中对象聚集成类,使得同一类中的对象是相似的,而不同类中的对象是不同的。

迄今研究者已经提出了为数众多的聚类算法,并已经在商务智能、图形分析、生物信息等领域得到了广泛应用。

作为一种非监督学习的方法,对学习得到的聚类结果进行评估是非常有必要的。

因为许多聚类算法需要用户给定数据集的聚类数量,而在实际应用中这通常是事先不知道的。

确定数据集的聚类数问题目前仍是聚类分析研究中的基础性难题之一 [1][2]。

聚类评估用于评价聚类结果的质量,这被认为是影响聚类分析成功与否的重要因素之一[3]。

它在聚类分析过程中的位置如图1所示。

聚类评估的一些重要问题包括确定数据集的聚类趋势、确定正确的类个数、将聚类分析结果与已知的客观结果比较等,本文主要研究其中的最佳聚类数的确定。

通常最佳聚类数的确定是通过以下计算过程来确定的。

在给定的数据集上,通过使用不同的输入参数(如聚类数)运行特定的聚类算法,对数据集进行不同的划分,计算每种划分的聚类有效性指标,最后比较各个指标值的大小或变化情况,符合预定条件的指标值所对应的算法参数被认为是最佳的聚类数 [4]。

迄今为止,已有各种类型的度量指标从不同角度来评估数据集划分的有效性,这些指标称为聚类有效性指标(Clustering Validation Indices)。

一般地,用于评估聚类的各方面的评估度量指标可分成以下两类[5]。

1)外部指标(External index):指聚类分析的评价函数是针对基准问题的,其簇的个数及每个数据对象的正确分类均为已知。

代表性外部指标有熵、纯度、F-measure等。

2)内部指标(Internal index):指数据集结构未知的情况下,聚类结果的评价只依靠数据集自身的特征和量值。

在这种情况下,聚类分析的度量追求两个目标:类内紧密度和类间分离度。

这也是本文的主要研究领域,代表性内部指标有DB,CH,XB,SD等。

从其他不同角度,聚类有效性指标又可分为分割指标与层次指标,模糊指标与非模糊指标,统计指标与几何指标。

用内部指标来评估聚类有效性,获取数据集最佳划分或最佳聚类数的过程一般分为以下4步[6]:第一步:给出一系列用来对数据集进行聚类的聚类算法;第二步:对于每一种聚类算法,分别使用不同的输入参数以获得不同的聚类结果;第三步:对于第二步中得到的不同聚类结果,计算其内部指标并得到相应的取值;第四步:根据内部指标所要求的规则选择最佳分割或最佳聚类数。

1 常用聚类有效性指标1.1 Davies-Bouldin 指标(DB)[7]DB指标首先计算每个类中各点与类中心的平均距离,然后以此计算每个类与其他各类的相似度,并取最大值作为该类的相似度,最后,DB指标由所有类的相似度平均得到。

容易得出,DB越小表示类与类之间的相似度越低,从而对应越佳的聚类结果。

1.2 Calinski-Harabasz指标(CH)[8]CH指标通过计算类中各点与类中心的距离平方和来度量类内的紧密度,通过计算各类中心点与数据集中心点距离平方和来度量数据集的分离度,CH指标由分离度与紧密度的比值得到。

从而,CH越大代表着类自身越紧密,类与类之间越分散,即更优的聚类结果。

1.3 Xie-Beni指标(XB)[9]XB指标使用最小的类与类中心距离平方来衡量类间分离度,使用类中各点与类中心的距离平方和来衡量类内紧密度。

XB指标也是类内紧密度与类间分离度的比值。

和CH指标一样,XB就是在类内紧密度与类间分离度之间寻找一个平衡点,使其达到最小,从而得到最优的聚类结果。

1.4 SD指标[10]SD有效性指标定义为SD指标通过计算类中对象的标准差来衡量类内紧密度,通过计算类与类之间的距离来衡量类间分离度。

其中是加权项,可以平衡类内紧密度和类间分离度之间的相对重要性,在本文中,取值为。

、分别是类与数据集的标准偏差。

2 基于密度的聚类有效性指标(Density Based Index)由于对于一个特定的聚类算法,不同的输入参数会导致不同的聚类划分。

而对某一个特定的数据集而言,只有一个划分结果是最优的。

此处的最优划分是指,相比其他划分,它和数据集原本的真实划分是最接近的。

因此,本课题研究的目标是定义一个新的聚类有效性指标,用来评估不同聚类划分的质量。

这个聚类有效性指标可以从数据集使用某一聚类算法得到的划分结果中,找出最符合真实情况的那一个划分,从而得到这一划分所需的输入参数,如聚类个数。

现有的聚类有效性指标大都是基于对象与中心之间的距离度量,使得其不能很好地捕捉类内部的对象分布情况,同时也忽略了类间的对象分布紧密程度。

由于聚类分析的目的是将数据集中对象聚集成类,使得同一类中的对象是相似的,而不同类中的对象是不同的。

从数据几何分布的角度来看,聚类将使得同一类空间里的对象分布较为密集,而类与类之间的空间对象分布较为稀疏,即可理解为同一类中对象密度比类间对象密度更大。

使用基于密度的方法来评估聚类结果的有效性,是和聚类分析的本质相符合的。

给定一个维数据集,为一个数据对象,为数据集中数据对象的个数。

一个硬划分聚类算法将划分为个子集的集合,子集称为的类。

本文中用表示数据集中心点,用表示类中心点,表示中对象个数,表示对象间距离。

定义1:类中心密度(cluster center density)类中心密度是以类中心点为中心,给定半径范围,此类中所有到类中心点距离小于等于的对象个数。

定义2:类半径(cluster radius)类半径是类中所有对象到类中心的距离的平均值。

定义3:类间中位点(medium point between clusters)类间中位点是在以两类中心的连线上的一个点,使得中位点到两类中心的距离的比值等于两类半径的比值。

如图2所示,数据集中存在类、、三个类,其中类的半径是类、的一半,则类与类的中位点到类中心距离为到类中心距离的一半,而类与类的中位点到类中心距离与到类中心距离相等。

定义4:类边缘密度(cluster boundary density)类边缘密度是以类中心点与数据集中某一类中心点的中位点(medium point)为中心,给定半径范围,与中所有到中位点距离小于等于的对象个数的均值。

在本文中,取值为。

定义5:基于密度有效性指标(Density Based Index, DBI)3 实验结果为了说明新指标DBI的效果,我们测试了DBI在各种各样的数据下的表现,现仅以较具代表性的5组来做一个说明,其中包括了3组生成数据和2组实际数据。

3组生成数据由混合高斯分布生成,而另外2组实际数据来源于UCI数据库。

这5组数据的特征如表1所示。

由于数据集Iris和Satimage的维数都大于3维,在文中无法展示其结构。

而人工数据集DS1、DS2、DS3的分布如图3所示。

从图中可以看出,DS1中存在5个分布较好的类和一些噪音,DS2中3个类之间存在着不均衡的分布,而DS3的5个类中存在着子簇群。

实验中,使用CLUTO工具对数据集进行聚类,其中数据集DS2使用了Chameleon算法,其余数据集使用了Kmeans算法。

因为DS2中存在着不均衡分布,Kmeans算法无法得到合适的聚类结果。

实验中设置最小聚类数为2,最大聚类数为9,包括了5个数据集的最佳聚类数。

各指标对5个数据集所选择的最佳聚类数如表2所示。

从实验结果可以看出,CH指标对数据集DS2选择了错误的聚类数,DB和SD在数据集DS3下没能选择正确的聚类数。

对实际数据Iris,只有新指标DBI选择了正确聚类数3,而对实际数据Satimage,所有的指标都没有选择正确的聚类数。

在这组实验中,DBI的正确率最高,为80%,而其他4个指标中,最高为XB正确率60%,其他均只有40%。

4 结论与展望现有的聚类算法通常都需要用户根据经验知识提供输入参数,如聚类数,但通常情况下这事先无法确定。

使得在实际应用中,用户对于聚类分析的结果无法进行正确的选择。

本文提出了一种新的确定最佳聚类数的有效性指标,该指标着重于分析簇的几何结构,从数据对象分布密度的角度来度量类内紧密度与类间分离度。

该指标对噪声不敏感并且可以识别数据集中的子簇群,在实际数据和合成数据上的实验结果表明,新指标的性能优于广泛使用的其他指标,对于聚类分析的实际应用提供了一定的参考。

参考文献[1] 陈黎飞,姜青山,王声瑞,基于层次划分的最佳聚类数确定方法,软件学报,(19):1, 2008, pp.62-72.[2] 杨燕,靳蕃,K. Mohamed,聚类有效性评价综述,计算机应用研究,(25):6, 2008, pp.1630-1632.[3]A. K. Jain and R. C. Dubes, Algorithms for clustering data. Upper Saddle River, NJ, USA: Prentice-Hall, Inc., 1988.[4] 杨善林,李永森,胡笑旋,等,K-means算法中的k值优化问题研究,系统工程理论与实践,2006(2):97-101.[5] P.N. Tan, M. Steinbach, and V. Kumar, Introduction to Data Mining. USA: Addison-Wesley Longman, Inc., 2005.[6] 周世兵,徐振源,唐旭清,新的K-均值算法最佳聚类数确定方法,计算机工程与应用,46(16), 2010, pp.27-31.[7] D. Davies and D. Bouldin, “A cluster separation measure,” IEEE PAMI, vol. 1, no. 2, pp. 224–227, 1979.[8] T. Calinski and J. Harabasz, “A dendrite method for cluster analysis,” Comm. in Statistics, vol. 3, no. 1, pp. 1–27, 1974.[9] X. L. Xie and G. Beni, “A validity measure for fuzzy clustering,” IEEE PAMI, vol. 13, no. 8, pp. 841–847, 1991.[10] M. Halkidi, M. Vazirgiannis, and Y. Batistakis, “Quality scheme assessment in the clusteri ng process,” in PKDD, London, UK, 2000, pp. 265–276作者简介刘燕驰,男,江西吉安人,博士研究生,主要研究方向:数据挖掘,智能数据分析。