实用最优化算法及其应用--Homework2

正则化和最优化算法

正则化和最优化算法正则化和最优化算法是机器学习中常用的两个概念,它们在模型训练和优化过程中起着重要的作用。

本文将介绍正则化和最优化算法的概念、原理以及在机器学习中的应用。

一、正则化正则化是为了防止模型过拟合而引入的一种方法。

在机器学习中,我们通常会遇到两种情况:欠拟合和过拟合。

欠拟合指的是模型无法很好地拟合训练数据,而过拟合则是指模型过于复杂,过度拟合了训练数据,导致在新数据上表现不佳。

为了解决过拟合问题,我们可以通过正则化来限制模型的复杂度。

常用的正则化方法有L1正则化和L2正则化。

L1正则化通过在损失函数中增加L1范数的惩罚项,使得模型的权重向量趋向于稀疏,即某些权重变为0,从而达到特征选择的效果。

L2正则化则是在损失函数中增加L2范数的惩罚项,使得模型的权重向量变得更小,从而减小模型的复杂度。

正则化可以有效地减少模型的过拟合程度,提高模型的泛化能力。

二、最优化算法最优化算法是为了求解最优化问题而设计的一类算法。

在机器学习中,我们通常需要通过优化算法来求解模型的参数,使得模型在训练数据上的损失函数最小化。

最优化算法的目标是找到使得损失函数取得最小值的参数。

常用的最优化算法有梯度下降法和牛顿法。

梯度下降法是一种迭代算法,通过计算损失函数对参数的梯度,并沿着梯度的反方向更新参数,以此来逐步减小损失函数的值。

梯度下降法的优点是简单易实现,但可能会陷入局部最优解。

牛顿法是一种基于二阶导数信息的优化算法,它通过计算损失函数的一阶导数和二阶导数来更新参数,具有更快的收敛速度,但计算复杂度较高。

三、正则化和最优化算法的应用正则化和最优化算法在机器学习中有广泛的应用。

在回归问题中,通过正则化可以控制模型的复杂度,避免过拟合。

在分类问题中,正则化可以提高模型的泛化能力,减小分类错误率。

在神经网络中,正则化可以通过限制权重的大小来防止过拟合。

最优化算法则用于求解模型的参数,使得模型在训练数据上的损失函数最小化。

最优化方法及其应用

最优化方法及其应用最优化方法可以分为无约束优化和约束优化两种情况。

无约束优化是指在没有任何限制条件下,通过优化算法寻找函数的最小值或最大值。

约束优化则是在一定的约束条件下,寻找函数的最优解。

无约束优化问题可以通过求导数或者对函数进行逼近来解决,而约束优化问题往往需要使用更为复杂的方法,如拉格朗日乘数法、内点法等。

最优化方法在工程领域中有着广泛的应用。

例如在电力系统中,需要优化电力分配,以确保电力的高效利用和供应的稳定性。

另外,在机器学习算法中,最优化方法被用于调整模型参数,以提高模型的预测能力。

最优化方法还被广泛应用于交通流优化、资源分配、供应链管理等各种工程问题中。

经济学中的优化方法可以帮助决策者在有限资源下做出最佳的决策。

例如,在企业决策中,需要通过优化方法确定生产数量和价格,以实现最大的利润。

此外,最优化方法还可以帮助经济学家解决资源配置、市场设计等问题。

最优化方法在运筹学中也有着重要的应用。

运筹学是一门研究如何有效利用有限资源的学科,最优化方法在其中发挥着重要的作用。

例如,在物流领域中,需要通过最优化方法确定最短路径和最佳资源分配,以提高物流运输的效率。

此外,最优化方法还可以应用于排产调度、库存管理等问题中。

最优化方法的常见算法主要有梯度下降法、牛顿法、拟牛顿法等。

梯度下降法是一种迭代优化算法,通过不断迭代更新参数值,直至达到最优解。

牛顿法基于函数的泰勒展开式,通过求解线性方程组来逼近最优解。

拟牛顿法则是对牛顿法的改进,通过近似求解Hessian矩阵,减少计算量。

除了传统的最优化方法,近年来深度学习的兴起也为最优化方法带来了新的挑战和应用。

深度学习网络中的参数优化也可以看作是一种最优化问题,通过梯度下降法或其他优化方法来调整参数值,以降低模型在训练数据上的误差。

随着深度学习的发展,越来越多的变种最优化算法被提出和应用于不同的深度学习架构中。

总结来说,最优化方法是一种解决最优化问题的强大工具,可以应用于各个领域中的决策问题。

最优化算法分析及应用

最优化算法分析及应用最优化算法是一类用于求解最优问题的数学模型和算法。

最优问题是指在一定约束条件下,寻求使得目标函数取得最大或者最小值的问题。

最优化算法包括解析法和数值法两种方法。

解析法是通过对目标函数进行数学分析,利用导数、求极限等数学工具,从而找到最优解的一类算法。

其中最常用的方法是求解目标函数的一阶或者二阶偏导数,通过解方程求得目标函数的稳定点或是极值点,从而得到最优解。

解析法的优点是可以得到精确的最优解,其中最著名的算法是拉格朗日乘数法、KKT条件和牛顿法等。

这些方法在多种领域有着广泛的应用,比如经济学中的效用函数最大化问题、工程学中的最优设计问题等。

数值法是通过迭代计算的方式逼近最优解的一类算法。

与解析法不同,数值法不需要对目标函数进行精确的数学分析,而是通过给定初始点,通过一定规则进行迭代计算,从而逐步逼近最优解。

数值法的优点是可以处理复杂的非线性问题,也可以应用于高维问题或者没有解析解的问题。

常用的数值法有梯度下降法、共轭梯度法、模拟退火算法等等。

这些方法在机器学习、数据挖掘、图像处理等领域都有广泛的应用,比如利用梯度下降法进行参数优化,利用模拟退火算法求解旅行商问题等。

最优化算法在现实生活中有很多应用。

在工程领域,最优化算法被广泛应用于优化设计问题,比如在汽车工业中,通过最优化算法可以实现车辆的轻量化设计,从而降低燃料消耗和排放。

在物流领域,最优化算法可以帮助货物合理分配,提高物流效率,降低物流成本。

在电力系统中,最优化算法可以用于电力调度问题,从而实时调整发电机组的出力,保证电网的供需平衡。

在经济学中,最优化算法可以用来解决资源配置和决策问题,比如最大化收益、最小化成本等。

此外,最优化算法还可以应用于交通流量优化、医疗资源优化、网络传输优化等各个领域。

通过合理选择和应用最优化算法,可以提高效率,降低成本,优化资源配置,从而实现经济可持续发展和社会效益最大化。

总而言之,最优化算法是一类用于求解最优问题的数学模型和算法。

实用最优化方法第三版课程设计

实用最优化方法第三版课程设计一、引言随着数值计算技术和计算机硬件设施的快速发展,最优化方法在科学、工程和经济领域中得到了广泛应用。

实用最优化方法是一门交叉学科,涉及数学、计算机科学、应用统计学、运筹学、工业工程等多个领域。

本课程将介绍最优化方法的基本概念、数学理论和相关算法,以及它们在实际问题中的应用。

二、课程目标本课程旨在使学生掌握最优化方法的基本概念和理论,并能熟练应用各种最优化算法解决实际问题。

具体目标如下:1.理解最优化问题的定义、形式和分类;2.掌握最优化模型的建立方法和求解技巧;3.熟悉常用最优化算法的原理、优缺点和适用范围;4.能够使用软件工具解决实际的最优化问题;5.培养学生的科学素养和实际操作能力。

三、课程大纲第一章最优化问题的基本概念1.1 优化问题的定义与分类 1.2 最优解的存在与唯一性 1.3 凸优化问题的性质和解法 1.4 梯度下降法、牛顿法和拟牛顿法第二章线性规划2.1 线性规划问题的标准型 2.2 单纯形法和对偶理论 2.3 整数规划和混合整数规划第三章非线性规划3.1 非线性规划问题的形式化描述 3.2 无约束优化问题的解法3.3 约束优化问题的解法 3.4 全局优化问题的解法第四章非线性方程组和方程求解4.1 非线性方程组的求解方法 4.2 无约束最小化问题的求解及其应用 4.3 连续和离散函数最优化的重要应用第五章数值优化软件5.1 Matlab的优化工具箱 5.2 R语言的优化软件 5.3 Python的Scipy优化库第六章应用案例分析6.1 供应链优化 6.2 生产计划与排产 6.3 飞机航线优化 6.4 基于机器学习的最优化四、教学方法和评估方式本课程采用课堂讲授和实验练习相结合的教学方法,教师会提供许多实际问题和案例,学生可以在课后按照教材和指导文件完成实验练习。

评估方式主要包括平时成绩、实验成绩和期末考试成绩。

其中平时成绩包括作业成绩、上课表现及课堂积极性等方面。

USC算法导论作业2

Problem 1 (4.3-2): The recurrence T (n) = 7T (n/2) + n2 describes the running time of an algorithm A. A competing algorithm A has a running time of T (n) = aT (n/4) + n2 . What is the largest integer value for a such that A is asymptotically faster than A? Solution 1: By the master theorem, the worst-case asymptotic complexity of A is Θ(nlg 7 ) ≈ Θ(n2.80735 ), and the worst-case asymptotic complexity of A is Θ(nlog4 a ), if a > 16. For A to be asymptotically faster than A, log4 a < lg 7 = log4 49. Therefore, the largest integer value for a such that A is asymptotically faster than A is 48. Problem 2 (Derived from 4-1 and 4-4): Give asymptotic upper and lower bounds for T (n) in each of the following recurrences. Make your bounds as tight as possible, and justify your answers. a. T (n) = 2T (n/2) + n3 . b. T (n) = 16T (n/4) + n2 . c. T (n) = 7T (n/3) + n2 . d. T (n) = 7T (n/2) + n2 . √ e. T (n) = 2T (n/4) + n. f. T (n) = 3T (n/2) + n lg n. √ g. T (n) = 4T (n/2) + n2 n. h. T (n) = T (9n/10) + n. Solution 2: Use the master method to solve these recurrences. a. Case 3 of master theorem. T (n) = Θ(n3 ). b. Case 2 of master theorem. T (n) = Θ(n2 lg n). c. Case 3 of master theorem. T (n) = Θ(n2 ). d. Case 1 of master theorem. T (n) = Θ(nlg 7 ). √ e. Case 2 of master theorem. T (n) = Θ( n lg n). f. Case 1 of master theorem. T (n) = Θ(nlg 3 ). √ g. Case 3 of master theorem. T (n) = Θ(n2 n). h. Case 3 of master theorem. T (n) = Θ(n). Problem 3 (Derived from 4-1 and 4-4): Give asymptotic upper and lower bounds for T (n) in each of the following recurrences. Make your bounds as tight as possible, and justify your answers. You may assume that T (1) is a constant. a. T (n) = T (n − 1) + n.

最优化方法及其应用要点

最优化方法及其应用要点

一、贝叶斯优化算法

贝叶斯优化算法是一种基于贝叶斯统计学理论的机器学习算法,是一

种基于概率的优化方法。

贝叶斯优化算法通过有效地表征目标函数的平均

性质来自动调节空间,这样可以有效的从多个最优解中选择最佳的最优解。

贝叶斯优化算法可以用来优化复杂的决策问题,如机器学习模型的参

数优化,机器视觉模型参数优化,机器人控制任务参数优化,机器学习的

特征选择,语音识别系统的参数优化,预测算法的参数优化。

贝叶斯优化算法的应用要点是以下几点。

1.首先,贝叶斯优化算法是一种基于目标函数的优化方法,因此需要

首先定义一个目标函数,也就是一个要优化的目标函数,以最小化或最大

化其中一个函数的值。

2.其次,贝叶斯优化算法是一种贝叶斯统计学理论的方法,它使用贝

叶斯置信分布(Bayesian Confidence Distribution)来表征目标函数的

平均性质,从而自动调节空间。

3.此外,贝叶斯优化算法需要定义一系列模型参数,这些参数决定了

的范围和方向,可以用来控制优化的步伐和步长,以达到更好的优化结果。

4.最后,贝叶斯优化算法需要定义一个优化方法,这个方法用于根据

当前的置信分布,使用参数估计算法。

最优化算法及其应用

最优化算法及其应用最优化算法是一种通过优化目标函数来寻找最佳结果的方法,被广泛应用于各种领域的问题求解中。

在工业、经济、数学和计算机科学等领域,最优化算法都扮演着重要的角色,其研究和应用不断推动着这些领域的发展进程。

一、最优化算法的分类在实际问题中,存在很多种不同类型的问题,同时也存在多种不同的最优化算法。

这些算法可以按照其搜索方式和优化目标的性质来分类。

常见的分类方法包括:1. 单目标优化算法 vs 多目标优化算法单目标优化算法被设计用于处理只有一个优化目标函数的问题,其目标是使这个函数的取值达到最大或最小。

而多目标优化算法则尝试在同时优化多个目标时寻找到最优解。

2. 梯度型算法 vs 非梯度型算法梯度型算法依赖于目标函数的梯度信息,通过计算梯度来决定要更改哪些参数以最小化或最大化目标函数的值。

而非梯度型算法则是无需计算梯度的方法,采用其他的搜索策略去寻找最优解。

3. 局部搜索算法 vs 全局搜索算法局部搜索算法着眼于在一个已知的搜索空间中寻找最大或最小的局部优化解,而全局搜索算法则尝试在整个搜索空间范围内找到全局最优解。

4. 硬性约束 vs 软性约束硬性约束指那些限制条件会导致一个解被完全排除的情况,而软性约束则是指那些只会引入一定程度的不便或者代价,但并不会严重影响解决方案的情况。

对于涉及约束条件的问题,最优化算法需要考虑如何处理这些约束条件。

二、最优化算法的应用最优化算法在各种实际问题中都有着广泛的应用。

以下是一些典型的应用场景:1. 工程应用最优化算法在工程优化设计中扮演着至关重要的角色,可以用来优化各种工程系统的设计和维护。

例如,可以利用最优化算法来确定一个复杂机械装置的尺寸、材料及配制,以最小化能源消耗或者最大化生产效率。

2. 金融应用在金融领域,最优化算法可以用于根据历史数据对股票、期权和其他金融资产的价格进行建模。

通过对复杂的财务数据进行分析,最优化算法可以帮助金融机构做出更好的风险决策,从而更好地保护资产。

组合优化的算法及应用

组合优化的算法及应用组合优化是指在一定条件下,寻找最优解的过程。

这种最优化过程往往涉及到很多方面,如经济、物流、资源分配等问题。

在这些问题中,需要找出最佳的、最优化的解决方法,以达到最大化收益或利益的目的。

在组合优化的问题中,我们往往需要通过特定的算法来解决问题。

今天,我们将重点介绍一些常用的组合优化算法及其应用。

这些算法包括贪心算法、回溯算法、动态规划、分支定界、遗传算法等。

下面,我们将逐一深入地讨论它们的原理和应用。

1. 贪心算法贪心算法是一种简单,高效的求解最优化问题的方法,这种算法在针对某些问题时能够提供最优解,但并不保证在所有情况下都能实现最优化。

贪心算法是建立在优化子结构性质的基础上的。

具有这种特性的问题的最优解可以通过一些局部的最优决策来达到,而这些最优决策的组合是达到最终最优解的必要条件。

贪心算法的应用十分广泛,例如贪心算法可以用于动态规划的预处理过程中,也可以用于另一个组合优化算法——分支定界中的剪枝。

2. 回溯算法回溯算法是一种试错的算法,可以解决诸如组合优化问题的一些计算问题。

在回溯过程中需要遵守很多约束条件,当然约束条件在不同问题中不尽相同。

在回溯算法的运行过程中,可能会多次出现重复计算的情况,因此,将动态的记录每个元素的状态是一个可行的方案。

回溯算法是N皇后问题的一种常见解法,也是很多非确定算法的重要组成部分。

3. 动态规划动态规划是一种常见的组合优化算法,常常用于解决最优化问题。

这种算法需求满足一些特定的条件,比如具有重叠子问题性质和无后效性。

如若满足这些条件,动态规划算法能够得出最优解。

动态规划的应用场景极广,例如: 背包问题、最长公共子序列问题、最大子段和问题、最短路径问题、最优搜索二叉树问题等。

4. 分支定界分支定界算法是一种求解离散数学问题的有效算法,和回溯算法有很多无法分割的相似之处。

分支定界算法在许多情况下被用来解决最优化问题。

在这种算法中,设定一个上下界,然后不停地进行二分查找以及例行 subtractive processing 的过程,以取得更好的优化结果,并将问题进一步细化。

哈工大人工智能原理习题homework-2

人工智能原理 练习题-2从习题中选择自己感兴趣的题目进行思考和解答,任何尝试都是有益的。

必要时,仔细阅读教科书当中的某些章节。

对于加星号的习题,应该编写程序来完成。

第3章 逻辑与推理1 对于下列每对原子语句,请给出最一般合一者,如果存在的话:a. (,,),(,,)P A B B P x y zb. (,(,)),((,),)Q y G A B Q G x y yc. ((),),((),)Older Father y y Older Father x Johnd. ((),),(,)Knows Father y y Knows x x2 写出下列语句的逻辑表示,使得它们适合应用一般化分离规则:a. 马、奶牛和猪都是哺乳动物。

b. 一匹马的后代是马。

c. Bluebeard 是一匹马。

d. Bluebeard 是Charlie 的父亲。

e. 后代和双亲是逆关系。

f. 每个哺乳动物都有一个双亲。

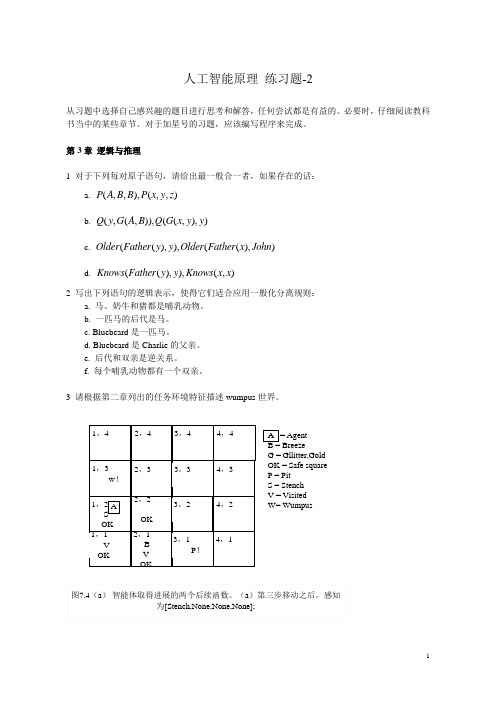

3 请根据第二章列出的任务环境特征描述wumpus 世界。

1,42,43,44,41,3 w !2,33,34,31,2 S OK 2,2OK3,24,21,1 V OK 2,1B V OK3,1 P !4,1A图7.4(a ) 智能体取得进展的两个后续函数。

(a )第三步移动之后,感知为[Stench,None,None,None];A = AgentB = BreezeG = Gllitter,GoldOK = Safe squareP = PitS = StenchV = Visited W= WumpusA4 假定智能体已经前进到图7.4(a)(如上图)所示的位置,感知到的情况为:[1,1]什么也没有,[2,1]有微风,[1,2]有臭气。

它现在想知道[1,3]、[2,2]和[3,1]的情况。

这3个位置中的每一个都可能包含陷阱,而最多只有一个可能有wumpus。

按照图7.5的实例,构造出可能世界的集合。

最优化方法及其应用课后答案(郭科_陈聆_魏友华)

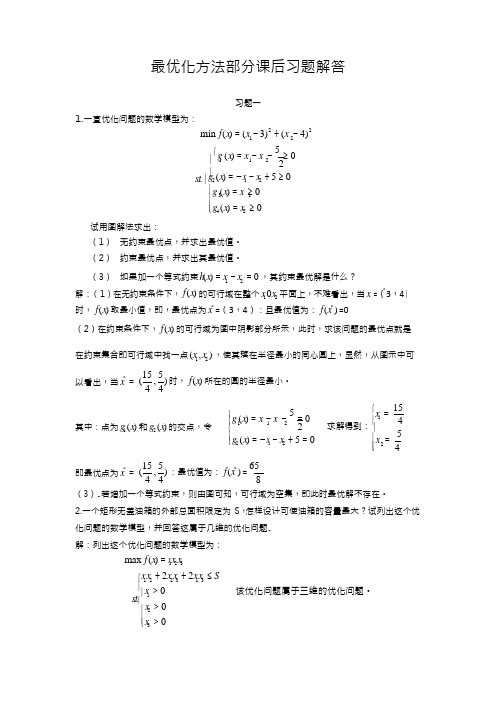

1 2((⎨最优化方法部分课后习题解答1.一直优化问题的数学模型为:习题一min f (x ) = (x − 3)2 + (x − 4)2⎧g (x ) = x − x − 5 ≥ 0 ⎪ 11 2 2 ⎪试用图解法求出:s .t . ⎨g 2 (x ) = −x 1 − x 2 + 5 ≥ 0 ⎪g (x ) = x ≥ 0 ⎪ 3 1 ⎪⎩g 4 (x ) = x 2 ≥ 0(1) 无约束最优点,并求出最优值。

(2) 约束最优点,并求出其最优值。

(3) 如果加一个等式约束 h (x ) = x 1 −x 2 = 0 ,其约束最优解是什么? *解 :(1)在无约束条件下, f (x ) 的可行域在整个 x 1 0x 2 平面上,不难看出,当 x =(3,4) 时, f (x ) 取最小值,即,最优点为 x * =(3,4):且最优值为: f (x * ) =0(2)在约束条件下, f (x ) 的可行域为图中阴影部分所示,此时,求该问题的最优点就是在约束集合即可行域中找一点 (x 1 ,x 2 ) ,使其落在半径最小的同心圆上,显然,从图示中可以看出,当 x *=15 , 5) 时, f (x ) 所在的圆的半径最小。

4 4⎧g (x ) = x − x − 5 = 0⎧ 15 ⎪x 1 = 其中:点为 g 1 (x) 和 g 2 (x ) 的交点,令 ⎪ 1 1 2⎨ 2 求解得到: ⎨ 4 5即最优点为 x *= ⎪⎩g 2 (x ) = −x 1 − x 2 + 5 = 015 , 5 ) :最优值为: f (x * ) = 65⎪x = ⎪⎩ 244 4 8(3).若增加一个等式约束,则由图可知,可行域为空集,即此时最优解不存在。

2.一个矩形无盖油箱的外部总面积限定为 S ,怎样设计可使油箱的容量最大?试列出这个优 化问题的数学模型,并回答这属于几维的优化问题. 解:列出这个优化问题的数学模型为:max f (x ) = x 1x 2 x 3⎧x 1x 2 + 2x 2 x 3 + 2x 1x 3 ≤ S ⎪ s .t . ⎪x 1 > 0 ⎪x 2 > 0 ⎪⎩x 3 > 0该优化问题属于三维的优化问题。

迭代方法和最优化算法及其应用

迭代方法和最优化算法及其应用概述迭代方法和最优化算法是当代数学和计算机科学领域中非常重要的研究方向。

它们被广泛应用于各种实际问题的求解中,比如物理、金融、工程、医学、社会科学等领域。

本文将讨论迭代方法和最优化算法的基本概念、性质和应用,并以实际案例为例,说明它们在现实生活中的重要性和实用价值。

迭代方法迭代方法是一种基于递推公式或迭代框架的数值计算方法。

它的基本思想是利用已知结果来推导新的结果,并不断逼近最终解。

常见的迭代方法有牛顿迭代法、Jacobi迭代法、Gauss-Seidel迭代法、共轭梯度法、Krylov子空间方法等。

以牛顿迭代法为例,其递推公式为:$x_{k+1}=x_k-\frac{f(x_k)}{f'(x_k)}$其中,$x_k$是第k次迭代得到的近似解,$f(x)$和$f'(x)$分别是函数f(x)及其导数。

牛顿迭代法的主要优点是收敛速度较快,但也有不足之处,如迭代路径不一定收敛、局部最优解的存在、计算导数的困难性等。

最优化算法最优化算法是一种通过数学优化模型来求解优化问题的方法。

它的基本思想是通过优化目标函数来找到最优解,其中目标函数可以是线性的或非线性的,并且通常还要满足一定的限制条件。

最优化算法的常见分类有线性规划、整数规划、非线性规划、凸优化、半定规划等等。

其中最常用的最优化算法之一是梯度下降法,其主要思想是朝着当前位置负梯度方向走一步,来不断逼近最小值。

应用实例迭代方法和最优化算法被广泛应用于现实生活中各种领域的问题求解中。

以金融领域为例,投资组合优化是一个经典的优化问题,目的是在给定的风险和收益目标下,找到最优的投资组合。

这个问题可以通过构建数学模型来求解,其中一个应用广泛且高效的方法是基于最优化算法的组合优化模型。

另一方面,迭代方法和最优化算法在医学中也有广泛应用。

例如,在医学影像重建中,迭代算法可以用于改善低剂量CT图像的清晰度,从而帮助医生更准确地诊断病情。

实用最优化算法及其应用--读书材料

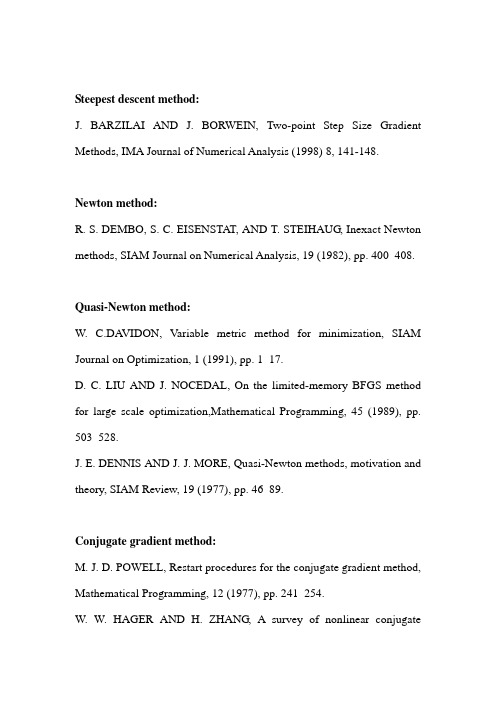

Steepest descent method:J. BARZILAI AND J. BORWEIN, Two-point Step Size Gradient Methods, IMA Journal of Numerical Analysis (1998) 8, 141-148.Newton method:R. S. DEMBO, S. C. EISENSTAT, AND T. STEIHAUG, Inexact Newton methods, SIAM Journal on Numerical Analysis, 19 (1982), pp. 400–408.Quasi-Newton method:W. C.DA VIDON, Variable metric method for minimization, SIAM Journal on Optimization, 1 (1991), pp. 1–17.D. C. LIU AND J. NOCEDAL, On the limited-memory BFGS method for large scale optimization,Mathematical Programming, 45 (1989), pp. 503–528.J. E. DENNIS AND J. J. MORE, Quasi-Newton methods, motivation and theory, SIAM Review, 19 (1977), pp. 46–89.Conjugate gradient method:M. J. D. POWELL, Restart procedures for the conjugate gradient method, Mathematical Programming, 12 (1977), pp. 241–254.W. W. HAGER AND H. ZHANG, A survey of nonlinear conjugategradient methods, Pacific Journal of Optimization, 2005.Trust region method:R. H. BYRD, R. B. SCHNABEL, AND G. A. SCHULTZ, Approximate solution of the trust regions problem by minimization over two-dimensional subspaces, Mathematical Programming, 40 (1988),pp. 247–263.Y. YUAN, On the truncated conjugate-gradient method, Mathematical Programming, Series A, 87 (2000), pp. 561–573.J. J.MORE ANDD. C. SORENSEN, Computing a trust region step, SIAM Journal on Scientific and Statistical Computing, 4(1983), pp. 553–572.R. H. BYRD, H. F. KHALFAN, AND R. B. SCHNABEL, Analysis of a symmetric rank-one trust region method, SIAM Journal on Optimization, 6 (1996), pp. 1025–1039.Optimality theory:R. T. ROCKAFELLAR, Lagrange multipliers and optimality, SIAM Review, 35 (1993), pp. 183–238.Methods for constrained optimization:R. FLETCHER AND S. LEYFFER, Nonlinear programming without apenalty function, Mathematical Programming, Series A, 91 (2002), pp. 239–269.A. FORSGREN, P. E. GILL, AND M. H.WRIGHT, Interior methods for nonlinear optimization, SIAM Review, 44 (2003), pp. 525–597.Software related:C. ZHU, R. H. BYRD, P. LU, AND J. NOCEDAL, Algorithm 778: L-BFGS-B, FORTRAN subroutines for large scale bound constrained optimization, ACM Transactions on Mathematical Software, 23 (1997), pp. 550–560.E. M. GERTZ AND S. J. WRIGHT, Object-oriented software for quadratic programming, ACM Transactions on Mathematical Software, 29 (2003), pp. 58–81.Y. ZHANG, Solving large-scale linear programs with interior-point methods under the Matlab environment, Optimization Methods and Software, 10 (1998), pp. 1–31.A.WACHTER AND L. T. BIEGLER, On the implementation of an interior-point filter line-search algorithm for large-scale nonlinear programming, Mathematical Programming, 106 (2006), pp. 25–57.A. R.CONN, N. I.M. GOULD, AND P. L. TOINT, LANCELOT: a FORTRAN package for large-scale nonlinear optimization (Release A), no. 17 in Springer Series in Computational Mathematics, Springer-Verlag,New York, 1992.P. E. GILL, W. MURRAY, AND M. A. SAUNDERS, SNOPT: An SQP algorithm for large-scale constrained optimization, SIAM Journal on Optimization, 12 (2002), pp. 979–1006.。

最优化算法的研究与应用

最优化算法的研究与应用随着现代科学技术的不断发展,最优化算法在各个领域得到了广泛应用。

而什么是最优化算法?简单地说,它就是一种数学方法或计算过程,用于求解某种特定问题中最优的解。

最优化算法可以应用于众多领域,例如经济学、工程学、运筹学等。

在这些领域中,人们一直在探索如何利用最优化算法来解决问题。

下面将从三个方面探讨最优化算法的研究与应用。

一、传统最优化算法传统最优化算法是指基于一定前提条件的、使用特定的数学方法来解决最优化问题的算法。

例如最小二乘法、线性规划等。

这些算法在很多领域都有广泛应用,如经济学的成本最小化、机器学习的回归分析等。

其中,最小二乘法是处理线性回归问题的一种有效方法,它使用最小平方和原则来确定模型的参数。

而线性规划则是一种盲目搜索技术,用于确定一个线性函数的最优值。

传统最优化算法虽然应用广泛,但其应用场景受限,较难适用于复杂问题的求解。

二、优化算法的发展优化算法是一种基于自适应、迭代式求解策略的算法,它通过多次迭代来寻找函数的最优解。

例如遗传算法、模拟退火算法等。

遗传算法是一种模拟自然选择和进化的求解最优问题的方法。

它使用选择、交叉和变异操作,并将每个个体与其他个体进行比较,最终选出最优个体。

而模拟退火算法则是一种基于随机漫步的优化技术,它在搜索空间中随机移动,并以一定的概率接受劣解,从而避免陷入局部最优解。

众多优化算法的发展,为各种复杂问题的解决提供了新的思路和方法。

其中,粒子群算法、蚁群算法、人工免疫算法等都是比较典型的优化算法。

三、最优化算法在实际应用中的优势最优化算法在实际应用中有很多优势。

首先,它能够帮助人们节省大量的时间和人力成本,提高解决问题的效率。

其次,最优化算法可以针对不同的问题进行优化,满足各种需求。

例如,在工程学中,最优化算法可以用于设计中的参数优化,帮助设计师优化某个问题的多个因素。

在金融学中,最优化算法可以用于投资策略的优化,帮助投资人在不同的投资时间、风险和回报之间进行权衡。

最优化方法及其应用课后答案

最优化方法及其应用课后答案1. 最优化方法的分类包括哪些方面?最优化方法可分为三类:数学规划、非数学规划和元启发式方法。

2. 线性规划的标准形式是什么?线性规划的标准形式为:max cTxsubject toAx ≤ bx ≥ 0其中,cTx表示优化目标,Ax≤b表示约束条件,x≥0表示非负约束条件。

3. 拉格朗日乘数法是如何解决带有等式约束的优化问题的?拉格朗日乘数法是通过构建拉格朗日函数来解决带有等式约束的优化问题的。

具体地,拉格朗日函数L(x,λ)定义为:L(x,λ)=f(x)+λTh(x)其中,f(x)是优化目标函数,h(x)是等式约束函数,λ是拉格朗日乘数。

然后,通过求解L(x,λ)的梯度和等于0的条件,得到原问题的解。

4. 什么是梯度下降法?梯度下降法是一种迭代求解方法,用于优化无约束的多次可微函数。

该方法通过向负梯度方向下降来逐步逼近优化目标的最小值。

具体地,梯度下降法的迭代公式为:x(k+1)=x(k)-αk∇f(x(k))其中,x(k)是第k次迭代后的解,αk是步长,∇f(x(k))表示f(x(k))的梯度。

5. 遗传算法是如何实现优化的?遗传算法是一种元启发式方法,它基于模拟生物进化过程来实现优化。

算法先随机生成一组初始的个体,然后对这些个体进行遗传操作(交叉、变异),以产生新的个体,并按照适应度函数的大小保留一部分个体,舍弃一部分个体。

通过多次迭代,逐步优化得到最优解。

6. 模拟退火算法的基本思想是什么?模拟退火算法是一种元启发式方法,它基于物理中的退火现象进行优化。

算法维护一个当前解,然后随机生成一个新的解,并计算当前解到新解的能量差。

如果新解比当前解更优,则直接接受它。

若不是,则以一定概率接受新解,并降低概率参数T,然后继续下一步迭代。

通过多次迭代,逐步优化得到最优解。

7. 最大熵模型的基本原理是什么?最大熵模型是一种概率模型,它通过最大化经验熵与先验熵之和来实现分类或回归问题的优化。

常用优化计算方法

常用优化计算方法

计算是现代科学和技术发展的基础,而优化计算方法则是提高计算效率和精度的关键。

优化计算方法可以应用于各个领域,包括工程、经济、医学等等。

本文将介绍几种常用的优化计算方法,包括贪婪算法、遗传算法、模拟退火算法和粒子群算法。

贪婪算法是一种简单而有效的优化方法。

它通过每次选择当前最优解来逐步构建整体最优解。

贪婪算法的优势在于其高效性和易于实现,但也存在局限性,可能无法得到整体最优解。

遗传算法是一种模拟生物进化过程的优化计算方法。

遗传算法通过模拟自然选择、交叉和变异等过程,逐步优化解的质量。

遗传算法具有较强的全局搜索能力,但对问题的建模和参数的选择要求较高。

第三,模拟退火算法是一种基于物理退火过程的优化方法。

模拟退火算法通过模拟固体物质退火时的温度变化,使解能够从局部最优逃脱并逐步趋于全局最优。

模拟退火算法可以灵活地调整搜索策略,但需要合理设置退火参数。

粒子群算法是一种模拟鸟群觅食行为的优化计算方法。

粒子群算法通过模拟粒子在解空间中的搜索和交流行为,逐步优化解的质量。

粒子群算法具有较强的全局搜索能力和较快的收敛速度,但对问题的建模和参数的选择也有一定要求。

贪婪算法、遗传算法、模拟退火算法和粒子群算法是常用的优化计算方法。

它们各自具有特点和适用范围,可以根据问题的性质选择合适的方法。

在实际应用中,还可以结合多种优化计算方法,以进一步提高计算效率和精度。

不同的方法有不同的适用场景,研究者和工程师可以根据具体问题的特点选择合适的方法。

通过不断优化计算方法,我们将能够更好地解决实际问题,推动科学技术的发展。

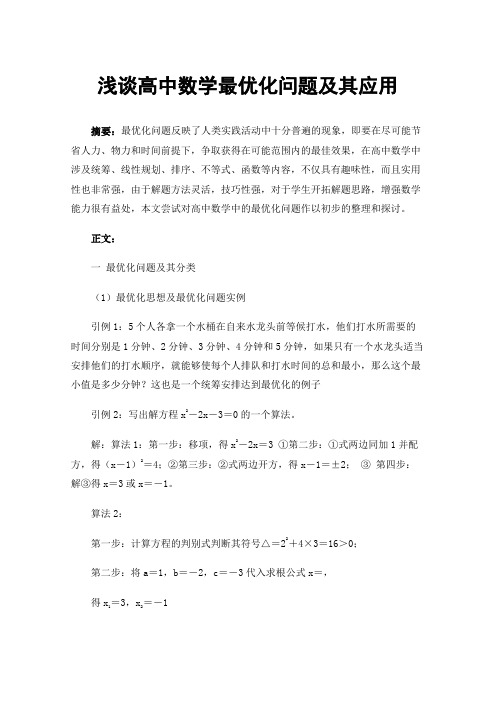

浅谈高中数学最优化问题及其应用

浅谈高中数学最优化问题及其应用摘要:最优化问题反映了人类实践活动中十分普遍的现象,即要在尽可能节省人力、物力和时间前提下,争取获得在可能范围内的最佳效果,在高中数学中涉及统筹、线性规划、排序、不等式、函数等内容,不仅具有趣味性,而且实用性也非常强,由于解题方法灵活,技巧性强,对于学生开拓解题思路,增强数学能力很有益处,本文尝试对高中数学中的最优化问题作以初步的整理和探讨。

正文:一最优化问题及其分类(1)最优化思想及最优化问题实例引例1:5个人各拿一个水桶在自来水龙头前等候打水,他们打水所需要的时间分别是1分钟、2分钟、3分钟、4分钟和5分钟,如果只有一个水龙头适当安排他们的打水顺序,就能够使每个人排队和打水时间的总和最小,那么这个最小值是多少分钟?这也是一个统筹安排达到最优化的例子引例2:写出解方程x2-2x-3=0的一个算法。

解:算法1:第一步:移项,得x2-2x=3 ①第二步:①式两边同加1并配方,得(x-1)2=4;②第三步:②式两边开方,得x-1=±2;③ 第四步:解③得x=3或x=-1。

算法2:第一步:计算方程的判别式判断其符号△=22+4×3=16>0;第二步:将a=1,b=-2,c=-3代入求根公式x=,得x1=3,x2=-1评析:比较两种算法,算法2更简单,步骤少,所以利用公式解决问题是最理想、合算的算法,达到了优化算法的目的。

像以上例子中所述的问题都属于最优化问题:即要在尽可能节省人力、物力和时间前提下,利用数学中的线性规划及函数,算法等争取获得在可能范围内的最佳效果。

(2)高中数学中常见的最优化问题:线性规划、算法的最优化,利用图解法求解函数的最佳、简便运算二最优化问题应用举例例1: 用10尺长的竹竿来截取3尺、4尺长的甲、乙两种短竹竿各100根,至少要用去原材料几根?怎样截法最合算?[分析与解] 一个10尺长的竹竿应有三种截法:(1) 3尺两根和4尺一根,最省;(2) 3尺三根,余一尺;(3) 4尺两根,余2尺。

编程技巧:优化算法实战指南

编程技巧:优化算法实战指南引言编程是一门艺术,而优化算法则是一种技巧。

无论是初学者还是有经验的程序员,掌握优化算法都是提高代码性能和效率的关键。

本文将为你提供一份实战指南,介绍一些常用的算法优化技巧,帮助你更好地理解和应用它们。

什么是算法优化在开始之前,我们先来了解一下算法优化的概念。

算法优化是指通过改进算法的设计和实现,以提高程序的性能和效率。

在编程中,我们通常会遇到运行时间长、消耗资源多的问题,这时候就需要对算法进行优化。

优化算法可以帮助我们提高程序的效率,减少资源的占用,提升用户体验。

为什么需要算法优化优化算法的目的是提高程序的性能和效率,为什么我们要关注这个问题呢?这是因为在现代计算机科学领域,计算资源的利用是非常宝贵的。

如果一个程序运行时间太长或者消耗过多的内存,将会给计算机带来很大的负担,甚至导致系统崩溃。

而优化算法则可以帮助我们提高程序的效率,使得它能够更好地利用计算资源,提升性能。

常用的算法优化技巧接下来,我们将介绍一些常用的算法优化技巧,帮助你更好地理解和应用它们。

1. 循环迭代循环是编程中常用的结构,但是不恰当的循环迭代方式会导致程序性能下降。

为了优化循环,我们可以注意以下几点:•减少循环次数:如果循环中的某个操作可以在循环之外完成,我们可以将其移到循环之前或之后,减少循环次数。

•合理使用循环变量:合理使用循环变量可以减少循环内的重复计算。

在循环结束后,循环变量的值可以作为后续计算的基础。

2. 数据结构选择选择合适的数据结构对算法的性能有很大的影响。

不同的数据结构适合不同类型的操作,选择合适的数据结构可以减少算法的时间和空间复杂度。

常见的数据结构包括数组、链表、栈、队列、堆等,根据具体的需求选择合适的数据结构会更加高效。

3. 减少内存占用内存占用是一个常见的性能问题,如果程序消耗过多的内存,将导致系统负担增加,甚至出现内存不足的问题。

为了减少内存占用,我们可以注意以下几点:•释放不再使用的内存:及时释放不再使用的内存可以减少程序的内存占用。

最优化方法及其应用

第一章 最优化问题总论无论做任何一件事,人们总希望以最少的代价取得最大的效益,也就是力求最好,这就是优化问题.最优化就是在一切可能的方案中选择一个最好的方案以达到最优目标的学科.例如,从甲地到乙地有公路、水路、铁路、航空四种走法,如果我们追求的目标是省钱,那么只要比较一下这四种走法的票价,从中选择最便宜的那一种走法就达到目标.这是最简单的最优化问题,实际优化问题一般都比较复杂.概括地说,凡是追求最优目标的数学问题都属于最优化问题.作为最优化问题,一般要有三个要素:第一是目标;第二是方案;第三是限制条件.而且目标应是方案的“函数”.如果方案与时间无关,则该问题属于静态最优化问题;否则称为动态最优化问题.§1.1 最优化问题数学模型最简单的最优化问题实际上在高等数学中已遇到,这就是所谓函数极值,我们习惯上又称之为经典极值问题.例1.1 对边长为a 的正方形铁板,在四个角处剪去相等的正方形以制成方形无盖水槽,问如何剪法使水槽的容积最大?解 设剪去的正方形边长为x ,由题意易知,与此相应的水槽容积为x x a x f 2)2()(-=.令0)6)(2()2()2)(2(2)('2=--=-+--=x a x a x a x x a x f ,得两个驻点:a x a x 6121==,.第一个驻点不合实际,这是因为剪去4个边长为2a的正方形相当于将铁板全部剪去.现在来判断第二个驻点是否为极大点.∵ a x f 824)(''-=, 04)6(''<-=a af ,∴6a x =是极大点. 因此,每个角剪去边长为6a的正方形可使所制成的水槽容积最大.例1.2 求侧面积为常数)0(62>a a ,体积最大的长方体体积.解 设长方体的长、宽、高分别为z y x ,,体积为v ,则依题意知体积为 xyz z y x f v ==)(,,,条件为06)(2)(2=-++=a xy xz yz z y x ,,ϕ.由拉格朗日乘数法,考虑函数)6222()(2a xy xz yz xyz z y x F -+++=λ,,,2()02()02()0x y z F yz y z F xz z x F xy x y λλλ'=++='=++='=++=,,,由题意可知z y x ,,应是正数,由此0≠λ,将上面三个等式分别乘以z y x ,,并利用条件23a xy zx yz =++,得到2222(3)02(3)02(3)0xyz a yz xyz a zx xyz a xy λλλ⎧+-=⎪+-=⎨⎪+-=⎩,,.比较以上三式可得xy a zx a yz a -=-=-222333,从而a z y x ===.又侧面积固定的长方体的最大体积客观存在,因此侧面积固定的长方体中以正方体体积最大,其最大值为3a .例1.3 某单位拟建一排四间的停车房,平面位置如图1.1所示.由于资金及材料的限制,围墙和隔墙的总长度不能超过40m ,为使车房面积最大,应如何选择长、宽尺寸?解 设四间停车房长为1x ,宽为2x .由题意可知面积为2121)(x x x x f =,,且变量1x ,2x 应满足405221≤+x x , 1200x x ≥≥,.即求2121),(m ax x x x x f =,1212254000x x x x +≤⎧⎨≥≥⎩,,.以上三个例子,虽然简单,但是它代表了三种类型的最优化问题.第一个例子代表无约束极值问题:一般可表示为),,,(m i n21n x x x f 或),,,(m ax 21n x x x f .这里,),,,(21n x x x f 是定义在n R 上的可微函数.求极值的方法是从如下含有n 个未知数n x x x ,,,21 的非线性方程组⎪⎪⎩⎪⎪⎨⎧===0)('0)('0)('21212121n x n x n x x x x f x x x f x x x f n ,,,,,中解出驻点,然后判定或验证这些驻点是不是极值点.第二个例子代表具有等式约束的极值问题: 一般可表示为121212min ()max ()()0123()n n j n f x x x f x x x h x x x j m m n ⎧⎪⎨==<⎪⎩,,,或,,,,,,,,,,,,.该问题的求解通常采用拉格朗日乘数法,即把这个问题转化为求121212121()()()mn m n j j n j L x x x f x x x h x x x λλλλ==-∑,,,;,,,,,,,,,的无约束极值问题.第三个例子代表具有不等式约束的极值问题.下面具体分析上述三种类型的最优化问题中按经典极值问题解法可能出现不能解决的情况:(1)当变量个数增加且方程组又是非线性,求解此方程组只有在相当特殊情况下才能人工解出.正因为如此,通常高等数学中的求极值问题的变量个数一般不超过三个.(2)当限制条件出现不等式,无论变量数多少,按经典极值方法求解根本无法解决. 直到本世纪50年代,最优化理论的建立以及电子计算机的迅速发展,才为求解各种最优化问题提供了雄厚的基础和有效手段.不过最优化方法作为一门崭新的应用学科,有关理论和方法还没有完善,有许多问题还有待解决,目前正处于迅速发展之中.最优化问题的数学模型包含三个要素:变量(又称设计变量)、目标函数、约束条件. 一、变量一个优化设计方案是用一组设计参数的最优组合来表示的.这些设计参数可概括地划分为两类:一类是可以根据客观规律、具体条件、已有数据等预先给定的参数,统称为常量;另一类是在优化过程中经过逐步调整,最后达到最优值的独立参数,称为变量.优化问题的目的就是使各变量达到最优组合.变量的个数称为优化问题的维数.例如有n 个变量n x x x ,,, 21的优化问题就是在n 维空间n R 中寻优.n 维空间n R 中的点T n x x x X ][21,,, =就代表优化问题中的一个方案.当变量为连续量时,称为连续变量;若变量只能在离散量中取值,称为离散变量.二、目标函数反映变量间相互关系的数学表达式称为目标函数.其值的大小可以用来评价优化方案的好坏.按照规范化的形式,一般把优化问题归结为求目标函数的极小化问题,换句话说,目标函数值越小,优化方案越好.对于某些追求目标函数极大的问题,可以转化成求其负值最小的问题,即12max ()max ()min[()]n f X f x x x f X ==--,,,.因此在本书的叙述中,一律把优化问题描述为目标函数的极小化问题,其一般形式为12min ()min ()n f X f x x x =,,,. 如果优化问题只有一个目标函数,称为单目标函数,如果优化问题同时追求多个目标,则该问题的目标函数称为多目标函数.多目标优化问题的目标函数通常表示为12min ()[()()()]T m V F X f X f X f X -=,,,,其中Tn x x x X ][21,,, =.这时的目标函数在目标空间中是一个m 维矢量,所以又称之为矢量优化问题(一般用min 加一个前缀“-V ”来表示矢量极小化). 三、约束条件变量间本身应该遵循的限制条件的数学表达式称为约束条件或约束函数. 约束条件按其表达式可分为不等式约束和等式约束两种,即()012..()012i j g X i l s t h X j m ≥=⎧⎪⎨==⎪⎩,,,,,,,,,.上式中“s . t .”为Subject to 的缩写,意即“满足于”或“受限于”.按约束条件的作用还可将约束条件划分为起作用的约束(紧约束、有效约束)和不起作用的约束(松约束、消极约束).等式约束相当于空间里一条曲线(曲面或超曲面),点X 必须为该曲线(曲面或超曲面)上的一点,因而总是紧约束.有一个独立的等式约束,就可用代入法消去一个变量,使优化问题降低一维.因此,数学模型中独立的等式约束个数应小于变量个数;如果相等,就不是一个待定优化系统,而是一个没有优化余地的既定系统.不等式约束通常是以其边界)0)((0)(≈=X g X g 或表现出约束作用的,它只限制点X 必须落在允许的区域内(包括边界上),因而不等式约束的个数与变量个数无关.不带约束条件的优化问题称为无约束最优化问题;带约束条件的优化问题称为约束最优化问题.四、带约束条件的优化问题数学模型表示形式综上所述,全书所要讨论的问题是如下的(静态)最优化问题,其表示形式有三种: 第一种最优化问题表示形式为1212[]1212min()()012..()012()T n n x x x i n j n f x x x g x x x i l s t h x x x j m m n ∈Ω≥=⎧⎪⎨==<⎪⎩,,,,,,,,,,,,,,,,,,,,,,. 第二种最优化问题表示形式为m i n ()()012..()012()X i j f X g X i l s t h X j m m n ∈Ω≥=⎧⎪⎨==<⎪⎩,,,,,,,,,,.第三种最优化问题表示形式为min ()()0..()0X f G X s t H X ∈Ω≥⎧⎨=⎩,,,X(1.1)其中11()[()()]()[()()]T Tl m G X g X g X H X h X h X ==,,,,,. 上述三种表示形式中,X ∈Ω称为集约束.在所讨论的最优化问题中,集约束是无关紧要的.这是因为一般nR ≡Ω,不然的话,Ω通常也可用不等式约束表达出来.因此今后一般不再考虑集约束.满足所有约束的点X 称为容许点或可行点.容许点的集合称为容许集或可行域.可用{|()012()012()}i j D X g X i l h X j m m n =≥===<,,,,;,,,, 表示.一般地,对于最优化问题(1.1)的求解,是指在可行域内找一点*X ,使得目标函数)(X f在该点取得极小值,即***()min ()()0..()0f X f X G X s t H X =≥⎧⎨=⎩,,.这样的*X 称为问题(1.1)的最优点,也称极小点,而相应的目标函数值)(*X f 称为最优值;合起来,))((**X f X ,称为最优解,但习惯上常把*X 本身称为最优解.最优点的各分量和最优值必须是有限数.§1.2 最优化问题的算法一、二维最优化问题的图解法二维最优化问题具有鲜明的几何解释,这对于理解有关理论和掌握所述的方法是很有益处的.下面讨论的二维最优化问题为⎩⎨⎧==≥.0)(210)(..)(min 212121x x h l i x x g t s x x f i ,,,,,,,(一)约束集合当约束函数为线性时,等式约束在21x x ,的坐标平面上为一条直线;不等式约束在21x x ,的坐标平面上为一半平面.当约束函数(例如)(21x x h ,)为非线性时,则等式约束条件0)(21=x x h ,在21x x ,的坐标平面上为一条曲线(如图 1.2所示).当约束函数(例如)(211x x g ,)为非线性时,则不等式约束0)(211≥x x g ,在21x x ,的坐标平面上为曲线0)(211=x x g ,把坐标平面分成两部分当中的一部分(如图1.3所示).图1.2图1.3综上所述,当把约束条件中的每一个等式所确定的曲线,以及每一个不等式所确定的部分在21x x ,坐标平面上画出之后,它们相交的公共部分即为约束集合D . 例1.4 在21x x ,坐标平面上画出约束集合 }001|],{[21222121≥≥≤+=x x x x x x D T ,,.解 满足12221≤+x x 的区域为以原点为圆心,半径为1的圆盘;满足0021≥≥x x ,的区域为第一象限中的扇形(如图1.4所示).(二)等高线我们知道)(21x x f t ,=在三维空间中表示一张曲面.c t =(其中c 为常数)在三维空间中表示平行于21x x ,平面的一个平面,这个平面上任何一点的高度都等于常数c (如图1.5所示).图1.4图1.5现在,在三维空间中曲面)(21x x f t ,=与平面c t =有一条交线L .交线L 在21x x ,平面上的投影曲线是L ',可见曲线L '上的点T x x ][21,到平面c t =的高度都等于常数c ,也即曲线L '上的T x x ][21,的函数值)(21x x f ,都具有相同的值c .当常数c 取不同的值时,重复上面的讨论,在21x x ,平面上得到一簇曲线——等高线.不难看出,等高线的形状完全由曲面)(21x x f t ,=的形状所决定;反之,由等高线的形状也可以推测出曲面)(21x x f t ,=的形状.在以后的讨论中,不必具体画出曲面)(21x x f t ,=的图形,只须在21x x ,平面上变动常数c 画出曲线簇c x x f =)(21,. 例1.5 在21x x ,坐标平面上画出目标函数222121)(x x x x f +=,的等高线.解 因为当取0>c 时,曲线c x x =+2221表示是以原点为圆心,半径为c 的圆.因此等高线是一簇以原点为圆心的同心圆(如图1.6所示).(三)几何意义及图解法当在21x x ,坐标平面上分别画出约束集合D 以及目标函数)(21x x f ,的等高线后,不难求出二维最优化问题的最优解.下面举例说明.例1.6 用图解法求解二维最优化问题2212221212min[(2)(2)]1..00x x x x s t x x +++⎧+≤⎪⎨≥≥⎪⎩,,,.解 由例1.4得到约束集合D (如图1.7所示).目标函数的等高线是以T]22[--,为圆心的同心圆,并且这簇同心圆的外圈比内圈的目标函数值大.因此,这一问题成为在约束集合中找一点Tx x ][21,,使其落在半径最小的那个同心圆上.不难看出,问题的最优解图1.6T T x x X ]00[][21*,,==.图1.7二、最优化问题的迭代解法(一)迭代方法在经典极值问题中,解析法虽然具有概念简明,计算精确等优点,但因只能适用于简单或特殊问题的寻优,对于复杂的工程实际问题通常无能为力,所以极少使用.最优化问题的迭代算法是指:从某一选定的初始点出发,根据目标函数、约束函数在该点的某些信息,确定本次迭代的一个搜索方向和适当的步长,从而到达一个新点,用式子表示即为1012k k k k X X t P k +=+=,,,,(1.2)式中k X 代表前一次已取得的迭代点,在开始计算时为迭代初始点0X ,1+k X 代表新的迭代点,k P 代表第k 次迭代计算的搜索方向,k t 代表第k 次迭代计算的步长因子.按照式(1.2)进行一系列迭代计算所根据的思想是所谓的“爬山法”,就是将寻求函数极小点(无约束或约束极小点)的过程比喻为向“山”的顶峰攀登的过程,始终保持向“高”的方向前进,直至达到“山顶”.当然“山顶”可以理解为目标函数的极大值,也可以理解为极小值,前者称为上升算法,后者称为下降算法.这两种算法都有一个共同的特点,就是每前进一步都应该使目标函数有所改善,同时还要为下一步移动的搜索方向提供有用的信息.如果是下降算法,则序列迭代点的目标函数值必须满足下列关系011()()()()k k f X f X f X f X +>>>>.如果是求一个约束的极小点,则每一次迭代的新点 ,,21X X 都应该在约束可行域内,即 012k X D k ∈=,,,,图1.8为迭代过程示意图.由上面的迭代过程可知,在迭代过程中有两个规则需要确定:一个是搜索方向k P 的选取;一个是步长因子k t 的选取.一旦k P 和k t 的选取方法确定,则一种迭代算法就确定,即不同的规则就对应不同的最优化方法.(二)收敛速度与计算终止准则(1)收敛速度作为一个算法,能够收敛于问题的最优解当然是必要8的,但仅收敛还不够,还必须能以较快的速度收敛,这才是好的算法.图1.8定义1.1 设由算法A 产生的迭代点列{}k X 在某种“||·||”的意义下收敛 于点*X ,即0||||lim *=-∞→X X k k ,若存在实数0>α及一个与迭代次数k 无关的常数0>q ,使得,q X X X X k k k =--+∞→α||||||||lim **1则称算法A 产生的迭代点列}{k X 具有α阶收敛速度,或称算法A 为α阶收敛的.特别地:① 当01>=q ,α时,称迭代点列}{k X 具有线性收敛速度或称算法A 为线性收敛的. ② 当021><<q ,α时,或0,1==q α时,称迭代点列}{k X 具有超线性收敛速度或称算法A 是超线性收敛.③ 当2=α时,迭代点列}{k X 叫做具有二阶收敛速度或算法A 是二阶收敛的. 一般认为,具有超线性收敛或二阶收敛的算法是较快速的算法.例1.7 设一算法A 产生迭代点列}1{k X k =,它收敛于点0*=X ,试判定算法A 的收敛速度.解 因为 1|01||011|lim =--+∞→k k k ,即取 01,1>==q α.所以算法A 具有线性收敛速度.例1.8 设一算法A 产生迭代点列}1{kk k X =,它收敛于0*=X ,试确定A 的收敛速度.解 因为11)1(lim |01||0)1(1|lim +∞→+∞→+=--+k k k k k k k k k k11lim()01k k k k k +→∞=⋅=+,即取0,1==q α. 所以A 是超线性收敛的. (2)计算终止准则用迭代方法寻优时,其迭代过程不能无限制地进行下去,那么什么时候截断这种迭代呢?这就是迭代什么时候终止的问题.从理论上说,当然希望最终迭代点到达理论极小点,或者使最终迭代点与理论极小点之间的距离足够小时才终止迭代.但是这在实际上是办不到的.因为对于一个待求的优化问题,其理论极小点在哪里并不知道.所知道的只是通过迭代计算获得的迭代点列}{k X ,因此只能从点列所提供的信息来判断是否应该终止迭代.对于无约束优化问题通常采用的迭代终止准则有以下几种: ①点距准则相邻两迭代点1+k k X X ,之间的距离已达到充分小,即 ε≤-+||||1k k X X ,上式中ε是一个充分小的正数,代表计算精度.②函数下降量准则相邻两迭代点的函数值下降量已达到充分小.当1|)(|1<+k X f 时,可用函数绝对下降量准则ε≤-+|)()(|1k k X f X f .当1|)(|1>+k X f 时,可用函数相对下降量准则ε≤-++|)()()(|11k k k X f X f X f .③梯度准则目标函数在迭代点的梯度已达到充分小,即ε≤∇+||)(||1k X f .这一准则对于定义域上的凸函数是完全正确的.若是非凸函数,有可能导致误把驻点作为最优点.(凸函数的定义请参见第二章2.6节)对于约束优化问题,不同的优化方法有各自的终止准则. 综上所述,优化算法的基本迭代过程如下: ① 选定初始点0X ,置0=k .② 按照某种规则确定搜索方向k P . ③ 按某种规则确定k t 使得)()(k k k k X f P t X f <+.④ 计算k k k k P t X X +=+1.⑤ 判定1+k X 是否满足终止准则.若满足,则打印1+k X 和)(1+k X f ,停机;否则置1+=k k ,转②.上述算法用框图表达如图1.9.§1.3 最优化算法分类所谓优化算法,其实就是一种搜索过程或规则,它是基于某种思想和机制,通过一定的途径或规则来得到满足用户要求的问题的解.就优化机制与行为而分,目前工程中常用的优化算法主要可分为:经典算法、构造型算法、改进型算法、基于系统动态演化的算法和混合型算法等.(1)经典算法.包括线性规划、动态规划、整数规划和分枝定界等运筹学中的传统算法,其算法计算复杂性一般很大,只适于求解小规模问题,在工程中往往不实用.(2)构造型算法.用构造的方法快速建立问题的解,通常算法的优化质量差,难以满足工程需要.譬如,调度问题中的典型构造型方法有:Johnson 法、Palmer 法、Gupta 法、CDS 法、Daunenbring 的快速接近法、NEH 法等.(3)改进型算法,或称邻域搜索算法.从任一解出发,对其邻域的不断搜索和当前解的替换来实现优化.根据搜索行为,它又可分为局部搜索法和指导性搜索法.①局部搜索法.以局部优化策略在当前解的邻域中贪婪搜索,如只接受优于当前解的状态作为下一当前解的爬山法;接受当前解邻域中的最好解作为下一当前解的最陡下降法等.②指导性搜索法.利用一些指导规则来指导整个解空间中优良解的探索,如SA 、GA 、TS 等.(4)基于系统动态演化的算法.将优化过程转化为系统动态的演化过程,基于系统动态的演化来实现优化,如神经网络和混沌搜索等.(5)混合型算法.指上述各算法从结构或操作上相混合而产生的各类算法. 优化算法当然还可以从别的角度进行分类,如确定性算法和不确定性算法,局部优化算法和全局优化算法等.§1.4 组合优化问题简介一、组合优化问题建模优化问题涉及的工程领域很广,问题种类与性质繁多,归纳而言,最优化问题可分为函数优化问题和组合优化问题两大类,上一节介绍的最优化数学模型属于函数优化问题,该函数优化的对象是一定区间内的连续变量,而组合优化的对象则是解空间中的离散状态.本节重点介绍组合优化问题.组合优化问题是通过对数学方法的研究去寻找离散事件的最优编排、分组、次序或筛选等,所研究的问题涉及信息技术、经济管理、工业工程、交通运输、通信网络等诸多领域,该问题数学模型可表示为⎩⎨⎧=≥Ω∈,,0)(0)(..)(min X H X G t s X f X其中)(X f 为目标函数,)(X G 和)(X H 为约束函数,X 为决策变量,Ω表示有限个点组成的集合.一个组合优化问题可用3个参数)(f D ,,Ω表示,其中Ω表示决策变量的定义域,D 表示可行解区域}0)(0)(|{=≥Ω∈=X H X G X X D ,,,D 中的任何一个元素称为该问题的可行解,f 表示目标函数,满足}|)(m in{)(*D X X f X f ∈=的可行解*X 称为该问题的最优解.组合最优化问题的特点是可行解集合为有限集.由直观可知,只要将Ω中有限个点逐一判别是否满足约束条件0)(0)(=≥X H X G ,和比较目标函数值的大小,该问题的最优解一定存在并可以求得,下面是三个典型的组合优化问题.例1.9 0-1背包问题(knapsack problem )设有一个容积为b 的背包,n 个体积分别为),,2,1(n i a i =,价值分别为),,2,1(n i c i =的物品,如何以最大的价值装包?这个问题称为0-1背包问题.用数学模型表示为∑=ni ii x c 1max , (1.3)⎪⎩⎪⎨⎧=∈≤∑=)5.1(21}10{)4.1(..1.,,,,,,n i x b x a t s ini i i其中目标(1.3)欲使包内所装物品的价值最大,式(1.4)为包的能力限制,式(1.5)表示i x 为二进制变量,1=i x 表示装第i 个物品,0=i x 则表示不装.例1.10 旅行商问题(TSP ,traveling salesman problem )一个商人欲到n 个城市推销商品,每两个城市i 和j 之间的距离为ij d ,如何选择一条道路使得商人每个城市走一遍后回到起点且所走路径最短.TSP 还可以细分为对称和非对称距离两大类问题.当对任意的j i ,时都有ji ij d d =,则称该TSP 为对称距离TSP ,否则称为非对称距离TSP .对一般的TSP ,它的一种数学模型描述为∑≠ji ijij x d min , (1.6)11,112(1.7)112(1.8)..||12||2{12}(1.9){01}12(1.10)nij j n ij i ij i j Sij x i n x j n s t x S S n S n x i j n i j ==∈⎧==⎪⎪⎪⎪==⎨⎪≤-≤≤-⊂⎪⎪⎪∈=≠⎩∑∑∑,,,,,,,,,,,,,,,,,,,,,,,.以上是基于图论的数学模型.其中式(1.10)中的决策变量ij x =1表示商人行走的路线包含从城市i 到城市j 的路径,0=ijx 表示商人没有选择走这条路.j i ≠的约束可以减少变量的个数,使得共有)1(-⨯n n 个决策变量.目标(1.6)要求距离之和最小.式(1.7)要求商人从城市i 出来一次,式(1.8)要求商人走入城市j 只有一次.式(1.7)和式(1.8)表示每个城市经过一次.仅有式(1.7)和式(1.8)的约束无法避免回路的产生,一条回路是由)1(n k k ≤≤个城市和k 条弧组成,因此,式(1.9)约束旅行商在任何一个城市子集中不形成回路,其中||S 表示集合S 中元素个数.例1.11 聚类问题m 维空间上的n 个模式}21|{n i X i ,,,=要求聚类成k 类,使得各类本身内的点最相近,即∑=-ni p p i R X 0)(||||min ,其中p R 为第p 类的中心,∑==pn i p ip p Xn R 1)(1,k p ,,, 21=,p n 为第p 类中的点数.二、算法复杂性前面给大家介绍的三个组合优化问题例子,模型建立都比较简单,但要求它们的最优解却很困难,而解模型的困难主要原因是所谓的“组合爆炸”,如聚类问题的可能划分方式有!/k k n 个,TSP 问题有!n 个.显然状态数量随问题规模呈超指数增长,若计算机每秒处理1亿种排列,则列举20个城市问题的20!种排列约需几百年.如此巨大的计算量是无法承受的,更不用谈更大规模问题的求解,因此解决这些问题的关键在于寻求有效的优化算法,也正是由于组合优化问题算法的复杂性,激起了人们对它的理论与算法研究的兴趣.算法的复杂性是指算法对时间复杂性和对空间复杂性.按照算法复杂性求解的难易程度,可把组合优化问题分为P 类,NP 类和NP 完全类.算法或问题的复杂性一般表示为问题规模n (如TSP 问题中的城市数)的函数,时间的复杂性记为)(n T ,空间的复杂性记为)(n S .在算法分析和设计中,沿用实用性的复杂性概念,即把求解问题的关键操作,如加、减、乘,比较等运算指定为基本操作,算法执行基本操作的次数则定义的算法的时间复杂性,算法执行期间占用的存储单元则定义为算法的空间复杂性.P 类问题指具有多项式时间求解算法的问题类.许多优化问题仍没有找到求得最优解的多项式时间算法,称这种比P 类问题更广泛的问题为非确定型多项式算法的问题类,即NP 问题.三、NP 完全问题离散问题的求解常常要从有限个方案中选出一个满意的结果来 ,也许有人认为,从有限个方案中挑选一个,总是比较容易的.然而,事实并非如此,关键在于问题的规模.由于计算机的出现,人们对问题的求解在观念上发生了改变,一个在理论上可解的问题如果在求解时需要花费相当多,以至于不合理的时间(如几百年甚至更长时间),我们不能认为它已解决,而应当努力寻找更好的算法.如何比较算法的好坏呢?从不同的角度出发可以有不同的回答.这里,仅就算法的计算速度作一个十分粗略的比较.设有一台每小时能进行M 次运算的计算机.并设问题已有两种不同的算法,算法A 对规模为n 的问题约需作2n 次运算,算法B 则约需作n2次运算.运用算法A 在一个小时内大约可解一个规模为M 的问题,而算法B 则大约可解一个规模为M 2log 的问题.现在假设计算机有了改进,例如计算速度提高了100倍.此时,利用算法A 能求解的问题规模增大了10倍,利用算法B 可解的问题规模只增加了7100log 2<.前者得到了成倍的增加,而后者则几乎没有什么改变,今天无法求解的问题,将来也很少有希望解决.由于这一原因,对算法作如下分类.定义1.2(多项式算法) 设A 是求解某类问题D 的一个算法,n 为问题D 的规模,用)(n D f A ,表示用算法A 在计算机上求解这一问题时需作的初等运算的次数.若存在一个多项式)(n P 和正整数N ,当N n ≥时,总有)(),(n P n D f A ≤(不论求解的D 是怎样的具体实例),则称算法A 是求解问题D 的一个多项式算法.定义1.3(指数算法) 设算法B 是求解某类问题D 的一个算法,若存在一个常数0>k ,对任意n ,总可以找到问题D 的一个规模为n 的实例,用算法B 求解时,所需的计算量约为)2()(kn B o n D f =,,则称B 为求解问题D 的一个指数算法.多项式算法被称为是“好”算法(或有效算法),而指数算法则一般认为是“坏”算法,因为它只能用来求解规模很小的问题.这样看来,对一个问题只有在找到求解它的多项式算法后才能较为放心.然而十分可惜的是,对于许多具有广泛应用价值的离散模型,人们至今仍未找到多项式算法.现在的任何算法在最坏的情况下计算量均可达到或接近n2.1971年和1972年,S. Cook 和R. Karp 分别发表了相关论文,奠定了NP 完全理论基础.Cook 指出,NP 完全类问题,具有两个性质:(1)这类问题中的任何一个问题至今均未发现有多项式算法.(2)只要其中任一个问题找到了多项式算法,那么其他所有问题也就有了多项式算法.。