视频处理_跟踪和监控性能评估国际专题讨论会(PETS)2001)

盈可视班班通全自动录播技术方案2

Ncast 班班通系列高清全自动录播技术解决方案目录第一章概述 (3)第二章方案设计 (3)解决方案概述 (3)方案优势 (4)实用 (4)易用 (4)易安装 (4)免调试 (4)设计思路 (4)第三章方案详细介绍 (5)系统特色 (5)录播主机 (5)视频采集及处理 (5)音频采集及处理 (6)系统操控 (6)录播系统拓朴图 (7)Ncast EX1093班班通录播系统主机 (8)概述 (8)H.264高清视频编码,AAC高清音频编码 (8)单流/多流同步录制 (8)多格式同步录制 (10)硬件HDMI/VGA采集 (10)师生互动对话模式 (10)高达200路并发直播网页Flash收看 (11)移动终端收看 (12)支持多种品牌网络摄像机与监控系统共用前端设备 (12)视频回收站功能 (12)低电压供电,环保无辐射 (13)本地回显高清输出 (13)多画面IE远程导播管理模块 (13)定时录制 (14)视频文件集中管理 (15)录播主机性能参数表 (16)智能图像识别跟踪模块 (17)自动导播策略管理模块 (17)班班通系列全自动录播系统安装示意图 (18)7寸触摸式控制屏 (19)视频摄像系统 (20)超低照度枪型网络摄像机 (20)网络系统 (20)TP-LINK 8口百兆POE交换机 (20)音频系统 (21)数字音频处理器 Ncast APC 200 (21)全向盒式麦克风T86 (22)专业机架式调音台 (23)功率放大器—Ncast PA-1000 (24)全频扬声--Ncast NS200系列专业音箱 (25)无线麦克风以及接收主机WR-202 (27)第四章系统配置 (28)云平台共享解决方案 (30)我们的认证 (33)数字校园示范校建设参考指标 (38)第一章概述2013年是我国教育信息化的关键一年,“三通两平台”建设,“教学点数字教育资源全覆盖”项目的实施,都是在为信息化时代如何实现教育现代化,促进信息技术与教育教学的深度融合打基础。

视频处理_(IEEE跟踪和监控性能评估国际专题讨论会(PETS)2002)

IEEE International Workshop on PerformanceEvaluation of Tracking and Surveillance(PETS)2002(IEEE跟踪和监控性能评估国际专题讨论会(PETS)2002)数据摘要:PETS'2002 consists of datasets for two distinct applications:- people tracking and counting- hand posture classificationMOVING PEOPLEThe datasets consists of people moving in front of a shop window. HAND POSTURE RECOGNITIONThe datasets consist of close-ups of hand postures in front of a uniform light, dark and complex backgrounds. The task is to perform hand posture classification. A protocol package is provided (see below) giving details about which data to use for training anf testing.中文关键词:PETS2002,跟踪,监控,室内,手势,英文关键词:PETS2001,tracking,surveillance,indoor,hand posture,数据格式:VIDEO数据用途:This dataset is for indoor people tracking (and counting) and hand posture classification data (annotated).数据详细介绍:PETS2002 DatasetsPETS'2002 consists of datasets for two distinct applications:- people tracking and counting- hand posture classificationMOVING PEOPLEThe datasets consists of people moving in front of a shop window. The task is to determine:- how many people are passing in front of the shop window- how many people stop and look into the window- how many people are looking into the window at each instant (frame) in time - the trajectories of people passing in front of the store- the time spent per frame (processing time): a histogram of the microseconds spent processing each frame.It is recommended that these results (for test datasets 1, 2, and 3) are placed into graph(s)/table in the paper submission.The task is made difficult by:- the reflections from the ground and from the opposing window- occlusions from the text on the window- occluding groups of people walking together- occlusions among the people standing in front of the storeThe datasets are available under hereThe entire people training set (gzipped tar file) can be downloaded here.The entire people test set (gzipped tar file) can be downloaded here.You can also download all files under one directory using wget i.e.wget -m ftp:///PETS2002/PEOPLE/will download all people datasets to the current directory. Please see/software/wget/wget.html for more details.Note that both individual Jpeg files and MPEG sequences are available for each dataset.If you are having problems, please access via direct ftp as shown above. There are two directories - one for training, and one for testing. Results should be presented only on the test data - see below for more detailed instructions.PEOPLE - TRAINING: DATASET 1 (377 frames)PEOPLE - TRAINING: DATASET 2 (1471 frames)Frame 665 Frame 967PEOPLE - TRAINING: DATASET 3 (1297 frames)PEOPLE - TESTING: DATASET 1 (653 frames)Frame 390 Frame 510PEOPLE - TESTING: DATASET 2 (1752 frames)Frame 1116 Frame 1240PEOPLE - TESTING: DATASET 3 (1304 frames)Frame 570 Frame 730Notes on datasets:∙the training directory contains a training set of frames in both MPEG movie format and as individual Jpeg images for two training sets.∙the test directory contains a training set of frames in both MPEG movie format and as individual Jpeg images for four test sets.The tracking/counting can be performed on the entire test sequence 1, 2, or 3, or a portion of it. The images may be converted to any other format as appropriate, e.g. subsampled, or converted to monochrome. All results reported in the paper should clearly indicate which part of the test data is used, ideally with reference to frame numbers where appropriate, e.g. PEOPLE TRACKING, TEST DATASET 1, FRAMES 1-100.There is no requirement to report results on all the test sequences (1, 2, and 3), however you are encouraged to test your algorithms on as much of the test data as possible.Please ensure when quoting training or test sequences in the paper, that they match the datasets on this website.The tracking results must be submitted along with the paper, with the tracking results generated in XML format (details to be posted here soon.) This will be straightforward and should not add a significant overhead to your effort. AcknowledgementThe sequences have been provided by the consortium of Project IST VISOR BASE (IST-1999-10808) - http://www.vtools.es/visorbase/index.htmlHAND POSTURE RECOGNITIONThe datasets consist of close-ups of hand postures in front of a uniform light, dark and complex backgrounds. The task is to perform hand posture classification. A protocol package is provided (see below) giving details about which data to use for training anf testing.Note: currently there exist no reference databases and no standards for the evaluation and comparison of developed algorithms in hand posture recognition, and more generally in gesture recognition.The datasets for PETS2002 are the Jochen Triesch Hand Posture Gallery available here.The individual PGM files may be viewed here.The protocol package including details on training and testing is provided here. If you are having problems, please access via direct ftp as shown above. Details on how to submit your classification results in XML format will be added here shortly.VERY IMPORTANT INFORMATION FOR PAPER SUBMISSIONThe results that you report in your paper submission (irrespective of either application - hand posture recognition or people tracking/counting): should be performed using the test data, but the training data may optionally be used if the algorithms require it for learning etc.The paper that you submit may be based on previously published tracking methods/algorithms (including papers submitted to the main ECCVconference). The importance is that your paper MUST report results using the datasets supplied.If you have any queries please email pets2002@.数据预览:点此下载完整数据集。

大学课程名中英文对照一览表

课程名《多媒体计算机应用基础》课程设计《红楼梦》与中国文化《计算机网络》课程设计《数据库应用技术》课程设计《数字媒体制作》课程设计《数字通信》课程设计《数字信号处理》课程设计《通信原理Ⅱ》课程设计《现代交换原理》课程设计《移动通信》课程设计3D图形程序设计3D图形程序设计7号信令和通信网信号系统ASIC设计原理及应用ASIC设计原理及应用C + +程序设计C#程序设计C++程序设计C++程序设计基础C++程序设计基础C++高级语言程序课程设计C++高级语言程序设计C++高级语言程序设计C++高级语言程序设计C++高级语言程序设计C++语言程序设计CAD/CAM技术CI策划Computer Networks and Internet C程序设计实践C程序设计实践C高级语言程序设计C高级语言程序设计C高级语言程序设计C高级语言程序设计C语言程序设计C语言程序设计C语言程序设计基础DSP技术DSP设计及应用DSP原理与应用DSP原理与应用EDA技术ERP沙盘模拟实战ERP沙盘模拟与价值管理ERP原理与应用Flash动画编程Flash动画制作ICT管制Internet 技术Internet 应用基础Internet 应用技术Internet服务质量与NS2仿真INTERNET技术Internet技术与网页制作IP电话与软交换IT服务管理IT企业文化教育Java EE平台技术Java SE 程序设计实践JAVA编程JAVA程序设计JAVA程序设计JAVA高级语言程序设计JAVA高级语言程序设计JAVA高级语言程序设计Java高级语言程序设计Java网络编程JAVA语言程序设计Java语言与编程Java语言与程序设计LABVIEW虚拟实验系统的设计Linux 操作系统Linux 操作系统LINUX操作系统Linux环境及开发工具应用实践Linux系统与程序设计Linux系统与程序设计Linux系统与程序设计基础Linux系统与程序设计基础LSI/VLSI数字集成电路MATLAB程序设计MATLAB及其在通信中的应用MATLAB应用Matlab语言及其信号处理应用MATLAB在信号与系统课程中的应用Multisim电路设计软件Multisim电路设计软件应用NS2网络仿真方法office 开发技术Photoshop电脑美术基础SoC设计方法SoPC与嵌入式系统应用TCP/IP原理与编程UNIX编程环境Unix操作系统UNIX操作系统及应用UNIX原理与编程VI形象设计VLSI原理与CAD技术VLSI原理与EDA技术WEB编程Web开发技术WEB搜索技术WINDOWS NT 系统管理WINDOWS NT系统管理WTO法XML&WebserviceXML及其应用安全及认证安全及验证安全教育办公自动化半导体器件电子学半导体器件物理半导体物理半正定规划保险学报刊选读比较政府体制毕业论文毕业论文毕业论文毕业论文毕业论文毕业论文毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计毕业设计(上)毕业设计(上)毕业设计(上)毕业设计(下)毕业设计(下)毕业设计(下)毕业设计Ⅱ毕业设计Ⅱ毕业实习编码理论编码理论编码理论编译原理与技术编译原理与技术编译原理与技术编译原理与技术编译原理与技术课程设计并行计算并元理论材料力学财务管理财务管理财务会计财政学财政学财政与税收采购管理操作系统操作系统操作系统操作系统基础操作系统课程设计操作系统原理测控电路测控电路课程设计测控电子工艺实习测控技术课程设计测控软件设计实践测控系统课程设计测控仪器设计测试与检测技术基础测试与检测技术基础产品概念设计产品结构设计与表达产品开发产品开发产品开发设计产品设计(二)(信息产品)产品设计(三)(结构设计)产品设计(一)产品设计课程设计(产品、数字媒体)产品设计课程设计(产品/交互)产品摄影产品系统设计产品与品牌管理产业经济学常微分方程常微分方程成本会计程序设计基础程序设计基础程序设计课程设计程序设计实践程序设计实践程序设计语言原理与实践冲压工艺与模具设计抽样调查初等软件工程实践传感技术与应用传感技术与应用传感器网络传媒与经济传送网技术创新管理创新实验创业管理创意训练创作写作大客户营销与客户关系管理讲座大气化学与环境保护大型程序设计大型程序设计大型程序设计(二)大型程序设计(二)大型程序设计(一)大型程序设计(一)大学俄语1大学俄语2大学俄语一外1大学俄语一外2大学俄语一外3大学俄语一外4大学国文大学计算机基础大学计算机基础大学计算机基础大学美学大学日语1大学日语2大学日语3大学日语4大学日语一外1大学日语一外2大学日语一外3大学日语一外4大学生安全教育大学生心理健康教育大学生心理健康与咨询大学数学(上)大学数学(下)大学物理大学物理 (双语)大学物理(上)大学物理(下)大学物理(选修)大学物理A班大学物理B(上)大学物理B(上)A班大学物理B(上)双语班大学物理B(下)大学物理B(下)A班大学物理B(下)双语班大学物理C大学物理D(上)大学物理D(下)大学物理E大学物理解题法大学物理解题方法(上)大学物理解题方法(下)大学物理拓展与应用大学物理拓展与应用大学学习论大学学习论大学英语1-2级大学英语2大学英语3大学英语3-4级大学英语4大学英语5大学英语5大学英语二级大学英语二级大学英语二外1大学英语二外2大学英语二外3大学英语二外4大学英语二外5大学英语二外6大学英语三、四级大学英语三级大学英语四级大学英语听力口语测试大学英语五级大学英语选修大学英语一、二级大学英语一级大学英语一级大学语文大学语文大学语文水平测试大学语文水平测试大众传播学单片机C语言及应用系统设计单片机原理及PLC控制单片机原理及应用单片机原理与系统设计当代国际关系当代世界经济与政治当代世界经济与政治当代西方哲学当代中国外交当代中国政府与行政笛子演奏基本技巧典型机构分析点集拓扑学电波传播电波传播电磁场理论与微波技术电磁场实验电磁场与电磁波电磁场与电磁波电磁场与电磁波测量实验电磁场与微波技术实验电磁场与无线通信原理电磁兼容原理电磁学电磁学电动力学电动力学电机控制电接触、电连接理论电接触及电连接理论与应用电接触与电连接基础电力电子技术电路分析电路分析基础电路分析基础电路分析基础(双语)电路分析与电子电路电路分析与电子电路基础电路分析与电子电路基础电路辅助设计与仿真电路基础电路基础程序设计电路课程设计电路与电子学基础电路与电子学实验电路与信号电路综合创新实验电路综合设计类课程设计电路综合设计应用电路综合实验电路综合实验电路综合实验电路综合实验电路综合实验(1)电路综合实验(2)电信传播学电信法电信管理电信管制理论与政策电信基础电信竞争与规制电信企业资本运营电信企业资本运营电信市场竞争与规制电信系统电信系统电信新业务及技术电信与互联网基础电信运营管理电信组织管理电影欣赏电子材料学基础电子测量与电子电路实验电子测量与电子电路实验(上)电子测量与电子电路实验(上)电子测量与电子电路实验(下)电子测量与电子电路实验(下)电子电路基础电子电路基础电子电路基础电子电路自动化设计与VHDL语言电子废弃物的资源化电子工艺实习电子工艺实习电子工艺实习电子工艺实习电子工艺实习1电子工艺实习2电子及电磁场理论电子科学与技术专业课程设计电子科学与技术专业实验电子商务电子商务电子商务安全管理电子商务法电子商务法电子商务法电子商务法电子商务法电子商务概论电子商务概论电子商务概论电子商务开发技术电子商务模拟电子商务实习电子商务实习电子商务网站设计基础电子商务物流管理电子商务物流组织与管理电子商务系统建设与管理电子商务系统与技术电子商务与安全协议电子商务与电子金融电子商务与网络营销电子商务与网络营销电子设备机构设计(二)电子设备机构设计(一)电子设备结构设计电子设备结构设计(二)电子设备结构设计(一)电子系统基础电子线路设计与仿真电子信息科学与技术专业课程设计电子信息科学与技术专业实验电子信息系统概论电子学导论电子证据法概论电子政务电子政务网站设计基础电子政务网站设计实验电子政务专题讲座电子支付与网络金融调幅调频及立体声广播东西方数学文化选讲动画编剧动画场景设计动画创作动画创作动画创作实践动画概论动画技法动画技法(上)动画技法(下)动画脚本程序设计动画片赏析动画原理动画原理动画原理动漫创作综合实践动漫艺术分析动漫音乐评析短片创作短片配乐对称密码技术对称密码学及其应用多媒体和数字电视类课程设计多媒体计算机应用基础多媒体技术多媒体技术多媒体技术应用基础多媒体技术与应用多媒体技术与应用多媒体技术与应用多媒体通信多媒体通信多媒体通信类课程设计多媒体通信专业综合实验多媒体网络编程多媒体网页设计多媒体系统多媒体系统多媒体信息处理多媒体信息处理多媒体信息处理与传输多媒体信息处理与传输多媒体应用程序设计多模态信息处理多模态信息处理多元统计分析俄罗斯国情与文化概况俄语二外1俄语二外2俄语二外3二维动画创作实践二维动画制作基础发展经济学发展经济学法理学法律基础法律事业认识实习法律思想史法学论文写作技巧法语二外法语二外法语二外1法语二外2法语二外3法哲学与法社会学翻译基础翻译理论与实践 1翻译理论与实践 2翻译理论与实践(1)翻译理论与实践(2)翻译实践犯罪心理学犯罪学泛函分析仿真技术应用非线性编辑非线性光学非线性光学导论非线性光学导论非线性微分方程非线性物理非线性物理学非线性最优化方法非营利组织管理分布式计算分布式计算分布式系统分布式系统分子细胞生物学风险理论风险投资与管理服务科学与服务工程概论服务科学与工程服务营销学复变函数复变函数复变函数复杂问题的算法及程序设计概率论与数理统计概率论与数理统计概率论与数理统计概率论与随机过程概率论与随机过程高层网络协议高等代数高等代数(上)高等代数(下)高等软件工程实践高等数学(上)高等数学(上)高等数学(文上)高等数学(文下)高等数学(下)高等数学(下)高等数学A(上)高等数学A(下)高等数学B(上)高等数学B(下)高等数学解题法高等数学解题法(上)高等数学解题法(下)高等数学解题方法高等数学解题方法(下)高等统计学高级变换高级变换高级财务会计高级日语1高级日语2高级商务英语高级商务英语(双语)高级网络程序设计高级网络程序设计高级物理实验高级英语1高级英语2高频电子线路个人发展计划Ⅰ个人发展计划II个人发展计划III个体软件过程工程材料工程高等代数工程管理概论工程光学工程光学(二)工程光学(一)工程经济学工程力学工程力学与材料工程数学工程图学工程图学工程图学(二)工程图学(上)工程图学(下)工程图学(一)工程图学辅导工程项目管理实训工程项目监理工程制图基础工业机器人工业设计导论工业自动化系统课程设计工业自动化与控制网络工作分析与绩效管理工作站技术及其应用公共财政公共法语二外1公共法语二外2公共关系学公共关系学公共日语二外1公共日语二外2公共事业管理概论公共信息管理专题讲座公共行政学公共形体与礼仪公共政策公共政策公司并购法理论与实务公司法公司理财公司理财学公司运营与管理公司治理公文写作公益劳动公钥密码技术及其应用公钥密码应用供应链管理供应链管理构成设计(上)构成设计(下)构形与造型设计赏析固体物理固体物理学固体物理与半导体物理固网与移动网融合技术管理沟通管理沟通(双语)管理会计学管理经济学管理经济学管理前沿理论(第五项修炼)管理实习管理实习管理文秘管理心理学管理心理学管理信息系统管理信息系统课程设计管理学管理学概论管理学概论管理学原理管理学原理管理研讨光波导原理光波导原理与技术光传送与接入技术光电检测技术光电检测与传感技术光电检测与传感技术光电信息科学专题讲座光电子器件与集成技术光电子器件原理及应用光电子学光电子学光电子学光计算机简介光交换技术光通信的物理基础光网络基础光网络技术光纤通信光纤通信基础光纤通信类课程设计光纤通信网络光纤通信系统光纤通信系统光纤通信原理光信息处理光信息科学与技术专业课程设计光信息科学与技术专业实验光学光学光学光学系统与光电仪器光学系统与光电仪器光学信息处理广播电视艺术广告策划广告设计广告学与广告设计广告学与广告设计广告与营销策划国际电信服务贸易国际法国际法学国际会计国际会议交流英语国际结算国际结算国际金融学国际经济法国际经济法国际经济合作国际经济学国际经济学(双语)国际贸易国际贸易理论与实务国际贸易理论与实务国际贸易模拟国际贸易与国际金融国际贸易与国际金融国际贸易与金融国际企业管理国际商法国际商务函电国际商务函电(双语)国际商务礼仪国际商务礼仪国际商务礼仪(英文授课)国际市场研究国际市场营销国际市场营销国际市场营销学国际私法国际私法国际投资国际投资学国家大学英语四级考试国家大学英语四级考试国家地理资源国家公务员制度国家日语四级国家英语六级统考国家英语四级统考过程控制汉语阅读与写作航天技术概论合唱训练与指挥合同法合同法宏观经济学互动多媒体设计(二)互动多媒体设计(一)互动媒体课程设计互动媒体设计(二)互动媒体设计(一)互换性与测量技术互联网(社会)概论互联网编程互联网数据库互联网协议互联网协议互联网应用互联网应用环境法环境物理汇编语言与接口技术会计报表分析会计报表分析会计电算化会计电算化会计电算化与ERP沙盘模拟会计学会计学会计学基础会计学基础与模拟会计综合实训婚姻家庭法混沌计算混沌理论及其应用货币银行学机电控制系统机电一体化机器人嵌入式系统实验机器人系统综合实验机器视觉机器学习机器智能机械创新设计机械设计机械设计基础机械设计基础实验机械设计课程设计机械设计课程设计机械原理机械原理及设计机械原理课程设计机械制造工程基础机械制造工艺实习机械制造工艺实习机械制造基础机械制造基础(上)机械制造基础(下)机制工艺课程设计机制工艺实习基础会计学基础力学实验基础日语1基础日语2基础日语2基础日语3基础日语4基础设计基础素描基础英语(二)基础英语(一)基础英语1基础英语2基础英语3基础英语4基于C/C++语言的编程实践基于多媒体信息检索平台的设计激光光谱激光技术激光原理激光原理与技术激光原理与技术集成电路工艺及电子化学品集成电路设计概论集成电路制造技术集散控制系统集体创作集邮学集邮学计量经济学计量经济学计算导论与程序设计计算方法计算方法程序设计计算机3D造型设计计算机病毒及其防治计算机病毒及其防治计算机操作基础和程序设计计算机导论计算机犯罪计算机犯罪计算机仿真计算机仿真计算机仿真计算机辅助工业设计(二)计算机辅助工业设计(一)计算机辅助机械工程计算机工程实践计算机工程实践计算机和网络类课程设计计算机检测控制系统课程设计计算机检测控制系统课程设计(上)计算机控制仿真课程设计计算机控制系统计算机控制系统计算机控制系统设计计算机类课程设计计算机立体辅助设计计算机平面辅助设计计算机软件技术基础计算机实习计算机实习计算机实习计算机实习计算机实习计算机实习计算机实习计算机实习计算机实习计算机视觉计算机算法与数学模型计算机算法与数学模型计算机算法与数学模型(上)计算机算法与数学模型(下)计算机通信与网络计算机通信与网络实验计算机图形图像处理计算机图形学计算机图形学计算机图形学计算机图形学计算机图形学基础计算机图形学基础计算机网络计算机网络计算机网络计算机网络计算机网络计算机网络基础计算机网络技术实践计算机网络技术与应用计算机网络技术与应用计算机网络课程设计计算机网络课程设计计算机网络课程设计计算机网络实验计算机网络与通信计算机文化基础计算机系统结构计算机系统结构计算机系统结构计算机应用基础计算机游戏开发计算机与办公自动化计算机原理计算机组成与系统结构计算机组成与系统结构计算机组成原理计算机组成原理计算机组成原理计算机组成原理课程设计计算机组成原理与系统结构计算机组织与结构计算机组织与结构计算数学计算物理与实践计算物理与实践计算智能计算智能技术经济学技术经济学技术美学价格管理讲座价值评估与管理检测技术与信号处理检测与估值检测与估值理论健美健美操交互设计交互式媒体设计交互式媒体设计交互式网页设计交换网络与性能分析交流技能1交流技能2角色与场景设计脚本设计接口技术课程设计接入网技术界面设计金工实习金工实习金工实习金融法金融风险管理金融工程与风险管理金融市场金融数学金融学金融学金融学金属腐蚀和防护近代光学近代物理基础近代物理实验近代物理实验(续)近世代数近世代数及其应用近世代数及其应用经典英文电影赏析经济法经济法经济法经济法概论经济法学经济管理经济管理论文研究与写作方法经济管理综合案例分析经济统计学经济学经济学原理精密机械与仪器精密机械与仪器课程设计精算数学精算学基础竞争情报技术镜头画面设计镜头画面设计I镜头画面设计II就业指导就业指导矩阵理论剧作结构分析决策分析军事理论军训军训科技法科技史与方法学科技史与方法学科技文献检索与利用科技文献阅读与翻译科技英语笔译科技英语口译科技英语文献阅读与翻译科技英语阅读科学计算与Fortran语言科学计算与编程科学技术史可编程逻辑设计可用性测试技术客户关系管理客户关系管理前沿课程设计课程设计课程设计空间解析几何控制工程基础控制原理跨国财务管理跨国公司财务管理跨国经营跨文化交际实用技能跨文化交际学宽带接入网宽带通信网宽带通信网络宽带网络与媒体传输扩频通信篮球劳动法和社会保障法劳动合同法学乐理垒球离散多元分析离散计算机技术离散计算技术离散事件控制系统离散数学离散数学离散数学离散数学离散数学离散数学(上)离散数学(下)离散数学(下)礼仪与形象理解人际沟通理论力学理论力学力学历史管理学立体构成立体构成量子力学量子力学量子力学导论量子力学与统计物理量子力学专题讲座量子信息基础量子信息科学领导学领导学概论流体传动与控制旅游日语马克思主义基本原理马克思主义哲学原理马克思主义政治经济学原理毛泽东思想、邓小平理论和“三个代表”重要思想(上)毛泽东思想、邓小平理论和“三个代表”重要思想(上)(实践)毛泽东思想、邓小平理论和“三个代表”重要思想(下)毛泽东思想、邓小平理论和“三个代表”重要思想概论(下)(实践)毛泽东思想概论毛泽东思想和中国特色社会主义理论体系概论毛泽东思想和中国特色社会主义理论体系概论(实践)贸易实务操作实训贸易实务操作实验美国经济、商业与股市的理解与分析美国文学美国文学简史及选读美术基础与欣赏美术鉴赏美术经典作品鉴赏美术造型基础(上)美术造型基础(下)美学概论秘书学面向对象程序设计面向对象程序设计面向对象程序设计方法面向对象程序设计与交互系统面向对象程序设计与实践(C++)1面向对象程序设计与实践(C++)2面向对象程序设计与实践1面向对象程序设计与实践2面向对象大型程序设计实践面向对象的UML与JAVA面向对象的UML与JAVA面向对象的分析与设计面向对象方法与C++面向对象分析与设计面向对象分析与设计(Java)面向领域的实践1面向领域的实践2民法分论民法学(上)民法学(下)民法总论民事诉讼法模糊集合与灰色系统应用模糊数学模拟电子技术模拟电子技术模拟法庭模拟集成电路设计模式分析模式识别模式识别模式识别模式识别及应用模式识别及应用模型制作纳米材料与技术纳米技术与纳米材料脑与认知科学基础脑与认知科学认识实验排队论排队论排球偏微分方程品牌管理与CI策划乒乓球平面构成平面构成企业ERP及应用企业电子商务管理企业管理企业管理企业管理。

多媒体数据中视听一致性与质量评估方法研究

多媒体数据中视听一致性与质量评估方法研究在当今数字时代,多媒体数据的应用越来越广泛,涵盖了视频、音频、图像等多种形式。

然而,由于不同媒体的特性和传输过程中的干扰,多媒体数据在传输、处理和展示的过程中可能出现视听不一致和质量损失的问题。

因此,研究多媒体数据中的视听一致性和质量评估方法变得至关重要。

视听一致性是指在多媒体展示过程中,图像和声音之间的协调性和一致性。

若图像和声音之间存在明显的不匹配,观众可能会感到困惑、不适感,并影响对内容的理解和享受。

因此,视听一致性评估是确定多媒体展示是否达到人类感知的一致性标准的关键。

为了评估视听一致性,研究者们提出了一系列客观和主观评估方法。

客观评估方法通过对多媒体数据的各个属性进行测量和分析来判断视听一致性。

典型的客观评估方法包括视觉显著性分析、音频特征提取和相应性检测等。

其中,视觉显著性分析是一种测量图像或视频中感兴趣区域的方法,可通过计算图像的视觉显著性图来评估视听一致性。

而音频特征提取则是通过分析音频信号中的频率、幅度和时域特征等来衡量音频的一致性。

相应性检测则是通过计算图像和声音的对应关系,判断它们是否在时间和空间上协调一致。

与客观评估方法相比,主观评估方法,例如用户调查和感知质量评估,可以更直接地了解用户对多媒体数据视听一致性的感受和满意度。

用户调查可以通过问卷和实验等方式收集用户的意见和反馈,以评估多媒体数据的视听一致性。

感知质量评估则是通过让观众对多媒体数据进行主观打分,从而推测其视听一致性情况。

这种方法可以考虑到用户对不同内容和媒体的主观感受,更贴近真实的使用场景。

除了视听一致性评估,质量评估也是多媒体数据研究中的重要内容。

质量评估主要是衡量多媒体数据的感知质量,包括图像清晰度、音频还原度等方面。

传统的质量评估方法主要基于主观评价,即通过观众的主观感受和打分来判断多媒体数据的质量。

然而,主观评价不仅需要大量的时间和人力资源,而且结果的可靠性和客观性存在一定的问题。

Blue Coat视频会议质量保障解决方案通过CSTC评测

50 50系列 的 5 双路机 架 式服 务器产 品 ,具有极 高 的全方 U

位 安全 防 护能 力 ,强劲 的计 算 、存 储 和输 入 /输 出性能 ,计 等 、 KI 安 全产 品和 技术 提供 灵活 的扩 展接 口。() 4 安全 集 中管理 。

浪 潮信 息安全 事业 部相 关 负责人 指 出 ,一直 以来 ,安

全 技 术 防范 的 目标 是 防 外 ,近 年 来 也逐 渐 重 视 防 内。但 信 息安全 存 在短 板效 应 ,这就 是 主机 ( 服务 器 ) 身 的安 本

全 。在主机 安全 的初期 ,主 要是 针对操 作 系统 的安全 ,针 对这 一 方面 ,浪潮 在 2 0 0 6年推 出了服 务 器 安全 加 固 系统 S R,是 国 内首款操 作 系统 内核 级 别安全 产品 ,基 本免 疫 S 了针对 服务 器操作 系统 的攻 击 , 受 已知或 未知病 毒程 序 、 免

通过 运营 视 图 ,可 以便 捷地 对各 类型 安全服 务器 进行 集中 管理 ,包括安 全状 态 的反馈 ,安全 策 略的分 发等 ,直观 而

适 用于对 安全性 要求 高 、处 理 速度 、运算 能力 有较高 要求

的应 用环境 ;同时兼具 高 可靠 的系统设 计 ,完全 胜任 关键 业务 7 4小时 不 问断运行 的需求 。 2 X

容 易操作 ,降 低管理 难度 。

浪潮 表 示 ,浪潮 安全 服务器 要为 政府 、军 工 、公安 等 涉密 单位 以及金 融 、 电力、 电信 、能源 等重点 企业铸 就最

一 并 结

访 问控 制 、入侵检 测 、 内容 过滤 、 网络 阻断 、强制 访 问控

视频显著性检测与目标跟踪技术

视频显著性检测与目标跟踪技术随着科技的不断发展,计算机视觉技术已经成为了一个非常热门的研究领域。

视频显著性检测与目标跟踪技术是其中两个重要的研究方向,本文将从基础概念开始,进行系统的介绍和探讨。

一、视频显著性检测视频显著性检测(Video Saliency Detection)是计算机视觉领域的一个分支,是指在视频中寻找最具有显著性的图像,即使得其在视觉效果上“脱颖而出”,从而引起人眼的注意力。

在很多应用场景中,显著对象的提取是非常重要的,因为显著对象可以吸引我们的注意力,帮助我们更好的理解视频中所表达的内容。

视频显著性检测算法的核心思想是通过分析视频帧中图像的亮度、颜色、纹理等特征,并结合运动、前后景等信息提取显著对象。

常见的算法有频域方法、时域方法、空间域方法等。

其中时域方法是基于细胞自动机模型,其原理是通过对前后两帧之间的差异进行判定,以确定显著对象。

在实际应用中,视频显著性检测主要用于视频编辑、场景分析、目标跟踪等领域。

例如在视频编辑中,将显著对象作为一个单独的元素进行编辑,可以提高整体的视觉效果。

二、目标跟踪目标跟踪(Object Tracking)是计算机视觉领域的另一项重要技术,指的是在视频中跟踪目标对象的位置、大小等状态。

在实际应用中,目标跟踪技术可以帮助我们跟踪运动中的物体,比如在行车记录仪中跟踪车辆、在安防监控中跟踪嫌疑人等。

目标跟踪技术的核心思想是根据目标对象的特征进行跟踪。

其中,常见的特征包括颜色、纹理、形状等。

目标跟踪算法可以分为基于颜色直方图的方法、基于模板匹配的方法、基于卡尔曼滤波的方法等。

目标跟踪技术的难点在于对目标特征的提取和跟踪过程中的漂移问题。

针对这些问题,目前研究者提出了许多解决方案,比如基于深度学习的目标跟踪算法、基于多目标跟踪的算法等。

三、视频显著性检测与目标跟踪的结合视频显著性检测和目标跟踪在实际应用中经常会结合起来使用。

在这种情况下,通过利用显著性检测提取视频中的显著对象,然后对显著对象进行目标跟踪,可以提高跟踪的效果和准确度。

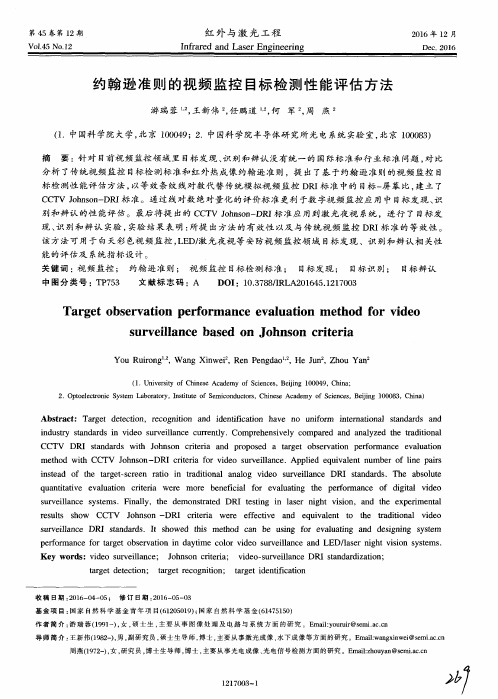

约翰逊准则的视频监控目标检测性能评估方法

s u r v e i l l a n c e b a s e d o n J o h n s o n c r i t e r i a

Yo u Ru i r o n g ,W a n g Xi n we i ,Re n Pe n g d a o ,He J u n ,Zh o u Ya n 。

游瑞 蓉 . - , 王 新伟 。 , 任 鹏道 . - , 何 军 , 周 燕z

( 1 .中国科 学院大 学 , 北京 1 0 0 0 4 9 ;2 .中国科 学院半 导体研 究所光 电 系统 实验 室 , 北京 1 0 0 0 8 3 )

摘 要 :针 对 目前视频 监控 领域 里 目标发 现 、 识 别和辨 认 没有 统一 的 国 际标 准 和行 业标 准 问题 , 对 比 分析 了传 统视频 监控 目标检 测标 准和 红外 热成像 约翰 逊 准则 ,提 出了基 于 约翰 逊 准 则 的视 频 监控 目 标 检 测性 能评估 方 法 , 以等 效条 纹 线对数 代 替传 统模 拟视 频 监控 DR I 标 准 中的 目标一 屏幕比, 建立了 C C T V J o h n s o n — D R / 标 准。通 过 线对数 绝 对量化 的评 价标 准 更利 于数 字视 频 监控 应 用 中 目标发 现 、 识

该 方法 可 用于 白天 彩 色视 频 监控 , L E D/ 激光 夜视 等安 防视频 监 控领 域 目标 发现 、识 别和 辨认 相 关性

能 的 评 估 及 系统 指 标 设 计 。

关键 词 : 视 频监 控 ; 约翰 逊 准则 ; 视 频监 控 目标检 测 标 准 ; 目标发 现 ; 目标识 别 ; 目标辨认

别 和辨认 的性 能评 估 。最后 将提 出的 C C T V J o h n s o n — D R I 标 准应 用到 激光 夜视 系统 ,进 行 了 目标发

视频处理_(IEEE跟踪和监控性能评估国际专题讨论会(PETS 2006))

IEEE International Workshop on PerformanceEvaluation of Tracking and Surveillance(PETS 2006)(IEEE跟踪和监控性能评估国际专题讨论会(PETS 2006))数据摘要:The data-sets are multi-sensor sequences containing left-luggage scenarios with increasing scene complexity.The aim of this workshop is to use existing systems for the detection of left (i.e. abandoned) luggage in a real-world environment. The scenarios are filmed from multiple cameras and involve multiple actors.中文关键词:PETS,多摄像头,扔弃,遗留行李,真实环境,英文关键词:PETS,multi-sensor,abandon,left-luggage,real-world environment,数据格式:VIDEO数据用途:Surveillance of public spaces, detection of left luggage events.数据详细介绍:PETS 2006 Benchmark DataOverviewThe data-sets are multi-sensor sequences containing left-luggage scenarios with increasing scene complexity. The results of processing the datasets are to submitted in XML format (details below).Please e-mail datasets@ if you require assistance obtaining these data-sets for the workshop.Aims and ObjectivesThe aim of this workshop is to use existing systems for the detection of left (i.e. abandoned) luggage in a real-world environment. The scenarios are filmed from multiple cameras and involve multiple actors.Definition of Left-LuggageLeft-luggage in the context of PETS 2006 is defined as items of luggage that have been abandoned by their owner. In the published scenarios each item of luggage has one owner and each person owns at most one item of luggage.To implement a system based on this definition there are three additional components that need to be defined:A.What items are classed as luggage? Luggage is defined to include all types of baggage that can be carried by hand e.g. trunks, bags, rucksacks, backpacks, parcels, and suitcases.Five common types of luggage are considered in this study:1. Briefcase2. Suitcase3. 25 litre rucksack4. 70 litre backpack5. Ski gear carrierB.What constitutes attended and unattended luggage? In this study three rules are used to determine whether luggage is attended to by a person (or not):1. A luggage is owned and attended to by a person who enters the scenewith the luggage until such point that the luggage is not in physicalcontact with the person (contextual rule).2. At this point the luggage is attended to by the owner ONLY when theyare within a distance a metres of the luggage (spatial rule). All distances are measured between object centroids on the ground plane (i.e. z=0).The image below shows a person within a (=2) metres of their luggage.In this situation no alarm should be raised by the system.3. A luggage item is unattended when the owner is further than b metres(where b>=a *) from the luggage. The image below shows a personcrossing the line at b(=3) metres. In this situation the system should use the spatio-temporal rule in item C, below, to detect whether this item of luggage has been abandoned (an alarm event).* If b > a, the distance between radii a and b is determined to be a warning zone where the luggage is neither attended to nor left unattended. This zone is defined to separate the detection points of the two states, reducinguncertainties introduced due to calibration / detection errors in the sensor system etc. The image below shows a person crossing the line at a (=2) metres, but within the radius b (=3) metres. In this scenario the system can be set up to trigger a warning event, using a rule similar to the spatio-temporal rule in item C, below. Both warning and alarm events will be given in the ground truth.C. What constitutes abandonment of luggage by the owner? The abandonment of an item of luggage is defined spatially and temporally. Abandonment (causing an alarm) is defined as:1. An item of luggage that has been left unattended by the owner for aperiod of t consecutive seconds in which time the owner has notre-attended to the luggage, nor has the luggage been attended to by a second party (instigated by physical contact, in which case a theft /tampering event may be raised). The image below shows an item ofluggage left unattended for t (=30) seconds, at which point the alarmevent is triggered.Calibration DataThe geometric patterns on the floor of the station were used for calibration purposes. The following point locations were used as the calibration pattern (click to view full 1800x500 resolution image):All spatial measurements are in metres. The provided calibration parameters were obtained using the freely available Tsai Camera Calibration Software by Reg Willson. For instructions on how to use Reg Willsons software visit Chris Needhams helpful page. More information on the Tsai camera model is available on CVonline.An example of the provided calibration parameter XML file is given here. This XML file contains Tsai camera parameters obtained from Reg Willsons software (output file), using this reference image and this set of points. C++ code (available here) is provided to allow you to load and use the calibration parameters in your program (courtesy of project ETISEO).The DV cameras used to film all data-sets are:Camera 1: Canon MV-1 1xCCD w/progressive scanCamera 2: Sony DCR-PC1000E 3xCMOSCamera 3: Canon MV-1 1xCCD w/progressive scanCamera 4: Sony DCR-PC1000E 3xCMOSThe resolution of all sequences are PAL standard (768 x 576 pixels, 25 frames per second) and compressed as JPEG image sequences (approx. 90% quality).XML schemaAll scenarios come with two XML files. The first of these files contains camera calibration parameters, these are given in the sub-directory 'calibration'. See the previous section (Calibration Data) for information on this XML file format.The second XML file (given in the sub-directory 'xml') contains both configuration and ground-truth information. This xml format is also used for submission of results.The XML schema for the configuration / ground-truth / submission isgiven here.The XML files provided contain scenario details, parameters and ground-truth information (e.g. the radii distances, luggage location, warning / alarm triggers etc). A fully commented example of the provided XML is given here.For submitted XML not all details need to be provided. An example of the (minimum) data to be submitted is given here.Dataset S1 (Take 1-C)Scenario: left luggageElements: 1 person, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains a single person with a rucksack who loiters before leaving the item of luggage unattended.Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S1-T1-C.zip, (1.10Gb)Dataset S2 (Take 3-C)Scenario: left luggageElements: 2 people, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains two people who enter the scene from opposite directions. One person places a suitcase on the ground, before both people leave together (without the suitcase).Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S2-T3-C.zip, (0.93Gb)Dataset S3 (Take 7-A)Scenario: left luggageElements: 1 person, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains a person waiting for a train, the person temporarily places their briefcase on the ground before picking it up again and moving to a nearby shop.Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S3-T7-A.zip, (0.88Gb)Dataset S4 (Take 5-A)Scenario: left luggageElements: 2 people, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains a person placing a suitcase on the ground. Following this a second person arrives and talks with the first person. The first person leaves the scene without their luggage. Distracted by a newspaper, the second person does not notice that the first persons luggage is left unattended.Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S4-T5-A.zip, (1.04Gb)Dataset S5 (Take 1-G)Scenario: left luggageElements: 1 person, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains a single person with ski equipment who loiters before abandoning the item of luggage.Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S5-T1-G.zip, (1.25Gb)Dataset S6 (Take 3-H)Scenario: left luggageElements: 2 people, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains two people who enter the scene together. One person places a rucksack on the ground, before both people leave together (without the rucksack).Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S6-T3-H.zip, (0.98Gb)Dataset S7 (Take 6-B)Scenario: left luggageElements: 6 people, 1 luggage itemGround truth parameters: a = 2 metres, b = 3 metres, t = 30 secondsThis scenario contains a single person with a suitcase who loiters before leaving the item of luggage unattended. During this event five other people move in close proximity to the item of luggage.Sample ImagesThe following images show representative images captured from cameras 1-4.DownloadThe entire scenario including the calibration and ground truth data S7-T6-B.zip, (1.22Gb)Additional InformationThe scenarios can also be downloadedfrom ftp:///pub/PETS2006/ (use anonymous login). Warning: ftp:// is not listing files correctly on some ftp clients. If you experience problems you can connect to the http serverat /PETS2006/.Legal note: The UK Information Commisioner has agreed that the PETS 2006 data-sets described here may be made publicly available for the purposes of academic research. The video sequences are copyright ISCAPS consortium and permission is hereby granted for free download for the purposes of the PETS 2006 workshop.数据预览:点此下载完整数据集。

网络视频监控关键技术

3 固定码率和可变码率编解码

视频编码可以分为可变码率 和固定码率两种。 如采用VBR,压缩软件在压缩时根据音频数据即时确定使用 什么比特率,这是以质量为前提兼顾文件大小的方式。可变码率 视频编码算法中不同图像组的平均码率是可变的数值,它可以根 据图像的内容而变动,保证解码后重建图像的质量恒定,没有大 的起伏。其主要优点是显著的减少了“填充比特”,大大提高了 传输带宽或存储容量的利用率,具有巨大的经济效益,其代价是 编码器的技术难度大,成本高。 CBR是指编码时从头到尾都采用一种速率。相对于VBR和 ABR来讲,它压缩出来的文件体积很大,而且音质相对于VBR 和ABR不会有明显的提高。当输入的图像内容有可能使输出的平 均码率超出额定值时,不得不以牺牲图像局部的、瞬时的主观质 量为代价。另一方面,当图像内容不复杂时,又不得不大量地插 入毫无意义的“填充码”,来维持输出的视频码率为预定的恒定 值。固定码率的视频编码算法简单易行,但编码效率不高。

一种并行的新闻视频镜头检测方法

一

种并行的新闻视 频镜头检测方法

文/ 潘忠平 吴庆波 谭郁松

其Hale Waihona Puke 中,日 ( ) ,H ( ) 分 别为归一化直 在第 个颜 色上 的取值 。如

有 全局 阈值法 、双重 阈值 渐变镜头检 测

从集群 的执行 效率上 看 ,一般主从 存 在 关 键 帧 ,而 且 关 键 帧 间 隔 距 离 ( 3 )各 节 点 处 理 所 分 配 区段 ∽ 视 Ⅳ

“

> ×

州

>一 式并行 方法达到 了最 高 ,但是 由于 视频 没 有 规 则 的 特 点 。 修 改 O p e n C V中 频 帧,计 算 相邻 帧直 方 图差 值 并 求 k 和

法 的愈加复杂 ,镜头检测的处理 时间越

在进行镜 头边界检测 时,顺序计算

来越长 ,已经成为 新闻视频分析 和检索 视频流相邻两 帧的直方 图差异 ,当此差

技术 发展 应用的瓶 颈。所 以 ,在 能够保 异值大于某个 预先设定 的阈值 时,说 明 证检 测效果的 同时 ,缩短 大量的镜头检 两帧 问发生了较大 的变化 ,即认 为它们 测处理 时间就非常重要 。随着并行计算 之间存在一个 镜头突变切换 。

式并行算法 。

( 5 )主节 点计 算所有 相邻 帧直方 图差值 的平均值并分发到所有节点 。

( 6 )各节 点根据 阈值 计算切 换 帧

}

>

但 是第 9 5帧不 是 关键 帧 ,其压 缩 算法

2 . 2 . 1 任务分配 。

的关键 帧号 为第 1 o 0帧 ,那么 当前定位 号和数量 r l u m 并输 出。

无参考视频质量评价的泛化性

确保数据集中包含各种类型的视频,并确保每种类型的视频都有足 够的数量,以便模型能够学习到更全面的特征。

数据增强技术

利用数据增强技术,如随机裁剪、旋转、缩放等,增加数据集的大 小和多样性,提高模型的泛化能力。

模型的泛化性

深度学习模型的泛化性

深度学习模型具有强大的表示能 力,但容易过拟合训练数据。为 了提高模型的泛化性,可以使用 正则化技术,如权重衰减、 dropout等,以减少过拟合。

特征比较

跨帧比较

01

将连续帧之间的特征进行比较,以检测视频中的动态变化和稳

定性。

相似度比较

02

将提取的特征与已知高质量视频的特征进行比较,以评估视频

的质量。

差异度比较

03

将提取的特征与已知低质量视频的特征进行比较,以评估视频

的质量。

质量评估

主观质量评估

通过人类观察者对视频进行质量评估,以获得准确的 评价结果。

通过实验验证,该方法在不同场景下均表现出良好的泛化性能

,能够适应不同的视频内容和质量变化。

与传统方法相比,该方法具有更高的准确性和稳定性,能够更

03

好地满足实际应用需求。

研究不足与展望

虽然本文提出的方法在实验中取得了较 好的效果,但在实际应用中仍存在一些 局限性,例如对于某些特殊场景或复杂 视频的处理能力有待进一步提高。

实验结果

泛化性能

在多个不同数据集上测试 模型的泛化性能,包括自 然场景、室内场景、高清 和标清等。

准确性

评估模型在不同数据集上 的准确性,包括客观评价 指标如PSN分辨率、 不同压缩比、不同编码格 式等条件下的鲁棒性。

结果分析

01

对比分析

ITTC – Recommended Procedures and Guidelines

Loads and Responses, Seakeeping Experiments on Rarely OccurringEventsEffective Date 2002 Revision01Updated byApprovedLoad and Responses Committee of 23rd ITTC23rd ITTCDate 2002 DateTable of Contents1 PURPOSE OF PROCEDURE……...2 2STANDARDS FOR EXPERIMENTS ON RARELY OCCURRINGEVENTS……………………………….2 2.1 Previous Recommendations ofITTC.................................................2 2.2 Model Design and Construction....2 2.3Standard for Duration andRepetition of Test Runs (2)2.4 Video Recording..............................3 2.5Criteria (3)3 PARAMETERS………………………..34 VALIDATION…………………………3 4.1 Uncertainty Analysis.......................3 4.2Benchmark Tests (3)Loads and Responses, Sea Keeping Experiments on Rarely OccurringEvents Effective Date2002Revision01Experiments on Rarely Occurring Events1PURPOSE OF PROCEDUREThe rarely occurring events are associated with slamming, green water, large amplitude motion, acceleration, etc. of ships and offshore structures.Purpose of this procedure is to de-fine standards for experiments on rarely occur-ring events.2STANDARDS FOR EXPERIMENTS ON RARELY OCCURRING EVENTS2.1Previous Recommendations of ITTC1987 pp 525 When performing tests on moored systems special note should be taken of the lack of model/full scale correlation of the low frequency motions, the importance of the system damping, and the potentially important scale effects on damping that may influence the results of the tests.1996 pp 295 Recent studies carried out with multi or single point moored vessels have shown that most severe loads do not occur when wind, wave and current are co-linear and therefore it is necessary to consider the point probabilities of both the magnitude of the wind, wave and current parameters and their direc-tion. 2.2Model Design and ConstructionThe model scale should be as large as prac-ticable with respect to the test facility em-ployed and appropriate to enable the requisite of full scale significant wave height to be gen-erated.The model should be complete up to the upper-most weather deck, including forecastle, bulwarks, deck fittings, deckhouses and freeing ports. The model should be equipped with ex-ternal appendages such as bilge keels, rudder, or fins as may reasonably be expected to influ-ence the results of the tests.It is recommended that ship models should be self-propelled and remotely controlled, ei-ther by radio or by a light umbilical attach-ment; or towed from a carriage equipped with the capability for free-to-surge under constant towing force, with freedom to heave, pitch and roll.2.3Standard for Duration and Repetitionof Test RunsThe following interim recommended proce-dure for experiments on rarely occurring events is proposed:Experiments to determine the statistics of rarely occurring events such as slamming and deck wetness in irregular waves should last for a minimum of one hour for ship and threeLoads and Responses, Sea Keeping Experiments on Rarely OccurringEvents Effective Date2002Revision01hours for moored floating offshore structures (full scale equivalent). Care should be taken to avoid a repeating wave time history. Alterna-tively, selected time histories with rare wave events can be used instead. In comparative tests (e.g. to establish the relative merits of different designs) the wave conditions should be chosen so that a substantial number of events occur.2.4Video RecordingVideo recording of test and rarely occurring events is recommended.2.5CriteriaCriteria for acceptable motions and other rough weather phenomena are all too often not related to specific activities of the ship. The Committee recommends that ship model basins should play a more active role in determining criteria and that:a.Criteria should relate to responses thatare of specific importance to the mis-sion considered.b.Acceptable response levels should bedetermined by long term monitoring ofdata, trials, questionnaires or discus-sions with the operators.3PARAMETERSThe following parameters could be taken into account: •Relative water level at different hull posi-tions•Accelerations•Instrumentation to measure roll and pitch angles, and heave position may be deemed helpful•Frequency of deck wetness•Volume of water accumulated during each test run•Impact loads (pressure or forces, moments) due to green water or slamming•State dynamic properties of model, such as stiffness and natural periods•Waves4VALIDATION4.1Uncertainty AnalysisNone4.2Benchmark Tests1) Seagoing Quality of Ships(7th 1955 pp.247-293)A Model of the Todd-Forest Series 60,Cb=0.60:7 tanks used 5ft. models, 2 tanks used 10 ft.models, and 1 tank used 16 ft. model Froude Numbers 0,0.18,0.21,0.24,0.27 and0.30The Ratio wave height to the Length of the Model: 1/36 1/48 1/60 1/72 for Wave Length 0.75L 1.0L 1.25L 1.5L 2) Comparative Tests in Waves at Three Ex-perimental Establishments Using the Same Model(11th 1966 pp.332-342)Loads and Responses, Sea Keeping Experiments on Rarely OccurringEvents Effective Date2002Revision01British Towing Tank Panel: A 10 ft. Fibre-Glass Model of the S.S.CairndhuA Series of Experiments on a Ship Model inRegular Waves Using Different Test Tech-niquesData Obtained in Irregular and Transient Waves and Some Result Predicted by theTheory (Based on Korvin Kroukovsky's Work and Employing the Added Mass andDamping Coefficients Calculated by Grim) 3) Full Scale Destroyer Motion Measurements(11th l966 pp.342-350)Full Scale Destroyer Motion Tests in HeadSeaComparison among Motion Response Ob-tained from Full Scale Tests, Model Ex-periments and Computer CalculationsThe Destroyer H.M. "Groningen” of the Royal Netherlands NavyA Scale Ration 40 to 14) Comparison of the Computer Calculations ofShip Motions (11th 1966 pp.350-355)ShipResponseFunctionsfortheSeries60Cb=0.70 Parent Form5) Computer Program Results for Ship Behav-iour in Regular Oblique Waves(11th l966 pp.408~-411)Series 60, Cb=0.60 and 0.70 Parent FormDTMB Model 421OW and 4212W6) Experiments in Head Seas6-1) Comparative Tests of a Series 60 Ship Model in Regular Waves(11th 1966 pp.411-415)Series 60 Cb=0.60 6-2) Experiments on Heaving and Pitching Motions of a Ship Model in Regular Longi-tudinal Waves (11th 1966 pp.415-418)Series 60 Cb=0.606-3) Experiments on the Series 60, Cb=0.60 and 0.70 Ship Models in Regular Head Waves(11th 1966 pp.418-420)Series 60, ~Cb=0.60 and 0.706-4) Comparison of Measured Ship Motions and Thrust Increase of Series 60 Ship Mod-els in Regular Head Waves (11th 1966 pp.420-426)Series 60, ~Cb=0. 60 and 0. 706-5) Estimation of Ship Behaviour at Sea from Limited Observation (11th 1966 ~pp.426-428)7) Computer Results, Head Seas7-1) Theoretical Calculations of Ship Motions and Vertical Wave Bending Moments in Regular Head Seas (11th 1966 pp. 428-430) Series 60, Cb=0.707-2) Comparison of Computer Program Results and Experiments for Ship Behaviour in Regular Head Seas (11th l966 pp.430-432)Series 60, ~Cb=0.60 and 0.707-3) Computer Program Results for Ship Be-haviour in Regular Head Waves(11th 1966 pp.433-436) Series 60, Cb=0.60 and 0.70 Parent Form DTMB Model 421OW and 4212W7-4) Comparison of Calculated and Measured Heaving and Pitching Motions of a SeriesLoads and Responses, Sea Keeping Experiments on Rarely OccurringEvents Effective Date2002Revision0160, Cb=0.70 Ship Model in Regular Longi-tudinal Waves (11th 1966 pp.436-442)Series 60, Cb=0.707-5) Computer Calculations of Ship Motions (11th 1966 pp.442)7-6) Comparison of the Computer Calculations of Ship Motions and Vertical Wave Bending Moment ( 11th 1966 pp. 442-445)Series 60, Cb=0.60 and 0.708) Comparison of the Computer Calculationsfor Ship Motions and Seakeeping Qualities by Strip Theory (14th 1975 Vol.4pp.341-350)A Large-Sized Ore Carrier9) Comparison on Results Obtained with Com-puter Programs to Predict Ship Motions in Six Degrees of Freedom(15th 1978 pp. 79-90)S-175, Cb = 0. 57210) Comparison of Results Obtained withCompute Programs to Predict Ship Motions in Six-Degrees-of-Freedom and Associated Responses (16th 1981 pp.217-224)To Identify the Differences in the Various Strip Theories and Computation Procedures utilised by the Various Computer Programsand Provide Guidance for Improvement if NecessaryS-175 Container Ship for Fn = 0.27511) Analysis of the S-175 Comparative Study(17th 1984 pp.503-511)12) S-175 Comparative Model Experiments(18th 1987 pp.415-427)13) Rare Events(19th 1990 pp.434-442, Seakeeping)14) Validation Standards of Reporting and Un-certainty Analysis Strip Theory Predictions ( 19th 1990 pp.460-464)15) ITTC Database of Seakeeping Experiments(20th 1993 pp.449-451)Two Dimensional Model, Wigley Hull Form, S-17516) Validation of Seakeeping Calculations (21st1996 pp.41-43)Basic Theoretical LimitationsNumerical Software Engineering Aspects 17) ITTC Database of Seakeeping Experiments(21st 1996 pp.43)S-175, High Speed Marine Vehicle。

GAT_1400.3-2017公安视频图像信息应用系统_第3部分:数据库技术要求

目次

GA/T 1400.3—2017

前 言 ............................................................................... VI

1 范围 ................................................................................1 2 规范性引用文件 ......................................................................1 3 术语、定义和缩略语 ..................................................................2

附 录 A (规范性附录) 视图库对象特征属性 .......................................... 12

A.1 采集设备对象 .....................................................................12 A.2 采集系统对象 .....................................................................13 A.3 视频卡口对象 .....................................................................13 A.4 车道对象 .........................................................................13 A.5 视频片段对象 .....................................................................14 A.6 图像对象 .........................................................................17 A.7 文件对象 .........................................................................19 A.8 人员对象 .........................................................................20

petsc用户指南

超级计算环境基础并行软件平台建设与应用并行软件开发小组系列测试报告之一PETSc 用户指南中科院计算机网络信息中心超级计算中心Email程强迟学斌冯仰德王建赵永华N C I C-S C-001,S C C A S 2004年8月,北京目录前言1 PETSc简介概况 (1)体系结构 (1)基本特色 (4)安装PETSc (5)2 PETSc的基本对象向量 (7)创建和聚集............................ .. (7)基本运算操作............................ .. (8)索引和排序............................... .. (8)规则网格与DA (9)无结构网格与IS (10)矩阵.......................................................................... . . . (11)创建和聚集............................ . (11)基本运算操作............................ .. (11)无矩阵运算 (12)矩阵的划分........................................ . (12)3 PETSc的基本功能线性方程求解 (13)基本用法............................ ............................ . . .. (13)Krylov子空间方法 (13)预条件子 (14)奇异方程求解 (16)非线性方程求解 (16)基本用法............................ .. (17)非线性解法器............................ .. (17)无矩阵方法............................... .. (17)有限差分雅可比逼近 (18)时间步进积分 (18)基本用法............................ ............................ . . .. (19)求解时间依赖问题...................... ........................... . . (19)求解时间稳态问题...................... ........................... . . (19)其它求解器............................... ................................ (19)PETSc的其他功能 (20)性能分析............................ ................................... . . (20)图形输出.................................. .. (22)调试和错误检测......................... .. (23)PETSc与其它软件 (23)DMMG ............................ .. (24)ADIC/ADIFOR ......................... ................................... . (24)Matlab ............................... ................................ . . . . . . (24)ESI ............................ ....................................... . . . . . . . . .. (24)4 PETSc编程PETSc程序范例 (25)PETSc程序结构 (28)5 PETSc范例测试线性方程求解 (29)范例简介............................... (29)非线性方程求解 (30)范例简介 (30)时间步进积分 (31)范例简介 (31)6 PETSc测试总结参考文献前言通过计算手段进行重大科学发现,已普遍为人们所共识。

智能视频监控中运动目标检测的算法研究

智能视频监控中运动目标检测的算法研究一、本文概述随着科技的飞速发展和技术的广泛应用,智能视频监控在公共安全、智能交通、智能家居等领域扮演着越来越重要的角色。

运动目标检测作为智能视频监控系统的核心技术之一,旨在从监控视频中准确识别并跟踪运动目标,对于提高监控系统的智能化水平和实际应用效果具有重要意义。

本文旨在深入探讨智能视频监控中运动目标检测的算法研究,通过对现有算法的分析、比较和优化,提出一种更加高效、准确的运动目标检测算法,以期推动智能视频监控技术的发展和应用。

本文首先将对智能视频监控系统的基本架构和工作原理进行简要介绍,明确运动目标检测在其中的地位和作用。

接着,将重点回顾和分析现有的运动目标检测算法,包括基于背景减除、帧间差分、光流法等传统算法,以及基于深度学习和卷积神经网络的现代算法。

在此基础上,本文将深入探讨各种算法的优缺点和适用范围,为后续的算法优化和创新提供理论支撑。

本文还将关注运动目标检测算法在实际应用中所面临的挑战和问题,如光照变化、背景干扰、目标遮挡等。

针对这些问题,本文将提出一系列针对性的优化策略和方法,旨在提高算法在复杂环境下的鲁棒性和准确性。

本文将通过实验验证所提算法的有效性和性能,并与现有算法进行比较分析,以证明其在实际应用中的优越性和价值。

本文将总结智能视频监控中运动目标检测算法的研究现状和发展趋势,展望未来的研究方向和应用前景。

通过本文的研究,旨在为智能视频监控技术的发展提供有益的理论和实践支持,推动其在各个领域的应用和推广。

二、相关技术研究综述随着计算机视觉和技术的飞速发展,智能视频监控在运动目标检测方面取得了显著进展。

运动目标检测作为视频监控的核心技术之一,其准确性和实时性对于智能监控系统的性能至关重要。

本节将综述当前运动目标检测的主要算法及其优缺点,为后续研究提供参考。

帧间差分法是一种基于连续帧之间像素差异的运动目标检测方法。

它通过比较相邻帧之间的像素变化来检测运动物体。

CVPR2013_Benchmark翻译

在线目标跟踪:一种评估基准吴毅Jongwoo Lim 杨明玄摘要目标跟踪是计算机视觉大量应用中的重要组成部分之一。

近年来,尽管在分享源码和数据集方面的努力已经取得了许多进展,开发一套库和标准用于评估当前最先进的跟踪算法仍然是极其重要的。

在简单回顾近年来在线目标跟踪的研究进展后,我们以多种评价标准进行了大量的实验,用于研究这些算法的性能。

为了便于性能评估和分析,测试图片序列分别被标注了不同的特性。

通过定量分析结果,我们得出了实现鲁棒性跟踪的有效方法,并给出了目标跟踪领域潜在的未来研究方向。

1.介绍在计算机视觉的许多不同应用之中,目标跟踪是最重要的组成部分之一。

比如监视、人机交互和医疗图像[60,12]。

在视频的一帧中,目标的初始状态(比如位置和尺寸)是给定的,跟踪的目的就是在随后的帧中评估出目标的状态。

尽管目标跟踪问题已经被研究了数十年,近年来也取得了许多进展[28, 16, 47, 5, 40, 26, 19],但它仍是一个非常具有挑战性的问题。

大量因素影响着跟踪算法的性能,比如光照变化、遮挡和杂乱的背景,目前也不存在单一跟踪方法可以成功地处理所有的应用场景。

因此,评估这些最先进的跟踪器的性能以展示其优势和弱点是至关重要的,而且有助于明确该领域未来的研究方向,从而设计出更加鲁棒的算法。

对于综合性能评估,收集具有代表性的数据集是极其重要的。

目前已经存在一些针对监控场景中视觉跟踪的数据集,比如VIVID [14],CA VIAR [21]和PETS数据集。

然而,这些监控序列中的目标对象通常是人或小尺寸的车,并且背景通常都是静态的。

尽管有一部分普通场景下的跟踪数据集[47, 5, 33]被标定好了边界框,但是绝大部分并没有被标定好。

对于那些没有被标注ground truth的序列,评估跟踪算法是困难的,因为结果是基于不一致的目标标注位置。

近年来,更多的跟踪源码已经可以公开获得,比如OAB [22],IVT [47],MIL [5],L1 [40]和TLD [31]算法,这些算法通常都被用于评估。

浅谈北京奥运会报道上的ENG系统---鉴定专业水准的“第三只眼睛”

浅谈北京奥运会报道上的ENG系统---鉴定专业水准的“第三只眼睛”摘要:eng现场单机采访以直观、快速的特点成为奥运会电视报道的主力,作为“eng”主体的专项记者必须具备过硬的职业素质和较高的专业水平。

“eng”系统的指挥者要有高瞻远瞩的宏观意识和处变不惊的调度能力,这也是各个媒体奥运报道竞争的关键所在。

关键词:奥运会报道专业素质eng系统万众瞩目的第29届奥运会即将到来,对于各个行业来说,这都是一次机遇,一次挑战。

作为媒体宣传中的电视报道,以直观、快速、广泛的特点,成为受众率最高的报道形式。

那么,如何做好奥运会的电视报道,就成为我们电视工作者的重要课题。

奥运会的电视报道一共有三个层次:就北京奥运会而言:第一层次是bob提供的公用信号,由专业从事赛事转播的国际团队完成;第二层次是电视台所构建的现场演播室、场外演播室系统和支撑、补充这个系统的“单边注入点”系统;第三层次就是eng系统(electron news gathering),我们俗称为现场单机采访组。

对于奥运会的电视报道而言,“第一层次”是事件;“第二层次”是看事件的两只“眼睛”;第三层次是“第三只眼睛”。

三个电视系统,给受众提供的视角是不同的:“第一系统”是国际视角,虽然组成这个系统的人员来自世界各地,难免在一些赛事的信号制作中具有一些“国别”特征(例如澳大利亚人对于游泳、中国人对于乒乓球),但是总体而言,他们制作的信号是国际性的。

“第二系统”是国家视角,例如在北京奥运会上,演播室和“单边注入点”承担的功能,是代表中国的。

这个系统所关注的,当然主要是中国运动员和中国代表团的其他成员,就这一点而言,她是有明显倾向性的。

但是,由于这种倾向性代表媒体的观点,因此她必须是适可而止的、经过深思熟虑的、具有“导向”意识的。

换言之就是:可以有倾向性,但不应该是绝对的倾向性。

“第三系统”是个性视角,用现场采访记者的眼睛去表现赛场上有看点、有趣味、有意义的事件。

视频分析技术在实物保护系统上的应用分析

视频分析技术在实物保护系统上的应用分析刘建;伍文飞;陈华平;张继伟【摘要】Physical protection systems undertakes the responsibility of protection of nuclear material and nuclear facilities, video surveillance systems are an important part of physical protection systems for nuclear power plants. Has only recorded general video surveillance systems, storage, transmission, display, features related to scene, video analysis, you can automatically analyze the scene, identify the anomalies in the scene in real time, in order to effectively assist security officers will be on duty to deal with nuclear power plant safety and security related events. Based on video analysis technology applied to physical protection systems for nuclear power plants need, significance and major difficulties described,the expectations for video analysis technology to provide reference to the application of physical protection systems for nuclear power plants.%实物保护系统承担着保卫核材料及核设施的重任,视频监控系统是核电厂实物保护系统的重要组成部分。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

IEEE International Workshop on PerformanceEvaluation of Tracking and Surveillance(PETS)2001(IEEE跟踪和监控性能评估国际专题讨论会(PETS)2001)数据摘要:PETS'2001 consists of five separate sets of training and test sequences, i.e. each set consists of one training sequence and one test sequence.All the datasets are multi-view (2 cameras) and are significantly more challenging than for PETS'2000 in terms of significant lighting variation, occlusion, scene activity and use of multi-view data.中文关键词:PETS2001,跟踪,监控,多视角,光线变化,遮挡,英文关键词:PETS2001,tracking,surveillance,multi-view,lightingvariation,occlusion,数据格式:VIDEO数据用途:Outdoor people and vehicle tracking (two synchronised views; includes omnidirectional and moving camera) (annotation available).数据详细介绍:PETS2001 DatasetsDatasetPETS'2001 consists of five separate sets of training and test sequences, i.e. each set consists of one training sequence and one test sequence.All the datasets are multi-view (2 cameras) and are significantly more challenging than for PETS'2000 in terms of significant lighting variation, occlusion, scene activity and use of multi-view data.The annotation (ground truth) for the datasets is available here.Dataset 1 (training = 3064 frames, testing = 2688 frames): Moving people and vehicles. The camera calibration may be found here.Dataset 2 (training = 2989 frames, testing = 2823 frames): Moving people and vehicles. The camera calibration may be found here.Dataset 3 (training = 5563 frames, testing = 5336 frames): Moving people. This is a more challenging sequence in terms of multiple targets and significant lighting variation. The camera calibration may be found here.Dataset 4 (training = 6789 frames, testing = 5010 frames): Moving people and vehicles (catadioptric vision) - one narrow field of view, one panoramic. The camera calibration may be found here.Dataset 5 (training = 2866 frames, testing = 2867 frames): Moving vehicle (forward and rear views). The camera calibration may be found here.For each dataset∙the training directory contains a training set of frames in both QuickTime movie format with Motion JpegA compression and as individual Jpegimages. The directory contains frame synchronised images for the two cameras.∙the test directory contains a training set of frames in both QuickTime movie format with Motion JpegA compression and as individual Jpegimages. The directory contains frame synchronised images for thetwo cameras.The annotation (ground truth) for the datasets is available here.VERY IMPORTANT INFORMATIONThe tracking results that you report in your paper submission∙should be performed using the test sequences, but the training sequences may optionally be used if the algorithms require it forlearning etc.∙may be based on a single camera view of the scene (CAMERA1), or using the dual-view data (the approach used must be clearly stated inthe paper).The tracking can be performed on the entire test sequence, or a portion of it. The images may be converted to any other format as appropriate, e.g. subsampled to half-PAL, or converted to monochrome. All results reported in the paper should clearly indicate which part of the test sequence is used, ideally with reference to frame numbers where appropriate.The tracking results must be submitted along with the paper, with the tracking results generated in XML format.This will be straightforward and should not add a significant overhead to your effort. The results you provide will be used to perform automatic performance evaluation.The paper that you submit may be based on previously published tracking methods/algorithms (including papers submitted to the main CVPR conference). The importance is that your paper MUST report results on tracking using the datasets supplied.The recommendation is that:∙you attempt to track the objects (people or vehicles or both) in Datasets1 or2 first and report tracking results on the test sequences for thesedatasets in the paper. (note that you need only use single-view databut you may use both views of the same scene (frame synchronised) if your algorithms/methods of tracking allow it.) The pre-requisite forsubmitting your paper to the workshop is that you minimally reporttracking results on either OR both of datasets 1 and 2.∙if you have been successfully completed the above, attempt Dataset 3 & possibly 4 (if you are interested in catadioptric vision) which aresignificantly longer in length and include significant lighting variation.∙Dataset 5 is primarily included for those people interested in moving cameras. Your paper may report results on this dataset alone.If you have any queries please email pets2001@.数据预览:点此下载完整数据集。