半马尔可夫过程

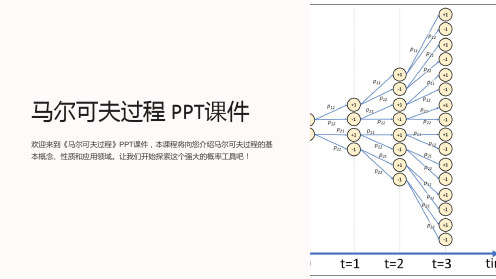

《马尔可夫过程 》课件

马尔可夫过程的应用实例

隐马尔可夫模型

隐马尔可夫模型是一种概率模型,常用于语音 识别、手写识别和自然语言处理等领域。

马尔可夫链蒙特卡罗法

马尔可夫链蒙特卡罗法是一种随机模拟方法, 用于估计复杂概率分布的数值解。

马尔可夫决策过程

马尔可夫决策过程是一种用来模拟决策问题的 数学框架,常应用于人工智能和运筹学领域。

马尔可夫过程的应用

自然语言处理

马尔可夫过程在自 然语言处理中被广 泛应用于语言模型 和信息检索等领域。

机器学习

马尔可夫过程是许 多机器学习算法中 的核心概念,如隐 马尔可夫模型和马 尔可夫决策过程。

金融市场分析

马尔可夫过程被用 于预测金融市场的 变化趋势和风险评 估。

生态学模型

马尔可夫过程能够 模拟生态系统中的 物种迁移和数量变 化,帮助研究者理 解生态系统的动态。

1 唯一性

2 可逆性

马尔可夫链的过渡概率是唯一确定的,无 论起始状态如何。

某些马尔可夫链具有可逆性,可以在时间 上逆转而保持同样的概率性质。

3 ቤተ መጻሕፍቲ ባይዱ态分布

4 马尔可夫链收敛于定态分布

马尔可夫链能够收敛于某个稳定的定态分 布。

随着时间的推移,马尔可夫链的状态会趋 向于定态分布,并在该分布上进行随机转 移。

PageRank算法

PageRank算法是根据网页之间的链接关系进行 排名的算法,被Google用于搜索引擎的搜索结 果排序。

结论

马尔可夫过程是一种强大的概率工具,它在不同的领域有着广泛的应用。深 入研究马尔可夫过程可能会带来更多的应用和发现。

参考文献

• [1] 马尔可夫过程 - 维基百科 • [2] 黄永宏《马尔可夫过程与随机游动》 • [3] 李航《统计学习方法》第10章

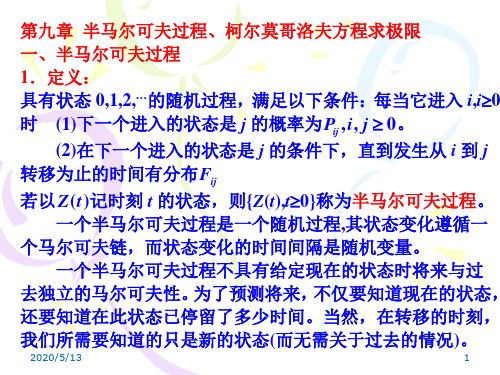

第09章 半非马尔可夫过程,柯尔莫哥洛夫方程求极限

占的比率。 2018/11/3

4

定理 4.8.3

假设命题 4.8.1 的条件成立,且进一步假设嵌

入马尔可夫链{Xn,n0}是正常返的,则 Pi

i i

j

j

j

证明 定义记号如下: Yi ( j )=第 j 次到达状态 i 后在状态 i 逗留的时间,i,j0。 N i ( m ) =在半马尔可夫过程的前 m 次转移中到达状态 i 的 次数。 利用上述记号可见,在前 m 次转移中处于状态 i 的时间的 比率(记为 Pi m )如下: Ni ( m ) N i ( m ) N i ( m ) Yi ( j ) Yi ( j ) m j 1 j 1 N i ( m ) (4.8.1) Pi m N i ( m ) Ni (m ) N i (m ) Yi ( j ) Yi ( j ) m i 0 j 1 i 0 j 1 N i ( m )

4.极限状态概率 以Tii 记相继进入状态 i 之间的时间,且令 ii E[Tii ]。运用交 错更新过程理论,导出半马尔可夫过程的极限概率的表达式 命题 4.8.1 若半马尔可夫过程是不可约的,且Tii 具有非格点的分布与 有限的均值, 则 Pi lim P{ Z ( t ) i | Z (0) j }存在且与初始状态

j

以 i 记其均值,即 i xdH i ( x )

0

3.嵌入马尔可夫链 若以 Xn 记第 n 个到达的状态, 则{Xn,n0}是一个转移概率为 Pij 的马尔可夫链, 它称为半马尔可夫过程的嵌入马尔可夫链。 若 此嵌入马尔可夫链是不可约的, 则称此半马尔可夫过程是不可 约的。 2018/11/3 2

马尔可夫决策过程简介(Ⅰ)

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process, MDP)是一种用于描述随机决策问题的数学框架。

它是由苏联数学家安德雷·马尔可夫在20世纪初提出的,被广泛应用于控制理论、人工智能、经济学等领域。

马尔可夫决策过程的核心思想是通过数学模型描述决策者在具有随机性的环境中做出决策的过程,以及这些决策对环境的影响。

本文将介绍马尔可夫决策过程的基本概念和应用。

1. 随机过程马尔可夫决策过程是建立在随机过程的基础上的。

随机过程是指随机变量随时间变化的过程,它可以用来描述许多自然现象和工程问题。

在马尔可夫决策过程中,状态和行动都是随机变量,它们的变化是随机的。

这种随机性使得马尔可夫决策过程具有很强的适用性,可以用来描述各种真实世界中的决策问题。

2. 状态空间和转移概率在马尔可夫决策过程中,环境的状态被建模为一个有限的状态空间。

状态空间中的每个状态都代表了环境可能处于的一种情况。

例如,在一个机器人导航的问题中,状态空间可以表示为机器人可能所处的每个位置。

转移概率则描述了从一个状态转移到另一个状态的概率。

这个概率可以用一个转移矩阵来表示,矩阵的每个元素代表了从一个状态到另一个状态的转移概率。

3. 奖励函数在马尔可夫决策过程中,决策者的目标通常是最大化长期的累积奖励。

奖励函数用来描述在不同状态下采取不同行动所获得的奖励。

这个奖励可以是实数,也可以是离散的,它可以是正也可以是负。

决策者的目标就是通过选择合适的行动,使得累积奖励达到最大。

4. 策略在马尔可夫决策过程中,策略是决策者的行动规则。

它描述了在每个状态下选择行动的概率分布。

一个好的策略可以使得决策者在长期累积奖励最大化的同时,也可以使得系统的性能达到最优。

通常情况下,我们希望找到一个最优策略,使得系统在给定的状态空间和转移概率下能够最大化累积奖励。

5. 值函数值函数是描述在给定策略下,系统在每个状态下的长期累积奖励的期望值。

马尔可夫决策过程 马尔可夫决策过程(Markov Decision Processes

马尔可夫决策过程马尔可夫决策过程(Markov Decision Processes,MDP)马尔可夫决策过程概述马尔可夫决策过程是基于马尔可夫过程理论的随机动态系统的最优决策过程。

马尔可夫决策过程是序贯决策的主要研究领域。

它是马尔可夫过程与确定性的动态规划相结合的产物,故又称马尔可夫型随机动态规划,属于运筹学中数学规划的一个分支。

马尔可夫决策过程是指决策者周期地或连续地观察具有马尔可夫性的随机动态系统,序贯地作出决策。

即根据每个时刻观察到的状态,从可用的行动集合中选用一个行动作出决策,系统下一步(未来)的状态是随机的,并且其状态转移概率具有马尔可夫性。

决策者根据新观察到的状态,再作新的决策,依此反复地进行。

马尔可夫性是指一个随机过程未来发展的概率规律与观察之前的历史无关的性质。

马尔可夫性又可简单叙述为状态转移概率的无后效性。

状态转移概率具有马尔可夫性的随机过程即为马尔可夫过程。

马尔可夫决策过程又可看作随机对策的特殊情形,在这种随机对策中对策的一方是无意志的。

马尔可夫决策过程还可作为马尔可夫型随机最优控制,其决策变量就是控制变量。

马尔可夫决策过程的发展概况50年代R.贝尔曼研究动态规划时和L.S.沙普利研究随机对策时已出现马尔可夫决策过程的基本思想。

R.A.霍华德(1960)和D.布莱克韦尔(1962)等人的研究工作奠定了马尔可夫决策过程的理论基础。

1965年,布莱克韦尔关于一般状态空间的研究和E.B.丁金关于非时齐(非时间平稳性)的研究,推动了这一理论的发展。

1960年以来,马尔可夫决策过程理论得到迅速发展,应用领域不断扩大。

凡是以马尔可夫过程作为数学模型的问题,只要能引入决策和效用结构,均可应用这种理论。

马尔可夫决策过程的数学描述周期地进行观察的马尔可夫决策过程可用如下五元组来描述:{S,(A(i),i∈S,q,γ,V},其中S 为系统的状态空间(见状态空间法);A(i)为状态i(i∈S)的可用行动(措施,控制)集;q为时齐的马尔可夫转移律族,族的参数是可用的行动;γ是定义在Γ(Г呏{(i,ɑ):a∈A(i),i∈S}上的单值实函数;若观察到的状态为i,选用行动a,则下一步转移到状态j的概率为q(j│i,ɑ),而且获得报酬γ(j,ɑ),它们均与系统的历史无关;V是衡量策略优劣的指标(准则)。

部分可观察马尔可夫决策过程研究进展.

0引言部分可观察马尔可夫决策过程 (partially observable Markov decision processes , POMDP 描述的是当前世界模型部分可知的情况下,智能体 Agent Agent 的例如, 足球运动员在球场上踢足球, 每个球员并不完全清楚他周围的所有状态, 当他向前带球的过程中, 他可能知道在他前面人的位置和状态, 但是可能不知道在他后面的其他队友的位置和状态, 此时他观察到的信息是不完整的, 但是一个优秀的足球运动员往往靠着一种感觉传给他身后的最有利的队员, 使其进行最有利的进攻,过程就是部分可观察马尔可夫决策过程。

在部分可感知模型中, 不仅要考虑到状态的不确定性, 同时还要考虑到动作的不确定性,这种世界模型更加能够客观的描述真实世界, 因此应用十分广泛。

本文综述了目前在 POMDP 领域的研究情况, 介绍了 MDP 的数学理论基础和决策模型, 以及一种典型的 POMDP 决策算法-值迭代算法, 介绍了目前现有的几种经典的决策算法, 并分析它们之间的优点和不足, 列举了一些 POMDP 常见的应用领域, 并进行了总结和展望。

1马尔可夫决策过程Agent 每一个时刻都要做一些决策, 做决策时不仅要考虑甚至是其它 Agents (Markov decision process , MDP 的最优解, MDP 可以用一个四元组<, >来描述 [1]::Agent的行为集;, :×:当 Agent在状态 ,可能转移到状态的概率,使用 |:→ 情况下采用动作-2116--2117-, Agent 使 Agent 选择的动作能够获得在 MDP 模型中, Agent在为折扣因子,其目标是让期望值有界(1由于 MDP 决策过程中, 要同时考虑世界模型的不确定性和目标的长远性,需要在策略时刻,状态的情况下,值函数构造如下=,=,*,也就是 Agent 每个时刻都能做到的最优决策, 根据 Bellman最优策略公式可以得到。

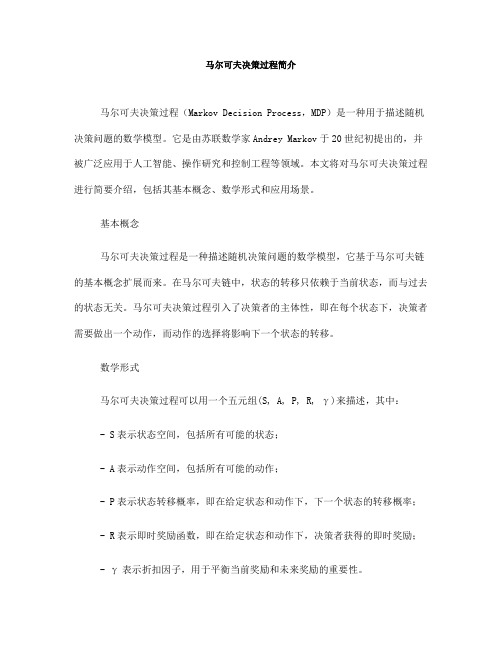

马尔可夫决策过程简介(四)

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process,简称MDP)是一种用于描述随机决策问题的数学模型。

它是一种理论工具,被广泛地应用于控制理论、机器学习、人工智能等领域。

在这篇文章中,我们将简要介绍马尔可夫决策过程的基本概念和应用。

1. 马尔可夫决策过程的基本概念马尔可夫决策过程是由五元组$(S, A, P, R, \gamma)$组成的。

其中,$S$表示状态空间,$A$表示动作空间,$P$表示状态转移概率,$R$表示奖励函数,$\gamma$表示折扣因子。

状态空间$S$包含所有可能的状态,动作空间$A$包含所有可能的动作。

状态转移概率$P$表示在某一状态下采取某一动作后转移到下一状态的概率。

奖励函数$R$用来衡量在某一状态下采取某一动作所获得的即时奖励。

折扣因子$\gamma$用来平衡当前奖励和未来奖励的重要性。

2. 马尔可夫决策过程的求解方法马尔可夫决策过程的求解方法有很多种,其中比较著名的有值迭代和策略迭代。

值迭代是一种通过迭代更新值函数和策略来求解最优策略的方法。

策略迭代是一种通过迭代更新策略来求解最优策略的方法。

这两种方法各有优劣,可以根据具体的问题和应用场景选择适合的方法。

3. 马尔可夫决策过程的应用马尔可夫决策过程在很多领域都有着重要的应用。

在控制理论中,马尔可夫决策过程被用来描述动态系统的控制问题。

在机器学习中,马尔可夫决策过程被用来建模强化学习问题。

在人工智能中,马尔可夫决策过程被用来解决智能体与环境交互的决策问题。

总之,马尔可夫决策过程在现代科学技术中有着广泛的应用前景。

4. 马尔可夫决策过程的发展趋势随着计算机技术的不断发展,马尔可夫决策过程的求解方法和应用领域也在不断拓展。

近年来,深度学习技术的兴起为马尔可夫决策过程的求解和应用带来了新的机遇和挑战。

未来,马尔可夫决策过程将会在更多的领域和行业中得到应用,为人类社会的发展进步做出更大的贡献。

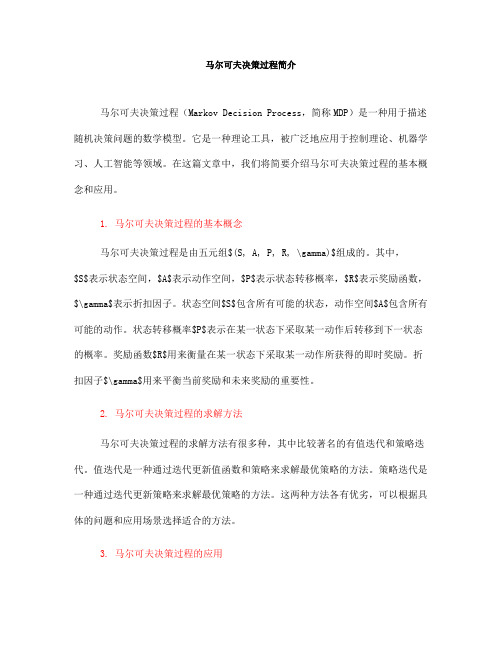

【国家自然科学基金】_半马尔可夫过程_基金支持热词逐年推荐_【万方软件创新助手】_20140731

2012年 序号 1 2 3 4 5

科研热词 连续数据保护 索引日志 文件视图 数据恢复 半马尔可夫模型

推荐指数 1 1 1 1 1

2013年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14

科研热词 隐半马尔可夫模型 超时策略 服务质量 报丈格式 应用层协议 在线优化 半马尔可夫过程 半markov控制过程 动态预测 动态电源管理 分段 事例推理 web服务 lte-drx

2008年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16

科研热词 半马尔可夫过程 软件衰退 软件抗衰 系统负载 移动模型 状态转移 点空间分布 模拟仿真 机会式频谱接入 无线传感器网络 平均速率 干扰避免 安全属性 入侵容忍 信道预测 信道感知

推荐指数 3 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

科研热词 半马尔可夫过程 可靠性 马尔可夫过程 预防性检修 隐半马尔可夫模型 长期平均成本率 退化 连续搅拌反应釜 运行风险评估 贝叶斯网络 继电保护 策略迭代算法 等效频谱 瞬时状态概率 电力系统 最优潮流 最优故障维修策略 时变停运模型 无线传感器网络 故障预报 故障率 拓扑容侵 强化学习 延迟更新过程 定量评估 多目标优化 多状态退化系统 变压器 半马尔可夫决策过程 半马尔可夫决策规划 剩余寿命 位相型近似 q(λ )学习算法

2009年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22

科研热词 马尔可夫决策过程 随机模型 连续时间马尔可夫决策过程 认证性 虚拟植物 自动机 约束平均最优策略 状态转移 植物分枝结构 机密性 最优策略 平均最优平稳策略 平均准则 完整性 安全属性 多尺度分析 增强学 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

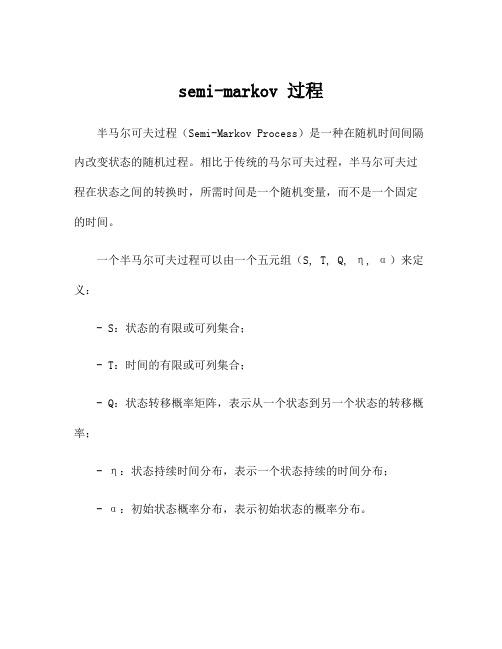

semi-markov 过程

semi-markov 过程半马尔可夫过程(Semi-Markov Process)是一种在随机时间间隔内改变状态的随机过程。

相比于传统的马尔可夫过程,半马尔可夫过程在状态之间的转换时,所需时间是一个随机变量,而不是一个固定的时间。

一个半马尔可夫过程可以由一个五元组(S, T, Q, η, α)来定义:- S:状态的有限或可列集合;- T:时间的有限或可列集合;- Q:状态转移概率矩阵,表示从一个状态到另一个状态的转移概率;- η:状态持续时间分布,表示一个状态持续的时间分布;- α:初始状态概率分布,表示初始状态的概率分布。

半马尔可夫过程的本质是将时间和状态结合在一起,使得在随机时间点上状态的改变成为可能。

这种随机时间点的转换可以用来建模各种实际情况,如电话通话时长、服务过程中的等待时间等。

半马尔可夫过程有两种基本类型:无记忆和有记忆。

无记忆型的半马尔可夫过程中,状态持续时间的分布与上一个状态转移的概率无关。

相反,有记忆型的半马尔可夫过程中,状态持续时间的分布与上一个状态的持续时间以及上一个状态转移的概率相关。

半马尔可夫过程的建模可以通过转移概率矩阵来表示状态之间的转换关系。

转移概率矩阵中的每个元素表示从一个状态到另一个状态的转移概率。

状态持续时间的分布可以通过选择合适的概率分布来建模,常见的有指数分布、伽马分布等。

在实际应用中,半马尔可夫过程可以用于建模和分析一些复杂的系统,例如网络流量模型、通信系统等。

它可以通过模拟和统计方法来分析系统的性能,如平均等待时间、吞吐量等。

半马尔可夫过程有一些特殊的性质,如马尔可夫性质、增量性质和半马尔可夫性质。

马尔可夫性质表示在给定当前状态下,未来状态的转换概率只与当前状态有关,与过去的状态无关。

增量性质表示半马尔可夫过程的增量是独立的,即在任何时间段上都是随机独立的。

半马尔可夫性质表示在给定当前状态和经过的时间后,未来状态的转换概率只与当前状态和经过的时间有关。

马尔可夫更新过程与半马尔可夫过程”的讨论

关于“马尔可夫更新过程与半马尔可夫过程”的讨论前言马尔可夫更新过程是马尔可夫过程和更新过程的综合与推广。

马尔可夫更新过程以及由其产生的半马尔可夫过程,与马尔可夫过程、更新过程仅有紧密的联系,又有明显的区别。

马尔可夫更新过程是一个二维(包括状态和时间)随机过程,而半马尔可夫过程是由其产生的一维随机过程。

半马尔可夫过程的状态逗留时间是一般分布,不具有马尔可夫性,但在各状态转移时刻具有马尔可夫性。

马尔可夫更新过程是马尔可夫过程的推广。

如果忽略马尔可夫更新过程中的时间变量,就可得到离散时间马尔可夫链。

如果半马尔可夫过程在各个状态的逗留时间都服从指数分布,就可得到连续时间马尔可夫链。

马尔可夫更新过程是更新过程的推广。

状态逗留时间可以看作是受到一个马尔可夫链调制。

如果忽略确切的状态或状态固定,即只有一个状态,就可得到更新过程。

本读书报告主要对马尔可夫更新过程和半马尔可夫过程的概念进行了分析,讨论了马尔可夫更新过程和半马尔可夫过程、马尔可夫过程、更新过程的区别与联系,并分析总结了马尔可夫更新过程的基本特性。

一、对相关定义的理解1、马尔可夫更新过程随机变量n X 取值于状态空间{} ,,,210=S ,n T 是取值[)∞,0的随机变量,并且 ≤≤≤≤≤=-n n T T T T T 12100,则称随机过程{}0),,(≥n T X n n 是马尔可夫更新过程,如果对于0,,0≥∈≥∀t S j n 满足[][]n n n n n n n n n X t T T j X P T X T X T X t T T j X P |,),(),,(),,(|,11110011≤-==≤-=++++ (1)上式称作“半马尔可夫性”,其含义是:已知现在状态n X ,将来状态1+n X 与逗留在当前状态n X 的时间n n T T -+1的联合分布与过去的历史111100,,,,,--n n T X T X T X 独立。

马尔可夫链-续3

Pi

∞

只依赖于当前

j

∑P

j =i

⇒ { X n : n ≥ 1}是MC, 而且有

Pi1 = P{T = i | T ≥ i} = λ (i ) = 1 − Pi ,i +1 , ∀i ≥ 1 。

求极限概率 {π i , i ≥ 1} 。

逆向过程:年龄一直减少,直到状态 1,接着 依概率分布{Pi , i ≥ 1} 跳到某一状态。

例 4.7(a) 遍历随机游动

Pi ,i +1 + Pi ,i −1 = 1

⇒ 这个遍历链是时间可逆的。

想说明:从 i 到 i + 1 转移的比率 = 从 i + 1 到 i 转移的比率 转移次数: ni ,i +1 − ni +1,i ≤ 1 。

i

i+1 i+1

i

i+1

i

∞

对于一个马尔可夫链,若 xi Pij = x j Pji , ∀i, j ,且 ∑ xi = 1 有解,则时间可逆。

d d

P{ X 1 = i1 ,⋯ , X n = in } = π i1 Pi1 ,i2 ⋯ Pin−2 ,in−1 Pin−1 ,in

= Pi2 ,i1π i2 Pi2 ,i3 ⋯ Pin−2 ,in−1 Pin−1 ,in = ⋯ = π in Pin ,in−1 ⋯ Pi2 ,i1 = P{ X n = i1 ,⋯ , X 1 = in }

转移 i → k → j → i 的比率 = 转移i → j → k → i 的比率

π i Pik Pkj Pji = π i Pij Pjk Pki

定理 4.7.1 平稳 MC 时间可逆,当且仅当对一切状态 i, i1 ,⋯ , ik

马尔可夫决策过程简介(Ⅲ)

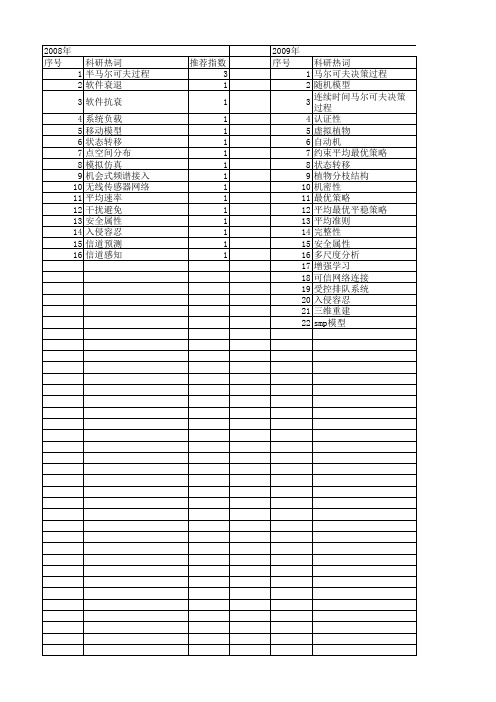

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process,MDP)是一种用于描述随机决策问题的数学模型。

它是由苏联数学家Andrey Markov于20世纪初提出的,并被广泛应用于人工智能、操作研究和控制工程等领域。

本文将对马尔可夫决策过程进行简要介绍,包括其基本概念、数学形式和应用场景。

基本概念马尔可夫决策过程是一种描述随机决策问题的数学模型,它基于马尔可夫链的基本概念扩展而来。

在马尔可夫链中,状态的转移只依赖于当前状态,而与过去的状态无关。

马尔可夫决策过程引入了决策者的主体性,即在每个状态下,决策者需要做出一个动作,而动作的选择将影响下一个状态的转移。

数学形式马尔可夫决策过程可以用一个五元组(S, A, P, R, γ)来描述,其中:- S表示状态空间,包括所有可能的状态;- A表示动作空间,包括所有可能的动作;- P表示状态转移概率,即在给定状态和动作下,下一个状态的转移概率;- R表示即时奖励函数,即在给定状态和动作下,决策者获得的即时奖励;- γ表示折扣因子,用于平衡当前奖励和未来奖励的重要性。

应用场景马尔可夫决策过程被广泛应用于人工智能领域,尤其是强化学习。

在强化学习中,智能体需要在环境中学习并做出决策,以最大化长期奖励。

马尔可夫决策过程提供了一种形式化建模的方法,帮助智能体理解环境和做出合理的决策。

此外,马尔可夫决策过程还在运筹学、控制工程、金融等领域有着重要的应用。

例如,在运筹学中,马尔可夫决策过程可以用于描述排队系统、库存管理等问题;在控制工程中,它可以用于描述机器人路径规划、自动驾驶等问题;在金融领域,它可以用于风险管理、投资组合优化等问题。

总结马尔可夫决策过程是一种重要的数学模型,能够有效地描述随机决策问题,并在多个领域得到了广泛的应用。

通过对其基本概念、数学形式和应用场景的介绍,希望读者能够对马尔可夫决策过程有一个初步的了解,并对其在实际问题中的应用有所启发。

马尔可夫决策过程简介(七)

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process,MDP)是一种用于描述具有随机性和决策性的动态系统的数学模型。

MDP在人工智能、运筹学和控制理论等领域有着广泛的应用,能够帮助我们理解和解决实际问题。

状态、动作和奖励在MDP中,系统的演化被划分为一系列离散的时间步骤。

在每个时间步骤,系统处于一个特定的状态。

状态可以是离散的,也可以是连续的,取决于具体的应用场景。

系统可以采取一系列可能的动作,每个动作都会导致系统转移到下一个状态。

在每个状态下,系统会收到一个奖励,奖励可以是立即的,也可以是延迟的。

系统的目标是选择动作,以最大化长期累积的奖励。

马尔可夫性质MDP的一个重要特征是马尔可夫性质,即未来的状态只取决于当前的状态和采取的动作,而与过去的状态和动作无关。

这一特性简化了对系统的建模,使得我们只需要考虑当前时刻的状态和动作,而不需要关心系统的整个历史轨迹。

值函数和策略为了解决MDP,我们需要定义值函数和策略。

值函数表示在特定状态下采取特定动作可以获得的长期累积奖励的期望值。

策略则表示在每个状态下选择动作的规则。

我们的目标是找到最优的策略,使得值函数最大化。

贝尔曼方程与动态规划贝尔曼方程是MDP的核心方程,描述了值函数之间的关系。

通过贝尔曼方程,我们可以递归地计算值函数,从而找到最优策略。

动态规划是一种基于贝尔曼方程的求解方法,通过不断迭代更新值函数,最终找到最优策略。

强化学习与深度强化学习除了动态规划,强化学习是另一种解决MDP的方法。

强化学习通过代理与环境的交互,不断试错,从而学习到最优策略。

近年来,随着深度学习的兴起,深度强化学习成为了解决MDP的新方法,通过深度神经网络来近似值函数和策略,取得了许多令人瞩目的成果。

MDP的应用MDP在人工智能领域有着广泛的应用,例如智能游戏、机器人控制、自动驾驶等。

在运筹学中,MDP也被用来建模优化问题,如库存管理、资源分配等。

马尔可夫过程CTMDP,DTMDP,SMDP区别与联系

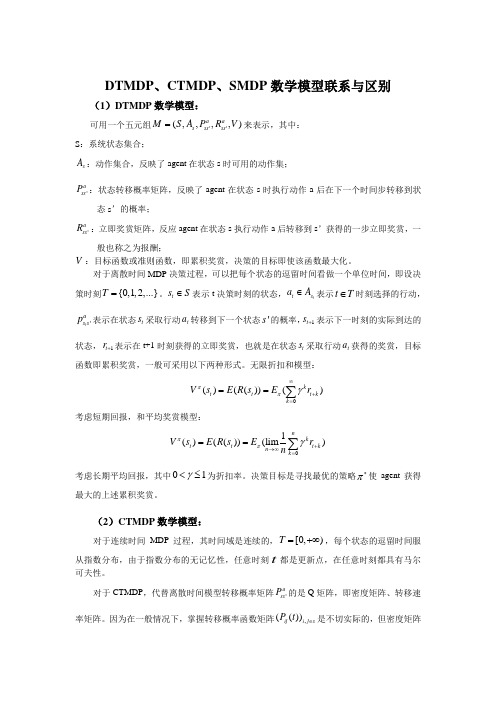

DTMDP 、CTMDP 、SMDP 数学模型联系与区别(1)DTMDP 数学模型:可用一个五元组''(,,,,)a a s ss ss M S A P R V =来表示,其中:S :系统状态集合;s A :动作集合,反映了agent 在状态s 时可用的动作集;'a ss P :状态转移概率矩阵,反映了agent 在状态s 时执行动作a 后在下一个时间步转移到状态s ’的概率;'a ss R :立即奖赏矩阵,反应agent 在状态s 执行动作a 后转移到s ’获得的一步立即奖赏,一般也称之为报酬;V :目标函数或准则函数,即累积奖赏,决策的目标即使该函数最大化。

对于离散时间MDP 决策过程,可以把每个状态的逗留时间看做一个单位时间,即设决策时刻{0,1,2,...}T =。

t s S ∈表示t 决策时刻的状态,t t s a A ∈表示t T ∈时刻选择的行动,'t a s s p 表示在状态t s 采取行动t a 转移到下一个状态's 的概率,1t s +表示下一时刻的实际到达的状态,1t r +表示在t+1时刻获得的立即奖赏,也就是在状态t s 采取行动t a 获得的奖赏,目标函数即累积奖赏,一般可采用以下两种形式。

无限折扣和模型:0()(())()k t t t k k V s E R s E r ππγ∞+===∑ 考虑短期回报,和平均奖赏模型:01()(())(lim )n k t t t k n k V s E R s E r n ππγ+→∞===∑ 考虑长期平均回报,其中01γ<≤为折扣率。

决策目标是寻找最优的策略π*使agent 获得最大的上述累积奖赏。

(2)CTMDP 数学模型:对于连续时间MDP 过程,其时间域是连续的,[0,)T =+∞,每个状态的逗留时间服从指数分布,由于指数分布的无记忆性,任意时刻t 都是更新点,在任意时刻都具有马尔可夫性。

[讲解]马尔可夫过程及其应用

![[讲解]马尔可夫过程及其应用](https://img.taocdn.com/s3/m/796b22c732d4b14e852458fb770bf78a65293aa8.png)

马尔可夫过程马尔可夫过程(Markov Process)什么是马尔可夫过程1、马尔可夫性(无后效性)过程或(系统)在时刻t0所处的状态为已知的条件下,过程在时刻t > t0所处状态的条件分布,与过程在时刻t0之前年处的状态无关的特性称为马尔可夫性或无后效性。

即:过程“将来”的情况与“过去”的情况是无关的。

2、马尔可夫过程的定义具有马尔可夫性的随机过程称为马尔可夫过程。

用分布函数表述马尔可夫过程:设I:随机过程{X(t),t\in T}的状态空间,如果对时间t的任意n个数值:(注:X(t n)在条件X(t i) = x i下的条件分布函数)(注:X(t n))在条件X(t n− 1) = x n− 1下的条件分布函数)或写成:这时称过程具马尔可夫性或无后性,并称此过程为马尔可夫过程。

3、马尔可夫链的定义时间和状态都是离散的马尔可夫过程称为马尔可夫链, 简记为。

[编辑]马尔可夫过程的概率分布研究时间和状态都是离散的随机序列:,状态空间为1、用分布律描述马尔可夫性对任意的正整数n,r和,有:PX m + n = a j | X m = a i,其中。

2、转移概率称条件概率P ij(m,m + n) = PX m + n = a j | X m = a i为马氏链在时刻m处于状态a i条件下,在时刻m+n转移到状态a j的转移概率。

说明:转移概率具胡特点:。

由转移概率组成的矩阵称为马氏链的转移概率矩阵。

它是随机矩阵。

3、平稳性当转移概率P ij(m,m + n)只与i,j及时间间距n有关时,称转移概率具有平稳性。

同时也称些链是齐次的或时齐的。

此时,记P ij(m,m + n) = P ij(n),P ij(n) = PX m + n = a j | X m = a i(注:称为马氏链的n步转移概率)P(n) = (P ij(n))为n步转移概率矩阵。

特别的, 当k=1 时,一步转移概率:P ij = P ij(1) = PX m + 1 = a j | X m = a i。

半马尔可夫决策过程 定义

半马尔可夫决策过程定义嘿,朋友!你知道半马尔可夫决策过程吗?这玩意儿听起来是不是特别高大上,感觉很难懂?其实啊,没那么可怕!咱先来说说啥叫决策过程。

就好比你出门前纠结今天穿啥衣服,是选那件帅气的夹克还是舒适的运动衫,这就是一个小小的决策过程。

而半马尔可夫决策过程呢,就像是这个决策过程的升级版。

想象一下,你在一个游戏里,每走一步都要做出选择,比如是往左走还是往右走,是打怪还是躲起来。

但这个游戏可不是简单的走一步算一步,它还有时间因素在里面。

这就像你等公交车,有时候车很快就来了,有时候你得等好久,这等待的时间是不确定的。

半马尔可夫决策过程就是考虑了这种不确定的时间间隔的决策情况。

它不仅仅关心你做出的选择,还关心你在每个状态上停留的时间长短。

比如说,你经营一家小商店,每天要决定进多少货。

有时候货物卖得快,有时候卖得慢,这卖货的速度就是不确定的时间间隔。

而你根据这些情况做出的进货决策,就是在半马尔可夫决策过程的范畴里啦。

再打个比方,你准备考研,每天决定学习多长时间,学习哪些科目。

有时候状态好,学得快,有时候状态不好,学得慢,这学习效率的变化就相当于不确定的时间间隔。

你根据这些来调整学习计划,不也是一种半马尔可夫决策过程嘛!所以说,半马尔可夫决策过程其实就在我们生活中到处都有,只是我们可能没有意识到而已。

它能帮助我们更好地做出决策,让我们在面对不确定的情况时,更有策略,更有方法。

总之,半马尔可夫决策过程虽然名字有点复杂,但理解起来并不难,只要我们多想想生活中的例子,就能明白它的奥秘啦!。

部分可观测马尔可夫决策过程(pa...

部分可观测马尔可夫决策过程(pa...

部分可观测马尔可夫决策过程(partially observable Markov decision processes ,POMDP) 模型是马尔可夫决策过程(MDP)模型的扩展。

MDP 模型根据系统当前实际状态做出决策,但是很多情况下,系统的精确状态难以获取。

例如,对复杂的机械系统,测量系统状态的传感器信号常受到噪声污染,难以获得系统的精确状态。

POMDP 假设系统的状态信息不能直接观测得到,是部分可知的,因⽽对只有不完全状态信息的系统建模,依据当前的不完全状态信息做出决策。

POMDP 的应⽤领域⾮常⼴泛,包括⼯业(机械维修、结构检查、电梯控制及渔业等) 、科学(机器⼈控制、⽣态⾏为及机器视觉等) 、商业(⽹络故障发现和修理、分布式数据库查询、⾏销、问卷调查表设计及团体政策等) 、军事(移动⽬标搜索、搜索营救、⽬标辨识及武器分配等) 和社会(教育及医疗诊断等) 等[ 1 ] 。

⽬前对POMDP 算法的研究包括精确算法和近似算法。

精确算法理论上可以获得最优解,但由于计算复杂性

随着问题的规模呈指数增长,⼀般只适⽤于求解⼀些⼩规模的问题。

因此出现了许多求解POMDP 的近似算法,近

似算法⼤都以精确算法为基础,精确算是研究和构造近似算法的基础[ 2 ] 。

本⽂在对POMDP 的模型以及性质介绍的基础上,对当前的POMDP 主要精确算法进⾏了分析,并简要介绍了常⽤的近似算法。

摘⾃桂林,武⼩悦,部分可观测马尔可夫决策过程算法综述,系统⼯程与电⼦技术,2008 年 6⽉。

有限阶段半马尔可夫决策过程的开题报告

有限阶段半马尔可夫决策过程的开题报告一、选题背景半马尔可夫决策过程(Semi-Markov Decision Process,SMDP)是马尔可夫决策过程(Markov Decision Process,MDP)的一个扩展,它把时间分解成了阶段(epoch),并且允许每一个阶段的长度是非常数的。

SMDP在实际应用中具有广泛的应用,比如在传统的工业生产中,在医疗护理行业里等。

在很多实际应用中,一个状态持续的时间并不是确定的,它可能与当前的状态有关,随机性很强,并且这个时间通常是连续的而不是离散的。

所以,将半马尔可夫过程应用于这些问题就能更好的描述实际问题。

有限阶段半马尔可夫决策过程具有状态数、行动数和观察数都是有限个数的特点,是SMDP模型的一种特例。

它是半马尔可夫过程一种简化的模型,在很多应用场景下得到了广泛地应用。

因此,了解有限阶段半马尔可夫决策过程的性质和算法是非常重要和有必要的。

本文结合相关文献,对有限阶段半马尔可夫决策过程的性质和解法进行探究和分析,旨在从更深入的角度理解SMDP的基础理论和完整算法体系,在实际应用中能更好的利用SMDP解决问题。

二、研究目的与意义有限阶段半马尔可夫决策过程是实际应用中较为常用的一种半马尔可夫过程的简化模型,对于研究该模型的性质和建立该模型的有效算法具有重要意义。

在理论方面,探究有限阶段半马尔可夫决策过程的性质和性能,能够从更深入的角度把握半马尔可夫决策过程的基本特点,对于半马尔可夫决策过程相关的理论研究和应用深入开展提供了理论基础和保障。

在应用方面,掌握有限阶段半马尔可夫决策过程的解法,有利于实际应用中更好地选择模型并应用模型来解决问题。

同时,SMDP模型的局限性也能够得到深刻认识。

三、研究内容本文将探究有限阶段半马尔可夫决策过程的相关性质和解法,具体包括以下几个方面:1. 有限阶段半马尔可夫决策过程的基本概念和表述方法2. 有限阶段半马尔可夫决策过程的基本特性分析,包括数学分析和实际应用分析。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一个半马尔可夫过程是这样的过程,它的状态按一个马尔可夫链转移,但是在状态转移之间的时间间隔是随机的。

更特别的是,考虑一个状态为 1, ,0 ⋅⋅⋅的随机过程,它每次进入状态()0≥i i 时有:

下一个进入的状态是j 的概率为0 , ,≥j i P ij ,

在指定下一个进入的状态是j 时,直至从i 到j 的转移发生的时间具有分布ij F 。

如果我们以()t Z 记在时刻t 的状态,则(){}0,≥t t Z 称为一个半马尔可夫过程。

于是半马尔可夫过程并没有在给定现在的状态时将来独立与过去的马尔可夫性。

因为为了预测将来,我们不仅需要知道现在的状态,而且还需要知道在那个状态停留的时间长度。

当然在转移的时刻,我们需要知道一切是新的状态(而不需要有关过去的情形)。

马尔可夫链是半马尔可夫过程,它具有

()⎩

⎨⎧≥<=1 11 0t t t F ij 即马尔可夫链的一切转移时间恒等于1。

以i H 记半马尔可夫过程在转移前停留在状态i 的时间分布。

即,由取条件于下一个状态,我们有

()()∑=j

ij ij i t F P t H ,

以i μ记它的均值。

即

()⎰∞

=0d x H x i i μ。

若我们以n X 记第n 个被访问的状态,则{}0,≥n X n 是以ij P 为转移概率的马尔可夫链。

它称为半马尔可夫过程的嵌入马尔可夫链。

若嵌入马尔可夫链是不可约的,则我们称半马尔可夫过程不可约。

以ii T 记相继转移到状态i 之间的时间,且令[]ii ii T E =μ。

用交替更新过程理论推导半马尔可夫过程的极限概率是一件简单的事情。