利用OpenMP线程绑定技术提升多核平台应用性能

在C++中使用openmp进行多线程编程

在C++中使⽤openmp进⾏多线程编程在C++中使⽤openmp进⾏多线程编程⼀、前⾔多线程在实际的编程中的重要性不⾔⽽喻。

对于C++⽽⾔,当我们需要使⽤多线程时,可以使⽤boost::thread库或者⾃从C++ 11开始⽀持的std::thread,也可以使⽤操作系统相关的线程API,如在Linux上,可以使⽤pthread库。

除此之外,还可以使⽤omp来使⽤多线程。

它的好处是跨平台,使⽤简单。

在Linux平台上,如果需要使⽤omp,只需在编译时使⽤"-fopenmp"指令。

在Windows的visual studio开发环境中,开启omp⽀持的步骤为“项⽬属性 -> C/C++ -> 所有选项 -> openmp⽀持 -> 是(/openmp)”。

本⽂我们就介绍omp在C++中的使⽤⽅法。

⼆、c++ openmp⼊门简介openmp是由⼀系列#paragma指令组成,这些指令控制如何多线程的执⾏程序。

另外,即使编译器不⽀持omp,程序也也能够正常运⾏,只是程序不会多线程并⾏运⾏。

以下为使⽤omp的简单的例⼦:int main(){vector<int> vecInt(100);#pragma omp parallel forfor (int i = 0; i < vecInt.size(); ++i){vecInt[i] = i*i;}return 0;}12345678910以上代码会⾃动以多线程的⽅式运⾏for循环中的内容。

如果你删除"#pragma omp parallel for"这⾏,程序依然能够正常运⾏,唯⼀的区别在于程序是在单线程中执⾏。

由于C和C++的标准规定,当编译器遇到⽆法识别的"#pragma"指令时,编译器⾃动忽略这条指令。

所以即使编译器不⽀持omp,也不会影响程序的编译和运⾏。

多核构架下OpenMP多线程应用运行性能的研究_徐磊

CN43-1258/T P ISSN1007-130X计算机工程与科学COM P U T ER EN GIN EERIN G&SCIEN CE2009年第31卷第11期Vo l131,N o111,2009文章编号:1007-130X(2009)11-0050-04多核构架下OpenM P多线程应用运行性能的研究* A Study of the OpenM P M ultithread Application Ex ecution Performance on M ulticore A rchitecures徐磊,徐莹,张丹丹XU Lei,XU Ying,ZHANG Dan-dan(上海超级计算中心,上海201203)(Shanghai Supercomputer Center,Shanghai201203,C hina)摘要:多核平台下,OpenM P线程在核间的动态迁移在一定程度上会导致应用程序性能的下降,如果将线程绑定在固定的核上运行,使其不再迁移,这种方法将有可能提升应用程序性能,达到充分利用多核平台的计算能力的目的。

本文将介绍如何使用主流的编译器绑定接口以及Linux内核A PI的方式实现OpenM P线程与核之间的绑定,使用ST REA M Benchmar k和NP B在上海超级计算中心的/魔方0超级计算机刀片上测试、比较绑定前后的应用程序的性能。

结果证明,使用绑定方案将有可能提升O penM P应用程序的性能。

Abstract:T he perfo rmance o f multit hr ead application w ill go down because O penM P thr eads may be migr ated between the physical co res on a multico re system.It is possible to impr ov e t he perfo rmance if OpenM P threads are bound on spec-i fied co res.T his paper intro duces several way s to bind O penM P thr eads to the physical cor es by using the thr ead affinity in-ter face o f the main ST REA M compilers or the A PI of the L inux kernel.F inally,the ST REAM Benchmark and N PB are used t o test the per formance on a blade at the Shanghai Superco mputer Center.T he r esults sho w that the bet ter perfo rm-ance will be achieved if the OpenM P threads are bound to co res.关键词:多核;OpenM P线程;绑定;ST R EAM;N PBKey words:multicor e;O penM P T hreads;bind;ST R EAM;N PBdoi:10.3969/j.issn.1007-130X.2009.11.013中图分类号:T P314文献标识码:A1引言如今绝大部分的HPC系统采用Cluster方式构建,采用具有高带宽低延迟的通讯网络连接高性能的计算节点,计算节点通常是具有多核多CPU的SM P节点。

OpenMP与C++:事半功倍地获得多线程的好处

OpenMP与C++:事半功倍地获得多线程的好处Kang Su Gatlin & Pete Isensee 著赖勇浩译在并行计算领域有一个广为流传的笑话——并行计算是未来之事并且永远都是。

这个小笑话几十年来一直都是对的。

一种类似的观点在计算机架构社区中流传,处理器时钟速度的极限似乎近在眼前,但时钟速度却一直在加快。

多核革命是并行社区的乐观和架构社区的悲观的冲突。

现在主流的CPU厂商开始从追求时钟频率转移到通过多核处理器来增加并行支持。

原因很简单:把多个CPU内核封装在一个芯片里可以让双核单处理器系统就像双处理器系统一样、四核单处理器系统像四处理器系统一样。

这一实用方法让CPU厂商在能够提供更强大的处理器的同时规避了加速频率的诸多障碍。

到此为止这听起来是一个好消息,但事实上如果你的程序没有从多核里获取优势的话,它并不会运行得更快。

这就是OpenMP的用武之地了。

OpenMP可以帮助C++开发者更快地开发出多线程应用程序。

在这短小的篇幅里完整讲述OpenMP这个大而强的API库的相关内容是不可能的。

因此,本文仅作一些初始介绍,通过示例让你能够快速地应用OpenMP的诸多特性编写多线程应用程序。

如果你希望阅读更深入的内容,我们建议你去OpenMP的网站看看。

在Visual C++中使用OpenMPOpenMP标准作为一个用以编写可移植的多线程应用程序的API库,规划于1997年。

它一开始是一个基于Fortran的标准,但很快就支持C和C++了。

当前的版本是OpenMP 2.0(译者注:最新版本已经是2.5版), Visual C++ 2005和XBox360平台都完全支持这一标准。

在我们开始编码之前,你需要知道如何让编译器支持OpenMP。

Visual C++ 2005提供了一个新的/openmp开关来使能编译器支持OpenMP指令。

(你也可以通过项目属性页来使能OpenMP指令。

点击配置属性页,然后[C/C++],然后[语言],选中OpenMP支持。

并发和并行编程:利用多线程和多核处理器提高程序性能

并发和并行编程:利用多线程和多核处理器提高程序性能并发和并行是两个在计算机科学中常见的概念,用于描述多线程和多核处理器的优化技术。

本文将详细介绍并发和并行编程的概念、原理以及其对程序性能的影响。

一、并发编程并发编程是指在一个时间段内可以执行多个任务或操作,并且这些任务或操作可能是同时运行的。

在单核处理器的情况下,通过使用多线程来实现并发操作。

每个线程独立运行,并且可以同时执行不同的任务。

并发编程的核心思想是将一个大的问题划分成多个小的子问题,然后将这些子问题分配给不同的线程进行处理。

每个线程独立运行,当所有线程完成任务后,结果将被合并。

这样可以提高程序的性能,尤其是在有大量计算和繁重任务的情况下。

并发编程的好处在于可以充分利用CPU的时间片,提高程序的执行效率。

例如,当一个线程正在等待网络资源时,另一个线程可以继续执行其他任务,从而减少了等待时间。

此外,并发编程还可以提高程序的响应性,使得用户体验更好。

然而,并发编程也会带来一些问题,最主要的问题是线程之间的同步和通信。

线程之间的同步就是确保线程按照某种顺序执行,以避免数据竞争和死锁等问题。

线程之间的通信是指线程之间交换数据或信息的机制,例如使用消息队列、共享内存等。

正确地管理线程之间的同步和通信是并发编程的关键,也是非常困难的。

二、并行编程并行编程是指同时执行多个任务或操作,这些任务或操作可以是相互独立的,也可以是相互依赖的。

与并发编程不同的是,并行编程需要多个处理器或多个核心来同时执行任务。

并行编程可以显著提高程序的性能,尤其是对于需要大量计算和处理的任务来说。

通过将一个任务划分成多个子任务,并且将这些子任务分配给不同的处理器或核心来执行,可以大大缩短任务的完成时间。

并行编程对于高性能计算、科学模拟、图像处理等领域具有重要意义。

然而,与并发编程一样,并行编程也面临着同步和通信的挑战。

不同的是,并行编程的同步和通信更加困难,因为需要协调多个处理器或核心的操作。

CPU-OpenMP和GPU-CUDA并行计算技术对矩阵乘法运算的加速效果分析

CPU-OpenMP和GPU-CUDA并行计算技术对矩阵乘法运算的加速效果分析张岩【摘要】本文对比了CPU-OpenMP和GPU-CUDA并行计算技术对不同阶矩阵乘法运算相对于CPU单线程计算的加速效果.结果表明,CPU-OpenMP并行的计算加速比与矩阵阶数无关,且低于所采用的线程数目.GPU-CUDA并行的计算加速比随矩阵阶数的增加显著增加,最大计算加速比可达570倍以上.相对于CPU单线程计算结果,CPU-OpenMP并行计算未产生误差,而GPU-CUDA并行计算会产生误差.结果表明,GPU-CUDA并行适合高阶数矩阵乘法的加速计算,而CPU-OpenMP 并行适合低阶数矩阵乘法的加速计算.【期刊名称】《科技视界》【年(卷),期】2017(000)026【总页数】3页(P45-47)【关键词】矩阵乘法;并行计算;CPU-OpenMP;GPU-CUDA【作者】张岩【作者单位】北京师范大学附属中学京西分校高三1班,中国北京 100042【正文语种】中文【中图分类】TP391在信息化技术不断发展的今天,人们处在“大数据”时代。

由于数据量巨大,普通的串行计算方式计算效率低下,无法满足人们对数据进行快速处理的需求。

因此,如何能够提高计算机处理“大数据”的计算效率已成为人们日益关注的话题。

为了减少计算时间、提升计算效率,并行计算的出现成为解决上述问题的有效方法。

与普通的串行计算相比,并行计算将计算任务分配到计算机的多个处理器协同处理,从而提高计算效率。

随着并行计算结果的发展,并行算法也逐渐成熟。

目前,人们采用的并行计算技术大致可能分为两种:一是基于CPU(Central Processing Unit)多核多线程的并行计算;二是基于 GPU(Graphics Processing Unit)的通用并行计算。

对于CPU并行计算,根据并行粒度的不同可分为“共享式内存结构”和“分布式内存结构”[1]。

对于“共享式内存结构”的并行计算,OpenMP(Open Multi-Processing)作为该类型计算技术的代表,已被广泛应用于数据处理及科学计算中。

OpenMP在多核处理器上的应用研究

Computer Science and Application 计算机科学与应用, 2014, 4, 175-180Published Online September 2014 in Hans. /journal/csa/10.12677/csa.2014.49025The Application Research of OpenMP onMulticore ProcessorsXiaoping Wang, Xiucheng Dong, Weicheng XieSchool of Electrical and Information Engineering, Xihua University, ChengduEmail: sichuanwww@Received: Jul. 6th, 2014; revised: Aug. 6th, 2014; accepted: Aug. 15th, 2014Copyright © 2014 by authors and Hans Publishers Inc.This work is licensed under the Creative Commons Attribution International License (CC BY)./licenses/by/4.0/AbstractMulticore operating system is superior in assigning and scheduling the general processes, but it is unsatisfying in processing parallel data of the application layer. We study the characteristics of OpenMP and propose a mechanism for the development of application-layer multi-core parallel program. We conduct a comprehensive study and compare its performance. Our experimental re-sults show that the mechanism is convenient and flexible to control the multicore parallel granu-larity of data, take advantage of multicore computing resources, and enhance the real-time of ap-plications. To the ten million of computation, there are greater improvements in running time: the ratio is 0.5:1 between the dual-core and the non-parallel systems; the ratio is 0.38:1 between the quad-core and the non-parallel systems; the ratio is 0.19:1 between the eight-core and the non- parallel systems; the ratio is 0.14:1 between the sixteen-core and the non-parallel systems.KeywordsMulticore Programming, Parallel Computing, OpenMPOpenMP在多核处理器上的应用研究王孝平,董秀成,谢维成西华大学电气信息学院,成都Email: sichuanwww@收稿日期:2014年7月6日;修回日期:2014年8月6日;录用日期:2014年8月15日摘要多核操作系统在解决通用进程的分配和调度等宏观问题上表现优越,而对于应用层的多核数据并行计算没有做到精确控制。

利用OpenMP线程绑定技术提升多核平台应用性能

Intel编译器在中间层提供了和PGI、GCC类似 的绑定方法,实现线程与核的一对一的绑定。这 种模式需要借助环境变量GOMP_CPU_AFFINITY, 具体的设置方法和GCC相同。同时也可以借助 KMP_AFFINITY来实现,在explicit模式下可以利 用参数proclist指定需要绑定到的核,具体的设置 可以为:KMP_AFFINITY=granularity=fine,proclist =[3,0,1,2],explicit。采用这种方式将0-3号线程依次绑 定到核3,0,1,2。使用proclist可以更灵活的使部分 线程绑定在一个核上运行,部分线程在指定的核间 动态的迁移,例:

该段代码将paralle region里面的8个线程依次绑 定到核2,5,13,9,3,6,7,4。同样可以使用 sched_getaffinity函数获取线程的能够使用的核的列 表,示例代码如下:

int num_processors = sysconf(_SC_NPROCESSORS_

CONF); //获取当前节点核的数目

关键词:OpenMP 多核 线程 绑定

1. 引言

如今绝大部分的高性能的Cluster采用多核处理 器来构建SMP节点,在单个处理器内集成多个内核已 经称为处理器发展的方向。面对越来越多的处理核 心,如何进行高效的使用这些核,已经成为研究的 热点。针对新的多核平台,主流的操作系统都对其 调度算法进行了调整,以提高所有处理器核的使用 效率。其中最常用的一种方法就是负载平衡技术, 将CPU的负荷平均分配到多个CPU核中,这就意味 着,在比较繁忙的CPU核上运行的线程将可能会被操 作系统自动迁移到空闲的CPU核上,这种迁移将导致 被迁移的线程的Context(包括寄存器值和Cache中的 数据)需要迁移到新的CPU核上。如果这种迁移过于 频繁,很显然会导致应用程序性能的下降。

利用OpenMP给程序加速

二、OpenMP使用方法

1、搭建OpenMP编译环境

• 在VS2005以上的版本中,只需要在“项 目——属性——C/C++——语言—— OpenMP”中点选“是” • 在GCC4.2以上的版本中,只需要编译 时加上-fopenmp参数就行了

ห้องสมุดไป่ตู้

2、OpenMP一些语法

它的语法很简单,如下所示:

#pragma omp option [clause[ [, ]clause] …] { Program code1; Program code2; }

多核的简单编程——

利用OpenMP给程序加速

报告者:空气

主要内容

一、OpenMP简介 二、OpenMP使用方法 三、OpenMP效率测试

一、OpenMP简介

1、OpenMP的特点

1)、OpenMP是作为共享存储标准 而问世的 2)、它是为在多处理机上编写并行 程序而设计的一个应用编程接口 3)、它包括一套编译指导语句和一 个用来支持它的函数库

三、OpenMP效率测试

欢迎大家批评指正 谢谢!

• void main() • { • #pragma omp parallel sections num_threads(2){ • #pragma omp section • • • • } • 执行后将打印出以下结果: • section 1 ThreadId = 0 • section 2 ThreadId = 1 printf(“section 1 ThreadId = %d\n”,omp_get_thread_num()); printf(“section 2 ThreadId = %d\n”,omp_get_thread_num()); } • #pragma omp section

《针对OpenMP程序的多类型资源弹性扩展研究》范文

《针对OpenMP程序的多类型资源弹性扩展研究》篇一一、引言随着计算任务的复杂性和规模的日益增长,高性能计算的需求也在不断增加。

OpenMP作为一种并行编程模型,被广泛应用于多核处理器和共享内存系统的程序开发中。

然而,在面对不断变化的任务负载和资源需求时,如何实现OpenMP程序的弹性扩展成为了一个重要的研究课题。

本文旨在研究针对OpenMP程序的多类型资源弹性扩展,包括硬件资源的动态扩展、任务负载的动态分配以及并行算法的优化。

二、OpenMP的概述与现状OpenMP是一种并行编程模型,用于编写跨平台和多线程的并行程序。

通过使用OpenMP,开发者可以在多核处理器和共享内存系统中实现高效的并行计算。

然而,随着任务复杂性和规模的不断增长,传统的固定资源分配模式已经无法满足日益增长的计算需求。

因此,研究多类型资源的弹性扩展对于提高OpenMP 程序的性能和效率具有重要意义。

三、多类型资源弹性扩展的必要性多类型资源弹性扩展对于OpenMP程序至关重要。

首先,硬件资源的动态扩展可以提高计算能力和系统的可靠性。

其次,任务负载的动态分配可以根据程序的实时需求动态调整计算资源的分配,从而实现高效的计算资源利用。

此外,并行算法的优化可以进一步提高程序的并行性能和效率。

因此,研究多类型资源弹性扩展对于提高OpenMP程序的性能和效率具有重要意义。

四、硬件资源动态扩展研究硬件资源的动态扩展是解决计算需求变化的关键手段之一。

在OpenMP程序中,可以通过动态调整线程数、增加处理器核心数或使用分布式计算节点等方式实现硬件资源的动态扩展。

此外,还可以通过虚拟化技术实现计算资源的灵活分配和共享,从而提高系统的可靠性和可用性。

在硬件资源动态扩展的过程中,需要考虑资源的分配策略、调度算法以及负载均衡等问题。

五、任务负载动态分配研究任务负载的动态分配是实现多类型资源弹性扩展的关键技术之一。

在OpenMP程序中,可以通过任务调度算法实现任务负载的动态分配。

OpenMP

OpenMP编程指南进入多核时代后,必须使用多线程编写程序才能让各个CPU核得到利用。

在单核时代,通常使用操作系统提供的API来创建线程,然而,在多核系统中,情况发生了很大的变化,如果仍然使用操作系统API来创建线程会遇到一些问题。

具体来说,有以下三个问题:1)CPU核数扩展性问题多核编程需要考虑程序性能随CPU核数的扩展性,即硬件升级到更多核后,能够不修改程序就让程序性能增长,这要求程序中创建的线程数量需要随CPU核数变化,不能创建固定数量的线程,否则在CPU核数超过线程数量上的机器上运行,将无法完全利用机器性能。

虽然通过一定方法可以使用操作系统API创建可变化数量的线程,但是比较麻烦,不如OpenMP 方便。

2)方便性问题在多核编程时,要求计算均摊到各个CPU核上去,所有的程序都需要并行化执行,对计算的负载均衡有很高要求。

这就要求在同一个函数内或同一个循环中,可能也需要将计算分摊到各个CPU核上,需要创建多个线程。

操作系统API创建线程时,需要线程入口函数,很难满足这个需求,除非将一个函数内的代码手工拆成多个线程入口函数,这将大大增加程序员的工作量。

使用OpenMP创建线程则不需要入口函数,非常方便,可以将同一函数内的代码分解成多个线程执行,也可以将一个for循环分解成多个线程执行。

3)可移植性问题目前各个主流操作系统的线程API互不兼容,缺乏事实上的统一规范,要满足可移植性得自己写一些代码,将各种不同操作系统的api封装成一套统一的接口。

OpenMP是标准规范,所有支持它的编译器都是执行同一套标准,不存在可移植性问题。

综上所述,在多核编程中,使用OpenMP就很有必要,下面列出以前发表在我的CSDN博客中的OpenMP文章,供大家参考。

1、OpenMP并行程序设计(一)介绍OpenMP程序在并行计算时的效率,在双核CPU上效率增加了整整一倍。

阅读全文2、OpenMP并行程序设计(二)1、fork/join并行执行模式的概念2、OpenMP指令和库函数介绍3、parallel 指令的用法4、for指令的使用方法 5 sections和section指令的用法。

OpenMP的多核并行程序设计

public void insert(Object obj) {

用。 只要能理解并熟练掌握反射机制, 就可以将其应用到应用

this.insertRow(0, this.rowObj(obj)); lst.add(0, obj); this.fireTableDataChanged(); }

程序中, 这样不仅可以使程序更加专业化, 而且可以节省很多 的代码, 大大减轻编码的工作量。

if (result[i] == null) { result[i] = "";

} }

进 行 初 始 化 时 , 只 需 要 生 成 一 个 java.util.List 的 具 体 类 实 例 的 集 合 , 如 果 结 合 Hibernate 来 使 用 就 更 方 便 了 。 添 加 记 录 时 , 只需要生成被添加 的类实例, 然后调用 RefTableModel 的 insert

始 化 操 作 和 终 结 操 作 , firstprivate 将 串 行 的 变 量 值 复 制 到 同 名 的私有变量中, 且在每一个线程开始执行的时候初始化一次。 而 lastprivate 则 将 并 行 执 行 中 的 最 后 一 次 循 环 的 私 有 变 量 值 复 制到同名的串行变量中。 3.5 使用规约

规约操作是应用程序中经常出现的, 即将一个二元运算符 应用在一个变量和另外一个值上, 并把结果保存在原变量中, OpenMP 提供了 reduction 子句, 可以有效地合并 循 环 中 关 于 一 个或多个变量的规约操作, 下面代码给出了对 “+” 的规约操 作:

sum=0; #pragma omp parallel for reduction(+:sum) for(k=0;k<100;k++) {

openmp原理

openmp原理OpenMP(Open Multi-Processing)是一种并行编程模型,可简化共享内存编程中多线程编程的任务。

该编程模型利用编译器扩展语法和库等工具提供并行性,使得程序员无需显式地用锁和信号量等同步机制来管理线程。

OpenMP是一个针对共享内存多处理器(SMP)系统的编程打包标准。

OpenMP允许应用程序开发者通过为程序添加特殊的编译指示来创建线程。

这些线程可以并行运行,而不需要开发者显式地进行线程管理。

这种方法可以减少开发时间和代码复杂性,并且可以简化并行化过程。

OpenMP 的原理主要基于以下三个方面:1.编译器扩展语法OpenMP允许编译器对代码进行扩展,以便在代码中添加并行化的指令。

这些指令用于指示编译器在编译期间将计算分割成子任务,并在多线程环境中执行这些子任务。

该指令可以被嵌入到C、C++和Fortran程序中。

以下是OpenMP实现的一个简单的并行 for 循环示例:```c#include <omp.h>#include <stdio.h>int i;#pragma omp parallel for num_threads(4)for (i = 0; i < 8; i++) {printf("Thread %d is running for i=%d.\n", omp_get_thread_num(), i);}return 0;}```omp_get_thread_num()指示当前线程的编号,num_threads()指定使用 4 个线程,使 for 循环分配给这 4 个线程进行并行处理。

在运行上述代码时,将看到 4 个线程交替运行。

2.运行时库OpenMP 运行时库负责管理线程、同步和共享内存访问等操作。

它位于编译器和操作系统之间,是连接应用代码的关键。

在启动程序后,运行时库会自动创建相应数量的线程,根据代码中OpenMP指令控制线程数、同步和并行化任务等。

omp single nowait 用法

omp single nowait 用法OpenMP是一种用于并行计算的编程模型,它允许开发者在多核和多线程系统上编写并行代码,从而提高程序的执行效率。

在OpenMP中,single指令是一种特殊的指令,用于标记一个共享资源,以避免在并发访问时产生数据竞争。

nowait 选项则表示在遇到无法满足的请求时立即返回,而不是等待资源可用。

一、single指令的使用single指令用于标记一个共享资源,以确保在同一时间只有一个线程可以访问该资源。

在使用single指令时,需要指定要保护的资源。

例如,在一个多线程程序中,如果有多个线程需要访问同一个全局变量或共享内存,就可以使用single指令来保护这些资源。

二、nowait选项的使用nowait选项表示在遇到无法满足的请求时立即返回,而不是等待资源可用。

使用nowait选项可以提高程序的执行效率,因为它可以避免等待资源的线程一直阻塞,从而减少程序的运行时间。

但是,需要注意的是,使用nowait选项可能会增加程序的不确定性,因为无法保证请求的线程会立即得到满足。

三、示例代码下面是一个使用single指令和nowait选项的示例代码:```c++#pragmaompparallelforprivate(i)shared(arr)for(inti=0;i<N;i++){#pragmaompsinglenowait{arr[i]=i;//保护共享资源}}```在这个示例中,我们使用single指令保护了一个全局数组arr,以确保在同一时间只有一个线程可以访问它。

同时,我们使用了nowait选项来避免等待资源可用时的阻塞。

在循环中,每个线程都会尝试访问arr数组中的一个元素,并使用single指令来确保只有一个线程可以访问它。

如果其他线程已经访问了该元素,那么当前线程会立即返回,而不会等待该元素可用。

四、注意事项在使用single指令和nowait选项时,需要注意以下几点:1.single指令只能保护共享资源,不能保护私有变量或临时变量。

OpenMP多线程编程及性能优化_707706743

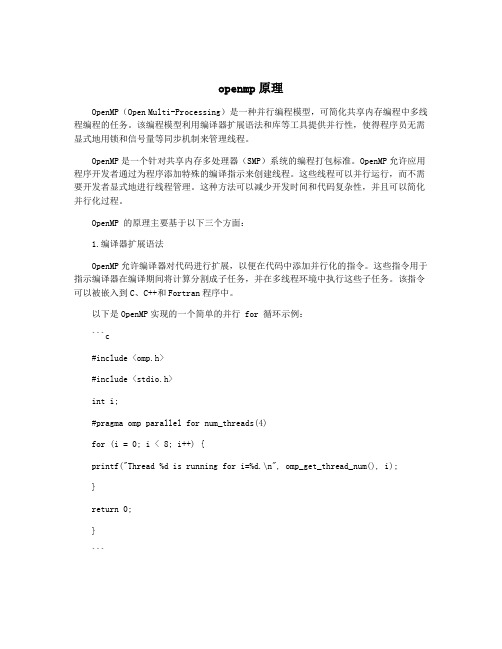

编译指导语句

运行时函数库

ቤተ መጻሕፍቲ ባይዱ

环境变量

图 6. 3 OpenMP 应用程序的组成部分 编译指导语句是 OpenMP 组成中最重要的部分,也是编写 OpenMP 程序的关键。

1.3 使用 Microsoft Visual 2005 编写 OpenMP 程 序

由于 Microsoft Visual Studio .Net 2005 已经支持 OpenMP 的编程,给 OpenMP 的初学者 带来极大的方便。Visual Studio .Net 2005 Professional 完全安装之后,即可编写 OpenMP 程 序,无需另外安装其它软件。因此,本章拟以 Visual Studio .Net 2005 环境讲解 OpenMP 的 编程。在类 Unix 环境下面,编写 OpenMP 程序与编写其它程序类似,需要加上一些有关 OpenMP 的编译选项以及链接相应的库,可以参考相应的编译器选项。从 网站上可以找到相应的信息。

OpenMP 多线程编程及性能优化

本章将以 OpenMP 为例,具体介绍多线程编程的基本技能。OpenMP 是一种针对共享内 存的多线程编程技术,由一些具有国际影响力的大规模软件和硬件厂商共同定义标准。它是 一种编译指导语句指导多线程、共享内存并行的应用程序编程接口(API)。本章介绍 OpenMP 编程的概况、编写 OpenMP 程序所需要的基本技术以及 OpenMP 程序优化的基本方法。由 于 OpenMP 同时支持 C/C++语言和 Fortran 语言,针对 OpenMP 的参考书籍非常少,而使用 C/C++来讲解 OpenMP 的参考资料也更少,因此本章将主要讲解如何用 C/C++语言来实现 OpenMP 的多线程编程。

多核软件开发技术第六讲: OpenMP多线程编程及性能优化

运行时库函数

• OpenMP运行时函数库主要用以设置和获取 执行环境相关的信息 • 它们当中也包含一系列用以同步的API

编译指导语 句

运行时函数库

环境变量

使用VS 2005编写OpenMP程序

• 当前的Visual Studio .Net 2005完全支持 OpenMP 2.0标准 • 通过新的编译器选项 /openmp来支持 OpenMP程序的编译和链接

明确的同步屏障语句

• 在有些情况下,隐含的同步屏障并不能提供有效的 同步措施 • 程序员可以在需要的地方插入明确的同步屏障语句 #pragma omp barrier • 在并行区域的执行过程中,所有的执行线程都会在 同步屏障语句上进行同步

• #pragma omp parallel

{

initialization(); #pragma omp barrier process();

• 循环并行化实际上是并行区域编程的一个特 例 • 并行区域简单的说就是通过循环并行化编译 指导语句使得一段代码能够在多个线程内部 同时执行 • 在C/C++语言中,并行区域编写的格式如下: #pragma omp parallel [clause[clause]…] block

parallel编译指导语句的执行过程

OpenMP多线程应用程序性能分析

影响性能的主要因素

• • • • • 程序并行部分的比率 OpenMP本身的开销 负载均衡 局部性 线程同步带来的开销

}

循环并行化中的顺序语句(ordered)

• 对于循环并行化中的某些处理需要规定执行 的顺序 • 典型的情况:在一次循环的过程中

– 一大部分的工作是可以并行执行的,而其余的工 作需要等到前面的工作全部完成之后才能够执行

Python中的并发编程利用多线程和多进程提升性能

Python中的并发编程利用多线程和多进程提升性能Python中的并发编程:利用多线程和多进程提升性能随着计算机硬件的发展,单核处理器已经不能满足现代计算需求的同时,多核处理器越来越常见。

为了充分利用硬件资源,提升程序的性能,Python提供了多种并发编程的方式,其中包括多线程和多进程。

本文将介绍Python中的并发编程,并探讨如何利用多线程和多进程提升程序的性能。

1. 并发编程概述并发编程是指程序中多个任务(线程或进程)同时运行的技术。

通过并发编程,可以充分利用多核处理器的计算能力,提升程序的运行速度。

2. 多线程2.1 线程基础线程是操作系统能够进行运算调度的最小单位。

在Python中,使用`threading`模块来创建和管理线程。

通过创建多个线程,可以将程序的不同部分并行执行,提高程序的效率。

2.2 多线程应用场景多线程适用于I/O密集型任务,例如网络请求、文件读写等。

在这些任务中,线程可以在等待I/O操作完成的过程中,切换到其他线程执行,从而提高整体的执行效率。

2.3 示例代码```pythonimport threadingdef task():# 执行任务的代码块passif __name__ == "__main__":for _ in range(10):t = threading.Thread(target=task)t.start()```上述代码创建了10个线程,并分别执行相同的任务。

通过多线程的方式,可以同时处理多个任务,提高程序的性能。

3. 多进程3.1 进程基础进程是操作系统中资源分配和调度的基本单位,每个进程都有独立的内存空间和系统资源。

在Python中,使用`multiprocessing`模块来创建和管理进程。

通过创建多个进程,可以将程序的不同部分同时执行,从而提升程序的性能。

3.2 多进程应用场景多进程适用于CPU密集型任务,例如图像处理、科学计算等。

基于OpenMP技术的多核处理器程序的开发实现

基于OpenMP技术的多核处理器程序的开发实现孙洪迪;高柱【摘要】随着多核处理器的日益普及,应用程序能够充分地利用多核处理器的处理能力成为编程的重点.介绍了OpenMP技术的实现机制、使用方法、编程过程中常遇到的问题以及OpenMP技术的优点和缺陷.【期刊名称】《北京工业职业技术学院学报》【年(卷),期】2010(009)001【总页数】4页(P19-22)【关键词】多核处理器;并行化;OpenMP技术【作者】孙洪迪;高柱【作者单位】北京工业职业技术学院,北京100042;目标软件(北京)有限公司,北京100083【正文语种】中文【中图分类】TP311.110 引言近年来,CPU(中央处理器)在飞速的发展,不断的有主频更高、处理能力更强的新产品问世,而如今主频之路已经走到了拐点。

控制 CPU电压和发热量成为限制提高CPU主频从而提高 CPU计算能力的最大障碍。

面对主频之路走到尽头,最具实际意义的方式是增加 CPU内处理核心的数量。

多核 CPU目前市场上已经比较普及了,如何让我们写的程序最大限度的在多核CPU上得到性能的提升,本文将介绍一种解决方案,即 OpenMP技术。

通过OpenMP技术,只需要在原有程序代码上稍加修改,就可以得到多核 CPU强大的并行处理能力。

1 OpenMP原理OpenMP技术是多家计算机供应商联合开发的、针对共享内存多处理器体系结构的可移植并行编程模型。

它采用分叉 -合并的并行执行模式。

当线程遇到并行构造时,就会创建由其自身及其他一些额外线程组成的线程组。

遇到并行构造的线程成为新组中的主线程,组中的其他线程称为组的从属线程。

所有组成员都执行并行构造内的代码。

如果某个线程完成了其在并行构造内的工作,它就会在并行构造末尾的隐式屏障处等待。

当所有组成员都到达该屏障时,这些线程就可以离开该屏障了。

主线程继续执行并行构造之后的用户代码,而从属线程则等待被召集加入到其他组。

因此,大部分的OpenMP线程都在第一次使用线程的时候将其创建,并在整个程序中重复的被使用。

多核环境下OpenMP并行编程(修改版——centos78)

多核环境下OpenMP并⾏编程(修改版——centos78)⼀、 OpenMP简介OpenMP是由OpenMP Architecture Review Board牵头提出的,并已被⼴泛接受的,⽤于共享内存并⾏系统的多线程程序设计的⼀套指导性注释(Compiler Directive)。

OpenMP是⼀种⾯向共享内存以及分布式共享内存的多处理器多线程并⾏编程语⾔,能被⽤于显⽰指导多线程、共享内存并⾏的应⽤程序编程接⼝。

其规范由SGI发起,具有良好的可移植性,⽀持多种编⾔,⽀持多种平台,包括⼤多数的类UNIX以及WindowsNT系统。

OpenMP最初是为了共享内存多处理的系统结构设计的并⾏编程⽅法,与通过消息传递进⾏并⾏编程的模型有很⼤的区别,多个处理器在访问内存的时候使⽤的是相同的内存编址空间。

SMP是⼀种共享内存的体系结构,同时分布式共享内存的系统也属于共享内存的多处理器结构,分布式共享内存将多机的内存资源通过虚拟化的⽅式形成⼀个相同的内存空间提供给多个机⼦上的处理器使⽤,OpenMP对这样的机器也提供了⼀定的⽀持。

所以OpenMP提供了对并⾏算法的⾼层的抽象描述,程序员通过在源代码中加⼊专⽤的pragma来指明⾃⼰的意图,由此编译器可以⾃动将程序进⾏并⾏化,并在必要之处加⼊同步互斥以及通信。

当选择忽略这些pragma,或者编译器不⽀持OpenMP时,程序⼜可退化为通常的程序(⼀般为串⾏),代码仍然可以正常运作,只是不能利⽤多线程来加速程序执⾏。

OpenMP的编程模型以线程为基础,通过编译指导语句来显⽰地指导并⾏化,为编程⼈员提供了对并⾏化的完整控制。

OpenMP的执⾏模型采⽤Fork-Join的形式,Fork-Join执⾏模式在开始执⾏的时候,只有⼀个叫做“主线程“的运⾏线程存在。

主线程在运⾏过程中,当遇到需要进⾏并⾏计算的时候,派⽣出线程来进⾏并⾏执⾏,在并⾏执⾏的时候,主线程和派⽣线程共同⼯作,在并⾏代码结束后,派⽣线程退出或者是挂起,不再⼯作,控制流程回到单独的主线程中。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

现在使用的主流编译器都通过设置环境变量 的方式提供了OpenMP线程与核绑定的接口,在 Linux2.6以上版本内核中也提供了内核函数(sched_ setaffinity)用以实现这种绑定。本文第2部分将分别 介绍PGI、Intel编译器和GCC下实现线程与CPU核的 绑定方法,同时也将介绍sched_setaffinity函数的具体 用法。第3部分将使用benchmark:STREAM在魔方( 曙光5000A)刀片上测试比较在线程绑定与不绑定情 况下的结果。第4部分将对测试结果进行分析并得到 结论。第5部分为全文总结部分。

{

if(CPU_ISSET(i, &get))

{

printf(“The current thread %d bound to

core %d\n“, omp_get_thread_num(), i);

}

}

有内核函数的支持,将可以更灵活的设置线 程与核绑定的情况。编译器的环境变量只能在应用 程序启动之前对应用程序设置绑定的方案,如果将 内核函数添加到应用程序的代码中可以同样实现。 假如应用程序已经启动,再想重新设置绑定方案, 此时编译器选项将无能为力,这时可以借助sched_ setaffinity函数实现工具,动态的调整应用程序的核绑 定方案。使用sched_setaffinity函数,无论是应用程序 代码是否已知,应用程序是否正在运行,都能灵活 的实现或更改绑定方案。

使用PGI编译器编译的OpenMP应用程序可以设

置环境变量MP_BIND和MP_BLIST来实现绑定,环境

变量的作用如下表:

表1 PGI环境变量

环境变量

作用

MP_BIND

设置为“yes”或“y”表示启用绑定功 能;设置为“no”或“n”表示禁用绑 定功能,在默认情况下绑定功能被禁用

MP_BLIST

67

利用OpenMP线程绑定技术提升多核平台应用性能

徐磊 徐莹 张丹丹 上海超级计算中心 上海 201203 lxu@ssc.net.cn

摘要: 多核平台下,线程在核间的动态迁移在一定程度上会导致应用程序性能的下降,如果将线

程绑定在固定的核上运行,使其不再迁移,这种方法将有可能提升应用程序性能,更充分的利 用多核平台的计算能力。本文将介绍如何使用主流的编译器绑定接口以及Linux内核API的方式 实现OpenMP线程与核之间的绑定,使用STREAM这一benchmark来测试比较绑定前后的应用程 序的性能。

关键词:OpenMP 多核 线程 绑定

1. 引言

如今绝大部分的高性能的Cluster采用多核处理 器来构建SMP节点,在单个处理器内集成多个内核已 经称为处理器发展的方向。面对越来越多的处理核 心,如何进行高效的使用这些核,已经成为研究的 热点。针对新的多核平台,主流的操作系统都对其 调度算法进行了调整,以提高所有处理器核的使用 效率。其中最常用的一种方法就是负载平衡技术, 将CPU的负荷平均分配到多个CPU核中,这就意味 着,在比较繁忙的CPU核上运行的线程将可能会被操 作系统自动迁移到空闲的CPU核上,这种迁移将导致 被迁移的线程的Context(包括寄存器值和Cache中的 数据)需要迁移到新的CPU核上。如果这种迁移过于 频繁,很显然会导致应用程序性能的下降。

该段代码将paralle region里面的8个线程依次绑 定到核2,5,13,9,3,6,7,4。同样可以使用 sched_getaffinity函数获取线程的能够使用的核的列 表,示例代码如下:

int num_processors = sysconf(_SC_NPROCESSORS_

CONF); //获取当前节点核的数目

68

《高性能计算发展与应用》 2009年第一期 总第二十六期

2.1.2 GCC[2] 使用GCC(注:GCC4.2以上版本才支持 OpenMP)编译的OpenMP应用程序实现线程绑定需 要设置环境变量GOMP_CPU_AFFINITY,GOMP_ CPU_AFFINITY的取值和MP_BLIST类似,需要绑 定的核ID之间使用空格隔开,例:GOMP_CPU_ AFFINITY="2 3 5 7"。

图2 scatter模式 图2描述了当KMP_AFFINITY=granularity=fine, scatter时线程的绑定情况。scatter模式将线程尽可

能在所有的CPU(Package)间分散开,这种模式适 合线程间需要竞争资源的情况,将这些线程分散开 后,线程之间的竞争将会减少,所有的核的资源能 得到充分的利用。

2.1.3 Intel编译器[3] Intel编译器分别从上层、中间层和底层三个 层次提供线程与CPU核绑定的接口(只适用与采用 Intel处理器的平台),在上层可以通过设置环境变量 KMP_AFFINITY来实现,利用KMP_AFFINITY可以实 现多种绑定模式,常用的有三种:compact,scatter和 explicit。 图1描述了当KMP_AFFINITY=granularity=fine, compact时线程的绑定情况。当前的节点拥有两个 CPU(Package0,1)每个CPU内集成两个核, 每个核支持超线程技术( HT,Hyper-Threading Technology)。

compact和scatter两种模式简化了绑定方案的设 置,在用户对当前节点处理器拓扑结构未知的情况 下,实现线程的聚集与分散,不需要用户根据每个 核的物理位置,手动的设置线程与具体核的绑定方 案,这种方式适合不同的Intel平台,具有可移植性。

Intel编译器在中间层提供了和PGI、GCC类似 的绑定方法,实现线程与核的一对一的绑定。这 种模式需要借助环境变量GOMP_CPU_AFFINITY, 具体的设置方法和GCC相同。同时也可以借助 KMP_AFFINITY来实现,在explicit模式下可以利 用参数proclist指定需要绑定到的核,具体的设置 可以为:KMP_AFFINITY=granularity=fine,proclist =[3,0,1,2],explicit。采用这种方式将0-3号线程依次绑 定到核3,0,1,2。使用proclist可以更灵活的使部分 线程绑定在一个核上运行,部分线程在指定的核间 动态的迁移,例:

2.1.4 通过内核函数实现OpenMP线程绑定核 从Linux2.6内核开始,Linux系统提供API函数 sched_setaffinity和sched_getaffinity用于设置或获取线 程的可以使用的CPU核。这两个函数的定义如下:

int sched_setaffinity(pid_t pid, unsigned int cpusetsize, cpu_set_t *mask);

图1 compact模式 采用compact模式时,所有的OpenMP线程将尽 可能均匀的集中分配在一个Package内部,如上图所 示,0-3号线程优先绑定到Package0的核上,余下 的绑定到Package1上。compact适合OpenMP线程在 连续的迭代过程中需要共享数据的情况,将这些线 程尽可能的绑定到一起,将减少通讯的开销,提高 Cache的命中率。

指定线程被绑定到的核ID列表

使用示例脚本如下:

export OMP_DYNAMIC=false export OMP_NUM_THREADS=8 export MP_BIND=’y’ export MP_BLIST=0,3,7,9,11,12,14,的作用是将OpenMP应用程序appbind. exe的parallel region里面的8个线程依次绑定到核0, 3,7,9,11,12,14,15。

2. 进程绑定到核的实现方法

2.1 通过编译器实现OpenMP线程绑定核 编译器通过设置环境变量的方式来指定每个

OpenMP线程需要绑定到的核的ID,每个核的ID对 应于cpuinfo文件中的processor号。下面将分别介绍 PGI、GCC和Intel编译器下的设置方法。

2.1.1 PGI[1]

3. 使用STREAM进行性能测试

下面将使用STREAM分别对线程绑定与不绑定的 情况进行测试,比较这两种情况下应用程序的性能。

3.1 测试环境 测试环境使用一个魔方刀片,安装SELS10SP2操

作系统,内核版本2.6.16.60-0.21-smp,采用4路4核 AMD Opteron 8347HE 1.9G,64GB内存,PGI版本 8.0-5。编译选项使用-fast -mp -tp barcelona-64 - mcmodel=medium

cpu_set_t get;

int i = 0;

CPU_ZERO(&get);

sched_getaffinity(0, sizeof(cpu_set_t), &get); //获取当前

调用线程的可以使用的核

for(i = 0; i < num_processors; i++)

int sched_getaffinity(pid_t pid, unsigned int cpusetsize, cpu_set_t *mask);

这两个函数的参数列表完全一致,其中pid表示 需要设置或获取绑定信息的线程id(或进程id),如

果为0,表示对当前调用的线程进行设置;第2个参 数cpusetsize一般设置为sizeof(cpu_set_t),用以表示 第3个参数指向的内存结构对象的大小;第3个参数 mask指向类型为cpu_set_t对象的指针,用以设置或获 取指定线程可以使用的CPU核列表。Linux提供函数 CPU_ZERO、CPU_SET和CPU_ISSET对cpu_set_t类型 的对象进行操作,其中CPU_ZERO用于清空cpu_set_ t类型对象的内容,CPU_SET用于设置cpu_set_t类型 对象,CPU_ISSET用于判断cpu_set_t类型对象与核对 应的位是否被设置。