jieba模块的分词方法

自然语言处理之jieba分词

⾃然语⾔处理之jieba分词在所有⼈类语⾔中,⼀句话、⼀段⽂本、⼀篇⽂章都是有⼀个个的词组成的。

词是包含独⽴意义的最⼩⽂本单元,将长⽂本拆分成单个独⽴的词汇的过程叫做分词。

分词之后,⽂本原本的语义将被拆分到在更加精细化的各个独⽴词汇中,词汇的结构⽐长⽂本简单,对于计算机⽽⾔,更容易理解和分析,所以,分词往往是⾃然语⾔处理的第⼀步。

对于英⽂⽂本,句⼦中的词汇可以通过空格很容易得进⾏划分,但是在我们中⽂中则不然,没有明显的划分标志,所以需要通过专门的⽅法(算法)进⾏分词。

在Python中,有多种库实现了各种⽅法⽀持中⽂分词,例如:jieba、hanlp、pkuseg等。

在本篇中,先来说说jieba分词。

1 四种模式分词(1)精确模式:试图将句⼦最精确地切开,适合⽂本分析。

精确分词模式对应的⽅法是jieba.cut,该⽅法接受四个输⼊参数: 需要分词的字符串;cut_all 参数⽤来控制是否采⽤全模式,值为False时表⽰采⽤精确分词模式;HMM 参数⽤来控制是否使⽤ HMM 模型。

(2)全模式:把句⼦中所有的可以成词的词语都扫描出来,速度⾮常快,但是不能解决歧义。

全模式同样是调⽤jieba.cut⽅法实现,不过cut_all参数值设置为True。

(3)搜索引擎模式:在精确模式的基础上,对长词再词切分,提⾼召回率,适合⽤于搜索引擎分词。

搜索引擎模式对应的⽅法是jieba.cut_for_search。

该⽅法接受两个参数:需要分词的字符串;是否使⽤ HMM 模型。

该⽅法适合⽤于搜索引擎构建倒排索引的分词,粒度⽐较细。

注意,待分词的字符串可以是 unicode 或 UTF-8 字符串、GBK 字符串。

注意:不建议直接输⼊ GBK 字符串,可能⽆法预料地错误解码成 UTF-8。

另外,jieba.cut 以及 jieba.cut_for_search 返回的结构都是⼀个可迭代的generator,可以使⽤ for 循环来获得分词后得到的每⼀个词语(unicode),或者⽤jieba.lcut 以及 jieba.lcut_for_search 直接返回 list。

jieba分词归纳总结

jieba分词归纳总结

⼀、jieba介绍

jieba是NLP中常⽤的中⽂分词库

⼆、词库

1、默认词库

jieba 默认有349046个词,然后每⾏的含义是: 词词频词性

⾸先来看看jieba分词每次启动时,做了件什么事情,它做了2件事情:

1. 加载结巴⾃⾝的默认词库

2. 将默认词库模型加载到本机缓存,之后每次都从本地缓存中去加载默认词库缓存⽂件: jieba.cache

使⽤add_word(word, freq=None, tag=None)和del_word(word)可在程序中动态修改词典。

使⽤suggest_freq(segment, tune=True)可调节单个词语的词频,使其能(或不能)被分出来。

2、⾃定义词库

jieba.load_userdict(config.keywords_path)

三、词性标注

词性(词类)是词汇中剧本的语法属性,⽽词性标注是在给定句⼦中判定每个词的语法范畴,确定它的词性并加以标注的过程。

参考。

jieba库的原理

jieba库的原理

jieba库是一款中文文本分词库,采用了基于前缀词典和动态规划算法的分词方法。

该库可用于中文文本的分词、关键词提取、词性标注等任务。

jieba库的原理主要有以下几个方面:

1. 前缀词典

jieba库采用了基于前缀词典的分词方法。

前缀词典是一个包含了所有中文单词的列表,每个单词都有一个或多个前缀。

例如,“中国”这个词的前缀可以是“中”、“中国”等。

在分词时,首先需要对中文文本进行分词,得到一个单词列表。

然后按照前缀词典中的单词顺序,从前往后匹配单词,直到找到匹配的单词为止。

如果找不到匹配的单词,则将当前单词与下一个单词合并,继续匹配,直到匹配成功或者无法匹配为止。

2. 动态规划算法

在基于前缀词典的分词方法中,如果匹配失败,则需要进行回溯。

jieba库采用了动态规划算法来避免回溯,提高分词速度。

动态规划算法是一种将问题分解成子问题并重复利用已经求解过的子问题结

果的算法。

在jieba库中,将文本划分成多个子问题,每个子问题的解决依赖于前面子问题的结果,并且已经求解过的子问题结果可以被重复利用。

3. HMM模型

jieba库还采用了隐马尔可夫模型(HMM)来进行词性标注。

HMM

模型是一种统计模型,可以根据给定的序列,推断出隐藏的状态序列。

在jieba库中,将文本划分成多个子问题,每个子问题都对应一个状态。

然后使用HMM模型来根据子问题的状态序列,对文本进行词性标注。

总之,jieba库的原理是将中文文本分解成多个子问题,使用前缀词典、动态规划算法和HMM模型来进行分词、关键词提取和词性标注等任务。

python中import jieba 注释

Python 是一种简单易学,功能强大的编程语言,被广泛应用于数据分析、人工智能、网络爬虫等领域。

在 Python 中,jieba 是一个强大的中文分词工具,可以帮助我们对中文文本进行分词处理,是自然语言处理中常用的工具之一。

1. jieba 的安装和导入在使用 jieba 进行中文分词之前,首先要进行安装。

可以使用 pip 命令来进行安装,命令如下:```pip install jieba```安装完成后,就可以在 Python 中通过 import 命令导入 jieba 模块了:```import jieba```2. jieba 中文分词的基本用法导入 jieba 模块后,就可以开始使用 jieba 进行中文分词了。

jieba 提供了两种模式的分词:精确模式和全模式。

精确模式是将文本精确地切分,适合文本分析时使用。

```seg_list = jieba.cut("我来到北京清华大学", cut_all=False)print("精确模式: " + "/ ".join(seg_list))```全模式是将文本中所有可能的词语都扫描出来,并以列表的形式返回,适合搜索引擎对文本进行切分。

```seg_list = jieba.cut("我来到北京清华大学", cut_all=True)print("全模式: " + "/ ".join(seg_list))```3. jieba 中文分词的高级用法除了基本的分词功能外,jieba 还提供了许多高级的功能,如添加自定义词典、关键词提取、词性标注等。

添加自定义词典可以帮助 jieba 更好地识别特定领域的词汇,提高分词的准确性。

```jieba.load_userdict("userdict.txt")```关键词提取可以帮助我们从文本中抽取出一些关键词,常用于文本摘要、关键词标注等场景。

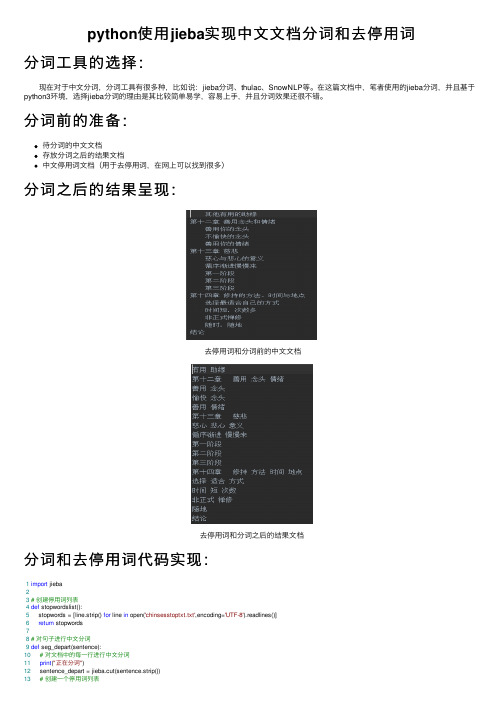

python使用jieba实现中文文档分词和去停用词

python使⽤jieba实现中⽂⽂档分词和去停⽤词分词⼯具的选择: 现在对于中⽂分词,分词⼯具有很多种,⽐如说:jieba分词、thulac、SnowNLP等。

在这篇⽂档中,笔者使⽤的jieba分词,并且基于python3环境,选择jieba分词的理由是其⽐较简单易学,容易上⼿,并且分词效果还很不错。

分词前的准备:待分词的中⽂⽂档存放分词之后的结果⽂档中⽂停⽤词⽂档(⽤于去停⽤词,在⽹上可以找到很多)分词之后的结果呈现:去停⽤词和分词前的中⽂⽂档去停⽤词和分词之后的结果⽂档分词和去停⽤词代码实现:1import jieba23# 创建停⽤词列表4def stopwordslist():5 stopwords = [line.strip() for line in open('chinsesstoptxt.txt',encoding='UTF-8').readlines()]6return stopwords78# 对句⼦进⾏中⽂分词9def seg_depart(sentence):10# 对⽂档中的每⼀⾏进⾏中⽂分词11print("正在分词")12 sentence_depart = jieba.cut(sentence.strip())13# 创建⼀个停⽤词列表14 stopwords = stopwordslist()15# 输出结果为outstr16 outstr = ''17# 去停⽤词18for word in sentence_depart:19if word not in stopwords:20if word != '\t':21 outstr += word22 outstr += ""23return outstr2425# 给出⽂档路径26 filename = "Init.txt"27 outfilename = "out.txt"28 inputs = open(filename, 'r', encoding='UTF-8')29 outputs = open(outfilename, 'w', encoding='UTF-8') 3031# 将输出结果写⼊ou.txt中32for line in inputs:33 line_seg = seg_depart(line)34 outputs.write(line_seg + '\n')35print("-------------------正在分词和去停⽤词-----------")36 outputs.close()37 inputs.close()38print("删除停⽤词和分词成功!!!")。

jieba分词的公式

jieba分词的公式

jieba分词的公式主要包括基于词频统计的分词原则和关键词提取方法。

基于词频统计的分词原则是jieba分词的核心,它采用词频统计计算得分最高者,为最终分词结果。

具体计算公式如下:

输入文本:S,词典总词频:N(常量),单个词语的词频:P(A)

1)S = A+B+C+D 分词概率:p1= P(A)P(B)P(C)P(D)/NNNN 2)S = A +BC+D 分词概率:p2= P(A)P(BC)P(D)/NNN

字典新增词语时,词频设置基于此公式即可。

另外,jieba分词还提供了两种关键词提取方法,分别基于TF-IDF算法和TextRank算法。

基于TF-IDF算法的关键词提取是jieba分词中常用的方法之一,其计算公式为:TF-IDF = TF IDF。

其中,TF(term frequency,词频)表示某个给定的词语在该文件中出现的次数,IDF(inverse document frequency,逆

文件频率)表示如果包含词条的文件越少,则说明词条具有很好的类别区分能力。

以上是jieba分词的公式,仅供参考,如需获取更多信息,建议咨询专业的技术人员。

Jieba分词词性标注以及词性说明

Jieba分词词性标注以及词性说明分词实例import jiebaimport jieba.analyseimport jieba.possegdef dosegment_al(sentence):"""带词性标注,对句⼦进⾏分词,不排除停词等"""sentence_seged = jieba.posseg.cut(sentence.strip())outStr = ''for x in setence_seged:outStr += "{}/{}".format(x.world,x.flag)return outStr词性标注表test test1test2ag形语素形容词性语素。

形容词代码为 a,语素代码g前⾯置以A。

a形容词取英语形容词 adjective的第1个字母。

ad副形词直接作状语的形容词。

形容词代码 a和副词代码d并在⼀起。

an名形词具有名词功能的形容词。

形容词代码 a和名词代码n并在⼀起。

b区别词取汉字“别”的声母。

c连词取英语连词 conjunction的第1个字母。

dg副语素副词性语素。

副词代码为 d,语素代码g前⾯置以D。

d副词取 adverb的第2个字母,因其第1个字母已⽤于形容词。

e叹词取英语叹词 exclamation的第1个字母。

f⽅位词取汉字“⽅”g语素绝⼤多数语素都能作为合成词的“词根”,取汉字“根”的声母。

h前接成分取英语 head的第1个字母。

i成语取英语成语 idiom的第1个字母。

j简称略语取汉字“简”的声母。

k后接成分l习⽤语习⽤语尚未成为成语,有点“临时性”,取“临”的声母。

m数词取英语 numeral的第3个字母,n,u已有他⽤。

Ng名语素名词性语素。

名词代码为 n,语素代码g前⾯置以N。

n名词取英语名词 noun的第1个字母。

nr⼈名名词代码 n和“⼈(ren)”的声母并在⼀起。

jieba分词库介绍-关键字提取

jieba分词库介绍-关键字提取jieba介绍jieba是优秀的中⽂分词第三⽅库- 中⽂⽂本需要通过分词获得单个的词语 - jieba是优秀的中⽂分词第三⽅库,需要额外安装- jieba库提供三种分词模式,最简单只需掌握⼀个函数之前疫情监控系统的词云图制作过程中的分词技术就是⽤jieba实现的,效果图如下:安装⽅式直接cmd命令⾏进⾏pip安装 pip install jiebajieba分词的三种模式精确模式:把⽂本精确的切分开,不存在冗余单词全模式:把⽂本中所有可能的词语都扫描出来,有冗余搜索引擎模式:在精确模式基础上,对长词再次切分jieba库常⽤函数jieba分词实例先看⼀个简单的例⼦:将下⾯这句话进⾏分词:⽯家庄铁道⼤学是⼀个⾮常好的⼤学,这⾥的⼀切都是美好的分词效果如下:但是可见“⼤学”这个词没有被分出来是什么原因呢?其实这⾥是因为设置了⼀个词语停⽤表,关键词对⽐过程中如果有停⽤表中的词可以删除不显⽰,分词结果我是⽤关键词权重前6名的词⽤-连接起来输出。

停⽤表可以⾃⼰设置代码实现1import jieba2import jieba.analyse34#第⼀步:分词,这⾥使⽤结巴分词全模式5 text = '''⽯家庄铁道⼤学是⼀个⾮常⾮常好的⼤学,这⾥的⼀切都是美好的'''6 fenci_text = jieba.cut(text)7#print(fenci_text)89#第⼆步:去停⽤词10#这⾥是有⼀个⽂件存放要改的⽂章,⼀个⽂件存放停⽤表,然后和停⽤表⾥的词⽐较,⼀样的就删掉,最后把结果存放在⼀个⽂件中11 stopwords = {}.fromkeys([ line.rstrip() for line in open('D:\learnpath\Python\jieba_cut_text\stop.txt',encoding='UTF-8') ]) #line.rstrip是⽤来跳过换⾏符号的12 final = ""13for word in fenci_text:14if word not in stopwords:15if (word != "。

pythonjieba分词进阶

pythonjieba分词进阶⽂本准备到⽹上随便⼀搜"三体全集",就很容易下载到三体三部曲的全集⽂本(txt⽂档⼤概有2~3Mb),这⾥重命名为santi.txt,并存放到当前⽬录下。

读取三体全集⽂本# coding:utf-8import sys# 设置环境为utf-8编码格式,防⽌处理中⽂出错reload(sys)sys.setdefaultencoding('utf-8')# 读取三体全集⽂本santi_text = open('./santi.txt').read()print len(santi_text)# 输出:'''2681968'''可以看出⽂本的长度有2681968字节,数据量还是很庞⼤的,语料库⾜够丰富。

对⽂本分词并缓存到⽂件中下⾯⽤jieba.posseg模块对⽂本进⾏分词并标注词性,这⾥标注词性的⽬的是为了后⾯接下来根据词性过滤掉那些没有实际意义的词(如'好的'、'⼀般'、'他的'等等这种词),⽽将分词结果缓存到⽂件中是为了提⾼每次运⾏脚本的效率,毕竟这么⼤的数据量,分词⼀次还是耗时很长的(⼤概为⼏分钟),缓存到⽂件中,只需第⼀次做⼀次分词,后⾯再运⾏脚本就只需从⽂件中读取分词结果即可,毕竟读⽂件的速度⽐分词要快很多。

下⾯上代码:import jieba.posseg as psg# 将三体全集⽂本分词,并附带上词性,因为数据量⽐较⼤,防⽌每次运⾏脚本都花⼤量时间,所以第⼀次分词后就将结果存⼊⽂件out.txt中# 相当于做⼀个缓存,格式为每个词占⼀⾏,每⼀⾏的内容为:# 词词性santi_words_with_attr = [(x.word,x.flag) for x in psg.cut(santi_text) if len(x.word) >= 2] # 这⾥的x.word为词本⾝,x.flag为词性print len(santi_words_with_attr) # 输出:with open('out.txt','w+') as f:for x in santi_words_with_attr:f.write('{0}\t{1}\n'.format(x[0],x[1]))运⾏上⾯⼀段代码,⼏分钟之后在当前⽬录⽣成了⼀个out.txt⽂件,有273033⾏,数据量还是⾮常⼤的,其前⼏⾏的内容如下:'''⼿机 nTXT eng⼩说 n下载 vwww engsjtxt engcom eng欢迎您 lsjtxt eng推荐 v好书 nxxx'''你肯定会⼤呼⼀声:这什么⿁不急,这是因为⽂本中存在⼤量的我们不需要的词,甚⾄还有很多空⽩符词,这肯定是没法玩的,所以接下来我们对垃圾词进⾏过滤,对数据做⼀下清洗。

jieba分词的选择题

jieba分词的选择题好的,以下是一篇完整的关于《jieba分词的选择题》文档:一、什么是jieba分词?jieba是一个基于统计的中文分词工具库,主要用于自然语言处理和文本挖掘领域。

它可以实现对中文文本进行精确的分词,并提供多种分词模式和优化策略,以满足不同场景下的需求。

二、jieba分词的基本使用方法1. 安装jieba库:可以通过pip命令进行安装,或者通过conda等工具进行安装。

2. 导入jieba库:在Python代码中导入jieba库,以便使用其分词功能。

3. 输入待分词的文本:将要分词的文本输入到Python代码中。

4. 使用jieba进行分词:使用jieba库提供的分词方法对文本进行分词。

1. 下列哪种分词方式最适合中文文本处理?A. 基于规则的分词B. 基于统计的分词C. 基于深度学习的分词D. 基于混合模型的分词E. 其他2. jieba库提供了哪些分词模式?A. 全模式B. 精确模式C. 搜索引擎模式D. 自定义模式E. 以上全部3. 如何使用jieba库提供的搜索引擎模式进行大规模文本检索?A. 将所有文本输入到jieba中进行分词,然后使用搜索引擎算法进行检索。

B. 使用jieba库提供的搜索引擎接口,将待检索的文本进行分词后,再通过搜索引擎算法进行检索。

C. 使用其他搜索引擎库,如Elasticsearch等,与jieba库结合使用。

D. 不需要进行特殊处理,直接使用jieba库的搜索引擎模式进行检索即可。

4. 如何优化jieba分词的性能?A. 使用更多的GPU计算资源,提高分词速度。

B. 对文本进行批量处理,减少内存占用。

C. 对分词结果进行多次迭代优化,提高准确率。

D. 以上全部。

5. jieba库支持哪些语言的文本处理?A. 中文B. 英文C. 日文D. 其他语言都可以支持,但需要自行编写额外的分词规则。

E. 不支持其他语言的文本处理。

6. 如果在使用jieba库时遇到问题,应该如何寻求帮助?A. 查看jieba库的官方文档和示例代码,自行解决问题。

jieba库用法(一)

jieba库用法(一)jieba库的用法jieba库是一款常用的中文分词工具,可以将文本按照词语进行切分,帮助开发者进行中文文本处理。

本文介绍了jieba库的几个常用用法。

安装jieba库使用pip命令可以很方便地安装jieba库:pip install jieba安装完成后,即可在Python中使用jieba库的功能。

分词功能jieba库最主要的功能就是对中文文本进行分词,将文本切分成一个个独立的词语。

可以通过以下代码实现分词功能:import jiebasentence = "这是一段中文文本"words = (sentence)for word in words:print(word)上述代码中,首先导入jieba库,然后定义一个中文文本sentence。

通过调用jieba的cut()函数对文本进行分词,返回一个可迭代的词语列表。

最后通过for循环逐个输出分词结果。

分词模式jieba提供了不同的分词模式,可以根据需要进行选择。

精确模式精确模式是默认的分词模式,试图将句子最精确地切分成词语。

可以使用()函数的默认参数来实现。

import jiebasentence = "我来到北京清华大学"words = (sentence)print("/ ".join(words))上述代码中,使用了精确模式对句子进行分词,并将切分结果使用"/ "连接成字符串输出。

全模式全模式会对句子中所有可能的词语进行切分,速度非常快,但可能会产生一些冗余的词语。

可以使用()函数的cut_all参数设为True 来启用全模式。

import jiebasentence = "我来到北京清华大学"words = (sentence, cut_all=True)print("/ ".join(words))上述代码中,通过将cut_all参数设为True,启用了全模式。

python 古诗词词语 jieba

一、介绍Python自然语言处理工具jiebaPython是一种广受欢迎的编程语言,它被广泛应用于数据分析、文本处理、人工智能等领域。

在自然语言处理方面,Python有许多强大的工具和库,其中jieba是一个常用的中文分词工具。

它可以帮助我们对中文文本进行分词、词性标注等操作,为后续的文本分析和处理提供基础支持。

二、Python中jieba的安装和基本使用1. 安装jieba使用pip工具可以轻松安装jieba,只需在命令行中输入以下命令即可:```bashpip install jieba```安装完成后,就可以在Python代码中导入jieba模块,开始使用它提供的功能了。

2. 分词示例下面是一个简单的分词示例,展示如何利用jieba对一句中文古诗进行分词:```pythonimport jiebapoem = "床前明月光,疑是地上霜。

举头望明月,低头思故乡。

"words = jieba.lcut(poem)print(words)```运行以上代码,会得到以下输出:```['床前', '明月', '光', ',', '疑是', '地上', '霜', '。

', '举头', '望', '明月', ',', '低头', '思', '故乡', '。

']```可以看到,jieba成功地将古诗中的词语进行了分词,并且保留了标点符号。

这为后续的词频统计、情感分析等工作奠定了基础。

三、jieba的高级应用1. 添加自定义词典在某些特定的领域中,可能会有一些领域相关的专有名词或术语,这些词语可能不在jieba的默认词典中。

但是,我们可以通过添加自定义词典的方式,让jieba能够识别并分词这些词语。

jieba库使用实例

jieba库使用实例一、介绍jieba库是一个中文分词工具,它能够将中文文本分成词语序列。

jieba 库支持三种分词模式,包括精确模式、全模式和搜索引擎模式。

此外,它还支持添加自定义词典和关键词提取功能。

二、安装jieba库的安装非常简单,只需要在命令行输入以下命令即可:```pip install jieba```三、基本用法1. 精确模式:精确模式是默认的分词模式,它能够将文本尽可能多地切分成单独的词语。

```pythonimport jiebatext = "我爱自然语言处理"seg_list = jieba.cut(text, cut_all=False)print("精确模式:", "/".join(seg_list))```输出结果为:```精确模式:我/爱/自然语言处理```2. 全模式:全模式会将文本中所有可能的词语都切分出来,速度较快但存在冗余。

```pythonimport jiebatext = "我爱自然语言处理"seg_list = jieba.cut(text, cut_all=True)print("全模式:", "/".join(seg_list))```输出结果为:```全模式:我/爱/自然/自然语言/语言/处理```3. 搜索引擎模式:搜索引擎模式会对长词进行再次切分,提高召回率,适用于搜索引擎分词。

```pythonimport jiebatext = "我爱自然语言处理"seg_list = jieba.cut_for_search(text)print("搜索引擎模式:", "/".join(seg_list))```输出结果为:```搜索引擎模式:我/爱/自然/语言/处理/自然语言```四、添加自定义词典jieba库支持添加自定义词典,可以通过添加自定义词典来提高分词的准确性。

python中文分词库jieba使用方法详解

python中⽂分词库jieba使⽤⽅法详解安装python中⽂分词库jieba法1:Anaconda Prompt下输⼊conda install jieba法2:Terminal下输⼊pip3 install jieba1、分词1.1、CUT函数简介cut(sentence, cut_all=False, HMM=True)返回⽣成器,遍历⽣成器即可获得分词的结果lcut(sentence)返回分词列表import jiebasentence = '我爱⾃然语⾔处理'# 创建【Tokenizer.cut ⽣成器】对象generator = jieba.cut(sentence)# 遍历⽣成器,打印分词结果words = '/'.join(generator)print(words)打印结果我/爱/⾃然语⾔/处理import jiebaprint(jieba.lcut('我爱南海中学'))打印结果[‘我', ‘爱', ‘南海中学']1.2、分词模式精确模式:精确地切开全模式:所有可能的词语都切出,速度快搜索引擎模式:在精确模式的基础上,对长词再次切分import jiebasentence = '订单数据分析'print('精准模式:', jieba.lcut(sentence))print('全模式:', jieba.lcut(sentence, cut_all=True))print('搜索引擎模式:', jieba.lcut_for_search(sentence))打印结果精准模式: [‘订单', ‘数据分析']全模式: [‘订单', ‘订单数', ‘单数', ‘数据', ‘数据分析', ‘分析']搜索引擎模式: [‘订单', ‘数据', ‘分析', ‘数据分析']1.3、词性标注jieba.possegimport jieba.posseg as jpsentence = '我爱Python数据分析'posseg = jp.cut(sentence)for i in posseg:print(i.__dict__)# print(i.word, i.flag)打印结果{‘word': ‘我', ‘flag': ‘r'}{‘word': ‘爱', ‘flag': ‘v'}{‘word': ‘Python', ‘flag': ‘eng'}{‘word': ‘数据分析', ‘flag': ‘l'}词性标注表标注解释标注解释标注解释a形容词mq数量词tg时语素ad副形词n名词u助词ag形语素ng例:义乳亭ud例:得an名形词nr⼈名ug例:过b区别词nrfg也是⼈名uj例:的c连词nrt也是⼈名ul例:了d副词ns地名uv例:地df例:不要nt机构团体uz例:着dg副语素nz其他专名v动词e叹词o拟声词vd副动词f⽅位词p介词vg动语素g语素q量词vi例:沉溺于等同于h前接成分r代词vn名动词i成语rg例:兹vq例:去浄去过唸过j简称略语rr⼈称代词x⾮语素字k后接成分rz例:这位y语⽓词l习⽤语s处所词z状态词m数词t时间词zg例:且丗丟1.4、词语出现的位置jieba.tokenize(sentence)import jiebasentence = '订单数据分析'generator = jieba.tokenize(sentence)for position in generator:print(position)打印结果(‘订单', 0, 2)(‘数据分析', 2, 6)2、词典2.1、默认词典import jieba, os, pandas as pd# 词典所在位置print(jieba.__file__)jieba_dict = os.path.dirname(jieba.__file__) + r'\dict.txt'# 读取字典df = pd.read_table(jieba_dict, sep=' ', header=None)[[0, 2]]print(df.head())# 转字典dt = dict(df.values)print(dt.get('暨南⼤学'))2.2、添词和删词往词典添词add_word(word, freq=None, tag=None)往词典删词,等价于add_word(word, freq=0)del_word(word)import jiebasentence = '天长地久有时尽,此恨绵绵⽆绝期'# 添词jieba.add_word('时尽', 999, 'nz')print('添加【时尽】:', jieba.lcut(sentence))# 删词jieba.del_word('时尽')print('删除【时尽】:', jieba.lcut(sentence))打印结果添加【时尽】: [‘天长地久', ‘有', ‘时尽', ‘,', ‘此恨绵绵', ‘⽆', ‘绝期']删除【时尽】: [‘天长地久', ‘有时', ‘尽', ‘,', ‘此恨绵绵', ‘⽆', ‘绝期']2.3、⾃定义词典加载新建词典,按照格式【单词词频词性】添词,以UTF-8编码保存使⽤函数load_userdict加载词典import os, jieba# 创建⾃定义字典my_dict = 'my_dict.txt'with open(my_dict, 'w', encoding='utf-8') as f:f.write('慕容紫英 9 nr\n云天河 9 nr\n天河剑 9 nz')# 加载字典进⾏测试sentence = '慕容紫英为云天河打造了天河剑'print('加载前:', jieba.lcut(sentence))jieba.load_userdict(my_dict)print('加载后:', jieba.lcut(sentence))os.remove(my_dict)打印结果加载前: [‘慕容', ‘紫英为', ‘云', ‘天河', ‘打造', ‘了', ‘天河', ‘剑']加载后: [‘慕容紫英', ‘为', ‘云天河', ‘打造', ‘了', ‘天河剑']2.4、使单词中的字符连接或拆分suggest_freq(segment, tune=False)import jiebasentence = '上穷碧落下黄泉,两处茫茫皆不见'print('修正前:', ' | '.join(jieba.cut(sentence)))jieba.suggest_freq(('落', '下'), True)print('修正后:', ' | '.join(jieba.cut(sentence)))打印结果修正前:上穷 | 碧 | 落下 | 黄泉 | , | 两处 | 茫茫 | 皆 | 不见修正后:上穷 | 碧落 | 下 | 黄泉 | , | 两处 | 茫茫 | 皆 | 不见3、jieba分词原理基于词典,对句⼦进⾏词图扫描,⽣成所有成词情况所构成的有向⽆环图(Directed Acyclic Graph)根据DAG,反向计算最⼤概率路径(动态规划算法;取对数防⽌下溢,乘法运算转为加法)根据路径获取最⼤概率的分词序列import jiebasentence = '中⼼⼩学放假'DAG = jieba.get_DAG(sentence)print(DAG)route = {}jieba.calc(sentence, DAG, route)print(route){0: [0, 1, 3], 1: [1], 2: [2, 3], 3: [3], 4: [4, 5], 5: [5]}最⼤概率路径{6: (0, 0), 5: (-9.4, 5), 4: (-12.6, 5), 3: (-20.8, 3), 2: (-22.5, 3), 1: (-30.8, 1), 0: (-29.5, 3)} 4、识别【带空格的词】⽰例:使Blade Master这类中间有空格的词被识别import jieba, resentence = 'Blade Master疾风刺杀Archmage'jieba.add_word('Blade Master') # 添词print('修改前:', jieba.lcut(sentence))jieba.re_han_default = pile('(.+)', re.U) # 修改格式print('修改后:', jieba.lcut(sentence))打印结果修改前: [‘Blade', ' ', ‘Master', ‘疾风', ‘刺杀', ‘Archmage']修改后: [‘Blade Master', ‘疾风', ‘刺杀', ‘Archmage']5、其它5.1、并⾏分词运⾏环境:linux系统开启并⾏分词模式,参数n为并发数:jieba.enable_parallel(n)关闭并⾏分词模式:jieba.disable_parallel()5.2、关键词提取基于TF-IDF:jieba.analyse基于TextRank:jieba.textrankimport jieba.analyse as ja, jiebatext = '柳梦璃施法破解了狐仙的法术'jieba.add_word('柳梦璃', tag='nr')keywords1 = ja.extract_tags(text, allowPOS=('n', 'nr', 'ns', 'nt', 'nz'))print('基于TF-IDF:', keywords1)keywords2 = ja.textrank(text, allowPOS=('n', 'nr', 'ns', 'nt', 'nz'))print('基于TextRank:', keywords2)打印结果基于TF-IDF: [‘柳梦璃', ‘狐仙', ‘法术']基于TextRank: [‘狐仙', ‘柳梦璃', ‘法术']5.3、修改HMM参数import jiebatext = '柳梦璃解梦C法'print(jieba.lcut(text, HMM=False)) # ['柳', '梦', '璃', '解梦', 'C', '法']print(jieba.lcut(text)) # ['柳梦璃', '解梦', 'C', '法']jieba.finalseg.emit_P['B']['C'] = -1e-9 # beginprint(jieba.lcut(text)) # ['柳梦璃', '解梦', 'C', '法']jieba.finalseg.emit_P['M']['梦'] = -100 # middleprint(jieba.lcut(text)) # ['柳', '梦璃', '解梦', 'C', '法']jieba.finalseg.emit_P['S']['梦'] = -.1 # singleprint(jieba.lcut(text)) # ['柳', '梦', '璃', '解梦', 'C', '法']jieba.finalseg.emit_P['E']['梦'] = -.01 # endprint(jieba.lcut(text)) # ['柳梦', '璃', '解梦', 'C', '法']jieba.del_word('柳梦') # Force_Split_Wordsprint(jieba.lcut(text)) # ['柳', '梦', '璃', '解梦', 'C', '法'][‘柳', ‘梦', ‘璃', ‘解梦', ‘C', ‘法'][‘柳梦璃', ‘解梦', ‘C', ‘法'][‘柳梦璃', ‘解梦', ‘C', ‘法'][‘柳', ‘梦璃', ‘解梦', ‘C', ‘法'][‘柳', ‘梦', ‘璃', ‘解梦', ‘C', ‘法'][‘柳梦', ‘璃', ‘解梦', ‘C', ‘法'][‘柳', ‘梦', ‘璃', ‘解梦', ‘C', ‘法']更多关于python中⽂分词库jieba使⽤⽅法请查看下⾯的相关链接。

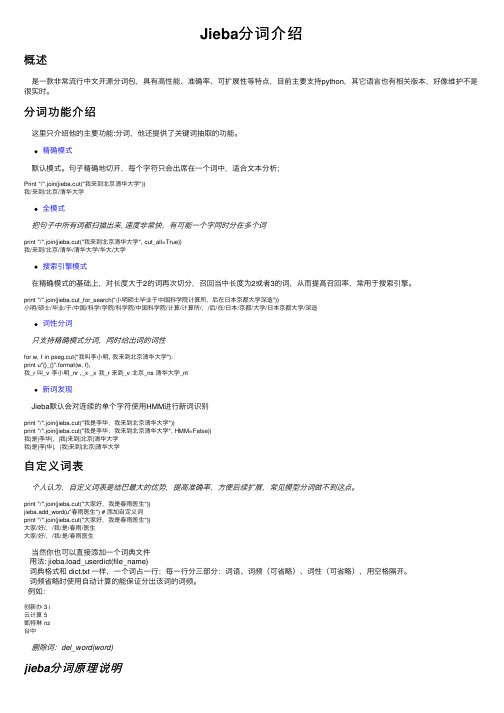

Jieba分词介绍

Jieba分词介绍概述是⼀款⾮常流⾏中⽂开源分词包,具有⾼性能、准确率、可扩展性等特点,⽬前主要⽀持python,其它语⾔也有相关版本,好像维护不是很实时。

分词功能介绍这⾥只介绍他的主要功能:分词,他还提供了关键词抽取的功能。

精确模式默认模式。

句⼦精确地切开,每个字符只会出席在⼀个词中,适合⽂本分析;Print "/".join(jieba.cut("我来到北京清华⼤学"))我/来到/北京/清华⼤学全模式把句⼦中所有词都扫描出来, 速度⾮常快,有可能⼀个字同时分在多个词print "/".join(jieba.cut("我来到北京清华⼤学", cut_all=True))我/来到/北京/清华/清华⼤学/华⼤/⼤学搜索引擎模式在精确模式的基础上,对长度⼤于2的词再次切分,召回当中长度为2或者3的词,从⽽提⾼召回率,常⽤于搜索引擎。

print "/".join(jieba.cut_for_search("⼩明硕⼠毕业于中国科学院计算所,后在⽇本京都⼤学深造"))⼩明/硕⼠/毕业/于/中国/科学/学院/科学院/中国科学院/计算/计算所/,/后/在/⽇本/京都/⼤学/⽇本京都⼤学/深造词性分词只⽀持精确模式分词,同时给出词的词性for w, f in pseg.cut("我叫李⼩明, 我来到北京清华⼤学"):print u"{}_{}".format(w, f),我_r 叫_v 李⼩明_nr ,_x _x 我_r 来到_v 北京_ns 清华⼤学_nt新词发现Jieba默认会对连续的单个字符使⽤HMM进⾏新词识别print "/".join(jieba.cut("我是李华,我来到北京清华⼤学"))print "/".join(jieba.cut("我是李华,我来到北京清华⼤学", HMM=False))我|是|李华|,|我|来到|北京|清华⼤学我|是|李|华|,|我|来到|北京|清华⼤学⾃定义词表个⼈认为,⾃定义词表是结巴最⼤的优势,提⾼准确率,⽅便后续扩展,常见模型分词做不到这点。

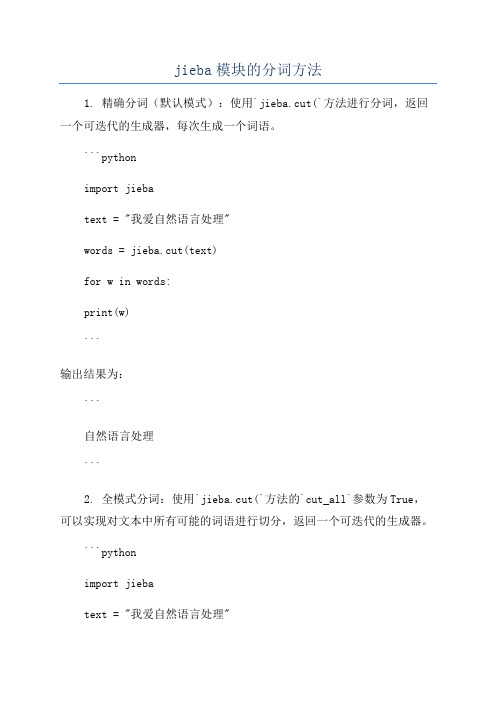

jieba模块的分词方法

jieba模块的分词方法1. 精确分词(默认模式):使用`jieba.cut(`方法进行分词,返回一个可迭代的生成器,每次生成一个词语。

```pythonimport jiebatext = "我爱自然语言处理"words = jieba.cut(text)for w in words:print(w)```输出结果为:```自然语言处理```2. 全模式分词:使用`jieba.cut(`方法的`cut_all`参数为True,可以实现对文本中所有可能的词语进行切分,返回一个可迭代的生成器。

```pythonimport jiebatext = "我爱自然语言处理"words = jieba.cut(text, cut_all=True)for w in words:print(w)```输出结果为:```自然自然语言自然语言处理语言语言处理处理```3. 引擎模式分词:使用`jieba.cut_for_search(`方法进行分词,返回一个可迭代的生成器。

该方法采用了一种更适合引擎和文本分析的分词算法。

```pythonimport jiebatext = "我爱自然语言处理"words = jieba.cut_for_search(text)for w in words:print(w)```输出结果为:```自然语言自然语言处理语言处理自然语言处理。

Python中jieba库的使用方法

Python中jieba库的使⽤⽅法⽬录⼀、jieba库的安装⼆、jieba三种模式的使⽤三、jieba 分词简单应⽤四、扩展:英⽂单词统计jieba库是⼀款优秀的 Python 第三⽅中⽂分词库,jieba⽀持三种分词模式:精确模式、全模式和搜索引擎模式,下⾯是三种模式的特点。

精确模式:试图将语句最精确的切分,不存在冗余数据,适合做⽂本分析全模式:将语句中所有可能是词的词语都切分出来,速度很快,但是存在冗余数据搜索引擎模式:在精确模式的基础上,对长词再次进⾏切分⼀、jieba库的安装因为jieba是⼀个第三⽅库,所有需要我们在本地进⾏安装。

Windows 下使⽤命令安装:在联⽹状态下,在命令⾏下输⼊pip install jieba进⾏安装,安装完成后会提⽰安装成功在 pyCharm 中安装:打开settings,搜索Project Interpreter,在右边的窗⼝选择+号,点击后在搜索框搜索jieba,点击安装即可⼆、jieba三种模式的使⽤# -*- coding: utf-8 -*-import jiebaseg_str = "好好学习,天天向上。

"print("/".join(jieba.lcut(seg_str))) # 精简模式,返回⼀个列表类型的结果print("/".join(jieba.lcut(seg_str, cut_all=True))) # 全模式,使⽤ 'cut_all=True' 指定print("/".join(jieba.lcut_for_search(seg_str))) # 搜索引擎模式分词效果:三、jieba 分词简单应⽤需求:使⽤jieba分词对⼀个⽂本进⾏分词,统计次数出现最多的词语,这⾥以三国演义为例# -*- coding: utf-8 -*-import jiebatxt = open("三国演义.txt", "r", encoding='utf-8').read()words = jieba.lcut(txt) # 使⽤精确模式对⽂本进⾏分词counts = {} # 通过键值对的形式存储词语及其出现的次数for word in words:if len(word) == 1: # 单个词语不计算在内continueelse:counts[word] = counts.get(word, 0) + 1 # 遍历所有词语,每出现⼀次其对应的值加 1items = list(counts.items())items.sort(key=lambda x: x[1], reverse=True) # 根据词语出现的次数进⾏从⼤到⼩排序for i in range(3):word, count = items[i]print("{0:<5}{1:>5}".format(word, count))统计结果:四、扩展:英⽂单词统计上⾯的例⼦统计实现了中⽂⽂档中出现最多的词语,接着我们就来统计⼀下⼀个英⽂⽂档中出现次数最多的单词。

jieba库的用法

jieba库的用法jieba是一款Python接口的中文分词组件,是一个开源的中文分词工具。

它采用基于前向和后向最大匹配算法,结合了其他一些算法,使得它可以识别出准确率极高,性能极佳的词语。

1. jieba的安装安装jieba库的方式有两种,一种是通过pip安装,另一种是从github上clone并且安装,这两种方式都可以很容易的完成jieba的安装。

如果是使用pip进行安装,可以使用命令“pip install jieba”进行安装;如果是使用github进行安装,可以通过clone github上的源码,再使用“python setup.py install”命令完成安装。

2. jieba的使用jieba的使用比较简单,可以直接使用提供的接口来完成分词任务,也可以使用提供的接口完成词性标注以及关键词提取等任务。

(1) jieba分词接口对于jieba的分词接口,有三种接口:jieba.cut:可以进行精准模式的分词;jieba.lcut:可以进行全切分模式的分词;jieba.cut_for_search:可以进行最细粒度切分模式的分词其中,jieba.cut接口是最常用的接口,它可以根据句子的任何一个词语进行分词,只要调用jieba.cut接口就可以对句子进行分词。

(2) jieba词性标注接口jieba的词性标注接口除了提供接口并返回标注结果外,还可以进行额外的配置,比如在词性标注时可以选择是否使用词典中的词语来进行拼音标注,是否在词语之间使用空格等配置。

(3) jieba关键词提取接口最后,jieba还提供了关键词提取接口,该接口可以提取出文章中的关键词,以及此关键词对应的权重,并且可以配置参数来进行筛选,比如筛选出长度大于等于某个数值的关键词等。

3. jieba的优势一、jieba拥有识别准确率极高,性能极佳的词语,它采用基于前向和后向最大匹配算法,结合了其他一些算法,比如极限概率算法,可以有效地提高分词的准确率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

jieba模块的分词方法

【实用版3篇】

目录(篇1)

1.介绍 jieba 模块

2.jieba 模块的分词方法概述

3.jieba 模块的分词方法实现

4.jieba 模块的分词方法应用实例

5.总结

正文(篇1)

一、介绍 jieba 模块

jieba 模块是一款中文分词工具,基于前缀词典实现高效的词图扫描,生成有向无环图(DAG),采用动态规划查找最大概率路径,实现分词。

该模块使用 Python 编写,支持 Python 2.7 及以上版本,具有较高的分词准确率和较快的分词速度。

二、jieba 模块的分词方法概述

jieba 模块的分词方法采用了基于词典的分词策略,通过建立一个词典,将中文词汇按照一定的规则进行编码,然后根据这些编码进行分词。

在分词过程中,jieba 模块会根据词典中的词汇和句子的语义信息,选择最可能的分词结果。

三、jieba 模块的分词方法实现

1.词典构建:jieba 模块首先需要构建一个词典,词典中包含了中文词汇的编码信息。

词典的构建方法有多种,如基于统计方法、基于规则方法等。

2.词图扫描:在分词过程中,jieba 模块会根据词典对句子进行词图

扫描,生成有向无环图(DAG)。

词图是一个有向图,其中每个节点表示一个词汇,每条边表示一个词汇出现的概率。

3.最大概率路径查找:jieba 模块采用动态规划方法查找词图中的最大概率路径,从而确定分词结果。

动态规划是一种在数学、计算机科学和经济学领域中使用的,通过把原问题分解为相对简单的子问题的方式求解复杂问题的方法。

四、jieba 模块的分词方法应用实例

以下是一个使用 jieba 模块进行分词的实例:

```python

import jieba

sentence = "我爱自然语言处理技术"

seg_list = jieba.cut(sentence)

print(seg_list)

```

运行上述代码,输出结果为:

```

["我", "爱", "自然语言", "处理", "技术"]

```

五、总结

jieba 模块是一种高效的中文分词工具,采用基于词典的分词策略,具有较高的分词准确率和较快的分词速度。

通过词典构建、词图扫描和最大概率路径查找等方法,实现了对中文句子的高效分词。

目录(篇2)

1.介绍分词的重要性

2.介绍 jieba 模块

3.jieba 模块的分词方法

4.jieba 模块的分词示例

5.jieba 模块的分词应用

正文(篇2)

一、介绍分词的重要性

分词是自然语言处理中一个重要的步骤,它能将连续的文本切分成有独立意义的词汇或短语。

分词的准确性直接影响到后续的自然语言处理任务,如文本分类、情感分析、机器翻译等。

二、介绍 jieba 模块

jieba 是一个中文分词模块,它基于前缀词典实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG),并采用动态规划查找最大概率路径,切分出最可能的词汇序列。

三、jieba 模块的分词方法

jieba 模块提供了三种分词方法:

1.精确模式:把句子最精确地切开,适合文本分析。

这种模式下,jieba 会尽可能多地将文本分割成精确的词汇。

2.全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义问题。

这种模式下,jieba 会尽可能多地将文本分割成可以成词的词语,但是不能保证词语的精确性。

3.搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

这种模式下,jieba 会在精确模式的基础上,对长词进行再次切分,以提高搜索引擎的召回率。

四、jieba 模块的分词示例

以下是一个使用 jieba 模块进行分词的示例:

```python

import jieba

sentence = "我爱自然语言处理技术"

seg_list = jieba.cut(sentence, mode="精确")

print(seg_list)

```

运行上述代码,输出结果为:[["我", "爱", "自然语言", "处理", "技术"]]

五、jieba 模块的分词应用

jieba 模块在中文自然语言处理中有广泛的应用,如文本分类、情感分析、机器翻译等。

目录(篇3)

1.引言

2.jieba 模块简介

3.jieba 的分词方法

3.1 基于前缀词典的分词方法

3.2 基于词频的分词方法

3.3 基于隐马尔可夫模型的分词方法

4.jieba 模块的分词效果与应用

5.结语

正文(篇3)

一、引言

中文分词是自然语言处理中的一个重要环节,它将连续的文本切分成有意义的词汇序列。

在众多的中文分词工具中,jieba 模块以其高效的分词效果和简洁的使用方法受到广泛关注。

本文将对 jieba 模块的分词方

法进行详细介绍。

二、jieba 模块简介

jieba 模块是一款基于 Python 的中文分词工具,其全称为“结巴分词”。

它支持多种分词算法,具有较高的分词速度和准确率,适用于各种

中文文本处理场景。

三、jieba 的分词方法

1.基于前缀词典的分词方法

jieba 模块采用了一种基于前缀词典的分词方法。

这种方法通过构建一个包含所有可能的前缀词典,利用最大正向匹配和最大逆向匹配等策略,找到最可能的分词结果。

这种方法具有较高的准确率,但速度较慢。

2.基于词频的分词方法

jieba 模块还提供了一种基于词频的分词方法。

这种方法通过对大量已分词的文本进行学习,构建一个词频统计模型,利用该模型进行分词。

这种方法速度较快,但可能因为缺乏上下文信息而导致准确率降低。

3.基于隐马尔可夫模型的分词方法

jieba 模块还支持基于隐马尔可夫模型(HMM)的分词方法。

这种方

法利用 HMM 模型对文本进行建模,通过最大熵原理求解最可能的分词结果。

这种方法在很多情况下能获得较高的准确率,但计算复杂度较高,速度较慢。

四、jieba 模块的分词效果与应用

jieba 模块的分词效果在多数情况下较好,可以满足一般用户的需求。

同时,jieba 模块提供了丰富的参数和配置选项,可以根据实际需求进行调整。

在实际应用中,jieba 模块可以广泛应用于文本挖掘、信息检索、

机器翻译等领域。

五、结语

jieba 模块作为一款实用的中文分词工具,其分词方法多样,具有较高的准确率和速度。