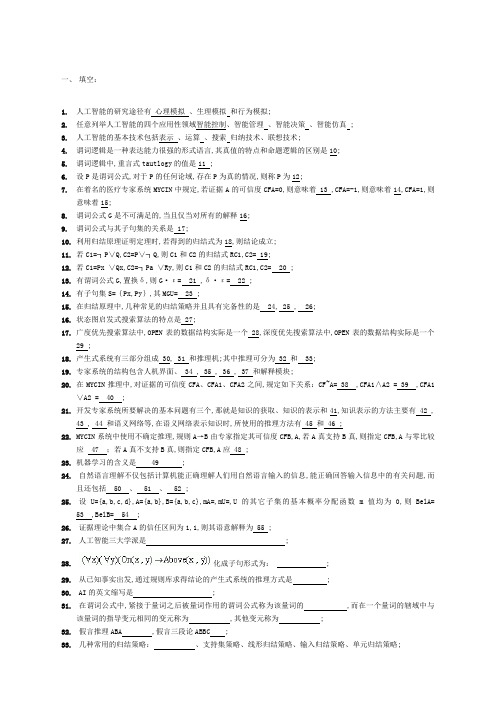

华南理工大学《人工智能》复习资料汇总

人工智能 考试复习提纲

第一章绪论●人工智能的诞生:1965年夏季,在达特茅斯大学●人工智能的学派:符号主义,联结主义,行为主义第二章知识表示方法●知识的特性:1.相对正确性;2.不确定性;3.可表示性;4.可利用性●★用谓词公式表示知识的步骤:1.定义谓词及个体,确定每个谓词及个体的确切含义。

2.根据所要表达的事物或概念,为每个谓词中的变元赋以特定的值。

3.根据所要表达的知识的语义,用适当的联接符号将各个谓词联接起来,形成谓词公式。

●★★机器人搬弄积木块问题表示P19●★一阶谓词逻辑表示法的特点:1.自然性;2.适宜于精确性知识的表示;3.易实现;4.与谓词逻辑表示法相对应的推理方法。

●产生式系统的组成:1.规则库;2.综合数据库;3.推理机●★产生式系统的推理方式:1.正向推理:①规则库中的规则与综合数据库中的事实进行匹配,得到匹配的规则集合;②使用冲突解决算法,从匹配规则集合中选择一条规则作为启用规则;③执行启动规则的后件。

将该启用规则的后件送入综合数据库或对综合数据库进行必要的修改。

重复这个过程直至达到目标。

2.反向推理:①规则库中的规划后件与目标事实进行匹配,得到匹配的规则集合;②使用冲突解决算法,从匹配规则集合中选择一条规则作为启用规则;③将启用规则的前件作为子目标。

重复这个过程直至各子目标均为已知事实,则反向推理的过程成功结束。

●★★语义网络表示知识举例:P36 例2.5、2.6、2.7;P71 作业18●框架的定义及组成:一个框架由若干个“槽”组成,每个“槽”又可划分为若干个“侧面”。

一个槽用于描述所论及对象的某一方面的属性,一个侧面用于描述相应属性的一个方面。

框架名<槽名><侧面><值>●脚本表示法:美国耶鲁大学的R.C.Schank及其同事们根据概念从属理论提出了一种知识表示方法——脚本表示法。

●问题状态空间的构成:1.状态;(2).算符;3.状态空间。

●★用状态空间表示问题的步骤1.定义状态的描述形式;2.用所定义的状态描述形式把问题的所有可能的状态都表示出来,并确定出问题的初始状态集合描述和目标状态集合描述;3.定义一组算符。

人工智能原理复习题

人工智能原理复习题一、人工智能的定义与发展历程人工智能(Artificial Intelligence,简称 AI),简单来说,就是让机器模拟人类的智能行为和思维方式。

它旨在使计算机能够像人类一样学习、推理、解决问题和执行任务。

人工智能的发展可以追溯到上世纪 50 年代。

早期的研究主要集中在基于规则的系统和逻辑推理。

然而,由于计算能力的限制和对智能本质理解的不足,进展相对缓慢。

到了 80 年代,专家系统开始流行,它们基于特定领域的知识和规则,能够为用户提供专业的建议和解决方案。

但专家系统的局限性也逐渐显现,比如难以处理不确定性和动态变化的问题。

进入 21 世纪,随着大数据的兴起、计算能力的大幅提升以及深度学习算法的突破,人工智能迎来了新的发展高潮。

图像识别、语音识别、自然语言处理等领域取得了显著的成果,人工智能开始广泛应用于医疗、交通、金融、教育等众多领域。

二、人工智能的主要技术(一)机器学习机器学习是人工智能的核心技术之一。

它使计算机通过数据自动学习和改进,而无需明确编程。

机器学习主要包括监督学习、无监督学习和强化学习。

监督学习是最常见的类型,通过有标记的训练数据来学习预测未知数据的标签。

例如,通过大量带有标签的图像(如猫、狗)来训练模型,使其能够识别新的未标记图像中的动物类别。

无监督学习则是在没有标记的数据中寻找模式和结构。

聚类分析就是一种无监督学习方法,它可以将相似的数据点分组在一起。

强化学习通过与环境进行交互并根据奖励信号来学习最佳策略。

比如,在机器人控制中,通过不断尝试不同的动作并根据获得的奖励来优化行为。

(二)深度学习深度学习是机器学习的一个分支,它基于深度神经网络(Deep Neural Network,简称 DNN)。

DNN 由多层神经元组成,可以自动从数据中提取特征和模式。

卷积神经网络(Convolutional Neural Network,简称 CNN)在图像识别中表现出色,能够识别图像中的物体、场景等。

华南理工大学《人工智能》复习资料分析

按选择范围分类: 全局择优搜索:考虑所有待考察节点 局部择优搜索:只考虑当前节点的子节点

【与或图的广度/深度搜索】

Step1:S0 放入 OPEN 表 Step2:OPEN 表第一个点(记为 N)取出放入 CLOSED 表, 冠以编号 n。 Step3:若 n 可扩展: (1)扩展 N,其子节点放入 OPEN 表(深度:尾部,广度:首部) (2)考查这些节点是否终止节点。若是,放入 CLOSED 表, 标为可解节点,并对先辈点标示。若 S0 被标可解,得解。 (3)从 OPEN 表删除具有可解先辈的节点。转 Step2。 Step4:若 N 不可扩展: (1)标示 N 为不可解。 (2)标示先辈节。若 S0 被标不可解,失败。 (3)从 OPEN 表删除具有不可解先辈的节点。转 Step2。

【与或图】

【状态空间图搜索使用的数据结构】

OPEN 表:已生成但没考察的节点(待考察节点) CLOSED 表:考察过的节点及节点间关系(搜索树)

Q 与 Q1,Q2 与等价(即 Q 可以分解为 Q1+Q2) Q1 与{Q1i},{Q1i’}或等价(即 Q1 可以转换为{Q1i}或{Q1i’})

【与或图中的概念】

【常用逻辑等价式】

【常用推理定律】

【子句集】

文字:原子谓ห้องสมุดไป่ตู้公式及其否定 子句:任何文字的析取

【子句集特点】

1. 没有蕴含词、等值词 2. “¬”作用原子谓词 3. 没有量词( 、 ) 4. 合取范式 5. 元素之间变元不同 6. 集合形式

【由谓词公式得到子句集】

(对应子句集特点的序号) 1. 根据蕴含等价式消去蕴含关系 2. 根据量词转换律、双重否定律、摩根定律转换 3. 存在量词:受x 约束,则定义 f(x)替换 y (Skolem 函数)

人工智能期末复习材料

、选择填空。

1.智能:1956年智能作为个专业术语出现。

智能有以下点:AI(ArtificialIntelligence)1.智能具有感知能;2.智能具有记忆和思维能:记忆和思维是脑最重要的功能,记忆和思维需要同时具备,它们是由智能的根本原因;思维分为好种:逻辑思维,形象思维,以及顿悟思维;3.智能具有学习能,适应能及为能。

2.图灵1950年发表“计算机与智能”的论,章以“机器能思维吗?”开始,论述并提出了著名的“图灵测试”,以测试个计算机系统是否具有智能。

3.智能界主要由符号主义,为主义和连结主义等研究学派。

4.智能主要的研究领域(挑选5或6个认真看)1.专家系统2.模式识别3.机器学4.动定理证明5.博弈6.智能检索7.动程序设计 8.组合调度问题 9.软计算 10.分布式智能 11.数据挖掘5.智能研究的3个主要内容:知识的获取、知识的表和知识的运。

6.知识的描述:知识的某领域中所涉及的各有关的种符号表。

7.知识的特点:(1)相对正确性(2)不确定性(3)可表性(4)可利性8.知识的分类(1)事实性知识(2)过程性知识(3)为性知识(4)实例性知识(5)类性知识(6)元知识9.确定性和不确定性规则知识的产式表:确定性:P Q或者 if P then Q不确定性:P Q(可信度)或者 if P then Q(可信度)10.确定性和不确定性事实性知识的产式表:确定性事实性知识般使三元组(对象,属性,值)或(关系,对象1,对象2)不确定性事实性知识般使四元组(对象,属性,值,不确定度量值)或(关系,对象1,对象2,不确定度量值)11.产式系统通常由规则库、数据库、推理机这3个基本部分组成。

它们之间的关系可以表为12.规则库是专家系统的核。

数据库,称事实库。

13.产式系统推理机的推理式:正向推理,反向推理,双向推理和混合式推理。

个较常的槽名:(要会判断属于哪种槽)P46(1)ISA槽(2)AKO槽(3)Instance槽(4)Part-of槽15.语义络的基本语义联系(学会如何表各种关系,重点是类属关系)1.类属关系2.包含关系3.属性关系4.时间关系5.位置关系6.相近关系7.因果关系8.组成关系16类属关系:(1)AKO(A-Kind-of)表个事物是另个事物的种类型。

人工智能复习参考(带答案).doc

复习参考题一、填空I•构成产生式系统的基本元素有综合数据库、规则库、控制系统,控制策略按执行规则的方式分类,分为止向、逆向、双向三类。

2•归结过程中控制策略的作用是给出控制策略,以使仅对选择合适的子句间方可做归结,避免多余的、不必要的归结式出现或者说,少做些归结仍能导出空子句。

常见的控制策略有线性归结策略、支持集策略、单元归结、输入归结。

3.公式G和公式的子句集并不等值,但它们在不可满足的意义下是一致的。

4.与或图的启发式搜索算法(A0*算法)的两个过程分别是图生成过程即扩展节点和计算耗散值的过程。

5.人工智能的研究途径主要有两种不同的观点,一种观点称为符号主义,认为人类智能基木单元是符号。

另一种观点称为连接主义(仿牛主义),认为职能的基本单元是神经元。

6.集合{P(a, x, f (g(y))? P(z, f (z) ,f(u)))的mgu (最一般合一置换)为{z/a, f(x)/x, u/g(y)}o7•语义网络是对知识的有向图表示方法,一个最简单的语义网络是一个形如节点1、弧、节点2的三元组,语义网络可以描述事物间多种复杂的语义关系、常用ISA、AKO弧表示节点间具有类屈的分类关系。

语义网络下的推理是通过继承和匹配实现的。

8.当前人工智能研究的热点之一就是机器学习。

常见的机器学习方法可分为连接学习、归纳学习、分析学习和遗传算法与分类器系统等。

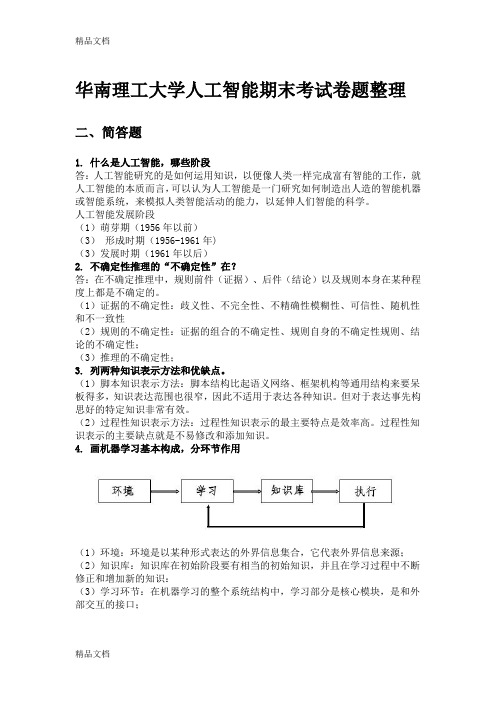

一个机器学习系统应有环境、知识库、学习环节和执行环节四个基本部分组成。

9•常用的知识表示法有逻辑表示法、产牛式规则表示法、语义网络表示法、框架理论表示法、过程表示法等。

10.有两个A*算法A1和A2,若A1比A2有较多的启发信息,贝9hl(n)>h2(n)oII.关于A算法与A*算法,若规定h(n)M0,并J1定义启发函数:P|c(n)=g*(n)+h*(n) 表示初始状态S。

经点n到Fl标状态Sg最优路径的费用。

其屮g*(n)为So到n的最小费用,h*(n)为到Sg的实际最小费用。

人工智能原理及应用复习提纲

人工智能原理及应用复习提纲第一章1.什么是人工智能?答:人工智能从学科角度说是一门研究如何构造智能机器或智能系统,使它能模拟、延伸和扩展人类智能的学科。

2.人工智能的产生和发展过程有哪些?答:①孕育期(1956年以前)②形成期(1956年~1970年)③知识应用期(1971年~80年代末)④综合集成期3.人工智能的研究和应用领域答:机器学习;自然语言理解;专家系统;模式识别;计算机视觉;机器人学;博弈;自动定理证明;自动程序设计;智能控制;智能决策支持系统;人工神经网络;知识发现和数据挖掘;分布式人工智能第二章1.什么是知识表示?答:知识表示:就是对知识的一种描述,即用一些约定的符号把知识编码成一组计算机可以接受的数据结构。

2.常用的知识表示方法有哪些?答:目前使用较多的有:一阶谓词逻辑表示法、产生式表示法、语义网络表示法、框架表示法等。

3.产生式系统的基本结构答:综合数据库;规则库;控制系统4. 什么是产生式系统?答:用产生式知识表示方法构造的智能系统称为产生式系统。

第三章1.什么是推理?答:所谓推理是指按照某种策略从已知事实出发去推出结论的过程2.推理的控制策略包括哪些内容?分别解决什么问题?答:推理的控制策略又可分为推理策略和搜索策略推理策略主要解决推理方向、冲突消解等问题。

搜索策略主要解决推理线路、推理效果、推理效率等问题。

3.推理的方向有哪些?答:推理分为正向、逆向及混合推理。

4.冲突消解策略有几种?答:特殊知识优先;新鲜知识优先;差异性大的知识优先;领域特点优先;上下文关系优先;前提条件少者优先第四章1.什么是不确定性推理答:不确定性推理就是从不确定性的初始证据出发,通过运用不确定性的知识,最终推理出具有一定程度的不确定性,但又是合理或者基本合理的结论的思维过程。

2.C-F模型(大题)在C-F模型中,知识是用产生式规则表示的,其一般形式为:IF E THEN H (CF(H,E))例4.2 设有如下一组知识:r1: IF E1 THEN H (0.9)r2: IF E2 THEN H (0.6)r3: IF E3 THEN H (-0.5)r4: IF E4 AND (E5 OR E6 ) THEN E1 (0.8)已知:CF(E2)=0.8, CF(E3)=0.6, CF(E4)=0.5, CF(E5)=0.6, CF(E6)=0.8 求:CF(H)=?解:由r4得到:CF(E1)=0.8xmax{0,CF(E4 AND (E5 OR E6 ))}= 0.8xmax{0,min{CF(E4),CF(E5 OR E6 )}}= 0.8xmax{0,min{CF(E4),max{CF(E5),CF(E6)}}}= 0.8xmax{0,min{CF(E4),max{0.6,0.8}}}= 0.8xmax{0,min{0.5,0.8}}= 0.8xmax{0,0.5}= 0.4由r1得到:CF1(H) = CF(H,E1) x max{0, CF(E1)}=0.9x max{0,0.4}=0.36由r2得到:CF2(H) = CF(H,E2) x max{0, CF(E2)}=0.6x max{0,0.8}=0.48由r3得到:CF3(H) = CF(H,E3) x max{0, CF(E3)}= -0.5x max{0,0.6}= -0.3根据结论非精确性的合成算法得到:CF1,2(H)=CF1(H) + CF2(H) - CF1(H) x CF2(H)=0.36+0.48-0.36x0.48=0.84-0.17=0.67= 0.53CF(H)=0.53第五章1.什么是搜索?答:根据问题的实际情况,不断寻找可利用知识,从而构造一条代价最小的推理路线,使问题得以解决的过程称为搜索。

人工智能期末复习

人工智能原理期末考试复习1. 什么是人工智能?发展经历了几个阶段?人工智能指的是能够感知或推断信息,并将其作为知识而拥有,以应用于环境或语境中适合的行为;机器的智能称为人工智能,通常在运用程序、间或适当硬件的计算机系统中得以实现.2. 人工智能研究的内容有哪些?机器学习、知识表示方法、搜索求解策略、进化算法及其应用、确定性及不确定性推理方法、群体智能算法及其应用。

3. 人工智能有哪些研究领域?安全防范、医疗诊断、语音识别、工业制造、计算机游戏、机器翻译。

4. 什么是知识?有哪些特性?有几种分类方法?知识是人们在长期的生活及社会实践中、在科学研究及实验中积累起来的对客观世界的认识与经验。

相对正确性、不确定性、可表示性与可利用性。

分类方法:(1)按知识的作用范围分为∶常识性知识和领域性知识﹔(2)按知识的作用及表示分为∶事实性知识、规则性知识、控制性知识和元知识;(3 )按知识的确定性分为:确定知识和不确定知识;(4) 按人类思维及认识方法分为:逻辑性知识和形象性知识。

5. 什么是知识表示、命题、谓词,一阶谓词逻辑、产生式、框架、语义网络?知识表示就是将人类知识形式化或者模型化;命题是一个非真即假的陈述句;谓词的一般形式: ),...,,(21n x x x P );n x x x ,...,,21是个体,某个独立存在的事物或者某个抽象的概念, P 是谓词名,用来刻画个体的性质、状态或个体间的关系。

一阶谓词逻辑表示:谓词不但可表示一些简单的事实,而且可以表示带有变量的“知识”,有时称为“事实的函数”。

进而可用谓词演算中的逻辑联接词“与()”、“或(v)"、“非(┐)”和“蕴含(→)”等来组合已有知识,从而表示出更复杂的知识。

产生式通常用于表示事实、规则以及它们的不确定性度量,适合于表示事实性知识和规则性知识。

框架是一种描述所论对象(一个事物、事件或概念)属性的数据结构。

语义网络:从图论的观点看,它其实就是“一个带标识的有向图”,由结点和弧(也称“边”)所组成。

人工智能复习题及答案

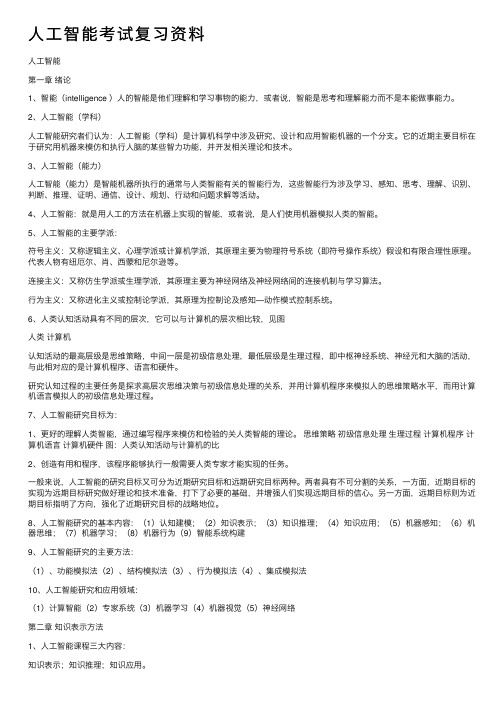

一、填空:1.人工智能的研究途径有心理模拟、生理模拟和行为模拟;2.任意列举人工智能的四个应用性领域智能控制、智能管理、智能决策、智能仿真 ;3.人工智能的基本技术包括表示、运算、搜索归纳技术、联想技术;4.谓词逻辑是一种表达能力很强的形式语言,其真值的特点和命题逻辑的区别是10;5.谓词逻辑中,重言式tautlogy的值是11 ;6.设P是谓词公式,对于P的任何论域,存在P为真的情况,则称P为12;7.在着名的医疗专家系统MYCIN中规定,若证据A的可信度CFA=0,则意味着 13 ,CFA=-1,则意味着14,CFA=1,则意味着15;8.谓词公式G是不可满足的,当且仅当对所有的解释16;9.谓词公式与其子句集的关系是 17;10.利用归结原理证明定理时,若得到的归结式为18,则结论成立;11.若C1=┐P∨Q,C2=P∨┐Q,则C1和C2的归结式RC1,C2= 19;12.若C1=Px ∨Qx,C2=┐Pa ∨Ry,则C1和C2的归结式RC1,C2= 20 ;13.有谓词公式G,置换δ,则G·ε= 21 ,δ·ε= 22 ;14.有子句集S={Px,Py},其MGU= 23 ;15.在归结原理中,几种常见的归结策略并且具有完备性的是 24, 25 , 26;16.状态图启发式搜索算法的特点是 27;17.广度优先搜索算法中,OPEN表的数据结构实际是一个 28,深度优先搜索算法中,OPEN表的数据结构实际是一个29 ;18.产生式系统有三部分组成 30, 31 和推理机;其中推理可分为 32 和 33;19.专家系统的结构包含人机界面、 34 , 35 , 36 , 37 和解释模块;20.在MYCIN推理中,对证据的可信度CFA、CFA1、CFA2之间,规定如下关系:CF~A= 38 ,CFA1∧A2 = 39 ,CFA1∨A2 = 40 ;21.开发专家系统所要解决的基本问题有三个,那就是知识的获取、知识的表示和41,知识表示的方法主要有 42 ,43 , 44 和语义网络等,在语义网络表示知识时,所使用的推理方法有 45 和 46 ;22.MYCIN系统中使用不确定推理,规则A→B由专家指定其可信度CFB,A,若A真支持B真,则指定CFB,A与零比较应 47 ;若A真不支持B真,则指定CFB,A应 48 ;23.机器学习的含义是 49 ;24.自然语言理解不仅包括计算机能正确理解人们用自然语言输入的信息,能正确回答输入信息中的有关问题,而且还包括 50 、 51 、 52 ;25.设U={a,b,c,d},A={a,b},B={a,b,c},mA=,mU=,U的其它子集的基本概率分配函数m值均为0,则BelA=53 ,BelB= 54 ;26.证据理论中集合A的信任区间为1,1,则其语意解释为 55 ;27.人工智能三大学派是 ;28.化成子句形式为: ;29.从已知事实出发,通过规则库求得结论的产生式系统的推理方式是 ;30.AI的英文缩写是 ;31.在谓词公式中,紧接于量词之后被量词作用的谓词公式称为该量词的 ,而在一个量词的辖域中与该量词的指导变元相同的变元称为 ,其他变元称为 ;32.假言推理ABA ,假言三段论ABBC ;33.几种常用的归结策略:、支持集策略、线形归结策略、输入归结策略、单元归结策略;34.在诸如走迷宫、下棋、八数码游戏等游戏中,常用到的一种人工智能的核心技术称为技术,解这类问题时,常把在迷宫的位置、棋的布局、八数码所排成的形势用图来表,这种图称为 ;35.在启发式搜索当中,通常用来表示启发性信息;36.在二人博弈问题中,最常用的一种分析技术是 ,这种方法的思想是先生成一棵博弈树,然后再计算其倒推值;但它的效率较低,因此人们在此基础上,又提出了 ;37.37.某产生式系统中的一条规则:AxBx,则前件是 ,后件是 ;38.38.在框架和语义网络两种知识表示方法中, 适合于表示结构性强的知识,而则适合表示一些复杂的关系和联系的知识; 不仅仅是一种知识表示方法,也是一种流行的软件设计和开发技术;39.不确定性类型按性质分:, , , ;40.在删除策略归结的过程中删除以下子句:含有的子句;含有的子句;子句集中被别的子句的子句;41.对证据的可信度CFA、CFA1、CFA2之间,规定如下关系:CF~A= 、CFA1∧A2 = 、CFA1∨A2 =42.合一算法:求非空有限具有相同谓词名的原子公式集的43.产生式系统的推理过程中,从可触发规则中选择一个规则来执行,被执行的规则称为;44.PB|A 表示在规则中,证据A为真的作用下结论B为真的;45.人工智能的远期目标是,近期目标是;46.常用的二种盲目搜索方法是_________和_________;引入启发式知识来指导OPEN表中节点的排序可划分为二种方式_________和_________;47.产生式系统的推理可以分为_________和_________两种基本方式;48.知识表示的性能应从以下二个方面评价:_________和_________;后者又分二个方面_________和 _________;49.人工智能的表现形式至少有_______、_______、_______、_______和______几种;50.目前所用的知识表示形式有_________、_________、________、_________等;51.框架系统的特性继承功能可通过组合应用槽的三个侧面来灵活实现,它们是_________、_________和_________;52.产生式系统是由_________、_________和_________三部分组成的;53.________就是所考察判断的事物或对象的集合,记为____;它的子集构成______;54.证据理论是经典概率论的一种扩充形式,构成这一理论的函数有_________、_________和_________;55.对于模糊不确定性,一般采用_______或_______来刻划;56.归结法中,可以通过---------的方法得到问题的解答;57.化成子句形式为: ;58.58.从已知事实出发,通过规则库求得结论的产生式系统的推理方式是 ;59.谓词逻辑中,重言式tautlogy的值是 ;60.利用归结原理证明定理时,若得到的归结式为 ,则结论成立;61.在启发式搜索当中,通常用来表示启发性信息;二、选择题选择题:13小题,共13分1.人工智能的含义最早由一位科学家于1950年提出,并且同时提出一个机器智能的测试模型,请问这个科学家是;A. 明斯基B. 扎德C. 图灵D. 冯.诺依曼2.下列哪个不是人工智能的研究领域A. 机器证明D. 编译原理3.神经网络研究属于下列学派A. 符号主义B. 连接主义C. 行为主义D. 都不是4.已知初始问题的描述,通过一系列变换把此问题最终变为一个子问题集合;这些子问题的解可以直接得到,从而解决了初始问题;这是知识表示法叫A. 状态空间法B. 问题归约法C. 谓词逻辑法D. 语义网络法5.在公式中yxpx,y,存在量词是在全称量词的辖域内,我们允许所存在的x可能依赖于y值;令这种依赖关系明显地由函数所定义,它把每个y值映射到存在的那个x;这种函数叫做A. 依赖函数B. Skolem函数C. 决定函数D. 多元函数6.子句~PQ和P经过消解以后,得到A. PB. QC. ~PD.PQ7,ABA 称为 ,~AB~A~B称为A.结合律B.分配律C.吸收律D.摩根律9,10.如果问题存在最优解,则下面几种搜索算法中, 必然可以得到该最优解, 可以认为是“智能程度相对比较高”的算法;A.广度优先搜索B.深度优先搜索C.有界深度优先搜索D.启发式搜索11.产生式系统的推理不包括A. 正向推理B. 逆向推理C. 双向推理D. 简单推理12.下列哪部分不是专家系统的组成部分A. 用户B. 综合数据库C. 推理机D. 知识库13. 要想让机器具有智能,必须让机器具有知识;因此,在人工智能中有一个研究领域,主要研究计算机如何自动获取知识和技能,实现自我完善,这门研究分支学科叫 ;A. 专家系统D. 模式识别14、AI的英文缩写是AAutomatic Intelligence BArtifical IntelligenceCAutomatice Information DArtifical Information15、反演归结消解证明定理时,若当前归结式是时,则定理得证;A永真式B包孕式subsumed C空子句16、从已知事实出发,通过规则库求得结论的产生式系统的推理方式是A正向推理B反向推理C双向推理17、语义网络表达知识时,有向弧AKO 链、ISA 链是用来表达节点知识的 ;A无悖性B可扩充性C继承性18、A→B∧A => B是A附加律B拒收律C假言推理DUS19、命题是可以判断真假的A祈使句B疑问句C感叹句D陈述句20、仅个体变元被量化的谓词称为A一阶谓词B原子公式C二阶谓词D全称量词21、MGU是A最一般合一B最一般替换C最一般谓词D基替换22、1997年5月,着名的“人机大战”,最终计算机以比的总比分将世界国际象棋棋王卡斯帕罗夫击败,这台计算机被称为A深蓝BIBM C深思D蓝天23、下列不在人工智能系统的知识包含的4个要素中A事实B规则C控制和元知识D关系24、谓词逻辑下,子句, C1=L∨C1‘, C2=L∨C2‘,若σ是互补文字的最一般合一置换,则其归结式C=A C1’σ∨C2’σB C1’∨C2’C C1’σ∧C2’σD C1’∧C2’25、或图通常称为A框架网络B语义图C博亦图D状态图26、不属于人工智能的学派是A符号主义B机会主义C行为主义D连接主义;27、人工智能是一门A数学和生理学B心理学和生理学C语言学D综合性的交叉学科和边缘学科28、下列不在人工智能系统的知识包含的4个要素中A 事实B 规则C 控制D 关系29、当前归结式是时,则定理得证;A 永真式B 包孕式subsumedC 空子句30、或图通常称为A框架网络B语义图C博亦图D状态图31、所谓不确定性推理就是从的初始证据出发,通过运用的知识,最终推出具有一定程度的不确定性但却是合理或者近乎合理的结论的思维过程;A不确定性, 不确定性 B确定性, 确定性C确定性, 不确定性 D 不确定性确定性32、CB|A 表示在规则A->B中,证据A为真的作用下结论B为真的A可信度B信度C信任增长度D概率33. 谓词逻辑下,子句, C1=L∨C1‘, C2=L∨C2‘,若σ是互补文字的最一般合一置换,则其归结式C=A C1’σ∨C2’σB C1’∨C2’C C1’σ∧C2’σD C1’∧C2’二、简答题1.将下列自然语言转化为谓词表示形式:(1)所有的人都是要呼吸的;(2)每个学生都要参加考试;(3)任何整数或是正的或是负的;2.何谓“图灵实验”简单描述之3.写出图中树的结点两个访问序列,要求分别满足以下两个搜索策略:1深度优先搜索;2广度优先搜索4.试实现一个“大学教师”的框架,大学教师类属于教师,包括以下属性:学历学士、硕士、博士、专业计算机、电子、自动化、……、职称助教、讲师、副教授、教授5.用谓词逻辑形式化下列描述“不存在最大的整数”6.用语义网络表示“苹果”知识;7. 什么是产生式产生式规则的语义是什么8. 谓词公式G通过8个步骤所得的子句集合S,称为G的子句集;请写出这些步骤;9.1已知S={Pfx,y,gy,Pfx,z,gx},求MGU2已知W={Pfx,gA,y,z,Pfx,z,z},求MGU10.1 证明G是否是F的逻辑结论;2证明G是否是F1、F2的逻辑结论;11. 1、用语义网络表示下列信息:1胡途是思源公司的经理,他35岁,住在飞天胡同68号2清华大学与北京大学进行蓝球比赛,最后以89:102的比分结束;3将命题:“某个学生读过三国演义”分别用谓词公式和语义网络表示4把语句“每个学生都喜欢老师上的一门课;”表示为语义网络;5请把下列命题表示的事实用一个语义网络表示出来;1树和草都是植物;2树和草都是有根有叶的;3水草是草,且长在水中;4果树是树,且会结果;5樱桃树是一种果树,它结樱桃;6用语义网络表示下列事实姚明是一位年近半百的男教师,中等身材,他在本学年第二学期给计算机专业学生讲授“人工智能”课程;该课程是一门选修课,比较难;13. 图示博弈树,其中末一行的数字为假设的估值,请利用α-β剪枝技术剪去不必要的分枝;在节点及边上直接加注释14. 设有如下关系:1如果x是y的父亲,y又是z的父亲,则x是z的祖父;2老李是大李的父亲;3大李是小李的父亲;问上述人员中谁和谁是祖孙关系15解释下列模糊性知识:1 张三,体型,胖,;2 患者,症状,头疼, ∧患者,症状,发烧, →患者,疾病,感冒,16. 简单阐述产生式系统的组成;17. 试用线性消解策略证明:子句集S={ P∨Q, ﹁P∨R, ﹁Q∨R, ﹁R }是可消解的;18广度优先搜索与深度优先搜索各有什么特点19.语义网络可以表达事物之间的哪些关系20.假设已知下列事实:1超市Supermarket卖Sail的商品Goods便宜Cheap;2王Wang买Buy需要的Want便宜商品;3自行车Bicycle是商品且超市卖自行车;4王需要自行车;5赵Zhao跟随王买同样的商品;请应用归结反演证明方法回答以下问题:1王买自行车吗2赵买什么商品21.已知一个使用可信度方法的推理网络如图所示,其证据的可信度均标示在图中;推理规则的可信度分别为:A∧B →H, C∨D→H, E→H,试按照可信度方法的求解步骤计算每个证据节点对假设H推理的可信度,并据此推算全部证据复合证据对于H推理的可信度;22. 求子句Rx, y∨﹁QB, y∨Wx, fy 和Rx, C∨Qy, C 的归结式;23. 何谓估价函数启发式图搜索的A算法和A算法最显着的区别是什么24. 什么是置换置换是可交换的吗25. 给1~9九个数字排一个序列,使得该序列的前nn=1,...,9 个数字组成的整数能被n整除;1、讨论哪些知识可以帮助该问题的求解;2、用产生式系统描述该问题.26. .α-β剪枝的条件是什么27将下列自然语言转化为谓词表示形式:1所有的人都是要呼吸的;2每个学生都要参加考试;3 任何整数或是正的或是负的;28、人工智能主要有哪几种研究途径和技术方法,简单说明之;三、1、1将下列谓词公式化成子句集2把下列谓词公式分别化成相应的子句集:xyPx,y→~yQx,y→Rx,y2.若谓词公式E=Px,fy,z,置换s1={fx,y/z,z/w},s2={a/x,b/y,w/z},求Es1·s2,Es2·s1;3.用加权图的启发式搜索算法不能用Dijkstra算法求解下列问题:下图是一个交通图,设A是出发地,E是目的地,边上的数字表示两城市之间的交通费;求从A到E最小费用的旅行路线,画出搜索树,画出Closed表和Open表的变化过程;4.用标准逻辑经典逻辑,谓词逻辑的子句集表示下述刑侦知识,并用反演归解的线性策略证明结论现定义如下谓词其项变量X,Y,Z,皆为全称量词;ThiefX-----某人X是贼;LikesX,Y------某人X喜欢某物Y;May-stealX,Y------某人X可能会偷窃某物Y;5.用子句集表达下述刑侦知识:I. John是贼;II. Paul喜欢酒wineIII. Paul 也喜欢奶酪cheeseIV. 如果Paul喜欢某物则John 也喜欢某物;V. 如果某人是贼,而且他喜欢某物,则他就可能会偷窃该物;6.求证结论:John可能会偷窃了什么即求证目标:may-stealJohn,Z, Z=要求将求证目标作为顶子句,按线性策略进行归结推理,注明每次求归结式所进行的置换及其父子句的编号7.1已知一组规则和证据事实:R1:A1→B1,CFB1,A1=R2:A2→B1,CFB1,A2=R3:B1∧A3->B2,CFB2,B1∧A3=初始证据A1,A2,A3,并且CFA1=CFA2=CFA3=1, 并且初始时对B1,B2一无所知;根据Shortliffe的确定性理论可信度方法,求证据B1,B2的可信度在执行规则R1,R2,R3后的更新值CFB1,CFB2;2已知有如下不确定推理规则:r1:C11∨C12 T H1 ;r2:H1 T H ;r3:C21∧C22 T H -;r4:C31∧C32∨C33 T H ;CFC11 = , CFC12 = ,CFC21 = ,CFC22 = ,CFC31 = ,CFC32 = ,CFC33 =;请应用MYCIN的确定性方法求出CFH;8.设有A,B,C三人中有人从不说真话,也有人从不说假话,某人向这三人分别提出同一个问题:谁是说谎者A 答:“B 和C都是说谎者”;B答:“A和C都是说谎者”;C答:“A和B中至少有一个是说谎者”;求谁是老实人,谁是说谎者15分9. 1设已知:1能阅读者是识字的;2海豚不识字;3有些海豚是聪明的;求证:有些聪明者并不能阅读.2利用谓词逻辑表示下列知识包括已知和结论,然后化成子句集:1凡是清洁的东西就有人喜欢;2人们都不喜欢苍蝇求证:苍蝇是不清洁的;10. 八数码游戏,初始棋局和目标棋局如图,定义启发函数hx表示某状态下与目标数码不同的位置个数,用全局择优法画出搜索的过程;初始状态:,目标状态:11. 张某被盗,公安局派了五个侦察员去调查;研究案情时,侦察员A说:“赵与钱中至少有一人作案”;侦察员D说:“钱与孙至少有一人作案”;侦察员C说:“孙与李中至少有一个作案”;侦察员D说“赵与孙至少一个与案无关”;侦察员E说“钱与李中至少有一人与此案无关”;如果这五个侦察员的话都是可信的,试用消解原理推理求出谁是盗窃犯;12. 某企业欲招聘一个JAVA程序员,定义如下产生式规则要求:r1: IF有工作经验 or 本科以上学历 and 有相关知识背景 then 录用r2:IF 工作两年以上 and 作过相关工作 then 有工作经验r3:IF 学过数据结构 and 学过JAVA and 学过数据库 and 学过软件工程 then 有相关知识背景r4:学过数据结构相关课程的成绩/100r5:学过JAVA相关课程的成绩/100r6:学过数据库相关课程的成绩/100r7:学过软件工程相关课程的成绩/100 r8:做过相关工作:JAVA 程序员:1,项目经理:1,数据库开发工程师:,数据库管理员:,网络管理员:,客服人员: 设有一本科毕业生甲,其相关课程的成绩为数据结构=85,JAVA=80,数据库=40,软件工程=90 另有一社会招聘人员乙,参加工作三年,曾做过数据库管理员和数据库开发人员根据确定性理论,问该公司应该招聘谁如果你是该本科生,为了能在招聘中胜出,你应该加强哪门课程,并使该门课程的成绩至少达到多少13. 某问题由下列公式描述: 试用归结法证明xRx ;14. 下图所示博弈树,按从左到右的顺序进行α-β剪枝搜索,试标明各生成节点的到推值,何处发生剪枝,及应选择的走步;10分15.剪枝方法只是极小极大方法的一种近似,剪枝可能会遗漏掉最佳走步;这种说法是否正确 1. 什么是人工智能人工智能与计算机程序的区别 2.答:AI 是研究如何制造人造的智能机器或智能系统来模拟人类智能活动的能力以延伸人类智能的科学,它与计算机程序的区别是: AI 研究的是符号表示的知识而不是数值数据为研究对象 AI 采用启发式搜索方法而不是普通的算法 控制结构与知识是分离的允许出现不正确的答案 3. 化下列逻辑表达式为不含存在量词的前束范式 答: 4.求下列谓词公式的子句集答:所以子句集为: {),(),(~),,(),(~y x R y x Q y x R y x P ∨∨}5. 若有梯形ABCD,将其中的若干定理形式化即定义一些谓词公式,然后利用归结原理证明内错角CDB ABD ∠=∠证明:设梯形顶点依次为a,b,c,d,定义谓词: Tx,y,u,v:表示xy 为上底,uv 为下底的梯形. Px,y,u,v:表示xy||uvEx,y,z,u,v,w 表示∠xyz=∠uvw,问题的描述和相应的子句集为 xyuvTx,y,u,v →Px,y,u,v...梯形上下底平行 子句:~Tx,y,u,v ∨Px,y,u,vxyuvPx,y,u,v →Ex,y,v,u,v,y...平行则内错交相等子句:Ta,b,c,d...已知 子句:Ta,b,c,dA B DEa,b,d,c,d,b...要证明的结论子句:~Ea,b,d,c,d,b 子句集S 为~Tx,y,u,v ∨Px,y,u,v ~Px,y,u,v ∨Ex,y,v,u,v,y Ta,b,c,d ~Ea,b,d,c,d,b 下面利用归结原理证明 Pa,b,c,d 1和3归结,置换{a/x,b/y,c/u,d/v} Ea,b,d,c,d,b 2和5归结,置换{a/x,b/y,c/u,d/v} NIL4和6归结根据归结原理得证; 6.求子句集{}f(u))u),h(z,P(z,f(g(y)),a,P(x ,S =的MGU解:k=0;S0=S;δ0=ε;S0不是单元素集,求得差异集D0={a/z },其中z 是变元,a 是项,且z 不在a 中出现;k=k+1=1有δ1=δ0·{a/z }=ε·{a/z }={a/z },S1=S0·{a/z }={Pa,x,fgy,Pa,ha,u,fu,S1不是单元素集,求得差异集D1={x,ha,u },k=k+1=2;δ2=δ1·{ha,u/x }={a/z,ha,u/x }, S2=S1·{ha,u/x }={Pa,ha,u,fgy,Pa,ha,u,fu, S2不是单元素集,求得差异集D2={gy,u },k=k+1=3δ3=δ2·{gy/u }={a/z,ha,u/x }·{gy/u }={a/z,ha,gy/x,gy/u } S3=S2·{gy/u }={Pa,ha,gy,fgy }是单元素集; 根据求MGU 算法,MGU=δ3={a/z,ha,gy/x,gy/u } 7.用代价优先算法求解下图的旅行推销员问题,请找一条从北京出发能遍历各城市的最佳路径旅行费最少,每条弧上的数字表示城市间的旅行费用;并用CLOSED 表记录遍历过的结点,OPEN 表记录待遍历的结点;画出closed 和open 表的变化过程,然后根据closed 表找出最佳路径; 解: OPEN 表CLOSE 表8.用框架表示下述报导的沙尘暴灾害事件提示:分析概括用下划线标出的要点,经过概念化形成槽Slot并拟出槽的名称,选填侧面face值;侧面包含“值value”,“默认值default”,“如果需要值if-needed”,“如果附加值if-added”几个方面,用不到的侧面值可删除;解:1. 5分什么是“知识工程”它对人工智能的发展有何重要作用2. 10分请用相应的谓词公式表示下述语句:1有的人喜欢足球,有的人喜欢排球,有的人既喜欢足球又喜欢排球;2不是每一个人都喜欢游泳;3如果没有利息,那么就没有人愿意去存钱;4对于所有的x和y,如果x是y的父亲,y是z的父亲,那么x是z的祖父;5对于所有的x和y,如果x是y的孩子,那么y是x的父母;6登高望远;7响鼓不用重锤;8如果b>a>0和c>d>0,则有ba+c/d>b;3. 5分试建立一个“学生”框架网络,其中至少有“学生基本情况”、“学生课程学习情况”和“学生奖惩情况”三个框架描述;4. 10分请把下述事实用一个语义网络表示出来:1李明是东方大学计算机系的一名学生;2他住在计算机系的学生宿舍里;3计算机系的每间学生宿舍都有一台联网的计算机;4李明喜欢在宿舍的计算机上浏览;5. 10分已知下述事实:1小李只喜欢较容易的课程;2工程类课程是较难的;3PR系的所有课程都是较容易的;4PR150是PR系的一门课程;应用归结演绎推理回答问题:小李喜欢什么课程6. 10分已知:规则1:任何人的兄弟不是女性规则2:任何人的姐妹必是女性事实:Mary是Bill的姐妹用归结推理方法证明Mary不是Tom的兄弟;7. 15分考虑下面的句子:每个程序都存在Bug含有Bug的程序无法工作P是一个程序1一阶谓词逻辑表示上述句子;2使用归结原理证明P不能工作;8. 10分任何通过了历史考试并中了彩票的人都是快乐的;任何肯学习或幸运的人可以通过所有考试,小张不学习,但很幸运,任何人只要是幸运的就能中彩票;求证:小张是快乐的;9. 10分已知:海关职员检查每一个入境的不重要人物,某些贩毒者入境,并且仅受到贩毒者的检查,没有一个贩毒者是重要人物;证明:海关职员中有贩毒者;10. 15分有一堆硬币,开始时有9枚;A、B两人轮流从中取硬币,每次取时,可以取1枚或者2枚或者3枚,拣起最后一枚硬币者为输方;试用博弈树证明:后开始取硬币者总能获胜,或者先开始取硬币者总是会输;1. 5分一阶谓词逻辑表示法适合于表示哪种类型的知识它有哪些主要特点2. 10分请用语义网络分别表示下述语句:1与会者有男、有女,有的年老、有的年轻;2李明是图灵电脑公司的经理,他住在江滨路102号,今年38岁;3大门前的这棵树从春天到秋天都开花;4计算机系的每个学生都学习“人工智能原理”,它是计算机专业的一门主干课程;3. 10分已知前提:每个储蓄钱的人都获得利息;求证结论:如果没有利息,那么就没有人去储蓄钱;4. 10分已知前提:1某些病人喜欢所有的医生;2没有一个病人喜欢任何一个骗子;求证结论:任何一个医生都不是骗子;5. 10分下述公式集F是否可合一,若可合一,则求出F的最一般合一;1F={Pa,b,Px,y}2F={Pfx,b,Py,z}3F={Pfx,y,Py,fb}4F={Pfy,y,x,Px,fa,fb}6. 10分已知有些人喜欢所有的花,没有任何人喜欢任意的杂草,证明花不是杂草;7. 10分已知下述事实:1小杨、小刘和小林是高山俱乐部成员;2高山俱乐部的每个成员是滑雪者或登山者,或者既滑雪又登山;3没有一个登山者喜欢下雨;4所有滑雪者都喜欢下雪;5凡是小杨喜欢的,小刘就不喜欢;6凡是小杨不喜欢的,小刘就喜欢;7小杨喜欢下雨和下雪;试证明:俱乐部是否有是登山者而不是滑雪者的成员如果有,他是谁8. 10分把下列谓词公式分别化为相应的子句集:1∀x∀yPx,y∧Qx,y2∀x∀yPx,y→Qx,y3∀x∃yPx,y∨Qx,y→Rx,y4∀x∀y∃zPx,y→Qx,y∨Rx,z5∃x∃y∀z∃u∀v∃wPx,y,z,u,v,w∧Qx,y,z,u,v,w∨~Rx,z,w9. 10分1用子句集表示下述知识:①John是贼;②Paul喜欢酒wine;③Paul也喜欢奶酪cheese;④如果Paul喜欢某物,则John也喜欢;⑤如果某人是贼,而且喜欢某物,则他就可能会偷窃该物;2求解结论:John可能会偷窃什么10.15分五子棋棋盘是一个行、列皆有5个方格的5X5方格棋盘,A、B两人轮流投子,每次投一子于一个空的方格中,谁先布成五子成一线行、列、对角线均可,谁就获胜;请定义估价函数,并站在A的立场上,找出获胜的最佳走步;11、某公司招聘工作人员,A,B,C三人应试,经面试后公司表示如下想法:1 三人中至少录取一人;2 如果录取A而不录取B,则一定录取C;3 如果录取B,则一定录取C;求证:公司一定录取C;12、用语义网络表示下列命题1树和草都是植物2树和草都有根和叶3水草是草,它长在水中4果树是树,会结果5苹果树结苹果一、选择题每题1分,共15分1、人工智能是一门A数学和生理学B心理学和生理学C语言学D综合性的交叉学科和边缘学科2、语义网络表达知识时,有向弧AKO 链、ISA 链是用来表达节点知识的 ;A 无悖性B 可扩充性C 继承性3、A->B∧A => B是A附加律B拒收律C假言推理DUS4、命题是可以判断真假的A祈使句B疑问句C感叹句D陈述句5、仅个体变元被量化的谓词称为A一阶谓词B原子公式C二阶谓词D全称量词6、MGU是A 最一般合一 B最一般替换 C 最一般谓词D基替换最一般合一7、下列不在人工智能系统的知识包含的4个要素中A 事实B 规则C 控制D 关系8、当前归结式是时,则定理得证;A 永真式B 包孕式subsumedC 空子句9、或图通常称为A框架网络B语义图C博亦图D状态图10、不属于人工智能的学派是A符号主义 B 机会主义C行为主义D连接主义;11、所谓不确定性推理就是从的初始证据出发,通过运用的知识,最终推出具有一定程度的不确定性但却是合理或者近乎合理的结论的思维过程;A不确定性, 不确定性 B确定性, 确定性C确定性, 不确定性 D 不确定性确定性12.要想让机器具有智能,必须让机器具有知识;因此,在人工智能中有一个研究领域,主要研究计算机如何自动获取知识和技能,实现自。

人工智能知识点总复习(附答案)

知识点1.什么是人工智能?它的研究目标是什么?人工智能的研究目标远期目标揭示人类智能的根本机理,用智能机器去模拟、延伸和扩展人类的智能涉及到脑科学、认知科学、计算机科学、系统科学、控制论等多种学科,并依赖于它们的共同发展近期目标研究如何使现有的计算机更聪明,即使它能够运用知识去处理问题,能够模拟人类的智能行为。

相互关系远期目标为近期目标指明了方向近期目标则为远期目标奠定了理论和技术基础2.人工智能有哪几个主要学派?各自的特点是什么?人工智能研究的三大学派:随着人工神经网络的再度兴起和布鲁克(R.A.Brooks)的机器虫的出现,人工智能研究形成了符号主义、联结主义和行为主义三大学派。

符号主义学派是指基于符号运算的人工智能学派,他们认为知识可以用符号来表示,认知可以通过符号运算来实现。

例如,专家系统等。

联结主义学派是指神经网络学派,在神经网络方面,继鲁梅尔哈特研制出BP网络之后,人工神经网络研究掀起了第二次高潮。

之后,随着模糊逻辑和进化计算的逐步成熟,又形成了“计算智能”这个统一的学科范畴。

行为主义学派是指进化主义学派,在行为模拟方面,麻省理工学院的布鲁克教授1991年研制成功了能在未知的动态环境中漫游的有6条腿的机器虫。

智能科学技术学科研究的主要特征(1)由对人工智能的单一研究走向以自然智能、人工智能、集成智能为一体的协同研究;(2)由人工智能学科的独立研究走向重视与脑科学、认知科学、等学科的交叉研究;(3)由多个不同学派的独立研究走向多学派的综合研究;(4)由对个体、集中智能的研究走向对群体、分布智能的研究;(5)智能技术应用已渗透到人类社会的各个领域。

知识表示的类型按知识的不同存储方式:陈述性知识:知识用某种数据结构来表示;知识本身和使用知识的过程相分离。

过程性知识:知识和使用知识的过程结合在一起。

知识表示的基本方法非结构化方法:一阶谓词逻辑产生式规则结构化方法:语义网络框架知识表示的其它方法状态空间法和问题归约法。

人工智能复习资料(手工整理版)

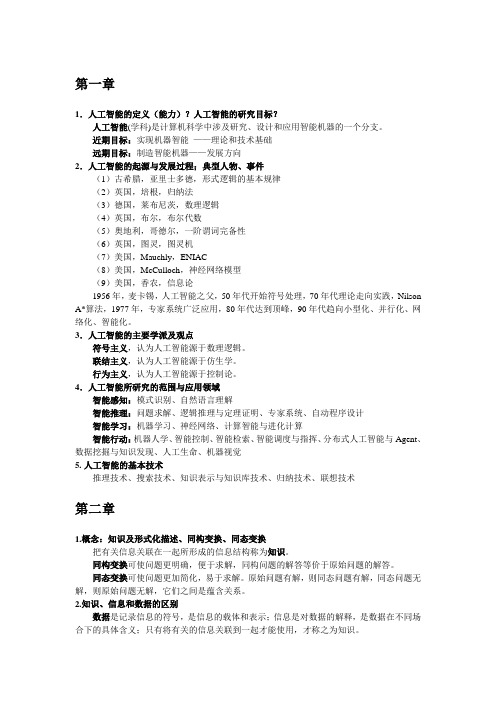

第一章1.人工智能的定义(能力)?人工智能的研究目标?人工智能(学科)是计算机科学中涉及研究、设计和应用智能机器的一个分支。

近期目标:实现机器智能——理论和技术基础远期目标:制造智能机器——发展方向2.人工智能的起源与发展过程;典型人物、事件(1)古希腊,亚里士多德,形式逻辑的基本规律(2)英国,培根,归纳法(3)德国,莱布尼茨,数理逻辑(4)英国,布尔,布尔代数(5)奥地利,哥德尔,一阶谓词完备性(6)英国,图灵,图灵机(7)美国,Mauchly,ENIAC(8)美国,McCulloch,神经网络模型(9)美国,香农,信息论1956年,麦卡锡,人工智能之父,50年代开始符号处理,70年代理论走向实践,Nilson A*算法,1977年,专家系统广泛应用,80年代达到顶峰,90年代趋向小型化、并行化、网络化、智能化。

3.人工智能的主要学派及观点符号主义,认为人工智能源于数理逻辑。

联结主义,认为人工智能源于仿生学。

行为主义,认为人工智能源于控制论。

4.人工智能所研究的范围与应用领域智能感知:模式识别、自然语言理解智能推理:问题求解、逻辑推理与定理证明、专家系统、自动程序设计智能学习:机器学习、神经网络、计算智能与进化计算智能行动:机器人学、智能控制、智能检索、智能调度与指挥、分布式人工智能与Agent、数据挖掘与知识发现、人工生命、机器视觉5.人工智能的基本技术推理技术、搜索技术、知识表示与知识库技术、归纳技术、联想技术第二章1.概念:知识及形式化描述、同构变换、同态变换把有关信息关联在一起所形成的信息结构称为知识。

同构变换可使问题更明确,便于求解,同构问题的解答等价于原始问题的解答。

同态变换可使问题更加简化,易于求解。

原始问题有解,则同态问题有解,同态问题无解,则原始问题无解,它们之间是蕴含关系。

2.知识、信息和数据的区别数据是记录信息的符号,是信息的载体和表示;信息是对数据的解释,是数据在不同场合下的具体含义;只有将有关的信息关联到一起才能使用,才称之为知识。

人工智能考试复习资料

⼈⼯智能考试复习资料⼈⼯智能第⼀章绪论1、智能(intelligence )⼈的智能是他们理解和学习事物的能⼒,或者说,智能是思考和理解能⼒⽽不是本能做事能⼒。

2、⼈⼯智能(学科)⼈⼯智能研究者们认为:⼈⼯智能(学科)是计算机科学中涉及研究、设计和应⽤智能机器的⼀个分⽀。

它的近期主要⽬标在于研究⽤机器来模仿和执⾏⼈脑的某些智⼒功能,并开发相关理论和技术。

3、⼈⼯智能(能⼒)⼈⼯智能(能⼒)是智能机器所执⾏的通常与⼈类智能有关的智能⾏为,这些智能⾏为涉及学习、感知、思考、理解、识别、判断、推理、证明、通信、设计、规划、⾏动和问题求解等活动。

4、⼈⼯智能:就是⽤⼈⼯的⽅法在机器上实现的智能,或者说,是⼈们使⽤机器模拟⼈类的智能。

5、⼈⼯智能的主要学派:符号主义:⼜称逻辑主义、⼼理学派或计算机学派,其原理主要为物理符号系统(即符号操作系统)假设和有限合理性原理。

代表⼈物有纽厄尔、肖、西蒙和尼尔逊等。

连接主义:⼜称仿⽣学派或⽣理学派,其原理主要为神经⽹络及神经⽹络间的连接机制与学习算法。

⾏为主义:⼜称进化主义或控制论学派,其原理为控制论及感知—动作模式控制系统。

6、⼈类认知活动具有不同的层次,它可以与计算机的层次相⽐较,见图⼈类计算机认知活动的最⾼层级是思维策略,中间⼀层是初级信息处理,最低层级是⽣理过程,即中枢神经系统、神经元和⼤脑的活动,与此相对应的是计算机程序、语⾔和硬件。

研究认知过程的主要任务是探求⾼层次思维决策与初级信息处理的关系,并⽤计算机程序来模拟⼈的思维策略⽔平,⽽⽤计算机语⾔模拟⼈的初级信息处理过程。

7、⼈⼯智能研究⽬标为:1、更好的理解⼈类智能,通过编写程序来模仿和检验的关⼈类智能的理论。

思维策略初级信息处理⽣理过程计算机程序计算机语⾔计算机硬件图:⼈类认知活动与计算机的⽐2、创造有⽤和程序,该程序能够执⾏⼀般需要⼈类专家才能实现的任务。

⼀般来说,⼈⼯智能的研究⽬标⼜可分为近期研究⽬标和远期研究⽬标两种。

最新华南理工大学人工智能期末考试卷题整理

华南理工大学人工智能期末考试卷题整理二、简答题1.什么是人工智能,哪些阶段答:人工智能研究的是如何运用知识,以便像人类一样完成富有智能的工作,就人工智能的本质而言,可以认为人工智能是一门研究如何制造出人造的智能机器或智能系统,来模拟人类智能活动的能力,以延伸人们智能的科学。

人工智能发展阶段(1)萌芽期(1956年以前)(3)形成时期(1956-1961年)(3)发展时期(1961年以后)2.不确定性推理的“不确定性”在?答:在不确定推理中,规则前件(证据)、后件(结论)以及规则本身在某种程度上都是不确定的。

(1)证据的不确定性:歧义性、不完全性、不精确性模糊性、可信性、随机性和不一致性(2)规则的不确定性:证据的组合的不确定性、规则自身的不确定性规则、结论的不确定性;(3)推理的不确定性;3.列两种知识表示方法和优缺点。

(1)脚本知识表示方法:脚本结构比起语义网络、框架机构等通用结构来要呆板得多,知识表达范围也很窄,因此不适用于表达各种知识。

但对于表达事先构思好的特定知识非常有效。

(2)过程性知识表示方法:过程性知识表示的最主要特点是效率高。

过程性知识表示的主要缺点就是不易修改和添加知识。

4.画机器学习基本构成,分环节作用(1)环境:环境是以某种形式表达的外界信息集合,它代表外界信息来源;(2)知识库:知识库在初始阶段要有相当的初始知识,并且在学习过程中不断修正和增加新的知识:(3)学习环节:在机器学习的整个系统结构中,学习部分是核心模块,是和外部交互的接口;(4)执行环节:执行部分是根据知识库执行一系列任务,同时把执行结果过执行过程中获得的信息反馈给学习部分,完成对新知识库的评价,指导进一步的工作。

5.说常规与高级搜索的区别常规搜索可以找到最优解,但是.即便是A*算法,一般情况下,其算法复杂性仍然是指数时间级的,因此,当问题的规模大到一定程度后,常规搜索就显得无能为力了,而高级搜索放弃每次必然找到最优解的目标,换取算法时间复杂度的降低,适合于求解大规模的优化问题。

《人工智能》知识点整理

《人工智能》知识点整理第二讲知识表示2.0.知识表示的重要性知识是智能的基础:获得知识、运用知识符合计算机要求的知识模式:计算机能存储、处理的知识表示模式;数据结构(List, Table, Tree, Graph, etc.)2.1 基本概念2.1.1 数据、信息与知识数据(Data)⏹信息的载体和表示⏹用一组符号及其组合表示信息信息(Information)⏹数据的语义⏹数据在特定场合下的具体含义知识(Knowledge)⏹信息关联后所形成的信息结构:事实& 规则⏹经加工、整理、解释、挑选、改造后的信息2.1.2 知识的特性⏹相对正确性⏹一定条件下⏹某种环境中⏹......⏹不确定性⏹存在“中间状态”⏹“真”(“假”)程度⏹随机性⏹模糊性⏹经验性⏹不完全性⏹...... ⏹可表示性& 可利用性⏹语言⏹文字⏹图形⏹图像⏹视频⏹音频⏹神经网络⏹概率图模型⏹......2.1.3 知识的分类⏹常识性知识、领域性知识(作用范围)⏹事实性知识、过程性知识、控制知识(作用及表示)⏹确定性知识、不确定性知识(确定性)⏹逻辑性知识、形象性知识(结构及表现形式)⏹零级知识、一级知识、二级知识(抽象程度)2.1.4 常用的知识表示方法⏹一阶谓词(First Order Predicate)⏹产生式(Production)⏹框架(Framework)⏹语义网络(Semantic Network)⏹剧本(Script)⏹过程(Procedure)⏹面向对象(Object-Oriented)⏹Petri网(Petri Network)⏹信念网(Belief Network)⏹本体论(Ontology)……2.1.5 如何选择合适的表示方法?⏹充分表示领域知识⏹有利于对知识的利用⏹便于理解和实现⏹便于对知识的组织、管理与维护2.2 一阶谓词表示法1. 优点⏹自然性⏹接近自然语言,容易接受⏹精确性⏹用于表示精确知识⏹严密性⏹有严格的形式定义和推理规则⏹易实现性⏹易于转换为计算机内部形式2. 缺点⏹无法表示不确定性知识⏹所能表示的知识范围太狭窄⏹难以表示启发性知识及元知识⏹未能充分利用与问题本身特性有关的知识⏹组合爆炸⏹经常出现事实、规则等的组合爆炸⏹效率低⏹推理与知识的语义完全割裂2.3 产生式表示法⏹1943年E. Post第一次提出⏹称为“Post机”的计算模型(《计算理论》)⏹一种描述形式语言的语法⏹AI中应用最多的知识方法之一⏹Feigenbaum研制的化学分子结构专家系统DENDRAL⏹Shortliffe研制的的诊断感染性疾病的专家系统MYCIN⏹……2.3.1 产生式的基本形式P → Q 或IF P THEN Q CF = [0, 1]其中,P是产生式的前提,Q是一组结论或操作,CF(Certainty Factor)为确定性因子,也称置信度。

人工智能总复习

②选择下一个被考察结点的标准。有三种不同的标准:

●

d(N)——搜索树中从S0到N的路径长度;

● g(N)——代价树中从S0到N的路径的代价;

● f(N)——代价树中从 S0出发,经过N结点再到 Sg 的路径的最小代价。它既考虑了已经付出的代价g(N), 又对将要付出的代价给出了估计h(N),所以比d(N)和 g(N)都要准确。

2.5.2 “二人零和、全信息、非偶然”博

弈

诸如下棋、打牌、竞技、战争等一类竞争性智 能活动称为博弈。其中最简单的一种称为“二人零 和、全信息、非偶然”博弈。所谓“二人零和、全 信息、非偶然”博弈是指: (1)对垒的A,B双方轮流采取行动,博弈的结 果只有三种情况:A方胜,B方败;B方胜,A方败; 双方战成平局。 (2)在对垒过程中,任何一方都了解当前的格局

1. 广度优先搜索 广度优先搜索就是始终先在同一级节点 中考查,只有当同一级节点考查完之后,才考查 下一级节点。或者说,是以初始节点为根节点, 向下逐级扩展搜索树。所以,广度优先策略的搜 索树是自顶向下一层一层逐渐生成的。又称宽度 优先或横向搜索。

广度优先:扩展当前节点后生成的子节点总是置于 OPEN表的尾端,即OPEN表作为FIFO的队列使用, 使搜索优先向横广方向发展。CLOSED表是一个顺 序表,正被考察的节点在表中编号最大。 广度优先搜索的优点:能确保找到最短解路径。如 果问题的解存在,用此搜索法一定能找到解,且找 到的解还是最优解(即最短的路径)。 缺点是搜索效率低。

2.深度优先搜索 深度优先搜索就是在搜索树的每一层始终 先只扩展一个子节点,不断地向纵深前进,直 到不能再前进(到达叶子节点或受到深度限制) 时,才从当前节点返回到上一级节点,沿另一 方向又继续前进。这种方法的搜索树是从树根 开始一枝一枝逐渐形成的。

人工智能经典习题集及各章总结

人工智能经典习题集及各章总结第一部分绪论习题解答:1.什么是人工智能?进展过程中经历了什么阶段?解:人工智能是计算机科学的一个重要分支,也是一门正在进展中的综合性前沿学科,它是由计算机科学、操纵论、信息论、神经生理学、哲学、语言学等多种学科相互渗透而进展起来的,目前正处于进展阶段尚未形成完整体系。

进展过程中经历的阶段有:第一阶段(40年代中~50年代末)神经元网络时代第二阶段(50年代中~60年代中)通用方法时代第三阶段(60年代中~80年代初)知识工程时代第四阶段(80年代中~90年代初)新的神经元网络时代第五阶段(90年代初~现在)海量信息处理与网络时代2.人工智能研究的基本内容是什么?解:基本内容是:搜索技术、知识表示、规划方法、机器学习、认知科学、自然语言懂得与机器翻译、专家系统与知识工程、定理证明、博弈、机器人、数据挖掘与知识发现、多Agent系统、复杂系统、足球机器人、人机交互技术等。

3.人工智能要紧有哪几大研究学派?解:(1)符号主义学派:由心理学途径产生,符号主义认为人工智能起源于数理逻辑,人类认识(智能)的基本元素是符号,而智能行为则是符号运算的结果。

(2)连接主义学派:由生理学途径产生,连接主义又称之仿生学派,认为人工智能的基本元素是神经元,智能产生于大量神经元的并行分布式联结之中,而智能行为则是联结计算的结果。

(3)行为主义学派:由生物演化途径产生,行为主义认为人工智能起源于操纵论,提出智能取决于感知与行为,取决于对外界复杂环境的习惯,而不是表示与推理。

4.人工智能有什么要紧的研究领域?解:(1)问题求解(2)逻辑推理与定理证明(3)自然语言懂得(4)自动程序设计(5)专家系统(6)机器学习(7)神经网络(8)机器人学(9)模式识别(10)机器视觉(11)智能操纵(12)智能检索(13)智能调度与指挥(14)分布式人工智能与Agent(15)计算智能与进化计算(16)数据挖掘与知识发现(17)人工生命(18)系统与语言工具第2部分知识与知识表示本章小结:习题解答:1 设有如下问题:(1)有五个相互可直达且距离已知的城市A、B、C、D、E,如图所示;(2)某人从A地出发,去其它四个城市各参观一次后回到A;(3)找一条最短的旅行路线请用产生式规则表示旅行过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

= {a/x, f(u)/y ,y/z},λ ={b/u,z/y,g(x)/z}

{a/x,f(b)/y ,z/z,b/u,z/y,g(x)/z},删去:

/z,z/y,g(x)/z

θ·λ= {a/x, f(b)/y ,b/u}

合一:F1λ=F2λ=…=Fnλ则λ为F的合一,F为可合一的 (一个公式的合一一般不唯一) 最一般合一:σ为F的一个合一,如果对F任何合一θ都存在λ使得θ = σ ?λ,则σ为F的最一般合一,极为MGU(一个公式集的MGU不唯一) 差异集:S是具有相同谓词名的原子公式集,从各公式左边开始,同时向右比较,直到发现第一个不都相同的项为止,用这些项的差异部分组成的集合 【合一算法】 Step1:置k=0,Fk=F, σk =ε; Step2:若Fk只含有一个谓词公式,则算法停止, σk就是最一般合一; Step3:求Fk的差异集Dk; Step4:若Dk中存在元素xk和tk ,其中xk是变元, tk是项且xk不在tk中出现,则置Sk +1=Fk{tk/ xk} ,σk+1= σk ?{tk/ xk} ,k=k+1然后转Step2; Step5:算法停止,F的最一般合一不存在。 对任一非空有限可合一的公式集,一定存在最一般合 一,而且用合一算法一定能找到最一般合一 【合一算法例子】 求公式集F={Q(a,x,f(g(y))),Q(z,h(z,u),f(u))}的最一般合一 解: 解 k=0; F0=F,σ0=ε,D0={a,z} σ1= σ0·{a/z}= {a/z} F1= F0{a/z}= {Q(a,x,f(g(y))),Q(a,h(a,u),f(u))} k=1; D1={x, h(a,u)} σ2= σ1·{h(a,u) /x}= {a/z,h(a,u) /x} F2= F1{a/z, h(a,u) /x}= {P(a, h(a,u) ,f(g(y))),P(a,h(a,u),f(u))} k=2; D2={g(y),u} σ3= {a/z ,h(a, g(y)) /x ,g(y)/u} F3= F2{g(y)/u}= {P(a,h(a,g(y)),f(g(y)))} S3单元素集 , σ3为MGU。 【谓词逻辑中的归结原理定义】 二元归结式(二元消解式): (C1 σ -{L1 σ}) ∪ ( C2 σ- {L2 σ}),其中: 亲本子句:C1,C2为无相同变元的子句 消解文字:L1,L2 σ为L1和?L2的最一般合一 因子:C σ。其中σ为C的子句文字的最一般合一 单因子:C σ为单元句子

Nil。

1)简化性策略。

2)限制性策略。 (3)有序性策略(包含排序策略) 【归结策略类型】 删除策略 支持集策略 线性归结策略 单元归结策略 语义归结策略 祖先过滤型策略 【正向演绎推理--初始事实F0】 任意谓词公式 前束范式表示;消去量词,改名 与或图表示:析取部分用与节点表示 合取部分用或节点表示 【正向演绎推理-- F-规则】 形如 L=>W,L为单一文字 W为任意与或型谓词公式;(消去量词,改名) 【正向演绎推理—目标谓词】 文字的析取式(消去量词,改名) 【正向演绎推理图解】 012':()(()())':()()':()()':()()FPxQxRxFPySyFQzNzGSaNa ? P(x)∨(Q(x)∧R(x))Q(x)∧R(x)? P(x)Q(x)R(x)Q(z)? P(y)N(x)? S(x)F0F1 {x/z}F2 {x/y}{a/x}{a/x}N(a)? S(a) 【代换集一致性】 设有代换集{u1,u2,…,un},其中每个ui都是代换{ti1/ vi1, ti2/ vi2,…, tim(i)/ vim(i)} U1={v

,f(x)) ? R(x,g(x)) ]

标准型与原公式一般并不等价

:G是F1、F2 、… 、Fn的逻辑结论,当

I,如果F1、F2 、… 、Fn都为真,则

也为真。F1、F2 、… 、Fn为G的前提。

:L与?L

C1包含L1,C2包含L2,L1与L2互补。把L1和

删除,并把剩余部分析取,得到C12

函数值=子节点价值+子节点与父节

PP3 Ch3.P117-120

对手(MIN)力图干扰MAX的选择。因此站在我方

MAX)的立场,由MIN出棋的结点具有与结点的性质。

我方(MAX)力图通往取胜。MAX出棋的结点

,β剪枝】

剪枝:对MIN节点,若其倒推上确界β不大于MIN的父

α,即α≥β,则不必扩展该MIN节点其余

:若Nil在CLAUSES,归结成功

:若CLAUSES存在可归结子句对,则归结,并将归

CLAUSES表,step2

:归结失败

step3的搜索次序

:0层(原子句集S)两两进行归结,产生1层

:1层与0、1层两两进行归结,得到2层

:2层与0、1、2层两两进行归结,得到3层

Nil

如果对于不可满足的子句集,使

, …, vim(1),…, vn1, …, vnm(n)}(所有下边的变量)

={t

, …, tim(1),…, tn1, …, tnm(n)} (所有上边的项)

,u2,…,un}是一致的,当且仅当U1和U2是可合一

剪枝:对MAX节点,若其倒推下确界α不小于MAX的

β,即α≥β,则不必扩展该MAX节点

Ch 3. 【离散数学相关定义】 命题(proposition):具有真假意义的语句 谓词(predicate):刻画个体的性质、状态或个体间的关系,例如P(x,y): x是y的父亲 个体域:个体变元的变化范围。(如P(x,y)中,x,y是变元) 全总个体域:包揽一切事物的集合 函数:个体之间的对应关系,例如father(x): 值为x的父亲 项:个体常元和变元都是项。若t1,t2,,,tn是项,则f( t1,t2,,, tn )是项 原子公式:若t1,t2,,,tn为项,P(t1,t2,,,tn)称为原子谓词公式,简称原子或原子公式 谓词公式:原子公式是谓词公式。若A、B是谓词公式,则? A,A∪B等都是谓词公式 辖域:紧接于量词之后被量词作用的谓词公式 指导变量:量词后的变量 约束变量:量词辖域中,与该量词的指导变元相同的变量 自由变量:除了约束变量之外的变量 一阶谓词:仅个体变元被量化的谓词 二阶谓词:个体变元、函数符号、谓词符号被量化 从谓词公式得到命题: (1)把谓词中的个体变元代入个体常元 (2)把谓词中的个体变元全部量化 如P(x)表示"x是素数", 则x P(x),P(a)都是命题 合取范式:B1 B2 … Bn,如 (()())(()())(()())PxQxQyRyPzSz8 析取范式:B1 B2 … Bn,如 (()())(DyLayPxCzPuLuv,(()())())(,)) 谓词公式永真性:P对个体域D全部成立,则P在D上永真。P在全总个体集成立,则P永真 谓词公式可满足性:P对个体域D至少有一个个体成立,则P在D上可满足。 【常用逻辑等价式】

C2 =>(C1 σ -{L1 σ}) ∪ ( C2 σ- {L2 σ})

S是不可满足的,那么必存在一个由S推出空

:前提化为子句集S

:确定目标谓词,化为子句,并析取助谓词新子句,

S形成S’。

:对S’应用归结原理。

:当只剩辅助谓词时,归结结束。

例子见CH3 P105 )

:子句集S置入CLAUSES表

FG,,

:初始状态的集合

:操作的集合

:目标状态的集合

07{}{}{}QabcQQ,,,,,

表:已生成但没考察的节点(待考察节点)

表:考察过的节点及节点间关系(搜索树)

/深度优先搜索特点】

:完备的(一定能找到最优解),搜索效率低,OPEN

:不能保证找Leabharlann 最优解,OPEN表为堆栈结构 :即使能求出解,也不一定是最优

:深度可变,每次深度超过阈值

(在CLOSED表中)

:考虑所有待考察节点

:只考虑当前节点的子节点 【A*算法】 f(x) =g(x)+h(x) g(x)为当前点的代价 h(x)为距离目标的距离 A*对A算法的改进: 对h(x)作限制,使其总是小于实际最小距离h(x) h* (x),具有完备性 【与或图】 Q与Q1,Q2与等价(即Q可以分解为Q1+Q2) Q1与{Q1i},{Q1i’}或等价(即Q1可以转换为{Q1i}或{Q1i’}) 【与或图中的概念】 本原问题:直接可解的问题。 终止节点:本原问题对应的节点 端节点: 无子节点的节点 与节点: 子节点为与关系 或节点: 子节点为或关系 【与或图的广度/深度搜索】 Step1:S0放入OPEN表 Step2:OPEN表第一个点(记为N)取出放入CLOSED表,冠以编号n。 Step3:若n可扩展: (1)扩展N,其子节点放入OPEN表(深度:尾部,广度:首部) (2)考查这些节点是否终止节点。若是,放入CLOSED表,标为可解节点,并对先辈点标示。若S0被标可解,得解。 (3)从OPEN表删除具有可解先辈的节点。转Step2。 Step4:若N不可扩展: (1)标示N为不可解。 (2)标示先辈节。若S0被标不可解,失败。 (3)从OPEN表删除具有不可解先辈的节点。转Step2。

E在θ下的例

/乘积:

= {t1/x1, t2/x2, …, tm/xm},

= {u1/y1, u2/y2, …, un/yn},

{t1λ/x1,t2λ/x2,…,tmλ/xm ,u1/y1,u2/y2,…,un/yn}中:

λ/xi 当tiλ= xi

当yi∈ {x1,…, xn}

θ 与λ 的复合或乘积,记为θ ?λ

RSPC12

C

,C2归结式,是下列二元归结式之一:

1) C

和C2的二元归结式;

2) C

和C2的因子的二元归结式;